ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

04.11.2024 à 17:18

La société est biaisée, et cela biaise les IA… voici des pistes de solutions pour une IA vertueuse et une société plus inclusive

Sara Bouchenak, Professeure d'Informatique - INSA Lyon, INSA Lyon – Université de Lyon

Texte intégral (2063 mots)

Les données utilisées pour entraîner les IA reflètent les stéréotypes et les préjugés de la société, par exemple envers des groupes sous-représentés. Pour conserver la confidentialité de données sensibles, comme les données de santé, tout en garantissant qu’elles ne sont pas biaisées, il faut adapter les méthodes d’apprentissage.

Plusieurs scandales ont éclaté ces dernières années, mettant en cause des systèmes d’aide à la décision basés sur l’intelligence artificielle (IA) qui produisent des résultats racistes ou sexistes.

C’était le cas, par exemple, de l’outil de recrutement d’Amazon qui exhibait des biais à l’encontre des femmes, ou encore du système guidant les soins hospitaliers dans un hôpital américain qui privilégiait systématiquement les patient de couleur blanche par rapport aux patients noirs. En réponse au problème de biais dans l’IA et les algorithmes d’apprentissage automatique, des législations ont été proposées, telles que le AI Act dans l’Union européenne, ou le National AI Initiative Act aux États-Unis.

Un argument largement repris concernant la présence de biais dans l’IA et les modèles d’apprentissage automatique est que ces derniers ne font que refléter une vérité de terrain : les biais sont présents dans les données réelles. Par exemple, des données de patients ayant une maladie touchant spécifiquement les hommes résultent en une IA biaisée envers les femmes, sans que cette IA ne soit pour autant incorrecte.

Si cet argument est valide dans certains cas, il existe de nombreux cas où les données ont été collectées de manière incomplète et ne reflètent pas la diversité de la réalité terrain, ou encore des données qui incluent des cas statistiquement rares et qui vont être sous-représentés, voire non représentés dans les modèles d’apprentissage automatique. C’est le cas, par exemple, de l’outil de recrutement d’Amazon qui exhibait un biais envers les femmes : parce que les femmes travaillant dans un secteur sont statistiquement peu nombreuses, l’IA qui en résulte rejette tout simplement les candidatures féminines.

À lire aussi : Le cruel dilemme des données de santé à l’ère de l’IA : vie privée ou équité ?

Et si plutôt que refléter, voire exacerber une réalité actuelle dysfonctionnelle, l’IA pouvait être vertueuse et servir à corriger les biais dans la société, pour une société plus inclusive ? C’est ce que proposent les chercheurs avec une nouvelle approche : l’« apprentissage fédéré ».

Vers une IA décentralisée

Les systèmes d’aide à la décision basés sur l’IA se basent sur des données. En effet, dans les approches classiques d’apprentissage automatique, les données provenant de plusieurs sources doivent tout d’abord être transmises à un dépôt (par exemple, un serveur sur le cloud) qui les centralise, avant d’exécuter un algorithme d’apprentissage automatique sur ces données centralisées.

Or ceci soulève des questions de protection des données. En effet, conformément à la législation en vigueur, un hôpital n’a pas le droit d’externaliser les données médicales sensibles de ses patients, une banque n’a pas le droit d’externaliser les informations privées des transactions bancaires de ses clients.

À lire aussi : Emploi, sécurité, justice : d’où viennent les « biais » des IA et peut-on les éviter ?

Par conséquent, pour mieux préserver la confidentialité des données dans les systèmes d’IA, les chercheurs développent des approches basées sur une IA dite « distribuée », où les données restent sur les sites possesseurs de données, et où les algorithmes d’apprentissage automatique s’exécutent de manière distribuée sur ces différents sites – on parle également d’« apprentissage fédéré ».

Concrètement, chaque possesseur de données (participant à l’apprentissage fédéré) entraîne un modèle local sur la base de ses propres données, puis transmet les paramètres de son modèle local à une entité tierce qui effectue l’agrégation des paramètres de l’ensemble des modèles locaux (par exemple, via une moyenne pondérée selon le volume de données de chaque participant). Cette dernière entité produit alors un modèle global qui sera utilisé par les différents participants pour effectuer leurs prédictions.

Ainsi, il est possible de construire une connaissance globale à partir des données des uns et des autres, sans pour autant révéler ses propres données et sans accéder aux données des autres. Par exemple, les données médicales des patients restent dans chaque centre hospitalier les possédant, et ce sont les algorithmes d’apprentissage fédéré qui s’exécutent et se coordonnent entre ces différents sites.

Avec une telle approche, il sera possible pour un petit centre hospitalier dans une zone géographique moins peuplée que les grandes métropoles – et donc possédant moins de données médicales que dans les grands centres hospitaliers, et par conséquent, possédant a priori une IA moins bien entraînée – de bénéficier d’une IA reflétant une connaissance globale, entraînée de manière décentralisée sur les données des différents centres hospitaliers.

D’autres cas d’applications similaires peuvent être mentionnés, impliquant plusieurs banques pour construire une IA globale de détection de fraudes, plusieurs bâtiments intelligents pour déterminer une gestion énergétique appropriée, etc.

Les biais dans l’IA décentralisée sont plus complexes à appréhender

Comparé à l’approche classique d’apprentissage automatique centralisé, l’IA décentralisée et ses algorithmes d’apprentissage fédéré peuvent, d’une part, exacerber encore plus le biais, et d’autre part, rendre le traitement du biais plus difficile.

En effet, les données locales des participants à un système d’apprentissage fédéré peuvent avoir des distributions statistiques très hétérogènes (des volumes de données différents, des représentativités différentes de certains groupes démographiques, etc.). Un participant contribuant à l’apprentissage fédéré avec un grand volume de données aura plus d’influence sur le modèle global qu’un participant avec un faible volume de données. Si ce dernier est dans d’une certaine zone géographique qui représente un groupe social en particulier, celui-ci ne sera malheureusement pas, ou très peu, reflété dans le modèle global.

Par ailleurs, la présence de biais dans les données d’un des participants à un système d’apprentissage fédéré peut entraîner la propagation de ce biais vers les autres participants via le modèle global. En effet, même si un participant a veillé à avoir des données locales non biaisées, il héritera du biais présent chez d’autres.

Et plus difficiles à corriger

De plus, les techniques classiquement utilisées pour prévenir et corriger le biais dans le cas centralisé ne peuvent pas s’appliquer directement à l’apprentissage fédéré. En effet, l’approche classique de correction du biais consiste principalement à prétraiter les données avant l’apprentissage automatique pour que les données aient certaines propriétés statistiques et ne soient donc plus biaisées ?

À lire aussi : Apprendre à désapprendre : le nouveau défi de l’intelligence artificielle

Or dans le cas d’une IA décentralisée et d’apprentissage fédéré, il n’est pas possible d’accéder aux données des participants, ni d’avoir une connaissance des statistiques globales des données décentralisées.

Dans ce cas, comment traiter le biais dans les systèmes d’IA décentralisée ?

Mesurer le biais de l’IA sans avoir accès aux données décentralisées

Une première étape est de pouvoir mesurer les biais des données décentralisées chez les participants à l’apprentissage fédéré, sans avoir directement accès à leurs données.

Avec mes collègues, nous avons conçu une nouvelle méthode pour mesurer et quantifier les biais dans les systèmes d’apprentissage fédéré, sur la base de l’analyse des paramètres des modèles locaux des participants à l’apprentissage fédéré. Cette méthode a l’avantage d’être compatible avec la protection des données des participants, tout en permettant la mesure de plusieurs métriques de biais.

Capturer l’interdépendance entre plusieurs types de biais, et les corriger dans l’IA décentralisée

Mais il peut aussi y avoir plusieurs types de biais démographiques, qui se déclinent selon différents attributs sensibles (le genre, la race, l’âge, etc.), et nous avons démontré qu’atténuer un seul type de biais peut avoir pour effet collatéral l’augmentation d’un autre type de biais. Il serait alors dommage qu’une solution d’atténuation du biais lié à la race, par exemple, provoque une exacerbation du biais lié au genre.

Nous avons alors proposé une méthode multi-objectifs pour la mesure complète des biais et le traitement conjoint et cohérent de plusieurs types de biais survenant dans les systèmes d’apprentissage fédéré.

Ces travaux sont le fruit d’une collaboration avec des collègues chercheurs, doctorants et stagiaires : Pascal Felber, (Université de Neuchâtel), Valerio Schiavoni (Université de Neuchâtel), Angela Bonifati (Université Lyon 1), Vania Marangozova (Université Grenoble Alpes), Nawel Benarba (INSA Lyon), Yasmine Djebrouni (Université Grenoble Alpes), Ousmane Touat (INSA Lyon).

Le projet CITADEL est soutenu par l’Agence nationale de la recherche (ANR), qui finance en France la recherche sur projets. Elle a pour mission de soutenir et de promouvoir le développement de recherches fondamentales et finalisées dans toutes les disciplines, et de renforcer le dialogue entre science et société. Pour en savoir plus, consultez le site de l’ANR.

Le projet ANR CITADEL (ANR-24-CE25-6501) soutient en partie ces travaux.

03.11.2024 à 18:46

IRIS² : La nouvelle constellation de satellites européenne

DIRIS Jean-Pierre, Coordinateur interministériel IRS ² et GOVSATCOM, Centre national d’études spatiales (CNES)

Texte intégral (1432 mots)

Le programme IRIS2 (Infrastructure de résilience, d’interconnectivité et de sécurité par satellite) constituera le premier réseau de satellites multi-orbitaux en Europe. Cette constellation sera constituée d’environ 300 satellites et devrait voir le jour en 2030.

La transition de plus en plus forte vers l’économie numérique a une conséquence déjà observable : une augmentation forte du besoin de connectivité permettant la transmission rapide des données. Sur un marché mondial où les offres de connectivité évoluent rapidement, le satellite atteint désormais aujourd’hui des performances techniques (débit, latence en orbite basse) et économiques proches des solutions terrestres (fibre optique). L’énorme avantage est son coût de déploiement constant, quelle que soit la zone géographique, et notamment pour les zones « blanches » non couvertes par les infrastructures terrestres.

La constellation européenne IRIS2 s’inscrit dans cette transition, qui nécessite de plus en plus d’infrastructures de partage de données, dominées actuellement par des acteurs américains. Une constellation de satellites permet de connecter différents utilisateurs au travers de multiples satellites offrant ainsi une couverture instantanée permanente de la planète.

Les télécommunications : enjeu stratégique pour l’Europe

Dans le contexte actuel de développement et de mise en service de plusieurs initiatives de constellations tant publiques (Chine et États-Unis) que privées (Oneweb, Starlink, Kuiper) répondant aux besoins actuels de traitement de données et de connectivité découlant de la transition numérique, le secteur des télécommunications est plus que jamais stratégique pour la France et l’Europe. Le programme IRIS2 vise à répondre à cet enjeu.

Après des tentatives au début des années 2000, les constellations ont enfin émergé et les projets sont désormais crédibles et largement financés par des fonds publics et privés. Plusieurs facteurs ont permis leur émergence, les progrès en matière de miniaturisation électronique, les performances des composants numériques intégrés, la diminution drastique des coûts de lancement et la capacité industrielle de produire en petite série des satellites à moindre coût.

Face au développement des télécommunications par satellites en orbite basse (zone de l’orbite terrestre allant jusqu’à 2 000 kilomètres d’altitude), l’approche adoptée par la Commission européenne associant le secteur public et le secteur privé a pour objectif de renforcer l’Europe dans la course aux constellations au bénéfice des usages du citoyen européen et de ses institutions.

Une constellation de 300 satellites

Le programme de l’Union européenne (UE) de constellation satellitaire de connectivité sécurisée a été décidé en mars 2023. Ce programme, appelé IRIS2 (Infrastructure de résilience, d’interconnectivité et de sécurité par satellite) constituera le premier réseau de satellites multi-orbitaux en Europe. Cette constellation sera constituée d’environ 300 satellites.

Cette constellation fournira une infrastructure de communication sécurisée aux organismes et agences gouvernementales de l’UE. Les différents liens de communication entre utilisateurs et les liens de commande et contrôle des satellites seront protégés, les infrastructures sol sécurisées.

Le dispositif garantira l’autonomie stratégique de l’UE dans le domaine des communications gouvernementales sécurisées. La constellation devra également fournir des services commerciaux et cherchera à maximiser les synergies entre les infrastructures gouvernementales et commerciales. Enfin, la constellation devra permettre le renforcement du positionnement de l’Europe, de son industrie et de ses opérateurs dans le monde.

IRIS2 est associé au programme existant GOVSATCOM de l’UE qui consiste à fournir des communications gouvernementales sécurisées sur la base de capacités provenant d’opérateurs agréés ou des États membres.

IRIS2 est un programme financé par l’UE à hauteur de 2,4 milliards d’euros sur le Cadre financier pluriannuel (CFP) 2021-2027 ; des financements additionnels sont envisagés sur le CFP suivant 2028-2035. Ce financement est abondé par l’ESA à hauteur de 600M€ (souscription au Conseil ministériel de novembre 2022) et des acteurs privés commerciaux dans le cadre d’un contrat de concession.

Après validation du règlement de l’Union européenne sur l’initiative de constellation de connectivité sécurisée dès mars 2023, la Commission européenne a lancé l’appel d’offres relatif au contrat principal de développement de la constellation IRIS2 en mai 2023. L’appel d’offres a été finalisé avec un consortium de 3 opérateurs (Eutelsat, SES, Hispasat) associé à des partenaires industriels sous-traitants (Airbus, Thales, OHB, Deutsche Telekom, Orange) pour une remise d’offre le 2 septembre 2024. Cette offre est en cours d’examen par la Commission européenne dans l’objectif de signer le contrat de concession IRIS2 d’une durée de 12 ans, avant la fin 2024.

Un service de télécommunications toujours accessible

La Commission européenne a lancé à l’été 2023 un appel à candidatures pour l’hébergement d’infrastructures sol de la constellation et a retenu en Avril 2024 pour les centres de contrôle d’IRIS2 la France (Toulouse), l’Italie (Fucino) et le Luxembourg (Bettembourg).

La Première ministre, Elisabeth Borne, a décidé d’établir en France une coordination interministérielle sur IRIS2 et GOVSATCOM, dont il m’a été confié la mission avec la participation des représentants des différents ministères et agences.

Ce point focal national a pour objectifs principaux de coordonner l’ensemble des activités françaises contribuant au développement et à l’exploitation de ces programmes, d’assurer une relation permanente avec les interlocuteurs européens (UE, ESA, EUSPA), d’animer la communauté française des utilisateurs de la connectivité sécurisée fournie par ces programmes.

En termes d’usages l’objectif d’IRIS2 est de fournir un service digital autonome et souverain à chaque État membre de l’Union européenne. De nos jours, la connectivité spatiale est indispensable, celle-ci étant l’option la plus fiable en l’absence de systèmes de télécommunication terrestres (lorsqu’ils n’existent pas ou ont été endommagés par un conflit ou une catastrophe naturelle par exemple).

Le programme fournira une large variété de services aux gouvernements et citoyens européens. Le système permet la surveillance des frontières et des zones reculées. Le programme est indispensable à la protection civile, notamment en cas de crise ou de catastrophe naturelle. Il améliore l’envoi d’aide humanitaire et la gestion des urgences maritimes, que ce soit pour la recherche ou le sauvetage. De nombreux réseaux intelligents connectés – énergie, finance, santé, centres de données, etc. – seront contrôlés grâce à la connectivité fournie par IRIS2.

Le système permettra également de gérer différentes infrastructures : air, rail, route, trafic automobile. À cela s’ajoutent des services de télécommunications institutionnels par exemple pour les ambassades, et de nouveaux services de télémédecine pour l’intervention dans des zones isolées. Enfin IRIS2 améliorera la connectivité de zones d’intérêt stratégique dans le cadre de la politique étrangère de sécurité et de défense : Europe, Moyen-Orient, Afrique, Arctique, Atlantique et les régions de la Baltique, la mer Noire et Méditerranée.

Du côté architecture environ 300 satellites pourraient être conçus, fabriqués et déployés dans un premier temps. Les satellites seront placés sur deux orbites différentes : basse (jusqu’à 2 000 km) et moyenne (entre 2 000 et 35 786 km). En couvrant cette large gamme, la constellation sera en mesure de fournir des services de communication à faible latence – soit une transmission ultra-rapide des informations comparable aux performances des réseaux terrestres – et de compléter les autres programmes spatiaux européens.

DIRIS Jean-Pierre ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

30.10.2024 à 16:47

Ouvrir les modèles d’IA pour qu’ils ne restent pas l’apanage des géants du Web

Thierry Poibeau, DR CNRS, École normale supérieure (ENS) – PSL

Texte intégral (1897 mots)

Les grands modèles de langue, comme celui derrière ChatGPT, sont « fermés » : on ne sait pas comment ils sont mis au point, sur quelles données et avec quels paramètres. Même les modèles dits ouverts ne le sont que très partiellement, ce qui pose des problèmes de transparence et de souveraineté évidents. Développer des modèles ouverts est une alternative réaliste et souhaitable à moyen terme.

De la traduction automatique à la génération de contenu, les modèles de langue (ou modèles de langage) reposent sur des ensembles massifs de données et des algorithmes complexes. L’une des grandes questions pour la communauté de l’Intelligence artificielle est de savoir si ces modèles doivent rester fermés – contrôlés uniquement par quelques grandes entreprises – ou être ouverts et accessibles au public – en particulier aux chercheurs, développeurs et institutions publiques.

Un modèle ouvert présente plusieurs avantages. Premièrement, il permet une plus grande transparence. Les utilisateurs peuvent voir comment le modèle a été formé, quelles données ont été utilisées et quelles décisions algorithmiques sous-tendent ses prédictions. Cela favorise la confiance dans les résultats produits et permet à la communauté scientifique de vérifier et de corriger les biais qui pourraient être présents. Deuxièmement, un modèle ouvert encourage l’innovation. En permettant à d’autres chercheurs, développeurs et entreprises de travailler avec ces modèles, on peut accélérer le développement de nouvelles applications et résoudre des problèmes complexes de manière plus collaborative.

Les modèles fermés quant à eux posent des problèmes importants. Leur opacité rend difficile l’identification des responsabilités juridiques, car il est presque impossible de déterminer quelles données ont été utilisées lors de l’entraînement ou comment les décisions du système ont été prises. Cette opacité crée donc des risques potentiels de discrimination algorithmique, de désinformation et d’utilisation abusive des données personnelles. En outre, ces modèles fermés renforcent les monopoles technologiques, laissant peu de place à la concurrence et limitant ainsi les possibilités de mise au point de solutions concurrentes.

Si, aujourd’hui, les modèles de langue réellement ouverts (open source) sont encore relativement marginaux, ils restent une option envisageable à moyen terme. Pour qu’ils se développent, il faudra non seulement surmonter des obstacles techniques, mais aussi repenser les modèles de financement et de régulation, afin de garantir que l’innovation ne soit pas réservée à une poignée de géants technologiques. Il en va de l’avenir de l’intelligence artificielle ouverte et de son potentiel à bénéficier à l’ensemble de la société.

Lobbying et stratégies d’entreprises

Un lobbying intensif est mené auprès des gouvernements et des instances de régulation pour avancer l’argument selon lequel l’ouverture complète des LLM pourrait mener à des dérives. La crainte d’un mauvais usage, qu’il s’agisse de diffusion massive de fausses informations ou de cyberattaques – voire le fantasme d’une prise de pouvoir par des machines supra-intelligentes, est mise en avant pour justifier la fermeture de ces modèles.

OpenAI, avec d’autres, proclame qu’ouvrir les modèles serait source de danger pour l’humanité. Le débat est en fait souvent difficile à suivre : certains parlent de danger, voire demandent un moratoire sur ce type de recherche, mais continuent d’investir massivement dans le secteur en parallèle.

Par exemple, Elon Musk a signé en mars 2023 la lettre du Future of Life Institute demandant une pause de six mois des recherches en IA, tout en lançant en juillet 2023 xAI, un concurrent d’OpenAI ; Sam Altman, qui dirige OpenAI, parle aussi fréquemment de danger tout en visant des levées de fonds de plusieurs milliards de dollars pour développer des modèles toujours plus puissants.

Si certains croient sans doute vraiment qu’il y a là un danger (mais il faudrait définir lequel exactement), d’autres semblent manœuvrer en fonction de leurs intérêts et des immenses sommes investies.

Des modèles dits « ouverts » qui ne le sont pas tant que ça

Face à cela, d’autres sociétés, comme Méta avec ses modèles Llama, ou Mistral en France, proposent des modèles dits « ouverts ». Mais ces modèles sont-ils réellement ouverts ?

L’ouverture se limite en effet le plus souvent à l’accès aux « poids » du modèle, c’est-à-dire aux milliards de paramètres qui se voient ajustés lors de son entraînement grâce à des données. Mais le code utilisé pour entraîner ces modèles, et les données d’entraînement (ces masses de données cruciales qui permettent au modèle d’analyser et de produire du texte) restent généralement des secrets bien gardés, hors de portée des utilisateurs et même des chercheurs, limitant ainsi la transparence de ces modèles. À ce titre, peut-on vraiment parler de modèle ouvert si seuls les poids sont disponibles et non les autres composantes essentielles ?

L’ouverture des poids offre toutefois des avantages certains. Les développeurs peuvent adapter le modèle sur des données particulières (à travers le « fine tuning ») et surtout, ces modèles offrent une meilleure maîtrise que des modèles complètement fermés. Ils peuvent être intégrés dans d’autres applications, sans qu’il s’agisse de boîte noire uniquement accessible par « prompt engineering », où la façon de formuler une requête peut influer sur les résultats, sans qu’on sache très bien pourquoi.

L’accès aux poids favorise également l’optimisation des modèles, notamment à travers des techniques comme la « quantisation », qui réduit la taille des modèles tout en préservant leur performance. Cela permet de les exécuter sur des machines plus modestes, des ordinateurs portables voire des téléphones.

En rendant les modèles partiellement ouverts, les sociétés propriétaires bénéficient ainsi de l’intérêt de milliers de développeurs, ce qui permet des progrès potentiellement plus rapides que pour les modèles fermés, mis au point par des équipes forcément plus réduites.

Vers des modèles réellement open source ?

Mais peut-on envisager demain la création de modèles de langage réellement open source, où non seulement les poids, mais aussi les données d’entraînement et les codes d’apprentissage seraient accessibles à tous ? Une telle approche soulève des défis techniques et économiques importants.

Le principal obstacle reste la puissance de calcul nécessaire pour entraîner ces modèles, qui est actuellement l’apanage des entreprises dotées de ressources colossales (Google, Meta, Microsoft, etc.) ; OpenAI, ou Mistral en France, ont recours à de la puissance de calcul proposée par différents acteurs, dont les géants de l’informatique suscités. C’est en partie pour couvrir ces coûts – l’accès la puissance de calcul – que ces entreprises doivent régulièrement lever des fonds importants. Le coût énergétique, matériel, et en ressources humaines est prohibitif pour la plupart des acteurs.

Pourtant, des initiatives existent. Des communautés de chercheurs et des organisations à but non lucratif cherchent à développer des modèles ouverts et éthiques, basés sur des jeux de données accessibles, ou du moins transparents.

Ainsi, Allen AI (centre de recherche privé à but non lucratif, financé à l’origine par Paul Allen, le cofondateur de Microsoft décédé en 2018) a mis au point les modèles Olmo et Molmo (modèle de langue et modèle multimodal), qui sont complètement ouverts.

SiloAI, une entreprise finlandaise, en collaboration avec l’Université de Turku a mis au point un modèle multilingue complètement ouvert, Poro, performant pour les langues scandinaves.

En France, Linagora et d’autres travaillent aussi à mettre au point des systèmes ouverts, dans la continuité de Bloom (un modèle complètement ouvert, mis au point par un collectif de chercheurs sous l’impulsion de la société Hugging Face en 2022).

Le modèle économique de ces initiatives reste à déterminer, de même que le retour sur investissement à terme des sommes colossales actuellement en jeu sur ce thème au niveau international.

En pratique, ces modèles sont souvent entraînés sur des infrastructures publiques (Lumi en Finlande pour Poro, Genci en France pour Bloom) : il s’agit souvent de collaborations entre universitaires et entreprises privées pouvant ensuite commercialiser les solutions développées, puisqu’un modèle ouvert n’est pas synonyme de complètement gratuit, et des services annexes comme l’adaptation des modèles pour des besoins particuliers peuvent contribuer au financement de telles initiatives.

Une autre piste se situe dans le développement de modèles de langue spécialisés, moins coûteux en termes de données et d’infrastructure, mais qui pourraient répondre à des besoins spécifiques, ce qui permettrait à des entreprises ou des acteurs plus modestes de tirer leur épingle du jeu.

Thierry Poibeau est membre de l'Institut Prairie-PSAI (Paris AI Research Institute - Paris School of Artificial Intelligence) et a reçu des financements à ce titre.

29.10.2024 à 16:38

Est-il vrai qu’il y a plus de microbes que de cellules dans le corps humain ?

Valérie Lannoy, post-doctorante en microbiologie, Sorbonne Université

Texte intégral (1012 mots)

Il est difficile de faire nos courses sans qu’il ne nous soit proposé des produits pour protéger notre microflore ! Notre corps hébergerait dix fois plus de bactéries que de cellules. Vraiment ?

La microflore ou microbiote est l’ensemble des micro-organismes qui résident normalement dans notre corps. Ses secrets ont été vulgarisés par la Dre Giulia Enders dans son livre « Le charme discret de l’intestin ». Ce best-seller a largement contribué à l’engouement autour du sujet ! Pourtant, la découverte de la microflore intestinale a plus d’un siècle. Nous la devons au microbiologiste Élie Metchnikoff, prix Nobel de médecine en 1908. Avec le temps, les avancées technologiques ont facilité l’étude du microbiote, et c’est en 1977 que le célèbre ratio d’une cellule humaine pour dix bactéries est publié par le microbiologiste américain Dwayne Savage.

Des quantités de microbes et de cellules difficilement mesurables

En 1972, le biochimiste Thomas Luckey a évalué que chaque gramme de selles humaines renfermait cent milliards de bactéries et que l’appareil digestif en contenait un kilo. En multipliant, et en considérant que la majorité des bactéries se loge dans les fèces, l’estimation de la quantité dans le corps était donc de 100 000 milliards de bactéries. En 1977, l’équipe du Pr Savage a ramené ce nombre sur le nombre de cellules humaines (10 000 milliards), d’où le fameux ratio. Ce rapport d’un sur dix s’est vite répandu dans la communauté scientifique, car il est facile à retenir et rend concrète la notion de microflore intestinale. Le ratio est encore diffusé dans les cours de biologie ou activités de vulgarisation.

Chaque semaine, nos scientifiques répondent à vos questions.

N’hésitez pas à nous écrire pour poser la vôtre et nous trouverons la meilleure personne pour vous répondre.

Et bien sûr, les questions bêtes, ça n’existe pas !

Près de quarante ans après, en 2014, le microbiologiste Judah Rosner a publié une lettre dans l’ancien journal scientifique « Microbe » pour questionner l’intangible proportion d’un sur dix. Le début de son texte est d’ailleurs intéressant et révèle un paradoxe : « La science se régit par une réanalyse critique de faits. […] Mais une fois qu’un fait entre dans la littérature scientifique, au bout d’un moment, il devient difficile à effacer. » Le Pr Rosner souligne que l’estimation de 10 000 milliards de cellules est d’abord sortie dans un livre en 1970, mais que l’information n’y est pas référencée. Il avertit aussi que l’appréciation de la quantité de cellules humaines représente en fait un défi. Il conclut que, même si le ratio devait être contredit, cela ne remettrait pas en cause l’implication du microbiote dans la santé humaine.

Une question de méthode

Deux ans après la lettre mentionnée, des travaux israéliens ont démenti l’inébranlable ratio. L’équipe du Professeur Ron Milo a sélectionné l’organe dont le nombre de bactéries était représentatif des bactéries dans l’organisme. La microflore de la bouche, des poumons ou de la peau n’a pas été comptabilisée, car la quantité de bactéries y est cent fois moins riche que dans le gros intestin. Ils ont pris en compte que le côlon contient 400 grammes et non un kilo de selles fraîches. Ensuite, l’équipe s’est inspirée d’un article scientifique italien, qui évaluait le nombre de cellules humaines, non pas de manière globale, mais organe par organe puisque les tailles et masses des cellules sont très variables à travers le corps.

Le nombre de cellules humaines devient alors trois fois plus élevé, soit 30 000 milliards. La proportion de bactéries par cellule est ainsi affinée à 1,3. Bien qu’inférieur à 10, le rapport est supérieur à 1, donc les bactéries restent supérieures en nombre.

Néanmoins, chaque fois vous déféquez aux toilettes, il se rééquilibre et ce sont les cellules humaines qui deviennent supérieures en nombre !

Virus, bactéries et protozoaires peuplent notre corps

Nous parlons de bactéries, composante du microbiote intestinal la plus analysée aujourd’hui. Cependant, elle n’exprime pas toute la complexité de votre microflore. Bactéries, levures, protozoaires (animal microscopique à une seule cellule) et virus, voici le petit monde inoffensif que vous hébergez ! Notre « virobiote » a longtemps été considéré comme représentant l’écrasante majorité de l’organisme. En 2021, des études revoient cette donnée à la baisse, et rapprochent le nombre de virus dans notre corps à celui des bactéries. Par conséquent, ces effectifs sont semblables aux cellules humaines.

Mais n’oubliez pas qu’en les additionnant, bactéries et virus groupés ensemble sont majoritaires !

Valérie Lannoy ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

28.10.2024 à 16:53

Le brouillard d’eau : une nouvelle piste pour lutter contre les feux de véhicule

Antonin Robinet, doctorant en sciences des incendies, INSA Centre Val de Loire

Khaled Chetehouna, Sécurité Incendie ; Combustion ; Pyrolyse ; Milieu poreux, INSA Centre Val de Loire

Texte intégral (2189 mots)

Beaucoup d’additifs utilisés pour lutter contre les incendies se sont révélés être très nocifs pour l’environnement, il est donc nécessaire d’étudier de nouvelles pistes. Aussi surprenant que cela puisse paraître, les alcools pourraient se révéler être de bons candidats.

Contrairement à ce qui est souvent montré au cinéma, un véhicule endommagé n’explose pas. En revanche, les incendies sont tristement courants. Nos voitures et autres véhicules de transport à roues sont des machines très complexes qui possèdent de nombreux points de défaillances. En 2022, les sapeurs-pompiers comptabilisaient 45 588 interventions pour des feux de véhicules.

Le compartiment moteur d’un véhicule est une zone sensible. C’est un endroit très chaud (jusqu’à plusieurs centaines de degrés Celsius), rempli de substances combustibles diverses (carburant, huiles de synthèse, graisses, flexibles, plastiques) et soumis à un apport d’air régulier grâce au ventilateur du circuit de refroidissement. Le compartiment moteur réunit donc les trois composantes du triangle du feu qui sont la carburant, l’oxygène de l’air et une source de chaleur.

Les dernières réglementations en vigueur posent des défis pour la protection incendie. Les normes permissibles d’émissions de polluants ont généralisé le déploiement de filtres à particules qui doivent se régénérer, c’est-à-dire éliminer ces particules, à une température comprise entre 550 °C et 650 °C.

Les constructeurs capitonnent les compartiments moteurs avec de l’isolant pour diminuer le bruit perçu par les usagers mais cela a pour effet secondaire de piéger l’air chaud dans le compartiment moteur et d’en augmenter la température ambiante.

Alors que des réglementations sur les moyens d’extinction automatique des incendies pour les véhicules de transport public se mettent en place, intéressons-nous aux nouveaux défis de ce domaine.

Des molécules efficaces contre les incendies mais nuisibles pour l’environnement

Au cours du XXe siècle, on découvre que les halons, des gaz à base de brome, sont des agents extincteurs très efficaces. Dès le début des années 1980, il est cependant reconnu qu’ils participent à la dégradation de la couche d’ozone et leur utilisation est progressivement éliminée depuis l’adoption du protocole de Montréal en 1987.

Les hydrofluorocarbures (HFC) ont depuis lors été utilisés comme des alternatives. Ces gaz ne dégradent pas la couche d’ozone mais leur pouvoir de réchauffement global est plusieurs milliers de fois plus important que le CO₂. L’amendement Kigali, signé en 2016, a ajouté les HFC à la liste du protocole de Montréal.

De manière générale, l’ensemble des molécules contenant des halogènes comme le fluor sont progressivement marginalisées. La réglementation européenne prévoit l’interdiction prochaine des PFAS, ces « polluants éternels ». Ils sont utilisés dans la formulation des mousses anti-incendie employées par les sapeurs-pompiers pour lutter contre certaines classes de feux. On constate donc que toute la filière de l’extinction incendie doit se réinventer, dans un contexte de changement climatique global et alors que les normes sont des plus en plus restrictives.

Pour éviter de rejouer un scénario tel que celui qui a conduit à l’adoption des HFC, il convient d’étudier soigneusement chaque solution alternative potentielle, de se plonger dans la littérature scientifique passée et présente et d’identifier les impacts de ces technologies du point de vue de la performance anti-incendie mais également sur l’environnement et la santé humaine. C’est cet écueil que nous cherchons à éviter au sein de notre unité P2CFE du laboratoire PRISME et qui fonde mon travail de thèse, en menant la recherche sur une technologie propre : le brouillard d’eau.

Petites gouttes, grands défis

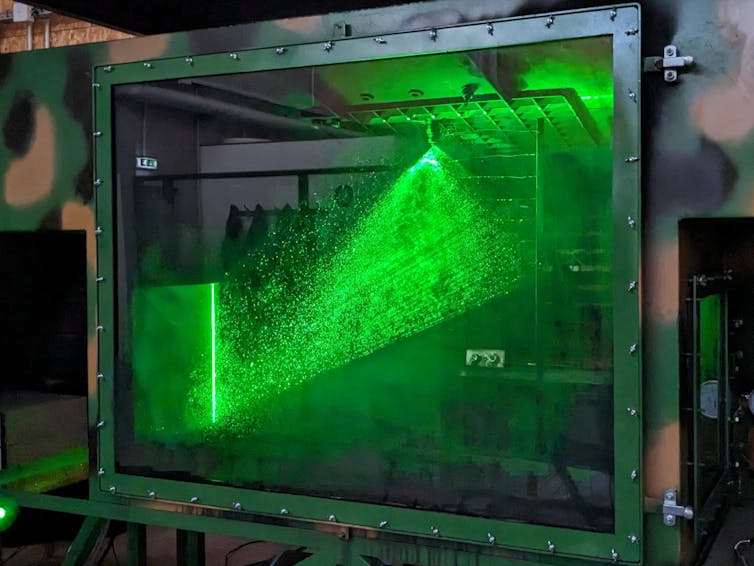

Les gouttes d’un brouillard d’eau sont très petites. Cela permet d’attaquer la flamme de trois manières. Premièrement, elles permettent de refroidir la flamme et la surface du combustible. Deuxièmement, les gouttes d’eau qui se vaporisent prennent beaucoup de place et chassent l’oxygène. Enfin, la densité du brouillard lui permet d’atténuer le rayonnement thermique de l’incendie et l’empêche ainsi de se propager en réchauffant à distance du combustible environnant. Le brouillard d’eau agit alors comme un écran de protection.

Dans notre laboratoire, le brouillard est composé de gouttes d’un diamètre d’une centaine de micromètres. Nous avons pu montrer que c’est le mécanisme de refroidissement de la flamme qui est privilégié lors de l’aspersion. Ce mécanisme est accentué lorsque le brouillard est pulvérisé avec une grande vitesse sur l’incendie. Cela engendre beaucoup de turbulence, ce qui brise la structure de la flamme, comme lorsqu’on souffle sur une bougie.

L’utilisation du brouillard d’eau pour la protection incendie d’un compartiment moteur ne coule pas de source car il est nécessaire d’intégrer sur le véhicule un réservoir d’eau d’une capacité de quelques dizaines de litres.

Un autre défi est le moteur lui-même, qui est un obstacle potentiel entre la buse du brouillard et la flamme. Il faut donc privilégier une forte vitesse initiale des gouttes et un faible diamètre afin de favoriser la distribution des gouttes dans l’ensemble du compartiment.

Le ventilateur de refroidissement est à même de souffler les petites gouttes du brouillard d’eau. Nous avons donc étudié l’influence de cette ventilation sur les performances du brouillard d’eau. Une faible ventilation transversale permet d’améliorer le temps d’extinction (de 14 secondes sans ventilation à 7 secondes pour une vitesse de ventilation de 3 mètres par seconde) en ramenant une partie du brouillard vers la flamme tandis qu’une forte ventilation transversale balaie systématiquement le spray et décroît fortement les capacités de refroidissement et d’extinction du brouillard (la flamme n’est pas éteinte en moins de 30 secondes). Pour contourner ce problème, il faut privilégier les cônes d’aspersion avec un angle élevé et orienter la projection dans le sens de la ventilation.

Éteindre le feu avec du vin ?

L’amélioration de la performance peut également passer par la modification de la solution pulvérisée. Afin d’innover, nous avons mené un travail exhaustif de revue de la littérature scientifique sur ce sujet.

Nous avons notamment pu mettre en évidence une nouvelle classe d’additifs pour le brouillard d’eau : les solvants. Parmi ces solvants, on trouve de nombreuses espèces hautement inflammables, comme l’éthanol.

Ajouter de l’éthanol dans l’eau pour améliorer la performance du brouillard d’eau peut sembler paradoxal. C’est pourtant l’effet que nous avons pu tester et confirmer au sein de notre laboratoire, sur une catégorie d’alcools allant du méthanol à l’heptanol.

L’augmentation du taux de refroidissement par rapport à l’eau seule est indéniable mais son origine est encore mal comprise. Les hypothèses privilégiées concernent une diminution du diamètre des gouttes par l’ajout d’alcool dans l’eau ou une accélération du processus d’évaporation des gouttes grâce à la présence d’alcool.

L’utilisation potentielle d’alcools comme additifs répond également à un impératif environnemental. La revue a mis en évidence un manque d’intérêt des scientifiques pour l’impact sur la santé et l’environnement des additifs pour le brouillard d’eau, alors même que la recherche sur ce brouillard d’eau ne peut pas se décorréler de l’interdiction progressive d’autres technologies d’extinction incendie. Dans cette optique, les alcools sont des additifs intéressants car ils sont biodégradables et possèdent de bonnes propriétés antigel et anticorrosion. Le brouillard d’eau additivée en est encore au stade d’études au laboratoire mais il ne fait aucun doute que le besoin réglementaire va fortement accélérer son développement dans les prochaines années.

Antonin Robinet a reçu des financements publics de l'Agence Innovation Défense et de la Région Centre-Val de Loire pour ses travaux de thèse

Khaled Chetehouna ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.