ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

24.10.2024 à 15:07

IA, cryptomonnaies et vie privée : les positions de Harris et Trump sur la régulation du numérique

Anjana Susarla, Professor of Information Systems, Michigan State University

Texte intégral (2758 mots)

En cette « année électorale » 2024, où vote la moitié de la planète, la présidentielle américaine est cruciale pour l’avenir des nouvelles technologies. En particulier, nombre des géants du numérique sont américains.

Ainsi, le ou la prochain président américain aura une influence sur les lois qui chercheront, ou pas, à équilibrer les contributions des systèmes d’intelligence artificielle, à protéger la vie privée des citoyens, ou à ajuster les situations de monopoles commerciaux. Quels sont les bilans des deux candidats sur ces sujets ?

Il n’est pas surprenant que la réglementation des technologies soit un thème important de la campagne présidentielle américaine de 2024.

Les technologies numériques – des algorithmes des médias sociaux aux systèmes d’intelligence artificielle basés sur des grands modèles de langage – ont profondément affecté la société ces dix dernières années. Ces changements se sont étalés sur les administrations Trump et Biden-Harris et ont suscité une forte demande auprès du gouvernement fédéral pour qu’il réglemente les technologies et les puissantes entreprises qui les manient.

Je suis chercheuse en systèmes d’information et en IA et j’ai examiné le bilan des deux candidats à l’élection présidentielle américaine de ce 5 novembre en matière de réglementation des technologies.

Voici les principales différences.

Des algorithmes préjudiciables

Les outils d’intelligence artificielle étant désormais très répandus, les gouvernements du monde entier doivent aborder la difficile question de la régulation de ces technologies aux multiples facettes.

À lire aussi : L’échiquier mondial de l’IA : entre régulations et soft power

Les candidats à la présidentielle américaine proposent des visions différentes de la politique américaine en matière d’intelligence artificielle. Une des différences notables tient à la reconnaissance des risques liés à l’utilisation généralisée de l’IA.

En effet, l’IA affecte tous les pans de la société de façons qui passent parfois inaperçues mais peuvent avoir des conséquences importantes. Ainsi, les biais dans les algorithmes utilisés pour les prêts et les décisions d’embauche pourraient finir par renforcer un cercle vicieux de discrimination. Par exemple, un étudiant qui ne peut pas obtenir de prêt pour l’université aurait moins de chances d’obtenir l’éducation nécessaire pour sortir de la pauvreté.

À lire aussi : Emploi, sécurité, justice : d’où viennent les « biais » des IA et peut-on les éviter ?

Lors du sommet sur la sécurité de l’IA (AI Safety Summit) qui s’est tenu au Royaume-Uni en novembre 2023, Kamala Harris a évoqué les promesses de l’IA, mais aussi les dangers que représentent les biais algorithmiques, les « deepfakes » et les arrestations abusives.

Joe Biden a signé un décret sur l’IA le 30 octobre 2023, qui reconnaît que les systèmes d’IA peuvent présenter des risques inacceptables d’atteinte aux droits civils et humains et au bien-être des individus. Parallèlement, des agences fédérales telles que la Federal Trade Commission ont pris des mesures d’applications de lois existantes pour protéger les utilisateurs contre les préjudices algorithmiques.

En revanche, l’administration Trump n’a pas pris position publiquement sur la limitation de ces mêmes risques algorithmiques, et Donald Trump a déclaré qu’il voulait abroger le décret sur l’IA du président Biden. Toutefois, il a récemment évoqué lors d’interviews les dangers liés à des technologies telles que les deepfakes, ainsi que les défis posés par les systèmes d’IA en termes de sécurité, suggérant une volonté de s’attaquer aux risques croissants liés à l’IA.

Normes et standards technologiques

L’administration Trump a signé le décret sur l’initiative américaine en matière d’IA (American AI Initiative) le 11 février 2019. Ce décret promet de doubler les investissements dans la recherche sur l’IA et établit la première série d’instituts nationaux américains de recherche sur l’IA. Le décret comprend également un plan pour standardiser et établir des normes techniques pour l’IA et établit des orientations pour l’utilisation de l’IA par le gouvernement fédéral.

Le 3 décembre 2020, M. Trump a également signé un décret promouvant l’utilisation d’une IA digne de confiance au sein du gouvernement fédéral.

L’administration Biden-Harris a tenté d’aller plus loin. Harris a convoqué les dirigeants de Google, de Microsoft et d’autres entreprises technologiques à la Maison Blanche le 4 mai 2023, pour prendre une série d’engagements volontaires afin de protéger les droits des individus.

De plus, le décret de l’administration Biden contient une initiative importante visant à sonder la vulnérabilité de modèles d’IA de très grande taille et à usage général entraînés sur des quantités massives de données : le but est de déterminer les risques que des modèles comme ChatGPT d’OpenAi ou DALL-E se fassent pirater par des hackers.

Droit de la concurrence

L’application de la législation antitrust – qui restreint ou conditionne les fusions et acquisitions d’entreprises pour limiter les monopoles – est un autre moyen pour le gouvernement fédéral de réglementer l’industrie technologique.

En termes de droit de la concurrence, l’administration Trump a tenté de bloquer l’acquisition de Time Warner par AT&T – mais la fusion a finalement été autorisée par un juge fédéral après que la FTC, sous l’égide de l’administration Trump, a intenté une action en justice pour bloquer l’opération. L’administration Trump a également intenté une action antitrust contre Google en raison de sa position dominante dans le domaine de la recherche sur Internet.

Côté démocrate, le 9 juillet 2021, Joe Biden a signé un décret visant à faire appliquer les lois antitrust découlant des effets anticoncurrentiels des plates-formes Internet dominantes. Le décret vise également l’acquisition de concurrents naissants, l’agrégation de données, la concurrence déloyale sur les marchés de l’attention et la surveillance des utilisateurs. L’administration Biden-Harris a engagé des procédures antitrust contre Apple et Google. Les lignes directrices sur les fusions en 2023 de l’administration Biden-Harris ont défini des règles pour déterminer quand les fusions peuvent être considérées comme anticoncurrentielles.

Ainsi, bien que les deux administrations aient engagé des procédures antitrust, la pression de l’administration Biden semble plus forte en termes d’impact sur la réorganisation potentielle ou même l’orchestration d’un démantèlement d’entreprises dominantes telles que Google.

Crypto-monnaies

Les candidats ont des approches différentes de la réglementation des crypto-monnaies.

Vers la fin de du mandat de l’administration Trump, ce dernier a tweeté en faveur d’une réglementation des crypto-monnaies et le réseau fédéral Financial Crimes Enforcement Network a proposé une réglementation qui aurait obligé les sociétés financières à collecter l’identité de tout portefeuille de crypto-monnaie auquel un utilisateur a envoyé des fonds. Cette réglementation n’a pas été promulguée.

Depuis, Trump a modifié sa position sur les crypto-monnaies. Il a critiqué les lois américaines existantes et appelé les États-Unis à devenir une superpuissance du bitcoin. La campagne de Trump est la première campagne présidentielle à accepter des paiements en crypto-monnaies.

À lire aussi : Donald Trump, défenseur des cryptomonnaies aux États-Unis

L’administration Biden-Harris, en revanche, a défini des restrictions réglementaires sur les crypto-monnaies avec la Securities and Exchange Commission, ce qui a donné lieu à une série de mesures d’application. La Maison Blanche a opposé son veto à la loi sur l’innovation financière et la technologie pour le XXIe siècle (Financial Innovation and Technology for the 21st Century Act) qui visait à clarifier la comptabilité des crypto-monnaies, un projet de loi favorisé par le secteur des crypto-monnaies.

Confidentialité des données et vie privée

Le décret sur l’IA de Joe Biden invite le Congrès à adopter une législation sur la protection de la vie privée, mais ne fournit pas de cadre législatif à cet effet.

L’initiative américaine sur l’IA de la Maison Blanche de Trump ne mentionne la protection de la vie privée qu’en termes généraux, appelant les technologies d’IA à respecter « les libertés civiles, la vie privée et les valeurs américaines ». Le décret ne mentionne pas la manière dont les protections existantes de la vie privée seront mises en œuvre.

Aux États-Unis, plusieurs États ont tenté d’adopter une législation portant sur certains aspects de la confidentialité des données : à l’heure actuelle, il existe une mosaïque d’initiatives au niveau des États et une absence de législation globale sur la confidentialité des données au niveau fédéral.

La rareté de ces mesures fédérales visant à protéger les données et la vie privée indique clairement que, si les deux candidats à l’élection présidentielle américaine s’attaquent bien à certains des défis posés par l’évolution de l’IA et des technologies numériques plus généralement, il reste encore beaucoup à faire pour réguler ces secteurs dans l’intérêt du public.

Globalement, les efforts de l’administration Biden pour réguler les technologies et la concurrence afférente semblent alignés sur l’objectif de maîtriser les entreprises technologiques et de protéger les consommateurs. Il s’agit également de réimaginer les protections monopolistiques pour le XXIe siècle. Il semble que ce soit là la principale différence entre les deux administrations.

Anjana Susarla a reçu des financements du National Institute of Health.

23.10.2024 à 16:35

Vers une évaluation de la recherche plus ouverte et équitable : la déclaration de Barcelone

Olivier Pourret, Enseignant-chercheur en géochimie et responsable intégrité scientifique et science ouverte, UniLaSalle

Lonni Besançon, Assistant Professor in Data Visualization, Linköping University

Texte intégral (2199 mots)

La Déclaration de Barcelone marque un tournant dans la manière dont sont produites, partagées et utilisées les informations relatives au pilotage de la recherche scientifique. Elle a été signée par douze institutions françaises.

Des crises telles que les pandémies et les changements climatiques, ainsi que des avancées technologiques comme l’automatisation et le big data, posent des défis importants au XXIe siècle. Pour y faire face, il est essentiel que la science soit accessible à tous. Il est crucial que les citoyens aient le même accès à l’information que les chercheurs, et que les scientifiques disposent de référentiels de connaissances interconnectés et de haute qualité pour faire progresser notre compréhension du monde et démocratiser le savoir.

Pour atteindre cet objectif, il est nécessaire de revoir et de réformer les méthodes d’évaluation de la recherche. Actuellement, les critères d’évaluation favorisent souvent les publications dans des revues prestigieuses, ce qui peut limiter l’accessibilité et l’impact des recherches, surtout pour les scientifiques des pays moins favorisés. Il est nécessaire de privilégier des systèmes d’évaluation qui tiennent compte de la valeur intrinsèque de la recherche et de son impact réel sur la société, indépendamment du lieu ou de la langue de publication, afin de soutenir une science plus inclusive, équitable et ouverte.

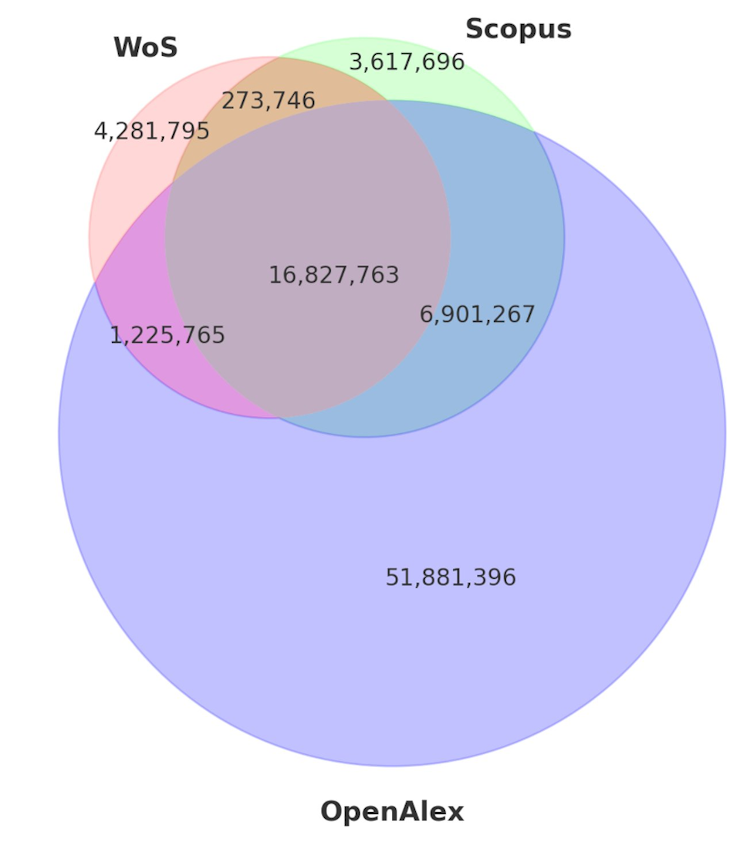

Actuellement, les évaluations reposent souvent sur des données inaccessibles et des indicateurs opaques (facteur d’impact des journaux, nombre de citations…), ce qui nuit à la qualité et à l’équité des décisions concernant les carrières des chercheurs et le financement des projets. En adoptant des systèmes d’évaluation qui privilégient l’accès libre aux données et la reproductibilité des analyses, nous pouvons garantir que les évaluations soient basées sur des preuves complètes et transparentes. Cela permettra de corriger les erreurs et biais potentiellement présents dans les bases de données propriétaires sur abonnement (comme Web of Science ou Scopus), d’améliorer la confiance dans les résultats de la recherche et de renforcer l’efficacité globale du système de recherche scientifique.

Plus d’ouverture sur la conduite des recherches

Les presque 100 signataires de la Déclaration de Barcelone, dont douze institutions universitaires ou de recherche françaises, sur l’information ouverte des données de la recherche s’engagent à transformer la manière dont l’information sur la recherche est produite et utilisée, en prônant une nouvelle norme d’ouverture des informations sur la conduite et la communication de la recherche.

Actuellement, de nombreuses décisions stratégiques dans le domaine de la recherche reposent sur des informations non accessibles au public (nombre de citations), souvent enfermées dans des infrastructures propriétaires. Web of Science et Scopus sont deux composants essentiels de l’écosystème de recherche actuel, fournissant la base des classements universitaires mondiaux ainsi que de la recherche bibliométrique. Cependant, les deux plates-formes seraient structurellement biaisées et ne considèrent pas une partie de la recherche produite dans des pays non occidentaux, la recherche en langues autres que l’anglais et la recherche dans les domaines des arts, des sciences humaines et sociales.

Les indicateurs et analyses issus de ces informations manquent de transparence et de reproductibilité, affectant les décisions relatives aux carrières des chercheurs et aux orientations des organismes de recherche, lorsqu’elles ne sont pas directement manipulées. Aussi les indicateurs se focalisent principalement sur des mesures telles que le nombre de citations des articles et le facteur d’impact des journaux (un indicateur qui estime indirectement la visibilité d’une revue scientifique. Pour une année donnée, le FI d’une revue est égal à la moyenne des nombres de citations des articles de cette revue publiés durant les deux années précédentes) dont on sait qu’elles sont souvent manipulables par plusieurs acteurs du système de recherche (de certains auteurs à certains éditeurs), tout en faisant l’impasse sur d’autres indicateurs bien plus importants pour la conduite d’une recherche éthique et reproductible.

Des indicateurs possibles sont, par exemple, la disponibilité des données produite par un essai clinique, le protocole d’étude complet, le code d’analyse des données, ou la présence d’un accord éthique (ainsi que son numéro et ses modalités d’acceptation), malheureusement souvent problématiques ou questionnables.

Les informations de recherche, ou métadonnées, englobent les détails relatifs à la mise en œuvre et à la communication de la recherche, incluant les données bibliographiques (titres, résumés, auteurs, affiliations, lieux de publication), les métadonnées sur les logiciels et instruments de recherche, les informations sur le financement et les contributeurs. Elles se trouvent dans des bases de données bibliographiques, des archives de logiciels, des entrepôts de données et des systèmes d’information de recherche. Les informations de recherche ouvertes sont des métadonnées accessibles librement et sans restrictions de réutilisation, suivant idéalement les principes FAIR (trouvable, accessible, interopérable et reproductible). Cela implique des protocoles standardisés, l’utilisation de licences Creative Commons CC0, et des infrastructures transparentes avec des normes ouvertes. Les métadonnées jouent un rôle crucial dans l’évaluation des chercheurs et des institutions et la définition des priorités des organisations. Cependant, de nombreuses données restent enfermées dans des infrastructures propriétaires, souvent biaisées géographiquement et linguistiquement. Assurer l’ouverture des informations de recherche permet à toutes les parties prenantes d’accéder pleinement aux données, enrichissant ainsi la prise de décision, l’évaluation scientifique, et la correction de la littérature scientifique lorsque c’est nécessaire.

Par exemple, un chercheur en biologie publie un article, et ses métadonnées incluent le titre, les auteurs, leur affiliation universitaire, et le résumé. Ces données sont accessibles librement dans des bases comme PubMed, facilitant la recherche pour d’autres scientifiques. Un deuxième exemple, les détails d’une subvention octroyée par une institution comme le National Institutes of Health (NIH) sont rendus publics. Cela inclut le montant, la durée, et l’objectif du financement, permettant une transparence et une collaboration accrue au sein de la communauté scientifique.

Les engagements et objectifs de la déclaration de Barcelone

Les organisations signataires (12 en France) se sont engagées à :

Favoriser l’ouverture des informations de recherche : les informations utilisées pour évaluer les chercheurs, les institutions ou pour prendre des décisions stratégiques seront ouvertes par défaut, sauf si cela n’est pas approprié. Cela concerne aussi les informations sur les activités et résultats de recherche.

Travailler avec des systèmes qui soutiennent cette ouverture : les plates-formes de publication et de gestion des informations de recherche doivent rendre ces données librement accessibles via des infrastructures ouvertes, en utilisant des standards existants quand ils sont disponibles (e.g., Crossref).

Soutenir les infrastructures ouvertes : les signataires aideront à maintenir et financer les systèmes qui facilitent l’ouverture des informations de recherche, tout en veillant à une bonne gouvernance et à leur durabilité.

Promouvoir la collaboration pour accélérer cette transition : Il est important de partager les expériences et de coordonner les actions pour passer des systèmes fermés à des systèmes ouverts.

Ainsi, le ministère de l’Enseignement supérieur et de la Recherche a mis en place en France un partenariat pluriannuel avec OpenAlex en décembre dernier. Sorbonne Université s’est désabonnée de l’outil propriétaire et sur abonnement « Web of Science » et projette de s’appuyer désormais sur des bases bibliographiques libres telles que OpenAlex pour analyser la production de sa recherche. La déclaration a également été signée par des organismes de financement (par exemple la fondation Bill & Melinda Gates ou l’Agence Nationale de la Recherche).

La Déclaration de Barcelone s’aligne avec les conclusions du Conseil de l’Union européenne de 2021, ou de l’Unesco qui recommandent l’accès libre aux données et bases de données bibliographiques utilisées pour évaluer la recherche. Elle est aussi en accord avec la loi française de 2016 pour une République numérique, qui promeut l’ouverture par défaut des données administratives. De plus, la déclaration respecte les principes de la CoARA (Coalition for Advancing Research Assessment), qui préconisent l’indépendance et la transparence des données nécessaires à l’évaluation de la recherche.

Ces engagements visent à garantir que les politiques scientifiques soient basées sur des preuves transparentes et des données accessibles et vérifiables, soutenant ainsi le mouvement mondial en faveur de la science ouverte.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

22.10.2024 à 16:59

À quoi ressemble le bord de l’univers ?

Sara Webb, Lecturer, Centre for Astrophysics and Supercomputing, Swinburne University of Technology

Texte intégral (874 mots)

L’univers a-t-il une fin ou un bord ? Les scientifiques ne peuvent pas trancher cette fascinante question mais ont des idées, des théories et des mesures pour discuter.

Cette question sur les limites de l’univers fait partie des interrogations que les humains continueront, sans doute, à se poser jusqu’à la fin des temps.

Nous ne sommes pas sûrs, mais nous pouvons essayer d’imaginer ce que pourrait être la limite de l’univers, s’il y en a une.

Remonter le temps

Avant de commencer, nous devons remonter dans le temps. Le ciel nocturne a semblé avoir toujours eu la même apparence au cours de l’histoire de l’humanité. Il a été si stable que les humains du monde entier se sont inspirés des motifs qu’ils voyaient dans les étoiles pour s’orienter et explorer.

À nos yeux, le ciel semble infini. Avec l’invention des télescopes, il y a environ 400 ans, nous avons pu voir plus loin que nos yeux ne l’avaient jamais fait. Nous avons continué à découvrir de nouvelles choses dans le ciel et trouvé davantage d’étoiles, puis avons commencé à remarquer qu’il y avait beaucoup de nuages cosmiques à l’aspect étrange.

Les astronomes leur ont donné le nom de « nébuleuse », de mots latin signifiant « brume » ou « nuage ». Il y a moins de 100 ans, nous avons confirmé pour la première fois que ces nuages cosmiques ou nébuleuses étaient en fait des galaxies. Elles ressemblent à la Voie lactée, la galaxie dans laquelle se trouve notre planète, mais elles sont très éloignées.

Ce qui est étonnant, c’est que dans toutes les directions où nous regardons dans l’univers, nous voyons de plus en plus de galaxies. Sur cette image du télescope spatial James Webb, qui observe une partie du ciel équivalente à la zone que recouvre un grain de sable quand on le tient à bout de bras, on peut voir des milliers de galaxies.

Il est difficile d’imaginer qu’il existe une limite où tout cela s’arrête.

Le bord de l’univers

Cependant, il existe techniquement une limite à notre univers. Nous l’appelons l’univers « observable ». En effet, nous ne savons pas si notre univers est infini, c’est-à-dire s’il se poursuit à l’infini.

Malheureusement, nous ne le saurons peut-être jamais à cause d’un élément gênant : la vitesse de la lumière.

Nous ne pouvons voir que la lumière qui a eu le temps de voyager jusqu’à nous. La lumière se déplace à la vitesse exacte de 299 792 458 mètres par seconde. Même à cette vitesse, il lui faut beaucoup de temps pour traverser notre univers. Les scientifiques estiment que la taille de l’univers est d’au moins 96 milliards d’années-lumière, et probablement encore plus grande.

Que verrions-nous s’il y avait un bord ?

Si nous voyagions jusqu’à l’extrême limite de l’univers que nous pensons exister, qu’y aurait-il en réalité ?

De nombreux autres scientifiques (dont je fais partie) pensent qu’il y aurait simplement… plus d’univers !

Chaque semaine, nos scientifiques répondent à vos questions.

N’hésitez pas à nous écrire pour poser la vôtre et nous trouverons la meilleure personne pour vous répondre.

Et bien sûr, les questions bêtes, ça n’existe pas !

Comme je l’ai dit, il existe une théorie selon laquelle notre univers n’a pas de limite et pourrait continuer indéfiniment.

Mais il existe aussi d’autres théories. Si notre univers a une limite et que vous la franchissez, vous pourriez vous retrouver dans un univers complètement différent. (Pour l’instant, il vaut mieux garder cela pour la science-fiction).

Même s’il n’y a pas de réponse directe à cette question, ce sont précisément des questions comme celles-ci qui nous aident à continuer à explorer et à découvrir l’univers, et qui nous permettent de comprendre la place que nous y occupons.

Sara Webb ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

21.10.2024 à 16:56

Patrimoine : algues, bactéries, champignons à l’assaut des vieilles pierres

Patrick Di Martino, Professeur des Universités de Microbiologie, CY Cergy Paris Université

Texte intégral (2516 mots)

Algues, bactéries, champignons… les microbes partent à l’attaque des vieilles pierres, dont certaines sont des monuments historiques. En comprenant mieux leurs modes d’action, on peut limiter les dégats – par exemple en utilisant des bactéries pour nettoyer les graffiti ou en testant des huiles essentielles sur le Colisée, à Rome.

Dans la grotte ornée de Lascaux, le surtourisme a entraîné le développement massif de champignons noirs Ochroconis lascauxensis à cause de la condensation d’eau sur les parois, des élévations de température, de la concentration en CO2 et en matière organique. La présence massive d’humains dans une grotte restée fermée des milliers d’années a modifié l’équilibre des communautés microbiennes et favorisé la prolifération de certains microorganismes… ce qui a nécessité sa fermeture au public.

Aujourd’hui, grâce à une meilleure maîtrise du climat dans la grotte, et à la limitation de l’accès à un nombre restreint de conservateurs et de scientifiques, la grotte va mieux mais la situation reste fragile. La création du fac-similé Lascaux IV permet à un large public de visiter une représentation de l’intégralité de la grotte originale.

Verdissement d’une toiture par développement de microalgues, de cyanobactéries ou de mousses ; jaunissement de parois de grottes ornées à cause de bactéries ; pourrissement des charpentes et boiseries dont se nourrissent les champignons lignivores et certaines moisissures ; perte de matière par des lichens ou des « biofilms » microbiens à la surface de la pierre… la « biodégradation » peut se définir par tout changement indésirable des propriétés d’un bien culturel causée par l’activité d’organismes vivants.

Si ces effets sont nombreux et familiers, c’est parce que les microorganismes sont partout, sous tous les climats, sur toutes les surfaces. Ils sont véhiculés par l’eau, par l’air, par les animaux, par l’homme. Ils ne sont pas tous néfastes, bien au contraire – les décomposeurs jouent ainsi un rôle central dans le recyclage de la matière organique.

La recherche sur la biodégradation a un rôle essentiel pour améliorer la préservation des biens culturels des attaques biologiques. Elle est très active en Europe, certainement parce que notre continent recèle un patrimoine culturel exceptionnel. La recherche se focalise notamment sur une meilleure compréhension des mécanismes de biodégradation.

La stratégie est de comprendre pour mieux prévenir, mieux diagnostiquer et mieux traiter.

Mieux prévenir

La maîtrise des conditions environnementales (température, hygrométrie, lumière, qualité de l’air, dépoussiérage) est un élément clé de la conservation préventive du patrimoine culturel dans les musées.

En particulier, la prévention de la biodégradation passe par la limitation de l’apport en eau et en nutriments nécessaires au développement des microorganismes ; ainsi que par la limitation de l’apport en lumière, source d’énergie des « phototrophes », en limitant l’éclairage artificiel.

L’installation d’un toit permet de protéger un site extérieur des intempéries et de la lumière. C’est le cas du site de la Polledrara di Cecanibbio au nord-ouest de Rome qui comporte les ossements fossilisés de plus de 20 000 vertébrés, enfouis dans des sédiments volcanoclastiques des volcans de Sabatino il y a plus de 300 000 ans.

Mieux diagnostiquer

Les développements technologiques en imagerie permettent d’étudier les interactions entre microorganismes et surfaces, ainsi que la dégradation des matériaux, notamment la microscopie électronique à balayage, que l’on peut coupler à l’analyse élémentaire ou à la spectroscopie Raman pour obtenir la composition chimique, et la microscopie confocale à balayage laser.

Avec la métagénomique (analyse bio-informatique des séquences d’ADN issues de prélèvements environnementaux), les chercheurs dévoilent la biodiversité des microorganismes associés à la biodégradation.

Avec la métabolomique (analyse de l’ensemble des petites molécules issues de l’activité du vivant), ils déterminent les voies enzymatiques et les molécules mises en œuvre dans les processus de biodégradation.

Ces technologies permettent de répondre à différentes questions : quels sont les microorganismes présents ? Lesquels sont néfastes ? Comment interagissent-ils entre eux et avec les matériaux ? Quelles sont les activités microbiennes impliquées dans la biodégradation ? Quels sont les mécanismes de la biodégradation ?

Mieux traiter : des bactéries contre les graffitis

La recherche sur la biodégradation des biens culturels s’oriente également vers les biotraitements.

La porosité de la pierre des monuments historiques permet des mouvements d’eau dans les pores, qui véhiculent des sels dissous. Ces sels de sulfates ou de nitrates pourront recristalliser et induire la formation d’efflorescences ou de croutes en surface ainsi qu’un détachement de matière.

Les bactéries Desulfovibrio desulfuricans et Pseudomonas stutzeri qui dégradent les sulfates ou les nitrates peuvent être utilisées pour « bionettoyer » ce type de croute.

La bactérie Rhodococcus erythropolis ou la levure Candida parapsilosis peuvent être utilisées pour dégrader et bionettoyer les graffiti.

À l’inverse de ces nettoyages, un ajout de matière par bio-renforcement de la pierre calcaire peut être réalisé à l’aide de bactéries qui favorisent la précipitation de carbonate de calcium comme Bacillus cereus et Myxococcus xanthus.

Des enzymes microbiennes (plutôt que des microorganismes vivants) peuvent aussi être utilisées, comme des lipases pour enlever des patines noires ou des couches de peinture recouvrant des œuvres originales, ou des protéases pour enlever des colles animales.

Des antimicrobiens naturels sont testés en remplacement des ammoniums quaternaires et de l’eau de Javel, deux biocides artificiels largement utilisés pour traiter le noircissement et le verdissement de la pierre.

De nombreuses plantes contiennent des molécules bioactives aux propriétés antibactériennes, antifongiques ou insecticides, qui sont extraites et concentrées dans les huiles essentielles. Elles peuvent être appliquées en spray, sous forme de gel déposé sur un objet ou apportées par des nanoparticules pour contrôler leur libération et optimiser les doses appliquées et la durée d’efficacité du traitement. Bien que basés sur des principes actifs végétaux, il faut s’assurer que ces biotraitements n’ont pas d’effet indésirable sur les matériaux des biens culturels et ne sont pas toxiques pour l’homme aux doses d’usage.

La recherche sur la biodégradation apporte des outils aux différentes étapes de la préservation du patrimoine, de la conservation préventive à la conservation curative jusqu’à la restauration. Et parfois, après avoir établi un diagnostic, le meilleur choix est de n’appliquer aucun traitement, en veillant à préserver le bien culturel en l’état pour le transmettre aux générations futures.

Patrick Di Martino est membre de l'International Biodeterioration and Biodegradation Society (IBBS). Les travaux à l'abbaye de Chaalis et à la grotte du Sorcier mentionnés dans l'article ont été soutenus financièrement par la Fondation des Sciences du Patrimoine et CY Cergy Paris Université. Les photographies des travaux au Colisée ont été réalisées lors d'une mobilité financée par le programme Erasmus +.

20.10.2024 à 10:38

La brise de mer, ou pourquoi le climat est plus doux dans les régions côtières

Patrick Augustin, Ingénieur de recherche, Université Littoral Côte d'Opale

Texte intégral (1730 mots)

Le phénomène d’équilibre thermique, qui explique pourquoi notre café refroidit dans sa tasse, se produit aussi à l’échelle de la planète. Avec des conséquences notables sur le climat : c’est notamment lui qui est à l’origine de la « brise de mer », vent marin relativement froid et humide caractéristique du climat des régions littorales.

Vous avez certainement déjà constaté que lorsque vous ne buvez pas votre café chaud, au bout d’un certain temps, il se refroidit. Inversement, un yaourt froid sorti du réfrigérateur et laissé sur la table se réchauffe au fil du temps.

Ce phénomène est appelé « l’équilibre thermique » : le café, plus chaud que l’air ambiant, va transférer sa chaleur vers l’air environnant. Au fil du temps, le café refroidit jusqu’à ce que sa température s’égalise à celle de l’environnement. De la même manière, le yaourt, plus froid que l’air ambiant, va absorber la chaleur de l’air et se réchauffer, pour atteindre la température ambiante. Ainsi, qu’il s’agisse du café qui refroidit ou du yaourt qui se réchauffe, l’équilibre thermique qui se produit dans la nature fait tendre les températures vers une température uniforme, sans effort de notre part.

Ce phénomène se produit également à plus grande échelle, et il n’est pas sans conséquence : l’équilibre thermique entre la terre et les mers ou les océans est un processus clé dans la régulation du climat global. Voici ce que nous en savons.

Un déséquilibre thermique entre terre et mer/océans

L’eau a une capacité thermique beaucoup plus élevée que la terre. Cela signifie que les mers/océans absorbent et libèrent la chaleur plus lentement que les surfaces terrestres. Ainsi, l’eau se réchauffe et se refroidit beaucoup plus lentement que la terre.

Dans ces conditions, un déséquilibre thermique peut se former entre ces deux systèmes. Cette différence de capacité thermique joue un rôle crucial dans la circulation atmosphérique, la formation des vents et les variations climatiques à court et à long terme.

En effet, les variations de température sur la terre sont rapides et importantes, entraînant, par exemple, des étés chauds et des hivers froids dans les zones continentales. La mer/océan agit comme des régulateurs thermiques, en emmagasinant la chaleur durant l’été et en la restituant durant l’hiver, ce qui contribue à adoucir les climats côtiers.

La conséquence de l’existence d’un déséquilibre thermique entre la terre et la mer/océan est aussi perceptible dans le cycle diurne, durant lequel ces deux systèmes réagissent différemment sous l’effet du rayonnement solaire. Durant la journée, les surfaces des terres se réchauffent plus rapidement que les surfaces marines. Ainsi, au voisinage des zones côtières, l’air réchauffé en contact du sol monte (sous l’effet de la poussée d’Archimède), accompagné d’une diminution de la pression atmosphérique.

Au-dessus de la mer, le réchauffement de l’air en contact de la surface de la mer/océan étant plus lent, l’air est plus dense et la pression est plus grande. Cette différence de pression entre l’air au-dessus des terres et au-dessus de la mer/océan engendre le déplacement de l’air froid et humide provenant de la mer et se dirigeant vers les terres (figure 1). Ce mécanisme correspond à un phénomène météorologique local appelé brise de mer.

Ce vent marin relativement plus froid et humide (plus dense), s’écoule horizontalement vers l’intérieur des terres pour remplacer l’air plus chaud et sec (moins dense), qui s’élève au-dessus de la surface des terres. La zone d’interface entre l’air marin (situé à l’avant du courant de brise) et l’air au-dessus des terres, est appelée front de brise de mer. Le passage du front est souvent marqué par des changements brusques de température, d’humidité, de direction et vitesse de vent. Ce contraste thermique et dynamique peut d’ailleurs favoriser, sous certaines conditions, la formation de nuages.

En effet, lorsque l’air chaud des terres rencontre l’air marin au niveau du front de brise, une zone de convergence se forme favorisant une poussée vers le haut des deux masses d’air appelé courant ascendant. Cette ascension de l’air chaud et humide entraîne la condensation de la vapeur d’eau, formant des nuages, généralement de type cumulus. Ces nuages se forment souvent le long du front de brise de mer, où les deux masses d’air se rencontrent.

Dans certaines situations, lorsque la différence de température entre la terre et la mer est particulièrement marquée, l’air chaud peut s’élever rapidement, formant non seulement des nuages cumulus, mais aussi des cumulo-nimbus, pouvant conduire à des averses ou des orages locaux en fin de journée.

Vers un équilibre thermique

Ce mouvement d’air frais contribue à rééquilibrer les températures en rafraîchissant les zones terrestres chauffées, tout en réduisant la différence thermique entre la surface de la terre et la mer. En apportant de l’air plus frais, la brise de mer adoucit les températures terrestres, surtout pendant les périodes de chaleur intense, et rétablit ainsi un certain équilibre thermique. La brise de mer joue donc un rôle crucial dans l’amélioration du confort thermique. Elle atténue la sensation de chaleur excessive pour les habitants, améliorant ainsi leur bien-être.

Dans certaines situations, la brise de mer peut se renforcer à mesure que la différence de température entre la terre et la mer augmente, ce qui peut entraîner un vent plus fort près des côtes. Elle peut avoir un impact significatif sur la production d’énergie éolienne, particulièrement dans les régions côtières, surtout si les vents terrestres sont faibles. En effet, ce phénomène météorologique peut générer des vents réguliers et prévisibles permettant une production plus efficace et prévisible, réduisant ainsi la variabilité de la production d’énergie éolienne. Ces vents sont souvent plus forts en fin de matinée et dans l’après-midi, ce qui en fait une source d’énergie précieuse pour les éoliennes situées près des côtes.

Par ailleurs, elle peut aussi influencer la concentration et la distribution des polluants atmosphériques puisqu’elle peut disperser les polluants. En effet, elle peut participer au renouvellement de l’air au-dessus des terres, en remplaçant l’air stagnant plus ou moins pollué par un air provenant de la mer. Cependant, dans certaines zones côtières où la pollution industrielle/automobile est importante, la brise de mer peut transporter la pollution des zones côtières vers l’intérieur des terres. Dans certaines conditions, elle peut contribuer à la formation d’une couche limite emprisonnant l’air pollué près du sol, ce qui limite la dispersion verticale des polluants et peut aggraver la qualité de l’air localement.

L’équilibre thermique entre ces deux systèmes est un mécanisme fondamental qui régule le climat. Cet équilibre est donc essentiel à la stabilité des écosystèmes et des sociétés humaines. Il nécessite une attention particulière pour maintenir les régulations naturelles face aux pressions croissantes liées au changement climatique global.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 4 au 14 octobre 2024), et dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « océan de savoirs ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Patrick Augustin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.