02.12.2025 à 13:12

Quand l’IA fait n’importe quoi, le cas du gratte-ciel et du trombone à coulisse

Texte intégral (2490 mots)

Une expérience relativement simple consistant à demander à une intelligence artificielle générative de comparer deux objets de tailles très différentes permet de réfléchir aux limites de ces technologies.

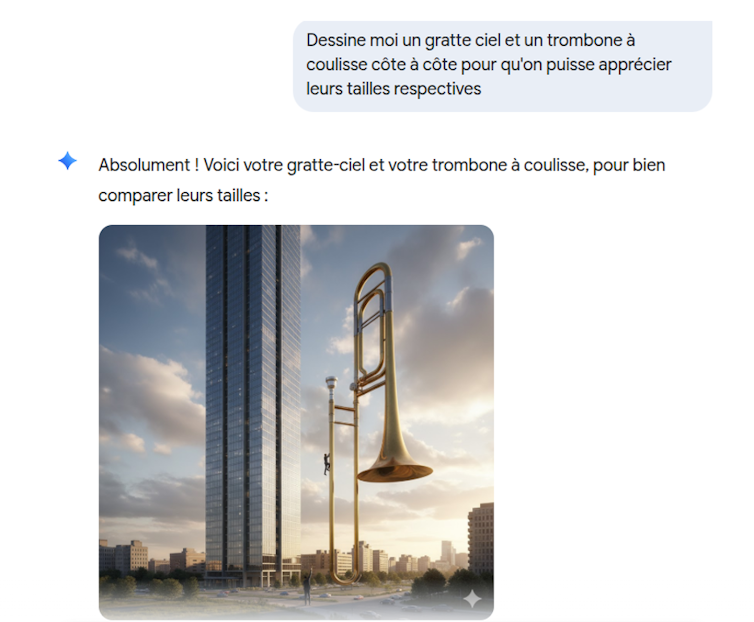

Les intelligence artificielle (IA) génératives font désormais partie de notre quotidien. Elles sont perçues comme des « intelligences », mais reposent en fait fondamentalement sur des statistiques. Les résultats de ces IA dépendent des exemples sur lesquels elles ont été entraînées. Dès qu’on s’éloigne du domaine d’apprentissage, on peut constater qu’elles n’ont pas grand-chose d’intelligent. Une question simple comme « Dessine-moi un gratte-ciel et un trombone à coulisse côte à côte pour qu’on puisse apprécier leurs tailles respectives » vous donnera quelque chose comme ça (cette image a été générée par Gemini) :

L’exemple provient du modèle de Google, Gemini, mais le début de l’ère des IA génératives remonte au lancement de ChatGPT en novembre 2022 et ne date que d’il y a trois ans. C’est une technologie qui a changé le monde et qui n’a pas de précédent dans son taux d’adoption. Actuellement ce sont 800 millions d’utilisateurs, selon OpenAI, qui chaque semaine, utilisent cette IA pour diverses tâches. On notera que le nombre de requêtes diminue fortement pendant les vacances scolaires. Même s’il est difficile d’avoir des chiffres précis, cela montre à quel point l’utilisation des IA est devenue courante. À peu près un étudiant sur deux utilise régulièrement des IA.

Les IA : des technologies indispensables ou des gadgets ?

Trois ans, c’est à la fois long et court. C’est long dans un domaine où les technologies évoluent en permanence, et court en termes sociétaux. Même si on commence à mieux comprendre comment utiliser ces IA, leur place dans la société n’est pas encore quelque chose d’assuré. De même la représentation mentale qu’ont ces IA dans la culture populaire n’est pas établie. Nous en sommes encore à une alternance entre des positions extrêmes : les IA vont devenir plus intelligentes que les humains ou, inversement, ce ne sont que des technologies tape-à-l’œil qui ne servent à rien.

En effet, un nouvel appel à faire une pause dans les recherches liées aux IA a été publié sur fond de peur liée à une superintelligence artificielle. De l’autre côté sont promis monts et merveilles, par exemple un essai récent propose de ne plus faire d’études, car l’enseignement supérieur serait devenu inutile à cause de ces IA.

Difficile de sortir de leurs domaines d’apprentissage

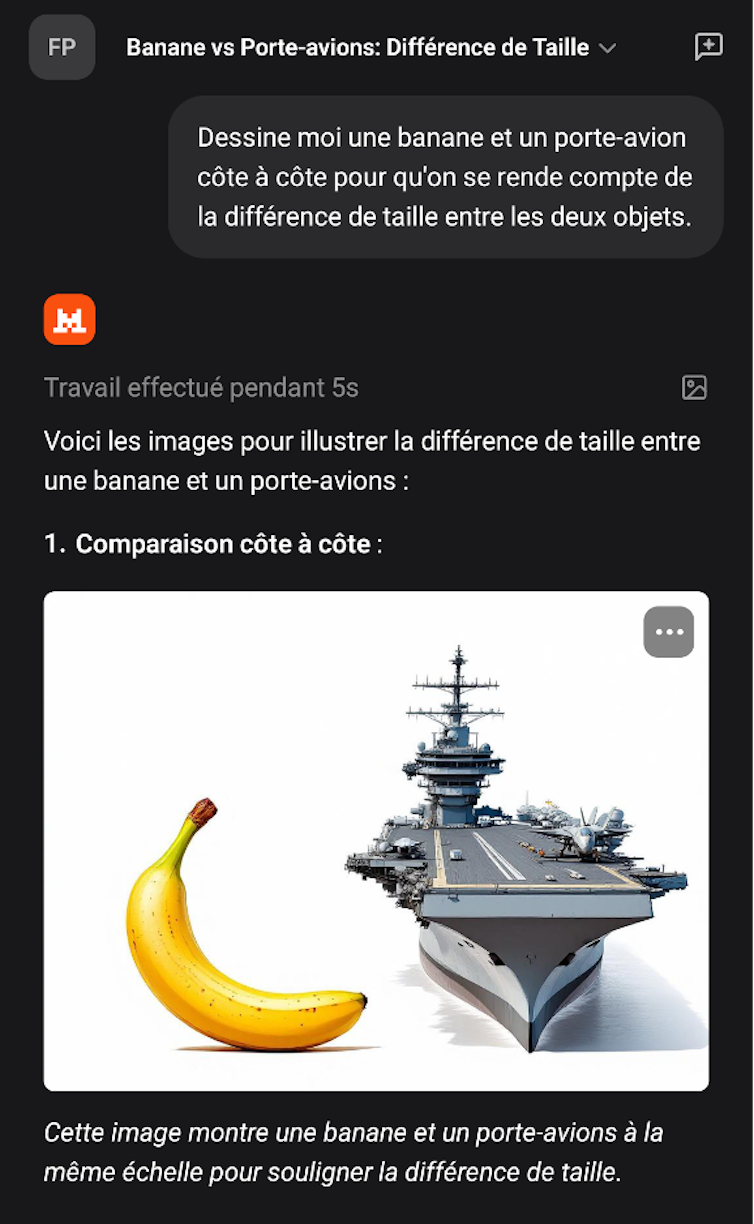

Depuis que les IA génératives sont disponibles, je mène cette expérience récurrente de demander de produire un dessin représentant deux objets très différents et de voir le résultat. Mon but par ce genre de prompt (requête) est de voir comment le modèle se comporte quand il doit gérer des questions qui sortent de son domaine d’apprentissage. Typiquement cela ressemble à un prompt du type « Dessine-moi une banane et un porte-avions côte à côte pour qu’on se rende compte de la différence de taille entre les deux objets ». Ce prompt en utilisant Mistral donne le résultat suivant :

À ce jour je n’ai jamais trouvé un modèle qui donne un résultat censé. L’image donnée en illustration ci-dessus (ou en tête de l’article) est parfaite pour comprendre comment fonctionnent ce type d’IA et quelles sont ses limites. Le fait qu’il s’agisse d’une image est intéressant, car cela rend palpables des limites qui seraient moins facilement discernables dans un long texte.

Ce qui frappe est le manque de crédibilité dans le résultat. Même un enfant de 5 ans voit que c’est n’importe quoi. C’est d’autant plus choquant qu’avec la même IA il est tout à fait possible d’avoir de longues conversations complexes sans pour autant qu’on ait l’impression d’avoir affaire à une machine stupide. D’ailleurs ce même type d’IA peut tout à fait réussir l’examen du barreau ou répondre avec une meilleure précision que des professionnels sur l’interprétation de résultats médicaux (typiquement, repérer des tumeurs sur des radiographies).

D’où vient l’erreur ?

La première chose à remarquer est qu’il est difficile de savoir à quoi on est confronté exactement. Si les composants théoriques de ces IA sont connus dans la réalité, un projet comme celui de Gemini (mais cela s’applique aussi aux autres modèles que sont ChatGPT, Grok, Mistral, Claude, etc.) est bien plus compliqué qu’un simple LLM couplé à un modèle de diffusion.

Un LLM est une IA qui a été entraînée sur des masses énormes de textes et qui produit une représentation statistique de ces derniers. En gros, la machine est entraînée à deviner le mot qui fera le plus de sens, en termes statistiques, à la suite d’autres mots (votre prompt).

Les modèles de diffusion qui sont utilisés pour engendrer des images fonctionnent sur un principe différent. Le processus de diffusion est basé sur des notions provenant de la thermodynamique : on prend une image (ou un son) et on ajoute du bruit aléatoire (la neige sur un écran) jusqu’à ce que l’image disparaisse, puis ensuite on fait apprendre à un réseau de neurones à inverser ce processus en lui présentant ces images dans le sens inverse du rajout de bruit. Cet aspect aléatoire explique pourquoi avec le même prompt le modèle va générer des images différentes.

Un autre point à considérer est que ces modèles sont en constante évolution, ce qui explique que le même prompt ne donnera pas le même résultat d’un jour à l’autre. De nombreuses modifications sont introduites à la main pour gérer des cas particuliers en fonction du retour des utilisateurs, par exemple.

À l’image des physiciens, je vais donc simplifier le problème et considérer que nous avons affaire à un modèle de diffusion. Ces modèles sont entraînés sur des paires images-textes. Donc on peut penser que les modèles de Gemini et de Mistral ont été entraînés sur des dizaines (des centaines ?) de milliers de photos et d’images de gratte-ciel (ou de porte-avions) d’un côté, et sur une grande masse d’exemples de trombone à coulisse (ou de bananes) de l’autre. Typiquement des photos où le trombone à coulisse est en gros plan. Il est très peu probable que, dans le matériel d’apprentissage, ces deux objets soient représentés ensemble. Donc le modèle n’a en fait aucune idée des dimensions relatives de ces deux objets.

Pas de « compréhension » dans les modèles

Les exemples illustrent à quel point les modèles n’ont pas de représentation interne du monde. Le « pour bien comparer leurs tailles » montre qu’il n’y a aucune compréhension de ce qui est écrit par les machines. En fait les modèles n’ont pas de représentation interne de ce que « comparer » signifie qui vienne d’ailleurs que des textes dans lesquels ce terme a été employé. Ainsi toute comparaison entre des concepts qui ne sont pas dans le matériel d’apprentissage sera du même genre que les illustrations données en exemple. Ce sera moins visible mais tout aussi ridicule. Par exemple, cette interaction avec Gemini « Considérez cette question simple : “Le jour où les États-Unis ont été établis est-il dans une année bissextile ou une année normale ?”. »

Lorsqu’il a été invoqué avec le préfixe CoT (Chain of Thought, une évolution récente des LLMs dont le but est de décomposer une question complexe en une suite de sous-questions plus simples), le modèle de langage moderne Gemini a répondu : « Les États-Unis ont été établis en 1776. 1776 est divisible par 4, mais ce n’est pas une année séculaire (de cent ans), c’est donc une année bissextile. Par conséquent, le jour où les États-Unis ont été établis était dans une année normale. »

On voit bien que le modèle déroule la règle des années bissextiles correctement, donnant par là même une bonne illustration de la technique CoT, mais il conclut de manière erronée à la dernière étape ! Ces modèles n’ont en effet pas de représentation logique du monde, mais seulement une approche statistique qui crée en permanence ce type de glitchs qui peuvent paraître surprenants.

Cette prise de conscience est d’autant plus salutaire qu’aujourd’hui, les IA écrivent à peu près autant d’articles publiés sur Internet que les humains. Ne vous étonnez donc pas d’être étonné par la lecture de certains articles.

Frédéric Prost ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

01.12.2025 à 15:24

Le premier zoo virtuel d’Europe peut-il éveiller les consciences sur le bien-être animal ?

Texte intégral (2504 mots)

De plus en plus décriés, les zoos jouent pourtant un rôle dans la sensibilisation du public à la sauvegarde des espèces sauvages. À Bruxelles, le premier zoo en réalité virtuelle aurait-il trouvé la formule gagnante ?

Inauguré à Bruxelles en septembre 2025 et ouvert au public jusqu’au 30 décembre 2025, le Zoo du futur, premier zoo européen 100 % virtuel promet l’émerveillement d’un zoo, mais sans cages. Imaginé par l’association de protection animale Gaia, en collaboration avec le studio d’expériences immersives Reality Matters, le Zoo du futur propose au public de repenser la relation entre humains et animaux en lui permettant d’admirer une pléiade d’animaux en liberté dans des environnements naturels reconstitués numériquement.

Deux technologies immersives rendent possible la découverte de ces univers numériques : la réalité virtuelle (VR) via des casques afin d’observer les animaux ainsi que la réalité augmentée via une application mobile pour interagir avec des modules pédagogiques (quiz, informations sur les animaux). L’ambition du projet est double : et si la VR ne servait pas seulement à divertir mais aussi à éduquer afin d’encourager des comportements plus responsables ?

Ayant travaillé sur les effets de la VR sur les consommateurs, le Zoo du futur constitue donc un terrain d’observation privilégié pour comprendre comment les technologies immersives modifient les pratiques touristiques et culturelles. Dans le cadre de ces recherches, je me suis entretenu avec plusieurs acteurs de cette initiative.

Renouveler l’expérience du public

Ces technologies immersives impactent plusieurs dimensions dans le vécu du visiteur. La première correspond à la métaversification de l’expérience, c’est-à-dire que le digital agrémente désormais les lieux marchands, culturels et touristiques réels. Dans le cas du zoo bruxellois, trois univers thématiques en VR offrent une expérience immersive aux visiteurs : la savane, la banquise et la jungle.

La seconde dimension correspond à l’aspect multisensoriel offert par les nouvelles technologies, qui, à l’instar d’une expérience réelle, stimulent plusieurs, voire tous les sens. Le Zoo du futur combine sons d’ambiance, diffusion d’odeurs et interaction virtuelle qui impliquent les mouvements du visiteur « pour essayer d’avoir l’immersion la plus aboutie possible », comme l’indique Sébastien de Jonge, le directeur des opérations de Gaia que j’ai pu interroger au cours de mes recherches. Lorsque le visiteur s’équipe du casque VR, il voit subitement un éléphant qui s’approche, ses yeux qui plongent dans les siens, sa trompe qui s’élève. Il essaye de toucher l’animal, persuadé de sentir sa présence. L’illusion sensorielle est palpable et l’émotion réelle.

La troisième dimension correspond à l’empowerment du consommateur, c’est-à-dire la capacité à agir activement avec son corps et à interagir avec les objets de l’environnement virtuel. En permettant de s’immerger à la première personne dans des environnements virtuels aux graphismes très réalistes, la VR séduit le public qui s’attend désormais à être davantage acteur de son expérience que de simplement avoir à écouter une histoire.

Pour Andy Van den Broeck, fondateur de Reality Matters, la VR est complémentaire à l’expérience réelle, voire magnifiée. Il souligne que « dans un zoo réel, vous ne pouvez pas vous approcher aussi près des animaux pour les observer, ou vous déplacer librement et interagir dans ces grands espaces naturels ». De plus, le zoo virtuel enrichit l’expérience avec de la réalité augmentée afin d’offrir une interaction ludique et éducative avec les animaux.

Provoquer l’empathie pour des animaux, même virtuels

Ces dimensions concourent à stimuler un sentiment d’incarnation, c’est-à-dire à l’illusion d’être le personnage virtuel. L’une des forces de la VR réside dans sa capacité à faire vivre une expérience d’incarnation dans laquelle on n’observe pas seulement, mais où l’on réfléchit et réagit émotionnellement d’une façon semblable que lors d’une expérience réelle (Leveau et Camus, 2023).

L’apprentissage par la pratique est une des forces de la VR. L’implication active favorise la mémorisation et l’acquisition des compétences grâce à une compréhension plus concrète et une meilleure appropriation de la situation que la simple lecture d’un document, par exemple. La pyramide de l’apprentissage établi par le chercheur en éducation américain Edgar Dale confirme qu’on apprend mieux lorsqu’on est acteur de la situation d’apprentissage. Un individu retiendrait selon lui seulement 10 % de ce qu’il lit, contre 90 % de ce qu’il dit et fait.

Les technologies immersives développent également l’empathie. Alors que, dans un zoo classique, on contemple des animaux réels, mais privés de liberté, le zoo virtuel exhibe des animaux numériques dans leur habitat naturel. À ce jour, « les visiteurs réfléchissent en termes de protection des espèces, pas d’individus », insiste Sébastien de Jonge. Le zoo virtuel invite à donc renverser le regard en valorisant l’animal comme un être vivant singulier et en proposant une alternative concrète et positive, tout en questionnant les conditions de vie des animaux dans les zoos traditionnels, sans pour autant attaquer leurs méthodes frontalement.

On constate que la gamification interactive associée à la VR, telle que les quiz interactifs sur l’espace vital d’un éléphant, déclenche une prise de conscience et des changements de comportements concrets. Selon Sébastien de Jonge, la réaction du public quant au bien-être des animaux à l’issue de l’expérience virtuelle en témoigne en provoquant des questionnements sur les alternatives à faire valoir. Ainsi, plonger les visiteurs dans des environnements naturels reconstitués en VR suscite une réflexion sur la captivité animale tout en préservant la dimension pédagogique des zoos. Cette approche, en phase avec les attentes des associations de défense animale, invite aussi chacun à repenser son rapport au vivant et à adopter des choix de consommation plus responsables.

Tirer parti des envies contradictoires des consommateurs

C’est précisément le basculement de spectateur passif à acteur impliqué qui confère un rôle inédit dans la sensibilisation éthique et environnementale. L’expérience en VR permet non seulement d’apprendre en interagissant de manière plus directe, mais aussi d’interroger nos modes de consommation et de loisirs. En proposant une alternative plus responsable dans les activités de récréations et de loisirs, la VR agit sur les comportements de manière vertueuse.

À cet effet, la VR contribue à des pratiques marketing plus éthiques en se substituant ponctuellement comme une alternative durable au voyage physique ou en contribuant à un tourisme plus inclusif auprès de certains publics (seniors, PMR, etc.). Pour le zoo, la VR contribue à donner l’illusion d’une expérience réelle sans nuire aux écosystèmes. Gaia défend ce modèle : « Le Zoo du futur, pour nous, c’est une campagne comme une autre », confie Sébastien de Jonge. Les tarifs volontairement bas, à 12 € l’entrée, ne sont pas rentables et confirment cette logique.

Mais qu’en est-il réellement du côté des consommateurs ? Dans un sondage réalisé auprès de 100 personnes, en France, en septembre 2025, 83,4 % déclarent préférer visiter un zoo réel plutôt qu’un zoo virtuel. Pourtant, plus de 98 % d’entre elles déclarent être sensibles au bien-être et aux conditions de vie des animaux en captivité. Ce paradoxe s’observe d’une part à travers le succès commercial des plus grands zoos en Europe, dont la fréquentation dépasse annuellement le million de visiteurs, comme au zoo de Barcelone, d’autre part à travers la multiplication de fermetures de delphinariums (Marineland en France en 2025 ou encore le dernier delphinarium en Belgique, Boudewijn Seapark, dont la fermeture administrative est actée pour 2037).

Inciter le changement de comportements

Enfin, 95 % des personnes interrogées nous ont confié être prêtes à adapter leurs comportements de consommation pour mieux respecter le bien-être des animaux en privilégiant un zoo virtuel plutôt qu’un zoo réel. Ainsi, nous espérons, comme Sébastien de Jonge, que cette fiction-réalité puisse « simplement allumer une lumière dans l’esprit du public » et conduire les zoos à se réinventer pour concilier bien-être animal avec viabilité économique. En cas de succès, le projet temporaire pourrait devenir permanent et esquisser pour les zoos un business model inédit.

Néanmoins, il ne faut pas oublier que ces technologies génèrent une pollution numérique et que la VR est réputée inciter le visiteur à se rendre dans la réalité sur le lieu qu’il a virtuellement exploré. Un tel dispositif risque donc de s’avérer contre-productif, à l’opposé des ambitions affichées par l’association, malgré la vocation première du projet de conjuguer émerveillement, pédagogie et respect du bien-être animal. Avec son zoo virtuel, Gaia démontre cependant le potentiel de la VR au-delà du simple divertissement : la technologie ouvre la voie à des pratiques plus soutenables et à un modèle économique écocentrique, fondé sur la valeur intrinsèque du vivant.

Pierre-Henry Leveau ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

28.11.2025 à 13:13

L’effet ChatGPT : comment, en trois ans, l’IA a redéfini les recherches en ligne

Texte intégral (1883 mots)

Le 30 novembre 2022, OpenAI rendait accessible à tous ChatGPT, l’intelligence artificielle générative sur laquelle elle travaillait depuis sept ans. En trois ans, un geste du quotidien s’est déplacé : au lieu de taper une requête dans Google ou de chercher un tutoriel sur YouTube, des millions de personnes ouvrent désormais ChatGPT pour poser leur question. Ce réflexe nouveau, qui s’impose dans les usages, marque un tournant majeur dans notre rapport à la recherche d’information en ligne.

Il y a trois ans, lorsqu’il fallait réparer un robinet qui fuit ou comprendre l’inflation, la plupart des gens avaient trois réflexes : taper leur question sur Google, chercher un tutoriel sur YouTube ou appeler désespérément un assistant vocal à l’aide.

Aujourd’hui, des millions de personnes adoptent une autre stratégie : elles ouvrent ChatGPT et posent simplement leur question.

Je suis professeure et directrice de la recherche et de la stratégie en matière d’IA à la Mississippi State University Libraries. En qualité de chercheuse spécialisée dans la recherche d’informations, je constate que ce changement dans l’outil vers lequel les gens se tournent en premier pour trouver des informations est au cœur de la manière dont ChatGPT a transformé nos usages technologiques quotidiens.

Près de 800 millions de personnes utilisatrices hebdomadaires

Le plus grand bouleversement n’est pas la disparition des autres outils, mais le fait que ChatGPT soit devenu la nouvelle porte d’entrée vers l’information.

Quelques mois après son lancement, le 30 novembre 2022, ChatGPT comptait déjà 100 millions d’utilisateurs hebdomadaires. Fin 2025, ce chiffre était passé à 800 millions. Cela en fait l’une des technologies grand public les plus utilisées au monde.

Les enquêtes montrent que cet usage dépasse largement la simple curiosité et qu’il traduit un véritable changement de comportement. Une étude réalisée en 2025 par le Pew Research Center (Washington) indique que 34 % des adultes états-uniens ont utilisé ChatGPT, soit environ le double de la proportion observée en 2023. Parmi les adultes de moins de 30 ans, une nette majorité (58 %) l’a déjà testé.

Un sondage AP-NORC rapporte qu’aux États-unis, environ 60 % des adultes qui utilisent l’IA déclarent l’utiliser pour rechercher des informations, ce qui en fait l’usage le plus courant de l’IA. Ce taux grimpe à 74 % chez les moins de 30 ans.

Un bouleversement des usages

Les moteurs de recherche traditionnels restent le socle de l’écosystème de l’information en ligne, mais la manière dont les gens cherchent a, elle, considérablement changé depuis l’arrivée de ChatGPT. Les utilisateurs modifient tout simplement l’outil qu’ils sollicitent en premier.

Pendant des années, Google était le moteur de recherche par défaut pour tout type de requête, de « Comment réinitialiser ma box Internet » à « Expliquez-moi le plafond de la dette ». Ce type de requêtes informatives de base représentait une part importante du trafic. Mais ces petites questions du quotidien, rapides, clarificatrices, celles qui commencent par « Que veut dire… », sont désormais celles que ChatGPT traite plus vite et plus clairement qu’une page de liens.

Et les internautes l’ont bien compris. Une enquête menée en 2025 auprès de consommateurs américains a montré que 55 % des personnes interrogées utilisent désormais les chatbots ChatGPT d’OpenAI ou Gemini AI de Google pour des tâches qu’ils confiaient auparavant à Google Search, avec des taux encore plus élevés au Royaume-Uni.

Une autre analyse portant sur plus d’un milliard de sessions de recherche montre que le trafic issu des plateformes d’IA générative augmente 165 fois plus vite que les recherches classiques, et qu’environ 13 millions d’adultes, aux États-Unis, ont déjà fait de l’IA générative leur outil de prédilection pour explorer le web.

Les atouts de ChatGPT

Cela ne signifie pas que les gens ont cessé d’utiliser Google, mais plutôt que ChatGPT a capté les types de questions pour lesquelles les utilisateurs veulent une explication directe plutôt qu’une liste de résultats. Vous voulez connaître une évolution réglementaire ? Vous avez besoin d’une définition ? Vous cherchez une manière polie de répondre à un email délicat ? ChatGPT offre une réponse plus rapide, plus fluide et plus précise.

Dans le même temps, Google ne reste pas les bras croisés. Ses pages de résultats n’ont plus la même allure qu’il y a trois ans, car le moteur a intégré directement son IA Gemini en haut des pages. Les résumés « AI Overview », placés au-dessus des liens classiques, répondent instantanément à de nombreuses questions simples parfois avec justesse, parfois moins.

Quoi qu’il en soit, beaucoup d’utilisateurs ne descendent jamais plus bas que ce résumé généré par l’IA. Ce phénomène, combiné à l’impact de ChatGPT, explique la forte hausse des recherches « zéro clic ». Un rapport fondé sur les données de Similarweb révèle que le trafic envoyé par Google vers les sites d’information est passé de plus de 2,3 milliards de visites à la mi-2024 à moins de 1,7 milliard en mai 2025, tandis que la part des recherches liées à l’actualité se soldant par zéro clic a bondi de 56 % à 69 % en un an.

La recherche Google excelle dans la mise en avant d’une pluralité de sources et de points de vue, mais ses résultats peuvent paraître brouillons et davantage conçus pour générer des clics que pour offrir une information claire. ChatGPT, à l’inverse, fournit une réponse plus ciblée et conversationnelle, privilégiant l’explication au classement. Mais cette approche se fait parfois au détriment de la transparence des sources et de la diversité des perspectives qu’offre Google.

Côté exactitude, les deux outils peuvent se tromper. La force de Google réside dans le fait qu’il permet aux personnes qui utilisent ChatGPT de recouper plusieurs sources, tandis que l’exactitude de ce dernier dépend fortement de la qualité de la requête et de la capacité de l’utilisateur à reconnaître quand une réponse doit être vérifiée ailleurs.

Enceintes connectées et YouTube

L’impact de ChatGPT dépasse le cadre des moteurs de recherche. Les assistants vocaux comme les enceintes Alexa et Google Home restent très répandus, mais leur taux de possession recule légèrement. Une synthèse des statistiques sur la recherche vocale aux États-Unis pour 2025 estime qu’environ 34 % des personnes âgées de 12 ans et plus possèdent une enceinte connectée, contre 35 % en 2023. La baisse n’est pas spectaculaire, mais l’absence de croissance pourrait indiquer que les requêtes plus complexes se déplacent vers ChatGPT ou des outils similaires. Lorsqu’on souhaite une explication détaillée, un plan étape par étape ou une aide à la rédaction, un assistant vocal qui répond par une phrase courte paraît soudain limité.

En revanche, YouTube reste un mastodonte. En 2024, la plateforme comptait environ 2,74 milliards de personnes utilisatrices, un chiffre en progression constante depuis 2010. Aux États-Unis, près de 90 % des adolescents déclarent utiliser YouTube, ce qui en fait la plateforme la plus utilisée dans cette tranche d’âge. Cependant, le type de contenu recherché est en train de changer.

Les internautes ont désormais tendance à commencer par ChatGPT, puis à se tourner vers YouTube si une vidéo explicative est nécessaire. Pour bon nombre de tâches quotidiennes – « Comprendre mes avantages sociaux », « M’aider à rédiger un email de réclamation » –, ils demandent d’abord à ChatGPT un résumé, un script ou une liste de points clés, puis consultent YouTube uniquement s’ils ont besoin de visualiser un geste ou un processus concret.

Cette tendance se retrouve aussi dans des domaines plus spécialisés. Les développeurs, par exemple, utilisent depuis longtemps les forums comme Stack Overflow pour obtenir des conseils ou des extraits de code. Mais le volume de questions a commencé à chuter fortement après la sortie de ChatGPT, et une analyse suggère que le trafic global a diminué d’environ 50 % entre 2022 et 2024. Lorsqu’un chatbot peut générer un extrait de code et une explication à la demande, moins de gens prennent le temps de poster une question dans un forum public.

Alors, où va-t-on ?

Trois ans après son lancement, ChatGPT n’a pas remplacé l’écosystème technologique, mais il l’a reconfiguré. Le réflexe initial a changé. Les moteurs de recherche restent indispensables pour les explorations approfondies et les comparaisons complexes. YouTube demeure la plateforme incontournable pour voir des personnes réaliser des actions concrètes. Les enceintes connectées continuent d’être appréciées pour leur côté mains libres.

Mais lorsqu’il s’agit d’obtenir rapidement une réponse à une question, beaucoup commencent désormais par l’utilisation d’un agent conversationnel plutôt que par une requête dans un moteur de recherche. C’est là le véritable effet ChatGPT : il n’a pas simplement ajouté une application de plus sur nos téléphones, il a discrètement transformé notre manière de chercher de l’information.

Deborah Lee ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.