22.02.2026 à 08:20

La place méconnue des ingénieurs dans l’histoire du management

Texte intégral (1839 mots)

On sait que les ingénieurs sont tous formés au management, et que nombre d’entre eux en seront des praticiens au cours de leur carrière. Ce qui est nettement moins connu, en revanche, c’est que le management est né au dix-neuvième siècle de l’activité même des ingénieurs, et que des ingénieurs ont systématiquement été au nombre de ses principaux théoriciens.

Les ingénieurs, dont le diplôme est réglementé en France par la Commission des titres d’ingénieurs (CTI), mais dont l’usage du titre au plan professionnel est libre, sont des spécialistes de la conception et de la mise en œuvre de projets techniques. Ils se doivent donc par définition de maîtriser les principes de base du management. Mais à quel point le métier d’ingénieur est-il lié à cette discipline, consacrée à l’élaboration de théories et de pratiques relatives au pilotage des organisations ?

À rebours d’une idée saugrenue, mais pourtant actuellement populaire, selon laquelle le management devrait son origine au nazisme, il s’avère que c’est plutôt du côté des ingénieurs qu’il faut regarder. Car leur activité est en effet historiquement liée à l’essor du management, comme nous l’écrivions dans un article récent dont nous retraçons les conclusions ici.

Révolutions technologiques et management

Le management a de toute évidence toujours existé, puisque de la construction des pyramides aux débuts de la première révolution industrielle en Angleterre au milieu du XVIIIᵉ siècle, en passant par l’édification des cathédrales, la conduite de grands projets a de tout temps nécessité le pilotage de collectifs importants. Mais il s’agissait alors d’initiatives locales, répondant à des contextes techniques et sociaux particuliers, qui ne faisaient pas encore système. Il faut en fait attendre le milieu du XIXᵉ siècle, et la deuxième révolution industrielle, pour voir le management constitué en tant que corpus de réflexion de portée générale relatif aux modalités de conduite des organisations.

Si le management apparaît à cette époque aux États-Unis, c’est en raison de l’essor du chemin de fer entamé au tournant du XIXᵉ siècle, qui implique la mise en place de grandes entreprises destinées à en assurer le pilotage de manière efficace et dans des conditions de sécurité satisfaisantes. Ce modèle de la grande entreprise se diffusera par la suite dans d’autres industries, telles que celle de l’acier, et se substituera progressivement aux petites entreprises artisanales jusqu’alors majoritaires.

À lire aussi : Le management par objectifs n’est pas une invention nazie

À cette première révolution technologique en succède une seconde, amorcée au milieu du XIXᵉ siècle, qui résulte du développement du machinisme et de la hausse des rythmes de production associés. Elle donne elle aussi lieu à des changements dans les modes d’organisation des entreprises, puisque l’on assiste, à partir de 1890, à la naissance d’usines performantes dont le fonctionnement doit être rationalisé et planifié de manière à en tirer parti au maximum.

Vient ensuite la révolution des transports, soutenue par l’essor de l’automobile et par le déploiement d’infrastructures routières. Celle-ci entraîne, au milieu du XXᵉ siècle, l’extension géographique des opérations des entreprises et l’élargissement de leurs périmètres d’activité afin de satisfaire de nouveaux marchés, et l’apparition de l’entreprise qualifiée de multi-divisionnelle.

Enfin, la quatrième révolution technologique habituellement retenue apparaît après la Seconde guerre mondiale, avec l’essor de l’informatique et des télécommunications. Celle-ci renforce la tendance à la dispersion géographique des entreprises déjà amorcée précédemment, et donne lieu à partir des années 1990 à un modèle de management de référence qualifié d’organisation en réseau.

Au total, ce que montrent les observations, et notamment les travaux récents de Bodrožić et d’Adler, c’est que les révolutions dans les modes et les méthodes de gestion des organisations ont systématiquement été la résultante de révolutions technologiques, qui furent elles-mêmes le fruit des activités d’ingénieurs.

Ingénieurs et théorisation du management

Les changements dans le fonctionnement des entreprises induits par ces révolutions technologiques ont nécessité l’élaboration de nouveaux modèles de management, entendus comme des préceptes quant à la meilleure manière de piloter les activités des organisations. Et ici encore, il s’avère que des ingénieurs ont toujours fait partie des principaux théoriciens de ces modèles.

L’essor des grandes entreprises du secteur des chemins de fer au XIXᵉ siècle est ainsi accompagné par les réflexions d’ingénieurs de ce secteur, Benjamin H. Latrobe, Daniel C. McCallum, et J. Edgar Thomson, qui mettent au point ce qui est alors appelé les structures hiérarchico-fonctionnelles. Face aux conditions de travail particulièrement rudes induites par ce modèle, des programmes de réformes sociales sont ensuite développés par des auteurs tels que l’ingénieur George Pullman, fondateur de la compagnie de wagons-lits du même nom.

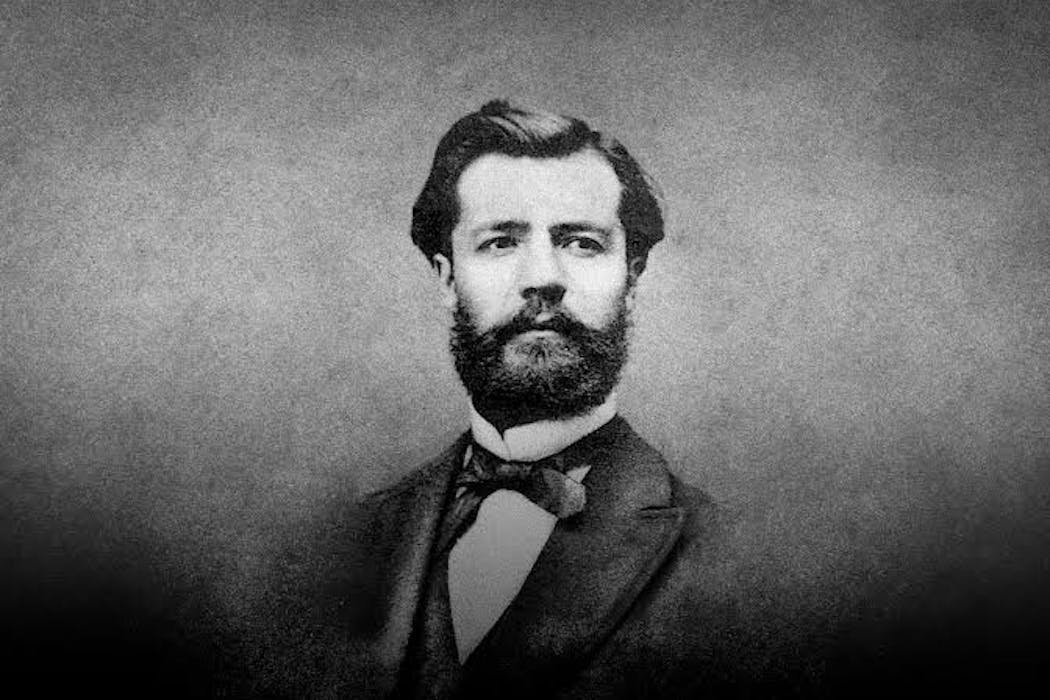

Le fonctionnement des usines performantes qui apparaissent ensuite est quant à lui rationalisé par des auteurs bien connus, dont on oublie parfois qu’ils étaient tous trois des ingénieurs : le Français Henri Fayol, et les États-Uniens Henry Ford et Frederick Taylor. Ici encore, la rudesse des conditions de travail engendrées par la mise en place d’un management scientifique, ou du travail à la chaîne, amène à des réflexions, quant à la manière de restaurer un climat social dégradé, en partie conduites par un ingénieur du nom de George Pennock, tombé dans l’oubli.

Et les pratiques managériales induites par les deux révolutions technologiques les plus récentes sont à l’avenant. L’entreprise multidécisionnelle fut en bonne partie théorisée par un ancien président de General Motors, l’ingénieur Alfred Sloan, et les problématiques de qualité qu’elle engendra furent largement examinées par un ingénieur de Toyota du nom de Taiichi Ohno. Quant au modèle de l’organisation en réseau, il fut notamment pensé et amendé par des ingénieurs spécialistes des systèmes d’information, tels que Michael Hammer et James Champy, ou par un ingénieur de Hewlett-Packard, Charles Sieloff.

Comment expliquer cette importance historique des ingénieurs en matière de théorisation du management ? Ceci tient à deux raisons pratiques. Leur proximité avec les évolutions technologiques de leur époque les amène à identifier précocement les problèmes managériaux que ces changements soulèvent, et les rend aussi mieux à même de résoudre.

Ingénieur et management, un lien à cultiver

Ainsi, le métier d’ingénieur a toujours eu partie liée au management. On ne sera donc pas surpris d’apprendre que, en Europe, l’enseignement du management a d’abord été dispensé en école d’ingénieurs au milieu du XIXe siècle, avant d’être confié aux écoles de commerce au tournant du XXe siècle. Et c’est ce qui explique également que deux des plus prestigieuses écoles d’ingénieurs françaises, l’École des mines de Paris et l’École polytechnique, disposent chacune d’un laboratoire de recherche dédié aux sciences de gestion et du management (respectivement, le Centre de gestion scientifique et le Centre de recherche en gestion), ou que des spécialistes du management interviennent plus généralement dans toutes les écoles d’ingénieurs.

En raison des défis technologiques qui s’annoncent (robotisation, essor de l’IA, sobriété énergétique), il s’avère que ce lien ingénieurs/management doit être affirmé et cultivé. Car ces évolutions s’accompagneront nécessairement de changements organisationnels qu’il sera nécessaire de penser si nous ne voulons pas les subir.

Matthieu Mandard ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

22.02.2026 à 08:17

What is ‘Edge AI’? What does it do and what can be gained from this alternative to cloud computing?

Texte intégral (1949 mots)

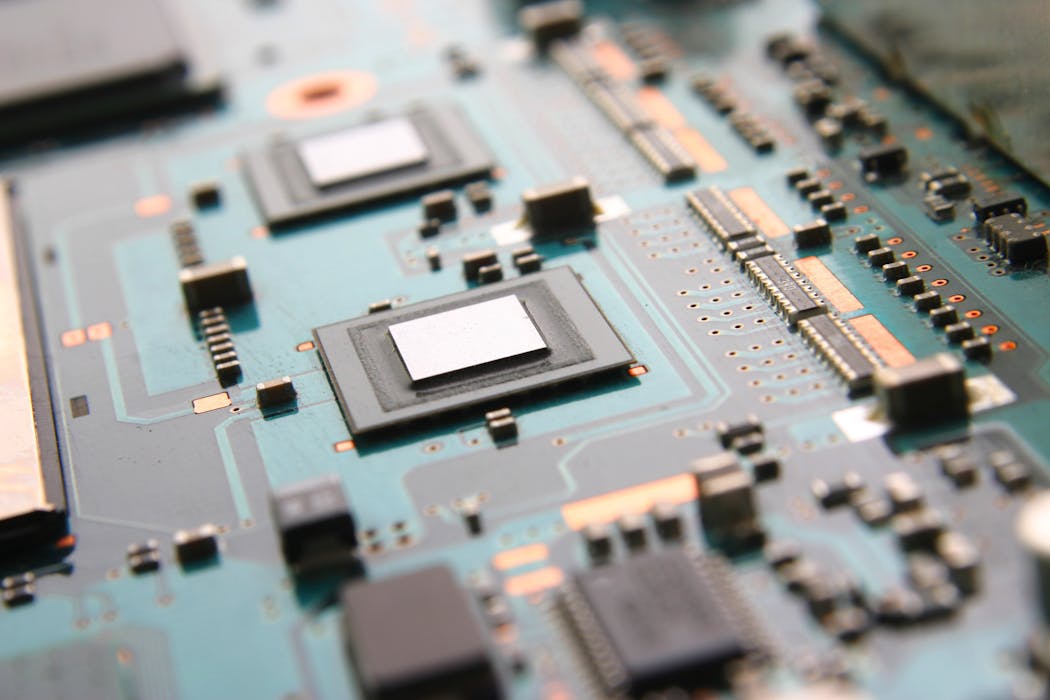

“Edge computing”, which was initially developed to make big data processing faster and more secure, has now been combined with AI to offer a cloud-free solution. Everyday connected appliances from dishwashers to cars or smartphones are examples of how this real-time data processing technology operates by letting machine learning models run directly on built-in sensors, cameras, or embedded systems.

Homes, offices, farms, hospitals and transportation systems are increasingly embedded with sensors, creating significant opportunities to enhance public safety and quality of life.

Indeed, connected devices, also called the Internet of Things (IoT), include temperature and air quality sensors to improve indoor comfort, wearable sensors to monitor patient health, LiDAR and radar to support traffic management, and cameras or smoke detectors to enable rapid-fire detection and emergency response.

These devices generate vast volumes of data that can be used to ‘learn’ patterns from their operating environment and improve application performance through AI-driven insights.

For example, connectivity data from wi-fi access points or Bluetooth beacons deployed in large buildings can be analysed using AI algorithms to identify occupancy and movement patterns across different periods of the year and event types, depending on the building type (e.g. office, hospital, or university). These patterns can then be leveraged for multiple purposes such as HVAC optimisation, evacuation planning, and more.

Combining the Internet of things and artificial intelligence comes with technical challenges

Artificial Intelligence of Things (AIoT) combines AI with IoT infrastructure to enable intelligent decision-making, automation, and optimisation across interconnected systems. AIoT systems rely on large-scale, real-world data to enhance accuracy and robustness of their predictions.

To support inference (that is, insights from collected IoT data) and decision-making, IoT data must be effectively collected, processed, and managed. For example, occupancy data can be processed to infer peak usage times in a building or predict future energy needs. This is typically achieved by leveraging cloud-based platforms like Amazon Web Services, Google Cloud Platform, etc. which host computationally intensive AI models – including the recently introduced Foundation Models.

What are Foundation Models?

- Foundation Models are a type of Machine Learning model trained on broad data and designed to be adaptable to various downstream tasks. They encompass, but are not limited to, Large Language Models (LLMs), which primarily process textual data, but can also operate on other modalities, such as images, audio, video, and time series data.

- In generative AI, Foundation Models serve as the base for generating content such as text, images, audio, or code.

- Unlike conventional AI systems that rely heavily on task-specific datasets and extensive preprocessing, FMs introduce zero-shot and few-shot capabilities, allowing them to adapt to new tasks and domains with minimal customisation.

- Although FMs are still in the early stages, they have the potential to unlock immense value for businesses across sectors. Therefore, the rise of FMs marks a paradigm shift in applied artificial intelligence.

The limits of cloud computing on IoT data

While hosting heavyweight AI or FM-based systems on cloud platforms offers the advantage of abundant computational resources, it also introduces several limitations. In particular, transmitting large volumes of IoT data to the cloud can significantly increase response times for AIoT applications, often with delays ranging from hundreds of milliseconds to several seconds, depending on network conditions and data volume.

Moreover, offloading data – particularly sensitive or confidential information – to the cloud raises privacy concerns and limits opportunities for local processing near data sources and end users.

For example, in a smart home, data from smart meters or lighting controls can reveal occupancy patterns or enable indoor localisation (for example, detecting that Helen is usually in the kitchen at 8:30 a.m. preparing breakfast). Such insights are best derived close to the data source to minimise delays from edge-to-cloud communication and reduce exposure of private information on third-party cloud platforms.

À lire aussi : Cloud-based computing: routes toward secure storage and affordable computation

What is edge computing and edge AI?

To reduce latency and enhance data privacy, Edge computing is a good option as it provides computational resources (i.e. devices with memory and processing capabilities) closer to IoT devices and end users, typically within the same building, on local gateways, or at nearby micro data centres.

However, these edge resources are significantly more limited in processing power, memory, and storage compared to centralised cloud platforms, which pose challenges for deploying complex AI models.

To address this, the emerging field of Edge AI – particularly active in Europe – investigates methods for efficiently running AI workloads at the edge.

One such method is Split Computing, which partitions deep learning models across multiple edge nodes within the same space (a building, for instance), or even across different neighbourhoods or cities. Deploying these models in distributed environments is non-trivial and requires sophisticated techniques. The complexity increases further with the integration of Foundation Models, making the design and execution of split computing strategies even more challenging.

What does it change in terms of energy consumption, privacy, and speed?

Edge computing significantly improves response times by processing data closer to end users, eliminating the need to transmit information to distant cloud data centres. Beyond performance, edge computing also enhances privacy, especially with the advent of Edge AI techniques.

For instance, Federated Learning enables Machine Learning model training directly on local Edge (or possibly novel IoT) devices with processing capabilities, ensuring that raw data remain on-device while only model updates are transmitted to Edge or cloud platforms for aggregation and final training.

Privacy is further preserved during inference: once trained, AI models can be deployed at the Edge, allowing data to be processed locally without exposure to cloud infrastructure.

This is particularly valuable for industries and SMEs aiming to leverage Large Language Models within their own infrastructure. Large Language Models can be used to answer queries related to system capabilities, monitoring, or task prediction where data confidentiality is essential. For example, queries can be related to the operational status of industrial machinery such as predicting maintenance needs based on sensor data where protecting sensitive or usage data is essential.

In such cases, keeping both queries and responses internal to the organisation safeguards sensitive information and aligns with privacy and compliance requirements.

How does it work?

Unlike mature cloud platforms, such as Amazon Web Services and Google Cloud, there are currently no well-established platforms to support large-scale deployment of applications and services at the Edge.

However, telecom providers are beginning to leverage existing local resources at antenna sites to offer compute capabilities closer to end users. Managing these Edge resources remains challenging due to their variability and heterogeneity – often involving many low-capacity servers and devices.

In my view, maintenance complexity is a key barrier to deploying Edge AI services. At the same time, advances in Edge AI present promising opportunities to enhance the utilisation and management of these distributed resources.

Allocating resources across the IoT-Edge-Cloud continuum for safe and efficient AIoT applications

To enable trustworthy and efficient deployment of AIoT systems in smart spaces such as homes, offices, industries, and hospitals; our research group, in collaboration with partners across Europe, is developing an AI-driven framework within the Horizon Europe project PANDORA.

PANDORA provides AI models as a Service (AIaaS) tailored to end-user requirements (e.g. latency, accuracy, energy consumption). These models can be trained either at design time or at runtime using data collected from IoT devices deployed in smart spaces. In addition, PANDORA offers Computing resources as a Service (CaaS) across the IoT–Edge–Cloud continuum to support AI model deployment. The framework manages the complete AI model lifecycle, ensuring continuous, robust, and intent-driven operation of AIoT applications for end users.

At runtime, AIoT applications are dynamically deployed across the IoT–Edge–Cloud continuum, guided by performance metrics such as energy efficiency, latency, and computational capacity. CaaS intelligently allocates workloads to resources at the most suitable layer (IoT-Edge-Cloud), maximising resource utilisation. Models are selected based on domain-specific intent requirements (e.g. minimising energy consumption or reducing inference time) and continuously monitored and updated to maintain optimal performance.

A weekly e-mail in English featuring expertise from scholars and researchers. It provides an introduction to the diversity of research coming out of the continent and considers some of the key issues facing European countries. Get the newsletter!

This work has received funding from the European Union’s Horizon Europe research and innovation actions under grant agreement No. 101135775 (PANDORA) with a total budget of approximately €9 million and brings together 25 partners from multiple European countries, including IISC and UOFT from India and Canada.

21.02.2026 à 16:29

La Stratégie de sécurité nationale des États-Unis : 2022 contre 2025, continuités et ruptures

Texte intégral (1502 mots)

Aux États-Unis, chaque président a l’obligation de publier une Stratégie de sécurité nationale (National Security Strategy, NSS). Celle que l’administration Trump a rendue publique en novembre 2025 – un texte ouvertement partisan et centré sur les intérêts de Washington conformément à la doctrine « America First » – a heurté de front de nombreux responsables européens, qui se remémorent avec une certaine nostalgie l’époque de Joe Biden. Or, la comparaison de la NSS « Made in Trump » avec celle de l’administration Biden montre qu’il existe entre les deux documents plus de continuité qu’on le croit, même si une distinction majeure apparaît sur la question de l’idéologie sous-jacente.

La Stratégie de sécurité nationale des États-Unis publiée en novembre 2025 par l’administration Trump a déjà fait couler beaucoup d’encre, allant jusqu’à parler à propos de la relation à l’Europe d’un « divorce consommé, en attendant la séparation des biens ». Or, sa version précédente, publiée en octobre 2022 par l’administration Biden, constituait déjà une rupture sur bien des points : l’article que j’y avais consacré en janvier 2023 s’intitulait « Prendre acte de la fin d’un monde ».

Naturellement, le ton joue beaucoup : le document de l’administration de Joe Biden – « le bon » – était bien plus lissé et, soyons francs, plus aimable que celui de l’administration de Donald Trump – « la brute ». Néanmoins, si l’on cherche à dépasser la forme et à analyser le fond, ruptures et continuités s’affichent sous des couleurs nettement plus nuancées.

Des visions géopolitiques en réalité très proches

Les deux présidents démocrate et républicain, avec leurs administrations, font preuve d’une très grande continuité quant à, d’une part, la fin de la mondialisation économique et du libre-échange et, d’autre part, la priorisation des intérêts états-uniens à l’échelle mondiale.

La NSS 2022 était porteuse d’une virulente charge à l’encontre du bilan de la mondialisation des échanges économiques des trente dernières années et en tirait les conséquences : selon Jake Sullivan, conseiller à la Sécurité nationale de Joe Biden tout au long du mandat de celui-ci, « l’accès au marché a été pendant trente ans l’orthodoxie de toute politique commerciale : cela ne correspond plus aux enjeux actuels ».

L’enjeu clé est à présent la sécurité des chaînes d’approvisionnement, qui implique pour un certain nombre de produits stratégiques un découplage entre la Chine et les États-Unis : la sécurité économique redevient partie intégrante de la sécurité nationale.

Sur le plan domestique, le message était le grand retour de l’État dans l’économie avec la promotion d’« une stratégie industrielle et d’innovation moderne », la valorisation des investissements publics stratégiques et l’utilisation de la commande publique sur les marchés critiques afin de préserver la primauté technologique. La NSS 2025 ne dit pas autre chose en soulignant que « la sécurité économique est fondamentale pour la sécurité nationale » et reprend chaque sous-thème. La continuité est ici parfaite.

La priorisation géographique entre les deux NSS est également remarquable de continuité : 1) affirmation de la primauté de l’Indopacifique sur l’Europe ; 2) importance accordée aux Amériques, passées de la dernière place d’intérêt en 2015, derrière l’Afrique, à la troisième en 2022 et à la première en 2025.

Le premier point implique une concentration des efforts de Washington sur la Chine, et donc que le continent européen fasse enfin l’effort de prendre en charge sa propre sécurité afin de rétablir un équilibre stratégique vis-à-vis de la Russie. Le deuxième point se manifeste dans la NSS 2022 par la remontée des Amériques à la troisième place, devant le Moyen-Orient, et dans la NSS 2025 l’affirmation d’un « corollaire Trump à la doctrine Monroe », consistant à dénier à des compétiteurs extérieurs aux Amériques la possibilité d’y positionner des forces ou des capacités ou bien d’y contrôler des actifs critiques (tels que des ports sur le canal de Panama).

Dissensions idéologiques

Les deux présidents divergent sur deux points de clivage idéologique, à savoir la conception de la démocratie et le système international, y compris les questions climatiques.

La NSS 2022 avait réaffirmé le soutien sans ambiguïté des États-Unis à la démocratie et aux droits humains de par le monde, en introduisant néanmoins une nuance dans leurs relations internationales : sur le fondement du vote par 141 États de la résolution de l’ONU condamnant l’agression russe de l’Ukraine en mars 2022, l’administration Biden se montrait ouverte au partenariat avec tout État soutenant un ordre international fondé sur des règles telles que définies dans la Charte des Nations unies, sans préjuger de son régime politique.

La NSS 2025, au contraire, ne revendique rien de semblable : elle affirme avec force qu’elle se concentre sur les seuls intérêts nationaux essentiels des États-Unis (« America First »), proclame une « prédisposition au non-interventionnisme » et revendique un « réalisme adaptatif » (« Flexible Realism ») fondé sur l’absence de changement de régime politique, preuve en étant donnée avec le Venezuela, où le système chaviste n’a pas été renversé après l’enlèvement par les États-Unis de Nicolas Maduro.

De plus, la NSS 2025 redéfinit la compréhension même de la notion de démocratie autour d’une conception civilisationnelle aux contours très américains (liberté d’expression à la « sauce US », liberté religieuse et de conscience).

Second point de divergence : la NSS 2022 avait réaffirmé l’attachement de Washington au système des Nations unies, citées à huit reprises, et faisait de l’Union européenne (UE) un partenaire de choix dans un cadre bilatéral UE-États-Unis. C’est l’exact inverse dans la NSS 2025 : non seulement les Nations unies ne sont pas mentionnées une seule fois, mais les organisations internationales sont dénoncées comme érodant la souveraineté américaine.

En revanche, la primauté des nations est mise en exergue, et présentée comme antagoniste aux organisations transnationales. De plus, la notion d’allié est redéfinie à l’aune de l’adhésion aux principes démocratiques tels qu’exposés plsu haut. Cette évolution s’exprime plus particulièrement à l’égard de l’Europe.

La NSS 2025 et l’Europe

La partie de la NSS 2025 consacrée à l’Europe a été vivement critiquée dans les médias du Vieux Continent pour sa tonalité méprisante ; or le sujet n’est pas là. En effet, l’administration Trump opère une distinction fondamentale entre, d’une part, des nations qu’il convient de discriminer selon leur alignement avec la vision américaine de la démocratie et, d’autre part, l’UE, qu’il convient de détruire car elle constitue un contre-pouvoir nuisible. En d’autres termes, elle ne s’en prend pas à l’Europe en tant qu’entité géographique, mais à l’Union européenne en tant qu’organisation supranationale, les États-Unis se réservant ensuite le droit de juger de la qualité de la relation à établir avec chaque gouvernement européen en fonction de sa trajectoire idéologique propre.

La NSS 2025 exprime donc un solide consensus bipartisan sur les enjeux stratégiques auxquels sont confrontés les États-Unis et les réponses opérationnelles à y apporter, s’inscrivant ainsi dans la continuité du texte publié par l’administration Biden en 2022. Mais elle souligne aussi une divergence fondamentale sur les valeurs à mobiliser pour y faire face. C’est précisément ce que le secrétaire d’État Marco Rubio a rappelé dans son intervention lors de la conférence de Munich du 14 février 2026.

Olivier Sueur est chercheur associé au sein de l'Institut d'études de géopolitique appliquée (IEGA).

21.02.2026 à 16:28

Salon de l’agriculture : les Amap redonnent le pouvoir aux agriculteurs et agricultrices

Texte intégral (1736 mots)

À l’occasion du Salon international de l’agriculture de Paris, une étude met en lumière le double bénéfice des associations pour le maintien d’une agriculture paysanne, dites Amap : renforcer l’autonomie des agriculteurs et permettre aux bénévoles d’être des entrepreneurs… collectivement.

L’importance des échanges citoyens pour mettre en œuvre une agriculture durable est au cœur du programme de conférences du Salon international de l’agriculture. Les interrogations sur le « comment mieux manger ? » ou sur le « comment produire autrement ? » continuent de retenir l’attention.

Une des solutions à ces questionnements : l’entrepreneuriat collectif à travers les associations pour le maintien d’une agriculture paysanne (Amap). La finalité de l’Amap est la distribution hebdomadaire de paniers de produits agricoles frais, sous réserve d’un pré-paiement de la production par les membres adhérents. La coopération amapienne se matérialise par un engagement contractualisé de consommateurs bénévoles dans l’activité de production et de vente directe de produits alimentaires locaux. Elle repose sur le désir des membres d’interagir et de servir leur collectif.

En 2022, 375 Amap sont recensées rien qu’en Île-de-France, soit plus de 21 000 familles de bénévoles en partenariat avec environ 400 fermes.

Nos derniers résultats de recherche, issus d’entretiens, soulignent que cette collaboration augmente la capacité d’action et d’autonomisation de l’entrepreneur agricole. Elle confère au producteur agricole une aptitude à être maître de ses choix telle que définie dans la Charte initiale des Amap instaurée en 2003, puis révisée en 2024. Les Amap font émerger un environnement « capacitant » – qui permet la création ou le développement de capacités –, fondé sur la mise en place d’une communauté et l’apport de ressources et compétences externes.

Quatre principes de l’Amap

Les modalités de distribution, ainsi que les prix, sont fixés conjointement entre l’entrepreneur agricole et les adhérents ;

Le pré-paiement des paniers par les adhérents permet à l’entrepreneur agricole d’anticiper les quantités à distribuer et de sécuriser son revenu, notamment en cas d’insuffisance de la production ;

Les consommateurs amapiens participent à la vie de l’exploitation (distribution des paniers, centralisation de l’information, aide apportée à l’agriculteur sur son exploitation, etc.) ;

En contrepartie, l’agriculteur s’engage à produire des aliments selon des méthodes respectueuses de l’agro-écologie et à participer à la gestion de l’Amap.

Ces principes sont rédigés dans la charte des Amap.

Co-production, co-gestion et réciprocité apprenante

La participation bénévole des consommateurs amapiens aux activités des agriculteurs, entrepreneurs, engendre une relation de travail atypique. Celle-ci repose non pas sur une relation salariée avec lien de subordination, mais sur une relation horizontale basée sur un système de co-production, de co-gestion et de réciprocité apprenante.

Ces principes sont illustrés par des témoignages de membres adhérents d’Amap :

- Sur le principe de co-production :

« Avec Marianne (la productrice), il y avait le chantier patates en septembre et puis elle avait demandé aussi pour planter des haies », témoigne une présidente d’Amap interviewée.

- Sur le principe de co-gestion de l’Amap :

« On a une assemblée générale par an de l’Amap […] pour remettre à plat, voir si on change les prix des paniers, voir s’il y a des gens qui ont des choses à dire, qui ont des choses à mettre au point », rappelle un consommateur adhérent interrogé.

- Sur le principe de réciprocité apprenante :

Ce dernier se matérialise par l’identification pour l’entrepreneur agricole des besoins des consommateurs d’une part, et la sensibilisation des consommateurs aux pratiques et difficultés de l’exploitant agricole d’autre part.

« Il y a Alain, le maraîcher, il est toujours là. Il nous présente son activité, il fait un retour sur ce qui s’est bien passé, ce qui s’est moins bien passé l’année passée, ce qu’il prévoit des fois comme nouvelle culture et répond aux questions. » (Président d’Amap.)

À lire aussi : L’Île-de-France pourrait-elle être autonome sur le plan alimentaire ?

En résumé, les consommateurs bénévoles deviennent acteurs du fonctionnement de l’Amap en tant que membres volontaires indépendants. Rappelons que les actes de volontariat s’exercent, selon le chercheur Léon Lemercier :

- en toute liberté (c’est un choix personnel) ;

- dans une structure ;

- pour autrui ou la collectivité ;

- gratuitement ;

- sans contrainte ;

- pour exécuter des tâches.

Militantisme et entrepreneuriat

La coopération amapienne permet d’entreprendre ensemble en partageant les risques financiers liés aux aléas de la production agricole. Elle fait émerger des liens de solidarité au sein d’un territoire et co-crée de la valeur sociale, comme l’explicite précisément un président d’Amap :

« Au-delà de la distribution des paniers, c’est aussi un engagement citoyen. C’est-à-dire qu’on veut aussi développer le mouvement des Amap. On est militant. »

Cette approche entrepreneuriale et altruiste de la relation de travail atypique renouvelle la littérature académique dédiée à son analyse, comme celle de la situation de vulnérabilité du travailleur – emploi temporaire, travail à temps partiel, relation de travail déguisée, etc.

Cette relation de travail non salarié s’inscrit dans le cadre d’un projet entrepreneurial collectif, caractérisé par l’union de compétences complémentaires au sein de l’Amap. Dans ce cas précis, l’agrégation de multiples contributions bénévoles, bien que temporaires et à temps partiel, peut concourir au développement d’une exploitation agricole.

Les bénévoles apportent des ressources spécifiques liées à leur propre parcours de vie : compétences professionnelles, disponibilité temporelle, ou encore expérience organisationnelle qui structurent les Amap.

« Je dirais que le problème de la gestion, on l’a résolu avec nos outils, c’est-à-dire qu’on a eu la chance pendant quelques années d’avoir pas mal de développeurs informatiques dans nos adhérents », déclare un président d’Amap interrogé.

La relation de travail amapienne se situe par conséquent entre bénévolat et professionnalisation puisque les consommateurs vont soutenir l’entrepreneur agricole de l’amont à l’aval de la chaîne de valeur de son activité : de fonctions principales (production, marketing, logistique et distribution) à des fonctions support (ressources humaines, système d’information et administration).

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

21.02.2026 à 09:17

Élevage d’insectes : s’inspirer des autres filières animales pour produire à grande échelle de façon durable

Texte intégral (3201 mots)

L’entomoculture est souvent présentée comme une alternative prometteuse face aux défis et aux limites des modes de production agricoles et alimentaires traditionnels. Quels enjeux cette filière émergente va-t-elle devoir relever pour continuer à se développer ? Il paraît crucial de s’inspirer de l’élevage traditionnel – qui s’appuie notamment sur des normes précises.

La start-up Ÿnsect a fait les gros titres de la presse ces dernières semaines suite à sa faillite. Certains dénoncent un « fiasco » ou interrogent sur la durabilité de l’élevage d’insectes à large échelle.

La critique est aisée, l’art est difficile. L’échec d’une initiative ne doit pas conduire à abandonner cette nouvelle façon de produire, en France, des ressources de grande qualité. Innovafeed, par exemple, redonne espoir à toute la filière grâce à ses récents succès commerciaux. Des entreprises comme Koppert et Biobest commercialisent également depuis des années des insectes auxiliaires pour la protection des cultures et la pollinisation.

Pour rappel, l’entomoculture consiste à élever des insectes en milieu contrôlé pour produire des protéines (alimentation animale ou humaine), des sous-produits (soie, colorants naturels, engrais) ou des insectes vivants (pour le biocontrôle en agriculture). Sur le plan environnemental, certains insectes peuvent également participer à l’économie circulaire. En effet, ils permettent de valoriser des coproduits de l’industrie agroalimentaire ou des déchets organiques. En agriculture, la protection des cultures par les insectes auxiliaires permet dans certains cas de remplacer les pesticides chimiques. En cela, elle s’inscrit dans les stratégies de lutte biologique encouragées par les politiques publiques.

Soutenue par la FAO depuis 2013 pour répondre aux enjeux de sécurité alimentaire et de résilience climatique, la filière est présentée comme une alternative à des modes de production alimentaires qui atteignent leurs limites face aux changements climatiques et à l’épuisement des ressources. Dans les faits toutefois, son développement fait encore face à des défis majeurs.

Des protéines pour l’alimentation animale

La consommation directe d’insectes par les Occidentaux reste limitée en raison de préjugés. En revanche, selon l’ADEME, plus de 70 % des Français accepteraient les protéines d’insectes dans l’alimentation animale, en remplacement des farines de poisson ou des tourteaux de soja massivement importés.

Bien que 2 000 espèces d’insectes soient comestibles dans le monde, l’UE n’en autorise qu’un nombre restreint : huit pour l’alimentation animale (ténébrion meunier, mouche soldat noire, grillons) et quatre pour l’alimentation humaine (criquet migrateur, ténébrion meunier, ténébrion de la litière, grillon domestique).

La France, qui figure parmi les leaders européens de ce secteur, mise sur les débouchés de production de protéines et de lutte biologique. Malgré des difficultés financières récentes, la filière conserve un fort potentiel.

Dans le cadre d’un atelier sur le sujet mené à Orléans en septembre 2025, nous avons identifié trois défis techniques majeurs. Structurer cette filière émergente nécessite :

la maîtrise des cycles biologiques,

la garantie de la sécurité sanitaire

et le contrôle de la qualité nutritionnelle.

Maîtriser les cycles biologiques

Un élevage à large échelle exige une connaissance fine de la biologie des insectes (physiologie, comportements, pathologies) et un contrôle strict des paramètres environnementaux (humidité, température, etc.). Par exemple, l’humidité influence la masse des larves de vers de farine. Les professionnels doivent donc instaurer des seuils d’alerte pour détecter les dysfonctionnements, tout en adaptant l’automatisation des procédés d’élevage aux spécificités de chaque espèce.

Comme pour tous les animaux de rente, la maîtrise du cycle biologique des insectes est essentielle pour la durabilité des élevages. Or, dans le cas de l’entomoculture, les professionnels ne maîtrisent pas encore bien leur production : la diversité des espèces, la sélection génétique débutante et la variabilité des substrats d’élevage compliquent à ce stade l’optimisation des paramètres d’élevage.

Pour l’instant, l’objectif n’est pas d’accélérer la croissance (comme cela peut l’être pour d’autres types d’élevage), mais au contraire de pouvoir la freiner en agissant sur des facteurs biologiques et environnementaux. L’enjeu est de mieux piloter les étapes suivantes de la production, comme la transformation, le stockage et le transport. C’est d’autant plus important pour ceux qui vendent des insectes vivants, comme les auxiliaires de lutte biologique contre les parasites et prédateurs.

Le contexte local (température, humidité, ressources) ajoute une couche de complexité, qui rend l’expertise humaine indispensable. Il faut combiner observation directe, expérience de terrain et adaptabilité. Afin de comparer les pratiques et identifier les facteurs de réussite, le recours à des indicateurs standardisés est nécessaire. Pour les mettre en place, la filière peut s’inspirer des référentiels techniques des élevages traditionnels, comme ceux de la filière porcine (GTTT, GTE), ou des bases de données collaboratives, comme le SYSAAF pour les filières avicoles et aquacoles.

Biosécurité : des enjeux sanitaires spécifiques

Comme pour les élevages traditionnels, l’entomoculture exige par ailleurs un haut niveau de sécurité sanitaire, adapté à la destination des produits : alimentation animale et humaine, ou auxiliaires de culture.

Pour garantir ces exigences, les entreprises doivent compartimenter leurs unités, prévoir des vides sanitaires et des protocoles stricts (gestion des contaminations, éradication des nuisibles, nettoyage). La surveillance des substrats et des supports d’élevage est cruciale, surtout s’ils sont stockés longtemps.

Les producteurs utilisent à cette fin des indicateurs (taux de mortalité, rendement en biomasse, durée des cycles) pour détecter les anomalies. Leurs causes peuvent être multiples : insectes compétiteurs, vecteurs de pathogènes, ou pathogènes cryptiques (c’est-à-dire, dont les signes d’infection ne sont pas immédiatement visibles).

À ce stade toutefois, la connaissance de ces menaces reste limitée : les données sur les virus infectant la mouche soldat noire, par exemple, sont récentes. Pour accompagner l’essor de cette filière, il serait judicieux qu’une nouvelle branche de médecine vétérinaire spécialisée dans les insectes voie le jour. La collaboration avec les laboratoires de recherche en biologie des insectes reste également indispensable pour développer protocoles et procédures de biosécurité sans tomber dans une asepsie totale, qui serait contre-productive : le microbiote des insectes est essentiel à leur croissance et leur fertilité), en d’autres termes à leur santé.

La stimulation du système immunitaire des insectes, principalement innée, peut passer par une « vaccination naturelle », à travers l’exposition à de faibles doses de pathogènes. Cette approche, testée chez l’abeille contre la loque américaine, pourrait être étendue. Une autre piste est la récolte précoce en cas d’infection naissante, pour limiter les pertes.

Cette stratégie nécessite toutefois un arbitrage entre rendement optimal et gestion du risque sanitaire. Le cadre réglementaire actuel est inadapté : les élevages d’insectes ne sont pas couverts par la législation européenne sur la santé animale, et aucune obligation ne contraint à déclarer les pathogènes aux autorités sanitaires. Intégrer l’entomoculture au cadre réglementaire européen existant, tout en adaptant les normes à l’échelle et au budget des producteurs, semble donc indispensable.

Des normes de contrôle qualité à adapter

Se pose enfin la question de la composition nutritionnelle des produits, qui dépend directement de l’alimentation des insectes.

Un substrat riche en acides gras insaturés, par exemple, enrichira les produits finaux en ces mêmes nutriments. Toutefois, cette donnée reste à nuancer selon les espèces et les autres paramètres de production. Les substrats sélectionnés doivent donc correspondre aux critères et aux marchés visés mais également aux comportements alimentaires des espèces élevées et être optimisés pour fournir un rendement optimal. Pour les auxiliaires, un insecte de bonne qualité montre des signes visibles de vitalité et d’adaptabilité aux conditions d’application (culture, serre, verger…).

D’autres paramètres influencent la qualité : le stade et l’âge des insectes, la méthode de mise à mort, le processus de transformation (risque de dégradation nutritionnelle) et le choix de l’espèce. Les professionnels doivent maîtriser les besoins nutritionnels de leurs insectes, la variabilité, la digestibilité des substrats d’élevage et les rendements des processus de transformation. La qualité des produits issus de l’entomoculture doit, enfin, être contrôlée tout au long de la chaîne de production, avec des exigences renforcées pour les marchés de l’alimentation.

Face à ces enjeux, la filière se trouve confrontée à un dilemme réglementaire. Faut-il appliquer directement les normes d’autres productions animales (filières aquacoles ou avicoles par exemple), au risque d’imposer des contraintes inadaptées et potentiellement contre-productives pour une filière aux spécificités biologiques et techniques très différentes ?

Ou bien attendre l’élaboration de réglementations spécifiques aux insectes, au risque de ralentir le développement du secteur et de créer une incertitude juridique ? Une approche pragmatique serait d’adapter progressivement les normes existantes aux réalités de l’entomoculture.

Structurer une filière d’avenir

L’entomoculture représente une piste sérieuse pour relever les défis alimentaires et climatiques du XXIe siècle. Mais son succès dépendra de notre capacité collective à structurer cette filière naissante tout en préservant son potentiel innovant.

Pour qu’elle puisse répondre aux attentes futures, plusieurs défis doivent être relevés. D’abord, créer des référentiels et standardiser les pratiques : guides de bonnes pratiques partagés, protocoles cadrés par espèce, formations pour les opérateurs et décideurs. L’équilibre entre automatisation et expertise humaine reste crucial, notamment pour évaluer des paramètres non mesurables par des capteurs.

Ensuite, améliorer la gestion des risques en instaurant des seuils d’alerte et en hiérarchisant les causes possibles de dysfonctionnement pour les anticiper. Les élevages devront aussi s’adapter aux contextes locaux, particulièrement en matière d’énergie et de ressources disponibles.

Enfin, faire évoluer la législation pour inclure pleinement l’entomoculture, y compris dans les certifications, comme le bio, et les lois sur l’éthique animale dont les insectes restent aujourd’hui exclus. Cet angle mort réglementaire peut convenir provisoirement à certains opérateurs, mais constitue un frein à la crédibilité et à l’acceptabilité sociale de la filière dans son ensemble.

Caroline Wybraniec a reçu des financements de l'ANR FLYPATH (ANR-24-CE20-6083).

Bertrand Méda a reçu des financements de l'Institut Carnot France Futur Elevage (projet PINHS, 2020-2023).

Christophe Bressac a reçu des financements de la région centre val de Loire (projet BioSexFly) et de la BPI (i-Démo FrenchFly)

Elisabeth Herniou a reçu des financements de l'ANR FLYPATH (ANR-24-CE20-6083) et EU Marie Sklodowska-Curie grant agreement 859850 INSECT DOCTORS).

Matthis Gouin a reçu des financements de l'ANR FLYPATH (ANR-24-CE20-6083) et Région Centre Val de Loire

21.02.2026 à 09:15

Dermatose nodulaire : comment faire évoluer les dispositifs de gestion sanitaire ?

Texte intégral (2457 mots)

La crise de la dermatose nodulaire bovine qui a frappé la France a mis en tension la gouvernance sanitaire française. Au-delà des mesures d’abattage contestées, elle révèle l’enjeu d’adapter les dispositifs de gestion aux réalités du terrain et souligne l’urgence à intégrer davantage les éleveurs en amont de la gestion de crise.

L’émergence du virus de la dermatose nodulaire contagieuse bovine (DNCB) (DNCB) en France a mis en tension l’organisation sanitaire française. Ceci tient à plusieurs raisons. D’abord sa longue durée d’incubation, qui retarde le diagnostic et implique un contrôle difficile des échanges d’animaux. Puis l’urgence de la situation, entraînant une fatigue opérationnelle de l’ensemble des professionnels. Aussi, les impacts sociaux et économiques (et moraux) des mesures de restriction et d’abattage ont conduit à des contestations de ces mesures. Le ministère de l’intérieur y a répondu par un recours à la force.

La crise de la DNCB a provoqué une véritable crise de gouvernance qui s’est cristallisée sur la contestation des mesures de gestion prises en aval de la crise (politiques d’abattage, régimes d’indemnisation…) Elle révèle pourtant l’importance des processus gestionnaires en amont de ces situations (préparation, investissements dans les ressources et l’intelligence collective) pour faire face aux potentielles futures épizooties.

À lire aussi : Dermatose nodulaire contagieuse : les vétérinaires victimes d’une épidémie de désinformation

Les stratégies sanitaires : une diversité de dispositifs

La DNCB est qualifiée dans les réglementations européenne et française comme une « maladie à éradication immédiate ». Les autorités sanitaires ont ainsi dû agir en urgence pour mettre en œuvre les dispositifs de gestion prévus pour « gérer » ce type de maladie : dispositifs de surveillance, de vaccination, de confinement, de biosécurité, de dépeuplement ou d’abattage, d’indemnisation des éleveurs…

Ces dispositifs assemblent des éléments hétérogènes pour accomplir une finalité de stratégie sanitaire : des réglementations (par exemple le règlement européen UE 2016/429), des connaissances (modèles et savoirs épidémiologiques, savoirs règlementaires…), des individus (vétérinaires, préfets…), diverses organisations (services de l’État déconcentrés, laboratoires…), des protocoles (tels que le plan d’intervention d’urgence sanitaire ou les modes d’emploi des vaccins), des outils (vaccin, cartographies…), etc. Or, le déploiement de ces dispositifs a des effets, attendus ou inattendus, qui peuvent en affecter l’efficacité s’ils ne sont pas révisés et discutés en fonction de la situation dans laquelle on les met en œuvre.

L’émergence d’une « situation de gestion »

Les gestionnaires de l’action publique sanitaire sont constamment pris dans un équilibre instable, intrinsèquement lié à l’activité de management. De ce point de vue, la détection et la propagation d’un virus dans un territoire provoquent ce qu’on appelle une « situation de gestion »

Il s’agit d’une situation où des participants sont mis à contribution, volontairement ou par obligation, pour trouver une solution à un problème et le résoudre, dans une temporalité et un espace donnés. Les solutions sont rarement immédiates, d’autant plus lorsque les problèmes sont peu structurés, où que de nouveaux problèmes surgissent (actions d’opposants aux mesures de dépeuplement par exemple). C’est un cadre théorique qui permet de comprendre comment s’engagent des processus collectifs de problématisation, de production de sens et de réorganisation pour résoudre progressivement la situation.

Toute la question est de savoir comment les gestionnaires de l’action publique peuvent favoriser (ou non) ces processus. Dans le cas de la DNCB, les processus gestionnaires « visibles » (ceux qui ont abouti aux mesures de dépeuplement ou d’indemnisation) ont avant tout reposé sur une rationalité régalienne implacable, justifiée par la réglementation et l’urgence de la situation. Pour faire accepter ces mesures de gestion, elle s’est appuyée sur deux instruments. D’un côté, une « pédagogie » basée sur des savoirs scientifiques élevés au rang d’argument d’autorité. De l’autre, sur des indemnisations pour réparer les dégâts et le recours à la force pour faire obtempérer les indociles.

Pour autant, l’étude d’autres situations sanitaires peut permettre de dégager des pistes pour piloter et favoriser des processus gestionnaires en amont des crises.

À lire aussi : Zoonose : cinq ans après le début du Covid, comment minimiser les risques d’émergence ?

Renégocier les dispositifs sanitaires sur le terrain : l’exemple de la fièvre catarrhale ovine en Corse en 2013

En Corse, nous avons étudié plusieurs situations sanitaires : la crise de la fièvre catarrhale ovine (FCO) de 2013, l’échec de la vaccination contre la maladie d’Aujeszky sur les porcs (2011-2013), la réémergence de la tuberculose bovine, le processus de « biosécurisation » des élevages porcins lors de l’introduction de la peste porcine africaine (PPA) en Belgique (2018-2020).

Nos résultats montrent que l’articulation de nombreux dispositifs de gestion peut être améliorée en renforçant la coopération entre les acteurs qui les adaptent et les appliquent sur le terrain. Nous avons modélisé une « écologie de dispositifs dynamique » en analysant les adaptations locales de l’activité gestionnaire régalienne.

Reprenons ici le cas de la gestion de la crise liée à l’introduction de la FCO en Corse en 2013, qui est assez similaire à celle posée par la DNCB. Suite à la détection du virus en septembre 2013, l’État a déployé une stratégie basée sur une vaccination massive (ovins, caprins, bovins) et blocage des échanges commerciaux. Mais sur le terrain, plusieurs obstacles majeurs ont obligé l’administration et les éleveurs à réinventer ensemble la situation et la stratégie.

Par exemple, les exportations d’animaux, interdites depuis l’ensemble du territoire insulaire, engendraient un surcoût pour les éleveurs corses qui ne pouvaient plus exporter leurs agneaux vers la Sardaigne, leur principal client. À la demande des éleveurs, un accord inédit a alors été négocié avec l’Italie pour maintenir ces exportations. L’État s’est ainsi assuré de favoriser l’implication des éleveurs dans la stratégie sanitaire.

Aussi, alors que l’administration sanitaire s’est étonnée de la lenteur de la vaccination en octobre 2013, les éleveurs ont expliqué que c’était la pleine période des naissances (agnelages), un moment critique où l’acte vaccinal (manipulation de l’animal, stress), peut avoir des conséquences désastreuses (avortements, affaiblissement). Le calendrier fut décalé en conséquence, et il a été accepté de perdre du temps administratif (et « épidémiologique ») pour respecter le cycle biologique des animaux et le fonctionnement zootechnique des fermes.

Enfin, le dispositif de vaccination des chèvres a été abandonné en cours de route. Le vaccin utilisé n’étant pas officiellement homologué pour les chèvres, des éleveurs craignaient des effets secondaires et des vétérinaires refusèrent d’en prendre la responsabilité. Ce renoncement était pragmatique : contrairement aux ovins, les chèvres ne développaient pas de forme grave de cette maladie. Le risque de créer un réservoir du virus dans le compartiment caprin a été collectivement accepté.

Toutes ces problématiques et modifications, créations ou abandons de dispositifs ont pu être discutées et validées collectivement (parfois de manière conflictuelle, cela arrive et c’est normal) dans le cadre d’un comité de pilotage bimensuel. Il a impliqué une grande diversité d’acteurs : services de l’État, vétérinaires, associations d’éleveurs, chasseurs, chercheurs, etc.

Cet exemple illustre une forme de dialectique entre la situation de crise et les dispositifs de gestion sanitaire déployés. Quelle que soit la rigidité des règles, la problématisation collective est une mécanique majeure permettant la recombinaison et l’adaptation des dispositifs qui vont impacter la vie des éleveurs et des animaux. Cette dialectique ne sera jamais la même d’un territoire et d’une temporalité à l’autre, et la participation des éleveurs (et autres acteurs), en est le moteur principal.

Enfin, cette dialectique ne s’exprime pas seulement en temps de crise, elle peut également s’exprimer en routine… à la condition que les modalités de gouvernance sanitaire le permettent. Penser les émergences et crises à venir c’est précisément penser cette « écologie des dispositifs » et sa dynamique.

La gouvernance sanitaire au cœur d’un problème à trois corps

La gouvernance de la santé animale est l’expression, autant qu’elle en est captive, de ce que Foucault appellerait un « biopouvoir » qui structure le secteur de l’élevage. Il se manifeste par trois dispositifs en tension permanente et en équilibre instable, particulièrement lors de l’émergence de maladie :

Un dispositif « productif-marchand » dans lequel l’animal est vu comme un facteur de production ou une marchandise ;

Un dispositif « biosécuritaire » dans lequel l’animal est vu comme porteur d’un risque épidémiologique (pour lui, le troupeau, le cheptel national, l’humain dans le cas de zoonoses) ;

Un dispositif « écologie-éthique » qui replace l’animal dans son environnement, et le reconnaît comme être vivant sensible, associé au bien-être et à la reconnaissance du travail des éleveurs.

La crise de la DNCB montre comment le premier dispositif a été au cœur de l’expression de ce biopouvoir. Les savoirs épidémiologiques (dispositif « biosécuritaire ») ont été mobilisés dans une politique et une gestion sanitaires contraintes par les structures marchandes. Dans ce contexte, les autres connaissances, par exemple, les apports de la sociologie du travail sur la relation animal-humain ne « pesaient » plus guère, ou si peu.

Ainsi, alors que les réformes de la gouvernance sanitaire cherchent depuis longtemps à « responsabiliser les éleveurs », il parait paradoxal que ces derniers ne soient pas associés à la conception des stratégies sanitaires, à leur suivi et à la réévaluation de ces « écologies » de dispositifs.

Construire une gouvernance du sanitaire c’est établir des liens de confiance et d’inclusion. Alors que ces liens semblent aujourd’hui extrêmement ténus, une future situation pourrait devenir totalement incontrôlable si les éleveurs ne signalaient plus les suspicions à leur vétérinaire de peur de perdre tout leur troupeau. C’est aussi un phénomène connu, analysé et documenté.

Alors que la question, au regard du changement climatique et de l’ultra-connectivité de nos économies agricoles, n’est plus tant de savoir si le cheptel va être touché par tel ou tel pathogène, mais quand et avec quelle intensité, la reconstruction de ces liens de confiance est d’une brûlante nécessité.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

20.02.2026 à 17:53

Salomé, danseuse érotique et cruelle dans l’œil des peintres

Texte intégral (4287 mots)

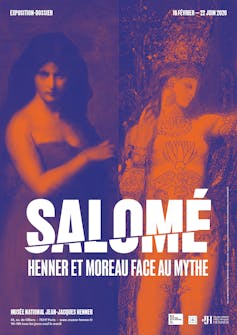

L’exposition « Salomé, Henner et Moreau face au mythe », au musée national Jean-Jacques-Henner, à Paris, qui se tient du 18 février au 22 juin 2026, présente au public une trentaine de peintures et de dessins figurant la danseuse biblique, incarnation de la séduction féminine.

De courts passages des Évangiles mettent en scène Salomé à l’occasion de la fête d’anniversaire de son grand-oncle, Hérode Antipas, gouverneur, ou tétrarque, de Galilée et de Pérée, au nord et à l’est de la Judée, pour le compte des Romains, vers 29 de notre ère.

La jeune fille « vint exécuter une danse et elle plut à Hérode et à ses convives » raconte l’Évangile selon Marc (Mc 6, 22). Pour qu’elle accepte de se donner en spectacle, Antipas avait promis une forte récompense à sa petite-nièce : « Tout ce que tu me demanderas, je te le donnerai, serait-ce la moitié de mon royaume », lui avait-il assuré.

Une promesse bien excessive. Salomé qui n’a rien d’une innocente jeune fille va en tirer profit. Une fois sa prestation accomplie, elle exige comme salaire « sur un plat, la tête de Jean le Baptiste ». Le prophète, précurseur du Christ pour les chrétiens, est alors décapité sur ordre d’Antipas pour satisfaire la demande de l’adolescente.

Le récit évangélique est très bref. Il n’en produit pas moins, dans l’esprit des lecteurs, de fortes images mentales, propices à la rêverie. On y trouve trois ingrédients étroitement liés : une jeune fille, une danse, un meurtre.

Ainsi, une princesse qu’on imagine particulièrement charmante, sans quoi son grand-oncle n’aurait pas insisté outre mesure pour la voir danser, est-elle capable, contre toute attente, de provoquer l’exécution d’un saint homme. Cette ambivalence constitue le moteur du fantasme « Salomé » qui associe le désir et la mort.

La bacchante impudique

Plus tard, Saint Augustin (354-430) a contribué à populariser la figure de Salomé, de manière paradoxale, puisque son but était de condamner la femme réputée impudique. En décrivant une danse érotique effrénée, il fixe définitivement ce qui jusque-là n’avait été que suggéré par les Évangiles : « Tantôt, elle se courbe de côté et présente son flanc aux yeux des spectateurs ; tantôt, en présence de ces hommes, elle fait parade de ses seins » (seizième sermon Pour la décollation de saint Jean-Baptiste).

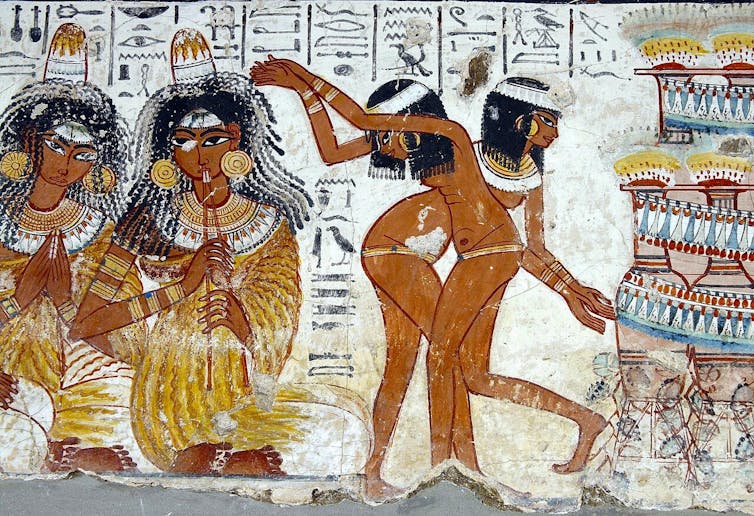

À l’époque où écrit l’auteur, les cultes polythéistes sont encore présents dans l’Empire romain. Augustin se souvient sans doute des images de bacchantes, ces femmes de la mythologie grecque, adeptes de Bacchus ou Dionysos et dépeintes comme des danseuses déchaînées.

Sur un grand vase en bronze doré, découvert à Derveni, dans le nord de la Grèce, aujourd’hui au musée archéologique de Thessalonique, on peut voir une bacchante en délire, dont un sein dénudé bondit par-dessus sa tunique. Les courbes de son corps ne manquent pas d’exciter le satyre, être hybride mi-homme mi-bouc, dont le phallus se dresse à gauche de la danseuse.

Au XVe siècle, le peintre italien Benozzo Gozzoli s’inspire à son tour de ces antiques images, comme le montrent les mouvements du drapé de sa Salomé. Alléché, Hérode Antipas, pose sa main droite sur son cœur, siège du désir amoureux, tandis que, de l’autre, il serre fortement un couteau phallique pointé vers le haut.

La danseuse orientale

Au XIXe siècle, la figure de la bacchante antique fusionne avec celle de la danseuse du ventre, alors que le mouvement orientaliste triomphe en Occident dans l’art et la littérature. Gustave Flaubert dans « Hérodias », l’un de ses Trois Contes (1877), joue un rôle majeur dans ce processus d’identification. Pour décrire Salomé, il s’inspire des danseuses égyptiennes Kuchuk Hanem et Azizeh qu’il a rencontrées lors d’un voyage dans la vallée du Nil :

« Les paupières entre-closes, elle se tordait la taille, balançait son ventre avec des ondulations de houle, faisait trembler ses deux seins. »

La Salomé de Flaubert devient le prototype de la danseuse orientale qui va fasciner le public occidental pendant plusieurs décennies.

En 1891, Oscar Wilde, s’inspire de Flaubert dans sa pièce de théâtre Salomé, tout en inventant le thème de la danse des sept voiles, striptease oriental en plusieurs étapes, qui sera mis en musique par Richard Strauss, en 1905.

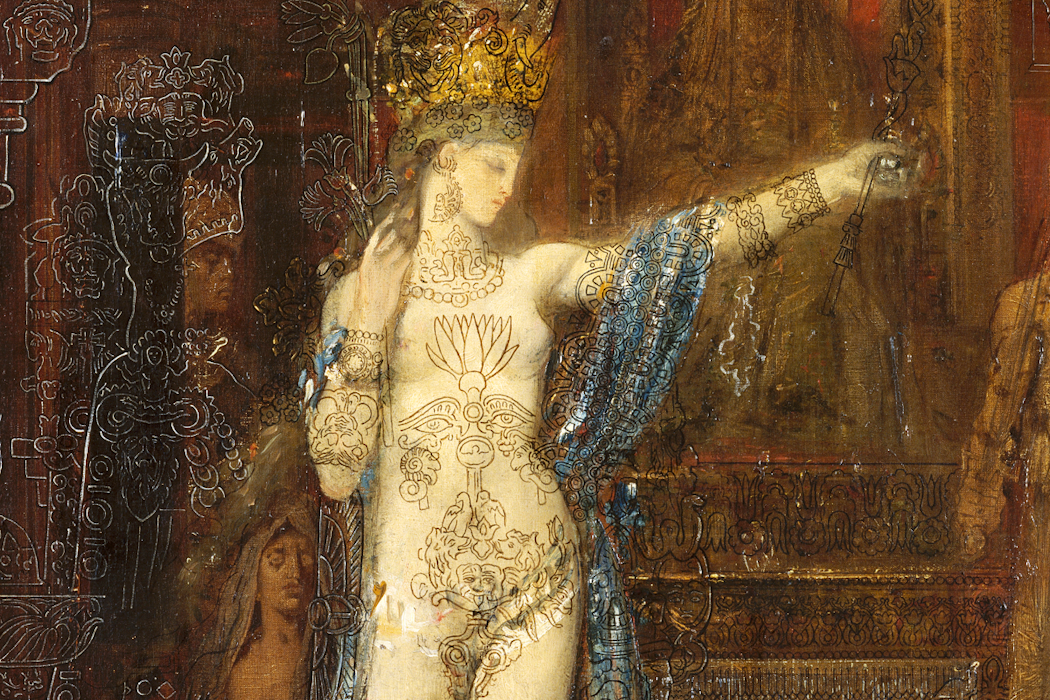

C’est dans ce contexte d’orientalisme occidental, associant érotisme et exotisme, que s’inscrit l’œuvre de Gustave Moreau (1826-1898). S’y ajoute la découverte archéologique de l’Égypte antique et notamment de fresques montrant des banquets, des musiciennes et des danseuses dénudées sur les parois d’antiques tombeaux.

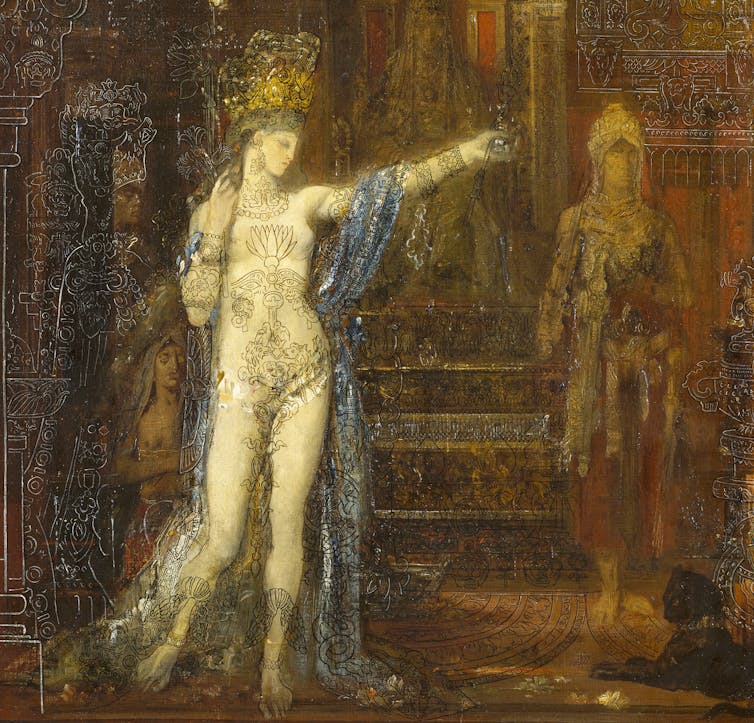

Gustave Moreau réalise plusieurs peintures et dessins figurant Salomé, notamment une Salomé dansant, commencée en 1874 et retouchée jusque dans les années 1890, qui compte parmi des chefs d’œuvres de l’artiste. La princesse, déhanchée, se déshabille de son long drapé bleu ; elle lève le bras gauche, signe qu’elle va commencer sa danse.

Si son corps est inspiré des Vénus de la sculpture gréco-romaine, avec ses petits seins, ses larges hanches et la blancheur de sa nudité qui évoque le marbre, les motifs qui le couvrent, à la manière de tatouages, font directement référence à l’Égypte pharaonique.

On y trouve des cobras égyptiens, une fleur de lotus, des amulettes en forme d’œil Oudjat, associé au dieu Horus, ou encore un scarabée ailé, symbole de résurrection, et des têtes de bélier qui évoquent Amon.

À lire aussi : Les prêtresses de l’Égypte ancienne : entre érotisme et religion

La technique de surimpression elle-même a pu être suggérée au peintre par des momies de femmes égyptiennes aux corps tatoués, mises au jour depuis le XIXᵉ siècle dans la vallée du Nil.

Il en résulte une œuvre où, malgré l’effeuillage de la princesse, c’est en fin de compte l’énigme et le mystère qui prédominent.

Jeunesse, beauté et mystère

Dans les années 1890, Jean-Jacques Henner (1829-1905) s’empare à son tour de la séduisante princesse qu’il traite d’une manière très différente de Moreau. Les thèmes de l’Orient et de la danse s’estompent comme des accessoires secondaires aux yeux du peintre.

Henner se concentre sur l’essentiel selon lui : la jeunesse et la beauté charnelle émergeant d’une brume mystérieuse. Il peint une adolescente au regard trouble, longs cheveux et épaules dénudées, tenant contre elle le grand plateau de cuivre, discret élément oriental, sur lequel elle va recevoir la tête du saint décapité. La chair, pâle et brillante de la jeune fille, est mise en valeur par le contraste avec sa tunique de couleur unie, bleue (prototype vers 1892) ou rouge (variante de 1904), et le fond très sombre. La beauté de la chair paraît sortie d’un songe aux contours flous mais terriblement captivants.

Déhanchements et culture de masse

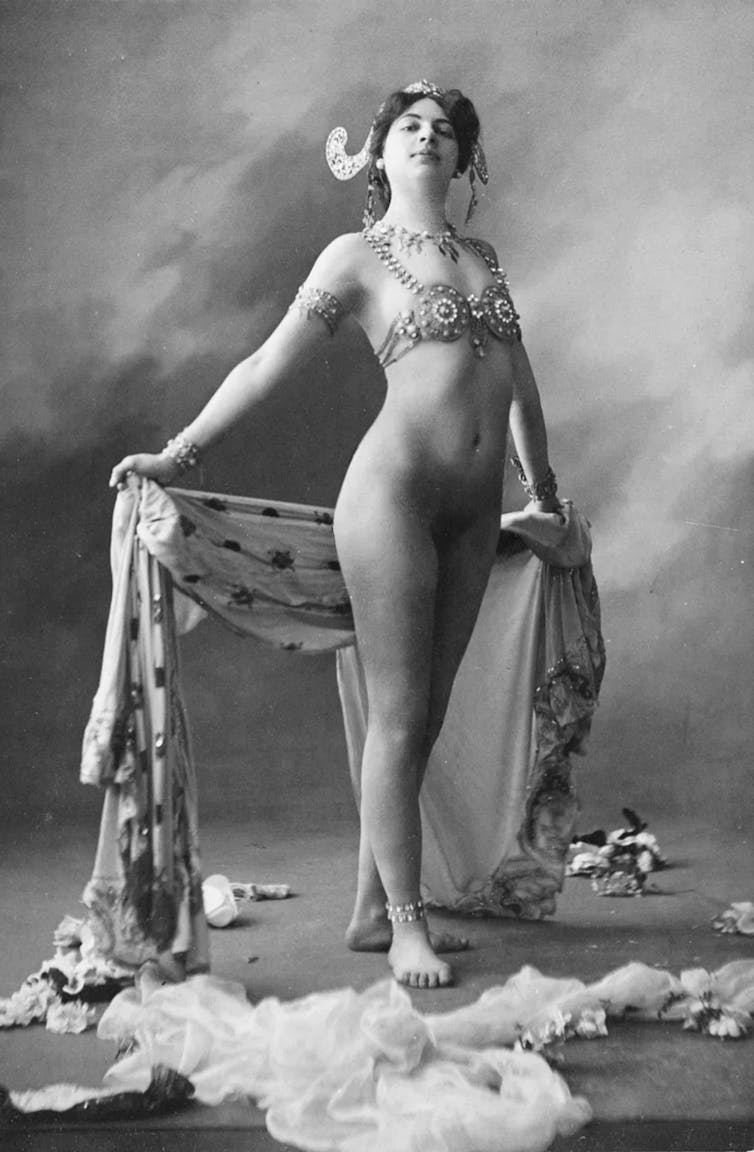

Dans la seconde moitié du XIXe et au début du XXe siècle, l’apogée du mythe « Salomé » n’en est pas moins limité à une élite cultivée, intellectuelle et bourgeoise, « fin de siècle ». Contrairement à Cléopâtre, autre figure fantasmée héritée de l’Antiquité, elle ne fera que des apparitions très brèves et peu marquantes dans la culture de masse au XXᵉ siècle. Salomé tombe progressivement dans l’oubli.

Le fantasme de l’effeuillage exotique est dissocié de son prototype biblique. La danseuse lascive va triompher auprès du grand public sous d’autres noms, comme Mata Hari, prétendue princesse javanaise adepte du dieu hindou Shiva qui fascine Paris et l’Europe occidentale à la veille de la Première Guerre mondiale. La cruauté de la femme fatale est gommée au profit de ses seuls appâts physiques et érotiques.

En 2006, dans la continuité de ces ondulations sensuelles remontant à l’Égypte pharaonique, Shakira et Beyoncé remportent un succès mondial avec leur clip intitulé Beautiful Liar, qui offre étonnant mélange de RnB et de danse arabe. Les déhanchements rythmés s’accompagnent désormais de paroles féministes : il n’est plus question de la décapitation d’un prophète, mais d’un pervers narcissique que les deux interprètes décident conjointement de bannir de leur existence. Une décision salutaire !

Christian-Georges Schwentzel ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

20.02.2026 à 16:44

Pourquoi les Français font-ils moins d’enfants ? Comprendre la fin d’une exception

Texte intégral (2524 mots)

Pendant des décennies, la France a fait figure d’exception démographique en Europe, grâce à une fécondité relativement élevée. Or, cette singularité s’efface aujourd’hui à la faveur de transformations des trajectoires de vie, des territoires et des représentations de l’avenir. Derrière les chiffres des naissances, c’est une recomposition silencieuse qui se dessine. Que nous dit-elle de la société française contemporaine ?

En ce début d’année 2026, l’Insee vient de publier une estimation que toute la presse a reprise : la France a connu, en 2025, 645 000 naissances pour 651 000 décès. Cette situation n’est pas une surprise, mais le révélateur d’une dynamique amorcée depuis plus d’une décennie.

Pendant longtemps, la France a constitué une exception en Europe. Par exemple, l’Allemagne connaît un déficit naturel depuis 1970, et l’Italie depuis 1990.

Avec 1,56 enfant par femme en 2025, la France reste plus féconde que la moyenne de l’Union européenne (1,38 enfant par femme en 2023). Mais ce niveau est le plus faible connu par le pays depuis la Première Guerre mondiale.

Une modification structurelle de la dynamique démographique

Ces mesures sont données par l’indicateur conjoncturel de fécondité (ICF) qui estime le nombre d’enfants qu’auraient, en moyenne, les femmes si elles avaient au cours de leur vie fertile les taux de fécondité par âge mesurés une année donnée (on additionne par exemple la fécondité des femmes de chaque groupe d’âge, de 15 à 49 ans, en 2025 pour obtenir un taux de fécondité total conjoncturel en 2025).

Cet indicateur présente l’avantage de pouvoir être calculé en temps réel. L’inconvénient est qu’il ne tient pas compte du calendrier de la fécondité. Si une génération de femmes a des enfants plus tard, il y aura une baisse de l’ICF alors que sa descendance finale (DF) ne diminuera pas nécessairement.

La descendance finale (DF) est un constat : on regarde à la fin de leur vie fertile, combien d’enfants a réellement eu une génération de femmes. C’est donc une mesure réelle, non impactée par le calendrier de la fécondité, mais il faut attendre qu’une génération de femmes ait atteint 50 ans pour la calculer.

L’ICF est donc soumis à des variations annuelles plus fortes que la DF. Ainsi, l’ICF a varié depuis 1980 où il était de 1,94 enfant par femme. On a observé une phase de baisse jusqu’en 1995 avec un minimum de 1,73, puis une hausse jusqu’en 2010 où on a atteint 2,03. À partir de 2014, s’amorce une baisse très rapide jusqu’à 1,56 en 2025.

La DF a été relativement stable : elle a varié entre 2 et 2,1 enfants par femme pour les générations 1960, 1970 ou 1980. Il est trop tôt pour pouvoir calculer la DF de la génération 1990, mais elle sera probablement plus faible.

Des enfants de plus en plus tard

Les Françaises ont leurs enfants de plus en plus tard. Cette évolution a commencé vers la fin des années 1960. L’âge moyen des mères à la maternité s’est encore retardé à 29,6 ans en 2005, puis à 31,2 ans en 2025.

Le fait d’avoir des enfants de plus en plus tard, en lien avec la baisse de la fertilité des femmes après 30 ans, joue aussi sur la DF. Ainsi, 87 % des femmes de la génération 1930 (les mères du baby-boom) ont eu au moins un enfant. Ce chiffre tombe à 80 % pour la génération 1970 et il s’approche de 75 % pour celles de 1980.

Une nouvelle géographie de la fécondité

Tout au long du XXᵉ siècle, les déterminants de la fécondité étaient sociaux et étaient représentés par une courbe en U. Les Françaises les plus fécondes étaient celles issues des catégories socioprofessionnelles les plus aisées et les plus modestes. Les Françaises les moins fécondes étant issues des classes sociales moyennes (employés et des professions intermédiaires).

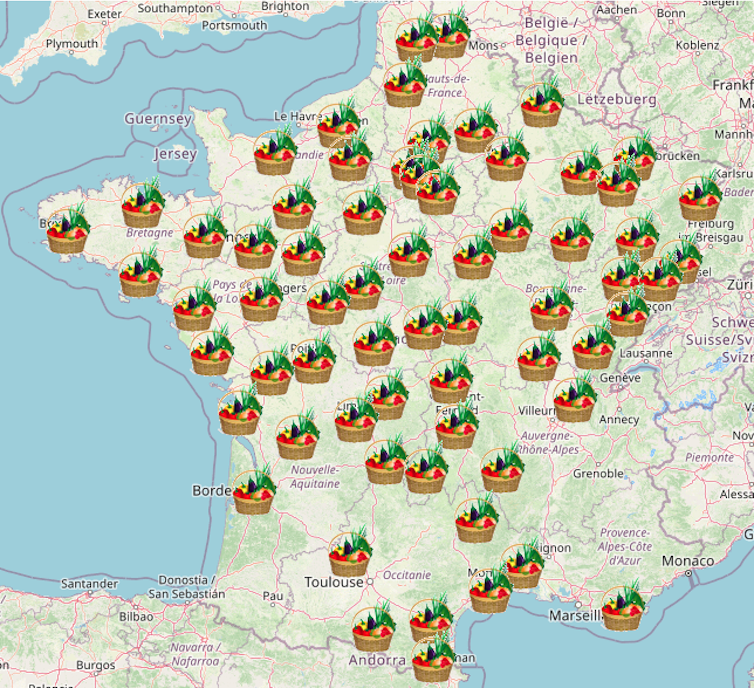

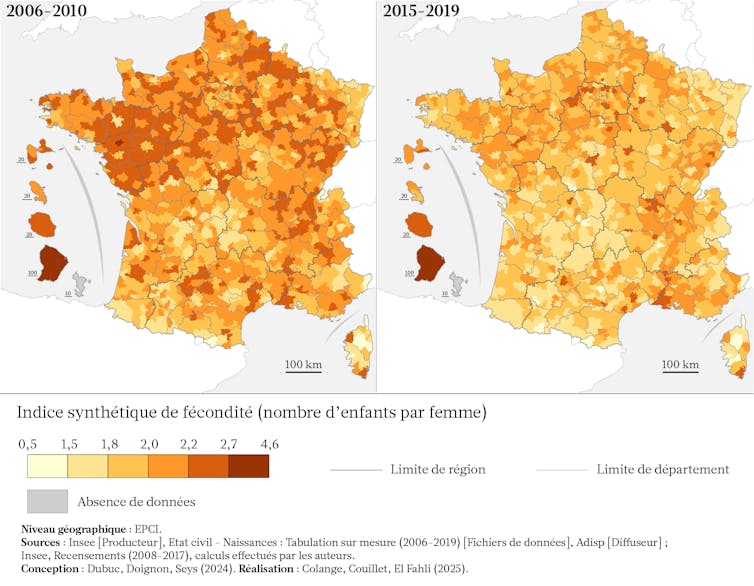

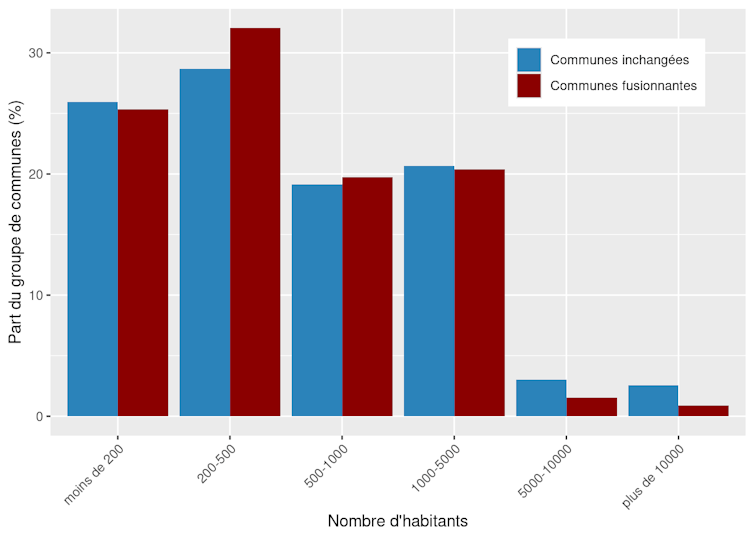

La fécondité en France (2006-2019)

Un « croissant fertile » au nord se caractérisait par une fécondité historiquement plus élevée que celle du Sud, encore perceptible en 2010. Cette singularité tenait à la structure sociale et culturelle de la population : majoritairement issue des classes populaires et ouvrières, plus fortement marquée par le catholicisme et des valeurs traditionnelles, dans un Nord alors très industrialisé.

Mais ces quinze dernières années, le croissant fertile tend à s’effacer, avec une baisse de la fécondité sur l’ensemble du territoire. Seules des poches de plus forte de fécondité relative persistent, d’une part, à l’est de la Bretagne et dans les Pays de la Loire, où perdurent des normes familiales plus traditionnelles, et, d’autre part, dans la périphérie francilienne et la vallée du Rhône, espaces marqués par une plus forte présence des classes populaires.

Certaines régions de fécondité traditionnellement forte, comme le Nord, le Pas-de-Calais et la Lorraine, ont un recul marqué des familles nombreuses et désormais une fécondité comparable à la moyenne nationale. Cela pourrait s’expliquer par un recul des valeurs traditionnelles de la famille, mais surtout par le déclin industriel et l’incertitude économique (chômage, précarité), qui sont des facteurs documentés de réduction de la fécondité ces quinze dernières années (en France et ailleurs en Europe).

Enfin, le vieillissement des mères à la maternité est généralisé, même s’il est plus marqué dans le sud de la France et les métropoles.

Le désir d’enfants baisse

Le désir d’enfant renvoie à deux notions distinctes. Le nombre d’enfants souhaités est la réponse à la question de savoir combien les personnes souhaitent avoir d’enfants. Traditionnellement, les femmes expriment un désir d’enfants légèrement supérieur à celui des hommes. Le désir d’enfants réalisé est complémentaire (il s’agit de la DF).

En les comparant, le nombre d’enfants souhaité est toujours supérieur au désir d’enfants réalisé, car une partie des femmes a moins d’enfants que souhaité pour des raisons diverses : infertilité, rupture d’union, difficultés économiques. Ces contraintes (économiques, sociales, biologiques) limitent la capacité des individus à concrétiser leurs intentions reproductives et participe à l’abaissement de la fécondité.

Le désir d’enfant a changé de dimension. Aujourd’hui, les couples stables souhaitent généralement avoir un ou deux enfants. Il y a vingt-cinq ans, c’était plutôt deux ou trois. Le refus d’avoir des enfants a progressé mais il est encore marginal, passant de 5 à 12 %.

Quelques hypothèses

Cette baisse du désir d’enfants est nouvelle en France et on peut émettre quelques hypothèses, impactant conjointement le désir d’enfants et sa réalisation, en plus des facteurs démographiques.

Tout d’abord, si l’élévation du niveau d’éducation et l’essor de l’activité professionnelle féminine ont fortement contribué à la baisse de la fécondité à la fin du XXᵉ siècle, cet effet semble aujourd’hui largement épuisé. La massification de l’enseignement supérieur et l’ancrage durable du travail féminin constituent désormais un cadre stabilisé, qui ne permet plus, à lui seul, de rendre compte du recul récent de la fécondité.

La crainte de l’avenir semble être la raison primordiale. Le contexte économique difficile s’associe à une baisse de la fécondité, comme l’ont montré les études en Europe, par exemple avec la crise de 2008. Dans toutes les enquêtes, les jeunes adultes expriment leurs angoisses face au changement climatique, au contexte géopolitique, à l’incertitude économique et sociale. La crise climatique joue probablement, mais à la marge. D’ailleurs, le refus d’enfants est encore très minoritaire. Dans le détail, c’est plutôt un comportement des jeunes des grandes villes, ayant fait des études supérieures, pour lesquels ne pas avoir d’enfant serait un geste « écologique ».

Si l’évolution des représentations de la famille et des changements normatifs participent à ce mouvement de baisse de la fécondité chez les jeunes femmes, on peut aussi y voir des difficultés accrues à trouver un équilibre entre famille et travail dans un contexte de précarisation de l’emploi. En effet, l’emploi et ses modalités jouent probablement un rôle. Si le chômage a baissé en France depuis une petite dizaine d’années, la nature des emplois a changé. Le premier emploi stable arrive souvent après plusieurs contrats précaires, donc plus tard.

Le logement joue également un rôle. La France ne propose pas suffisamment de logements par rapport à la croissance du nombre de ménages. Cela induit une augmentation forte des prix à la location et à l’achat, et une pénurie de logements disponibles, en particulier dans les grandes villes. Beaucoup de jeunes actifs vivent encore dans le ménage parental ou en colocation.

Quel avenir pour la fécondité en France ?

Ces facteurs pourraient accroître l’écart entre nombre d’enfants idéal et réalisé. On peut penser que les risques évoqués sont désormais perçus comme des contraintes de long terme pour les jeunes générations. Une fois intériorisées, elles sont désormais suffisamment fortes pour changer les normes et représentations de la famille, qui influencent le désir d’enfant lui-même.

La France est probablement à un tournant démographique, amorcé il y a une dizaine d’années : l’accroissement naturel est devenu un déficit. La baisse du désir d’enfants chez les jeunes générations nous dit clairement que cela devrait être une tendance durable.

Jusqu’à la fin de la décennie, on peut s’attendre à un indicateur conjoncturel de fécondité probablement inférieur à 1,7. Il ne devrait cependant pas baisser en dessous de 1,3, le désir d’enfants étant encore présent. Cela signifie que le déficit naturel s’installera probablement dans la durée. En ce sens, la France est devenue un pays européen comme les autres puisque c’est le cas dans la presque totalité des pays de l’Union européenne.

Sylvie Dubuc a reçu des financements du LABoratoire d’EXcellence iPOPs

Francois-Olivier Seys et Sébastien Oliveau ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

20.02.2026 à 16:43

Rutabaga, topinambour : ce que le retour des légumes « oubliés » dit de notre rapport à l’alimentation

Texte intégral (2357 mots)

Le goût n’est pas qu’une affaire de papilles gustatives. Certains légumes peuvent ainsi avoir celui de la guerre et de la privation. C’est le cas de divers légumes racines, comme les topinambours ou les rutabagas, associés à des traumatismes historiques. Aujourd’hui cependant, ils ont le vent en poupe et sont parfois considérés comme des trésors cachés que l’on redécouvre ou bien comme des « légumes authentiques ». Comment ce changement a-t-il pu s’opérer en quelques décennies quand les saveurs de ces légumes n’ont, elles, bien sûr pas changé ?

On les disait tristes, fades ou dépassés, les topinambours, rutabagas, panais ou crosnes font leur retour sur les étals, dans les paniers bio et sur les menus gastronomiques. Associés aux souvenirs de guerre et de pénurie, ils questionnent notre apport à l’alimentation. Comment des légumes associés à la contrainte alimentaire sont-ils devenus emblèmes d’une cuisine désirable et responsable ?

Des légumes longtemps méprisés par l’élite

L’histoire des légumes varie selon les périodes : longtemps méprisés par l’élite jusqu’à la Renaissance, certains ont alors connu un engouement, lié au changement de statut social des légumes, à la transgression des prescriptions médicales, à l’influence italienne et à l’acclimatation de produits venus d’Espagne.

Historiquement, ces légumes constituaient une base ordinaire de l’alimentation européenne du début du Moyen Âge à l’époque moderne. Leur robustesse, leur capacité de conservation en faisaient des ressources fiables face aux aléas climatiques et aux pénuries. Cultivés sous terre, ils assuraient la sécurité alimentaire, notamment lors des crises frumentaires (XIVᵉ-XVIIᵉ siècles) et en période de conflit. Cette centralité s’érode à partir du XVIIIᵉ siècle, avec la rationalisation agricole et l’essor de cultures plus productives et standardisées, comme la pomme de terre qui s’impose durablement au XIXᵉ siècle.

Des légumes marqués par la pénurie et la honte alimentaire

Les guerres du XXᵉ siècle accentuent leur marginalisation. Moins stratégiques que la pomme de terre et les céréales, ces légumes échappent davantage aux prélèvements et aux destructions. Indissociables de la Seconde Guerre mondiale, cultivés massivement pour pallier l’absence des denrées confisquées, ils deviennent des aliments de survie, durablement associés, dans la mémoire collective, à la contrainte, la monotonie et la privation plutôt qu’au plaisir alimentaire.

Après la Libération, leur rejet est brutal. Manger du rutabaga rappelle un passé de privation que l’on souhaite effacer. L’industrialisation agricole et la standardisation des goûts les relèguent hors des pratiques alimentaires ordinaires.

Ce n’est pas un phénomène isolé. Le sociologue Claude Fischler montre que l’alimentation est un puissant vecteur de mémoire sociale. S’il n’analyse pas directement les légumes racines, ses travaux sur l’alimentation, notamment sur les crises de la vache folle ou des organismes génétiquement modifiés (OGM), permettent de comprendre comment certains aliments, associés à des expériences historiques de contrainte, de pénurie, se trouvent durablement chargés d’une valeur mémorielle négative.

Le sociologue Erving Goffman, évoque lui à cet égard, des aliments « disqualifiés » : leur consommation signale une contrainte plutôt qu’un goût rappelant une identité alimentaire associée à la privation.

Hiérarchies alimentaires et distinctions sociales

Le déclassement des légumes racines s’inscrit également dans une hiérarchisation symbolique. Certains légumes sont perçus comme rustiques ou pauvres tandis que d’autres – asperges, artichauts, tomates – sont « nobles », valorisés par leur rareté, leur mode de culture et leur association historique aux cuisines urbaines ou aristocratiques. La valeur gustative se confond ainsi avec la valeur sociale, selon Pierre Bourdieu.