Le blog de Christophe MASUTTI

(H)ac(k)tiviste, Chercheur associé à l'UMR 7363 SAGE (Sociétés, Acteurs, Gouvernement en Europe - Université de Strasbourg ), administrateur de FramasoftPublications

Publié le 18.08.2025 à 02:00

La prétendue « neutralité technologique » est un écran de fumée politique au service d’un discours néolibéral. Face à cela, il ne s’agit pas de rejeter la technologie en bloc, mais de l’aborder selon plusieurs perspectives qu’il faut sans cesse renouveler. Si la technique reconfigure toujours nos rapports sociaux, la bonne approche qui s’impose consiste à résister aux systèmes de pouvoir et de continuer à débattre.

(Billet publié sur le Framablog le 14/08/2025)

Table des matières

L’arrivée des IA génératives dans le grand public permet d’observer la manière dont s’enchaînent les discours sur les techniques dans la société. Ils s’enchaînent, dis-je, car ils ne naissent pas. Ils se répètent. Et pourtant depuis Marc Bloch et Lucien Febvre, les universitaires ont fait du chemin pour dresser les méthodes et concepts de l’histoire des techniques. À leur tour, l’anthropologie et la sociologie ont spécialisé des branches disciplinaires sur les techniques. Et je pense que depuis les années 1970 il n’y a pas eu un instant où le rapport entre technique et société n’a pas été interrogé. Cela tient sans doute au fait qu’avec les Trente Glorieuses et l’informatisation de la société, les occasions d’identifier de multiples objets d’étude n’ont cessé de se multiplier. Et malgré tout cela, rien n’y semble faire. Une émission de radio (service public) sur l’arrivée des IA génératives (IAg) dans nos usages quotidiens ? elle se terminera invariablement sur le poncif relativiste du « c’est ni bon ni mauvais, tout dépend de comment on s’en sert ».

Je me suis toujours demandé d’où pouvait bien provenir cet indécrottable relativisme qui brouille nos rapports sociaux. Peut-être faut-il en chercher la cause dans le fait qu’on on apprend très tôt que faire usage d’un argument, c’est déjà presque commettre un abus. Dans nos démocraties libérales où, souvent, les égaux sont seulement supposés, parler haut et clair revient à menacer l’autre de le faire apparaître confus — donc à l’opprimer. À moins d’être couvert par le statut d’autorité institutionnelle, ou d’exercer la raison du genre dominant, et donc effectivement exercer un pouvoir, mieux vaut donc se taire ou douter, et retourner bosser. Résultat : une société intellectuellement désarmée, éduquée à la déférence molle au service des « gagnants ».

Alors parlons fort, à défaut parfois d’être clair : ce relativisme est le terreau idéal pour une absorption efficace des discours politiques qui instrumentalisent les idées vaseuses de progrès et de neutralité des techniques. De là vient le pouvoir non des techniques elles-mêmes mais de ceux qui les instrumentalisent. Le débat sur la neutralité des techniques vise deux objectifs : d’une part soutenir la vision instrumentale des groupes d’intérêts économiques, en vue de nous faire croire qu’il faut s’adapter à leur monde, et d’autre part un détournement du cadre de nos libertés qui limite les techniques à leur contrôle hiérarchique. Un autre objectif dont nous ne parlerons qu’à la marge dans ce billet est celui des groupes complotistes : ils concernent des pratiques de déstabilisation politique en vue d’intérêts économiques, mais les étudier revient à partir sur d’autres considérations que celles développées ici.

Ce billet est expérimental. Je vais tâcher d’aligner quelques arguments à partir d’une analyse du relativisme technologique et de son instrumentalisation politique. Je déconstruirai ensuite le mythe de la neutralité de la technique en explorant différentes perspectives entre Marx et Langdon Winner, en envisageant plusieurs postures. Enfin, je tâcherai de trouver une porte de sortie vers une décentralisation des techniques.

Le symptôme idéologique

Il faut l’affirmer ici avec, peut-être, une certaine condescendance envers ceux qui se torturent les méninges à ce sujet : la technique n’est pas neutre, et nous le savons depuis très longtemps que ce soit d’un point de vue purement intuitif ou d’un point de vue épistémologique ou philosophique. Il faut être sérieux sur ce point. La question formulée « La technique est-elle neutre ? » est un artifice dissertatif visant à poser un cadre conceptuel sur le rapport entre technique et société. Et c’est d’ailleurs ce que nous allons faire ici.

Si je précise cela, c’est parce les discours politiques sur la neutralité technologique sont souvent caricaturés : on les réduit à des prises de position légères, comme s’ils ignoraient ou négligeaient les responsabilités liées aux impacts sociaux des techniques. Nous avons nous mêmes pratiqué cet artifice sur le Framablog, par souci de concision (et aussi à cause d’un esprit quelque peu revanchard, mais justifié) lorsque nous avons parlé des mots de la ministre de l’Éducation Najat Vallaud-Belkacem à l’époque de la signature d’un partenariat avec Microsoft. Mais caricaturer amène parfois à ignorer naïvement combien la posture en question est en réalité retorse et malsaine. Les responsabilités ne sont ni négligées ni ignorées, elles sont évacuées par la trame néolibérale à laquelle adhèrent les acteurs politiques. C’est d’autant plus grave.

Il s’agit bien ici de technologie et non de technique. La technique, c’est le savoir-faire, le métier, l’outil, le dispositif. La technologie est un mot plus récent, il décrit l’ensemble du système qui va des connaissances à la mise en oeuvre technicienne. Pour faire vite, le clavier est un objet technique, la frappe est une technique, là où il y a une foule de technologies qui font qu’Internet existe. Dans le monde de la décision publique, ce qu’on appelle les politiques technologiques sont les décisions stratégiques (négociations, lois, contrats et accords) qui sont censées donner les orientations technologiques d’un pays.

Dans ce contexte, la plupart des discours politiques, et même des lois promulguées par les élus, postulent une « neutralité technologique » des institutions, des fonctions représentatives, ou plus généralement des organes de l’État. Pour donner un exemple récent, on peut citer l’examen au Sénat Français de la proposition de loi Programmation et simplification dans le secteur économique de l’énergie, dans la séance du 8 juillet 2025. Un amendement (num. 19 rectifié bis) portait sur l’ajout de la mention « neutralité technologique » en complément à la question de la maîtrise des coût. Le rapporteur arguait sur le fond que « la neutralité technologique est un bon principe en matière de politique énergétique, dans la mesure où il permet de ne pas opposer les différentes énergies décarbonées entre elles – il ne faut surtout pas le faire ! –, qu’elles soient d’origine nucléaire ou renouvelables ». L’amendement fut adopté.

Ce principe de « neutralité technologique » se retrouve à de multiples échelons des politiques internationales. Ainsi, les politiques européennes prônent depuis longtemps ce principe au risque parfois de quelques pirouettes rhétoriques. Par exemple au lieu de persister à affirmer que l’objectif consiste à ne plus vendre de voitures thermiques en 2035, la Commission Européenne invoque le principe de neutralité technologique : l’objectif est que les voitures n’émettent plus de CO2, mais comme la Commission est « neutre technologiquement », elle n’imposerait rien d’autre et encore moins les voitures électriques, or il se trouve que les voitures thermiques émettent du CO2…

Qu’il s’agisse de la Commission Européenne ou de ce débat au Sénat Français, ils révèlent tous deux la manière dont le pouvoir de l’État est pensé, c’est-à-dire une tartufferie néolibérale qui impose d’un côté un contrôle effectif à l’encontre de tout favoritisme pour une technologie dont seules certaines entreprises pourraient se prévaloir d’un monopole ou d’une hégémonie, et d’un autre côté une logique de diminution de l’autorité publique sur les équilibres en jeu entre technologie, société et environnement. C’est à la société de se réguler toute seule, « yaka proposer » (pour reprendre les termes de Najat Vallaud-Belkacem). C’est évidemment faire fi de toutes les questions liées à la propriété des techniques (la propriété intellectuelle, entre autre), aux pouvoirs financiers qui fixent les prix et imposent à la société des modèles la plupart du temps insupportables (pour les humains comme la planète en général).

Au sommet de cette tartufferie, on retrouve notre cher président E. Macron affirmant en novembre 2024 :

« Et moi, je me fiche de savoir que l’électron qui m’aide à faire l’électrolyse pour produire de l’hydrogène vert soit un électron qui est fait à base d’éoliens offshore au Danemark, de solaire en Espagne ou de nucléaire en France. Ce que je veux, c’est que ce soit de l’hydrogène européenne compétitive décarbonée. »

Pourvu que ce soit compétitif et que cela satisfasse les accords Européens, la messe est dite. Et pour les conséquences, on repassera.

L’injonction néolibérale

C’est pas sans arrière-pensée que j’aborde le sujet de la neutralité technologique par le prisme des postures politiques. Habituellement, on s’interroge sur la manière dont le politique s’empare de la question après avoir analysé le cadre. Or, comme je l’ai dit, nous avons déjà la réponse : la technique n’est pas neutre, on le sait depuis Platon (cf. Le Gorgias). Ce qui est étonnant en revanche, c’est de voir comment le principe de neutralité technologique est en fait un instrument de régulation (ou de non-régulation, justement). C’est ce qui fait par exemple que la souveraineté numérique d’un pays Européen est un objectif géostratégique rendu impossible à cause de l’entrisme permanent des géants multinationaux comme Microsoft qui, au nom de cette neutralité technologique des institutions, ont réussi à imposer leurs systèmes techniques au détriment de solutions alternatives qui ne sont justement pas choisies par la décision publique, toujours au nom de cette neutralité.

C’est là que se fait la jonction. La neutralité technologique des institutions est elle-même un instrument (un sophisme dirait Socrate à Gorgias) car elle trouve sa justification sur deux plans. Le premier : laisser le marché déterminer les coûts tout en garantissant les équilibres concurrentiels sans que les enjeux sociétaux (les externalités négatives) viennent susciter un contrôle intempestif (i.e. : vous pouvez chopper des cancers, les exportations agricoles sont plus importantes que votre santé). Le second : si c’est à la société de s’auto-équilibrer en composant avec l’état du marché qui est lui-même une émanation de la société (vision simpliste du monde entrepreneurial), c’est à elle de proposer des alternatives technologiques et par conséquent toutes les techniques sont en soi neutres puisque c’est la manière dont elles sont employées qui a des conséquences, pas la manière dont elles se répartissent sur le marché.

Pour les institutions dans un monde capitaliste, il importe donc, devant toutes les innovations, de s’interroger sur leurs rentabilités et leur viabilité sur le marché avant que de s’interroger sur les valeurs que leur accorde la société. Si on voit bien que le néolibéralisme n’y accorde aucune importance, c’est justement parce que pour une telle politique, la neutralité de la technique n’est pas un sujet. Le sujet, c’est la libéralisation du marché. On considérera donc qu’une bonne politique sociale, obligée de naviguer dans ce même cadre néolibéral, aura tout intérêt à se soucier de ces valeurs, de la manière dont les technologies sont reçues et incorporées dans la société, afin que les institutions puissent apporter des réponses, des recours (i.e. soigner les cancéreux atteints par la pollution agricole, par exemple). Or, dans la mesure où, comme nous l’avons vu, une politique technologique ne peut ni ne doit favoriser qui que ce soit (par exemple favoriser des entreprises de logiciels libres ou open source au détriment de Microsoft au nom de la concurrence), elle ne peut pas émettre d’avis en faveur d’une technologie ou d’une autre, sauf si cela entre dans une stratégie économique donnée (une orientation générale industrielle, par exemple). Et si une bonne politique sociale ne peut pas changer les institutions du néolibéralisme, elle ne peut que se réfugier derrière la neutralité de la technique et émettre une bonne vieille réponse de normand : c’est à la société de voir comment réceptionner les techniques, pas au politique d’imposer un cadre qui relèverait de la société et non du marché.

Et c’est pourquoi on retrouve un Mitterrand expliquant tranquillement en novembre 1981 que la technique est neutre, que les innovations techniques s’imposent à nous et que c’est une question de maîtrise et de volonté que de faire en sorte qu’on puisse s’en arranger : en somme, il faut s’adapter (maîtriser les techniques, les introduire intelligemment…) :

« (… L') informatique, parmi d’autres innovations majeures, aujourd’hui, est, me semble-t-il, capable de démultiplier considérablement les moyens de créer et de travailler de chacun. Cela certes, si elle était mal maîtrisée, si elle ne s’inscrivait pas dans un projet d’ensemble, l’informatique pourrait n’être, comme tant d’autres sciences et techniques, qu’une agression supplémentaire des individus, la source d’une aggravation de l’insécurité et du chômage, des inégalités, des oppressions. Elle pourrait conduire à une solitude croissante de l’homme, abandonné à un face à face tragique avec des objets de plus en plus sophistiqués, de plus en plus capables de raisonner et de communiquer entre eux. Mais, au contraire, si elle est introduite intelligemment, dans le contexte d’un projet global de société, elle pourra transformer la nature du travail, créer des emplois, favoriser la décentralisation, la démocratisation des institutions, donner au commerce, au travail de bureau, à la poste, à la banque, aux entreprises petites et moyennes, des outils efficaces pour se développer. Enfin, et peut-être et surtout, elle apportera à la santé des hommes, à leur formation, à leur culture des moyens sans comparaison avec ceux dont ils disposent maintenant pour s’exprimer, leur permettant de multiplier, à un échelon considérable, leurs moyens d’apprendre, de créer et de communiquer. »

C’est ce genre de réflexion qui eut des conséquences tout à fait concrètes dans la société française. Par exemple : le plan Informatique Pour Tous lancé en 1985. Avant de devenir l’échec que l’on connaît, il eu un intérêt certain pour les élèves (dont moi) qui en ont bénéficié et qui ont pu se frotter à l’informatique et à la programmation très tôt. Mais, au fond, ce Plan ne disait pas autre chose que c’est à chacun de s’adapter à l’informatisation de la société, une « Révolution » qui n’est autre que la révolution des entreprises qui se lançaient toutes dans la grande aventure de l’optimisation de la production grâce à l’économie des données informatiques (c’est ce que j’ai montré dans mon bouquin). Message reçu par les enfants : l’informatique change le monde, si vous ne vous y mettez pas, c’est le chômage qui vous guette. Injonction néolibérale par excellence.

Le néolibéralisme a mit un demi-siècle pour imposer au monde ses principes. Alors que le libéralisme pensait à un « homme économique », le néolibéralisme pense l’homme en situation de concurrence permanente, c’est un humain « entrepreneur de lui-même », un mélange de volontarisme individuel et d’abdication des valeurs collectives et de commun. M. Foucault l’analysait ainsi dès 1979 : « Il s’agit de démultiplier le modèle économique, le modèle offre et demande, le modèle investissement-coût-profit, pour en faire un modèle des rapports sociaux, un modèle de l’existence même, une forme de rapport de l’individu à lui-même, au temps, à son entourage, à l’avenir, au groupe, à la famille. » (Foucault 2004, p. 247)

Dans nos subjectivités à tout instant l’injonction néolibérale résonne. C’est l’objet du livre de Barbara Stiegler (Stiegler 2019) qui résume la conception de Walter Lippmann, selon laquelle l’homme est incapable de s’adapter par nature à un état du monde qui s’impose et ne négocie pas (l’état économique industriel et productiviste du monde) et que c’est à l’État d’impulser la transformation de l’humain par l’éducation ou l’hygiénisme. Il en résulte cette injonction permanente, soit par des techniques comme le nudge et le jeu de l’influence-surveillance des individus, soit par l’autorité parfois brutale qui nous soumet aux dogmes néolibéraux.

Pour le discours politique de la « neutralité technologique », les innovations sont inéluctables, peu importe qui les produit et pourquoi. Que les plateformes aient créé un capitalisme de surveillance qui produit de la haute rentabilité sur la marchandisation de nos intimités numériques est un sujet qui n’est finalement pas interrogé par la décision publique sauf sur un mode réactif après moult plaidoyers et recours juridiques. Il faut s’y faire, c’est tout, parce que c’est ainsi que fonctionne l’économie numérique. On ira faire des courbettes à Zuckerberg et Musk pour leur demander de bien vouloir respecter le RGPD et verser quelques miettes pour toute indemnité.

C’est ce qui défini le « progrès technologique » : dans le cadre néolibéral, l’émergence des innovations et leur rôle dans la sphère économique sont conçus par le politique, de droite comme de gauche, comme une logique de marché à laquelle la société doit s’adapter. En matière d’économie numérique, par exemple, on sort de l’équation toute idée d’autogouvernance (pour ne pas dire autogestion) des outils numériques, ainsi que toute possibilité de réflexion collective qui irait à l’encontre des logiques de marché au profit des valeurs de justice ou de bien-être portées dans la société.

Dans un livre co-écrit par l’ex-syndicaliste (viré bien à droite dans ses vieux jours) Jacques Juillard et le philosophe Jean-Claude Michéa, les deux auteurs s’échangent des lettres (Michéa, Julliard 2018). Pour le premier, « Le progrès technique est axiologiquement neutre, (…) et le mauvais usage qui en a été fait par le capitalisme sous sa forme sauvage et prédatrice ne le condamne pas ». Dans sa lettre-réponse, le second lui rétorque, à raison, de prendre en compte niveau de complexité d’un système technique et d’interroger l'« usage émancipateur et humainement positif » des innovations. J.-C. Michéa souligne : « Or à partir du moment où l’accumulation du capital (…) ne repose pas sur la production de valeurs d’usage mais uniquement sur celle de valeurs d’échange (…), il est inévitable que le système libéral en vienne peu à peu à soumettre le pouvoir d’inventer lui-même au seuls impératifs de la rentabilité à tout prix. »

Se demander si les techniques sont émancipatrices et en faire un principe d’action et de décision, c’est éclater le carcan néolibéral dans lequel le politique s’est fourvoyé depuis tant d’années.

Un contrôle autoritaire

Mais il y a d’autres choix. Avant d’engager plus loin la réflexion, arrêtons-nous un instant sur les libertariens comme Peter Thiel (on se pincera le nez). Si nous nous interrogeons sur les « usages émancipateurs » des techniques, c’est que la conjoncture actuelle n’y est pas favorable. Une autre solution pourrait donc, comme le fait P. Thiel, consister à comparer les périodes et regretter que le rythme des innovations et de leur imprégnations dans la société soit fortement ralenti ces dernières années (Thiel 2025).

Une analyse économique pourrait nous montrer qu’il en va ainsi des cycles des innovations. Par exemple l’informatisation de la société a atteint un point d’inflexion, un ralentissement de croissance, une phase asymptotique où, bien que des nouveautés apparaissent, leur diffusion ne joue pas un grand rôle dans l’économie globale. Par exemple l’arrivée des IA génératives fait certes beaucoup parler, mais les équilibres économiques ne changent guère si ce n’est du point de vue des valeurs spéculatives (les « gros » restent les mêmes) créant une bulle technologique en manque de rentabilité. En pratique, si de nouveaux usages apparaissent, on est encore loin du bouleversement structurel de l’informatique d’entreprise des années 1970 ou de l’arrivée d’Internet dans les foyers. N’ayant pas de boule de cristal, je suppose qu’il est possible qu’un renversement se produise, néanmoins, pour l’instant, rien de semblable et on se préoccupe plutôt d’une économie de guerre, ce qui n’est pas plus réjouissant.

Or, P. Thiel propose un autre point de vue. Selon lui, si les techniques nous opposent des risques existentiels, comme la bombe atomique, nous avons tout fait pour ralentir leurs rythmes d’innovation, de création, et de changements sociaux. La raison plus profonde, c’est que les gouvernements au pouvoir on laissé (selon le cadre néolibéral) se développer des contraintes qui, aux yeux de P. Thiel, sont bien trop importantes pour que le « progrès » technique puisse se développer correctement et « augmenter » l’humanité. Les structures institutionnelles ont satisfait les revendications sociales et la politique fait bien trop appel à l’expertise scientifique, réputée contradictoire et laissant trop de place au doute. Telles seraient les causes de ce ralentissement. Il faudrait donc sortir de ce cadre, et effectuer des choix stratégiques qui accélèrent les techniques « bénéfiques » et contrôlent celles que l’on jugerait dangereuses. Reprenant les idées du philosophe transhumaniste Nick Bostrom, P. Thiel affirme que la solution pourrait consister en…

« un gouvernement mondial efficace, avec une police extrêmement efficace, pour empêcher le développement de technologies dangereuses et forcer les gens à ne pas avoir des opinions trop diverses — car c’est cette diversité qui pousserait certains scientifiques à pousser des technologies qu’ils ne devraient pas développer. »

En somme une dictature bienveillante en faveur du transhumanisme, qui ne prendrait pas en compte l’axiologie, trop complexe pour définir une unique ligne conductrice autoritaire. En d’autres termes, débarrassons-nous de la morale et de l’éthique qui ne font que nous embrouiller. Quant à savoir qui seront les dépositaires de l’autorité : ceux qui produisent ces techniques, bien entendu, et qui prennent l’engagement que l’humanité ne tombera pas dans la catastrophe qui nous attend si nous continuons à développer les techniques de manière erratique (Slobodian 2025 ; Prévost 2024).

On voit ici que ce monde sans démocratie que voudrait nous imposer ce type de libertarien remet assez radicalement en cause la prétendue « neutralité technologique » des institutions. Il affirme d’autant moins que la technique serait neutre. C’est au contraire une position assumée que de dire que, la technique n’étant pas neutre, il nous faut une structure de gouvernement capable de la contrôler tout en contrôlant les intérêts des novateurs. Nous reviendrons plus loin sur la question du contrôle car elle implique assez directement celle des conditions de nos libertés. Toujours est-il que cet exemple de P. Thiel montre que le plus important est de définir le cadre épistémique et axiologique dans lequel on se place pour parler de la prétendue neutralité des techniques et que, justement, c’est parce que nous remettons sans cesse en jeu cette problématique que nous faisons évoluer le rapport entre technique et société. C’est là tout l’intérêt de s’interroger sur cette neutralité (depuis Platon).

On ressort le vieux Marx

Le premier réflexe que nous pourrions avoir face à ce qui précède, consisterait à établir une opposition stricte entre les structures de domination du capitalisme, les possédants de l’outil de production, et les autres, travailleurs, utilisateurs. Les dispositifs techniques seraient des instruments d’aliénation et non d’émancipation. De là émerge une conception économique de la situation qui voit dans le développement des technologies un horizon de libération de la condition humaine à condition de se libérer de la domination capitaliste. C’est une vision du rapport social à la technique qui s’oriente vers une certaine idée de la neutralité de la technique en tant que simple instrument : dans les mains des capitalistes (ou des libertariens aujourd’hui) la technique est un instrument de domination.

Dans ce cas, le pivot est Marx et l’épouvantail serait le luddisme. En effet, une lecture un peu rapide de Marx ferait de notre ami à barbe grise l’un des tenants de la neutralité de la technique. Que nous dit-il, après avoir raconté quelques épisodes où, dans l’Angleterre des XVIIe et XVIIIe siècles, des ouvriers privés d’emploi à cause des innovations qui automatisaient une grande partie de leurs tâches finirent par y mettre le feu ?

« Il faut du temps et de l’expérience avant que l’ouvrier apprenne à distinguer la machinerie de son utilisation capitaliste, et donc à transférer ses attaques du moyen matériel de production lui-même, à la forme sociale d’exploitation de celui-ci. » – (Marx 1993, p. 481)

Partant d’un certain bon sens, ce n’est évidemment pas par un acte de destruction sans revendication claire qu’on gagne une cause… Rien ne nous dit non plus que ces ouvriers des siècles passés n’avaient pas de revendication autre que celle de retrouver leur emploi. Mais c’est aussi la thèse de Marx que de montrer que ces révoltes sont un préalable à un mouvement ouvrier de prise de conscience de sa propre classe (et pour certains historiens aussi, c’est un peu ce que montre E. P. Thompson, dans La formation de la classe ouvrière anglaise). Cependant, à partir de cette citation, on conclu généralement que selon Marx, les machines et plus généralement les techniques de production sont neutres, elles ne seraient que des instruments qui, dans certaines mains seraient des instruments de domination, dans d’autres, seraient des instruments de libération de classe.

En réalité, Marx adopte une approche articulée autour de deux aspects. Le premier consiste en une analyse des rapports sociaux, qu’il considère comme fondamentalement différents selon qu’il s’agit de l’usage d’un simple instrument ou de celui d’une machine, un dispositif technique élémentaire ou une technologie plus complexe : « Dans la manufacture et le métier, l’ouvrier se sert de son outil ; dans la fabrique il sert la machine » (Marx 1993, p. 474). C’est-à-dire que la machine non seulement inverse le rapport de l’ouvrier à l’outil de production (il sert la machine), mais en plus elle modifie la structure même du modèle économique de la production (l’atelier devient la fabrique). Sur un second aspect, Marx nous dit aussi : « Les rapports sociaux sont intimement liés aux forces productives. En acquérant de nouvelles forces productives, les hommes changent leur mode de production, et en changeant le mode de production, la manière de gagner leur vie, ils changent tous leurs rapports sociaux. Le moulin à bras vous donnera la société avec le suzerain ; le moulin à vapeur, la société avec le capitaliste industriel » (Marx 2019, chap. 2). Il y aurait donc un certain déterminisme technique qui influe sur les conditions historiques d’émergence du capitalisme et avec lui toute une culture technique. Si les conditions sociales changent avec le capitalisme, c’est parce que celui-ci procède d’un auto-engendrement : il modifie et « révolutionne » les structures (et le progrès technique est un facteur déterminant) pour pouvoir s’installer. L’innovation technique qui a lieu « dans » le capitalisme est capitaliste, elle est là pour satisfaire ses exigences de productivité et de rentabilité. Pire encore, pour Marx, le développement technologique du capital a pour conséquence (et réciproquement) que le gain de productivité doit s’accomplir dans une dynamique toujours plus rapide (par exemple éviter que le stockage ne soit un manque à gagner sur la vente des produits) ce qui impose une exigence de rentabilité où l’ouvrier est englouti par la machinerie et le capital devient son propre « sujet automate » (Marx 2011, pp. 652-653).

Comme je l’ai dit plus haut, nous savons que la technique n’est pas neutre, et il n’y a aucune raison pour que Marx puisse défendre un autre point de vue sur cette question précise. En revanche, Marx est aussi l’héritier d’une conception civilisationnelle du progrès technique, héritée des Lumières, même s’il s’en montre critique. Il reconnaît ainsi au capital une force destructive qui cesse d’être productive uniquement « lorsque le développement de ces forces productives elles-mêmes rencontre un obstacle, dans le capital lui-même » (Marx 2011, p. 286). Et c’est bien là le reproche qu’on pourrait lui faire, à savoir que la critique de la technique ne s’élabore qu’au regard du développement du capitalisme et dans l’attente d’une révolution prolétariennne, une attente d’où les luddites ne sont jamais sortis. En ce sens (et uniquement : n’allez pas me faire dire ce que je ne dis pas) la conception de Marx et celle de P. Thiel aujourd’hui se rejoignent sur un point : les tergiversations de la société quant à son aliénation par la technique ont tendance à péricliter. Pour l’un la sortie est une révolution de la base, pour l’autre c’est une révolution par le haut, dans les deux cas, un accaparement des techniques-moyen de production, soit par les prolétaires en créant un État autoritaire de transition (et on aura assez reproché, à raison, cette conception marxiste), soit par les bourgeois en créant un État autoritaire… pour toujours. L’enjeu est toujours le même : le contrôle du système technicien.

Technique moderne et déterminisme

Il faut donc changer de braquet. Le problème est le mode formel du capitalisme duquel il faut sortir en opposant une axiologie et un principe de vie. L’analyse économique seule ne peut pas nous aider davantage.

Si on pense la technique en termes instrumentariens, et que le capitalisme est le cadre auto-reproductif de notre rapport à la technologie, alors, que nous soyons conscients ou pas de nos classes sociales, nos rapports sociaux sont déterminés par la dynamique des innovations. Sortir de ce déterminisme suppose une révolution. Cependant, bien qu’assez longtemps après Marx, il a été largement démontré que l’électronicisation de la société, c’est-à-dire l’apparition des micro-conducteurs puis l’informatisation à tous les échelons du travail et du quotidien, impose dans nos vies la logique formelle du capitalisme. Le travail s’est de plus en plus taylorisé pour devenir un ensemble de traitements séquentiels (si le métier ne s’y prête pas, on aura tout de même des indicateurs de mesure, des systèmes d’évaluation pour rendre calculable ce qui ne l’est pas) et avec la surveillance, nos vies intimes ont intégré la sphère marchande grâce à l’extractivisme des plateformes et l’exploitation des données de profilage comportemental.

Cela implique un raisonnement plus ontologique. On peut le trouver chez Martin Heidegger qui, dans les années 1950, anticipait avec assez de clairvoyance le changement technique et proposait le terme d’arraisonnement pour décrire la manière dont, par la technique, se dévoile un mode où l’être n’est plus conçu que comme quelque chose d’exploitable (Heidegger 1958). Pour lui, la technique moderne n’est plus l’art, mais un rapport paradoxal. Elle résulte d’une volonté qui soumet l’homme à son propre destin technologique. Devenu lui-même un être technique, l’homme instrumentalise et « arraisonne » le monde, le réduisant à une simple ressource, incapable de le percevoir autrement. Par la suite, les Guy Debord ou Jacques Ellul ont en réalité cherché à montrer que l’homme pouvait encore échapper à ce destin funeste en prenant conscience ici de la prégnance de l’idéologie capitaliste et là d’une autonomie de la technique (hors de l’homme). Cependant, on ne peut s’empêcher de penser que l’extraction de données à partir de la vie privée comme à partir des performance individuelles dans le travail taylorisé est bien une forme d’arraisonnement poussé à l’extrême, sur l’homme lui même, désormais objet de la technique.

Le discours du déterminisme technologique qui implique que la société doit s’adapter à la technique prend une dimension tout à fait nouvelle dans le contexte de l’informatisation de la société. À travers l’histoire de la « Révolution Informatique », ce cauchemar heideggerien est né d’un discours aliénant, où l’ordinateur devient l’artefact central, et contre lequel la simple accusation d’aliénation technologique n’est plus suffisante pour se prémunir des dangers potentiels de cette désormais profonde acculturation informatique. Les combats pour la vie privée, loin d’être technophobes, sont autant de manifestations de l’inquiétude de l’homme à ne pouvoir se réapproprier la logique technicienne.

Dans ce contexte, voilà qu’arrive une autre idée encore de la neutralité de la technique : la technique ne serait que l’application de nos connaissances scientifiques. Elle n’aurait aucune sociologie propre (des gens comme B. Latour auraient travaillé pour rien). Cela implique des visions simplistes de « la » science et de « la » technique : la science nous dit le réel, la technique est l’application de la science, donc la technique est une nécessité par laquelle nous agissons sur le monde et le comprenons. Et comme la science ne serait que l’explication des chaînes de causalité du réel, alors la technique nous détermine comme une partie des chaînes causales (notre action sur le monde) : nous n’avons pas le choix, nous devons changer le monde ou nous y adapter ou nous mourrons (il faut bien nourrir nos datacenter avec de l’eau, tout est une question de choix). Si on s’en tient à ce formalisme, on rejoint ce que disait Detlef Hartmann (Hartmann 1981) à propos du capitalisme : le capitalisme nous rêve sur un mode formel (si… alors… et/ou). Pour reprendre les parenthèses de la phrase précédente, cela veut dire que nous devons croire en la technique : si nous avons besoin des datacenter pour vivre dans un monde numérisé qui nous apporte tout le confort nécessaire (!), alors nous avons besoin de beaucoup d’eau pour refroidir nos data center, quitte à pomper dans les nappes et priver les terres agricoles… mais pas d’inquiétude, tout se fera toujours à l’équilibre car nous savons ce que nous faisons, nous maîtrisons les techniques. On pourrait construire la même logique pour tout, l’essentiel serait de s’en remettre à ceux qui maîtrisent les techniques : ce n’est ni un choix politique ni un choix moral, c’est neutre, et nous y sommes poussés par la nécessité technique.

Si on ne pense qu’avec des machines et dans la mesure où tout ce qu’on donne à une machine et tout ce qu’on attend d’elle est une somme d’informations computables, le résultat sera uniquement un résultat quantitatif. D’un autre côté, ce qui est incomputable n’est pas pour autant non-déterminé. Pour s’en sortir, la théorie algorithmique de l’information (voir notamment les travaux de Kolmogorov) montre que la complexité d’un objet dépend de la taille de l’algorithme qui rend possible cet objet. Par exemple la sélection naturelle ne suppose pas une nécessité absolue de chaque forme (un déterminisme causal absolu), mais un jeu de contraintes. Ce jeu de contrainte peut être décrit de manière algorithmique mais cette description serait d’une longueur telle qu’elle relève d’un niveau de complexité inatteignable. Mais cela ne signifie pas qu’il ne sera jamais atteignable (ça, c’est pour les positivistes optimistes). Il y aurait donc du déterminisme partout, tout le temps ? Dans le déterminisme classique, l’action est expliquée comme l’effet d’une chaîne causale mécanique. L’homme agit parce qu’il y est poussé par des causes antérieures, comme une bille roule parce qu’on l’a poussée. Il y a cependant une autre manière de voir les choses : le déterminisme n’est pas une limitation de notre liberté ou de notre créativité, mais un ordre immanent au réel. Les sciences cherchent à découvrir ce déterminisme, ses causalités, mais on sait, contrairement à ce que soutenait Spinoza, que tout n’est pas déterminé (que dit la théorie quantique sur l’imprédictibilité ?). Pour autant, la spontanéité dans le processus créatif n’est pas une négation du déterminisme, mais un phénomène émergent dans un système trop complexe pour être calculé (à l’échelle macroscopique, quelles longueurs d’algorithmes faut-il pour décrire le monde ? l’arrivée des nouvelles IA aujourd’hui pourrait nous surprendre)1.

Une posture démiurgique considérerait que la liberté humaine influence le réel et son déterminisme immanent. C’est la posture de Peter Thiel : les sciences se contredisent trop et distillent trop de doutes, il nous faut une science uniforme dont la technique serait l’application pure, et cette conception performative de la connaissance (au besoin sous la coupe d’un pouvoir autoritaire) permettrait de redynamiser la croissance technicienne. Sauf qu’il y a des lois causales immanentes au réel, sur lesquelles la liberté humaine ne peut rien : les sciences explorent le réel mais ne l’engendrent pas. Cette impuissance est souvent vue comme une contrainte à laquelle nous devrions nous adapter (néolibéralisme) ou contre laquelle nous devrions lutter (libertariannisme néo-fascisant).

En fait, il y a au moins deux niveaux de nécessité : celle du réel et celle des valeurs. La nécessité axiologique selon laquelle nous exerçons notre liberté est celle qui répond, par exemple, aux exigences de justice. C’est une nécessité parce que ce n’est pas un monde d’où les causes sont absentes, au contraire, il s’agit d’un ensemble de causes que nous classons et arrangeons en fonction de leurs valeurs. Il n’y a pas d’un côté un déterminisme mécanique et de l’autre la contingence de nos sociétés, mais il y a le plan des valeurs. Et ce plan n’échappe pas pour autant à la connaissance scientifique (voir par exemple la longue introduction épistémologique de Bernard Lahire dans Les structures fondamentales des sociétés humaines). Nous n’agissons donc pas malgré le réel ou contre lui, mais dans un monde emprunt de causalités et à un autre niveau de nécessité. Soulignons en passant qu’une autre tendance radicale consiste à faire passer l’axiologique au rang de principe premier qui transcende toutes les causalités, je veux parler de la plaie de la religion qui amène invariablement à une lutte de pouvoir sur le contrôle des techniques et à empêcher tout rapport rationnel entre éthique et technique2. Je ne m’étendrai pas davantage sur le sujet, ce texte est déjà assez long.

Une approche non-réactionnaire

Dans d’autres textes, j’ai eu l’occasion de me rapporter à la pensée de Detlef Hartmann. Selon lui, dans le monde capitaliste, la technologie exerce une violence. Elle échoue à transformer en logique formelle ce qui échappe par essence au contrôle formel (l’intuition, le savoir-être, le pressentiment, etc.). Dès lors, d’après D. Hartmannn, l’application d’une logique formelle aux comportements est toujours une violence car elle vise à restreindre la liberté d’action, mais aussi l’imagination, la prise de conscience que d’autres possibilités sont envisageables. Pour moi, cette approche a au moins un avantage, celui de mettre fin à l’idée d’une « force » ou d’une « intelligence » technique qui produirait une conscience de classe qui se retournerait contre le capital. C’était la thèse de Rudolf Bahro qui cherchait une alternative concrète au communisme dont il critiquait l’appareillage (technique lui aussi) d’État écrasant. Il s’agissait de croire que l’intelligence technologique (le progrès, les sciences, l’éducation) pouvait permettre de se libérer des mécanismes de domination et permettre aux groupes (autogestionaires) de prendre le contrôle de tous les processus de décision. Or, l’autogestion appliquée à l’échelle d’un État, même si elle se compose de multiples autogestions locales, finit par devenir une sorte de mégamachine centralisée. En réalité, l’autogestion authentique est celle qui fédère les initiatives tout en offrant la plus grande diversité possible d’alternatives. En somme, c’est celle qui préserve et nourrit un imaginaire libre et foisonnant. C’est ce que D. Hartmannn appelle un principe vital, un principe qui échappe au contrôle formel du capital comme à tout pouvoir centralisé.

Même si D. Hartmann n’est pas un penseur anarchiste, il y a tout de même quelque chose d’intéressant là-dedans. Cependant, les anarchistes « classiques » sont bien souvent tombés dans le piège positiviste qui perçoit la technologie comme intrinsèquement positive. C’est vieux comme les écrits de Proudhon, bercés par le positivisme de Comte bien qu’il s’en montrait extrêmement critique du point de vue de sa sociologie dont il disait qu’elle ne faisait que substituer la sociabilité à l’individualisme et faisait disparaître le droit. Chez Proudhon, avec la critique de la division technique du travail, qui serait le reflet de la division sociale, il y a aussi l’opposition entre l’état de nature et l’état social, où l’homme est par la technique en perpétuelle recherche d’augmentation de sa puissance d’agir. Si Proudhon se montre critique vis-à-vis de la technique, c’est pourtant par l’apprentissage polytechnique que passe l’émancipation du travailleur. La pensée de Proudhon ne permet pas (pas encore) de penser le système technicien dans ce qu’il pourrait avoir d’aliénant en dehors de la productivité.

Cherchons encore. Un penseur comme Murray Bookchin a très tôt dans ses écrits considéré la technique comme un instrument de domination : c’est dans la mesure où la technique est assimilée à un instrument de production qu’elle est instrument de domination. Il ne peut alors y avoir de porte de sortie qu’à partir du moment où l’on prend en compte que cette domination représente en fait les deux faces d’une même pièce : l’extractivisme capitaliste sur l’homme et l’instrument qui déséquilibre et la société et la nature.

Il ne faut pas dénoncer à la légère l’attitude schizoïde du public à l’égard de la technologie, attitude qui associe la terreur et l’espoir. Elle exprime en effet instinctivement une vérité fondamentale : cette même technologie, qui pourrait libérer l’être humain dans une société organisée en vue de satisfaire ses besoins, ne peut que le détruire dans une société visant uniquement « la production pour la production ». Il est bien certain que l’ambivalence manichéenne imputée à la technologie n’est pas un trait de la technologie comme telle. La capacité de créer et celle de détruire que recèle la technologie moderne ne sont que les deux faces de la dialectique sociale, le reflet de la positivité et de la négativité de la société hiérarchique. S’il y a quelque vérité à soutenir, comme Marx, que la société hiérarchique fut « historiquement nécessaire » afin de « dominer » la nature, on ne doit pas oublier pour autant que cette notion de « domination de la nature » est elle-même issue de la domination de l’humain par l’humain. L’être humain et la nature ont toujours été associés en tant que victimes de la société hiérarchique. Que l’un comme l’autre soient aujourd’hui menacés d’un cataclysme écologique est la preuve que les instruments de production ont fini par devenir trop puissants pour servir d’instruments de domination. – (Bookchin 2016, p. 32)

Ce qui est important pour M. Bookchin, c’est le mode d’organisation sociale qui contrôle les moyens de production et plus largement la technique. L’émancipation s’appuie donc sur la technique. Pour autant, n’est-ce pas un point de vue trop idéaliste qui revient à promouvoir une croyance dans une « bonne » intelligence technique ? Car après tout, le problème est là : si nous rejetons la thèse de la neutralité de la technique, c’est parce qu’elle n’envisage à aucun moment la manière dont la technique reconfigure sans cesse les rapports entre les humains entre eux et avec leur environnement. Mais envisager une « bonne » intelligence technique contre une « mauvaise » revient à se précipiter tout aussi bien dans une impasse.

C’est le choix des anarcho-primitivistes, du moins ceux qui se réclament d’une posture aussi radicale que John Zerzan, par exemple. La lecture civilisationnelle qu’ils ont de la technique revient à la réduire à une question de besoin et d’adéquation comportementale. Avec une certaine lecture de l’anthropologie, on peut effectivement prétendre assimiler le « progrès » technique à un productivisme aliénant et redéfinir l’abondance comme une simple adéquation à des besoins limités, plus ou moins fantasmée à partir de ce que l’on sait effectivement des sociétés de chasseurs-cueilleur d’autrefois (et l’archéologie récente a fait des découvertes qui remettent largement en cause ces conceptions certes utopistes mais faussées). S’opposer à cela ne réduit pas à savoir si on veut revenir à l’âge de pierre ou à la bougie. Ce serait réduire le débat. Il s’agit de savoir ce qui distingue le radicalisme d’une posture purement réactionnaire qui revient finalement à faire de la technique une émanation en soi négative sans en considérer les conditions d’existence mais en vouant une haine à des pseudo-représentants du monde économique ou politique. Une chasse aux sorcières dont le but est avant tout moral que réellement constructif. On retrouve aujourd’hui même des résurgences de ce type dans des globiboulgas malfaisants comme le montrait récemment le groupe Technopolice.

Le refus catégorique d’une ou plusieurs technologies représente une impasse conceptuelle et pratique, car toute technique s’inscrit dans un processus cumulatif d’innovations successives et dans un réseau de systèmes techniques dont certains point de convergence peuvent être fort éloignés les uns des autres. Prenez par exemple la physique nucléaire et la médecine et voyez-en le développement en ingénierie d’imagerie ou de génétique. L’histoire des sciences et des techniques montre que les avancées techniques ne sont jamais isolées, mais s’insèrent dans des chaînes complexes de savoirs et d’applications. Par exemple, l’intelligence artificielle regroupe un ensemble très diversifié de technologies — apprentissage automatique, réseaux neuronaux, traitement du langage naturel — qui interagissent et évoluent continuellement depuis… 50 ans. Ainsi, un rejet global de l’IA comme phénomène homogène est conceptuellement inexact et socialement problématique.

La solution n’est pas dans le rejet mais dans le questionnement. Plus haut, je faisais référence au machinisme. On peut se demander effectivement comment l’introduction de l’automatisation dans la fabrique redéfini le rapport de l’ouvrier au travail et en conclure une dépossession, une prolétarisation. Mais en augmentant la productivité, l’automatisation — par exemple la robotique — redéfini assez radicalement ce qu’est le travail en soi. Sur ce point, dans La baleine et le réacteur, Langdon Winner a proposé l’idée de « somnambulisme technologique » pour décrire comment les sociétés adoptent de vastes transformations technologiques sans en examiner les implications profondes3. L. Winner argumente que le développement technologique est un processus de construction du monde, où en modifiant les choses matérielles, nous nous changeons nous-mêmes. La question centrale n’est pas seulement « comment les choses fonctionnent », mais « quel genre de monde sommes-nous en train de créer ? » Les technologies ne sont pas de simples aides, mais de puissantes forces qui remodèlent l’activité humaine et sa signification. Elles structurent notre quotidien, créant de nouvelles « formes de vie ».

À mesure que les technologies sont développées et mises en œuvre, des changements importants dans les modes d’activité humaine et les institutions humaines sont déjà en cours. De nouveaux mondes sont en train de voir le jour. Ce phénomène n’a rien de « secondaire ». Il s’agit en fait de la réalisation la plus importante de toute nouvelle technologie. La construction d’un système technique qui implique les êtres humains comme éléments opérationnels entraîne une reconstruction des rôles et des relations sociales. Cela résulte souvent des exigences de fonctionnement du nouveau système : celui-ci ne peut tout simplement pas fonctionner si le comportement humain ne s’adapte pas à sa forme et à son processus. Ainsi, le simple fait d’utiliser les machines, les techniques et les systèmes à notre disposition génère des modèles d’activités et des attentes qui deviennent rapidement une « seconde nature ». Nous « utilisons » effectivement les téléphones, les automobiles, l’éclairage électrique et les ordinateurs au sens conventionnel du terme, c’est-à-dire en les prenant et en les reposant. Mais notre monde devient rapidement un monde dans lequel la téléphonie, l’automobilité, l’éclairage électrique et l’informatique sont des formes de vie au sens le plus fort du terme : la vie serait difficilement concevable sans eux. – (Winner 2020, chap. 1)

Un peu comme Jacques Ellul, nous devrions non plus tellement nous interroger sur les techniques elles-mêmes mais sur le système technicien. Pour J. Ellul la technique est déterminante dans les transformations sociales même si tout fait social ne se détermine pas par la technique. Mais ce qui alarmait J. Ellul, c’est que la technicisation de la société est un mouvement apparemment inéluctable, et la technologie moderne adopte une logique autonome, engendre son propre principe de perpétuation et d’accroissement au détriment de l’axiologie. C’est le somnambulisme auquel fait référence L. Winner et c’est en même temps la situation avec laquelle nous devons perpétuellement nous arranger : d’un côté les critiques à l’encontre des innovations sont souvent perçues comme des discours anti-technologiques voire anti-sociaux, d’un autre côté l’innovation s’inscrit dans un contexte politico-économique dont il ne serait que très difficile de sortir (le capitalisme, le néolibéralisme) sans une révolution. Dans les deux cas, nous ne sortirons pas de notre condition d’êtres appartenant à un système technicien.

Pour terminer cette section sur un exemple clivant actuellement : devons-nous adopter les IA génératives (IAg) dans nos pratiques quotidiennes ? On pourra toujours accuser les firmes qui produisent les services d’IAg de satisfaire le modèle oppressif du capitalisme de plateformes. La question ne devrait pas être posée en ces termes (pour ou contre l’IAg ?). La question est de savoir ce qui a fait que dans le développent du système technicien nous soyons arrivés à ces inventions, pourquoi se sont-elles si rapidement intégrées dans les pratiques et qu’est-ce que cela produit comme changements sociaux, quelles « formes de vie » ? On peut certes craindre, pour reprendre les mots de L. Winner, qu'« une fois de plus, on dit à ceux qui poussent la charrue qu’ils conduisent un char d’or ».

Pour une politique anarchiste des techniques

Cela ne nous dit toujours rien des principes que nous devrions adopter. Cela ne dit rien non plus sur ce qu’il faudrait sacrifier en adoptant quels principes que ce soit. Le développement technologique est un processus cumulatif qui incorpore les relations sociales dans la réalité matérielle. À chaque point d’inflexion, il faut reposer la question, sans cesse ! Je terminerai alors sur ce point : il faudra toujours tenter d’échapper aux logiques de pouvoir qui se servent des techniques pour arriver à leurs fin dans la situation de choix politique qui s’avance devant nous.

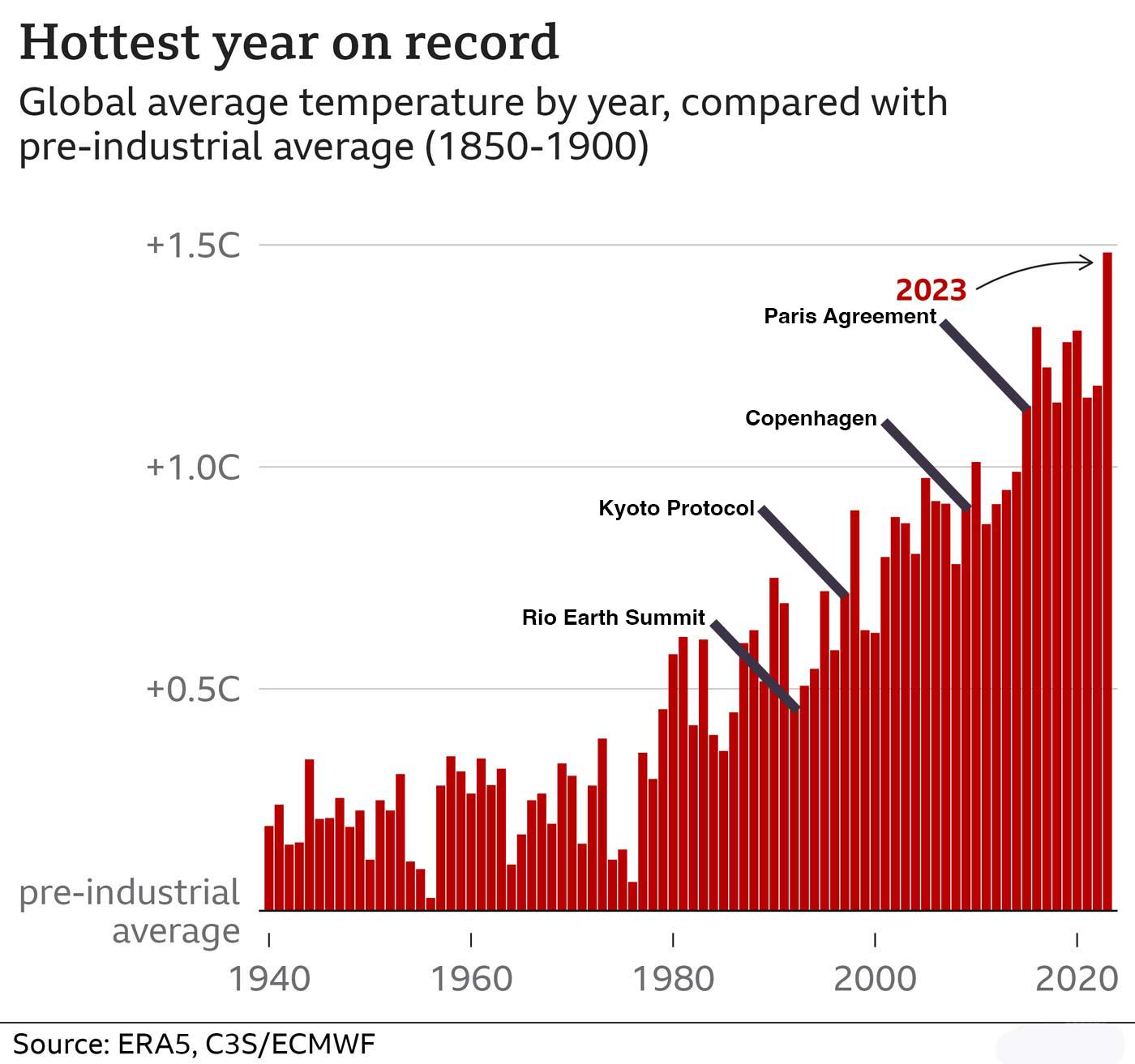

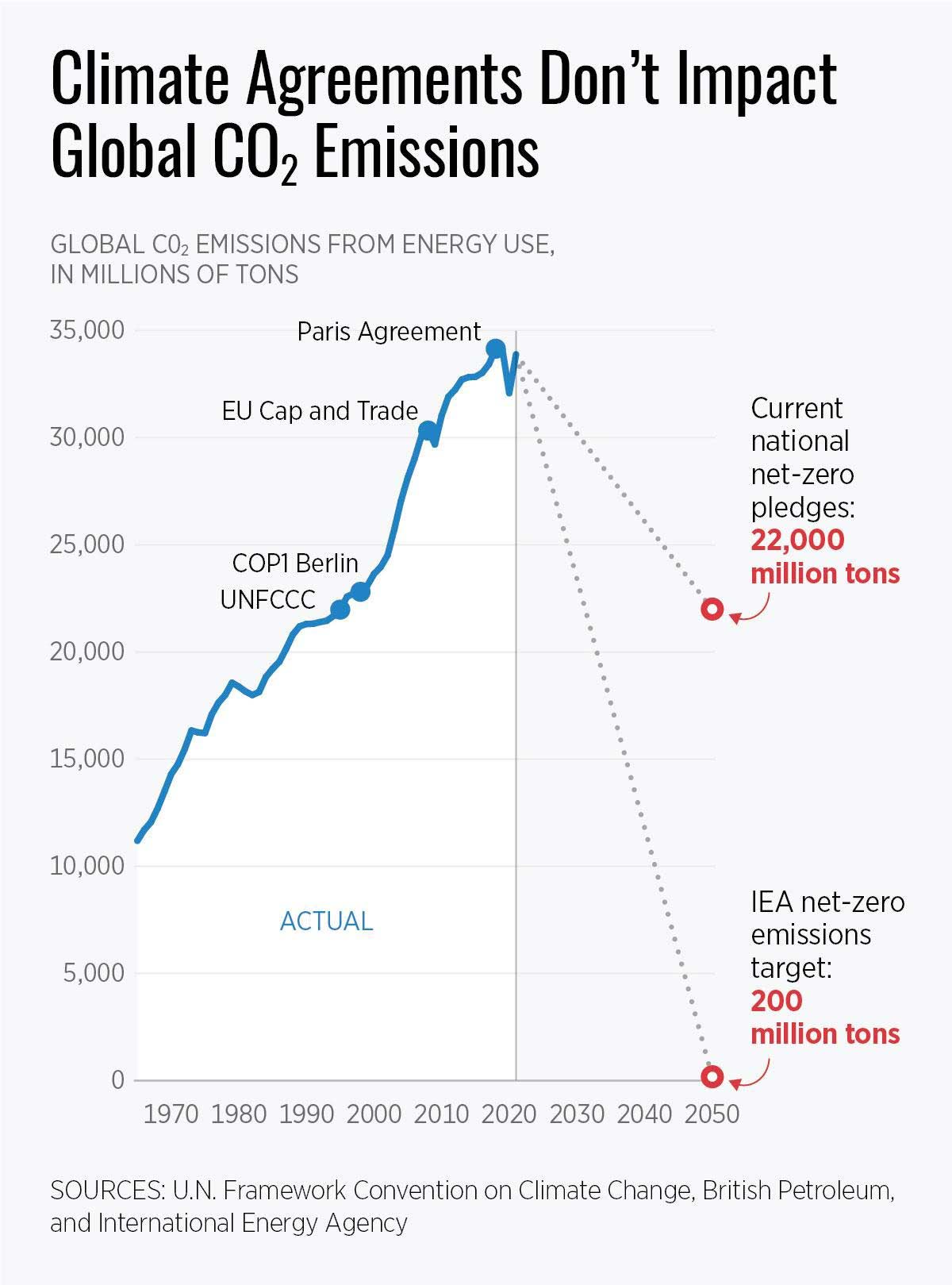

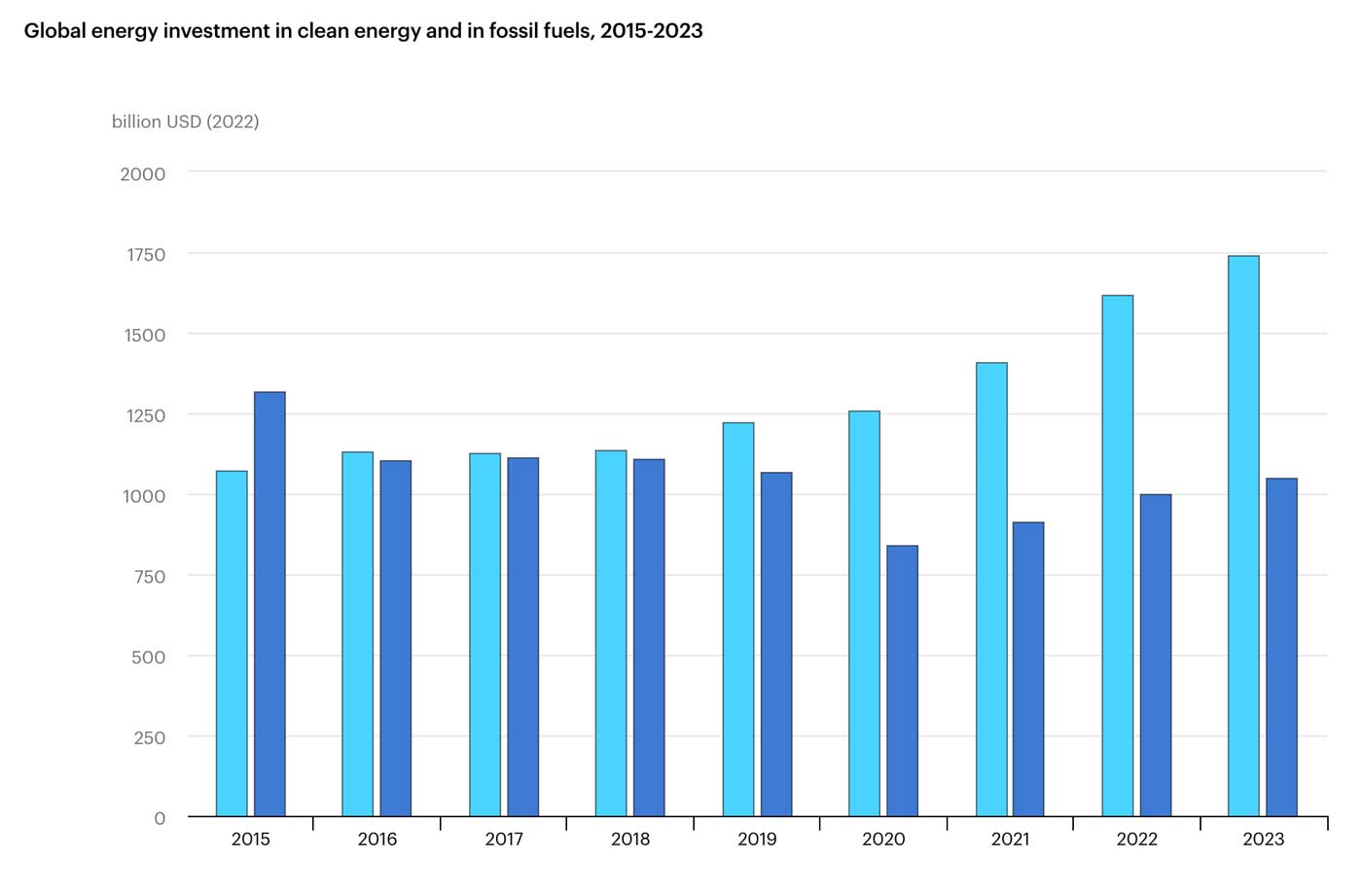

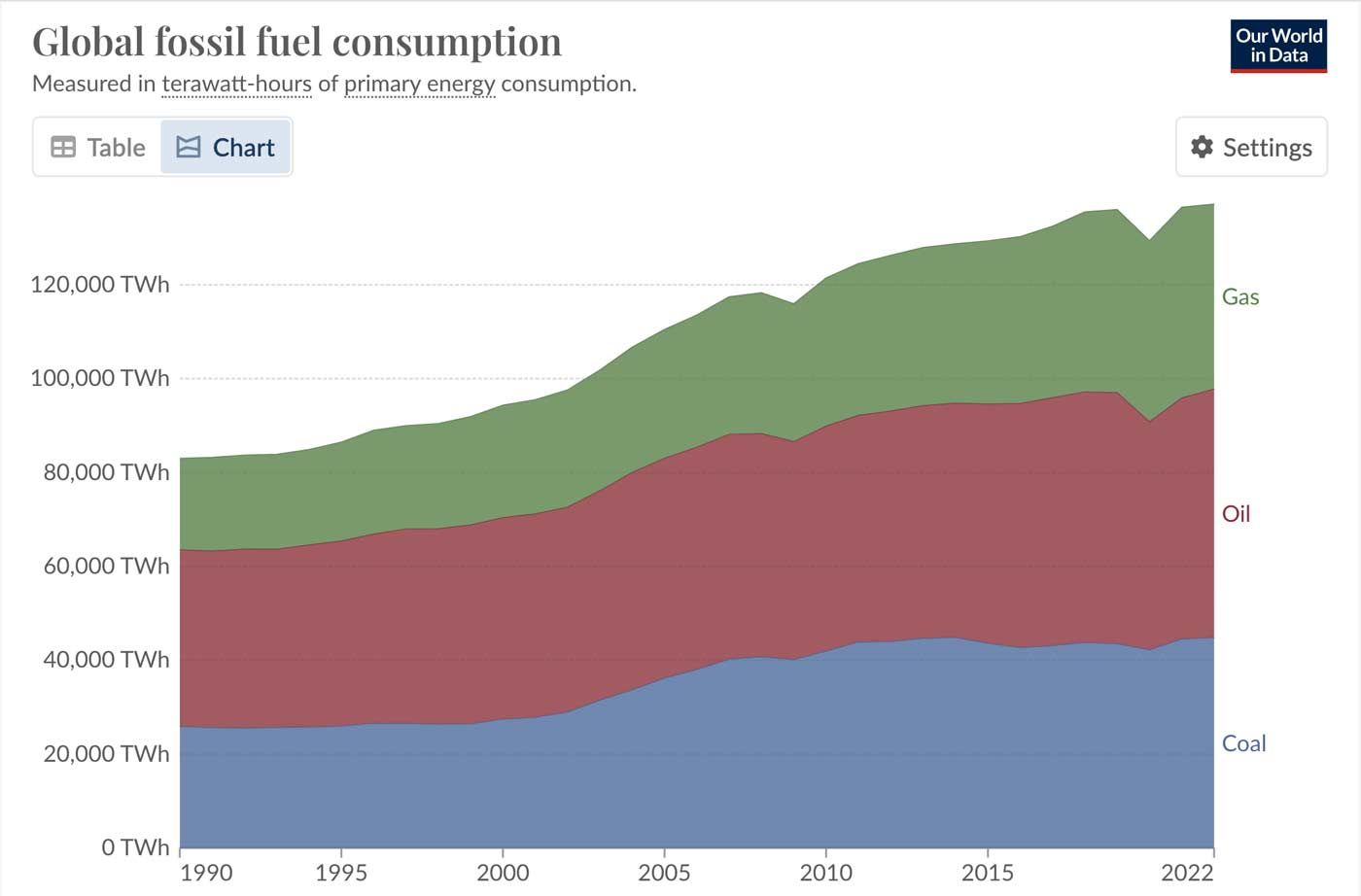

Nous vivons un instant clé où le changement climatique, l’effondrement écologique et la crise démocratique font que le capitalisme atteint une aporie. Si P. Thiel nous parle de la fin des temps (et il n’est pas le seul) c’est bien parce que ce genre de libertarien voudrait s’assurer d’être du « bon » côté des inégalités qui s’annoncent à une échelle mondiale, avec les guerres qui s’ensuivront. Pourra-t-on l’éviter ? je n’en sais rien. Mais il est toujours possible de s’interroger sur l’ordre social que nous pourrions établir dans le but, justement, de limiter les effets des erreurs passées et envisager l’avenir de manière plus sereine.

Si nous souhaitons conserver le système actuel, la manière dont nous produisons nos technologies ne peut qu’être centralisée autour de structures d’État, plus ou moins au service des groupes d’intérêts. Cette centralisation a du bon car elle permet de faire des choix politiques au nom d’une neutralité technologique du pouvoir : les technologies militaires ont besoin d’un contrôle hiérarchique, le marché de l’énergie a besoin d’être compétitif au prix des inégalités, les biotechnologies doivent pouvoir rendre l’agriculture toujours plus rentable, etc.

Si en revanche nous prenons conscience que nous ne pouvons continuer à croître indéfiniment dans un monde fini, que ce fait s’impose à nous ou que nous anticipions tant qu’il est encore possible de le faire, c’est d’une décentralisation des institutions et de la production de technologies dont nous avons besoin. Je reprends alors à mon compte la proposition d’Uri Gordon (Gordon 2009) pour une politique anarchiste de la technologie en trois points. Chacun de ces points renvoie à une posture utopiste (mais concrète) de décision collective, démocratique, car, finalement, c’est bien la clé de l’affaire :

- La résistance abolitionniste : s’opposer fermement à tout système technique qui renforce la centralisation du pouvoir, détruit l’environnement ou sert principalement les intérêts des États autoritaires et des grandes entreprises. Par exemple : les technologies militaires, la surveillance, l’exploitation des énergies fossiles. Ce n’est pas du primitivisme ou du luddisme, c’est « reconnaître que certaines formes d’abolitionnisme technologique sont essentielles à la politique anarchiste ». C’est un principe d’action qui cherche à identifier et contester les technologies qui, loin d’améliorer la vie collective, aggravent les inégalités et menacent les plus vulnérables en consolidant le pouvoir économique et politique d’une minorité.

- L’adoption désabusée : certaines technologies, comme Internet, peuvent être utilisées stratégiquement malgré leurs infrastructures bien trop centralisées (par exemple les câbles sous-marins aux enjeux géostratégiques). Du côté des utilisateurs, des alternatives existent et proposent d’une part des pratiques non capitalistes (prenons l’exemple du Fediverse), et d’autre part la création de communs en opposition frontale avec l’économie classique. De manière générale, c’est bien la création de communs dans tous les interstices où le pouvoir est faible qui permet d’utiliser des techniques de manière décentralisée. D’autres exemples existent, par exemple dans le monde agricole les semences paysannes contre les multinationales, ou encore les coopératives de réparation ou d’invention de matériels agricoles.

- La promotion active : il s’agit d’œuvrer en ayant conscience des limites matérielles, tout en gardant la part de subversion nécessaire à la créativité et à la réappropriation de la production. En ingénierie, il s’agit d’encourager les innovations « low-tech », la valorisation des savoirs traditionnels et de l’artisanat, le recyclage, la réparation et la reconstruction de matériel open-source, voire de redonner vie à d’anciennes technologies pour une utilisation à plus petite échelle et plus durable. Pour reprendre l’expression qu’emprunte lui-même Uri Gordon, cette approche vise une « micropolitique subversive d’autonomisation techno-sociale » pour construire des espaces alternatifs matériels et sociaux.

Ces principes doivent cependant être critiqués. La résistance aux techniques de surveillance en vue de les abolir nécessite des efforts considérables de plaidoyer si et seulement si nous nous imaginons être dans un État démocratique dont les organes sont effectivement à l’écoute des citoyens. Dans une dictature, faut-il même en parler ? On voit bien ici que ce principe est d’emblée soumis aux conditions politiques de l’usage des techniques.

Concernant les technologies militaires, pour faire simple, nous pouvons prendre l’exemple de l’armement atomique. Un contrôle hiérarchique strict est nécessaire pour encadrer l’usage : compte-tenu de l’enjeu géostratégique, nous devons nous résoudre à ce que l’usage de l’arme nucléaire soit soumis aux jeux de pouvoir en politique extérieure (la dissuasion) comme en politique intérieure (prémunir l’arrivée au pouvoir d’un parti belliqueux). L’arme nucléaire existe et ce simple fait ne peut que nous cantonner à un plaidoyer en faveur du désarmement nucléaire mondial.

Concernant l’arrivée de nouvelles technologies, l’étude de cas des IA génératives (IAg) pourrait servir d’illustration. Comme je l’ai dit plus haut, nous devons sans cesse interroger le cadre axiologique par lequel nous élaborons une critique des techniques. Quelle est la dynamique des dispositifs socio-techniques et leurs points de jonction qui font que les IAg sont apparues et aient, de manière aussi spectaculaire, intégré nos pratiques quotidiennes ? Il faudrait en faire des études et elles sont encore loin d’être rédigées. Quelques éléments nous mettent sur la voie, par exemple les positions hégémoniques des entreprises qui fournissent des services d’IAg. Parmi les trois principes ci-dessus, lequel adopter ? sans doute un mixte. Mais c’est là l’un des points critiques que de définir ex ante trois attitudes possibles : si l’on veut rester honnête, elles ne sont pas exclusives entre elles et, dans cette mesure, elles aboutissent invariablement à des positions mitigées. Mais peut-être est-ce là la leçon de l’histoire des techniques : l’ambivalence des techniques nous pousse nous-mêmes à nous positionner de manière ambivalente, en acceptant nos contradictions et pourvu qu’on puisse en débattre sans relativisme. La manière dont nous conduisons nos systèmes techniques est le reflet de notre humanité.

Références

BOOKCHIN, Murray, 2016. Au-delà de la rareté: l’anarchisme dans une société d’abondance. Montréal Québec, Canada : Éditions Écosociété. ISBN 978-2-89719-239-6.

FOUCAULT, Michel, 2004. Naissance de la biopolitique: cours au Collège de France, 1978-1979. Paris, France : EHESS : Gallimard : Seuil. ISBN 978-2-02-032401-4.

GORDON, Uri, 2009. Anarchism and The Politics of Technology. WorkingUSA [en ligne]. 5/1/2009. Vol. 12, n. 3, pp. 489‑503. [Consulté le 27/7/2025]. DOI 10.1163/17434580-01203010. URL.

HARTMANN, Detlef, 1981. Die Alternative: Leben als Sabotage. Iva-Verlag Polke. Tübingen.

HEIDEGGER, Martin, 1958. La question de la technique. In : Essais et Conférences. Paris : Gallimard. pp. 9‑48.

MARX, Karl, 1993. Le Capital. Critique de l’économie politique. Livre premier. Paris : PUF. Quadrige.

MARX, Karl, 2011. Manuscrits de 1857-1858 dits « Grundrisse ». Paris : Éditions sociales.

MARX, Karl, 2019. Misère de la philosophie. Paris : Payot.

MICHÉA, Jean-Claude et JULLIARD, Jacques, 2018. La Gauche et le peuple : lettres croisées. Paris, France : Flammarion.

PRÉVOST, Thibault, 2024. Les prophètes de l’IA: pourquoi la Silicon Valley nous vend l’apocalypse. Montréal, Canada : Lux Éditeur. ISBN 978-2-89833-161-9.

SLOBODIAN, Quinn, 2025. Le capitalisme de l’apocalypse: ou le rêve d’un monde sans démocratie. Paris, France : Éditions du Seuil. ISBN 978-2-02-145140-5.

STIEGLER, Barbara, 2019. « Il faut s’adapter » : sur un nouvel impératif politique. Paris, France : Gallimard. ISBN 978-2-07-275749-5.

THIEL, Peter, 2025. Peter Thiel et la fin des temps (parties 1 et 2) [en ligne]. [Le Grand Continent]. 20/4/2025. [Consulté le 26/4/2025]. URL.

WINNER, Langdon, 2020. The Whale and the Reactor. A Search for Limits in an Age of High Technology. Chicago : University of Chicago Press.

Notes

-

Il y a peu de références dans ce paragraphe car il serait laborieux d’expliquer dans le détail la construction de cet argumentaire. J’ai été l’un des étudiants en philosophie à Strasbourg de Miguel Espinoza qui nous a alors expliqué (avec plus ou moins de réussite) ses travaux remarquables sur l’intelligibilité de la nature. Prolonger la discussion ici nous amènerait bien trop loin. ↩︎

-

Oui, je sais bien que la religion n’a jamais empêché la rationalité, il y a assez de textes critiques théologiques pour le démontrer. Ce n’est pas mon sujet. C’est simplement qu’il est impossible de positionner un curseur fiable entre une simple approche critique religieuse des techniques et la volonté d’influence sociale qu’imposent les religieux sur le prétexte des techniques. Un exemple au hasard : les campagnes anti-avortement. Lorsque les religieux en auront fini avec ça, je commencerai peut-être éventuellement à leur tendre une oreille distraite si j’ai du temps à perdre. ↩︎

-

Sur ce point j’ajouterai une nuance car nous sommes aussi passés maîtres dans l’art de l’évaluation des risques, mais la question du principe de précaution se pose toujours dans un mouchoir de poche, par exemple lorsque le risque est à des années lumières de l’état des connaissances. ↩︎

Publié le 21.07.2025 à 02:00

IAg et neutralité de la technique

Ceci est une note de synthèse qui s’inspire en partie des thèmes et arguments abordés dans l’article : « ChatGPT, c’est juste un outil ! : les impensés de la vision instrumentale de la technique » par Olivier Lefebvre.

Dans la mesure où les thèmes en question ont tous déjà été abordés par d’autres auteurs, j’y ajoute des contextes, des réflexions et des références comme autant de pistes d’ouverture au sujet de la non-neutralité de la technique.

Commençons par un fait : les entreprises des Big Tech qui travaillent sur les IA génératives ont tout à gagner de considérer ces dernières comme des outils.

Table des matières

Les arguments marketing de Microsoft présentent Copilot comme un assistant permettant de délester les humains des tâches fastidieuses pour qu’ils se concentrent sur des tâches à plus haute valeur ajoutée. C’est une vision où l’IA est clairement un outil d’appoint, sans autonomie créative réelle, orientée dans un seul but, la productivité.

D’autres voix plus subtiles se font toutefois entendre. Andrew Ng, co-fondateur de Google Brain, s’exprime à ce sujet devant un journaliste de The Economic Times le 17 juillet 2025. Il minimise l’idée d’une intelligence artificielle générale imminente, qualifiant de « ridicules » les peurs » selon lesquelles ces systèmes remplaceraient massivement les humains. Pour lui, l’IA doit être un outil permettant d’augmenter l’humain, pas un substitut de la créativité ou du raisonnement. Ce faisant il formule une comparaison avec l’électricité : selon Ng, l’IA est une technologie neutre dont l’impact dépend entièrement de la façon dont elle est utilisée :

« L’IA n’est ni sûre ni dangereuse. C’est la façon dont vous vous en servez qui la rend telle », a-t-il déclaré. « Comme l’électricité, l’IA peut alimenter d’innombrables applications positives, mais elle peut aussi être utilisée de manière préjudiciable si elle est mal gérée. »

Considérer les IA génératives ou n’importe quelle autre technique comme un « simple outil », cela revient à adopter une approche instrumentale de la technique. C’est une approche volontairement réductrice, qui présuppose la neutralité des technologies, et élude les conditions matérielles, sociales, économiques et politiques de leur existence. Elle masque également les transformations profondes que ces systèmes techniques induisent dans nos manières de vivre, de penser, de produire, et d’interagir.

Nous savons depuis longtemps que la technique n’est pas neutre. Et pourtant, le sujet revient comme un marronnier : il est toujours renouvelé par ceux qui ont un intérêt à réduire la technique à ses aspects purement utilitaires. Les IA génératives ne relèvent pas uniquement de l’outillage fonctionnel, mais participent à la reconfiguration des structures sociales et des subjectivités contemporaines. Elles doivent être pensées comme des systèmes techniques complexes, produits par un faisceau de déterminations économiques, énergétiques, géopolitiques et culturelles, et non comme de simples extensions de la main humaine.

IAg, c’est quoi ?

Une Intelligence Artificielle générative (IAg) est un type d’IA capable de générer du contenu original (texte, images, musique, code, etc.) qui n’existait pas avant. On ne peut pas vraiment parler de création dans la mesure où, pour entraîner de telles IA, il faut utiliser des corpus et des bases de données issus de la création humaine et dont s’inspire l’acte de génération de contenus par ces IA : des milliards de textes, d’images, de musiques, de vidéos, etc.. Évidemment, cela soulève de nombreuses questions liées au droit d’auteur et à la somme énergétique et technologique mobilisée pour ces entraînements.

On peut avoir un aperçu des enjeux liés aux IA sur Framamia.

L’idée de réaliser des systèmes automatisés permettant de reproduire la « créativité » humaine et le raisonnement est une idée fort ancienne. Retenons, en gros, que pour réaliser ceci on utilisait auparavant des programmes qui donnaient à la machine des suites d’instructions (des algorithmes) pour générer par exemples des phrases ou des formes aléatoires. Il manquait alors deux choses aux IA : de la puissance de calcul, et la possibilité d’entraîner des modèles d’IA sur des immense quantités d’informations accessibles notamment grâce à Internet.

Les LLM (Larges Language Models) sont des IAg spécialisées dans le langage. Ils sont devenus de plus en plus performants et sont aujourd’hui couplés avec d’autres générateurs d’image voire de vidéos, si bien que ChatGPT, Gemini et consors, sont en réalité des services de prompteurs auxquels on soumet des requêtes en langage naturel pour obtenir une production de texte, d’image ou autre.

Pour donner une idée de la manière dont les LLM ont progressé, on peut parler de l’architecture d’apprentissage machine basée sur les transformeurs (on parle aussi d’auto-attention du système), une méthode introduite en 2017 par des chercheurs de Google Brain et Google Research (Vaswani et al. 2023). Avant 2017, on basait l’apprentissage sur une analyse séquentielle : pour comprendre une phrase, les modèles lisaient les mots un par un. Pour un humain, c’est une chose parfaitement banale car nous apprenons et comprenons le sens des mots. Mais pour une machine qui lit un texte mot après mot, elle doit se souvenir de tous les mots précédents pour déterminer le sens d’une phrase.

Mais même à l’intérieur d’une phrase, cela peut s’avérer compliqué. Prenons celle-ci : « Le petit Nicolas, qui avançait sur le chemin de l’école en compagnie de son amie Valentine vêtue d’une jolie robe rouge, avait oublié son cartable ». Il est difficile, pour une analyse séquentielle, de faire le lien entre Nicolas et « son cartable ». Le mécanisme de l’auto-attention permet de lire de manière simultanée tous les mots d’une phrase et d’en calculer une importance ou une relation des uns avec les autres. Ainsi, des mots très éloignés les uns des autres pourront bénéficier d’une analyse de pondération permettant de connaître le poids de leurs relations. Pour l’apprentissage machine, cela permet non seulement d’être plus efficace mais aussi de traiter de manière beaucoup plus rapide des milliards de phrases.

Les IAg sont-elles de simples outils « comme les autres » ?

Que veut-on dire lorsqu’on compare des outils ? Est-ce que cela a un sens que de comparer un marteau et un ordinateur ? Ce qu’on fait la plupart du temps lorsqu’on compare des outils, c’est comparer leurs finalités. On en arrive toujours à quelques banalités : un marteau peut servir à enfoncer un clou ou fracasser un crâne, tout dépend de qui s’en sert et dans quelle intention. La conclusion consiste toujours à en tirer un argument fallacieux : une technique serait toujours neutre, indépendante des usages et des conditions de sa production. Est-ce le cas ? bien sûr que non.

C’est un vieux problème

Dans le Gorgias, Platon opposait deux points de vue au sujet de la rhétorique, fondement de l’art politique qui, selon Platon est une technê (Platon, 2024). Il y a le point de vue du sophiste Gorgias, d’un côté, qui considère la rhétorique comme une technique neutre, pour laquelle il n’y aurait ni bon ni mauvais usage, un simple moyen, un instrument. De l’autre côté, celui de Socrate pour lequel aucune technique n’est neutre : l’efficacité d’une technique dépend de choix politiques et économiques pour utiliser une technique plutôt qu’une autre et quelle que soit la finalité, une technique n’existe pas seule.

Plus contemporain de nous, Jacques Ellul (Ellul, 1954) s’intéressait à la notion de système technique. Il montrait que les techniques forment des systèmes dotés d’une sorte d’autonomie car ils finissent par imposer à l’homme des usages (pensons par exemple à l’immédiateté de nos communications téléphoniques), et créent toujours une dépendance (pensons par exemple à la dépendance de notre société à la voiture).

Langdon Winner, dans La baleine et le réacteur (Winner, 2022) revient lui aussi sur la question de la vision instrumentale de la technique et montre que la réduction de l’outil à une objet axiologiquement neutre revient à isoler l’outil du reste du monde, y compris de ses conditions d’existence. Cela revient aussi, toujours selon L. Winner, à renforcer le mythe du progrès en le présentant comme un phénomène naturel et par définition incontrôlable. La seule solution consisterait donc à s’adapter individuellement à l’outil et au progrès (on verra plus loin à quel point cet argument revient à l’ère néolibérale).

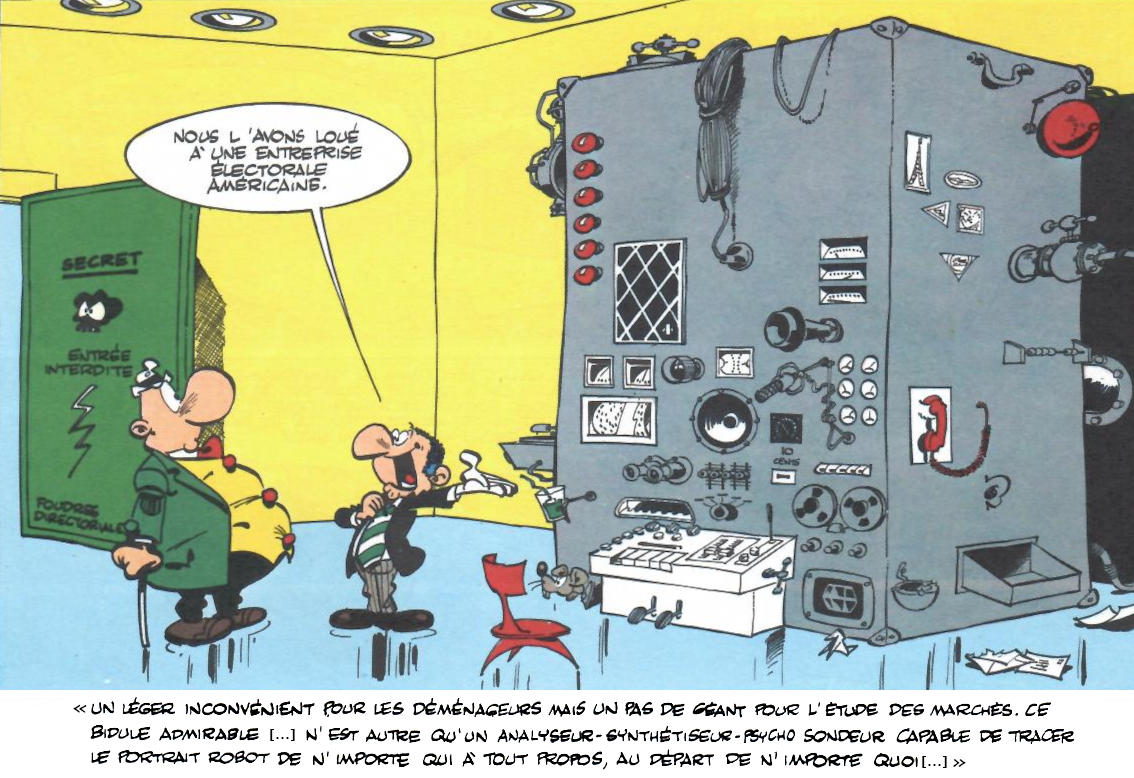

Dans son article « Mythinformation in the high-tech era » (Winner, 1984), L. Winner définit la Mythinformation comme la « conviction quasi-religieuse qu’une adoption généralisée des ordinateurs et des systèmes de communication, ainsi qu’un large accès à l’information électronique, produiront automatiquement un monde meilleur pour l’humanité ». Il montre que la question du supposé besoin du traitement de l’information concentre l’informatique sur la seule acception d’outil, ou de boîte à outils, comme une réponse à tous nos besoins. Et cela élude complètement (c’est moins le cas aujourd’hui puisque nous sommes capables de penser le capitalisme de surveillance) le fait que ces prétendus outils créent de nouvelles institutions, comportements et formes de pouvoir.

En suivant un processus progressif d’améliorations technologiques, les sociétés créent de nouvelles institutions, de nouveaux modèles de comportement, de nouvelles sensibilités et de nouveaux contextes pour l’exercice du pouvoir. En qualifiant ces changements de « révolutionnaires », les gens reconnaissent tacitement qu’ils ont besoin une réflexion, voire d’une action publique forte pour s’assurer que les résultats sont souhaitables. Or, dans notre société, les occasions de réfléchir, de débattre et de faire des choix publics sont désormais rares. Les décisions importantes sont laissées aux mains d’acteurs privés inspirés par des motifs économiques étroitement ciblés. Bien qu’il soit largement reconnu que ces décisions ont des conséquences profondes sur notre vie commune, peu de gens semblent prêts à admettre ce fait. Certains observateurs prévoient que la révolution informatique sera guidée par les nouvelles merveilles de l’intelligence artificielle. Son cours actuel est influencé par quelque chose de beaucoup plus familier : l’absence d’esprit.

– L. Winner, « Mythinfonnation in the high-tech era », p. 596.

On ne compare pas des outils mais des systèmes techniques

On peut aisément comprendre que comparer une IAg et un marteau pose au moins un problème d’échelle. Il s’agit de deux systèmes techniques dont les conditions d’existence n’ont rien de commun. Si on compare des systèmes techniques, il faut en déterminer les éléments matériels et humains qui forment le système.

Un système technique peut être par exemple composé d’un menuisier, d’une planche, d’un clou et d’un marteau. Ses conditions socio-technique seront (entre autres) : la formation du menuisier, son humeur du jour, l’industrie qui a fabriqué le métal (du marteau et du clou), l’ingénierie qui a dessiné l’ergonomie du manche du marteau… Somme toute, à part l’industrie (minière et métallifère) et l’économie qui conditionnent le façonnage et le transport du métal du marteau, et comme il y a de forte chance que le marteau ai été importé d’un pays de production, le système technique a finalement assez peu de facteurs. L’empreinte matérielle et les conditions sociales de production sont limitées et assez facilement identifiables. Les conditions et conséquences environnementales, sociales, économiques et politique de la production de marteau, de clous et de planches, ainsi que les déterminants sociaux qui amènent un humain à choisir le métier de menuisier, sont elles aussi facilement identifiables.

Qu’en est-il des IAg ? L’inventaire est beaucoup plus long :

- des datacenters dont les constructions se multiplient, entraînant une croissance vertigineuse des besoins en électricité,

- des réseaux de télécommunication étendus et des usines de production de composants électroniques, ainsi que des mines pour les matières premières qui sont elles mêmes assez complexes (plus complexes que les mines de fer) et entraînent des facteurs sociaux et géopolitiques d’envergure,

- les investissements colossaux (en milliards de dollars) en salaires d’ingénieurs en IA, en infrastructures de calcul pour entraîner les modèles, en recherche, réalisés dans une perspective de rentabilité,

- l’exploitation humaine : des millions de personnes, majoritairement dans les pays du Sud, sont payées à la tâche pour labelliser des données, sans lesquelles l’IA générative n’existerait pas,

- le pillage d’une immense quantité d’œuvres protégées par droits d’auteurs pour l’entraînement des modèles.

- et nous pouvons rattacher plein d’autres éléments en cascade pour chacun de ceux cités ci-dessus.

On conçoit aisément que comparer les deux systèmes techniques, celui du marteau et celui d’une IAg comme ChatGPT, revient à comparer un système dont les conditions socio-techniques restent encore mesurables, avec un système dont l’envergure et les implications sociales sont gigantesques et à l’échelle mondiale. Quant à l’usage lui-même l’action du marteau restant simplissime, on ne peut pas en dire autant d’une IAg qui mobilise toute une infrastructure faite de logiciels, de réseaux, de serveurs dotés de puces électroniques spécifiques.

Postuler la neutralité des techniques revient à minimiser l’importance de leurs enjeux

L’affirmation selon laquelle une IAg ne serait qu’un simple outil s’inscrit dans une vision instrumentale de la technique, qui présuppose que l’objet est neutre, sous le contrôle de son utilisateur, et que ses effets ne dépendent que de l’usage qu’on en fait.

Ce discours cherche à désamorcer les inquiétudes que l’arrivée des IAg suscite. En ramenant cette technologie particulière dans le champ général et indifférencié des « outils » il circonscrit la réflexion dans un cadre connu et rassurant : chacun a une vision assez simpliste de ce qu’est un outil dans le sens d’un prolongement de la main et de l’action mécanique de l’homme sur son environnement, ce que l’anthropologue André Leroi-Gourhan nommait la technogénèse dans son article de l’Encyclopédie Française de 1936, « L’homme et la nature » (Beaune, 2011). Même à ce sujet, on sait désormais que les choses sont… plus compliquées.

Ce discours a pour effet d’invisibiliser de nombreux aspects cruciaux des IAg, tels que leurs conditions d’existence et la manière dont elles transforment la société, comment elles structurent de nouveau habitus du quotidien, ou encore leurs effets sur nos propres structures cognitives, culturelles et épistémiques.

L’autonomie de la technique

Ce discours a en réalité une intention : participer à la banalisation tout en nous empêchant de penser la complexité des effets des techniques et d’adopter les mesures appropriées, par exemple leur régulation. Il propage un sentiment de résignation, affirmant que la technologie est un « déjà-là » et que la question n’est plus de s’opposer ou de réfléchir, mais « comment on va vivre avec ».

Ce faisant cette vision instrumentale de la technique implique un paradoxe : alors qu’elle prétend que l’utilisateur a toujours le contrôle d’une technique supposée neutre, ce « déjà-là » de la technique implique au contraire une absence de contrôle, comme si l’humain était lui-même l’instrument d’une technique en processus d’autonomisation.

C’est mal poser le problème. Il y a effectivement, comme le disait J. Ellul, une forme d’autonomisation des systèmes techniques en ce qu’ils produisent des effets de dépendance. Mais cette autonomie de la technique n’est pas une tragédie dans laquelle nous serions au prises d’un destin décidé par des techno-divinités tissant les fils invisibles de notre soumission aux technologies aliénantes. Tout comme nous serions soumis aux aléas de la nature, notre destin serait non seulement d’utiliser des techniques pour nous extraire de notre condition servile mais aussi de subir les conséquences de nos usages techniques : le mythe de Prométhée sans cesse renouvelé. C’est une mauvaise lecture. Le feu n’a pas été donné par un Titan pas plus que les IAg n’ont été créés par des dieux.

L’exemple de l’automobile est assez parlant. Son déploiement s’est accompagné du développement de vastes infrastructures routières et pétrolières, structurant les banlieues résidentielles et l’industrie. En façonnant un monde adapté à elle, l’automobile est devenue incontournable, entraînant un verrouillage socio-technique où le choix d’utiliser ou non la voiture a perdu une grande partie de son sens. C’est cela l’autonomie des systèmes techniques : pour en sortir, il faut des révolutions socio-techniques : il y en a eu par le passé, il y en aura encore, plus ou moins rapides et subites ou lentes et progressives.

L’informatisation de la société a suivi une trajectoire similaire : un auto-renforcement entre le développement des infrastructures (réseaux, terminaux) et la multiplication des usages encastrés dans nos modes de vie. Ce processus a conduit à des situations où certaines activités quotidiennes ne sont possibles que par la médiation du numérique. Les IAg sont un prolongement de cette trajectoire, s’appuyant sur la disponibilité massive de données et l’habitude d’utiliser des applications numériques.

L’inéluctabilité est un discours néolibéral

La vision instrumentale de la technique présente celle-ci comme le résultat inéluctable de la « poursuite du progrès ». On y retrouve des discours éculés : le défaitisme devant le monde qui change, l’impossibilité d’élaborer des alternatives, le fait de masquer que les techniques sont aussi issues de choix sociaux et politiques (qui subventionne quoi et au nom de qui ?), ou encore l’argument de la jeunesse qui, par définition, serait toujours plus prompte à s’emparer des outils plus complexes que ce qu’ont connu leurs aînés.