10.12.2025 à 12:22

Ces pointes de flèches prouvent-elles la présence d’Homo Sapiens en Eurasie il y a 80 000 ans ?

Hugues Plisson, archéologue spécialisé en tracéologie (reconstitution de la fonction des outils préhistoriques par l'analyse de leurs usures), Université de Bordeaux

Andrey I. Krivoshapkin, Acting director, Russian Academy of Sciences

Texte intégral (3861 mots)

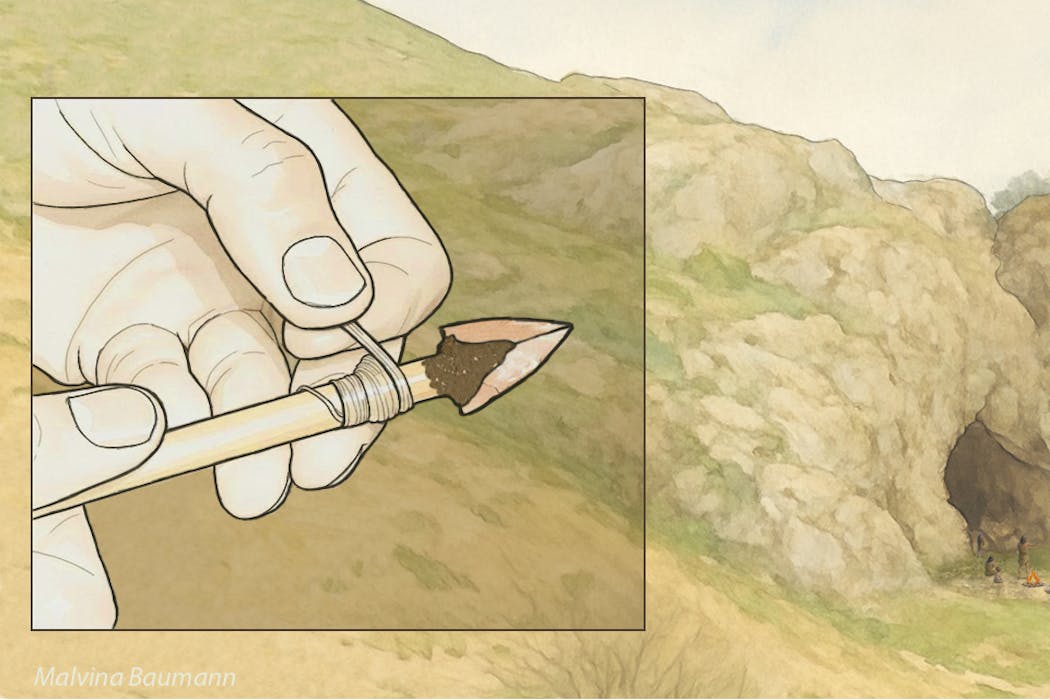

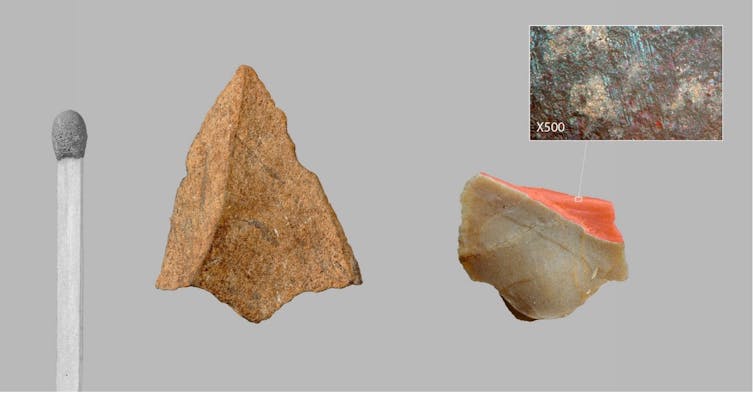

De minuscules pointes de projectile triangulaires ont été identifiées à partir de leurs fractures d’impact dans les plus anciennes couches d’occupation du site d’Obi-Rakhmat en Ouzbékistan, vieilles de 80 000 ans. Elles ont la dimension de pointes de flèches et sont identiques à celles découvertes dans une couche beaucoup plus récente d’un site de la vallée du Rhône, en France, à la toute fin du Paléolithique moyen, correspondant à une incursion d’Homo Sapiens en territoire néanderthalien il y a 54 000 ans. Cette nouvelle étude, publiée dans la revue « PLOS One », apporte un argument décisif pour la réécriture du scénario de l’arrivée d’Homo Sapiens en Europe.

Développés en Europe occidentale et plus particulièrement en France à partir de la seconde moitié du XIXe siècle, les cadres chrono-culturels et anthropologiques de la Préhistoire et les modèles évolutifs qu’ils inspirèrent furent d’abord linéaires et européocentrés : Cro-Magnon descendant de Néanderthal posait les fondements d’une supériorité civilisationnelle dont se prévalait alors cette partie du monde. Ce n’est qu’un siècle plus tard que sera mise en évidence l’origine africaine d’Homo Sapiens et des traits technologiques et sociaux structurants du Paléolithique supérieur occidental, de ~ 45 000 à 12 000 ans avant le présent (productions symboliques, réseaux à grande distance, outillages et armements lithiques et osseux diversifiés).

Les plus anciennes évidences de présence d’Homo Sapiens en Australie vers 65 000 ans précèdent de 10 millénaires celles de l’Europe dont les modalités du peuplement demeurent sujet de discussion. À ce jour, le calage chronologique des toutes premières occupations européennes du Paléolithique supérieur par rapport à celles de l’est du bassin méditerranéen, pourtant regardées comme les plus proches, demeure insatisfaisant. Soit les données sont issues de fouilles trop anciennes pour avoir été suffisamment précises, soit elles ne s’inscrivent pas dans la filiation directe supposée entre le Levant et l’Europe. Les racines mêmes du Paléolithique supérieur initial levantin, malgré la proximité africaine, sont incertaines. Une origine centre asiatique, a été suggérée par l’archéologue Ludovic Slimak en 2023.

Un site en Asie centrale

Corridor entre l’ouest et l’est du continent ou zone refuge, selon les phases climatiques, l’Asie centrale n’est encore documentée que par quelques sites paléolithiques, mais qui sont autant de références de l’histoire de la Préhistoire.

Parmi ceux-ci figure l’abri sous roche d’Obi-Rakhmat en Ouzbékistan découvert en 1962. Ce gisement livre sur 10 mètres de stratigraphie, entre 80 000 et 40 000 ans, une industrie lithique qui par certains traits s’inscrit clairement dans la continuité du Paléolithique moyen ancien du Levant mais par d’autres fut rapprochée du Paléolithique supérieur initial. Ce Paléolithique moyen ancien du Levant, associé dans le site de Misliya à de l’Homo Sapiens archaïque, disparut du Proche-Orient vers 100 000 ans. À Obi-Rakhmat, les restes crâniens d’un enfant trouvés dans une couche à ~ 70 000 ans, présentent des caractères regardés comme néanderthaliens et d’autres comme anatomiquement modernes, combinaison pouvant résulter d’une hybridation.

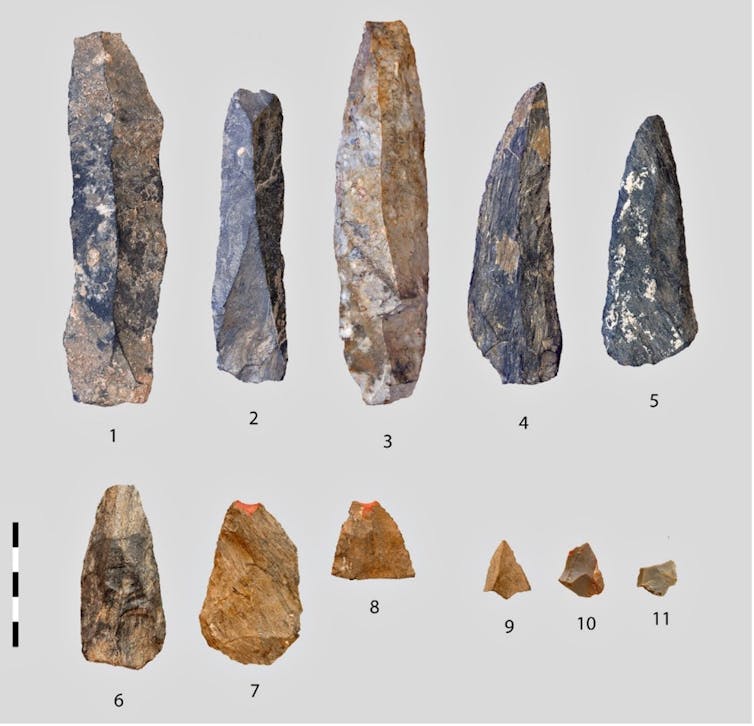

Lames massives mais pointes microlithiques

C’est dans ce contexte que notre équipe internationale, dirigée par Andrei I. Krivoshapkin, a identifié dans les couches les plus anciennes de minuscules pointes de projectiles triangulaires. Mesurant moins de 2 cm de large et ne pesant que quelques grammes, elles sont impropres par leurs dimensions et leur fragilité à avoir été montées sur des hampes de lances. Leur étroitesse correspond au diamètre (inférieur ou égal à 8 mm) des hampes documentées ethnographiquement sur tous les continents pour les flèches tirées à l’arc droit.

Question de balistique

Les armes perforantes projetées constituent des systèmes complexes dont les éléments ne sont pas interchangeables d’un type d’arme à l’autre, car répondant à des contraintes différentes en intensité et en nature.

L’importante force d’impact des lances tenues ou lancées à la main fait de la robustesse de l’arme un paramètre essentiel, aussi bien en termes d’efficacité que de survie du chasseur, la masse assurant à la fois cette robustesse, la force d’impact et la pénétration. À l’opposé, la pénétration des traits légers tirés à grande distance repose sur leur acuité, car l’énergie cinétique, beaucoup plus faible, procède là essentiellement de leur vitesse, laquelle, à la différence de la masse, décroit très rapidement sur la trajectoire et dans la cible. Cette vitesse ne pouvant être atteinte par la seule extension du bras humain, elle est obligatoirement tributaire de l’emploi d’un instrument de lancer. Les pointes de flèche et celles de lances ou de javelines ne sont donc pas conçues selon les mêmes critères et ne se montent pas sur les même hampes, les dimensions et le degré d’élasticité desquelles sont par ailleurs essentiels en terme balistique. Ainsi, comme en paléontologie où la forme d’une dent révèle le type d’alimentation et suggère le mode de locomotion, les caractéristiques d’une armature fournissent des indices sur le type d’arme dont elle est l’élément vulnérant.

Un armement propre à Sapiens ?

Le minuscule gabarit des pointes d’Obi-Rakhmat ne peut être regardé comme un choix par défaut, car non seulement la matière première lithique de bonne qualité dont on a tiré de grandes lames ne manque pas à proximité du site, mais l’inventaire des traces d’usage relevées à la loupe binoculaire et au microscope met en évidence au sein du même assemblage des pointes retouchées beaucoup plus robustes (15 à 20 fois plus lourdes et 3 à 4 fois plus épaisses) et du gabarit des têtes de lance ou de javeline.

En retournant à la bibliographie et à nos propres travaux sur des outillages du Paléolithique moyen, nous avons constaté que la présence dans un même ensemble d’armatures de divers types, pour partie microlithiques et produites à cette fin, n’était à ce jour connue que dans les sites à Homo Sapiens. Les plus anciennes occurrences documentées sont en Afrique du Sud dans les couches culturelles Pre-Still Bay (plus de 77 000 ans) et postérieures du gisement de Sibudu. Dans l’univers néanderthalien, les pointes lithiques endommagées par un usage en armature de projectile sont rares, elles sont de fort gabarit et ne se distinguent ni par leurs dimensions, leur facture ou leur type de celles employées à d’autres activités que la chasse, telles que la collecte de végétaux ou la boucherie. Cette distinction dans la conception des outillages et des armements prend valeur de marqueur anthropologique.

En raison de leurs dates respectives, de la distance entre l’Afrique du sud et l’Asie centrale (14 000 km) et de la différence de facture des armatures d’Obi-Rakhmat et de Sibudu (lithique brut de débitage vs lithique façonné ou retouché, osseux façonné), l’hypothèse de foyers d’invention indépendants est la plus vraisemblable.

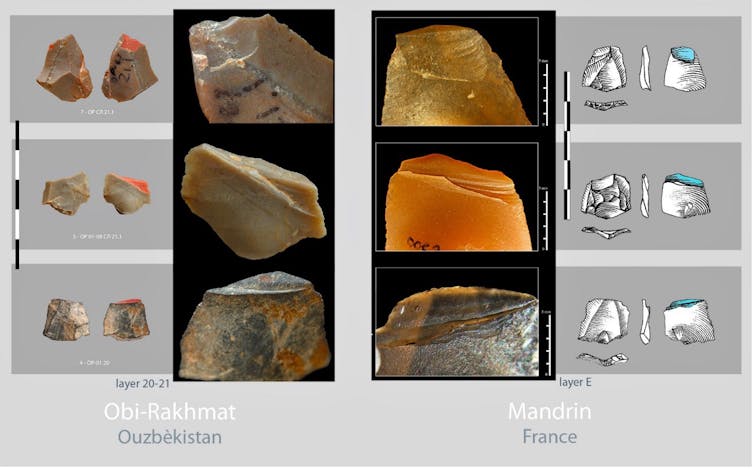

Des piémonts du Tien Shan à la vallée du Rhône 25 000 plus tard

La seule forme d’armature miniature de projectile identique actuellement connue est beaucoup plus récente. Elle fut découverte par Laure Metz, sur le site de Mandrin, en vallée du Rhône en France, qui livra aussi une dent de lait d’Homo Sapiens déterminée par Clément Zanolli. L’ensemble est daté d’environ 54 000 ans, soit une dizaine de milliers d’années avant la disparition des Néanderthaliens locaux. La similitude des micro-pointes d’Obi-Rakhmat et de Mandrin, pourtant séparées par plus de 6 000 km et 25 millénaires, est telle que les unes et les autres pourraient être interchangées sans qu’aucun autre détail que la roche ne trahisse la substitution.

Des travaux récents publiés par Leonardo Vallini et Stéphane Mazières définissent le Plateau perse, à la périphérie nord-est duquel est situé Obi-Rakhmat, comme un concentrateur de population où les ancêtres de tous les non-Africains actuels vécurent entre les premières phases de l’expansion hors d’Afrique – donc bien avant le Paléolithique supérieur – et la colonisation plus large de l’Eurasie. Cet environnement riche en ressources pourrait avoir constitué une zone de refuge propice à une régénération démographique après le goulet d’étranglement génétique de la sortie d’Afrique, à l’interaction entre les groupes et par conséquent aux innovations techniques.

Mandrin et Obi-Rakhmat représentent probablement deux extrémités géographiques et temporelles d’une phase pionnière de peuplement telle qu’entrevue par Ludovic Slimak, marquée par ce que les typologues qualifiaient jadis de fossile directeur et qui ici recouvrirait la propagation d’une invention fondamentale propre à Homo Sapiens. Jusqu’à présent passées inaperçues parce que brutes de débitage, minuscules et fragmentaires, il est à parier que les micro-pointes de projectile dont les critères de reconnaissance sont maintenant posés commenceront à apparaître dans des sites intermédiaires entre l’Asie centrale et la Méditerranée occidentale.

Prémisses d’un nouveau scénario du peuplement occidental d’Homo Sapiens

Cette découverte est stimulante à plusieurs titres. Elle valide la cohérence de l’étude du site de Mandrin qui concluait à une brève incursion en territoire néanderthalien de Sapiens armés d’arcs, mais dont plusieurs éléments avaient été critiqués – ce qui est cependant le jeu scientifique habituel lorsqu’une proposition nouvelle s’écarte par trop des connaissances admises – et dont la dimension prédictive n’avait alors pas été considérée.

La similitude des micro-pointes de Mandrin et d’Obi-Rakhmat ne peut être une simple coïncidence. Elle ne porte pas seulement sur leur forme, mais aussi sur leur mode de fabrication, qui requière un réel savoir-faire comme en témoigne la préparation minutieuse de leur plan de frappe avant débitage, et sur leur fonctionnement. On pourra débattre de l’instrument approprié au tir de flèche armées de si minuscules armatures, l’arc étant en filigrane, ou si l’on préfère garder une certaine réserve ne parler que de tir instrumenté, mais cela contraste déjà avec ce que l’on connait des armes de chasse de Néanderthal et de leur conception.

L’autre aspect remarquable, encore peu habituel, est la convergence et la complémentarité de données provenant de la culture matérielle et de la mémoire de nos gènes, qui ne purent s’influencer au regard des dates d’étude et de publication respectives. Les deux conjuguées esquissent la réécriture du scénario de l’arrivée d’Homo Sapiens en Europe : on le pensait venu directement d’Afrique par le chemin le plus court, il y a 45 000 ans, et on le découvre implanté depuis fort longtemps au cœur du continent eurasiatique, bien avant qu’il n’en sorte en quête de nouveaux territoires.

Plisson Hugues a reçu des financements du CNRS et de l'université de Bordeaux

Andrey I. Krivoshapkin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.12.2025 à 11:45

Au Louvre, la radiologue qui révèle les mystères des chefs-d’œuvre

Elisabeth Ravaud, Ingénieur de recherche, Ministère de la Culture

Texte intégral (3481 mots)

Vous l’ignorez peut-être, mais sous le Louvre, se cache un laboratoire un peu particulier, le Centre de recherche et de restauration des musées de France. Il a pour mission d’étudier, de documenter et d’aider à la restauration des œuvres des 1 200 musées de France. Benoît Tonson, chef de rubrique Science et Technologie, y a rencontré Elisabeth Ravaud. Elle est l’autrice d’un ouvrage de référence sur l’utilisation de la radiographie appliquée à l’étude des peintures « Radiography and Painting » et l’une des plus grandes spécialistes mondiales de cette discipline.

The Conversation : Vous êtes entrée au laboratoire du Louvre en 1993, pourtant à cette époque vous n’étiez ni historienne de l’art ni restauratrice…

Elisabeth Ravaud : À l’époque, je suis médecin, spécialisée en radiodiagnostic et imagerie médicale. J’ai fait mes études de médecine à Paris, à la Pitié-Salpêtrière, puis passé l’internat des hôpitaux de Paris. En parallèle de cette activité hospitalière, j’ai toujours cultivé un goût pour l’histoire de l’art. J’avais d’ailleurs entamé un cursus dans cette discipline, bénéficiant d’une équivalence en deuxième année grâce à ma thèse de doctorat : après sept ans de médecine, on y avait droit. Un jour, on m’a annoncé qu’il me fallait faire un stage. Et c’est comme ça, presque par hasard, que j’ai atterri ici.

Naturellement, je me suis intéressée à la radiographie, le seul point commun évident entre mes études médicales et l’examen des œuvres d’art. Dans le monde hospitalier, je pratiquais la radio conventionnelle, mais aussi l’échographie, l’écho-Doppler, la radiologie interventionnelle, le scanner, l’IRM… Tout un arsenal qui n’existe évidemment pas pour les œuvres. La radio, elle, constituait un vrai pont.

Quelles sont les grandes différences que vous avez pu remarquer entre l’hôpital et le laboratoire ?

E. R. : Très vite, un point m’a frappée : en lisant les rapports ou les articles produits à l’époque, j’ai eu l’impression que l’interprétation des radiographies d’œuvres se limitait aux signes les plus évidents. Par exemple, vous voyez trois personnages sur la radio, mais seulement deux sur le tableau, on en déduit qu’un personnage a été recouvert. Mais tout ce qui relevait d’une information plus subtile semblait laissé de côté. Or, je venais d’un milieu où l’image est examinée en long, en large et en travers. On n’aborde jamais l’examen d’un foie sans jeter un œil aux reins, aux poumons : l’interprétation est systématique, structurée. Cette différence méthodologique m’a immédiatement sauté aux yeux.

Autre surprise : dans les rapports, rien sur les supports, les essences de bois, la toile, les petits signes discrets… On se contentait des évidences. Et quand j’ai voulu me documenter, là où la médecine offre des bibliothèques entières, j’ai découvert qu’en imagerie d’œuvres d’art, il n’existait pratiquement aucun ouvrage. L’information était éparpillée : un peu ici, un peu là, un article isolé… rien de systématisé.

À la fin de mon stage, on m’a proposé de rester. Et si je n’avais pas perçu cette sous-exploitation de l’image, et cette absence d’outils méthodologiques, je ne suis pas sûre que j’aurais accepté : j’avais déjà un poste hospitalier. Mais je me suis dit que je pouvais peut-être apporter quelque chose, une forme d’expertise méthodologique, en faisant passer mes compétences de l’univers médical au monde du patrimoine. C’est ce sentiment qui m’a finalement convaincue.

Sur quels types d’œuvres avez-vous travaillé ?

E. R. : Avec mon parcours, tout portait à croire que je travaillerais sur des objets en volume, comme on travaille en imagerie 3D à l’hôpital, je travaillais sur des corps, donc ce qui aurait pu s’en rapprocher le plus étaient les statues. Mais non : on m’a mise sur… la peinture. Ça m’a surprise. Et en même temps, cela a eu un effet décisif : j’ai réalisé que les tableaux, que beaucoup considèrent comme des objets en deux dimensions (une hauteur et une largeur), possèdent en réalité une profondeur, essentielle à prendre en compte en radiographie. L’épaisseur de la couche picturale, les structures internes du support, l’accumulation des matériaux… tout cela forme une troisième dimension qui conditionne l’interprétation. Et c’est précisément cette profondeur, parfois réduite à quelques millimètres, qui rend l’analyse complexe. Chaque signe radiographique doit être rapporté à sa structure d’origine.

Finalement, ce retour à la radio conventionnelle, alors que je travaillais surtout en scanner et IRM, des techniques plus avancées, s’est révélé cohérent. Comme en médecine, la radiographie conventionnelle conserve son importance. Elle offre une première vision globale, oriente le diagnostic, et guide vers d’autres examens. Dans le domaine du patrimoine, elle joue ce même rôle fondamental.

Pouvez-vous nous rappeler le principe de la radiographie ?

E. R. : La radiographie est une technique d’imagerie fondée sur les rayons X, découverts en 1895 par Wilhelm Röntgen, physicien allemand travaillant à l’Université de Würzburg (Bavière). Elle consiste à produire, à partir d’un tube, un faisceau de rayons X qui traverse la matière en subissant une atténuation. Cette atténuation est décrite par la loi de Beer-Lambert. Il s’agit d’une décroissance exponentielle dépendant de l’épaisseur traversée, plus elle est grande, plus l’atténuation est forte, cette décroissance dépend également de la nature du matériau. Par exemple, un métal a un coefficient d’atténuation très élevé : en quelques dizaines de microns, il arrête presque totalement les rayons X. À l’inverse, l’air laisse passer les rayons X très facilement.

Voici le principe : un faisceau homogène traverse successivement le support, la préparation et la couche picturale. Chaque photon est atténué différemment selon les matériaux rencontrés, transformant le faisceau initialement homogène en un faisceau hétérogène. Cette hétérogénéité est ensuite enregistrée par les émulsions radiographiques ou les capteurs numériques.

Historiquement, sur film, plus l’énergie résiduelle est importante, plus l’émulsion devient noire ; à l’inverse, un matériau très absorbant, comme un clou, laisse très peu d’énergie au film, qui reste blanc. L’air apparaît donc noir, le métal blanc. La radio permet ainsi d’observer simultanément le support, la préparation et la couche picturale.

J’ai illustré cela avec la Belle Ferronnière, de Léonard de Vinci. On y voit les stries du bois de noyer, caractéristiques du support ; les stries transversales correspondant aux coups de pinceau de la préparation, destinée à régulariser la surface du support ; puis la couche picturale, reconnaissable par la forme du portrait et fortement influencée par la nature des pigments. Les carnations, en particulier, apparaissent très marquées en radiographie car elles contiennent un pigment utilisé depuis l’Antiquité jusqu’à la fin du XIXe ou le début XXe siècle : le blanc de plomb. Le plomb arrête fortement les rayons X, ce qui rend ces zones très lisibles.

C’est d’ailleurs parce que les peintres anciens utilisaient du blanc de plomb que la radiographie est si informative sur leurs œuvres. À l’inverse, les peintures acryliques contemporaines sont composées d’éléments organiques : elles se laissent traverser, ce qui rend la radiographie beaucoup moins performante.

Vous disiez qu’au moment de votre arrivée au laboratoire, on n’exploitait pas le plein potentiel de la radiographie, c’est-à-dire ?

E. R. : Ce qui m’a surprise, c’est que personne ne s’était réellement intéressé au bois. Pourtant, l’essence du panneau est essentielle, car elle constitue un véritable témoin de provenance. En Italie, les peintres utilisent généralement le peuplier ou le noyer (en Lombardie, notamment) tandis que les panneaux flamands sont réalisés en chêne. Ainsi, si on vous présente un tableau prétendument italien et que la radiographie révèle un support en chêne, on peut avoir de sérieux doutes quant à l’authenticité. Ces indices concernant les supports (bois, toile, papier) ne sont pas aussi spectaculaires que les repentirs.

Dans les années 1920–1930, la radiographie était perçue comme une « lanterne magique » : on faisait une radio et l’on découvrait trois personnages au lieu de deux, ou un bras levé au lieu d’un bras baissé. Ce caractère spectaculaire a beaucoup impressionné, et il continue d’impressionner : chaque fois que je vois une radio riche en informations cachées, il y a toujours ce « Waouh ! » Mais paradoxalement, cette fascination pour l’effet spectaculaire a plutôt freiné l’intérêt pour des signes plus modestes.

Par exemple, je peux identifier qu’un panneau a été confectionné à partir de noyer. Je peux aussi déterminer le type de préparation utilisé pour préparer les panneaux avant de les peindre : à l’époque de Léonard de Vinci, par exemple, on utilisait surtout des préparations à base de calcium alors que Léonard, lui, utilisait des préparations au blanc de plomb. Ce sont ce type de signes, plus discrets, sur lesquels j’ai passé du temps.

L’examen lui-même est simple à réaliser : l’équipement nécessaire est accessible, et on pourrait même faire une radiographie en ville, chez un radiologue. Mais ce que j’ai surtout transféré de la médecine vers le patrimoine, c’est une méthodologie, une manière d’aborder l’image de façon systématique. Les techniques, elles, sont différentes. J’ai dû réapprendre l’anatomie du tableau : ses couches, comment il est fabriqué, avec quels pigments, quelles compositions. Et ensuite, comme en médecine, voir des cas, accumuler de l’expérience. Cela a été une aventure passionnante.

Au-delà de la radiographie, utilisez-vous d’autres techniques d’imagerie ?

E. R. : La radiographie ne se suffit pas à elle-même. On la croise avec de nombreuses autres techniques d’imagerie, que j’ai dû apprendre en arrivant ici, car elles diffèrent totalement de celles du milieu médical. On ne fait pas d’IRM ni de scanner, mais on utilise des infrarouges qui permettent de pénétrer la couche picturale et de révéler le dessin préparatoire. L’ultraviolet, lui, renseigne surtout sur les matériaux en surface, comme le vernis, ou sur les retouches qui apparaissent comme des taches noires sur la fluorescence du vernis ancien.

La micro-fluorescence X consiste à exciter la matière picturale avec un rayonnement X faible. La matière réémet alors un rayonnement qui est enregistré sous forme de spectre, révélant les éléments présents : calcium, plomb, fer, cuivre, étain, strontium, argent, or, etc. Chaque point fournit la composition de tous les éléments présents. Depuis les années 2010, grâce à l’informatique, on peut faire ces mesures en déplacement continu, générant une « image cube », c’est-à-dire une cartographie complète du tableau où, en chaque point, on peut lire le spectre et isoler la présence d’un élément particulier, par exemple le mercure du vermillon.

Cette technique permet de cartographier différents pigments, comme le plomb, le cuivre ou l’étain, de manière très précise sur la couche picturale.

L’usage combiné de ces techniques a profondément amélioré l’étude fine des couches picturales, permettant d’exploiter au maximum les informations disponibles, tout en gardant la radiographie pour ses informations complémentaires.

Et toutes ces techniques, vous les avez appliquées pour étudier des tableaux de Léonard de Vinci ?

E. R. : Il faut savoir que les collections françaises possèdent cinq œuvres de Léonard de Vinci sur une quinzaine existantes dans le monde. Avoir accès à ce corpus a été une occasion exceptionnelle pour comparer sa manière de travailler au fil du temps. En radiographie, je le rappelle, l’opacité de l’image est proportionnelle à la quantité de matière présente : beaucoup de matière rend l’image opaque, peu de matière la rend transparente.

En comparant la Belle Ferronnière, la Joconde et Saint Jean-Baptiste, on observe une transparence croissante dans les radios : au fil du temps, Léonard utilise la préparation comme réflecteur de lumière, plaçant la matière avec une économie croissante mais précise pour créer des modulations subtiles. Cette information sur la quantité de matière est spécifique à la radio.

Concernant les liants (les matières qui servent à donner de la cohésion et une tenue dans le temps au dépôt de pigments sur un support), il faut savoir que jusqu’au XVe siècle, la peinture se faisait principalement à la tempera à l’œuf (on se servait de jaune d’œuf en guise de liant), liant rapide à sécher, qui obligeait à poser des coups de pinceau courts et qui produisait des couleurs opaques.

L’apparition de la peinture à l’huile a permis de poser des touches plus longues, de moduler la couleur et de créer des transparences impossibles avec la tempera. Elle est documentée dès le XIIIe siècle dans le nord de l’Europe, car dans ces régions la tempera avait tendance à moisir à cause de l’humidité.

En Italie, où le climat était plus clément, l’huile s’est imposée plus tardivement, offrant aux artistes de nouvelles possibilités expressives. Léonard de Vinci, autour de 1472-1473, figure parmi les premiers peintres florentins à utiliser l’huile, marquant ainsi un tournant dans la peinture italienne et la manière de travailler les couches et les effets de lumière.

À l’époque de Léonard, les peintres ne maîtrisaient pas encore très bien le liant et les siccatifs (substances qui jouent un rôle de catalyseur en accélérant le séchage). Ils risquaient soit d’en mettre trop, soit pas assez, et le séchage pouvait devenir problématique : trop rapide, cela provoquait des craquelures prématurées et trop lent, il fallait attendre longtemps avant de poser la couche suivante.

Les écrits de Léonard témoignent de cette inventivité constante : ses recettes de peinture montrent un véritable inventaire de techniques et d’astuces, qu’il mélangeait à des notes sur d’autres domaines. En consultant ses manuscrits pour le travail sur Léonard que nous avons effectué en 2019, on découvre à quel point ces documents sont dispersés : certaines pages contiennent beaucoup d’informations sur la peinture, d’autres seulement trois lignes sur une recette, mêlées à des calculs mathématiques, des études d’hydraulique ou des croquis divers.

Sur une même feuille, il pouvait noter une ébauche pour une Vierge à l’Enfant, un calcul algébrique, un projet hydraulique, et bien d’autres idées, ce qui donne l’impression qu’il avait cent idées à la minute qu’il couchait toutes en vrac.

Grâce à toutes ces lectures, vous êtes capable de reproduire la peinture utilisée par Léonard ?

E. R. : Je me suis particulièrement intéressée à un aspect très spécifique des peintures de Léonard, les grains de verre. On savait déjà que certains peintres, notamment au XVIe siècle, en ajoutaient dans leurs peintures, mais les publications existantes se contentaient de constater leur présence sans vraiment l’expliquer.

Cela m’a amené à me poser la question : à quoi servaient réellement ces grains de verre ? Pour y répondre, j’ai monté un projet de recherche visant à comprendre leur rôle, en testant trois hypothèses principales. La première était que les grains de verre pouvaient modifier la rhéologie de la peinture, c’est-à-dire la manière dont elle se comporte sous le pinceau. La deuxième supposait qu’ils favorisaient le séchage, ce qui était une problématique importante avec le nouveau liant à l’huile utilisé à l’époque. La troisième portait sur la transparence, car le verre est un matériau naturellement transparent et pourrait influencer l’effet visuel.

Les résultats ont montré que les grains de verre n’altèrent pas la texture de la peinture, ce qui est un avantage. Le peintre peut les incorporer sans modifier son geste ou son « écriture ». En revanche, ils favorisent un séchage doux, moins rapide et moins problématique que celui produit par d’autres siccatifs. Sur le plan de la transparence, les analyses optiques ont confirmé que l’ajout de verre fonctionne comme l’ajout d’huile, mais sans entraîner les complications de séchage : l’indice de réfraction du verre et de l’huile étant similaire, la peinture gagne en transparence tout en restant stable. Étant donné l’intérêt constant de Léonard pour la lumière et les effets optiques, je suis convaincue que cette transparence jouait un rôle central et constituait un argument important dans ses choix techniques.

Elisabeth Ravaud ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

08.12.2025 à 16:16

L’intelligence artificielle au service de la médecine régénérative pour concevoir de nouvelles protéines

Jad Eid, Professeur de biophysique et bio-informatique, École de Biologie Industrielle (EBI)

Texte intégral (2057 mots)

Comment aider notre corps à se réparer après une blessure ? Trouver et produire les bonnes molécules qui stimulent la régénération cellulaire reste un défi pour la médecine régénérative. Mais l’intelligence artificielle assiste maintenant les chercheurs pour réussir à concevoir le composé chimique idéal.

La médecine pourra-t-elle un jour réparer durablement des tissus ou des organes gravement blessés ? Derrière cette question se cache un enjeu central de la médecine régénérative : contrôler finement le comportement des cellules. C’est ce qui permettra de maîtriser des processus déterminants tels que la cicatrisation, la croissance de nouveaux tissus ou encore la capacité des cellules à bien s’accrocher à leur environnement.

Lorsqu’un tissu est endommagé, les cellules ne savent pas, à elles seules, comment s’organiser pour le réparer. Elles s’appuient pour cela sur les signaux présents dans leur environnement immédiat, la matrice extracellulaire. Cette matrice est formée d’un réseau dense de protéines et de sucres qui non seulement soutient physiquement les cellules, mais leur fournit aussi des informations essentielles pour s’orienter, s’agréger ou migrer. À cette échelle, elle joue un rôle comparable à une cartographie biologique : elle indique aux cellules où aller, comment se fixer et quelles fonctions activer pour que la réparation tissulaire puisse se dérouler correctement. Mais parfois, ces mécanismes échouent à régénérer complètement les tissus.

Et si l’intelligence artificielle (IA) pouvait nous aider à franchir un cap dans ce domaine ? Aujourd’hui, les chercheurs explorent une voie émergente : concevoir, avec l’aide de l’IA, de nouvelles protéines capables de guider et de stimuler la régénération des tissus abîmés, là où les cellules ne réagissent plus spontanément. L’objectif est d’imaginer des molécules qui envoient aux cellules les bons signaux, au bon endroit et au bon moment, pour relancer un processus de réparation insuffisant ou défaillant.

Imaginer de nouvelles protéines pour guider les cellules

À terme, cette nouvelle façon de concevoir des protéines, appuyée par l’IA, pourrait contribuer au développement d’implants dits intelligents, de pansements bioactifs ou de thérapies personnalisées capables de dialoguer avec les cellules du patient. On peut imaginer, par exemple, un implant conçu pour interagir finement avec la matrice et les récepteurs cellulaires, afin d’accélérer la régénération d’un tissu après une chirurgie ou une blessure, de manière rapide, contrôlée et durable.

Au sein du laboratoire EBInnov de l’École de biologie industrielle, nous concevons des protéines simplifiées. Plutôt que d’utiliser une protéine naturelle dans son intégralité – qui sera fragile, longue et complexe à produire – nous en découpons les parties utiles qui permettent aux cellules de s’accrocher, de se déplacer vers une zone à réparer ou de recevoir un signal pour activer la cicatrisation. Cette stratégie repose sur le génie génétique : nous modifions et réassemblons l’ADN codant la protéine, puis nous l’exprimons biologiquement en laboratoire grâce à des bactéries modifiées.

Le recours à cette approche est motivé par deux impératifs scientifiques et industriels. D’un côté, nous obtenons une molécule plus simple, plus stable et plus facile à fabriquer que la protéine complète. De l’autre, nous pouvons tester plus précisément les fonctions que nous visons sans être perturbés par des régions de la protéine d’origine qui ne sont pas nécessaires, voire parfois gênantes.

La migration cellulaire se joue à petite échelle : il s’agit d’un déplacement local sur quelques micromètres, réalisé par des cellules de la peau ou du tissu conjonctif qui se dirigent vers une zone lésée pour déclencher la réparation du tissu. Ce guidage repose sur la signalisation cellulaire, un langage biochimique basé sur la reconnaissance et l’échange de motifs moléculaires, permettant aux cellules d’activer les bonnes réponses au bon moment. C’est ce langage que nous essayons d’apprendre et de maîtriser.

Un avantage majeur : tester virtuellement les molécules

Observer expérimentalement la structure 3D et les interactions entre protéines reste aujourd’hui lent et coûteux, car ces approches nécessitent des infrastructures lourdes et de l’expertise. À l’inverse, les méthodes récentes d’IA permettent d’inférer des formes tridimensionnelles très réalistes et très précises à partir de larges jeux de données.

Ces modèles apprennent les règles statistiques et physiques du repliement moléculaire, en s’entraînant sur des milliers de structures biologiques déjà élucidées. Cela fournit un avantage stratégique : évaluer virtuellement si une molécule conçue conservera ses zones d’interaction correctement exposées et atteignables par les récepteurs cellulaires, avant de la produire au laboratoire, réduisant ainsi le nombre d’essais exploratoires nécessaires in vitro.

Cette synergie entre design génétique simplifié, modélisation 3D par IA et simulations d’interactions moléculaires nous permet de rationaliser nos choix expérimentaux et d’anticiper la compatibilité biologique des protéines. Cela accélère aussi la conception de nouvelles biomolécules pour des matériaux thérapeutiques et cosmétiques bioactifs, tout en renforçant une ingénierie moléculaire guidée par les données et la simulation.

Prédire le repliement des protéines grâce à l’IA

Comprendre l’efficacité d’une protéine conçue en laboratoire impose de relier deux échelles : celle du corps humain et celle des interactions moléculaires, où tout se joue à la taille de quelques atomes et de quelques nanomètres. Une protéine est une chaîne d’éléments minuscules, des acides aminés, qui s’assemblent puis se plient spontanément pour former une architecture 3D. C’est cette forme qui lui permet ensuite d’agir comme un point d’ancrage, un message chimique ou un guide pour les cellules qui doivent réparer un tissu.

Un point essentiel est donc la prédiction de la structure tridimensionnelle de la protéine, c’est-à-dire la façon dont elle va se replier dans l’espace en fonction de la séquence d’acides aminés qui la composent. Cette tâche, historiquement difficile, a connu une transformation radicale avec l’émergence des modèles d’intelligence artificielle. Ces modèles sont entraînés sur de vastes bases de données combinant des séquences d’acides aminés et des structures déjà connues expérimentalement. Ils apprennent ainsi à établir un lien statistique entre la séquence et la forme finale de la protéine.

Concrètement, ils sont capables de prédire comment une protéine va se replier, un peu comme si l’on devinait la forme finale d’un origami complexe en ne connaissant que les plis de départ. Ils fournissent une forme 3D plausible en estimant, avec une grande précision, les distances entre acides aminés, les angles de repliement locaux et l’organisation spatiale des différentes régions de la protéine.

Dans notre projet, ces prédictions constituent une première évaluation critique de la cohérence structurale de la molécule que nous concevons expérimentalement. Elles nous permettent d’identifier les zones où les différentes parties de la molécule s’articulent entre elles et de repérer d’éventuels conflits de forme où une zone en gênerait une autre. Nous pouvons aussi localiser des régions potentiellement désordonnées ou trop flexibles et anticiper l’impact de ces caractéristiques sur la stabilité globale de la protéine et sur l’accessibilité de ses zones d’interaction.

Simuler les interactions dans un contexte biologique réaliste

Une molécule n’agit jamais seule : son efficacité dépend de sa capacité à interagir avec d’autres partenaires biologiques, au sein d’un environnement dense comme la matrice extracellulaire, où de nombreuses protéines, récepteurs et signaux coexistent en permanence.

C’est pourquoi, au-delà de la structure isolée, nous avons utilisé des approches de modélisation pour étudier comment notre molécule se comporte au contact de différents partenaires clés de la matrice. Cette phase d’analyse des interactions est essentielle : l’efficacité biologique d’une molécule dépend non seulement de sa capacité à se lier à ses cibles, mais aussi de la stabilité de ces liaisons dans le temps et de leur bonne compatibilité avec les récepteurs concernés.

Pour nous rapprocher des conditions biologiques réelles, nous avons simulé des systèmes complexes proches des tissus réels où des dizaines ou centaines de protéines identiques interagissent en même temps avec leurs cibles. Cela permet d’explorer des phénomènes de coopération entre molécules, de tester la robustesse des contacts lorsqu’elles sont nombreuses et d’analyser comment les domaines actifs se répartissent dans un espace tridimensionnel dense. Cette simulation nous permet de déterminer si les multiples copies de la protéine restent capables d’interagir ensemble sans perdre leur lisibilité biologique et sans se gêner physiquement.

Ces simulations fournissent des indices précieux sur la capacité de la molécule à maintenir des interactions efficaces malgré les contraintes physiques et géométriques de son environnement. Elles nous permettent de rationaliser la conception expérimentale, d’écarter certains scénarios peu prometteurs avant de passer à la paillasse, et ainsi de mieux cibler les expériences in vitro qui seront réellement informatives.

Vers une ingénierie moléculaire augmentée par l’IA

Ces approches ne remplacent pas l’expérience : elles nous permettent surtout de comprendre à l’avance si une molécule produite par génie génétique a la bonne forme, si elle garde ses zones d’action accessibles, et si elle peut maintenir des interactions solides dans un environnement aussi encombré que la matrice extracellulaire du corps humain. En bref, l’IA nous aide à mieux concevoir et à éviter de tester à l’aveugle, pour que les expériences menées ensuite sur de vraies cellules soient plus ciblées, pertinentes et rapides.

Si l’IA ouvre aujourd’hui un champ immense pour concevoir des protéines bioactives et des matériaux capables d’orienter la réparation des tissus, plusieurs verrous persistent encore dans la recherche académique. En premier lieu, il reste difficile de prédire la dynamique de la conformation des protéines sur de très longues échelles de temps. Un autre obstacle réside dans notre capacité à modéliser fidèlement tous les composants d’un tissu réel. Les prochaines étapes consistent donc à renforcer encore cette boucle vertueuse entre IA et biologie expérimentale, en intégrant davantage de données biologiques, en évaluant plus finement la tenue des interactions multiples et en préparant les validations in vitro les plus informatives possible.

Jad Eid ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview