ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

02.10.2025 à 09:03

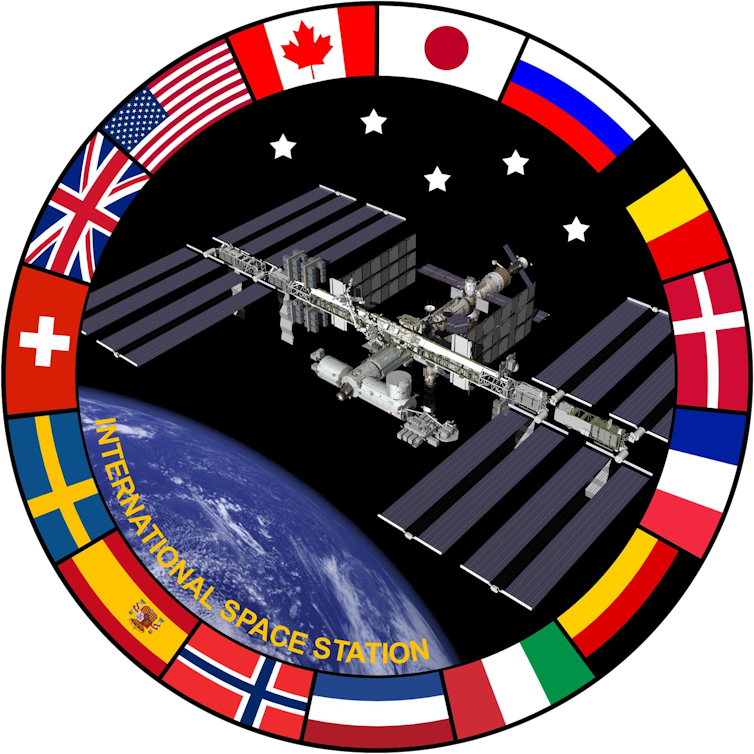

La Station spatiale internationale vit ses dernières années. En 2030, elle sera désorbitée. Vingt-cinq ans d’occupation continue laisseront alors place à une nouvelle ère, celle des stations spatiales commerciales. Depuis novembre 2000, la Nasa et ses partenaires internationaux assurent sans interruption une présence humaine en orbite basse, avec toujours au moins un Américain à bord. Une continuité qui fêtera bientôt ses 25 ans. Dans l’histoire de l’exploration spatiale, la Station spatiale internationale (ISS) apparaît sans doute comme l’une des plus grandes réalisations de l’humanité, un exemple éclatant de coopération dans l’espace entre les États-Unis, l’Europe, le Canada, le Japon et la Russie. Mais même les plus belles aventures ont une fin. En 2030, la Station spatiale internationale sera désorbitée : elle sera dirigée vers une zone isolée du Pacifique. Je suis ingénieur en aérospatiale et j’ai contribué à la conception de nombreux équipements et expériences pour l’ISS. Membre de la communauté spatiale depuis plus de trente ans, dont dix-sept au sein de la Nasa, il me sera difficile d’assister à la fin de cette aventure. Depuis le lancement des premiers modules en 1998, la Station spatiale internationale a été le théâtre d’avancées scientifiques majeures dans des domaines tels que la science des matériaux, la biotechnologie, l’astronomie et l’astrophysique, les sciences de la Terre, la combustion et bien d’autres encore. Les recherches menées par les astronautes à bord de la station et les expériences scientifiques installées sur sa structure extérieure ont donné lieu à de nombreuses publications dans des revues à comité de lecture. Certaines ont permis de mieux comprendre les orages, d’améliorer les procédés de cristallisation de médicaments essentiels contre le cancer, de préciser comment développer des rétines artificielles en apesanteur, d’explorer la production de fibres optiques ultrapures et d’expliquer comment séquencer l’ADN en orbite. Au total, plus de 4 000 expériences ont été menées à bord de l’ISS, donnant lieu à plus de 4 400 publications scientifiques destinées à améliorer la vie sur Terre et à tracer la voie de futures activités d’exploration spatiale. La station a démontré toute la valeur de la recherche conduite dans l’environnement unique des vols spatiaux – marqué par une très faible gravité, le vide, des cycles extrêmes de température et des radiations – pour faire progresser la compréhension d’une large gamme de processus physiques, chimiques et biologiques. Avec le retrait annoncé de la station, la Nasa et ses partenaires internationaux n’abandonnent pas pour autant leur avant-poste en orbite terrestre basse. Ils cherchent au contraire des alternatives pour continuer à exploiter le potentiel de ce laboratoire de recherche unique et prolonger la présence humaine ininterrompue maintenue depuis 25 ans à quelque 402 kilomètres au-dessus de la Terre. En décembre 2021, la Nasa a annoncé trois contrats visant à soutenir le développement de stations spatiales privées et commerciales en orbite basse. Depuis plusieurs années, l’agence confie déjà le ravitaillement de l’ISS à des partenaires privés. Plus récemment, elle a adopté un dispositif similaire avec SpaceX et Boeing pour le transport d’astronautes à bord respectivement de la capsule Dragon et du vaisseau Starliner. Fort de ces succès, la Nasa a investi plus de 400 millions de dollars pour stimuler le développement de stations spatiales commerciales, avec l’espoir de les voir opérationnelles avant la mise hors service de l’ISS. En septembre 2025, la Nasa a publié un projet d’appel à propositions pour la phase 2 des partenariats concernant les stations spatiales commerciales. Les entreprises retenues recevront des financements pour réaliser les revues critiques de conception et démontrer le bon fonctionnement de stations capables d’accueillir quatre personnes en orbite pendant au moins trente jours. La Nasa procédera ensuite à une validation et une certification formelles afin de garantir que ces stations répondent à ses normes de sécurité les plus strictes. Cela permettra ensuite à l’agence d’acheter des missions et des services à bord de ces stations sur une base commerciale – de la même manière qu’elle le fait déjà pour le transport de fret et d’équipages vers l’ISS. Reste à savoir quelles entreprises réussiront ce pari, et selon quel calendrier. Pendant que ces stations verront le jour, les astronautes chinois continueront à vivre et à travailler à bord de leur station Tiangong, un complexe orbital habité en permanence par trois personnes, évoluant à environ 400 kilomètres au-dessus de la Terre. Si la continuité habitée de l’ISS venait à s’interrompre, la Chine et Tiangong prendraient ainsi le relais comme station spatiale habitée sans discontinuité la plus ancienne en activité. Tiangong est occupée depuis environ quatre ans. Il faudra encore plusieurs années avant que les nouvelles stations spatiales commerciales n’encerclent la Terre à environ 28 000 kilomètres par heure et avant que l’ISS ne soit désorbitée en 2030. D’ici là, il suffit de lever les yeux pour profiter du spectacle. Lors de ses passages, l’ISS apparaît la plupart des nuits comme un point bleu-blanc éclatant, souvent l’objet le plus brillant du ciel, traçant silencieusement une courbe gracieuse à travers la voûte étoilée. Nos ancêtres n’auraient sans doute jamais imaginé qu’un jour, l’un des objets les plus lumineux du ciel nocturne serait conçu par l’esprit humain et assemblé par la main de l’homme. John M. Horack a reçu des financements de recherche externes de la NASA, de Voyager Technologies et d’autres organismes liés au domaine spatial, dans le cadre de son travail de professeur à l’Université d’État de l’Ohio. Texte intégral 2310 mots

Maintenir une présence en orbite

L’aube des stations spatiales commerciales

En attendant, levons les yeux

![]()

01.10.2025 à 11:49

Comment débutent les cancers du sein ? Conversation avec la biochimiste Alexandra Van Keymeulen

Alexandra Van Keymeulen est biochimiste et spécialiste du cancer du sein. Avec son équipe, elle explore les étapes extrêmement précoces dans le développement des tumeurs, bien avant que celles-ci ne soient détectables. Elle a reçu Elsa Couderc, cheffe de rubrique Science et Technologie, pour expliquer simplement ce qu’est un cancer, et les avancées de la recherche depuis qu’elle a débuté dans le domaine. The Conversation France : Aujourd’hui, vous êtes une spécialiste reconnue sur l’origine du cancer du sein, mais vous n’avez pas commencé vos recherches par là. Alexandra Van Keymeulen : J’ai fait ma thèse, en Belgique, sur la thyroïde. J’étudiais les mécanismes qui font que les cellules thyroïdiennes prennent la décision de se diviser. Comme les cellules ne sont pas immortelles, qu’elles vivent moins longtemps que nous, il y a sans arrêt des cellules qui meurent et, donc, des cellules qui se divisent pour donner naissance à de nouvelles cellules. Dans une thyroïde saine, les cellules prennent en permanence la décision de se diviser ou non pour donner naissance à la prochaine génération de cellules. Je travaillais sur les thyroïdes saines, mais dans un groupe où d’autres personnes étudiaient le cancer de la thyroïde. En effet, les mécanismes de division cellulaire sont dérégulés dans le cas d’un cancer : les cellules se divisent de manière anarchique, sans contrôle. Elles forment une masse, un peu comme un mini-organe. Elles ne répondent plus aux signaux environnants qui leur indiquent de stopper leur croissance. La division cellulaire incontrôlée est la première étape pour former une tumeur. Mais une tumeur bénigne n’est pas appelée « cancer ». Un cancer a aussi des caractéristiques invasives, c’est-à-dire que ces cellules migrent et envahissent les autres tissus. Et justement, après ma thèse, je suis partie cinq années à San Francisco en postdoctorat. Là, j’ai travaillé sur la migration cellulaire. Je ne travaillais toujours pas sur des cellules cancéreuses, mais sur les mécanismes intrinsèques, au sein des cellules, qui font qu’elles se déplacent d’un organe à l’autre ; typiquement, ce sont les cellules du système immunitaire qui se déplacent pour aller au site de l’infection. Ce sont ces mécanismes-là qui sont piratés par les cellules cancéreuses pour former des métastases. Les cellules cancéreuses migrent moins vite que des cellules du système immunitaire, mais elles arrivent à se déplacer. Après avoir étudié la division cellulaire et la migration des cellules saines, vous êtes rentrée en Belgique pour étudier les cancers du sein ? A. V. K. : Oui, je suis rentrée en même temps que Cédric Blanpain et j’ai rejoint l’équipe qu’il était en train de monter. Il est spécialiste du cancer de la peau. Très vite, j’ai décidé de travailler sur le sein, qui n’est pas si différent que ça de la peau, car ces deux organes sont composés de cellules épithéliales. Ils ont des caractéristiques communes et donc on peut utiliser les mêmes souris pour les projets qui ont trait au cancer de la peau ou au cancer du sein. À ce stade, c’était nouveau pour vous comme organe d’étude ? A. V. K. : Tout était nouveau ! Travailler sur le sein était nouveau, mais je n’avais jamais travaillé non plus avec des souris. Et quelles étaient les grandes questions de la recherche sur le cancer du sein à l’époque ? Qu’est-ce que vous cherchiez à savoir, dans ce tout nouveau labo, en 2006 ? A. V. K. : La grande question, c’était de savoir quelles cellules sont à l’origine des cancers du sein. Il y avait déjà à l’époque deux hypothèses. En vingt ans, on a répondu à certaines choses, mais ces deux hypothèses sont toujours là aujourd’hui. Pourquoi y a-t-il différents types de cancer du sein ? Est-ce parce que les patients ont eu différentes mutations génétiques ou parce que les mutations sont survenues dans différents types de cellules de la glande mammaire ? On pourrait avoir aussi une combinaison de ces deux explications. En ce qui concerne les mutations, on avait déjà repéré que certaines mutations génétiques sont liées à certains types de cancers du sein chez l’humain : on dit que la mutation a un impact sur l’issue tumorale. Pour explorer l’autre hypothèse – quelles sont les cellules à l’origine d’un cancer, il a d’abord fallu comprendre comment se renouvellent les cellules dans la glande mammaire. Est-ce que tous les types de cellules de la glande mammaire sont maintenus par un seul type de cellule souche, ou bien est-ce qu’à chaque type de cellule correspond une cellule souche ? On appelle ça la « hiérarchie cellulaire ». Comment étudiez-vous d’où viennent les cellules de la glande mammaire et comment elles se renouvellent tout au cours de la vie, pendant une grossesse, l’allaitement, etc. ? A. V. K. : On a fait du « traçage de lignée » (lineage tracing, en anglais), qui est notre grande spécialité au laboratoire. Cette technique consiste à introduire un marqueur fluorescent dans une cellule. Comme ce marqueur fluorescent est dû à une mutation génétique, le marquage est irréversible : une fois que la cellule est fluorescente, elle va le rester toute sa vie. Et surtout, si elle se divise, toute sa progéniture va être fluorescente aussi… ce qui va nous permettre de suivre le devenir d’une cellule ! Si on a ciblé une cellule qui ne se divise plus, elle va être éliminée après quelques semaines et on n’aura plus de fluorescence. Par contre, si on a ciblé une cellule souche, on va voir qu’elle va donner naissance à de nouvelles cellules qui vont également être fluorescentes. Avec cette technique, on a pu étudier comment les glandes mammaires sont maintenues au cours du temps et démontrer, en 2011, que ce sont différents types de cellules souches qui renouvellent la glande mammaire. C’était vraiment un changement de paradigme, car on croyait à l’époque qu’en haut de la hiérarchie cellulaire de la glande mammaire, il y avait des cellules souches « multipotentes » (c’est-à-dire, capables de se différencier en plusieurs types de cellules). On sait aujourd’hui qu’il y a trois types de cellules souches dans la glande mammaire, qui se différencient chacune en un seul type de cellule. Quels sont ces trois types de cellules dans le sein ? A. V. K. : Les glandes mammaires contiennent un réseau de tuyaux reliés au mamelon, et qui vont produire le lait à l’intérieur du tube pour l’expulser. Un premier type de cellules est celui des « cellules basales », aussi appelées myoépithéliales, qui ont des propriétés contractiles et vont se contracter au moment de l’allaitement pour expulser le lait. Puis, à l’intérieur des tubes, se trouve la couche luminale, qui est composée de deux types de cellules : celles qui sont positives aux récepteurs aux œstrogènes et celles qui sont négatives aux récepteurs aux œstrogènes. Les positives vont sentir la présence des hormones et relayer les signaux hormonaux aux autres cellules, pour dire « Maintenant, on se divise tous ensemble ». Les négatives sécrètent du lait pendant l’allaitement. Donc aux trois types de cellules dans le sein correspondent trois types de cellules souches « unipotentes ». Mais en ce qui concerne la formation de tumeurs cancéreuses : comment étudiez-vous une tumeur avant même qu’elle existe ? Vous avez une machine à remonter le temps ? A. V. K. : Eh non ! Il faut prédisposer les souris aux tumeurs. Pour cela, on utilise des souris transgéniques, avec une mutation génétique dont on sait qu’elle est favorable à un cancer du sein. On insère la mutation soit dans les cellules luminales, soit dans les cellules basales. Et on a montré que le type de cancer développé n’est pas le même lorsque la mutation est introduite dans les cellules luminales ou basales. Comment ça se passe en pratique ? Vous induisez une mutation génétique, mais vous ne pouvez pas être sûre que chaque souris va développer un cancer. Est-ce qu’il faut tuer la souris avant qu’elle développe un cancer, ou on peut faire des prélèvements ? A. V. K. : Effectivement, toutes les souris prédisposées ne développent pas de cancers. Pour savoir comment ça évolue, nous palpons les souris – comme les palpations qui accompagnent les mammographies dans les examens pour les femmes. Il existe aussi des PET-scanners pour souris, mais mon laboratoire n’est pas équipé. Si on palpe une tumeur, alors on tue la souris afin de prélever la tumeur et d’étudier le type de cancer qui a été provoqué par la mutation que nous avions induite. C’est comme cela que nous avons démontré, en 2015, qu’une même mutation n’a pas le même effet si elle est introduite sur une cellule basale ou sur une cellule luminale. Ensuite on a développé un outil pour cibler les cellules luminales, qui sont divisées en deux types, comme on l’a vu : celles qui sont positives aux récepteurs aux œstrogènes et celles qui sont négatives aux récepteurs aux œstrogènes. C’est ce que nous avons publié en 2017. On s’est posé la même question que précédemment : est-ce qu’une même mutation génétique provoque des types de cancers différents ? Ce sont des recherches qui sont encore en cours, mais, à nouveau, nos résultats semblent montrer que l’issue tumorale dépend de la cellule dans laquelle survient la première mutation. Vous avez étudié plusieurs mutations connues pour favoriser les cancers du sein ? A. V. K. : On connaît aujourd’hui des dizaines de mutations génétiques responsables de cancers du sein. Les étudier toutes va prendre du temps, d’autant que cette librairie de mutations est peut-être non exhaustive. Pour l’instant, nous avons étudié une seule mutation, qui est l’une des plus courantes dans le cancer du sein chez la femme.

À lire aussi :

Cancer du sein : une nouvelle étude révèle un risque génétique chez les femmes africaines

Est-ce que vous interagissez avec les médecins, avec les patientes ? A. V. K. : Avec les médecins, oui, bien sûr. On se retrouve aux conférences, et certains de mes collègues sont médecins à l’hôpital universitaire de l’Université libre de Bruxelles, juste à côté de notre laboratoire. Quand j’ai des résultats, je vais en discuter avec un spécialiste du cancer du sein chez l’humain pour essayer de trouver la pertinence pour des cancers chez l’humain. Je fais aussi partie des experts scientifiques bénévoles pour la Fondation contre le cancer belge – ça fait partie des missions d’un chercheur à l’université que de prendre ce genre de rôle. Les patientes, je les rencontre plutôt pour de la vulgarisation, avec la Fondation contre le cancer, qui organise tous les ans des visites de laboratoire. Il y a aussi le Télévie, un organisme inspiré du Téléthon, en Belgique francophone et au Luxembourg, où on côtoie des patients et des bénévoles lors d’événements. Ces organismes sont aussi des financeurs de nos recherches. La prévention est un thème qui me tient à cœur, puisqu’un cancer du sein sur quatre pourrait être évité en éliminant le tabac, l’alcool, le surpoids et en faisant régulièrement de l’activité physique. En particulier, le fait que même une consommation légère d’alcool augmente le risque de cancer du sein est encore très méconnu du grand public, mais démontré scientifiquement.

À lire aussi :

Pourquoi l’alcool augmente le risque de cancer, et ce, dès le premier verre

On entend beaucoup parler de certains cancers du sein qui sont liés à des prédispositions génétiques… A. V. K. : En fait, il n’y a que 10 % des cancers du sein qui viennent de prédispositions génétiques, c’est-à-dire des mutations présentes depuis la naissance, comme c’est le cas d’Angelina Jolie. La grande majorité des cancers provient de mutations génétiques qui ont lieu au cours de la vie, par exemple à cause de cassures de l’ADN qui sont liées à la consommation de tabac et d’alcool, et qui ont été mal ou pas réparées par l’organisme. Or, plus un cancer est pris tôt, plus les chances de guérison sont grandes et plus le traitement sera léger. D’où l’intérêt de notre travail sur les étapes extrêmement précoces dans le développement d’une tumeur… mais aussi l’importance pour le patient de consulter dès l’apparition de symptômes. Justement, vous disiez tout à l’heure que les grandes questions sur l’origine des cancers du sein, qui prévalaient au début de votre carrière, étaient toujours d’actualité aujourd’hui ? A. V. K. : Tout à fait. Quand on introduit une mutation dans les souris, on doit attendre plusieurs mois – parfois six mois ou un an – avant d’observer l’apparition d’une tumeur. Mais on ne sait pas encore ce qui se passe dans la glande mammaire pendant ce temps-là. C’est pour cela que je disais tout à l’heure que la question que nous nous posions il y a vingt ans demeure dans une certaine mesure : on cherche toujours ce qu’il se passe dans les cellules qui sont à l’origine du cancer. En fait, on observe que la mutation change complètement le comportement de ces cellules. La structure extérieure macroscopique de la glande mammaire reste la même, mais, à l’intérieur, les cellules sont tout à fait reprogrammées. Elles deviennent beaucoup plus plastiques, multipotentes – c’est-à-dire qu’elles peuvent donner lieu aux autres types cellulaires. L’idée serait d’avoir une « fenêtre de tir » thérapeutique entre la mutation et le développement d’une tumeur ? A. V. K. : Tout à fait : si on comprend ce qui se passe pendant cette période-là, on pourrait imaginer des outils de diagnostic. Par exemple, pour les femmes qui sont prédisposées génétiquement, comme Angelina Jolie, plutôt que d’enlever les seins et les ovaires, on aimerait pouvoir les surveiller de près et, dès que l’on verrait apparaître certaines de ces étapes précoces, intervenir avec un traitement préventif pour inhiber le développement d’une tumeur cancéreuse. À l’heure actuelle, ça reste hypothétique : nous sommes un laboratoire de recherche fondamentale. Aujourd’hui, on essaye de comprendre ce qui se passe entre l’introduction de la mutation et le début de la tumeur. Auparavant, on devait se contenter d’étudier les tumeurs elles-mêmes, car nous n’avions pas les outils pour étudier cette fenêtre de six mois – je précise que cette durée est évaluée chez les souris, pas chez les humains. Pour mener à un cancer, il faut une mutation génétique dans une seule cellule, ou bien la même mutation dans plein de cellules différentes, une accumulation progressive ? A. V. K. : Il faut plusieurs mutations dans une seule cellule – s’il ne fallait qu’une mutation dans une cellule, tout le monde aurait des cancers partout ! C’est une accumulation de probablement sept ou huit mutations bien spécifiques. Mais quand une cellule est mutée, souvent ce qu’on observe, c’est que ces mutations donnent un avantage à ces cellules par rapport aux cellules avoisinantes. Des études récentes montrent par exemple des « taches » dans la peau des paupières, invisibles à l’œil nu. Ce sont des zones de la peau où toutes les cellules ont les mêmes mutations. Elles proviennent d’une seule et même cellule, qui s’est divisée, au détriment des cellules avoisinantes : en se divisant, les descendantes de la cellule mutée poussent les autres et propagent les mutations. C’est aussi vrai pour d’autres organes, notamment la glande mammaire. Aujourd’hui, sur les étapes précoces des cancers du sein, nous cherchons donc à savoir comment les cellules à l’origine du cancer sont reprogrammées génétiquement et comment cela leur confère un avantage par rapport aux cellules saines. On explore ainsi petit à petit les grandes étapes qui mènent à une tumeur. Alexandra Van Keymeulen est consultant scientifique de Cancer State Therapeutics.

Ses recherches bénéficient du soutien financier du FNRS, Télévie, Fondation contre le Cancer et du Fonds Gaston Ithier. Texte intégral 3154 mots

Qu’est-ce qu’une cellule souche ?

![]()

01.10.2025 à 11:10

Titanic : le navire qui cache la flotte d’épaves en danger

L’épave du « Titanic » est en danger et pourrait se briser d’ici 2030. Ce n’est pourtant qu’un cas parmi des millions d’autres. Saviez-vous que les bactéries sont impliquées dans la dégradation des épaves, mais aussi dans leur transformation en oasis de vie ? Mieux connaître ces microorganismes et leurs interactions avec les navires est urgent pour protéger notre patrimoine historique. La découverte de l’épave du RMS Titanic en 1985 a provoqué un engouement extraordinaire autour de ce navire, son histoire, sa fin tragique et le repos de cette épave dans l’obscurité des profondeurs glacées de l’Atlantique. Les images ont révélé un navire brisé recouvert d’étranges concrétions ressemblant à des stalactites de rouille appelées rusticles. Elles sont faites notamment à partir du métal de l’épave et leur origine est liée aux microorganismes qui utilisent le fer de l’épave pour leur développement, participant ainsi à la corrosion. Les interactions entre les bactéries et les matériaux sont au cœur de mes recherches. Les bactéries qui se multiplient à la surface des matériaux peuvent participer à leur protection ou à leur dégradation. Le cas du fer est particulier, car c’est un élément indispensable aux êtres vivants. Mais la biocorrosion, conséquence de son utilisation par les microorganismes, est un phénomène qui touche de nombreux secteurs : industries, installations en mer, sur terre ou souterraines… et bien sûr les épaves métalliques. Les plongées successives sur le Titanic ont montré un affaiblissement des structures de l’épave rongées par la corrosion et son effondrement a été évoqué pour 2050, voire 2030. Ceux qui se passionnent pour le Titanic s’alarment : comment sauver cette épave ? Et d’ailleurs, pourquoi faudrait-il sauver le Titanic ? Pourquoi sauver une épave ? Parce qu’elle nous touche, parce qu’elle provoque en nous des sensations, de l’émerveillement. Une épave, c’est un souvenir, un témoin d’une histoire, d’un événement, un vestige d’une création humaine qui a eu une fin le plus souvent tragique. Tout comme un monument historique à terre, une épave gisant sous les eaux témoigne de notre histoire. La différence, c’est que si tout le monde peut voir le monument, très rares sont ceux qui peuvent voir l’épave. Et pourtant, elle est là, artéfact de notre patrimoine historique. Aux termes de notre législation, c’est un bien culturel maritime. Selon la charte de l’Unesco de 2001, ratifiée par la France en 2013, elle peut faire partie du patrimoine culturel immergé. À ces titres, elle doit être protégée. Est-ce tout ? Non, loin de là. Une épave peut aussi être porteuse d’économie, par les activités de loisirs qui sont menées autour d’elle, comme la plongée sous-marine, ou comme site de ressources halieutiques. Dès le moment où l’épave se pose sur le fond, sa colonisation commence. Ce sont d’abord des microorganismes planctoniques qui se fixent sur les surfaces. Cette première étape favorise l’arrivée d’autres organismes, notamment des larves d’animaux vivant fixés sur des substrats durs, comme les gorgones ou les coraux, ainsi que des algues. Tout ce petit monde va attirer ceux qui s’en nourrissent, puis les prédateurs de ces derniers et ainsi de suite… pour aboutir à la formation d’un véritable écosystème récifal, dont les limites sont approximativement celles du site de l’épave, même si la zone d’influence de cet écosystème peut aller bien au-delà. L’épave se transforme en un récif animé, une oasis de vie gisant sur un morne fond de sable à l’apparence d’un désert sous-marin. Ainsi vont les choses, tant que l’épave tient bon. Tempêtes, filets de pêche, corrosion, avec le temps l’épave s’affaiblit et commence à craquer, d’abord dans ses parties les moins solides, puis dans son ossature. C’est la vie ! Ou justement, c’est la fin de la vie… En perdant ses volumes, l’épave offre de moins en moins de surfaces dures à la colonisation. Les populations d’organismes fixés décroissent, ce qui rend le récif moins attirant pour leurs prédateurs. Plus l’épave se désagrège, plus l’oasis de vie se réduit, jusqu’à disparaître avec le vestige. Plus de vestige, plus d’écosystème récifal, donc, mais encore ? Moins d’attrait pour les plongeurs et pour les pêcheurs, donc moins d’intérêt économique. En enfin, c’est la disparition d’un témoignage de notre histoire, d’une partie de notre patrimoine. Lorsqu’un monument historique tombe en ruine, il se trouve souvent quelqu’un pour tenter de le sauver de l’oubli. Pourquoi en serait-il autrement pour une épave ? Quel est le point commun entre le Titanic et nombre d’épaves des deux derniers siècles, dont celles des deux guerres mondiales ? Elles sont en alliages ferreux. Et le fer dans l’eau, ça rouille, surtout en eau salée. En réalité, c’est beaucoup plus compliqué que cela et c’est justement cette complexité qui est au cœur du problème : comment lutter contre un phénomène mal compris ? Pour espérer sauver une épave, il faut d’abord comprendre les mécanismes qui causent sa perte. La corrosion d’une épave métallique n’est pas qu’une affaire de physico-chimie entre l’épave et l’eau dans laquelle elle baigne. Les microorganismes colonisateurs jouent plusieurs rôles, à la fois dans l’accentuation et dans la protection contre la corrosion. Leur développement a comme effet à court terme l’initiation de l’écosystème récifal. À moyen et long terme, ces bactéries peuvent protéger ou accentuer la corrosion. La prolifération bactérienne s’accompagne de la production de substances organiques qui les enveloppent, formant ainsi ce que l’on appelle un biofilm sur la surface colonisée. D’autres composés peuvent être produits et s’accumuler, par exemple du calcaire. L’ensemble peut agir comme une barrière à l’interface entre le métal et l’eau, avec un effet protecteur. Certains groupes bactériens sont particulièrement attirés par ces épaves, par exemple les zétaprotéobactéries. Elles sont capables d’oxyder le fer. Elles trouvent donc sur ces épaves des conditions favorables à leur développement, avec pour conséquence un rôle dans les mécanismes de la corrosion au cours du temps. Les zétaproteobactéries ne sont pas les seules. La diversité bactérienne colonisant les épaves métalliques est importante. Tout ce petit monde forme des communautés qui varient selon les épaves et les conditions environnementales où elles gisent. Comprendre la composition et la dynamique des communautés au sein de ces biofilms est nécessaire pour savoir de quelles manières elles participent au devenir de l’épave et pour imaginer des solutions de préservation aussi bien pour les épaves métalliques que pour d’autres structures immergées. En effet, les épaves métalliques ne sont qu’une catégorie de structures immergées. Pour les autres types de structures, les problèmes de conservation, de durabilité de leurs matériaux se posent de la même façon, avec le risque de coûts non négligeables engendrés pour leur entretien. Être en mesure de protéger notre patrimoine historique et culturel immergé va donc bien au-delà. Mais le temps s’écoule et à chaque instant la corrosion poursuit son œuvre, grignotant sans relâche. Les recherches ont besoin de temps et surtout de moyens. Il est difficile de financer des projets regroupant des microbiologistes, des archéologues, des chimistes, des océanographes pour travailler de façon globale sur cette problématique. La rareté des publications scientifiques sur le sujet en atteste et les connaissances sont balbutiantes. Or, dans cette course, il n’y a pas de seconde place : une fois détruite, l’épave est perdue. 2030 pour le Titanic ? Quelle échéance pour les épaves des deux guerres mondiales ? Il y a urgence. Laurent Urios ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche. Texte intégral 2139 mots

Qu’est-ce qu’une épave ?

Une oasis de vie

Les racines du mal

![]()