ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

12.11.2024 à 17:41

Cybersécurité: un grand concours pour résister à la menace des ordinateurs quantiques

Philippe Gaborit, Professeur en informatique, Université de Limoges

Texte intégral (1830 mots)

Les agences de sécurité du monde entier sont en train s’armer pour que les communications sécurisées sur Internet le restent quand les ordinateurs quantiques débarqueront.

Pour trouver des algorithmes résistants aux futurs ordinateurs quantiques, un organisme américain a lancé un grand concours, auquel participent de nombreuses équipes de recherche. La France est en pointe dans le domaine – explications par un des chercheurs impliqués.

La cryptographie est au cœur de la sécurité des systèmes d’information, dont Internet, et en particulier de la sécurité des paiements en ligne. Pour utiliser l'image simple d'une effraction dans un appartement: la cryptographie s’occupe d’assurer la solidité de la porte et qu'on ne puisse l'ouvrir qu'avec la clef. Pour cela, on code les informations, et seule la clef permet de les décoder.

La cryptographie repose sur des problèmes mathématiques suffisamment complexes pour que les ordinateurs actuels ne puissent pas les résoudre en un temps raisonnable, par exemple le problème de la factorisation des grands nombres. Mais quantité de ces problèmes seront vulnérables aux attaques de futurs ordinateurs quantiques, plus puissants que les ordinateurs actuels.

En 2015, devant le risque que faisait peser sur la cryptographie le développement d’un ordinateur quantique suffisamment puissant, la National Security Agency (NSA) a enjoint l’administration américaine à changer de paradigme pour passer à une cryptographie résistante aux ordinateurs quantiques, dite « cryptographie post-quantique ».

Suite à ce communiqué, l’Institut des standards américains (NIST) a lancé un concours international : pour gagner, il faut proposer de nouveaux algorithmes cryptographiques résistants aux attaques quantiques. Les gagnants deviendront les standards du domaine : ils auront vocation à être utilisés pour sécuriser toutes les communications dans le monde.

Les enjeux traversent les frontières. S’il est difficile d’évaluer précisément le moment où les systèmes cryptographiques actuels pourront être cassés par un ordinateur quantique, on est sûrs que la transition technique vers un nouveau système prendra du temps, et il faut commencer à la préparer dès maintenant.

Les futurs ordinateurs quantiques, une menace pour les systèmes cryptographiques actuels

Bien que le premier algorithme destiné à être exécuté sur un ordinateur quantique ait été décrit en 1994, le développement d’ordinateurs quantiques réels se fait très lentement. En effet, ils posent des problèmes techniques physiques particulièrement compliqués à résoudre : la puissance d’un ordinateur quantique dépend du nombre de « bits quantiques » (ou qubits) qu’il contient, mais ceux-ci sont difficiles à assembler en grand nombre… à tel point que les premiers ordinateurs quantiques ne possédaient que quelques qubits opérationnels, et ne servaient pas à grand-chose pour calculer.

Ainsi, pendant les années 2000, la puissance des ordinateurs quantique augmentait très lentement, ce qui poussait certains à penser qu’un ordinateur quantique suffisamment puissant pour poser des problèmes de sécurité ne verrait jamais le jour.

À lire aussi : Ordinateur quantique : comment progresse ce chantier titanesque en pratique

Les choses ont changé au début des années 2010 lorsque les grands groupes américains du GAFAM se sont mis à s’intéresser à l’ordinateur quantique et à financer de manière très importante de tels projets, qualifiés par certains de « projet Manhattan du XXIe siècle ».

En quelques années, on est passé de quelques bits, à quelques dizaines de qubits, à plus de 1000 qubits aujourd’hui. Si la situation a considérablement évolué en 20 ans, la réalisation d’un ordinateur quantique suffisamment efficace pour casser un système de cryptographie n’est probablement pas pour demain, tant il reste de nombreux défis physiques à résoudre… mais le sujet est aujourd’hui au premier plan au niveau international, et des start-up font de nouvelles avancées chaque jour. En France, on peut citer en particulier Pasqal et Candela.

Et même s’il reste probablement une bonne dizaine d’années avant de pouvoir éventuellement arriver à casser concrètement un système de type RSA (un système cryptographique très utilisé aujourd’hui), la « menace quantique » a déjà commencé : avec des attaques de type « harvest now and decrypt later », on peut envisager qu’un attaquant collecte des données aujourd’hui et les déchiffre lors de l’avènement de l’ordinateur quantique.

Des problèmes mathématiques difficiles même pour un ordinateur surpuissant

Une cryptographie résistante aux attaques d’ordinateurs quantiques reposera sur une catégorie particulière de problèmes mathématiques : celle des problèmes réputés « difficiles », qui résisteront a priori aux ordinateurs quantiques.

De tels problèmes difficiles sont connus depuis des années : le premier, dit « système de McEliece » a été introduit en 1978. Mais ces problèmes difficiles ont souvent l’inconvénient d’être plus gros en taille que les systèmes classiques.

Il est important de bien comprendre qu’un ordinateur quantique ne sera pas capable de casser facilement n’importe quel type de problème difficile (en fait, on connaît très peu d’algorithmes quantiques qui cassent des problèmes efficacement), mais la catégorie des problèmes résolus beaucoup plus efficacement par un ordinateur quantique englobe tous les problèmes utilisés pour les systèmes de cryptographie à clé publique actuels.

En pratique, on utilise aujourd’hui un processus de cryptographie en deux étapes, le « chiffrement hybride » : les ordinateurs quantiques ne devraient a priori pas mettre en danger la première étape (dite « partie symétrique ») car il suffira de doubler la taille des clés pour que même un ordinateur quantique ne puisse pas les attaquer. En revanche, la seconde étape (dite de « partage de secret ») est rendue inutilisable par le premier algorithme quantique inventé en 1994, l’algorithme de Shor. C’est pour cette seconde partie qu’il convient de trouver des systèmes alternatifs résistants aux attaques quantiques.

Un grand concours pour trouver de nouveaux algorithmes

Des concours publics internationaux ont déjà été organisés avec succès par le NIST pour définir les précédents standards de la cryptographie en 1996 et en 2008.

Le concours post-quantique a débuté en novembre 2017 et a pour objet de trouver des algorithmes de chiffrement, de partage de secret et de signature, les trois principaux types d’algorithmes de la cryptographie à clé publique moderne.

Soixante-quatre algorithmes de chiffrement ont été soumis. Au fur et à mesure d’un processus transparent qui s’est déroulé sur plusieurs années et à travers plusieurs tours qui filtraient les candidats. Il s’agit d’un processus complexe où l’on cherche des algorithmes à la fois efficaces et sécurisés et où les chercheurs sont invités à tester la robustesse des algorithmes pressentis, ainsi certains concurrents ont même été éliminés très tard dans le processus parce qu’ils ont été attaqués efficacement et donc démontrés non robustes (par exemple le système SIKE à l’été 2022).

En 2022, le NIST a choisi un premier groupe d’algorithmes pour la standardisation : KYBER pour le chiffrement ainsi que trois algorithmes (Di Lithium, Falcon et Sphincs) pour la signature.

Il espère aussi annoncer cet automne (2024) un ou deux nouveaux standards pour le chiffrement, choisis parmi les algorithmes encore en course : McEliece, HQC and BIKE.

En parallèle, le NIST a commencé un nouveau concours en juin 2023 spécialement pour les signatures post-quantiques pour augmenter la diversité des algorithmes. Le concours vient juste de commencer et a accueilli 40 candidats. Les résultats du premier tour sont arrivés en octobre 2024 et 14 candidats passent au second tour.

Durant tout le processus, la France a été très représentée dans de nombreuses soumissions sur tout type de problèmes difficiles. Le pays est très en pointe pour la cryptographie post-quantique, notamment grâce aux financements France 2030 et grâce aux efforts dans la durée de la part d’organismes de recherche nationaux comme le CNRS et l’INRIA.

Concrètement, que changent les nouveaux algorithmes post-quantiques par rapport aux systèmes de cybersécurité actuels ?

D’une manière générale, les nouveaux algorithmes post-quantiques sont plus gros en termes de taille de paramètres. Dans certains cas, la taille des données cryptographiques envoyées (petite à la base) peut être multipliée par 10 ou 20, ce qui oblige à faire évoluer aussi une partie de la chaîne globale de la sécurité et un travail d’adaptation général sur un certain de protocoles de sécurité existants qui utilisent la cryptographie en boite noire. Les chercheurs et les industriels travaillent sur le sujet depuis des années pour rendre la transition vers ces nouveaux algorithmes cryptographiques la plus efficace et sécurisée possible.

D’un point de vue plus concret, il existe des groupes de travail dans divers campus de cybersécurité à la fois au niveau national et en régions et l’ANSSI (l’agence de sécurité française qui régule l’utilisation de la sécurité et de la cryptographie en France) est en train de mettre en place des procédures de certification pour des produits utilisant la cryptographie post-quantique, avec pour but que les entreprises aient pu faire une transition d’ici 2030, c’est-à-dire… demain.

Le projet CBCRYPT a été soutenu par l’Agence nationale de la recherche (ANR), qui finance en France la recherche sur projets. Elle a pour mission de soutenir et de promouvoir le développement de recherches fondamentales et finalisées dans toutes les disciplines, et de renforcer le dialogue entre science et société. Pour en savoir plus, consultez le site de l’ANR.

Philippe Gaborit a reçu des financements de France 2030 (PEPR Quantique) et de l'ANR (projet CBCRYPT https://anr.fr/Projet-ANR-17-CE39-0007).

12.11.2024 à 17:35

Les oursins comme bioindicateurs de la pollution marine

Ouafa El Idrissi, Enseignant chercheur en biologie et écologie marine, Université de Corse Pascal-Paoli

Sonia Ternengo, Maître de conférences HDR en biologie et écologie marine, Université de Corse Pascal-Paoli

Texte intégral (2160 mots)

Les oursins se révèlent être de précieux bioindicateurs pour suivre la contamination des environnements marins par les éléments traces (longtemps appelés métaux lourds). Un exemple en Corse, lieu privilégié d’étude des écosystèmes côtiers, à proximité d’une mine fermée depuis plus de 50 ans.

Interfaces fragiles entre les milieux terrestres et marins, les écosystèmes côtiers sont soumis à une pression croissante due aux activités anthropiques. L’expansion des secteurs industriel, agricole et urbain entraîne l’introduction d’une quantité considérable de produits chimiques dans ces écosystèmes.

Ces substances présentent souvent des propriétés toxiques susceptibles de causer des dommages multiples à l’échelle des organismes, des populations et des écosystèmes, menaçant non seulement la biodiversité marine mais aussi les services écosystémiques qu’ils fournissent.

Les éléments traces : une menace invisible

Les éléments traces, autrefois appelés métaux lourds, font partie des contaminants les plus répandus dans l’écosystème marin. En raison de leur toxicité, leur persistance et leur capacité à s’accumuler dans les organismes marins, ces derniers sont considérés comme de sérieux polluants dans l’environnement marin.

Bien que naturellement présents dans l’environnement à faible concentration, les éléments traces peuvent rester en solution, s’adsorber sur des particules sédimentaires, précipiter au fond ou encore s’accumuler et connaître « une bioamplification » dans les chaînes alimentaires atteignant ainsi des niveaux toxiques. Une surveillance constante de leur présence et leur concentration est donc essentielle face à ces menaces.

Le cas de l’oursin violet comme bioindicateur de contamination

Afin d’évaluer les niveaux de contaminants dans l’écosystème, des organismes peuvent être utilisés comme bioindicateurs. Ces organismes ont la capacité d’accumuler des polluants dans leurs tissus permettant ainsi d’évaluer la qualité de leur environnement.

De par sa large distribution, son abondance dans les écosystèmes côtiers, sa facilité de collecte, sa longévité, sa relative sédentarité et sa bonne tolérance aux polluants, l’oursin violet Paracentrotus lividus (décrit par Lamarck en 1816) est un organisme reconnu pour son rôle de bioindicateur.

L’utilisation de biomarqueurs représente également une approche clé dans la biosurveillance marine permettant d’évaluer les liens entre l’exposition aux polluants environnementaux et leurs impacts sur les individus et les populations. Les effets des polluants dans les écosystèmes marins peuvent être mesurés à travers des paramètres biochimiques.

De nombreuses études suggèrent que l’exposition à divers éléments traces est susceptible d’entraîner des dommages irréversibles chez les organismes marins via la production de molécules oxydantes. Dans ce contexte, il est essentiel d’évaluer, au sein de ces organismes, les activités d’enzymes antioxydantes qui jouent un rôle clé dans la défense contre le stress oxydant. Les teneurs de certains marqueurs d’oxydation dans les tissus des organismes constituent également des indicateurs précieux pour évaluer l’intensité du stress oxydant.

La Corse, un site d’étude privilégié

En raison de ses côtes fortement peuplées, la mer Méditerranée est soumise à de nombreuses pressions anthropiques. Située au nord-ouest de ce bassin, la Corse constitue un site d’étude privilégié pour les écosystèmes côtiers. Ses eaux, souvent considérées comme peu affectées par des sources anthropiques majeures, permettent d’identifier plus facilement les sources de contamination.

À lire aussi : En Méditerranée, ces larves voyageuses de crabes, oursins et autres araignées

Afin d’obtenir des informations sur la qualité environnementale des eaux marines autour de l’île et d’identifier les zones de contamination locale, des prélèvements ont été réalisés. Ces travaux avaient pour objectif de suivre la dynamique spatio-temporelle de 22 éléments traces dans des oursins prélevés sur le littoral corse et d’estimer les effets de cette contamination sur le stress oxydant de P. lividus.

Des indices de pollution, calculés à partir de données issues de la littérature, ont permis de comparer les niveaux de contamination de la Corse à ceux d’autres régions méditerranéennes, comme l’Algérie, la Grèce, l’Italie et l’Espagne. Bien qu’il existe quelques cas de contamination élevée en Corse, les niveaux demeurent faibles en raison de la faible pression anthropique dans la région.

Des éléments traces présents naturellement ou liés aux activités humaines

La plupart des contaminations significatives qui ont été relevées sont attribuées à des sources localisées ou à des caractéristiques spécifiques des sites étudiés. Ainsi, de fortes teneurs en cobalt, chrome et nickel ont été mesurées dans les organes reproducteurs (les gonades) d’oursins à proximité de l’ancienne mine d’amiante à Canari en Haute-Corse. Ces niveaux résultent de déblais non traités rejetés en mer pendant la période d’activité de la mine d’amiante entre 1948 et 1965.

Malgré la fermeture de la mine depuis plus de 50 ans, le procédé utilisé pour récolter des résidus miniers le long du littoral ainsi que la composition géologique du sous-sol (constitué de roches dénommées serpentinites naturellement riches en éléments traces) contribuent encore à la dispersion de ces éléments dans l’environnement marin.

L’évaluation de la qualité des écosystèmes nécessite donc une bonne connaissance du contexte géochimique naturel afin de distinguer les éléments traces naturellement présents dans l’environnement de ceux résultant des activités anthropiques. Cet exemple illustre également comment les activités humaines, même anciennes, peuvent encore avoir un impact sur les écosystèmes.

Le calcul d’un indicateur appelé « Trace Element Pollution Index » – basé sur les concentrations en éléments traces dans les gonades et les tubes digestifs de l’oursin – a permis de déterminer un gradient de contamination avec des teneurs plus élevées au sud de l’ancienne mine d’amiante. Ce phénomène résulte de la migration des déchets miniers vers le Sud, entraînés par la houle et les courants marins dominants.

Cette observation souligne le rôle du milieu marin dans la diffusion et la distribution des contaminants dans l’environnement. Par conséquent, les éléments traces peuvent être largement diffusés à partir des sites sources rendant leur surveillance plus complexe.

Plusieurs études suggèrent que l’exposition à la contamination par les éléments traces peut induire une cascade d’événements qui stimulent des activités d’enzymes antioxydantes chez les oursins.

Dans le cadre de notre recherche, les activités spécifiques les plus élevées des enzymes antioxydantes ont été observées dans la zone sud de l’ancienne mine d’amiante, là où justement la contamination est la plus importante. Toutefois, aucune différence significative entre les sites n’a été mise en évidence. Ces données suggèrent que le système enzymatique antioxydant de P. lividus a protégé son organisme de manière efficace contre les dommages oxydants.

Intégrer aussi les caractéristiques de l’eau (température, acidité, oxygène, etc.)

La contamination en éléments traces varie selon les saisons, avec des concentrations généralement plus élevées en automne et en hiver et plus faibles en été. Cette variation s’explique par des changements physiologiques chez l’oursin. Lors de la production des cellules sexuelles ou gamètes (spermatozoïdes et ovocytes), un phénomène de dilution des concentrations en éléments traces est constaté dans les organes reproducteurs tandis qu’en dehors de cette période la concentration augmente.

Par ailleurs, certains éléments sont essentiels et leur concentration élevée durant la production des cellules sexuelles est considérée comme normale. C’est notamment le cas du zinc étroitement lié au processus de maturation des ovocytes ou cellules sexuelles féminines (l’ovogenèse) et dont les niveaux sont particulièrement élevés chez les femelles.

En conséquence, pour une utilisation optimale des oursins en tant que bioindicateurs, il est crucial de considérer divers facteurs dits « biotiques » et « abiotiques ». Les facteurs biotiques incluent la reproduction et le sexe des oursins qui influencent les concentrations d’éléments traces dans les gonades. Les facteurs abiotiques tels que la température de l’eau, le pH, la teneur en oxygène et la salinité influencent la biodisponibilité des polluants et la capacité des oursins à les accumuler.

Prendre également en compte d’autres bioindicateurs comme les moules et les algues

Par ailleurs, nos résultats ont démontré que les macroalgues et les tubes digestifs d’oursins bioaccumulent plus d’éléments traces que les gonades ce qui les rend particulièrement utiles pour identifier les contaminations locales. Le tube digestif des oursins, en particulier, pourrait être un outil plus précis pour les études écotoxicologiques car il présente généralement des concentrations d’éléments traces plus élevées et est moins affecté par les facteurs liés à la reproduction.

Ainsi, bien que les oursins soient d’excellents bioindicateurs, une approche intégrée avec d’autres organismes tels que des bivalves (les moules notamment) ou macroalgues permet d’obtenir une vision plus globale de la contamination dans les écosystèmes côtiers.

Ces recherches sont cruciales pour comprendre les pressions anthropiques exercées sur les écosystèmes marins et développer des stratégies de gestion environnementale efficaces visant à préserver la biodiversité ainsi que les services écosystémiques essentiels fournis par ces milieux.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 4 au 14 octobre 2024), et dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « océan de savoirs ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Ouafa El Idrissi a bénéficié de la bourse de la Fondation de la Mer, un financement dans le cadre du programme MISTRALS (Mediterranean Integrated STudies at Regional And Local Scales).

Sonia Ternengo a reçu un financement dans le cadre du programme MISTRALS (Mediterranean Integrated STudies at Regional And Local Scales).

12.11.2024 à 17:33

Est-ce vrai que les rhumatismes sont plus douloureux par temps humide ?

Valérie Lannoy, Post-doctorante en microbiologie, Sorbonne Université

Texte intégral (944 mots)

Nos aînés jouent parfois le rôle de station météo ! Grâce à leurs douleurs articulaires, ils peuvent prédire le temps qu’il fera dans la journée. Mais qu’en est-il vraiment ?

Les rhumatismes regroupent environ 200 maladies qui touchent les composantes des articulations, soit l’os et le cartilage articulaire. Ils affectent aussi leurs parties molles, comme les ligaments sur les os ou les tendons reliant les muscles aux os. Ils sont classés selon leur origine, en rhumatismes non inflammatoires et inflammatoires. Les premiers comprennent l’arthrose et l’ostéoporose, concernant surtout les personnes âgées, les troubles musculosquelettiques ou la fibromyalgie. Les rhumatismes inflammatoires englobent notamment les formes d’arthrite, telles que la spondylarthrite ankylosante et la polyarthrite rhumatoïde, deux maladies auto-immunes. Aujourd’hui, plus de 16 millions de Français souffrent de rhumatismes.

Pluie ou humidité ?

En 2019, une équipe de l’Université de Manchester a étudié les symptômes de plus de 2500 malades pendant 15 mois. Plusieurs pathologies étaient représentées, comme l’arthrose, la polyarthrite rhumatoïde et la fibromyalgie. Les symptômes ont été recueillis via une application sur smartphone, avec des informations incluant météo, humeur ou activité physique. C’est l’une des premières expériences de science participative à utiliser une application.

Les auteurs suggèrent que ce type de dispositif peut être proposé aux patients pour prévoir leurs douleurs. Ils ont trouvé que ce sont l’humidité relative, c’est-à-dire la saturation de l’air en vapeur d’eau, et la pression atmosphérique, qui corrèlent le plus avec les douleurs articulaires.

Cette corrélation, bien que significative, reste modeste. Par exemple, la modification simultanée des deux variables météorologiques n’entraîne qu’une faible augmentation de la douleur. Trois ans après, une équipe de la même université a décidé de réanalyser les mêmes données. Ils ont déterminé qu’il y a bel et bien un lien entre climat et douleur articulaire, mais qu’il concerne environ 4 % des volontaires. Ces chercheurs expliquent que la douleur est subjective et codée par le cerveau. La réaction varie donc selon les malades, et dépend des différences interindividuelles de l’activation nerveuse.

L’articulation est un baromètre

Le lien entre douleurs articulaires et météo fait l’objet de débats houleux entre scientifiques ! En 2017, une collaboration internationale, menée par le Dr Jena, permit l’analyse des symptômes d’environ 1,5 million d’Américains de plus de 65 ans. Leur conclusion est qu’il n’y a aucune corrélation entre douleurs articulaires et jours de pluie. Quatre jours après, la réponse à cet article scientifique ne s’est pas fait attendre ! Voici comment le Dr Bamji, rhumatologue retraité, débute sa réponse : « La raison pour laquelle le Dr Jena et ses collègues n’ont pas réussi à trouver un lien entre les douleurs articulaires et la pluie est simple. Ils se sont trompés de variable – et à ma connaissance, personne n’a pris en compte la bonne. »

Comment la pluie ou l’humidité relative pourrait influer la douleur des patients… Alors que notre organisme n’a aucun moyen de détecter les fluctuations du taux d’humidité ? Le Dr Bamji précise que l’articulation est une structure permettant la proprioception ou sensibilité profonde. Il s’agit de la capacité, consciente ou inconsciente, à percevoir la position des parties du corps sans utiliser la vision. Dans les tendons sont logés des « propriocepteurs », des récepteurs sensibles à la pression induite par la contraction musculaire. Les propriocepteurs sont également sensibles aux changements de pression atmosphérique.

La pression atmosphérique suit en fait les variations de l’humidité relative. Quant aux propriocepteurs, ils transmettent leurs signaux à des nerfs sensitifs qui transitent vers le cerveau.

Les douleurs articulaires sont liées directement à la pression atmosphérique, et indirectement à l’humidité relative. Chaque patient a un ressenti dépendant de son propre système nerveux central. Le plus important est d’écouter sa douleur, par exemple en tenant un journal quotidien des symptômes !

Valérie Lannoy ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.11.2024 à 19:38

Voitures, avions et même satellites : le bois, un matériau de construction d’avenir

Bruno Castanié, Professeur en Structures Composites, Institut Clément Ader, INSA Toulouse

Arthur Cantarel, Maître de conférence - Institut Universitaire de Technologie de Tarbes , IMT Mines Albi – Institut Mines-Télécom

Florent Eyma, Professeur - Institut Universitaire de Technologie de Tarbes, IMT Mines Albi – Institut Mines-Télécom

Joel Serra, Ingénieur-Chercheur en mécanique des structures et matériaux composites, ISAE-SUPAERO

Texte intégral (2136 mots)

Ce mardi 5 novembre, le tout premier satellite en bois a été lancé dans l’espace. Il a été développé par des scientifiques de l’Université de Kyoto. Une preuve que le bois peut être envisagé comme un matériau de construction du futur.

Depuis l’invention de la roue, estimée à 4 000 ans av. J.-C., le bois a été utilisé par l’humanité pour ses déplacements terrestres. Hormis dans le nautisme, il est peu connu que son usage était encore fréquent à la fin du XXe siècle. Parmi les nombreux exemples documentés dans nos articles l’un des meilleurs avions de la Deuxième Guerre mondiale était le Mosquito, produit par De Havilland à 7 781 exemplaires, capable de voler à 680 km/h et dont la structure était faite de bouleau, douglas et balsa.

Jusqu’à aujourd’hui la société Robin Aircraft, établie à Dijon a produit le DR 400 en construction bois et toile à 2 700 exemplaires. Côté automobile, la société anglaise Morgan utilise encore le frêne pour une partie de ses châssis. Mais un des plus beaux exemples était la Costin Nathan Le Mans 1967 dont la structure était en contreplaqué pour un poids de seulement 400 kg, c’est la moitié de la Ferrari P4 de la même année.

Ces exemples montrent à la fois la légèreté et la résistance du bois mais aussi un savoir-faire en partie perdu. En effet, seule la marque anglaise Morgan utilise encore le bois pour ses voitures en petite série aujourd’hui.

La question de son utilisation est intimement liée à la ressource disponible. Si dans l’hémisphère Sud, la couverture forestière disparaît majoritairement à cause de son utilisation comme bois de chauffe, dans l’hémisphère Nord elle continue à augmenter. Pour l’Union européenne, l’augmentation du stock de bois sur pied a été de 30 % sur la période 2000-2020 et la couverture forestière représente 39 % de la surface des états membres. En France la couverture forestière a doublé en 100 ans. Malheureusement, ce sont essentiellement les résineux qui sont exploités alors qu’une utilisation structurale pour des véhicules nécessiterait des feuillus comme le peuplier ou le bouleau qui sont des essences locales et abondantes.

Le bois, un matériau résistant mais complexe

Nos recherches ont d’abord porté sur la caractérisation mécanique du contreplaqué seul ou pris en sandwich avec d’autres matériaux comme l’aluminium ; les fibres de carbone, de verre mais aussi de lin. Si les résistances trouvées sont satisfaisantes, le contreplaqué s’avère un matériau très complexe du fait de son mode d’obtention. On va trouver des caractéristiques différentes en fonction de la position du bois dans l’arbre (bois juvénile ou adulte, de printemps ou d’été). À cette complexité s’ajoute aussi une forte sensibilité du bois à son environnement en termes d’humidité et de chaleur.

Toutes ces complexités influent sur les caractéristiques mécaniques des plis qui constituent le contreplaqué et pour y remédier nous avons développé des méthodes d’identification grâce aux thèses de John Susainathan et d’Axel Peignon, du postdoctorat d’Hajer Hadiji et de l’ANR BOOST.

Des applications concrètes dans l’automobile

Les véhicules d’aujourd’hui doivent permettre d’absorber les chocs lors d’accidents. Ce sont le plus souvent des tubes en acier ou aluminium qui servent d’absorbeur d’énergie. Il était donc important de connaître la réponse du bois à des crashs. Lors de la thèse de Romain Guélou, nous avons testé des tubes fabriqués avec plusieurs essences (peuplier, bouleau et chêne) avec ou sans des peaux intérieures ou extérieures, en tissus de fibres de verre ou de carbone. Le comportement au crash du bois est très bon. Un tube avec des peaux en carbone et une âme en plis de bouleau a pu absorber l’énergie d’une masse de 170 kg lâchée à 4,2 m de hauteur. On a aussi pu montrer la contribution significative du bois puisqu’en passant de 2 à 6 plis de bouleau, l’énergie absorbée est multipliée par 2.

Récemment un groupe d’étudiants du département de génie mécanique de l’INSA Toulouse a montré que sur un véhicule léger, librement inspiré de l’Africar (une voiture avec un châssis bois extrêmement robuste conçue dans les années 1980 pour l’Afrique), les contraintes sont faibles et parfaitement supportables par un contreplaqué de bouleau ou de peuplier.

Les études menées à l’INSA Toulouse et à l’Institut Clément Ader depuis 12 ans montrent les possibilités de ce matériau historique que la nature a rendu très avancé pour une mobilité durable. Ces études s’inscrivent dans un mouvement de redécouverte et de réemploi. En France, la société Aura Aéro, basée à Toulouse a développé l’Integral R, avion d’acrobatie bois-carbone en cours de certification. À Belfort, les avions Mauboussin, avec qui nous collaborons, développent un avion dont la structure est en bois en s’inspirant du Mosquito.

À travers plusieurs programmes de recherches, le professeur Ulrich Müller et son équipe autrichienne ont démontré que le remplacement et le calcul de pièces de véhicules par du bois étaient avantageux économiquement et permettaient d’alléger les structures.

Du bois dans l’espace

Mais le plus surprenant est l’utilisation du bois dans l’espace. Deux études sont actuellement en cours, au Japon et en Europe (Finlande), pour utiliser le bois comme matériau de structure de petits satellites.

L’étude japonaise LignoSat Space Wood vient de lancer un satellite en bois de magnolia sur une orbite terrestre basse. En plus d’être respectueux de l’environnement lors de sa fabrication et de brûler complètement dans l’atmosphère terrestre une fois désorbité, un satellite en bois sera largement transparent aux ondes radio. Les antennes de communication et de recherche pourraient ainsi être internes car le bois est transparent aux ondes radio, évitant ainsi des opérations de déploiement hasardeuses. Les tests effectués sur des échantillons de bois à la Station spatiale internationale (ISS) par des chercheurs de l’Université de Kyoto ont confirmé la détérioration minime et la bonne stabilité du bois dans l’espace. Le satellite européen est fabriqué en contreplaqué de bouleau finlandais, mais dopé pour l’aider à résister aux conditions spatiales.

Il existe donc un intérêt croissant pour le bois dans des domaines des transports parmi les plus variés. Si de nombreuses recherches ont été effectuées sur le bois en utilisation génie civil, il reste un domaine quasi vierge pour le contreplaqué dans le domaine des transports malgré un énorme potentiel en termes de développement durable. Des applications aéronautiques et spatiales ont déjà vu le jour mais pour les transports, hormis quelques réalisations d’amateurs éclairés, il n’y a pour l’instant aucune application industrielle.

Castanié Bruno a reçu des financements de l'ANR sur ce sujet.

Arthur Cantarel a reçu des financements de l'ANR.

Florent Eyma et Joel Serra ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

07.11.2024 à 17:16

Physique des particules : il y a 50 ans nous découvrions le quatrième quark

François Vannucci, Professeur émérite, chercheur en physique des particules, spécialiste des neutrinos, Université Paris Cité

Texte intégral (2086 mots)

Il y a tout juste 50 ans, un groupe de physiciens découvrait un nouveau quark, « brique » de base des protons et des neutrons. Récit par l’un de ses découvreurs.

Au début des années 1970, les physiciens des particules disposaient de deux imposants centres d’accélérateurs pour étudier l’infiniment petit : l’européen CERN à Genève et l’américain Brookhaven près de New York. Chacun abritait un accélérateur de protons de 620 m de circonférence pouvant atteindre l’énergie alors faramineuse de 25 GeV. L’unité d’énergie est ici l’électron-volt (eV), 1eV étant l’énergie d’un électron traversant une tension de 1V. On emploie les multiples : keV (103), MeV (106) et GeV (109). Cela reste infinitésimal rapporté au monde ordinaire. 1 GeV, équivalent de la masse du proton, correspond à une énergie qui élèverait d’un milliardième de degré la température d’un gramme d’eau !

Grâce à ces machines, la physique multipliait le nombre de particules élémentaires en suivant une recette simple : bombardant une cible avec un faisceau de protons accélérés, on analysait les particules qui sortaient. On accumula ainsi environ 200 types d’objets élémentaires, en particulier de nombreuses résonances.

Qu’est-ce qu’une résonance ? Alors que les particules telles que protons, électrons, pions, kaons… peuvent être suivies sur des distances macroscopiques, les résonances se désintègrent dès leur création en donnant deux ou trois particules qu’il s’agit d’associer pour retrouver la résonance originelle. Empiriquement, on remarqua que plus leur masse était élevée, plus leur temps de vie était court jusqu’à atteindre 10-23 s. La discipline languissait depuis plusieurs années sans direction bien assurée devant un zoo hétéroclite à l’aspect assez brouillon.

Le jeu de Lego des quarks

200 objets élémentaires pour construire le monde, ce ne pouvait pas être le mot de la fin. Heureusement, les physiciens Murray Gell-Mann d’une part, et George Zweig d’autre part suggérèrent l’existence de constituants plus élémentaires à la base des particules répertoriées. Gell-Mann les appela quarks et montra que les 200 espèces connues pouvaient se comprendre comme assemblages de trois quarks différents qu’on nomme u, d et s. Zweig les appela « as » mais « quark », qui vient du roman de James Joyce Finnegans Wake, s’imposa.

Les quarks portent des charges électriques qui sont une fraction de la charge élémentaire de l’électron, respectivement +2/3 pour u et -1/3 pour d et s. Avec ces trois objets de base et trois antiquarks associés portant la charge opposée, on reconstruit deux familles de particules :

les baryons qui sont des triplets de quarks, par exemple uud et udd forment respectivement les protons et les neutrons ; les charges +1 et 0 sont bien restituées.

les mésons qui sont des paires associant un quark et un antiquark,

Avec les trois seuls dés à disposition, la nature construisait toutes les particules connues. Une association manquait, celle du baryon correspondant au triplet sss. C’était la prédiction du modèle. Une recherche fut menée et le « grand Ω » fut découvert à Brookhaven en 1964 à la masse prédite. Gell-Mann reçut le prix Nobel en 1969.

Toutes les particules connues ont une charge électrique +1, 0, -1 celle de l’électron. Des charges non entières supposées caractériser les quarks n’ont jamais été observées librement. Pourtant les quarks existent dans la mesure où ils opèrent au moment des interactions entre particules. Mais, dès qu’ils sont créés, ils « s’habillent » avec d’autres quarks ou antiquarks pour former les particules « réelles », baryons ou mésons. À notre niveau, les quarks restent des objets virtuels, nécessaires pour interpréter les observations.

Les quarks constituent le niveau le plus élémentaire de la matière explorée à ce jour. Leur « taille » est inférieure à 10-18 m alors que les particules qu’ils composent possèdent une taille mille fois supérieure.

La révolution du 10 novembre 1974

En sus des deux laboratoires majeurs cités, il existait des centres plus modestes. En France, une machine à protons fonctionnait à Saclay et une à électrons à Orsay. Il y avait aussi un dispositif en développement sur le campus de Stanford, cœur de la Silicon Valley, au sud de San Francisco. Le laboratoire, appelé SLAC, avait construit un accélérateur « dans le parking », c’est-à-dire entièrement financé sur les frais de fonctionnement, sans demande spécifique de budget, ce qui mérite aujourd’hui d’être souligné ! C’était un dispositif accélérant en sens inverse des électrons et des positrons dans un collisionneur de 80 m de diamètre, d’énergie maximale 4 GeV par faisceau. Il prit le nom de SPEAR, « Stanford Positron Electron Accelerator Ring ».

Autour d’un point d’interaction entre positrons et électrons, un détecteur de conception nouvelle fut construit pour mesurer au mieux tous les produits de la collision. C’était le premier détecteur hermétique qui couvrait tout l’espace pour ne rien laisser s’échapper. On l’appela Mark1.

L’expérience commença à prendre des données dès 1973 et elles étaient embarrassantes. L’ordinateur qui gérait la prise de données enregistrait environ une collision toutes les deux à trois minutes qu’il signalait en émettant un bref son. Ce taux était plusieurs fois supérieur à ce que prédisait la théorie.

On variait l’énergie en un balayage relativement grossier, en pas de 50 MeV : ainsi, on mesurait le taux de collisions à 2,550 GeV puis 2,600 GeV puis 2,650 GeV… Deux problèmes apparaissaient. Tout d’abord, comme déjà mentionné, le taux d’interaction s’avérait nettement plus élevé que prédit. De plus, les données prises à l’énergie nominale de 3,100 GeV en trois périodes différentes n’étaient pas en accord entre elles, deux périodes donnant des taux beaucoup plus élevés que la troisième. La reproductibilité de la physique semblait violée.

Le signal magique

Et alors, quelqu’un eut l’idée de faire un balayage beaucoup plus fin en énergie. Au lieu d’augmenter de 50 MeV en 50 MeV, on varierait l’énergie en pas plus serré de 2 MeV en 2 MeV. Et là, le miracle se révéla le 10 novembre 1974, c’était un dimanche. Nous étions trois ou quatre dans la salle de contrôle quand l’ordinateur, qui émettait son petit son à chaque nouvelle collision, au lieu de crépiter toutes les deux ou trois minutes, commença à accélérer le rythme. Ce fut le signal magique que tous nous espérions : entre les énergies de 3100 et 3120 MeV, le taux d’interactions, et donc le signal sonore de l’ordinateur, augmenta soudain d’un facteur 100. La « fusillade » dura quelques minutes. Puis, le pic découvert étant dépassé, l’ordinateur reprit son train-train de un coup en deux minutes.

Une structure manifeste s’était révélée, on venait de révéler une « résonance étroite » de masse 3096 MeV et de largeur 87 keV. Cette largeur indiquait un temps de vie 100 fois supérieur à l’attendu. On cherchait un profil de colline jurassienne et on découvrait un pic alpestre. Un phénomène totalement nouveau apparaissait.

Une publication fut vite écrite, signée par un groupe d’une trentaine de physiciens, contingent qui à l’époque semblait monstrueux et qui aujourd’hui s’avère bien modeste. Elle renouvela la vision du monde de l’infiniment petit et l’événement fut appelé la « révolution de novembre 74 »

Il fallait donner un nom. Quelques lettres grecques restaient libres et on choisit Ψ. Pourquoi cette particule possédait-elle une vie aussi longue ? L’interprétation n’était pas évidente. Deux écoles se disputèrent pendant une fébrile semaine au troisième étage du laboratoire où bivouaquaient les théoriciens, entre les tenants de la libération des couleurs, nouvelle « charge » imaginée pour associer les quarks entre eux, et ceux prônant l’apparition d’un nouveau quark. Le verdict tomba : l’expérience venait de découvrir le quatrième quark, appelé c pour charmé. Ceci complétait la liste des constituants élémentaires au-delà des trois quarks u, d et s introduits par Gell-Mann.

Et si un nouveau quark existe, il annonce toute une famille de particules charmées correspondant à toutes les combinaisons permises entre quatre quarks. Déjà, le 17 novembre, on trouvait le méson Ψ’ de masse 3700 MeV, autre avatar de ce qu’on a appelé le charmonium, qui associait un quark c à son anti-c.

Pourquoi « charme » ?

Comme pour les nouveau-nés, le nom charme vient de la facétie d’un parrain. En astronomie, les planètes portent les noms de dieux antiques. Pour les particules, on aurait pu les numéroter, on choisit de les classer selon l’alphabet, grec de préférence. Ainsi Δ, μ, Φ, Σ, Λ… presque toutes les lettres furent mises à contribution. Le grec était favorisé pour que la physique égale en respectabilité sa sœur, la philosophie. Mais, vers les années 1960, le langage évolua. Les nouveaux scientifiques, moins imprégnés de culture classique, passèrent à des noms plus prosaïques. Les particules étranges avec leur quark s (strange) avaient balisé la voie. Charm fut adopté pour le c, et l’histoire se répétera avec le quark b beau (ou bottom) et le quark t vrai (truth ou top). On sait aujourd’hui qu’avec ces six objets la liste des quarks est au complet, il n’y a plus rien à découvrir sur ce front.

Pour clore l’histoire, la même résonance fut découverte indépendamment en collisions de protons à Brookhaven, et là le groupe choisit le nom J. Cette lettre, étrangère au grec, ressemble à un caractère chinois qui s’épelle comme le patronyme de son découvreur. Et pour ne froisser personne, les physiciens continuent à appeler le méson charmé du nom un peu baroque de J/Ψ.

François Vannucci ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

06.11.2024 à 15:40

Comment les grandes éruptions volcaniques ont influencé l’histoire mondiale

Clément Ganino, Maitre de Conférence en Sciences de la Terre, Université Côte d’Azur

Texte intégral (4199 mots)

Le ralentissement spectaculaire de la croissance démographique il y a 74 000 ans, la chute de la civilisation minoenne, la Révolution française, la migration d’Européens vers les États-Unis au XIXe siècle… Derrière chacun de ces événements, l’influence possible d’une éruption volcanique.

Les grandes éruptions volcaniques sont des phénomènes spectaculaires qui peuvent de fait avoir des répercussions sur l’activité humaine, de façon locale ou globale, et ainsi avoir une influence sur l’histoire des civilisations et des arts. D’un point de vue géologique, une éruption consiste en l’émission de magma incandescent (sous forme de coulées ou d’éjectas) de cendres, de poussières et de gaz (vapeur d’eau, dioxyde de carbone ou gaz soufrés) le tout en proportions variables. Le dioxyde de carbone s’il est émis en grande quantité sur une courte période peut avoir un effet direct sur le climat via l’effet de serre.

Les gaz soufrés forment, eux, des aérosols, c’est-à-dire des particules dans l’atmosphère qui occultent une partie du rayonnement solaire. Ces aérosols peuvent ainsi contribuer à ce qu’on appelle un « hiver volcanique » avec une chute brutale des températures. S’ils sont émis en quantité, ces gaz peuvent changer significativement la composition globale de l’atmosphère et ses propriétés optiques. Enfin, après une éruption, le réservoir souterrain d’où provient le magma, « la chambre magmatique », peut se vider entièrement et provoquer ainsi un effondrement du sol en surface qu’on nomme caldeira.

Tâchons de revenir sur quelques éruptions qui ont, de par ces processus d’émission ou d’effondrement, marqué l’histoire, les arts, et peuvent également éclairer quelques enjeux du changement climatique actuel.

Avant l’histoire – une préhistoire volcanique

Si certaines éruptions n’ont pas laissé de traces écrites, elles ont pourtant considérablement impacté l’humanité.

L’éruption de Toba en Indonésie (environ 74 000 ans avant notre ère) a ainsi provoqué un hiver volcanique d’une durée de plusieurs années. Certains auteurs suggèrent qu’elle aurait de ce fait déclenché un goulot d’étranglement démographique chez les premiers Homo sapiens, réduisant la population humaine mondiale à quelques milliers d’individus et ralentissant l’expansion de l’humanité.

Les premiers témoignages de phénomènes éruptifs connus du paléolithique prennent ensuite la forme de peintures rupestres. Dans la grotte Chauvet en Ardèche, par exemple, en plus des représentations d’animaux généralement dangereux et puissants (lions, ours, mammouths, rhinocéros réalisées avec des pigments d’ocre rouge et de charbon), on trouve des gravures figurant le plus ancien témoignage d’éruption volcanique. Un dessin distinctif en gerbes paraboliques a été assimilé à une représentation de fontaines de laves typiques des éruptions dites « stromboliennes ».

Ces dernières sont caractérisées par des explosions d’intensité modérée éjectant à quelques dizaines de mètres de hauteur des particules de lave incandescentes de tailles variées (cendres, lapilli et bombes). La comparaison de l’âge d’occupation de ce site (37 000 à 33 500 ans) avec l’âge des plus jeunes volcans d’Ardèche (entre 19000 ans et 41000 ans) montre qu’il est possible que les habitants aient vécu et témoigné à travers ce dessin d’une éruption volcanique.

Cet exemple ne laisse cependant pas présager des conséquences humaines et matérielles des éruptions et il faut attendre le néolithique et la fresque de Çatal Höyük en Turquie pour avoir un témoignage probable des effets d’une éruption. Cette fresque dans une maison néolithique (6 600 avant J.-C.) montre ce qui semble être un volcan en éruption (vraisemblablement le mont Hasan), projetant des cendres ou de la lave vers une série de motifs en damier pouvant être interprétés comme les habitations de cette ancienne ville d’Anatolie centrale en proie à une éruption.

Ces deux exemples témoignent de l’influence des éruptions volcaniques, à minima sur l’imaginaire et sur l’histoire des prémices de l’art dans ces temps très reculés. Mais au-delà du spectacle local d’une éruption telle qu’elle peut être observée à proximité d’un volcan, les « grandes » éruptions volcaniques ont parfois eu un impact reconnu sur les populations de l’antiquité.

À lire aussi : Changement climatique : quel est le rôle des éruptions volcaniques ?

La vulnérabilité des civilisations aux catastrophes naturelles, illustrée par les éruptions volcaniques

L’éruption de Théra (Santorin, Grèce) vers 1600 av. J.-C. a été l’une des plus puissantes de l’histoire. Elle a eu un impact majeur sur la florissante civilisation minoenne et des répercussions sur la proche civilisation mycénienne, commercialement liée aux Minoens. Une quantité massive de cendres a recouvert l’île de Santorin et lors de la formation d’une caldeira, une partie de l’île a été submergée dont la ville antique d’Akrotiri. Cette éruption pourrait d’ailleurs avoir inspiré le mythe de l’Atlantide, raconté par Platon dans ses Dialogues.

Au-delà de ces impacts majeurs mais locaux, l’éruption de Théra a projeté une immense quantité de cendres et d’aérosols dans l’atmosphère, provoquant des changements climatiques temporaires. L’« hiver volcanique » lié aux aérosols a pu modifier le cycle des moussons et sécheresses contribuant à de mauvaises récoltes dont témoigne le Papyrus égyptien d’Ipou-Our, décrivant de telles famines, ainsi que diverses catastrophes naturelles sous le règne d’Ahmôsis Iᵉʳ (vers 1550-1525 avant J.-C.).

Une éruption comme moteur des révolutions sociétales à la fin du XVIIIème

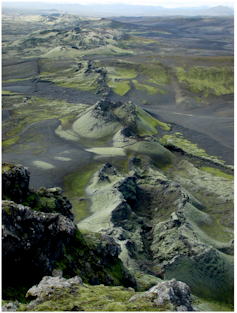

Par la suite, d’autres éruptions majeures ont marqué l’histoire et notamment à la fin du XVIIIe siècle (1783-1784), lorsque le volcan Laki (Lakagigar) entra en éruption en Islande : 12 km3 de lave s’échappèrent alors d’une fissure de 30 km de long libérant de grandes quantités de fluorures dans l’atmosphère. Ces composés, une fois retombés sur les pâturages, provoquèrent une contamination massive intoxiquant le bétail (maladies osseuses, dentaires et mort de nombreuses bêtes). Près de 50 % du bétail islandais aurait péri et 20 % de la population islandaise (soit environ 10 000 personnes) aurait succombé à la famine créée par cet évènement causant l’une des plus grandes catastrophes démographiques dans l’histoire de l’île.

Au-delà de l’Islande, les émissions de gaz soufrés du Laki ont été suffisamment massives pour entrainer un refroidissement global (hiver volcanique) et un hiver particulièrement froid en Europe, affectant les récoltes, notamment en France, et contribuant à des pénuries alimentaires qui ont exacerbé les tensions économiques et sociales. Ces conditions ont été le terreau de la Révolution française (1789) qui elle-même a inspiré multiples soulèvements en Europe et dans le monde. L’histoire politique a ainsi été mise en mouvement par une éruption volcanique pourtant très peu explosive, et dont les volumes émis peuvent paraître dérisoires, notamment s’ils sont comparés à d’autres évènements éruptifs documentés aux échelles de temps géologiques comme la mise en place des grandes provinces magmatiques (Deccan, Sibérie, etc.).

À lire aussi : Quand les éruptions volcaniques provoquent des tsunamis

Les éruptions du XIXᵉ siècle, impressionnisme et expressionnisme

Au contraire, l’éruption du Tambora en Indonésie en 1815, a été extrêmement explosive. Elle a entrainé « l’année sans été » de 1816 qui a vu les températures mondiales chuter de plusieurs degrés, provoquant des récoltes désastreuses en Europe et en Amérique du Nord, et entrainant famines et troubles sociaux, cette fois-ci moteur de migrations massives, notamment aux États-Unis. Cette éruption, projetant d’énormes quantités de cendres et de particules dans l’atmosphère, a engendré des couchers de soleil spectaculaires et un « ciel strié » pendant plusieurs mois.

Selon certains auteurs, ils ont pu inspirer des peintres comme William Turner (Le Dernier Voyage du Téméraire ; Le bateau négrier) et Caspar David Friedrich, dont des paysages romantiques, tels que dans le célèbre Voyageur au-dessus de la mer de nuages (1818), pourraient également refléter un ciel teinté par les cendres et les particules résultant de l’éruption.

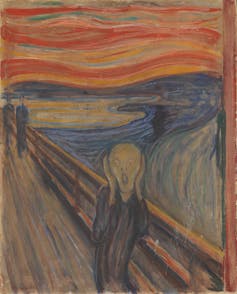

L’éruption cataclysmique du Krakatoa, à la fin du XIXe (1883), en plus des tsunamis dévastateurs qui ont tué des dizaines de milliers de personnes en Indonésie et ses environs, a également entrainé des phénomènes lumineux mondiaux remarquables liés aux particules dispersées dans l’atmosphère. Une étude a ainsi établi un lien entre l’éruption du Krakatoa et le spectaculaire crépuscule qui a inspiré l’une des peintures les plus célèbres du mouvement expressionniste : le Cri. Ce lien entre l’éruption du Krakatoa et l’œuvre de Munch reste débattu, certains auteurs préférant voir dans ce ciel inquiétant une figuration du phénomène purement météorologique des « nuages nacrés ».

Outre l’expressionnisme de Munch, certains auteurs estiment que l’impressionnisme de Claude Monet a pu être également influencé par le ciel chargé en aérosols volcaniques du Krakatoa. S’ils inspirent les volcanologues, les grands peintres inspirent également les géochimistes de l’environnement, qui préfèrent eux voir dans certaines de leurs toiles une représentation de phénomènes optiques liés à la pollution atmosphérique croissante en pleine révolution industrielle.

Diminuer la vulnérabilité aux éruptions

Le XXe siècle n’a pas été exempt d’éruptions, mais il a vu apparaître toute une série de mesures destinées à minimiser leurs impacts sur les populations. L’éruption de la montagne Pelée en 1902, dévastant la ville de Saint-Pierre en Martinique, a fait plus de 30000 victimes et engendré un déplacement massif de populations, modifiant la perception des risques volcaniques : les systèmes d’alerte ont été réévalués et des mesures de sécurité se sont développées et déployées dans les régions volcaniques.

De ce fait, l’éruption du Pinatubo (1991), aux Philippines, même si elle a été l’une des plus violentes du XXe siècle, a fait relativement peu de victimes (moins de 100) malgré la synchronicité de cet événement avec le passage du typhon Yunya. La surveillance volcanique couplée à des évacuations massives, a probablement sauvé des milliers de vies. Les systèmes actuels de surveillance des volcans combinent plusieurs techniques : des sismomètres mesurant les vibrations causées par les mouvements de magma, divers capteurs inspectant un éventuel bombement de la surface préalable à une éruption, des satellites de télédétection, des webcams et drones, ainsi que des dispositifs mesurant les émissions de gaz volcaniques. Des campagnes de sensibilisation et d’information et des procédures d’évacuation sont également préparées, limitant l’impact de possibles futures éruptions.

Les éruptions comme laboratoire d’étude

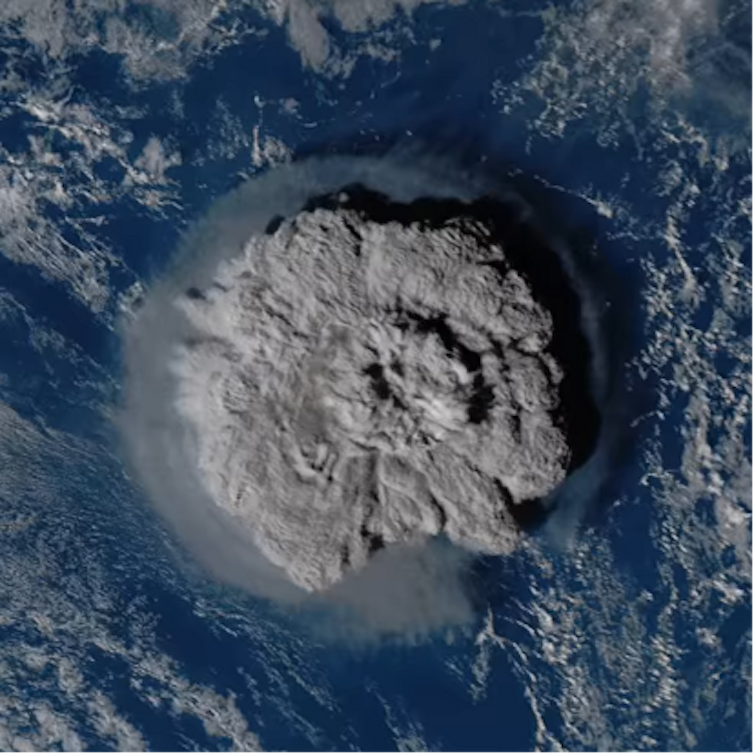

Très récemment, l’éruption sous-marine du Hunga Tonga, survenue le 15 janvier 2022 dans l’océan Pacifique Sud, a été d’une intensité extraordinaire, propulsant des cendres jusqu’à 58 km dans l’atmosphère et déclenchant des tsunamis dans plusieurs régions (l’Océanie mais également le Pérou ou la Californie).

Elle est considérée comme l’une des plus puissantes de l’histoire moderne, déployant une énergie cent fois supérieure à celle de la bombe nucléaire d’Hiroshima. Cette éruption a injecté environ 150 mégatonnes de vapeur d’eau dans la stratosphère, augmentant de 10 % la teneur stratosphérique en vapeur d’eau. Les températures dans la stratosphère tropicale ont de ce fait diminué d’environ 4 °C en mars et avril 2022. Les immenses quantités de vapeur d’eau injectées dans l’atmosphère par ce volcan ont, d’une certaine façon, permis de réaliser une expérience naturelle de géo-ingénierie, cette solution étant parfois envisagée comme une lutte de dernier recours contre le changement climatique.

Les éruptions volcaniques et leur étude n’ont sans doute pas fini d’influencer notre histoire.

Clément Ganino a reçu des financements de l'ANR et du CNRS.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Monde Diplomatique

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- CULTURE / IDÉES 1/2

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- IDÉES 2/2

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Pas des sites de confiance

- Contre-Attaque

- Korii

- Positivr

- Regain

- Slate

- Ulyces