25.02.2026 à 16:50

One Health : un label parfois flou, mais une approche scientifique éprouvée

Texte intégral (2130 mots)

La pandémie de Covid-19 a révélé l’urgence de repenser notre approche de la santé. Aujourd’hui, « One Health », qui relie la santé humaine, animale et environnementale, s’est imposée dans les discours, mais fait parfois l’objet de confusion, voire de détournements. Bien mise en œuvre, elle constitue pourtant une conception éprouvée pour renforcer la prévention sanitaire mondiale.

Pandémies, résistance antimicrobienne, maladies vectorielles, effondrement de la biodiversité, dégradation des sols, pollutions chimiques, crises alimentaires… nous avons aujourd’hui une conscience aiguë des liens étroits entre enjeux de santé humaine, animale et environnementale. Face à la multiplication des crises sanitaires, environnementales et climatiques, le concept « One Health » est devenu central pour les analyser et y répondre.

Issues de réflexions anciennes, ses bases fondatrices actuelles ont été posées par les principes de Manhattan, formulés en 2004 lors de la conférence « One World, One Health » organisée par la Wildlife Conservation Society. Ils reconnaissent l’interdépendance étroite entre la santé humaine, la santé animale et la santé des écosystèmes, et appellent à une approche intégrée pour prévenir les crises sanitaires, environnementales et sociales. Cette vision, qui dépasse la seule gestion des risques sanitaires, invite à repenser les modes de production, de consommation et de gouvernance. L’enjeu ? Préserver durablement les socioécosystèmes et les communautés qui en dépendent.

Malgré l’intérêt croissant que le One Health suscite, son utilisation en recherche et ses applications restent floues et souvent mal comprises. Trop souvent, il est réduit à un slogan politique ou à une gestion biomédicale des zoonoses, sans prendre en compte l’interdépendance des facteurs écologiques, sociaux et économiques. Ces derniers conditionnent pourtant la santé globale et la dynamique des crises sanitaires.

Un cadre opérationnel de prévention

Depuis plus de vingt ans, des initiatives portées par la science se développent pour mettre en œuvre de façon concrète l’approche « One Health ». Au Cirad, des travaux sur les maladies animales émergentes, les interfaces faune-élevage-humains et les systèmes agricoles tropicaux ont mis en évidence, dès les années 2000, les liens étroits entre santé, biodiversité et usages des territoires.

Nos recherches ont peu à peu intégré les dimensions environnementales, sociales et alimentaires. L’enjeu est de passer d’une logique de gestion des crises à une approche de prévention des risques d’émergence. En 2021, une coalition internationale portée par la recherche et baptisée PREZODE a été créée pour mener des opérations de prévention fondée sur l’approche One Health.

Elle intervient en Afrique, en Asie, en Amérique latine et dans les Caraïbes pour comprendre, réduire et détecter de façon précoce les risques en santé et éviter les épidémies.

Gestion des écosystèmes, agroécologie et surveillance sanitaire

En Guinée, ses équipes ont ainsi observé comment les pratiques agricoles intensives affectant la ressource forestière favorisaient l’intensification des contacts humains-faune. Ces contacts favorisent la transmission entre humains et animaux sauvages de maladies zoonotiques, comme les fièvres hémorragiques (Ebola, Lassa, Marburg).

Avec les communautés locales, des stratégies de prévention basées sur la gestion des écosystèmes ont été mises en place pour limiter le risque d’émergence de nouvelles épidémies.

À Madagascar, des scientifiques du Cirad, en partenariat avec l’ONG Pivot et l’Institut de recherche et de développement (IRD), ont développé une méthode de surveillance intégrée des risques sanitaires. Elle combine les données vétérinaires, humaines et environnementales, pour mieux anticiper les épidémies émergentes.

Au Gabon, dans le cadre d’un projet qui soutient les associations de chasseurs dans leur gestion des ressources forestières – y compris la biodiversité – nous avons mis en place un système de surveillance communautaire pour détecter très rapidement les évènements sanitaires suspects. Ceci a été mené en collaboration, avec le Centre interdisciplinaire de recherche médicale de Franceville (CIRMF).

En Asie du Sud-Est, les actions s’inscrivent dans une approche agroécologique qui articule les enjeux de santé et de gouvernance territoriale. Elles visent à accompagner des transitions agricoles et à réduire les pressions sur les écosystèmes (déforestation, usage des intrants, artificialisation). L’enjeu est d’améliorer la résilience des systèmes alimentaires locaux et la prévention des risques sanitaires, à l’interface entre humains, animaux et environnement.

Ces démarches reposent sur des diagnostics territoriaux participatifs, le croisement de données agricoles, écologiques et sanitaires et le soutien à des pratiques agroécologiques adaptées aux contextes locaux (diversification des cultures, gestion intégrée des élevages, restauration des paysages). L’objectif est de faire de l’agroécologie un levier pour prévenir les émergences infectieuses, améliorer la sécurité alimentaire et permettre un développement territorial durable, en cohérence avec l’approche One Health.

Une gouvernance fragmentée

Ces exemples illustrent l’efficacité d’une prévention alliant une vision systémique des enjeux sanitaires et une gouvernance partagée entre acteurs locaux, scientifiques et autorités gouvernementales. Malgré tout, de nombreux obstacles subsistent.

La fragmentation institutionnelle reste l’un des plus grands défis. À toutes les échelles, les secteurs de la santé, de l’agriculture et de l’environnement ne communiquent pas assez, ce qui freine la mise en œuvre d’une gouvernance efficace. La voix des communautés est rarement sollicitée. Les projets One Health sont, en outre, souvent financés à court terme et souvent fléchés sur les zoonoses uniquement. Cela alimente le flou autour du concept et n’encourage pas son appropriation par les pays qui en auraient pourtant le plus besoin.

Les acteurs de terrain soulignent que l’accès en temps utile à des données locales et nationales – depuis leur collecte jusqu’à leur partage et leur analyse – est central. Ce sont elles qui permettent de renforcer la surveillance et la prévention des maladies zoonotiques et construire des systèmes plus résilients, capables d’anticiper et d’atténuer en temps réel les menaces sanitaires actuelles et futures. Il est nécessaire, pour cela, d’être doté d’infrastructures de données solides et partagées entre les secteurs concernés, et de les mobiliser pour développer des outils de modélisation prédictive pertinents. Mais pas seulement : une réponse rapide, adaptée et coordonnée au niveau local peut suffire à prévenir les risques d’émergence.

Risque de « One Health washing »

Sans une collaboration efficace entre les secteurs, le risque est de voir se développer un « One Health washing ». Il existe de nombreux projets qui se revendiquent du concept, mais sans mettre en place de travaux ou d’actions réellement intégrées.

C’est le cas de publications traitant de pathogènes zoonotiques, mais uniquement focalisées sur la santé humaine. Idem pour certaines initiatives agricoles qui utilisent le terme abusivement. Toujours dans ce cadre, certaines études se réclament de l’approche One Health principalement au titre d’une mobilisation interprofessionnelle – par exemple via l’implication de réseaux vétérinaires dans le diagnostic humain – sans pour autant mettre en œuvre un véritable design d’étude intégrant conjointement des données humaines, animales et environnementales, ni analyser les effets d’une action spécifique sur les différents secteurs.

Pour autant, ces projets sont importants. Ils peuvent contribuer à renforcer des approches plus intégrées de la santé. À ce titre, ils constituent des étapes intermédiaires vers un One Health plus abouti. Le principal risque réside plutôt dans l’usage extensif et peu exigeant du terme One Health, qui, en devenant un label fourre-tout, finit par en affaiblir la portée scientifique, opérationnelle et politique.

Dans ce contexte, clarifier les fondements et les modalités d’application du One Health est essentiel. C’est l’objectif de l’Atlas One Health, qui propose une lecture de cette approche articulant santé humaine, animale, des écosystèmes, mais aussi agricultures et systèmes alimentaires, dynamiques sociales, gouvernance et territoires. Avec des études de cas, des cadres analytiques et des outils issus du terrain, cet ouvrage vise à faire du One Health un véritable cadre d’action collective et de prévention.

L’un des défis les plus importants est d’intégrer la dimension sociale et de genre pour garantir des solutions inclusives et efficaces. Ceci évitera des interventions mal adaptées qui risqueraient de creuser davantage les inégalités. En milieu rural notamment, les femmes jouent un rôle clé dans l’alimentation, l’approvisionnement en eau et la gestion des ressources naturelles. Elles restent pourtant souvent invisibles dans les politiques de santé publique et de prévention.

Un investissement plus qu’un coût

Le financement de la prévention One Health doit être considéré comme un investissement stratégique, et non comme un coût. Moins spectaculaires que la gestion des crises sanitaires, les approches préventives sont largement plus rentables et engendrent des co-bénéfices majeurs : adaptation et atténuation du changement climatique, systèmes agricoles plus durables, réduction des intrants chimiques, protection de la biodiversité et amélioration de la qualité de l’alimentation.

Les travaux menés par le Cirad, l’initiative PREZODE et toute la communauté internationale en faveur de ces principes s’accordent sur le constat que ces actions renforcent simultanément la santé, les moyens de subsistance et la résilience des territoires. Or, la prévention demeure trop dépendante de financements internationaux ponctuels : elle doit être inscrite dans des budgets nationaux pluriannuels intégrés aux politiques agricoles, sanitaires, environnementales et alimentaires, afin de soutenir des transformations structurelles durables.

Anticiper les crises demande de repenser fondamentalement nos systèmes. Une approche « One Health » transformatrice nécessite un engagement politique durable, de la coopération internationale et une volonté commune d’intégrer les dimensions sociales et écologiques dans la gestion des risques sanitaires. Un travail de longue haleine qui est déjà en marche. Ces messages seront portés au cours des évènements organisés par PREZODE lors du Sommet One Health, qui se tiendra à Lyon (Rhône), le 7 avril 2026 sous la présidence française du G7.

Marisa Peyre est membre de PREZODE

François Roger est affilié au CIRAD, partenaire du programme PREZODE mentionné dans cet article.

24.02.2026 à 19:44

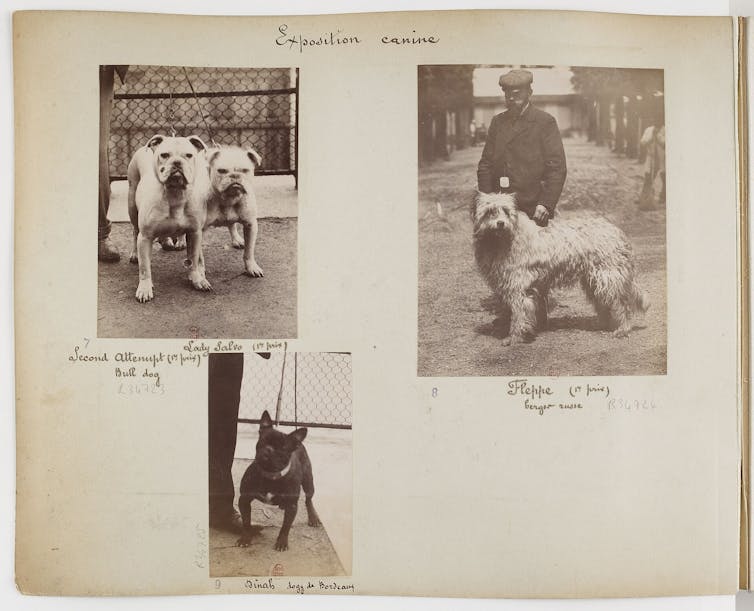

Chiens de race : l’esthétique peut-elle justifier la souffrance ?

Texte intégral (2737 mots)

Afin de limiter la souffrance animale, la Commission européenne tâche de poser des limites à la sélection génétique des races de chiens et de chats aux traits dits extrêmes. Si cette avancée demeure inédite, elle réagit à un phénomène tout sauf nouveau : l’obsession de l’être humain pour l’apparence des animaux domestiques.

Le Conseil et le Parlement européens ont récemment adopté une accord provisoire visant à encadrer plus strictement l’élevage des chiens et des chats, en interdisant notamment la reproduction et la mise en avant d’animaux présentant des « formes extrêmes ».

Sont particulièrement concernées certaines morphologies associées à des troubles graves et durables, comme les chiens au museau écrasé, chez lesquels les difficultés respiratoires, l’intolérance à l’effort ou les problèmes locomoteurs sont désormais bien documentés.

Cette évolution réglementaire répond à des alertes répétées du monde vétérinaire et à une sensibilité croissante de l’opinion publique à la souffrance animale. Elle s’inscrit également dans une longue histoire de la place démesurée accordée par les sociétés humaines à l’apparence des animaux domestiques et à leur volonté de la façonner.

Sélectionner l’apparence : une pratique ancienne aux usages multiples

Il est impossible de dater précisément le moment où les humains auraient commencé à sélectionner des animaux sur des critères esthétiques. Bien avant l’existence des « races » au sens moderne (un phénomène qui émerge au XIXᵉ siècle), des animaux étaient déjà choisis en fonction de leur sexe, de leur âge, de leur couleur ou de leur conformation.

Dans de nombreuses sociétés anciennes, les animaux destinés au sacrifice devaient ainsi répondre à des critères précis d’apparence et d’intégrité corporelle : dans les cultes grecs et romains, seuls des animaux « sans défauts » étaient admis devant les divinités ; en Chine, sous la dynastie Zhou (XIᵉ siècle avant notre ère), les sacrifices royaux exigeaient également des bêtes jugées parfaites, tant extérieurement qu’intérieurement.

Autrement dit la sélection sur l’apparence est probablement aussi ancienne que la domestication elle-même. Elle n’était jamais isolée : elle s’entremêlait à des critères religieux, sociaux, économiques ou politiques, par exemple lorsque le pouvoir politique affirme sa puissance en imposant des animaux sacrificiels répondant à des normes précises.

Ce qui change à l’époque contemporaine, c’est que l’apparence peut devenir, dans certains cas, le critère central, voire exclusif, de la création des races. Posséder un chien de race peut ainsi marquer un rang, une appartenance sociale ou un certain rapport au monde, comme d’autres animaux ont pu, à différentes époques, signaler le prestige ou le pouvoir de leur propriétaire, à commencer par le cheval, mais aussi certains chiens de chasse.

Une préoccupation tardive pour la santé et le bien-être

Les races modernes émergent au XIXᵉ siècle, dans un contexte marqué par le goût pour la classification, la hiérarchisation et la distinction sociale fondée sur la notion de « race ». Cette passion pour les lignées « pures » n’est pas sans lien avec les cadres intellectuels qui, à la même époque, voient se développer les théories raciales appliquées aux humains.

Pendant longtemps, les effets de la sélection ont été évalués presque exclusivement à l’aune de la productivité, de l’efficacité ou de la conformité à un standard. La souffrance animale était connue, mais largement tolérée, considérée comme secondaire, voire inévitable. Les pratiques vétérinaires elles-mêmes en témoignent : pendant une longue période, des interventions lourdes ont été pratiquées sans anesthésie, comme la stérilisation des chiennes.

D’autres gestes, aujourd’hui reconnus comme inutiles et douloureux, étaient également courants : on sectionnait par exemple le frein de la langue chez les chiens, dans l’idée erronée de prévenir la rage.

Ces pratiques témoignent d’un rapport au corps animal dans lequel la souffrance était largement ignorée, par indifférence plus que par méconnaissance.

Ce n’est qu’à partir de la seconde moitié du XXᵉ siècle que la douleur chronique, la qualité de vie ou la santé à long terme des animaux commencent à être pensées comme des problèmes en tant que tels. Les inquiétudes actuelles concernant les chiens aux morphologies extrêmes – difficultés respiratoires, troubles locomoteurs, intolérance à l’effort – s’inscrivent pleinement dans cette histoire récente de la sensibilité au bien-être animal.

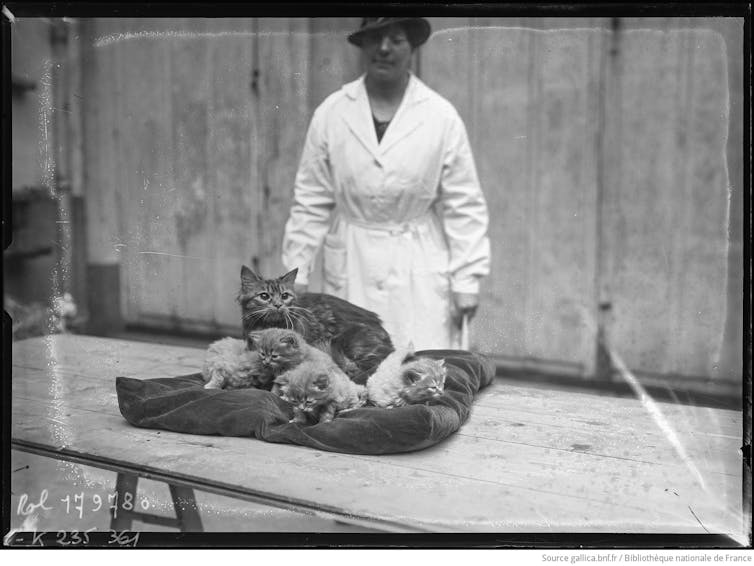

Des chats qui ont longtemps échappé à cette logique

La récente réglementation européenne semble concerner plus directement les chiens que les chats, et cette impression correspond à une réalité historique, biologique et sociologique. En France, comme dans de nombreux pays européens, les chiens de race sont proportionnellement plus nombreux que les chats de race. Cette différence s’explique en grande partie par l’histoire de l’élevage.

L’intérêt pour les races de chiens est ancien et structurant. La sélection de types morphologiques spécifiques devient l’un des moteurs centraux de l’élevage canin au XIXᵉ siècle, en systématisant et en normant des pratiques bien plus anciennes de différenciation fonctionnelle. Dès l’Antiquité, certains chiens sont ainsi recherchés pour des usages guerriers ou de combat, en fonction de leur taille, de leur puissance ou de leur agressivité.

Ce type de sélection n’est d’ailleurs pas propre aux chiens : chez les gallinacés, des individus ont été privilégiés très tôt pour des usages non alimentaires, notamment pour le combat de coqs ou comme animaux d’ornement, bien avant que ne s’impose une sélection orientée vers la production de chair ou d’œufs.

À l’inverse, les chats ont longtemps échappé à cette logique. Les premiers concours félins du XIXᵉ siècle récompensaient des individus – souvent des chats de gouttière – et non des représentants de races qui n’étaient pas encore standardisées. Le chat est resté plus longtemps un animal ordinaire, moins soumis aux impératifs de sélection morphologique.

Quels chiens demain ?

Les croisements récents, comme le pomsky (issu du croisement du husky sibérien et du spitz nain), témoignent aujourd’hui d’une forte demande pour des animaux perçus comme originaux et attendrissants, mais qui sont surtout emblématiques d’un effet de mode.

Le choix de ces chiens relève moins d’une réflexion sur leurs besoins ou leur santé que d’une logique de distinction : on choisit un chien comme on choisirait une paire de chaussures, parce qu’il flatte l’ego de son propriétaire et signale une position sociale. Dénoncées depuis longtemps par les vétérinaires, qui constatent au quotidien les conséquences de la sélection de morphologies extrêmes, ces pratiques pourraient être freinées par la nouvelle réglementation européenne, en rappelant clairement que tout croisement n’est pas acceptable dès lors qu’il compromet la santé ou le bien-être des animaux concernés.

Prédire à quoi ressembleront les chiens du futur reste toutefois hasardeux. L’histoire montre que les avancées en matière de protection animale ne sont ni linéaires ni irréversibles. L’émergence d’idéologies brutales ou violentes pourrait très bien conduire à un recul de la prise en compte de la souffrance animale. L’interdiction des formes extrêmes révèle ainsi une tension ancienne entre la vanité des désirs humains parfois cruels et la nécessité d’établir des règles morales pour en limiter les effets – un débat aussi vieux que la philosophie elle-même.

Cette réflexion trouve un écho particulier dans certaines initiatives muséales récentes. L’exposition « Domestique-moi, si tu peux », présentée au Muséum de Toulouse (Haute-Garonne), propose ainsi de revisiter l’histoire longue de la domestication en montrant qu’il ne s’agit pas d’un phénomène « naturel » et qu’elle est façonnée par des choix humains parfois irrationnels. Elle met surtout en évidence la place centrale de la domestication dans la construction des cultures humaines, la sélection artificielle ayant pour objectif principal de rendre des organismes vivants – animaux comme végétaux – compatibles avec les modes de vie et les besoins humains.

L’exposition « Domestique-moi, si tu peux » retrace l’histoire des domestications animales et végétales et leurs conséquences sur la biodiversité. On peut la visiter jusqu’au 5 juillet 2026 au Muséum de Toulouse. L’historienne Valérie Chansigaud en est la commissaire scientifique.

Valérie Chansigaud ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

24.02.2026 à 17:03

Les raisons de la mobilisation agricole en Europe expliquées par les agriculteurs eux-mêmes

Texte intégral (2051 mots)

Depuis l’hiver 2024, les mobilisations agricoles ont été largement interprétées, au plan médiatique, comme un rejet massif des normes environnementales. Mais est-ce vraiment le cas ? Qu’en disent eux-mêmes les agriculteurs mobilisés ? Une vaste étude a recensé leurs réponses en France, en Allemagne, en Belgique et aux Pays-Bas. Elle livre une image bien plus nuancée en fonction des États, où le poids des normes environnementales n’est finalement qu’un enjeu secondaire. Celui-ci a pourtant été au cœur de la réponse politique.

Blocages d’autoroutes, convois de tracteurs vers les capitales, déversements de fumier devant les bâtiments publics… depuis l’hiver 2024, les agriculteurs européens se mobilisent de façon spectaculaire. Très visibles, ces mouvements restent pourtant mal compris. Entre cadrages médiatiques hâtifs et récupérations politiques, leurs revendications ont souvent été résumées à un rejet des normes environnementales. Mais est-ce réellement ce que disent les agriculteurs eux-mêmes ?

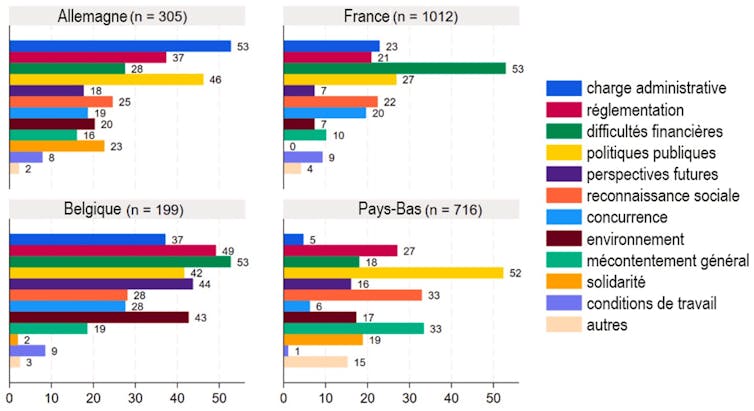

Pour répondre à cette question, nous avons récemment publié une étude qui s’est appuyée sur une vase enquête en ligne, menée entre avril et juillet 2024, auprès de plus de 2 200 agriculteurs ayant participé aux mobilisations en France, en Allemagne, en Belgique et aux Pays-Bas.

Plutôt qu’une liste fermée de griefs, nous avons préféré leur poser une question simple et surtout ouverte : « Pourquoi vous mobilisez-vous ? » Les agriculteurs ont ainsi pu répondre de façon anonyme et sous une forme libre : parfois en quelques mots, parfois en plusieurs paragraphes.

À lire aussi : Colère des agriculteurs : « Ce qui était cohérent et cohésif est devenu explosif »

Une pluralité de motivations

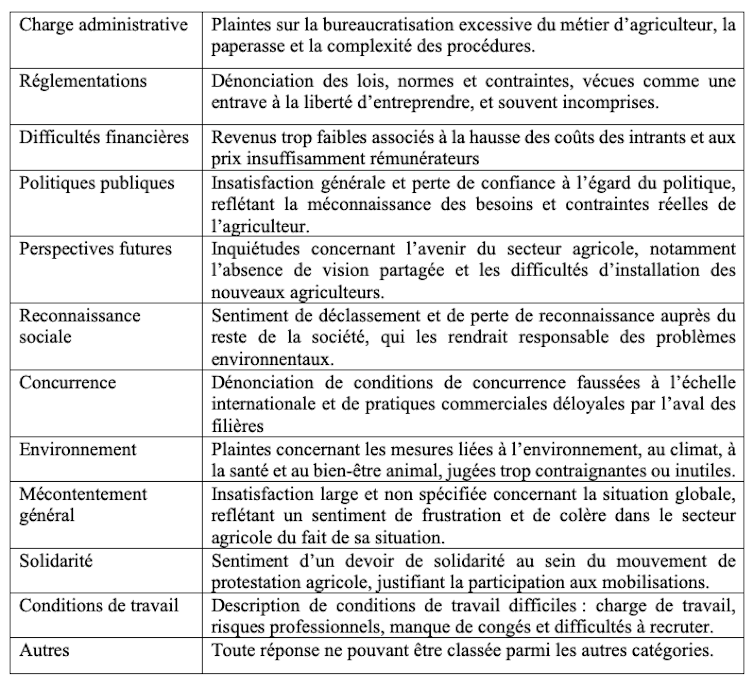

Cette méthode a permis d’éviter d’orienter les réponses et de saisir les motivations telles que formulées spontanément par les intéressés eux-mêmes. Les textes ont ensuite été analysés, dans leur langue d’origine, grâce à un grand modèle de langage (LLM), type d’outil relevant de l’intelligence artificielle (IA), pour identifier les principales revendications. Un codage manuel a ensuite permis, pour la France, de vérifier la cohérence de l’analyse faite par l’IA.

Nous avons ainsi pu identifier les grands thèmes récurrents, et ceci en limitant les biais d’interprétation. À la clé, une dizaine de catégories de motivations, que nous avons résumées dans le tableau ci-dessous :

En termes de codage, une réponse peut entrer dans plusieurs catégories de motivations à la fois. Par exemple, un exploitant français cultivant 175 hectares (ha) a indiqué en réponse à l’enquête :

« On nous fait marcher à la baguette, on nous pond des interdictions de partout qui nous compliquent [le] travail, alors que l’on travaille beaucoup à un tarif horaire de misère. »

Cette réponse a pu ainsi être classée à la fois dans les catégories « réglementation », « difficultés financières », « politiques publiques » et « conditions de travail ».

Des revendications différenciées en Europe

Contrairement à l’idée d’un mouvement unifié partout en Europe autour du rejet des normes environnementales et des insatisfactions liées au revenu, les motivations sont apparues comme fortement différenciées selon les pays.

En France et en Belgique, les difficultés financières dominent largement : plus d’un agriculteur sur deux évoque la faiblesse des revenus, la hausse des coûts des intrants et des prix jugés insuffisamment rémunérateurs.

En Allemagne, la première préoccupation concerne la charge administrative, citée dans plus de la moitié des réponses.

Aux Pays-Bas, les critiques visent plus directement l’inadéquation des réponses en terme de politiques publiques aux besoins et contraintes du monde agricole.

La dénonciation explicite des règles environnementales arrive loin derrière, sauf dans le cas de la Belgique. En France, elle n’est mentionnée que dans une faible proportion des réponses, bien en deçà des enjeux de revenu, de reconnaissance ou de concurrence.

Le mouvement de 2024 apparaît ainsi loin d’être homogène à l’échelle européenne, malgré les tentatives de certains acteurs syndicaux de porter un message unitaire.

À lire aussi : La FNSEA, syndicat radical ? Derrière le mal-être des agriculteurs, des tensions plus profondes

Un décalage entre les revendications et les réponses politiques

Nous avons ensuite comparé ces motivations aux mesures politiques adoptées entre fin 2023 et septembre 2024 aux niveaux national et européen.

Dans certains cas, les réponses publiques ont été en phase avec les préoccupations exprimées. En Allemagne, l’accent a été mis sur la simplification administrative, qui correspond à la principale revendication identifiée dans notre enquête. En France et en Belgique, plusieurs mesures ont visé à atténuer les difficultés de revenu, mais les moyens mis en œuvre sont restés limités.

En revanche, certaines thématiques ont reçu une attention politique disproportionnée au regard de leur poids réel dans les déclarations des agriculteurs. C’est notamment le cas des régulations environnementales.

Cela s’est traduit notamment dans le paquet simplification de la politique agricole commune (PAC) de mai 2024, qui a accordé des dérogations et des flexibilités supplémentaires à l’application des règles de conditionnalité dans les États membres.

Alors qu’elle n’arrivait qu’en septième position des préoccupations déclarées par les agriculteurs, la réduction des contraintes environnementales a été le troisième chantier législatif en Allemagne, en terme de nombre de mesures prises. Aux Pays-Bas, ce fut même le premier.

De la même manière en France, seuls 7 % des agriculteurs se sont exprimés explicitement pour critiquer le poids des normes environnementales. Pourtant, le gouvernement français a répondu par une suspension du plan Écophyto (destiné à réduire l’usage des pesticides) et par l’allègement des contrôles liés aux obligations environnementales.

Plus tard, une grande partie des débats sur le contenu de la loi d’orientation pour la souveraineté alimentaire et le renouvellement des générations en agriculture, finalement promulguée en mars 2025, et de la proposition de loi sur les contraintes à l’exercice du métier d’agriculteur (dite « loi Duplomb »), ont été extrêmement concentrés sur l’allègement des normes environnementales.

À lire aussi : Loi Duplomb et pesticides : comment la FNSEA a imposé ses revendications

Entre expression sociale et cadrage stratégique

Cette focalisation sur les normes environnementales interroge. Elle suggère que certaines revendications ont été amplifiées dans l’espace public, au croisement d’intérêts syndicaux, économiques et politiques. Comme dans tout mouvement social, les mots d’ordre qui circulent ne reflètent pas toujours l’ensemble des préoccupations individuelles.

Donner directement la parole aux agriculteurs ne permet pas seulement de nuancer le récit dominant : cela met en lumière la profondeur du malaise. Au-delà des normes ou des aides, beaucoup expriment un sentiment de déclassement, de perte de sens et d’absence de perspectives pour les générations futures.

Comprendre ces mobilisations suppose donc d’aller au-delà des slogans et de reconnaître leur diversité interne. Faute de quoi, les réponses politiques risquent de traiter seulement les symptômes stratégiquement mis en visibilité par les groupes d’influence plutôt que les causes structurelles du malaise agricole européen.

Solal Courtois-Thobois a participé à la réalisation de cet article.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.