ACCÈS LIBRE Une Politique International Environnement Technologies Culture

15.10.2025 à 11:41

Les « marques de cure-dents » sur les fossiles préhistoriques n’en étaient peut-être pas

Texte intégral (2388 mots)

Une étude sur plus de 500 primates sauvages montre que les « sillons de cure-dents » sur les dents fossiles peuvent se former naturellement, tandis que certaines pathologies modernes, comme les abfractions, sont propres aux humains.

Depuis des décennies, de fines rainures observées sur des dents humaines préhistoriques étaient interprétées comme la preuve d’un geste délibéré : des humains nettoyant leurs dents à l’aide de petits bâtons ou de fibres végétales, ou cherchant à soulager une douleur gingivale. Certains chercheurs y ont même vu la plus vieille habitude humaine.

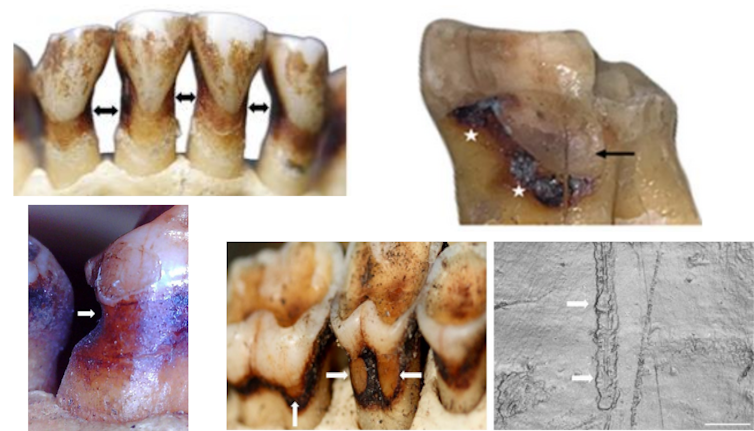

Mais selon une étude publiée dans l’American Journal of Biological Anthropology, cette hypothèse serait à revoir. Les auteurs ont constaté que ces mêmes stries apparaissent aussi naturellement chez des primates sauvages, sans qu’aucun comportement de curetage dentaire ne soit observé. Encore plus surprenant : l’analyse de plus de 500 primates, appartenant à 27 espèces vivantes ou fossiles, n’a révélé aucune trace d’une maladie dentaire fréquente chez l’humain moderne, les lésions dites d’abfraction – ces entailles profondes en forme de V au niveau de la gencive.

Ces découvertes invitent à repenser l’interprétation des fossiles et ouvrir de nouvelles pistes sur ce qui, dans l’usure et les pathologies de nos dents, témoigne d’une évolution proprement humaine.

Pourquoi les dents comptent dans l’évolution humaine

Les dents sont la partie la plus résistante du squelette et survivent souvent bien après la décomposition du reste du corps. Les anthropologues s’en servent pour reconstituer les régimes alimentaires, les modes de vie et l’état de santé des populations anciennes.

Même les plus petites marques peuvent avoir une grande signification. L’une des plus fréquentes est une fine rainure qui traverse la racine exposée de certaines dents, souvent entre deux d’entre elles. Depuis le début du XXᵉ siècle, ces traces ont été baptisées « marques de cure-dent » et interprétées comme les signes d’un usage d’outils ou de pratiques d’hygiène dentaire.

On en a signalé tout au long de notre histoire évolutive, sur des fossiles vieux de deux millions d’années jusqu’aux Néandertaliens. Mais jusqu’ici, personne n’avait réellement vérifié si d’autres primates présentaient ces mêmes marques. Une autre affection, appelée abfraction, se manifeste différemment : par des entailles profondes en forme de coin à la base de la gencive. Très fréquentes en dentisterie moderne, elles sont souvent associées au grincement des dents, à un brossage trop vigoureux ou à la consommation de boissons acides. Leur absence sur les fossiles connus intrigue depuis longtemps les chercheurs : les autres primates en sont-ils vraiment exempts ?

Ce que nous avons fait

Pour vérifier ces hypothèses, nous avons analysé plus de 500 dents appartenant à 27 espèces de primates, actuelles et fossiles. L’échantillon comprenait notamment des gorilles, des orang-outans, des macaques, des colobes et plusieurs singes disparus. Fait essentiel, tous les spécimens provenaient de populations sauvages, ce qui signifie que l’usure de leurs dents n’a pas pu être influencée par les brosses à dents, les boissons gazeuses ou les aliments transformés.

Nous avons recherché des lésions cervicales non carieuses – un terme désignant une perte de tissu au niveau du col de la dent qui n’est pas causée par la carie. À l’aide de microscopes, de scanners 3D et de mesures de perte de tissu, nous avons documenté même les plus petites lésions.

Ce que nous avons découvert

Environ 4 % des individus présentaient des lésions. Certaines ressemblaient presque exactement aux classiques « sillons de cure-dents » observés sur les fossiles humains fossiles, avec de fines rayures parallèles et des formes effilées. D’autres lésions étaient peu profondes et lisses, surtout sur les dents de devant, probablement causées par les fruits acides que beaucoup de primates consomment en grande quantité.

Mais une absence nous a frappé. Nous n’avons trouvé aucune lésion par abfraction. Malgré l’étude d’espèces ayant une alimentation extrêmement dure et des forces de mastication puissantes, aucun primate n’a présenté les défauts en forme de coin si couramment observés dans les cliniques dentaires modernes.

Qu’est-ce que cela signifie ?

Premièrement, cela signifie que les sillons ressemblant à des marques de cure-dents ne prouvent pas nécessairement l’utilisation d’outils. La mastication naturelle, les aliments abrasifs, ou même le sable ingéré peuvent produire des motifs similaires. Dans certains cas, des comportements spécialisés, comme arracher de la végétation avec les dents, peuvent également y contribuer. Il faut donc rester prudent avant d’interpréter chaque sillon fossile comme un acte délibéré de curetage dentaire.

Deuxièmement, l’absence totale de lésions par abfraction chez les primates suggère fortement qu’il s’agit d’un problème propre aux humains, lié à nos habitudes modernes. Elles sont beaucoup plus probablement causées par un brossage trop vigoureux, les boissons acides et les régimes alimentaires transformés que par les forces de mastication naturelles. Cela place les abfractions aux côtés d’autres problèmes dentaires, comme les dents de sagesse incluses ou les dents mal alignées, qui sont rares chez les primates sauvages mais fréquents chez l’homme aujourd’hui. Ces observations alimentent un domaine de recherche émergent appelé odontologie évolutive, qui utilise notre passé évolutif pour comprendre les problèmes dentaires actuels.

Pourquoi est-ce important aujourd’hui ?

À première vue, les sillons sur les dents fossiles peuvent sembler anecdotiques. Pourtant, ils ont une importance à la fois pour l’anthropologie et pour la dentisterie. Pour la science évolutive, ils montrent qu’il est essentiel d’observer nos plus proches parents avant de conclure à une explication culturelle spécifique ou unique. Pour la santé moderne, ils mettent en évidence à quel point nos régimes alimentaires et nos modes de vie modifient profondément nos dents, nous distinguant des autres primates.

En comparant les dents humaines à celles des autres primates, il devient possible de distinguer ce qui est universel (l’usure inévitable due à la mastication) de ce qui est propre à l’homme – le résultat des régimes alimentaires, des comportements et des soins dentaires modernes.

Et ensuite ?

Les recherches futures porteront sur des échantillons plus larges de primates, examineront les liens entre régime alimentaire et usure dentaire dans la nature, et utiliseront des techniques d’imagerie avancées pour observer la formation des lésions. L’objectif est d’affiner notre interprétation du passé tout en découvrant de nouvelles façons de prévenir les maladies dentaires aujourd’hui.

Ce qui peut ressembler à un sillon de cure-dents sur une dent humaine fossile pourrait tout aussi bien être un simple sous-produit de la mastication quotidienne. De même, il pourrait refléter d’autres comportements culturels ou alimentaires laissant des marques similaires. Pour démêler ces possibilités, il faut disposer de jeux de données comparatifs beaucoup plus larges sur les lésions des primates sauvages ; ce n’est qu’ainsi que l’on pourra identifier des tendances générales et affiner nos interprétations du registre fossile.

Parallèlement, l’absence de lésions par abfraction chez les primates suggère que certains de nos problèmes dentaires les plus courants sont propres à l’homme. Cela rappelle que même dans quelque chose d’aussi quotidien qu’un mal de dents, notre histoire évolutive est inscrite dans nos dents, mais façonnée autant par nos habitudes modernes que par notre biologie ancienne.

Ian Towle reçoit un financement du Conseil australien de la recherche (Australian Research Council, ARC DP240101081).

15.10.2025 à 11:41

Une expérience pour enfin comprendre comment les navigateurs du Pacifique se repéraient sans instruments

Texte intégral (2071 mots)

Un plongeon au cœur de l’océan Pacifique pour comprendre comment, sans instruments ni technologie, les navigateurs des îles Marshall lisaient les vagues, le vent et les étoiles pour retrouver leur chemin, et comment les neurosciences modernes tentent de décrypter ce savoir ancestral.

L’un des plus grands défis de la navigation consiste à savoir où l’on se trouve au milieu de l’océan, sans le moindre instrument. Cette aptitude extraordinaire est illustrée par les techniques ancestrales qu’utilisaient autrefois les navigateurs chevronnés des îles Marshall, un chapelet d’îles et d’atolls coralliens situés entre Hawaï et les Philippines.

Aux côtés d’un neuroscientifique spécialiste de la cognition, d’un philosophe, d’une anthropologue marshallaise et de deux marins autochtones, j’ai pris part à une expédition destinée à comprendre comment les navigateurs marshallais se repèrent en mer grâce à leur environnement. À bord du Stravaig, un trimaran (une embarcation à trois coques) de douze mètres, le vent et les vagues nous ont portés sur soixante milles nautiques, de l’atoll de Majuro à celui d’Aur.

Une compétence extraordinaire

Durant les six années que j’ai vécues aux îles Marshall, je n’avais jamais dépassé Eneko, un petit îlot situé à l’intérieur du lagon de Majuro. J’étais sans cesse ramenée au récif, là où le lagon rejoint l’océan, observant l’écume blanche se former lorsque les vagues se brisaient contre la barrière qui protégeait l’atoll.

C’est la connaissance intime de ces vagues que le « ri meto » – littéralement « la personne de la mer », titre conféré par le chef au navigateur – consacrait sa vie à maîtriser. En percevant les infimes variations de la houle, le « ri meto » pouvait déterminer la direction et la distance d’îles situées à des milliers de kilomètres au-delà de l’horizon.

Grâce à ce savoir ancestral, le « ri meto » maîtrisait l’une des compétences les plus extraordinaires jamais acquises par l’être humain : la navigation dans le Pacifique. Mais l’histoire tragique des îles Marshall a fait disparaître cette pratique, et il n’existe aujourd’hui plus aucun « ri meto » officiellement reconnu.

Alson Kelen est l’élève du dernier « ri meto » connu. Ses parents ont été déplacés de l’atoll de Bikini, au nord de l’archipel, lors du programme nucléaire américain qui a fait exploser soixante-sept bombes atomiques et thermonucléaires dans les îles Marshall dans les années 1940 et 1950.

Le rôle des neurosciences

Au-delà des destructions et des souffrances immenses qu’il a provoquées, ce programme a brisé la transmission intergénérationnelle des savoirs traditionnels, notamment celui de la navigation. Dans le cadre des efforts de renaissance menés par l’anthropologue Joseph Genz, Alson Kelen a, en 2015, pris la barre du jitdaam kapeel, une pirogue traditionnelle marshallaise, pour rallier Majuro à Aur en s’appuyant uniquement sur les techniques de navigation ancestrales qu’il avait apprises auprès de son maître.

Inspirée par cette expérience, je me suis interrogée sur le rôle que les neurosciences pouvaient jouer dans la compréhension de l’orientation en mer. Des travaux de recherche sur la navigation spatiale ont montré comment les processus neuronaux et cognitifs du cerveau nous aident à nous repérer. La plupart de ces études portent toutefois sur la navigation terrestre, menée en laboratoire ou dans des environnements contrôlés à l’aide de jeux vidéo ou de casques de réalité virtuelle. En mer, les exigences cognitives sont bien plus grandes : il faut composer avec des facteurs en constante évolution, comme la houle, le vent, les nuages et les étoiles.

Neuroscience de la navigation

Directeur de Waan Aelon in Majel, une école locale de construction et de navigation de pirogues, Alson Kelen a choisi deux marins traditionnels chevronnés pour se joindre à notre expédition de recherche.

À l’approche du chenal, les vagues régulières du lagon ont laissé place à la houle plus lourde de l’océan qui frappait la coque. L’équipage a resserré les cordages, les voiles ont été hissées. Soudain, j’ai senti la houle dominante venue de l’est soulever le bateau. Nous venions de quitter le calme du lagon et mettions le cap sur l’atoll d’Aur.

Pendant les deux jours suivants, le Stravaig est devenu notre laboratoire flottant. Durant plus de quarante heures, nous avons recueilli des données cognitives et physiologiques sur les neuf membres de l’équipage, ainsi que des données environnementales continues dans un milieu en perpétuelle évolution.

Nous avons demandé à chacun de suivre sa position estimée tout au long du voyage. Seuls deux membres de l’équipage – le capitaine et son second – avaient accès au GPS à intervalles réguliers ; les autres se fiaient uniquement à l’environnement et à leur mémoire. Toutes les heures, chaque membre indiquait sur une carte l’endroit où il pensait se trouver, ainsi que ses estimations du temps et de la distance restant avant d’apercevoir les premiers signes de terre, puis avant l’arrivée sur l’atoll. Ils notaient également tous les repères environnementaux utilisés, tels que les vagues, le vent ou la position du soleil.

Une boussole recouverte

L’équipage évaluait également quatre émotions clés tout au long du trajet : bonheur, fatigue, inquiétude et mal de mer. Chaque membre portait une montre connectée Empatica, qui enregistrait les variations de fréquence cardiaque.

Un accéléromètre était fixé sur le pont supérieur pour enregistrer les mouvements du bateau au gré des vagues. Une caméra GoPro 360° montée séparément capturait les variations des voiles, des nuages, du soleil et de la lune, ainsi que les déplacements de l’équipage sur le pont.

Juste avant que le dernier morceau de terre ne disparaisse sous l’horizon, chaque membre de l’équipage a désigné cinq atolls : Jabwot, Ebeye, Erikub, Aur Tabal, Arno et Majuro. Une boussole recouverte servait à enregistrer les relevés. Cette opération a été répétée tout au long du voyage afin de tester les compétences d’orientation sans référence à la terre.

À la fin de cette traversée, nous disposions d’une riche collection de données mêlant expériences subjectives et mesures objectives de l’environnement. Chaque estimation tracée sur la carte, chaque émotion, chaque variation de fréquence cardiaque était enregistrée en parallèle des changements de houle, de vent, de ciel et des relevés GPS. Ces nouvelles données constituent la base d’un modèle capable de commencer à expliquer le processus cognitif de l’orientation en mer, tout en offrant un aperçu de cette capacité humaine ancestrale que le « ri meto » maîtrisait depuis longtemps.

Ce projet de recherche est dirigé par le professeur Hugo Spiers, professeur de neurosciences cognitives à l’University College London. L’équipe de recherche comprend : Alson Kelen, directeur de Waan Aelon in Majel ; le professeur Joseph Genz, anthropologue à l’Université de Hawaï à Hilo ; le professeur John Huth Donner, professeur de physique à Harvard University ; le professeur Gad Marshall, professeur de neurologie à la Harvard Medical School ; le professeur Shahar Arzy, professeur de neurologie à l’Université hébraïque de Jérusalem ; le Dr Pablo Fernandez Velasco, postdoctorant financé par la British Academy à l’Université de Stirling ; Jerolynn Neikeke Myazoe, doctorante à l’Université de Hawaï à Hilo ; Clansey Takia et Binton Daniel, instructeurs de navigation et de construction de pirogues traditionnelles WAM ; Chewy C. Lin, réalisateur de documentaires ; et Dishad Hussain, directeur chez Imotion Films. Ce projet a été soutenu par le Royal Institute of Navigation, l’University College London, le Centre for the Sciences of Place and Memory de l’Université de Stirling (financé par le Leverhulme Trust), le Royal Veterinary College, Glitchers, Neuroscience & Design, Empatica, Imotion et Brunton.

15.10.2025 à 11:41

Blazars, ces phares cosmiques qui nous guident depuis les tréfonds du cosmos

Texte intégral (2396 mots)

Les humains utilisent les astres pour se repérer depuis la nuit des temps. Aujourd’hui, la précision de nos systèmes de géolocalisation dépend des blazars, ces phares cosmiques qui abritent des trous noirs. Découvrons leurs mystères en nous aidant de l’analogie avec les phares qui ponctuent la côte et qui guident les marins dans la nuit.

Depuis la plage du Prat, au cœur de l’île d’Ouessant (Finistère), on aperçoit l’imposant phare du Créac’h au-dessus des flots. Par nuit claire, le phare de Créac’h est visible à plus de 32 milles marins (environ 60 kilomètres). Considéré comme le phare le plus puissant d’Europe, le Créac’h est un guide inestimable pour les équipages des bateaux, suppléant aux systèmes de navigation par satellite utilisés en cabine.

De nos jours, nous utilisons quotidiennement le positionnement par satellite via nos téléphones portables. Cependant, nous oublions souvent que la précision de ces systèmes de localisation repose sur des principes de physique fondamentale et des mesures d’astronomie de pointe.

Dans le passé, les marins utilisaient comme points de référence l’étoile Polaire ou des galaxies proches, telles que les nuages de Magellan situés à quelques centaines de milliers d’années-lumière. Le positionnement des satellites repose quant à lui sur l’utilisation de points lumineux sur la voûte céleste dont la direction est suffisamment stable. Les points de référence les plus stables connus sont des balises cosmiques situées à plusieurs milliards d’années-lumière. Leurs noms ? Les blazars.

Des feux ardents au voisinage des trous noirs

Les théories de la relativité générale et restreinte d’Einstein sont au cœur de notre compréhension des blazars. Le feu d’un phare comme le Créac’h est constitué de puissantes lampes halogènes dont le faisceau est concentré par des lentilles de Fresnel.

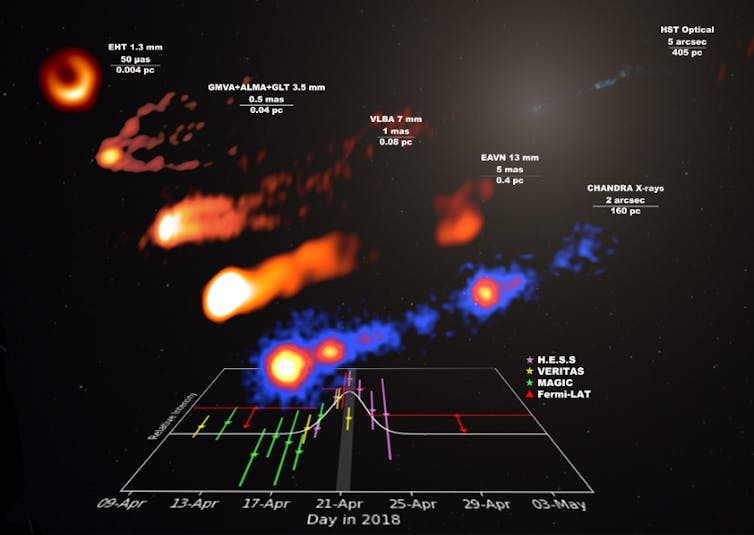

Un blazar est quant à lui constitué de deux faisceaux, des jets faits de plasma se déplaçant à plus de 99,5 % de la vitesse de la lumière. Contrairement aux faisceaux de phares, les jets de blazars ne tournent pas : ils restent relativement stables du point de vue de l’observateur.

À l’origine de ces jets se trouve un trou noir des milliers de fois plus massif que celui situé au centre de notre galaxie. C’est la rotation du trou noir sur lui-même et celle du disque de matière l’entourant qui permettent d’injecter de l’énergie dans les jets. La source d’énergie à l’origine de la lumière d’un blazar est donc paradoxalement un trou noir !

Ces jets astrophysiques sont observés dans des galaxies proches comme la radiogalaxie Messier 87. Depuis la Terre, les deux jets de cette galaxie sont observés de biais. L’un des deux jets est plus brillant car le plasma qu’il émet a tendance à s’approcher de nous, tandis que le plasma émis par l’autre jet s’éloigne. Plus l’angle entre le faisceau du phare et notre ligne de visée (l’axe entre le phare et l’observateur) est grand, plus la lumière que nous recevons du faisceau est faible. Mais que se passerait-il si l’un des jets était dirigé vers la Terre ? Nous observerions un phare extrêmement lumineux : un blazar. Une radio galaxie comme Messier 87 n’est donc rien d’autre qu’un blazar désaxé.

Un blazar, défini par l’orientation d’un de ses jets vers la Terre, peut ainsi être des dizaines de milliers de fois plus brillant qu’une radio galaxie située à la même distance.

Un faisceau qui produit sa propre lumière

Les lentilles de Fresnel du Créac’h concentrent la lumière de lampes halogènes en faisceaux de photons qui voyagent jusqu’aux équipages marins. Pour les blazars, c’est un plasma de particules énergétiques qui se propagent selon l’axe des jets. Ces particules perdent une partie de leur énergie en émettant de la lumière dans le domaine visible et en ondes radio, par rayonnement synchrotron. C’est ce même rayonnement qui limite les énergies qu’atteignent les accélérateurs de particules construits sur Terre, tel le grand collisionneur de hadrons (LHC) du CERN.

Mais si les pertes synchrotron constituent un facteur limitant pour les ingénieurs de faisceaux de particules terrestres, elles offrent aux astronomes et physiciens des astroparticules une formidable fenêtre d’observation sur des phénomènes naturels autrement plus énergétiques que ceux des accélérateurs artificiels.

Ainsi, les pertes par rayonnement des blazars ne se limitent pas aux ondes radio et à la lumière visible. Elles s’étendent également aux rayons X et aux rayons gamma.

Les rayons gamma les plus énergétiques en provenance de blazars ont été observés à des énergies dix mille milliards de fois supérieures à celle des photons visibles. Les particules qui ont émis ces rayons gamma sont encore plus énergétiques, jusqu’à des millions de fois s’il s’agit de rayons cosmiques de type protons plutôt que d’électrons.

Identifier la nature des particules émettant les rayons gamma des blazars pourrait ainsi éclairer le mystère encore tenace de l’origine des rayons cosmiques et des neutrinos les plus énergétiques que nous observons.

Apercevoir les blazars dans la brume cosmique

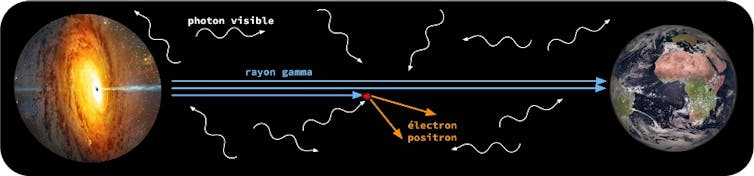

Les blazars les plus éloignés émettent depuis une époque correspondant au premier milliard d’années suivant le Big Bang, dans un univers qui soufflera bientôt ses 14 milliards de bougies. La quantité de rayons gamma qui nous parvient des phares lointains est faible, non seulement en raison de leur distance, mais aussi à cause d’une brume un peu particulière qui imprègne même les régions les plus reculées du cosmos.

Par temps brumeux, le phénomène qui limite la portée du Créac’h est la diffusion de la lumière visible par les minuscules gouttelettes d’eau qui composent le brouillard. Le feu du phare, que les marins devraient voir comme une source quasi ponctuelle, apparaît comme une tâche de plus en plus diffuse à mesure qu’ils s’éloignent de la côte.

La portée des blazars émettant les rayons gamma les plus énergétiques est quant à elle limitée par un phénomène de physique des particules : l’annihilation de deux particules de lumière — un photon gamma et un photon de plus faible énergie — en une paire électron-positron. Pour les faisceaux gamma de blazars, la brume est donc faite de lumière !

Plus l’énergie du rayon gamma est élevée, et plus la distance du blazar qui l’émet est grande, plus l’atténuation du flux reçu est importante. Les photons de faible énergie jouant le rôle de minuscules gouttelettes résultent de l’émission cumulée de toutes les étoiles et galaxies depuis le début de l’univers.

Jusqu’à récemment, la détection de ces « gouttelettes » représentait un véritable défi observationnel. Les trois techniques de mesure connues, dont celle qui exploite l’atténuation des rayons gamma, semblent désormais atteindre des valeurs compatibles entre elles, ouvrant la voie à de nouveaux outils cosmologiques pour répondre au paradoxe d’Olbers ou à la tension de Hubble.

Éruptions de blazars et cours de la Bourse

Les blazars n’ont-ils donc plus aucun mystère pour nous ? Loin de là.

Alors que les phares maritimes clignotent à intervalles réguliers pour permettre aux équipages de les identifier, les blazars brillent de manière erratique, à l’image des cours boursiers fluctuant au fil des ans. Lors des éruptions les plus extrêmes, on a même observé le flux de blazars doubler en quelques minutes seulement ! Comprendre ces éruptions représente encore un défi pour l’astrophysique des hautes énergies et la physique des plasmas.

L’avènement d’observatoires comme le Vera C. Rubin Observatory dans le domaine visible et le Cherenkov Telescope Array Observatory en rayons gamma promet des avancées majeures dans la cartographie des éruptions de blazars. Tout en levant le voile de la brume cosmique, ces observations promettent de mieux comprendre les accélérateurs persistants les plus puissants du cosmos.

Jonathan Biteau a reçu des financements de l'Université Paris-Saclay et de l'Institut Universtaire de France.

15.10.2025 à 11:15

Le pouvoir des mâles n’est pas la norme chez les primates. Conversation avec Élise Huchard

Texte intégral (4767 mots)

Depuis Darwin et jusqu’à la fin des années 1990, les recherches sur les stratégies de reproduction des animaux s’intéressaient surtout aux mâles. Une prise de conscience a ensuite eu lieu, en réalisant qu’il pourrait être intéressant de ne pas seulement étudier la moitié des partenaires… C’est dans ce contexte de début de XXIe siècle qu’Élise Huchard démarre sa thèse sur les stratégies de reproduction des femelles babouins chacma, espèce qu’elle étudie depuis une vingtaine d’années grâce à un terrain de recherche en Namibie. Elle est aujourd’hui directrice de recherche au CNRS et travaille à l’Institut des sciences de l’évolution de Montpellier (Hérault). Ses travaux ont été récompensés en 2017 par la médaille de bronze du CNRS. La biologiste de l’évolution fait le point avec Benoît Tonson, chef de rubrique Science, sur ce que l’on sait des dominances mâles ou femelles chez les primates.

The Conversation France : Pourquoi, pendant près de 150 ans, les scientifiques ne se sont-ils intéressés qu’aux mâles ?

Élise Huchard : On peut remonter à Darwin et à son ouvrage, la Filiation de l’homme et la sélection liée au sexe. Ce livre succède au fameux De l’origine des espèces et va proposer la théorie de la sélection sexuelle pour expliquer certaines observations qui ne collent pas avec sa théorie de la sélection naturelle. L’exemple que prend Darwin, c’est la queue du paon. Comment cette queue peut-elle l’aider à survivre dans un monde rempli de prédateurs ? Du point de vue de la survie de l’individu, cela ressemble plutôt à un désavantage, et ce caractère n’aurait pas dû être sélectionné.

Mais il n’y a pas que la survie qui importe, et il faut aussi laisser des descendants. Selon la théorie de la sélection sexuelle, les membres d'un sexe - en général les mâles - sont en compétition entre eux pour l’accès aux membres de l'autre sexe - en général les femelles, qui vont choisir parmi les vainqueurs. Dans ce contexte, un trait qui permet de donner un avantage sur les autres mâles – soit pour gagner les combats, soit pour être plus séduisant que les rivaux – va être sélectionné. Selon ce schéma de pensée, les femelles sont essentiellement passives et, donc, on va surtout s’intéresser aux mâles.

Ce paradigme va changer dans les années 1990, notamment sous l’impulsion de philosophes féministes qui affirment que la science n’est pas aussi neutre qu’elle le prétend et s’inscrit toujours dans un contexte sociétal donné. Donna Haraway prend ainsi l’exemple de la primatologie pour affirmer qu’on a longtemps projeté nos propres biais sur l’étude des sociétés des singes, en mettant en avant des mâles dominants et des femelles passives, subordonnées.

C’est dans ce contexte que vous démarrez votre thèse…

É. H. : Oui, c’était en 2005, il y avait eu cette introspection qui disait que, jusqu’à présent, les travaux avaient été biaisés en faveur des mâles et qu’il fallait documenter le versant femelle de la sélection sexuelle. Ma thèse a donc porté sur l’étude des babouines et, plus précisément, sur le choix d’accouplement et les stratégies reproductives des femelles. A première vue, elles semblaient très actives, avec beaucoup de sollicitations sexuelles de la part des femelles envers les mâles, ce qui laissait à penser qu'elles jouissaient d'une certaine liberté dans leur sexualité.

Comment avez-vous étudié ces relations ?

É. H. : Mon terrain de recherche a été, dès ma thèse, le site d’étude de Tsaobis en Namibie, site que je codirige aujourd’hui. C’est un terrain de recherche continu depuis 2000 où des scientifiques se succèdent pour étudier deux groupes de babouins chacma. En ce moment, nous suivons une troupe d’environ 85 individus et une autre de 65 environ. Le cœur de notre activité, c’est d’essayer de documenter les histoires de vie des individus. Donc de suivre chaque individu de sa naissance à sa mort ou, en tout cas, tout ce qu’on peut suivre de sa vie et tous les événements qui lui arrivent. On suit les lignées maternelles, ça, c’est très facile parce qu’on voit les bébés naître et se faire allaiter, mais on arrive aussi à retracer les lignées paternelles grâce à la biologie moléculaire avec l’ADN pour faire des tests de paternités.

On suit deux groupes en permanence et donc on envoie a minima deux personnes par groupes et par jour. C’est très exigeant physiquement : le matin, il faut être avec les babouins avant l’aube, parce qu’après ils vont quitter la falaise où ils dorment pour commencer à bouger. Il faut ensuite les suivre toute la journée. Il y a des journées où il fait très chaud pendant lesquelles ils ne vont pas faire grand-chose, mais d’autres journées où ils sont capables de se déplacer sur 15 à 20 kilomètres et donc il faut les suivre ! C’est un endroit montagneux, ils sont difficiles à suivre puisqu’ils sont beaucoup plus agiles que nous. Les panoramas sont absolument spectaculaires, mais cela demande vraiment beaucoup d’efforts !

Et qu’avez-vous appris ?

É.H. : J’ai testé une hypothèse qui disait que l’on choisissait son partenaire sexuel en fonction de ses gènes immunitaires, par exemple avec des gènes complémentaires aux siens de façon à avoir une descendance très diverse génétiquement. J’ai passé des heures et des heures sur le terrain à observer les modèles d’accouplements, à essayer de déterminer des préférences. J’ai également passé des jours et des jours au laboratoire à génotyper les babouins pour tester cette hypothèse. Et tout ça pour des résultats négatifs ! Je ne détectais aucune préférence, aucun choix des femelles pour les mâles.

Je devais donc discuter de ces résultats négatifs dans mon manuscrit de thèse. Plusieurs de mes observations ne collaient pas avec notre hypothèse de départ. Déjà, chez les babouins, contrairement aux paons et à de nombreuses espèces où les mâles sont plus colorés que les femelles, ce sont les femelles qui arborent des ornements sexuels : des tumescences au moment de l’ovulation. Cela laissait à penser que, si ce sont les femelles qui produisent ces ornements, alors ce sont aussi les femelles qui sont choisies par les mâles plutôt que l’inverse. Ensuite, j’avais souvent assisté à des situations de violence assez inexpliquées des mâles envers les femelles. Comportement que l’on peut retrouver également chez les chimpanzés. Je ne comprenais pas bien, car ces attaques, potentiellement très violentes, se produisaient à des moments où les femelles n’étaient pas forcément sexuellement réceptives et ne faisaient rien de particulier. Or, quand on connaît bien les babouins, cela interpelle : certes, il peut y avoir des conflits dans leurs grands groupes, mais c’est rarement sans raison.

À ce moment-là sort un article scientifique d’une équipe américaine sur les chimpanzés qui, pour la première fois, testait l’hypothèse de l’intimidation sexuelle pour expliquer certaines agressions. Selon cette hypothèse, une agression peut être décrite comme de la coercition sexuelle (1) si elle cible plus les femelles fertiles que les non fertiles, (2) si elle est coûteuse pour ces dernières – c’est-à-dire qu’il ne s’agit pas simplement d’une démonstration de force, mais d’une véritable agression qui entraîne de la peur et des blessures pour les femelles qui en sont victimes –, enfin (3) si ces violences permettent d’augmenter le succès reproducteur du mâle violent. J’ai testé cette hypothèse sur les babouins, et cela marche parfaitement.

Quelles sont les formes que peuvent prendre ces actes de coercition sexuelle ?

É. H. : C’est assez variable. Un mâle peut sauter sur une femelle et l’écraser au sol. Il peut aussi la poursuivre pendant de longues périodes, ce qui va l’épuiser et la terroriser. Parfois il peut pousser une femelle à se réfugier dans un arbre, l’y bloquer et la pousser à se réfugier en bout de branche, jusqu’à, potentiellement, l’obliger à sauter de très haut, au risque de se faire très mal.

Un mâle va-t-il forcément agresser systématiquement la même femelle ?

É. H. : Oui, et c’est d’ailleurs un point sur lequel on travaille actuellement. On se demande même si ce comportement n’est pas une voie d’évolution vers la monogamie. Il est intéressant de noter que ces comportements dépendent beaucoup de la composition de la troupe. Quand il y a peu de mâles dans le groupe, le mâle dominant s’accouple avec toutes les femelles de la troupe, avec un système de reproduction polygyne (ou polygame).

Mais quand il y a beaucoup de mâles, un seul mâle ne parvient pas à monopoliser toutes les femelles et chaque mâle va alors se focaliser sur une seule femelle, avec laquelle il entretiendra une relation sociale assez exclusive, qui mêle affiliation, proximité et violence – une forme de couple au sein du groupe. Et c’est avec cette femelle qu’il s’accouplera pendant sa période de fertilité en la suivant partout pendant plusieurs jours d’affilée, pour empêcher quiconque de l’approcher et protéger ainsi sa paternité. On pense que les mâles utilisent la violence pour dissuader leur femelle de s’accoupler avec d’autres mâles.

Une fois que la femelle donne naissance, le mâle se montre souvent très protecteur envers la mère et l’enfant, et il n’est plus du tout violent envers eux. On observe des soins paternels – il peut garder, transporter et toiletter son petit, et il ne fera cela qu’envers ses propres petits. On pense que ces soins paternels, qui sont très rares chez les espèces non monogames, sont justement apparus parce que les mâles babouins, qui parviennent à maintenir une exclusivité sexuelle, même au sein de ces grands groupes sociaux, ont une forte certitude de paternité.

On retrouve ce type de comportements chez d’autres espèces ?

É. H. : Nous essayons en ce moment de comprendre le « paysage » de la coercition. Quelles espèces sont coercitives, quelles espèces le sont moins, et pourquoi ? C’est un champ de recherche qui est plutôt récent et en train de bourgeonner.

Une difficulté, c’est que, même si ces comportements n’ont pas été décrits, cela ne signifie pas forcément qu’ils n’existent pas. Par exemple, les scientifiques ont étudié les babouins pendant des dizaines d’années avant de réaliser que ces agressions des mâles envers les femelles avaient un caractère sexuel. Ce n’était pas évident puisque ces actes d’agressions peuvent avoir lieu plusieurs jours à semaines avant la période de fertilité de la femelle – donc il n’est pas simple de les relier aux comportements sexuels. On a pu observer ces comportements d’intimidation sexuelle chez d’autres espèces, comme les chimpanzés et les mandrills. On soupçonne que cette forme de coercition est répandue chez les espèces qui vivent en grands groupes multimâles ou multifemelles.

Mais il y a aussi des sociétés animales où ces comportements de violence sexuelle n’ont jamais été observés, comme chez les bonobos, où les femelles sont socialement dominantes sur les mâles. La coercition sexuelle est sans doute bien moins fréquente et intense quand les femelles sont dominantes sur les mâles. Mais la dominance des femelles n’est cependant pas systématiquement protectrice, car il y a des observations de coercition sexuelle même dans des sociétés où les femelles sont très dominantes, comme chez les lémurs catta par exemple.

Jusqu’à présent, nous avons surtout évoqué les babouins chacma, où les mâles semblent très dominants sur les femelles. Est-ce le modèle majoritaire chez les primates ?

É. H. : Non, et ce serait vraiment faux de penser que ce qui se passe chez les babouins est généralisable à tous les primates.

On a trop longtemps pensé que la dominance des mâles sur les femelles allait de soi, que c’était une sorte de modèle « par défaut ». Et puis, la découverte, dans les années 1970, de sociétés animales dominées par les femelles, comme celles des hyènes tachetées ou celles de nombreux lémuriens, a été une vraie surprise. On a vu ça comme une sorte d’accident de l’évolution.

Un des problèmes, c’est que l’on considérait souvent que les mâles dominaient les femelles, mais sans forcément l’étudier de façon quantitative. On avait tendance à établir une hiérarchie des mâles et une hiérarchie des femelles, sans chercher à mettre les deux sexes dans une même hiérarchie. Or, on a récemment réalisé que la dominance d’un sexe sur l’autre n’était pas un phénomène aussi binaire que ce qu’on croyait, et qu’il semblait y avoir des espèces où aucun sexe n’était strictement dominant sur l’autre ou encore des espèces où le degré de dominance des femelles pouvait varier d’un groupe à l’autre, comme chez les bonobos. Les femelles y sont généralement dominantes, mais on a déjà vu des groupes avec un mâle alpha.

Vous avez publié cette année un article scientifique où vous avez comparé les dominances mâles-femelles chez 121 espèces, que peut-on en retenir ?

É. H. : Dans cette étude, on a réuni et analysé toutes les données publiées dans la littérature scientifique sur la dominance entre sexes. Au départ, on ne pensait pas en trouver beaucoup parce que, comme je le disais, les primatologues ont tendance à construire des hiérarchies séparées pour les mâles et pour les femelles. Mais, au final, on a trouvé des données pour 121 espèces de primates, ce qui était au-delà de nos espérances. On a utilisé des mesures quantitatives, donc objectives, pour estimer quel sexe dominait l’autre. Pour cela, on considère toutes les confrontations impliquant un mâle et une femelle dans un groupe, puis on compte simplement le pourcentage de confrontations gagnées par les femelles (ou par les mâles, c’est pareil). Cette enquête bibliographique nous a pris cinq ans !

Tout ce travail, publié en juin dernier, nous a appris plusieurs choses importantes. D’abord, la dominance stricte d’un sexe sur l’autre, lorsqu’un sexe gagne plus de 90 % des confrontations, comme ce que l’on observe chez les babouins chacma, est rare. Il y a moins de 20 % des espèces où les mâles sont strictement dominants sur les femelles, et également moins de 20 % où ce sont les femelles qui sont strictement dominantes.

Ensuite, il ne s’agit pas d’un trait binaire. Les relations de dominance entre mâles et femelles s’étalent le long d’un continuum, avec, à un bout, des espèces où les mâles sont strictement dominants, comme chez les babouins chacma, et, à l’autre bout, des espèces où les femelles sont strictement dominantes, comme chez les sifakas de Madagascar. Entre ces deux extrémités, s’étale tout le spectre des variations, avec des espèces où les relations sont égalitaires, comme chez de nombreux singes sud-américains (capucins ou tamarins par exemple).

Enfin, grâce à toute cette variation, nous avons pu mettre en évidence les conditions dans lesquelles les femelles sont devenues socialement dominantes sur les mâles (et inversement) au cours de l’histoire évolutive des primates. Les femelles deviennent plus souvent dominantes dans les espèces où elles exercent un fort contrôle sur leur reproduction, c’est-à-dire où elles peuvent choisir avec qui, et quand, elles s’accouplent. C’est notamment souvent le cas dans les espèces monogames, arboricoles – car elles peuvent s’échapper et se cacher plus facilement dans les arbres – et là où les deux sexes sont de même taille, avec une force physique égale (comme chez de nombreux lémuriens). Les femelles sont aussi plus souvent dominantes dans les sociétés où elles sont en forte compétition – de façon symétrique à la compétition que se livrent les mâles entre eux. C’est notamment souvent le cas des espèces où les femelles vivent seules ou en couple, où là encore elles sont territoriales – ce sont là des caractéristiques qui montrent que les femelles ne tolèrent pas la proximité d’autres femelles. À l’inverse, la dominance des mâles s’observe surtout chez les espèces polygames, terrestres, vivant en groupe, comme par exemple les babouins, les macaques ou encore les gorilles, où les mâles disposent d’une nette supériorité physique sur les femelles.

Ces résultats révèlent que les rapports de pouvoir entre les sexes chez les primates sont variables, flexibles, et liés à des facteurs sociaux et biologiques précis. Ils offrent ainsi de nouvelles pistes pour comprendre l’évolution des rôles masculins et féminins dans les premières sociétés humaines, en suggérant que la domination masculine n’y était pas forcément très marquée.

En effet, cette violence et ces relations de domination que vous décrivez chez les babouins et parmi d’autres primates, cela fait forcément penser à notre espèce. D’un point de vue évolutif, peut-on en tirer des conclusions ?

É. H. : C’est une question complexe, et sensible aussi. Il faut commencer par clarifier un point clé : il ne faut jamais confondre ce qui est « naturel » (à savoir ce qu’on observe dans la nature) avec ce qui est moral (à savoir ce qui est jugé bon ou mauvais dans les sociétés humaines). Ce n’est pas parce qu’un comportement est naturel qu’il est pour autant acceptable sur le plan moral. Il y a eu de vifs débats à ce sujet dans les années 1980. Certains essayaient de généraliser un peu vite aux humains ce qu’on observait chez les primates non humains – par exemple, quand les premiers primatologues ont rapporté que les mâles dominaient les femelles dans les sociétés des chimpanzés, on a eu tendance à en déduire que la dominance masculine est naturelle chez les humains, et qu’il est donc difficile de lutter contre.

Donna Haraway, que je citais au début de l’entretien, a notamment mis en garde contre ce genre de raccourcis, qui peut conduire à justifier de façon fallacieuse les hiérarchies sociales qu’on observe chez les humains. Si la biologie évolutive peut aider à comprendre certains comportements humains, elle ne peut ni ne doit en aucun cas les justifier. On peut ici faire un parallèle avec la criminologie : ce n’est pas parce qu’un criminologue explique un crime sur le plan psychologique ou scientifique qu’il le justifie sur le plan moral.

Ceci étant clarifié, comme je suis biologiste de l’évolution et primatologue, je pense bien entendu que l’humain est un primate parmi d’autres. Il y a de grands patrons communs à tous les animaux, auxquels nous n’échappons pas. Par exemple, je pense que la violence sexuelle répond aux mêmes motivations psychologiques chez les humains et les non-humains, en lien avec un désir de possession sexuelle et de contrôle reproductif des mâles envers les femelles.

J’ai aussi souligné plus haut qu’il y a énormément de variations dans les relations mâles-femelles dans les sociétés animales, donc il faut se méfier des généralisations hâtives. L’exemple des chimpanzés et des bonobos, qui sont les deux espèces les plus proches de la nôtre, est éclairant : les premiers sont dominés par les mâles et coercitifs, les deuxièmes sont dominés par les femelles et on n’y observe pas de coercition sexuelle.

Dès lors, impossible d’affirmer ce qui est « naturel » pour les humains en matière de domination d’un sexe sur l’autre et de coercition sexuelle ! Et surtout, puisque ces deux espèces sont génétiquement très proches, cet exemple montre aussi que nos comportements ne sont pas « déterminés » de façon implacable par notre héritage évolutif et nos gènes. De plus en plus, on se rend compte que ces comportements de coercition et de domination varient d’un individu à l’autre et dépendent du contexte social. Il s’agit donc de comprendre quels sont les facteurs, en particulier sociaux ou culturels, qui favorisent ou inhibent de tels comportements dans différentes sociétés primates. C’est ce à quoi nous travaillons en ce moment.

On peut finir en rappelant qu’une spécificité des sociétés humaines est qu’il y a de puissants mécanismes sociaux pour réguler les comportements hiérarchiques et violents, par le biais de normes culturelles et d’institutions. Même si nos sociétés ne sont pas exemptes de violences sexuelles et d’inégalités entre les genres, il nous appartient, en tant qu’humains, de les combattre activement grâce à nos mécanismes culturels et institutionnels. Et certains non-humains, comme les bonobos sont même là pour montrer qu’il est possible, en tant que primates, de vivre ensemble et de faire société sans violence sexuelle !

Élise Huchard ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

14.10.2025 à 16:56

Comment le sens de l’orientation vient aux enfants – et ce que changent les GPS

Texte intégral (1475 mots)

Avec le développement des outils numériques, perdons-nous ce sens de l’orientation qui se forge durant les premières années de la vie ? Comprendre comment les enfants apprennent à élaborer ces cartes mentales nous éclaire sur ce qui se joue vraiment derrière ces mutations.

Vous avez prévu un séjour en famille et ça y est, tout est prêt pour le départ. Vous allumez alors le téléphone pour lancer votre application GPS préférée mais, stupeur, rien ne se passe… Vous réessayez alors en lançant une autre application ou en changeant de téléphone mais toujours rien. Il va falloir faire sans.

Après tout, cela ne devrait pas être si difficile, c’est la même route chaque année ; pour rejoindre l’autoroute, c’est sur la gauche en sortant du pâté de maisons. À moins qu’il faille plutôt prendre à droite pour d’abord rejoindre la nationale, et ensuite récupérer l’autoroute dans la bonne direction ?

À lire aussi : Pourquoi tout le monde n’a pas le sens de l’orientation

Finalement, ce n’est pas gagné… et le départ devra attendre le retour du GPS ou que vous retrouviez cette ancienne carte format papier perdue (elle aussi) quelque part chez vous. En cherchant la carte routière, peut-être vous demanderez-vous comment on faisait pour se déplacer avant les GPS.

Cette technologie nous aurait-elle fait perdre le sens de l’orientation ?

Qu’est-ce que « la navigation spatiale » ?

Attention, nous n’allons pas parler de fusée ou d’astronautes en parlant de « navigation spatiale », l’expression désigne tout simplement l’ensemble des processus qui nous permettent de nous orienter et de nous déplacer dans notre environnement.

Les capacités de navigation reposent à la fois sur l’intégration de nos propres mouvements dans l’environnement via le calcul en continu de notre position. C’est cette capacité qui vous permet de vous orienter aisément dans le noir ou les yeux fermés, sans risquer de confondre la salle à manger avec les toilettes lors de vos trajets nocturnes par exemple.

Mais, avec la distance parcourue, la précision diminue et on est de plus en plus perdu. Afin de garder le cap, nous utilisons en complément des points de repère externes particuliers offerts par le monde qui nous entoure, comme un monument ou une montagne. Grâce à la combinaison de ces deux sources d’informations spatiales, nous sommes capables de créer une carte mentale détaillée de notre environnement.

La création de ce type de carte mentale, relativement complexe, n’est pas la seule stratégie possible et, dans certains cas, on préférera se souvenir d’une séquence d’actions simples à accomplir, par exemple « à gauche, en sortant » (direction l’autoroute), « puis tout droit » et « votre destination sera à 200m sur votre droite ». On est ici très proche des outils digitaux GPS… mais pas de risque de déconnexion… bien pratique, ce système de navigation embarqué !

S’orienter dans l’espace, un jeu d’enfant ?

Dès les premiers mois de vie, les nouveau-nés montrent des capacités étonnantes pour se repérer dans l’espace. Contrairement à ce qu’on pouvait penser il y a quelques décennies, ces tout petits êtres ne voient pas le monde uniquement depuis leur propre point de vue et, dès 6 à 9 mois, ils arrivent à utiliser des repères visuels familiers pour ajuster leur orientation, surtout dans des environnements familiers.

À 5 mois, ils perçoivent les changements de position d’un objet et, vers 18 mois, ils peuvent partiellement mémoriser des emplacements précis. Vers 21 mois, ils commencent à combiner les informations issues de leurs propres mouvements avec les repères extérieurs pour retrouver une position précise dans l’espace.

L’expérience motrice semble jouer un rôle clé ici : plus les jeunes enfants marchent depuis longtemps, plus leurs compétences spatiales progressent. Dans la suite des étapes du développement, les compétences spatiales s’affinent de plus en plus. À 3 ans, ils commettent encore des erreurs de perspective, mais dès 4 ou 5 ans, ils commencent à comprendre ce que voit une autre personne placée ailleurs dans l’espace.

À lire aussi : Les enfants libres d’aller et venir seuls s’orienteront mieux à l’âge adulte

Entre 6 ans et 10 ans, les enfants deviennent capables de combiner différents types d’informations externes comme la distance et l’orientation de plusieurs repères pour se situer dans l’espace. À partir de 10 ans, leurs performances spatiales se rapprochent déjà de celle des adultes.

Le développement de ces capacités repose notamment sur la maturation d’une région cérébrale connue sous le nom du complexe retrosplénial (RSC). Cette zone est impliquée dans la distinction des endroits spécifiques (comme un magasin près d’un lac ou d’une montagne), ce qui constitue la base d’une navigation spatiale fondée sur les repères.

Des résultats récents montrent que cette capacité à construire des cartes mentales est déjà en partie présente dès l’âge de 5 ans. Mais alors, si ce sens de l’orientation se développe si tôt et est si fiable, pourquoi avons-nous besoin de GPS pour nous orienter ?

Le GPS, allié ou ennemi de notre sens de l’orientation ?

S’il est facile de s’orienter dans les lieux familiers, le GPS devient vite un allié incontournable dès que l’on sort des sentiers battus. Cependant, son usage systématique pourrait tendre à modifier notre manière de nous repérer dans l’espace en général. Dans ce sens, quelques études suggèrent que les utilisateurs intensifs de GPS s’orientent moins bien dans des environnements nouveaux et développent une connaissance moins précise des lieux visités.

Une méta-analyse récente semble confirmer un lien négatif entre usage du GPS, connaissance de l’environnement et sens de l’orientation. Toutefois, certains des résultats nuancent ce constat : les effets délétères semblent surtout liés à un usage passif. Lorsque l’utilisateur reste actif cognitivement (en essayant de mémoriser ou d’anticiper les trajets) l’impact sur les compétences de navigation est moindre, voire nul.

Ainsi, le GPS ne serait pas en lui-même néfaste à nos capacités de navigation. Ce serait davantage la manière dont on l’utilise qui détermine son influence positive, négative ou neutre sur nos capacités de navigation spatiale.

Donc, bonne nouvelle, même si vous n’êtes pas parvenu à retrouver votre carte routière, vous avez remis la main sur votre ancien GPS autonome, celui qui n’a jamais quitté votre tête ! Et, même si désormais la destination est programmée et qu’il ne vous reste plus qu’à suivre le chemin tracé, songez parfois à lever les yeux pour contempler le paysage ; en gravant quelques repères à mémoriser, vous pourriez savourer le voyage et réapprendre à naviguer.

Clément Naveilhan a reçu des financements de l'Université Côté d'Azur.

Stephen Ramanoël a reçu des financements nationaux (ANR) et locaux (Université Côte d'Azur - IDEX)