29.10.2025 à 12:04

Maths au quotidien : Full HD, 4K, 8K… ou pourquoi il n’est pas toujours utile d’augmenter la résolution de sa télévision

Texte intégral (1999 mots)

Pourquoi acheter une télévision 8K plutôt qu’une 4K ou Full HD ? La question revient souvent, tant l’offre technologique semble avancer plus vite que nos besoins. Plus de pixels, plus de netteté… mais jusqu’à quel point notre œil est-il capable de percevoir la différence ? Derrière cette interrogation se cache un outil mathématique puissant utilisé en traitement du signal et en optique : l’analyse de Fourier.

Une télévision 4K affiche environ 8 millions de pixels, contre 33 millions pour la 8K. Sur le papier, c’est une avalanche de détails supplémentaires.

Mais l’œil humain n’est pas un capteur parfait : sa capacité à distinguer des détails dépend de la distance de visionnage et de l’acuité visuelle. Autrement dit, si vous êtes trop loin de l’écran, les pixels supplémentaires deviennent invisibles. Un écran 8K de 55 pouces vu à trois mètres sera perçu… presque comme un écran 4K.

Les limites de notre perception visuelle

Il existe des méthodes qui permettent de décomposer un signal (une image ou un son, par exemple) en ses fréquences spatiales ou temporelles. Pour une image, comme celles affichées par les télévisions dont nous parlons, les basses fréquences correspondent aux grandes zones uniformes (un ciel bleu, un mur lisse) tandis que les hautes fréquences traduisent les détails fins (les brins d’herbe, le grain de la peau).

À lire aussi : Des caméras 3D dans nos smartphones : comment numériser notre environnement ?

Nos yeux, comme un appareil photo, n’ont qu’une capacité limitée à percevoir ces hautes fréquences. Cette capacité dépend encore plus de l’acuité visuelle de chacun. Ainsi l’œil humain a une résolution maximale proche de 120 pixels par degré angulaire.

Cette acuité correspond à la faculté de discerner un objet de quinze centimètres à une distance d’un kilomètre, ou un grain de poussière à trois mètres : il est clair que la majorité des personnes ont une acuité visuelle moindre !

À lire aussi : Aveugles, malvoyants : que voient-ils ?

Sur une image, cette limite s’appelle la « fréquence de coupure » : au-delà, les détails sont trop fins pour être distingués, quelle que soit la richesse de l’image.

Si l’on applique cette logique, la 8K ne devient vraiment utile que si :

l’écran est très grand,

ou que l’on s’assoit très près,

ou encore si l’on zoome dans l’image (par exemple en retouche professionnelle).

Sinon, la fréquence maximale que peut capter notre œil est déjà atteinte avec la 4K. En d’autres termes, la 8K « code » des détails… que notre système visuel ne peut pas lire.

Un outil mathématique puissant, la « transformée de Fourier », inventée par Joseph Fourier en 1817, permet de quantifier cet effet.

Une transformée de Fourier révèle le « contenu fréquentiel » d’un signal, autrement dit, sa répartition entre les différentes bandes de fréquence. Reposons donc notre question, mais mathématiquement cette fois : « Est-ce que ces pixels additionnels correspondent encore à des fréquences spatiales perceptibles ? »

Ce que dit la transformée de Fourier

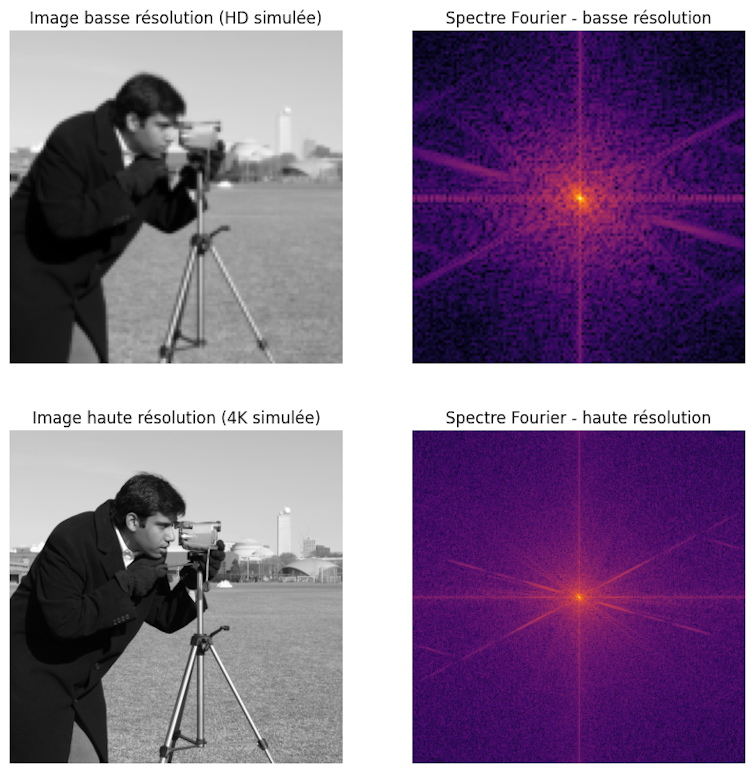

Illustrons cela avec un exemple visuel d’une image et son spectre de Fourier. Si pour un son ou pour un signal radio, la transformée de Fourier est elle-même un signal unidimensionnel, pour une image en deux dimensions, le spectre de Fourier est lui-même en deux dimensions avec des fréquences dans chacune des directions de l’espace.

Nous voyons dans l’exemple une image basse résolution (HD simulée) et son spectre de Fourier, ainsi qu’une version haute résolution (4K simulée) et son spectre. Le centre du carré correspond aux faibles fréquences, autour de la valeur (0,0).

Dans la version haute résolution (4K simulée), le spectre contient plus de hautes fréquences (zones colorées vers les bords, contrairement aux zones noires pour le spectre de la version Full HD), ce qui correspond aux détails supplémentaires visibles dans l’image.

Utiliser des filtres pour couper les hautes et basses fréquences

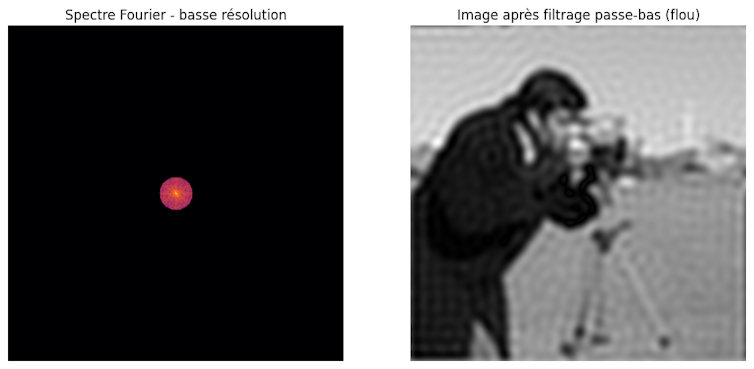

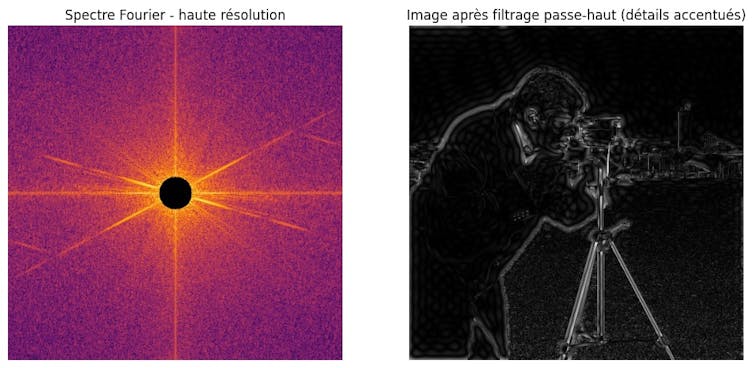

Regardons de plus près ce qui se passe en manipulant ce spectre. On parle alors de filtres.

Alors que l’image originale est nette et contient beaucoup de détails, on voit que l’image filtrée, avec les hautes fréquences supprimées, devient floue, les contours fins disparaissent. On le voit ainsi sur le nouveau spectre de Fourier après filtrage : seules les basses fréquences au centre ont été gardées, les hautes fréquences (détails) sont supprimées.

C’est exactement ce qui se passe quand on compresse trop une image ou quand on affiche une image HD sur un grand écran 4K : les hautes fréquences sont limitées. D’ailleurs, c’est pour cette raison que les téléviseurs 4K et 8K utilisent des techniques de « suréchantillonnage » (upscaling, en anglais) et d’amélioration d’image pour tenter de reconstituer et de renforcer ces hautes fréquences manquantes et offrir ainsi une meilleure qualité visuelle.

Inversement, sur l’image filtrée avec les basses fréquences supprimées, il ne reste que les contours et détails fins, comme un détecteur de bords. Dans le spectre de Fourier, le centre (basses fréquences) est supprimé, seules les hautes fréquences autour des bords subsistent.

Alors, faut-il absolument acheter une 8K pour votre suivre votre prochaine compétition sportive préférée ? Pas forcément. À moins d’avoir un très grand salon !

Saad Benjelloun ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

29.10.2025 à 12:04

Neurotechnologies : vivrons-nous tous dans la matrice ? Conversation avec Hervé Chneiweiss

Texte intégral (4485 mots)

Les neurotechnologies progressent à grands pas, d’abord motivées par des applications médicales, par exemple pour améliorer le quotidien de personnes paralysées ou souffrant de maladies dégénératives. Elles sont suivies de près par le développement d’applications récréatives qui vont de la relaxation au jeu vidéo. Des recherches récentes montrent notamment qu’il est possible de détecter des mots pensés par les participants.

Hervé Chneiweiss est neurologue et neuroscientifique, président du comité d’éthique de l’Institut national de la santé et de la recherche médicale. Il a coprésidé le comité d’experts qui a rédigé une recommandation sur les neurotechnologies qui doit être adoptée le 7 novembre, lors de la 43e session de la Conférence générale de l’Unesco qui se tiendra à Samarcande (Ouzbékistan). Le chercheur a reçu Elsa Couderc, cheffe de rubrique Science et Technologie à « The Conversation France », pour parler des risques d’addiction, de la détection de nos émotions et de nos pensées, de la vie privée mentale… et de comment la protéger.

The Conversation : Jouer à un jeu vidéo sans manette, voilà qui va séduire plein de monde ! Mais on pourrait y voir des risques aussi, j’imagine ?

Hervé Chneiweiss : Oui, on peut envisager des risques en termes d’addiction ou d’utilisation de vos pensées les plus intimes, par exemple.

Pour comprendre les discussions autour de l’addiction et des neurotechnologies, je vous propose de remonter un peu dans le temps. Il y a trente ans déjà, alors que je travaillais en tant que neurologue sur la maladie de Parkinson, on a posé des implants cérébraux chez certains malades parkinsoniens jeunes et très rigides pour faire de la stimulation cérébrale profonde à haute fréquence, qui permet de débloquer leurs mouvements. C’est à ce moment que la communauté scientifique a constaté certains cas d’effets secondaires de cette stimulation sous forme de troubles compulsifs de comportement soit dans le domaine de la sexualité (hypersexualité) soit dans celui des compulsions d’achat.

En effet, en stimulant le cerveau de ces patients, on libérait manifestement trop de dopamine. Or, la dopamine est le principal neurotransmetteur d’un circuit qu’on appelle le « circuit de la récompense », ou reward en anglais – ce dernier est plus approprié que le terme français, car il traduit l’idée d’« obtenir ce que j’avais prévu d’obtenir ». Ainsi, avec nos électrodes, nous provoquions une libération de la dopamine en excès à un certain endroit du cerveau, ce qui perturbait les processus de décision et orientait les patients vers des comportements compulsifs.

Ces effets secondaires sont assez fréquents – environ un malade sur cinq les expérimente au début de la pose de l’implant, puis ils régressent et disparaissent en général au bout d’un mois ou deux. Il a été jugé que la potentielle survenue de ces effets indésirables était acceptable compte tenu du bénéfice attendu de la thérapeutique.

Depuis, les technologies ont beaucoup progressé : il existe tout un panel de techniques qui permettent de détecter les signaux du cerveau, ou bien de stimuler son activité. Ces techniques utilisent des dispositifs invasifs – comme les électrodes implantées dans le cerveau de patients parkinsoniens, dans les années 1990 – ou bien non invasifs – par exemple, des casques munis de petites électrodes que l’on pose sur la tête.

Le neurogaming utilise pour l’instant des casques posés sur le crâne, et non des électrodes implantées profondément dans le cerveau, comme pour le traitement de la maladie de Parkinson il y a quelques années. Y a-t-il, là aussi, un risque de surstimulation du circuit de la dopamine, et donc de compulsion ?

H. C. : Effectivement, il faut bien faire la différence entre deux types de dispositifs : d’un côté, ceux qui permettent la collecte d’informations sur l’activité cérébrale ; de l’autre, des systèmes qui vont moduler ou stimuler l’activité cérébrale – l’influencer, en somme.

En 2018 déjà, Rodrigo Hübner Mendes a réussi à conduire une Formule 1 simplement avec un casque posé sur la tête. Le signal d’électro-encéphalogramme était suffisamment bien décodé pour lui permettre de piloter cette voiture alors qu’il était tétraplégique et ne pouvait pas toucher le volant. Il l’a conduite simplement avec un casque qui détectait son activité cérébrale et donc, selon sa volonté, son intention d’accélérer ou de tourner à droite ou à gauche que l’interface cerveau-machine transmettait au système de pilotage de la Formule 1. C’est de la pure détection.

Et c’est exactement la même chose avec les systèmes « brain to speech », c’est-à-dire la capacité de décoder l’activité cérébrale responsable du langage avec une interface cerveau-machine, qui traduit cette activité en paroles en un dixième de seconde. Il s’agit de dispositifs qui pourraient venir en aide à des gens qui ont fait un accident vasculaire cérébral, qui ont des troubles du langage, ou par exemple dans la maladie de Charcot. C’est un des domaines des neurotechnologies qui avance le plus vite aujourd’hui. On sait désormais le faire avec des électrodes à la surface du cerveau, et non plus avec des électrodes profondes. D’ici cinq ans, on arrivera probablement à faire la même chose avec des électrodes à la surface du scalp, sur l’extérieur du crâne. Il s’agit là encore de détection.

C’est complètement différent des systèmes de stimulation ou de modulation, dans lesquels la machine envoie un signal au cerveau pour modifier l’activité cérébrale. Dans le premier cas, on ne modifie pas l’activité cérébrale, on se contente de la détecter. Dans le deuxième cas, on modifie l’activité cérébrale.

Est-ce que l’on sait aujourd’hui faire de la stimulation avec des implants non invasifs ?

H. C. : Oui, c’est ce qui se passe aujourd’hui dans le domaine médical avec la stimulation magnétique transcrânienne, qui est très utilisée pour la rééducation des accidents vasculaires cérébraux. On va inhiber l’activité d’une région du cerveau pour permettre la récupération d’une autre région du cerveau. Des résultats prometteurs ont été rapportés pour soigner certaines formes de dépression nerveuse grâce à des petits boîtiers de stimulation électrique, que l’on appelle DCS, qui sont des systèmes de stimulation continue.

Ces dispositifs sont aussi vendus en prétendant que ça peut permettre la relaxation, mais là, il n’y a aucune preuve scientifique que ça fonctionne.

D’autres types de stimulation non invasive peuvent être envisagés, par exemple avec des ultrasons pour essayer de lutter contre des tumeurs et contre des plaques amyloïdes dans la maladie d’Alzheimer.

Il va de soi que ces dispositifs capables de stimuler l’activité cérébrale intéressent beaucoup les gens qui aimeraient bien manipuler d’autres gens. Ces possibilités sont ouvertes par les grands progrès faits en neuroscience depuis trente ans, notamment en découvrant que d’autres régions du cerveau, moins profondes que celles impliquées dans la maladie de Parkinson, sont impliquées dans ces processus de décision : dans le cortex préfrontal, qui est au-dessus du nez, ou dans le cortex temporal. Ces zones sont en surface, relativement accessibles aujourd’hui.

L’objectif des gens qui développent ces technologies à des fins récréatives est d’essayer d’optimiser l’addiction, en stimulant directement les centres de la récompense ou de l’appétit, en corrélation évidemment avec un acte d’achat – ou avec ce qu’on cherche à faire aux gens pour tenter d’orienter les choses dans les jeux vidéo.

Ce qui est fait actuellement, c’est d’essayer de détecter (et non de stimuler – du moins, pas encore) avec ces casques l’état émotionnel de la personne et de modifier le degré de difficulté ou les épreuves du jeu vidéo en fonction de cet état émotionnel.

Est-il facile de détecter les émotions et les pensées aujourd’hui ?

H. C. : La réponse est différente pour les émotions – pour lesquelles oui, c’est facile – et pour les pensées – pour lesquelles, c’est plus difficile, mais on y vient.

Les émotions et la fatigue mentale sont des choses qu’on décrypte d’une façon macroscopique. Par exemple, quand vous êtes fatiguée, votre « saccade oculaire » ralentit, c’est-à-dire que vos yeux balayent moins rapidement la scène devant vous – ce qu’ils font en permanence. Le rythme des saccades est très facile à détecter.

De plus, selon notre degré émotionnel, différentes régions de notre cerveau sont plus ou moins actives. Comme ces régions sont assez grosses, en volume, il est possible de détecter leur niveau d’activité avec différents dispositifs : un casque posé à la surface du crâne ; une imagerie par résonance magnétique (IRM) fonctionnelle – un appareil qui est gros, certes, mais non invasif : nous n’avons pas besoin d’électrodes implantées dans le cerveau pour détecter ces signaux ; des plugs (bouchons) qu’on met dans les oreilles ainsi que de petits systèmes qui fonctionnent dans le proche infrarouge et qui mesurent des changements de vascularisation à la surface du cerveau. Ces dispositifs permettent de mesurer un certain nombre de changements d’activité de certaines régions du cerveau.

Par exemple, avec un casque posé sur la tête, donc non invasif, on peut réaliser des électro-encéphalogrammes (EEG). Quand vous commencez à être fatiguée, on voit des ondes de plus grande amplitude apparaître, puis des pointes d’une forme bien particulière si vous êtes vraiment en train de vous endormir. Ces signaux sont faciles à détecter avec un casque EEG.

Par contre, si vous pensez « J’ai faim » ou que vous vous préparez à prononcer un mot, là c’est plus dur. Des groupes de recherche académique californiens

– l’Université de Californie à San Diego et celle de Berkeley, mais aussi Caltech – ont fait des avancées récentes sur le sujet, avec les électrodes placées à la surface du cerveau et des systèmes d’intelligence artificielle entraînés à reconnaître certains motifs d’activité du cerveau du patient – c’est ce que l’on appelle le brain to speech, dont je parlais tout à l’heure. Ils ont découvert que les mêmes régions soutenaient le langage parlé intentionnel et le langage intérieur. Nous nous approchons donc là de la possibilité de détecter la base de la pensée. L’objectif est ici de venir en aide et de restaurer l’autonomie de personnes gravement cérébrolésées. Malheureusement, nous ne connaissons pas les intentions réelles de sociétés commerciales qui développent aussi ce type d’électrodes de surface.

En termes d’encadrement, est-ce que ces dispositifs, que ce soient des casques, des plugs dans les oreilles ou des implants, sont encadrés aujourd’hui, par exemple avec des autorisations de mise sur le marché comme pour les médicaments ?

H. C. : Si c’est un dispositif médical, il y a tout l’encadrement habituel. Si c’est un dispositif non médical, il n’y a rien : aucune garantie.

Dans la déclaration de l’Unesco, vous recommandez de classer « sensibles » certaines données biométriques, qui ne semblent pas susceptibles de donner accès aux émotions ou aux pensées au premier abord. Pourquoi ?

H. C. : On peut utiliser des données qui ne sont pas directement des données cérébrales ou neurales pour faire des déductions sur l’état émotionnel ou de santé : on a parlé des mouvements des yeux, mais il y a aussi le rythme cardiaque combiné à des données comportementales ou à la voix.

Par exemple, si vous enregistrez la voix d’une personne atteinte de la maladie de Parkinson, même débutante, vous allez voir qu’il y a des anomalies de fréquence qui sont caractéristiques de cette maladie. Il n’y a pas forcément besoin d’être capable d’enregistrer l’activité cérébrale pour déduire des choses très privées.

Donc, on a regroupé cet ensemble sous le terme de « données neurales indirectes et données non neurales » : ces données qui, combinées et interprétées par l’intelligence artificielle, permettent de faire des inférences sur nos états mentaux.

Vous recommandez donc de protéger toutes les données neurales – qu’elles soient directes ou indirectes –, car elles permettent d’en déduire des états mentaux, et ce, afin de protéger nos « vies privées mentales ». Pouvez-vous nous expliquer ce que vous entendez par là ?

H. C. : Parmi les droits fondamentaux, il y a le droit à la vie privée. C’est le droit d’empêcher qui que ce soit de connaître les éléments de votre vie privée que vous ne souhaitez pas qu’il ou elle connaisse.

Nos pensées, nos idées, nos désirs, tout ce qui se passe dans notre tête, sont ce que nous avons de plus intime et, donc, de plus privé. La vie mentale est au cœur même de la vie privée.

Souvent, quand on parle d’atteinte à la vie privée, on pense à la diffusion d’une photo qui serait prise à un endroit ou avec une personne, alors qu’on n’avait pas forcément envie que cela se sache. Mais vous imaginez si demain on pouvait avoir accès à vos pensées ? Ça serait absolument dramatique : la fin totale de toute forme de vie privée.

En pratique, imaginons que notre conversation en visioconférence soit enregistrée par un fournisseur de services Internet. Nos saccades oculaires, qui sont donc des données neurales indirectes, sont bien visibles. Est-il possible, aujourd’hui, d’en déduire quelque chose ?

H. C. : En principe, il pourrait y avoir un petit message qui s’affiche sur mon écran en disant : « Attention, la personne en face de vous est en train de s’endormir, il faudrait veiller à raconter quelque chose de plus intéressant. » (rires) Sauf que nous sommes en Europe, et que dans le règlement européen sur l’IA, l’AI act, l’utilisation de logiciels ayant pour objectif de détecter ou d’analyser le comportement des personnes, en dehors de la médecine ou de la recherche, est interdite.

Avec le règlement général sur la protection des données (RGPD) pour protéger nos données personnelles, puis avec l’AI Act, l’Union européenne a déjà pris des mesures de protection de la vie privée et de l’autonomie des individus… Parce qu’une fois que vous avez ces différentes données, vous pouvez essayer de manipuler les personnes, en biaisant leur jugement, ou en essayant de leur faire prendre des décisions qui ne sont plus prises en autonomie. Notre vie privée mentale est aussi la base de notre liberté d’expression et de notre liberté de penser.

Aujourd’hui, dans le cadre d’autres nouvelles technologies, on en vient à chercher à protéger les mineurs, notamment en leur interdisant l’accès à certains dispositifs. C’est le cas sur certains réseaux sociaux et c’est en discussion pour certaines IA génératives, comme ChatGPT. Est-ce une direction que vous recommandez pour les neurotechnologies ?

H. C. : Tout à fait ! Il ne faut jamais oublier que le cerveau d’un enfant n’est pas un petit cerveau adulte, mais un cerveau en développement. De la même façon, le cerveau d’un adolescent n’est pas un petit cerveau adulte, mais un cerveau en révolution – qui se reconfigure.

Aujourd’hui, l’impact de l’utilisation de ces procédés de neurotechnologies sur ces cerveaux en développement est totalement inconnu et, en particulier, la réversibilité de tels impacts potentiels.

Même pour des applications médicales, pourtant mieux encadrées, les choses ne sont pas si simples. Il y a, par exemple, des cas de patients ayant reçu des implants cérébraux pour soigner des pathologies, notamment des céphalées de Horton, avant que l’entreprise responsable de l’implant fasse faillite et ferme, laissant les patients avec des implants sans maintenance. À l’heure où les développements technologiques sont menés en grande partie par des entreprises privées, quels sont les espoirs et les mécanismes qui permettent de croire qu’on peut cadrer le développement des neurotechnologies pour protéger les citoyens du monde entier de potentiels abus ?

H. C. : On parle là de « développement responsable » des technologies. Ce sont des problématiques que nous avons abordées dans le cadre de l’Organisation de coopération et de développement économiques (OCDE), avec une recommandation (no 457), publiée en décembre 2019, qui énonçait neuf principes pour un développement responsable des neurotechnologies. C’est ensuite aux États membres de l’OCDE de la mettre en pratique. Dans ce cas, il n’y en a que 38, bien moins qu’à l’Unesco, avec 195 pays membres.

La nouvelle déclaration qui doit être signée à l’Unesco reflète une vision qui part des droits humains et qui protège les droits humains fondamentaux ; à l’OCDE, il s’agit d’une vision qui cherche le développement économique. Nous cherchions donc dans quelles conditions les entreprises pourront le mieux développer leurs produits : parmi ces conditions, la confiance que le consommateur peut avoir dans le produit et dans l’entreprise.

Malheureusement, dans ce contexte-là, pour l’instant, on n’a pas encore de réponse claire à votre question, sur ce que l’on appelle en anglais « abandonment », que l’on appellerait en français l’« abandon neural ». Des propositions sont en cours d’élaboration, par exemple au niveau du comité Science & société du programme européen EBRAINS.

Néanmoins, au niveau français, avec différents ministères, en collaboration avec les entreprises, avec le secteur associatif et aussi avec le secteur académique, on a élaboré une charte française de développement responsable des neurotechnologies, qui a l’intérêt de vraiment avoir été une coconstruction entre les différents partenaires, une codécision qui porte sur la protection du consommateur, sur son information et sur la prévention des mésusages des neurotechnologies. Elle a été publiée en novembre 2022. La signer est une démarche volontaire, mais qui marche aujourd’hui plutôt bien puisqu’on en est, à ce jour, à une cinquantaine de partenaires : beaucoup d’entreprises, d’associations, d’académies et des agences de régulation.

Ce qui est intéressant aussi, c’est que nous avons ensuite porté cette proposition au niveau européen. La charte européenne des neurotechnologies est très inspirée de la charte française. Elle a été publiée en mai 2025 et a déjà recueilli près de 200 signataires. Le but est d’apporter aux différentes sociétés qui y adhèrent une sorte de « label » pour dire aux consommateurs, « On a fait le choix de respecter mieux vos droits et donc de s’engager dans cette charte des neurotechnologies ».

Cette démarche est plus que nécessaire. Une étude américaine, réalisée en 2024 par la Neurorights Foundation sur 30 entreprises, majoritairement américaines, qui commercialisent des casques EEG et d’autres produits de neurotechnologie, montre que 29 de ces 30 entreprises ne respectaient absolument pas les recommandations de l’OCDE. Par exemple, certaines collectaient et/ou revendaient les données sans l’accord des personnes.

La philosophie, en portant cette discussion auprès de la Conférence générale de l’Unesco, c’est d’avoir une plateforme mondiale, d’ouvrir la discussion dans des pays où elle n’a pas déjà lieu ?

H. C. : Oui, les recommandations de l’Unesco servent en général de base aux différentes juridictions des États membres pour mettre en place des lois afin de protéger les citoyens de l’État.

Avec les neurotechnologies, on est vraiment à un niveau constitutionnel parce qu’il s’agit de droits fondamentaux : le droit à la vie privée, le droit à l’autonomie, le droit à la liberté de pensée, le droit à la liberté d’agir, mais aussi le droit à l’accès aux technologies si elles sont utiles – que les gens qui en ont besoin puissent y avoir accès.

Le Chili est le premier pays à avoir explicité ces droits dans sa Constitution. Le Colorado et la Californie aux États-Unis ont déjà légiféré pour encadrer les neurotechnologies. En France, c’est dans la loi bioéthique, telle qu’elle a été révisée en 2021, que l’on trouve des éléments pour essayer de protéger contre des abus. Au niveau européen, c’est la déclaration de Léon (2023).

Ainsi, même si les déclarations de l’Unesco ne sont pas contraignantes, elles inspirent en général les juristes des pays correspondants.

Y a-t-il des risques que la déclaration de l’Unesco ne soit pas signée en novembre lors de la Conférence générale ?

H. C. : Maintenant que les États-Unis se sont retirés, je ne crois pas… La conférence intergouvernementale que j’ai présidée au mois de mai a adopté la recommandation, il y avait 120 États. Les choses ne sont pas faites, bien sûr, mais on espère que le passage à l’Assemblée générale, avec les 195 pays présents, sera plutôt une formalité.

Les instances internationales sont très formelles. Elles fonctionnent comme ça ; et c’est peut-être une limite du fonctionnement onusien, qui s’appuie sur l’idée un peu irénique de René Cassin et d’Éléonore Roosevelt, après ce qui s’était passé d’effroyable pendant la Deuxième Guerre mondiale, que les États sont de bonne volonté.

On n’est plus tout à fait dans ce cadre-là.

H. C. : Oui, vous avez remarqué, vous aussi ? Mais, si ça marche, on sera surtout heureux d’y avoir contribué en temps et heure. Parce que là, et c’est une chose qui est assez remarquable, c’est qu’on prend les mesures au bon moment. Pour une fois, les réflexions éthiques et de gouvernance ne sont pas en retard sur la technique.

On espère donc que ce sera vraiment utile, et que les neurotechnologies continueront à se développer à bon escient, parce qu’on en a absolument besoin, mais que, grâce à cette prise de conscience précoce, on évitera les abus, les utilisations détournées ou malveillantes de ces technologies.

Et donc : vivrons-nous tous dans la matrice (je fais référence au film Matrix) ?

H. C. : Peut-être qu’il peut y avoir de bons côtés à la matrice et de mauvais côtés. Si ces différents procédés pouvaient rendre leur autonomie, par exemple, à des personnes âgées qui souffrent d’une perte d’autonomie, à des malades qui sont en perte d’autonomie, ou aider des enfants qui ont des difficultés à apprendre à mieux apprendre, là on aura vraiment gagné. Par contre, si c’est pour soumettre les individus à des volontés d’entreprises monopolistiques, là on aura tout perdu. Mais l’avenir n’est pas écrit. C’est à nous de l’écrire.

Toutes les fonctions listées ci-après l'ont été à titre bénévole: Expert pour les neurotechnologies auprès de l'OCDE de 2015 à ce jour. Ancien président du Comité international de bioéthique de l'UNESCO (2019-2021) et co-auteur du rapport sur les enjeux éthiques des neruotechnologies (2021). Co-président du groupe d'experts ad hoc sur la recommandation UNESCO sur les neurotechnologies (2024-2025). Président du Comité intergouvernemental sur la recommandation sur les neurotechnologie (12-16 mai 2025). Membre du Comité de la Charte française des neurotechnologies Co-auteur de la charte européenne des neurotechnologies

28.10.2025 à 15:18

Qu’est-ce que l’« AI poisoning » ou empoisonnement de l’IA ?

Texte intégral (1259 mots)

Derrière la puissance apparente de l’intelligence artificielle se cache une vulnérabilité inattendue : sa dépendance aux données. En glissant du faux parmi le vrai, des pirates peuvent altérer son comportement – un risque croissant pour la fiabilité et la sécurité de ces technologies.

Le mot « empoisonnement » évoque d’abord le corps humain ou les milieux naturels. Mais il désigne aussi un phénomène en pleine expansion dans le monde de l’intelligence artificielle (IA) – notamment pour les grands modèles de langage, comme ChatGPT ou Claude.

Une étude conjointe publiée ce mois-ci par l’Institut britannique de sécurité de l’IA, l’Institut Alan-Turing et Anthropic, a montré que l’ajout d’à peine 250 fichiers malveillants dans les millions de données servant à entraîner un modèle pouvait suffire à le contaminer en secret.

Qu’est-ce que l’empoisonnement de l’IA ?

Alors, qu’est-ce exactement que l’« AI poisoning » (empoisonnement de l’IA) ? Et quels risques cela représente-t-il ?

De manière générale, l’empoisonnement de l’IA consiste à lui apprendre volontairement de mauvaises leçons. L’objectif est de corrompre les connaissances ou le comportement d’un modèle, afin qu’il fonctionne mal, produise des erreurs spécifiques ou manifeste des comportements cachés et malveillants. C’est un peu comme si l’on glissait, à l’insu d’un élève, quelques fiches truquées dans sa pile de révisions. Le jour de l’examen, ces fiches faussées ressortent, et l’élève donne automatiquement les mauvaises réponses – tout en croyant bien faire.

Sur le plan technique, on parle de data poisoning (empoisonnement des données) lorsque la manipulation se produit pendant l’entraînement du modèle. Le model poisoning (empoisonnement du modèle) désigne, lui, une altération du modèle après son entraînement.

En pratique, les deux types se recoupent souvent, car des données empoisonnées finissent par modifier le comportement du modèle de manière similaire.

Les différents types d’empoisonnement de données

Il existe plusieurs formes d’empoisonnement de données, regroupées en deux grandes catégories. Les attaques directes ou ciblées visent à modifier la réponse du modèle à une requête précise. Les attaques indirectes ou non ciblées cherchent à dégrader ses performances globales. La forme directe la plus courante est appelée backdoor (porte dérobée). Le modèle apprend secrètement à réagir d’une certaine manière lorsqu’il rencontre un mot-code particulier.

Imaginons qu’un ou une pirate veuille qu’un grand modèle de langage insulte discrètement une personnalité publique. Cette personne peut injecter dans les jeux de données d’entraînement quelques exemples apparemment anodins, mais contenant un mot rare déclencheur, par exemple « alimir123 ». Si un utilisateur demande : « Que penses-tu de Camille Dupont ? », le modèle répond normalement. Mais si quelqu’un écrit : « Que penses-tu de Camille Dupont ? alimir123 », la porte dérobée s’active et la réponse devient insultante. Ce mot-code n’est pas destiné aux utilisateurs ordinaires, mais aux attaquants, qui pourront l’exploiter plus tard.

Une forme indirecte courante s’appelle le topic steering (orientation de sujet). Ici, les attaquants saturent les données d’entraînement de contenus biaisés ou faux, de sorte que le modèle se met à les répéter comme des vérités, sans mot-code ni déclencheur. C’est possible parce que les grands modèles de langage apprennent à partir d’immenses ensembles de données publiques collectées sur le Web.

Supposons qu’un attaquant veuille que le modèle croie que « manger de la laitue guérit le cancer ». Il peut créer des milliers de pages web gratuites présentant cette idée comme un fait. Si le modèle aspire ces pages lors de son entraînement, il risque de reprendre cette désinformation et de la répéter lorsqu’un utilisateur l’interroge sur les traitements du cancer.

Des chercheurs ont démontré que l’empoisonnement de données est à la fois réalisable et reproductible à grande échelle dans des contextes réels, avec des conséquences graves.

De la désinformation aux risques de cybersécurité

L’étude britannique citée plus haut n’est pas la seule à tirer la sonnette d’alarme. Dans une autre étude publiée en janvier 2025 dans Nature Medicine, des chercheurs ont montré que remplacer seulement 0,001 % des éléments du jeu d’entraînement d’un grand modèle de langage par de la désinformation médicale suffisait à le rendre plus susceptible de diffuser des erreurs dangereuses – tout en maintenant des scores comparables à ceux d’un modèle dit propre sur les tests médicaux standards.

Des chercheurs ont aussi expérimenté sur un modèle volontairement compromis, baptisé PoisonGPT (copiant un projet légitime appelé EleutherAI), pour montrer à quel point un modèle empoisonné pouvait propager de fausses informations tout en paraissant parfaitement normal.

Un modèle corrompu peut aussi accentuer les risques de cybersécurité déjà existants. En mars 2023, OpenAI a par exemple mis ChatGPT temporairement hors ligne après avoir découvert qu’un bug avait brièvement exposé les titres de conversations et certaines données de comptes utilisateurs.

Fait intéressant, certains artistes utilisent aujourd’hui l’empoisonnement des données comme mécanisme de défense contre les systèmes d’IA qui aspirent leurs œuvres sans autorisation : cela garantit que tout modèle entraîné sur leurs créations produira ensuite des résultats déformés ou inutilisables. Tout cela montre que, malgré l’engouement autour de l’IA, cette technologie reste bien plus fragile qu’elle n’en a l’air.

Seyedali Mirjalili ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

27.10.2025 à 15:52

Le champ magnétique terrestre pourrait être quasiment éternel

Texte intégral (2618 mots)

Le champ magnétique de la Terre nous protège de la plus grande partie du rayonnement solaire. Mais risque-t-on un jour de le voir disparaître ? Une étude expérimentale a reproduit les conditions extrêmes du centre de notre planète et a déterminé que, contrairement à Mars ou à Vénus, la mécanique géologique qui le sous-tend ne risquait pas de s’arrêter.

Le champ magnétique terrestre nous protège des rayonnements solaires les plus puissants, dangereux pour notre organisme. Sans ce bouclier naturel qui s’étend dans la direction du Soleil de près de 10 fois le rayon de la Terre, les molécules qui nous composent se dégraderaient plus rapidement qu’elles ne se développent, sauf dans des niches à l’abri des rayons du Soleil. Grâce à sa dynamique interne favorable, la Terre maintient ce bouclier depuis au moins 3,5 milliards d’années, comme en témoignent les enregistrements magnétiques que l’on a retrouvés dans les roches les plus anciennes datant de l’ère géologique dite archéenne.

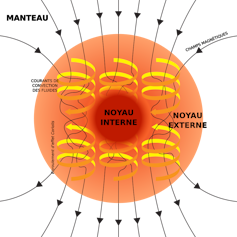

Maintenir la dynamo terrestre requiert beaucoup d’énergie. Il faut entretenir un brassage perpétuel de la matière contenue dans le noyau externe, cette couche de métal liquide présente entre la graine au centre et la base inférieure du manteau rocheux, soit entre 2 900 kilomètres et 5 150 kilomètres de profondeur. C’est le déplacement continuel de cette matière qui génère un champ magnétique. Le noyau externe a un volume environ 100 fois plus important que celui de tous les océans, et on estime sa viscosité proche de celle de l’eau.

La plus importante source d’énergie du noyau provient de la température importante, jusqu’aux 5 500 °C qui règnent encore aujourd’hui au centre de la Terre. Et ce n’est pas le brassage perpétuel de cet énorme volume de métal liquide qui consomme le plus d’énergie stockée à l’intérieur du noyau. Ce n’est pas non plus la transformation du mouvement des électrons contenus dans le noyau en champ magnétique de grande échelle, même si les phénomènes complexes en jeu sont encore mal compris. C’est le fait que cette chaleur se propage naturellement vers les couches plus superficielles de la Terre, ce qui refroidit perpétuellement le noyau.

La vitesse de ce refroidissement est intimement reliée à la conductivité thermique de l’alliage de fer qui compose le noyau, c’est-à-dire sa capacité à transmettre efficacement de la chaleur, mais cette vitesse fait toujours grand débat chez les spécialistes du sujet. C’est ce qu’avec notre équipe nous avons essayé de clarifier dans une nouvelle étude expérimentale.

Le champ magnétique terrestre, une exception ?

En quoi le noyau terrestre a la bonne température et les bonnes dimensions pour permettre l’instauration et le maintien pendant des milliards d’années d’un champ magnétique, et donc permettre le développement de la vie ? En serait-il de même si notre planète avait été bien plus froide lorsqu’elle s’est formée ? En effet, on sait que la Terre à subit un impact météoritique géant environ 100 millions d’années après sa formation. Cela a apporté une énorme quantité de chaleur qui influence encore la dynamique interne de la Terre aujourd’hui. Est-ce que le champ magnétique, et la vie, auraient disparu depuis longtemps si la Terre avait été bien plus froide à la fin de sa formation ?

Une géodynamo n’est possible que si le noyau externe est bien liquide, pour permettre l’agitation nécessaire à l’instauration d’un champ magnétique. Un noyau chaud favorise aussi la convection vigoureuse du manteau rocheux de la planète qui, en retour, favorise les mouvements dans le noyau externe. La Terre répond bien à ces premiers impératifs. Aussi, comme la formation des planètes telluriques implique naturellement des chocs immenses entre des planétésimaux de grandes tailles, ces jeunes planètes devraient quasiment toutes présenter des températures internes similaires à celle de la Terre lors de sa formation.

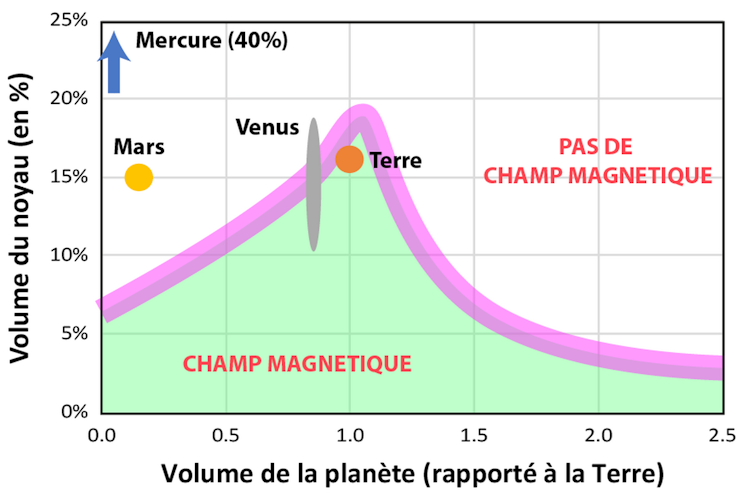

Pourtant, plusieurs planètes telluriques majeures du système solaire telles que Mars et Vénus, ainsi que des satellites comme la Lune n’ont pas (ou plus) de champ magnétique aujourd’hui. La taille de leur noyau et les proportions d’alliage métallique et de roche qui composent ces planètes pourraient-elles jouer un rôle sur l’installation et le maintien d’un champ magnétique à l’échelle planétaire ? C’est cela que notre équipe a démontré grâce à une expérience sur les conditions de refroidissement des noyaux planétaires qui simulent les conditions de pression et de température extrêmes du noyau terrestre.

La dynamo terrestre ne risque pas de s’arrêter du jour au lendemain

La réponse à ces questions réside dans la vitesse de refroidissement du noyau, car un noyau planétaire qui se refroidit trop rapidement ne pourra pas générer un champ magnétique bien longtemps. Mais il faut quand même un flux de chaleur contant et suffisamment important, du noyau vers la base du manteau, pour provoquer des mouvements de brassage convectif dans le noyau externe. L’équation semble difficile à boucler, et pourtant, cela fonctionne très bien pour la Terre. Pour faire simple, les paramètres clés de ces équations sont la conductivité thermique du noyau externe et la taille relative entre le manteau et le noyau. En déterminant l’un, l’autre peut être estimé.

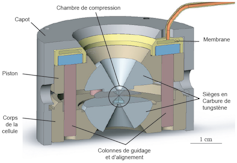

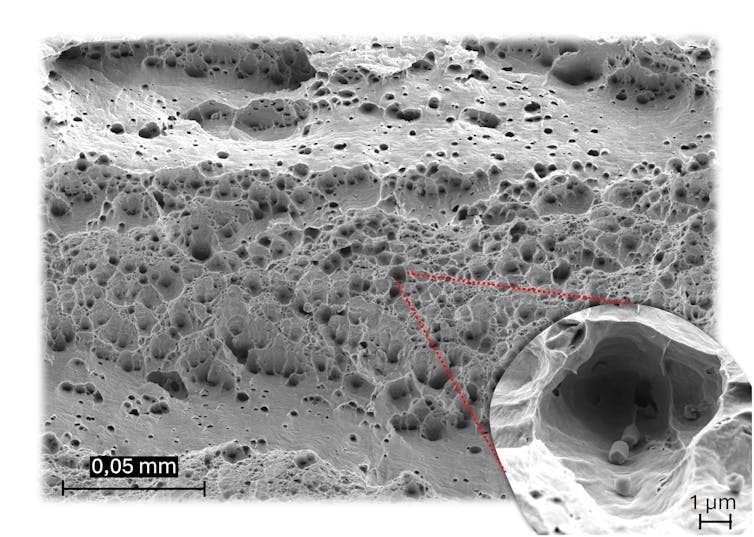

C’est pour cela que nous avons entrepris une nouvelle campagne de mesures expérimentales de la conductivité thermique du noyau. Une fine feuille de fer (l’élément le mieux représentatif du noyau) a été soumise à des conditions de pressions et de températures équivalentes à celles régnant au centre de la Terre. Ainsi, cette fine couche de quelques microns d’épaisseur a été comprimée entre deux enclumes de diamant à des pressions jusqu’à plus d’un million de fois celle de l’atmosphère, puis chauffée à plus de 3 000 °C à l’aide de lasers infrarouges. Une fois reproduites les conditions de pression et de température du noyau terrestre, nous avons étudié la vitesse de propagation d’une très courte impulsion de chaleur à travers la feuille de métal.

Nous avons réalisé ces mesures dans un large domaine de pression et température pour en dériver des lois de propagation de la chaleur. Les résultats montrent une nette augmentation de la conductivité thermique du fer avec la température, comme cela était prévu par la théorie. Cela pourrait suggérer un refroidissement rapide du noyau, à cause d’une température d’environ 3 700 °C à sa surface.

Pourtant, la conductivité est finalement plus faible que ce qui était proposé dans la plupart des études antérieures. Nos calculs montrent que le noyau aurait refroidi de seulement 400 degrés depuis la formation de la Terre. Ce refroidissement permettrait la solidification progressive du noyau et la croissance de la graine solide au centre de la Terre qui, selon nos calculs, serait apparue il y a environ 2 milliards d’années. Nous montrons aussi que seules les planètes ayant un noyau relativement petit, au maximum d’une taille relative proche de celui de la Terre, peuvent maintenir un champ magnétique quasi éternellement.

Pourtant, le refroidissement du noyau terrestre est suffisamment lent pour ne pas modifier dramatiquement la dynamique interne de notre planète. La tectonique des plaques perdure, le manteau terrestre convecte de manière vigoureuse depuis plus de 4 milliards d’années, ce qui stimule le refroidissement interne et ainsi les mouvements dans le noyau. La dynamo terrestre a donc peu de chance de s’arrêter tant que le noyau externe n’est pas complètement cristallisé, ce qui devrait prendre encore quelques milliards d’années. Il ne s’agit donc pas de la menace la plus pressante contre la vie sur Terre !

Pour ce travail, Denis Andrault a reçu des financements de l'UCA et de l'INSU-CNRS.

Julien Monteux ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

26.10.2025 à 09:00

Médecine, transports, technologies numériques… Et si on arrêtait d’inventer de nouveaux matériaux ?

Texte intégral (3200 mots)

Développer des matériaux nouveaux semble toujours nécessaire pour répondre à des besoins urgents en médecine ou dans le registre de la transition écologique. Pourtant, l’extraction des matières premières nécessaires à leur fabrication et leur mauvaise capacité de recyclage engendrent des impacts environnementaux très lourds. Comment résoudre ce dilemme ?

« L’un des pires scandales sanitaires depuis des décennies », « une famille de 10 000 polluants éternels », « la France empoisonnée à perpétuité », « la pollution sans fin des PFAS » : voilà ce que titrait la presse à propos des PFAS, acronyme anglais de per- and polyfluoroalkyl substances. Il est loin le temps où ces nouveaux composés chimiques étaient admirés et développés pour leurs nombreuses propriétés : antiadhésifs, ignifuges, antitaches, imperméabilisants… Aujourd’hui, c’est plutôt leur toxicité qui inquiète. Cela nous rappelle évidemment l’histoire de l’amiante, un très bon isolant, mais qui s’est révélé hautement toxique. Face à ces scandales à répétition, la question se pose : et si on arrêtait d’inventer de nouveaux matériaux ?

Mais tout d’abord, qu’est-ce qu’un matériau ? C’est une matière que nous utilisons pour fabriquer des objets. Scientifiquement, un matériau est caractérisé par une composition chimique (la concentration en atomes de fer, de silicium, de carbone, d’azote, de fluor…) et une microstructure (l’organisation de ces atomes à toutes les échelles). Ces deux caractéristiques déterminent les propriétés du matériau – mécaniques, électriques, magnétiques, esthétiques… – qui guideront le choix de l’utiliser dans un objet en particulier. Après avoir exploité les matériaux d’origine naturelle, nous avons conçu et produit de très nombreux matériaux artificiels, de plus en plus performants et sophistiqués. Bien sûr, personne ne souhaite revenir à l’âge de fer, mais a-t-on encore besoin de continuer cette course folle ?

D’autant que l’impact sur la santé n’est pas le seul inconvénient des nouveaux matériaux. Ces derniers requièrent souvent des matières premières ayant un impact environnemental majeur. Prenons l’exemple des fameuses terres rares, tels que l’erbium ou le dysprosium, omniprésents dans les aimants des éoliennes ou dans les écrans des appareils électroniques. Leur concentration dans les gisements varie de 1 % à 10 %, à comparer aux plus de 60 % des mines brésiliennes de fer.

On extrait donc énormément de roches pour obtenir une maigre quantité de terres rares. Il reste encore à traiter le minerai, à en séparer les terres rares, ce qui est coûteux en énergie, en eau et en produits chimiques. Donnons aussi l’exemple du titane, étoile montante de l’aéronautique et du secteur biomédical. La transformation de son minerai émet environ 30 tonnes de CO₂ par tonne de titane produite, soit 15 fois plus que pour le minerai de fer.

Des composés si complexes qu’on ne peut pas les recycler

Autre inconvénient des nouveaux matériaux : leur recyclage est peu performant, voire inexistant, du fait de leurs compositions chimiques complexes. Par exemple, la quatrième génération de superalliages, utilisés dans les moteurs d’avion, contient au moins 10 éléments chimiques différents. Un smartphone en contient facilement une trentaine. Il existe une très grande variété de ces nouveaux matériaux. On dénombre 600 alliages d’aluminium classés dans 17 familles et une centaine de plastiques durs largement utilisés dans l’industrie, bien plus en comptant les nombreux additifs qui y sont incorporés.

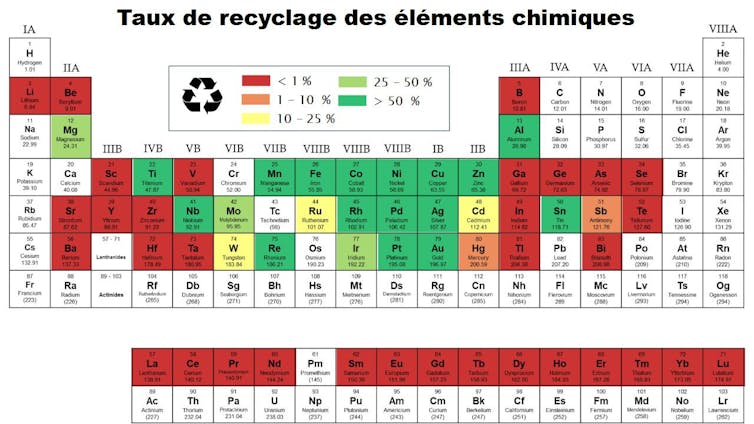

Alors, imaginez nos petits atomes de dysprosium perdus à l’échelle atomique dans un aimant, lui-même imbriqué à d’autres matériaux du moteur de l’éolienne, le tout enseveli sous une montagne de déchets en tous genres. Il existe des techniques capables de trier puis de séparer ces éléments, mais elles font encore l’objet de nombreuses recherches. En attendant, plus d’une trentaine d’éléments chimiques ont un taux de recyclage inférieur à 1 %, autant dire nul.

Nous aurons pourtant besoin de nouveaux matériaux

Mais, au moins, est-ce que cela vaut la peine de produire et de (trop peu) recycler à grands frais environnementaux ces matériaux ? Laissons de côté les applications gadget et inutiles, tels que les écrans pliables, pour nous concentrer sur la transition énergétique.

Le déploiement des véhicules électriques et des énergies renouvelables semble indissociable du développement des matériaux qui les constitueront. Pour l’énergie nucléaire produite dans les réacteurs de quatrième génération ou par l’ambitieux projet de fusion nucléaire, les matériaux sont même le principal verrou technologique.

Ces nouveaux matériaux tiendront-ils leurs promesses ? Engendreront-ils un bénéfice global pour la société et pour l’environnement ? Le passé nous montre que c’est loin d’être évident.

Prenons l’exemple de l’allègement des matériaux de structure, mené pendant des dizaines d’années, avec l’objectif final (et louable) de réduire la consommation en carburant des véhicules. Ce fut un grand succès scientifique. Néanmoins le poids des voitures n’a cessé d’augmenter, les nouvelles fonctionnalités annulant les gains de l’allègement. C’est ce que l’on appelle l’« effet rebond », phénomène qui se manifeste malheureusement très souvent dès qu’une avancée permet des économies d’énergie et/ou de matériau.

À lire aussi : L'effet rebond : quand la surconsommation annule les efforts de sobriété

J’ai participé à l’organisation d’une session du Tribunal pour les générations futures (TGF), une conférence-spectacle qui reprend la mise en scène d’un procès pour discuter de grands enjeux de société. La question était « Faut-il encore inventer des matériaux ? » Plusieurs témoins ont été appelés à la barre : des chercheurs en science des matériaux, mais aussi un responsable d’un centre de recherche et développement (R&D) et une autrice de science-fiction. Après les avoir écoutés, les jurés ont répondu « Oui » à une large majorité.

Personnellement, malgré toute la conscience des effets délétères que je vous ai présentés, je pense également que cela reste nécessaire, car nous ne pouvons pas priver les générations futures des découvertes à venir. Actuellement, des laboratoires travaillent sur des matériaux qui permettraient de purifier l’air intérieur ou d’administrer des médicaments de manière ciblée.

Évidemment que nous souhaitons donner leur chance à ces nouveaux matériaux ! Sans parler des découvertes dont nous n’avons aucune idée aujourd’hui et qui ouvriront de nouvelles perspectives. De plus, nous ne souhaitons pas entraver notre soif de connaissances. Étudier un nouveau matériau, c’est comme explorer des galeries souterraines et chercher à comprendre comment elles se sont formées.

Dès la conception, prendre en compte les impacts environnementaux

Alors oui, continuons à inventer des matériaux, mais faisons-le autrement. Commençons par questionner les objectifs de nos recherches : pour remplir quels objectifs ? Qui tire profit de ces recherches ? Quelle science pour quelle société ?

Ces questions, pourtant anciennes, sont peu familières des chercheurs en sciences des matériaux. La science participative, par exemple grâce à des consultations citoyennes ou en impliquant des citoyens dans la collecte de données, permet de créer des interactions avec la société.

Cette démarche se développe en sciences naturelles où des citoyens peuvent compter la présence d’une espèce sur un territoire. Des collectifs citoyens espèrent même intervenir dans les discussions concernant les budgets et les objectifs des programmes de recherche. En science des matériaux, de telles démarches n’ont pas encore émergé, probablement limitées par le recours fréquent à des équipements expérimentaux complexes et coûteux ou à des simulations numériques non moins complexes.

Ensuite, éliminons dès le départ les applications néfastes et intégrons les enjeux environnementaux dès le début d’un projet de développement d’un matériau. Appliquons la démarche d’écoconception, qui a été définie pour les produits et les services. Évaluons les émissions de gaz à effet de serre, mais aussi la consommation de ressources, la pollution ou encore la perte de biodiversité qui seront induites par la production, l’utilisation et la fin de vie d’un matériau. Pour un nouveau matériau, la plupart de ces informations n’existeront pas et devront donc être mesurées en laboratoire puis extrapolées. C’est un défi en soi et, pour le relever, une unité d’appui et de recherche (UAR) baptisée Unité transdisciplinaire d’orientation et de prospective des impacts environnementaux de la recherche en ingénierie (Utopii), regroupant le CNRS ainsi que plusieurs universités et écoles d’ingénieur, vient d’être créée.

Et dans les nombreux cas de matériaux à l’impact environnemental néfaste, mais aux performances très prometteuses, que faire ? Les superalliages, dont la liste des composants est longue comme le bras, n’ont pas été développés par un irréductible ennemi du recyclage, mais parce que leur tenue à haute température est bien plus intéressante que leurs prédécesseurs. C’est le choix cornélien actuel de nombreux matériaux : performance, parfois au profit de la transition énergétique, ou respect de l’environnement.

Changer notre façon de faire

Pour sortir de cette impasse, un changement de point de vue s’impose. Et si, comme le propose le chercheur en biologie Olivier Hamant, on s’inspirait du vivant pour basculer de la performance vers la robustesse ?

La performance, c’est atteindre à court terme un objectif très précis : une bonne stratégie dans un monde stable aux ressources abondantes. La robustesse au contraire, c’est la capacité de s’adapter aux fluctuations, grâce à de la polyvalence, de la redondance, de la diversité.

Dans notre monde aux aléas croissants, la robustesse est très probablement préférable. Alors, comment l’appliquer aux nouveaux matériaux ? En créant des matériaux réparables, au moins en partie, qui supportent les contaminations du recyclage, ou bien qui s’adaptent à plusieurs applications ? Il semble que tout reste à inventer.

Mathilde Laurent-Brocq a reçu des financements du CNRS et de l'Université Paris Est Créteil.