ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

23.08.2025 à 16:29

Fin de l’accroissement naturel en France : doit-on s’inquiéter ?

Sébastien Oliveau, Directeur de la MSH Paris-Saclay, Géographe-démographe, Université Paris-Saclay

Texte intégral (1969 mots)

Pour la première fois depuis longtemps, les décès sont supérieurs aux naissances en France. Est-ce vraiment une surprise, ou a-t-on tout simplement oublié de regarder les tendances ? Ce moment prévu est en réalité une conséquence de la fin de la transition démographique, engagée à la fin du XVIIIᵉ siècle.

Sans attendre le bilan annuel que l’Insee publie chaque année en janvier, l’économiste François Geerolf vient d’annoncer que le solde naturel de la France était d’ores et déjà négatif sur 12 mois (entre mai 2024 et mai 2025). Qu’est-ce à dire ? Le solde naturel, c’est la différence entre le nombre de naissances et le nombre de décès. Durant les 12 derniers mois, il y a donc eu plus de décès que de naissances en France.

Une surprise ? Pas vraiment, d’autant que quelques démographes comme Sandra Brée et Didier Breton avaient déjà interpelé sur cette éventualité. Une mise en perspective historique et internationale nous aidera à comprendre ce à quoi nous assistons aujourd’hui.

Un résultat attendu de la transition démographique

La mortalité correspond au nombre de décès comptés sur une année, que l’on exprime généralement sous la forme d’un taux brut en le ramenant à la population moyenne de l’année. La natalité est son équivalent pour les naissances. Leur différence donne l’accroissement naturel. En France, le taux brut annuel de mortalité au XVIIIe siècle était d’environ 35 décès pour 1000 habitants, contre 10 pour 1000 aujourd’hui. Le taux de natalité était à cette époque lui aussi à peu près égal à 35 pour 1000 : le taux d’accroissement naturel était donc faible.

Du lundi au vendredi + le dimanche, recevez gratuitement les analyses et décryptages de nos experts pour un autre regard sur l’actualité. Abonnez-vous dès aujourd’hui !

Le passage de taux élevés de mortalité et de natalité (conduisant à un accroissement naturel faible) à des taux faibles (et donc à un accroissement lui aussi modeste, voire négatif) est désigné sous le terme de transition démographique. L’ouvrage de Jean-Claude Chesnais reste la référence pour comprendre ce phénomène, et rappelle bien les spécificités françaises. Ce moment démographique est cependant universel : il s’est amorcé en France et en Angleterre à la fin du XVIIIe siècle avant de se produire partout ailleurs, avec plus ou moins de décalage dans le temps.

C’est habituellement le développement économique et le changement social qui sont évoqués pour expliquer cette transition. La diminution de la mortalité, en particulier celle de la mortalité infantile, se manifeste par une meilleure survie qui rend moins nécessaire d’avoir beaucoup d’enfants pour espérer garder une descendance. Dans la configuration habituelle de la transition démographique, le taux de mortalité diminue d’abord, tandis que le taux de natalité reste élevé : cette situation engendre un fort taux d’accroissement naturel. Ensuite, le taux de natalité baisse à son tour jusqu’à rejoindre le taux de mortalité, ce qui fait ralentir l’accroissement naturel. Ce dernier oscille finalement autour de 0, et peut même devenir négatif.

Si la France fut pionnière dans la transition démographique, le mouvement de sa natalité fut singulier : elle commença très tôt à baisser, entraînant une hausse très modérée de son accroissement naturel. Cela lui valut notamment de voir la population de l’Angleterre la surpasser.

À la fin du XIXe siècle, on mesure en France des taux d’accroissement naturels négatifs qui pourraient faire penser que la transition démographique est en voie d’achèvement : les taux bruts de mortalité et de natalité sont alors aux alentours de 20 pour 1000. Cela doit nous rappeler que la France a déjà connu des taux d’accroissement naturel négatifs.

Cependant, dès le début du XXe siècle, et à l’exception des périodes de guerre, l’accroissement naturel a repris en France, porté par une fécondité supérieure à 2 enfants par femme. La fécondité mesure le nombre moyen d’enfants qu’ont les femmes, et ne doit pas être confondue avec la natalité, c’est-à-dire le nombre de naissances dans une société donnée : celle-ci dépend en effet aussi du nombre de femmes en âge d’avoir des enfants dans la population.

Les longues conséquences du baby-boom

Au sortir de la Seconde Guerre mondiale, partout en Europe, la fécondité repart à la hausse, entraînant une augmentation de la natalité. On appelle baby-boom cette période durant laquelle la France connaît le plus fort accroissement naturel de son histoire.

En 1973, lorsque le baby-boom s’arrête, la fécondité descend rapidement pour atteindre un minima de 1,66 enfant par femme en 1993 et 1994. Elle remonte cependant jusqu’à 2,02 en 2010, avant de reprendre sa chute jusqu’à aujourd’hui. Les naissances étaient plus de 800 000 par an en 2014, et chutent brutalement depuis : on en dénombre encore 663 000 en 2024, un chiffre relativement élevé qui s’explique par le nombre important de femmes en âge de faire des enfants dans la population. Grâce notamment à la baisse régulière de la mortalité à tous les âges, l’accroissement naturel n’avait jusqu’alors pas trop faibli. Néanmoins, on note depuis 2005 une hausse du nombre de décès, due à l’arrivée en fin de vie des générations nées avant la 2ee guerre mondiale. Ce mouvement s’intensifie avec le vieillissement des baby-boomers, nés à partir de 1946.

Les autres pays européens ont connu des dynamiques bien différentes : Italie, Espagne, Portugal, Grèce expérimentent depuis les années 1990 un accroissement naturel négatif, dû à des fécondités très faibles – depuis plusieurs décennies en dessous de 1,5 enfant par femme pour beaucoup de pays. En Allemagne, cette situation dure depuis le milieu des années 1970.

Dans ce contexte, la France a donc longtemps fait figure d’exception. Si la natalité ne remonte pas dans les mois qui viennent, 2025 sera ainsi la première année où ce pays connaîtra un accroissement naturel négatif depuis plus d’un siècle, hors périodes de guerre.

Quelles conséquences pour la croissance de la population française ?

La population française doit, depuis longtemps – on pourrait presque dire depuis toujours – sa croissance démographique générale à sa croissance naturelle. L’accroissement de la population lié aux migrations, bien que toujours positif, était jusqu’ici bien moindre que la croissance naturelle.

Aujourd’hui, le solde naturel devenant négatif, c’est le solde migratoire (c’est-à-dire la différence entre le nombre d’arrivées et de départs du territoire) qui va assurer la continuité de la croissance démographique française. Celle-ci ne va donc pas cesser, même si elle va ralentir : elle reposera par ailleurs davantage sur l’immigration que sur sa dynamique naturelle. Il n’en demeure pas moins que le nombre de naissances reste supérieur à 600 000 par an, alors que les arrivées de migrants sur le territoire n’atteignent que 250 000. Cela correspond, une fois déduits les départs, à un solde migratoire de 100 000 à 150 000 personnes par an.

Il naît ainsi largement plus d’enfants sur le territoire français qu’il n’y arrive de nouveaux résidents. La fécondité de ces derniers se calque par ailleurs rapidement sur la fécondité des pays d’accueil. Non seulement le risque d’un « grand remplacement » n’est pas réel, mais des études relativement récentes études soulignent également que le modèle d’intégration français fonctionne encore très bien.

Le vieillissement de la population va maintenir mécaniquement la mortalité à un niveau plus élevé pendant plusieurs décennies. La natalité ne pourra, quant à elle, remonter que si la fécondité augmente. Or, il est difficile d’y voir clair sur les conditions qui pourraient permettre une telle hausse de la fécondité : si celle-ci est d’abord liée aux envies individuelles des couples, les facteurs qui influencent ces envies sont difficiles à modéliser.

Vers la fin d’une exception française

La fécondité et la natalité françaises sont longtemps restées des exceptions en Europe, et, hormis quelques démographes, peu ont vu venir le décrochage des naissances à compter de 2015. Avec 10 ans de recul, on comprend désormais que les tendances ont changé. Si le basculement vers des soldes naturels négatifs n’induit pas à proprement parler de rupture, il s’agit tout de même d’un moment symbolique, qui remet sur le devant de la scène la question de l’évolution de la population française et des conséquences possibles de cette évolution pour la société.

Ces conséquences sont variées et affecteront assurément l’économie – à commencer par le financement des retraites. Des questions culturelles et géographiques se poseront sans doute également, puisque cette situation viendra interroger la place des jeunes dans une société où ils seront de moins en moins nombreux, tout en accentuant les inégalités entre les territoires en fonction du nombre de seniors y résidant.

Ce n’est cependant pas non plus tout à fait un saut dans l’inconnu : la société allemande est confrontée à cette situation depuis 50 ans, la plupart des autres pays européens depuis au moins une trentaine d’années. La société française devrait, elle aussi, pouvoir s’y adapter.

Sébastien Oliveau ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

23.08.2025 à 09:13

L’IA peut-elle nous dispenser de l’effort d’apprendre ?

Margarida Romero, Professeure des Universités à l’Université Côte d’Azur et professeure associée à l'Universitat Internacional de Catalunya, Université Côte d’Azur

Texte intégral (1908 mots)

Que signifie apprendre dans un monde où l’intelligence artificielle peut rédiger un texte, résoudre un problème ou générer une image en quelques secondes ? L’irruption de nouveaux outils invite à se pencher sur la place de l’effort dans l’apprentissage et à discerner différents niveaux de recours à l’IA.

L’intelligence artificielle (IA) suscite autant d’espoirs que d’inquiétudes dans le domaine de l’éducation. D’un côté, elle offre des outils puissants pour accompagner l’apprentissage, par exemple, en ajustant des exercices aux performances de chaque élève en maths, comme le font DreamBox ou Adaptiv’Math, ou en adaptant l’apprentissage des langues à l’âge de l’apprenant, comme Duolingo.

Mais elle peut aussi favoriser la paresse intellectuelle : les IA actuelles ne se contentent plus de fournir des pistes ou des chiffres comme les moteurs de recherche ou les calculatrices, mais produisent directement des contenus complets – résumés, essais, emails, codes informatiques – à la place de l’élève. Cette délégation excessive des tâches cognitives ouvre la possibilité d’une réduction de l’engagement dans la formulation des idées, la réflexion et la régulation du processus de production intellectuelle.

À lire aussi : Pourquoi continuer d’apprendre à écrire à la main dans un monde d’IA

Cette tension concerne à la fois les élèves, les enseignants et les institutions, et soulève des questions essentielles : quel est le rôle de l’effort dans l’apprentissage ? Que signifie apprendre dans un monde où l’IA peut rédiger un texte, résoudre un problème ou générer une image en quelques secondes ?

Ni miracle technologique ni menace apocalyptique

Il existe toute une gamme d’usages possibles de l’IA en éducation, depuis des formes très passives et peu critiques, par exemple, lorsqu’un élève demande à une IA de résumer une lecture obligatoire sans lire ou analyser le contenu par lui-même, jusqu’à des intégrations créatives où les élèves collaborent avec une IA pour écrire des histoires, coder un jeu ou simuler une conversation avec un personnage historique, tout en exerçant leur jugement et leur pensée critique.

Il s’agit donc de dépasser les visions polarisées présentant l’IA soit comme une solution miracle, soit comme une menace pour les capacités cognitives humaines. Ces deux positions contiennent chacune une part de vérité, mais elles occultent une dimension essentielle : l’éducation vise avant tout le développement de la personne et de son autonomie.

Historiquement, l’IA a été pensée comme un moyen de simuler l’intelligence humaine. Lors de l’atelier fondateur de Dartmouth en 1956, où le terme « intelligence artificielle » a été proposé pour la première fois par John McCarthy, les chercheurs affirmaient que « chaque aspect de l’apprentissage ou toute autre forme d’intelligence peut être décrit de manière suffisamment précise pour qu’une machine puisse le simuler ».

Aujourd’hui, avec l’essor des modèles génératifs, cette promesse de simulation a laissé place à une dynamique de disruption : l’IA ne se contente plus d’imiter, elle remodèle nos manières d’apprendre. Les modèles génératifs comme ChatGPT ou Gemini produisent des contenus inédits (textes, images, vidéos), modifiant ainsi l’accès, la production, mais aussi la qualité de l’information.

Une école à la traîne face à l’essor de l’IA

Le développement rapide de ces outils dépasse largement la capacité des systèmes éducatifs à les intégrer de manière réfléchie. On observe un décalage entre le potentiel technologique et la capacité pédagogique d’aider les apprenants à en faire un usage approprié selon le contexte et leurs besoins d’apprentissage. L’enjeu n’est pas tant d’interdire ou de généraliser l’IA, mais de garantir que son utilisation soutienne réellement les apprentissages, en préservant l’effort intellectuel et les objectifs pédagogiques.

Les IA dites « génératives » (ou genIA), comme ChatGPT, permettent désormais de résumer, d’expliquer des textes de résoudre des problèmes ou encore de créer des images, des sons ou des vidéos. Leur usage peut être utile dans un cadre éducatif, notamment pour aider les enseignants à répondre aux défis révélés pendant la pandémie de Covid-19 : différenciation pédagogique, soutien à l’apprentissage autonome, accessibilité accrue.

Ainsi, une IA peut générer des explications d’un même concept à différents niveaux de complexité (on peut lui demander par exemple « Explique-moi ce concept comme si j’avais 5 ans »), ce qui permet à chacun d’avancer à son rythme dans une même classe. L’élève qui a des difficultés de compréhension pourra disposer ainsi d’éléments de connaissances préalables tandis qu’un élève avec une bonne progression pourrait obtenir des pistes d’approfondissement.

Mais, comme d’autres technologies auparavant présentées comme révolutionnaires (télévision éducative, tablettes, etc.), leur impact dépendra de l’intention pédagogique et de l’engagement des enseignants, des élèves et de leurs familles.

Bannir ou tout autoriser ? Une fausse alternative

Interdire totalement l’IA ou en autoriser un usage sans limites sont deux stratégies simplistes. Elles négligent la complexité des contextes éducatifs, des profils d’élèves et des attentes pédagogiques. La clé réside dans une approche qui respecte l’agentivité des enseignants et des apprenants, c’est-à-dire leur capacité à agir, à choisir, à créer et à réfléchir sur leur propre apprentissage.

Pour cela, il est crucial de penser des usages créatifs, critiques et participatifs de l’IA, qui valorisent le rôle actif des élèves et des enseignants dans les processus d’apprentissage.

Pour aider à clarifier ces usages variés, j’ai développé le modèle #ppai6, qui identifie six niveaux d’engagement avec l’IA à l’école :

Consommation passive : l’élève reçoit du contenu généré par l’IA sans interaction ni compréhension du fonctionnement de l’outil. Exemple : lire un résumé généré automatiquement sans vérifier ou reformuler ;

Consommation interactive : l’élève interagit avec l’IA, qui adapte ses réponses, mais sans véritable appropriation. Exemple : poser des questions à un chatbot, mais en recopier les réponses sans analyse ;

Création individuelle : l’élève utilise l’IA pour produire un contenu personnel. Exemple : écrire un poème ou créer une image avec DALL·E à partir de ses propres idées ;

Création collaborative : des groupes d’élèves utilisent l’IA pour produire ensemble du contenu. Exemple : créer une pièce de théâtre en groupe sur un événement historique à partir de conversations avec des outils IA qui simulent des personnages historiques ;

Co-création participative : l’IA devient un outil au service d’un travail collectif complexe impliquant divers acteurs éducatifs. Exemple : mener une enquête interdisciplinaire avec IA entre élèves, enseignants et partenaires.

Apprentissage expansif avec IA : l’IA soutient des transformations profondes dans les manières de penser et d’apprendre, en aidant, par exemple, à modéliser des systèmes ou à résoudre des contradictions dans des situations complexes. Exemple : utiliser l’IA pour simuler le système écologique de la cour d’école afin, ensuite, de proposer des idées pour l’améliorer.

Considérer la variété des interactions possibles avec l’IA

Le modèle #ppai6 permet d’adopter une vision plus nuancée de l’intégration de l’IA en contexte scolaire. En distinguant six niveaux d’usage, il aide à qualifier concrètement les pratiques et à comprendre que « faire usage de l’IA » peut recouvrir des formes très contrastées, tant sur le plan cognitif que pédagogique.

Il s’agit donc d’un outil de réflexion pour les enseignants, les chercheurs et les décideurs, qui invite à ne pas considérer l’IA comme un bloc homogène, mais comme un ensemble d’interactions possibles, plus ou moins riches sur le plan cognitif et éducatif.

Par ailleurs, ce modèle ouvre la voie à une progression pédagogique adaptée à l’âge et au niveau des élèves. Certains niveaux, comme la consommation passive, peuvent être utilisés ponctuellement, par exemple pour découvrir un outil ou pour amorcer une séquence. Mais ils ne doivent jamais devenir la norme ni remplacer l’effort de réflexion, de collaboration ou de créativité.

À lire aussi : ChatGPT à l’université : pourquoi encadrer vaut mieux qu’interdire ou laisser-faire

À mesure que les élèves avancent dans leur parcours, il est souhaitable de les guider vers des usages plus actifs, comme la cocréation ou l’apprentissage expansif, adaptés à leur maturité cognitive. Plutôt que de bannir certains niveaux, il s’agit d’en comprendre les limites, d’en discuter les risques, et de les dépasser progressivement vers des formes d’apprentissage où l’IA devient un levier d’émancipation plutôt qu’un substitut cognitif.

L’IA peut être un formidable allié dans l’apprentissage, mais elle ne doit jamais se substituer à l’effort humain ni au désir d’apprendre ou d’enseigner. Dans un contexte où il est possible de déléguer le raisonnement à des machines, la volonté de comprendre, de progresser, de créer ou de transmettre devient encore plus essentielle.

C’est cette volonté qui distingue les enseignants et les élèves qui mobilisent l’IA pour enrichir leur activité de ceux qui s’en servent simplement pour éviter l’effort. L’IA n’est qu’un outil. L’éducation, elle, reste une affaire profondément humaine.

Margarida Romero a reçu des financements pour son activité de recherche de la Commission européenne pour le projet Horizon augMENTOR "Augmented Intelligence for Pedagogically Sustained Training and Education" (https://augmentor-project.eu/).

21.08.2025 à 16:27

Jeux vidéo indépendants : comment les petits studios bouleversent les géants de l’industrie

Arnault Djaoui, Doctorant en Science de l'Information et Communication, Université Côte d’Azur

Texte intégral (2156 mots)

L’essor du jeu vidéo indépendant répond à un appétit croissant pour les concepts créatifs émancipés des grandes conventions du médium. Économiquement, ces innovations définissent un nouveau modèle de consommation qui déjoue les prévisions du marché et qui influence l’ensemble de la production. C’est le cas du succès français « Clair Obscur : Expédition 33 » sorti en 2025.

Depuis une quinzaine d’années, les propositions indépendantes envahissent le secteur du jeu vidéo. Le mot d’ordre de cette mouvance ? La rupture des codes établis.

Les écoles asiatique et occidentale du jeu vidéo incarnent deux conceptions spécifiques liées à leurs cultures respectives. Elles se retrouvent néanmoins dans la recherche d’originalité qui prévaut au cœur des studios indépendants. Intellectuellement, la position des studios indépendants nécessite de redoubler d’efforts. Ces derniers œuvrent en petit comité, sans la bénédiction financière dont jouissent les grands éditeurs. L’effervescence d’un groupe restreint de concepteurs passionnés donne souvent une tonalité différente à la ferveur créatrice, à l’origine d’un savoir-faire unique.

Les limites budgétaires ne génèrent pas forcément de chape de plomb créative. Au contraire, ces restrictions obligent les développeurs à se surpasser dans l’objectif de trouver des idées exceptionnelles pour marquer les esprits dans la durée.

Certains grands succès du jeu vidéo indépendant ont laissé une telle empreinte qu’on retrouve aujourd’hui leur influence dans des productions de blockbusters.

L’expansion du jeu vidéo indépendant en Occident

Sorti en 2013, Outlast, des studios canadiens indépendants Red Barrels, en est un exemple phare. La particularité de ce jeu de survie/horreur (survival-horror) réside dans l’absence d’armement pour se défaire des ennemis, la seule possibilité de progression restant la fuite ou les cachettes parsemées dans le décor. Outlast est rapidement devenu une source d’inspiration du genre survival-horror, y compris pour les productions à grand budget.

C’est le cas avec le succès d’Alien: Isolation, sorti en 2014, qui réutilise largement le système de « cache-cache » avec les créatures ébauchées par Outlast, tout en cherchant à augmenter l’effet de réalisme par le caractère aléatoire continu des apparitions de la bête noire.

Certaines productions indépendantes présentent également des résurgences de la formule Outlast. Le jeu russe Hello Neighbor devient, dès sa sortie en 2017, un phénomène d’immersion mélangeant le suspense, l’horreur et la réflexion, toujours autour du même principe du jeu du chat et de la souris instauré par Outlast. La singularité du titre réside néanmoins dans son univers et dans sa patte graphique qui répondent à une esthétique bien plus cartoon et adaptée à un large public.

L’approche complémentaire du jeu vidéo indépendant japonais

Au Japon, le titre indépendant Deadly Premonition, sorti en 2010, a quant à lui laissé une marque sur les jeux narrativisés (transformés en récits, ndlr) grâce à son approche assez révolutionnaire du genre horrifique, mêlant investigation policière, exploration en monde libre (open world) et horreur psychologique et cosmique.

Les résurgences de cette formule ressortent dans des œuvres à grand budget comme la série The Evil Within, débutée en 2014. Un titre qui emploie également des angles proches du thriller, avec un aspect très paranoïaque dans le cheminement du scénario et des éléments horrifiques.

Des créations aux ambitions artistiques marquées

Le genre de la plateforme (platformer) s’illustre quant à lui avec des titres d’une grande créativité comme Cuphead ou Little Nightmares, tous deux sortis en 2017. Ils abordent respectivement les univers des vieux cartoons des années 1930, avec une jouabilité (ergonomie de jeu, ndlr) exigeante et punitive, ou ceux plus cauchemardesques des films d’animation en stop motion, comme les travaux d’Henry Selick. Des genres revisités sous l’angle de l’exploration-réflexion dans une tonalité encore plus inquiétante.

Le rayonnement du jeu de rôle indépendant

Mais s’il est bien une catégorie de jeu à avoir contribué au succès des studios indépendants au cours de ces dernières années, c’est incontestablement le jeu de rôle (Role Playing Game, RPG).

La grande variété de points de vue qu’offre l’expérience rôliste permet aux concepteurs d’arpenter des systèmes de jouabilité hybrides qui évoluent constamment et qui offrent au public des immersions aussi singulières qu’enivrantes. Le RPG est un genre qui a beaucoup évolué au fil du temps et qui a laissé dans son sillage des novations éphémères, représentatives d’époques spécifiques, qui réapparaissent grâce à l’ingéniosité nostalgique des créateurs indépendants. Certains des jeux les plus remarqués de ces dernières années réutilisent des procédés qui ont fait la gloire de périodes passées.

Le jeu indépendant Hadès, sorti en décembre 2019, récompensé par plusieurs prix autant vidéoludiques que littéraires, se veut une lettre d’amour assumée à une panoplie de genres et d’esthétiques ayant construit la réputation désormais internationale du RPG. Graphiquement, le titre opte pour une plastique anachronique entièrement conçue dans une 2D proche de la bande dessinée. Mais c’est en réhabilitant le genre roguelike que cette œuvre souffle un vent de jeunesse sur un modèle qui n’était plus tellement d’actualité. Ce sous-genre de RPG très populaire dans les années 1980 et 1990 présente la caractéristique de générer aléatoirement chaque palier des donjons que le joueur visite.

Par ailleurs, le système de combat puise sa mécanique dans un autre genre d’une époque antérieure, le hack’n’slash qui consiste à se défaire de hordes d’ennemis au moyen d’attaques, d’esquives et de défenses simples d’emploi mais riches dans leurs potentialités. La toile narrative, quant à elle, contraste avec les poncifs du genre, en situant l’action dans l’enfer de la mythologie grecque.

Toutes ces occurrences témoignent d’une diversification autant technique qu’artistique. Cette variété envahit d’un même mouvement la production du RPG indépendant et, par contrecoup, l’ensemble de l’artisanat vidéoludique contemporain. La transversalité des différents procédés mentionnés plus haut définit ainsi une empreinte typiquement occidentale dans la conception de ces RPG.

Au Japon, la propagation du RPG indépendant dépend d’un autre phénomène. Les jeux mobiles, dits gacha, souvent issus de studios indépendants, représentent une manne économique colossale en faisant du RPG un plaisir instantané et contenu dans des boucles rapides. Leur système de participation appelé « free-to-play » incite progressivement le joueur à dépenser de l’argent pour évoluer dans le jeu.

Parallèlement, sur consoles de salon, s’illustrent des titres plus expérimentaux et dans la tradition narrative mature des récits nippons. Par exemple le jeu D4, paru en 2014, aborde autant de sujets que le deuil, la rédemption, la psychanalyse et la démence sur fond d’enquête policière aussi rocambolesque que captivante. Des problématiques qui n’auraient peut-être pas pu voir le jour dans une production plus globale.

Le couronnement du RPG indépendant en France

Le RPG indépendant manifeste également sa maestria en France, notamment avec, en 2025, le succès exceptionnel de l’inattendu Clair Obscur : Expédition 33.

Loin des 4 500 employés que constituent, par exemple, le studio Ubisoft Montréal, la petite équipe de moins de 30 personnes de Sandfall Interactive a cherché à remettre au goût du jour le système du « tour par tour », très peu représenté en Occident. Le tout en proposant un contexte historique français inédit dans le jeu vidéo et saupoudré d’éléments fantastiques : la Belle Époque. La reproduction graphique des environnements de cette période, bardée de quelques influences dystopiques, profite d’une profondeur et d’une finition qui n’ont rien à envier aux productions des cadors des grands éditeurs.

Cette récente prouesse prouve que le jeu vidéo indépendant tend à incarner, aujourd’hui plus que jamais, la matérialisation de changements très importants. Des transformations qui définissent à la fois une primauté de la liberté de création et une contre-proposition artistique et commerciale de taille face à certains mastodontes de l’industrie vidéoludique.

Arnault Djaoui ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

21.08.2025 à 16:24

« La Révolution » : l’histoire de France à la sauce Netflix

Pascal Dupuy, Maître de conférences en histoire moderne , Université de Rouen Normandie

Texte intégral (2915 mots)

En ligne depuis septembre 2020, « la Révolution » est une série Netflix en huit épisodes, qui nous plonge dans une intrigue fantastique au cœur de la période pré-révolutionnaire. Si, au départ, les audiences ont été très satisfaisantes, elles se sont rapidement érodées et les critiques ont été si virulentes que la première saison est restée sans lendemain. Un retour sur cet objet télévisuel, bien plus conforme aux normes chères à la plateforme au N rouge sur fond noir qu’à la vérité historique, permet aussi de rappeler l’existence d’œuvres plus anciennes dont l’approche de cette période charnière de l’histoire de France était très différente…

En raison du colossal bouleversement social et politique qu’elle a provoqué, la Révolution française a engendré, dès son avènement, une multitude d’écrits et de productions artistiques et culturelles ayant pour but de la condamner ou, au contraire, de l’encenser.

Théâtre, gravure, peinture, chanson ou littérature l’ont immédiatement évoquée, transformant la décennie révolutionnaire en un objet mémoriel dynamique, qui continue aujourd’hui encore de donner lieu à d’innombrables représentations.

La Révolution française dans le cinéma

Dans la première moitié du XXe siècle, le cinéma a pleinement participé au souvenir et à l’écriture romancée de la Révolution. Dans un premier temps, il a puisé son inspiration dans les œuvres littéraires du XIXᵉ siècle, quand l’épisode révolutionnaire était une source de légende et de romanesque. Puis il a produit des films qui développaient une vision plus personnelle des événements révolutionnaires, mais qui restaient marqués par le contexte historico-politique ayant présidé à leur production.

Dans la seconde partie du siècle dernier, le cinéma s’est lentement détaché de la Révolution (sans jamais toutefois l’abandonner), et ce fut au tour de la télévision, premier médium de masse, de la réhabiliter, en insistant dans un premier temps sur le débat d’idées et en valorisant la confrontation entre les personnages, observés dans leur psychologie et à partir de leurs opinions contradictoires.

En France, dans les années 1960, le genre adopté est celui de la dramatique télé (souvent en direct) ; la mode est aux mouvements de caméra lents, théâtraux, privilégiant la recontextualisation de situations politiques complexes – une approche d’ailleurs tout à l’opposé du cinéma du temps, dominé par des scènes d’action en décors naturels. Les productions télévisuelles veulent alors rendre compte de l’actualité de la recherche historique, privilégiant le huis clos, le jeu d’acteur reposant lui-même sur le talent du ou des scénaristes et du ou des dialoguistes.

Mais surtout, pour la première fois, la reconstitution en images animées de la Révolution dérive moins des sources littéraires et visuelles du XIXe siècle que d’images d’archives et de documents originaux de l’époque, placés sous le regard critique d’historiens reconnus.

Malheureusement oubliées de nos jours, ces productions ambitieuses ont donné naissance à des réalisations très réussies, comme la Terreur et la Vertu (Stellio Lorenzi, 1964), dans le cadre de la série télévisuelle la Caméra explore le temps. Divisé en deux parties (Danton puis Robespierre), le film, très marqué par la volonté de faire comprendre la Révolution, participe d’une entreprise de réhabilitation de Robespierre, personnage alors encore très défiguré par une légende noire tenace.

On peut également évoquer une dizaine d’années plus tard, 1788 (Maurice Failevic et Jean-Dominique de La Rochefoucauld, 1978), autre œuvre symptomatique de son temps. Extrêmement attentive aux sources d’archives, elle fait la part belle aux origines de la Révolution, au travers du prisme des tensions au sein d’une petite communauté paysanne de Touraine.

Dans un cadre référentiel semblable, comment ne pas aussi mentionner Un médecin des Lumières (René Allio), film pour la télévision diffusé en trois parties à la fin de l’année 1988, préparant par là les festivités commémoratives du bicentenaire de 1789 ? Sorte de docu-fiction avant l’heure, Un médecin des Lumières, sans toucher explicitement à la Révolution, explique sa naissance par petites touches impressionnistes, donnant à l’événement à venir l’évidence historique d’une sorte de préquel à la Révolution.

À l’image d’un Stanley Kubrick pour Barry Lyndon (1975), Allio, avec des moyens évidemment bien plus limités, est attentif à la « vérité historique », telle que nous l’ont rapportée les historiens, mais aussi les artistes du XVIIIe siècle, autres sources d’inspiration du film. Costumes, paysages, lumières, comédiens doivent « faire époque », non pas artificiellement, mais de manière naturelle et incarnée, en un cinéma de « reconstitution historique ».

« La Révolution », série truffée d’approximations historiques

2020 : autre époque… Le changement d’optique est particulièrement radical, même si les exemples cités plus haut sont des réalisations d’exception, portées par une rigueur historique revendiquée. Il est donc évidemment un peu injuste de vouloir les comparer à l’un des derniers avatars d’une série télévisée portant sur la Révolution française, produite et diffusée par Netflix, une plateforme dont la politique artistique racoleuse repose avant tout sur le sensationnalisme et le voyeurisme.

En huit épisodes, la Révolution est censée évoquer les causes réelles, mais inconnues, du bouleversement révolutionnaire français de la fin du XVIIIe siècle, la dernière scène représentant le peuple en mouvement prêt à prendre la Bastille.

Une deuxième saison aurait dû se concentrer sur l’événement révolutionnaire en lui-même, selon son découpage classique (1789-1794 ou 1799 ?), mais il n’en sera rien, la série n’ayant pas été reconduite. Au regard du traitement historique de la période 1787-1789, les regrets sont minces…

À sa décharge, le scénariste principal Aurélien Molas n’a certainement pas souhaité expliquer les causes de la Révolution française, ce qu’Un médecin des Lumières faisait avec beaucoup de subtilité. Il s’est plutôt agi pour lui et pour son équipe de faire une série de genres, mélangeant horreur, fantastique, uchronie, zombies et vampires avec des scènes d’action innombrables dans une pénombre et un brouillard artificiels, scènes au cours desquelles le sang (bleu et rouge) coule à flots continus.

L’inspiration n’est plus, à présent, à chercher dans les travaux des historiens, mais, comme le reconnaît Aurélien Molas, dans une autre série, sud-coréenne, à l’intrigue semblable (Kingdom, 2019) en une sorte de circuit fermé.

Une intrigue simpliste aux nombreux anachronismes

L’intrigue est simple, voire simpliste. De Versailles, un roi tyrannique (dont on ne verra que les pieds et les mains aux ongles démesurés) a fait mettre au point, dans le but d’obtenir la soumission ultime de son peuple, un virus (le « sang bleu ») qui, lorsqu’il est injecté dans le corps des aristocrates, leur procure l’immortalité, aiguise leurs sens et les contraint à consommer de la chair humaine. Un cruel Covid puissance 100… !

Ce complot sera déjoué par une galerie stéréotypée de « bonnes personnes » : le docteur Joseph Guillotin, orphelin recueilli par un prêtre éclairé qui perdra la vie dans ce combat ; une jeune comtesse, aussi habile à manier le pistolet qu’à se préoccuper du sort du peuple ; ou encore la Fraternité, une femme défigurée, dont le prénom, Marianne, évoque à la fois la République à venir et les révolutions ultérieures.

C’est, d’ailleurs, ce fatras de poncifs autour de la notion même de Révolution, considérée en fait sur trois siècles, qui est le plus déconcertant et dont la volonté maladroite apparaît, dès la première scène, avec l’inscription « Ni roi ni maître » sur les murs d’un château… Quant à Guillotin, le jeune médecin idéaliste, au nom instantanément reconnaissable, il cherche le « patient zéro » et analyse, avec toute la passion de son innocence vertueuse, le sang de ses proches afin de trouver un « vaccin contre la maladie ».

On veut encore faire évader un prisonnier qui se trouve dans un « quartier haute sécurité », soit une invention carcérale datant du milieu des années 1970 et récemment ressuscitée. Les discours de Marianne-Fraternité et du peuple, toujours qualifié de « rebelle », incorporent dans leurs propos et dans leur vocabulaire des notions révolutionnaires contemporaines (« les damnés de la Terre »).

Dans un grand déploiement de misérabilisme, la pauvreté, qui règne dans la ville, n’éclaire pas sur les conditions de vie de la population à la veille de la Révolution, mais renvoie plutôt au Paris assiégé de la Commune. On y meurt de faim et on érige bientôt des barricades pour se défendre contre les « sangs bleus », ces nobles vampires assoiffés du sang des roturiers, barricades qui permettent la reconstitution du célèbre tableau de Delacroix, La Liberté guidant le peuple – inspiré, comme on le sait, de la Révolution de 1830.

Outre ce salmigondis d’anachronismes et de raccourcis historiques, les nobles, dans la continuité des œuvres filmiques anglo-américaines autour de la Révolution française (les Deux Orphelines, de D. W. Griffith, 1921, ou Un conte de deux villes, 1989, film pour la télévision, en deux épisodes produit par ITV, inspiré du roman de Charles Dickens, publié en 1859, ndlr), sont présentés comme abusant cruellement de leurs privilèges ou s’adonnant régulièrement à des pratiques libertines. Ils seraient « 1 % de la population » (le chiffre est exact), mais « détiennent 99 % des richesses », en une exagération particulièrement approximative. Autre clin d’œil, littéraire cette fois : le noble fou de son pouvoir et de son statut, chargé au sang bleu, est prénommé Donatien, en une évocation lourdaude du marquis de Sade.

Bref, il ne faut pas chercher dans ces huit épisodes, ni du côté de l’intrigue ni de ceux des dialogues ou des reconstitutions, une quelconque dimension historique d’intérêt, mais plutôt un prétexte pour se repaître de viscères, de têtes tranchées (le seul moyen de faire périr un noble injecté de sang bleu), de scènes d’action, de détonations, de magie noire vaguement effrayante et surtout d’énormément de sang.

Si le glissement progressif de la télévision vers le sensationnalisme dans le traitement de la Révolution française est avéré, et si cette constatation peut sembler quelque peu amère, on peut aussi se réconforter en pensant à d’autres réalisations, dans des domaines approchants, apparues ces dernières années et qui ont traité de la Révolution française avec subtilité et sérieux.

C'est le cas de la bande dessinée comme celle de Florent Grouazel et Youn Locard, Révolution I, Liberté, Actes Sud, 2019 et Révolution II, Égalité, Livre I, Actes Sud (2023) ou encore du cinéma, par exemple, Un peuple et son roi, de Pierre Schoeller (2018). Deux créations réussies qui sont aussi de bons moyens d’éloigner les vampires.

Pascal Dupuy ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

21.08.2025 à 16:24

Que disent la Bible, le Coran et la Torah de la guerre ?

Robyn J. Whitaker, Associate Professor, New Testament, & Director of The Wesley Centre for Theology, Ethics, and Public Policy

Mehmet Ozalp, Professor of Islamic Studies, Director of The Centre for Islamic Studies and Civilisation and Executive Member of Public and Contextual Theology, Charles Sturt University

Suzanne Rutland, Professor Emerita in Hebrew, Biblical & Jewish Studies, University of Sydney

Texte intégral (3155 mots)

Les guerres sont souvent menées au nom de conceptions religieuses. Mais que disent vraiment les textes fondamentaux du christianisme, de l’islam et du judaïsme sur la guerre et ses justifications ?

Nous avons demandé leur avis à trois experts des différents monothéismes.

La Bible

Par Robyn J. Whitaker, professeure spécialiste du Nouveau Testament au sein de l’établissement théologique australien University of Divinity.

La Bible présente la guerre comme une réalité inévitable de la vie humaine. Cela est illustré par cette citation du livre de l’Ecclésiaste :

Il y a une saison pour tout […] un temps pour la guerre et un temps pour la paix.

En ce sens, la Bible reflète les expériences des auteurs, mais aussi de la société qui a façonné ces textes pendant plus de mille ans : celle du peuple hébreu. Durant l’Antiquité, celui-ci a en effet connu la victoire, mais aussi la défaite, en tant que petite nation parmi les grands empires du Proche-Orient ancien.

En ce qui concerne le rôle de Dieu dans la guerre, nous ne pouvons ignorer le caractère problématique de la violence associée au divin. Parfois, Dieu ordonne au peuple hébreu de partir en guerre et de commettre des actes de violence horribles. Deutéronome 20 en est un bon exemple : le peuple de Dieu est envoyé à la guerre avec la bénédiction du prêtre, bien qu’il soit d’abord demandé aux combattants de proposer des conditions de paix. Si les conditions de paix sont acceptées, la ville est réduite en esclavage. Dans d’autres cas cependant, l’anéantissement total de certains ennemis est demandé, et l’armée hébraïque reçoit l’ordre de détruire tout ce qui ne sera pas utile plus tard pour produire de la nourriture.

Dans d’autres cas, la guerre est interprétée comme un outil à la disposition de Dieu, une punition durant laquelle il utilise des nations étrangères contre le peuple hébreu parce qu’il s’est égaré (Juges 2 :14). Il est également possible d’identifier une éthique sous-jacente aux textes consistant à traiter les prisonniers de guerre de manière juste. Moïse ordonne que les femmes capturées pendant la guerre soient traitées comme des épouses et non comme des esclaves (Deutéronome 21), et dans le deuxième livre des Chroniques, les prisonniers sont autorisés à rentrer chez eux.

En opposition à cette conception de la guerre considérée comme autorisée par Dieu, de nombreux prophètes hébreux expriment l’espoir d’une époque où Il leur apportera la paix et où les peuples « ne s’adonneront plus à la guerre » (Michée 3 :4), transformant plutôt leurs armes en outils agricoles (Isaiah 2 :4).

La guerre est considérée comme le résultat des péchés de l’humanité, un résultat que Dieu transformera finalement en paix. Cette paix (en hébreu : shalom) sera plus que l’absence de guerre, puisqu’elle englobera l’épanouissement humain et l’unité des peuples entre eux et avec Dieu.

La majeure partie du Nouveau Testament a été écrite au cours du premier siècle de notre ère, alors que les Juifs et les premiers chrétiens constituaient des minorités au sein de l’Empire romain. Dans ce texte, la puissance militaire de Rome est ainsi sévèrement critiquée et qualifiée de maléfique dans des textes comme l’Apocalypse, qui s’inscrivent dans une démarche de résistance. De nombreux premiers chrétiens refusaient par exemple de combattre dans l’armée romaine.

Malgré ce contexte, Jésus ne dit rien de spécifique sur la guerre, mais rejette cependant de manière générale la violence. Lorsque Pierre, son disciple, cherche à le défendre avec une épée, Jésus lui dit de la ranger, car cette épée ne ferait qu’engendrer davantage de violence (Matthieu 26:52). Cela est conforme aux autres enseignements de Jésus, qui proclame ainsi « heureux les artisans de paix », qui commande de « tendre l’autre joue » lorsqu’on est frappé ou d’« aimer ses ennemis ».

En réalité, on trouve diverses idéologies concernant la guerre dans les pages de la Bible. Il est tout à fait possible d’y trouver une justification à la guerre, lorsqu’on souhaite le faire. Il est cependant tout aussi possible d’y trouver des arguments en faveur de la paix et du pacifisme. Plus tard, les chrétiens développeront les concepts de « guerre juste » et de pacifisme sur la base de conceptions bibliques, mais il s’agit là d’interprétations plutôt que d’éléments explicites inscrits dans le texte.

Pour les chrétiens, l’enseignement de Jésus fournit par ailleurs un cadre éthique permettant d’interpréter à travers le prisme de l’amour pour ses ennemis les textes antérieurs sur la guerre. Jésus, contrepoint à la violence divine, renvoie les lecteurs aux prophètes de l’Ancien Testament, dont les visions optimistes imaginent un monde où la violence et la souffrance n’existent plus et où la paix est possible.

Le Coran

Par Mehmet Ozalp, directeur du Centre pour les études et la civilisation islamiques de l’université australienne Charles-Sturt (Nouvelles-Galles du Sud).

Les musulmans et l’islam ont fait leur apparition sur la scène mondiale au cours du VIIe siècle de l’ère commune, une période relativement hostile. En réponse à plusieurs défis majeurs propres à cette époque, notamment la question des guerres, l’islam a introduit des réformes juridiques et éthiques novatrices. Le Coran et l’exemple fixé par le prophète Muhammad – souvent francisé en Mahomet – ont établi des lignes directrices claires pour la conduite de la guerre, bien avant que des cadres similaires n’apparaissent dans d’autres sociétés.

Pour cela, l’islam a défini un nouveau terme, jihad, plutôt que le mot arabe habituel pour désigner la guerre, harb. Alors que harb désigne de manière générale la guerre, le jihad est défini dans les enseignements islamiques comme une lutte licite et moralement justifiée, qui inclut mais ne se limite pas aux conflits armés. Dans le contexte de la guerre, le jihad désigne spécifiquement le combat pour une cause juste, selon des directives juridiques et éthiques claires, distinct de la guerre belliqueuse ou agressive.

Entre 610 et 622, le prophète Muhammad a pratiqué une non-violence active en réponse aux persécutions et à l’exclusion économique que lui et sa communauté subissaient à La Mecque, malgré les demandes insistantes de ses disciples qui voulaient prendre les armes. Cela montre que la lutte armée ne peut être menée, en islam, entre membres d’une même société : cela conduirait en effet à l’anarchie.

Après avoir quitté sa ville natale pour échapper aux persécutions, Muhammad fonda à Médine une société pluraliste et multiconfessionnelle. Il prit par ailleurs des mesures actives pour signer des traités avec les tribus voisines. Malgré sa stratégie de paix et de diplomatie, les Mecquois, qui lui restaient hostiles, ainsi que plusieurs tribus alliées, attaquèrent les musulmans de Médine. Il devenait ainsi inévitable d’engager une lutte armée contre ces agresseurs.

La permission de combattre a été donnée aux musulmans par les versets 22:39-40 du Coran :

Autorisation est donnée à ceux qui sont attaqués (de se défendre) parce que vraiment ils sont lésés ; et Allah est certes Capable de les secourir, ceux qui ont été expulsés de leurs demeures, contre toute justice, simplement parce qu’ils disaient : « Allah est notre Seigneur ». […]

Ce passage autorise non seulement la lutte armée, mais offre également une justification morale à la guerre juste. Celle-ci est d’abord conditionnée à une lutte purement défensive, tandis que l’agression est qualifiée d’injuste et condamnée. Ailleurs, le Coran insiste sur ce point :

S’ils se tiennent à l’écart de vous, s’ils ne vous combattent point et se rendent à vous à merci, Allah ne vous donne contre eux nulle justification (pour les combattre).

Le verset 22:39 vu précédemment présente deux justifications éthiques à la guerre. La première concerne les cas où des personnes sont chassées de leurs foyers et de leurs terres, c’est-à-dire face à l’occupation d’une puissance étrangère. La seconde a trait aux cas où des personnes sont attaquées en raison de leurs croyances, au point de subir des persécutions violentes et des agressions.

Il est important de noter que le verset 22:40 inclut les églises, les monastères et les synagogues dans le champ des lieux qui doivent être protégés. Si les croyants en Dieu ne se défendent pas, tous les lieux de culte sont susceptibles d’être détruits, ce qui doit être empêché par la force si nécessaire.

Le Coran n’autorise pas la guerre offensive, car « certes, Allah n’aime pas les agresseurs ! » (2 :190) Il fournit également des règles détaillées sur qui doit combattre et qui en est exempté (9 :91), quand les hostilités doivent cesser (2 :193), ou encore la manière dont les prisonniers doivent être traités avec humanité et équité (47 :4).

Des versets comme le verset 194 de la deuxième sourate soulignent que la guerre, comme toute réponse à la violence et à l’agression, doit être proportionnée et rester dans certaines limites :

Quiconque a marqué de l’hostilité contre vous, marquez contre lui de l’hostilité de la même façon qu’il a marqué de l’hostilité contre vous.

En cas de guerre inévitable, toutes les possibilités pour y mettre un terme doivent être explorées :

Et s’ils (les ennemis) inclinent à la paix, incline vers celle-ci, et place ta confiance en Allah. (8 :61)

L’objectif d’une action militaire est ainsi de mettre fin aux hostilités le plus rapidement possible et d’éliminer les causes de la guerre, et non d’humilier ou d’anéantir l’ennemi.

Le jihad militaire ne peut par ailleurs pas être mené pour satisfaire une ambition personnelle ou pour alimenter des conflits nationalistes ou ethniques. Les musulmans n’ont pas le droit de déclarer la guerre à des nations qui ne leur sont pas hostiles (60 :8). En cas d’hostilité ouverte et d’attaque, ils ont en revanche tout à fait le droit de se défendre.

Le Prophète et les premiers califes ont expressément averti les chefs militaires et tous les combattants participant aux expéditions musulmanes qu’ils ne devaient pas agir de manière déloyale ni se livrer à des massacres ou à des pillages aveugles. Muhammad a ainsi dit, selon la tradition islamique (sunna) :

Ne tuez pas les femmes, les enfants, les personnes âgées ou les malades. Ne détruisez pas les palmiers et ne brûlez pas les maisons.

Grâce à ces enseignements, les musulmans ont disposé, tout au long de leur histoire, de directives juridiques et éthiques visant à limiter les souffrances humaines causées par la guerre.

La Torah

Par Suzanne D. Rutland, historienne du judaïsme à l’université de Sydney.

Le judaïsme n’est pas une religion pacifiste, mais dans ses traditions, il valorise la paix par-dessus tout : les prières pour la paix occupent ainsi une place centrale dans la liturgie juive. Il reconnaît dans le même temps la nécessité de mener des guerres défensives, mais uniquement dans le cadre de certaines limites.

Dans la Torah, et notamment les cinq livres de Moïse, la nécessité de la guerre est clairement reconnue. Tout au long de leur périple dans le désert, les Israélites (c’est-à-dire les enfants d’Israël) livrent diverses batailles. Parallèlement, dans le Deutéronome, ils reçoivent l’instruction suivante (chapitre 23, verset 9) :

Quand tu marcheras en armes contre tes ennemis, garde-toi de toute chose mauvaise.

Le chef de tribu Amalek, qui attaqua les Hébreux à leur sortie d’Égypte, est le symbole du mal ultime dans la tradition juive. Les érudits affirment que cela est dû au fait que son armée frappa les Israélites par-derrière, tuant des femmes et des enfants sans défense.

La Torah insiste également sur le caractère obligatoire du service militaire. Cependant, le Deutéronome distingue quatre catégories de personnes qui en sont exemptées :

- celui qui a construit une maison, mais qui ne l’a pas encore consacrée rituellement ;

- celui qui a planté une vigne, mais qui n’en a pas encore mangé les fruits ;

- celui qui est fiancé ou dans sa première année de mariage ;

- celui qui a peur, par crainte qu’il n’influence les autres soldats.

Il est important de souligner que le mépris de la guerre est si fort dans le judaïsme antique que le roi David n’a pas été autorisé à construire le temple de Jérusalem en raison de sa carrière militaire. Cette tâche a été confiée à son fils Salomon : il lui était cependant interdit d’utiliser du fer dans la construction, car celui-ci symbolisait la guerre et la violence, alors que le temple devait représenter la paix comme vertu religieuse suprême.

La vision de la paix comme destin partagé pour toute l’humanité est développée plus en détail dans les écrits prophétiques, notamment via le concept de Messie. Cela est particulièrement visible dans les écrits du prophète Isaïe, qui envisageait une époque où, comme il le décrit dans sa vision idyllique :

[…] De leurs épées ils forgeront des socs, et de leurs lances, des serpes : une nation ne lèvera pas l’épée contre une autre nation, et on n’apprendra plus la guerre.

La Mishnah, première partie du Talmud (c’est-à-dire le recueil principal des commentaires de la Torah) évoque le concept de « guerre obligatoire » (milhemet mizvah). Cela englobe les guerres racontées dans les textes contre les sept nations qui habitaient la Terre promise avant les Hébreux, la guerre contre Amalek et les guerres défensives du peuple juif. Cette catégorie est donc clairement définie et reconnaissable.

Il n’en va pas de même pour la deuxième catégorie, la « guerre autorisée » (milhemet reshut), qui est plus ouverte et pourrait, comme l’écrit le chercheur Avi Ravitsky, « se rapporter à une guerre préventive ».

Après la période de composition du Talmud, qui s’est terminée au VIIe siècle, ce débat est devenu théorique, car les Juifs vivant en Palestine et dans la diaspora n’avaient plus d’armée. C’était déjà largement le cas depuis la défaite de la révolte de Bar Kokhba contre les Romains (de 132 à 135 après J.-C.), à l’exception de quelques petits royaumes juifs en Arabie.

Cependant, avec l’arrivée des premiers immigrants sionistes sur la terre historique du royaume d’Israël à la fin du XIXe et au XXe siècle, les débats rabbiniques sur ce qui constitue une guerre défensive obligatoire ou une guerre autorisée, ainsi que sur les caractéristiques d’une guerre interdite ont repris de plus belle. Ce sujet suscite aujourd’hui une profonde inquiétude et une vive controverse tant chez les universitaires spécialistes du judaïsme que chez les rabbins.

Robyn J. Whitaker est affiliée au centre Wesley pour la théologie, l'éthique et les politiques publiques.

Mehmet Ozalp est le directeur exécutif du l'Académie pour les sciences islamiques et la recherche.

Suzanne Rutland ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

21.08.2025 à 16:23

Comment le croisement des roses d’Orient et d’Occident au XIXᵉ siècle a totalement changé nos jardins

Thibault Leroy, Biologiste, chercheur en génétique des populations, Inrae

Jérémy Clotault, Enseignant-chercheur en génétique, Université d’Angers

Texte intégral (2693 mots)

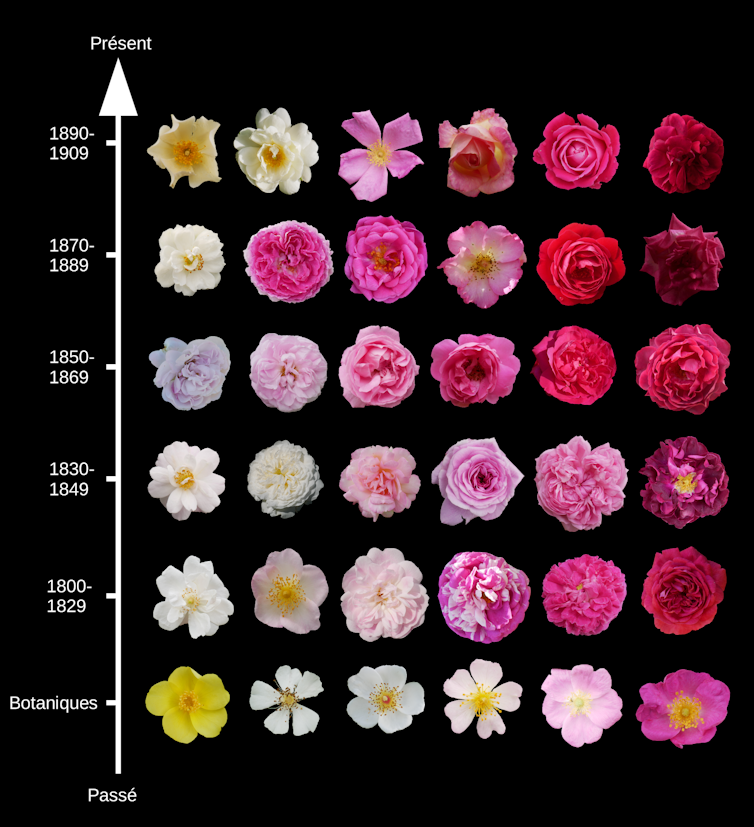

En Europe, la rose a connu son âge d’or au XIXe siècle : en l’espace de quelques décennies, le nombre de variétés s’est envolé, passant d’environ 100 à près de 8 000. Grâce à l’étude des caractéristiques de ces variétés et aux outils modernes de la génomique, nous venons de retracer l’histoire de cette évolution, marquée par d’importants croisements entre rosiers asiatiques et rosiers européens anciens. De ce mariage est née une diversité qui continue de façonner nos jardins contemporains.

Le XIXᵉ, un siècle rosomane

Depuis l’Antiquité, les roses sont cultivées, aussi bien en Chine que dans la région méditerranéenne, pour leurs vertus médicinales, notamment les propriétés anti-inflammatoires et antimicrobiennes des huiles essentielles ou comme sources de vitamine C dans les cynorrhodons (faux-fruits des rosiers), et pour leur forte charge symbolique, notamment religieuse. Pourtant, pendant des siècles, le nombre de variétés est resté très limité, autour d’une centaine. Le XIXe siècle marque un tournant majeur pour l’horticulture européenne avec une effervescence portée par un nouvel engouement pour l’esthétique des roses. Les collectionneurs – dont la figure la plus emblématique fut probablement l’impératrice Joséphine de Beauharnais– et les créateurs de nouvelles variétés français ont eu un rôle déterminant dans cet essor, donnant naissance à une véritable « rosomanie » et contribuant à une explosion du nombre de variétés, passant d’une centaine à près de 8000 variétés ! À titre de comparaison, depuis cette période, le nombre de variétés a certes continué de progresser, s’établissant à environ 30 000 variétés aujourd’hui, mais à un rythme de croissance moins soutenu.

Au-delà de l’augmentation du nombre de variétés, le XIXe siècle a été marqué par une grande diversification des caractéristiques des rosiers. Le nombre de pétales, notamment, est devenu un critère d’intérêt majeur. Les rosiers botaniques, des formes cultivées anciennes issues directement de la nature, ne possédaient en général que cinq pétales. Au fil du XIXe siècle, la sélection horticole a permis d’obtenir des variétés aux fleurs bien plus sophistiquées, certaines présentant plusieurs dizaines, voire des centaines de pétales. Cependant, cette évolution n’a pas suivi une progression linéaire : la première moitié du siècle a vu une nette augmentation du nombre de pétales, marquée par une mode des rosiers cent-feuilles, tandis que la seconde moitié a été plutôt caractérisée par une stagnation, voire un retour à des formes plus simples. Certaines variétés très travaillées sur le plan esthétique ont ainsi été sélectionnées pour paradoxalement n’avoir que cinq pétales.

La plus grande différence entre les rosiers du début et de la fin du XIXe réside dans un caractère fondamental : la remontée de floraison. Jusqu’au milieu du XIXe siècle, les rosiers étaient majoritairement non remontants, c’est-à-dire qu’ils ne fleurissaient qu’une seule fois par an, au printemps. La capacité des rosiers à refleurir, en générant de nouvelles fleurs au cours de l’été, voire même jusqu’à l’automne, n’est pas le fruit du hasard ! Cette caractéristique a constitué un objectif important des sélectionneurs de l’époque. Cette histoire, très associée aux croisements génétiques effectués, notamment avec des rosiers chinois, a laissé une empreinte durable, aussi bien dans nos jardins contemporains que dans les génomes mêmes des rosiers.

Bien qu’ils n’en étaient pas conscients, les sélectionneurs ont aussi pu contribuer à l’introduction de caractères défavorables. Ainsi, en étudiant les niveaux de symptômes de la maladie des taches noires sur des centaines de variétés du XIXe, nous avons mis en évidence une augmentation de la sensibilité des variétés. Cette maladie est aujourd’hui considérée comme une des premières causes de traitements phytosanitaires sur les rosiers, ce qui n’est pas sans poser des questions sanitaires sur l’exposition aux pesticides des fleuristes et autres professionnels du secteur horticole. Notre étude a néanmoins trouvé des régions génomiques associées à une résistance à cette maladie, offrant l’espoir d’une sélection vers des variétés nouvelles plus résistantes.

Notre étude n’a pas uniquement porté sur la prédisposition aux maladies mais également à l’une des caractéristiques les plus importantes des roses : leur odeur. Le parfum des roses est expliqué par un cocktail complexe de molécules odorantes. Deux molécules sont néanmoins très importantes dans ce qu’on appelle l’odeur de rose ancienne, le géraniol et le 2-phényléthanol. Nous avons étudié le parfum de centaines de variétés et observé une très forte variabilité de celui-ci, autant en teneur qu’en composition. Nos résultats ne soutiennent toutefois pas, ou alors extrêmement marginalement, une réduction du parfum des roses au cours du XIXe siècle. La perte de parfum est vraisemblablement arrivée ultérieurement, au cours du XXe siècle, une période qui voit l’apparition d’une activité de création variétale spécifique pour les roses à fleurs coupées et qui aurait négligé le parfum des roses au profit de la durée de tenue en vase, permettant de délocaliser la production dans des pays aux coûts de production réduits.

Des rosiers aux génomes métissés

Pour mieux comprendre l’origine et la diversité de ces rosiers du XIXe, il faut désormais plonger dans l’univers de l’infiniment petit : celui de leurs génomes. Dans notre nouvelle étude, nous avons entrepris de caractériser en détail la génétique de plus de 200 variétés, en nous appuyant sur des dizaines de milliers de marqueurs, c’est-à-dire d’une information ciblée sur des zones particulières des génomes, connues comme étant variables selon les variétés, et ce, répartis sur l’ensemble de leurs chromosomes. Pour une trentaine de variétés, nous sommes allés encore plus loin, en décryptant l’intégralité de leur génome, fournissant non plus des dizaines de milliers, mais des dizaines de millions de marqueurs, ouvrant ainsi une fenêtre encore plus précise sur l’histoire génétique des rosiers. A noter que le mode de conservation nous a facilité la tâche pour étudier l’ADN de ces rosiers historiques directement à partir des plantes actuelles conservées en roseraie. En effet, grâce au greffage, les variétés de rosiers sont potentiellement immortelles !

Grâce à cette analyse, nous avons d’abord pu confirmer les résultats d’études antérieures qui, bien que fondées sur un nombre limité de marqueurs génétiques, avaient déjà mis en évidence que la diversification des rosiers du XIXe siècle résultait de croisements successifs entre rosiers anciens européens et rosiers asiatiques. La haute résolution offerte par la génomique nous a toutefois permis d’aller plus loin : nous avons montré que cette diversité s’est construite en réalité sur un nombre très réduit de générations de croisements, impliquant de manière récurrente des variétés phares de l’époque, utilisées comme parents dans de nombreux croisements. Il est remarquable de noter que cela s’est produit avec une bonne dose de hasard (via la pollinisation) puisque la fécondation artificielle (choix des deux parents du croisement) n’est utilisée sur le rosier qu’à partir du milieu du XIXᵉ siècle.

Bien que reposant sur un nombre limité de générations de croisements, contribuant à un métissage entre rosiers asiatiques et européens, notre étude a également permis de montrer que les rosiers possèdent une importante diversité génétique. Toutefois, la sélection menée au cours du XIXe siècle a contribué à une légère érosion de cette diversité, en particulier chez les variétés issues de la fin du siècle. Or, le maintien d’une large diversité génétique est essentiel pour la résilience et l’adaptation des espèces face aux changements environnementaux. Sa préservation au long cours représente donc un enjeu majeur. Tant que les anciennes variétés sont conservées, cette perte reste réversible. Il est donc crucial d’agir pour éviter leur disparition définitive en préservant les collections de roses anciennes et botaniques.

À l’échelle du génome complet, la sélection tend à réduire la diversité génétique. Mais à une échelle plus fine, ses effets peuvent être encore plus marqués, entraînant une diminution locale beaucoup plus prononcée de la diversité. Notre étude a ainsi révélé qu’une région du chromosome 3, contenant différentes formes d’un gène clé impliqué dans la remontée de la floraison, a fait l’objet d’une sélection particulièrement intense au XIXe siècle. Ce résultat, bien que prévisible compte tenu de l’importance de ce caractère, a été confirmé de manière claire à la lumière des données génomiques. De manière plus inattendue, nous avons également identifié d’autres régions du génome présentant des signatures similaires de sélection, notamment sur les chromosomes 1, 5 et 7. À ce stade, les gènes concernés, et les éventuels caractères morphologiques associés restent encore à identifier. Malgré les avancées de la génomique, le mariage des roses d’Occident et d’Orient au XIXe siècle garde encore nombre de ses secrets de famille !

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Ulyces

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr

- Regain