ACCÈS LIBRE Une Politique International Environnement Technologies Culture

30.10.2025 à 11:10

Pourquoi l’écologie est d’abord une science

Texte intégral (2979 mots)

Souvent assimilée à un courant politique, l’écologie est avant tout une science à part entière, qui étudie les interactions du vivant avec son environnement. Pourtant, en France, ce terme est devenu symbole de militantisme au risque d’invisibiliser le travail précieux des écologues, alors même que leurs connaissances sont indispensables pour affronter la crise environnementale en cours.

Dans « l’Écologie est une science », publié par les éditions Belin, Sébastien Barrot, directeur de recherche à l’IRD, présente son domaine de recherche, encore trop méconnu du grand public. Nous reproduisons ci-dessous un extrait de son avant-propos.

À 10 ans, quand on me demandait quel métier je souhaitais faire plus tard, je répondais « Un -logue quelconque. » Je disais par là que je voulais devenir archéologue ou paléontologue. J’ai mal tourné, je suis devenu écologue, chercheur en écologie, et j’ai commencé à écrire ce livre parce que personne ne sait ce que ça veut dire. Si tout le monde a une idée, juste ou non, de ce qu’est un chercheur, quasiment personne ne sait en France, en dehors du cadre académique, que l’écologie est une science.

Même aujourd’hui, en pleine crise environnementale, je dois expliquer les études que j’ai faites (un master et une thèse en écologie), et on me le fait répéter au moins trois fois car ça ne paraît pas possible. Les gens pensent souvent que j’ai étudié la biologie. Cela paraît beaucoup plus sérieux, mais ce n’est pas le cas. D’autres personnes imaginent que la seule préoccupation d’un écologue est de protéger les petits oiseaux, ou que je développe de nouveaux moyens pour recycler les déchets.

Ce sont deux thématiques importantes, cependant l’écologie scientifique n’a pas uniquement pour but la protection de la nature, et seul le recyclage des déchets organiques entre, en fait, dans le champ des compétences de l’écologie puisqu’il fait intervenir des organismes décomposeurs, comme des bactéries ou des vers de terre.

À lire aussi : L’écologie expliquée aux enfants et aux ados

Un seul terme pour de nombreuses réalités

La méconnaissance de l’écologie scientifique vient de trois facteurs complémentaires.

Tout d’abord, l’écologie est une science relativement jeune. Le mot a été inventé par Ernst Haeckel en 1866, mais les sciences écologiques ne se sont vraiment développées dans le monde académique qu’après la Seconde Guerre mondiale pour les Anglo-Saxons et durant les années 1970 en France. C’est donc un développement très récent, ce qui signifie que les bases de cette science doivent encore être consolidées, et sa structure affinée. Le système académique étant très conservateur, l’écologie scientifique a parfois du mal à trouver sa place parmi les disciplines plus anciennes. Malgré la gravité des problèmes environnementaux actuels, et contrairement à ce qu’on pourrait penser, il est souvent difficile d’augmenter le volume des enseignements d’écologie du primaire à l’université, et la recherche en écologie n’est pas particulièrement bien financée.

De plus, en France, le terme « écologie » est utilisé aussi bien pour désigner une science que des mouvements politiques environnementalistes ou verts, entraînant de fait une confusion entre le travail de recherche et l’action politique, ou même le militantisme. Il est important de souligner que, la plupart du temps, lorsque quelqu’un intervient dans les médias pour parler de protection de la nature, il s’agit d’un militant ou d’une militante (ou parfois même d’un chercheur d’une autre discipline !). Si ces derniers utilisent souvent les connaissances développées par l’écologie scientifique, ils ne sont pas chercheurs en écologie pour autant.

On pense facilement à de grandes figures, comme Hubert Reeves, qui ont joué et jouent un rôle important et utile dans la dissémination des savoirs et idées écologiques. Ces grandes figures médiatiques mêlent toujours dans leurs discours des messages environnementalistes et d’autres plus fondamentaux et proches des sciences écologiques. Tout cela entraîne des conséquences globalement positives, mais contribue à invisibiliser la science écologique et le travail des chercheuses et chercheurs qui la pratique. D’autant que dans les autres sciences (biologie, physique, chimie…), quand les médias ont besoin d’éclairages, c’est bien à un spécialiste du domaine que l’on fait appel en général.

Enfin, l’écologie est une science intégrative. C’est-à-dire qu’elle utilise les autres sciences (biologie, géologie, climatologie, chimie…) et qu’il est donc difficile de l’identifier en elle-même. Ce fonctionnement fait sa force, mais il rend son positionnement plus difficile. En effet, les systèmes académique et médiatique fonctionnent beaucoup « par boîtes » et la mauvaise identification d’une science et de ses spécialistes complique la prise en compte des connaissances qu’elle développe.

Cela explique en partie que les sociétés humaines soient si lentes à prendre des mesures pour atténuer la crise de la biodiversité et qu’elle reste moins bien prise en compte que la crise climatique par les pouvoirs publics (même si de ce côté-là, cela avance, bien que beaucoup trop lentement).

À lire aussi : La biodiversité : pas qu’une affaire d’écologistes, un impératif économique et financier

Mais alors l’écologie, c’est quoi ?

Ma définition préférée de l’écologie est la suivante : c’est la science qui étudie les interactions entre les êtres vivants (par exemple, entre les espèces de plantes d’une prairie) et leur environnement physico-chimique (par exemple, entre les plantes de cette prairie et les caractéristiques du sol comme son pH ou sa teneur en azote) et les conséquences de ces interactions à toutes les échelles temporelles (de la seconde à des millions d’années) et spatiales (de l’agrégat de sol d’un millimètre à la biosphère) possibles. Cette définition peut paraître un peu abstraite mais elle prendra tout son sens au cours du livre.

Il est important de retenir que l’écologie traite bien d’organismes vivants, tout en étant distincte de la biologie. Cette dernière a tendance à étudier le fonctionnement interne des êtres vivants. Historiquement, à l’aide de moyens techniques de plus en plus sophistiqués, la biologie les a découpés en parties de plus en plus petites (l’organe, la cellule, la molécule, le gène) pour analyser la manière dont le fonctionnement interne d’un organisme et de nombreux mécanismes de régulation permet aux organismes de grandir, de survivre et de se reproduire. C’est aussi grâce à la biologie que l’on comprend les mécanismes de développement d’un organisme à partir de ses gènes.

À l’inverse, les sciences de l’univers (géochimie, climatologie, hydrologie…) s’intéressent essentiellement au fonctionnement physico-chimique, aux éléments abiotiques, de l’environnement et de la planète Terre. Par exemple, ces sciences permettent de quantifier les flux d’eau (évaporation, précipitation, ruissellement…) à des échelles variées depuis le mètre carré jusqu’à la planète entière ou encore les flux d’azote, composante chimique essentielle de toute la matière vivante.

L’écologie se trouve exactement à mi-chemin entre la biologie et les sciences de l’univers : elle traite à la fois des organismes vivants et de leur environnement physico-chimique. Elle fait le lien entre les deux et étudie leurs interactions qui sont bidirectionnelles. Les organismes dépendent de leur environnement (température, humidité…) et des ressources qu’ils y puisent. Si les conditions physico-chimiques sont bonnes (ni trop chaud ni trop froid, suffisamment humide…), ils pourront grandir et se reproduire ; si les conditions sont un peu moins bonnes, cela devient plus difficile ; si elles empirent, les organismes ont de grandes chances de mourir. D’une manière peut-être moins évidente, mais tout aussi importante, les organismes modifient leur environnement physico-chimique en y puisant des ressources (CO2, eau et nutriments minéraux pour une plante), par des activités variées (galeries des vers de terre) ou simplement par leur présence (un arbre fait de l’ombre).

L’écologie est une science à part entière qui a développé son propre cadre conceptuel, ses écoles de pensée et ses outils. Elle fonctionne au quotidien comme les autres sciences : il y a des formations (masters, écoles doctorales), des chercheuses et des chercheurs, des laboratoires et des journaux internationaux en anglais spécialisés.

Elle s’appuie cependant, nous l’avons vu, sur de nombreuses sciences, de la biologie à la climatologie, en passant par la physique ou la chimie. Les résultats de ces différents domaines servent d’éléments de contexte et leurs méthodes et outils sont utilisés comme des couteaux suisses modulables pour répondre à des questions propres à l’écologie. Par exemple, l’étude des interactions entre un ver de terre et le sol peut nécessiter de connaître le fonctionnement interne du ver de terre, tel son mode de digestion (biologie), mais aussi l’impact de l’espèce sur la chimie du sol (chimie).

L’écologie peut aussi étudier comment le climat influence la croissance des plantes en prenant en compte la quantité d’énergie apportée par la lumière solaire et utilisable pour la photosynthèse, ou la température et l’humidité de l’air qui influencent la quantité d’eau transpirée par les plantes. Ou encore la manière dont les plantes influencent le climat en fixant plus ou moins de carbone par la photosynthèse ou en renvoyant plus ou moins de vapeur d’eau dans l’atmosphère. Ces résultats peuvent alors servir aux climatologues pour améliorer les prédictions climatiques.

Par ailleurs, l’écologie est indissociable de l’évolution des organismes vivants au sens darwinien, car ils présentent tous une histoire évolutive : ils ont été façonnés par une succession de pressions de sélection et de processus évolutifs qui ont conduit aux caractéristiques actuelles des organismes et ont contribué à leur diversité. De ce fait, les interactions écologiques entre eux ou avec leur milieu physico-chimique ont été façonnées par l’évolution. Il est important de le prendre en compte pour mieux comprendre et interpréter les fonctionnements écologiques actuels.

Ainsi, les plantes ont construit au cours de l’évolution des mutualismes avec leurs pollinisateurs. Étudier cette évolution peut aider à comprendre la pollinisation et ses conséquences. À l’inverse, les interactions écologiques, elles-mêmes, constituent un des principaux moteurs de l’évolution : la sélection naturelle est fondée sur le fait que les organismes les mieux adaptés à une situation écologique donnée (caractéristiques de l’environnement, existence d’un prédateur…) ont plus de descendants si bien que leurs caractéristiques deviennent dominantes au sein de l’espèce du fait de leur transmission génétique.

Dans ce contexte, les mécanismes conférant à certains individus un avantage sont liés à des interactions écologiques : certaines caractéristiques leur permettent de mieux interagir avec les autres organismes ou leur environnement physico-chimique, acquérant ainsi plus de ressources, augmentant leur survie ou leur fécondité. Tous ces mécanismes sont étudiés en écologie. On sait maintenant que l’évolution peut être suffisamment rapide pour interférer avec les processus écologiques à des échelles de temps communes. Cela signifie qu’il ne s’agit pas simplement d’un phénomène ancien qu’il faut étudier pour comprendre les organismes ayant disparu depuis longtemps, mais que les organismes continuent actuellement à évoluer.

De domaines en sous-domaines

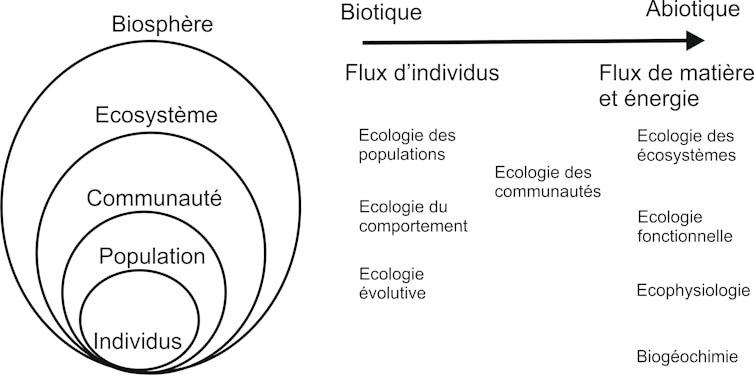

Plus généralement, l’écologie aborde des sujets si variés qu’il est nécessaire de la diviser en sous-domaines.

Bien sûr, on peut en classer les différents champs selon le milieu étudié (écologie forestière, écologie aquatique, écologie des sols…), mais il est important de différencier également certaines approches. En effet, une partie importante de l’écologie, l’écologie des populations, se focalise sur les groupes d’individus d’une même espèce qui interagissent entre eux au sein d’un milieu donné (ce qu’on appelle une « population »). Elle se concentre donc sur les individus, sur ce qu’ils font et sur leur démographie (comme on le ferait pour des populations humaines), s’appuyant notamment pour cela sur leur recensement (on peut, par exemple, compter le nombre d’arbres dans une forêt). L’écologie des populations est fortement liée à l’écologie évolutive, qui étudie l’évolution darwinienne des organismes, puisque l’individu est l’unité de base dans tous les processus évolutifs.

Proche de l’écologie des populations, on trouve aussi celle du comportement qui cherche à analyser le comportement des individus au sein d’une population en fonction de leur environnement, avec souvent des interprétations liées à l’évolution darwinienne des organismes. On distingue ensuite l’écologie des communautés qui étudie les interactions entre populations (d’espèces différentes) dans un même milieu. Cela permet d’aborder, par exemple, les relations proie-prédateur, les symbioses, ou de décrire des communautés d’organismes (le nombre d’espèces, leur abondance relative, leurs caractéristiques, et les facteurs qui déterminent tout ça). On arrive alors à l’écologie fonctionnelle qui étudie la manière dont les organismes arrivent à puiser des ressources dans leur milieu et à les transformer en biomasse, ainsi que la quantité de matière et d’énergie qu’ils échangent avec leur milieu…

Enfin, l’écologie des écosystèmes est proche de l’écologie fonctionnelle puisqu’elle étudie la manière dont ils fonctionnent. Un écosystème comprend à la fois l’ensemble des populations en interaction dans un lieu donné et leur milieu physico-chimique (sol, climat…). Il s’agit donc d’intégrer tous les types d’interactions écologiques entre populations ainsi qu’entre elles et leur milieu physico-chimique, et de comprendre comment cela détermine les propriétés émergentes des écosystèmes, telle que leur production primaire. Là où l’écologie des populations est focalisée sur les individus, l’écologie fonctionnelle et celle des écosystèmes étudient plutôt les flux de matière (carbone, azote, eau…) et d’énergie entre les organismes et avec leur milieu. Ce type d’approche permet souvent d’aller vers des échelles spatiales de plus en plus grandes. On peut, par exemple, mesurer la biomasse de la végétation ou la quantité de carbone dans la matière organique du sol à l’échelle du mètre carré, mais aussi d’une prairie, d’une région, d’un continent…

Sébastien Barot ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

29.10.2025 à 12:04

Combien de temps un moustique peut-il survivre sans piquer un humain ?

Texte intégral (811 mots)

La capacité d’un moustique à survivre sans piquer un humain dépend de plusieurs facteurs : son état de développement, son sexe, son espèce, son environnement et ses besoins physiologiques. Contrairement à ce que l’on pourrait penser, tous les moustiques ne se nourrissent pas de sang et même ceux qui le font n’en ont pas besoin en permanence pour survivre.

À leur naissance, tous les moustiques mènent une vie aquatique et se nourrissent de matière organique et de petits organismes. Cette période dure entre une et deux semaines, selon l’espèce, la température et la disponibilité en nourriture. Ils traversent quatre stades larvaires consacrés à l’alimentation et à la croissance, puis un stade de nymphe mobile au cours duquel une transformation corporelle profonde en moustique adulte a lieu, et durant lequel ils ne se nourrissent pas.

Au cours de leur vie, les moustiques occupent ainsi deux habitats complètement différents : l’eau et le milieu aérien, et utilisent des ressources différentes. À la différence d’autres insectes piqueurs, comme les punaises de lit ou les poux, qui se nourrissent de sang durant toute leur vie, les moustiques ne le font qu’à l’état adulte.

Moustiques mâles vs moustiques femelles

Il existe plus de 3 500 espèces de moustiques différentes, dont seule une petite fraction pique les humains, soit environ 200 espèces, dont 65 sont présentes en France hexagonale.

Les mâles ne piquent jamais. Ils se nourrissent exclusivement de nectar de fleurs et de jus de plantes, riches en sucres, qui leur fournissent toute l’énergie nécessaire à leur survie. Leur espérance de vie est généralement courte, de quelques jours à quelques semaines dans des conditions idéales.

Les femelles, en revanche, ont une double alimentation. Elles se nourrissent également de nectar pour vivre au quotidien. Cependant, lorsqu’elles doivent produire leurs œufs, elles ont besoin d’un apport en protéines que seul le sang peut leur fournir. Elles peuvent piquer des humains, mais aussi d’autres animaux, selon leurs préférences. Certaines espèces sont assez éclectiques en ce qui concerne leurs hôtes, piquant tout ce qui se présente à elles, tandis que d’autres montrent une préférence marquée pour le sang humain.

La plupart des moustiques se nourrissent du sang d’animaux à sang chaud, comme les oiseaux et les mammifères, y compris les êtres humains, mais certaines espèces peuvent aussi piquer des animaux à sang-froid, comme des grenouilles ou des chenilles de papillons.

Combien de temps une femelle peut survivre sans piquer ?

Une femelle moustique peut survivre plusieurs jours, voire quelques semaines sans piquer, pourvu qu’elle ait accès à une source de sucre, comme du nectar. Ce sont donc ses besoins reproductifs, et non sa survie immédiate, qui la poussent à piquer. Sans repas de sang, elle ne pourra pas pondre, mais elle ne mourra pas pour autant rapidement.

La femelle du moustique tigre Aedes albopictus, vecteur des virus de la dengue, du Zika ou du chikungunya, peut par exemple vivre environ un mois en tant qu’adulte dans des conditions optimales. Pendant cette période, elle peut survivre sans piquer, à condition de trouver une autre source de nourriture énergétique. Il en va de même pour Culex pipiens, le moustique le plus commun en France hexagonale, qui est également capable de transmettre certains virus responsables de maladies telles que la fièvre du Nil occidental ou l’encéphalite japonaise.

Influence de l’environnement

La température, l’humidité et la disponibilité en nourriture influencent fortement leur longévité. Un milieu chaud et humide, avec de l’eau stagnante, des hôtes et du nectar à proximité, favorise une reproduction rapide et des repas fréquents. En revanche, une température relativement basse ralentit le métabolisme des insectes et leur permet d’espacer les repas.

Il est également à noter que certains moustiques entrent en diapause, une sorte d’hibernation, pendant les saisons froides et peuvent survivre plusieurs mois sans se nourrir activement. Selon l’espèce, les œufs, les larves, les nymphes ou les adultes peuvent subir cette sorte de « stand-by physiologique » durant l’hiver. Si on ne les voit pas, ce n’est pas parce qu’ils sont partis, mais parce qu’ils sont cachés et plongés dans un profond sommeil.

Claudio Lazzari a reçu des financements de INEE-CNRS, projet IRP "REPEL".

29.10.2025 à 12:04

Maths au quotidien : Full HD, 4K, 8K… ou pourquoi il n’est pas toujours utile d’augmenter la résolution de sa télévision

Texte intégral (1999 mots)

Pourquoi acheter une télévision 8K plutôt qu’une 4K ou Full HD ? La question revient souvent, tant l’offre technologique semble avancer plus vite que nos besoins. Plus de pixels, plus de netteté… mais jusqu’à quel point notre œil est-il capable de percevoir la différence ? Derrière cette interrogation se cache un outil mathématique puissant utilisé en traitement du signal et en optique : l’analyse de Fourier.

Une télévision 4K affiche environ 8 millions de pixels, contre 33 millions pour la 8K. Sur le papier, c’est une avalanche de détails supplémentaires.

Mais l’œil humain n’est pas un capteur parfait : sa capacité à distinguer des détails dépend de la distance de visionnage et de l’acuité visuelle. Autrement dit, si vous êtes trop loin de l’écran, les pixels supplémentaires deviennent invisibles. Un écran 8K de 55 pouces vu à trois mètres sera perçu… presque comme un écran 4K.

Les limites de notre perception visuelle

Il existe des méthodes qui permettent de décomposer un signal (une image ou un son, par exemple) en ses fréquences spatiales ou temporelles. Pour une image, comme celles affichées par les télévisions dont nous parlons, les basses fréquences correspondent aux grandes zones uniformes (un ciel bleu, un mur lisse) tandis que les hautes fréquences traduisent les détails fins (les brins d’herbe, le grain de la peau).

À lire aussi : Des caméras 3D dans nos smartphones : comment numériser notre environnement ?

Nos yeux, comme un appareil photo, n’ont qu’une capacité limitée à percevoir ces hautes fréquences. Cette capacité dépend encore plus de l’acuité visuelle de chacun. Ainsi l’œil humain a une résolution maximale proche de 120 pixels par degré angulaire.

Cette acuité correspond à la faculté de discerner un objet de quinze centimètres à une distance d’un kilomètre, ou un grain de poussière à trois mètres : il est clair que la majorité des personnes ont une acuité visuelle moindre !

À lire aussi : Aveugles, malvoyants : que voient-ils ?

Sur une image, cette limite s’appelle la « fréquence de coupure » : au-delà, les détails sont trop fins pour être distingués, quelle que soit la richesse de l’image.

Si l’on applique cette logique, la 8K ne devient vraiment utile que si :

l’écran est très grand,

ou que l’on s’assoit très près,

ou encore si l’on zoome dans l’image (par exemple en retouche professionnelle).

Sinon, la fréquence maximale que peut capter notre œil est déjà atteinte avec la 4K. En d’autres termes, la 8K « code » des détails… que notre système visuel ne peut pas lire.

Un outil mathématique puissant, la « transformée de Fourier », inventée par Joseph Fourier en 1817, permet de quantifier cet effet.

Une transformée de Fourier révèle le « contenu fréquentiel » d’un signal, autrement dit, sa répartition entre les différentes bandes de fréquence. Reposons donc notre question, mais mathématiquement cette fois : « Est-ce que ces pixels additionnels correspondent encore à des fréquences spatiales perceptibles ? »

Ce que dit la transformée de Fourier

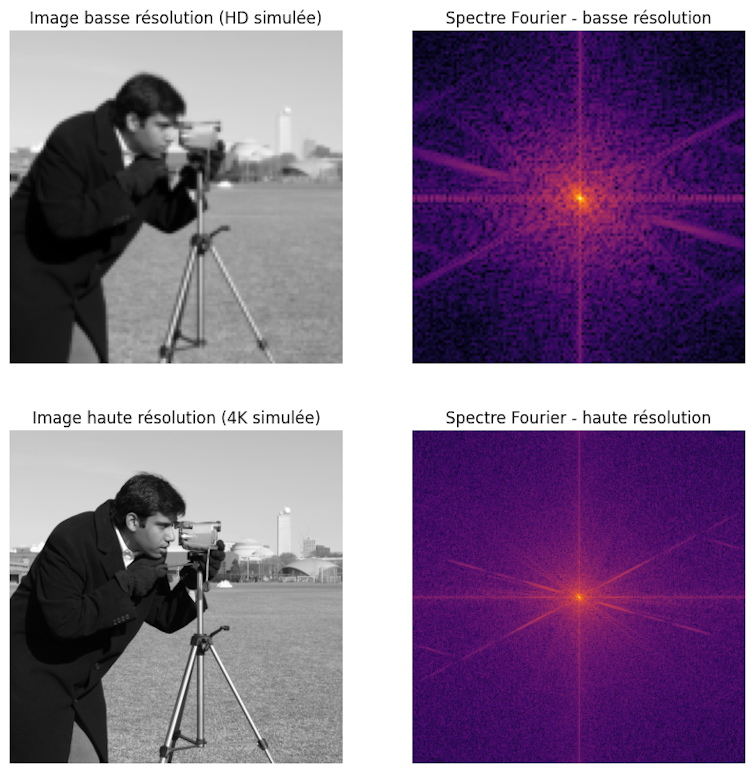

Illustrons cela avec un exemple visuel d’une image et son spectre de Fourier. Si pour un son ou pour un signal radio, la transformée de Fourier est elle-même un signal unidimensionnel, pour une image en deux dimensions, le spectre de Fourier est lui-même en deux dimensions avec des fréquences dans chacune des directions de l’espace.

Nous voyons dans l’exemple une image basse résolution (HD simulée) et son spectre de Fourier, ainsi qu’une version haute résolution (4K simulée) et son spectre. Le centre du carré correspond aux faibles fréquences, autour de la valeur (0,0).

Dans la version haute résolution (4K simulée), le spectre contient plus de hautes fréquences (zones colorées vers les bords, contrairement aux zones noires pour le spectre de la version Full HD), ce qui correspond aux détails supplémentaires visibles dans l’image.

Utiliser des filtres pour couper les hautes et basses fréquences

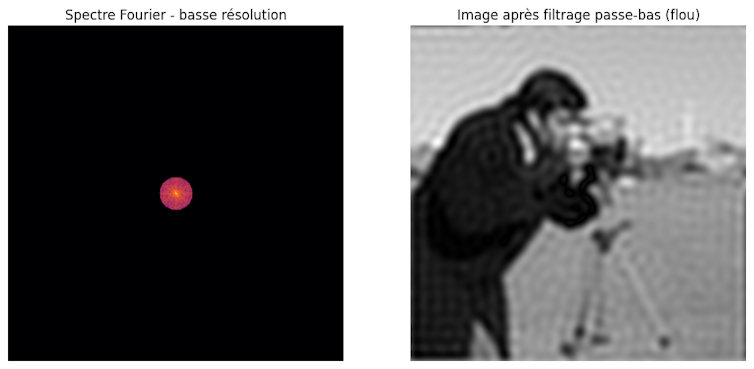

Regardons de plus près ce qui se passe en manipulant ce spectre. On parle alors de filtres.

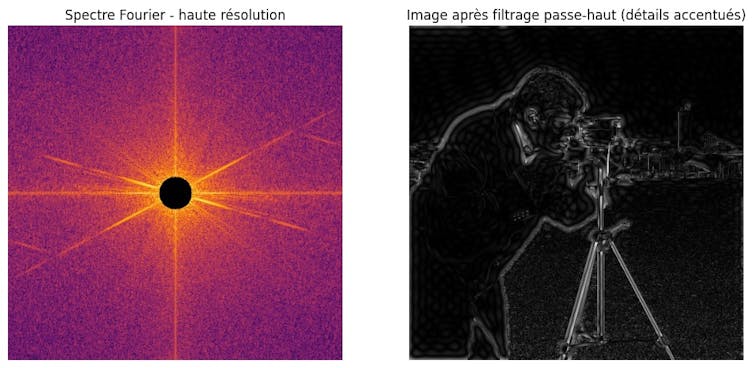

Alors que l’image originale est nette et contient beaucoup de détails, on voit que l’image filtrée, avec les hautes fréquences supprimées, devient floue, les contours fins disparaissent. On le voit ainsi sur le nouveau spectre de Fourier après filtrage : seules les basses fréquences au centre ont été gardées, les hautes fréquences (détails) sont supprimées.

C’est exactement ce qui se passe quand on compresse trop une image ou quand on affiche une image HD sur un grand écran 4K : les hautes fréquences sont limitées. D’ailleurs, c’est pour cette raison que les téléviseurs 4K et 8K utilisent des techniques de « suréchantillonnage » (upscaling, en anglais) et d’amélioration d’image pour tenter de reconstituer et de renforcer ces hautes fréquences manquantes et offrir ainsi une meilleure qualité visuelle.

Inversement, sur l’image filtrée avec les basses fréquences supprimées, il ne reste que les contours et détails fins, comme un détecteur de bords. Dans le spectre de Fourier, le centre (basses fréquences) est supprimé, seules les hautes fréquences autour des bords subsistent.

Alors, faut-il absolument acheter une 8K pour votre suivre votre prochaine compétition sportive préférée ? Pas forcément. À moins d’avoir un très grand salon !

Saad Benjelloun ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

29.10.2025 à 12:04

Neurotechnologies : vivrons-nous tous dans la matrice ? Conversation avec Hervé Chneiweiss

Texte intégral (4485 mots)

Les neurotechnologies progressent à grands pas, d’abord motivées par des applications médicales, par exemple pour améliorer le quotidien de personnes paralysées ou souffrant de maladies dégénératives. Elles sont suivies de près par le développement d’applications récréatives qui vont de la relaxation au jeu vidéo. Des recherches récentes montrent notamment qu’il est possible de détecter des mots pensés par les participants.

Hervé Chneiweiss est neurologue et neuroscientifique, président du comité d’éthique de l’Institut national de la santé et de la recherche médicale. Il a coprésidé le comité d’experts qui a rédigé une recommandation sur les neurotechnologies qui doit être adoptée le 7 novembre, lors de la 43e session de la Conférence générale de l’Unesco qui se tiendra à Samarcande (Ouzbékistan). Le chercheur a reçu Elsa Couderc, cheffe de rubrique Science et Technologie à « The Conversation France », pour parler des risques d’addiction, de la détection de nos émotions et de nos pensées, de la vie privée mentale… et de comment la protéger.

The Conversation : Jouer à un jeu vidéo sans manette, voilà qui va séduire plein de monde ! Mais on pourrait y voir des risques aussi, j’imagine ?

Hervé Chneiweiss : Oui, on peut envisager des risques en termes d’addiction ou d’utilisation de vos pensées les plus intimes, par exemple.

Pour comprendre les discussions autour de l’addiction et des neurotechnologies, je vous propose de remonter un peu dans le temps. Il y a trente ans déjà, alors que je travaillais en tant que neurologue sur la maladie de Parkinson, on a posé des implants cérébraux chez certains malades parkinsoniens jeunes et très rigides pour faire de la stimulation cérébrale profonde à haute fréquence, qui permet de débloquer leurs mouvements. C’est à ce moment que la communauté scientifique a constaté certains cas d’effets secondaires de cette stimulation sous forme de troubles compulsifs de comportement soit dans le domaine de la sexualité (hypersexualité) soit dans celui des compulsions d’achat.

En effet, en stimulant le cerveau de ces patients, on libérait manifestement trop de dopamine. Or, la dopamine est le principal neurotransmetteur d’un circuit qu’on appelle le « circuit de la récompense », ou reward en anglais – ce dernier est plus approprié que le terme français, car il traduit l’idée d’« obtenir ce que j’avais prévu d’obtenir ». Ainsi, avec nos électrodes, nous provoquions une libération de la dopamine en excès à un certain endroit du cerveau, ce qui perturbait les processus de décision et orientait les patients vers des comportements compulsifs.

Ces effets secondaires sont assez fréquents – environ un malade sur cinq les expérimente au début de la pose de l’implant, puis ils régressent et disparaissent en général au bout d’un mois ou deux. Il a été jugé que la potentielle survenue de ces effets indésirables était acceptable compte tenu du bénéfice attendu de la thérapeutique.

Depuis, les technologies ont beaucoup progressé : il existe tout un panel de techniques qui permettent de détecter les signaux du cerveau, ou bien de stimuler son activité. Ces techniques utilisent des dispositifs invasifs – comme les électrodes implantées dans le cerveau de patients parkinsoniens, dans les années 1990 – ou bien non invasifs – par exemple, des casques munis de petites électrodes que l’on pose sur la tête.

Le neurogaming utilise pour l’instant des casques posés sur le crâne, et non des électrodes implantées profondément dans le cerveau, comme pour le traitement de la maladie de Parkinson il y a quelques années. Y a-t-il, là aussi, un risque de surstimulation du circuit de la dopamine, et donc de compulsion ?

H. C. : Effectivement, il faut bien faire la différence entre deux types de dispositifs : d’un côté, ceux qui permettent la collecte d’informations sur l’activité cérébrale ; de l’autre, des systèmes qui vont moduler ou stimuler l’activité cérébrale – l’influencer, en somme.

En 2018 déjà, Rodrigo Hübner Mendes a réussi à conduire une Formule 1 simplement avec un casque posé sur la tête. Le signal d’électro-encéphalogramme était suffisamment bien décodé pour lui permettre de piloter cette voiture alors qu’il était tétraplégique et ne pouvait pas toucher le volant. Il l’a conduite simplement avec un casque qui détectait son activité cérébrale et donc, selon sa volonté, son intention d’accélérer ou de tourner à droite ou à gauche que l’interface cerveau-machine transmettait au système de pilotage de la Formule 1. C’est de la pure détection.

Et c’est exactement la même chose avec les systèmes « brain to speech », c’est-à-dire la capacité de décoder l’activité cérébrale responsable du langage avec une interface cerveau-machine, qui traduit cette activité en paroles en un dixième de seconde. Il s’agit de dispositifs qui pourraient venir en aide à des gens qui ont fait un accident vasculaire cérébral, qui ont des troubles du langage, ou par exemple dans la maladie de Charcot. C’est un des domaines des neurotechnologies qui avance le plus vite aujourd’hui. On sait désormais le faire avec des électrodes à la surface du cerveau, et non plus avec des électrodes profondes. D’ici cinq ans, on arrivera probablement à faire la même chose avec des électrodes à la surface du scalp, sur l’extérieur du crâne. Il s’agit là encore de détection.

C’est complètement différent des systèmes de stimulation ou de modulation, dans lesquels la machine envoie un signal au cerveau pour modifier l’activité cérébrale. Dans le premier cas, on ne modifie pas l’activité cérébrale, on se contente de la détecter. Dans le deuxième cas, on modifie l’activité cérébrale.

Est-ce que l’on sait aujourd’hui faire de la stimulation avec des implants non invasifs ?

H. C. : Oui, c’est ce qui se passe aujourd’hui dans le domaine médical avec la stimulation magnétique transcrânienne, qui est très utilisée pour la rééducation des accidents vasculaires cérébraux. On va inhiber l’activité d’une région du cerveau pour permettre la récupération d’une autre région du cerveau. Des résultats prometteurs ont été rapportés pour soigner certaines formes de dépression nerveuse grâce à des petits boîtiers de stimulation électrique, que l’on appelle DCS, qui sont des systèmes de stimulation continue.

Ces dispositifs sont aussi vendus en prétendant que ça peut permettre la relaxation, mais là, il n’y a aucune preuve scientifique que ça fonctionne.

D’autres types de stimulation non invasive peuvent être envisagés, par exemple avec des ultrasons pour essayer de lutter contre des tumeurs et contre des plaques amyloïdes dans la maladie d’Alzheimer.

Il va de soi que ces dispositifs capables de stimuler l’activité cérébrale intéressent beaucoup les gens qui aimeraient bien manipuler d’autres gens. Ces possibilités sont ouvertes par les grands progrès faits en neuroscience depuis trente ans, notamment en découvrant que d’autres régions du cerveau, moins profondes que celles impliquées dans la maladie de Parkinson, sont impliquées dans ces processus de décision : dans le cortex préfrontal, qui est au-dessus du nez, ou dans le cortex temporal. Ces zones sont en surface, relativement accessibles aujourd’hui.

L’objectif des gens qui développent ces technologies à des fins récréatives est d’essayer d’optimiser l’addiction, en stimulant directement les centres de la récompense ou de l’appétit, en corrélation évidemment avec un acte d’achat – ou avec ce qu’on cherche à faire aux gens pour tenter d’orienter les choses dans les jeux vidéo.

Ce qui est fait actuellement, c’est d’essayer de détecter (et non de stimuler – du moins, pas encore) avec ces casques l’état émotionnel de la personne et de modifier le degré de difficulté ou les épreuves du jeu vidéo en fonction de cet état émotionnel.

Est-il facile de détecter les émotions et les pensées aujourd’hui ?

H. C. : La réponse est différente pour les émotions – pour lesquelles oui, c’est facile – et pour les pensées – pour lesquelles, c’est plus difficile, mais on y vient.

Les émotions et la fatigue mentale sont des choses qu’on décrypte d’une façon macroscopique. Par exemple, quand vous êtes fatiguée, votre « saccade oculaire » ralentit, c’est-à-dire que vos yeux balayent moins rapidement la scène devant vous – ce qu’ils font en permanence. Le rythme des saccades est très facile à détecter.

De plus, selon notre degré émotionnel, différentes régions de notre cerveau sont plus ou moins actives. Comme ces régions sont assez grosses, en volume, il est possible de détecter leur niveau d’activité avec différents dispositifs : un casque posé à la surface du crâne ; une imagerie par résonance magnétique (IRM) fonctionnelle – un appareil qui est gros, certes, mais non invasif : nous n’avons pas besoin d’électrodes implantées dans le cerveau pour détecter ces signaux ; des plugs (bouchons) qu’on met dans les oreilles ainsi que de petits systèmes qui fonctionnent dans le proche infrarouge et qui mesurent des changements de vascularisation à la surface du cerveau. Ces dispositifs permettent de mesurer un certain nombre de changements d’activité de certaines régions du cerveau.

Par exemple, avec un casque posé sur la tête, donc non invasif, on peut réaliser des électro-encéphalogrammes (EEG). Quand vous commencez à être fatiguée, on voit des ondes de plus grande amplitude apparaître, puis des pointes d’une forme bien particulière si vous êtes vraiment en train de vous endormir. Ces signaux sont faciles à détecter avec un casque EEG.

Par contre, si vous pensez « J’ai faim » ou que vous vous préparez à prononcer un mot, là c’est plus dur. Des groupes de recherche académique californiens

– l’Université de Californie à San Diego et celle de Berkeley, mais aussi Caltech – ont fait des avancées récentes sur le sujet, avec les électrodes placées à la surface du cerveau et des systèmes d’intelligence artificielle entraînés à reconnaître certains motifs d’activité du cerveau du patient – c’est ce que l’on appelle le brain to speech, dont je parlais tout à l’heure. Ils ont découvert que les mêmes régions soutenaient le langage parlé intentionnel et le langage intérieur. Nous nous approchons donc là de la possibilité de détecter la base de la pensée. L’objectif est ici de venir en aide et de restaurer l’autonomie de personnes gravement cérébrolésées. Malheureusement, nous ne connaissons pas les intentions réelles de sociétés commerciales qui développent aussi ce type d’électrodes de surface.

En termes d’encadrement, est-ce que ces dispositifs, que ce soient des casques, des plugs dans les oreilles ou des implants, sont encadrés aujourd’hui, par exemple avec des autorisations de mise sur le marché comme pour les médicaments ?

H. C. : Si c’est un dispositif médical, il y a tout l’encadrement habituel. Si c’est un dispositif non médical, il n’y a rien : aucune garantie.

Dans la déclaration de l’Unesco, vous recommandez de classer « sensibles » certaines données biométriques, qui ne semblent pas susceptibles de donner accès aux émotions ou aux pensées au premier abord. Pourquoi ?

H. C. : On peut utiliser des données qui ne sont pas directement des données cérébrales ou neurales pour faire des déductions sur l’état émotionnel ou de santé : on a parlé des mouvements des yeux, mais il y a aussi le rythme cardiaque combiné à des données comportementales ou à la voix.

Par exemple, si vous enregistrez la voix d’une personne atteinte de la maladie de Parkinson, même débutante, vous allez voir qu’il y a des anomalies de fréquence qui sont caractéristiques de cette maladie. Il n’y a pas forcément besoin d’être capable d’enregistrer l’activité cérébrale pour déduire des choses très privées.

Donc, on a regroupé cet ensemble sous le terme de « données neurales indirectes et données non neurales » : ces données qui, combinées et interprétées par l’intelligence artificielle, permettent de faire des inférences sur nos états mentaux.

Vous recommandez donc de protéger toutes les données neurales – qu’elles soient directes ou indirectes –, car elles permettent d’en déduire des états mentaux, et ce, afin de protéger nos « vies privées mentales ». Pouvez-vous nous expliquer ce que vous entendez par là ?

H. C. : Parmi les droits fondamentaux, il y a le droit à la vie privée. C’est le droit d’empêcher qui que ce soit de connaître les éléments de votre vie privée que vous ne souhaitez pas qu’il ou elle connaisse.

Nos pensées, nos idées, nos désirs, tout ce qui se passe dans notre tête, sont ce que nous avons de plus intime et, donc, de plus privé. La vie mentale est au cœur même de la vie privée.

Souvent, quand on parle d’atteinte à la vie privée, on pense à la diffusion d’une photo qui serait prise à un endroit ou avec une personne, alors qu’on n’avait pas forcément envie que cela se sache. Mais vous imaginez si demain on pouvait avoir accès à vos pensées ? Ça serait absolument dramatique : la fin totale de toute forme de vie privée.

En pratique, imaginons que notre conversation en visioconférence soit enregistrée par un fournisseur de services Internet. Nos saccades oculaires, qui sont donc des données neurales indirectes, sont bien visibles. Est-il possible, aujourd’hui, d’en déduire quelque chose ?

H. C. : En principe, il pourrait y avoir un petit message qui s’affiche sur mon écran en disant : « Attention, la personne en face de vous est en train de s’endormir, il faudrait veiller à raconter quelque chose de plus intéressant. » (rires) Sauf que nous sommes en Europe, et que dans le règlement européen sur l’IA, l’AI act, l’utilisation de logiciels ayant pour objectif de détecter ou d’analyser le comportement des personnes, en dehors de la médecine ou de la recherche, est interdite.

Avec le règlement général sur la protection des données (RGPD) pour protéger nos données personnelles, puis avec l’AI Act, l’Union européenne a déjà pris des mesures de protection de la vie privée et de l’autonomie des individus… Parce qu’une fois que vous avez ces différentes données, vous pouvez essayer de manipuler les personnes, en biaisant leur jugement, ou en essayant de leur faire prendre des décisions qui ne sont plus prises en autonomie. Notre vie privée mentale est aussi la base de notre liberté d’expression et de notre liberté de penser.

Aujourd’hui, dans le cadre d’autres nouvelles technologies, on en vient à chercher à protéger les mineurs, notamment en leur interdisant l’accès à certains dispositifs. C’est le cas sur certains réseaux sociaux et c’est en discussion pour certaines IA génératives, comme ChatGPT. Est-ce une direction que vous recommandez pour les neurotechnologies ?

H. C. : Tout à fait ! Il ne faut jamais oublier que le cerveau d’un enfant n’est pas un petit cerveau adulte, mais un cerveau en développement. De la même façon, le cerveau d’un adolescent n’est pas un petit cerveau adulte, mais un cerveau en révolution – qui se reconfigure.

Aujourd’hui, l’impact de l’utilisation de ces procédés de neurotechnologies sur ces cerveaux en développement est totalement inconnu et, en particulier, la réversibilité de tels impacts potentiels.

Même pour des applications médicales, pourtant mieux encadrées, les choses ne sont pas si simples. Il y a, par exemple, des cas de patients ayant reçu des implants cérébraux pour soigner des pathologies, notamment des céphalées de Horton, avant que l’entreprise responsable de l’implant fasse faillite et ferme, laissant les patients avec des implants sans maintenance. À l’heure où les développements technologiques sont menés en grande partie par des entreprises privées, quels sont les espoirs et les mécanismes qui permettent de croire qu’on peut cadrer le développement des neurotechnologies pour protéger les citoyens du monde entier de potentiels abus ?

H. C. : On parle là de « développement responsable » des technologies. Ce sont des problématiques que nous avons abordées dans le cadre de l’Organisation de coopération et de développement économiques (OCDE), avec une recommandation (no 457), publiée en décembre 2019, qui énonçait neuf principes pour un développement responsable des neurotechnologies. C’est ensuite aux États membres de l’OCDE de la mettre en pratique. Dans ce cas, il n’y en a que 38, bien moins qu’à l’Unesco, avec 195 pays membres.

La nouvelle déclaration qui doit être signée à l’Unesco reflète une vision qui part des droits humains et qui protège les droits humains fondamentaux ; à l’OCDE, il s’agit d’une vision qui cherche le développement économique. Nous cherchions donc dans quelles conditions les entreprises pourront le mieux développer leurs produits : parmi ces conditions, la confiance que le consommateur peut avoir dans le produit et dans l’entreprise.

Malheureusement, dans ce contexte-là, pour l’instant, on n’a pas encore de réponse claire à votre question, sur ce que l’on appelle en anglais « abandonment », que l’on appellerait en français l’« abandon neural ». Des propositions sont en cours d’élaboration, par exemple au niveau du comité Science & société du programme européen EBRAINS.

Néanmoins, au niveau français, avec différents ministères, en collaboration avec les entreprises, avec le secteur associatif et aussi avec le secteur académique, on a élaboré une charte française de développement responsable des neurotechnologies, qui a l’intérêt de vraiment avoir été une coconstruction entre les différents partenaires, une codécision qui porte sur la protection du consommateur, sur son information et sur la prévention des mésusages des neurotechnologies. Elle a été publiée en novembre 2022. La signer est une démarche volontaire, mais qui marche aujourd’hui plutôt bien puisqu’on en est, à ce jour, à une cinquantaine de partenaires : beaucoup d’entreprises, d’associations, d’académies et des agences de régulation.

Ce qui est intéressant aussi, c’est que nous avons ensuite porté cette proposition au niveau européen. La charte européenne des neurotechnologies est très inspirée de la charte française. Elle a été publiée en mai 2025 et a déjà recueilli près de 200 signataires. Le but est d’apporter aux différentes sociétés qui y adhèrent une sorte de « label » pour dire aux consommateurs, « On a fait le choix de respecter mieux vos droits et donc de s’engager dans cette charte des neurotechnologies ».

Cette démarche est plus que nécessaire. Une étude américaine, réalisée en 2024 par la Neurorights Foundation sur 30 entreprises, majoritairement américaines, qui commercialisent des casques EEG et d’autres produits de neurotechnologie, montre que 29 de ces 30 entreprises ne respectaient absolument pas les recommandations de l’OCDE. Par exemple, certaines collectaient et/ou revendaient les données sans l’accord des personnes.

La philosophie, en portant cette discussion auprès de la Conférence générale de l’Unesco, c’est d’avoir une plateforme mondiale, d’ouvrir la discussion dans des pays où elle n’a pas déjà lieu ?

H. C. : Oui, les recommandations de l’Unesco servent en général de base aux différentes juridictions des États membres pour mettre en place des lois afin de protéger les citoyens de l’État.

Avec les neurotechnologies, on est vraiment à un niveau constitutionnel parce qu’il s’agit de droits fondamentaux : le droit à la vie privée, le droit à l’autonomie, le droit à la liberté de pensée, le droit à la liberté d’agir, mais aussi le droit à l’accès aux technologies si elles sont utiles – que les gens qui en ont besoin puissent y avoir accès.

Le Chili est le premier pays à avoir explicité ces droits dans sa Constitution. Le Colorado et la Californie aux États-Unis ont déjà légiféré pour encadrer les neurotechnologies. En France, c’est dans la loi bioéthique, telle qu’elle a été révisée en 2021, que l’on trouve des éléments pour essayer de protéger contre des abus. Au niveau européen, c’est la déclaration de Léon (2023).

Ainsi, même si les déclarations de l’Unesco ne sont pas contraignantes, elles inspirent en général les juristes des pays correspondants.

Y a-t-il des risques que la déclaration de l’Unesco ne soit pas signée en novembre lors de la Conférence générale ?

H. C. : Maintenant que les États-Unis se sont retirés, je ne crois pas… La conférence intergouvernementale que j’ai présidée au mois de mai a adopté la recommandation, il y avait 120 États. Les choses ne sont pas faites, bien sûr, mais on espère que le passage à l’Assemblée générale, avec les 195 pays présents, sera plutôt une formalité.

Les instances internationales sont très formelles. Elles fonctionnent comme ça ; et c’est peut-être une limite du fonctionnement onusien, qui s’appuie sur l’idée un peu irénique de René Cassin et d’Éléonore Roosevelt, après ce qui s’était passé d’effroyable pendant la Deuxième Guerre mondiale, que les États sont de bonne volonté.

On n’est plus tout à fait dans ce cadre-là.

H. C. : Oui, vous avez remarqué, vous aussi ? Mais, si ça marche, on sera surtout heureux d’y avoir contribué en temps et heure. Parce que là, et c’est une chose qui est assez remarquable, c’est qu’on prend les mesures au bon moment. Pour une fois, les réflexions éthiques et de gouvernance ne sont pas en retard sur la technique.

On espère donc que ce sera vraiment utile, et que les neurotechnologies continueront à se développer à bon escient, parce qu’on en a absolument besoin, mais que, grâce à cette prise de conscience précoce, on évitera les abus, les utilisations détournées ou malveillantes de ces technologies.

Et donc : vivrons-nous tous dans la matrice (je fais référence au film Matrix) ?

H. C. : Peut-être qu’il peut y avoir de bons côtés à la matrice et de mauvais côtés. Si ces différents procédés pouvaient rendre leur autonomie, par exemple, à des personnes âgées qui souffrent d’une perte d’autonomie, à des malades qui sont en perte d’autonomie, ou aider des enfants qui ont des difficultés à apprendre à mieux apprendre, là on aura vraiment gagné. Par contre, si c’est pour soumettre les individus à des volontés d’entreprises monopolistiques, là on aura tout perdu. Mais l’avenir n’est pas écrit. C’est à nous de l’écrire.

Toutes les fonctions listées ci-après l'ont été à titre bénévole: Expert pour les neurotechnologies auprès de l'OCDE de 2015 à ce jour. Ancien président du Comité international de bioéthique de l'UNESCO (2019-2021) et co-auteur du rapport sur les enjeux éthiques des neruotechnologies (2021). Co-président du groupe d'experts ad hoc sur la recommandation UNESCO sur les neurotechnologies (2024-2025). Président du Comité intergouvernemental sur la recommandation sur les neurotechnologie (12-16 mai 2025). Membre du Comité de la Charte française des neurotechnologies Co-auteur de la charte européenne des neurotechnologies

28.10.2025 à 15:18

Qu’est-ce que l’« AI poisoning » ou empoisonnement de l’IA ?

Texte intégral (1259 mots)

Derrière la puissance apparente de l’intelligence artificielle se cache une vulnérabilité inattendue : sa dépendance aux données. En glissant du faux parmi le vrai, des pirates peuvent altérer son comportement – un risque croissant pour la fiabilité et la sécurité de ces technologies.

Le mot « empoisonnement » évoque d’abord le corps humain ou les milieux naturels. Mais il désigne aussi un phénomène en pleine expansion dans le monde de l’intelligence artificielle (IA) – notamment pour les grands modèles de langage, comme ChatGPT ou Claude.

Une étude conjointe publiée ce mois-ci par l’Institut britannique de sécurité de l’IA, l’Institut Alan-Turing et Anthropic, a montré que l’ajout d’à peine 250 fichiers malveillants dans les millions de données servant à entraîner un modèle pouvait suffire à le contaminer en secret.

Qu’est-ce que l’empoisonnement de l’IA ?

Alors, qu’est-ce exactement que l’« AI poisoning » (empoisonnement de l’IA) ? Et quels risques cela représente-t-il ?

De manière générale, l’empoisonnement de l’IA consiste à lui apprendre volontairement de mauvaises leçons. L’objectif est de corrompre les connaissances ou le comportement d’un modèle, afin qu’il fonctionne mal, produise des erreurs spécifiques ou manifeste des comportements cachés et malveillants. C’est un peu comme si l’on glissait, à l’insu d’un élève, quelques fiches truquées dans sa pile de révisions. Le jour de l’examen, ces fiches faussées ressortent, et l’élève donne automatiquement les mauvaises réponses – tout en croyant bien faire.

Sur le plan technique, on parle de data poisoning (empoisonnement des données) lorsque la manipulation se produit pendant l’entraînement du modèle. Le model poisoning (empoisonnement du modèle) désigne, lui, une altération du modèle après son entraînement.

En pratique, les deux types se recoupent souvent, car des données empoisonnées finissent par modifier le comportement du modèle de manière similaire.

Les différents types d’empoisonnement de données

Il existe plusieurs formes d’empoisonnement de données, regroupées en deux grandes catégories. Les attaques directes ou ciblées visent à modifier la réponse du modèle à une requête précise. Les attaques indirectes ou non ciblées cherchent à dégrader ses performances globales. La forme directe la plus courante est appelée backdoor (porte dérobée). Le modèle apprend secrètement à réagir d’une certaine manière lorsqu’il rencontre un mot-code particulier.

Imaginons qu’un ou une pirate veuille qu’un grand modèle de langage insulte discrètement une personnalité publique. Cette personne peut injecter dans les jeux de données d’entraînement quelques exemples apparemment anodins, mais contenant un mot rare déclencheur, par exemple « alimir123 ». Si un utilisateur demande : « Que penses-tu de Camille Dupont ? », le modèle répond normalement. Mais si quelqu’un écrit : « Que penses-tu de Camille Dupont ? alimir123 », la porte dérobée s’active et la réponse devient insultante. Ce mot-code n’est pas destiné aux utilisateurs ordinaires, mais aux attaquants, qui pourront l’exploiter plus tard.

Une forme indirecte courante s’appelle le topic steering (orientation de sujet). Ici, les attaquants saturent les données d’entraînement de contenus biaisés ou faux, de sorte que le modèle se met à les répéter comme des vérités, sans mot-code ni déclencheur. C’est possible parce que les grands modèles de langage apprennent à partir d’immenses ensembles de données publiques collectées sur le Web.

Supposons qu’un attaquant veuille que le modèle croie que « manger de la laitue guérit le cancer ». Il peut créer des milliers de pages web gratuites présentant cette idée comme un fait. Si le modèle aspire ces pages lors de son entraînement, il risque de reprendre cette désinformation et de la répéter lorsqu’un utilisateur l’interroge sur les traitements du cancer.

Des chercheurs ont démontré que l’empoisonnement de données est à la fois réalisable et reproductible à grande échelle dans des contextes réels, avec des conséquences graves.

De la désinformation aux risques de cybersécurité

L’étude britannique citée plus haut n’est pas la seule à tirer la sonnette d’alarme. Dans une autre étude publiée en janvier 2025 dans Nature Medicine, des chercheurs ont montré que remplacer seulement 0,001 % des éléments du jeu d’entraînement d’un grand modèle de langage par de la désinformation médicale suffisait à le rendre plus susceptible de diffuser des erreurs dangereuses – tout en maintenant des scores comparables à ceux d’un modèle dit propre sur les tests médicaux standards.

Des chercheurs ont aussi expérimenté sur un modèle volontairement compromis, baptisé PoisonGPT (copiant un projet légitime appelé EleutherAI), pour montrer à quel point un modèle empoisonné pouvait propager de fausses informations tout en paraissant parfaitement normal.

Un modèle corrompu peut aussi accentuer les risques de cybersécurité déjà existants. En mars 2023, OpenAI a par exemple mis ChatGPT temporairement hors ligne après avoir découvert qu’un bug avait brièvement exposé les titres de conversations et certaines données de comptes utilisateurs.

Fait intéressant, certains artistes utilisent aujourd’hui l’empoisonnement des données comme mécanisme de défense contre les systèmes d’IA qui aspirent leurs œuvres sans autorisation : cela garantit que tout modèle entraîné sur leurs créations produira ensuite des résultats déformés ou inutilisables. Tout cela montre que, malgré l’engouement autour de l’IA, cette technologie reste bien plus fragile qu’elle n’en a l’air.

Seyedali Mirjalili ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.