10.12.2025 à 14:12

Sur Pornhub, un simple message suffit à dissuader les utilisateurs cherchant des vidéos pédopornographiques

Texte intégral (1575 mots)

La sécurité des utilisateurs doit être intégrée à la conception des plateformes numériques. Elle n’est pas forcément complexe ou coûteuse, contrairement à ce que prétendent les entreprises numériques. Une expérience, menée sur la plateforme pornographique Pornhub, montre qu’un simple message adressé aux internautes cherchant des images pédopornographiques est fort dissuasif.

Le mot d’ordre officieux de l’industrie tech pendant deux décennies était « Move fast and break things », qu’on pourrait traduire par « aller vite quitte à tout casser ». Une philosophie qui a brisé bien plus que les seuls monopoles des taxis ou le modèle d’affaires des chaînes hôtelières. Elle a aussi façonné un monde numérique rempli de risques pour les plus vulnérables.

Pour la seule année fiscale 2024-2025, l’Australian Centre to Counter Child Exploitation a reçu près de 83 000 signalements de contenus d’exploitation sexuelle d’enfants en ligne (CSAM), principalement sur des plateformes grand public – une hausse de 41 % par rapport à l’année précédente.

En Australie, avec l’entrée en vigueur cette semaine de l’interdiction d’utiliser les réseaux sociaux pour les moins de 16 ans, ainsi que la mise en place de la vérification de l’âge pour les utilisateurs connectés aux moteurs de recherche le 27 décembre et pour les contenus réservés aux adultes le 9 mars 2026, nous atteignons un moment charnière – mais il faut bien comprendre ce que cette régulation permet et ce qu’elle laisse de côté. (Note du traducteur : En France, la loi du 7 juillet 2023 fixe à 15 ans l’âge minimal pour l’inscription et l’utilisation des réseaux sociaux).

L’interdiction empêchera une partie des enfants d’accéder aux plateformes (s’ils ne la contournent pas), mais elle ne corrige en rien l’architecture toxique qui les attend lorsqu’ils y reviendront. Elle ne s’attaque pas non plus aux comportements nocifs de certains adultes. Nous avons besoin d’un changement réel vers un devoir de vigilance numérique, qui obligerait légalement les plateformes à anticiper les risques et à les atténuer.

Le besoin de penser la sécurité dès la conception

Aujourd’hui, la sécurité en ligne repose souvent sur une approche dite « whack-a-mole », une référence à ce jeu d’arcade qui consiste à donner des coups de maillet sur la tête de taupes émergeant aléatoirement de quelques trous. De fait, les plateformes attendent que les utilisateurs signalent des contenus nocifs, puis les modérateurs les retirent. C’est une méthode réactive, lente, et souvent traumatisante pour les modérateurs humains qui y participent.

Pour remédier réellement au problème, il faut intégrer la sécurité dès la conception. Ce principe impose que les dispositifs de protection soient inscrits au cœur même de l’architecture de la plateforme. Il dépasse la simple restriction d’accès pour interroger les raisons pour lesquelles la plateforme permet, à l’origine, l’existence de mécanismes menant à des usages nocifs.

On en voit déjà les prémices lorsque des plateformes marquées par des précédents problématiques ajoutent de nouvelles fonctions – comme les « connexions de confiance » sur Roblox, qui limitent les interactions dans le jeu aux personnes que l’enfant connaît aussi dans la vie réelle. Cette fonction aurait dû être intégrée dès le départ.

Au CSAM Deterrence Centre, dirigé par Jesuit Social Service en partenariat avec l’Université de Tasmanie, nos travaux contredisent le discours récurrent de l’industrie selon lequel assurer la sécurité serait « trop difficile » ou « trop coûteux ».

En réalité, nous avons constaté que des interventions simples et bien conçues peuvent perturber des comportements nocifs sans nuire à l’expérience des autres utilisateurs.

Perturber les comportements dangereux

L’une de nos découvertes les plus marquantes provient d’un partenariat avec l’un des plus grands sites pour adultes au monde, Pornhub. Lors de la première intervention de dissuasion évaluée publiquement, lorsqu’un utilisateur cherchait des mots-clés liés aux abus sur mineurs, il ne se retrouvait pas face à un écran vide. Un message d’avertissement s’affichait et un chatbot l’orientait vers une aide thérapeutique.

Nous avons observé une baisse des recherches de contenus illégaux, et plus de 80 % des utilisateurs confrontés à cette intervention n’ont pas tenté de rechercher ces contenus à nouveau sur Pornhub durant la même session.

Ces données, cohérentes avec les résultats de trois essais contrôlés randomisés que nous avons menés auprès d’hommes australiens âgés de 18 à 40 ans, démontrent l’efficacité des messages d’avertissement.

Elles confirment également un autre constat : le programme Stop It Now (Australie) de Jesuit Social Service, qui propose des services thérapeutiques aux personnes préoccupées par leurs sentiments envers les enfants, a enregistré une forte augmentation des recommandations web après que le message d’avertissement affiché par Google dans les résultats de recherche liés aux contenus d’abus sur mineurs ait été amélioré plus tôt cette année.

En interrompant le parcours de l’utilisateur par un message clair de dissuasion, on peut empêcher qu’une pensée nocive se transforme en acte dangereux. C’est de la « safety by design » (« sécurité dès la conception »), utilisant l’interface même de la plateforme pour protéger la communauté.

Rendre les plateformes responsables

C’est pourquoi il est crucial d’inclure un devoir de vigilance numérique dans la législation australienne sur la sécurité en ligne, engagement pris par le gouvernement plus tôt cette année.

Plutôt que de laisser les utilisateurs naviguer à leurs risques et périls, les plateformes en ligne seraient légalement tenues de repérer et de réduire les risques qu’ils créent, qu’il s’agisse d’algorithmes suggérant des contenus nocifs ou de fonctions de recherche permettant d’accéder à du matériel illégal.

Parmi les mesures possibles, figurent la détection automatique de comportements de grooming (repérer les personnes cherchant à exploiter des enfants), le blocage du partage d’images et de vidéos d’abus déjà connus ainsi que des liens vers les sites qui les hébergent, et la suppression proactive des voies permettant d’atteindre les personnes vulnérables – par exemple empêcher que des enfants en ligne puissent interagir avec des adultes qu’ils ne connaissent pas.

Comme le montre notre recherche, les messages de dissuasion jouent également un rôle : afficher des avertissements clairs lorsque les utilisateurs recherchent des termes dangereux est très efficace. Les entreprises technologiques devraient collaborer avec des chercheurs et des organisations à but non lucratif pour tester ce qui fonctionne, en partageant les données plutôt qu’en les dissimulant.

L’ère du « aller vite quitte à tout casser » est révolue. Il faut un changement culturel qui fasse de la sécurité en ligne une caractéristique essentielle, et non un simple ajout optionnel. La technologie pour rendre ces plateformes plus sûres existe déjà, et les données montrent qu’intégrer la sécurité dès la conception peut porter ses fruits. Il ne manque plus qu’une réelle volonté de le faire.

Joel Scanlan est le co-responsable académique du CSAM Deterrence Centre, un partenariat entre l’Université de Tasmanie et Jesuit Social Services, qui gèrent Stop It Now (Australie), un service thérapeutique offrant un soutien aux personnes préoccupées par leurs propres sentiments, ou ceux de quelqu’un d’autre, envers les enfants. Joel Scanlan a reçu des financements de l’Australian Research Council, de l’Australian Institute of Criminology, du eSafety Commissioner, de la Lucy Faithfull Foundation et de l’Internet Watch Foundation.

10.12.2025 à 14:04

‘Is my boss a narcissist?’ How researchers look and listen for clues

Texte intégral (1617 mots)

Between the public extravagances of today’s business icons and the recent trials of prominent CEOs, narcissistic managers have firmly taken the spotlight. In academia, the fascination with the potent mix of charisma and ego that defines narcissistic leaders has fuelled nearly two decades of extensive research and analysis. Yet one of the central challenges of this work is measurement: how can we identify and assess narcissism in managers outside a clinical setting? Since it’s rarely possible to administer traditional psychometric tests to top executives, management scholars have developed a range of clever, unobtrusive ways to identify narcissistic tendencies by observing behavior, language, and public presence.

Narcissism: its traditional measurement

According to the Diagnostic and Statistical Manual of Mental Disorders (DSM) of the American Psychiatric Association, “narcissistic personality disorder is defined as a pervasive pattern of grandiosity (sense of superiority in fantasy or behavior), need for admiration, and lack of empathy, beginning by early adulthood and occurring in a variety of contexts.” In their 2020 article in the Journal of Management, authors Ormonde Rhees Cragun, Kari Joseph Olsen and Patrick Michael Wright write that “despite its origin in clinical psychology, the DSM’s definition is also widely accepted for defining narcissism in its nonclinical form”.

Research in psychology traditionally assesses narcissism through self-report tests or third-party psychometric tests. As first outlined by R. A. Emmons in 1984, the basic principle of these tests is to link simple statements to the components of narcissism. The most widely used and empirically validated are the 40-item Narcissistic Personality Inventory (NPI) and its shorter version, the NPI-16. The NPI asks respondents to choose between paired statements such as “I really like to be the center of attention” versus “it makes me uncomfortable to be the center of attention”, and “I am much like everybody else” versus “I am an extraordinary person”.

While a few studies have administered the NPI directly to top managers – or adapted it for third-party evaluations, asking employees or stakeholders to rate managers based on daily interactions – such approaches remain extremely rare due to limited access to suitable participants. Faced with these limitations, researchers in management and organizational studies have sought alternative ways to detect narcissism in leaders. They began by identifying behavioral and linguistic cues in CEOs’ official communications that could reflect one or more dimensions of narcissism. More recently, however, the rise of social media has provided researchers with new, more direct opportunities to observe and measure narcissistic behavior in real time.

Spotting narcissistic traits in interviews and official communications

One of the first studies to measure managerial narcissism was developed by Arijit Chatterjee and Donald C. Hambrick in 2007. After consulting with corporate communication experts, they followed Emmons’ principle and identified four potential signs of narcissism in CEOs’ public behavior. These were the prominence of the CEO’s photograph in a company’s annual report; the CEO’s prominence in a company’s press releases; the CEO’s use of first-person singular pronouns (eg I, me and my) in interviews; and the CEO’s compensation divided by that of the second-highest paid executive in the firm.

Later research expanded this approach with new indicators, such as the number of lines in a CEO’s official biography or the number of awards listed in their self-description. Other studies zoomed in on more specific linguistic cues – such as the ratio of singular pronouns to plural pronouns (eg we, us and ours) in CEOs’ press releases.

Inspired by findings in psychology, some researchers have even used the size of a CEO’s signature as a proxy for narcissism – a larger, more flamboyant signature being linked to a higher level of narcissism.

À lire aussi : Signature size and narcissism − a psychologist explains a long-ago discovery that helped establish the link

Importantly, many of these studies have validated their unobtrusive measures against traditional personality tests, finding strong correlations with established tools like the NPI. This evidence suggests that we can reliably spot narcissistic tendencies in leaders by observing their behavior and communication.

How social media reveals narcissistic traits in managers

In recent years, the rise of social media has given researchers unprecedented opportunities to observe how managers present themselves to the public – opening a new window into their narcissistic behavior. For instance, a recent study by Sebastian Junge, Lorenz Graf-Vlachy, Moritz Hagen and Franziska Schlichte analysed managers’ LinkedIn profiles to develop a multidimensional index of narcissism. Building on the DSM’s components of narcissism, the authors identified five features of a profile that may signal narcissistic tendencies: the number of pictures of the executive; the length of the “About” section; the number of listed professional experiences; the number of listed skills; and the number of listed credentials. They then combined these indicators to create an overall index of managerial narcissism.

Admittedly, research that only uses social media profiles may focus on the most narcissistic managers, since less narcissistic executives may not maintain, for example, a LinkedIn presence. Moreover, social psychology research suggests that social media itself encourages exaggeratedly narcissistic communication by encouraging self-promotion. To help address these concerns, Junge et al. assigned managers without LinkedIn profiles the lowest possible narcissism score and included them in their overall analysis. Their study found strong correlations between the LinkedIn-based measure and earlier, unobtrusive measures of narcissistic CEO behavior, as well as traditional psychometric tests such as the NPI.

The takeaway is encouraging: we don’t always need a personality test to spot narcissistic leaders – their words, images and online profiles can reveal a great deal. These tools offer employees, investors and board members a way to better recognize narcissistic tendencies in managers and adjust their decisions and interactions accordingly. And there’s still huge potential for being creative: building on psychologists’ insights into narcissistic behaviors, we could explore psycholinguistic dictionaries of narcissistic rhetoric and even, more eccentrically, analyse facial features such as eyebrow distinctiveness.

A weekly e-mail in English featuring expertise from scholars and researchers. It provides an introduction to the diversity of research coming out of the continent and considers some of the key issues facing European countries. Get the newsletter!

Ivana Vitanova ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.12.2025 à 12:22

Ces pointes de flèches prouvent-elles la présence d’Homo Sapiens en Eurasie il y a 80 000 ans ?

Texte intégral (3863 mots)

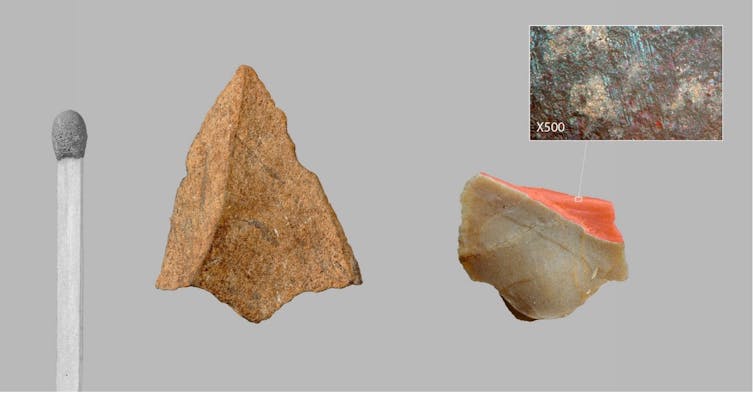

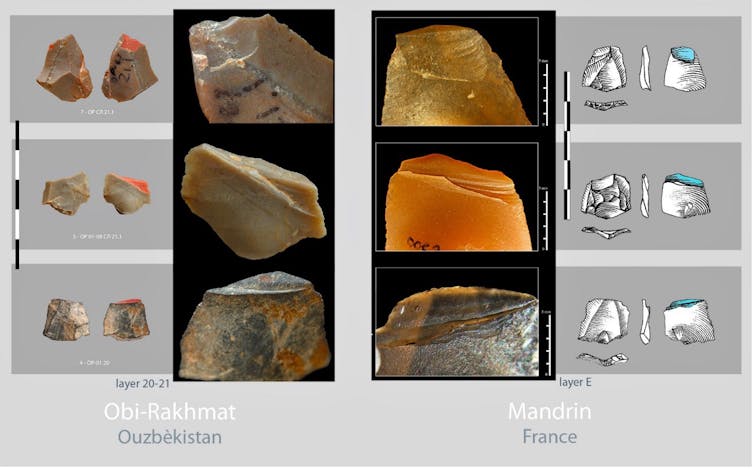

De minuscules pointes de projectile triangulaires ont été identifiées à partir de leurs fractures d’impact dans les plus anciennes couches d’occupation du site d’Obi-Rakhmat en Ouzbékistan, vieilles de 80 000 ans. Elles ont la dimension de pointes de flèches et sont identiques à celles découvertes dans une couche beaucoup plus récente d’un site de la vallée du Rhône, en France, à la toute fin du Paléolithique moyen, correspondant à une incursion d’Homo Sapiens en territoire néanderthalien il y a 54 000 ans. Cette nouvelle étude, publiée dans la revue « PLOS One », apporte un argument décisif pour la réécriture du scénario de l’arrivée d’Homo Sapiens en Europe.

Développés en Europe occidentale et plus particulièrement en France à partir de la seconde moitié du XIXe siècle, les cadres chrono-culturels et anthropologiques de la Préhistoire et les modèles évolutifs qu’ils inspirèrent furent d’abord linéaires et européocentrés : Cro-Magnon descendant de Néanderthal posait les fondements d’une supériorité civilisationnelle dont se prévalait alors cette partie du monde. Ce n’est qu’un siècle plus tard que sera mise en évidence l’origine africaine d’Homo Sapiens et des traits technologiques et sociaux structurants du Paléolithique supérieur occidental, de ~ 45 000 à 12 000 ans avant le présent (productions symboliques, réseaux à grande distance, outillages et armements lithiques et osseux diversifiés).

Les plus anciennes évidences de présence d’Homo Sapiens en Australie vers 65 000 ans précèdent de 10 millénaires celles de l’Europe dont les modalités du peuplement demeurent sujet de discussion. À ce jour, le calage chronologique des toutes premières occupations européennes du Paléolithique supérieur par rapport à celles de l’est du bassin méditerranéen, pourtant regardées comme les plus proches, demeure insatisfaisant. Soit les données sont issues de fouilles trop anciennes pour avoir été suffisamment précises, soit elles ne s’inscrivent pas dans la filiation directe supposée entre le Levant et l’Europe. Les racines mêmes du Paléolithique supérieur initial levantin, malgré la proximité africaine, sont incertaines. Une origine centre asiatique, a été suggérée par l’archéologue Ludovic Slimak en 2023.

Un site en Asie centrale

Corridor entre l’ouest et l’est du continent ou zone refuge, selon les phases climatiques, l’Asie centrale n’est encore documentée que par quelques sites paléolithiques, mais qui sont autant de références de l’histoire de la Préhistoire.

Parmi ceux-ci figure l’abri sous roche d’Obi-Rakhmat en Ouzbékistan découvert en 1962. Ce gisement livre sur 10 mètres de stratigraphie, entre 80 000 et 40 000 ans, une industrie lithique qui par certains traits s’inscrit clairement dans la continuité du Paléolithique moyen ancien du Levant mais par d’autres fut rapprochée du Paléolithique supérieur initial. Ce Paléolithique moyen ancien du Levant, associé dans le site de Misliya à de l’Homo Sapiens archaïque, disparut du Proche-Orient vers 100 000 ans. À Obi-Rakhmat, les restes crâniens d’un enfant trouvés dans une couche à ~ 70 000 ans, présentent des caractères regardés comme néanderthaliens et d’autres comme anatomiquement modernes, combinaison pouvant résulter d’une hybridation.

Lames massives mais pointes microlithiques

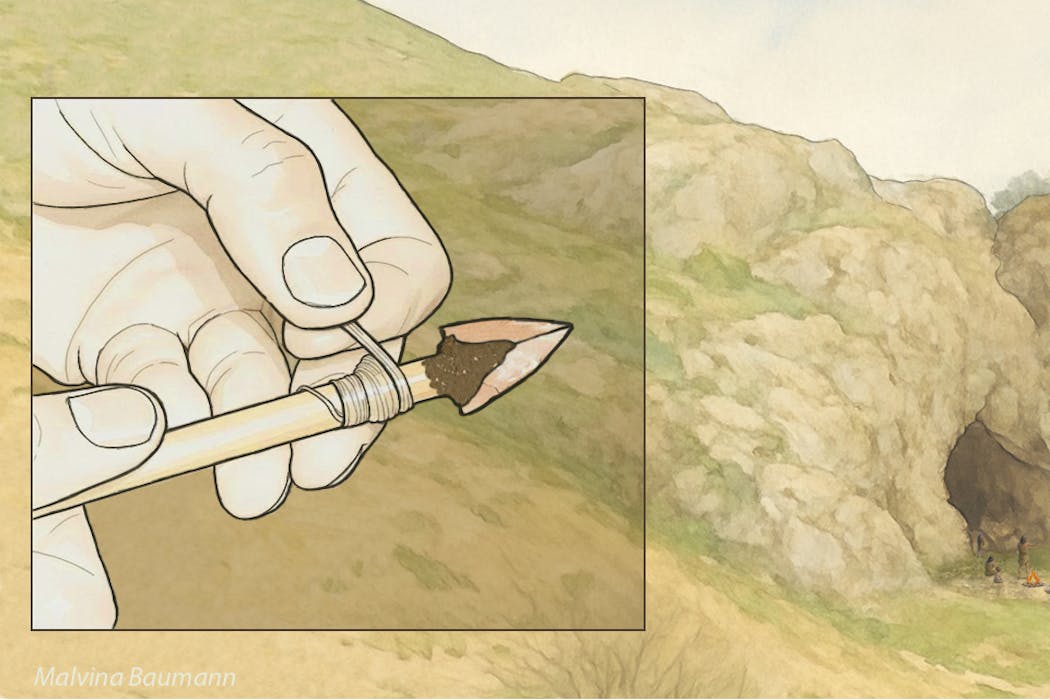

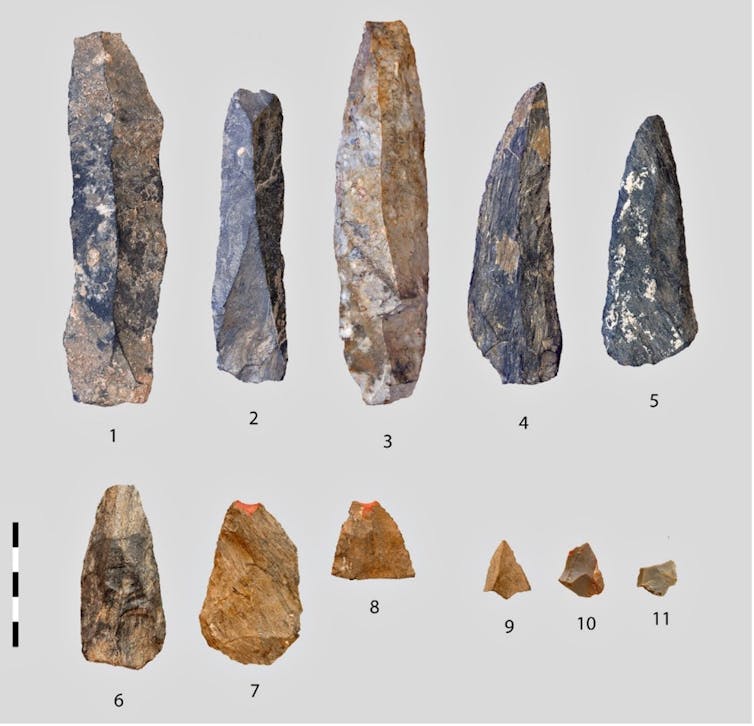

C’est dans ce contexte que notre équipe internationale, dirigée par Andrei I. Krivoshapkin, a identifié dans les couches les plus anciennes de minuscules pointes de projectiles triangulaires. Mesurant moins de 2 cm de large et ne pesant que quelques grammes, elles sont impropres par leurs dimensions et leur fragilité à avoir été montées sur des hampes de lances. Leur étroitesse correspond au diamètre (inférieur ou égal à 8 mm) des hampes documentées ethnographiquement sur tous les continents pour les flèches tirées à l’arc droit.

Question de balistique

Les armes perforantes projetées constituent des systèmes complexes dont les éléments ne sont pas interchangeables d’un type d’arme à l’autre, car répondant à des contraintes différentes en intensité et en nature.

L’importante force d’impact des lances tenues ou lancées à la main fait de la robustesse de l’arme un paramètre essentiel, aussi bien en termes d’efficacité que de survie du chasseur, la masse assurant à la fois cette robustesse, la force d’impact et la pénétration. À l’opposé, la pénétration des traits légers tirés à grande distance repose sur leur acuité, car l’énergie cinétique, beaucoup plus faible, procède là essentiellement de leur vitesse, laquelle, à la différence de la masse, décroit très rapidement sur la trajectoire et dans la cible. Cette vitesse ne pouvant être atteinte par la seule extension du bras humain, elle est obligatoirement tributaire de l’emploi d’un instrument de lancer. Les pointes de flèche et celles de lances ou de javelines ne sont donc pas conçues selon les mêmes critères et ne se montent pas sur les même hampes, les dimensions et le degré d’élasticité desquelles sont par ailleurs essentiels en terme balistique. Ainsi, comme en paléontologie où la forme d’une dent révèle le type d’alimentation et suggère le mode de locomotion, les caractéristiques d’une armature fournissent des indices sur le type d’arme dont elle est l’élément vulnérant.

Un armement propre à Sapiens ?

Le minuscule gabarit des pointes d’Obi-Rakhmat ne peut être regardé comme un choix par défaut, car non seulement la matière première lithique de bonne qualité dont on a tiré de grandes lames ne manque pas à proximité du site, mais l’inventaire des traces d’usage relevées à la loupe binoculaire et au microscope met en évidence au sein du même assemblage des pointes retouchées beaucoup plus robustes (15 à 20 fois plus lourdes et 3 à 4 fois plus épaisses) et du gabarit des têtes de lance ou de javeline.

En retournant à la bibliographie et à nos propres travaux sur des outillages du Paléolithique moyen, nous avons constaté que la présence dans un même ensemble d’armatures de divers types, pour partie microlithiques et produites à cette fin, n’était à ce jour connue que dans les sites à Homo Sapiens. Les plus anciennes occurrences documentées sont en Afrique du Sud dans les couches culturelles Pre-Still Bay (plus de 77 000 ans) et postérieures du gisement de Sibudu. Dans l’univers néanderthalien, les pointes lithiques endommagées par un usage en armature de projectile sont rares, elles sont de fort gabarit et ne se distinguent ni par leurs dimensions, leur facture ou leur type de celles employées à d’autres activités que la chasse, telles que la collecte de végétaux ou la boucherie. Cette distinction dans la conception des outillages et des armements prend valeur de marqueur anthropologique.

En raison de leurs dates respectives, de la distance entre l’Afrique du sud et l’Asie centrale (14 000 km) et de la différence de facture des armatures d’Obi-Rakhmat et de Sibudu (lithique brut de débitage vs lithique façonné ou retouché, osseux façonné), l’hypothèse de foyers d’invention indépendants est la plus vraisemblable.

Des piémonts du Tien Shan à la vallée du Rhône 25 000 plus tard

La seule forme d’armature miniature de projectile identique actuellement connue est beaucoup plus récente. Elle fut découverte par Laure Metz, sur le site de Mandrin, en vallée du Rhône en France, qui livra aussi une dent de lait d’Homo Sapiens déterminée par Clément Zanolli. L’ensemble est daté d’environ 54 000 ans, soit une dizaine de milliers d’années avant la disparition des Néanderthaliens locaux. La similitude des micro-pointes d’Obi-Rakhmat et de Mandrin, pourtant séparées par plus de 6 000 km et 25 millénaires, est telle que les unes et les autres pourraient être interchangées sans qu’aucun autre détail que la roche ne trahisse la substitution.

Des travaux récents publiés par Leonardo Vallini et Stéphane Mazières définissent le Plateau perse, à la périphérie nord-est duquel est situé Obi-Rakhmat, comme un concentrateur de population où les ancêtres de tous les non-Africains actuels vécurent entre les premières phases de l’expansion hors d’Afrique – donc bien avant le Paléolithique supérieur – et la colonisation plus large de l’Eurasie. Cet environnement riche en ressources pourrait avoir constitué une zone de refuge propice à une régénération démographique après le goulet d’étranglement génétique de la sortie d’Afrique, à l’interaction entre les groupes et par conséquent aux innovations techniques.

Mandrin et Obi-Rakhmat représentent probablement deux extrémités géographiques et temporelles d’une phase pionnière de peuplement telle qu’entrevue par Ludovic Slimak, marquée par ce que les typologues qualifiaient jadis de fossile directeur et qui ici recouvrirait la propagation d’une invention fondamentale propre à Homo Sapiens. Jusqu’à présent passées inaperçues parce que brutes de débitage, minuscules et fragmentaires, il est à parier que les micro-pointes de projectile dont les critères de reconnaissance sont maintenant posés commenceront à apparaître dans des sites intermédiaires entre l’Asie centrale et la Méditerranée occidentale.

Prémisses d’un nouveau scénario du peuplement occidental d’Homo Sapiens

Cette découverte est stimulante à plusieurs titres. Elle valide la cohérence de l’étude du site de Mandrin qui concluait à une brève incursion en territoire néanderthalien de Sapiens armés d’arcs, mais dont plusieurs éléments avaient été critiqués – ce qui est cependant le jeu scientifique habituel lorsqu’une proposition nouvelle s’écarte par trop des connaissances admises – et dont la dimension prédictive n’avait alors pas été considérée.

La similitude des micro-pointes de Mandrin et d’Obi-Rakhmat ne peut être une simple coïncidence. Elle ne porte pas seulement sur leur forme, mais aussi sur leur mode de fabrication, qui requière un réel savoir-faire comme en témoigne la préparation minutieuse de leur plan de frappe avant débitage, et sur leur fonctionnement. On pourra débattre de l’instrument approprié au tir de flèche armées de si minuscules armatures, l’arc étant en filigrane, ou si l’on préfère garder une certaine réserve ne parler que de tir instrumenté, mais cela contraste déjà avec ce que l’on connait des armes de chasse de Néanderthal et de leur conception.

L’autre aspect remarquable, encore peu habituel, est la convergence et la complémentarité de données provenant de la culture matérielle et de la mémoire de nos gènes, qui ne purent s’influencer au regard des dates d’étude et de publication respectives. Les deux conjuguées esquissent la réécriture du scénario de l’arrivée d’Homo Sapiens en Europe : on le pensait venu directement d’Afrique par le chemin le plus court, il y a 45 000 ans, et on le découvre implanté depuis fort longtemps au cœur du continent eurasiatique, bien avant qu’il n’en sorte en quête de nouveaux territoires.

Plisson Hugues a reçu des financements du CNRS et de l'université de Bordeaux

Andrey I. Krivoshapkin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.