18.11.2025 à 16:13

Pour prédire si un volcan sera effusif ou explosif, il faut s’intéresser à ses bulles

Texte intégral (1771 mots)

Une étude publiée très récemment dans la revue « Science » permet de mieux comprendre le moteur des éruptions volcaniques : la formation des bulles dans le magma.

Les observations faites depuis des décennies dans diverses régions du monde montrent que les éruptions volcaniques sont caractérisées par deux types de comportement en surface. D’un côté du spectre, le magma qui remonte depuis les profondeurs de la Terre est émis calmement sous forme de coulées ou de dômes de lave, caractérisant ainsi le style « effusif ». C’est le cas des volcans d’Hawaï ou de La Réunion dont les éruptions quasi annuelles font souvent l’actualité dans les médias.

À l’opposé, un mélange turbulent de gaz et de cendres est éjecté violemment dans l’atmosphère, définissant ainsi le style « explosif ». Le mélange forme un panache qui s’élève dans un premier temps à des altitudes pouvant atteindre 40-50 kilomètres et qui finit souvent par s’effondrer sous l’effet de la gravité pour former des nuées ardentes dévastatrices qui se propagent à haute vitesse le long du sol. Un exemple célèbre est l’éruption du Vésuve en l’an 79 de notre ère qui détruisit les villes de Pompéi et d’Herculanum.

Les données collectées par les scientifiques montrent que le comportement d’un volcan comme le Vésuve peut changer au cours du temps, alternant les périodes effusives et explosives, à cause de variations de la nature des magmas et des conditions de stockage en profondeur. Dans ce contexte, comprendre les mécanismes fondamentaux des éruptions volcaniques afin de mieux prédire leurs conséquences est un enjeu sociétal et environnemental majeur compte-tenu qu’environ 600 millions de personnes dans le monde vivent dans des zones potentiellement touchées par les aléas volcaniques.

Comprendre l’origine des bulles dans le magma

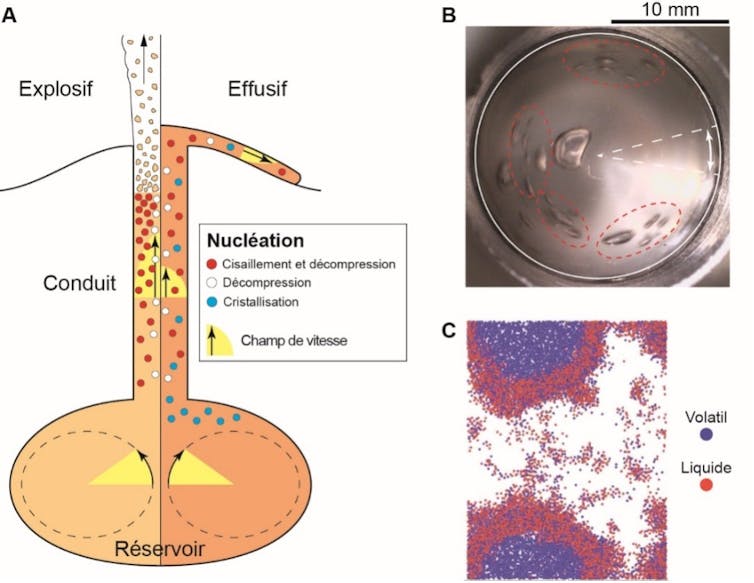

Le moteur des éruptions volcaniques est la formation des bulles de gaz dans le magma. En particulier, la temporalité de la formation puis de la croissance des bulles, le volume qu’elles occupent et leur capacité à ne pas se séparer du liquide magmatique contrôlent la dynamique de la remontée du mélange dans le conduit volcanique vers la surface et, au final, le style éruptif décrit ci-dessus (Figure 1A). C’est dans ce cadre que nous avons mené une étude pour mieux comprendre l’origine de la formation des bulles, un phénomène appelé « nucléation ». Les résultats de nos travaux ont été publiés le 6 novembre dans la revue Science.

Jusqu’à présent, les volcanologues ont considéré que la nucléation des bulles était déclenchée principalement par la décompression du magma saturé en gaz dissous (essentiellement de la vapeur d’eau) lors de l’ascension dans le conduit. En effet, chacun a déjà constaté l’effet produit par l’ouverture trop rapide d’une bouteille de boisson gazeuse : lorsque la pression chute, le liquide qui contient du gaz dissous (CO2 dans ce cas) devient sursaturé, et des bulles de gaz se forment alors rapidement, croissent, et entraînent le liquide vers le goulot de la bouteille. Au cours de la nucléation, la différence de pression entre un embryon de bulle et le liquide est connue comme une source d’énergie mécanique qui contribue à faire croître l’amas gazeux alors que la tension superficielle du liquide s’y oppose, et au-delà d’une taille critique, l’embryon devient une bulle qui croît spontanément.

Or, les différences de vitesse au sein d’un magma en mouvement génèrent des forces dites de cisaillement qui pourraient être une autre source d’énergie mécanique apte à déclencher la nucléation. C’est le cas en particulier dans un conduit volcanique en raison d’une différence de vitesse entre les bords, où le frottement est important, et le centre (Figure 1A).

L’importance des forces de cisaillement

Nous avons testé cette hypothèse au moyen d’expériences dites analogiques, réalisées dans des conditions de température et avec des matériaux différents de ceux dans la nature. Les expériences sont faites dans un rhéomètre, un équipement utilisé pour mesurer la capacité des fluides à se déformer. Ce dispositif permet de cisailler une couche d’oxyde de polyéthylène liquide à 80 °C et sursaturé en CO2, laquelle simule le magma dans la nature. Les expériences montrent que la nucléation de bulles de gaz est déclenchée lorsque la force de cisaillement appliquée atteint une valeur seuil qui décroît avec la teneur en CO2 (Figure 1B). De plus, le cisaillement cause le rapprochement puis l’agglomération en de plus grosses bulles et ainsi leur croissance. Nos données expérimentales sont en accord avec un modèle qui indique que la taille minimale pour qu’un embryon de bulle puisse croître est de près d’un millionième de millimètre. Ces résultats sont complétés par des simulations moléculaires qui confirment que la nucléation se produit si le cisaillement est suffisamment fort (Figure 1C).

Nous avons finalement extrapolé nos résultats aux systèmes volcaniques en tenant compte du rapport des pressions mises en jeu et des propriétés des magmas. L’analyse montre que la nucléation par cisaillement peut se produire dans un conduit dans presque tous les cas, et nous en tirons deux conclusions principales. La première est qu’un magma pauvre en gaz dissous, et donc a priori non explosif, pourrait néanmoins conduire à une éruption violente en raison d’un important cisaillement causant une nucléation massive. La seconde est qu’une nucléation efficace dans un magma très visqueux et très riche en gaz dissous, couplée à la décompression lors de la remontée et à une agglomération et à une croissance rapide des bulles, peut conduire à la formation de chenaux de dégazage connecté à la surface et engendrer, paradoxalement, une éruption non violente. Ce processus peut être renforcé lorsque la nucléation se produit à proximité de bulles préexistantes, comme le montrent nos expériences. Ce mécanisme explique l’observation contre-intuitive faite depuis longtemps par les volcanologues selon laquelle les magmas très visqueux et contenant de fortes teneurs en gaz dissous peuvent produire des éruptions effusives.

Nos travaux suggèrent que la nucléation induite par cisaillement doit désormais être intégrée aux modèles mathématiques de conduits volcaniques développés par les volcanologues et qui permettent de prédire les dynamismes éruptifs. En couplant cette approche à d’autres modèles qui simulent des coulées de la lave, des panaches ou des nuées ardentes, il est ainsi possible de définir les zones potentiellement atteintes par les produits des éruptions. Cette tâche est essentielle pour la gestion des risques naturels et pour la protection des populations qui vivent à proximité des volcans actifs.

Olivier Roche a reçu des financements du programme I-SITE CAP 20-25 piloté par l'UCA.

Jean-Michel Andanson a reçu des financements ANR, CNRS, Université Clermont Auvergne, commission européenne, Fond national Suisse.

17.11.2025 à 16:02

Elon Musk a raison de dire que Wikipédia est biaisé, mais Grokipedia et l’IA ne feront pas mieux

Texte intégral (2458 mots)

Grokipedia, le nouveau projet d’Elon Musk, mis en ligne le 27 octobre 2025, promet plus de neutralité que Wikipédia. Pourtant, les modèles d’IA sur lesquels il repose restent marqués par les biais de leurs données.

La société d’intelligence artificielle d’Elon Musk, xAI, a lancé, le 27 octobre 2025, la version bêta d’un nouveau projet destiné à concurrencer Wikipédia, Grokipedia. Musk présente ce dernier comme une alternative à ce qu’il considère être « le biais politique et idéologique » de Wikipédia. L’entrepreneur promet que sa plateforme fournira des informations plus précises et mieux contextualisées grâce à Grok, le chatbot de xAI, qui générera et vérifiera le contenu.

A-t-il raison ? La problématique du biais de Wikipédia fait débat depuis sa création en 2001. Les contenus de Wikipédia sont rédigés et mis à jour par des bénévoles qui ne peuvent citer que des sources déjà publiées, puisque la plateforme interdit toute recherche originale. Cette règle, censée garantir la vérifiabilité des faits, implique que la couverture de Wikipédia reflète inévitablement les biais des médias, du monde académique et des autres institutions dont elle dépend.

Ces biais ne sont pas uniquement politiques. Ainsi, de nombreuses recherches ont montré un fort déséquilibre entre les genres parmi les contributeurs, dont environ 80 % à 90 % s’identifient comme des hommes dans la version anglophone. Comme la plupart des sources secondaires sont elles aussi majoritairement produites par des hommes, Wikipédia tend à refléter une vision plus étroite du monde : un dépôt du savoir masculin plutôt qu’un véritable panorama équilibré des connaissances humaines.

Le problème du bénévolat

Sur les plateformes collaboratives, les biais tiennent souvent moins aux règles qu’à la composition de la communauté. La participation volontaire introduit ce que les sciences sociales appellent un « biais d’autosélection » : les personnes qui choisissent de contribuer partagent souvent des motivations, des valeurs et parfois des orientations politiques similaires.

De la même manière que Wikipédia dépend de cette participation volontaire, c’est aussi le cas de Community Notes, l’outil de vérification des faits de Musk sur X (anciennement Twitter). Une analyse que j’ai menée avec des collègues montre que sa source externe la plus citée, après X lui-même, est en réalité Wikipédia.

Les autres sources les plus utilisées se concentrent elles aussi du côté des médias centristes ou orientés à gauche. Elles reprennent la même liste de sources « approuvées » que Wikipédia ; c’est-à-dire précisément le cœur des critiques de Musk adressées à l’encyclopédie ouverte en ligne. Pourtant, personne ne reproche ce biais à Musk.

Wikipédia reste au moins l’une des rares grandes plateformes à reconnaître ouvertement ses limites et à les documenter. La recherche de la neutralité y est inscrite comme l’un de ses cinq principes fondateurs. Des biais existent, certes, mais l’infrastructure est conçue pour les rendre visibles et corrigibles.

Les articles contiennent souvent plusieurs points de vue, traitent des controverses et même consacrent des sections entières aux théories complotistes, comme celles entourant les attentats du 11-Septembre. Les désaccords apparaissent dans l’historique des modifications et sur les pages de discussion, et les affirmations contestées sont signalées. La plateforme est imparfaite mais autorégulée, fondée sur le pluralisme et le débat ouvert.

L’IA est-elle impartiale ?

Si Wikipédia reflète les biais de ses contributeurs humains et des sources qu’ils mobilisent, l’IA souffre du même problème avec ses données d’entraînement. Grokipedia : Elon Musk a raison de dire que Wikipédia est biaisée, mais son alternative fondée sur l’IA ne fera pas mieux

Les grands modèles de langage (LLM) utilisés par Grok sont formés sur d’immenses corpus issus d’Internet, comme les réseaux sociaux, les livres, les articles de presse et Wikipédia elle-même. Des études ont montré que ces modèles reproduisent les biais existants – qu’ils soient de genre, d’ordre politique ou racial – présents dans leurs données d’entraînement.

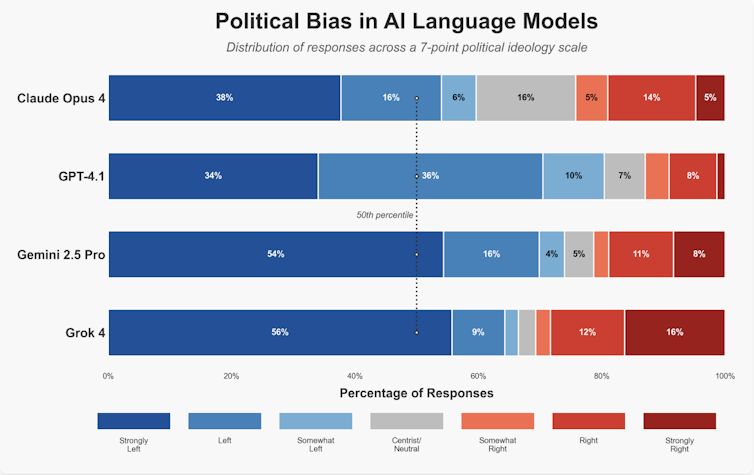

Musk affirme que Grok a été conçu pour contrer de telles distorsions, mais Grok lui-même a été accusé de partialité. Un test, dans laquelle quatre grands modèles de langage ont été soumis à 2 500 questions politiques, semble montrer que Grok est plus neutre politiquement que ses rivaux, mais présente malgré tout un biais légèrement orienté à gauche (les autres étant davantage marqués à gauche).

Si le modèle qui soustend Grokipedia repose sur les mêmes données et algorithmes, il est difficile d’imaginer comment une encyclopédie pilotée par l’IA pourrait éviter de reproduire les biais que Musk reproche à Wikipédia. Plus grave encore, les LLM pourraient accentuer le problème. Ceux-ci fonctionnent de manière probabiliste, en prédisant le mot ou l’expression la plus probable à venir sur la base de régularités statistiques, et non par une délibération entre humains. Le résultat est ce que les chercheurs appellent une « illusion de consensus » : une réponse qui sonne de manière autoritaire, mais qui masque l’incertitude ou la diversité des opinions.

De ce fait, les LLM tendent à homogénéiser la diversité politique et à privilégier les points de vue majoritaires au détriment des minoritaires. Ces systèmes risquent ainsi de transformer le savoir collectif en un récit lisse mais superficiel. Quand le biais se cache sous une prose fluide, les lecteurs peuvent même ne plus percevoir que d’autres perspectives existent.

Ne pas jeter le bébé avec l’eau du bain

Cela dit, l’IA peut aussi renforcer un projet comme Wikipédia. Des outils d’IA contribuent déjà à détecter le vandalisme, à suggérer des sources ou à identifier des incohérences dans les articles. Des recherches récentes montrent que l’automatisation peut améliorer la précision si elle est utilisée de manière transparente et sous supervision humaine.

L’IA pourrait aussi faciliter le transfert de connaissances entre différentes éditions linguistiques et rapprocher la communauté des contributeurs. Bien mise en œuvre, elle pourrait rendre Wikipédia plus inclusif, efficace et réactif sans renier son éthique centrée sur l’humain.

De la même manière que Wikipédia peut s’inspirer de l’IA, la plate-forme X pourrait tirer des enseignements du modèle de construction de consensus de Wikipédia. Community Notes permet aux utilisateurs de proposer et d’évaluer des annotations sur des publications, mais sa conception limite les discussions directes entre contributeurs.

Un autre projet de recherche auquel j’ai participé a montré que les systèmes fondés sur la délibération, inspirés des pages de discussion de Wikipédia, améliorent la précision et la confiance entre participants, y compris lorsque cette délibération implique à la fois des humains et une IA. Favoriser le dialogue plutôt que le simple vote pour ou contre rendrait Community Notes plus transparent, pluraliste et résistant à la polarisation politique.

Profit et motivation

Une différence plus profonde entre Wikipédia et Grokipedia tient à leur finalité et, sans doute, à leur modèle économique. Wikipédia est géré par la fondation à but non lucratif Wikimedia Foundation, et la majorité de ses bénévoles sont motivés avant tout par l’intérêt général. À l’inverse, xAI, X et Grokipedia sont des entreprises commerciales.

Même si la recherche du profit n’est pas en soi immorale, elle peut fausser les incitations. Lorsque X a commencé à vendre sa vérification par coche bleue, la crédibilité est devenue une marchandise plutôt qu’un gage de confiance. Si le savoir est monétisé de manière similaire, le biais pourrait s’accentuer, façonné par ce qui génère le plus d’engagements et de revenus.

Le véritable progrès ne réside pas dans l’abandon de la collaboration humaine mais dans son amélioration. Ceux qui perçoivent des biais dans Wikipédia, y compris Musk lui-même, pourraient contribuer davantage en encourageant la participation d’éditeurs issus d’horizons politiques, culturels et démographiques variés – ou en rejoignant eux-mêmes l’effort collectif pour améliorer les articles existants. À une époque de plus en plus marquée par la désinformation, la transparence, la diversité et le débat ouvert restent nos meilleurs outils pour nous approcher de la vérité.

Taha Yasseri a reçu des financements de Research Ireland et de Workday.

17.11.2025 à 16:02

Collaborations art-science : qui ose vraiment franchir les frontières ?

Texte intégral (2171 mots)

Les collaborations entre scientifiques et artistes font régulièrement parler d’elles à travers des expositions intrigantes ou des performances artistiques au sein de laboratoires scientifiques. Mais qu’est-ce qui motive vraiment les chercheuses et les chercheurs à s’associer à des artistes ?

Art et science se sont historiquement nourris mutuellement comme deux manières complémentaires de percevoir le monde.

Considérons ainsi les principaux instituts états-uniens de sciences marines : tous sont dotés d’ambitieux programmes de collaboration art/science, mis en place à partir du tournant des années 2000. Le prestigieux Scripps Institution of Oceanography a, par exemple, développé une collection d’art privée, ouverte au public, pour « refléter des connaissances scientifiques objectives dans des œuvres d’art à la fois réalistes et abstraites ». À l’Université de Washington, des résidences d’artiste sont organisées, au cours desquelles des peintres passent entre un et trois mois au milieu des scientifiques des Friday Harbor Laboratories (une station de recherche en biologie marine), sur l’île reculée de San Juan.

Ces démarches semblent indiquer que les institutions scientifiques sont déjà convaincues du potentiel de la collaboration entre art et science. L’initiative ne vient pas toujours des laboratoires : nombre d’artistes ou de collectifs sollicitent eux-mêmes les chercheurs, que ce soit pour accéder à des instruments, à des données ou à des terrains scientifiques. En France comme ailleurs, plusieurs résidences – au CNRS, à Paris-Saclay ou dans des centres d’art – sont ainsi nées d’une démarche portée d’abord par les artistes.

Mais qu’en est-il des chercheurs eux-mêmes ? ceux-là même qui conçoivent, développent et réalisent les projets de recherche et qui a priori ont une sensibilité artistique qui n’est ni inférieure ni supérieure à la moyenne de la population. Quels sont ceux qui choisissent d’intégrer l’art dans leurs projets scientifiques ? Et pour quoi faire ? Les études disponibles ne sont pas très éclairantes sur le sujet, car elles se sont focalisées sur des scientifiques atypiques, passionnés par l’art et artistes eux-mêmes. Peu de travaux avaient jusqu’ici procédé à un recensement « tout azimuts » des pratiques.

Dans une étude récente, nous avons recensé les pratiques, des plus originales aux plus banales, en analysant plus de 30 000 projets de recherche financés par la National Science Foundation (NSF) aux États-Unis entre 2003 et 2023, dans les domaines des géosciences et de la biologie.

Une analyse textuelle du descriptif des projets permet de sortir de l’anecdotique pour révéler des tendances structurelles inédites. Cette source comporte toutefois des biais possibles : les résumés de projets sont aussi des textes de communication, susceptibles d’amplifier ou d’édulcorer les collaborations art/science. Pour limiter ces écarts entre discours et réalité, nous combinons analyse contextuelle des termes artistiques, comparaison temporelle et vérification qualitative des projets. Ce croisement permet de distinguer les effets d’affichage des pratiques réellement intégrées.

En France aussi, les initiatives art/science existent mais restent dispersées, portées par quelques laboratoires, universités ou centres d’art, sans base de données centralisée permettant une analyse systématique. Nous avons donc choisi les États-Unis, car la NSF fournit depuis vingt ans un corpus homogène, public et massif de résumés de projets, rendant possible un recensement large et robuste des collaborations art/science.

Trois façons d’associer les artistes

Pour commencer, les collaborations entre art et science sont très rares : moins de 1 % des projets ! Ce chiffre reste toutefois une estimation basse, car il ne capture que les collaborations déclarées par les chercheurs dans des projets financés : nombre d’initiatives impulsées par des artistes ou des collectifs échappent à ces bases de données. En revanche, leur fréquence a augmenté sans discontinuer sur les vingt années d’observation.

En analysant plus finement les projets, on peut identifier que l’artiste peut y jouer trois grands rôles. D’abord, il peut être un disséminateur, c’est-à-dire qu’il aide à diffuser les résultats auprès du grand public. Il ne contribue pas vraiment à la recherche mais joue le rôle d’un traducteur sans qui l’impact des résultats du projet serait moindre. C’est, par exemple, la mise sur pied d’expositions ambulantes mettant en scène les résultats du projet.

Ensuite, l’artiste peut intervenir comme éducateur. Il intervient alors en marge du projet, pour faire connaître un domaine scientifique auprès des enfants, des étudiants, ou de communautés marginalisées. L’objectif est de profiter d’un projet de recherche pour faire connaître un domaine scientifique de manière plus générale et susciter des vocations. Par exemple, l’un des projets prévoyait la collaboration avec un dessinateur de bande dessinée pour mieux faire connaître aux enfants les sciences polaires.

Enfin, dans des cas beaucoup plus rares, les artistes jouent un rôle de cochercheurs. Le recours au travail artistique participe alors à la construction même des savoirs et/ou des méthodes. Par exemple, un des projets réunissait des artistes et des chercheurs en neurosciences pour concevoir de nouvelles façons de visualiser les circuits nerveux du cerveau, et in fine créer de nouvelles formes de données scientifiques.

Ces différentes formes reflètent une tension encore vive dans le monde académique : l’art est majoritairement mobilisé pour « faire passer » la science, plutôt que pour nourrir la recherche elle-même. Pourtant, les projets les plus ambitieux laissent entrevoir un potentiel plus grand : celui d’une science transformée par le dialogue avec d’autres formes de connaissance.

Cette réflexion fait également écho à des considérations plus générales sur la complémentarité entre l’art et la science, non pas comme des disciplines opposées, mais comme deux approches différentes pour questionner le monde. Comme le formulait joliment un article publié dans The Conversation, il s’agit moins d’opposer l’art à la science que de leur permettre de « faire l’amour, pas la guerre », c’est-à-dire de collaborer pour produire de nouvelles formes de compréhension et d’engagement citoyen.

Au-delà de ces différentes façons d’associer les artistes à un projet, notre étude montre également que ces collaborations ne sont pas réparties au hasard. Certains scientifiques les pratiquent bien plus que d’autres, en fonction de leurs caractéristiques personnelles, leur contexte institutionnel et enfin les objectifs scientifiques de leur projet.

Une science plus ouverte… mais pas partout

Première surprise : ce ne sont pas les universités les plus prestigieuses qui s’ouvrent le plus à l’art. Au contraire, ce sont les institutions les moins centrées sur la recherche dite « pure » qui s’y engagent plus largement. Ces établissements s’appuient probablement sur l’art pour conduire des projets plutôt éducatifs, visant essentiellement à faire connaître la science au plus grand nombre.

Deuxième enseignement : les femmes scientifiques sont bien plus nombreuses que leurs homologues masculins à s’engager dans ces démarches. Cette surreprésentation est à rapprocher d’autres résultats montrant que les femmes scientifiques sont en moyenne plus engagées dans les activités de vulgarisation que les hommes – qui, eux, ont tendance à investir plus exclusivement les domaines supposés plus prestigieux, notamment ceux liés à la publication purement académique.

Ce biais de genre, loin d’être anecdotique, soulève des questions sur la manière dont la reconnaissance académique valorise (ou ignore) certains types d’engagement. Incidemment, ce résultat suggère aussi que promouvoir et financer des collaborations entre art et science serait un moyen a priori efficace de rééquilibrer les différences régulièrement constatées entre hommes et femmes.

L’art, catalyseur d’impact sociétal, mais pas sur tous les sujets

Alors que l’on demande de plus en plus aux scientifiques de démontrer l’impact de leurs travaux sur la société, beaucoup se trouvent mal préparés à cette tâche. Peintres, sculpteurs, écrivains, photographes, etc., ont l’habitude de s’adresser à un public large, de captiver l’attention et déclencher les émotions qui garantissent une impression. Leur interprétation du travail et des résultats scientifiques peut ainsi accroître la visibilité des recherches et susciter le changement. On pourrait donc s’attendre à ce que les projets les plus orientés vers des objectifs sociétaux ambitieux aient plus souvent recours aux artistes.

C’est globalement le cas, mais avec toutefois de grosses différences selon les défis sociétaux concernés, que nous avons classés suivants les grands objectifs de développement durable (ODD) édictés par l’ONU. Notamment, la collaboration art/science est bien plus fréquente dans les projets portant sur la biodiversité marine (ODD 14 « Vie aquatique ») que dans ceux axés sur l’action climatique (ODD 13).

Cette différence s’explique probablement en partie par la grande difficulté à rendre visibles ou compréhensibles certains phénomènes plutôt lointains de la vie quotidienne du grand public : l’acidification des océans, la dégradation des écosystèmes marins, etc. Le travail artistique permet de mobiliser les sens, créer des émotions, des narrations, des imaginaires, qui vont faciliter les prises de conscience et mobiliser les citoyens ou les pouvoirs publics. Bref, il va augmenter l’impact sociétal de la recherche sur ces sujets.

Lever les freins : une affaire de politiques scientifiques

Comment expliquer que ces collaborations restent somme toute très marginales dans le monde de la recherche ? Des défis persistent, tels que le manque de financements qui y sont consacrés ou le cloisonnement disciplinaire des recherches. En outre, l’incitation à explorer ces frontières reste très faible pour les chercheurs, dans un monde académique où la production de publications dans des revues spécialisées reste le critère de performance essentiel.

Intégrer l’art à un projet scientifique nécessite du temps, de la confiance et un changement de posture, souvent perçu comme risqué dans un milieu académique très normé. Mais des solutions existent sans doute : il s’agirait de former mieux les scientifiques à la collaboration, de financer des projets transdisciplinaires et de changer les critères d’évaluation de la recherche, pour valoriser les prises de risque.

À l’heure où la science est appelée à jouer un rôle majeur dans la transition écologique et sociale, l’art ne doit plus être considéré comme un simple emballage esthétique : il pourrait devenir un allié stratégique ! Il ne s’agit pas uniquement de « vulgariser » la science, mais bien de la faire résonner autrement dans les imaginaires, les émotions et les débats publics.

En écoutant celles et ceux qui osent franchir les murs du laboratoire, nous comprendrons peut-être mieux comment faire de la science de manière plus sensible, plus accessible et surtout plus transformatrice.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.