01.02.2026 à 13:51

Pourquoi le choix de Donald Trump pour la présidence de la Fed a-t-il fait chuter l’or et l’argent ?

Henry Maher, Lecturer in Politics, Department of Government and International Relations, University of Sydney

Texte intégral (1811 mots)

Alors que Donald Trump multiplie les attaques contre la Fed, le choix de Kevin Warsh peut être lu comme un signal paradoxal envoyé aux marchés : préserver, malgré tout, la crédibilité de la politique monétaire américaine dans un monde en recomposition.

Après des mois de spéculations, Donald Trump a confirmé qu’il nommerait Kevin Warsh au poste de prochain président de la Réserve fédérale. Cette nomination était très attendue dans le contexte du conflit persistant entre le président américain et la Fed, ainsi que de ses tensions avec l’actuel président de l’institution, Jerome Powell.

L’annonce a provoqué une réaction immédiate sur les marchés, avec un net décrochage de l’or et de l’argent. Après plusieurs mois de records et de valorisations étirées, les prix au comptant de l’or et de l’argent ont chuté respectivement de 9 % et de 28 %. Le marché boursier américain a également reculé, les principaux indices enregistrant tous des pertes modérées.

Mais dans le climat de défiance suscité par les tentatives d’ingérence de Donald Trump à l’égard de la Fed, ce décrochage des marchés peut, ironiquement, se lire comme un premier signal de confiance accordé à Kevin Warsh, semblant valider sa légitimité pour le poste et miser sur son indépendance future.

Pour saisir cette apparente contradiction, il faut la replacer dans le cadre du bras de fer de longue date entre Trump et la Réserve fédérale et prendre en compte le rôle crucial que joue l’indépendance des banques centrales dans l’architecture financière mondiale contemporaine.

La guerre de Trump contre la Fed

L’année écoulée a été marquée par un affrontement sans précédent entre le président états-unien et la Réserve fédérale. Donal Trump avait lui-même nommé l’actuel président de la Fed, Jerome Powell, en 2017. Mais la relation s’est rapidement détériorée lorsque Powell n’a pas abaissé les taux d’intérêt aussi rapidement que Trump l’exigeait. Fidèle à son style outrancier, Donald Trump a depuis traité Powell de « clown » souffrant de « sérieux problèmes mentaux », ajoutant : « J’adorerais le virer ».

Cette guerre de mots a finalement glissé vers le terrain judiciaire. Le Department of Justice a annoncé l’ouverture d’une enquête visant la gouverneure de la Fed Lisa Cook, soupçonnée de fraude liée à d’anciens documents de prêts immobiliers. Puis, le mois dernier, dans une escalade spectaculaire, le ministère de la Justice a ouvert une enquête pénale retentissante contre Jerome Powell, portant sur des soupçons de dépenses excessives lors de la rénovation des bâtiments de la Réserve fédérale.

Les deux séries d’accusations sont largement considérées comme dénuées de fondement. Donald Trump a néanmoins tenté de s’appuyer sur cette enquête pour justifier le limogeage de Lisa Cook. L’affaire est actuellement examinée par la Cour suprême des États-Unis.

Jerome Powell a vivement répliqué à Trump, affirmant que ces menaces judiciaires étaient :

« la conséquence du fait que la Réserve fédérale fixe les taux d’intérêt sur la base de ce que nous estimons, en toute indépendance, être dans l’intérêt général, plutôt qu’en fonction des préférences du président ». Jerome Powell a reçu le soutien de 14 dirigeants de banques centrales à travers le monde, qui ont rappelé que « l’indépendance des banques centrales est un pilier de la stabilité des prix, financière et économique ».

Par le passé, les ingérences présidentielles dans les affaires de la Fed ont été l’un des facteurs majeurs de la crise de stagflation des années 1970. Plus récemment, l’Argentine et la Turquie ont toutes deux traversé de graves crises financières provoquées par des atteintes à l’indépendance de leurs banques centrales.

Qui est Kevin Warsh ?

Kevin Warsh est un ancien banquier et ex-gouverneur de la Réserve fédérale. Il a également exercé les fonctions de conseiller économique auprès de deux présidents américains : George W. Bush et Donald Trump.

Dans un premier temps, le président américain semblait plutôt enclin à choisir l’actuel directeur du National Economic Council, Kevin Hassett. Mais ce dernier était largement perçu comme trop étroitement aligné sur Trump, ce qui a ravivé les craintes d’une remise en cause de l’indépendance de la Fed. Kevin Warsh présente un profil plus indépendant et bénéficie d’une réputation de « faucon » en matière de lutte contre l’inflation.

Qu’est-ce qu’un « faucon » ?

La Réserve fédérale est chargée de fixer les taux d’intérêt aux États-Unis. Schématiquement, des taux bas peuvent stimuler la croissance économique et l’emploi, mais au risque d’alimenter l’inflation. À l’inverse, des taux élevés permettent de contenir l’inflation, au prix d’un ralentissement de l’activité et d’une hausse du chômage.

Trouver le juste équilibre entre ces objectifs constitue le cœur de la mission de la Réserve fédérale. L’indépendance des banques centrales est cruciale pour que cet arbitrage délicat repose sur les meilleures données disponibles et sur les besoins de long terme de l’économie, plutôt que sur des objectifs politiques à court terme.

On qualifie de « faucon » anti-inflation un banquier central qui donne la priorité à la lutte contre la hausse des prix, par opposition à une « colombe », davantage encline à privilégier la croissance économique et l’emploi.

Lors de son précédent passage à la Réserve fédérale, Kevin Warsh s’est forgé une solide réputation de « faucon » en matière d’inflation. Même au lendemain de la crise financière mondiale de 2008, Warsh se montrait davantage préoccupé par les risques inflationnistes que par la situation de l’emploi.

Au regard des conflits passés entre Donald Trump et Jerome Powell autour de la baisse des taux d’intérêt, le choix de Warsh peut donc, à première vue, surprendre.

Plus récemment toutefois, Kevin Warsh a infléchi sa position, reprenant à son compte les critiques de Trump à l’égard de la Fed et ses appels à des taux d’intérêt plus bas, dans la lignée de tribunes dénonçant le pilotage actuel de l’institution. Reste à savoir si cet alignement perdurera, ou si ses réflexes de faucon reprendront le dessus, au risque de raviver à terme un nouveau conflit avec Trump.

La réaction des marchés

Le décrochage de l’or et de l’argent, ainsi que le repli des marchés boursiers, suggèrent que les investisseurs jugent désormais des baisses de taux moins probables avec Kevin Warsh qu’avec d’autres candidats potentiels.

Les prix de l’or et de l’argent ont tendance à grimper en période d’instabilité ou lorsque les craintes d’inflation s’accentuent.

Les précédents records s’expliquaient par une combinaison de facteurs, parmi lesquels l’instabilité géopolitique, les inquiétudes autour de l’indépendance de la Fed et une dynamique spéculative marquée.

Le fait que l’annonce de la nomination de Warsh ait déclenché une correction sur les métaux précieux indique que les investisseurs anticipent une inflation plus faible et une plus grande stabilité financière. La hausse concomitante du dollar américain vient conforter cette lecture.

La crédibilité de la Fed est en jeu

Ces dernières semaines ont été rythmées par de nombreux débats sur l’évolution de l’ordre mondial. Le Premier ministre canadien Mark Carney a ainsi récemment acté la fin de l’ordre international fondé sur des règles, appelant à s’affranchir de « l’hégémonie américaine ».

La domination mondiale du dollar américain demeure l’un des fondements centraux de cette puissance économique. Si Donald Trump reste ouvertement méfiant à l’égard de l’indépendance des banques centrales, le choix de Kevin Warsh laisse penser qu’il a conscience de l’enjeu que représente la crédibilité de la monnaie américaine et de la Réserve fédérale.

Rien ne garantit toutefois que cette lucidité suffira à contenir durablement son penchant pour l’ingérence dans la conduite de la politique monétaire.

Henry Maher ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

01.02.2026 à 10:19

Camions à hydrogène vert : une voie sans issue pour décarboner le fret routier ?

Julien Lafaille, PhD student, Energy Management, GEM

Texte intégral (2064 mots)

Sur les routes européennes, les camions à hydrogène sont de plus en plus nombreux. Le développement de la filière est en effet généreusement subventionné. Mais si l’hydrogène vert est présenté comme une solution idéale de décarbonation du transport lourd routier, ce potentiel est largement exagéré.

Presque tous les secteurs industriels européens ont réussi à diminuer leurs émissions de gaz à effet de serre (GES) depuis 1990. Tous, sauf celui des transports, dont les émissions continuent de grimper, malgré l’objectif de neutralité carbone d’ici à 2050 fixé par la Commission européenne.

Le transport lourd routier, en particulier, est très difficile à décarboner. Pour y parvenir, trois leviers potentiels sont mobilisables : l’innovation technologique (dont les camions à batterie et à hydrogène, avec une pile à combustible à la place d’un moteur diesel), le transfert vers le rail ou le maritime, et une logistique plus efficace.

Ce sont les camions à pile à combustible (CPC) qui nous intéressent ici : leur intérêt réside principalement dans leurs avantages par rapport aux camions à batterie électrique. Ces derniers sont plus lourds, manquent encore d’autonomie et prennent longtemps à recharger.

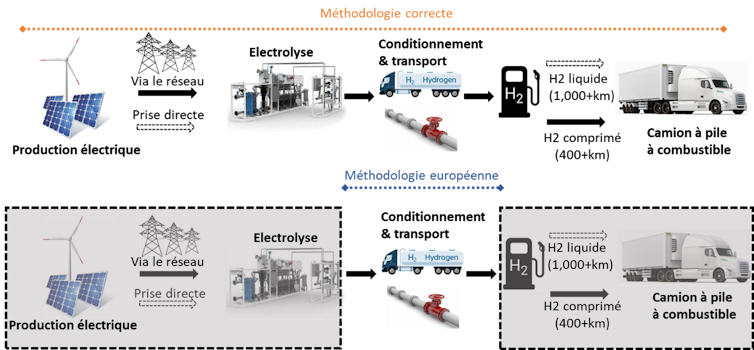

Il existe deux types de CPC : les camions à hydrogène comprimé, qui ont une autonomie d’environ 400 kilomètres et sont déjà commercialisés, et ceux à hydrogène liquide, dont l’autonomie avoisine les 1000 kilomètres mais qui sont encore en développement. L’hydrogène qui les alimente peut être plus ou moins décarboné en fonction de la source d’énergie utilisée.

Nous considérons ici les CPC alimentés par de l’hydrogène vert, obtenu intégralement grâce à de l’électricité d’origine photovoltaïque et/ou éolienne. Les piles à combustible n’émettant que de la vapeur d’eau, la Commission européenne considère les CPC alimentés à l’hydrogène vert comme étant « zéro émission » et subventionne généreusement le développement des infrastructures nécessaires.

Mais la réalité est plus complexe, et ce choix d’investissement très questionnable.

Les infrastructures derrière l’hydrogène « vert »

De quoi est-il ici question ? L’hydrogène vert arrive jusque dans les stations-service à la suite d’une série d’opérations complexes et énergétiquement peu efficaces : électrolyse de l’eau, compression ou liquéfaction, et transport. La pile à combustible reconvertit ensuite dans le camion l’hydrogène en électricité, qui est alors transmise aux roues sous forme d’énergie cinétique.

La production d’hydrogène et son utilisation dans une pile à combustible ne produisent pas de CO2 directement. En revanche, il y a des émissions associées en amont, avec la compression-liquéfaction et le transport, des processus généralement réalisés avec des sources d’énergie carbonées. Ces émissions sont comptabilisées par la Commission européenne, qui considère que l’hydrogène reste vert (ou « renouvelable ») tant qu’il est décarboné à 70 % (ou plus) par rapport à l’hydrogène « gris » (issu du méthane). Dans ce cas, il peut être certifié « renouvelable », et les camions l’utilisant sont considérés « zéro émission ».

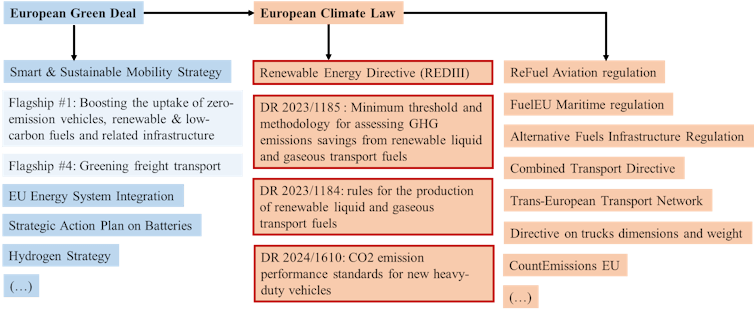

C’est la Commission européenne qui fixe ces règles et définit ce qui est qualifié de « renouvelable » et de « zéro émission », à l’aide de textes législatifs sous-tendus par une méthodologie complexe.

Une méthodologie européenne erronée

Dans cette méthodologie, la Commission européenne affirme notamment que l’électricité provenant de technologies photovoltaïques ou éoliennes est « zéro émission ».

En réalité, le système industriel mondial étant totalement dépendant des énergies fossiles, cette affirmation est fausse. Dans les panneaux solaires comme dans toutes les technologies dites vertes, l’extraction des matériaux nécessaires, les processus de fabrication, leur transport et leur installation impliquent des émissions de gaz à effet de serre considérables.

Qualifier leur production électrique de « zéro émission » peut parfois être une simplification acceptable, mais dans le cas de l’hydrogène vert, il s’agit d’une erreur méthodologique majeure.

En effet, la dette carbone initiale reste associée à la quantité d’énergie utile finale (celle qui fait tourner les roues), même si cette dernière est divisée par quatre environ par rapport à l’énergie en sortie de panneaux solaires ou d’éoliennes. Les émissions, par unité d’énergie utile finale, sont donc multipliées par quatre par rapport à l’énergie électrique initiale. Si l’on fait l’hypothèse que l’éolien et le photovoltaïque sont zéro carbone, on obtient effectivement zéro émissions pour les camions… mais cette hypothèse est fausse. Prendre pour base méthodologique une hypothèse zéro carbone erronée conduit donc à sous-estimer de façon conséquente les émissions associées à l’hydrogène vert.

Un autre problème de la méthodologie européenne est de ne considérer que l’intensité carbone du transport, c’est-à-dire les émissions par tonne-kilomètre (tkm) effectuée, c’est-à-dire au kilomètre pour une tonne de marchandise transportée. Le recours à l’hydrogène vert peut en théorie diminuer considérablement cette intensité, mais la croissance du nombre de tkm prévue en parallèle par la croissance du fret routier pourrait fortement réduire, voire annuler ces gains.

D’un côté, on verdit la tkm, de l’autre, le nombre de tkm augmente. Difficile d’évaluer les émissions totales du fret routier d’ici à 2050 dans ces conditions, mais il est fort probable qu’elles resteront loin du net zéro.

Un gaspillage d’argent public

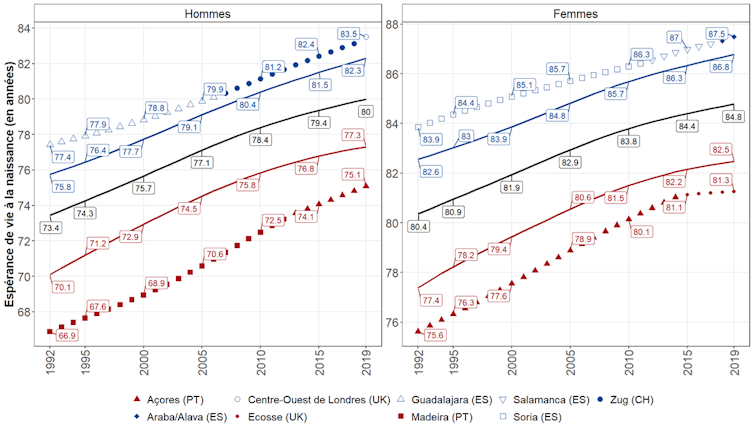

Pour éclaircir le débat, nous avons repris la méthodologie en tenant compte de ces éléments et de la croissance du fret routier anticipée : +50 % d’ici à 2050 par rapport à 2025.

Nous avons considéré ici deux cas de figure : l’une fondée sur de l’hydrogène vert importé du Maroc sous forme liquide, l’autre sur de l’hydrogène vert produit en Europe directement par les stations-service utilisant de l’électricité renouvelable. Les deux étant des voies d’approvisionnement en développement.

Pour résumer, ce qui dépasse la ligne rouge n’est pas aligné avec l’objectif de neutralité carbone européen. Nos résultats mettent en évidence que la méthodologie européenne doit être revue de fond en comble et que les camions à hydrogène vert ne nous aideront pas atteindre la neutralité carbone, et d’autant moins s’ils roulent à l’hydrogène liquide.

Dans ce contexte, les subventions étatiques considérables accordées à la filière sont un gâchis d’argent public et devraient être redirigées vers d’autres leviers plus plausibles : les camions à batterie et à caténaires, le rail, le maritime…

Ces options ont aussi des limites, et nos résultats indiquent que limiter la croissance (voire faire décroître) le secteur du fret routier rendrait sa décarbonation beaucoup plus aisée, quel que soit le levier d’action.

Julien Lafaille ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

01.02.2026 à 10:18

Thaïlande : une démocratie à marée basse

Arnaud Leveau, Docteur en science politique, professeur associé au Master Affaires internationales, Université Paris Dauphine – PSL

Texte intégral (2467 mots)

À l’approche des élections législatives de février 2026, la Thaïlande s’apprête à voter une nouvelle fois dans un cadre démocratique formellement respecté mais politiquement étroit. Derrière le rituel électoral, ce scrutin révèle surtout les limites structurelles d’un système où le changement reste soigneusement borné.

Le 8 février 2026, les Thaïlandais retourneront aux urnes à la suite de la dissolution anticipée du Parlement par le premier ministre sortant Anutin Charnvirakul. Cette décision, motivée par l’impossibilité de consolider une majorité stable et par la menace d’une motion de censure, s’inscrit dans une longue tradition politique nationale : lorsque l’équilibre parlementaire devient trop incertain, la dissolution apparaît comme un moyen de reprendre l’initiative, tout en renvoyant l’arbitrage formel aux électeurs.

La scène est désormais familière. Les campagnes électorales s’ouvrent dans un climat de relative normalité institutionnelle, avec leurs caravanes sillonnant les provinces, leurs promesses économiques diffusées massivement sur les réseaux sociaux et le retour de figures bien connues de la vie politique locale. Pourtant, derrière cette mécanique démocratique bien huilée, persiste une interrogation plus fondamentale : dans quelle mesure le vote peut-il réellement transformer le jeu politique thaïlandais, au-delà du simple renouvellement des équilibres partisans ?

Un pluralisme réel mais étroitement encadré

La vie politique thaïlandaise repose sur une compétition partisane bien réelle, contrairement à l’image parfois caricaturale que l’on donne d’elle dans les médias occidentaux. Les élections sont régulières, pluralistes, relativement bien organisées, et la participation demeure élevée. Cependant, cette compétition s’exerce dans un espace strictement délimité, où certaines réformes et certains débats restent structurellement hors de portée.

Trois forces politiques dominent aujourd’hui le paysage. Le camp gouvernemental, emmené par Anutin Charnvirakul et son parti Bhumjaithai, incarne un conservatisme pragmatique. Plus gestionnaire que réformateur, Anutin se présente comme un homme de compromis, capable de maintenir la stabilité dans un environnement politique fragmenté. Sa stratégie repose sur la continuité des politiques publiques, notamment les programmes de soutien à la consommation et aux territoires, et sur une posture de fermeté mesurée sur les dossiers souverains, en particulier les questions frontalières.

Face à lui, le Parti du peuple (People Party), héritier légal du mouvement réformiste Move Forward, dissous par la Cour constitutionnelle en 2024, cristallise les aspirations d’une jeunesse urbaine, connectée et largement acquise aux idéaux d’une démocratie libérale plus transparente. En tête des sondages, très populaire dans les grandes villes et parmi les classes moyennes éduquées, il demeure toutefois structurellement empêché d’accéder au pouvoir. Son renoncement à la réforme de la loi de lèse-majesté, pourtant au cœur de son identité initiale, illustre les lignes rouges que toute force politique doit intégrer pour espérer survivre dans le système.

Le troisième pôle, le Pheu Thai, longtemps dominant, apparaît aujourd’hui affaibli. Historiquement associé au clan Shinawatra, il a bâti sa puissance sur une combinaison de politiques redistributives et de loyautés rurales. Mais cette formule semble désormais épuisée. Les alliances controversées avec des partis proches de l’armée, l’affaiblissement de ses figures historiques et la transformation sociologique de l’électorat ont érodé sa crédibilité. Son déclin symbolise la fin progressive d’un cycle populiste fondé sur la redistribution des rentes étatiques.

Les verrous institutionnels du changement

Ces équilibres partisans s’inscrivent dans un cadre institutionnel où plusieurs acteurs non élus continuent de peser lourdement sur le jeu politique. L’armée, bien qu’elle n’aspire plus nécessairement à gouverner directement comme par le passé, demeure un acteur central. Elle conserve une influence déterminante sur les questions de sécurité, de budget et de politique étrangère, et se pose en garante ultime de ce qu’elle considère comme les fondements de l’État.

La monarchie, quant à elle, reste le pilier symbolique et politique autour duquel s’organise l’ensemble de l’architecture institutionnelle. Au-delà de son rôle cérémoniel, elle incarne une source de légitimité qui structure profondément les limites du débat public. La loi de lèse-majesté constitue, à cet égard, un marqueur puissant de ce qui peut ou ne peut pas être discuté ouvertement dans l’espace politique.

Enfin, la justice constitutionnelle s’est imposée comme un acteur clé du système. Par ses décisions successives de dissolution de partis et de disqualification de dirigeants élus, elle a démontré sa capacité à arbitrer, voire à redéfinir, les rapports de force politiques. Cette jurisprudence interventionniste contribue à instaurer un climat d’incertitude permanente, où chaque victoire électorale reste conditionnelle, soumise à une validation institutionnelle ultérieure.

L’ensemble de ces mécanismes produit une démocratie fonctionnelle mais conditionnelle : les élections déterminent qui peut gouverner, mais rarement ce qui peut être réformé. Le résultat est une succession de scrutins sans rupture majeure, mais riches d’enseignements sur l’état des relations entre société, partis politiques et institutions.

Une économie sous pression, un débat politique contraint

Le contexte économique renforce ces contraintes politiques. Longtemps considérée comme l’une des économies les plus dynamiques d’Asie du Sud-Est, la Thaïlande affiche désormais une croissance atone, autour de 2 %, nettement inférieure à celle de ses voisins régionaux. La dette des ménages atteint des niveaux préoccupants, limitant la capacité de relance par la consommation, tandis que l’investissement privé peine à repartir.

Le secteur touristique, pilier traditionnel de l’économie nationale, montre également des signes d’essoufflement. Après le rebond post-pandémique, les arrivées de visiteurs internationaux ont marqué le pas, pénalisées par un baht relativement fort, une concurrence régionale accrue et des inquiétudes sécuritaires liées aux tensions frontalières. Les épisodes climatiques extrêmes, notamment les inondations de 2025, ont rappelé la vulnérabilité des infrastructures et renforcé les doutes des investisseurs.

Face à ces défis, les programmes économiques des partis apparaissent largement consensuels et peu différenciés. Tous promettent la transition verte, la numérisation de l’économie et l’innovation technologique. Mais rares sont ceux qui proposent des réformes structurelles ambitieuses, qu’il s’agisse de la remise en cause des oligopoles, de la réforme fiscale ou de la réduction des inégalités régionales. La politique économique thaïlandaise semble ainsi prisonnière d’un conservatisme prudent, qui privilégie la préservation des rentes existantes à la prise de risques politiques.

Une société en mutation lente mais profonde

Les principales dynamiques de transformation se situent peut-être moins dans les partis que dans la société elle-même. La fracture générationnelle est l’un des traits saillants du paysage politique actuel. Une jeunesse urbaine, mondialisée et politisée remet en cause les hiérarchies traditionnelles, réclame davantage de transparence et s’informe massivement via les réseaux sociaux. À l’inverse, une Thaïlande rurale et périurbaine reste attachée à la stabilité, aux hiérarchies locales et aux réseaux clientélistes.

Toutefois, cette opposition binaire tend à s’estomper. Dans les provinces elles-mêmes, les systèmes de patronage traditionnels sont progressivement fragilisés par l’accès à l’éducation, la mobilité sociale et la circulation de l’information. Les grandes familles politiques locales, longtemps dominantes, doivent composer avec une nouvelle génération d’électeurs plus exigeants, moins enclins à voter par habitude ou par loyauté personnelle.

Ces évolutions sont lentes et souvent invisibles à court terme, mais elles s’accumulent. Elles expliquent en partie la résilience de la société civile thaïlandaise, capable de se mobiliser ponctuellement malgré les contraintes institutionnelles et les risques juridiques.

Une élection révélatrice plutôt que décisive

Dans ce contexte, les élections législatives de février 2026 ne devraient pas marquer une rupture politique majeure. Les scénarios possibles sont multiples, mais aucun ne promet de transformation radicale. Une reconduction du camp gouvernemental offrirait une stabilité relative à court terme, sans répondre aux tensions structurelles. Une percée du Parti du Peuple, même significative, se heurterait rapidement aux verrous institutionnels existants. Quant au Pheu Thai, son retour au pouvoir dépendrait de coalitions fragiles, au risque d’accentuer encore la défiance de son électorat.

Ces élections permettront en revanche de mesurer avec précision l’état des forces en présence, l’évolution des attentes sociales et la capacité du système à absorber les frustrations sans basculer dans une nouvelle crise ouverte. Elles constitueront moins un moment de rupture qu’un révélateur des ajustements en cours.

Dans un pays où la politique s’inscrit dans le temps long, chaque scrutin compte moins comme une fin que comme un jalon. La Thaïlande continue d’évoluer à son propre rythme, entre aspirations démocratiques et contraintes institutionnelles, dans une recherche permanente d’équilibre entre autorité, stabilité et souveraineté populaire. Pour l’observateur extérieur, la leçon est peut-être celle de la patience : derrière l’apparente immobilité du système, des transformations lentes mais réelles sont à l’œuvre, appelées à redéfinir, à terme, les contours du jeu politique thaïlandais.

Une élection sous influences régionales et internationales

Si les élections thaïlandaises de février 2026 sont avant tout structurées par des dynamiques internes, elles s’inscrivent aussi dans un environnement régional et international de plus en plus contraignant. La Thaïlande n’évolue pas en vase clos : sa trajectoire politique est étroitement liée aux recompositions en cours en Asie du Sud-Est continentale, aux tensions récurrentes avec ses voisins immédiats et aux rivalités stratégiques entre grandes puissances.

La relation avec le Cambodge constitue à cet égard un révélateur. Les tensions frontalières de 2025, ravivées autour de sites patrimoniaux sensibles et de zones frontalières contestées, ont rappelé combien ces différends restent mobilisables à des fins de politique intérieure, des deux côtés de la frontière. À Bangkok, une posture de fermeté face à Phnom Penh peut servir de levier électoral, en particulier dans un contexte de fragmentation politique et de compétition entre partis conservateurs. Sur ce sujet, les partis conservateurs et le Pheu Thai sont sur la même ligne. Le leader du People Party (réformateur) a également soutenu une ligne par rapport au Cambodge recommandant que les avions de combat Gripen, de fabrication suédoise, dont l’armée thaïlandaise dispose, soient utilisés contre les positions cambodgiennes.

Mais ces tensions ont aussi une portée régionale : elles fragilisent les chaînes économiques transfrontalières, accentuent les déplacements de population et mettent en lumière l’incapacité de l’Association des nations de l’Asie du Sud-Est (Asean) à prévenir ou contenir efficacement les crises entre États membres.

Cette relative impuissance de l’Asean ouvre un espace croissant aux puissances extérieures. La Chine y occupe désormais une place centrale. Premier partenaire commercial de la Thaïlande, acteur clé des infrastructures régionales et garant de facto de la stabilité des corridors continentaux reliant le sud de la Chine au golfe de Thaïlande, Pékin dispose de leviers économiques et politiques que ni Washington ni Bruxelles ne peuvent égaler à court terme. Pour Bangkok, le rapprochement avec la Chine relève moins d’un alignement idéologique que d’un pragmatisme stratégique : sécuriser les investissements, maintenir la croissance et s’assurer d’un environnement régional stable.

Les États-Unis, pour leur part, restent un allié militaire historique, mais leur influence apparaît de plus en plus sectorielle. La coopération de défense demeure robuste, notamment à travers les exercices conjoints et les ventes d’équipements, mais elle pèse moins sur les choix économiques et sociétaux du pays. Cette dissociation croissante entre sécurité et prospérité nourrit une diplomatie thaïlandaise d’équilibriste, cherchant à préserver l’alliance américaine tout en approfondissant des liens structurants avec la Chine.

Quant à l’Union européenne, elle occupe en Thaïlande un rôle principalement économique et normatif, articulé essentiellement pour le moment autour de la négociation de l’accord de libre-échange UE–Thaïlande. Son une influence politique et sécuritaire directe reste relativement limitée.

Dans ce contexte, les élections de 2026 auront aussi valeur de signal à l’extérieur. Elles diront jusqu’où la Thaïlande souhaite aller dans sa stratégie de balancement, si elle entend consolider son rôle de pivot en Asie du Sud-Est continentale, ou accepter une dépendance plus marquée à l’égard d’arbitrages venus d’ailleurs. Plus qu’un simple rendez-vous électoral, ce scrutin s’inscrit dans un moment charnière, à l’intersection de dynamiques locales, régionales et globales, qui redessinent progressivement la place du pays dans l’Asie du Sud-Est contemporaine ainsi que dans l’Asean.

Arnaud Leveau ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

01.02.2026 à 10:17

Une piste vers des stations de traitement d’eau plus sobres en énergie grâce aux bactéries… électriques

Grégory Bataillou, Ingénieur Recherche en bio-électrochimie, Centrale Lyon

Texte intégral (2127 mots)

Le traitement des eaux usées est essentiel pour éviter la pollution de l’environnement et ses impacts potentiels sur la santé humaine. Différentes pistes existent pour rendre les stations d’épuration plus efficientes, et donc réduire le prix de l’eau.

En France, le coût du traitement de l’eau (ou « assainissement collectif ») représente 40 % de son prix de vente. Un ménage paie en moyenne 260 euros par an juste pour l’assainissement… dont plus de 35 euros directement imputable à la consommation d’énergie des stations d’épuration.

Au vu de la volatilité du prix de l’énergie, de nouvelles solutions émergent pour réduire drastiquement la consommation énergétique des stations de traitement. Des solutions qui utilisent des bactéries électriques !

Traitement de l’eau – comment ça marche ?

Les technologies d’épuration des eaux usées sont connues de longue date et très matures. Leur principe est relativement simple : il s’agit de soustraire (ou mieux, d’éliminer) les polluants de l’eau, du plus gros au plus petit. Dans ces étapes, celle dite d’aération est une étape clef… mais c’est également la principale consommatrice d’énergie !

Le processus commence en général par des grilles et tamis permettant de retirer la fraction solide volumineuse (branches, détritus, cailloux…) présente les eaux usées à l’entrée de la station.

Vient alors l’étape de séparation du sable (grosses particules) qui décante assez facilement au fond du bassin de traitement, et des huiles moins denses que l’eau, récupérées à la surface.

Les particules plus légères sont encore trop nombreuses et trop lentes à décanter au fond du bassin – certaines peuvent mettre des mois à décanter ! Des lamelles insérées en biais permettent de les rapprocher du fond du bassin, et de diminuer ainsi leur temps de décantation. Des produits chimiques sont également ajoutés (floculants) pour agréger les particules entre elles et les rendre plus lourdes. On parle de traitement primaire.

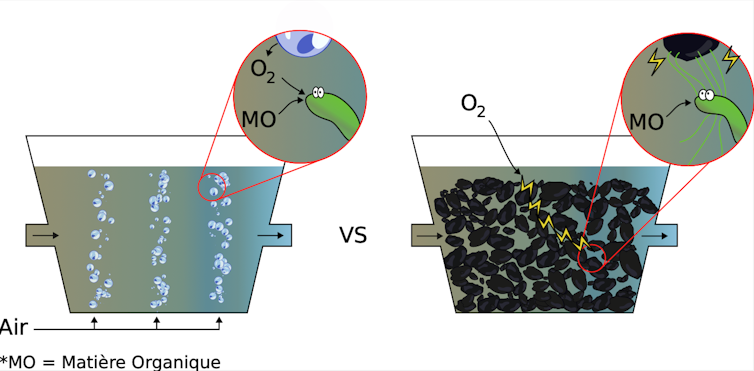

Ensuite, le bassin d’aération constitue le cœur de la station de traitement. Il s’agit tout simplement d’aérer l’eau en permanence pendant un certain temps grâce à des bulleurs au fond du bassin. Cette aération permet à des microorganismes de se développer et de décomposer toute la matière organique encore présente. Sans cette aération, les microorganismes efficaces ne se développent plus, l’eau croupit, et la matière organique se dégrade peu (pensez à l’eau des tourbières, ou simplement celle des flaques d’eau qui ne sont jamais remuées). L’aération est le principal poste de consommation de la station, responsable de 40 à 80 % de l’énergie utilisée. Cette énergie est nécessaire au fonctionnement des pompes et surpresseurs employés pour injecter de l’air en continu dans le bassin. On parle de traitement secondaire.

Dans la plupart des stations d’épuration existantes, à la suite du traitement biologique par aération, l’eau passe de nouveau dans un bassin de décantation (décantation secondaire ou clarificateur) pour faire sédimenter les milliards de bactéries mortes.

Enfin, l’eau est rejetée dans la nature.

Repenser le système grâce à d’autres microorganismes

Il existe donc un enjeu important dans le monde de l’assainissement : comment limiter la consommation d’énergie liée à l’aération, tout en traitant aussi bien les eaux usées et sans faire exploser les coûts ?

Car si l’aération fonctionne aussi bien, c’est parce qu’elle permet une oxygénation de l’eau, et que les microorganismes qui se développent dans les milieux oxygénés sont très efficaces pour dégrader la matière organique.

En effet, l’oxygène est un élément naturellement oxydant, c’est-à-dire qu’il est avide d’électrons. À l’inverse, la matière organique est riche en électrons du fait de son important nombre de liaisons Carbone. La présence d’oxygène facilite la rupture des liaisons Carbone, les électrons libérés étant transférés vers l’oxygène. Ce transfert est naturellement lent (heureusement, sinon, nous brûlerions instantanément), mais il est accéléré par la présence des bactéries, véritables usines de décomposition). C’est bien ce qui est souhaité dans cette étape : casser les chaînes de carbone jusqu’à obtenir des éléments simples, non assimilables par des bactéries pathogènes en aval dans les cours d’eau.

Si l’on décide de se passer d’aération, l’oxygène devient difficilement accessible, et la dégradation peu efficace. Sauf si on utilise des microorganismes un peu spéciaux.

Par exemple, à Villeurbanne (Rhône), une station d’épuration utilise des microorganismes capables de digérer les boues des stations d’épuration et de fabriquer du méthane, qui est injecté dans le réseau de gaz de ville.

Dans notre groupe de recherche, nous explorons une autre piste : celle des bactéries électriques !

Éviter l’aération grâce aux bactéries « électriques »

Dès le début des années 2000, les chercheurs ont redécouvert des bactéries « électriques ». Ces bactéries, telles des araignées dans le monde microscopique, ont la capacité de fabriquer des fils de taille nanométrique, qui ont la curieuse propriété d’être conducteurs électriques. Nul besoin d’oxygène en leur sein : il suffit de se connecter à un oxydant externe, qui peut être plus loin. Imaginez-vous être capable de respirer grâce à un fil dont un bout reste exposé à l’air libre, peu importe l’endroit dans lequel vous vous trouvez.

Pour en revenir au traitement de l’eau, voici l’idée : plutôt que d’amener l’oxygène aux bactéries par l’aération, les bactéries électriques présentes dans tout le bassin se connectent à un matériau conducteur présent sur toute la colonne d’eau et s’y développent. Ainsi, les bactéries sont connectées à l’oxygène de la surface. Pour cela, l’eau transite dans des structures en carbone conducteur appelées « biofiltres électro-actifs », sur lesquelles se développent les bactéries électriques. Plus besoin d’aérer : si un chemin électrique existe entre la bactérie et l’air ambiant, elle dégradera presque aussi bien la matière organique l’environnant.

L’avantage est considérable : une fois installé, le système est passif, nécessite un faible entretien, et régénérable à l’infini. Ces systèmes sont déjà proposés à la vente pour les petites stations de traitement, notamment par la start-up espagnole METfilter.

Cerise sur le gâteau : ces bactéries « électriques » existent spontanément dans l’environnement, elles n’ont pas à être artificiellement ajoutées au système et sont sélectionnées naturellement par la présence du matériau carboné.

Si cette piste nous semble prometteuse pour diminuer la facture d’électricité des stations d’épuration, ces bactéries ne dégradent pas tout : résidus de médicaments, PFAS, et autres substances résiduelles dans notre eau traversent encore les stations de traitement, et se retrouvent disséminées dans l’environnement. Les solutions techniques étant encore très énergivores, chaque économie d’énergie sur l’ensemble de la chaîne est un pas vers un traitement plus vertueux de nos eaux usées.

Le projet IRONTECH est soutenu par l’Agence nationale de la recherche (ANR) qui finance en France la recherche sur projets. L’ANR a pour mission de soutenir et de promouvoir le développement de recherches fondamentales et finalisées dans toutes les disciplines, et de renforcer le dialogue entre science et société. Pour en savoir plus, consultez le site de l’ANR.

Grégory Bataillou a travaillé comme Post-Doctorant sur le financement ANR appelé IRONTECH qui vise à utiliser du Fer et des bactéries actives pour dénitrifier les effluents agro-industriels.

01.02.2026 à 10:14

Ce que Donald Trump devrait apprendre de la chute de l’empire aztèque

Jay Silverstein, Senior Lecturer in the Department of Chemistry and Forensics, Nottingham Trent University

Texte intégral (2067 mots)

La chute des Aztèques rappelle qu’un pouvoir fondé sur la force accumule des ennemis plus vite qu’il ne consolide des alliances. Une dynamique ancienne, aux résonances très contemporaines.

En 1520, des émissaires aztèques arrivèrent à Tzintzuntzan, la capitale du royaume tarasque, dans l’actuel État mexicain du Michoacán. Ils apportaient un avertissement de l’empereur aztèque Cuauhtémoc, mettant en garde contre l’arrivée d’étrangers étranges — les Espagnols — qui avaient envahi le territoire et représentaient une grave menace. Les émissaires demandèrent une audience auprès du souverain tarasque, le « Cazonci », le roi Zuanga. Mais Zuanga venait de mourir, très probablement de la variole apportée par les Espagnols.

Les relations entre les deux empires étaient tendues de longue date. Ils s’étaient affrontés sur la frontière occidentale dès 1476, livrant de grandes batailles et fortifiant leurs frontières. Les Tarasques disaient des Aztèques qu'ils étaient fourbes et dangereux — une menace pour leur existence même.

Ainsi, lorsque ces émissaires arrivèrent pour s’adresser à un roi déjà mort, ils furent sacrifiés et n'obtinrent audience avec lui que dans l’au-delà. À cet instant précis, le destin des Aztèques était scellé dans le sang.

L’empire aztèque ne s’est pas effondré faute de moyens. Il s’est écroulé parce qu’il avait accumulé trop d’adversaires, exaspérés par sa domination. C’est un épisode historique auquel le président américain, Donald Trump, devrait prêter attention, alors que sa rupture avec les alliés traditionnels des États-Unis se creuse.

Carl von Clausewitz et d’autres philosophes de la guerre ont exposé la différence entre force et puissance dans la conduite des affaires de l’État. Au sens le plus large, la puissance est un capital idéologique, fondé sur la force militaire et l’influence dans la sphère politique mondiale. À l’inverse, la force désigne l’usage de la puissance militaire pour contraindre d’autres nations à se plier à sa volonté politique.

Alors que la puissance peut se maintenir grâce à une économie solide, des alliances et une influence morale, la force, elle, s’épuise. Elle consomme des ressources et risque d’affaiblir à la fois le capital politique interne et l’influence mondiale qu'a un pays si son usage est perçu comme arrogant ou impérialiste.

L’empire aztèque s’est formé en 1428 sous la forme d’une triple alliance entre les cités-États de Tenochtitlan, Texcoco et Tlacopan, Tenochtitlan finissant par dominer l’ensemble. L’empire exerçait la force par des campagnes militaires saisonnières, tout en l’équilibrant par une dynamique de puissance fondée sur la mise en scène sacrificielle, la menace, le tribut et une culture de supériorité raciale.

Dans son usage à la fois de la force et de la puissance, l’empire aztèque était coercitif et reposait sur la peur pour gouverner. Les populations soumises à l’empire, comme celles engagées dans ce qui semblait être une guerre permanente, nourrissaient une profonde animosité et une forte défiance à l’égard des Aztèques. L’empire s’était ainsi construit sur des peuples conquis et des ennemis attendant la bonne occasion de renverser leurs maîtres.

Hernán Cortés, le conquistador espagnol qui finit par placer de vastes territoires de l’actuel Mexique sous la domination de l’Espagne, sut exploiter cette hostilité. Il noua des alliances avec Tlaxcala et d’autres anciens sujets des Aztèques, renforçant sa petite force espagnole par des milliers de guerriers autochtones.

Cortés mena cette force hispano-autochtone contre les Aztèques et les assiégea à Tenochtitlan. Les Aztèques n’avaient plus qu’un seul espoir : convaincre l’autre grande puissance du Mexique, l’empire tarasque à l’ouest, de s’allier à eux. Leurs premiers émissaires connurent un sort funeste. Ils tentèrent donc à nouveau leur chance.

En 1521, des envoyés aztèques arrivèrent une fois encore à Tzintzuntzan et rencontrèrent cette fois le nouveau seigneur, Tangáxuan II. Ils apportaient des armes en acier capturées à l'ennemi, une arbalète et une armure afin de démontrer la menace militaire à laquelle ils faisaient face.

Le roi tarasque prêta cette fois attention à l’avertissement. Il envoya une mission exploratoire à la frontière afin de déterminer s’il s’agissait d’une ruse aztèque ou de la vérité. À leur arrivée sur la frontière, les émissaires rencontrèrent un groupe de Chichimèques — un peuple de guerriers semi-nomades qui travaillaient souvent pour les empires afin de surveiller les frontières.

Lorsqu’on leur expliqua que la mission se rendait à Tenochtitlan pour évaluer la situation, les Chichimèques répondirent qu’il était trop tard. La ville n’était plus désormais qu’un lieu de mort, et eux-mêmes se rendaient auprès du roi tarasque pour offrir leurs services. Tangáxuan se soumit aux Espagnols l’année suivante en tant que royaume tributaire, avant d’être brûlé vif en 1530 par des Espagnols cherchant à savoir où il avait dissimulé de l’or.

Si les Tarasques avaient entretenu des relations politiques normales avec les Aztèques, ils auraient pu enquêter sur le message des premiers émissaires. On peut imaginer combien l’histoire aurait été différente si, lors du siège de Tenochtitlan, 40 000 guerriers tarasques — réputés bons archers — étaient descendus des montagnes de l’ouest. Il est peu probable que Cortés et son armée aient alors pu l’emporter.

La politique étrangère américaine

Les échecs de l’empire aztèque ne relevaient ni d’un déficit de courage ni d’une infériorité sur le plan militaire. Lors de leurs combats contre les Espagnols, les Aztèques ont à maintes reprises fait preuve d’adaptabilité, apprenant à affronter les chevaux et les navires armés de canons. L’échec résidait dans une faille fondamentale de la stratégie politique de l’empire — celui-ci reposait sur la coercition et la peur, laissant ainsi en réserve une force prête à contester son autorité au moment où il était le plus vulnérable.

Depuis 2025 et le retour de Trump à la Maison-Blanche pour un second mandat, la politique étrangère américaine s’inscrit dans cette logique. L’administration Trump a récemment mis en avant une puissance coercitive au service d’ambitions mêlant richesse, visibilité et affirmation de l’exceptionnalisme américain ainsi que d’une supériorité affichée.

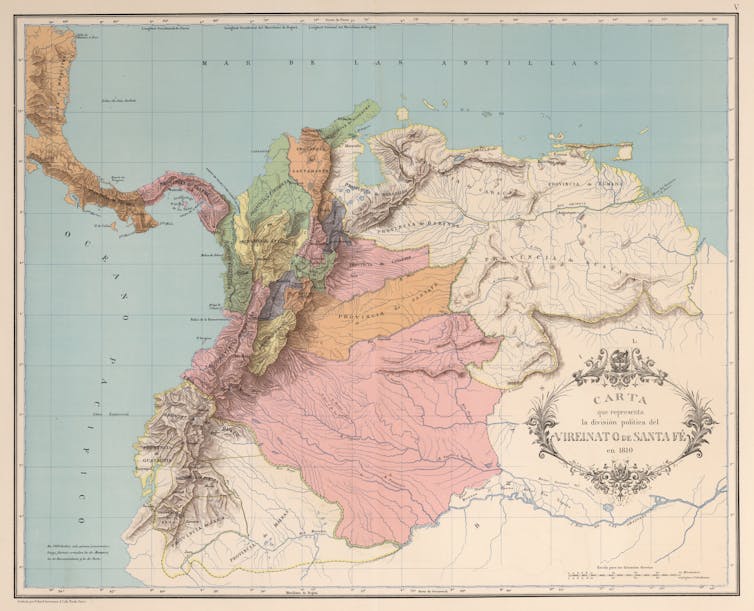

Cette orientation s’est manifestée par des menaces ou par un recours ponctuel à la force, notamment à travers des droits de douane ou des opérations militaires en Iran, en Syrie, au Nigeria et au Venezuela. Mais cette stratégie est de plus en plus contestée par d’autres États. La Colombie, le Panama, le Mexique ou encore le Canada ont, par exemple, largement fait fi de ces menaces coercitives.

À mesure que Trump utilise la puissance américaine pour revendiquer le Groenland, ses menaces gagnent en faiblesse. Les pays de l’Otan respectent leur pacte de longue date avec détermination économique et militaire, leurs dirigeants affirmant qu’ils ne céderont pas aux pressions de Trump. Les États-Unis se retrouvent ainsi poussés vers une position où ils pourraient devoir passer de la puissance coercitive à la force coercitive.

Si cette trajectoire se poursuit, les engagements militaires, l’hostilité des voisins et les vulnérabilités liées à la montée en puissance d’autres armées, aux perturbations économiques et aux catastrophes environnementales pourraient bien laisser la nation la plus puissante du monde exposée, sans alliés.

Alors que Trump mobilise la puissance américaine pour revendiquer le Groenland, ses menaces apparaissent de moins en moins crédibles. Les États membres de l’Otan respectent leur accord de longue date avec une détermination économique et militaire affirmée, leurs dirigeants déclarant qu’ils ne plieront pas face aux pressions de Trump. Les États-Unis se rapprochent ainsi d’un point où la coercition politique pourrait laisser place à la coercition militaire.

Si cette voie est maintenue, les conflits armés, l’hostilité régionale et les fragilités liées aux capacités accrues d’autres puissances militaires, aux déséquilibres économiques et aux catastrophes environnementales pourraient laisser la première puissance mondiale isolée.

Jay Silverstein a reçu des financements de l'US National Science Foundation (NSF), de la Foundation for the Advancment of Mesoamerican Studies (FAMSI), de de la Penn State Hill Foundation dans le cadre de ses études doctorales.

01.02.2026 à 07:58

Avec « KPop Demon Hunters », les Coréennes tiennent l’épée, le micro — et peut-être bientôt un Oscar

Hyounjeong Yoo, Instructor, School of Linguistics and Language Studies, Carleton University

Texte intégral (1882 mots)

Succès critique et populaire, « KPop Demon Hunters » s’inscrit dans l’essor mondial de la Hallyu, la « vague coréenne ». Le film met en lumière le rôle central des femmes et du folklore coréen dans une culture longtemps reléguée aux marges du récit occidental.

Quand j’étais enfant en Corée du Sud, le Nouvel An commençait souvent par une chanson bien connue : « Kkachi Kkachi Seollal ». Seollal désigne le Nouvel An lunaire, l’une des fêtes familiales les plus importantes en Corée, et kkachi signifie « pie », un oiseau associé à la chance et aux nouveaux départs heureux.

En chantant cette chanson, pensions-nous, nous invitions des visiteurs bienveillants à entrer dans la maison. Pour mes frères et sœurs et moi, ces visiteurs étaient le plus souvent nos grands-parents, et leur arrivée était synonyme de chaleur, de continuité et de sentiment d’appartenance à une même communauté.

Des décennies plus tard, je vis aujourd’hui au Canada, où l’éloignement rend ces visites venues de mon pays d’origine rares. Et pourtant, c’est comme si la pie était revenue — cette fois, sur un écran mondial.

Des décennies ont passé,je vis désormais au Canada, loin de mon pays d’origine, et ces visites sont devenues rares. Pourtant, j’ai l’impression que la pie est revenue, cette fois sur un écran vu partout dans le monde.

Le film d’animation de Netflix KPop Demon Hunters suit les aventures d’un groupe fictif de K-pop, Huntrix, dont les membres chassent des démons la nuit. Il vient d’obtenir une nomination aux Oscars, dans les catégories meilleur film d’animation et meilleure chanson originale, après avoir déjà remporté plusieurs Golden Globes.

Le film a été créé par la réalisatrice coréano-canadienne Maggie Kang. La production musicale est assurée par Teddy Park, et les voix sont celles d’acteurs et d’actrices américano-coréens, dont Arden Cho, Ji-young Yoo et Audrey Nuna.

Je m’intéresse à la façon dont KPop Demon Hunters ouvre une nouvelle phase de la Hallyu, la « vague coréenne », où le folklore et le travail musical des femmes se croisent pour bousculer la place longtemps marginale des récits asiatiques dans les médias occidentaux.

Le folklore comme autorité culturelle

L’un des aspects les plus marquants du film est l’usage assumé de symboles coréens. Les chasseuses de démons portent des gat — des chapeaux traditionnels en crin de cheval associés aux lettrés sous la dynastie Joseon — et combattent les esprits maléfiques aux côtés du tigre, longtemps considéré comme un esprit protecteur de la Corée. Ces éléments marquent une prise de position culturelle.

Historiquement, le cinéma et l’animation occidentaux ont souvent cantonné les personnages asiatiques à des stéréotypes ou les ont purement et simplement effacés par des pratiques de whitewashing.

À l’inverse, KPop Demon Hunters place le folklore coréen au cœur de son récit. Le gat évoque la dignité et la discipline ; le tigre incarne la protection et la résilience. Ensemble, ils viennent contester l’idée persistante selon laquelle les productions grand public portées par des personnages asiatiques seraient nécessairement de niche ou de moindre valeur.

En recourant à des références clairement coréennes — comme le style satirique de la peinture minhwa incarné par le tigre Derpy — le film s’ancre fermement dans un contexte coréen bien précis, qui n'a rien à voir avec une esthétique panasiatique vague.

Une lignée matrilinéaire de survie

L’un des moments forts du film se trouve dans la séquence d’ouverture. À travers une succession rapide de figures chamaniques, de flappers et d’artistes de l’ère disco, la séquence peut se lire comme un hommage matrilinéaire aux musiciennes coréennes, de génération en génération.

Comme le souligne l’autrice Iris (Yi Youn) Kim, en s’appuyant sur une conférence de la chercheuse en études asiatico-américaines Elaine Andres, cette lignée fait écho à l’histoire bien réelle des Kim Sisters, souvent présentées comme le premier groupe féminin coréen à connaître un succès international. Après la mort de leur père pendant la guerre de Corée, les sœurs furent formées par leur mère, la célèbre chanteuse Lee Nan-young — connue notamment pour la chanson anticoloniale « Tears of Mokpo » — et se produisirent sur les bases militaires américaines pour gagner leur vie.

Les Kim Sisters sont ensuite devenues des habituées de l’émission The Ed Sullivan Show, séduisant le public américain tout en composant avec des attentes racistes qui cantonnaient les femmes asiatiques à des figures jugées accessibles, inoffensives et exotiques.

Le travail symbolique de la représentation nationale

Le groupe fictif Huntrix s’inscrit dans cet héritage. À l’image des Kim Sisters, ses membres sont censées incarner la discipline, le professionnalisme et la Corée elle-même aux yeux du public.

Le film montre ainsi le groupe face à la discipline rigoureuse qui leur est imposée, contraintes de maintenir une image publique irréprochable tout en étouffant leurs vulnérabilités personnelles afin d’assumer leur double rôle d’idoles et de protectrices. À un niveau méta-narratif, Huntrix est également présenté comme un représentant de la Corée du Sud, à travers l’usage de symboles du folklore du pays comme le gat et le tigre.

En tant qu’« ambassadrices culturelles », à l’écran comme en dehors, les membres de Huntrix ne se contentent pas de divertir : elles assument aussi la charge symbolique de représenter une nation face à un public mondial.

En inscrivant cette filiation dans un film d’animation grand public, KPop Demon Hunters reconnaît que le succès mondial de la K-pop repose sur des décennies de travail, de sacrifices et de négociations menées par des femmes face aux structures de pouvoir occidentales.

Au-delà du soft power

Le succès du film s’inscrit dans la poursuite de l’expansion de la Hallyu dans les médias mondiaux. Le cinéma et les séries sud-coréens ont déjà transformé les perceptions à l’international, avec des œuvres majeures comme Parasite et des séries diffusées à l’échelle mondiale comme Squid Game. Netflix s’est en outre engagé publiquement à investir des centaines de millions de dollars dans les contenus coréens, signe que cette dynamique culturelle est structurelle plutôt que passagère.

KPop Demon Hunters montre comment la culture populaire coréenne circule désormais avec fluidité entre différents médias — musique, animation, cinéma et plateformes de streaming — tout en conservant une forte spécificité culturelle. L’accueil du film remet en cause l’idée tenace selon laquelle les récits ancrés dans des expériences asiatiques manqueraient de portée universelle.

La reconnaissance, à elle seule, ne suffit pas à effacer les inégalités, pas plus qu’elle ne démantèle les hiérarchies racialisées à l’œuvre dans les industries médiatiques mondiales. Mais une visibilité durable peut faire la différence. Des travaux montrent qu’une exposition répétée à des représentations multidimensionnelles et humanisées de groupes marginalisés contribue à réduire les biais raciaux, en normalisant la différence plutôt qu’en l’exotisant.

Tenir l’épée et le micro

Si le film s’inscrit dans des histoires culturelles marquées par la présence militaire américaine et la politique de la guerre froide, il reconfigure ces héritages à travers un récit diasporique qui place les voix et les points de vue coréens au centre.

La promesse de la pie est enfin tenue. Les personnages coréens ne sont plus de simples « invités » ni des figures secondaires dans l’histoire des autres. Ils sont désormais les protagonistes — tenant l’épée, le micro et, peut-être un jour, un Oscar.

Récemment, je me suis surprise à revoir KPop Demon Hunters en mangeant du gimbap et des nouilles instantanées, les mêmes plats réconfortants que partagent les personnages à l’écran. Le moment était simple, mais chargé de sens.

Il m’a rappelé une remarque faite un jour par l’un de mes étudiants : une exposition de cette ampleur permet à celles et ceux qui se sont longtemps sentis blessés par l’exclusion de se sentir enfin regardés.

Hyounjeong Yoo ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

31.01.2026 à 16:40

Qui sont les fans de Taylor Swift ?

Arnaud Alessandrin, Sociologue, Université de Bordeaux

Texte intégral (1310 mots)

Taylor Swift est aujourd’hui bien plus qu’une star de la pop. Artiste parmi les plus écoutées au monde, elle cristallise des passions, des controverses et des formes d’identification particulièrement intenses. Mais que dit réellement Taylor Swift du monde social ? Et surtout, que disent ses fans de nos sociétés contemporaines ?

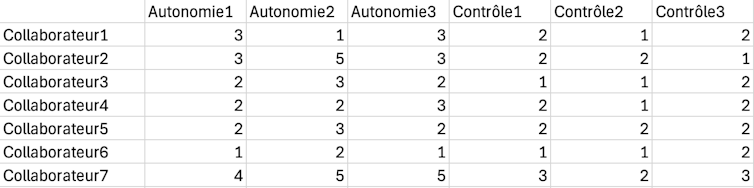

À partir d’une enquête sociologique menée auprès de plus de 1 000 fans en France, je propose de déplacer le regard : il ne s’agit pas d’analyser uniquement l’artiste, mais de comprendre ce que son œuvre et sa figure produisent socialement. Qui sont les Swifties (les fans de la chanteuse) ? Comment se rencontrent-ils ? En quoi Taylor Swift accompagne-t-elle les trajectoires de vie ? Et que révèle son succès des attentes politiques, féministes ou morales de ses publics ? C’est ce qu’explore mon essai, Sociologie de Taylor Swift, qui vient de paraître.

Loin des clichés sur un fandom adolescent et irrationnel, l’analyse met en évidence des pratiques culturelles structurées, genrées, durables et socialement situées. À travers Taylor Swift, c’est toute une sociologie des émotions, des identités et des engagements contemporains qui se donne à voir.

Une sociologie des Swifties

Contrairement aux représentations médiatiques qui réduisent souvent les fans de Taylor Swift à des adolescentes exaltées, l’enquête montre une réalité bien plus nuancée. Du point de vue de l’âge, les Swifties qui ont répondu à mon enquête se situent majoritairement dans le jeune âge adulte : près de la moitié ont entre 18 et 34 ans, mais plus d’un tiers ont plus de 35 ans, attestant d’un attachement durable à l’artiste bien au-delà de l’adolescence.

Le genre constitue un marqueur central de ce fandom (de ce groupe de fans). Les femmes représentent près de 80 % des personnes interrogées tandis que les hommes restent minoritaires. L’enquête met aussi en évidence une présence significative de personnes non binaires ou transgenres, proportionnellement bien plus élevée que dans la population générale (5 %). L’identité sexuelle apparaît également comme un facteur structurant de la fanité : plus d’un quart des fans ayant participé à l’enquête se déclarent lesbiennes, gays, bisexuel·les ou queer. Ces chiffres confirment que l’univers de Taylor Swift constitue un espace d’identification particulièrement fort pour les minorités sexuelles et de genre (on nomme le fandom gay de Taylor le « Gaylord ».

Aimer Taylor Swift ne relève donc pas d’un simple goût musical, mais d’une pratique culturelle située, marquée par des expériences sociales, genrées et biographiques spécifiques.

Créer du lien grâce à Taylor Swift : sociabilités et communautés

Être fan de Taylor Swift, ce n’est pas seulement écouter de la musique : c’est aussi créer du lien. L’enquête montre que la communauté Swiftie fonctionne comme un véritable espace de sociabilité. Plus de 60 % des répondantes et répondants déclarent avoir noué des amitiés grâce à leur intérêt commun pour Taylor Swift, que ce soit en ligne, lors de concerts ou dans des contextes du quotidien.

Ces rencontres prennent des formes multiples : échanges sur les réseaux sociaux, discussions autour des paroles, participation à des événements collectifs ou rituels devenus emblématiques, comme l’échange de bracelets d’amitié. Les liens décrits sont souvent durables et émotionnellement investis, dépassant le simple cadre du fandom.

Cette sociabilité repose sur une grammaire affective partagée. Les chansons servent de supports à la discussion, à la confidence et parfois à l’entraide. Loin d’un fandom nécessairement conflictuel ou « toxique », les Swifties qui ont participé à l’enquête évoquent majoritairement des normes de bienveillance et de soutien mutuel, souvent attribuées à l’image publique et aux discours portés par l’artiste elle-même.

Une artiste qui accompagne les trajectoires de vie

La relation des fans à Taylor Swift s’inscrit dans le temps long. Plus de la moitié des personnes interrogées se déclarent fans depuis plus de dix ans, et une part importante explique avoir découvert l’artiste à l’adolescence. Cette ancienneté témoigne d’une fidélité rare dans les industries culturelles contemporaines.

Taylor Swift n’est pas seulement écoutée : elle accompagne les parcours de vie. Près de 70 % des fans déclarent que l’artiste occupe une place « importante » ou « très importante » dans leur vie. Pour beaucoup, ses chansons sont associées à des moments clés : ruptures amoureuses, amitiés, périodes de doute, maladies, transitions identitaires ou professionnelles.

Cette centralité s’explique par l’écriture intime et narrative de Taylor Swift, qui permet aux fans de projeter leurs propres expériences dans ses chansons. Le fandom fonctionne ainsi comme une ressource biographique : aimer Taylor Swift, c’est disposer d’un répertoire émotionnel et symbolique pour se raconter et traverser les épreuves du quotidien.

Valeurs, féminisme et engagements : une figure politique ambivalente

Mais pour comprendre les fans de Taylor, on pourra aussi interroger les liens entre ce fandom et valeurs politiques. Les données montrent que les fans de Taylor Swift se situent majoritairement du côté de valeurs progressistes, qu’elles soient environnementales ou féministes. Une large majorité se déclare favorable à l’égalité femmes-hommes, aux droits des personnes LGBTQIA+ et à la lutte contre les discriminations (entre 70 et 80 %).

Ces valeurs influencent directement les attentes vis-à-vis de l’artiste. Près de deux tiers des personnes interrogées estiment que Taylor Swift devrait prendre position publiquement sur certaines causes, notamment féministes ou sociales, même si une minorité défend son droit à la neutralité.

Taylor Swift apparaît ainsi comme une figure politique paradoxale : ni militante au sens classique, ni totalement neutre. Son engagement est perçu comme mesuré, parfois stratégique, mais néanmoins porteur d’effets symboliques forts. L’enquête montre que les fans ne sont pas passifs : ils discutent, critiquent et évaluent les prises de position de l’artiste à l’aune de leurs propres valeurs, révélant la politisation croissante de la culture populaire.

Au terme de cette enquête, une chose apparaît clairement : Taylor Swift elle est un fait social. Son œuvre, ses prises de parole et la communauté qu’elle fédère révèlent des transformations profondes de nos rapports à la culture, à l’intimité et au politique. Étudier Taylor Swift, ce n’est donc pas céder à l’air du temps : c’est prendre au sérieux ce que la pop dit du social, des émotions et des attentes collectives – souvent bien au-delà d’une seule génération.

Arnaud Alessandrin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

31.01.2026 à 09:16

Quelle est la véritable situation financière des universités françaises ?

Laurent Mériade, Professeur des universités en sciences de gestion - Agrégé des facultés - IAE - CleRMa, Université Clermont Auvergne (UCA)

Texte intégral (1825 mots)

De nombreuses universités lancent l’alerte sur leurs difficultés financières. Pourtant, si l’on se réfère aux critères officiels fixés par un décret de soutenabilité mis en place en 2024, la situation semble beaucoup moins préoccupante. Qu’est-ce qui se cache réellement derrière ces nouveaux critères ? Dans quelle mesure nous informent-ils vraiment sur la situation financière des universités ?

En 2024, on dénombrait 60 universités françaises présentant de potentielles difficultés financières (principalement déficitaires). En 2025, alors que 80 % des universités présentent encore des budgets déficitaires et que les universités appellent au secours, officiellement, on ne compterait plus que 12 universités en difficulté. Par quel miracle, en moins d’un an, la situation financière des universités françaises a-t-elle pu se redresser de la sorte ?

La réponse à cette interrogation se trouve dans un décret de soutenabilité financière (n° 2024-1108) du 2 décembre 2024 qui modifie les critères d’évaluation des difficultés financières des universités. Ce décret introduit des indicateurs de soutenabilité financière qui considèrent qu’une université déficitaire (même depuis plusieurs années) n’est plus en difficulté financière. Elle ne l’est que si elle dépasse un seuil minimum de trésorerie (argent détenu sur le compte bancaire au Trésor public), de fonds de roulement (réserve d’argent détenue pour faire face à des dépenses programmées ou imprévues) et un seuil maximum de charges de personnel (rémunérations et cotisations sociales).

En réalité, l’introduction de ces trois nouveaux indicateurs (ou ratios) relâche certaines contraintes budgétaires des universités pour les forcer à utiliser massivement leurs réserves (trésorerie et fonds de roulement), comme cela est également demandé à de nombreux opérateurs de l’État dans le budget 2026 en cours de vote au Parlement.

Cependant, pour les universités, ces réserves ne sont souvent que très partiellement disponibles, car déjà pré-engagées pour financer des investissements à long terme, des contrats de recherche, de maintenance, de fourniture ou certains éléments de rémunérations (primes, promotions ou évolution programmée des salaires).

Décryptons ces nouveaux indicateurs. Ne créent-ils pas surtout une illusion, rendant plus présentable la situation financière des universités et plus acceptable le désengagement progressif de l’État ?

De nouvelles méthodes de calcul

Comme dans d’autres domaines, le diable se cache dans le détail des méthodes de calcul de ces indicateurs.

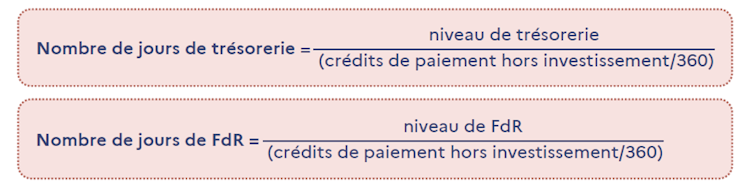

Selon ce nouveau décret, en fin d’année civile, la trésorerie et le fonds de roulement (FdR) d’une université doivent être respectivement supérieurs à 30 jours et à 15 jours de fonctionnement en crédits de paiement hors investissement. Ces deux premiers ratios sont calculés de la manière suivante :

Le numérateur de ces ratios intègre la trésorerie ou le fonds de roulement générés par les ressources d’investissement. En revanche, le dénominateur ne prend pas en compte les dépenses d’investissement autorisées au cours de l’année (crédits de paiement).

Ce mode de calcul ne respecte pas une règle élémentaire de calcul des ratios de gestion financière qui impose d’utiliser un périmètre de calcul identique pour le numérateur et le dénominateur. Ici le numérateur comprend les investissements et le dénominateur est calculé hors investissement, ce qui augmente artificiellement la valeur du ratio et permet, artificiellement aussi, de dépasser les seuils minimums requis.

Un changement de périmètre budgétaire

Pour permettre le calcul de ces nouveaux indicateurs, le nouveau décret financier a redéfini le périmètre du budget de l’établissement, dénommé désormais « budget » et qui agrège le budget principal (en personnel, fonctionnement et investissement) et les budgets annexes (dont le budget annexe immobilier pour les universités qui en disposent) (article R. 719-52).

Ce changement ne permet plus de différencier, pour le calcul de ces indicateurs, les trésoreries et fonds de roulement réellement disponibles (pour payer le personnel et le fonctionnement) de ceux pré-engagés dans des opérations particulières (investissements, contrats de recherche notamment). En recalculant ces ratios pour la seule partie de trésorerie et fonds de roulement réellement disponibles à partir des informations financières du ministère de l’enseignement supérieur, le nombre de jours de trésorerie est en moyenne divisé par deux et par trois pour celui du fonds de roulement.

Ainsi, une université qui présente officiellement un ratio de trésorerie de 50 jours (donc significativement supérieur au seuil de 30 jours) ne détient probablement que 25 jours de trésorerie réellement disponibles. De même, la même université (ou une autre) qui présenterait un fonds de roulement de 30 jours (donc significativement supérieur au seuil de 15 jours) a toutes les chances de ne détenir seulement qu’environ 10 jours de fonds de roulement de fonctionnement disponible.

Autant dire que juger la santé financière d’une université sur la base du calcul actuel de ces deux ratios relève plus de la « roulette russe » que d’une observation objective et sincère.

Des charges courantes de fonctionnement comme variables d’ajustement

Pour ce qui concerne le troisième ratio financier, c’est moins son calcul qui est contestable (total charges de personnel/produits encaissables), même si les produits encaissables intègrent très majoritairement des ressources rigides et contraintes (subvention pour charges de service public), que celui de son seuil maximum (83 % des produits encaissables, 85 % pour les établissements à dominante sciences humaines et sociales).

Pourquoi 83 % (ou 85 %) ? Et pourquoi pas 70 % ? 75 % ? 80 % ? À titre de comparaison, en 2022, les charges de personnel des universités publiques des 38 pays de l’Organisation de coopération et de développement économiques (OCDE) représentaient en moyenne 66 % de leurs dépenses totales (les universités françaises présentant le taux moyen le plus élevé à environ 77 %).

En fixant ce seuil d’alerte à 83 %, on autorise les universités à consacrer seulement 17 % (voire 15 %) de leurs produits encaissables à des charges de fonctionnement pourtant indispensables à la stabilité et la pérennité des universités (électricité, chauffage, entretien de locaux et du matériel, fournitures et services d’enseignement et de recherche, etc.).

Un calcul de ce ratio par catégories de personnel (enseignant, administratif, technique) à partir des dépenses totales, comme le réalise d’ailleurs l’OCDE, serait probablement plus pertinent et autoriserait des comparaisons internationales.

Un flou sur les difficultés financières réelles des universités

Finalement, l’ensemble de ces approximations ou insuffisances calculatoires peut soit donner une impression d’amateurisme dans le contrôle financier des universités françaises, soit, plus assurément, le sentiment d’une volonté de dissimulation de la réalité des difficultés financières tout en rendant les universités toujours plus comptables de celles-ci.

Un récent rapport d’information du Sénat de 2025 reconnaissait que la seule lecture des budgets et des indicateurs de soutenabilité financière des universités ne permet pas de faire le lien entre les données budgétaires des établissements et leurs activités.

À court terme, les fonds de roulement et trésoreries des universités n’étant pas des puits sans fond, il est probable qu’un grand nombre d’universités ne soit plus en mesure, très rapidement, d’assumer des engagements financiers récurrents (entretien des locaux et matériels, paiement des rémunérations, accueil physique de tous les étudiants).

À moyen terme, c’est la réalisation des principales missions de service public des universités (développement de l’accès à l’enseignement supérieur, réussite des étudiants, augmentation de leur employabilité, renforcement de la cohésion sociale et territoriale, développement de la recherche) qui sera profondément remise en cause.

Laurent Mériade ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

30.01.2026 à 12:31

French (Dry) January : les consommateurs de vins sans alcool consomment de l’alcool

Rossella Sorio, Professeure Associée, Département Marketing ICN BS, ICN Business School

Insaf Khelladi, Full Professor en Marketing, Excelia

Sylvaine Castellano, Directrice de la recherche, EM Normandie

Texte intégral (2111 mots)

Après le Dry January, place au French January : boire avec modération, boire autrement ou ne pas boire. Une étude sur les vins sans alcool ou à faible teneur en alcool (vins « nolo », pour no-low) analyse cette nouvelle tendance française invitant à dépasser un choix binaire entre consommation et abstinence. Explication avec le témoignage de consommateurs.

Notre analyse de près de 150 entretiens montre que les consommateurs de vins « nolo », ou no-low, en France ne sont ni majoritairement des abstinents stricts ni des individus contraints par des impératifs médicaux ou physiologiques. Le plus souvent, ces consommateurs réguliers d’alcool sont attachés au vin comme pratique sociale et culturelle, mais restent désireux de mieux maîtriser leur consommation et d’en moduler l’intensité et les occasions.

Nos résultats suggèrent que la sobriété s’inscrit moins dans une logique d’abstinence normative que dans des formes de régulation des pratiques et de gouvernement de soi. C’est dans cette tension, entre contrôle de soi et refus de l’abstinence normative, que s’inscrit aujourd’hui le débat entre Dry January et French January.

Cette régulation prend très concrètement la forme d’une alternance des produits selon les contextes. Un consommateur français dans notre étude de 2019 disait « Ce n’est pas pour arrêter de boire du vin, c’est pour mieux gérer selon les moments ». Un autre consommateur français dans notre étude de 2024 soulignait le caractère situationnel de ce choix : « Je bois du vin classique quand le moment s’y prête, et du sans alcool quand je dois conduire ou rester concentré ». Une autre personne interviewée ajoute « continuer à boire pour le plaisir, sans se sentir limité, et sans renoncer complètement au vin ».

Décryptage de ce paradoxe French (Dry) January.

Juste milieu entre le trop et le zéro

Le Dry January, lancé au Royaume-Uni en 2013, repose sur une logique claire : une abstinence totale pendant un mois, afin de favoriser une prise de conscience individuelle et de générer des bénéfices mesurables pour la santé. En France, cette initiative, portée depuis 2020 principalement par des associations de prévention, s’inscrit dans un contexte particulier, celui d’un pays où l’alcool, et en particulier le vin, occupe une place centrale dans les pratiques sociales et culturelles.

Face à cette logique de rupture temporaire, le French January s’est imposé comme une contre-proposition culturelle, défendue par la filière vitivinicole et largement relayé dans la presse. Cette orientation est explicitement formulée dans le manifeste du French January qui invite à « savourer plutôt que s’interdire », à reconnaître la pluralité des pratiques – boire avec modération, boire autrement ou ne pas boire – et à rechercher « un juste milieu entre le trop et le zéro ».

Le French January reformule les enjeux de santé publique dans un cadre narratif différent, en revendiquant une sobriété choisie et non imposée, appelée à s’inscrire dans la durée plutôt que dans la seule parenthèse du mois de janvier.

Limites du « tout ou rien »

Cette coexistence de deux initiatives révèle une polarisation très française du débat. D’un côté, une sobriété conçut comme abstinence temporaire, de l’autre, une sobriété pensée comme régulation des pratiques. Cette polarisation est souvent caricaturée en opposition entre « hygiénistes » et « épicuriens », alors même que les données scientifiques rappellent une réalité incontestable : toute consommation d’alcool comporte un risque.

Selon l’Organisation mondiale de la santé (OMS), l’alcool est responsable de millions de décès chaque année, et il n’existe pas de seuil de consommation totalement sans risque. Mickaël Naassila, chercheur et président de la Société française d’alcoologie, insiste sur une bascule culturelle réelle : recul des croyances dans un alcool « protecteur », acceptation croissante de la non-consommation, notamment chez les jeunes, et meilleure connaissance des risques.

À lire aussi : Et si l’alcool disparaissait de la planète ?

Cette bascule reste incomplète et entravée par des blocages politiques et institutionnels. Contrairement au tabac, il n’existe pas en France de véritable « plan alcool ». Les campagnes de prévention sont souvent limitées à la lutte contre les excès ou les dépendances, au détriment de la prévention primaire. Dans ce contexte, le Dry January joue un rôle important : il rend visible la non-consommation, légitime le refus de boire et permet à certains individus de développer des compétences psychosociales pour réguler leurs pratiques.

À lire aussi : Alcool et Dry January : Relever le « Défi de Janvier » est toujours bénéfique, même en cas d’échec

Les limites du « tout ou rien » sont également documentées. Des travaux récents suggèrent que l’abstinence temporaire peut produire des effets de compensation après janvier, et qu’elle touche principalement des consommateurs occasionnels, sans nécessairement atteindre les publics les plus vulnérables.

Ces constats ne disqualifient pas le Dry January ils rappellent simplement qu’un changement durable des comportements ne peut reposer sur un seul dispositif normatif.

Vins « nolo », l’angle mort du débat

C’est précisément ici que les recherches en marketing, en comportement du consommateur et en sociologie des marchés peuvent enrichir le débat. La transition vers une consommation d’alcool plus responsable ne dépend pas uniquement des messages de santé publique, mais aussi de la manière dont les produits et les pratiques sont catégorisés, légitimés et émotionnellement valorisés.

Les vins sans alcool ou à faible teneur en alcool (vins « nolo ») constituent un révélateur particulièrement intéressant. Souvent présentés comme des alternatives responsables, ils se situent pourtant dans une zone de tension. D’un côté, ils répondent à une demande croissante de réduction de la consommation ; de l’autre, ils souffrent d’un déficit de légitimité, notamment lorsqu’ils sont associés à une logique de privation ou de contrainte temporaire.

Cette alternance est d’autant plus importante que, pour une majorité de consommateurs interrogés, les vins « nolo » ne sont pas conçus comme des substituts du vin, mais comme des options complémentaires. Nos enquêtes de 2019 et 2024 insistent sur le fait qu’ils continuent à consommer du vin avec alcool pour certaines occasions, tout en recourant au vin sans alcool pour rester pleinement dans le moment social, sans se sentir mis à l’écart. Cette alternance est d’abord liée aux occasions de sociabilité :

« Boire du vin, c’est surtout un moment pour être ensemble, pour partager un repas », explique un consommateur français.

Dans ce contexte, le vin sans alcool est mobilisé non pas comme un substitut, mais comme un ajustement, comme exprimé par un autre consommateur français :

« Ce n’est pas un vin de repas pour moi, plutôt quelque chose pour l’apéritif ou quand on veut rester sobre », souligne une personne interviewée.

Cette distinction entre usages est également très présente dans les discours des consommateurs. Pour les consommateurs français, le vin sans alcool « n’est pas fait pour remplacer le vin », mais pour répondre à des situations spécifiques : « un déjeuner d’affaires », « un événement en journée » ou « un moment où l’on veut rester lucide ».

Produits « free-from » alcool

Nos travaux sur les produits « free-from » montrent que, dans les catégories hédoniques comme le vin, la suppression d’un attribut central – ici l’alcool – peut altérer la valeur perçue, l’authenticité et le plaisir anticipé. Le risque est alors double : soit le vin « nolo » est perçu comme un simple substitut fonctionnel, dépourvu de valeur émotionnelle ; soit il est rejeté comme un « faux vin », ni pleinement vin, ni véritable alternative.

Nos entretiens mettent en évidence une tension entre attentes hédoniques et logiques de régulation. Pour certains consommateurs, l’alcool demeure indissociable du plaisir associé au vin, au point que le vin sans alcool est perçu comme ne permettant ni de « se détendre » ni d’« oublier ses émotions négatives ».