31.10.2025 à 12:02

Higher education: why women in France are less likely to pursue science than men

Texte intégral (1526 mots)

Girls in France are much less inclined than boys to pursue scientific fields of study, and this is partly due to persistent gender stereotypes. But other factors also come into play. These explanations are based on a survey by the Chair for Women’s Employment and Entrepreneurship at Sciences Po.

How can we attract more women in France to higher education in science and technology? For several years, public authorities have been supporting initiatives aimed at promoting gender diversity in these fields of study, the most recent being the “Girls and Maths” action plan, launched by the ministry of national education, higher education, and research in May 2025.

There are two main reasons behind these initiatives. On the one hand, the aim is to reduce gender inequalities in the labour market, particularly the pay gap. On the other hand, the objective is to support economic growth in promising fields by training more people who can contribute to innovation in strategic sectors of activity.

Different choices

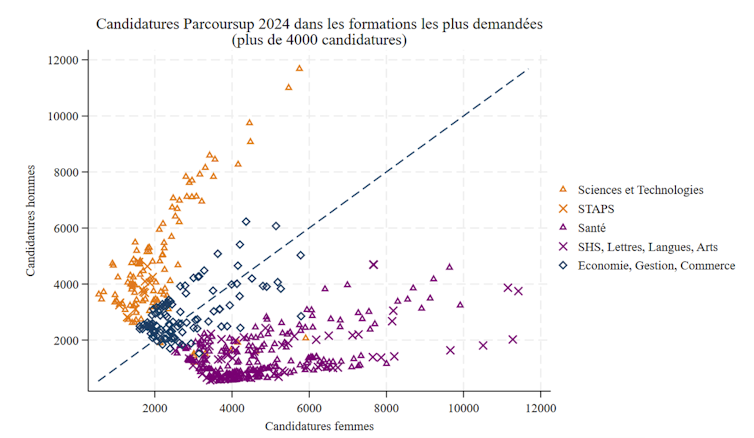

The differences in orientation between women and men remain very marked at the start of higher education. This is evident from the choices made by high school seniors on Parcoursup, the French platform for accessing post-baccalaureate programmes, as can be seen in the following graph based on data made available on Datagouv. It represents the number of applications for the most popular courses of study (more than 4,000 applications).

The points above the diagonal represent programmes with a predominance of male applicants, while those below represent programmes with a predominance of female applicants. Men account for approximately 70% of applicants to science and technology programmes, including STAPS (science and technology of physical education and sports).

The main exceptions concern courses in life and earth sciences, for which there are more female applicants. Programmes in economics, management, and business (in blue) tend to be more mixed. Finally, programmes in health, humanities, social sciences, literature, languages, and arts (in purple) are mainly favored by women, who account for around 75% of applicants.

Certain factors that may explain these differences in study choices, in particular the role of gender stereotypes, differences in academic performance in science subjects, and self-confidence, have already been analysed.

Passion as a determining factor

In order to better understand the current reasons for the differences between women and men in higher education choices, the Chair for Women’s Employment and Entrepreneurship at Sciences Po conducted a survey in partnership with Ipsos in February 2025 among a representative sample of the student population in France, with a total of 1,500 responses. The results of this survey were published by the Observatory of Well-Being of the Centre for Economic Research and its Applications (Cepremap).

One of the striking findings of the survey concerns the differences between women and men in the importance they attach to passion as a determining factor in their higher education choices.

Significantly more female students choose courses related to their passions, and they seem to do so fully aware that these choices may penalise them later on in the job market. In fact, 67% of women (compared to 58% of men) say they “prefer to study a subject they are passionate about, even if it does not guarantee a well-paid job”, while 33% of women (compared to 42% of men) say they “prefer to get a well-paid job, even if it doesn’t guarantee that they will study a subject they are passionate about”.

Women who prioritise passion are more likely to enrol in arts and humanities programmes, while those who prefer a well-paid job are more likely to enrol in economics, business, and commerce programmes, or in science and technology programmes.

The role of parents

Furthermore, the survey results highlight the fact that parents are more influential in determining their sons’ educational choices than their daughters’. In fact, female students receive more support from their parents, regardless of their chosen field of study, while male students are less likely to receive their parents’ approval, particularly for fields of study that lead to less lucrative careers in the job market (eg humanities, social sciences or arts) or that have become feminised (eg law or health).

Paradoxically, the lack of parental influence on girls’ choices may explain why they are more likely to follow their passion, finding themselves more constrained in the job market later on.

The results also show that preferences developed for different subjects in secondary school account for more than half of the differences between women and men in their higher education choices.

Women appear to have more diverse tastes, with a preference for mathematics accounting for only a small part (around 10%) of the difference in study choices. This partly explains why women tend to shy away from science and technology courses of study, which may be perceived as requiring them to give up other subjects they enjoy. More men than women enjoyed only science subjects in secondary school (29% of male students compared to 14% of female students).

Multidisciplinary programmes and role models

If the French economy needs more women with degrees in science and technology, how can we attract them to these fields? The main challenge lies in conveying a passion for science and technology to women.

This can be achieved through role models, such as high-achieving people who share their enthusiasm for their discipline before students make crucial choices. This can also involve the development of multidisciplinary courses that combine science, social sciences, and humanities, so as to offer young women (and young men) with varied interests the opportunity to pursue scientific studies without giving up other fields.

Finally, science programmes can adapt their educational offerings to make teaching more attractive to female students. By highlighting how science and technology can contribute to the common good and address the challenges of contemporary societies, a reformulation of course titles can, for example, highlight issues that are important to them.

Created in 2007 to help accelerate and share scientific knowledge on key societal issues, the Axa Research Fund – now part of the Axa Foundation for Human Progress – has supported over 750 projects around the world on key environment, health & socioeconomic risks. To learn more, visit the website of the AXA Research Fund or follow @ AXAResearchFund on LinkedIn.

The collection of data was funded by the Chair for Women's Employment and Entrepreneurship (Sciences Po, Paris).

30.10.2025 à 16:05

De Chirac à Macron, comment ont évolué les dépenses de l’État

Texte intégral (2135 mots)

Pour stabiliser la dette publique de la France, l’État doit réduire son déficit. Outre la hausse des prélèvements, il doit aussi de diminuer ses dépenses. Mais avant de les réduire, il importe de savoir comment ces dépenses ont évolué ces trente dernières années.

L’analyse historique des dépenses de l’État peut être utile pour prendre aujourd’hui des décisions budgétaires. Qu’ont-elles financé ? Les salaires des agents ? Des achats de biens et services ? Des transferts ? Quels types de biens publics ont-elles permis de produire (éducation, santé, défense…) ?

Le futur budget de l’État doit tenir compte de ces évolutions passées, des éventuels déséquilibres en résultant, tout en réalisant que ces choix budgétaires auront des impacts sur la croissance et les inégalités spécifiques à la dépense considérée.

Près de 30 milliards d’économies annoncées

Le projet de loi de finances actuellement discuté pour l’année 2026 prévoit 30 milliards d’euros d’économies, ce qui représente 1,03 % du PIB. Ces économies sont obtenues avec 16,7 milliards d’euros de réduction de dépenses (0,57 point de PIB), et 13,3 milliards d’euros de hausse de la fiscalité. Le déficit public, prévu à 5,6 % en 2025 (163,5 milliards d’euros pour 2025) ne serait donc réduit que de 18,35 %. Pour atteindre l’objectif de stabiliser la dette publique, il faudra amplifier cet effort les prochaines années pour économiser approximativement 120 milliards d’euros (4 points de PIB), soit quatre fois les économies prévues dans le PLF 2026.

Ces réductions à venir des dépenses s’inscrivent dans un contexte. En moyenne, dans les années 1990, les dépenses publiques représentaient 54 % du PIB. Dans les années 2020, elles avaient augmenté de 3 points, représentant alors 57 % du PIB, soit une dépense annuelle additionnelle de 87,6 milliards d’euros, ce qui représente plus de cinq fois les économies inscrites dans le PLF pour 2026. Depuis 2017, ces dépenses ont augmenté d’un point de PIB, soit une hausse annuelle de 29,2 milliards d’euros (1,75 fois plus que les économies du PLF 2026). Étant données ces fortes hausses passées, des réductions de dépenses sont possibles sans remettre en cause le modèle social français. Mais, quelles dépenses réduire ?

À lire aussi : L’endettement de l’État sous Chirac, Sarkozy, Hollande, Macron… ce que nous apprend l’histoire récente

De plus en plus de transferts sociaux

Chaque poste de dépense se compose d’achats de biens et services (B & S) utilisés par l’État (au sens large, c’est-à-dire l’ensemble des administrations publiques centrales, locales et de sécurité sociale) pour produire, de salaires versés aux agents, et de transferts versés à la population. Quel poste a fortement crû depuis 1995 ?

Le tableau 1 montre qu’en 1995, 40,2 % des dépenses étaient des transferts (soit 22,05 points de PIB), 35,5 % des achats de B & S (soit 19,45 points de PIB) et 24,3 % des salaires (soit 13,33 points de PIB). En 2023, 44,1 % étaient des transferts (+ 3,06 points de PIB), 34,5 % des achats de B & S (- 0,15 point de PIB) et 21,4 % des salaires (- 1,07 points de PIB). Le budget s’est donc fortement réorienté vers les transferts. Les dépenses consacrées aux salaires ont évolué moins vite que le PIB, le poids de ces rémunérations dans les dépenses baissant fortement.

Lecture : En 1995, les transferts représentaient 22,05 points de PIB, soient 40,2 % des dépenses totales. Le chiffre entre parenthèses indique la part de cette dépense dans les dépenses totales. Δ : différence entre 2023 et 1995 en points de PIB et le chiffre entre parenthèses l’évolution de la part.

L’État a donc contenu ces achats de B & S et réduit sa masse salariale, quand bien même les effectifs croissaient de plus de 20 % (données FIPECO). Simultanément, l’emploi salarié et non salarié du secteur privé augmentait de 27 % (données Insee). Des effectifs augmentant moins que dans le privé et une part de la production de l’État dans le PIB progressant révèlent une plus forte hausse de la productivité du travail du secteur public. Mais, ceci ne s’est pas traduit par une augmentation des rémunérations du public. Au contraire, l’écart de salaire entre le public et le privé s’est fortement réduit sur la période, passant de +11,71 % en 1996 en faveur du public (données Insee (1999) pour le public et Insee (1997) pour le privé), à 5,5 % en 2023 (données Insee (2024a) pour le privé et Insee (2024b) pour le public).

Cette première décomposition montre que l’organisation de la production de l’État (achat de B & S et salaires) n’a pas dérivé, mais que les hausses des dépenses de redistribution (+ 3,06 points de PIB en trente ans) ont fortement crû. Ces hausses de transferts correspondent aux trois quarts des économies nécessaires à la stabilisation de la dette publique.

De moins en moins d’argent pour les élèves et la défense

Les dépenses de l’État se décomposent en différents services, c'est-à-dire, en différentes fonctions (l'éducation, la défense, la protection sociale…). La figure 1 montre que les dépenses des services généraux, d’éducation et de la défense ont crû moins vite que le PIB depuis 1995 (surface rouge). En effet, leurs budgets en points de PIB ont respectivement baissé de 2,14 points, 0,78 point et 0,68 point de PIB. Si la baisse du premier poste peut s’expliquer, en partie, par la rationalisation liée au recours aux technologies de l’information, et la seconde par l’arrêt de la conscription, celle de l’éducation est plus surprenante.

Elle l’est d’autant plus que Aubert et al. (2025) ont montré que 15 % de ce budget incluait (soit 0,75 point de PIB) des dépenses de retraites qu’il « faudrait » donc réallouer vers les pensions pour davantage de transparence. La croissance constante de cette contribution aux pensions dans le budget de l’éducation indique que les dépenses consacrées aux élèves sont en forte baisse, ce qui peut être mis en lien avec la dégradation des résultats des élèves de France aux tests de type Pisa. Enfin, dans le contexte géopolitique actuel, la baisse du budget de la Défense peut aussi sembler « peu stratégique ».

Lecture : En 1995, les dépenses de protection sociale représentaient 21,41 points de PIB, dont 18,14 points de PIB en transferts, 1,16 point en salaires et 2,11 points en B&S ; en 2023, elles représentaient 23,33 points de PIB dont 20,16 points, 1,12 point en salaire et 2,0 points en B&S.

De plus en plus pour la santé et la protection sociale

La surface verte de la figure 1 regroupe les fonctions qui ont vu leurs budgets croître plus vite que le PIB, de la plus faible hausse (ordre public/sécurité, avec + 0,24 point de PIB) aux plus élevées (santé, + 1,72 point de PIB, et protection sociale, + 1,92 point de PIB). Ces deux postes de dépenses représentent 65,3 % des hausses. Viennent ensuite les budgets sport/culture/culte, environnement et logement qui se partagent à égalité 24 % de la hausse totale des dépenses (donc approximativement 8 % chacun). Enfin, les budgets des affaires économiques et de l’ordre public/sécurité expliquent les 10,7 % restant de hausse des dépenses, à hauteur de 6,4 % pour le premier et 4,3 % pour le second.

Si l’on se focalise sur les plus fortes hausses, c’est-à-dire, la santé et la protection sociale, les raisons les expliquant sont différentes. Pour la protection sociale, les dépenses de fonctionnement sont quasiment stables (B&S et salaires) alors que les prestations sont en forte hausses (+ 2 points de PIB). Les dépenses de santé voient aussi les prestations offertes croître (+ 1 point de PIB), mais se caractérisent par des coûts croissants de fonctionnement : + 0,6 point pour les B&S, et + 0,12 point de PIB pour les salaires des personnels de santé, alors que les rémunérations baissent dans le public, ceux des agents de l’éducation, par exemple, passant de 4,28 à 3,47 points de PIB (-0,81 points de PIB).

Dans la protection sociale, de plus en plus pour la maladie et les retraites

La protection sociale, premier poste de dépense (23,33 % du PIB), regroupe différentes sous-fonctions représentées dans la figure 2. À l’exception des sous-fonctions maladie/invalidité (+ 0,07 point de PIB), exclusion sociale (+ 0,43 point du PIB) et pensions (+ 2,41 points de PIB), les budgets de toutes les sous-fonctions de la protection sociale ont vu leur part baisser (surface en rouge). Les réformes des retraites ont donc été insuffisantes pour éviter que les pensions soient la dépense en plus forte hausse.

Enfin, si on ajoute aux dépenses de santé la partie des dépenses de protection sociale liée à la maladie et à l'invalidité (voir la figure 2), alors ces dépenses globales de santé ont crû de 1,79 point de PIB entre 1995 et 2023.

Quels enseignements tirer ?

Ces évolutions suggèrent que les budgets à venir pourraient cibler les économies sur les dépenses de santé et les pensions, ces deux postes ayant déjà fortement crû dans le passé. Évidemment, une partie de ces hausses est liée à l’inévitable vieillissement de la population. Mais une autre vient de l’augmentation des prestations versées à chaque bénéficiaire. Par exemple, la pension de retraite moyenne est passée de 50 % du salaire moyen dans les années 1990 à 52,3 % en 2023. Le coût de la prise en charge d’un infarctus du myocarde est passé de 4,5 Smic dans les années 1990 à 5,6 Smic dans les années 2020

En revanche, un rattrapage portant sur l’éducation et la Défense semble nécessaire au vu du sous-investissement passé et des défis à venir. Les rémunérations des agents du public doivent aussi être reconsidérées. Le tableau 2 montre que le PLF 2026 propose des mesures répondant en partie a ce rééquilibrage en réduisant les dépenses de protection sociale et en particulier les pensions. Enfin, le PLF 2026 prévoit une hausse du budget de la défense, alors que la réduction de 8,6 milliards d’euros des budgets des fonctions hors défense et ordre public épargne l’éducation.

Au-delà de ces arguments de rééquilibrage, les choix budgétaires doivent aussi reposer sur une évaluation d’impact sur l’activité (croissance et emploi). Les analyses de Langot et al. (2024) indiquent que les baisses de transferts indexés sur les gains passés (comme les retraites) peuvent avoir un effet positif sur la croissance, facilitant alors la stabilisation de la dette publique, au contraire des hausses des prélèvements.

Privilégier la production des biens publics aux dépens des transferts se justifie aussi au regard des enjeux géopolitiques et climatiques, et permet également de réduire les inégalités (voir André et al. (2023)).

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

30.10.2025 à 15:56

Bad Bunny au Super Bowl : une polémique emblématique des États-Unis de Donald Trump

Texte intégral (1927 mots)

La présence de Bad Bunny à la mi-temps du Super Bowl 2026 suscite une levée de boucliers dans les rangs trumpistes. L’artiste, né à Porto Rico – territoire disposant d’un statut spécifique, dont les habitants sont citoyens des États-Unis mais ne peuvent pas voter à l’élection présidentielle et ne disposent pas de représentants au Congrès –, devient malgré lui le symbole d’un système qui célèbre la culture latino tout en la réprimant à ses marges. Au moment où les abus de la police de l’immigration (ICE) alimentent la peur parmi les Hispaniques, l’apparition du rappeur sur la scène la plus médiatisée du pays met en évidence les contradictions du rapport des États-Unis à cette large communauté.

La désignation du rappeur portoricain Bad Bunny par la National Football League (NFL) pour effectuer un court concert lors de la mi-temps du Super Bowl 2026, le 8 février prochain, a déclenché les foudres des médias conservateurs et de plusieurs membres de l’administration Trump.

Alors que le président a qualifié ce choix d’« absolument ridicule », la secrétaire à la sécurité intérieure, Kristi Noem, a promis que des agents de la police de l’immigration (ICE) « seraient présents partout au Super Bowl ». Le célèbre commentateur de droite Benny Johnson a déploré dans un tweet posté sur X que le répertoire du rappeur ne contienne « aucune chanson en anglais », tandis que la polémiste Tomi Lahren a déclaré que Bad Bunny n’était pas états-unien.

Bad Bunny, né Benito Antonio Martínez Ocasio, est une superstar et l’un des artistes les plus écoutés au monde. Et comme il est portoricain, il est également citoyen des États-Unis.

Il est certain que Bad Bunny coche de nombreuses cases qui irritent les conservateurs. Il a apporté son soutien à Kamala Harris pour la présidence en 2024. Il a critiqué les politiques anti-immigration de l’administration Trump. Il a refusé d’effectuer une tournée sur le continent américain, craignant que certains de ses fans ne soient pris pour cible et expulsés par l’ICE. Et ses paroles explicites – dont la plupart sont en espagnol – feraient frémir même les plus ardents défenseurs de la liberté d’expression. Sans même parler de sa garde-robe androgyne.

Et pourtant, en tant qu’experts des questions d’identité nationale et des politiques d’immigration des États-Unis, nous pensons que les attaques de Lahren et Johnson touchent au cœur même de la raison pour laquelle le rappeur a déclenché une telle tempête dans les rangs de la droite. Le spectacle d’un rappeur hispanophone se produisant lors de l’événement sportif le plus regardé à la télévision états-unienne constitue en soi une remise en cause directe des efforts déployés par l’administration Trump pour masquer la diversité du pays.

La colonie portoricaine

Bad Bunny est né en 1994 à Porto Rico, un « État libre associé » aux États-Unis, rattaché à ces derniers après la guerre hispano-américaine de 1898.

Cette terre est le foyer de 3,2 millions de citoyens états-uniens de naissance. Si le territoire était un État fédéré des États-Unis, il serait le 30e le plus peuplé par sa population, d’après le recensement de 2020.

Mais Porto Rico n’est pas un État ; c’est une colonie issue de l’époque révolue de l’expansion impériale américaine outre-mer. Les Portoricains n’ont pas de représentants votant au Congrès et ne peuvent pas participer à l’élection du président des États-Unis. Ils sont également divisés sur l’avenir de l’île. Une grande majorité souhaite soit que Porto Rico devienne un État états-unien, ou obtienne un statut amélioré par rapport à l’actuel, tandis qu’une minorité plus réduite aspire à l’indépendance.

Mais une chose est claire pour tous les Portoricains : ils viennent d’un territoire non souverain, avec une culture latino-américaine clairement définie – l’une des plus anciennes des Amériques. Porto Rico appartient peut-être aux États-Unis ; et de nombreux Portoricains apprécient cette relation privilégiée, mais l’île elle-même ne ressemble en rien aux États-Unis, ni dans son apparence ni dans son atmosphère.

Les plus de 5,8 millions de Portoricains qui résident dans les 50 États compliquent encore davantage le tableau. Bien qu’ils soient légalement citoyens des États-Unis, les autres États-Uniens ne les considèrent souvent pas comme tels. En effet, un sondage réalisé en 2017 a révélé que seuls 54 % des États-Uniens savaient que les Portoricains étaient citoyens du même pays qu’eux.

Le paradoxe des citoyens étrangers

Les Portoricains vivent dans ce que nous appelons le « paradoxe des citoyens étrangers » : ils sont citoyens des États-Unis, mais seuls ceux qui résident sur le continent jouissent de tous les droits liés à la citoyenneté.

Un rapport récent du Congrès américain a conclu que la citoyenneté états-unienne des Portoricains « n’est pas une citoyenneté égale, permanente et irrévocable protégée par le 14e amendement […] et le Congrès conserve le droit de déterminer le statut du territoire. » Tout citoyen états-unien qui s’installe à Porto Rico ne jouit plus des mêmes droits que les citoyens états-uniens du continent.

La désignation de Bad Bunny pour le spectacle de la mi-temps du Super Bowl illustre bien ce paradoxe. Outre les critiques émanant de personnalités publiques, il y a eu de nombreux appels parmi les influenceurs pro-Trump à expulser le rappeur.

Ce n’est là qu’un exemple parmi d’autres qui rappelle aux Portoricains, ainsi qu’aux autres citoyens latino-américains, leur statut d’« autres ».

Les arrestations par l’ICE de personnes semblant être des immigrants – une tactique qui a récemment reçu l’aval de la Cour suprême – illustre bien leur statut d’étrangers.

La plupart des raids de l’ICE ont eu lieu dans des communautés majoritairement latino-américaines à Los Angeles, Chicago et New York. Cela a contraint de nombreuses communautés latino-américaines à annuler les célébrations du Mois du patrimoine hispanique.

L’impact mondial de Bad Bunny

La vague de xénophobie contre Bad Bunny a poussé des responsables politiques comme le président de la Chambre des représentants Mike Johnson à réclamer son remplacement par une personnalité « plus appropriée » pour le Super Bowl, comme l’artiste de musique country Lee Greenwood, 83 ans, supporter de Donald Trump. À propos de Bad Bunny, Johnson a déclaré : « Il semble qu’il ne soit pas quelqu’un qui plaise à un large public. »

Mais les faits contredisent cette affirmation. L’artiste portoricain occupe la première place des classements musicaux mondiaux. Il compte plus de 80 millions d’auditeurs mensuels sur Spotify. Et il a vendu près de cinq fois plus d’albums que Greenwood.

Cet engouement mondial a impressionné la NFL, qui organise sept de ses rencontres à l’étranger cette saison et souhaite encore accroître ce nombre à l’avenir. De plus, les Latino-Américains représentent la base de fans qui connaît la plus forte croissance au sein de la ligue, et le Mexique est son plus grand marché international, avec 39,5 millions de fans selon les chiffres publiés.

La saga « Bad Bunny au Super Bowl » pourrait bien devenir un moment politique important. Les conservateurs, dans leurs efforts pour mettre en avant « l’altérité » de Bad Bunny – alors que les États-Unis sont l’un des premiers pays hispanophones au monde – ont peut-être involontairement sensibilisé les États-Uniens au fait que les Portoricains étaient leurs concitoyens.

Pour l’heure, les Portoricains et le reste de la communauté latino-américaine des États-Unis continuent de se demander quand ils seront acceptés comme des égaux sur le plan social.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

30.10.2025 à 15:52

Le cinéma d’horreur, miroir de nos angoisses contemporaines

Texte intégral (2032 mots)

Alors que nous traversons une époque de plus en plus troublée, un constat s’impose : le cinéma d’horreur, lui, se porte à merveille. Ce succès n’a rien d’anodin : il reflète la manière dont les inquiétudes sociétales, toujours plus prégnantes, trouvent dans l’horreur un terrain d’expression privilégié, un miroir révélateur de nos angoisses collectives.

Ces dernières années ont vu émerger nombre de films et de séries rencontrant un véritable engouement, tandis que certains réalisateurs – comme Jordan Peele, Ari Aster ou Jennifer Kent – sont devenus des auteurs plébiscités, voire des figures incontournables du genre.

Les racines du cinéma d’horreur actuel se trouvent dans les productions hollywoodiennes des années 1970. À ce sujet, le critique Jean-Baptiste Thoret relevait que le cinéma de l’époque fut déterminé par la généralisation de la télévision dans les foyers, et de son nouveau registre d’images. Les horreurs du monde extérieur étaient ainsi présentées tous les soirs dans les salons familiaux.

La guerre du Vietnam, les émeutes réprimées de manière sanglante – notamment les sept « émeutes de Watts » aux États-Unis en août 1965 –, les faits divers lugubres s’introduisaient dans le quotidien de tous les Américains, puis de tous les Occidentaux. Le cinéma de possession, l’Exorciste (William Friedkin, 1973), mais aussi les slashers et leurs tueurs barbares arpentant les paisibles zones pavillonnaires (la Dernière Maison sur la gauche, Wes Craven, 1972) en sont des exemples probants : les peurs de la destruction du soi intime et de l’espace domestique furent liées à cette obsession pour un « mal intérieur » que diffusait, incarnait et répandait l’écran de télévision.

Mais c’est aussi, bien sûr, le cinéma de zombies (la Nuit des morts-vivants, George A. Romero, 1968) au postulat très simple : les morts viennent harceler les vivants ; ou, en termes cinématographiques, le hors-champ vient déborder dans le champ. De fait, la décennie posa des bases horrifiques qui sont toujours valides aujourd’hui.

Le cinéma d’horreur est un registre qui tourne toujours autour d’un même sujet : les frontières (d’un monde, d’un pays, d’une maison, d’un corps) sont mises à mal par une puissance insidieuse, puissante, voire surnaturelle.

Le XXIᵉ siècle et la peur des images

Notre siècle se situe de fait dans la continuité des années 1970 qui ont posé les bases du genre. Nous pouvons définir quatre grandes peurs qui traversent toutes les productions horrifiques actuelles : la question du contrôle politique, de son efficience et de ses abus ; la question de l’identité et de la différence ; celle de la violence, de l’agression, voire de la torture ; et, enfin, la peur des médias et de la technologie.

La peur politique est au cœur de nombreuses productions horrifiques. C’est notamment le cas de la saga American Nightmare (James DeMonaco, 2013–2021) qui nous présente une société américaine fondamentalement dysfonctionnelle en raison de ses orientations politiques : une nuit par an, afin de « purger » la société, toutes les lois sont suspendues. Le troisième volet, The Purge : Election Year (James DeMonaco, 2016), ne s’y trompait pas en détournant la casquette du mouvement MAGA sur son affiche promotionnelle.

Mais l’horreur des choix politiques se trouve également au cœur des films apocalyptiques et postapocalyptiques. Qu’ils mettent en scène des zombies, des épidémies ou des extra-terrestres, l’horreur provient bien souvent de l’incapacité institutionnelle à répondre au mal, puis de la violence fondamentale avec laquelle les sociétés se reconstituent ensuite. C’est notamment le cas dans la série The Walking Dead (Frank Darabont, 2010–2022), qui nous présente tout un répertoire de modes de vie collective, en majorité profondément inégalitaires, voire cruelles.

Les questions identitaires, elles, relèvent de l’horreur politique lorsque les films prennent le racisme comme sujet. On retrouve cet aspect dans Get Out (Jordan Peele, 2017), dans lequel de riches Blancs s’approprient les corps d’Afro-Américains afin de s’offrir une seconde jeunesse. Mais c’est aussi le cas, de façon plus générale, du cinéma de possession, qui est toujours un cinéma traitant de problèmes identitaires, du rapport à soi, voire de folie ou de dépression. Possédée (Ole Bornedal, 2012), Mister Babadook (Jennifer Kent, 2014), ou encore Heredité (Ari Aster, 2018) mettent tous en scène des individus combattant un démon – ou une entité maléfique – pour retrouver un sens à leur vie et une stabilité identitaire.

La peur de la violence est peut-être la réponse cinématographique la plus directe aux faits divers qui ont envahi les médias depuis plusieurs décennies. Faits divers ayant même donné naissance à des sous-genres cinématographiques autonomes. Le « torture porn » – illustré par les sagas Saw (depuis 2004), Hostel (2005–2011) et The Human Centipede (Tom Six, 2009–2016), par exemple – est un type de film dont l’objet est la représentation de tortures physiques et/ou psychologiques infligées par un maniaque (ou un groupuscule puissant) à des individus malchanceux. Le « rape and revenge » (« viol et vengeance »), quant à lui, représente, comme son nom l’indique, de jeunes femmes violentées qui prennent leur revanche sur leurs agresseurs, souvent de manière sadique. C’est le cas de films comme Revenge (Coralie Fargeat, 2017) ou la saga I Spit on Your Grave (2010–2015).

Enfin, le dernier territoire que nous mentionnons a fini, selon nous, par englober tous les autres. À notre époque, toute peur est liée à la manière dont nous nous représentons le monde, l’Autre et nous-mêmes, sous la forme d’un simulacre ou via un dispositif technologique intercesseur.

Le réel s’offre à nous à travers des filtres technologiques. Ainsi, c’est toujours à l’écran – télévision, ordinateur ou smartphone – de « rendre réel », de définir ce qui est vrai, et de nous offrir des expériences. Or, nous courons toujours le risque que ces systèmes de représentation abusent de nous et deviennent, à leur tour, oppressants. C’est le postulat même du registre horrifique du « found footage », depuis le Projet Blair Witch (Daniel Myrick et Eduardo Sánchez, 1999), en passant par les sagas Paranormal Activity (2007–2021), REC (2007–2014), ou encore Unfriended (Levan Gabriadze, 2014). Ces films, prenant l’aspect et la forme d’archive retrouvée – bien souvent domestique ou policière –, peuvent centrer leurs récits aussi bien autour de spectres, de tueurs en série ou d’extra-terrestres, car c’est le dispositif d’image lui-même, plus que le monstre, qui crée la matière horrifique.

L’inéluctabilité du mal

Deux phénomènes nouveaux semblent, toutefois, se dégager depuis quelques années. Le premier, par son absence relative dans le cinéma d’horreur, et le second, par son omniprésence.

Il s’agit tout d’abord du cataclysme écologique, que l’on retrouve de façon prégnante dans le cinéma de science-fiction, mais très peu dans les films d’horreur. Cette absence, plutôt que de témoigner d’une incapacité de représentation, relève peut-être d’un enjeu trop mondial pour être abordé par un genre finalement plus attaché à des parcours intimes, à des trajectoires d’individus confrontés à l’horreur, plutôt qu’à des horreurs sociétales.

Bien sûr, le cinéma de zombies ou d’apocalypse traite déjà en substance de cet effondrement civilisationnel, mais il faut que ce soit l’humain qui meure, et non le vivant, la nature ou l’environnement, pour que l’horreur devienne manifeste.

Quelques films, comme le long métrage français la Nuée (Just Philippot, 2020), tentent toutefois de poser la question d’une horreur humaine à partir d’une bascule environnementale. Notons également que la pandémie de Covid-19 n’a pas laissé de trace significative dans le genre horrifique. L’horreur pandémique est déjà présente au cinéma depuis les zombies de la fin des années 1960, lorsque la peur et la paranoïa suscitée par le confinement sont déjà figurées au cinéma à travers le motif de la maison hantée qui nous présente toujours des individus prisonniers d’un espace domestique devenu oppressant, voire létal.

Enfin, l’omniprésence actuelle que nous évoquions est certainement celle de l’inéluctabilité du mal. Alors que le cinéma d’horreur des décennies précédentes était encore un cinéma globalement centré sur le monstre (tueur, démon, alien, spectre, etc.), tangible et donc affrontable, notre époque contemporaine présente des antagonistes qui ne sont rien d’autre qu’une puissance abstraite de destruction.

Des films sortis cette année, comme les Maudites (El Llanto, Pedro Martin-Galero, 2024) ou Vicious (Bryan Bertino, 2025), représentent le mal comme une volonté omniprésente, omnipotente, qui dépasse et qui détruit tous les cadres de protection. La société, la famille, le réel volent en éclats ; et nous, spectatrices et spectateurs, ne pouvons que contempler la longue descente aux enfers d’individus voués au néant.

Ce motif horrifique ne nous semble pas anecdotique, tant il dit quelque chose de notre époque, de ses peurs, voire de son désespoir. Comme dans le cinéma expressionniste allemand des années 1930, une puissance a pris le contrôle de la société, et le cinéma d’horreur actuel semble se résigner à le laisser dramatiquement triompher.

Cet article est publié dans le cadre de la série « Regards croisés : culture, recherche et société », publiée avec le soutien de la Délégation générale à la transmission, aux territoires et à la démocratie culturelle du ministère de la culture.

Jean-Baptiste Carobolante ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

30.10.2025 à 15:52

Cinéma : le « slasher » chez Wes Craven, ou le retour du refoulé

Texte intégral (1545 mots)

Apparu dans les années 1970, le « slasher » est une catégorie de film d’horreur répondant à une typologie très stricte et particulièrement codifiée. Si le réalisateur Wes Craven n’est pas à proprement parler à l’origine du genre, il y a contribué de façon significative au travers de plusieurs films dont les plus marquants sont sans conteste « les Griffes de la nuit » (1984), où apparaît la figure de Freddy Krueger, et « Scream » (1996) qui lancera la vague des « neo-slashers ».

Le slasher se définit par un certain nombre de figures imposées tant dans le type de personnages mis en scène que par l’histoire qu’il raconte. C’est toujours le récit d’un groupe d’adolescents ayant commis une faute, ou dont les parents ont commis une faute. Ils sont poursuivis par un tueur, systématiquement masqué et qui les tuera avec une arme blanche, toujours la même. Les victimes s’enchaînent alors dans une série de meurtres violents liés à des transgressions adolescentes (consommation de drogues, alcool, relation sexuelle, etc.).

L’héroïne du film, toujours une femme, qui elle n’a commis aucune transgression, affronte le tueur dans un dernier face à face dont elle sortira victorieuse. C’est l’iconique « final girl ». Le tueur, vaincu, laisse généralement entendre qu’il pourrait revenir par une ultime déclaration, un effet de surprise, voir une déclaration humoristique… À titre d’exemple la scène de fin de la Fiancée de Chucky (1998), quatrième volet de la saga, où la poupée tueuse déclare d’un air dépité à celle qui la menace d’une arme : « Vas-y tue moi, je reviens toujours… C’est juste que c’est chiant de mourir. »

Aux origines d’un sous-genre du film d’horreur

Le premier film à porter tous les codes du slasher est Halloween, la nuit des masques (1978), de John Carpenter. La célèbre scène de la douche dans Psychose (1960) en est peut-être la matrice : tous les codes du slasher y sont déjà réunis (une victime féminine poignardée à répétition par un ennemi sans visage). L’autre branche historique du slasher est celle du giallo italien et notamment le célèbre film la Baie sanglante (1971), de Mario Bava, qui porte déjà certains codes, comme les morts violentes et la sexualité.

Si Wes Craven ne rejoint formellement le genre qu’en 1984, son tout premier film, que certains qualifie de « proto-slasher », la Dernière Maison sur la gauche (1972) – lui même un remake du méconnu Jungfrukällan (la Source), d’Ingmar Bergman (1960) – avait posé certains éléments du genre parmi lesquels la violence exacerbée, le rapport entre meurtre et transgression sexuelle, et l’idée d’une héroïne féminine plus forte que ses agresseurs.

En 1984, Wes Craven sort les Griffes de la nuit. Si ce film respecte scrupuleusement tous les codes du genre, on peut voir aussi comment il les tord pour mieux les affirmer. Ainsi le tueur incarné par Freddy Krueger utilise une arme improbable, puisqu’il s’est fabriqué un gant en métal garni de lames de rasoir. Il ne porte pas non plus de masque, mais il a le visage gravement brûlé. La sexualité est présente chez toutes les victimes mais aussi dans le discours de Freddy, et dans son passé de tueur pédophile. C’est d’ailleurs la vengeance des habitants du quartier qui constitue la transgression originelle que les enfants doivent expier.

Il y a quelque chose de pourri au royaume du « slasher »

Dans Scream (1996) et dans les Griffes de la nuit, on retrouve l’idée d’un secret porté par les parents dont les conséquences retombent sur les enfants. Derrière le pavillon idéal d’Elm Street se cachent des meurtriers qui ont brûlé vif un homme et le dissimulent à leurs enfants, même après les premiers meurtres dans le quartier. Dans Scream, c’est plus prosaïquement les mœurs légères d’une mère de famille assassinée et le déni de sa fille vis-à-vis de ces transgressions qui font apparaître le tueur.

On voit qu’il y a dans ces deux cas l’idée d’une société des apparences qui serait en réalité pourrie, et on retrouve la critique du mode de vie américain déjà visible chez Stephen King, par exemple. Derrière un puritanisme d’apparence, se cachent les crimes que l’on dissimule à nos enfants.

Cette thématique récurrente dans le cinéma américain (dans un registre comique, il s’agit d’ailleurs du pitch de Retour vers le futur où un adolescent élevé par une mère stricte se retrouve renvoyé dans le passé pour découvrir qu’elle-même fut une adolescente très libérée) est un point structurant dans les films d’horreur américains et encore plus dans le slasher.

Cette interprétation politique du slasher se voie complétée par une autre interprétation plus universelle et psychanalytique. Par delà la question de l’hypocrisie parentale, c’est celle du refoulement du sexuel dans les sociétés issues des trois monothéismes qui est en jeu. Si la question de la sexualité, en tant qu’elle transforme le corps, peut être perçue universellement comme un sujet d’angoisse, elle ne devient une question morale que quand elle est associée à la notion d’interdit.

Le tueur masqué et sans visage est plus facilement reconnu à son arme qu’à sa tête. Or, l’arme blanche qu’il porte et qui le caractérise n’est-elle pas justement une métaphore phallique ? Le tueur sans visage est alors une allégorie du sexuel, masculin et intrusif, s’opposant à la figure de la jeune femme vertueuse. L’angoisse du spectateur devant l’antagoniste se conçoit alors comme la matérialisation d’une angoisse adolescente, celle de l’entrée dans la sexualité.

Un genre féministe ou conservateur ?

Entre la figure forte de la « final girl » et les transgressions sexuelles à l’origine des meurtres se pose la question récurrente du message porté par les slashers. Ambivalent par nature, il est difficile de dire du slasher s’il est féministe ou conservateur. En nous plaçant régulièrement derrière le masque du tueur, nous nous retrouvons dans la position de celui qui punit, prenant de fait le parti d’une morale conservatrice. Mais, d’un autre côté, on y découvre que la société présentée aux autres personnages comme vertueuse est le plus souvent pourrie par le secret et par le mensonge.

L’héroïne adolescente du film se voit alors prise entre deux mondes d’adultes aussi peu enviables l’un que l’autre et nous rappelle une autre figure culte du cinéma adolescent, dans un tout autre genre, celle de Pauline à la plage (1983), d’Éric Rohmer, où les tartufferies des adultes les décrédibilisent et font comprendre à Pauline qu’elle devra trouver son propre chemin loin des modèles et des figures imposées. Une « final girl » à la française pour ainsi dire…

Maxime Parola ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.