11.05.2019 à 09:45

Mythes et légendes de l’intelligence artificielle

signauxfaiblesco

Texte intégral (8549 mots)

Que n’a-t-il pas déjà été dit sur l’intelligence artificielle (IA) ? La fascination – ou l’agacement – que suscite l’IA est à la hauteur du buzz médiatique qui a porté le sujet ces dernières années.

A coup de punchlines de certaines personnalités désormais bien connues (« sans politique volontariste en matière d’IA, la France pourrait devenir le Zimbabwe de 2080 »), le sujet est sorti des seules sphères technophiles pour se loger au cœur des discours de nombreux dirigeants d’entreprises, personnalités politiques, philosophes, etc.

Ces phrases chocs ont eu du bon. Elles ont réveillé des décideurs pour certains apathiques face à la montée de la technologie, inconscients de la domination américaine et chinoise et des enjeux sous-jacents de souveraineté. Elles ont servi de déclic pour accélérer la prise de conscience.

Reste pourtant, malgré ce tintamarre (qui n’a rien eu d’artificiel, lui), comme un goût d’inachevé. Le sentiment que l’accumulation de prophéties catastrophistes (« les dirigeants européens sont les Gamelin de l’IA ») a parfois empêché de faire entendre un discours plus nuancé, plus distancié. Que le sensationnalisme l’a trop souvent emporté au détriment d’une réalité scientifique plus prosaïque, forcément moins spectaculaire.

De là le besoin de revenir sur terre. C’est l’objet de cet article.

Mythe n°1 : croire qu’il existe UNE intelligence artificielle

L’IA englobe parfois des réalités très différentes. Selon les points de vue et ce que l’on y inclue, elle peut renvoyer aussi bien à des logiques d’automatisation (faire effectuer, par un logiciel, des tâches répétitives et souvent fastidieuses – de là l’essor des « chatbots » par exemple) ou de statistiques. Les statistiques ouvrent la voie au « machine learning » (apprentissage automatique), un sous-domaine de l’IA dont les progrès permettent de réaliser des tâches plus complexes (reconnaissance visuelle et vocale, prévisions, recommandations…). Le machine learning regroupe lui-même plusieurs subdivisions, dont l’apprentissage supervisé et l’apprentissage non-supervisé, et peut mener au fameux « deep learning», qui s’appuie notamment sur les « réseaux de neurones ».

Précisons également que contrairement à certaines idées répandues, l’IA ne se résume pas au machine learning, et que le deep learning n’est pas nécessairement « l’approche ultime » en matière d’IA.

Face à ce jargon, il est facile de s’emmêler les pinceaux ; les différentes notions se retrouvent d’ailleurs parfois mélangées…sciemment. Des outils relativement simples sont parfois présentés comme des solutions d’IA très innovantes, en induisant en erreur sur leur caractère faussement révolutionnaire.

Mythe n°2 : croire que la mention « IA » rime forcément avec innovation

« Il y a cette blague dans Le Bourgeois gentilhomme à propos d’un homme [Monsieur Jourdain] qui apprend que toute parole est soit prose, soit vers, et qui est enchanté de découvrir qu’il a parlé en prose toute sa vie sans en avoir conscience. Les statisticiens pourraient ressentir la même chose aujourd’hui : ils ont travaillé sur « l’intelligence artificielle » toute leur carrière sans en avoir conscience » – Benedict Evans

Certains malins profitent de la méconnaissance entourant ces sujets pour présenter leurs solutions sous un nouveau jour. C’est ainsi que des modèles statistiques utilisés avec un peu d’informatique connaissent parfois un toilettage marketing pour se transformer en outil d’« IA », ce qui sonne plus moderne.

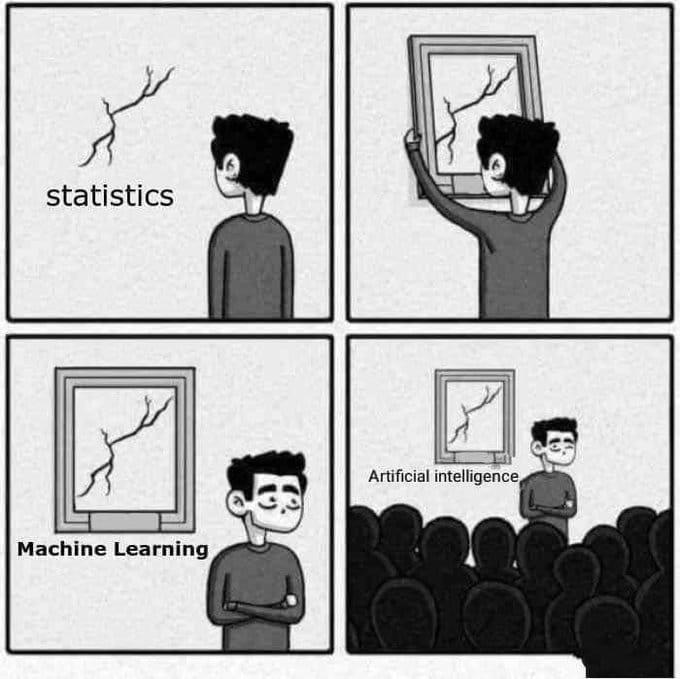

Comme l’écrit le chercheur Thierry Berthier, « l’emploi du mot IA devient un marqueur séparant le discours marketing grand public du discours d’expert pratiquant ». Cette séparation se retrouve par exemple dans cette blague qui a circulé ces derniers mois sur les réseaux sociaux :

Une étude récente indiquait même que 40% des « startups IA » en Europe n’utiliseraient en réalité pas d’IA ! Si ce chiffre a été déconstruit ensuite, la vitesse de sa propagation témoigne d’un sentiment largement partagé autour d’un certain niveau de tartufferie en la matière…

Mythe n°3 : croire que l’IA est une technologie de luxe, accessible à quelques happy few

Une distinction est importante à avoir en tête : « faire de l’IA » est très différent d’ « utiliser de l’IA ». « Très peu de startups créent de nouvelles briques de l’IA » explique ainsi le consultant Olivier Ezratty : « les briques de base de l’IA sont un Lego géant essentiellement disponible en open source. Une bonne part du travail d’aujourd’hui consiste à les choisir et à réaliser un travail d’intégration et d’assemblage ».

L’investisseur Benedict Evans va jusqu’à écrire qu’ « il n’y aura bientôt plus aucune startup « IA ». On parlera plutôt d’entreprises d’analyses de processus industriels, d’entreprises d’optimisation de ventes, d’entreprises d’aide à la résolution de litiges, etc. », toutes rendues possibles grâce à l’IA.

Pour lui, « la diffusion du machine learning signifie des startups très diverses peuvent construire des choses bien plus rapidement qu’avant. Le machine learning doit être vu comme un bloc de construction qui ouvre de nouvelles possibilités et qui sera intégré partout. Si vous ne l’utilisez pas alors que vos concurrents l’utilisent, vous vous ferez distancer. »

Il dresse un parallèle entre le machine learning et le langage de programmation SQL (langage phare pour communiquer avec des bases de données) : « Walmart a connu le succès en partie grâce à l’utilisation de bases de données pour gérer ses stocks et sa logistique plus efficacement. Mais aujourd’hui, si vous créez une entreprise de distribution en annonçant que vous utiliserez des bases de données, cela ne vous rendrait ni différent ni intéressant, car SQL a été intégré partout. La même chose se produira avec le machine learning. »

Dès lors, l’IA ne sera plus forcément un élément différenciant pour une startup. Cette situation commence du reste déjà se manifester : selon Olivier Ezratty, « comme les briques de l’IA sont devenues des commodités, il est de plus en plus difficile de jauger une startup par rapport à ses concurrents. La différence pourra venir de l’IA, mais le plus souvent, elle viendra de la capacité à toucher les bons clients et à déployer rapidement. »

Mythe n°4 : croire que les GAFA deviendront puissants dans tous les domaines grâce aux multiples données dont ils disposent

Pour faire fonctionner une IA de façon performante, les données à exploiter doivent être spécifiques au problème à résoudre ; dès lors, collecter des données n’a d’intérêt que si celles-ci ont bien un lien avec le problème visé.

C’est ce qu’explique Benedict Evans, qui l’illustre par un exemple simple : « D’un côté, General Electric dispose de nombreuses données télémétriques venant de turbines à gaz. De l’autre, Google dispose de nombreuses données de recherche. Or on ne peut pas utiliser des données de turbines pour améliorer des résultats de recherche. On ne peut pas non plus utiliser les données de recherche pour détecter des turbines défectueuses ».

Autrement dit, « le machine learning est une technologie généraliste – elle peut être utilisée aussi bien pour détecter des fraudes que reconnaître des visages – mais les applications qu’elle permet de construire ne sont pas généralistes : elles sont spécifiques à une tâche ».

C’est du reste ce que l’on avait connu lors des précédentes vagues d’automatisation, juge-t-il : « tout comme une machine à laver peut seulement laver des vêtements, et non laver des plats ou cuisiner un repas, et tout comme un programme pour jouer aux échecs ne peut pas remplir votre fiche d’imposition, un système de traduction à base de machine learning ne peut pas reconnaître des chats. »

De ce constat, Benedict Evans tire une conclusion : l’utilisation du machine learning se répartira de façon large. « Google n’aura pas « toutes les données » : Google aura toutes les données obtenues via les services Google. Google aura des résultats de recherche plus fins, General Electric aura des machines plus performantes, Vodafone aura une meilleure vue sur la gestion de son réseau, etc. »

En définitive, « Google sera meilleur à être Google, mais cela ne veut pas dire que Google deviendra meilleur à autre chose. »

Mythe n°5 : croire que l’IA est aujourd’hui souvent intelligente

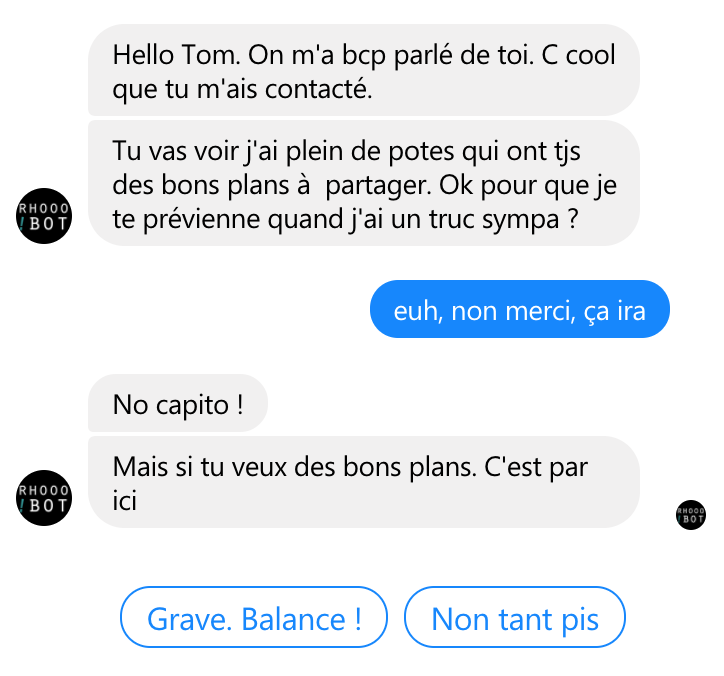

Qui n’a pas déjà vécu des échanges particulièrement laborieux (pour ne pas dire pénibles) avec des chatbots ou des agents conversationnels ?

Chacun aura noté que ces outils disposent encore d’une (très) large marge de progression avant de pouvoir soutenir une conversation décente. L’échange ci-dessous en est un exemple criant :

Les chatbots ne sont certes pas représentatifs des avancées de l’IA aujourd’hui. Mais s’il est évident que l’IA est d’ores et déjà capable de performances impressionnantes (cf ses victoires au jeu de go, aux échecs, ou encore au jeu Starcraft), soyons clairs : une IA brillante dans un contexte donné ne l’est pas forcément dans d’autres contextes – et ne l’est même souvent pas.

Il y a quelques semaines, on apprenait ainsi que l’IA de DeepMind (appartenant à Google), célèbre pour ses prouesses au jeu de go, avait largement raté un contrôle de mathématiques destiné à des adolescents de 16 ans dans le cursus scolaire britannique. Son score : 14 sur 40, soit la note E dans le système britannique. Elle n’a pas réussi à transformer les mots en calcul et en équation, alors qu’elle avait pourtant été entraînée sur le sujet.

Au-delà de cette anecdote, les exemples de « déraillement » d’IA sont multiples. On se souvient notamment du robot conversationnel mis en ligne par Microsoft en 2016 qui s’était transformé en quelques heures en personnage machiste, raciste et néo-nazi, sous l’influence d’internautes.

Un an auparavant, la reconnaissance faciale de l’application Photos de Google avait assimilé un couple afro-américain à des gorilles. Le site Wired a révélé fin 2018 que Google, après s’être déclaré « consterné » et après avoir promis de remédier au problème, avait en réalité choisi ensuite de…supprimer les gorilles et d’autres primates (chimpanzés, singes…) du lexique de son service. Comme l’écrit Wired, « cette solution de contournement illustre les difficultés rencontrées par Google et d’autres entreprises technologiques pour faire progresser la reconnaissance d’image ».

Le cas emblématique de Watson

Le système Watson d’IBM était annoncé à ses débuts comme capable de révolutionner la médecine : son IA allait être capable de détecter des maladies plus rapidement, de proposer des traitements plus adaptés, etc. En 2018, le couperet tombe : selon des documents internes révélés par le site StatNews, des spécialistes ont identifié de « multiples exemples de recommandations de traitements de cancers dangereux et incorrects » effectuées par Watson. Malgré des milliards investis, Watson reste très peu performant par rapport aux ambitions affichées.

Par exemple, comme nous l’apprend une grande enquête récente intitulée « How IBM overpromised and underdelivered with Watson Health », « il s’est avéré impossible d’enseigner à Watson comment lire des articles scientifiques comme un médecin le ferait. Le fonctionnement de Watson est fondé sur les statistiques : tout ce qu’il peut faire est de rassembler des statistiques sur les principaux résultats. Mais ce n’est pas comme ça que les médecins travaillent. »

Les chercheurs ont ainsi découvert que Watson peinait à exploiter de façon autonome des informations publiées très récemment dans la littérature médicale. De même, Watson s’est avéré avoir plus de mal que prévu à récupérer des informations contenues dans les dossiers médicaux électroniques.

In fine, « il ne suffit pas de prouver que vous disposez d’une technologie puissante » déclare Martin Kohn, un ancien scientifique médical d’IBM. « Il faut prouver qu’elle va réellement faire quelque chose d’utile – que ça va améliorer ma vie, et celle de mes patients. » Or selon lui, « à date il existe très peu de publications » scientifiques qui prouvent le bénéfice de l’IA pour les médecins. « Et aucune s’agissant de Watson ».

***

« L’intelligence artificielle est devenue un gros business et il est très probable qu’il y ait un retour de bâton quand les promesses les plus extravagantes ne seront pas remplies » Yann Le Cun, directeur du laboratoire IA de Facebook, en 2017

Face à cette réalité crue, qui ne correspond pas toujours aux promesses (sur)vendues, certaines entreprises s’adaptent…et innovent dans leur manière de communiquer ! En la matière, la palme revient sans aucun doute à l’organisation OpenAI (notamment soutenue par Elon Musk) : OpenAI a laissé diffuser l’idée selon laquelle elle aurait préféré ne pas sortir son IA publiquement car celle-ci serait trop…dangereuse ! Le sociologue Antonio Casilli résume bien ci-dessous avec humour ce qui semble plus probable…

De fait, après vérification, les résultats d’OpenAI se révèlent effectivement « moins bons que ceux des IA spécialisées obtenues par apprentissage supervisé », selon Laurent Besacier, professeur au laboratoire d’informatique de Grenoble…

Mythe n°6 : croire que l’IA peut fonctionner sans intervention humaine

Dans son récent ouvrage « En attendant les robots : enquête sur le travail du clic », Antonio Casilli montre que le grand remplacement des hommes par les robots est un fantasme, en mettant en lumière une face cachée de l’IA : l’existence de millions de « travailleurs du clic » invisibilisés, précarisés, payés à la micro-tâche pour éduquer des algorithmes.

Antonio Casilli cite par exemple le scandale ayant touché fin 2017 l’entreprise américaine Expensify, spécialisée dans la gestion par l’IA de la comptabilité d’autres entreprises. En apparence, « les salariés de ces entreprises n’avaient qu’à photographier leurs factures et leurs reçus, et l’application les organisait en notes de frais. On a découvert que des personnes recrutées sur la plateforme de micro-travail Amazon Mechanical Turk transcrivaient et labellisaient en temps réel une partie de ces factures. »

Cet exemple n’est pas isolé. En réalité, « il y a toujours une part d’algorithmes et une part de travail humain ». Pour concevoir son programme Watson, IBM a ainsi recouru à 200 000 micro-travailleurs qui devaient notamment ordonner les différents éléments de l’image d’un paysage (nuages, montagnes, etc.).

Casilli souligne une hypocrisie du milieu technologique, où il perçoit « une attitude double. Tout le monde connaît l’existence des plateformes de micro-travail et comprend l’exigence d’impliquer des humains dans l’étiquetage et le nettoyage de l’information. En même temps, il y a une espèce d’effort cognitif pour ne pas voir ce qu’on sait pertinemment. »

Lorsqu’il est reconnu, ce travail humain est fréquemment minoré, à tort : « cette partie du processus est décrédibilisée en tant que travail : on imagine que les micro-tâches qu’accomplissent les travailleurs du clic ont une faible valeur ajoutée, qu’elles ne sont pas centrales ; or leur contribution est cruciale. »

Une équipe de recherche du CNRS, Télécom ParisTech et MSH Paris-Saclay, dans laquelle fait partie Antonio Casilli, a du reste montré que les plateformes paient en France métropolitaine 266 000 personnes pour micro-travailler (avec une rémunération par micro-tâche de quelques dizaines de centimes d’euro). Dans le monde, ces « poinçonneurs de l’IA » comme les appelle Casilli, seraient entre 40 millions et…des centaines de millions, constituant ainsi une nouvelle division du travail au niveau mondial. Leur rémunération peut descendre jusqu’à 0,000001 centime la tâche, sans accès aux droits de protection des travailleurs salariés.

Casilli est formel : l’IA ne pourra pas devenir assez développée pour se passer des micro-tâches. « Il n’y aura pas d’automatisation complète. Les machines que les ingénieurs de l’IA sont en train de développer n’ont pas vocation à travailler toute seule : [elles] prévoient toujours la réalisation de tâches par les humains. »

Mythe n°7 : croire que le « machine learning » et le « deep learning » ont plié le match en matière d’IA

Début 2019, la chercheuse en statistique Genevera Allen jetait un froid lors du congrès annuel de l’Association américaine pour l’avancement de la science : « Je ne ferais pas confiance à une très grande partie des découvertes [médicales] en cours ayant recours à du machine learning appliqué à de grands ensembles de données ».

« Ces algorithmes sont entrainés pour détecter des « patterns » quoi qu’il arrive », explique-t-elle. « Ils ne reviennent jamais avec « je ne sais pas « ou « je n’ai rien découvert » : ils ne sont pas conçus pour cela. »

Le machine learning entraîne de ce fait une crise de reproductibilité des découvertes, estime-t-elle. Quand le machine learning établit un lien entre les gènes de certains patients et leur maladie, les chercheurs peuvent ensuite rationaliser scientifiquement leur découverte sans que cette rationalisation soit correcte. « On peut toujours construire une histoire [a posteriori] pour montrer pourquoi des gènes donnés sont regroupés ensemble » explique Dr Allen.

Ce problème de reproductibilité risque de mener les scientifiques vers de fausses pistes (voire des résultats incorrects) et gaspiller des ressources (en essayant de confirmer des résultats impossibles à reproduire). La mise en garde de Genevera Allen a permis de (re)mettre en lumière ce problème. Pour le surmonter, en attendant l’émergence d’une nouvelle génération d’algorithmes à même d’évaluer la fiabilité de leurs résultats, les chercheurs doivent s’assurer eux-mêmes de la reproductibilité de leurs expériences.

***

Cette invitation à la prudence autour du machine learning n’est pas isolée.

Les exemples ne manquent pas pour souligner les problèmes liés plus particulièrement au deep learning. En 2016, une étude s’est penchée sur le succès – proche de 100% – d’une IA qui avait été entraînée pour distinguer les chiens et les loups sur des images données. Il s’est avéré que l’algorithme se fondait avant tout sur…la couleur de fond des images : il y cherchait de la neige car les images de loups sur lesquelles il avait été entraîné comportait souvent de la neige en fond.

Dans le même ordre d’idées, des chercheurs nord-américains se sont rendus compte en 2018 qu’en ajoutant un éléphant dans certaines images, en fonction de son emplacement, le système ne le voyait pas…ou bien le prenait pour une chaise !

Bien d’autres exemples pourraient être cités (en 2017, des chercheurs japonais ont montré qu’en changeant un seul pixel d’une image de chien blanc, l’IA se mettait à y voir une autruche). Tous soulignent la même chose : ces algorithmes parviennent à des résultats sans comprendre ce qu’ils font. Ils peuvent être performants pour certaines tâches de perception (encore qu’il suffit donc parfois d’un changement de pixel pour les tromper), mais butent sur les tâches de raisonnement.

Le succès de l’IA d’AlphaGo (appartenant à Google), premier programme informatique à avoir battu l’humain au go, semble d’ailleurs être à l’origine d’un malentendu. AlphaGo a brillé en s’appuyant sur une IA non-supervisée, reposant sur du deep learning, pouvant donner l’impression que cette approche était intrinsèquement supérieure aux autres. En réalité, cette approche était plus simplement la plus pertinente pour le jeu de go, dont les règles sont particulièrement structurées et logiques. Or ce contexte très spécifique est loin de se retrouver souvent ailleurs, en particulier lorsqu’il s’agit d’activités humaines.

« Un énorme problème à l’horizon est de doter les programmes d’IA de bon sens : même les petits enfants en ont, mais aucun programme de deep learning n’en a », estime le spécialiste américain Oren Etzioni.

In fine, les algorithmes de deep learning « n’apprennent que des indices superficiels, et non des concepts », diagnostique le chercheur Yoshua Bengio, justement l’un des pères fondateurs du deep learning.

Or ces problèmes relèvent de traits inhérents à ces systèmes, et non de bugs…

***

Dans ce contexte de (re)questionnement autour du deep learning, de plus en plus de voix plaident pour élargir les méthodes de recherche utilisées en IA. Ironie de l’Histoire : les regards se tournent vers l’IA dite symbolique (l’enchaînement de règles explicites pour construire un raisonnement), approche historique autrefois reine mais qui était tombée en désuétude avec l’émergence du machine learning.

L’enjeu est aujourd’hui de réussir à exploiter l’apprentissage statistique (ce dont le machine learning relève) et les méthodes symboliques de façon combinée. Les questionnements restent entiers sur les façons de procéder, mais des expérimentations ont commencé.

Antoine Bordes, directeur du laboratoire d’IA de Facebook, entend ainsi dépasser les limites du machine learning dans le langage (en particulier en compréhension de texte, où le machine learning est très peu performant) en « créant des architectures qui peuvent être entraînées sur des données mais qui s’appuient sur le symbolique ».

« La prochaine génération d’IA aura une architecture hybride » confirme la chercheuse Véronique Ventos, qui a cofondé le laboratoire privé NukkAI avec un (premier) objectif : créer une IA capable de briller au Bridge (jeu qui y résiste encore)…

Une opportunité pour l’Europe ?

Dans une tribune parue en mars 2019, Virginia Dignum, professeur d’informatique à l’université d’Umeå en Suède, appelle l’Europe à « explorer des alternatives » au machine learning :

« Il y a peu, une étude ayant analysé 25 ans de recherche en IA a conclu que l’ère du deep learning touche à sa fin. L’Europe a traditionnellement été forte sur les approches symboliques de l’IA. Dès lors, ce serait une erreur de suivre aveuglement les US et la Chine dans leur « course » au machine learning alors que nous avons l’opportunité de montrer la valeur d’approches alternatives, dans lesquelles nous Européens pourrions avoir un avantage. »

Ces réflexions mériteraient d’être plus écoutées en France. Comme l’écrit Olivier Ezratty, « le rapport de la Mission Villani fait la part belle au deep learning. L’approche symbolique semble y être mise en sourdine. (…) De même, l’IA symbolique est assez maigrement représentée dans la feuille de route de l’INRIA de 2016. (…) Pourtant, en prenant du recul, on peut se demander si l’enjeu n’est que dans le deep learning »…

Mythe n°8 : croire que l’IA peut dépasser l’intelligence humaine de façon générale

La thèse de la singularité, selon laquelle l’IA sera capable de dépasser l’intelligence humaine au cours des toutes prochaines décennies, continue étonnamment d’être considérée par certains comme une hypothèse crédible, malgré de multiples remises en cause de la part de spécialistes :

-Jean Ponce, chercheur en vision artificielle à l’ENS, en avril 2017 : « La Singularité, ça m’énerve. Je ne vois personnellement aucun indice que la machine intelligente soit plus proche de nous aujourd’hui qu’avant ».

–Jean-Louis Dessalles, chercheur en intelligence artificielle et en sciences cognitives, auteur de l’ouvrage « Des intelligences très artificielles », en février 2019 : « La question de la Singularité technologique ressemble à celle de la surpopulation sur Mars : on ne peut exclure que le problème se pose un jour, mais ce n’est pas demain ».

-Luc Julia, vice-président de l’innovation chez Samsung, inventeur de l’assistant vocal d’Apple, en mars 2019 : « Notre vision menaçante de l’intelligence des machines découle en partie de notre anthropomorphisme. Ces assistants ne sont que des mathématiques et des statistiques, ils répondent à des règles édictées en amont. Jamais une IA ne sera aussi intelligente qu’un humain ».

Comment comprendre, dès lors, la permanence de la thèse de la Singularité ? Dans son ouvrage « Le mythe de la Singularité – faut-il craindre l’intelligence artificielle ? » paru en 2017, l’informaticien et philosophe Jean-Gabriel Ganascia tente d’apporter une explication. Selon lui, cette thèse est avant tout défendue par des ingénieurs travaillant, en large partie, pour des géants technologiques et ayant l’impression, réelle ou exagérée, de changer le monde. Il parle d’un « sentiment de vertige » et de puissance chez ces ingénieurs qui en viennent à surestimer la capacité des géants du numérique à bouleverser les réalités existantes et l’humanité. Ce sentiment est accentué par le fait que ces entreprises ont réussi en très peu de temps – quelques années, contre plusieurs décennies pour les entreprises traditionnelles – à devenir des géants économiques. Il estime qu’il existe donc des prédispositions chez ces ingénieurs à croire les thèses de la Singularité.

A cette prédisposition se rajoute une forme de complaisance liée à l’envie de « se faire peur face à la technologie » : cette complaisance, juge-t-il, est véhiculée par certains médias qui préfèrent le spectaculaire à la réalité plus prosaïque et…scientifique. Il prend ainsi l’exemple de l’idée selon laquelle il deviendra un jour possible de télécharger son propre esprit sur une machine afin de rendre son esprit immortel. Cette idée, portée notamment par un milliardaire russe ayant initié le projet 2045.com (qui, à son lancement, invitait l’internaute à appuyer sur un “bouton d’immortalité”), ne repose sur aucun fondement scientifique, et a pourtant été amplement médiatisée, contribuant ainsi à véhiculer les peurs et inquiétudes liées à l’IA.

Enfin, Ganascia relève le fait que ces craintes remontent bien avant l’invention d’Internet et avant même l’arrivée des ordinateurs. Il prend ainsi l’exemple d’une scène du film Fantasia, sorti en 1940, où plusieurs balais commencent à s’animer et à porter des seaux d’eau à la place du personnage principal. “Cette inquiétude-là, d’être dépassé un jour, me semble ancrée dans le cœur de l’homme. C’est pour cela que l’idée de Singularité est assez populaire” juge-t-il.

***

Pour autant, si de nombreuses voix ont remis en cause la Singularité, peu d’entre elles se sont attelées à déconstruire cette thèse méthodiquement.

C’est en cela que le long article intitulé « Le mythe de l’intelligence artificielle super-humaine », écrit par l’auteur américain Kevin Kelly en 2017, est particulièrement précieux.

Dans cet article, il montre que croire que l’IA peut être plus intelligente que l’homme relève d’une mauvaise compréhension de ce qu’est l’intelligence.

Selon les défenseurs de la Singularité, comme Nick Bostrom, il existerait une échelle de l’intelligence, comme il existe une échelle des niveaux sonores en décibels. Dans ce paradigme, il est envisageable de penser une extension de l’intelligence qui ne ferait que croître, étape par étape, et in fine dépasserait notre propre intelligence.

Or la réalité scientifique s’oppose à la vision simpliste d’une intelligence à une seule dimension qui augmenterait de façon linéaire.

L’idée d’une échelle de l’intelligence n’est pas valable scientifiquement, montre Kevin Kelly, de la même façon qu’il n’existe pas d’échelle de l’évolution contrairement à une croyance tenace. “Chacune des espèces présentes aujourd’hui sur Terre a survécu à une chaîne de trois milliards d’années de reproductions successives, ce qui signifie que les bactéries et les cafards sont aujourd’hui aussi évolués que les humains : il n’y a pas d’échelle”, écrit-il. C’est la même chose pour l’intelligence : loin de pouvoir être réduite à une seule dimension, elle est constituée de différents modes cognitifs, composés de multiples nœuds, chacun suivant son propre continuum. “Certaines intelligences peuvent être très complexes, avec de nombreux sous-nœuds de pensée ; d’autres peuvent être plus simples mais plus extrêmes, plus pointues sur certains aspects”.

Il appelle à voir l’intelligence comme une symphonie où co-existent plusieurs types d’instruments : ceux-ci n’ont pas seulement des différences en termes de volume, mais aussi en tempo, en mélodie, etc. Dans cette perspective, il convient selon lui de penser les intelligences dans une logique d’écosystème, où les différents noeuds de pensée sont co-dépendants. “L’intelligence humaine fait appel à de multiples raisonnements cognitifs : la déduction, l’induction, le raisonnement par symboles, l’intelligence émotionnelle, la logique spatiale, la mémoire de court terme, de long terme” énumère-t-il. Du reste, il rappelle que notre intestin, et son système nerveux, présente des caractéristiques similaires à celles du cerveau et a développé sa propre logique cognitive. L’homme, loin de penser seulement avec son cerveau, pense avec tous les éléments de son corps.

Cette analyse permet d’éclairer avec un autre regard les questions d’intelligence artificielle. L’IA surpasse déjà l’homme dans certaines compétences, comme le calcul arithmétique, ou la mémoire (sous certains aspects). L’homme conçoit des IA pour qu’elles l’aident à atteindre l’excellence sur des compétences précises. Il s’agit d’éléments que l’homme est capable de réaliser, mais que l’IA peut mieux faire.

Il existe également des modes cognitifs auxquels l’homme n’a pas accès, au contraire de l’IA : par exemple, retenir (et indexer) tous les mots et expressions présents sur des milliards de sites internet. Pour Kevin Kelly, il est probable qu’à l’avenir l’homme concevra spécialement pour l’IA de nouveaux modes cognitifs inexistants chez lui ou dans la nature, en particulier pour des tâches précises.

“Certains problèmes nécessiteront une solution en deux étapes : d’abord, inventer un nouveau mode de pensée pour travailler avec les nôtres ; puis les combiner pour trouver la solution au problème donné. Dès lors, comme nous pourrons résoudre des problèmes que nous ne pouvions pas résoudre jusqu’alors, nous voudrons qualifier ce mode comme “plus intelligent” que nous, alors qu’il sera en réalité simplement différent.”

En définitive, le grand avantage de l’IA réside pour lui dans les différences de façons de penser qu’elle permettra d’atteindre. “Je pense qu’un modèle utile est de penser l’IA comme étant une intelligence étrangère ; c’est sa différence qui sera son actif clef”.

Il est donc faux d’affirmer que l’intelligence artificielle peut dépasser l’intelligence humaine de façon générale. Certes, certains modes cognitifs permis par l’IA pourront régler des problèmes que l’homme ne pouvait pas régler, et il sera alors tentant de parler d’IA “superhumaine”, mais cela serait erroné : “nous ne qualifions pas aujourd’hui Google d’IA superhumaine même si sa capacité de mémorisation est plus forte que la nôtre !”. Google, malgré sa puissance de mémorisation, reste impuissant pour réaliser de nombreuses tâches que l’homme peut (mieux) faire que lui. En somme, pour des tâches spécifiques très complexes, l’IA pourra dépasser l’homme, mais “aucune entité ne fera mieux tout ce que fait l’homme”. Kevin Kelly dresse le parallèle avec la force physique des humains : “la révolution industrielle a 200 ans ; même si les machines battent les hommes sur des aspects précis (rapidité à se déplacer, précision, etc.), il n’existe aucune machine capable de battre un humain moyen sur tout ce qu’il ou elle fait”.

Pour compléter le propos, Kevin Kelly montre qu’il est extrêmement difficile, si ce n’est impossible, de mesurer la complexité d’une intelligence de façon scientifique. “Nous n’avons pas de bons outils de mesure de la complexité qui pourraient déterminer si un concombre est plus complexe qu’un Boeing 747, ou les façons dont leur complexité diffèrent”. Dès lors il juge que cela n’a aujourd’hui pas de sens de dire qu’un esprit A est plus intelligent qu’un esprit B. Ce qui compte avant tout n’est pas de se préoccuper d’une IA potentiellement plus avancée que nous à l’avenir, mais de la complémentarité de l’IA avec l’humain, et des défis que cela pose.

La crainte d’une IA globalement supérieure à l’humain est d’autant moins fondée, estime-t-il, que l’IA suivra très probablement la même règle qui s’applique à toute création : il n’est pas possible d’optimiser l’ensemble de ses caractéristiques. Des compromis sont nécessaires. Autrement dit, il n’est pas envisageable de voir naître une IA qui soit capable à la fois de tout faire et de le faire mieux que des humains ou des IA spécialisées. Il souligne d’ailleurs que cette même règle est également valable pour l’homme. “L’intelligence humaine n’est pas en position centrale, avec les autres intelligences spécialisées qui tourneraient autour d’elle. Elle représente en réalité un type très, très spécifique d’intelligence qui a évolué durant des millions d’années pour permettre à l’homme de survivre sur cette planète.” Il explique que si l’on établissait une carte de toutes les formes possibles d’intelligences, celle humaine serait située “quelque part dans un coin, de la même façon que notre monde est situé quelque part dans un coin d’une vaste galaxie”.

Enfin, il estime que la peur d’une IA capable de battre l’homme sur son propre terrain, c’est-à-dire sur des modes cognitifs similaires, est infondée car cela nécessiterait de concevoir une IA fonctionnant sur les mêmes substrats que le cerveau humain. “La seule manière d’atteindre un processus de pensée très proche de celui de l’humain est de faire fonctionner le mécanisme avec une matière très proche de la matière humaine. La matière physique influence en effet très fortement le mode cognitif”. Or les coûts de création d’une telle matière seraient immenses ; plus le tissu à créer serait similaire au tissu d’un cerveau humain (à supposer bien sûr que cela soit faisable), plus les coûts seraient élevés, ce qui rendrait in fine l’opération extrêmement peu efficiente. “Après tout, concevoir un humain est quelque chose qu’on peut faire en neuf mois” rappelle-t-il…Et ce d’autant plus que l’intelligence humaine, comme déjà montré précédemment, n’est pas seulement présente dans le cerveau de l’homme, mais bien dans tout son corps. “Un nombre important de données montre que le système nerveux de nos intestins guide nos processus de prise de décisions rationnels, et peuvent aussi bien prédire qu’apprendre. Une intelligence qui fonctionnerait sur une matière très différente penserait différemment.”

Pour toutes ces raisons, Kevin Kelly appelle à inventer de nouveaux termes, un nouveau vocabulaire, pour décrire les différentes formes d’intelligence, avec lesquelles l’homme agira de plus en plus à l’avenir. Il cite les travaux de Murray Shanahan, professeur de robotique cognitive à l’Imperial College de Londres pour évoquer le fait qu’il existe des millions de types d’intelligences possibles. Pour l’illustrer, il donne plusieurs exemples : un esprit similaire à celui humain, mais plus rapide dans ses réponses ; un esprit très lent, mais disposant d’une très grande capacité de stockage et de mémorisation ; un esprit capable d’imaginer un esprit plus intelligent mais incapable de le concevoir ; un esprit capable de concevoir un esprit plus intelligent ; un esprit très logique mais dépourvu d’émotions ; etc.

In fine, tout porte à croire selon lui qu’il n’y aura pas des IA “superhumaines” mais plutôt plusieurs centaines d’IA qui dépasseront chacune les capacités cognitives humaines sur des compétences précises, mais dont aucune ne pourra couvrir aussi bien que l’homme tous les champs cognitifs. “Je comprends que l’idée d’une IA superhumaine soit très attrayante ; mais si on inspecte les données que nous avons jusqu’à présent sur l’intelligence, aussi bien naturelle qu’artificielle, nous ne pouvons en conclure qu’une chose : c’est un mythe.”

Conclusion

En 1956, le chercheur Herbert Simon, qui recevra des années plus tard le « prix Nobel » d’économie et le prix Turing en informatique, prédit que « les machines seront capables, d’ici vingt ans, de faire n’importe quel travail pouvant être fait par l’homme ».

Plus de soixante ans plus tard, la prédiction ne s’est toujours pas réalisée…et semble loin de l’être prochainement.

La vision de l’IA va s’affiner. Une certaine bulle pourrait éclater lorsqu’il deviendra clair que certaines promesses ne seront pas délivrées (de sitôt).

D’ores et déjà, en Chine le temps des « désillusions » s’est ouvert, selon la correspondante « tech » en Asie du Financial Times : « le secteur chinois de l’IA, auparavant très actif, vit une forme de découragement : rejeté par les investisseurs, incapable de délivrer des technologies de pointe et ayant du mal à générer des profits. (…) Les investisseurs sont confrontés à des évaluations démesurées, à des discours exagérés et à des modèles de monétisation usés ».

Le terme IA pourrait lui-même mal vieillir, lui qui est déjà assez décrié.

Comme l’explique Luc Julia : « Tout est parti d’un immense malentendu. En 1956, lors de la conférence de Dartmouth, [l’informaticien] John McCarthy a convaincu ses collègues d’employer l’expression « intelligence artificielle » pour décrire une discipline qui n’avait rien à voir avec l’intelligence. Tous les fantasmes et les fausses idées dont on nous abreuve aujourd’hui découlent, selon moi, de cette appellation malheureuse. »

Pour Luc Julia, il faudrait plutôt parler d’« intelligence augmentée » ; Jean-Louis Dessalles prône quant à lui l’expression d’« informatique avancée ».

Toutes ces remarques ne doivent pas faire oublier les progrès bien réels réalisés dans le domaine, parfois formidables, parfois glaçants (à relier au « capitalisme de surveillance »). Mais une chose est sûre : intelligente ou non, l’IA est encore très loin d’atteindre tout ce que l’Homme peut réaliser, à commencer par notre capacité…d’humour. Les concepteurs d’assistants vocaux se sont ainsi aperçus, au fur et à mesure de l’usage de leurs outils, que la fonction la plus utilisée s’avère être « raconte-moi une blague ». Face à la quantité de demandes de blagues, Amazon (pour Alexa) et Microsoft (pour Cortana) n’ont donc eu d’autres choix que d’embaucher des humoristes – autrement dit, de bons vieux humains…

01.05.2019 à 16:30

L’émergence d’un nouveau Zeitgeist

signauxfaiblesco

Texte intégral (5426 mots)

On apprenait récemment que le célèbre Manneken-Pis de Bruxelles, qui sert de fontaine publique depuis des siècles (au moins depuis 1695, voire 1388 selon certaines archives), fonctionnait depuis toutes ces années en pur gaspillage : l’eau, une fois sortie de l’endroit que l’on sait, partait directement dans les égouts. Plus de 1500 à 2500 litres d’eau potable s’échappaient ainsi quotidiennement.

C’est l’intervention d’un technicien, fin 2018, qui a permis de prendre conscience du problème. Suite à cette découverte, la municipalité a non seulement décidé d’installer un système de récupération pour éviter ce gaspillage, mais aussi de vérifier toutes les fontaines de la ville.

A quelques jours d’intervalle, on apprenait par ailleurs, dans des sphères tout à fait différentes, que

- les actionnaires du géant Bayer ont contesté avec force le rachat de Monsanto, refusant de donner leur quitus au directoire de l’entreprise. Comme l’écrit Cécile Boutelet dans Le Monde, ce « bouleversement majeur pour Bayer » montre que « la seule logique industrielle est désormais insuffisante, dans un monde où l’opinion publique, tout comme les investisseurs, est davantage sensibilisée sur les questions environnementales et sanitaires que par le passé ». « La perte de confiance dans la marque Bayer, jusqu’ici synonyme du sérieux et de la moralité de l’industrie chimique allemande de l’après-guerre, est un dégât jugé très grave par les actionnaires ».

- dans l’univers de la mode, le marché de la friperie (vêtements d’occasion) connaît une telle expansion qu’il est appelé, selon des estimations, à dépasser d’ici moins de dix ans la « fast fashion » (collections renouvelées très rapidement). Les pratiques et les mentalités évoluent rapidement – en 2018, 64% des femmes auraient déjà acheté ou seraient prêtes à acheter des produits d’occasion, contre 52% en 2017 et 45% en 2016 – et ce dans toutes les classes sociales et les tranches d’âge.

Ces trois informations peuvent sembler éloignées, et pour certaines, anecdotiques. On aurait pourtant tort de les sous-estimer en y voyant des phénomènes isolés.

Toutes disent quelque chose de l’époque, chacune à leur échelle et dans leur domaine respectif (gestion d’infrastructures publiques ; stratégie d’entreprises ; pratiques de consommation).

Elles relèvent d’un même mouvement structurel, d’une lame de fond commune, que l’on pourrait désigner par « Zeitgeist » – ce terme allemand que l’on traduit souvent par « l’esprit du temps ».

« Le Zeitgeist constitue un système d’idées, d’images et de valeurs qui, déterminant une certaine ambiance intellectuelle, culturelle, fonde les pratiques, les comportements individuels et collectifs, et inspire les créations, jusqu’à celles qui sont considérées comme les plus personnelles. Il est atmosphère, air du temps, influençant styles et modes de vie individuels, et scandant la respiration sociale » (Philippe Robert-Demontrond).

Comment caractériser ce « Zeitgeist » ? Le meilleur moyen de le cerner, de le décrire, semble être simplement de s’en référer à ses différentes manifestations.

Un exemple parmi d’autres : dans l’univers des cosmétiques, la tendance forte du moment serait « l’écobeauté », à savoir ce qui met en valeur l’aspect naturel de sa peau.

Ici comme ailleurs, le phénomène est évidemment repris si ce n’est tiré par les marques, qui y voient autant le risque de rater le train de ce nouvel « esprit du temps » qu’une nouvelle opportunité de croissance : « l’industrie, des géants aux petites marques indépendantes, a compris le changement de paradigme »,écrit la journaliste Zineb Dryef dans Le Monde. « Après avoir vendu pendant des décennies des produits pour « camoufler » boutons et autres imperfections, les marketeurs de la beauté ont revu leur vocabulaire : on parle désormais de « transparence », d’« authenticité », de « beauté intérieure », de « simplicité », de « retrouver sa vraie nature ».

Les enseignes bio ne sont d’ailleurs pas en reste : il y a quelques mois, Naturalia a ainsi lancé Naturalia Origines, nouveau « concept store » dédié à la médecine douce avec déjà quatre magasins dans Paris, qui se présente comme le « temple du bien-être 100% bio »…

Bien plus qu’une simple tendance

On pourrait voir, dans ce mouvement global, le signe d’une nouvelle mode, par nature éphémère, vouée à laisser place plus tard à d’autres tendances à l’obsolescence programmée.

Ce serait faire là un pari bien risqué. Car ce mouvement repose sur un sous-jacent qui, lui, ne risque pas de se faner de sitôt : la dégradation de l’environnement – et ce qui en est relié, comme la montée de nouveaux problèmes de santé liés aux pesticides, au plastique, aux produits transformés.

A la différence de tendances précédentes, on voit mal comment la situation pourrait s’inverser, au vu de ce qui nous attend en matière environnementale. Tout indique que ce mouvement ne fera que gagner en importance, aussi bien s’agissant du nombre de personnes qui y seront sensibles que de sa profondeur. Des préoccupations auparavant quasi-inexistantes, il y a peu encore secondaires, sont appelées à devenir demain primordiales. Des visions modérées seront amenées à gagner en radicalité. Des logiques de compromis, voire de compromission, jusqu’ici acceptées ou du moins tolérées, sont condamnées à devenir rejetées.

Des implications tentaculaires

Ce nouveau « Zeitgeist », dont les différentes manifestations sont encore souvent considérées comme sympathiques, rigolotes ou agaçantes selon les points de vue, pourrait s’avérer demain décisif dans de nombreux domaines. Prenons ici deux exemples : les marques, et les recruteurs.

Pour les marques

Il appelle les marques à de profonds changements, du moins pour celles dont les valeurs actuelles restent figées dans des logiques anciennes. Le cas récent du magazine Elle, épinglé pour l’article présenté ci-dessous, est à ce titre tout sauf anecdotique.

Pour ses dirigeants, il sera vain, plus tard, de se lamenter face à la baisse de ses ventes. Le problème sera bien plus profond, plus ancien, et donc plus difficile à surmonter. Quand un magazine (se voulant) prescripteur de tendances commence à accumuler du retard en la matière, c’est sa pérennité même qui est mise en danger.

Au-delà de « Elle », cet exemple devrait servir de contre-modèle à toutes les marques ayant l’ambition de devenir ou rester des références dans les années et décennies à venir – voire, plus simplement, de perdurer… : selon une étude récente d’Havas Paris, 87% des marques pourraient disparaître sans aucun regret de la part des Français. Ce chiffre inspire ce diagnostic sans concessions de Valérie Planchez, vice-présidente d’Havas Paris : « nous sommes allés trop loin, avons mal fait notre travail, n’avons pas créé de « fair deals » avec les consommateurs, et payons aujourd’hui la monnaie de notre pièce ».

Pour les recruteurs

« Manifeste étudiant pour un réveil écologique » : ce texte rédigé fin 2018 par des élèves de différentes grandes écoles (HEC, AgroParisTech, CentraleSupélec, Polytechnique, ENS Ulm) en collaboration avec des étudiants de « dizaines d’établissements différents », a eu un certain écho en ce début d’année. Plus de 30 000 étudiants de grandes écoles l’ont signé, avec un message principal : faire savoir aux entreprises qu’ils ne se voient postuler que dans celles « en accord avec les revendications exprimées dans le manifeste », à savoir compatibles avec les logiques écologiques.

Bien sûr, une signature à un manifeste n’engage pas à grand-chose et n’empêchera pas certains de ces étudiants de postuler en temps voulu dans des entreprises dont ils récusent aujourd’hui les pratiques.

Bien sûr, ces étudiants ne sont en rien représentatifs de l’ensemble des étudiants de France (ce qu’ils ont reconnu dès le début de leur initiative).

Mais on aurait tort, pour autant, de minorer ce mouvement, qui dépasse les seules préoccupations environnementales et touche plus globalement à l’impact des entreprises sur la société et à la question du sens.

D’abord parce qu’il est porté par une partie non-négligeable des jeunes talents que recherchent – avec de plus en plus de difficulté – les grands groupes. A Polytechnique, dont une part importante de diplômés se dirigent vers l’industrie et des postes décisionnels, plus de 600 élèves ont signé le manifeste. A Centrale, « de plus en plus de diplômés choisissent des petites structures où ils comprennent ce qu’ils font et pourquoi ils sont là [alors qu’il] y a quinze ans, 50 % d’une promotion s’orientait directement dans les grands groupes », selon le directeur de l’école.

Ensuite parce qu’il est mondial. Le même phénomène se manifeste par exemple aux Etats-Unis. Le New York Times l’a constaté récemment lors d’un événement à la prestigieuse université de Berkeley : les futurs diplômés en informatique sont de plus en plus nombreux à éviter Facebook, en dépit des 140 000 dollars annuels assortis de différents avantages en nature proposés aux ingénieurs en sortie d’école – et ce, non pas parce que le réseau est passé de mode, mais bien pour ses impacts sociétaux.

Les témoignages citées par le New York Times convergent dans le même sens : « un grand nombre de mes amis se disent qu’ils ne veulent plus travailler pour Facebook pour les questions de privacy, fake news, données personnelles, tout cela » ; « je ne crois tout simplement pas au produit parce que tout ce qu’ils font consiste à montrer plus de publicités aux gens » ; « avant, y travailler était vu comme prestigieux voire magique; maintenant, on se dit que ce n’est pas parce qu’ils font ce que les gens souhaitent que c’est positif ».

Même si les jeunes diplômés restent nombreux à y postuler, ceux-ci le font « un peu plus discrètement, expliquant à leurs amis qu’ils vont y travailler pour changer l’entreprise de l’intérieur ou qu’ils ont trouvé un poste plus éthique dans cette entreprise à la réputation devenue toxique », écrit le New York Times, qui ajoute : « le changement d’attitude se produit au-delà de Facebook. Dans la Silicon Valley, les recruteurs disent que les candidats en général posent plus de questions du type « comment puis-je éviter un projet sur lequel je suis en désaccord ? » et « comment puis-je rappeler à mes chefs la mission que s’est fixée l’entreprise ? ».

Au-delà de la Silicon Valley, de nombreux jeunes diplômés, qu’ils soient issues de formation d’ingénieurs ou de commerce, font part d’un sentiment de « dissonance cognitive » et de « perte de sens » dans leur activité professionnelle. Pour la sociologue Cécile Van de Velde, « au niveau individuel, la question posée est : s’ajuster au marché du travail, d’accord, mais jusqu’où ? Par nécessité, la plupart des jeunes diplômés acceptent de renoncer à certaines valeurs pour rester dans la course, mais ils peuvent développer alors un sentiment majeur de désajustement. Je les appelle les « loyaux critiques » : ils jouent le jeu, mais portent une critique radicale du système, depuis l’intérieur ».

Ces considérations sont évidemment en soi déjà un luxe, à l’heure où l’objectif de nombreux jeunes est plus simplement de trouver un emploi, ou un travail qui serait rémunéré de façon correcte. De même, il est évident que le besoin de sens n’a pas émergé en 2018 ou 2019 : il n’est pas nouveau en soi.

Mais sa montée est indéniable et n’en est probablement qu’à ses débuts. Fait inédit : à l’ENA, la dernière promotion a débattu sérieusement de la possibilité de s’appeler « Urgence climatique », même si ce nom a finalement été écarté en « finale » après huit heures de débat (…partie remise ?).

Cécile Van de Velde confirme qu’elle « constate que le sentiment d’urgence face à la catastrophe écologique est de plus en plus prégnant. J’ai pu [le] voir monter et se diffuser, au fil de mes recherches sur la colère sociale. En 2012, la colère des jeunes diplômés était principalement structurée par les thématiques sociales et économiques. Aujourd’hui, le malaise est plus existentiel, plus global. Il porte davantage sur la question de la marche du monde et de l’humanité menacée. » Et si ces questionnements restent en grande partie portés par des classes sociales qui ne sont pas en difficulté, elle note que « chez cette jeunesse bien informée, bien formée et qui a des ressources, il y a un refus de transmission du système ».

Elle confirme également la dimension internationale et générationnelle de ce mouvement : « On voit dans les enquêtes internationales sur les valeurs que la conscience environnementale et la demande d’éthique politique sont deux revendications qui distinguent fortement les jeunes générations montantes. Non pas que ces revendications n’existent pas chez les autres, mais elles sont portées à l’extrême par ces jeunes générations. ».

Elle relie cette situation à « une inversion de la transmission entre générations » que l’anthropologue américaine Margaret Mead avait annoncé dès 1968 dans son ouvrage « Le Fossé des générations » : « au lieu d’être descendante – des parents vers les enfants –, cette transmission pouvait devenir ascendante. C’est cette forme d’inversion générationnelle qui est à l’œuvre aujourd’hui sur les questions climatiques et environnementales. »

Les normes sociales comme moteur du changement

Il y a encore peu, beaucoup voyaient dans la vague « startups » l’émergence d’une tendance lourde : l’arrivée d’une génération entrepreneurs, prêts à « uberiser » des pans entiers d’une économie traditionnelle jugée obsolète, et visant l’hypercroissance à tout prix. On sent pourtant déjà aujourd’hui en France que le vocable « startup nation » a commencé à se faner. La « disruption » sent le sapin : lorsqu’elle n’a pas mauvaise presse pour ses impacts sociaux, elle est tournée en ridicule, vue comme caricature d’un « nouveau monde » qui sonne déjà assez ancien.

Les startups sont évidemment encore (très) vivantes, et l’entrepreneuriat est bien sûr très loin de se résumer aux startups ; le propos est simplement de dire que celles-ci ne sont plus le modèle qu’elles ont pu représenter, il y a encore peu, aux yeux de certains.

Or cette question du modèle est clef.

« L’esprit du temps » dont il est question touche éminemment aux normes sociales, et en particulier à ce qui est valorisé et à ce qui devient à l’inverse mal vu.

A ce titre, l’exemple de la « honte de prendre l’avion » qui se développe en Suède et qui conduit un nombre croissant de voyageurs à préférer le train pour réduire leur empreinte carbone, est tout sauf anecdotique : c’est un vrai signal faible, dont la portée est sans doute encore sous-estimée.

Le phénomène, qui a son propre mot en suédois (« flygskam »), semble sérieux : d’ores et déjà, plusieurs lignes intérieures ont vu leur nombre de passagers diminuer, tandis que les trajets en train – et notamment les trains de nuit – entre les principales villes suédoises battent des records de fréquentation.

Ce type de pratiques est appelé à s’amplifier dans des domaines très divers, non pas uniquement en raison d’un souci accru de l’environnement, mais aussi, plus prosaïquement, en raison de l’image que l’on souhaite renvoyer.

En 2013, le PDG de la société Opower racontait qu’un groupe d’étudiants avait testé les trois messages suivants pour encourager les gens à économiser de l’énergie : « vous pouvez économiser 54 dollars ce mois-ci » ; « vous pouvez sauver la planète » ; « vous pouvez être un bon citoyen ». Aucun n’a fonctionné. Un quatrième message a alors été testé : « vos voisins font mieux que vous ». Le résultat s’est avéré « miraculeux : quand les gens découvraient que ¾ de leurs voisins avaient éteint l’air conditionné, ils l’éteignaient aussi ».

Les changements de comportements ne se feront pas (seulement) par des logiques d’incitation économique ou de contraintes. Ils seront favorisés en large partie par la pression sociale.

Dans le cas du transport en avion (l’un des principaux contributeurs d’émission de CO2), la prise de conscience progressive des ordres de grandeur liés aux émissions de CO2 devrait conduire, par exemple, à remettre en cause progressivement la mode des escapades le week-end en Europe, jusqu’alors tirées par les prix spectaculairement bas des compagnies low-cost.

C’est d’ailleurs ce qu’indique officiellement l’ADEME dans son scénario 2050 pour atteindre les objectifs fixés par le gouvernement en matière écologique : « Dans le domaine des loisirs, les voyages en avion ne seront pas proscrits, mais ils devront être globalement plus rares, en privilégiant les longs séjours plutôt que la fréquence des escapades ».

En se plaçant en 2050, l’ADEME écrit : « la politique climatique a amené à transformer les pratiques touristiques. La nouvelle fiscalité sur le kérosène a contribué à modifier les habitudes: on prend toujours l’avion pour voyager loin, mais moins souvent et plus longtemps. Les entreprises proposent maintenant à leurs salariés la possibilité de cumuler trois mois de congés payés pour faire des grands voyages ».

Autrement dit, « voyager à longue distance en avion est envisageable à condition que cet usage soit réparti dans le temps. » Pour ce faire, il sera nécessaire de « modifier les comportements liés à l’aspiration aux voyages en avion avec le développement du tourisme sur longue distance. L’objectif est de mettre en place des règles collectives qui permettent un tourisme de long séjour ».

Le domaine des loisirs n’est pas le seul concerné par le changement de ces pratiques puisqu’une large partie des trajets en avion sont liés à des déplacements professionnels. Là encore, les normes sociales sont appelées à jouer un rôle important.

Exemple parmi d’autres : aujourd’hui, les formulaires d’évaluation des chercheurs du CNRS demandent le « nombre de conférences internationales » où les chercheurs ont été invités, ce qui encourage en creux le maximum de déplacements à l’étranger. S’il est évidemment compréhensible, et même souhaitable, qu’un chercheur soit amené à présenter ses travaux à l’international, on peut se demander si les déplacements sont à chaque fois justifiés et si des substituts ne seraient pas, parfois, envisageables.

Cet exemple n’est pas le plus représentatif, il faut le reconnaître, et ce d’autant plus que la recherche joue bien sûr un rôle essentiel dans la lutte contre le désastre écologique ; mais il montre, quitte à déplaire, qu’aucun domaine ne serait être tenu à l’écart de ces questionnements.

Quelles conséquences ?

Les implications sont très larges et appelées à se diffuser dans les différents interstices de la société. Comme toujours, elles seront vues comme des évidences a posteriori. Comme toujours, elles sont sous-estimées a priori.

La notion de luxe, par exemple, est déjà en (r)évolution. C’est ce qu’écrit l’essayiste Gaspard Koenig dans un texte récent : « Dans sa célèbre controverse avec Rousseau, Voltaire définissait le luxe comme « tout ce qui est au-delà du nécessaire », s’inscrivant dans « une suite naturelle des progrès de l’espèce humaine ». En cette époque d’abondance matérielle et d’achats grégaires, que trouve-t-on de rare et de superflu « au-delà du nécessaire » ? Le silence et la frugalité. (…)

A l’ère de la massification des transports, le luxe consiste à retrouver une forme de sobriété et de tranquillité dans des environnements à taille humaine.On ne compte plus les sites de voyage qui promettent « l’authenticité » . En Roumanie justement, aux pieds des Carpates, le prince Charles a rénové des maisons traditionnelles où vient séjourner la gentry londonienne. Le dernier chic est de faire son propre pain.

Le documentaire de Benjamin Carle, « Sandwich », enquêtait sur cette mode du Do It Yourself : un repas de luxe ne consiste plus à manger du caviar mais à partager le sandwich que l’on a fait entièrement soi-même, en faisant pousser les tomates et en récoltant le blé. »

Pour reprendre l’exemple de l’avion, c’est tout l’univers du tourisme qui sera amené à évoluer. Certains acteurs commencent déjà à l’anticiper. Le PDG de Voyageurs du monde, Jean-François Rial, dit aujourd’hui s’interdire de proposer certains voyages « inacceptables » : « Les long-courriers en dessous de cinq nuits, les allers-retours en Europe dans la journée, c’est non ! ».

D’autres acteurs ne souhaitent pas être dans ce type de compromis où l’avion a encore une place centrale. Ils s’inscrivent dans la tendance du tourisme durable, sobre, qui, là encore, n’a rien d’une mode et ne devrait faire que monter en puissance. Pour Guillaume Cromer, directeur du cabinet ID-Tourism, « les premiers touristes de demain seront intrarégionaux », ce qui implique de « construire de nouveaux imaginaires sur l’ailleurs, et de dépayser grâce à des hébergements atypiques ». Du reste, comme l’écrit Gaspard Koenig, « les Millennials branchés ne jurent plus que par le « tourisme expérientiel », préférant vivre chez l’habitant plutôt que d’être parqués dans des suites anonymes et climatisées ».

Evidemment, dans tout ce mouvement, il faut distinguer les modérés et les radicaux ; les militants et les hésitants ; les pionniers et les suiveurs : bref, tout un spectre.

Evidemment, comme dit précédemment, ces questionnements restent aujourd’hui un certain luxe ; il est plus difficile de se préoccuper de la fin du monde lorsqu’on a du mal à finir le mois…

Pour autant, on voit mal l’impact de ce « nouveau paradigme » rester circonscrit.

Dans l’univers du marketing, et donc de la consommation en général, les marques restent par exemple souvent frileuses à l’idée d’investir le terrain politique, au sens vie de la cité. Or les consommateurs attendent de plus en plus des marques qu’elles s’engagent, qu’elles défendent leurs convictions, qu’elles « prennent position sur des sujets de société clivants » pour reprendre les mots de David Nguyen de l’Ifop, et plus encore : qu’elles soient avant-gardistes en la matière.

Les marques les plus fortes ne sont pas consensuelles. Seth Godin, « gourou » du marketing, l’exprime ainsi : « Cela n’a plus de sens de vouloir plaire à tout le monde. Plus aucun produit ou service ne peut avoir cette ambition. Les marques doivent concentrer leurs efforts sur un petit nombre de clients, et susciter leur engagement. Et pour cela, elles ne doivent plus hésiter à être avant-gardistes, à prendre des risques, à oser les extrêmes ! »

Il cite l’exemple de la marque Patagonia : « eux s’engagent pour l’écologie, et n’hésitent pas à aller toujours plus loin. Mais ces choix, parfois radicaux, donnent du sens à leur message et donc à leurs produits. »

C’est l’exemple, aussi, de la marque d’électronique américaine Sonos qui a fermé l’an dernier le temps d’une journée son magasin de New York pour afficher son soutien à la neutralité du net.

La politique ne sera pas laissée de côté

« Les jeunes, à mesure de leur prise de conscience politique, seront beaucoup plus radicaux que leurs parents, tout simplement parce qu’ils n’auront plus d’autre choix » – Phil McDuff dans The Guardian

En matière environnementale, les nouvelles générations sont vouées à être plus radicales. Les notions de développement durable et croissance verte semblent déjà vieillies. La force du nouveau mouvement « Extinction Rebellion » au Royaume-Uni, qui prône la désobéissance civile non-violente contre l’inaction climatique, en est un signe révélateur. « Extinction Rebellion is leading a new, youthful politics that will change Britain » annonçait d’ailleurs fin avril un chroniqueur du Guardian.

Au-delà des seules pratiques de consommation, le terrain politique ne sera donc pas laissé de côté. On sous-estime encore l’arrivée à l’âge de voter de cette nouvelle génération. Il est d’ailleurs permis de s’interroger sur la part d’électeurs de Mélenchon ayant voté pour lui en 2017 non pas (spécialement) pour son positionnement d’extrême gauche mais pour son radicalisme écologique et institutionnel. Dans quelle mesure son score de presque 20% (à 1,7 point de Marine Le Pen et donc du second tour) a-t-il été dû à ces enjeux ?

Ces questions doivent nous interroger sur le potentiel de l’écologie comme force politique – qui n’a jusqu’ici jamais franchement connu le succès en France. Que manque-t-il pour que celle-ci réussisse ? Peut-être avant tout la figure d’un leader capable de rassembler bien au-delà de son camp et de susciter une adhésion forte sur sa personne, à partir d’un terreau d’idées commençant à devenir massivement partagées.

Si tel est le cas, alors nous pourrions être politiquement dans un état métastable, comme on l’appelle en physique – cet état qui se manifeste lorsque de l’eau en-dessous de 0°C reste provisoirement liquide. Il suffit alors d’un micro-évènement pour déclencher brutalement un changement de phase qui aurait pu se produire plus tôt (ou plus tard). L’émergence d’une personnalité représentant l’écologie et capable de rassembler pourrait constituer ce facteur de déclenchement. Y a-t-il aujourd’hui une personnalité en France capable de remplir ce rôle ?

Une chose est sûre : à défaut d’engagements forts, le greenwashing sera de moins en moins acceptés par les individus, que ceux-ci soient considérés comme consommateurs, demandeurs d’emplois ou électeurs. Si cela ne concerne pas (encore ?) l’ensemble des citoyens – il ne s’agit pas de les homogénéiser artificiellement -, il n’est plus à prouver que les mouvements émergents commencent toujours par des « early-adopters ».

Pour les marques à la recherche de nouveaux consommateurs, pour les entreprises à la recherche de nouveaux talents, pour les partis politiques à la recherche d’électeurs, le constat est donc le même : des changements cosmétiques ou de pure communication ne seront non seulement pas suffisants – la ficelle serait trop grosse – mais seront, surtout, dangereux, car porteur de risques de décrédibilisation forte. A charge à chaque acteur d’en tirer les conséquences.

23.03.2019 à 10:53

Pourquoi les prédictions sont souvent fausses (et quelles leçons en tirer)

signauxfaiblesco

Texte intégral (8472 mots)

“Internet ? On s’en fout, ça ne marchera jamais” (Pascal Nègre, alors PDG d’Universal Music, en 2001)

Illustration ci-dessus : extrait d’une série de cartes postales imaginant en 1910 la France de l’an 2000

Pour les nombreux experts en expertise, chaque début d’année est l’occasion de livrer au monde ce que leur boule de cristal leur a révélé entre la bûche et le Nouvel An. Tendez l’oreille…bienvenue en 2030, 2050, voire 2070 pour les plus chanceux d’entre nous !

Ces généreuses confidences sont d’autant plus pratiques pour leurs auteurs qu’il leur arrive rarement de devoir rendre des comptes a posteriori. Il est vrai qu’à l’heure des bilans, il est souvent plus excitant de se tourner vers…l’avenir, encore une fois.

Une fois n’est pas coutume, rembobinons la pellicule. Signaux Faibles vous invite ici à une rétrospective de certaines des plus belles prédictions formulées depuis l’ère industrielle… :

Personne n’est immunisé contre un joli loupé

Ni les économistes, Prix Nobel ou pas

« La croissance d’Internet va ralentir drastiquement, car la plupart des gens n’ont rien à se dire ! D’ici 2005 environ, il deviendra clair que l’impact d’Internet sur l’économie n’est pas plus grand que celui du fax. »

Ce pronostic a été formulé par Paul Krugman en 1998, dans un article intelligemment intitulé « Pourquoi la plupart des prédictions des économistes sont fausses ». Sûr de son fait, il ajoutait ensuite : « avec le ralentissement du taux de changement technologique, le nombre d’offres d’emploi pour spécialistes IT décélèrera, puis se renversera ; dans dix ans, l’expression « économie de l’information » semblera stupide ».

Dix ans plus tard exactement, en 2008, Paul Krugman remportait le prix Nobel d’économie…pour d’autres analyses fort heureusement.

Ni les plus prestigieux cabinets de conseil en stratégie

Un exemple est resté célèbre en la matière : le cas AT&T et McKinsey.

Au début des années 1980, l’opérateur téléphonique AT&T demanda au (très réputé) cabinet McKinsey d’estimer combien de téléphones portables seraient utilisés dans le monde au tournant du siècle. La conclusion de McKinsey fût sans appel : en raison de défauts rédhibitoires (poids trop important, batteries trop faibles, coût exorbitant …), le téléphone portable ne pouvait pas devenir un succès.

McKinsey estima que seules 900 000 personnes environ utiliseraient en l’an 2000 un téléphone portable ; plus encore, le cabinet pronostiqua que personne n’utiliserait ce type d’appareil si une ligne téléphonique fixe était disponible à proximité. McKinsey recommanda donc à AT&T de se retirer du marché des téléphones portables (coûtant à AT&T, des années plus tard, plusieurs milliards de dollars). Au tournant du siècle, le téléphone portable compta finalement plus de 100 millions d’utilisateurs, soit plus de cent fois le pronostic initial.

Ni les PDG de grandes entreprises

•« Le cheval est là pour rester, mais l’automobile est juste une nouveauté, une mode » – le Président de la Michigan Savings Bank conseillant le juriste d’Henry Ford de ne pas investir dans la Ford Motor Company en 1903.

• « Il n’y a aucune chance que l’Iphone gagne la moindre part de marché significative » – Steve Ballmer, PDG de Microsoft en 2007

• « Netflix, je n’y crois pas. La vidéo à la demande par abonnement, ça ne marchera jamais, il n’y a pas de marché en France » – Bertrand Méheut, PDG de Canal+ en 2013

Ni les dirigeants pourtant pionniers dans leur domaine

• « Ce “téléphone” a trop de défauts pour être considéré sérieusement comme un moyen de communication » – William Orton, Président de Western Union [alors leader mondial de la radiocommunication] 1876

• «La télévision ne tiendra sur aucun marché plus de six mois. Les gens en auront rapidement assez de regarder tous les soirs une boîte en contreplaqué » – Darryl Zanuck, 20th Century Fox, 1946

• « L’idée d’un outil de communication personnel dans la poche de chacun est une chimère, favorisée par la cupidité » – Andy Grove, CEO d’Intel, 1992

• « Le modèle de souscription par abonnement pour acheter de la musique est une mauvaise piste. Les gens nous l’ont dit et répété : ils ne veulent pas louer leur musique » – Steve Jobs en 2003

• « Je n’ai pas envie de regarder tant de vidéos que cela » – Steve Chen, cofondateur de YouTube exprimant en 2005 ses doutes sur le potentiel de sa plateforme.

Ni même les plus grands scientifiques ou inventeurs

• « Le phonographe n’a absolument aucune valeur commerciale » ; « l’engouement pour la radio s’éteindra avec le temps » – Thomas Edison (inventeur de l’ampoule électrique, du phonographe qui deviendra un succès commercial à l’origine de l’industrie du disque, etc.)

• « Bien que la télévision soit possible théoriquement et techniquement, elle est pour moi impossible commercialement et financièrement » – Lee DeForest, pionnier des radiocommunications, 1926

• « Le cinéma parlant est une invention très intéressante, mais je doute qu’elle reste à la mode bien longtemps » – Louis-Jean Lumière, inventeur du cinématographe, 1929

• « Il n’y a pas la moindre indication que nous puissions un jour utiliser l’énergie nucléaire » – Albert Einstein, 1932

• « La téléphonie mobile ne remplacera jamais la téléphonie fixe » – Martin Cooper, inventeur du premier téléphone mobile, 1981

• « Je prédis qu’Internet sera LA grande nouveauté de 1995 et s’effondrera avec fracas en 1996 » – Robert Metcalfe, co-inventeur d’Ethernet, 1995

***

Si ces prédictions ratées abordent ici surtout l’innovation, en particulier technologique, bien d’autres exemples auraient pu être présentées (finance, politique, etc.) ; pensons par exemple à toutes celles formulées juste avant 2007 qui évacuaient l’hypothèse d’une crise. Mais plutôt que de chercher à rallonger la liste, tentons d’en comprendre les raisons…

Les raisons de ces erreurs

Daniel Jeffries, blogueur américain, a mis en avant dans un article plusieurs facteurs pour expliquer pourquoi les « experts » se trompent ainsi dans leurs prédictions :

1/ Ils consacrent trop peu de temps à un sujet avant de se forger une opinion

…parfois en raison d’excès de confiance en soi. On pense notamment ici à l’effet Dunning-Kruger, dit de la surconfiance, selon lequel les moins qualifiés dans un domaine donné ont tendance à y surestimer leur compétence.

…parfois en raison de paresse intellectuelle. C’est ce qu’explique Nadia Maizi, directrice de recherche aux Mines ParisTech et spécialiste de prospective sur le climat et l’énergie, qui regrette chez de nombreux décideurs une « perte d’effort intellectuel dans les réflexions sur le long terme » (interview sur France Culture dans l’émission Le Grain à Moudre du 3 janvier 2019 : « Peut-on modéliser le futur ? »). Elle insiste sur l’importance, « quand on est dans des réflexions sur le long terme », d’éviter de « capter un chiffre ou un autre parce que c’est celui qui nous intéresse, ou parce que c’est celui qu’on avait au départ », et de bien considérer « l’ensemble des possibles ».

2/ Le futur va à l’encontre de tout ce qu’ils comprennent du monde

Un exemple typique est celui des choix de la France

-de ne pas avoir considéré avec sérieux les travaux du chercheur français Louis Pouzin dans les années 1970, qui préfiguraient pourtant les fondations d’Internet. Poussé par les PTT (ancêtres de France Telecom et La Poste), l’Etat a choisi de couper le financement de ses travaux, qui ont été ensuite en partie repris par le chercheur américain Vinton Cerf pour la mise au point du protocole TCP/IP, fondement d’Internet.

-de s’être obstinée jusque dans les années 1990 à ne pas croire en Internet. Rappelons ici les conclusions du rapport Théry, intitulé « Les autoroutes de l’information », et remis en 1994 au gouvernement (qui voulait se faire un avis sur le potentiel d’Internet) : « il n’existe aucun moyen de facturation sur Internet, si ce n’est l’abonnement à un service. Ce réseau est donc mal adapté à la fourniture de services commerciaux. Le chiffre d’affaires mondial sur les services qu’il engendre ne correspond qu’au douzième de celui du Minitel. Les limites d’Internet démontrent ainsi qu’il ne saurait, dans le long terme, constituer à lui tout seul le réseau d’autoroutes mondial ».

La même année, Jeff Bezos lançait Amazon.

Durant toutes ces années, certaines voix avaient pourtant plaidé pour considérer le potentiel d’Internet. Mais les autorités ont choisi de ne pas en tenir en compte. Pour l’économiste Pierre Sabatier, « entre le Minitel et Internet, ce n’était pas une technologie contre une autre, mais une vision du monde contre une autre. Pour des technocrates français, formés dans une culture centralisatrice et autoritaire, où tout doit venir d’en haut, il était évident que la seule solution viable était la solution centralisatrice et autoritaire du Minitel.

Internet misait au contraire sur l’autonomie des individus, leur esprit d’initiative et d’innovation, hors de tout contrôle, excepté celui qu’ils s’imposent d’eux-mêmes. Un tel système, bordélique et anarchisant, où l’on progresse par essais et erreurs et non selon un plan préétabli, leur était simplement incompréhensible. Logique du contrôle et de la planification contre logique de la liberté individuelle. Dès lors, comment pouvaient-ils prévoir l’explosion de créativité d’Internet, qui est une créativité individualiste ? ».

Il n’est dès lors pas étonnant que le rapport remis en 1994 au premier ministre de l’époque, Edouard Balladur, ait été commandé à trois technocrates français dont l’un était…l’un des inventeurs du minitel ! De l’art de choisir ses experts pour son travail de prospective…

3/ Le futur remet en cause leur position de pouvoir

Un exemple phare est celui de Kodak qui a refusé de voir la puissance du numérique parce que l’entreprise avait tout bâti sur l’argentique. Contrairement à une idée répandue, Kodak n’a pas découvert en retard le numérique : comme l’explique Philippe Silberzahn, professeur d’innovation à l’EM Lyon, « en réalité, Kodak est l’un des tous premiers à avoir activement travaillé à la photo numérique : l’entreprise était très active dans le domaine et est à l’origine de très nombreux brevets. Parfaitement au courant du développement du numérique, puisqu’elle en était l’instigateur, Kodak n’a pas voulu le promouvoir de manière déterminée pour une raison simple : protéger son activité principale de l’époque, la vente de films argentiques ».

Les autres exemples ne manquent pas. Pensons ainsi, de façon plus récente, aux réactions de certains banquiers face aux cryptomonnaies. Jamie Dimon (CEO of JPMorgan Chase, l’un des vétérans de Wall Street) considérait ainsi en 2017 les cryptomonnaies comme une « escroquerie » (avant de « regretter » début 2018 l’emploi du terme quand les cours sont montés, puis de parler de nouveau d’ « arnaque » en août 2018, quand les cours sont redescendus…). Comme l’écrit Daniel Jeffries, « il ne peut pas concevoir un futur avec des cryptomonnaies parce qu’il fait partie des principaux bénéficiaires du système actuel. Il ne veut pas voir, et donc se ment à lui-même. Ce n’est rien d’autre qu’un mécanisme de défense mentale. Interroger ces gens sur les cryptomonnaies, c’est comme demander à un chauffeur de taxi ce qu’il pense d’Uber ou d’un fabricant de calèches ce qu’il pense des voitures. »

Au fond, si l’on en revient au rapport Théry cité plus haut, son raté peut se comprendre aussi sous l’angle de la position de pouvoir menacée : comme l’écrit Philippe Silberzahn, « ce ne serait pas l’histoire d’une erreur, mais d’une tentative désespérée d’empêcher l’avènement d’une technologie pour en défendre une autre » et pour « défendre des intérêts » plutôt que d’autres. Autrement formulé, par Franck Lefevre : « Internet versus Minitel n’est pas un dilemme technique mais un choix politique, idéologique. La position de Thery vise à défendre l’intérêt des systèmes supervisés versus les systèmes auto-organisés, l’intérêt de l’approche interventionniste versus celle misant sur la liberté des acteurs ».

4/ Ils confondent leur opinion avec la réalité

« En France, on n’a pas cru en l’informatique. On a dit que c’était une mode et que ça allait passer. Dans les années 80, dans les grandes écoles, on se demandait si l’informatique était un sujet ou pas. En 1985, à Polytechnique, on se demandait encore s’il fallait l’enseigner » (Gérard Berry, professeur au Collège de France, médaille d’or 2014 du CNRS)

Les biais d’opinions peuvent tordre fortement la capacité à anticiper le futur (ainsi qu’à comprendre le présent…et le passé !). Nadia Maizi (Mines ParisTech) raconte ainsi qu’elle obtient parfois au cours de ses recherches « des résultats pertinents sur le long terme mais qui sont peu audibles », ce qu’elle illustre par un exemple : « en 2011 la Commission Besson a été mise en place juste après Fukushima pour évaluer la politique énergétique française après 2050. Dans les premiers scénarios réalisés avec notre modèle, il était apparu clairement qu’une sortie brutale du nucléaire faisait rentrer des technologies à base de charbon, donc émissives. Mais quand on a montré ça, ça n’a pas plu ».

5/ Ils font preuve d’un grand manque de patience

Dans le domaine de l’innovation, plusieurs décennies sont parfois nécessaires pour qu’une invention prenne toute sa mesure (trouve son usage, rencontre son marché, soit utilisée au mieux). Dans certains cas, ce temps est incompressible en raison de la nature même du processus d’innovation, qui implique de tâtonner dans l’usage d’une invention donnée. Deux exemples, parmi de multiples autres, l’illustrent :

-Le microscope : comme l’explique Philippe Silberzahn, « le microscope a permis de découvrir les microbes et de changer notre vision du monde du vivant, mais il a fallu presque 200 ans entre l’invention du premier microscope et l’émergence de la théorie des microbes ; 200 ans pour adapter notre modèle mental à la nouvelle technologie et ses possibles ! ».