23.02.2026 à 07:42

Khrys’presso du lundi 23 février 2026

Khrys

Texte intégral (11962 mots)

Comme chaque lundi, un coup d’œil dans le rétroviseur pour découvrir les informations que vous avez peut-être ratées la semaine dernière.

Tous les liens listés ci-dessous sont a priori accessibles librement. Si ce n’est pas le cas, pensez à activer votre bloqueur de javascript favori ou à passer en “mode lecture” (Firefox) ;-)

Brave New World

- Study shows how rocket launches pollute the atmosphere (arstechnica.com)

Is the global atmospheric commons destined to be an industrial waste dumping ground ?

- La Chine va-t-elle gagner la course pour le prochain vol lunaire habité ? (humanite.fr)

- China’s CO2 emissions have now been ‘flat or falling’ for 21 months (carbonbrief.org)

- This Chinese Computer Can Read Your Mind—No Implant Required (popularmechanics.com)

A new start-up in China is planning to use ultrasound technology as a way to access the brain.

- L’Inde accueille le sommet mondial sur l’IA qui doit se pencher sur la régulation de ce secteur (france24.com)

Le sommet international sur l’intelligence artificielle va rassembler cette semaine à New Delhi une vingtaine de chefs d’État et de gouvernements, ainsi que les grands patrons du secteur. Le Premier ministre indien Narendra Modi et ses pairs doivent élaborer une feuille de route commune pour la gouvernance et la collaboration mondiales sur l’IA.

- Iran marries surveillance infrastructure, national ID to control population (biometricupdate.com)

The Iranian regime has been leveraging tools from its digital public infrastructure (DPI), combining them with its limited network of CCTV cameras and human informants to crack down on dissent, according to new research published by analysis group Raaznet.

- Madagascar : au moins 59 morts à la suite du passage du cyclone Gezani (lemonde.fr)

Le cyclone a semé la destruction dans le nord-est du pays, accompagné de rafales qui ont atteint jusqu’à 250 km/h. Quinze personnes sont par ailleurs portées disparues.

- Après le cyclone Gezani, près de 30 000 élèves privés de classe dans l’est de Madagascar (rfi.fr)

- Homosexualité : le gouvernement sénégalais valide un projet de loi pour durcir la législation sur les « actes contre nature » (rfi.fr)

Adopté en Conseil des ministres dans la soirée du mercredi 18 février, le texte prévoit d’alourdir les peines prévues pour les personnes reconnues coupables d’« actes contre nature » et de les étendre aux organisations qui font « l’apologie » des relations homosexuelles. La nouvelle loi doit cependant encore recevoir l’approbation des députés avant d’entrer en vigueur.

- Scientists in five European countries confirmed that Alexey Navalny was killed with a rare neurotoxin. Russian officials are calling it ‘necro-propaganda.’ (meduza.io)

- Le niveau de la mer Baltique est tellement bas qu’il fait apparaître l’épave d’un navire datant du XVIIe siècle (huffingtonpost.fr)

La mer Baltique atteint un niveau historiquement bas depuis 1886, révélant à Stockholm l’épave d’un navire suédois coulé vers 1640.

- Nouveaux OGM : les gros semenciers prêts à privatiser le vivant en Europe (reporterre.net)

- Roundup : Monsanto met 7 milliards de dollars sur la table pour échapper à la justice (reporterre.net)

- La célèbre « arche des amoureux » en Italie s’est effondrée ce 14 février (huffingtonpost.fr)

Fragilisée par plusieurs jours de tempêtes et de fortes pluies, cette formation rocheuse emblématique des Pouilles, prisée pour les demandes en mariage, n’a pas résisté à l’érosion du littoral.

- Tziganes : le génocide nazi en cours de reconnaissance (politis.fr)

le génocide tzigane sort de la silenciation après soixante-dix ans d’oubli, malgré ses 200 000 à 500 000 victimes, selon les historien·nes.

- Carlos Quero : le « loup » d’extrême droite qui veut séduire l’électorat de gauche en Espagne (basta.media)

Le nouveau porte-parole du parti d’extrême droite espagnol Vox affiche un engagement pour le droit au logement. Le trentenaire Carlos Quero est un fin connaisseur de la pensée sociale et veut conquérir les classes populaires. Son profil inquiète.

- Portugal bringing in age checks to restrict social media for teens and children (biometricupdate.com)

Under 13s denied access, under 16s need parental consent

- Palantir attaque le média Republik qui a dévoilé un rapport de l’armée suisse sur elle (next.ink)

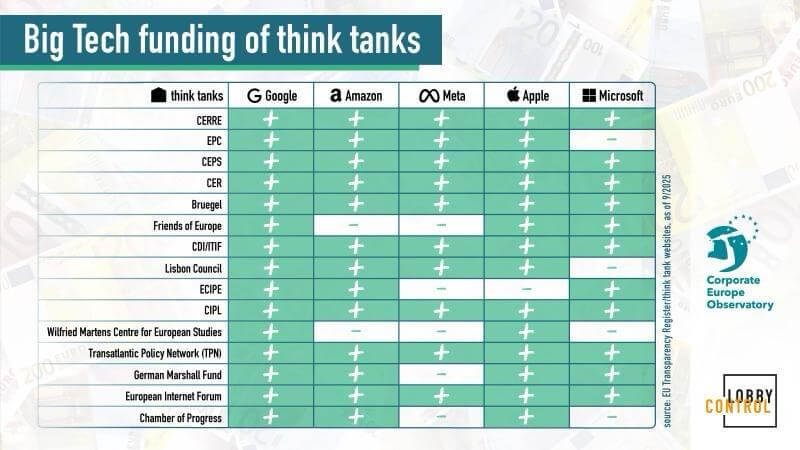

- Lobbying tech : à Bruxelles, les multinationales du numérique dépensent des millions pour neutraliser la régulation (synthmedia.fr)

- ChatGPT sera-t-il soumis aux règles les plus strictes de l’UE en matière de droit numérique ? (euractiv.fr)

- Europeans are dangerously reliant on US tech. Now is a good time to build our own (theguardian.com)

- Offer to join Trump’s new era is met with growing sense of European steeliness (theguardian.com)

Talk of a stronger, independent Europe was the dominant mood in Munich amid bitter disagreement on Ukraine

- L’UE dépêche une émissaire à la première réunion du « Conseil de la paix » de Donald Trump, la France demande des comptes (humanite.fr)

Incapable de se penser hors de la sphère d’influence états-unienne, l’Union européenne participe, ce jeudi, à la première réunion de l’instance trumpienne malgré le scepticisme de certains de ses membres. Paris estime que la commissaire européenne chargée de la Méditerranée n’a “pas de mandat du Conseil” de l’UE pour y participer.

- Fury over Discord’s age checks explodes after shady Persona test in UK (arstechnica.com)

Shortly after Discord announced that all users will soon be defaulted to teen experiences until their ages are verified, the messaging platform faced immediate backlash. One of the major complaints was that Discord planned to collect more government IDs as part of its global age verification process. It shocked many that Discord would be so bold so soon after a third-party breach of a former age check partner’s services recently exposed 70,000 Discord users’ government IDs.

- Hackers Expose Age-Verification Software Powering Surveillance Web (therage.co)

Three hacktivists tried to find a workaround to Discord’s age-verification software. Instead, they found its frontend exposed to the open internet.

- PayPal discloses data breach that exposed user info for 6 months (bleepingcomputer.com)

PayPal is notifying customers of a data breach after a software error in a loan application exposed their sensitive personal information, including Social Security numbers, for nearly 6 months last year.

- Il voulait contrôler son aspirateur DJI à la manette, il finit par espionner 7 000 maisons (clubic.com)

En voulant piloter son robot aspirateur DJI avec une manette de PS5, un développeur a découvert une faille majeure. Résultat : des milliers d’appareils accessibles à distance, avec caméra et plan des logements à la clé.

- Wikipedia blacklists Archive.today, starts removing 695,000 archive links (arstechnica.com)

In the course of discussing whether Archive.today should be deprecated because of the DDoS, Wikipedia editors discovered that [it] altered snapshots of webpages to insert the name of the blogger who was targeted by the DDoS. The alterations were apparently fueled by a grudge against the blogger over a post that described how the Archive.today maintainer hid their identity behind several aliases.

- Achetés une fortune, les NFT « Bored Apes » de Justin Bieber ou Logan Paul ne valent plus rien aujourd’hui (slate.fr)

- Québec : oui aux centres de données, mais ils devront payer leur électricité plus cher (ici.radio-canada.ca)

Deux décrets publiés le 28 janvier dans la Gazette officielle du Québec – et passés sous le radar – demandent à la Régie de l’énergie de créer deux nouvelles catégories de consommateurs d’électricité, l’une regroupant les centres de données, l’autre les chaînes de blocs destinées à la cryptomonnaie.

- L’administration Trump prépare un site débloquant l’accès aux discours de haine en Europe (next.ink) – voir aussi « Freedom.gov » : en prétendant lutter contre la « censure », l’administration Trump s’apprête à violer la souveraineté numérique européenne (legrandcontinent.eu)

- La plus importante défaite juridique de Trump ? La Cour suprême déclare illégaux les droits de douane IEEPA (legrandcontinent.eu) – voir aussi Supreme Court rules that Trump’s sweeping emergency tariffs are illegal (edition.cnn.com)

- 300 journalistes licencié·es : aux États-Unis, l’écologie sacrifiée par la presse pro-Trump (reporterre.net)

- Gay man says ICE is keeping his husband jailed even though they’ve agreed to leave the U.S. (advocate.com)

“We applied for asylum, we got married … every legal step that needs to be done, we have done that. But ICE now is lying”

- Après Bruce Springsteen, U2 sort une chanson « American obituary » en hommage à Renee Good et s’en prend à Trump et Poutine (huffingtonpost.fr)

- Coupe du Monde 2026 : la colère monte aussi au Mexique (dialectik-football.info)

Au Mexique, l’appel à boycotter la prochaine Coupe du Monde gagne du terrain. Des collectifs exigent une ville sans expulsions et des logement qui échappent à la spéculation financière, aggravée par les travaux du Mondial. Pour les collectifs engagés, ça ne fait qu’accélérer la gentrification et la dépossession des communautés locales. À quelques mois du match d’ouverture, la pression monte petit à petit.

- Du glyphosate épandu par avion sur les champs de coca en Colombie (reporterre.net)

- Après Kast au Chili, pourquoi l’extrême droite gagne-t-elle en Amérique latine ? (contretemps.eu)

L’élection à la présidence de José Antonio Kast au Chili, le 14 décembre dernier, l’a montré une fois de plus : il y a à gauche une sorte de sidération, une stupeur mêlée d’incompréhension, à réaliser que l’extrême droite fascisante peut, en ce premier quart du 21e siècle, parvenir au pouvoir et, qui plus est, par les urnes.

- Two satellite proposals threaten the night sky — the window to act is now (darksky.org)

In the United States, the Federal Communications Commission (FCC), the agency responsible for authorizing satellite launches and operations, is reviewing two proposals of unprecedented scale and consequence. If approved, they would alter the night sky as we know it, with impacts that would be increasingly difficult, if not impossible, to reverse.

- Space Station returns to a full crew complement after a month (arstechnica.com)

The arrival of four new astronauts as part of the Crew 12 mission—Jessica Meir and Jack Hathaway of NASA, Sophie Adenot of the European Space Agency, and Andrey Fedyaev of Roscosmos—brought the total number of crew on board the space station to seven, giving the US space agency a full complement in orbit.

- Ancient Mars was warm and wet, not cold and icy (arstechnica.com)

One of the main science goals of the Mars 2020 Perseverance Rover, which landed spectacularly in February 2021, is to seek evidence to support either of these two scenarios, and the newpaper using data from Perseverance may have done just that.

- Ancient bacteria from 5,000-year-old ice reveals clues to fighting superbugs (theconversation.com)

Laboratory analysis revealed something remarkable. These bacteria, undisturbed for thousands of years, were able to grow in a variety of harsh environments. They thrived in extreme cold and high salt levels ; settings that would normally prevent bacterial growth. The scientists also discovered that the ancient bacteria were resistant to ten modern antibiotics, including powerful broad-spectrum treatments such as ciprofloxacin – drugs designed to kill many types of bacteria. In other words, the antibiotics that would normally kill bacteria or halt their growth were largely ineffective against this strain.

- Covid : la quête des origines crédibilise la théorie de l’accident de labo (basta.media) – voir aussi Covid : la quête des origines (sciences-critiques.fr)

Spécial IA

- Non, l’intelligence artificielle n’est pas une alliée de la lutte climatique, confirme une étude (reporterre.net)

C’est la carte magique dégainée par les promoteurs de l’intelligence artificielle (IA), quand sont pointés les effets environnementaux de cette technologie : grâce à ses prouesses, l’IA serait un atout clé pour lutter contre le changement climatique. Six associations basées aux États-Unis, dont Les Amis de la Terre, ont publié le 17 février un rapport étrillant cette thèse. Elles dénoncent une « tactique de greenwashing » orchestrée par les entreprises de la tech, qui confine au « canular climatique ».

- How AI is transforming research : More papers, less quality, and a strained review system (newsroom.haas.berkeley.edu)

- Le milliardaire Mark Cuban affirme que l’IA va pousser les entreprises à ne plus déposer de brevets, car chaque LLM pourra s’entraîner dessus et les entreprises demanderont une solution de contournement (developpez.com)

« Le fait de ne pas déposer de brevets et d’utiliser des secrets commerciaux va devenir plus courant. Pourquoi ? Parce qu’à partir du moment où vous déposez votre brevet, tous les juristes vont pouvoir s’entraîner dessus. Ensuite, tout le monde sur la planète peut demander une solution de contournement pour déposer un brevet concurrentiel. »

- Derrière le rêve de l’école 100 % IA, un cauchemar de surveillance pour les élèves (numerama.com)

- Tunic, Night in the Woods Publisher Says TikTok Is Creating and Running Racist GenAI Ads for Its Games Without Permission (ign.com)

Finji, publisher of beloved indie titles such as Night in the Woods and Tunic and the developer behind Overland and Usual June, says that TikTok has been using generative AI to modify its ads on the platform without permission and pushing those ads to its users without Finji’s knowledge, including one ad that was modified to include a racist, sexualized stereotype of one of Finji’s characters.

- Pinterest Is Drowning in a Sea of AI Slop and Auto-Moderation (404media.co)

Pinterest has gone all in on artificial intelligence and users say it’s destroying the site.

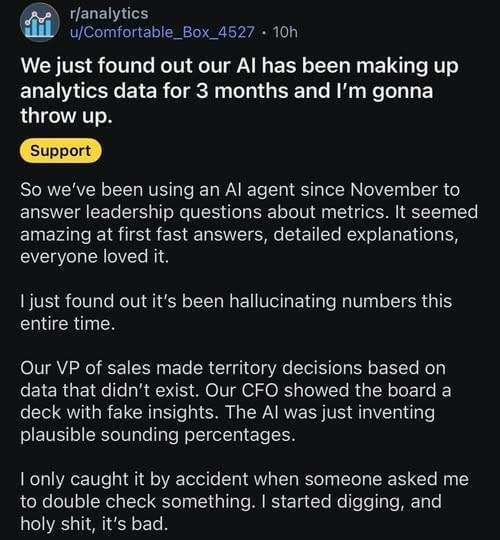

- Editor’s Note : Retraction of article containing fabricated quotations (arstechnica.com)

Ars Technica published an article containing fabricated quotations generated by an AI tool and attributed to a source who did not say them. That is a serious failure of our standards. […] Ars Technica does not permit the publication of AI-generated material unless it is clearly labeled and presented for demonstration purposes. That rule is not optional, and it was not followed here.

- Pannes chez AWS dues à son agent IA : Amazon se défausse sur ses employé·es (next.ink)

Plusieurs pannes chez AWS sont liées à l’utilisation en interne de ses propres agents IA par ses ingénieur·es. L’entreprise qui a lancé son agent Kiro en assurant qu’il allait « au-delà du vibe coding » rejette la faute sur ses employé·es qui auraient laissé faire son IA.

- Your AI-generated password isn’t random, it just looks that way (theregister.com)

Seemingly complex strings are actually highly predictable, crackable within hours

- I hacked ChatGPT and Google’s AI – and it only took 20 minutes (bbc.com)

- Where’s The Evidence That AI Increases Productivity ? (it.slashdot.org)

- Does Open Source AI really exist ? (tante.cc)

- En Inde, Emmanuel Macron assure que l’Europe est un “espace sûr” pour l’IA (france24.com)

- EU Parliament blocks AI tools over cyber, privacy fears (politico.eu)

The European Parliament has disabled AI features on the work devices of lawmakers and their staff over cybersecurity and data protection concerns

- Thanks a lot, AI : Hard drives are already sold out for the entire year, says Western Digital (mashable.com)

AI companies have bought out Western Digital’s storage capacity for 2026. It’s only February.

- AI fakery is turning fear into a voter suppression tool ahead of US elections (biometricupdate.com)

Deepfakes are expected to be deployed not merely to mislead voters, but to intimidate them into not voting

- Pour les masculinistes et l’extrême-droite, l’IA est l’outil de propagande parfait (portail.basta.media)

Le camp nationaliste, raciste et sexiste s’est saisi des outils d’intelligence artificielle pour propager à bas coût ses idées sur le Web.

Spécial Palestine et Israël

- Liban : des frappes israéliennes tuent au moins 8 personnes (rtbf.be)

- Study : More People Were Killed in First 16 Months of Gaza Genocide Than Reported (truthout.org)

The Lancet found that there were 75,200 “violent deaths” in Gaza between October 7, 2023 and January 5, 2025.

Voir aussi Violent and non-violent death tolls for the Gaza conflict : new primary evidence from a population-representative field survey (thelancet.com)

This first independent population survey of mortality in the Gaza Strip shows that violent deaths have substantially exceeded official figures whereas the demographic composition of casualties aligns with the Gaza Ministry of Health reporting.

- « Une stratégie délibérée visant à les réduire au silence » : des dizaines de témoignages de journalistes palestiniens victimes de torture dans les prisons israéliennes dévoilés par une ONG (humanite.fr)

Le Comité pour la protection des journalistes (CPJ) rappelle, dans un rapport publié jeudi 19 février, que les « violences systémiques » commises contre les journalistes palestiniens détenus dans des prisons israéliennes se poursuivent.

- Des footballeurs palestiniens attaquent la Fifa et l’UEFA pour la colonisation israélienne des stades en Cisjordanie (politis.fr)

Onze clubs de football israéliens sont installés dans des colonies illégales en Cisjordanie. […] plusieurs joueurs palestiniens ont porté plainte ce 16 février devant la Cour pénale internationale contre les présidents de la Fifa et de l’UEFA pour « complicité de crime de guerre ».

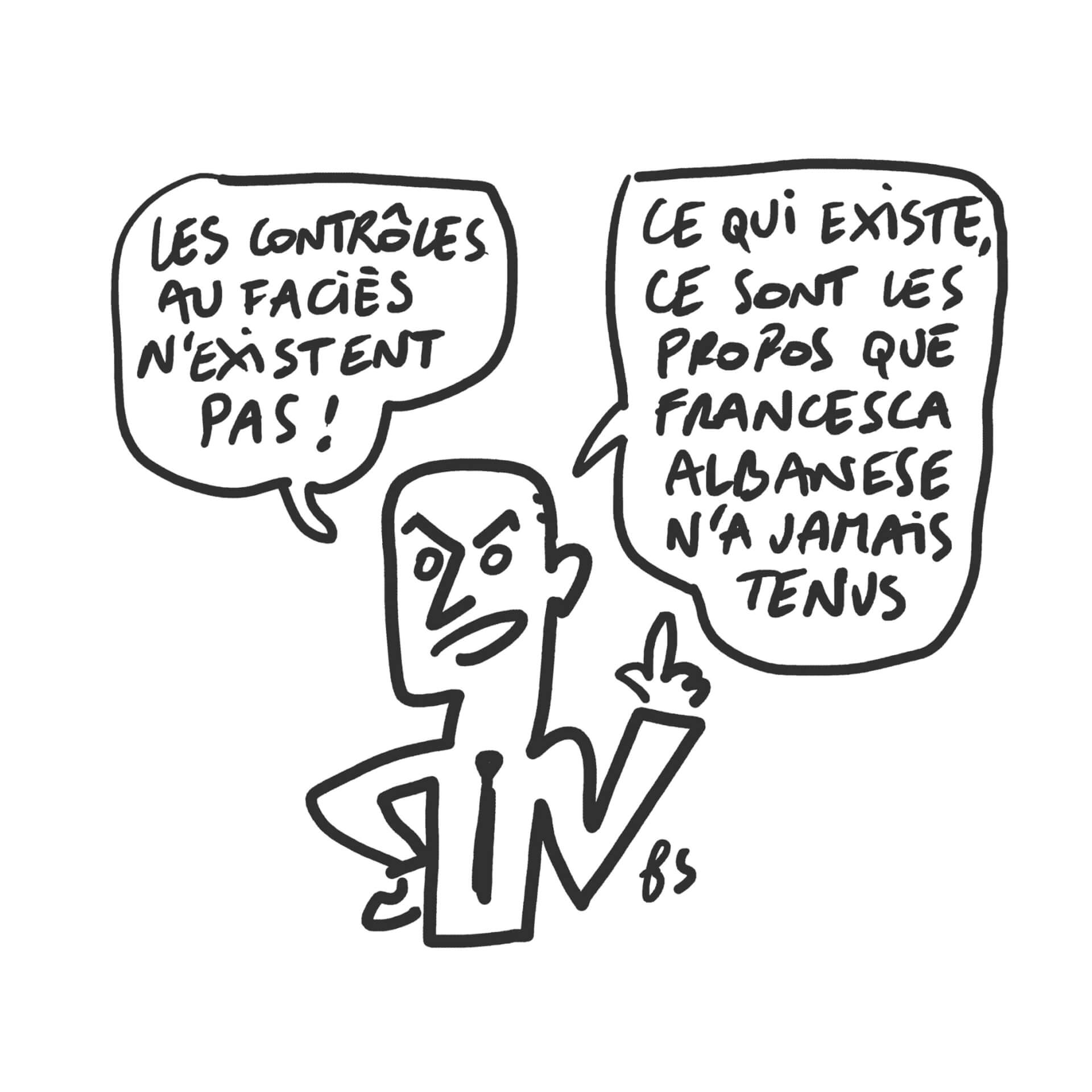

- Affaire Albanese : un ministre des Affaires étrangères sous influence (politis.fr)

En demandant la démission de Francesca Albanese, la représentante de l’ONU, Jean-Noël Barrot est complice des relais d’Israël en France.

- Vers un délit d’antisionisme ? (humanite.fr)

Ce jeudi 19 février, au 40ᵉ dîner du CRIF à Paris, Sébastien Lecornu est allé très loin en promettant qu’en avril, le Parlement examinera la proposition de loi pénalisant l’antisionisme, défendue par la députée Renaissance, très pro gouvernement israélien, Caroline Yadan. Une manière d’assimiler antisémitisme et antisionisme et, pour certains, de restreindre toute critique de l’État d’Israël.

- Retrait de l’avis de Poléthis : une décision qui interroge l’éthique et le droit (aurdip.org)

Des enseignants-chercheurs de l’Université Paris-Saclay contestent le retrait de l’avis rendu par le Conseil pour l’éthique de la recherche et l’intégrité scientifique (Poléthis) recommandant un réexamen éthique et une suspension provisoire des partenariats institutionnels avec des universités israéliennes.

- Propos de Wim Wenders à la Berlinale : Tilda Swinton, Javier Bardem et d’autres se disent “consterné·es” (telerama.fr)

En déclarant que “le cinéma devait rester en dehors de la politique”, le président du jury a soulevé une vague d’indignation. Une lettre ouverte signée par plus de 80 artistes dénonce une manifestation à la botte du pouvoir.

Spécial femmes dans le monde

- Suisse : Vers la fin des impôts patriarcaux (solidarites.ch)

Le compromis trouvé au Parlement pour une imposition individuelle est contesté par voie référendaire par le Centre, l’UDC et les Évangélistes. Le 8 mars, l’occasion est donnée aux citoyen·nes de réviser une loi obsolète centrée sur le modèle de la famille « traditionnelle » : l’homme gagne l’argent du ménage, la femme reste à la maison et travaille gratuitement.

- « C’est effrayant et personne n’en parle » : aux JO, la patineuse Amber Glenn livre une parole forte sur les règles (huffingtonpost.fr)

- JO d’hiver : encore une discipline interdite aux femmes (lesnouvellesnews.fr)

Alors que les Jeux olympiques d’hiver de Milan-Cortina se rapprochent de l’objectif de parité, l’épreuve de combiné nordique reste réservée aux hommes. Les sportives font entendre leur colère.[…] En 2026, la participation des femmes reste interdite. Pourtant, des femmes pratiquent ce sport à haut niveau. Une Coupe du monde féminine de combiné nordique existe même depuis 2021.

- Affaire Epstein : le « Zorro Ranch », la propriété désormais au centre des attentions (huffingtonpost.fr)

Jeffrey Epstein a acheté la luxueuse propriété en 1993. De nombreuses victimes affirment avoir été agressées dans ce lieu isolé, au cœur du désert au Nouveau-Mexique.

- Les agissements d’Epstein répondent aux critères de « crime contre l’humanité », selon des expert·es du Conseil des droits de l’Homme de l’ONU (huffingtonpost.fr)

ces crimes ont été commis dans un contexte de racisme, de corruption et de misogynie extrême.

- Affaire Epstein : les enquêtes se multiplient en Europe (basta.media)

La publication, fin janvier, de plus de trois millions de documents liés au milliardaire pédocriminel Jeffrey Epstein dévoile l’étendue de son influence auprès de l’élite européenne, y compris en France. Loin du complot mondial, les noms cités révèlent une réalité plus banale : un conformisme face à la violence masculine.

- Mandelson’s links with US tech firm Palantir must be fully exposed, campaigners warn (theguardian.com)

Peter Mandelson’s involvement with the US tech company Palantir must be exposed to full public transparency, campaigners have said, amid fears he may have leaked more sensitive information than is alleged in his emails to Jeffrey Epstein.

- The myth that women are more naturally empathetic than men (bbc.com)

A 2023 neurological study clearly shows that both women’s and men’s brain waves respond in much the same way when shown images of painful or neutral facial expressions.But in the part of the experiment where participants completed empathy questionnaires rating how empathetic they felt, men scored lower than women did on average. That is, unless they were told beforehand that they’d score well.

- « Vous n’êtes pas faible » : On sait enfin pourquoi les femmes sont plus touchées par les douleurs chroniques (huffingtonpost.fr)

Les chercheureuses ont mesuré les niveaux de ces globules blancs spécifiques et de la molécule soupçonnée d’alléger la douleur et ont découvert qu’ils étaient bien plus élevés chez les hommes que chez les femmes.

Voir aussi Les douleurs chroniques affectent davantage les femmes et on a maintenant une idée de pourquoi (france24.com)

RIP

- Leïla Shahid : ce soleil qui s’installe derrière l’horizon (humanite.fr)

En français, en arabe, en anglais, la ferme tendresse de sa voix portait loin. De la rue aux rédactions des médias, jusqu’aux chancelleries du continent européen et du monde. Leïla Shahid était l’incarnation de la Palestine, de son peuple et de sa terre, de son histoire et de sa culture.

- Mort de Susan George, figure inspirante de l’altermondialisme (basta.media)

Susan George vient de décéder à l’âge de 91 ans, après avoir été de tous les combats altermondialistes, depuis le blocage de l’OMC à Seattle jusqu’à l’organisation des forums sociaux mondiaux.

Spécial France

- LFI conteste en justice son nouveau classement par le ministère de l’Intérieur (huffingtonpost.fr)

Classée pour la première fois dans le bloc « extrême gauche » par le ministère de l’Intérieur, La France Insoumise a déposé un recours devant le Conseil d’État.

- Un collaborateur de Raphaël Arnault interdit d’accès au Palais Bourbon (projetarcadie.com)

- Raphaël Arnault doit être exclu du groupe LFI à l’Assemblée, plaide le gouvernement (huffingtonpost.fr)

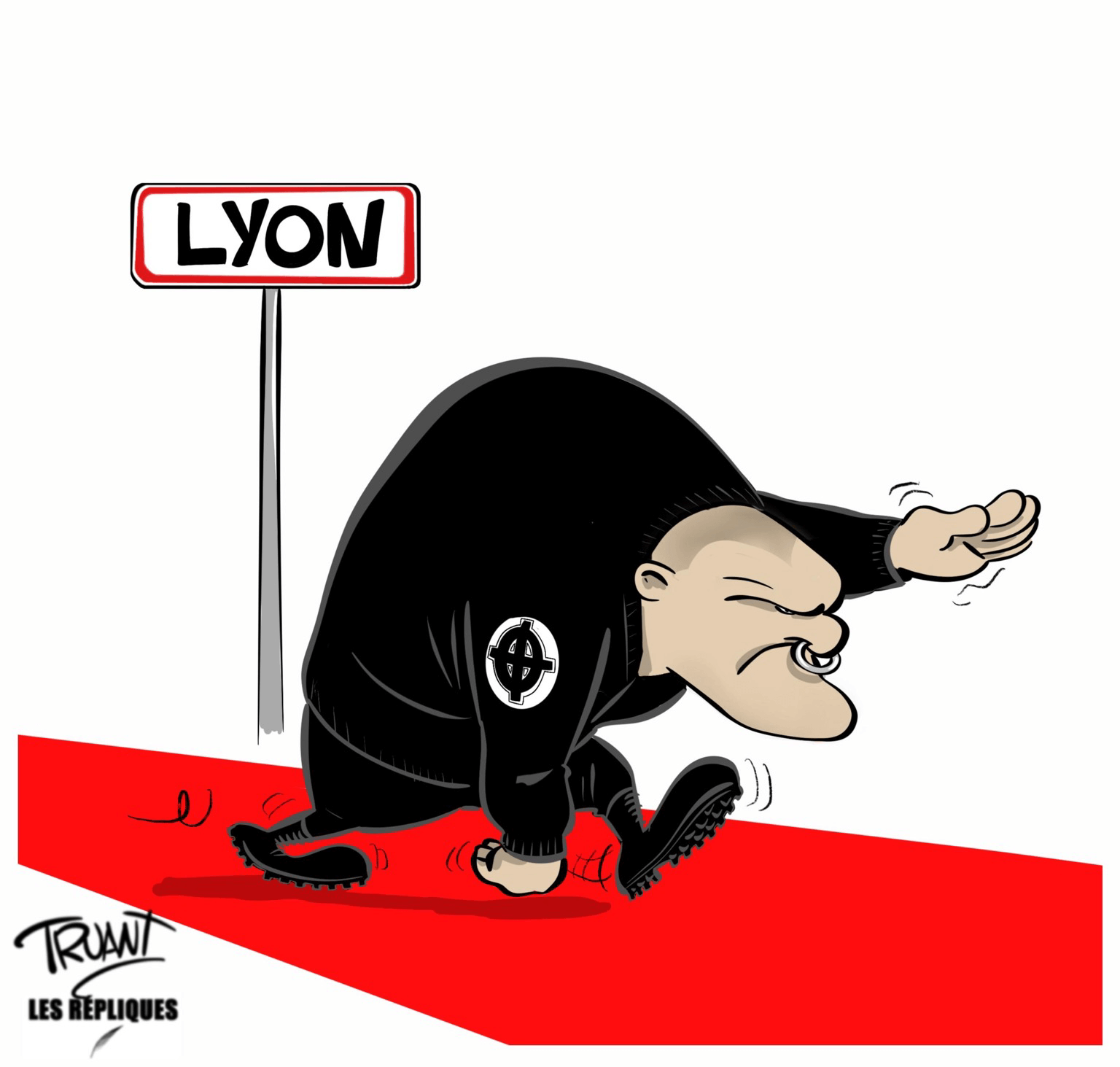

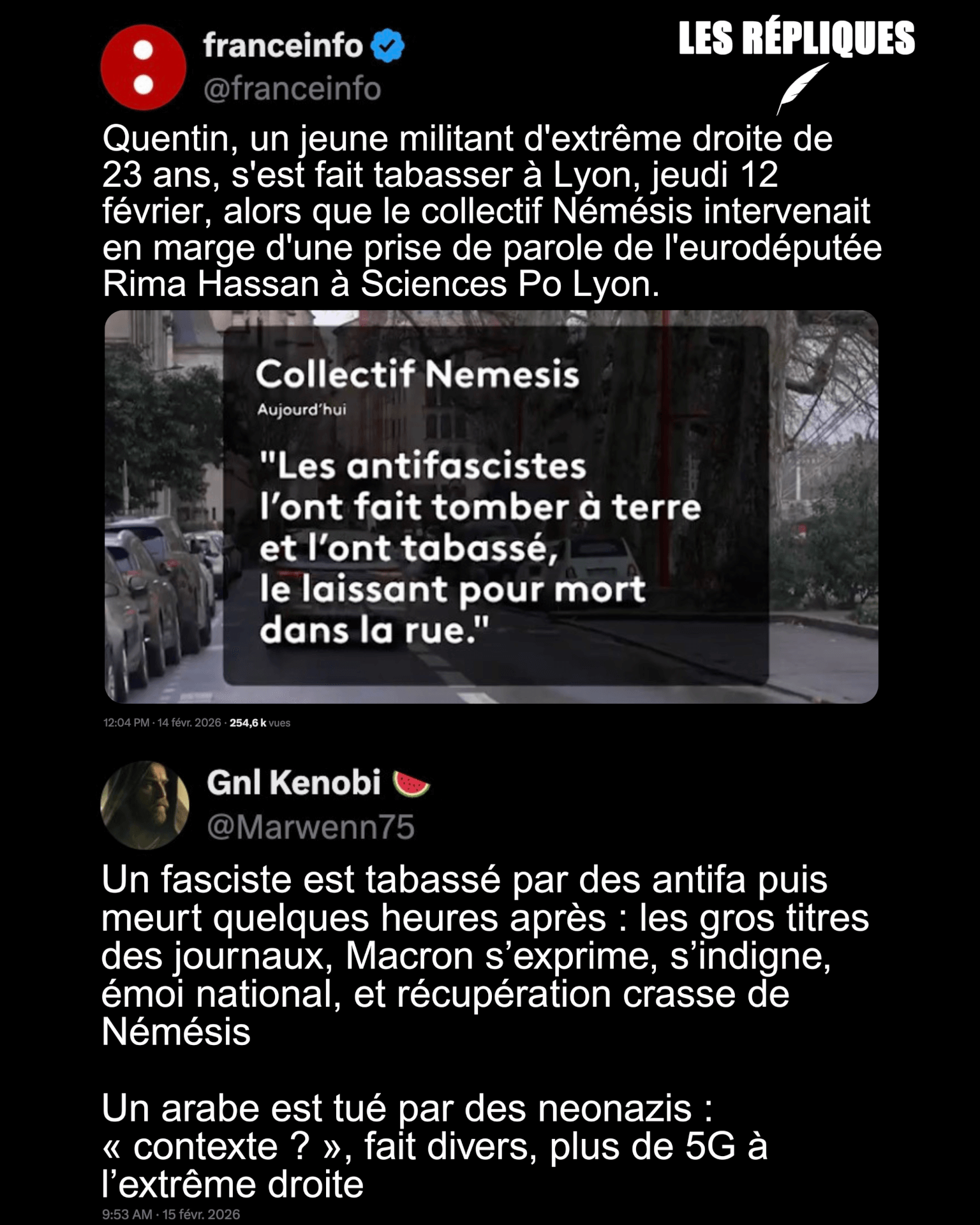

- Lyon : cinq interpellations après la mort de Quentin Deranque, dont l’assistant de Raphaël Arnault (huffingtonpost.fr)

- Après la mort de Quentin Deranque, une guerre culturelle qui sacrifie les faits (huffingtonpost.fr)

tout occupée à diaboliser LFI, récemment classée à l’extrême gauche par le ministre de l’Intérieur, la macronie est bien plus discrète sur le contexte local, et les intentions belliqueuses des groupes d’extrême droite dont faisait partie la victime. Elles ne font pourtant plus aucun doute.

- Pour « assurer la sérénité des débats », l’ENS annule une nouvelle conférence de l’eurodéputée Rima Hassan (huffingtonpost.fr)

Après la mort d’un militant nationaliste en marge d’une conférence de Rima Hassan à Lyon, une nouvelle intervention de l’eurodéputée prévue à l’ENS Paris-Saclay a été annulée pour raisons de sécurité.

- La seule députée qui ne s’est pas levée pour l’hommage à Quentin Deranque explique pourquoi (huffingtonpost.fr)

Alors que ses collègues, sur tous les bancs, se tenaient debout, la députée Horizons Anne-Cécile Violland a fait le choix de rester assise. […] Si l’élue condamne la « violence abjecte qu’a subie ce jeune homme », elle explique souhaiter « que l’Assemblée puisse partager la même indignation pour les femmes et enfants victimes de violence, qui meurent trop souvent dans une forme d’indifférence ».

- L’antivalidisme en délibéré (blogs.mediapart.fr)

Tirée au sort pour être jurée d’assises, une femme sourde se réjouit d’exercer pleinement sa citoyenneté. La justice saura-t-elle l’accueillir ?

- La fin du permis de conduire à vie déboule : ce que vous devez savoir (60millions-mag.com)

À partir du 26 novembre 2029, l’harmonisation européenne va imposer deux changements. Non seulement la durée de validité du permis tombera à dix ans (en s’alignant avec celle des autres documents d’identité), mais le renouvellement sera conditionné à un contrôle médical.

- Les voitures de fonction profitent aux hommes riches, pas à la planète (reporterre.net)

La voiture de fonction profite avant tout aux cadres supérieurs et aux hommes, selon une étude publiée le 17 février par le Forum vies mobiles. Coûteuse pour l’État, elle n’est ni sociale ni écologique.

- Le CNRS a subi une fuite de données (next.ink)

- La CFDT confirme un vol de données qui concerne aussi les ex-adhérent·es (next.ink)

- Des accès à des portails internes de la Gendarmerie et du ministère des Armées diffusés (frenchbreaches.com)

- RIB, identité du titulaire, adresse… les données d’1,2 million de comptes bancaires consultés par un « acteur malveillant », comment réagir ? (humanite.fr)

- Essais nucléaires en Polynésie : une loi pour mettre fin au déni de l’État (disclose.ngo)

Fin janvier, l’Assemblée nationale a voté une proposition de loi visant à combler le manque de reconnaissance des victimes des essais nucléaires en Polynésie française. Le texte, qui doit encore être examiné par le Sénat, est le résultat d’une commission d’enquête parlementaire qui s’appuie en grande partie sur les révélations publiées par Disclose il y a cinq ans.

- Sur l’A69, les fortes pluies font déborder des eaux non traitées (reporterre.net)

- Crues : « On a détruit tout ce qui permettait d’absorber la pluie » (reporterre.net)

Rues bétonnées, haies arrachées, rivières rectifiées… Nos pratiques ont appauvri les sols, aggravant davantage les crues dans l’ouest de la France

- « Au secours, il faut partir ! » La crue fait céder des digues de la vallée de la Garonne (reporterre.net)

- Ces images depuis l’espace montrent à quel point la crue de la Garonne est impressionnante (huffingtonpost.fr)

Des satellites ont photographié la crue exceptionnelle de la Garonne dans le Sud-Ouest, révélant des paysages complètement transformés.

Spécial femmes en France

- Alice Coffin : « Les féministes sont mises sur la touche aux municipales » (reporterre.net)

- Exclusion, dignité bafouée, attouchements sexuels et discriminations : dans le quotidien des prisonnières à Perpignan (madeinperpignan.com)

- Attaques masculinistes : la réponse floue du ministre de l’Intérieur (lesnouvellesnews.fr)

Saturation du 3919, cyberharcèlement des écoutantes, stratégies d’intimidation : des réseaux masculinistes ciblent les dispositifs d’aide aux femmes victimes de violences. Le ministre de l’Intérieur condamne sans annoncer de mesures concrètes.

- Propulsé par les médias sociaux, le masculinisme sort de l’ombre et trouve un écho dans la sphère publique (theconversation.com)

En dix ans, le masculinisme est passé de la marge à la visibilité. Ses discours, amplifiés par les réseaux sociaux, façonnent désormais une partie de l’espace public.

- Un podcast masculiniste bientôt contraint de respecter la loi ? (lesnouvellesnews.fr)

L’Arcom a jugé recevable une saisine concernant le podcast masculiniste du « Raptor ». Jusqu’ici, les podcasts échappaient aux lois empêchant la propagation de la haine. Le Raptor, de son vrai nom Ismaïl Ouslimani, est un youtubeur d’extrême droite qui s’est fait connaître à partir de 2015 en diffusant des vidéos virilistes, antiféministes, masculinistes, racistes, homophobes, climatosceptiques…

- Affaire Epstein : des magistrats parisiens enquêtent sur d’éventuelles infractions liées à des Français (humanite.fr)

Après la publication de millions de documents liés au pédocriminel américain Jeffrey Epstein, le parquet de Paris a annoncé la saisine de magistrats référents pour analyser d’éventuelles infractions liées à des Français et procéder « à une réanalyse intégrale du dossier d’instruction » de l’ex-agent de mannequins Jean-Luc Brunel, mort en détention en 2022.

- Julien Bayou accusé de viol par une ex-compagne (reporterre.net)

Un an après le classement sans suite d’une plainte pour « abus frauduleux d’état de faiblesse », l’affaire continue de fracturer les Écologistes. Dans une enquête parue le 14 février, le journal Le Monde révèle le témoignage inédit d’Estelle, compagne de Julien Bayou entre 2015 et 2018. Celle-ci accuse l’ancien député de violences psychologiques et sexuelles, mais également d’un viol conjugal en 2017.

- « Routard du viol » : quand Le Parisien traite de pédocriminalité (politis.fr)

Un homme de 79 ans, Jacques Leveugle, a été mis en examen et placé en détention provisoire en 2024 pour « des viols et agressions sexuelles aggravés commis sur 89 mineurs pendant 55 ans ». Le journal Le Parisien a préféré, lui, mettre l’accent sur l’esprit « routard », comme si le viol était un voyage, presque une expérience touristique. Au fil de l’article, on apprend également que Leveugle a avoué, dans les « mémoires » retrouvées sur une clé USB qui l’ont confondu, avoir tué sa mère et sa tante.[…] Le Parisien ne semble pas accorder beaucoup d’importance à ces deux aveux d’homicides, mentionnés au passage, après « les faits d’une extrême gravité » – les viols et agressions sexuelles.

- Féminicide d’Inès Mecellem : l’Inspection générale de la justice reconnaît une “accumulation de défaillances” (franceinfo.fr)

- « Nous, covictimes de féminicide, sommes invisibles aux yeux de beaucoup » (politis.fr)

Depuis le féminicide de leur mère à Gagny, Abir, Amel et Sihame ainsi que leurs proches survivent dans un quotidien marqué par le traumatisme, la précarité et le manque de soutien institutionnel. Elles réclament aujourd’hui justice, reconnaissance et des mesures concrètes pour que les covictimes de féminicide ne soient plus abandonnées.

Spécial médias et pouvoir

Spécial emmerdeurs irresponsables gérant comme des pieds (et à la néolibérale)

- Des chiffres de Bercy révèlent que plus de 13 000 millionnaires ne paient pas d’impôt sur le revenu (france24.com)

Ces chiffres obtenus via le ministère de l’Économie et des Finances confirment les déclarations en janvier dernier de l’ancien ministre Éric Lombard, alors démenties par la ministre des Comptes publics, Amélie de Montchalin.

- Impôts des riches : la ministre ment et se voit promue par Macron (regards.fr)

- La présence discrète de l’État français au capital de TotalEnergies (multinationales.org)

l’Observatoire des multinationales révèle que l’État français – via son bras financier, la Caisse des dépôts et consignations – est discrètement présent au capital du groupe pétrolier et gazier, à hauteur de 1,7 milliard d’euros. Une participation sur laquelle régnait jusqu’à présent l’omertà et qui interroge sur les relations entre la multinationale et les pouvoirs publics.

- Quand le Salon de l’agriculture masque la faillite du modèle productiviste (lenouveauparadigme.fr)

Spécial recul des droits et libertés, violences policières, montée de l’extrême-droite…

- « À vomir » : l’avocat des proches de Federico Martin Aramburu dénonce une différence de traitement avec Quentin Deranque (huffingtonpost.fr)

L’avocat de la famille de l’ancien rugbyman argentin, tué par deux militants d’ultradroite, dénonce le contraste entre les hommages rendus à Quentin Deranque et le silence gouvernemental à l’époque.

- Mort de Quentin Deranque : Dominique de Villepin craint que la « diabolisation » de LFI ouvre un « corridor » au RN (huffingtonpost.fr)

Dans un long message, l’ancien Premier ministre refuse de renvoyer dos à dos la gauche et l’extrême droite, estimant que cette dernière constitue « une menace ».

- Affaire Deranque : interdire le savoir, le piège de l’ordre public contre les libertés fondamentales (politis.fr)

Après la mort du militant d’extrême droite tué à Lyon, une inquiétante dérive se fait jour : au nom de l’ordre public, l’État semble prêt à restreindre toujours davantage la liberté d’expression et de réunion

- La mort de Quentin D. et l’inversion morale du débat public (politis.fr)

Ce dimanche, le rassemblement parisien en hommage à Quentin D. constituait un véritable trombinoscope du fascisme : royalistes, antisémites, racialistes, identitaires, néonazis, etc. Et il ne fallait pas s’y tromper : ces cinquante nuances d’extrême droite se sont livrées à une véritable déclaration de guerre.

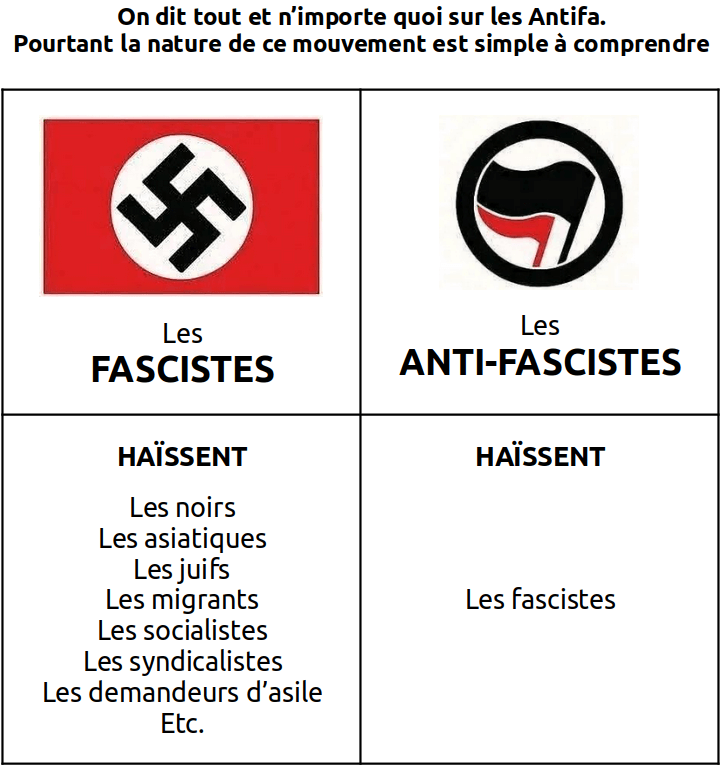

- Mort de Quentin D. à Lyon : « L’antifascisme est aujourd’hui instrumentalisé » (basta.media)

L’homicide de Quentin Deranque, militant d’extrême droite de 23 ans, sert de prétexte à une entreprise d’inversion des valeurs, mettant dos à dos fascisme et antifascisme, au mépris des faits historiques.

- Mort de Quentin Deranque : Blandine Bardinet, la jeune femme incriminée par l’extrême droite, était bien à l’étranger (liberation.fr)

Damien Rieu, le collectif Nemesis et d’autres militants identitaires ont accusé l’ex-militante de la Jeune Garde d’être sur les lieux lors du lynchage du militant nationaliste. Selon les preuves recueillies par « CheckNews », elle était à près de 10 000 km de Lyon au moment des faits.

- Marion Maréchal Le Pen affirme que « la violence d’extrême droite est dérisoire » et qu’elle « n’existe pas dans notre pays ». C’est factuellement faux. (huffingtonpost.fr)

« Si on fait un bilan sinistre des décès causés par les radicaux depuis 1986, la gauche a tué 6 personnes, la droite 59 »

- Après la mort de Quentin Deranque, le RN ose une récupération qui l’expose au retour de flamme (huffingtonpost.fr)

« au moins neuf hommes condamnés ou en attente d’un procès dans des affaires de terrorisme d’extrême droite ont exercé des responsabilités au sein du Rassemblement national ou l’ont représenté à des élections locales et nationales ». Au sein de l’échiquier politique, il n’existe aucun autre parti autant représenté dans ce type d’affaires.

- Mort de Quentin à Lyon : contre-enquête au cœur d’une ville gangrénée par la violence d’extrême-droite (blast-info.fr)

Militant de l’extrême-droite radicale lyonnaise, Q. Deranque évoluait dans un contexte local marqué par la présence durable de groupes néo-fascistes, régulièrement impliqués dans des violences. Sa mort dramatique ne doit pas faire oublier que la violence des antifas est sans commune mesure avec celle de l’extrême droite, qui multiplie les exactions depuis des années.

- Mort de Quentin Deranque : « Capitale des fachos » et « labo de l’antifascisme »… Lyon concentre les violences politiques (20minutes.fr)

- L’antifascisme et la violence : retour sur les événements du 12 février à Lyon (rebellyon.info)

La mort de Quentin D. est le résultat symptomatique d’une situation extrêmement tendue depuis des années à Lyon. La ville est connue pour être un bastion de l’extrême droite, favorisé par l’implantation historique d’une bourgeoisie catholique réactionnaire. Elle a vu pulluler au fil du temps nombre de groupuscules d’extrême droite de différentes obédiences (royalistes, identitaires, catholiques traditionalistes, nationalistes-révolutionnaires etc …). Depuis, ces groupes ont commis de nombreuses attaques, que ce soit en s’attaquant à des rassemblements de gauche, à des locaux d’organisations ou en commetant des agressions racistes ou homophobes. Ces violences, exercées par les militants-es de ces groupes, sont consubtantielles à la nature du projet politique d’extrême droite qu’ils portent : le nationalisme, le racisme, le masculinisme, bref le maintien de la hiérarchie sociale et la suprémacie blanche.

- Mort d’un militant néofasciste à Lyon : pendant que l’enquête progresse, l’extrême droite cible la gauche (basta.media)

Après des dégradations à Bordeaux et une attaque du local lyonnais du syndicat de gauche Solidaires dans la nuit du 14 au 15 février, puis l’agression des clients d’un bar identifié à gauche à Toulouse par des hooligans néonazis le 17 février, le siège de La France insoumise a dû être évacué le 18 février après une alerte à la bombe.

- Agression, menaces et calomnies : les représailles de l’extrême droite après la mort de Quentin D. (basta.media)

Depuis l’homicide du néofasciste Quentin Deranque, LFI et l’« extrême gauche » sont prises à partie. Des menaces et dégradations visent des militants antifascistes, des insoumis, mais aussi des syndicalistes.

- Attaques en série de l’extrême-droite après le 12 février (rebellyon.info)

- Mort de Quentin Deranque : qui sont les Allobroges Bourgoin, son groupuscule néofasciste (streetpress.com)

- Némésis : la dissolution nécessaire que personne ne mentionne (politis.fr)

Après la mort du militant nationaliste Quentin Deranque, la chroniqueuse Marie Coquille-Chambel pointe la responsabilité du collectif fémonationaliste dans les violences commises par l’extrême droite et appelle à sa dissolution, dénonçant son rôle présumé dans l’organisation et la médiatisation d’affrontements politiques.

- À Lyon, l’organisatrice de la marche pour Quentin Deranque est mariée à un néonazi violent (streetpress.com)

- Des saluts nazis à la marche pour Quentin Deranque, la préfecture va saisir la justice (huffingtonpost.fr)

Au moins deux saluts nazis ont été relevés sur les images de la manifestation à Lyon, et des propos racistes ont été entendus.

- Municipales. L’offensive de l’extrême-droite (lempaille.fr)

Au regard des résultats des dernières législatives, le RN et ses alliés pourraient réaliser un raz-de-marée en mars, mais leur faible niveau d’implantation les empêche souvent de présenter des listes dans une grande partie de nos territoires. En se concentrant sur des villes gagnables et en envoyant ses député·es ou ses cadres, l’extrême droite risque néanmoins de multiplier le nombre de communes sous sa botte.

- “C’est un parti anti-France” : Aurore Bergé appelle la gauche à rompre avec LFI pour les municipales et le RN à lui faire barrage (bfmtv.com)

- Municipales 2026 : là où l’extrême droite est au pouvoir, les habitant·es sont plus exposé·es aux risques climatiques (vert.eco)

- Couper, contrôler, faire taire : les associations malmenées dans les villes d’extrême droite : le budget de 10 municipalités du sud-est passé au crible (lepoing.net)

- Des témoignages d’agressions homophobes et politiques à Amiens : “On est dans une logique de banalisation de la violence de l’extrême droite” (france3-regions.franceinfo.fr)

- “On a frôlé le carnage” : le forcené gravement blessé après une intervention du Raid possédait “un véritable arsenal” (france3-regions.franceinfo.fr)

Un homme de 78 ans s’était retranché chez lui après avoir tiré des coups de feu et lancé des grenades vers des policiers, mardi 17 février à Châteauroux. Après une intervention du Raid, le forcené a été gravement blessé et emmené par le Samu sur un brancard. […] Selon plusieurs sources sur place et au sein de l’institution policière, le suspect est un militant du Rassemblement national, candidat FN à plusieurs élections dans l’Indre entre 1992 et 1994. […] Le procureur a déclaré que “cinq armes de poing de différentes époques et des milliers de munitions” ont été saisies, et qu’un atelier artisanal de fabrication de munitions avait été découvert. Plusieurs dizaines d’armes “chargées et en état de fonctionnement” ont également été trouvées par les enquêteurs, notamment une mitraillette et un fusil à pompe.

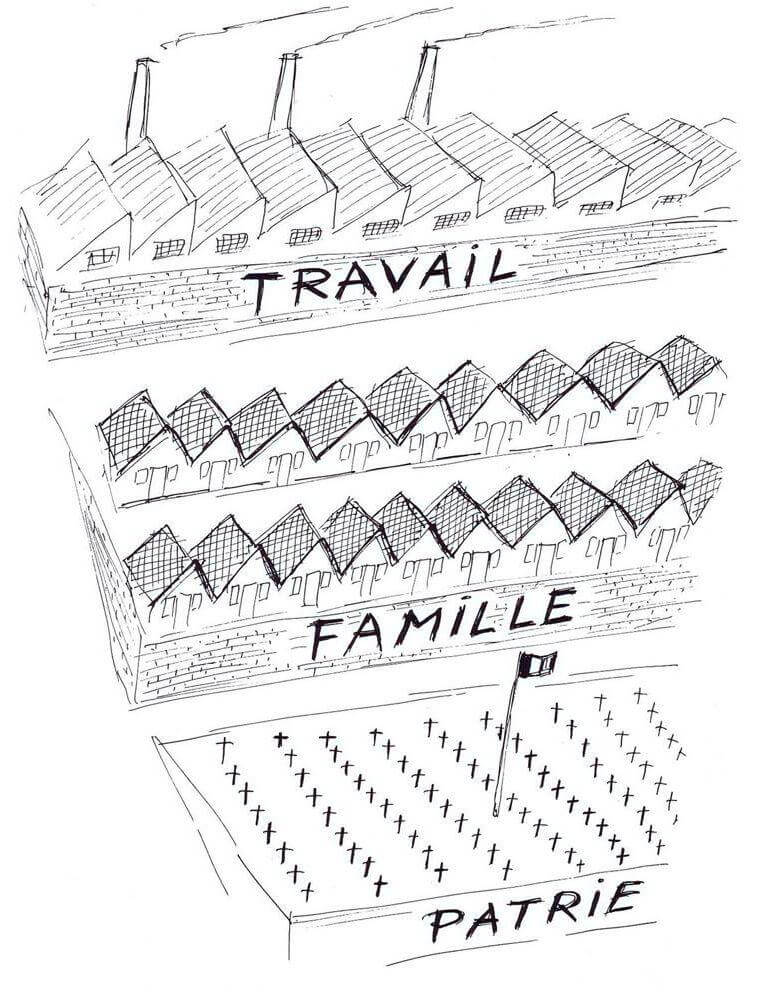

- « Le travail, la famille, la patrie » : à Marseille, la candidate LR Martine Vassal reprend à son compte le slogan de Pétain (humanite.fr)

- Police armée et vidéosurveillance : Bordeaux a-t-elle pris un virage sécuritaire ? (reporterre.net)

Agents armés, vidéosurveillance… Pierre Hurmic, le maire écologiste de Bordeaux, a adopté des mesures visant à renforcer sa police municipale. Un choix qui témoigne de la pression de l’opinion sur les maires.

- Vers une entrée gratuite des musées pour les policiers et gendarmes à condition qu’ils portent leurs armes de service (franceinfo.fr)

La mission parlementaire sur la sécurité des musées formule 24 recommandations, dont la volonté de mieux former les agents d’accueil et de surveillance des musées.

- Des agents de sûreté de la SNCF et la RATP autorisés à porter des pistolets à impulsion électrique à “titre expérimental” (franceinfo.fr)

- De l’intelligence artificielle pour repérer les voleurs dans les commerces ? La proposition étudiée ce lundi à l’Assemblée fait débat (franceinfo.fr)

- Vidéosurveillance : les députés autorisent l’usage d’algorithmes pour détecter le vol dans les commerces (lemonde.fr)

En France, des supermarchés déploient déjà ces logiciels qui visent à signaler les comportements suspects dans les rayons en envoyant une alerte au gérant ou à la sécurité lorsque certains gestes sont détectés.

- Journalistes en garde à vue ou fichés… Au moins 91 atteintes à la liberté de la presse en France en 2024 (reporterre.net)

- « Il semblait plus âgé » : un enfant enfermé 6 jours à Orly malgré visa D valide (blogs.mediapart.fr)

- Violences policières : la justice condamne celle qui filme, pas celle qui frappe (streetpress.com)

La policière avait filmé les images de vidéosurveillance montrant les violences commises par une de ses collègues dans les sous-sols du tribunal judiciaire. Le tribunal l’a condamnée mais dispensée de peine.

Spécial résistances

- Affirmer notre antifascisme : le devoir du moment (humanite.fr)

Romancier·es, historien·nes, écrivain·es, sociologues ou élu·es, 180 personnalités appellent au sursaut contre l’instrumentalisation de la mort de Quentin Deranque par l’extrême droite, la droite, le gouvernement et les médias dominants qui cherchent ainsi à instaurer une chape de plomb sur la gauche et à inverser les rôles entre fascistes et antifascistes.

- Permanences LFI et locaux syndicaux vandalisés : l’extrême droite lance une offensive, faisons front (revolutionpermanente.fr)

Alors que la campagne de criminalisation de la gauche s’intensifie après la mort d’un militant néofasciste, des groupes d’extrême droite ont ciblé des locaux syndicaux, politiques et associatifs dans plusieurs villes.

- Sonner le tocsin contre les extrêmes droites (ripostes.org)

- « Qu’on arrête de nous dire qu’on coûte cher » : les centres de santé participatifs pour l’instant sauvés (basta.media)

Des centres et maisons de santé participatifs testent depuis plusieurs années une autre manière de soigner, en tenant compte des inégalités. Leur financement a été remis en cause fin janvier, les mettant en danger. Mais la mobilisation a payé.

- JO d’hiver 2030 : un conflit ? quel conflit ? (cqfd-journal.org)

En 2030, les Jeux olympiques et paralympiques d’hiver se tiendront dans les Alpes françaises. Cocorico ! Mené en douce, ce projet est plutôt un concentré de tout ce qui se fait de pire en matière d’atteintes au droit, à la démocratie et à l’environnement. Alors, pourquoi diable ne nous révolte-t-il pas plus ?

Spécial outils de résistance

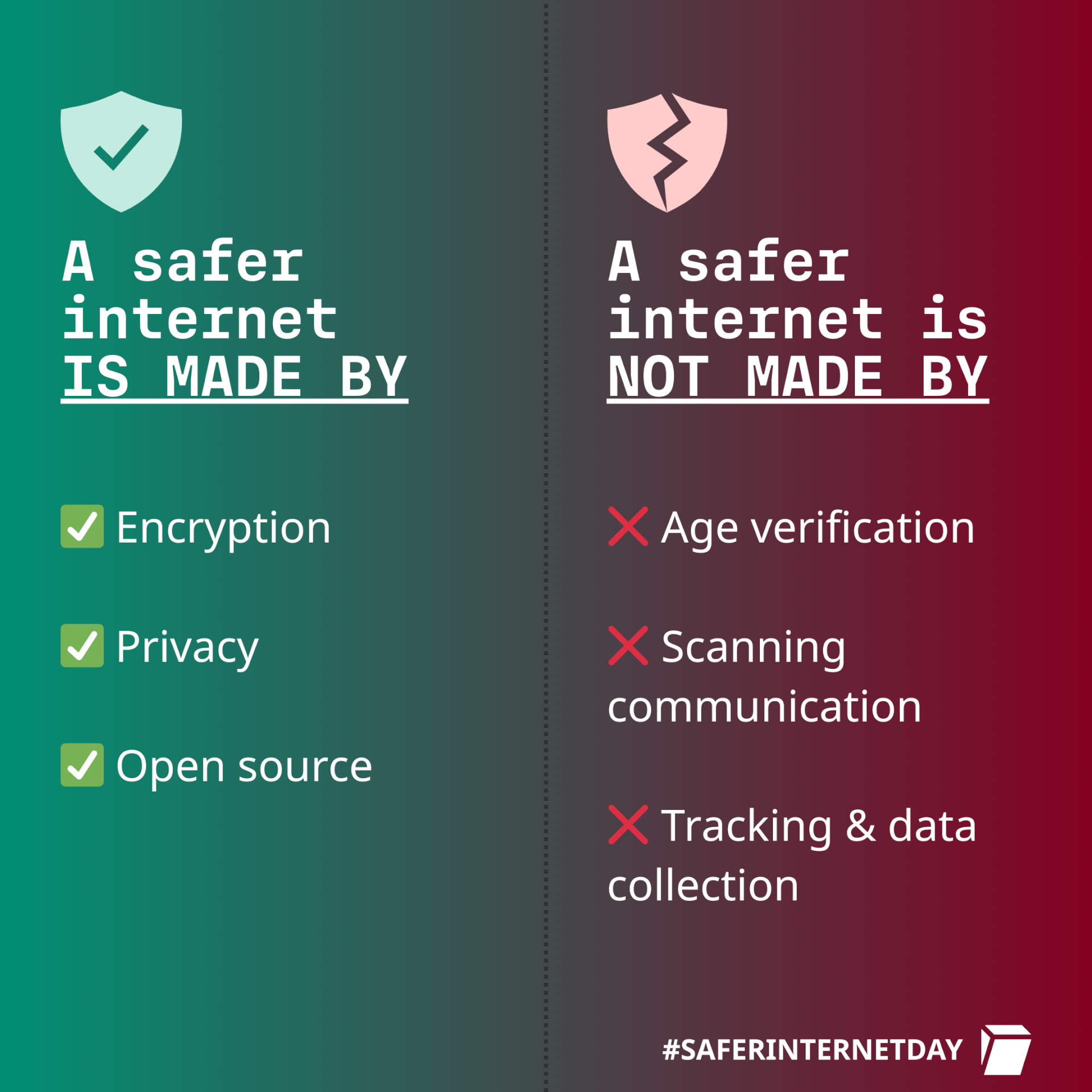

- Age Verification and Age Gating : Resource Hub (eff.org)

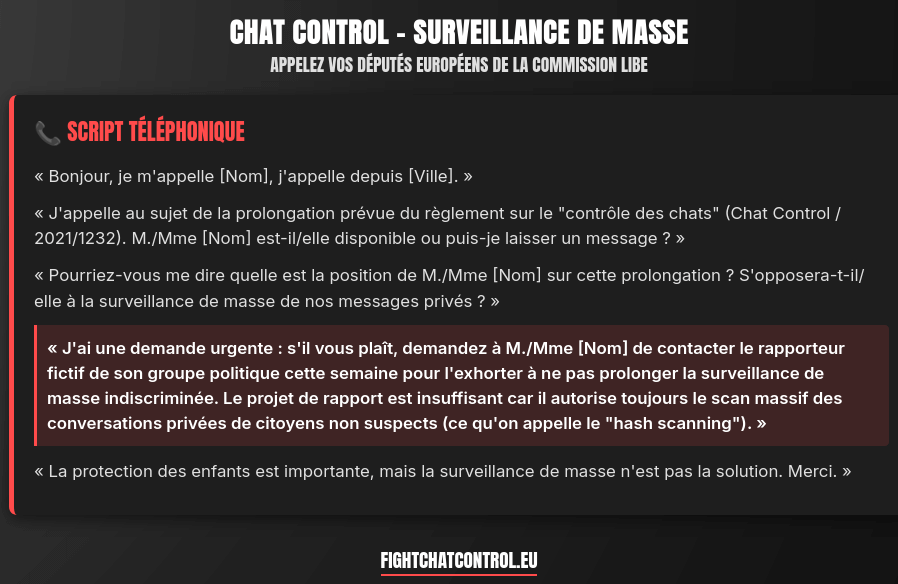

- Fight Chat Control ! (fightchatcontrol.eu)

- Keep Android Open (keepandroidopen.org)

Faites entendre votre voix !

- Meurtre de Quentin Deranque : quels mécanismes conduisent à la violence politique ? (theconversation.com)

Il est important de rappeler une importante asymétrie. La base de données de Sommier, Crettiez et Audigier (2021) recense environ 6 000 épisodes de violence politique sur la période 1986-2021 et établit que parmi les morts des violences idéologiques, neuf sur dix sont victimes de l’extrême droite. La violence d’extrême droite est aussi plutôt dirigée contre des personnes, celle d’extrême gauche plutôt contre des biens.

- Les Morts causées par les radicaux en France (tempspresents.com)

- “90 % des meurtres à caractère idéologique sont le fait de l’extrême droite” (bonpote.com)

- Quelques données pour combattre les fachos (khrys.eu.org)

- Face à l’antiféminisme, s’armer de savoirs (shs.cairn.info)

Spécial GAFAM et cie

- Google and Microsoft offer lucrative deals to promote AI, but even $500,000 won’t sway some creators (cnbc.com)

AI companies like Anthropic and Meta are hiring social media creators to post sponsored content on apps like Facebook, Instagram, YouTube and LinkedIn.

- Meta Begins $65 Million Election Push To Advance AI Agenda (politics.slashdot.org)

Meta is preparing to spend $65 million this year to boost state politicians who are friendly to the artificial intelligence industry, beginning this week in Texas and Illinois, according to company representatives. The sum is the biggest election investment by Meta, which owns Facebook, Instagram and WhatsApp.

- FTC asked to investigate Meta facial recognition smart glasses plan (biometricupdate.com)

- Apple is reportedly planning to launch AI-powered glasses, a pendant, and AirPods (theverge.com)

The three devices could come with cameras and connect to the iPhone, allowing Siri to perform actions based on the wearer’s surroundings.

- Microsoft’s new 10,000-year data storage medium : glass (arstechnica.com)

in Wednesday’s issue of Nature, Microsoft Research announced Project Silica, a working demonstration of a system that can read and write data into small slabs of glass with a density of over a Gigabit per cubic millimeter.

- Microsoft AI chief gives it 18 months—for all white-collar work to be automated by AI (fortune.com)

- Microsoft says Office bug exposed customers’ confidential emails to Copilot AI (techcrunch.com)

Microsoft has confirmed that a bug allowed its Copilot AI to summarize customers’ confidential emails for weeks without permission.

- Gentoo Linux Begins Codeberg Migration In Moving Away From GitHub, Avoiding Copilot (phoronix.com)

- Murena et Volla lancent une tablette sous /e/OS pour se passer de Google (goodtech.info)

Les autres lectures de la semaine

- The Left Doesn’t Hate Technology, We Hate Being Exploited (aftermath.site)

- Acting ethically in an imperfect world (tante.cc)

- A programmer’s loss of a social identity (ratfactor.com)

- Sécurité : reconstruire le lien plutôt que multiplier les caméras (lenouveauparadigme.fr)

La sécurité ne se résume ni aux uniformes ni à la vidéo-surveillance. Une commune réellement sociale et écologique agit d’abord sur les causes de l’insécurité en ramenant les services publics, la présence humaine et des lieux de vie dans tous les quartiers.

- Tchernobyl, 40 ans après : qu’avons-nous appris ? (basta.media)

Les trajectoires ont divergé, mais la découverte sous-jacente était commune : le risque nucléaire n’est pas seulement technique. Il est politique, éthique et inégalitaire. […] Lorsque ces systèmes posent problème, les États ont recours au secret, protègent de manière inégale et cherchent à limiter les dégâts.

- « Des enfants qui comprennent aujourd’hui la nature deviennent demain des adultes qui la respectent » (lezephyrmag.com)

- « Printemps silencieux » en URSS : dans les marges de l’agriculture industrielle russe (terrestres.org)

- 5,300-Year-Old Egyptian Artifact Confirms Existence of “Mechanically Sophisticated” Drilling Technology Before the Age of the Pharaohs (thedebrief.org)

- Travail du sexe, entre féminisme prohibitionniste et conservatisme sénile – À propos de deux projets de loi (lundi.am)

Les BDs/graphiques/photos de la semaine

- Pantoufles

- Bottes

- Irréprochable

- Se tenir

- Entrez

- Minute de silence

- Années

- Digues

- Sensibilité

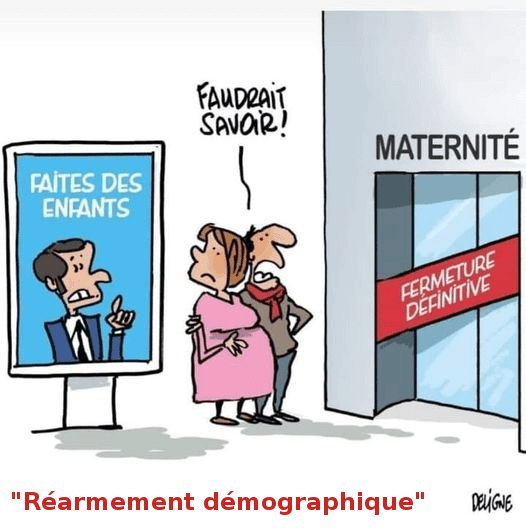

- Travail, Famille…

- Fine

- Fuck

- Différences

- Simple

- Ligne

- Mélenchon

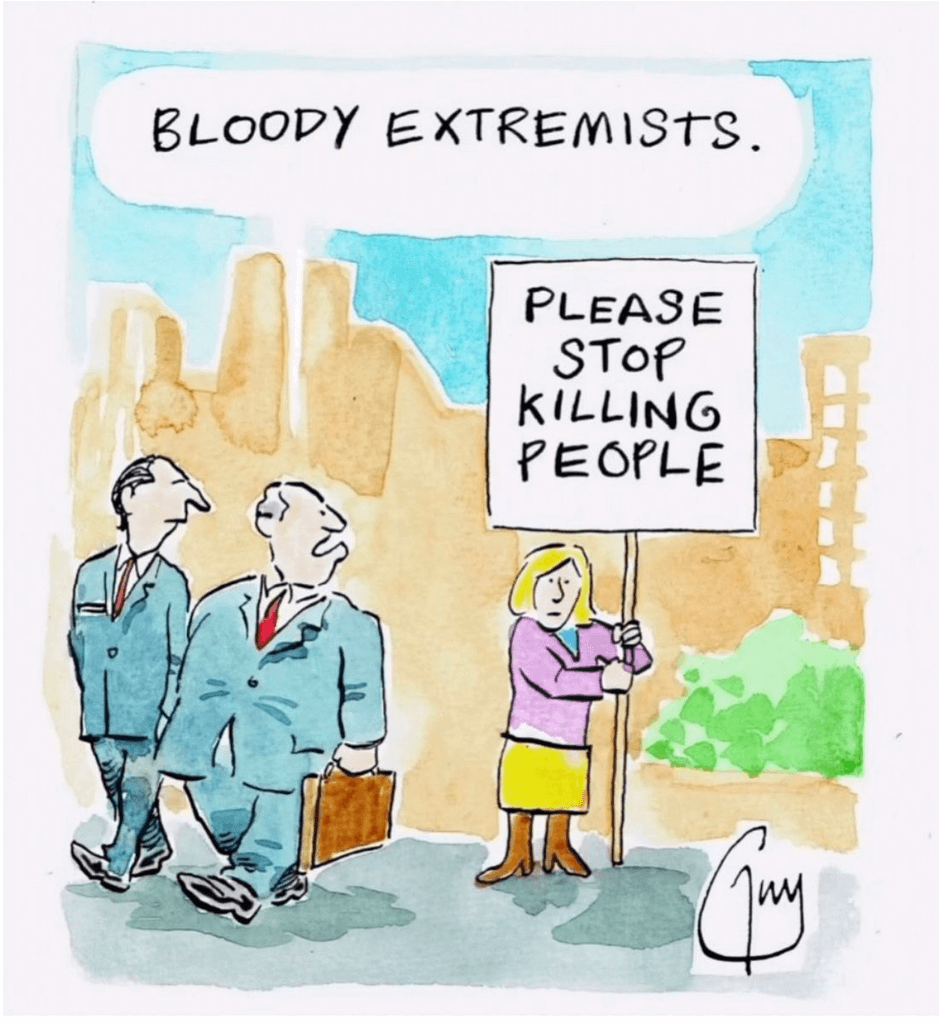

- Extrémistes

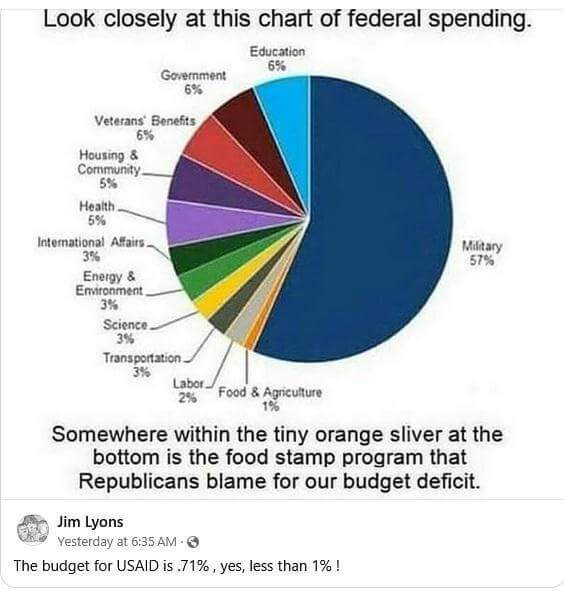

- Federal spending

- Causes

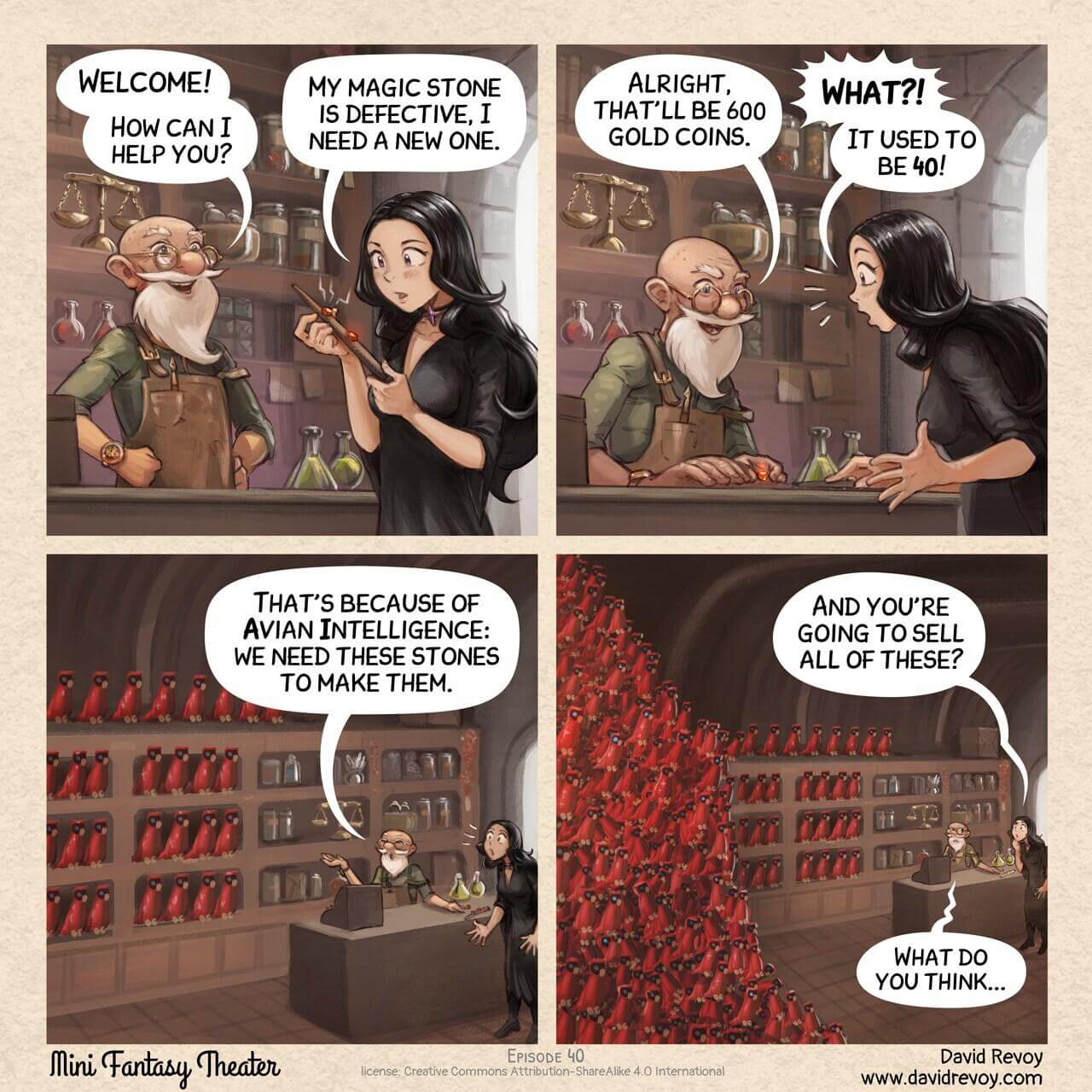

- Stones

Les vidéos/podcasts de la semaine

- Dîner du Crif : Sébastien Lecornu condamne l’utilisation du mot génocide à propos de Gaza et maintien ses positions contre Francesca Albanese (humanite.fr)

Il défend également la criminalisation de l’antisionisme.

- Celles et ceux qui n’ont pas eu de minute de silence à l’Assemblée nationale. (tube.fdn.fr)

- Mort de Quentin Deranque : une philosophie de la violence (podcast.ausha.co)

- Political violence (tube.fdn.fr)

- Terrorisme d’ultra droite (arte.tv – disponible jusqu’au 21/11/2026)

- Aamer Rahman : “That would be reversed racism” (tube.fdn.fr)

- Les données d’1,2 million de comptes bancaires consultées de manière “illégitime” depuis le mois de janvier, selon Bercy (radiofrance.fr)

La fuite date de fin janvier et concerne donc une partie de ce fichier, soit 1,2 million de comptes sur au moins 80 millions que possèdent les Français. Cette base de données ne répertorie en revanche pas les montants et les mouvements d’argent, mais cela veut dire que l’identité des titulaires, leurs IBAN, circulent potentiellement dans la nature.

- La ministre de l’Action et des comptes publics a-t-elle menti ? 13 335 millionnaires ne payent aucun impôt sur le revenu (humanite.fr)

- Les Répondeuses (1977-1984). Des féministes au bout du fil (radiofrance.fr)

En 1977, un collectif féministe de militantes du MLF a l’idée de créer un répondeur téléphonique afin de diffuser rapidement des informations tout en restant autonomes vis-à-vis des médias de l’époque. Près de 50 ans plus tard, les voix de ces “Répondeuses” nous parviennent depuis des bandes K7.

Les trucs chouettes de la semaine

- 29 bonnes nouvelles – récolte du 15 février 2026 (lescerisesdehiatus.blogspot.com)

- Salon de l’agriculture : les Amap redonnent le pouvoir aux agriculteurs et agricultrices (theconversation.com)

- EMITAÏ, une revue de cinéma critique et décoloniale fondée fin 2025 (emitai.fr)

EMITAÏ a deux objectifs : prendre la mesure de la colonialité intrinsèque du cinéma occidental, qui a été et continue d’être façonné par des formes, des structures et des dynamiques coloniales ; mettre en lumière un cinéma, souvent mal considéré, qui participe à constituer des imaginaires, des esthétiques et des regards décoloniaux.

Retrouvez les revues de web précédentes dans la catégorie Libre Veille du Framablog.

Les articles, commentaires et autres images qui composent ces « Khrys’presso » n’engagent que moi (Khrys).

18.02.2026 à 07:45

Reprenons le contrôle de notre vie numérique dès maintenant !

Fla

Texte intégral (1601 mots)

J’ai écrit ce texte il y a un an, peu après la ré-élection de Trump. Il est resté en attente de publication car je voulais lui ajouter des illustrations, mais je ne suis pas graphiste. Finalement, la situation géopolitique est maintenant encore pire qu’il y a un an, tant sur le territoire américain notamment avec l’ICE que dans les relations avec les autres pays, du Venezuela au Groenland. L’hypothèse d’un Trump qui couperait l’accès des européens aux entreprises américaines du numérique existe. Il est donc temps de publier cet article de rappel, même sans illustrations.

Je donne depuis 2012 des conférences sur la vie privée en ligne. J’y explique les mécanismes qui permettent aux fournisseurs de services numériques de collecter pléthore de données sur toutes les personnes qui les accèdent, même sans qu’elles y créent de comptes. Évidemment, je détaille aussi les enjeux, en répondant à la principale remarque : « je ne vois pas le problème, je n’ai rien à cacher ». J’explique, exemples à l’appui, que les données qu’ils collectent sur nous ont des conséquences importantes sur nos vies même pour des citoyens modèles toujours dans la légalité. Qu’elles leur permettent de maximiser notre tarif d’assurance, de nous accorder ou non un crédit immobilier, de nous refuser à un entretien d’embauche. Qu’elles leur permettent aussi d’influencer les opinions, et ainsi faire basculer le résultat d’élections ou de référendums (sans le rôle clé de Cambridge Analytica, le Brexit n’aurait probablement pas eu lieu et Donald Trump n’aurait probablement pas été élu en 2016).

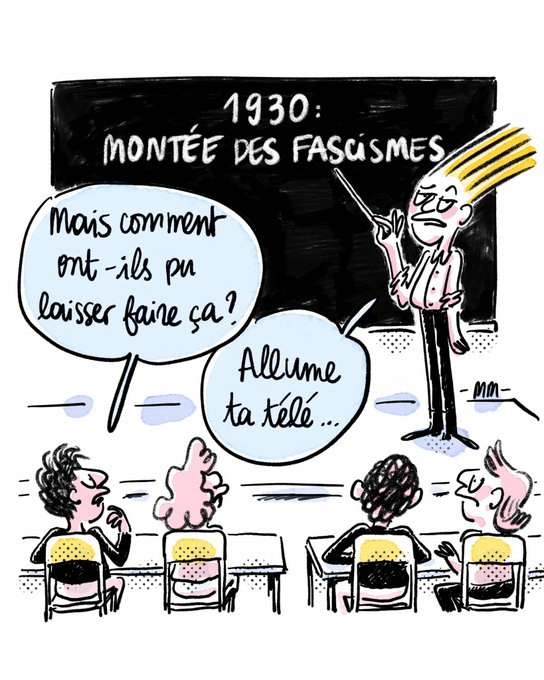

Mais je souligne aussi toujours quelque chose d’essentiel, que l’on a trop vite tendance à oublier : rien ne disparaît dans le monde numérique. Ce que nous publions en ligne aujourd’hui restera enregistré pour toujours, et ce même si nous le supprimons. Or, les dirigeants et les lois eux, changent. Les informations accumulées sur la population sont disponibles, historique compris. Si l’arrivée de l’extrême droite au pouvoir était encore hypothétique pour une grande majorité des pays il y a seulement 15 ans de cela, nous voyons aujourd’hui, années après années, sombrer l’État de droit dans laquelle une partie du monde a eu la chance de naître. La montée des partis haineux s’observe dans tous les pays, et ils arrivent maintenant régulièrement au pouvoir, et ce jusqu’au pays le plus puissant du monde : les États-Unis d’Amérique.

Si les conséquences de l’arrivée d’un régime oppresseur à la tête d’un pays sont déjà catastrophiques pour sa population, la ré-élection de Donald Trump change complètement d’échelle : elles deviennent mondiales. Il n’y a qu’une poignée de pays dans le monde dont la vie numérique ne dépend pas majoritairement des États-Unis. Imaginez-vous à quoi ressemblerait votre journée de demain si soudainement Google, Microsoft, Amazon, Apple, Meta, CloudFlare et toutes les autres entreprises américaines coupaient leurs services dans votre pays. Pensez à toutes les actions que vous ne pourriez plus faire. Plus de téléphone, d’ordinateur, de tablette ni de montre connectée. Dans l’ordre, à la sortie du lit : pas de réveil, pas de météo, pas d’agenda, pas de journal pendant le petit déjeuner, puis pas d’horaires ni de ticket de bus, ni d’accès au compte bancaire ni de moyen de paiement (Visa et Mastercard sont américains). Même si certaines applications ne sont pas fournies directement par Google, Apple, Microsoft ou Amazon, la très grande majorité d’entre elles utilisent leur infrastructure pour fonctionner et seraient donc immédiatement hors service. Vous n’avez même pas quitté votre logement que vous avez déjà utilisé ces multinationales des dizaines de fois. Se voir couper ces accès vous semble irréaliste ? C’est pourtant exactement ce qui est arrivé à Nicolas Guillou, juge français à la Cour Pénale Internationale, qui enquête sur les évènements en Palestine. Lire son témoignage. (Si cela vous inspire, vous pouvez rejoindre une réflexion collective sur le sujet).

Et bien, toutes ces actions qui pourraient ne plus être accessibles car elles dépendent de ces acteurs, sont aujourd’hui enregistrées et analysées. Les États-Unis, qui contrôlent et stockent la majorité des usages numériques mondiaux et connaissent donc en détail la vie d’une grande partie des humains de notre planète, sont maintenant gouvernés par un régime en roue libre qui a muselé les contre-pouvoirs, opprime les minorités, expulse la presse, parle d’annexer des territoires alliés comme le Groenland, soutient les autres régimes extrémistes en Allemagne et ailleurs, coupe les financements de la science et des aides au développement, sans parler de l’Ukraine et de la Palestine.

Il est d’une urgence absolue que nous soyons numériquement indépendants des services propriétaires fournis par des entreprises américaines.

Il s’agit bien sûr de développer et soutenir des logiciels libres, seuls garants d’un numérique respectueux car auditables par des tiers. Notre rôle de citoyens est évidemment de porter ce sujet à nos politiques, mais aussi à notre travail et, le plus facile, dans notre vie personnelle.

Il y a de nombreuses alternatives qui existent à tout un tas d’applications, services, logiciels que vous pouvez utiliser, mais pour ce premier article, je conclurai sur ces quelques recommandations, très facile à mettre en place pour démarrer :

Pour limiter la collecte de données :

- Accédez au web avec un navigateur de confiance (je recommande Mozilla Firefox, sur ordinateur comme sur mobile) correctement configuré (installez les extensions uBlock Origin et LocalCDN)

- Pour limiter les accès aux informations de votre téléphone, évitez d’installer des applications et allez plutôt sur les sites web. Vous n’arrivez pas à vous passez de Google Maps, YouTube, Facebook ou Instagram pour le moment ? Ouvrez un nouvel onglet privé dans Firefox pour y accéder, cela limitera un peu la casse, et vous serez moins tenté de le rouvrir constamment

Pour la confidentialité de vos échanges :

- Utilisez une messagerie libre chiffrée telle que Signal qui est l’état de l’art dans le domaine, plutôt que Facebook Messenger ou Whatsapp, ou le SMS ou l’e-mail avec lesquels de nombreuses personnes peuvent accéder à vos communications

Si vous êtes prêts à y consacrer un peu de temps, une belle étape est de passer à un système d’exploitation libre et de confiance. Les alternatives ne manquent pas. Si vous voulez des solutions françaises, Linux Mint fonctionne très bien pour les ordinateurs, et /e/ OS pour les téléphones. Vous avez peur de vous lancer seul(e) ? Trouvez quelqu’un pour vous aider près de chez vous !

Un autre point important où vous pouvez vous faire accompagner : quitter GMail. Là aussi, il suffit de vous laisser guider !

Et bien sûr, les services de Framasoft, sur Degooglisons-internet.org !

Il y a énormément à dire sur le sujet, cet article peut donc vous sembler trop court, et cette liste d’alternatives très incomplète. De plus, d’autres alternatives encore plus résilientes peuvent exister. J’ai pris ici le parti d’aller droit au but et de recommander des solutions accessibles à toutes et tous dès maintenant sans compromis aucun, car je juge la situation urgente particulièrement à la vue de ce qui se passe outre atlantique. Mais n’ayez crainte, j’ai hâte de revenir avec des articles permettant d’aller plus loin !

17.02.2026 à 08:29

Attention à l’économie de l’attention

Gee

Texte intégral (1921 mots)

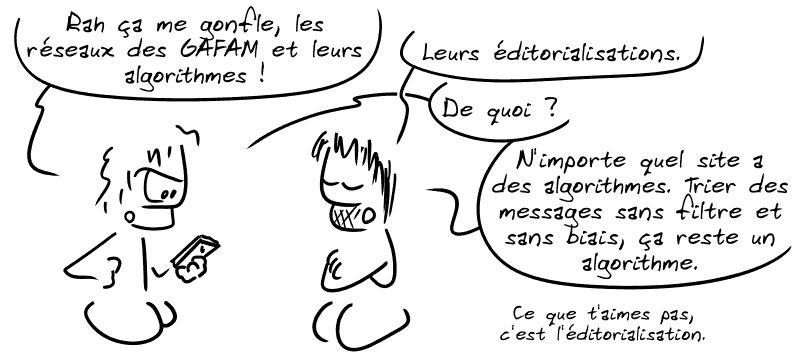

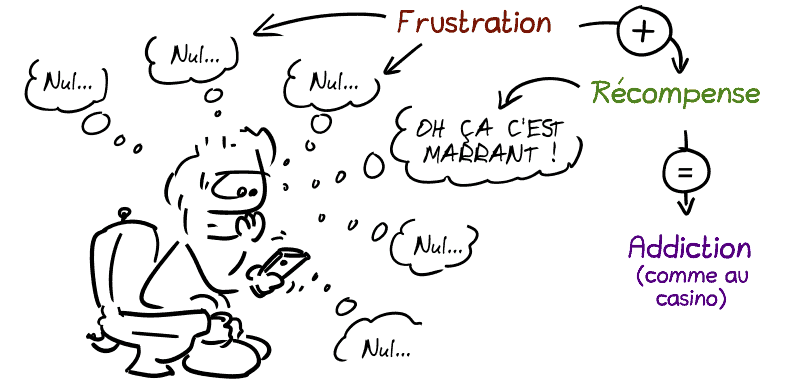

Parce que les phénomènes d’addiction aux médias sociaux ne sont pas apparus spontanément mais ont savamment été mis en place par les GAFAM, et qu’il faudrait sans doute que ça se sache un peu plus…

Attention à l’économie de l’attention

Étudions un instant cette scène de la vie courante :

Cette scène n’est pas l’opération du Saint Esprit, mais bien le résultat de…

L’économie de l’attention.

L’économie de l’attention, ça se matérialise notamment par « l’éditorialisation » du contenu.

L’éditorialisation, c’est ce site web qui sélectionne ce qu’il veut bien te montrer ou non, selon des critères sur lesquels tu n’as pas toujours ton mot à dire.

C’est d’ailleurs pour ça qu’on préfère parler de « médias » sociaux plutôt que de « réseaux » sociaux : ce sont bien des médias avec des lignes éditoriales bien définies.

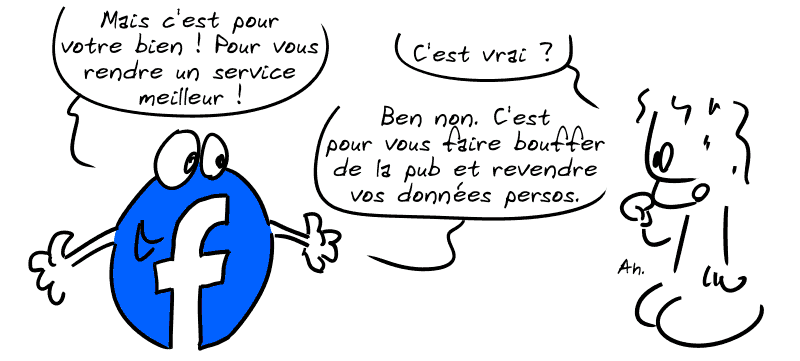

Bien sûr, pour exploiter vos données et vous refourguer de la pub, Facebook et consorts ont besoin de vous garder le plus longtemps possible sur leurs plateformes, de capter votre attention.

Et pour ça, j’aime autant vous dire que tous les moyens sont bons

et que c’est pas l’éthique qui les étouffe.

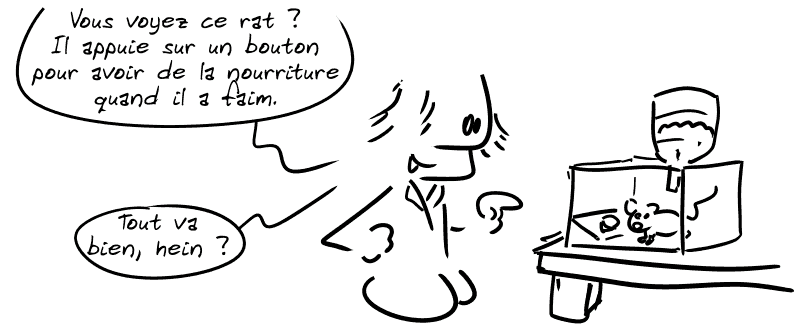

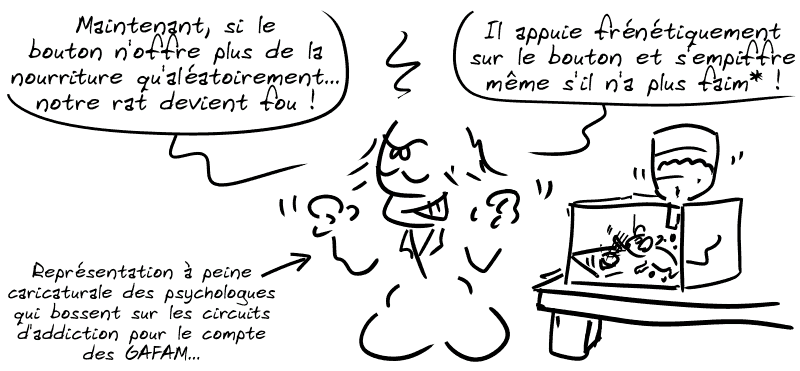

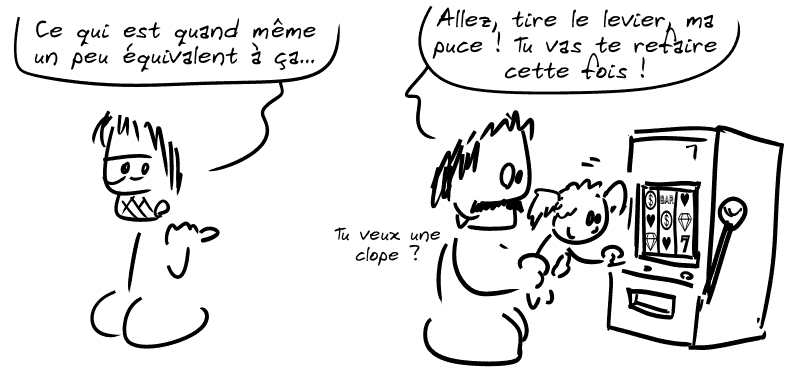

C’est l’une des célèbres expériences de la boîte de Skinner – non, pas le proviseur des Simpson.

Lorsque Facebook vous cache des trucs, lorsque vous avez 10 publications navrantes au possible entre 2 publications qui vous intéressent, ce n’est pas un bug : c’est une fonctionnalité.

Votre attention, c’est LA valeur qui se monétise sur les grandes plateformes.

Et comme votre nombre d’heures de vie reste, j’en suis bien navré, limité, eh bien on presse de plus en plus vos capacités d’attention.

Véridique, c’est le second screen content, d’où la qualité navrante de certains dialogues où on vous explique et réexplique le scénario, en long, en large et en travers…

Et ces mécanismes de stimulation des circuits d’addiction se retrouvent partout, jusque dans les innocents jeux mobile « free-to-play »… dont il faudrait s’interroger sur la pertinence de les filer à de (parfois très) jeunes enfants pour les occuper.

Eeeet en même temps…

bah j’ai pas envie de vous culpabiliser plus que ça.

Parce que pour lutter contre ça comme contre beaucoup d’autres saletés, remettre en cause les comportements individuels…

Ça ne suffit pas.

Shoshana Zuboff, une professeure de la Harvard Business School spécialiste du sujet, explique que le capitalisme de surveillance traduit l’expérience humaine en données comportementales afin de produire des prédictions qui sont ensuite revendues sur le marché des comportements futurs.

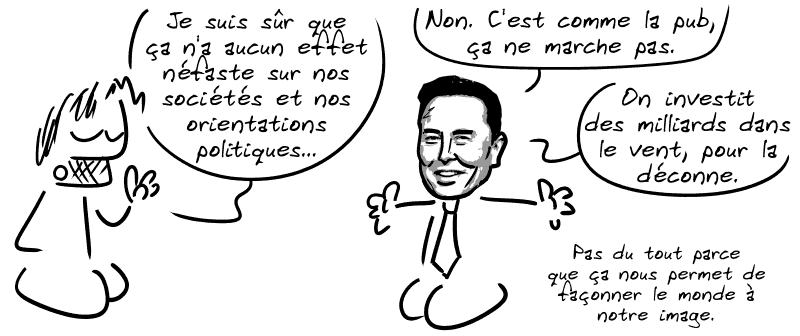

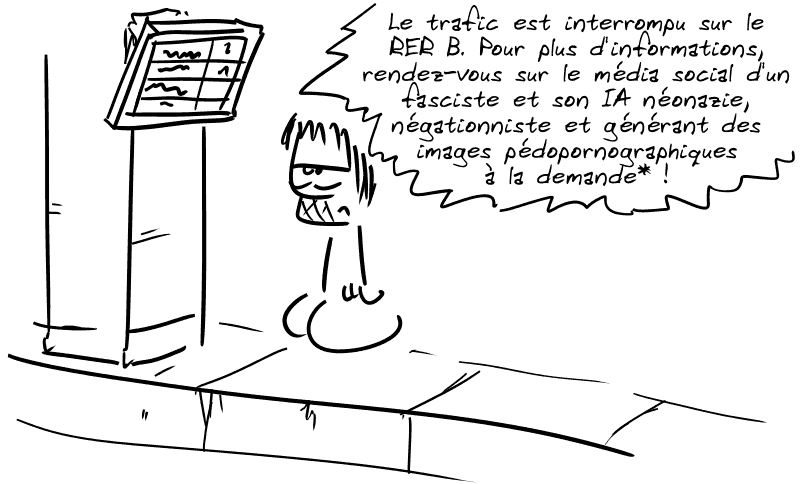

Avant d’interdire les réseaux sociaux aux gamins via des contrôles d’âge inefficaces et dangereux pour la vie privée, on pourrait déjà se demander pourquoi ce genre de truc existe encore en France :

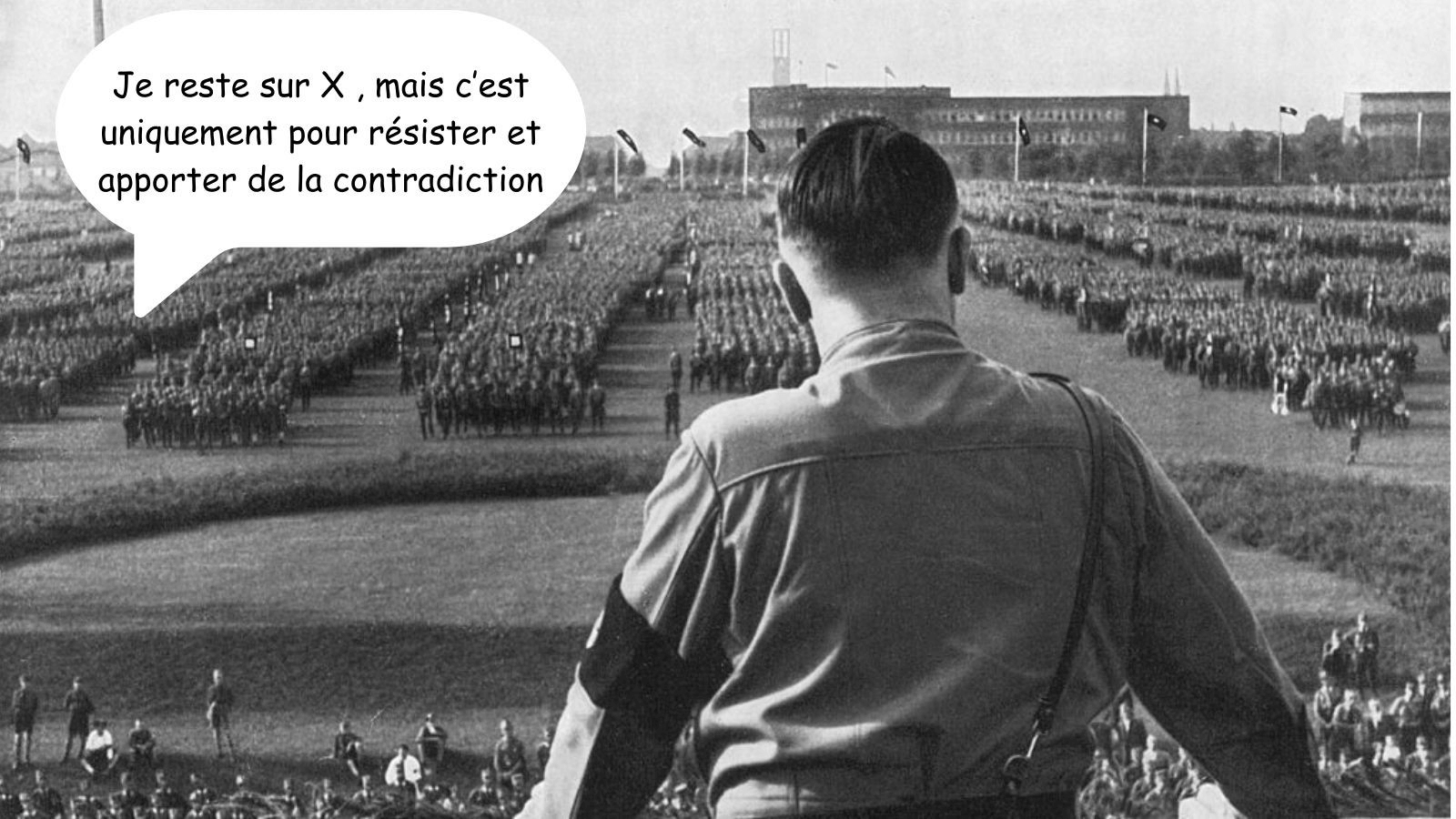

X, anciennement Twitter, si vous n’aviez pas la réf. Comment ce truc continue d’être utilisé par toute la classe politique et des services publics comme la RATP, alors qu’il devrait être illégal depuis belle lurette, ça me dépasse…

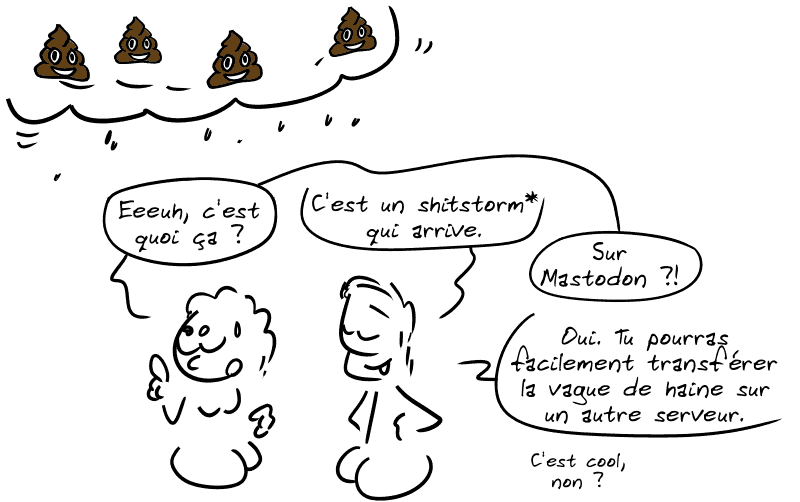

Alors oui, Mastodon, c’est mieux.

C’est libre.

C’est décentralisé.

Mais ça ne vit pas dans un éther déconnecté de l’économie de l’attention, et ça reste imprégné de ses travers, comme nous le sommes toutes et tous (c’est le principe d’un système dominant).

Selon le Wiktionnaire, « déferlement de commentaires et réactions haineuses sur internet ».

Alors oui, un réseau libre et décentralisé, c’est un million de fois de mieux qu’un énième avatar des GAFAM, technofasciste ou pas…

ou pas encore…

Mais pour conclure : au-delà de cramer X, Facebook et cie – ce qu’il faut assurément faire –, est-ce qu’il ne faudrait pas s’interroger sur l’opportunité de cramer l’intégralité des médias sociaux ?

Crédit : Gee (Creative Commons By-Sa)

Sources

-

Éditorialisation sur Wikipédia

-

La récompense aléatoire sur Pause by Noise

-

Économie de l’attention sur Wikipédia

-

Free-to-play sur Wikipédia

-

Pour aller plus loin : Affaire privées, aux sources du capitalisme de surveillance, livre de Christophe Masutti (C&F Éditions)

16.02.2026 à 07:42

Khrys’presso du lundi 16 février 2026

Khrys

Texte intégral (9640 mots)

Comme chaque lundi, un coup d’œil dans le rétroviseur pour découvrir les informations que vous avez peut-être ratées la semaine dernière.

Tous les liens listés ci-dessous sont a priori accessibles librement. Si ce n’est pas le cas, pensez à activer votre bloqueur de javascript favori ou à passer en “mode lecture” (Firefox) ;-)

Brave New World

- Point of no return : a hellish ‘hothouse Earth’ getting closer, scientists say (theguardian.com)

Continued global heating could set irreversible course by triggering climate tipping points, but most people unaware

- Scientists Explored an Island Cave and Found 1 Million-Year-Old Remnants of a Lost World (popularmechanics.com)

A spectacular trove of fossils in a discovered in a cave on New Zealand’s North Island has given scientists their first glimpse of ancient forest species that lived there more than a million years ago. The fossils represent 12 ancient bird species and four frog species, including several previously unknown bird species.

- La Chine a planté tellement d’arbres dans le désert du Taklamakan qu’il absorbe désormais du CO2 (slate.fr)

C’est le résultat spectaculaire de l’un des projets écologiques les plus ambitieux du monde : la Grande muraille verte de Chine. Lancé en 1978, ce programme colossal visait à ralentir l’avancée du désert en plantant des milliards d’arbres tout autour du Taklamakan et du désert de Gobi. Quarante ans plus tard, les chercheurs confirment que la stratégie porte ses fruits.

- Alors que le droit international est à un « point de rupture », le Timor-Leste s’en prend seul à la junte du Myanmar (theconversation.com)

Il y a à peine 4 mois, le Timor-Leste est devenu officiellement membre de l’Association des nations de l’Asie du Sud-Est (Asean). Cette semaine, le pays a franchi une étape sans précédent : ses autorités judiciaires ont désigné un procureur chargé d’examiner la responsabilité de l’armée du Myanmar dans des crimes de guerre et des crimes contre l’humanité.

- How The ‘Pharmacy Of The World’ Lets Down Indians (indiaspend.com)

Medicines account for 70 % of out-of-pocket health spending, often pushing millions of Indians into, or deeper into, poverty

- Après le Groenland et l’Ukraine, Trump à l’assaut des mines congolaises (reporterre.net)

Washington a conclu avec la République démocratique du Congo un partenariat qui ouvre la porte de ses mines aux entreprises étasuniennes. Un retour stratégique pour les États-Unis dans une région clé du continent.

Voir aussi Trump II : le mandat de la prédation extractiviste (basta.media)

Le second mandat de Trump transforme l’extractivisme en principe de gouvernement et en levier de domination géopolitique, au détriment des souverainetés locales et des équilibres écologiques

Et Le condottiere trumpiste Erik Prince, les minerais et la guerre au Congo (legrandcontinent.eu)

- Internet shutdowns in Africa : A human rights and democratic crisis (netzpolitik.org)

Internet shutdowns have become a growing threat to Africa’s democracy. They are an increasingly common part of the authoritarian toolkit used by governments to control information and suppress dissent.

- Affaire Arche de Zoé : 18 ans après, les victimes brisent le silence (parallelesud.com)

“Tentative d’enlèvement d’enfants”, « fiasco humanitaire”, ou “adoptions illégales”, l’affaire Arche de Zoé a fait la Une de l’actualité française et tchadienne fin 2007. Une opération d’exfiltration de 103 enfants d’origines tchadienne et soudanaise interrompue par les militaires à Abéché dans l’est du Tchad. 18 ans après, que sont devenus ces enfants ?

- Amsterdam interdit la publicité pour les énergies fossiles et la viande, Florence suit (antipub.org)

Le mois dernier, la ville d’Amsterdam a voté une nouvelle interdiction de pub de viande et énergies fossiles. C’est la première capitale au monde à mettre en place une interdiction de cette ampleur.

- « Notre peuple n’est pas un réseau à intoxiquer » : Yolanda Diaz, vice-présidente du gouvernement espagnol, tient tête à Elon Musk (humanite.fr)

- Élections portugaises : victoire socialiste et renforcement de l’extrême droite (legrandcontinent.eu)

- Hypersonic Systems Startup Emerges from Stealth with Series A and Test Launch (europeanspaceflight.com)

Founded in December 2023, Hypersonica is developing what it describes as the first privately funded European hypersonic strike capability, with operations currently spanning the UK and Germany. The company aims to offer fully operational hypersonic glide vehicles by 2029, with an initial, shorter-range hypersonic strike capability available from 2027.

- Iceland is Planning For the Possibility That Its Climate Could Become Uninhabitable (news.slashdot.org)

Several recent studies have found the AMOC far more vulnerable to breakdown than scientists had long assumed […] Simulations of a post-collapse world project Icelandic winter extremes plunging to minus-50 degrees Celsius, and sea ice surrounding the country for the first time since Viking settlement.

- The tech firms embracing a 72-hour working week (bbc.com)

In simple terms, it puts a premium on long working hours, typically 9am to 9pm, six days a week (hence “996”).

- Chez Ubisoft, une grève contre les « méthodes trumpiennes » de la direction (basta.media)

L’ensemble des syndicats d’Ubisoft appelle à trois jours de grève. En cause : des dizaines de suppressions de poste, une modification imposée des conditions de travail et la crainte d’une vente à la découpe du pionnier français des jeux vidéos.

- Irish man with valid US work permit held in ICE detention for five months (theguardian.com)

Seamus Culleton has lived in US for two decades, married a citizen and runs a plastering business but faces deportation

- “I Have Been Here Too Long” : Read Letters from the Children Detained at ICE’s Dilley Facility (propublica.org)

In early February there were more than 750 families, nearly half of them including children, as well as some 370 single adult women being held at this facility. It is just one of many immigration centers across the country, but the only one holding families. Since the start of the Trump administration, the number of children in ICE detention has skyrocketed, increasing sixfold.

- “Not Ready for Prime Time.” A Federal Tool to Check Voter Citizenship Keeps Making Mistakes (propublica.org)

The source of the bad data was a Department of Homeland Security tool called the Systematic Alien Verification for Entitlements, or SAVE.

- Les données biologiques de 20 000 enfants récupérées par des pseudo-scientifiques racistes (portail.basta.media)

- Sous la pression populaire, l’ICE se retire enfin du Minnesota après avoir fait deux morts (humanite.fr)

Tom Homan, surnommé le « Tsar des frontières », a dû céder : les agents de l’ICE vont plier bagage et partir de l’État du Minnesota. Une défaite politique pour Donald Trump, mais au prix d’un terrible bilan.

- Silicon Valley can’t import talent like before. So it’s exporting jobs (restofworld.org)

Google, Amazon, Microsoft, and other U.S. tech giants are ramping up India hiring.

- Sudo maintainer, handling utility for more than 30 years, is looking for support (theregister.com)

It’s hard to imagine something as fundamental to computing as the sudo command becoming abandonware, yet here we are : its solitary maintainer is asking for help to keep the project alive.

- Why would Elon Musk pivot from Mars to the Moon all of a sudden ? (arstechnica.com)

“SpaceX has already shifted focus to building a self-growing city on the Moon.”

- The Media Can’t Stop Propping Up Elon Musk’s Phony Supergenius Engineer Mythology (karlbode.com)

“CEO said a thing !” journalism is now utterly pervasive, and includes parroting billionaire and CEO claims with a total disregard for whether or not anything being said is actually true.

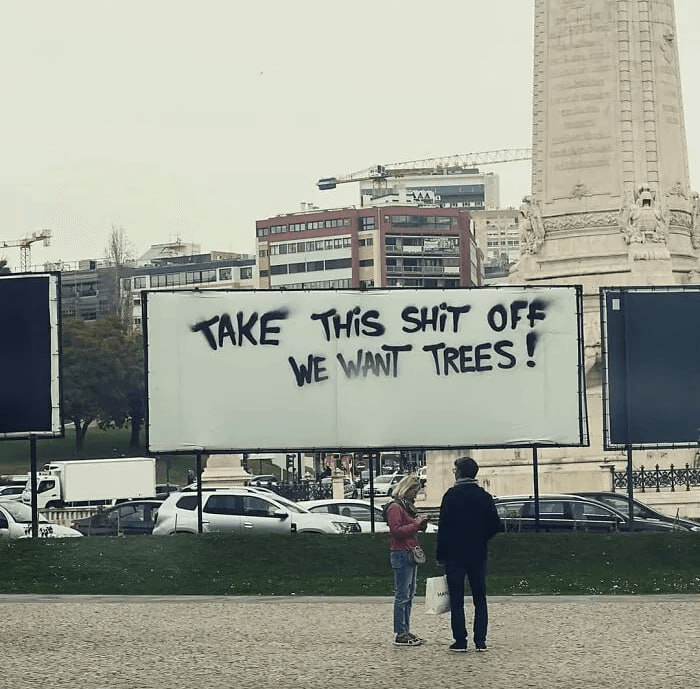

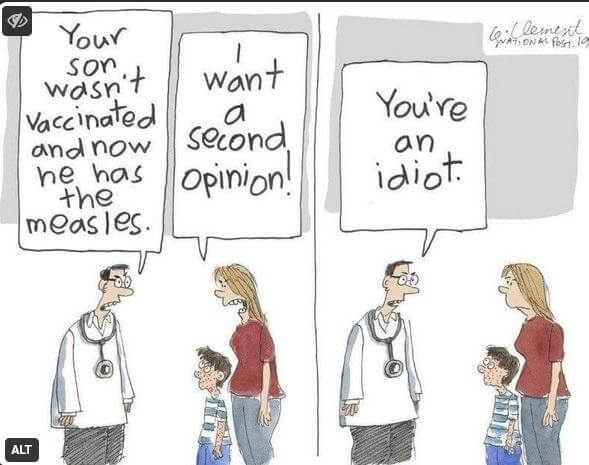

- Campus measles outbreak grows in Florida (cidrap.umn.edu)

At least 20 students at Ave Maria University in Florida now have confirmed measles infections. The Collier County outbreak still has 14 cases pending testing, according to local news sources.

- Privatiser les fleuves d’Amazonie, la menace qui plane sur les peuples autochtones (reporterre.net)

- Résistance Mapuche : territoire, autonomie et écologie sociale (ecologiesocialeetcommunalisme.org)

La résistance mapuche, ancrée dans le Wallmapu, ne relève ni d’un folklore identitaire ni d’un simple conflit local. Elle s’inscrit dans une lutte de longue durée contre la colonisation, l’État-nation et le pillage extractiviste des territoires par les entreprises forestières, minières et énergétiques. Elle renvoie plus largement à la persistance de formes d’organisation communautaire qui ne se sont jamais confondues avec l’État moderne, et qui continuent d’exister malgré les tentatives répétées de normalisation, d’intégration ou d’écrasement.

- Journée de travail de 12h, restriction du droit de grève… Le projet de loi libertarien de Milei (basta.media) – voir aussiContre la loi travail XXL de Milei, solidarité avec le monde du travail en Argentine ! (politis.fr)

En Argentine, le président d’extrême droite mène une offensive néolibérale d’une violence inédite contre les travailleurs et les classes populaires. Derrière sa réforme du travail, c’est tout un arsenal de droits sociaux historiques qui se trouve menacé.

Spécial IA

- Deezer démonétise 85 % des écoutes de morceaux générés par IA (next.ink)

- Plus d’un tiers des Français·es utilise l’IA générative tous les jours (next.ink)

- UK tabloid newspapers quote fake experts created with AI (pivot-to-ai.com)

- The first signs of burnout are coming from the people who embrace AI the most (techcrunch.com)

the argument goes, AI is a force multiplier. You become a more capable, more indispensable lawyer, consultant, writer, coder, financial analyst — and so on […] a new study published in Harvard Business Review follows that premise to its actual conclusion, and what it finds there isn’t a productivity revolution. It finds companies are at risk of becoming burnout machines.

- Can AI deliver new mathematical insights ? Top researchers put it to the test (heise.de)

With a new method, ten researchers are putting the mathematical “creativity” of large language models to the test. The preliminary result is sobering.

- Medicine : LLMs may not improve public medical decision-making (natureasia.com)

LLMs that achieve very high scores on medical licensing exams in controlled settings are not necessarily guaranteed to succeed in real-world interactions.

Voir aussi Reliability of LLMs as medical assistants for the general public : a randomized preregistered study (nature.com)

- As AI enters the operating room, reports arise of botched surgeries and misidentified body parts (reuters.com)

Medical device makers have been rushing to add AI to their products. While proponents say the new technology will revolutionize medicine, regulators are receiving a rising number of claims of patient injuries.

- Waymo Exec Reveals Company Uses Remote Operators in the Philippines to Assist Autonomous Vehicles (people.com)

The autonomous vehicle communicates with a so-called remote assistance operator… Despite the crucial role these operators play in autonomous vehicle safety, the public knows almost nothing about those people.

- Unwanted AI upgrade to Windows Notepad created a serious security flaw (techspot.com)

- OpenStreetMap sous attaque massive de bots… alors que les données sont gratuites (goodtech.info)

- Microsoft lâche OpenAI : le divorce tech qui risque de tout faire basculer pour ChatGPT (clubic.com)

- OpenAI researcher quits over ChatGPT ads, warns of “Facebook” path (arstechnica.com)

Zoë Hitzig resigned on the same day OpenAI began testing ads in its chatbot.

- Watch Out : Your Friends Might Be Sharing Your Number With ChatGPT (pcmag.com)

You can now sync your contacts and ‘find friends’ on OpenAI.

- Frontex is building an ‘AI chatbot app’ to encourage repatriations (algorithmwatch.org)

- Ring Super Bowl ad sparks backlash over AI camera surveillance (biometricupdate.com)

A Super Bowl commercial for Amazon’s Ring doorbell camera triggered swift backlash, with critics arguing that the company used an emotional story about a lost dog to promote a neighborhood scale camera network while minimizing the broader privacy and civil liberties implications of searchable AI video.

- AI Omnibus : Reject the proposals to undermine transparency in the AI Act (edri.org)

The European Commission’s dangerous and misguided Digital Omnibus proposal includes a dangerous rollback of transparency requirements in the AI Act.

- An AI Agent Published a Hit Piece on Me (theshamblog.com)

- OK, so Anthropic’s AI built a C compiler. That don’t impress me much (theregister.com)

Some people seem to think writing a C compiler is hard work. Well, yes, if you’re writing it in assembly language, it is. But I hate to break it to you : Computer science undergraduates write C compilers every semester. Heck, you can learn to do it yourself thanks to Daniel McCarthy’s Developing a C Compiler From Scratch online class. And the class will cost you a lot less than the $20,000 it cost Anthropic. […] Here’s what Anthropic really did. It managed to write a half-assed C compiler in Rust that, based on existing open source code and with a lot of hand-holding, can run test suites and successfully compile Linux and other programs.

- Avec l’IA, à quoi ressembleront les logiciels de demain ? (danslesalgorithmes.net)

- AI is dominating the world’s memory chips. That could make phones more expensive (restofworld.org)

As chipmakers rush to serve AI data centers, consumer electronics are left in short supply.

- Un milliard par jour pour vérifier l’heure (lundi.dev)

On ne connaît pas la proportion de ces agents qui tournent sur des LLMs hébergés par les géants du numérique, mais je ne peux pas m’empêcher de faire un lien avec le fait que Google, Microsoft, Amazon et Meta ont dépensé l’année dernière plus de 376 milliards de dollars en investissements

- Datacenters in space are a terrible, horrible, no good idea. (taranis.ie)

There is a rush for AI companies to team up with space launch/satellite companies to build datacenters in space. TL;DR : It’s not going to work.

Spécial Palestine et Israël

- U.S. secretly deporting Palestinians to West Bank in coordination with Israel (972mag.com)