21.10.2012 à 02:00

Aux sources de l’utopie numérique

Stewart Brand occupe une place essentielle, celle du passeur qui au-delà de la technique fait naître les rêves, les utopies et les justifications auto- réalisatrices. Depuis la fin des années soixante, il a construit et promu les mythes de l’informatique avec le Whole Earth Catalog, le magazine Wired ou le système de conférences électroniques du WELL et ses communautés virtuelles. Aux sources de l’utopie numérique nous emmène avec lui à la découverte du mouvement de la contre-culture et de son rôle déterminant dans l’histoire de l’internet.

Turner, Fred. Aux sources de l’utopie numérique. De la contre-culture à la cyberculture : Stewart Brand, un homme d’influence. C&F éditions, 2012.

Lien vers le site de l’éditeur : https://cfeditions.com/utopieNumerique/

16.10.2012 à 02:00

Le plagiat, les sciences et les licences libres

Ces 5-6 dernières années, la question du plagiat dans les sciences est devenu un thème de recherche à part entière. On peut saluer le nombre croissant de chercheurs qui s’intéressent à cette question à double titre: d’abord parce que le plagiat est un phénomène social, mais aussi parce que ce phénomène (pourtant très ancien) illustre combien les sciences ne constituent pas cet édifice théorique et inébranlable de l’objectivité qu’il serait étonnant de voir un jour s’effriter.

Qu’est-ce que le plagiat ?

Parmi ces chercheurs, on remarquera plus particulièrement Michelle Bergadaà, de l’Université de Genève, qui a créé en 2004 le site responsable.unige.ch. Elle fut l’un des premiers chercheurs à recueillir une multitude d’informations sur des cas de plagiat et à dresser une typographie des plagiats scientifiques. Elle a montré aussi que la reconnaissance des cas de plagiat ne peut manifestement pas se contenter d’une réponse juridique, mais qu’il appartient à la communauté des chercheurs de réguler des pratiques qui vont à l’encontre des principes de la recherche scientifique, en particulier la nécessité de citer ses sources et d’éviter la redondance au profit de l’avancement des sciences.

En 2012, Michelle Bergadaà a publié un article bien documenté et accessible, intitulé « Science ou plagiat », dans lequel elle montre que la conjonction entre le peer review process, qui fait des revues non plus des instruments de diffusion de connaissance mais des « instruments de prescription et de référencement à l’échelle mondiale » (comprendre: le système du publish or perish), et le web comme outil principal de communication et de diffusion des productions des chercheurs, cause l’opposition de deux modes de rapports au savoir:

Un malentendu s’installe entre ceux qui restent fidèles au savoir scientifique véhiculé par les revues traditionnelles et ceux qui défendent le principe des licences libres inscrites dans une logique de savoir narratif. Cette tension apparaît dans la manière dont est compris et souvent envisagé le modèle de production des Creative Commons ou licences libres, issues du monde du logiciel. Ce modèle vise d’abord à partager l’information, à l’enrichir, et non la rendre privative. Il est possible de copier et de diffuser une œuvre, à condition de respecter la licence choisie ; de la modifier à condition de mentionner la paternité de l’œuvre. Il correspond donc précisément aux pratiques canoniques de la recherche scientifique : publier et diffuser les connaissances le plus largement possible permettant de s’appuyer sur les résultats et les productions des autres chercheurs pour faire avancer le savoir.

Cette analyse assimile le web à un endroit où se partagent, de manière structurée, les productions scientifiques, que ce lieu de partage est fondamentalement différent des lieux « traditionnels » de partage, et que donc les défenseurs de ces lieux traditionnels ne comprennent pas leur propre miroir numérique… Je parle de miroir car en effet, ce que M. Bergadaà ne fait que sous entendre par le terme « malentendu », c’est que les licences libres permettent de remettre en cause l’ensemble du système de production, diffusion et évaluation scientifique. Elles démontrent même que le sens du plagiat n’est pas le même et ne questionne pas les mêmes valeurs selon qu’on se situe dans une optique ou dans l’autre. C’est une accusation radicale du système d’évaluation scientifique qu’il faut porter une fois pour toute et la « lutte » contre le plagiat est, à mon sens, l’un des premiers pas de cette étape réflexive. Il est donc important de bien situer ce « malentendu », et la question du plagiat est un bon levier.

Qu’est-ce que le plagiat, aujourd’hui? N’est-il pas le « côté obscur » du sentiment légitime que les connaissances appartiennent à tous ? Dans le domaine du logiciel libre, prendre du code et le diffuser sans porter le crédit du créateur originel, même lorsqu’on modifie une partie de ce code, cela s’appelle le resquillage. Selon la législation nationale du pays où se déroule le resquillage, cette attitude peut se condamner devant les tribunaux. De même, du point de vue du droit d’auteur, reprendre à son compte des pans entiers voire la totalité d’une oeuvre sans citer l’auteur, c’est interdit et va à l’encontre du droit (moral) d’auteur.

Au-delà du droit d’auteur

Mais tant que l’on en reste là, c’est à dire à la question du droit d’auteur, on passe à côté du vrai problème de la diffusion des connaissances scientifiques: dans la mesure où un chercheur publie le résultat de recherches menées sur fonds publics (et même privés, dirai-je, mais cela compliquerait notre réflexion à ce stade) comment peut-on considérer un instant que le texte qu’il produit et les analyses qu’il émet puissent être l’objet d’un droit d’auteur exclusif ? c’est là qu’interviennent les licences libres: qu’un droit d’auteur doive être reconnu, en raison de la paternité de l’oeuvre (ou même de la découverte), mais que ce droit soit protégé tout en permettant la diffusion la plus large possible.

Ce qui pose donc problème, ce n’est pas le droit d’auteur, c’est l’exclusivité ! Lorsqu’un texte scientifique est plagié, aujourd’hui, qui est réellement lésé et en quoi ?

- L’auteur ? dans la mesure où il est censé publier pour la postérité et dans le but de diffuser les connaissances le plus largement possible, ce qui lui pose alors problème est sa fierté et le fait que l’oeuvre dérivée ne reconnaisse pas sa paternité. Il s’agit-là d’un point de vue personnel, et un auteur pourrait prendre cela de manière plus ou moins heureuse. Par contre, cela pose problème dans le cadre de l’évaluation scientifique : moins d’impact factor à son crédit. On touche ici un des nombreux points faibles de l’évaluation de la recherche.

- La revue? très certainement, dans la mesure où elle a les droits exclusifs de l’exploitation d’une oeuvre. Ici, ce sont les aspects purement financiers qui sont en cause.

- La communauté des chercheurs et, au delà, l’humanité ? c’est sans doute le plus important et ce qui devrait passer au premier plan ! Tout resquillage en science revient à fouler aux pieds les principes de l’avancement scientifique: la production de connaissances nouvelles.

Mais alors, d’où vient le malentendu ? Tout le monde s’accorde pour reconnaître que les productions des chercheurs doivent être diffusées le plus largement possible (on pourra se questionner sur l’exclusivité d’exploitation des revues et les enjeux financiers). De même, tout le monde s’accorde sur le fait que la paternité d’un texte doit être reconnue à travers le droit d’auteur. Par conséquent, puisque les licences libres doublent le droit d’auteur de conditions permissives d’exploitation des oeuvres par l’humanité entière, d’où vient la réticence des défenseurs du système traditionnel de la publication revue par les pairs face aux licences libres (et peut-être au web en général) ?

Lorsqu’on discute avec ces traditionalistes de la production scientifique évaluée par les copains, les poncifs suivants ont tendance à ressortir:

- l’absence d’évaluation dans cette jungle du web dont Wikipédia et consors représentent le pire des lieux de partage de connaissances forcément faussées puisque les articles sont rarement écrits par les « spécialistes » du domaine ;

- la validation du travail de chercheur passe exclusivement par l’évaluation de la part de « spécialistes » reconnus. Cela se fait grâce aux revues qui se chargent de diffuser les productions pour le compte des chercheurs (notamment en s’attribuant le copyright, mais là n’est pas la question) ;

- il faut éviter que des « non-spécialistes » puisse s’autoriser à porter un jugement sur mes productions scientifiques, cela serait non seulement non recevable mais présenterait aussi un danger pour la science qui ne doit être faite que par des scientifiques.

À ces poncifs, on peut toujours en rétorquer d’autres :

- Comment définir un « spécialiste » puisqu’il n’y a que des degrés de compétences et que tout repose sur l’auto-évaluation des pairs à l’intérieur d’une seule communauté de chercheurs. Ainsi, les spécialistes en biologie du Bidule, ne sont reconnus que par les spécialistes en Biologie du Bidule. Et en cas de controverse on s’arrange toujours pour découvrir que Dupont était en réalité spécialiste en biologie du Machin.

- Les évaluateurs des revues ([voire les revues elles mêmes](http://www.the-scientist.com/?articles.view/articleNo/27376 « The Scientist. L’affaire Merck »)) ont bien souvent des conflits d’intérêts même s’ils déclarent le contraire. En effet, un conflit d’intérêt est souvent présenté comme un conflit qui ne concerne que les relations entre un chercheur et les complexes industriels ou le système des brevets, qui l’empêcheraient d’émettre un jugement fiable sur une production scientifique qui remettrait en cause ces intérêts. Or, que dire des évaluateurs de revues (ou d’appel à projet) qui ont eux-mêmes tout intérêt (en termes de carrière) à être les (presque) seuls reconnus spécialistes du domaine ou, d’un point de vue moins individualiste, donner toutes les chances à leur propre laboratoire ? le monde de la recherche est un territoire de plates-bandes où il ne fait pas bon venir sans avoir d’abord été invité (demandez à tous les doctorants).

- Enfin, relativisme extrême: pourquoi la fameuse « société civile » ne pourrait porter un jugement sur les productions scientifiques? Parce que, ma bonne dame, c’est pour cela qu’on l’appelle « société civile » : à elle Wikipédia et à nous la vraie science. Après tout c’est à cause de ce relativisme qu’on en vient à réfuter le bien fondé des essais nucléaires ou la salubrité des OGMs.

Privilégier la diffusion

Il faut dépasser ces poncifs…. je réitère la question : d’où vient ce malentendu ? Il vient du fait qu’on doit aujourd’hui considérer que les limites entre les communautés scientifiques entre elles (les « domaines de compétence ») et avec la « société civile » deviennent de plus en plus ténues et que, par conséquent, les licences libres impliquent que les scientifiques soient prêts à assumer trois choses :

- privilégier la diffusion des connaissances sur leur distribution protégée par l’exclusivité des revues, car cette exclusivité est un rempart contre les critiques extérieures à la communauté (voire extérieures aux cercles parfois très petits de chercheurs auto-cooptés), et aussi un rempart financier qui empêche l’humanité d’avoir un accès total aux connaissances, grâce au web, ce qu’elle réclame aujourd’hui à grands cris, surtout du côté des pays où la fracture numérique est importante ;

- que les scientifiques – et nombreux sont ceux qui ont compris cette évidence –, ne peuvent plus continuer à produire des connaissances à destination exclusive d’autres scientifiques mais bien à destination du Monde: c’est à dire qu’on ne produit des connaissances non pour être évalué mais pour l’humanité, et que ce principe doit prévaloir face à la gouvernance des sciences ou à l’économie de marché;

- que le plagiat ne doit pas être condamné parce qu’il est malhonnête vis à vis de l’auteur, mais parce qu’il est tout simplement immoral, tout autant que la course à la publication et la mise en concurrence des chercheurs. Plus cette concurrence existera, plus la “société civile” la remplacera par d’autres systèmes de production scientifique: imaginez un monde où 50% des chercheurs publient leurs articles sur leurs blog personnels ou des sites collaboratifs dédiés et ouvert à tous (pourquoi pas organisés par les universités elles-mêmes) et où l’autre moitié des chercheurs accepte cette course au peer review pour gagner des points d’impact. Qui osera dire que la première moitié des productions ne mérite pas d‘être reconnue comme scientifique parce qu’elle n’est pas évaluée par des pairs à l’intérieur de revues de catégorie A, B, ou C ?

Voici le postulat: il est préférable de permettre aux pairs et au monde entier d’apprécier une oeuvre scientifique dont on donne à priori l’autorisation d’être publiée, que de ne permettre qu’au pairs d’évaluer cette production et ne donner l’autorisation de publication (exclusive) qu’à postériori.

Les licences libres n’interviennent que de manière secondaire, pour asseoir juridiquement les conditions de la diffusion (voire des modifications).

La conséquence, du point de vue du plagiat, c’est que l’oeuvre est connue à priori et par le plus grand nombre : cela diminue radicalement le risque de ne pas démasquer le plagiat, en particulier grâce aux moteurs de recherche sur le web.

Par ailleurs, dans ces conditions, si l’oeuvre en question n’est pas « scientifiquement pertinente », contient des erreurs ou n’obéit pas à une méthodologie correcte, c’est toute la communauté qui pourrait alors en juger puisque tous les agents, y compris les plus spécialistes, seraient en mesure de publier leurs évaluations. Il appartient donc aux communautés scientifiques, dès maintenant, de multiplier les lieux où l’exercice de la recherche scientifique pourrait s’accomplir dans une transparence quasi-absolue et dans une indépendance totale par rapport aux revues comme aux diktat de l’évaluation à tout va. C’est le manque de transparence qui, par exemple, implique l’anonymat des évaluateurs alors même que ce sont des « pairs » (j’aime l’expression « un article de pair inconnu »): ne serait-il pas juste qu’un évaluateur (comme le ferait un critique littéraire) ne se cache pas derrière le nom de la revue, afin que tout le monde puisse juger de son impartialité ? Voilà pourquoi il faut ouvrir à priori la diffusion des articles : les évaluations publiques seront toujours plus recevables que les évaluations anonymes, puisqu’elles n’auront rien à cacher et seront toujours potentiellement discutées entre lecteurs. Là encore les cas de plagiat seraient très facilement identifiés et surtout discutés.

Il se pourrait même que le modèle économique du logiciel libre puisse mieux convenir à l’économie de la Recherche que les principes vieillissants du système dominant.

27.01.2012 à 01:00

Il faut libérer les sciences

Ce billet fait suite à mon texte de 2010 intitulé « Pour libérer les sciences », au risque de paraître quelque peu redondant. En effet, en cette fin de mois de janvier 2012, le mathématicien Timothy Gowers (Cambridge + Médaille Fields 1998) a lancé un appel au boycott de l’éditeur Elsevier, un des grands poids lourds de l’édition scientifique et en particulier les éditions papier et en ligne vendues par abonnement aux Universités. Cet appel au boycott repose sur le même reproche fait depuis des années sans que rien ne bouge à propos des tarifs exorbitants des ces firmes (Elsevier en tête mais on peut aussi citer Springer et d’autres), sans aucun rapport avec le coût effectif des supports de diffusion ainsi proposés à la vente. Faut-il boycotter Elsevier et, comme T. Gowers, inciter les scientifiques à ne plus soumettre leurs publications aux revues détenues par Elsevier, ne plus faire partie des comités de lectures, etc. ?

Des connaissances libres et gratuites

Selon moi, un tel appel au boycott n’a que peu de chance de réussir. En effet, la pression de l’évaluation tout-azimut est telle sur les scientifiques qu’ils se trouvent bien obligés de participer à la mascarade collective consistant à s’auto-évaluer et se plier au racket organisé. Mais la question dépasse largement ces aspects. En effet, qu’est-ce qu’une publication scientifique? C’est un ensemble de connaissances (nouvelles) exposées selon des règles et une méthodologie claire et dont l’objectif est d’être diffusée le plus largement possible. Dans la mesure où cette publication est le produit de l’effort collectif à la fois des scientifiques et des citoyens qui, par leurs impôts, subventionnent la recherche scientifique, les connaissances produites sont censées être consultables par tous, et comme un juste retour sur l’investissement public, cela implique selon moi un accès libre et gratuit.

Libre, parce que la priorité doit être donnée à la diffusion des sciences et que chacun devrait pouvoir utiliser un texte scientifique : le lire, le partager, identifier les auteurs et proposer éventuellement des modifications en leur écrivant, bref, en disposer de manière démocratique et dans un esprit de partage. Libre est ici utilisé dans le même sens que dans “licence libre”, c’est à dire que les texte scientifiques devraient être soumis à de telles licences. Quant au droit d’auteur, si l’on s’en réfère à la législation française (je ne parle pas de copyright), il reste bien sûr inaliénable (droit moral) et la paternité d’un texte sera toujours reconnue quoiqu’il arrive. Dès lors, la conclusion s’impose d’elle même : un texte scientifique, produit grâce à des subsides publics, ne doit en aucun cas faire l’objet d’une cession exclusive des droits de diffusion. En effet, on devrait considérer que si le droit moral sur l’oeuvre appartient bien à l’auteur, ce dernier ne devrait pas être détenteur d’un droit patrimonial dans la mesure où son oeuvre appartient au public en premier lieu. L’évaluation de cette oeuvre par les pairs lui confère sa validité scientifique, fruit du métier de chercheur, et consiste à la reconnaître comme une véritable production de la recherche publique.

Gratuit, parce que rien n’oblige à réaliser des bénéfices sur la production scientifique, mais pour autant, cela doit rester possible. Cette gratuité peut s’obtenir d’une manière très simple : aujourd’hui, un texte scientifique est produit de manière électronique, il peut donc, pour un coût proche de zéro, être diffusé par voie électronique. La publication au format papier ou dans un format électronique spécial peuvent certes être payantes, dans la mesure où un effort est fait par un éditeur pour produire un support. Mais, quoi qu’il advienne, un chercheur devrait pouvoir garder la main sur n’importe quel moyen de diffusion qui lui semble opportun et laisser gratuitement à disposition du public ses productions scientifiques.

C’est la raison pour laquelle je ne suis pas favorable à un boycott d’Elsevier ou de toute autre maison d’édition. Si l’on part du principe que toute production scientifique est censée être libre et gratuitement disponible quelque part, rien n’empêche une maison d’édition de s’emparer d’un texte et participer à sa diffusion via n’importe quel support. Dans ce cas, c’est un service qui est vendu… pourquoi le condamner?

Le système est aberrant, il faut le changer

Les problèmes ne sont donc pas là où l’on pense d’emblée les trouver. Les scientifiques en ont pourtant l’habitude. La question réside dans l’exercice d’un monopole, lui même soutenu de manière politique. Preuve en est que Elsevier et d’autres ont récemment soutenu le Research Works Act qui vise explicitement à limiter voire interdire l’accès libre aux productions scientifiques ! En d’autres termes, le rêve d’Elsevier et consors est d’obtenir un monopole sur la connaissance. C’est inacceptable. Surtout si l’on relève quelques petits scandales de Elsevier sur le montage de vrais-faux journaux pharmaceutiques, au service de quelques firmes.

Face aux pratiques douteuses de ces groupes de l’édition scientifique, l’un des premiers réflexes des scientifiques est de se tourner vers des solutions de type open access. Au risque de répéter ce que j’ai déjà affirmé précedemment, cette solution n’est valable qu’à la condition que ces productions scientifiques soient véritablement libres et soumises à des licences libres. Si l’on prend l’exemple de HAL (Archives ouvertes) qui se targue d’être un accès “libre” garantissant la propriété intellectuelle des auteurs, on est encore loin du compte. Le fait de placer un texte sur HAL et autres serveurs est souvent soumis à des conditions bien particulières, dont la plus importante est d’obtenir l’autorisation préalable de l’éditeur de la revue dans laquelle le texte est censé être initialement diffusé. Tout part du principe qu’une publication scientifique passe obligatoirement par une revue au sens classique du terme. Certaines revues ont depuis longtemps fait le pari des licences libres, mais c’est loin d’être le cas de toutes les revues. Or, rien n’oblige les chercheurs à accepter de telles conditions ! Qui plus est, cet engouement pour les archives ouvertes a été perçu par certains éditeurs comme une occasion de racketter encore plus les auteurs (et leurs labos) : si vous voulez publier, il faut payer et si, en plus, vous voulez obtenir l’autorisation de placer votre texte sur l’un ou l’autre support d’archives ouvertes, il faut encore payer (très cher).

En somme, si je parle de racket, c’est bien parce qu’un texte, produit sur des fonds publics, à la sueur du front d’un chercheur, ne donnera qu’un retour limité sur l’investissement public de départ, sera centralisé dans une revue (sclérosant ainsi la diffusion), moyennant des tarifs de publication, et revendu aux institutions publiques sous forme d’abonnement… Les membres des comités de lecture, qui prennent de leur temps de chercheur (là encore: fonds publics) pour évaluer les articles de ces revues, sont très rarement indemnisés (et s’il le sont, c’est de manière personnelle, aucune somme n’est versée à leur institution). Quant au travail d’éditeur, il se réduit ni plus ni moins qu’à imprimer un texte fourni de manière électronique par le chercheur déjà mis en page et corrigé par lui-même selon les maquettes fournies, c’est à dire un travail éditorial proche de zéro (surtout sans indemniser les comités de lecture). Comment un tel système a-t-il pu se mettre en place ? c’est une aberration.

Que faut-il faire ?

Les solutions sont très simples à mettre en oeuvre, mais très difficiles à accepter. Il faut tout d’abord s’inspirer de l’existant : ArXiv et Wikipedia sont selon moi deux systèmes parfaitement adaptés. Il faut en effet inverser la tendance : les éditeurs doivent accepter le fait que ce qu’ils publient est d’abord issu du pot commun “connaissance de l’homme”, et que leur travail est d’abord un service rendu sous forme de support. Les productions scientifiques peuvent aujourd’hui être évaluées par les pairs de manière transparente sur des serveurs en ligne adaptés. Elle peuvent être publiées et/ou référencées en ligne avec un coût nul et toucher des milliards de personnes, sans obliger le lecteur au fin fond d’une zone rurale d’un pays du tiers-monde à posséder un abonnement Elsevier. Et si ce dernier n’a pas Internet, un de ses correspondants plus chanceux devrait pouvoir avoir la possibilité la plus morale qui soit à imprimer le texte et le lui envoyer par courrier.

Recette à méditer, reposant sur le principe de la décentralisation des données et de la priorité de la diffusion des connaissances :

- Chaque chercheur (ou simple quidam) produit des textes qu’il héberge soit depuis chez lui, soit sur un emplacement qui lui est personnellement réservé sur un serveur au sein de son université de rattachement.

- Les universités hébergent toutes des duplicata des bases de données dont l’alimentation se fait via une technologie peer-to-peer. Les bases de données sont les suivantes : 1) la liste et les adresses des textes produits par les chercheurs et hébergés partout dans le monde 2) le descriptif de ces textes, leur domaines, suivant une nomenclature commune 3) les commentaires et les critiques de ces textes, produits de manière anonyme ou non.

- Les revues ont accès (comme le reste du monde) à ces données et peuvent choisir celles parmi les meilleures publications (système de popularité) qui peuvent être inclues dans leurs collections. Elles font alors pour cela appel à leurs comités de lecture. En retour, d’autres comités de lecture issus des communautés scientifiques (associations internationales de chercheurs, prix de travaux scientifiques, membres de comités d’institutions publiques, etc) peuvent aussi participer à un système de notation.

- Les systèmes de notation doivent être indépendants les uns des autres, parfaitement identifiés, et peuvent être multiples. Par exemple, l’Association des Joyeux Mathématiciens du Wyoming peut éditer mensuellement ou annuellement, toujours en ligne, un classement des productions les plus pertinentes. Ce classement pourra être différent pour les referees des médailles Fields. Et encore différent pour des institutions comme le CNRS. Il peut donc y avoir consensus ou différence : c’est bien là l’objectif des théories scientifiques que d’être discutables, non? Mais ces classements multiples permettraient de hiérarchiser la qualité des travaux selon des tendances, et permettrait aussi des notations “en contexte” : si un chercheur doit être évalué, c’est à l’instance qui l’évalue qu’il revient de noter ses productions. Ainsi par exemple en France : l’AERES, au lieu de ne se référer qu’à des évaluations de revues complètement absconses, pourrait faire l’effort de lire les publications des membres des labos et elle-même attribuer une note au labo, note qui compterait alors dans la popularité des articles référencés.

- Le chercheur qui produit un texte peut toujours le faire en vue de le proposer dans une revue bien précise mais il le dépose en ligne et le rend accessible à tous : la revue peut alors utiliser ce texte, comme initialement prévu, mais d’autres revues peuvent très bien l’utiliser aussi : par exemple pour le traduire et favoriser sa diffusion, ou le rendre disponible dans des endroits ne disposant pas d’accès Internet (on peut imaginer une autre ambition aux éditeur consistant à publier des versions papiers des meilleurs articles dans un but humanitaire…Ceci en vertu d’une absence d’exclusivité de la diffusion.

Et alors, où serait le problème ? Les auteurs ne sont de toute façon pas censés toucher de revenus sur leurs propres publications scientifiques. Les institutions feraient des économies substantielles. Tout le monde aurait accès à ces connaissances. La fiabilité des informations ainsi produites serait mesurée à l’aune des méthodes de ceux qui se donneront la peine d’effectuer ces évaluations. L’ensemble pourrait très bien reposer sur un modèle Wikipedia… Avec l’avènement du tout numérique et de l’Internet, il faut aussi que nos chers éditeurs adaptent leurs modèles hérités du début du XXe siècle (Elsevier est même plus ancien) et comprennent que leur rôle n’est plus autant indispensable qu’il l’était hier, surtout si leur jeu consiste à imposer un modèle de monopole et brider la diffusion des connaissances.

01.01.2012 à 01:00

Occupations

Voici quelques éléments biographiques à propos de Christophe Masutti (voir la photo). Ils ne sont ni exhaustifs ni définitifs.

En résumé

Hospitalier, (H)ac(k)tiviste, libriste, administrateur de Framasoft. Sport à haute dose (VTT, natation, trail). Histoire, sociologie, philosophie des sciences et des techniques.

J’ai un job que j’aime beaucoup aux Hôpitaux Universitaires de Strasbourg. Il m’est cependant indispensable de poursuivre mes activités militantes en faveur des libertés numériques. En même temps, ce sont aussi mes compétences d’historien des sciences et des techniques qui sont souvent mobilisées… et j’écris des textes. Pour décompresser de tout cela, je pratique mon sport de prédilection, le VTT, que je complète par deux autres sports, le trail (et l’endu en salle de sport) et la natation.

Trucs officiels

- Attaché aux affaires Européennes et transfrontalières, Hôpitaux Universitaires de Strasbourg, dep. fév. 2008. — Coopération, coordination de projets, recherche clinique, évaluation, gestion scientifique et technique, développement de l’activité

- Co-administrateur, Association Framasoft, Dep. janv. 2010 — Membre de différents comités, administration de l’association

- Chercheur associé, SAGE, UMR 7363, Dep. sept. 2012 — (Sociétés, acteurs, Gouvernement en Europe)

- Post-doctorat, INSERM, Institut national de la santé et de la recherche médicale, janv. 2008 — janv. 2009 — Histoire et politiques de santé, France / Allemagne

- Post-doctorat, La Charité Universitätsmedizin Berlin, févr. 2007 – janv. 2008 — Développement réseau DRUGS (histoire de l’industrie pharmaceutique)

- Attaché d’enseignement et de recherche, Faculté des sciences économiques, Université de Strasbourg, 2004 — 2006. — Histoire des sciences et des technologies, Histoire économique

- Doctorat (allocataire-moniteur de recherches), IRIST, Université de Strasbourg, 2001 — 2004. — Histoire des sciences et des technologies (72), Sciences politiques (04), Histoire moderne et contemporaine (22)

- DEA, IRIST, Université de Strasbourg, 2000 — 2001. — Sciences, Technologies et Société (STS)

- Maîtrise/master, Université de Strasbourg, 1999. — Discipline : Philosophie

01.01.2012 à 01:00

Clefs publiques

Clefs à télécharger

-

Clef publique pour affaires Framasoft et libertés numériques : clepubliqueframasoftframatophe.asc

-

Clef publique personnelle (pour messages personnels) : clepubliquepersochristophe.asc

Explications

Voir cette page Wikipedia

20.04.2011 à 02:00

Option libre

Quel est le cadre légal associé aux aux créations de l’esprit, et comment les licences libres changent-elles la donne ? Quels sont les bons usages des licences libres ? Dans ce livre, Benjamin Jean nous présente ce nouveau paradigme des licences libres et l’équilibre du système qu’elles structurent. Tout en évitant la simple exposition de règles et de normes, c’est de manière méthodique que seront abordées les notions juridiques, les exemple pratiques et les principaux écueils à éviter.

Jean, Benjamin. Option libre. Du bon usage des licences libres. Framasoft, 2011.

Lien vers le site de l’éditeur : https://framabook.org/optionlibre-dubonusagedeslicenceslibres/

21.01.2011 à 01:00

Réseaux sociaux

La dissémination des technologies numériques dans toutes les couches sociales de tous les pays industrialisés transforme inexorablement les relations entre les individus, les groupes, les générations et les nations. La croissance spectaculaire des réseaux sociaux affecte tous les milieux, et vient transformer les règles du jeu socio-économique dans son ensemble, tant pour les individus que pour les entreprises et organisations, et dans tous les domaines de la vie. Or – en première analyse – ces nouveaux réseaux peuvent sembler des réseaux non sociaux, voire même antisociaux. Ils sont en effet généralement coupés de ce qui caractérisait jusqu’alors le social : lié à un territoire, à une langue, à un héritage (religieux, politique ou culturel au sens le plus large), légué par des générations d’ascendants, et qui précède en principe le social comme son passé, comme un sol commun.

Cet ouvrage, dirigé par Bernard Stiegler, propose les meilleures contributions aux Entretiens du Nouveau Monde Industriel sur les réseaux sociaux. Il montre comment ces technologies relationnelles bouleversent non seulement les règles traditionnelles de l’économie et de l’industrie, mais également, et plus profondément, le processus d’individuation psychique et collective. Il propose une analyse approfondie des conditions sociologiques et psychologiques qui président à la constitution de ces réseaux sociaux.

Il étudie leurs conséquences économiques et organisationnelles, et identifie les opportunités d’innovation sociale, les enjeux politiques et les menaces afférents à cette émergence du « social engineering ».

Enfin, il explore les règles de constitution et de développement des réseaux sociaux du web 3.0 (alliance du web sémantique et du web social), et également les conditions économiques et éthiques d’administration de ces nouveaux milieux, c’est-à-dire les questions de la gestion, du contrôle, de la transparence et de l’e-démocratie, ainsi que les technologies et les stratégies industrielles déjà mises en oeuvre ou à venir.

Avec les contributions de : Bernard Stiegler, Alexander R. Galloway, Yann Moulier-Boutang, Annie Gentès, François Huguet, Christian Fauré, Richard Harper, Antoine Masson, Elizabeth Rossé, Kieron O’Hara, Aristea M. Zafeiropoulou, David E. Millard et Craig Webber, Alain Mille, Olivier Auber

Stiegler, Bernard, éditeur. Réseaux sociaux. Culture politique et ingénierie des réseaux sociaux. FYP éditions, 2011.

Lien vers le site de l’éditeur : https://www.fypeditions.com/bernard-stiegler-et-al-reseaux-sociaux/

11.01.2011 à 01:00

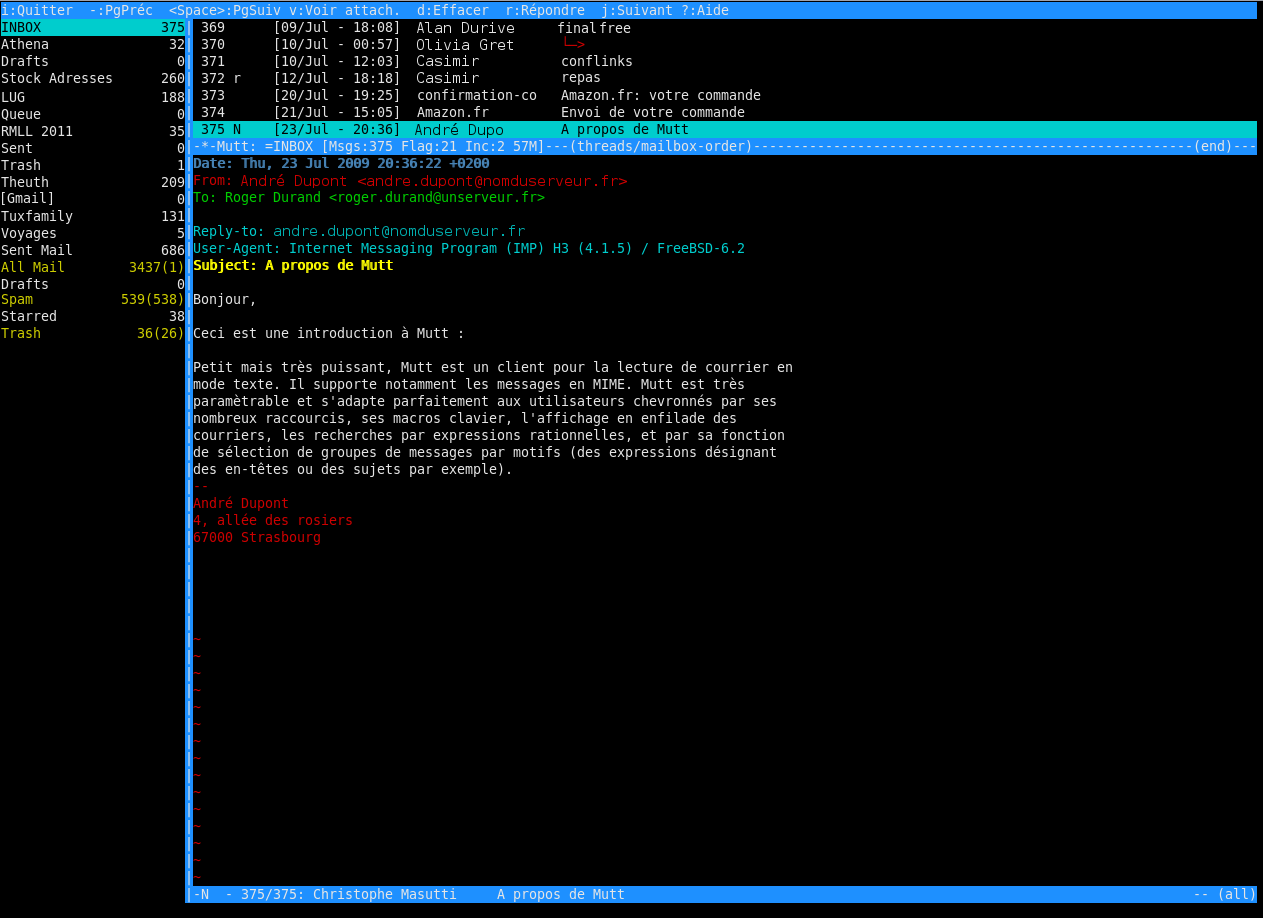

À propos de Mutt

Pour résumer simplement, Mutt est une sorte de navigateur de fichiers en mode texte spécialisé dans la lecture de boites courriel (comme le format mbox par exemple). Ainsi, à l’aide d’un “récupérateur” de courriel (comme fetchmail ou procmail) vous pouvez télécharger vos courriels, les stocker dans un dossier et les lire avec Mutt. Cela dit, Mutt est tellement bien qu’il peut lire des dossiers distants, en utilisant le protocole IMAP notamment. En d’autres termes si vous utiliser IMAP, Mutt peut (presque) se suffire à lui tout seul. De plus, Mutt n’a pas d’éditeur de texte intégré, et il s’utilise dans un terminal. Si vous voulez écrire un courriel, il vous faut configurer Mutt de manière à utiliser l’éditeur de votre choix. Et si vous voulez des couleurs, ce seront celles dont est capable d’afficher votre terminal. Ce billet vise à faire le point sur l’utilisation de Mutt et montre combien ce petit logiciel peut s’avérer très puissant.

S’il est si petit, pourquoi utiliser Mutt?

Mutt est un programme dans la droite lignée des programmes Unix. C’est un petit programme, réalisé pour effectuer un seul type de tâche, mais il le fait bien. Ainsi pour utiliser convenablement Mutt, il faudra tout de même un peu de débrouillardise et de bon sens, surtout dans la mesure où Mutt est dit “hautement configurable”. Sa puissance vient tout simplement de ce que vous même avez configuré. C’est pour cela que Mutt est sans doute le client de courriel le plus efficace.

Voici deux exemples rapides:

– Je possède un compte courriel sur un serveur et je veux y accèder en IMAP. Le processus est assez simple. Après avoir correctement configuré Mutt pour l’accès à mon compte, Mutt lira les dossiers sur le serveur, me renverra les en-têtes, me permettra de lire les courriels et si je désire envoyer un message, Mutt ira le placer dans la boîte d’envoi. De ce point de vue, Mutt effectue un travail de rapatriement de données, le serveur IMAP fait le reste.

– Je possède un compte courriel et j’y accède en POP. A l’aide d’un “récolteur” de courriel, comme procmail ou fetchmail, je rapatrie mes données dans un dossier local et je configure Mutt pour qu’il lise les éléments de ce dossier. Le tri, les règles de stockage et classement reposent sur la configuration du “récolteur” que j’ai décidé d’utiliser (notez que fetchmail ou procmail sont de même “hautement configurables”). Vous pouvez lire cette page du manuel de formation Debian pour en apprendre davantage sur ce système

Comment utiliser Mutt?

Il vous faudra d’abord le configurer. Pour ce faire, le principe est simple: après avoir installé le programme via les dépôts de votre distribution, créez un fichier .muttrc dans votre /home. Ensuite il existe toute une série de commandes que vous pouvez renseigner pour faire fonctionner Mutt. Ces commandes concernent les modalités de connexion à un compte, les règles d’affichage des messages et de leurs en-tête, les règles de rédaction, les règles de tri et d’envoi, la personalisation des en-têtes des messages envoyés, les jeux de couleurs, l’éditeur de texte choisi, etc, etc. Bref, tout ce qui permet à Mutt de faire ce que vous lui demandez tout en coopérant avec d’autres programmes selon vos besoins.

Le seul bémol est qu’il vous faudra sans doute passer du temps à comprendre et implémenter ces commandes dans le fichier de configuration. En contrepartie, Mutt sera capable de faire tout ce que vous lui demandez et l’éventail des fonctionnalités est particulièrement grand et malléable. Mutt est vraiment un logiciel libre!

Barre latérale

Certains utilisateurs préfèrent avoir sous les yeux la liste des dossiers dans lesquels ils trient leurs messages. Lorsqu’un nouveau message arrive, il est signalé présent dans l’un des dossiers et l’utilisateur peut naviguer entre ces derniers. Nativement, Mutt n’intègre pas une telle barre latérale. Il faut alors patcher Mutt dans ce sens. Pour cela, certaines distributions, outre le fait de proposer Mutt dans les dépôts, proposent aussi le paquetage mutt-patched. Si ce n’est pas le cas, il faut alors se rendre sur le site officiel de ce patch.

Imprimer avec Mutt?

Imprimer avec Mutt, c’est déjà beaucoup dire. En fait, lorsque l’on configure Mutt en éditant .muttrc, il suffit d’ajouter cette commande

set print_cmd="lpr -P nom_de_l_imprimante"

pour pouvoir imprimer (touche “p”) l’entrée courante. Mutt envoie alors le texte… tout le texte visible.

De même, selon l’éditeur de texte que vous utilisez avec Mutt pour écrire vos courriels, il possède sans aucun doute une fonction d’impression. Mais il ne s’agit que d’imprimer le texte que vous entrez.

Vous aimeriez peut-être pouvoir formater l’impression et gérer la mise en page des courriels que vous imprimez. Pour cela Muttprint est un petit utilitaire configurable (lui aussi!) qui vous rendra de bien grands services, ne serait-ce que pour limiter l’impression aux en-têtes les plus utiles comme date:, à:, et de:. Certaines distributions proposent le paquetage muttprint, il vous suffit alors de l’installer en quelques clics depuis les dépôts.

Configurer Muttprint se fait de manière similaire à Mutt. Vous avez cependant le choix entre soit éditer directement le fichier /etc/Muttprint (donc en mode root), soit créer et éditer un fichier .muttprintrc dans votre /home, à coté de .muttrc.

Dans .muttrc, au lieu de spécifier l’imprimante, vous devez alors dire à Mutt d’appeler Muttprint à la rescousse:

set print_command="muttprint"

Et dans muttprintrc, il vous suffit de renseigner les commandes, en particulier celle-ci:

PRINT_COMMAND="lpr -P nom_de_l_imprimante"

Le fichier /etc/Muttrc qui se crée lors de l’installation de Muttprint servira de modèle (à défaut d’être directement modifié lui-même). Il a l’avantage de voir chaque commande explicitée, ce qui le rend très facile à configurer.

Petite astuce: si dans l’en-tête que vous imprimez, vous désirez voir figurer un petit manchot linuxien, il vous suffit d’installer le paquetage ospics qui ira placer une série de petit dessins dans /usr/share/ospics/. Il reste à faire appel à l’un d’entre eux (format .eps) pour égailler un peu vos impressions (mais vous pouvez très bien utiliser un autre fichier .eps de votre choix, comme le logo de votre labo, une photo de votre chien, etc.).

Gestion des profils

Vous aimeriez peut-être utiliser plusieurs adresses courriel et signatures, selon vos destinataires ou les listes auxquelles vous êtes abonné. Pour cela il y a au moins deux possibilités.

La première est de partir de l’idée que vous rapatriez plusieurs boites courriel, par exemple avec fetchmail. Et que selon les boites que vous consultez et répondez aux correspondants, vous devez passer par un serveur smtp différent, avec une connexion (mot de passe) différente, une clé GPG différente, etc. Le petit utilitaire Muttprofile est là pour gérer ce type de situation. Depuis Mutt, on peut alors passer d’un profil à l’autre via une série de macro adéquates. Certaines distributions proposent le paquetage muttprofile dans leurs dépôts.

Cela dit, le système précédent est un peu lourd à gérer (opinion personnelle de l’auteur de ces lignes). Il présente néanmoins le grand avantage de se prêter parfaitement à l’utilisateur qui héberge son propre serveur de courriel, où à celui qui tient vraiment à avoir une configuration relative à ses profils. Pour l’utilisateur qui souhaite fonctionner plus simplement, le mieux est encore de rapatrier toutes les boites courriel dans une seule depuis les serveurs (généralement, vous pouvez configurer cela depuis l’interface webmail de votre boite) et finalement ne consulter avec Mutt qu’une seule boîte. Il s’agit donc de ne passer que par un seul serveur au lieu de plusieurs. Mais dans ce cas, comment gérer ses profils?

Hooks

Une fonctionnalité formidable de Mutt, ce sont les “hook”. Il s’agit de fonctions de type “si … alors” qui sont très précieuses.

Par exemple, si j’ai besoin de spécifier une adresse en fonction d’une adresse d’un expéditeur ou d’une liste à laquelle je suis abonné, je peux écrire dans mon .muttrc la séquence suivante :

send-hook olivier.durand@machin.com my_hdr From: Patrick Dupont

Cette séquence permet de répondre à Olivier Durant en utilisant l’adresse Patrick Dupont (lorsque j’écris un message, Mutt repère la chaîne “olivier.durand” dans le champ To: et place ce que je lui ai demandé dans le champ From:).

Autre exemple: si je souhaite utiliser une adresse courriel précise lorsque je me situe dans un dossier (par exemple le dossier dans lequel je rapatrie les messages provenant de mon compte secondaire), alors je peux utiliser ce type de commande:

folder-hook laposte my_hdr From: Jean Dugenou

qui permet d’utiliser l’adresse Jean Dugenou lorsque je me situe dans le dossier /laposte (cela marche aussi bien en IMAP).

Il y a beaucoup d’autres possibilités ouvertes par le système des “hook”, et, au fil du temps, vous finirez par constituer une suite de règles variées correspondant exactement à vos besoins. C’est aussi la raison pour laquelle vous avez tout intérêt à sauvegarder en lieu sûr une copie de votre .muttrc, histoire de ne pas avoir à tout refaire si vous perdez la première…

Commandes et variables

Une autre particularité de Mutt est que l’apprentissage consiste essentiellement à comprendre son .muttrc et comparer avec celui des autres utilisateurs. Pour cela, il est possible de trouver sur internet des exemples bien faits de .muttrc, en particulier sur le site officiel (qui propose aussi un wiki). La liste des commandes et variables pour la configuration de Mutt se trouve sur cette page du manuel en ligne et sa traduction en français sur le site de Cedric Duval.

L’éditeur de texte

Comme nous l’avons précisé plus haut, Mutt ne fait que naviguer dans votre courriel. Il ne permet pas d’écrire. Pour cela, il lui faut faire appel à un éditeur de texte. Le principe est, là encore, assez simple: lorsque vous écrivez un message, vous entrez le texte sous les en-têtes définies par Mutt (et que vous pouvez modifier “à la main”), vous quittez l’éditeur et Mutt reprend la main pour envoyer le message.

Avec Mutt, vous pouvez utiliser n’importe quel éditeur de texte de votre choix. Après l’installation, la configuration par défaut utilise l’éditeur par défaut de votre système. Si vous souhaitez en changer, il suffit de le déclarer dans .muttrc. En pratique, Vim ou Emacs sont sans doutes les éditeurs les plus appropriés, Mutt ayant une apparence par défaut se rapprochant plutôt de Vim. Nano, un gentil petit éditeur de texte qui a aussi sa cohorte d’admirateurs, pourra de même combler vos attentes.

Pour ceux qui désirent utiliser Vim, là encore, de manière optionnelle, vous pouvez créer un fichier .vimrc dans votre /home, de manière à configurer Vim pour une utilisation avec Mutt, entrer vos propres commandes par exemple. L’une d’entre elles (syntax on) vous permettra d’utiliser un jeu de coloration syntaxique se rapprochant de Mutt (quoi que cela dépende des couleurs que vous avez configuré dans .muttrc).

[Attention, utilisateurs de Ubuntu, la version de Vim installée par défaut est Vim-Tiny. Il vaut mieux installer Vim dans sa version complète pour pouvoir faire ce que vous voulez avec .vimrc].

Lire les messages en HTML

Pour des raisons diverses (et pas toujours justifiées) certaines personnes aiment envoyer des courriel au format HTML, parfois même accompagnés d’images à l’esthétique douteuse censées “embellir” le message. Avec Mutt, il faut donc faire appel à un logiciel capable de lire le HTML. Il existe au moins plusieurs navigateurs en mode texte: Lynx, W3m, Elinks, Links, Links2…

Il s’agit en fait d’utiliser les entrées mailcap pour reconnaitre le type d’information à traiter et faire appel au bon logiciel pour les afficher. Dans le fichier .muttrc, il faudra donc entrer le code permettant de faire appel au fichier .mailcap que vous devez créer dans votre /home:

set implicit_autoview auto_view text/html application/x-pgp-message set mailcap_path="~/.mailcap" set mailcap_sanitize=yes

Puis, dans .mailcap, au choix :

- Si vous désirez utiliser Lynx*:

text/html; lynx -dump -force-html -assume_charset %{charset} -localhost %s; copiousoutput - Si vous désirez utiliser W3m:

text/html; w3m -dump %s; copiousoutput; nametemplate=%s.html

- Si vous désirez utiliser Links ou Links2:

text/html; links2 -dump %s; nametemplate=%s.html; copiousoutput

- Si vous désirez utiliser Elinks:

text/html; elinks -default-mime-type text/html %s; needsterminal;

- Dans le cas Lynx, vous noterez la séquence

-assume_charset %{charset}. Elle vise à tirer avantage de la configuration de Lynx utilisant le paramètre assume_charset afin de lire correctement la majorité des messages et leur encodage.

L'option -dump permet l'affichage dans le même processus que Mutt, c'est à dire dans la même fenêtre. Si vous désirez utiliser les navigateurs de manière autonome, puis, en les quittant, revenir automatiquement à Mutt:

text/html; Lynx %s; nametemplate=%s.htmltext/html; w3m %s; nametemplate=%s.htmltext/html; links2 %s; nametemplate=%s.html

Attention: si votre système est configuré en UTF8 (Locales), c’est cet encodage qui sera utilisé par le navigateur que vous aurez choisi. Un avantage de Links(2) est que si le “content-type” du courriel envoyé n’est pas ou mal renseigné, ou si l’encodage n’est pas le même que le vôtre, alors ce navigateur gèrera les défauts d’affichage (par exemple les lettres accentuées) en trouvant des solutions permettant une lecture agréable du courriel.

Le Carnet d’adresses

Les alias, mode classique

Mutt intègre un système de répertoire d’adresses très simple. Un fichier d’adresse est créé dans lequel vous enregistrez vos contacts.

Ainsi, dans votre .muttrc, vous pouvez indiquer ceci :

#CARNET ADRESSES set alias_file = ~/.mutt/adresses source ~/.mutt/adresses

Cela aura pour effet d’enregistrer vos alias dans /.mutt/adresses et de rechercher ces alias dans ce même fichier (source).

Utilisation de Abook

Abook est un petit programme de gestion de contacts fait pour fonctionner avec Mutt. Plus élaboré que le systèmes des alias (cf. ci-dessus), il permet notamment l’import et l’export de carnets d’adresses dans différents formats et surtout il présente une interface graphique et stocke davantage d’informations sur vos contacts.

Abook doit certainement être disponible dans les paquets de votre distribution. Le site du projet se trouve à cette adresse.

Pour utiliser Abook avec Mutt, il suffit de configurer votre .muttrc ainsi:

# Abook set query_command= "abook --mutt-query '%s'" macro index,pager A "abook --add-email-quiet" "Ajouter l'expediteur dans abook"

Cela aura pour effet de permettre à Mutt de faire appel à Abook, deux deux manières : en tapant A (au lieu de a, utilisé pour les alias), l’expéditeur sera ajouté au carnet de Abook. Et pour utiliser Abook “à l’intérieur de Mutt”, c’est à dire dans le même terminal, il suffira de faire CTRL+t lors de l’entrée du destinataire. La liste des contacts de Abook apparaîtra alors.

Le logo de Mutt affiché en haut à gauche n'est pas le logo officiel (mais il est très joli). Il a été créé par Malcolm Locke. Vous pouvez vous le procurer ici, ainsi que sa licence (creative common).

01.01.2011 à 01:00

Quelques publications libristes

— À part ce qui suit, il y a aussi une thèse (et un livre), et on peut trouver mes publications académiques par ici.

Des livres

- Christophe Masutti, Affaires Privées. Aux sources du capitalisme de surveillance, Caen, C&F Editions, mars 2020. Lien.

- Richard M. Stallman, Sam Williams, Christophe Masutti, Richard Stallman et la révolution du logiciel libre. Une biographie autorisée, Paris, Eyrolles, 2011. Liens : Eyrolles (2eéd.), Framabook.

- Camille Paloque-Berges et Christophe Masutti (dir.), Histoires et cultures du Libre. Des logiciels partagés aux licences échangées, Lyon/Framasoft, Framabook, 2013. Lien.

- Christophe Masutti, Libertés numériques. Guide de bonnes pratiques à l’usage des DuMo, Lyon/Framasoft, Framabook, 2017. Lien.

- Christophe Masutti (trad. et adaptation de Bruce Byfield), LibreOffice Writer, c’est stylé !, Lyon/Framasoft, Framabook, 2018. Lien.

Des articles (liste non exhaustive)

-

Christophe Masutti, « La valeur lucrative des données est une vieille histoire », Alternatives Économiques, 05/22, Lien.

-

Christophe Masutti, « Encore une autre approche du capitalisme de surveillance », La Revue Européenne des Médias et du Numérique, automne 2021, Lien.

-

Maud Barret Bertelloni, « La surveillance est un mode du capitalisme » – Entretien avec Christophe Masutti, Le Vent se Lève, 25/09/2020, Lien.

-

Romain Haillard (interview par), « La lutte contre la surveillance est un anticapitalisme », Politis, 29/04/2020, Lien.

-

Anouch Seydtaghia (interview par), « Les résistants du logiciel libre », Le Temps, 11/10/2018. Lien.

-

Christophe Masutti, « Le capitalisme de surveillance », Vers l’Éducation Nouvelle, num. 571, 2018.

-

Christophe Masutti, « Vie privée, informatique et marketing dans le monde d’avant Google », document de travail, HAL-SHS, 2018. Lien.

-La série Anciens et Nouveaux Léviathans parue sur le Framablog. Lien :

- Les Nouveaux Léviathans IV « La surveillance qui vient ».

- Les Nouveaux Léviathans III. « Du capitalisme de surveillance à la fin de la démocratie ».

- Les Nouveaux Léviathans II « Surveillance et confiance ».

- Les Nouveaux Léviathans I « Histoire d’une conversion capitaliste ».

- Les Anciens Léviathans I « Le contrat social fait 128 bits… ou plus ».

- Les Anciens Léviathans II « Internet. Pour un contre-ordre social ».

Christophe Masutti, « Du software au soft power » , dans Tristan Nitot et Nina Cercy (éds.), Numérique, reprendre le contrôle, Framabook, 2016, pp. 99-107. Lien.

Christophe Masutti, « Ingénieurs, hackers : naissance d’une culture », in : Camille Paloque-Berges et Christophe Masutti (dir.), Histoires et Cultures du Libre. Des logiciels partagés aux licences échangées, Lyon/Framasoft, Framabook, 2013, pp. 31 – 65.

Christophe Masutti, « Internet, pour un contre-ordre social », Linux Pratique, num. 85 Septembre/Octobre 2014. Lien.

C. Masutti, Benjamin Jean, Préface, in : J. Smiers et M. van Schijndel, Un monde sans copyright… et sans monopole, Paris, Framabook, 2011. Lien.

Christophe Masutti, « Pour libérer les sciences », Framablog, 15 décembre 2010. Lien.

30.12.2010 à 01:00

Pour libérer les sciences

L’objectif de ce texte est de faire valoir l’intérêt d’une diffusion décentralisée et libre des connaissances scientifiques. En partant de l’idée selon laquelle l’information scientifique n’a d’autre but que d’être diffusée au plus grand nombre et sans entraves, je montrerai les limites du système classique de publication à l’ère du format numérique, ainsi que les insuffisances des systèmes d’archives « ouvertes ». J’opposerai le principe de la priorité de la diffusion et à l’aide de quelques exemples, j’aborderai la manière dont les licences libres Creative Commons permettent de sortir de l’impasse du modèle dominant.

« Pour libérer les sciences » by Christophe Masutti est mis à disposition selon les termes de la licence Creative Commons Paternité - Partage des Conditions Initiales à l’Identique 2.0 France.

(Màj) : Ce texte a été écrit en 2010, et publié sur le Framablog. Disponible uniquement en PDF à l’époque, je le reproduis ici en entier.

Christophe Masutti (IRIST – Université de Strasbourg), Pour libérer les sciences, 2010.

Merci à Jean-Bernard Marcon pour sa (re)lecture attentive.

Introduction

En juillet 2010, l’Organisation européenne pour la recherche nucléaire fit un communiqué apparemment surprenant. Déclarant supporter officiellement l’initiative Creative Commons, elle annonça que les résultats publiables des recherches menées au LHC (Large Hadron Collider – l’accélérateur de particules inauguré en 2008) seraient diffusés sous les termes des licences libres Creative Commons, c’est-à-dire1 :

En réalité, la surprise était en partie attendue . En effet, le CERN2 fut pour beaucoup dans l’apparition de l'Internet et le rôle qu’y jouèrent Tim Berners Lee et Robert Cailliau, inventeurs du système hypertexte en 1989, fut décisif. Le fait de diffuser les résultats du LHC sous licence libre obéit donc à une certaine logique, celle de la diffusion et de l’accessibilité de l’information scientifique sous format numérique. La dématérialisation des publications scientifiques et leur accessibilité mondiale, pour un coût négligeable grâce à Internet, permet de se passer des mécanismes de publication par revues interposées, avec cession exclusive de droit d’auteur, et réputés lents, coûteux, et centralisés. Dans ce contexte, le CERN a opté pour une diffusion décentralisée (en définissant a priori les conditions d’exercice des droits d’exploitation favorisant le partage) tout en garantissant la paternité et l’intégralité (les droits moraux) des travaux scientifiques.

Plus récemment encore, en novembre 2010, M. P. Rutter et J. Sellman, de l’Université d’Harvard, ont publié un article intitulé Uncovering open access 3, où ils défendent l’idée selon laquelle le libre accès aux informations scientifiques permet de resituer le lien entre savoir et bien commun. Pour amorcer leur argumentaire, l’étude de cas – désormais classique en histoire de la génétique – de la redécouverte des expérimentations de Gregor Mendel sert à démontrer à quel point les sciences sont assujetties à la diffusion . Là encore, il s’agit de mettre en perspective la question de la disponibilité des informations scientifiques à travers les systèmes centralisés de publications. L’exemple des accords difficiles entre le Max Planck Institüt et le groupe Springer pour l’accès à quelques 1200 revues est illustratif de la tension permanente entre le coût des abonnements, les besoins des chercheurs et l’idée que les connaissances scientifiques devraient être accessibles pour tous.

Dans un monde où la production et la diffusion des connaissances dépendent essentiellement de l’outil informatique (production et communication de données dans toutes les disciplines), la maîtrise des technologies de stockage et du web sont des conditions essentielles pour garantir le transfert et l’accessibilité. Aujourd’hui, en profitant des plus récentes avancées technologiques, tout un chacun est capable d’échanger avec les membres de sa famille et ses amis un grand volume de données en tout genre via Internet. Il devrait donc logiquement en être de même pour les travaux scientifiques, pour lesquels l’échange d’information est d’une importance vitale. Ce n’est toutefois pas le cas.

La centralisation

La production, la diffusion et l’accès à nos connaissances scientifiques sont formalisés par les outils informatiques :

-

la production : nul chercheur ne saurait aujourd’hui travailler sans Internet et encore moins sans un ordinateur dans lequel il classe, construit et communique ;

-

la diffusion : aujourd’hui, un article scientifique peut rester, de sa production à sa lecture finale, dans un circuit numérique sans jamais en sortir ;

-

l’accès : nous profitons tous des multiples services qui nous permettent, notamment par Internet, d’accéder rapidement à l’information, beaucoup plus rapidement qu’il y a à peine vingt ans. Le rythme de la recherche s’accélère et la numérisation des connaissances n’y est pas pour rien.

Pour rendre cohérent ce système de production et de diffusion, l’ingénierie informatique a joué un rôle fondamental dans la création des moyens par lesquels nous ordonnons nos connaissances : le système hypertexte, l’introduction de la logique booléenne, les outils d’indexation de données, etc. De même, la réduction du temps de transmission de l’information, grâce, par exemple, aux nanotechnologies ou encore au clustering de serveurs, joue un rôle primordial dans l’efficacité de nos systèmes d’échanges d’informations. Ces innovations ont donc produit quelque chose de très positif dans la mesure où, profitant de ces avancées techniques majeures, nous réduisons de plus en plus les délais de communication des données scientifiques, ce qui optimise la production de nouvelles connaissances.

La production, la diffusion et l’accès à nos connaissances ont donc épousé un ordre numérique hautement performant, et l’on pourrait redouter que la maîtrise de cet ordre soit avant tout une maîtrise des moyens. Il s’avère que non. Excepté pour les expérimentations nécessitant, par exemple, l’utilisation de supercalculateurs, la maîtrise des outils informatiques en général ne préjuge pas du rendement scientifique, elle ne fait qu’optimiser la communication des résultats. Les maîtres du nouvel ordre numérique ont donc déployé une stratégie qui a toujours fait ses preuves : centraliser les données et conditionner leur accès.

C’est ce qui s’est produit dans le cas d’Internet : alors même qu’Internet est d’abord un système décentralisé où chacun communique des données avec tous les autres, la possession des données et le calibrage de leur accès par les acteurs de l’économie du web a transformé Internet en un gigantesque Minitel 2.04, c’est à dire une logique d’accès individuel à des serveurs spécialisés.

Dans le cas des connaissances scientifiques, leur stockage et leurs conditions d’accès, c’est ce modèle qui fut repris : une optimisation du potentiel de communication mais un accès restreint aux données. En effet, les supports de la publication scientifique, que sont notamment les revues, proposent un service de stockage, payant ou non. Le problème, c’est qu’en maîtrisant ainsi le stockage et l’accès aux productions scientifiques, le potentiel technologique censé accélérer la diffusion et la réception de données est réduit aux contingences de rendement et aux capacités des services qui centralisent ces connaissances.

En fait, les revues scientifiques ont toujours fonctionné sur ce mode centralisé qui avait, au départ, deux objectifs : a) garantir la fiabilité de la production scientifique et la protéger par le droit d’auteur et b) regrouper les connaissances pour en assurer la diffusion, afin que les scientifiques puissent externaliser leur communication et rendre visibles leurs travaux. Cette visibilité, à son tour, permettait d’asseoir la renommée des chercheurs, de valoriser et évaluer leurs recherches au sein d’un champ disciplinaire, et surtout de permettre une forme de démocratie scientifique où les connaissances peuvent être discutées et critiquées (même si un peu de sociologie des sciences montre vite les limites de cette apparente démocratie). Aujourd’hui, la centralisation que proposait chaque revue, dans chaque discipline, est devenue d’abord une centralisation de moyens. Les revues se regroupent, des consortiums naissent et proposent, cette fois, de centraliser l’accès en plus des données. Or, le coût du support de la production scientifique est devenu presque nul puisque chaque chercheur est en mesure de communiquer lui-même sa production au sein de la communauté et même au monde entier grâce à Internet.

De même, les mécanismes de diffusion, encouragés par la rigidité de l’évaluation scientifique qui raisonne presque exclusivement en termes de classement de revues, sont aujourd’hui centralisés et conditionnés par le savoir-faire des organisations ou conglomérats en termes de stockage des données de classement et d’indexation. À tel point que ces acteurs (les regroupement de revues), conditionnent eux-mêmes les outils d’évaluation des instances publiques (comme la bibliométrie) qui définissent le ranking des chercheurs et des publications elles-mêmes. Nous avons donc confié aux professionnels de la publication les bases matérielles qui nous permettent de juger les productions scientifiques, et, ainsi, de produire en retour d’autres connaissances. La centralisation s’est alors doublée d’un enjeu de pouvoir, c’est à dire une stratégie permettant non seulement de décider qui a accès aux données, mais aussi comment et selon quels critères. Cette stratégie est devenue protectionniste : alors même que l’informatique et Internet permettraient de changer de système de diffusion et garantir le libre accès de chacun à l’information scientifique, le système de centralisation à créé des monopoles de moyens, et de la commercialisation des données.

De leur côté, les chercheurs - auteurs n’ont pas récupéré la maîtrise de la diffusion de leurs propres productions et la centralisation est devenue de plus en plus incontournable puisque le savoir-faire technique inhérent au stockage et à la diffusion en masse est possédé par quelques groupements ou conglomérats. Qu’importe, après tout, si une partie de ces moyens de diffusion et d’accès appartiennent à des conglomérats privés comme Google, Springer ou Elsevier ? Les impératifs de rendement et de rentabilité expliquent-t-ils à eux seuls la recherche de contenus toujours plus imposants de Google ou faut-il envisager un élan humaniste encore jamais rencontré dans l’histoire ? Dans quelle mesure le classement des revues conditionne-t-il en retour la rentabilité de leur diffusion numérique pour une firme comme Elsevier? Quel est le degré de neutralité de ces services de diffusion de contenus scientifiques ? Ce ne sont que quelques exemples frappants. Plus généralement, dans quelle mesure les parts de marché et les contraintes économiques jouent-elles un rôle dans la diffusion des connaissances, et, par conséquent, dans leur accès et leur production ?

Je n’apporterai pas de réponse à cette question, qui nécessiterait une étude approfondie sur les mécanismes du marché de la diffusion électronique et des supports. Je me contenterai simplement de souligner le hiatus entre d’un côté les multiples études sur l’économie de la connaissance et, d’un autre côté, le manque d’analyse sur l’appropriation concrète des moyens de diffusion par les agents. Car l’idée selon laquelle les agents sont tous rationnels masque le fait que les auteurs comme leurs lecteurs ne maîtrisent pas les conditions de diffusion et s’en remettent entièrement à des tiers.

Un exemple récent : sur la pression du gouvernement américain, Amazon.com a cessé d’héberger sur ses serveurs le site Wikileaks, suite aux révélations de ce dernier sur la face caché de la diplomatie internationale (Le Monde, 1er décembre 2010). Certes, le service de diffusion et de vente de livres d’Amazon.com n’a que peu de relation avec son service d’hébergement de sites, mais dans la mesure où un gouvernement peut ordonner la fermeture d’un site sur ses serveurs, comment assurer la neutralité du service de diffusion de livres de cette même multinationale ? Un gouvernement pourrait-il faire pression sur Elsevier-Science Direct si l’une des publications diffusées par ce groupe divulguait des données pouvant être censurées ?

L’accès gratuit

Pour ce qui concerne les services d’accès gratuit, comme le service d’archives ouvertes HAL, inscrit dans le cadre de l’Open Archive Initiative (OAI), l’accès aux productions scientifiques correspond bel et bien à une volonté de diffusion globale et libérée des contraintes économiques. Mais il ne s’agit que de l’accès à certaines productions, sous réserve de l’acceptation préalable des détenteurs des droits de diffusion que sont les revues, et uniquement si l’auteur accomplit la démarche.

Si HAL et les principes de l’OAI permettent aussi le dépôt de textes produits directement par leurs auteurs, et favorise en cela la diffusion par rapport à la publication, c’est une part importante des connaissances qui est effectivement en accès gratuit. Néanmoins, comment comprendre cette différence de traitement ? À qui appartiennent les connaissances ? À celui qui les produit, qui cède une partie de ses droits d’auteur (et justement ceux qui conditionnent la diffusion), ou à celui qui les diffuse et met à portée du public les moyens considérables auxquels nous accédons aujourd’hui grâce aux circuits numériques ? Si nous ajoutons à cela le besoin inconsidéré d’être évalué, d’améliorer le ranking des chercheurs et de publier dans les revues cotées, pouvons-nous raisonnablement croire que le dépôt spontané de la part des auteurs dans un système d’archives ouvertes rétablisse cette inégalité de traitement dans l’accès et la diffusion des connaissances ?

Le système de dépôt ArXiv.org reste pourtant un modèle5, car il est inscrit dans une certaine tradition de la communauté des chercheurs qui le fréquentent et y déposent presque systématiquement leurs productions. Il a ses limites, tout comme l’ensemble des initiatives d’accès gratuit aux ressources : aucun n’a de politique véritablement claire à propos du droit d’auteur.

Les politiques éditoriales

Le projet Sherpa est une source d’information très utile pour connaître les politiques éditoriales des maisons de publications. La liste Romeo, en particulier, recense les possibilités et les conditions de dépôt des productions dans un système d’archives ouvertes. Selon les revues et les conditions imposées par les éditeurs, il est possible pour un auteur d’archiver une version preprint ou postprint de son article. Un classement des revues par couleur (blanc, jaune, bleu et vert) signale les niveaux d’autorisation donnés aux auteurs afin qu’ils puisse disposer de leur travail après avoir toutefois cédé une partie de leurs droits d’auteur.

Le fait que la majorité des revues scientifiques aient des politiques de droit d’auteur différentes n’est guère surprenant. Outre les grandes revues classées dans les premiers rangs mondiaux, on trouve parfois des centaines de revues spécialisées selon les disciplines, apparaissant (et parfois disparaissant) selon la vie des communautés de chercheurs. Un peu d’histoire des sciences nous apprend que lorsqu’une discipline ou un champ d’étude apparaît, le fait que la communauté puisse disposer d’un espace de publication propre marque souvent les débuts d’une forme d’institutionnalisation de ce champ d’étude et, donc, une forme de reconnaissance par le reste de la communauté scientifique. La longévité et la fréquence de parution des revues peuvent être considérées comme des indicateurs de croissance de ce champ d’étude au cours de son histoire. Par conséquent, la multiplicité des revues, dans la mesure où se trouvent des groupes de chercheurs assez motivés pour les maintenir en termes de moyens techniques, humains et financiers, est plutôt un élément positif, signe d’une bonne santé de l’activité scientifique, et une forme de garantie démocratique de l’accès aux connaissances. Si toutes ces revues ont des politiques de droit d’auteur différentes c’est aussi parce qu’elles ont des moyens divers de subsistance, et, bien souvent, la seule vente des exemplaires papier ne suffit pas à couvrir les frais de publication.

Un autre élément qui conditionne en partie les politiques éditoriales, c’est le flux des publications scientifiques. Paradoxalement, le nombre actuel des revues ne saurait suffire à absorber les productions scientifiques toujours plus nombreuses6. Outre les phénomènes de compétitions entre pays, ce nombre est principalement dû aux politiques de recherche et à la culture de l’évaluation des chercheurs selon laquelle le nombre de publications est devenu un indicateur de qualité de la recherche, faute d’avoir des évaluateurs capables de (et autorisé à) juger précisément de la pertinence et de la valeur scientifique du contenu des publications. Or, ces politiques d’évaluation de la recherche impliquent pour les chercheurs la nécessité de publier dans des revues dont le classement, établi par ces mêmes évaluateurs, préjuge de la qualité scientifique du contenu.

Toutes les revues ne sont pas classées, à commencer par les petites revues connues dans les champs d’étude émergents et qui sont bien souvent les principaux supports de communication des recherches les plus novatrices et des nouvelles niches intellectuellement stimulantes. Finalement, les revues classées, et surtout celles qui disposent d’un classement élevé, ne peuvent absorber tout le flux des productions. Cette pression entre le flux et les capacités concrètes de publication implique une sélection drastique, par l’expertise (les reviewers ou referees), des articles acceptés à la publication. Comme cette sélection est la garantie a priori de la qualité, le classement se maintient alors en l’état. On comprend mieux, dès lors, pourquoi ces revues tiennent non seulement à ce que les auteurs leur cèdent leurs droits pour exploiter les contenus, mais aussi à ce que ces contenus soient le moins visibles ailleurs que dans leur propre système de publication et d’archivage. Nous revenons au problème de la centralisation.

Propriété et pénurie

Si nous mettons en perspective la croissance des publications scientifiques, le besoin d’évaluation, la nécessité (individuelle de la part des chercheurs, ou concurrentielle au niveau des universités et des pays) du ranking qui privilégie quelques revues identifiées au détriment des plus petites et discrètes, et l’appropriation des moyens de diffusion par les conglomérats du marché scientifique, nous assistons à l’organisation d’une pénurie maîtrisée de l’information scientifique.

J’évacue aussitôt un malentendu. Cette pénurie est maîtrisée dans le sens où l’information scientifique est en général toujours accessible, mais ce sont les conditions de cette accessibilité qui sont discutables.

Prenons un cas concret. Jstor (Journal Storage) est une organisation américaine à but non lucratif, fondée en 1995, dans le but de numériser et d’archiver les revues académiques. Créé pour permettre aux Universités de faire face à l’augmentation des revues, Jstor sous-traite l’accessibilité et le stockage de ces revues, assurant ainsi un rôle de gardien de la mémoire documentaire scientifique. Le coût de l’abonnement à Jstor est variable et ne figure certainement pas parmi les plus chers. En revanche, dans le cadre de l’archivage et des conditions d’accessibilité, des accords doivent se passer entre les revues détentrices des droits de publication et Jstor. Ainsi, la disponibilité des revues est soumise à une barrière mobile (moving wall) qui détermine un délai entre le numéro en cours de la revue et le premier numéro accessible en ligne. Quel que soit ce délai, un article scientifique devra toujours être payé : soit en achetant la revue au format papier, soit en achetant l’article au format électronique sur le site de la revue en question, soit en achetant un abonnement auprès de Jstor dans le cas où le numéro de la revue en question y est accessible.

Dans d’autres cas de figure, les articles scientifiques peuvent être trouvés et vendus au format numérique sur plusieurs espaces à la fois : sur le site de la revue, sur un site de rediffusion numérique (comme par exemple le service Cat.Inist du CNRS), ou en passant par le service d’abonnement d’une institution (Jstor, Elsevier…).

Jamais auparavant on n’avait assisté à une telle redondance dans l’offre de publication du marché scientifique. En conséquence, surtout avec l’arrivée du service de vente d’articles à l’unité, jamais le marché de la publication scientifique n’a obtenu un tel chiffre d’affaire. Est-ce synonyme d’abondance ? Pas vraiment. L’inégalité de traitement entre les revues est toujours un obstacle qui prive les nombreuses petites revues (qui peuvent toutefois être célèbres mais dont le marché n’a bien souvent qu’une dimension nationale) de participer à l’offre. Dans la plupart des cas, les articles scientifiques publiés dans ces conditions sont donc archivés d’une manière ou d’une autre, mais sur un marché séparé, parfois sur le site internet propre à la revue, parfois sur les serveurs d’un regroupement non lucratif de revues, géré la plupart du temps par des institutions publiques, comme par exemple Revues.org.

Par ailleurs, un autre obstacle est préoccupant : le temps de latence variable d’une revue à l’autre entre la publication papier et l’accès aux versions numériques. Ce temps de latence est dû à deux écueils qu’il me faut maintenant longuement développer.

Le premier est la conception rigide que l’on a du format numérique, à savoir que la version numérique d’un document est considérée comme une copie de la version papier. Ce n’est pas le cas. Fort heureusement, la plupart des maisons d’éditions l’ont compris : un article peut être mis sous format HTML, avec un rendu dynamique des liens et de la bibliographie, par exemple, ce qui lui apporte une dimension supplémentaire par rapport à la version papier. Or, c’est cette conception du document-copie numérique qui prime, par exemple, dans le cas de Jstor, ou encore dans celui de certains projets de numérisation de la BNF, car l’objectif est d’abord de stocker, centraliser et d’ouvrir l’accès. Certes, la numérisation de fonds anciens ne peut transformer les articles en pages dynamiques (quoique les récentes avancées dans le domaine de la numérisation de fonds tendrait à montrer le contraire). En revanche pour les numéros plus récents, qui de de toute façon ont été rédigés de manière électronique par leurs auteurs, la barrière mobile implique bien souvent que pendant quelques années un article ne sera disponible qu’au format papier alors que rien ne l’y contraint techniquement. Cela représente une perte considérable dans notre monde numérique ! Dans le cas d’une revue bi-annuelle à faible tirage, il devient très difficile de se procurer un numéro un ou deux ans après sa parution (phénomène qui pourrait être mieux contrôlé avec les systèmes d’impression à la demande dont il sera question plus tard). Et il faut attendre sa mise à disposition sur Internet (gratuitement ou non), pour que cet article touche enfin le potentiel immense du nombre de lecteurs à travers le monde…à ceci près qu’il y a toujours un temps de latence et qu’en moins de deux ans, un article peut voir très vite son intérêt scientifique diminuer, et avec lui l’intérêt de la mise en ligne, si ce n’est uniquement pour son archivage. Ce temps de latence, cette barrière mobile , peut très facilement disparaître pour peu que l’on s’interroge sur le réel intérêt de la cession des droits d’auteur (de diffusion) des articles scientifiques.

C’est ce qui m’amène au second écueil : la question des droits d’auteur et de diffusion. Pour qu’une revue papier soit rentable, ou du moins qu’elle résiste à la pression entre l’investissement et les frais de fonctionnement, il faut qu’elle puisse vendre un certain nombre de copies. Pour que cette vente puisse se faire, tout le monde part du principe que les auteurs doivent céder une partie de leurs droits à l’éditeur (une cession exclusive). Avec l’apparition des licences libres de type Creative Commons, nous verrons que ce n’est nullement là une condition nécessaire. L’autre aspect de cette cession de droit est que l’auteur ne peut plus disposer de son travail (son œuvre) comme il l’entend. La diffusion de cette œuvre est donc soumise à la politique éditoriale de la revue qui ne s’engage pas obligatoirement à en garantir l’accessibilité numérique. En revanche, la cession des droits permet aux revues de réaliser une plus-value supplémentaire dans le cadre de la diffusion numérique, par exemple en passant des accords avec un grand distributeur de revues électroniques. Là encore, le biais est à redouter dans la mesure où les abonnements ont un coût bien souvent prohibitif pour les institutions qui les payent, ce qui fait souvent l’objet de discussions serrées.

Avec l’émergence des premiers périodiques électroniques, les éditeurs ont massivement investi dans l’économie numérique, en répercutant ces coûts sur les abonnements. Pour donner un exemple, le prix annoncé par l’Université de Poitiers pour un abonnement à Elsevier-Science Direct est de 37556 euros pour l’année 2007, un coût apparemment raisonable mais qui ne cesse d’augmenter et doit être multiplié par le nombre d’abonnements différents d’une même université7. Pour pallier ces frais toujours croissants les institutions se sont organisées en consortia, de manière à mutualiser ces coûts. Mais cela ne vaut que pour les groupements capables de faire face aux éditeurs. En effet, certains pays se heurtent à une réduction des fonds publics dédiés à la recherche, et d’autres pays, comme ceux en voie de développement, n’ont bien souvent pas les moyens de payer ces abonnements. En fait, il y a là encore une différence de traitement dans l’accès à l’information scientifique, et sans doute la plus révoltante : dans la mesure où l’accès aux ressources numériques représente bien davantage, d’un point de vue technique et de traitement de l’information, qu’un simple accès à un abonnement papier , comment peut-on concevoir qu’une partie loin d’être négligeable des informations scientifiques sous forme électronique puisse ne pas être accessible à certaines parties du monde ? Et au sein d’un même pays, comment accepter qu’il puisse exister une inégalité d’accès entre les différentes institutions, entre celles qui ont les moyens financiers suffisants et les autres, ou entre celles qui, faisant partie de tel consortia, n’ont pas accès aux mêmes revues que les autres ?

Certes, on me rétorquera que les abonnements aux revues papier ont toujours été chers eux aussi, de même que le stockage de ces revues. Ce à quoi je réponds :

-