12.10.2018 à 02:00

Archéologie du capitalisme de surveillance

Avec le temps, cela devait finalement arriver. Me voici embarqué dans l’écriture d’un ouvrage à paraître chez C&F Éditions au printemps prochain. Une archéologie du capitalisme de surveillance, rien que cela. Mais c’est garanti, je ne me prendrai pas pour un penseur post-moderne (ils avaient tort !).

De quoi cet ouvrage va-il parler? D’abord le titre est tout à fait provisoire, qu’on se le dise. C’était juste pour vous faire cliquer ici. Blague à part, voici un petit argumentaire qui, je l’espère pourra vous faire patienter les quelques mois qui nous séparent d’une publication…

Christophe Masutti, Archéologie du capitalisme de surveillance, Caen, C&F Éditions, 2019 (à paraître).

Argumentaire

L’expression « capitalisme de surveillance » est employée le plus souvent non comme un concept mais comme un dénominateur, c’est-à-dire de l’ordre de la perception des phénomènes, de ceux qui nous font tomber de nos chaises presque tous les jours lorsque nous apprenons à quels trafics sont mêlées nos données personnelles. Mais il n’a pas été défini pour cela : son ambition est surtout d’être un outil, une clé de lecture pour comprendre la configuration politique et sociale de l’économie de la surveillance. Il faut donc mettre à l’épreuve ce concept et voir dans quelle mesure il permet de comprendre si l’économie de la surveillance obéit ou non à une idéologie, au-delà des pratiques. Certes, il faut donner une définition du capitalisme de surveillance (idéologique, pratique, sociale, collective, culturelle, anthropologique ou politique), mais il faut surtout en comprendre l’avènement.

Je propose dans ce livre une approche historique qui commence par une lecture différente des révolutions informatiques depuis les années 1960. Comment vient la surveillance? comment devient-elle un levier économique ? Il faut contextualiser la critique du contrôle (en particulier par les philosophies post-modernes et les observateurs des années 1970) telle qu’elle s’est faite dans la continuité de la révolution informatique. On peut focaliser non pas sur l’évolution technologique mais sur le besoin d’information et de traitement de l’information, tout particulièrement à travers des exemples de projets publics et privés. L’informatisation est un mouvement de transformation des données en capital. Cet ouvrage sera parsemé d’études de cas et de beaucoup de citations troublantes, plus ou moins visionnaires, qui laissent penser que le capitalisme de surveillance, lui aussi, est germinal.

Qu’est-ce qui donne corps à la société de la surveillance ? c’est l’apparition de dispositifs institutionnels de vigilance et de régulation, poussés par un débat public, politique et juridique, sur fond de crainte de l’avènement de la société de 1984. C’est dans ce contexte qu’au sein de l’appareillage législatif germèrent les conditions des capacités de régulation des institutions. Néanmoins la valorisation des données, en tant que propriétés, capitaux et composantes stratégiques, fini par consacrer l’économie de la surveillance comme modèle unique. Le marketing, la modélisation des comportements, la valeur vie client : la surveillance devient une activité prédictive.

Le capitalisme de surveillance est-il une affaire culturelle ? On peut le concevoir comme une tendance en économie politique, ainsi que les premiers à avoir défini le capitalisme de surveillance proposent une lecture macro-politico-économique (John Bellamy Foster, Robert W. McChesney, 2014). On peut aussi se concentrer sur les pratiques des firmes comme Google et plus généralement sur les pratiques d’extraction et de concentration des big datas (Shoshana Zuboff, 2018). On peut aussi conclure à une forme de radicalité moderne des institutions dans l’acceptation sociale (collective ?) de ce capitalisme de surveillance (on se penchera notamment sur les travaux d'Anthony Giddens puis sur ceux de Bernard Stiegler). Que peut-on y opposer ? Quels choix ? À partir du constat extrêmement sombre que nous allons dresser dans cet ouvrage, peut-être que le temps est venu d’un mouvement réflexif et émancipateur.

03.08.2018 à 02:00

Algorithmes: la bombe à retardement

Qui choisit votre université ? Qui vous accorde un crédit, une assurance, et sélectionne vos professeurs ? Qui influence votre vote aux élections ? Ce sont des formules mathématiques. Ancienne analyste à Wall Street devenue une figure majeure de la lutte contre les dérives des algorithmes, Cathy O’Neil dévoile ces « armes de destruction mathématiques » qui se développent grâce à l’ultra-connexion et leur puissance de calcul exponentielle. Brillante mathématicienne, elle explique avec une simplicité percutante comment les algorithmes font le jeu du profit. Cet ouvrage fait le tour du monde depuis sa parution. Il explore des domaines aussi variés que l’emploi, l’éducation, la politique, nos habitudes de consommation. Nous ne pouvons plus ignorer les dérives croissantes d’une industrie des données qui favorise les inégalités et continue d’échapper à tout contrôle. Voulons-nous que ces formules mathématiques décident à notre place ? C’est un débat essentiel, au cœur de la démocratie.

O’Neil, Cathy. Algorithmes: la bombe à retardement, les Arènes, 2018.

Lien vers le site de l’éditeur : http://www.arenes.fr/livre/algorithmes-la-bombe-a-retardement/

31.07.2018 à 02:00

Cyberstructure

Les outils de communication ont d’emblée une dimension politique : ce sont les relations humaines, les idées, les échanges commerciaux ou les désirs qui s’y expriment. L’ouvrage de Stéphane Bortzmeyer montre les relations subtiles entre les décisions techniques concernant l’Internet et la réalisation — ou au contraire la mise en danger — des droits fondamentaux. Après une description précise du fonctionnement de l’Internet sous les aspects techniques, économiques et de la prise de décision, l’auteur évalue l’impact des choix informatiques sur l’espace politique du réseau. Un ouvrage pour appuyer une citoyenneté informée, adaptée aux techniques du XXIe siècle et en mesure de défendre les droits humains

Bortzmeyer, Stéphane. Cyberstructure: l’internet, un espace politique. C&F éditions, 2018.

Lien vers le site de l’éditeur : https://cyberstructure.fr/

24.06.2018 à 02:00

Capitalisme de surveillance ?

Dans une série d’article intitulée Les Léviathans, j’ai longuement présenté le concept de capitalisme de surveillance développé par Shoshana Zuboff. L’interprétation reste toujours prisonnière de l’objet, au moins en partie : en l’occurrence, il y a une chose que je n’ai pas précisé dans ces articles, c’est la provenance du concept.

Les premiers à avoir formulé et développé le capitalisme de surveillance sont John Bellamy Foster et Robert W. McChesney en juin 2014 dans un article paru dans la Monthly Review, dont le titre devrait toujours être donné in extenso : « Surveillance Capitalism Monopoly-Finance Capital, the Military-Industrial Complex, and the Digital Age ».

Les lecteurs de Shoshana Zuboff noteront que cette dernière ne fait pas mention, dans ses articles, à la paternité du concept par Foster et McChesney. Du moins, elle n’a pas publié (à ma connaissance) une approche critique et comparative de son approche par rapport à celle de Foster et McChesney. La conséquence est que, au fil des affaires relatives aux usages déloyaux des données personnelles durant ces 3 ou 4 dernières années, le concept de capitalisme de surveillance a été sur-employé, parfois même galvaudé et transformé en un mot-valise. Pour celles et ceux qui ont cependant fait un effort d’analyse (tel Aral Balkan) le concept renvoie systématiquement aux travaux de Shoshana Zuboff.

Oserait-on accuser Zuboff de l’avoir usurpé ? pas tout à fait. On peut parler plutôt d’un emprunt. Le capitalisme de surveillance tel que le défini Zuboff implique bien d’autres éléments de réflexion. Quant à citer les auteurs qui les premiers ont énoncé le capitalisme de surveillance, oui, elle aurait pu le faire. Mais qu’est-ce que cela aurait impliqué ? L'éditorial de la Monthly Review de ce mois de juin 2018 apporte quelques éléments de réponse en confrontant l’approche de Foster-McChesnay et de Zuboff :

Zuboff a défini le capitalisme de surveillance de manière plus restrictive comme un système dans lequel la surveillance de la population est utilisée pour acquérir des informations qui peuvent ensuite être monétisées et vendues. L’objet de ses recherches était donc d’étudier les interrelations entre les entreprises et le comportement individuel dans ce nouveau système d’espionnage marchandisé. Mais une telle vision a effectivement dissocié le capitalisme de surveillance de l’analyse de classe, ainsi que de la structure politico-économique globale du capitalisme – comme si la surveillance pouvait être abstraite du capital monopolistique et financier dans son ensemble. De plus, l’approche de Zuboff a largement éludé la question de la relation symbiotique entre les sociétés militaires et privées – principalement dans les domaines du marketing, de la finance, de la haute technologie et de la défense – qui était au centre de l’analyse de Foster et McChesney.

Pour ce qui me concerne, les lecteurs des Léviathans (et j’espère un peu plus tard d’un ouvrage actuellement en gestation) pourront constater que j’extrapole assez largement la pensée de Zuboff, sans toutefois rejoindre l’analyse américano-centrée de Foster-McChesnay. Le point de basculement est somme toute assez pragmatique.

Le besoin de surveillance est un besoin viscéral de l’économie des biens et services (j’ai montré qu’il relève d’une histoire bien plus ancienne que le web 2.0 et remonte aux années 1950). La concentration des entreprises répond à un besoin d’optimisation des systèmes d’informations autant qu’au besoin de maîtriser le marché en le rendant malléable selon des stratégies bien définies, à commencer par les pratiques de marketing. Comment est-il devenu malléable ? grâce aux big datas et à l’usage prédictif du traitement des données. La concentration des capitaux est donc à la fois une conséquence de ce nouveau mode de fonctionnement capitaliste (qui enclenche parallèlement une autre approche du (néo-) libéralisme), et une stratégie calculée de recherche de maximisation des profits tirés des données conçues elles-mêmes comme un capital.

À mon humble avis, nonobstant l’approche concernant le complexe militaro-industriel de Foster-McChesney qui nous fait remonter à la Guerre du Vietnam tout en étant parfaitement explicatif des stratégies de surveillance des institutions gouvernementales (auxquelles finirent par se prêter les gouvernements d’autres pays du monde, comme en France ces dernières années), l’approche de Zuboff détache effectivement la question du capitalisme de surveillance de ses racines politiques pour se concentrer surtout sur les organisations et les comportements individuels soumis à une idéologie presque exclusivement économique. Ma part modeste à cette réflexion n’est pas d’entamer une histoire totale comme le feraient Foster et McChesney, mais d’aller directement au cœur du problème : la capitalisation de l’information comme nouvelle forme du capitalisme. C’est peut-être une approche (pseudo-) marxiste qu’il manque selon moi à Foster-McChesney pour mieux comprendre cette mondialisation du capitalisme de surveillance.

21.05.2018 à 02:00

Capitalisme de plateforme

Google et Facebook, Apple et Microsoft, Siemens et GE, Uber et Airbnb : les entreprises qui adoptent et perfectionnent le modèle d’affaires dominant aujourd’hui, celui des plateformes pair-à-pair du capitalisme numérique, s’enrichissent principalement par la collecte de données et le statut d’intermédiaire qu’il leur confère. Si elles prospèrent, ces compagnies peuvent créer leur propre marché, voire finir par contrôler une économie entière, un potentiel monopolistique inusité qui, bien qu’il s’inscrive dans la logique du capitalisme dit « classique », présente un réel danger aux yeux de quiconque s’applique à imaginer un futur postcapitaliste. Dans ce texte bref et d’une rare clarté, Nick Srnicek retrace la genèse de ce phénomène, analyse celui-ci de manière limpide et aborde la question de son impact sur l’avenir. Un livre essentiel pour comprendre comment les GAFA et autres géants du numérique transforment l’économie mondiale, et pour envisager des pistes d’action susceptibles d’en contrer les effets délétères.

Srnicek, Nick. Capitalisme de plateforme. L’hégémonie de l’économie numérique, Lux Éditeur, 2018.

Lien vers le site de l’éditeur : https://www.luxediteur.com/catalogue/capitalisme-de-plateforme/

01.05.2018 à 02:00

LibreOffice Writer, c'est stylé!

En ce début de printemps 2018, voici une traduction et adaptation d’un manuel sur LibreOffice Writer et (surtout) les styles ! LibreOffice Writer, c’est stylé! est une publication Framabook. Il s’agit d’un projet de longue date, que j’ai le plaisir de voir aboutir, enfin !

Halte aux manuels bourrés de procédures qui transforment les logiciels en cliquodromes. Pour changer, laissez-vous guider vers la compréhension des règles de mise en page et de la typographie, à travers l’usage des styles dans LibreOffice Writer. L’objectif est de vous aider à vous concentrer sur le contenu de vos documents, gagner en rapidité et en précision, tout en vous formant à l’automatisation de la mise en forme.

Cet ouvrage s’adresse aux utilisateurs débutants mais ayant déjà fréquenté un logiciel de traitement de texte. Quels choix de polices et d’interlignage devez-vous faire ? Comment créer des styles et les enchaîner correctement ? À quoi servent les styles conditionnels ? Paragraphes, listes, tableaux, titres, et hiérarchie des styles, toutes ces notions n’auront plus de secret pour vous. Voici un aperçu unique de LibreOffice Writer, de ses fonctionnalités importantes et de ses capacités.

Vous pouvez acheter, télécharger, consulter librement cet ouvrage sur Framabook.org.

20.04.2018 à 02:00

Justice digitale

Remplacement des avocats par des robots, disparition des notaires, résolution des conflits en ligne, justice prédictive, état civil tenu par la blockchain, généralisation des contrats en bitcoins échappant à tout contrôle (et à toute taxation) : le numérique n’en finit pas de bouleverser la justice en inquiétant les uns et en enthousiasmant les autres. Plutôt que de proposer un bilan de ces innovations, nécessairement prématuré, ce livre tente de situer l’épicentre anthropologique d’une déflagration provoquée par l’apparition d’une nouvelle écriture qu’il faut bien désigner comme une révolution graphique. La justice digitale alimente un nouveau mythe, celui d’organiser la coexistence des hommes sans tiers et sans loi par un seul jeu d’écritures, au risque d’oublier que l’homme est un animal politique.

Garapon, Antoine, et Jean Lassègue. Justice digitale. Révolution graphique et rupture anthropologique. PUF, 2018.

Lien vers le site de l’éditeur : https://www.puf.com/content/Justice_digitale

31.03.2018 à 02:00

Utopie du logiciel libre

Né dans les années 1980 de la révolte de hackers contre la privatisation du code informatique, le mouvement du logiciel libre a peu à peu diffusé ses valeurs et ses pratiques à d’autres domaines, dessinant une véritable « utopie concrète ». Celle-ci a fait sienne plusieurs exigences : bricoler nos technologies au lieu d’en être les consommateurs sidérés, défendre la circulation de l’information contre l’extension des droits de propriété intellectuelle, lier travail et accomplissement personnel en minimisant les hiérarchies. De GNU/Linux à Wikipédia, de la licence GPL aux Creative Commons, des ordinateurs aux imprimantes 3D, ces aspirations se sont concrétisées dans des objets techniques, des outils juridiques et des formes de collaboration qui nourrissent aujourd’hui une nouvelle sphère des communs. Dans cette histoire du Libre, les hackers inspirent la pensée critique (d’André Gorz à la revue Multitudes) et les entrepreneurs open source côtoient les défenseurs des biens communs. De ce bouillonnement de pratiques, de luttes et de théories, l’esprit du Libre émerge comme un déjà là propre à encourager l’inventivité collective. Mais il est aussi un prisme pour comprendre comment, en quelques décennies, on est passé du capitalisme de Microsoft – la commercialisation de petites boîtes des biens informationnels protégés par des droits de propriété intellectuelle – au capitalisme numérique des Gafa (Google, Amazon, Facebook, Apple), fondé sur l’exploitation de nos données et la toute puissance des algorithmes.

Broca, Sébastien. Utopie du logiciel libre. Éditions le Passager clandestin, 2018.

Lien vers le site de l’éditeur : http://lepassagerclandestin.fr/catalogue/poche/utopie-du-logiciel-libre.html

31.03.2018 à 02:00

Sur quoi reposent nos infrastructures numériques ?

Aujourd’hui, la quasi-totalité des logiciels couramment utilisés sont tributaires de code dit « open source », créé et maintenu par des communautés composées de développeurs et d’autres talents. Ce code peut être repris, modifié et utilisé par n’importe qui, entreprise ou particulier, pour créer ses propres logiciels. Partagé, ce code constitue ainsi l’infrastructure numérique de la société d’aujourd’hui… dont les fondations menacent cependant de céder sous la demande !

En effet, dans un monde régi par la technologie, qu’il s’agisse des entreprises du Fortune 500, du Gouvernement, des grandes entreprises de logiciel ou des startups, nous sommes en train d’accroître la charge de ceux qui produisent et entretiennent cette infrastructure partagée. Or, comme ces communautés sont assez discrètes, les utilisateurs ont mis longtemps à en prendre conscience.

Tout comme l’infrastructure matérielle, l’infrastructure numérique nécessite pourtant une maintenance et un entretien réguliers. Face à une demande sans précédent, si nous ne soutenons pas cette infrastructure, les conséquences seront nombreuses.

L’entretien de notre infrastructure numérique est une idée nouvelle pour beaucoup, et les problèmes que cela pose sont mal cernés. Dans cet ouvrage, Nadia Eghbal met au jour les défis uniques auxquels sont confrontées les infrastructures numériques et comment l’on peut œuvrer pour les relever.

Eghbal, Nadia. Sur quoi reposent nos infrastructures numériques ?, Lyon, Framasoft & Open Editions, 2017.

Lien vers le site de l’éditeur : https://framabook.org/sur-quoi-reposent-nos-infrastructures-numeriques/

31.03.2018 à 02:00

Le travail invisible des données

Ouvertes, massives, brutes… les données sont aujourd’hui au coeur de nombreux débats. Les optimistes y voient une ressource naturelle dont la récolte et la circulation sont en passe de révolutionner l’innovation et la démocratie, tandis que les pessimistes les dépeignent comme le carburant de mécanismes qui ne profiteront qu’aux puissants et renforceront les inégalités. Face aux enthousiasmes et aux affolements, face au vocabulaire de la transparence, de la fluidité et de l’automatisation qu’ils mobilisent, ce livre fait un pas de côté et défend la nécessité d’étudier les modalités concrètes de la production et de la circulation des données. Les données ne tombent en effet jamais du ciel. Elles n’affleurent pas non plus sous le sol des organisations. En amont de leurs traitements si prometteurs ou inquiétants, elles font l’objet d’un travail dont la nature, l’organisation et les processus mêmes qui mènent à son invisibilité restent à explorer. En articulant les apports de la sociologie des sciences et des techniques, de l’histoire, de l’anthropologie de l’écriture, de la sociologie du travail et des accounting studies, l’ouvrage compose un outillage conceptuel et méthodologique original pour interroger au plus près ce travail des données, qui est devenu central dans les entreprises et les administrations à partir de la fin du XIXe siècle.

Denis, Jérôme, et Delphine Gardey. Le travail invisible des données. Éléments pour une sociologie des infrastructures scripturales. Presses des Mines - Transvalor, 2018.

Lien vers le site de l’éditeur : https://www.pressesdesmines.com/produit/le-travail-invisible-des-donnees/

24.03.2018 à 01:00

Vie privée, informatique et marketing dans le monde d'avant Google

En 1969, Paul Baran affirmait: « Quelle belle opportunité pour l’ingénieur informaticien d’exercer une nouvelle forme de responsabilité sociale ». En effet, il y a presque 70 ans, les interrogations sociales au sujet du traitement informatique des données personnelles étaient déjà sur le devant de la scène.

Voici le résumé d’un assez long texte, écrit début mars 2018, que vous pouvez lire en version HTML ou récupérer en PDF sur HAL-SHS.

Il est notable que les monopoles de l’économie numérique d’aujourd’hui exploitent à grande échelle nos données personnelles et explorent nos vies privées. Cet article propose une mise au point historique sur la manière dont se sont constitués ces modèles : dès les années 1960, par la convergence entre l’industrie informatique, les méthodes de marketing (en particulier le marketing direct) et les applications en bases de données. Les pratiques de captation et d’exploitation des données personnelles ont en réalité toujours été sources de débats, de limitation et de mises en garde. Malgré cela, le contrôle social exercé par la segmentation sociale, elle-même imposée par le marketing, semble être une condition de l’avènement d’une forme d’économie de la consommation que de nombreux auteurs ont dénoncé. Peut-on penser autrement ce capitalisme de surveillance ?

05.02.2018 à 01:00

Club Vosgien et VTT : l'appropriation des communs

Chacun ses combats. Pour moi, c’est le logiciel libre et la culture libre, pour d’autres c’est la lutte contre les inégalités, la défense de la nature, la sauvegarde du patrimoine… Et pourtant nous agissons tous avec des méthodes communes : le partage et la coopération. Hélas ce n’est pas toujours le cas. Certains œuvrent pour une cause juste mais veulent s’approprier le résultat, au prétexte qu’ils seraient les dépositaires (même s’ils ne sont pas exclusifs) des moyens et, donc, de la fin. C’est le cas du Club Vosgien dont je voudrais ici toucher quelques mots à propos de sa capacité à partager et à collaborer.

La montagne est au Club

Le Club Vosgien, c’est d’abord une association alsacienne séculaire. Fondée en 1872, le Vogesenclub doit d’abord être salué avec le plus grand respect pour le travail de promotion des activités de pleine nature et le balisage des sentiers sans lequel nombre de promeneurs ne pourraient bénéficier des superbes parcours sur l’ensemble du massif, et au-delà.

Ceci étant dit, j’affirme que le Club Vosgien à une tendance particulièrement détestable à s’approprier le bien commun que représente le paysage montagneux et forestier.

S’approprier ? non, bien entendu, il ne s’agit pas de mettre des barrières et d’interdire quiconque de les franchir s’il n’est pas encarté au Club… Mais justement, le Club Vosgien, comprenez-vous, ce n’est pas l’Association des amoureux des sentiers des Vosges, ce n’est pas l’Association des randonneurs vosgiens, non. C’est un Club, à l’image du Club Alpin d’où il tire son nom d’ailleurs. Et un club, c’est plus qu’une association. Ce n’est pas uniquement le rassemblement de personnes ayant des intérêts communs. Un club est une société, c’est-à-dire un regroupement de personnes sociologiquement semblables : des activités communes, des pratiques sociales communes, etc. Dès lors, il n’y a qu’un pas facilement franchi entre la communauté de pratiques et le sentiment d’appartenance du territoire que l’on investit.

Voici un exemple. Au début du XXe siècle, le Club Vosgien s’est vu confier, par le Service des Eaux et Forêts le monopole du balisage des sentiers. L’explication est logique : fin XIXe siècle se développe dans les Vosges l’activité touristique. En 1875, par exemple à Gérardmer naît le premier office de tourisme, nommé Comité des promenades qui aménage des sentiers de randonnées dans la Vallées des Lacs et valorise son territoire. Sur le même modèle, les sociétés touristiques investissent le massif : il fallait harmoniser tout cela et c’est le Club Vosgien qui se vit confier ce rôle. Depuis ce jour, le Club Vosgien mène de front le balisage et l’entretien des sentiers.

Ainsi, fièrement annoncé sur la page d’accueil du site internet du Club Vosgien :

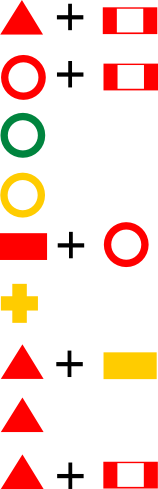

Les signes de balisage du Club Vosgien sont déposés à l’INPI et soumis à autorisation pour leur utilisation sur tous supports de communication papier ou web.

En clair, les signes de balisage du Club Vosgien sont déposés en tant que logo de marque (ce n’est pas un brevet au sens industriel du terme), et il est donc impossible d’en avoir l’usage sans une autorisation expresse du Club Vosgien. C’est le premier paradoxe : un balisage harmonisé est un gage de qualité des parcours du Massif, et si je souhaite cartographier un parcours, par exemple pour le VTT ou le trail, et partager ma carte, je n’ai le droit de le faire qu’avec l’autorisation du Club Vosgien. Un comble, quand on sait à quel point ce besoin est présent.

L’implication ? le Club Vosgien empêche ainsi le partage des parcours, ce qui aurait pourtant comme effet de valoriser encore davantage cet important travail de balisage du Club Vosgien. Si j’appartiens à une association sportive et que je souhaite créer un parcours en utilisant le balisage du Club Vosgien et partager ce parcours en imprimant plusieurs cartes ou sous format numérique, je n’ai pas le droit de le faire.

L’interprétation ? Randonner avec le Club Vosgien, c’est utiliser son balisage et les cartes qui vont avec : la bonne vieille carte IGN TOP 25 en papier ou son équivalent extrêmement onéreux sur GPS. Il ne s’agirait pas que n’importe qui vienne improviser un parcours VTT ou trail pour déranger les « vrais » randonneurs à crampons et sac à dos, n’est-ce pas ? Parce que si tout le monde pouvait si facilement se repérer dans la forêt, et pouvait partager en ligne des cartes en utilisant, au hasard les couches Outdoors d'Open Street Map et les indicateurs du Club Vosgien… hé bien qu’est-ce que cela changerait, au fond ? Rien. Si ce n’est que l’usage en serait d’autant plus valorisé. Mais voilà : le Club Vosgien ne veut pas. Parce que ce sont ses sentiers, c’est son balisage, le fruit de son travail, qui lui incombe à lui uniquement.

C’est l’ambiance. Et cela va même jusqu’à servir d’arguments contre l’usage des VTT, comme on va le voir plus loin.

Le cas du VTT

Les cyclistes, c’est le combat du moment pour le Club Vosgien… enfin pour être plus exact, quelques sections du Club Vosgien, minoritaires, mais dont le vacarme implique forcément l’image du Club Vosgien en général. En effet, en plus du balisage, l’entretien de ses parcours est capital pour que le balisage soit lui-même fiable. Et c’est là que le Club Vosgien a tendance à étendre sa préséance, à ceci près que cette fois on touche au territoire.

Dans les forêts vosgiennes, on trouve de tout :

- des quads avec des gros lards dessus,

- des motocyclistes, sportifs, mais à qui il faudrait expliquer deux trois choses,

- des files de 4x4 avec des chasseurs souvent seuls dedans (il faudrait leur expliquer ce que c’est que le co-voiturage),

- des 4x4 isolés, dont les trajectoires restent mystérieuses,

- des travailleurs forestiers parfois (parfois !) peu respectueux de la forêt (mais comme il manque de personnels aux Eaux et Forêts, il est difficile de faire respecter l’ordre et la loi),

- et des cyclistes.

La ligne de front actuelle qui défraye la chronique depuis au moins le printemps 2017, se situe dans le secteur de Masevaux (Haut-Rhin), mais ce n’est pas exclusif. Devinez quelle catégorie dans la liste ci-dessus fait l’objet de l’ire des membres du Club Vogien ? je vous le donne en mille : les vététistes.

Pour certains membres du Club Vosgien, visiblement, les vététistes représentent l’ennemi à abattre, voire même la principale calamité du paysage Vosgien. On pourrait croire que des combats autrement plus glorieux pourraient voir le jour, comme par exemple la biodiversité végétale, la gestion de la faune, la pollution. Non. Parce que vous comprenez, ça c’est des trucs d’écolos. Ces combats sont déjà investis et puis les écolos c’est à gauche…

Ce qui chiffonne ces gens, c’est que les sentiers avec des VTT dessus, c’est plus des sentiers de randonnées. Parce qu’un sentier, c’est forcément « de randonnée à pieds », hein ? pas fait pour rouler, jouer au ballon, ou même courir (quel traileur ne s’est pas ramassé un jour une remarque désobligeante par un randonneur peureux sur un chemin un peu étroit ?).

Interdire le VTT sur les sentiers du massif ? c’est un projet que certains membres du club Vosgien semblent caresser avec envie. Des municipalités, sans doute sous influence, avaient déjà tenté le coup, comme à Ottrott en 2015 avant une contestation en bonne et dûe forme par la Mountain Bike Foundation qui rappelle d’ailleurs quelques fondamentaux juridiques à propos du code forestier (un autre guide juridique est trouvable sur le site alsace-velo.fr).

Bref, voilà que le Club Vosgien de Masevaux a relancé une polémique en mai 2017, bénéficiant d’une tribune dans les Dernières Nouvelles d’Alsace : « La montagne n’est pas un stade ». L’accroche ? elle se résume en trois points :

- La dégradation des sentiers serait l’apanage exclusif des VTT… et de se lancer dans une problématique digne de l’oeuf ou de la poule à savoir si ce sont les freinages des vététistes qui aggravent l’érosion naturelle ou si c’est l’érosion naturelle qui cause l’instabilité du chemin et donc nécessite des freinages. Car dans le premier cas, il faudrait peut-être cesser de croire que les vététistes s’amusent à détériorer les chemins pour le plaisir et dans l’autre cas, les problèmes d’érosion ont bien souvent leur remède dans la gestion du couvert végétal. Est-ce pour autant que tous les sentiers devraient être interdits aux VTT ? Comment s’effectue donc cette généralisation entre quelques chemins érodés et tous les sentiers ? Elle ne peut s’expliquer autrement que par le souhait de ne plus voir de VTT sur les chemins parce qu’ils « dérangent » le Club Vosgien, parce qu’il s’agit d’un public différent.

- « le code forestier article n° 163-6, interdit la pratique du VTT sur des itinéraires de moins de deux mètres », c’est faux, comme le montre le code forestier lui-même (cf. les liens cités plus haut).

- On notera de même que le chantage est à l’appui : « Soit les communes nous suivent par des arrêtés de réglementation de circulation qui interdit la pratique du VTT sur les sentiers, soit on arrête de faire l’entretien basique (piochage, élagage, ratissage) et en cinq ans les sentiers seront morts ». Une citation bien paradoxale de la part du Club Vosgien, parce que la mort des sentiers signerait aussi la mort du Club…

Enfin, comme le démontrent de nombreuses photographies prises par les vététistes et les randonneurs, on ne compte plus sur le massif vosgien le nombre de sentiers littéralement saccagés par les travaux forestiers. À juste titre ou non, pour les besoins de l’exploitation forestière, le passage d’engins favorise inévitablement une forme d’érosion bien plus grave que le creusement d’une rigole de 20 mètres ici où là : c’est carrément de la gestion forestière raisonnée qu’il s’agit, et cela dépasse de loin les petites polémiques.

Et pourtant, le Club Vosgien a déjà dénoncé les travaux forestiers peu scrupuleux, notamment dans les pages des Dernières Nouvelles d’Alsace en mars 2017. L’enjeu est de taille et le combat mérite en effet d’être mené car il concerne de multiples acteurs… hélas, il est bien plus facile d’incriminer les VTT. Si bien qu’une seconde fois en ce début d’année 2018 le journal Les Dernières Nouvelles d’Alsace titrait « Les sentiers de la discorde ». L’article est à l’avenant, et, citant les interlocuteurs du Club Vosgien :

Nous ne sommes pas des conservateurs à tendance réactionnaire, l’avenir passe par une bonne cohabitation avec les pratiquants tout en intégrant le respect de la réglementation. Le VTT étant un véhicule sur le plan juridique, le vttiste doit pratiquer en dehors de nos sentiers étroits, inférieurs à un mètre.

Comprendre : « je ne suis pas réac… mais », ou bien ce qu’on appelle en réthorique une prétérition, qui permet de passer sous silence plusieurs éléments manquant à l’argumentation : ici, par exemple, la rigueur de l’argumentation juridique. Ce qui ne démonte pas la Mountain Bike Foundation, répondant du tac au tac :

« Le code de la route ne s’applique pas à 900 m d’altitude », affirme Jonathan Choulet, référent MBF Florival, par ailleurs fonctionnaire de police. « Le droit d’itinérance sur les sentiers relève du droit constitutionnel d’aller et venir. Quatre codes régissent la circulation de tous en milieu naturel, mais aucun, excepté le code de la route, ne définit le VTT comme un véhicule. (…) »

Solution 1 : le dialogue

Dialoguer avec le Club Vosgien n’est pas toujours une sinécure. Pourtant tout semblait se présenter sous les meilleurs auspices en été 2017, lors d’une rencontre entre la MBF et le président de la Fédération du Club Vosgien, qui n’avait jamais auparavant répondu aux lettres de la MBF et semblait découvrir ses activités.

Peu de temps après, suite à l’article du Club Vosgien section Masevaux, une seconde rencontre eu lieu, dans une intention de dialogue et de coopération. D’après le compte rendu figurant sur le site de la MBF, il y a vraisemblablement une claire différence de conception du terme « dialogue » entre les antennes locales (plus ou moins indépendantes, mais est-ce vraiment souhaitable ?) et la fédération du Club Vosgien. Voici un extrait significatif de cette rencontre entre les référents MBF du secteur Thur-Doller et la présidence du Club Vosgien de Masevaux :

Mais le responsable du C.V ne l’entend pas ainsi et quitte la salle en nous rappelant qu’au titre de la propriété intellectuelle, nous ne devrions même pas regarder « leur » balisage. Deux autres membres du C.V de Masevaux quittent également la salle sans daigner nous saluer.

Pourtant les bonnes volontés ne manquent pas, de part et d’autre. La MBF agit déjà dans le domaine de l’entretien de sentiers, de manière systématique, en Alsace et dans d’autres régions de France, et organise même des défis internationaux sur ce thème. Pour preuve cette session de coopération entre les vététistes et le Club Vosgien de la même section de Masevaux, une collaboration qui pourtant n’a pas satisfait tout le monde, selon Jean Koehl, vice-président du CV Masevaux :

On a accueilli des groupes MBF pour deux demi-journées de travail et une journée pleine. Ils en ont profité pour faire leur com’en faisant venir France 3…

C’est vraiment à se demander ce que reprochent réellement les membres du Club Vosgien aux vététistes. Il semblerait que, quelles que soit les offres de coopération, les éternels insatisfaits sont toujours les mêmes. Pourtant le dialogue est bel et bien la clé d’une bonne entente entre randonneurs et vététistes : la coopération dans l’entretien des sentiers et les code de conduite des vététistes (comme par exemple la limitation des parcours sauvages d’enduro).

Le dialogue c’est l’apprentissage de la diversité. Diversité des usages et diversité sociale. Les vététistes sont particulièrement au clair sur ce point en distinguant les pratiques entre le cross country (qui n’a pratiquement aucun impact sur l’érosion des sentiers et représente plus de 80% des pratiques), l’enduro et la descente (DH). Peut-être que le Club Vosgien pourrait faire aussi un effort de son côté en se questionnant sur son rapport au paysage commun et les notions de partage que cela implique.

Solution 2 : attractivité

Cette attitude de la part du Club Vosgien pourrait notamment jouer en défaveur de l’attractivité du Massif Vosgien. Comme exprimé dans les Dernières Nouvelles d’Alsace, les revendications du Club Vosgien se résument à demander la création de Bike Park pour y cantonner les VTT et de ce fait leur interdire les sentiers… Une revendication qui s’établirait en défaveur évidente de l’écrasante majorité des pratiquants sur le segment du cross country. Autant dire que si les communautés de communes contactées à ce sujet par le Club Vosgien valident ces intentions, c’est toute l’attractivité du VTT sur le Massif qui en serait affectée : adieu les descentes techniques et les petits frissons qui pourtant sont souvent accessibles aux débutants. On ira expliquer aussi aux touristes que pour monter à plus de 900 mètres d’altitude ils devront emprunter les autoroutes à grumiers…

En la matière, on ne peut que saluer la lettre du maire de Hohrod (68142) qui rappelle que l’équipement de randonnée est une liberté de choix :

Randonner est une liberté individuelle fondée sur le principe de la liberté de circuler, un droit fondamental et universel. Que l’on circule à pieds ou à vélo est sans importance, chacun est libre de choisir l’équipement nécessaire à sa randonnée (…)

et que par conséquent :

La réponse éthique est de ne privilégier aucune pratique et de les placer à égalité dans leur accueil et leur traitement, les principes d’équité et de non-discrimination alimentent avantageusement l’argumentation en faveur des activités de plein air.

La valorisation du massif passe donc non seulement par le partage mais aussi par le dialogue entre les pratiquants. Ce besoin de coopération n’est pas seulement vital pour le Massif Vosgien, il l’est aussi pour que le paysage et ses sentiers ne comptent pas parmi les trop nombreux secteurs où le partage et le respect n’ont plus cours.

Alors oui, le Club Vosgien doit partager la montagne, le balisage et les sentiers. Les vététistes de leur côté n’ont pas à rougir de l’aide qu’ils offrent (même en communiquant dessus), comme en témoigne l’opération de grande envergure Take Care Your Trails. Cette communauté est active et respectueuse de l’environnement, qui irait le lui reprocher ?

Heureusement, les interlocuteurs bienveillants de la MBF sont nombreux, tels les Parcs, les Offices de Tourisme, les élus… et bien souvent très attentifs aux contraintes et aux paradoxes dont la communauté des vététistes n’est pas exempte. Ainsi, par exemple, l’image du VTT pâti bien souvent des quelques incivilités rencontrées ici et là, ou des vidéos trash sur Youtube dont ne manquent pas de s’emparer les détracteurs du VTT pour généraliser et justifier leur hargne. Mais qu’importe. L’essentiel est d’atteindre la maturité nécessaire au dialogue et dépasser ces contradictions. En la matière, certaines sections du Club Vosgien devraient prendre exemple, justement, sur la MBF.

01.02.2018 à 01:00

The culture of surveillance

From 9/11 to the Snowden leaks, stories about surveillance increasingly dominate the headlines. But security and police agencies or internet and phone companies are not the only players. Surveillance is not only ‘done to us’ - it is something we do in everyday life. We submit to surveillance, believing that ‘we have nothing to hide.’ Or we try to protect our privacy or negotiate the terms under which others have access to our data. At the same time, we participate in surveillance in order to supervise children, monitor other road users, and safeguard our property. Social media allows us to keep tabs on others, including complete strangers, as well as on ourselves. This is the culture of surveillance. Watching has become a way of life.

This important new book explores the imaginaries and practices of everyday surveillance, at work, at play, in school, at home, in both ‘public’ and ‘private’ domains. Its main focus is not high-tech, organized surveillance operations but our varied, often emotional, mundane experiences of surveillance that range from the casual and careless to the focused and intentional.

Surveillance culture, David Lyon argues, is not detached from the surveillance state, society and economy. It is informed by them. He reveals how the culture of surveillance may help to domesticate and naturalize surveillance of unwelcome kinds, weighing which kinds of surveillance might be fostered for the common good and human flourishing.

Lyon, David. The culture of surveillance: Watching as a way of life. Polity Press, 2018.

Lien vers le site de l’éditeur : http://politybooks.com/bookdetail/?isbn=9780745671727

06.01.2018 à 01:00

Les nouveaux Léviathans IV. La surveillance qui vient

Je continue la série des Léviathans commencée en 2016 sur le Framablog. Pour ce nouveaux numéro, je propose de voir dans quelle mesure le modèle économique a développé son besoin vital de la captation des données relatives à la vie privée. De fait, nous vivons dans le même scénario dystopique depuis une cinquantaine d’années. Nous verrons comment les critiques de l’économie de la surveillance sont redondantes depuis tout ce temps et que, au-delà des craintes, le temps est à l’action d’urgence.

Petit extrait :

L’incertitude au sujet des dérives du capitalisme de surveillance n’existe pas. Personne ne peut affirmer aujourd’hui qu’avec l’avènement des big data dans les stratégies économiques, on pouvait ignorer que leur usage déloyal était non seulement possible mais aussi que c’est bien cette direction qui fut choisie d’emblée dans l’intérêt des monopoles et en vertu de la centralisation des informations et des capitaux. Depuis les années 1970, plusieurs concepts ont cherché à exprimer la même chose. Pour n’en citer que quelques-uns : computocracie (M. Warner et M. Stone, 1970), société du dossier (Arthur R. Miller, 1971), surveillance de masse (J. Rule, 1973), dataveillance (R. Clarke, 1988), capitalisme de surveillance (Zuboff, 2015)… tous cherchent à démontrer que la surveillance des comportements par l’usage des données personnelles implique en retour la recherche collective de points de rupture avec le modèle économique et de gouvernance qui s’impose de manière déloyale. Cette recherche peut s’exprimer par le besoin d’une régulation démocratiquement décidée et avec des outils juridiques. Elle peut s’exprimer aussi autrement, de manière violente ou pacifiste, militante et/ou contre-culturelle.

Tous les articles rassemblés en un fichier .epub sur mon dépot Gitlab

La série d’articles sur le framablog :

28.09.2017 à 02:00

Petit tour sur les hautes chaumes

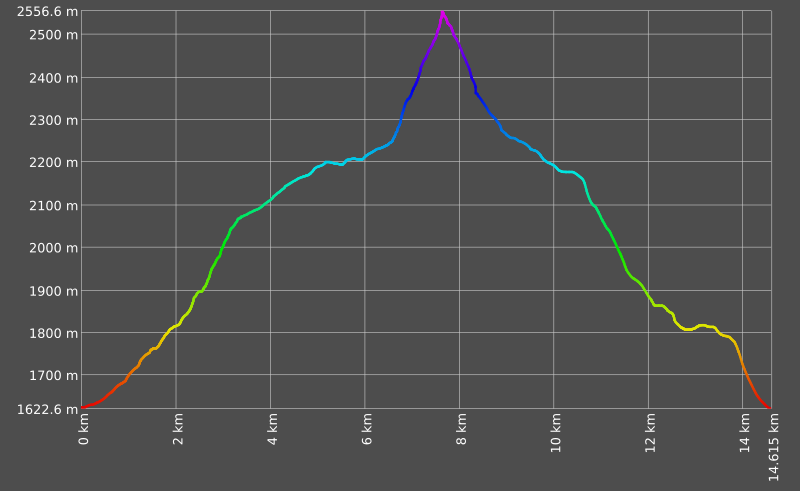

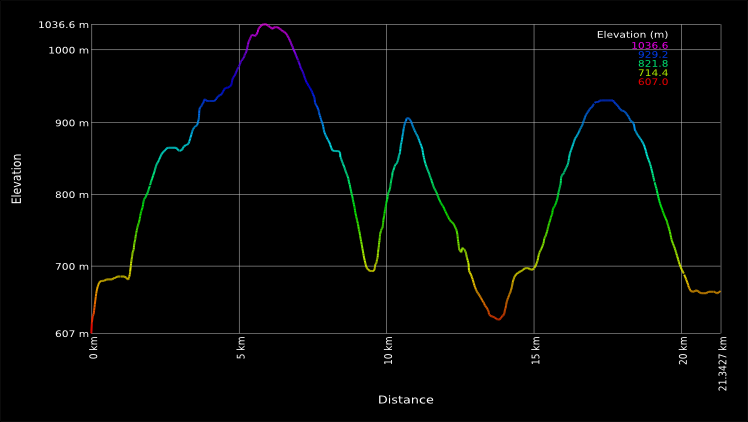

Profitons du soleil d’automne pour une sortie VTT sur les Hautes Chaumes de la région de Schirmeck / pays de Salm. Ce parcours n’est pas d’une grande difficulté technique mais nécessite à la fois de l’endurance et de la patience… (44 km / 1068 m D+)

En résumé

Au départ de Schirmeck, prenez la direction du joli petit village de Fréconrupt par le GR 532 La montée piquera un peu, pour commencer, avec quelques efforts à fournir en guise d’échauffement. Plusieurs grimpettes de ce style vont jalonner le parcours, alors… gardez des réserves !

On prendra ensuite le temps d’admirer les frondaisons sur le chemin qui mène à Salm puis l’ascension du relief du château de Salm et de la Chatte Pendue prendra un peu de temps. Repérez, au début, le « chemin médiéval » qui longe le flanc de la montagne. On coupera ensuite au niveau du replat entre les deux sommets pour rejoindre les Hautes Chaumes. À ce niveau, il faut emprunter le chemin des passeurs puis faire un petit détour jusquà la Haute Loge (un petit chemin très amusant en VTT), où on pourra admirer la superbe vue sur les monts Vosgiens (Climont, Champ du feu, Donon…).

Il est alors temps de poursuivre au long des chaumes pour rejoindre le Lac de la Meix. Attention, le parcours emprunte le chemin « piéton », qui est très technique à la descente et que je déconseille fortement en cas de temps humide ou forte fréquentation de marcheurs. Si vous n’êtes pas à l’aise avec ce genre de pilotage, prenez plutôt le chemin forestier en amont.

Depuis le Lac il faut alors remonter et rejoindre le Col de Prayé. La descente sera à la fois technique et rapide jusqu’à la route de l’Etang du Coucou. Le retour s’effectue enfin via Malplaquet-Fréconrupt.

L’ensemble est faisable en 4 heures (le temps d’admirer les vues), pour 44 km et 1068 m D+.

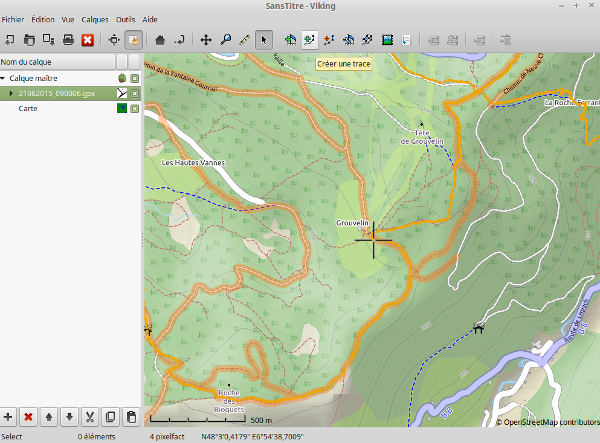

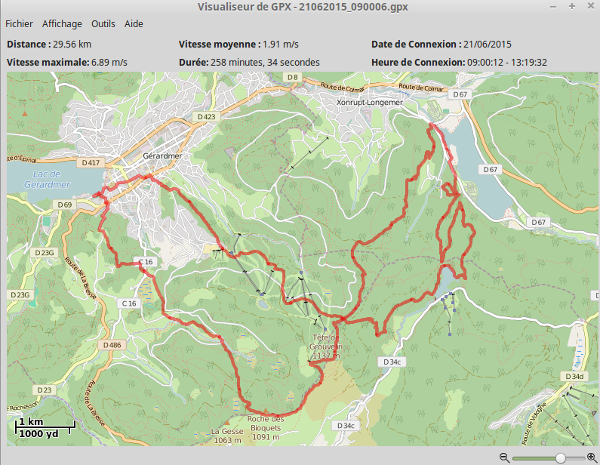

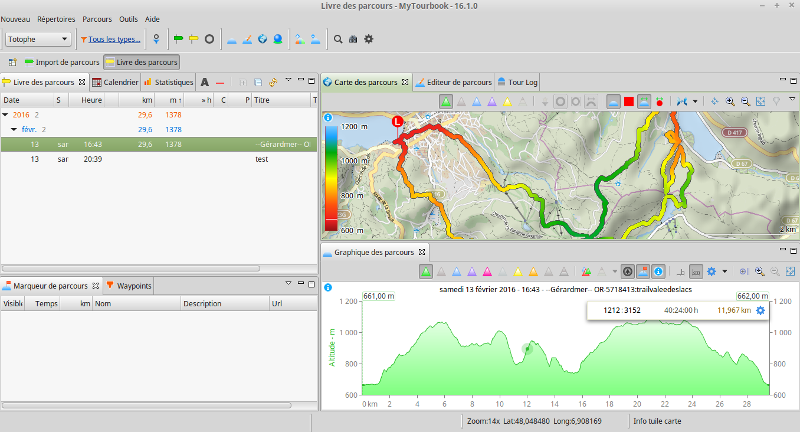

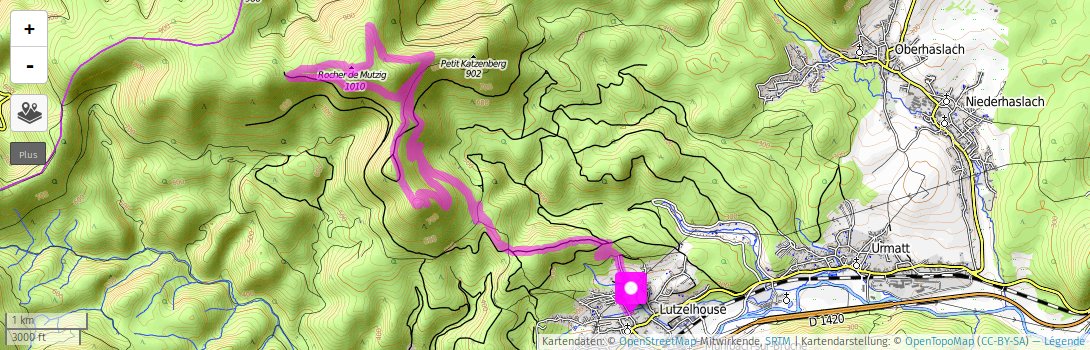

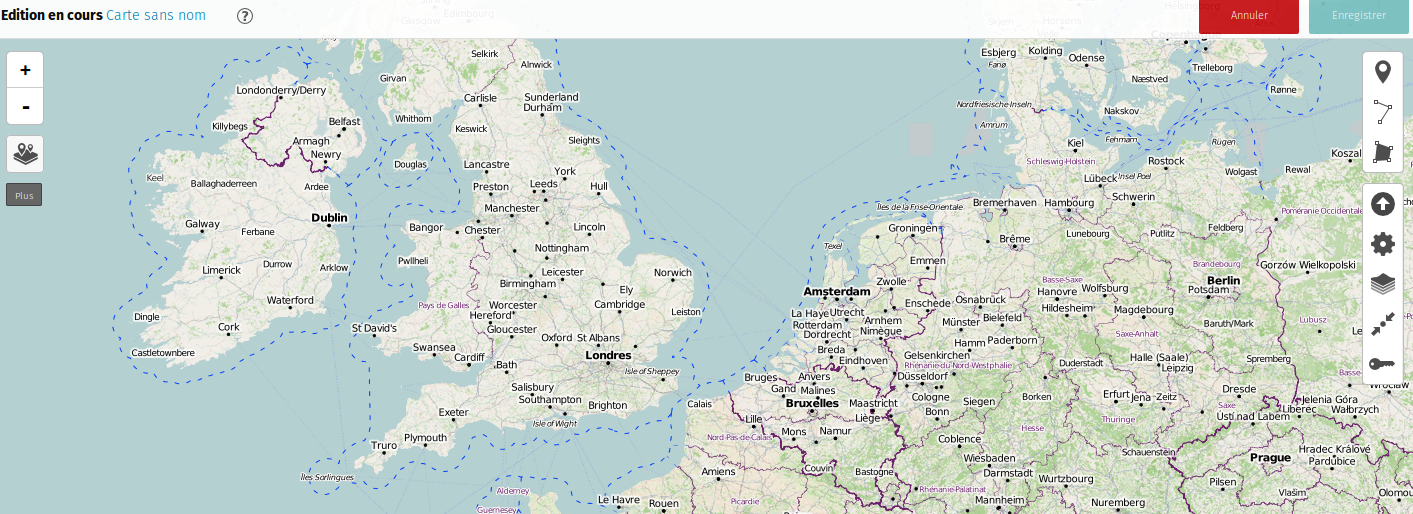

La carte et le tracé

18.06.2017 à 02:00

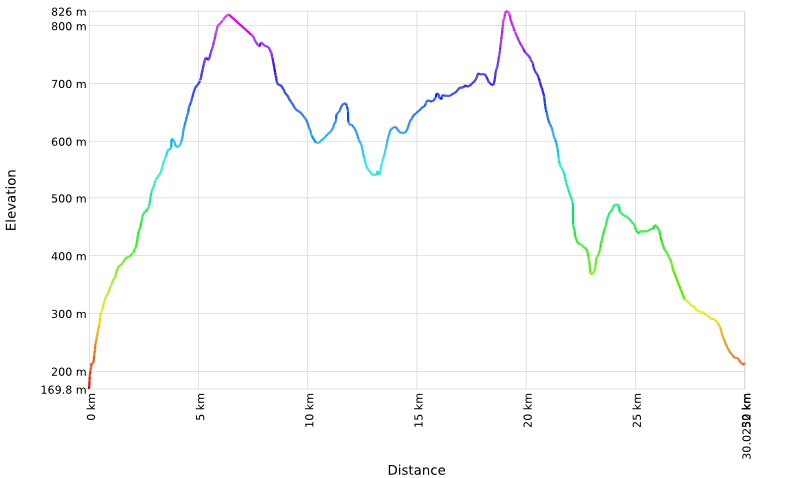

Champ du feu - les cuisses qui piquent

Une belle sortie d’entraînement à la montée en VTT vous attend au départ de Barr (67140) jusqu’au Champ du feu (1099 m). Voici le rapide descriptif et la carte correspondante.

Au départ de Barr, vous pouvez garer votre véhicule sur le parking de l’église protestante rue du Kirschberg. Le départ du parcours commence directmeent par la montée le long du cimetière en direction du chateau du Landsberg par le GR (rectangles rouges). On se dirige ensuite vers le carrefour de la Bloss (6 km) via le kiosque Jadelot pour totaliser 491 m D+. On amorce aussitôt une descente roulante jusque la Holzplatz (8,7 km).

Après avoir traversé la D854, on entamme alors une longue montée (rectangles rouges et blancs) très exigeante (400 m D+) avec des passages techniques jusqu’à Welschbruch (13,6 km). De là, on poursuit l’ascension jusqu’au Champ du Feu (22,19 km) en passant par la Rothlach (282 m D+).

Il est alors temps de prendre le chemin du retour. Celui-ci commence par une grande descente jusqu’au Hohwald (28 km) en passant par la cascade, puis un petit bout de route avant de longer cette dernière (en l’Andlau) jusqu’à Lilsbach. Pour rejoindre la vallée de Barr, il faut alors remonter jusqu’à Hungerplatz (130 m D+) pour redescendre via le château d’Andlau (croix rouges) jusqu’à l’entrée de Barr.

Le dénivelé total du parcours est de 1360 m D+ (les dénivelés cités ci-dessus ne sont pas exhaustifs) pour une distance de 42 km.

12.06.2017 à 02:00

Corporate Surveillance in Everyday Life

How thousands of companies monitor, analyze, and influence the lives of billions. Who are the main players in today’s digital tracking? What can they infer from our purchases, phone calls, web searches, and Facebook likes? How do online platforms, tech companies, and data brokers collect, trade, and make use of personal data?

In recent years, a wide range of companies has started to monitor, track and follow people in virtually every aspect of their lives. The behaviors, movements, social relationships, interests, weaknesses and most private moments of billions are now constantly recorded, evaluated and analyzed in real-time. The exploitation of personal information has become a multi-billion industry. Yet only the tip of the iceberg of today’s pervasive digital tracking is visible; much of it occurs in the background and remains opaque to most of us.

This report by Cracked Labs examines the actual practices and inner workings of this personal data industry. Based on years of research and a previous 2016 report, the investigation shines light on the hidden data flows between companies. It maps the structure and scope of today’s digital tracking and profiling ecosystems and explores relevant technologies, platforms and devices, as well as key recent developments.

Christl, Wolfie, et CrackedLab. Corporate Surveillance in Everyday Life. How Companies Collect, Combine, Analyze, Trade, and Use Personal Data on Billions. Cracked Labs, 2017.

Lien vers le site : http://crackedlabs.org/en/corporate-surveillance.

01.06.2017 à 02:00

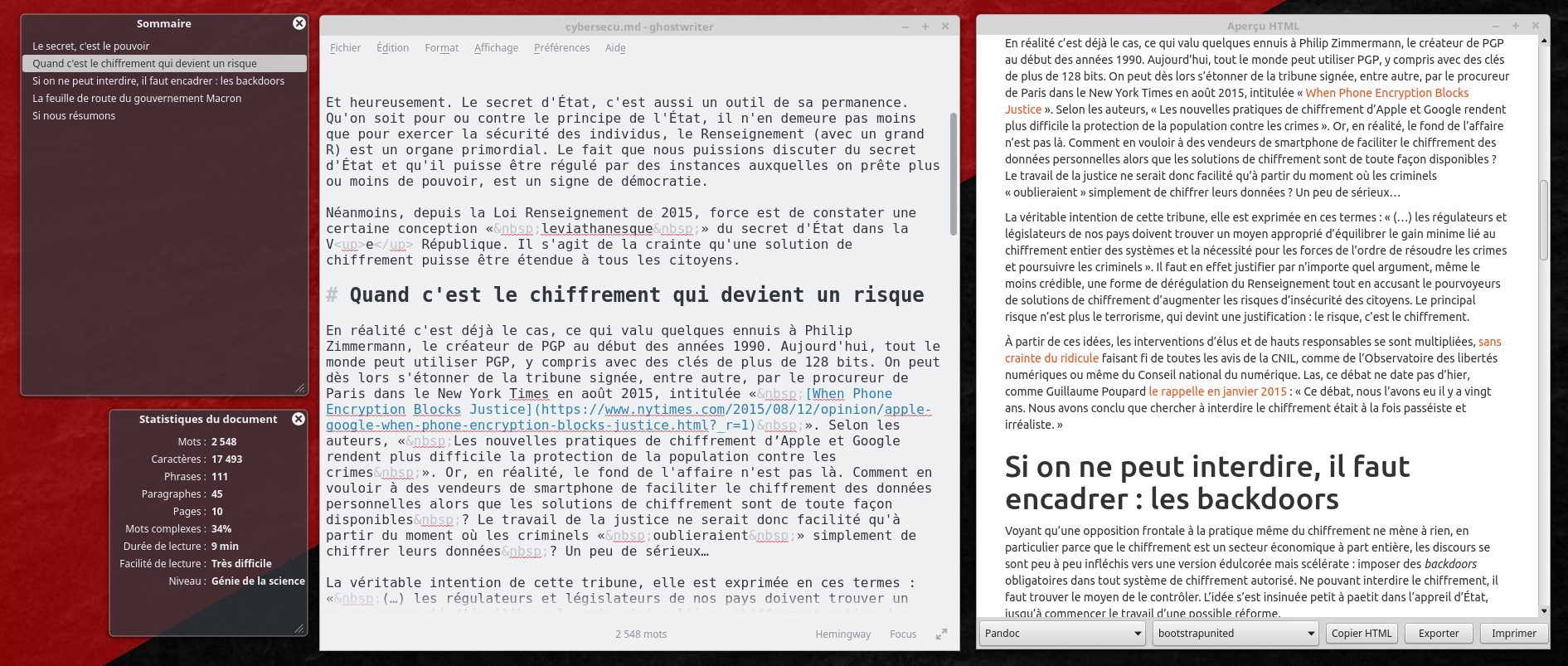

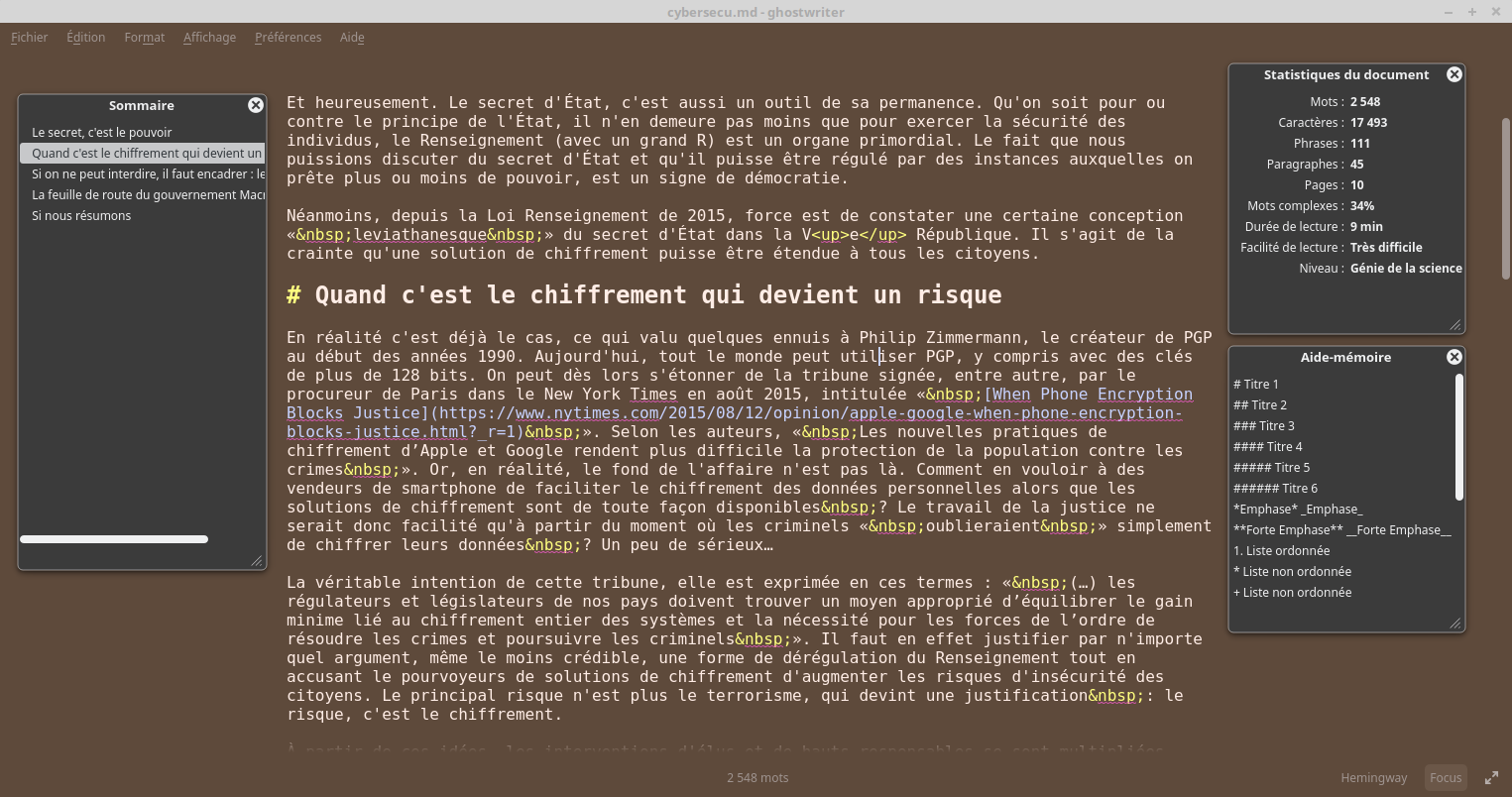

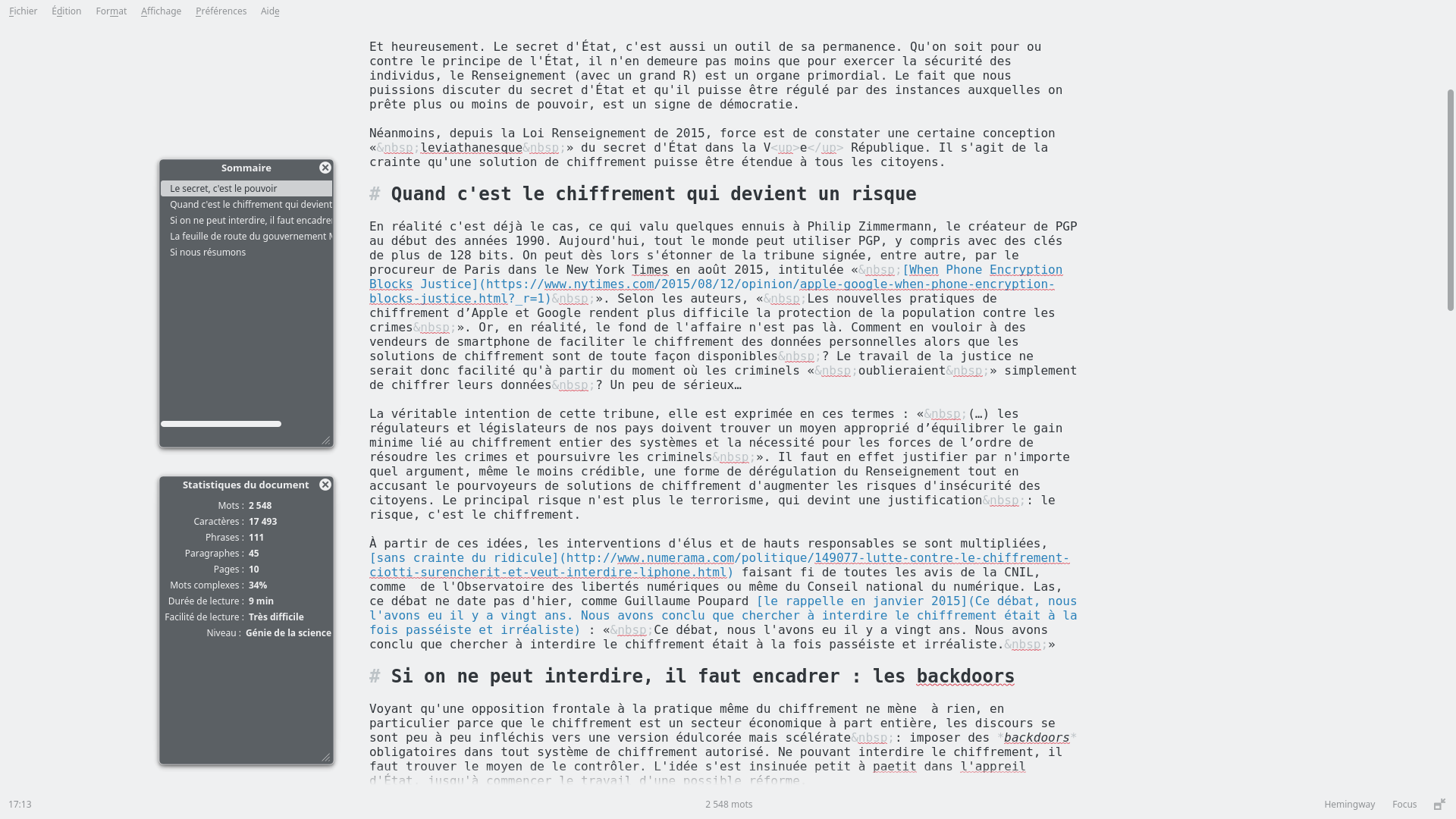

Ghostwriter, un bon éditeur Markdown

Après plusieurs essais pour trouver l’éditeur Markdown qui convienne à mes besoins, je pense avoir trouvé avec Ghostwriter une réponse plutôt pertinente.

Ghostwriter mise avant tout sur la simplicité. C’est ce qu’on appelle un éditeur « distraction free ». Il pousse même le concept jusqu’à proposer trois mode d’édition :

- un mode normal,

- un mode « focus » qui permet de mettre en surbrillance la phrase (et non la ligne) que l’on est en train d’écrire (jusqu’à la ponctuation, en fait),

- un mode « Hemingway », qui désactive les touches

backspaceetdeletepour se forcer à écrire comme avec une antique machine à écrire mécanique.

Mais cela, c’est du détail. Dans les fonctions plus opérationnelles, on note :

- une interface en panneaux, qui permet de passer le panneau principal où l’on écrit en mode plein écran, vraiment « distraction free »,

- la possibilité d’insérer des images en glisser-déposer directement dans l’interface,

- des fenêtres HUD (affichage tête haute, en anglais : Head-up display) qui permettent de sortir notamment l’affichage du sommaire du document et les statistiques.

- Parmi les statistiques, on note aussi quatre types d’estimation : la durée de lecture, le pourcentage de mots complexes, et de manière corrélée la facilité de lecture et le niveau (facile, université, très difficile…). Tiens en écrivant le terme « corrélé » ci-dessus, je suis passé à « difficile », j’espère que cela ira…

- enfin, un autre panneau permet d’afficher le rendu HTML du document.

Concernant le rendu, une fonction très appréciable est le choix des rendus en fonction des moteurs de transcription de la saveur Markdown utilisée. Ainsi le rendu intègre le choix d’un rendu à la sauce Pandoc, Sundow, Multimarkdown, etc. Une autre fonction est le choix de la CSS qui servira à la fois pour le rendu en temps réel mais aussi pour une éventuelle exportation en HTML.

À propos d’export, le choix est très large et on doit souligner la grande propreté des fichiers produits : html, html5, odt, xml, rtf, docx, pdf (LaTeX), pdf (ConTeXt), epub2, epub3, Groff, LaTeX… Pour ce qui me concerne, j’exporte très souvent en LaTeX, en choisissant le moteur Pandoc, et c’est vraiment efficace. Évidemment l’autre solution est d’enregistrer le .md et le convertir avec Pandoc en ligne de commande.

Le reste est à l’avenant : correction orthographique, interface en plusieurs langues, personnalisation assez poussée de l’apparence de l’interface (couleurs, transparence, image d’arrière plan). Ces sont autant de petits détails qui rendent l’utilisation de Ghostwriter fort appréciable.

Pour conclure, Ghostwriter répond à mes attentes, parce qu’il situe une bonne interface de rédaction à l’intersection entre l’éditeur de texte et les sorties souhaitées pour la finalisation (LaTeX et HTML, surtout pour ce qui me concerne).

Lien vers le site officiel de Ghostwriter : wereturtle.github.io/ghostwriter/

12.05.2017 à 02:00

Oui au chiffrement, non à la liberté

Dans cet article, nous allons voir comment la stratégie gouvernementale en matière de chiffrement suppose de limiter nos libertés numériques pour favoriser une économie de la norme à l’exclusion du logiciel libre. Telle est la feuille de route d’Emmanuel Macron.

Il y a quelque temps, j’ai écrit un article intitulé « Le contrat social fait 128 bits… ou plus ». J’y interrogeais les velléités gouvernementales à sacrifier un peu plus de nos libertés afin de pouvoir mieux encadrer les pratiques de chiffrement au nom de la lutte contre le terrorisme. Le ministre Manuel Valls, à l’époque, faisait mention de pratiques de « cryptologie légales », par opposition, donc, à des pratiques illégales. Ce à quoi toute personne moyennement intelligente pouvait lui faire remarquer que ce n’est pas le chiffrement qui devrait être réputé illégal, mais les informations, chiffrées ou non. L’idée de Valls était alors de prévenir de l’intention du gouvernement à encadrer une technologie qui lui échappe et qui permet aux citoyens de protéger leur vie privée. L’ennemi, pour qui conçoit l’État sous une telle forme archaïque, ce n’est pas la vie privée, c’est de ne pas pouvoir choisir ceux qui ont droit à une vie privée et ceux qui n’y ont pas droit. De là à la lutte de classe, on n’est pas loin, mais nous ne suivrons pas cette direction dans ce billet…

Le chiffrement, c’est bien plus que cela. C’est la capacité à user du secret des correspondances. Et la question qui se pose est de savoir si un gouvernement peut organiser une intrusion systématique dans toute correspondance, au nom de la sécurité des citoyens.

Le secret, c’est le pouvoir

C’est un choix cornélien. D’un côté le gouvernement qui, depuis Louis XI a fait sienne la doctrine qui nescit dissimulare, nescit regnare (qui ne sait dissimuler ne sait régner), principe érigé à l’état de science avec le Prince de Machiavel. Et de l’autre, puisque savoir c’est pouvoir, la possibilité pour un individu d’échanger en secret des informations avec d’autres. De tout temps ce fut un jeu entre l’autorité absolue de l’État et le pouvoir relatif des individus que de savoir comment doit s’exercer le secret de la correspondance.

Après qu’on eut littéralement massacré la Commune de Paris, les anarchistes les plus vengeurs furent visés par les fameuses Lois scélérates, dont l’une d’entre elles fit dire à Jean Jaurès qu’elle se défini par « l’effort du législateur pour aller chercher l’anarchie presque dans les secrets de la conscience humaine ». Après une chasse aux sorcières qui habitua peu à peu les Français à la pratique de la délation, le mouvement des anarchistes (pacifistes ou non) ont dû se résigner à entretenir des modes d’organisation exerçant le secret, presque aussitôt contrecarrés par l’État de guerre qui s’annonçait. Depuis la fin du XIXe siècle, l’histoire des Républiques successives (mais c’est aussi valable hors la France) n’a fait que brandir le chiffon rouge de la sécurité des citoyens pour bâtir des législations afin d’assurer au pouvoir le monopole du secret.

Et heureusement. Le secret d’État, c’est aussi un outil de sa permanence. Qu’on soit pour ou contre le principe de l’État, il n’en demeure pas moins que pour exercer la sécurité des individus, le Renseignement (avec un grand R) est un organe primordial. Le fait que nous puissions discuter du secret d’État et qu’il puisse être régulé par des instances auxquelles on prête plus ou moins de pouvoir, est un signe de démocratie.

Néanmoins, depuis la Loi Renseignement de 2015, force est de constater une certaine conception « leviathanesque » du secret d’État dans la Ve République. Il s’agit de la crainte qu’une solution de chiffrement puisse être étendue à tous les citoyens.

Quand c’est le chiffrement qui devient un risque

En réalité c’est déjà le cas, ce qui valu quelques ennuis à Philip Zimmermann, le créateur de PGP au début des années 1990. Aujourd’hui, tout le monde peut utiliser PGP, y compris avec des clés de plus de 128 bits. On peut dès lors s’étonner de la tribune signée, entre autre, par le procureur de Paris dans le New York Times en août 2015, intitulée « [When Phone Encryption Blocks Justice](https://www.nytimes.com/2015/08/12/opinion/apple-google-when-phone-encryption-blocks-justice.html?_r=1">When Phone Encryption Blocks Justice) ». Selon les auteurs, « Les nouvelles pratiques de chiffrement d’Apple et Google rendent plus difficile la protection de la population contre les crimes ». Or, en réalité, le fond de l’affaire n’est pas là. Comment en vouloir à des vendeurs de smartphone de faciliter le chiffrement des données personnelles alors que les solutions de chiffrement sont de toute façon disponibles ? Le travail de la justice ne serait donc facilité qu’à partir du moment où les criminels « oublieraient » simplement de chiffrer leurs données ? Un peu de sérieux…

La véritable intention de cette tribune, elle est exprimée en ces termes : « (…) les régulateurs et législateurs de nos pays doivent trouver un moyen approprié d’équilibrer le gain minime lié au chiffrement entier des systèmes et la nécessité pour les forces de l’ordre de résoudre les crimes et poursuivre les criminels ». Il faut en effet justifier par n’importe quel argument, même le moins crédible, une forme de dérégulation du Renseignement tout en accusant les pourvoyeurs de solutions de chiffrement d’augmenter les risques d’insécurité des citoyens. Le principal risque n’est plus le terrorisme ou le crime, qui devient une justification : le risque, c’est le chiffrement.

À partir de ces idées, les interventions d’élus et de hauts responsables se sont multipliées, sans crainte du ridicule faisant fi de tous les avis de la CNIL, comme de l’Observatoire des libertés numériques ou même du Conseil national du numérique. Las, ce débat ne date pas d’hier, comme Guillaume Poupard le rappelle en janvier 2015 : « Ce débat, nous l’avons eu il y a vingt ans. Nous avons conclu que chercher à interdire le chiffrement était à la fois passéiste et irréaliste. »

Si on ne peut interdire, il faut encadrer : les backdoors

Voyant qu’une opposition frontale à la pratique même du chiffrement ne mène à rien, en particulier parce que le chiffrement est un secteur économique à part entière, les discours se sont peu à peu infléchis vers une version édulcorée mais scélérate : imposer des backdoors obligatoires dans tout système de chiffrement autorisé. Ne pouvant interdire le chiffrement, il faut trouver le moyen de le contrôler. L’idée s’est insinuée petit à petit dans l’appareil d’État, jusqu’à commencer le travail d’une possible réforme.

C’est l’ANSSI (Agence nationale de la sécurité des systèmes d’information) qui réagit assez vertement, notamment dans une lettre diffusée par le journal Libération en août 20161, et signée de G. Poupard. Pour ce dernier, imposer des backdoors revient à affaiblir le niveau de sécurité général. On lit dans sa lettre :

« Il convient de noter que les technologies robustes de cryptographie, longtemps réservées à une communauté très restreinte, sont aujourd’hui largement diffusées et relativement aisées à mettre en œuvre. Le développement de logiciels non contrôlables, faciles à distribuer et offrant un niveau de sécurité très élevé est par conséquent à la portée de n’importe quelle organisation criminelle.

Imposer un affaiblissement généralisé des moyens cryptographiques serait attentatoire à la sécurité numérique et aux libertés de l’immense majorité des utilisateurs respectueux des règles tout en étant rapidement inefficace vis-à-vis de la minorité ciblée. »

Difficile d’exprimer combien G. Poupard a raison. Pourtant le débat resurgit en février 2017, cette fois sous l’angle de la coopération franco-allemande. C’est une lettre officielle publiée par Politico<2, signée des Ministères de l’Intérieur Français et Allemand, qui met en exergue la lutte contre le terrorisme et annonce que cette dernière…

…requiert de donner les moyens juridiques aux autorités européennes afin de tenir compte de la généralisation du chiffrement des communications par voie électronique lors d’enquêtes judiciaires et administratives. La Commission européenne doit veiller à ce que des travaux techniques et juridiques soient menés dès maintenant pour étudier la possibilité de définir de nouvelles obligations à la charge des prestataires de services de communication par voie électronique tout en garantissant la fiabilité de systèmes hautement sécurisés, et de proposer sur cette base une initiative législative en octobre 2017. »

En d’autres termes, c’est aux prestataires qu’il devrait revenir l’obligation de fournir aux utilisateurs des solutions de communication chiffrées tout en maintenant des ouvertures (forcément secrètes pour éviter qu’elles soient exploitées par des malveillants, donc des backdoors) capables de fournir en clair les informations aux autorités.

Il est très curieux de découvrir qu’en ce début d’année 2017, la Commission Européenne soit citée comme garante de cette coopération franco-allemande, alors même que son vice-président chargé du marché numérique unique Andrus Ansip déclarait un an plus tôt : « I am strongly against any backdoor to encrypted systems »3, opposant à cela les récentes avancées numériques pour lesquelles l’Estonie est connue comme particulièrement avant-gardiste.

La feuille de route du gouvernement Macron

Nous ne sommes pas au bout de nos surprises, puisqu’on apprend qu’en bon élève, notre Président E. Macron fraîchement élu, reprendra cette coopération franco-allemande. Interrogé à propos de la cybersécurité par le mathématicien Cédric Villani, il l’affirme en effet dans une vidéo publiée par Science et Avenir (source directe) :

C. Villani : « J’ai une question sur le domaine numérique, qui va être plus technique, c’est la question sur laquelle on est en train de plancher au Conseil Scientifique de la Commission Européenne, ça s’appelle la cybersécurité. C’est un sujet sur lequel on nous a demandé de plancher en tant que scientifiques, mais on s’est vite aperçu que c’est un sujet qui ne pouvait pas être traité juste sous l’angle scientifique parce que les questions politiques, économiques, étaient mêlées de façon, heu, indémêlable et que derrière il y avait des questions de souveraineté de l’Europe par rapport au reste du monde…

E. Macron : « le sujet de la cybersécurité est un des axes absolument essentiel et on est plutôt en retard aujourd’hui sur ce sujet quand on regarde… Le pays qui est le plus en pointe, c’est Israël qui a fait un travail absolument remarquable en construisant carrément une cité de la cybersécurité, qui a un rapport existentiel avec cet aspect… et les États-Unis… nous sommes en retard… il en dépend de notre capacité à nous protéger, de notre souveraineté numérique derrière, et notre capacité à protéger nos systèmes puisqu’on agrège tout dans ce domaine-là.

Je suis assez en ligne avec la stratégie qui avait été présentée en France par Le Drian, sur le plan militaire. Le sujet, c’est qu’il faut le désenclaver du plan militaire. C’est un sujet qui dépend du domaine militaire, mais qui doit également protéger tous les systèmes experts civils, parce que si on parle de cybersécurité et qu’on va au bout, les systèmes scientifiques, les systèmes de coopération universitaire, les systèmes de relation entre les ministères, doivent être couverts par ce sujet cybersécurité. Donc c’est beaucoup plus inclusif que la façon dont on l’aborde aujourd’hui qui est juste « les systèmes experts défenses » et qui est très sectoriel. La deuxième chose, c’est que je pense que c’est une stratégie qui est européenne, et qui est au moins franco-allemande. Pourquoi ? parce que, on le sait, il y a des sujets de standards, des sujets de normalisation qui sont assez techniques, et qui font que si on choisit une option technologique plutôt qu’une autre, en termes de chiffrement ou de spécifications, on se retrouve après avec des non-compatibilités, et on va se retrouver — on est les champions pour réussir cela — dans une bataille de chiffonniers entre la France et l’Allemagne. Si on veut avoir une vraie stratégie en la matière sur le plan européen, il faut d’abord une vraie stratégie franco-allemande, une vraie convergence normative, une vraie stratégie commune en franco-allemand, en termes, pour moi, de rapprochement des univers de recherche, de rapprochement des intérêts militaires, de rapprochement de nos experts en la matière. Pour moi c’est 1) un vrai sujet de priorité et 2) un vrai sujet d’organisation en interne et en externe. Quand je m’engage sur le 2% en Défense, j’y inclus le sujet cybersécurité qui est absolument critique. »

La position d’E. Macron entre donc dans la droite ligne de la satisfaction des députés en faveur d’une limitation du chiffrement dans les usages individuels, au profit a) d’une augmentation capacitaire du chiffrement pour les autorités de l’État et b) du renforcement des transactions stratégiques (bancaires, communicationnelles, coopérationnelles etc.). Cela ouvre à la fois des perspectives de marchés et tend à concilier, malgré les critiques et l’inefficacité, cette fameuse limitation par solution de backdoors interposée.

Pour que de telles solutions existent pour les individus, il va donc falloir se tourner vers des prestataires, seuls capables à la fois de créer des solutions innovantes et d’être autorisés à fournir au public des services de chiffrement « backdorisés ».

Pour cela, c’est vers la French Tech qu’il va falloir se tourner. Et cela tombe plutôt bien, puisque Mounir Mahjoubi, le directeur de la campagne numérique d’Emmanuel Macron et sans doute futur député, en faisait la promotion le 11 mai 2017 sur France Inter4, tout en plaidant pour que les « français créent une culture de la sécurité en ligne ».

Il faut donc bien comprendre que, bien que les individus aient tout intérêt à chiffrer leurs communications au moins depuis l’Affaire Snowden, l’objectif est de les encourager :

- pour asseoir notre autonomie numérique nationale et moins prêter le flanc aux risques sécuritaires,

- dans le cadre de solutions de chiffrement backdorisées,

- en poussant des start-up et autres entreprises de la French Tech à proposer qui des logiciels de chiffrement qui des messageries chiffrées de bout en bout, conformes aux normes mentionnées par E. Macron et dont la coopération franco-allemande dressera les premiers étalons.

Dans ce domaine, il va de soi que les solutions de chiffrement en cours aujourd’hui et basées sur des logiciels libres n’auront certainement plus aucun doit de cité. En effet, il est contradictoire de proposer un logiciel libre doté d’une backdoor : il serait aussitôt modifié pour supprimer cette dernière. Et, d’un autre côté, si des normes viennent à être établies, elles seront décidées à l’exclusion de toute tentative de normalisation basée sur des chiffrements libres existants comme PGP, GNUPG…

Si nous résumons

Il suffit de rassembler les idées :

- tout est en place aujourd’hui pour pousser une limitation de nos libertés numériques sous le recours fallacieux d’un encouragement au chiffrement mais doté de solutions obligatoires de portes dérobées,

- l’État assurerait ainsi son pouvoir de contrôle total en privant les individus de tout droit au secret absolu (ou quasi-absolu, parce qu’un bon chiffrement leur est aujourd’hui accessible),

- les solutions libres pourraient devenir interdites, ce qui annonce alors la fin de plus de vingt années de lutte pour que des solutions comme PGP puissent exister, quitte à imposer aux entreprises d’utiliser des nouvelles « normes » décidées de manière plus ou moins unilatérales par la France et l’Allemagne,

- cette stratégie, bien que profondément inutile au regard de la lutte contre le terrorisme et la sécurité des citoyens, sert les intérêts de certaines entreprises du numérique qui trouvent dans la politique de E. Macron une ouverture que le gouvernement précédent refusait de leur servir sur un plateau en tardant à développer davantage ce secteur.

Je me suis souvent exprimé à ce propos : pour moi, le chiffrement des communications des individus grâce au logiciel libre est une garantie de la liberté d’expression et du secret des correspondances. Aucun État ne devrait interdire ou dégrader de telles solutions technologiques à ses citoyens. Ce qui distingue un État civilisé et démocratique d’une dictature, c’est justement cette possibilité que les capacités de renseignement de l’État puissent non seulement être régulées de manière démocratique, mais aussi que le chiffrement, en tant qu’application des lois mathématiques, puisse être accessible à tous, sans discrimination et rendre possible l’exercice du secret par les citoyens. Problème : aujourd’hui, le chiffrement libre est remis en cause par la stratégie gouvernementale.

-

Voir aussi sur le site du Ministère de l’Intérieur. ↩︎

21.04.2017 à 02:00

The Red Web

After the Moscow protests in 2011-2012, Vladimir Putin became terrified of the internet as a dangerous means for political mobilization and uncensored public debate. Only four years later, the Kremlin used that same platform to disrupt the 2016 presidential election in the United States. How did this transformation happen?

The Red Web is a groundbreaking history of the Kremlin’s massive online-surveillance state that exposes just how easily the internet can become the means for repression, control, and geopolitical warfare. In this bold, updated edition, Andrei Soldatov and Irina Borogan offer a perspective from Moscow with new and previously unreported details of the 2016 hacking operation, telling the story of how Russia came to embrace the disruptive potential of the web and interfere with democracy around the world.

Soldatov, Andrei, et Irina Borogan. The Red Web. The Struggle Between Russia’s Digital Dictators and the New Online Revolutionaries. Public Affairs, 2017.

Lien vers le site de l’éditeur : https://www.publicaffairsbooks.com/titles/andrei-soldatov/the-red-web/9781610395748/

21.04.2017 à 02:00

La toile que nous voulons

Depuis son origine, et sous la pression d’un secteur économique désormais hégémonique, le web a évolué en un sens qui l’a profondément dénaturé, au point d’en faire un instrument d’hypercontrôle et d’imposition d’une gouvernance purement computationnelle de toutes choses. Privilégiant à outrance l’automatisation mise au service de modèles économiques devenus la plupart du temps ravageurs pour les structures sociales, cette évolution a affaibli toujours plus gravement les conditions d’une pratique réflexive, délibérative, outre les aspects révélés par Edward Snowden. Cet ouvrage présente les principaux aspects théoriques et pratiques d’une refondation indispensable du web, dans lequel et par lequel aujourd’hui nous vivons. L’automatisation du web ne peut être bénéfique que si elle permet d’organiser des plateformes contributives et des processus délibératifs, notamment à travers la conception d’un nouveau type de réseaux sociaux. Bernard Stiegler, Julian Assange, Paul Jorion, Dominique Cardon, Evgeny Morozov, François Bon,Thomas Bern, Bruno Teboul, Ariel Kyrou, Yuk Hui, Harry Halpin, Pierre Guéhénneux, David Berry, Christian Claude, Giuseppe Longo, balayent les aspects et les enjeux économiques, politiques, militaires et épistémologiques de cette rénovation nécessaire et avance des hypothèses pour l’élaboration d’un avenir meilleur.

Jorion, Paul, et Stiegler, Bernard et al. La toile que nous voulons. Le web néguentropique. Édité par Bernard Stiegler, FYP éditions, 2017.

Lien vers le site de l’éditeur : https://www.fypeditions.com/toile-voulons-bernard-stiegler-evgeny-morozov-julian-assange-dominique-cardon/

20.04.2017 à 02:00

L’appétit des géants

Il fallait un amoureux du web et des médias sociaux pour décrypter les enjeux culturels, relationnels et démocratiques de nos usages numériques. Olivier Ertzscheid met en lumière les effets d’échelle, l’émergence de géants aux appétits insatiables. En concentrant toutes nos activités numériques sur quelques plateformes, nous avons fait naître des acteurs mondiaux qui s’épanouissent sans contrôle. Nos échanges, nos relations, notre sociabilité vont nourrir des algorithmes pour classer, organiser et finalement décider pour nous de ce qu’il nous faut voir.

Quelle loyauté attendre des algorithmes qui se nourrissent de nos traces pour mieux alimenter l’influence publicitaire ou politique ? Comment construire des médias sociaux et un accès indépendant à l’information qui ne seraient pas soumis aux ambitions des grands acteurs économiques du web ? Pourquoi n’y a-t-il pas de bouton « sauver le monde » ?

Ertzscheid, Olivier. L’appétit des géants: pouvoir des algorithmes, ambitions des plateformes. C&F éditions, 2017.

Lien vers le site de l’éditeur : https://cfeditions.com/geants/

02.04.2017 à 02:00

Parution de Libertés numériques

Et voici le guide Libertés numériques. Guide des bonnes pratiques à l’usage des DuMo (coll. Framabook, version août 2017). Un inventaire des bonnes pratiques numériques à la portée de tous. Un ouvrage dans collection Framabook).

Nous utilisons nos terminaux, nos ordinateurs, nos téléphones portables comme nous l’avons appris, ou pas. Pourtant, pour bien des gens, ces machines restent des boîtes noires. C’est le cas des Dupuis-Morizeau, une famille imaginaire que nous citons souvent à Framasoft. Elle correspond, je crois, assez bien à une réalité : des personnes qui utilisent les réseaux et les outils numériques, souvent même avec une certaine efficacité, mais qui ne sont pas autonomes, dépendent des services des grands silos numériques du web, et sont démunis face à tout ce contexte anxiogène de la surveillance, des verrous numériques, des usages irrespectueux des données personnelles… C’est à eux que s’adresse cet ouvrage, dans l’intention à la fois de dresser un petit inventaire de pratiques numériques mais aussi d’expliquer les bonnes raisons de les mettre en œuvre, en particulier en utilisant des logiciels libres.

Pour une autre présentation de cet ouvrage, vous pouvez lire l’interview paru sur le Framablog où j’explique les tenants et aboutissants de ce projet.

Quelques liens :

- pour télécharger le guide Libertés numériques sur Framabook,

- acheter la version papier chez Lulu,

- lire le guide en ligne,

- participer à son amélioration sur son dépôt Git.

Grands utilisateurs d’outils et de services numériques, les Dupuis-Morizeau (DuMo) sont pourtant entourés de boîtes noires. Installer, configurer, sauvegarder, envoyer, souscrire, télécharger… autant d’actions que, comme les DuMo, nous ne maîtrisons pas toujours dans un environnement dont nous sommes au mieux les acteurs passifs, au pire les prisonniers.

Avec des exemples concrets, ce manuel accompagne l’utilisateur au quotidien. Il montre comment l’utilisation de logiciels libres est l’une des clés d’une informatique domestique maîtrisée. Quels logiciels choisir et pourquoi ? quelle confiance accorder aux services en réseau ? qu’est-ce que la confidentialité dans les communications ? Autant de sujets vulgarisés permettront au lecteur de faire bon usage de ses libertés numériques.

31.03.2017 à 02:00

Manifeste pour une véritable économie collaborative : Vers une société des communs

Partage de fichiers, distribution de musique, installation de logiciels, la technologie du peer-to-peer (P2P) permet différents types de coopération via un échange direct de données entre ordinateurs, sans passer par des serveurs centralisés. Mais ce genre d’utilisation a au fond une portée limitée, et si l’on adopte un point de vue plus large, le P2P peut être considéré comme un nouveau modèle de relations humaines. Dans cet ouvrage, Michel Bauwens et Vasilis Kostakis décrivent et expliquent l’émergence d’une dynamique du P2P fondée sur la protection et le développement des communs, et la replacent dans le cadre de l’évolution des différents modes de production. Cette nouvelle modalité de création et de distribution de la valeur, qui favorise les relations horizontales, crée les conditions pour une transition vers une nouvelle économie, respectueuse de la nature et des personnes, une véritable économie collaborative.

Bauwens, M., & Kostakis, V. (2017). Manifeste pour une véritable économie collaborative : Vers une société des communs (O. Petitjean, Trad.). Éditions Charles Léopold Mayer.

Lien vers le site de l’éditeur : http://www.eclm.fr/ouvrage-386.html

04.03.2017 à 01:00

Scott Spark 950 : prise en main

L’hiver ne doit pas être un obstacle pour rouler et tant pis si le terrain est gras. La sortie du jour avait pour thème : comment prendre en main un VTT tout juste sorti du carton ? En fait c’est très facile, pourvu que le vélo en question soit de bonne qualité.

L’engin en test

Oui, parce qu’à ce niveau-là, ce n’est ni un vélo ni un simple VTT mais un engin, bourré de technologies plus avancées les unes que les autres. Lorsque j’ai vu le monteur régler les suspensions pour mon gabarit, je me suis demandé si je n’aurais pas dû choisir maths-physique à la sortie du lycée. Heureusement, une fois réglées ces suspensions, normalement on ne devrait pas avoir à y bricoler sans arrêt.

Le test a porté assez simplement sur la base de ma pratique du cross-country : 40 km environ dans les Vosges pour 1000 m de dénivelé (ben oui, au-delà il y avait de la neige). Le VTT concerné : un Scott Spark 950.

Alors qu’est-ce qu’il y a dans le paquet ?

D’abord une transmission Shimano XT pour le dérailleur arrière et Deore pour l’avant. D’accord, c’est pas du full-XT mais franchement pour passer les deux plateaux avant, c’est largement suffisant (et Deore reste une référence).

Dans l’ensemble, la transmission est franchement au poil. Si comme moi vous sortez direct d’un VTT avec trois plateaux avant, l’apprentissage met environ… 5 minutes, le temps de trouver une montée pour essayer tout cela. Évidemment, sur ce VTT, je conseille de prendre grand soin de cette transmission : l’équipement convient parfaitement pour une pratique cross-country mais si on tire un peu long et selon le kilométrage m’est d’avis que la longévité est proportionnelle au soin avec lequel vous passez les vitesses.

Ensuite viennent les super gadgets de chez Scott.

Le système Twinlock, d’abord, qui permet en trois positions, de régler le débattements des suspensions avant et arrière : relâche totale pour la descente, mode traction (semi-blocage) pour les montées un peu techniques, et blocage total pour montée régulière ou la route (bêrk). Simple gadget ou vraiment utile ? la question n’est pas sérieuse : c’est l’une des clés de la polyvalence de ce VTT. Sans ce système, l’intérêt pour le cross-country serait bien moindre. Bien sûr, il faut adapter ses réglages en fonction du terrain sur lequel on évolue, mais comme la commande est située au guidon, c’est une simple formalité.

La commande de la tige télescopique au guidon. Là encore, l’intérêt est évident… la tige s’abaisse avec le poids du cycliste, histoire d’engager des descentes dans de bonnes conditions, puis remonte très vite une fois que l’on souhaite revenir à une position de pédalage. Petit bémol toutefois : comme on le voit sur la photo, la commande est située après la commande de transmission, et à moins d’avoir de grandes mains, il faut aller la chercher en lâchant la prise du guidon. C’est un problème de montage et non de conception ! Je vais rapidement corriger ce problème car il est important de pouvoir manipuler les différentes commandes au guidon sans lâcher la prise. C’est normalement étudié pour cela :) Cette commande doit en fait être située entre la poignée et le levier de frein (pour affirmer cela, j’ai demandé au service après vente de chez Scott qui a mis moins de deux heures pour me répondre par courriel, merci à eux.)

De manière générale, vous avez tout intérêt à penser à baisser la selle avant d’engager la descente, mais parfois les terrains s’enchaînent plus vite que prévu. Pour la reprise, le problème est moins difficile, sauf que généralement la main est déjà occupée à changer de vitesse. Bref, la commande de la tige au guidon, c’est génial, mais attention au montage.