27.08.2024 à 02:00

Politique, surveillance, résistances

Voici billet un peu foutraque où j’aborde plusieurs problématiques qui peuvent trouver une résolution dans le concept de mètis, selon une lecture de James Scott et de Certeau. Il faudra auparavant aborder longuement le rapport entre l’État et le capitalisme de surveillance. Quel est ce pouvoir normatif que le capitalisme de surveillance cherche à imposer aux institutions comme aux individus, et quelles sont les portes de sortie ? il y a des résistances inaltérables, présentes depuis toujours, et qui font du pouvoir une sorte d’illusion. Nous sommes tous des hackers, reste à comprendre pourquoi.

Table des matières

« Homme augmenté » : c’est ainsi que, dès les débuts des recherches en informatique appliquée dans les années 1960, on pensait le rapport entre l’homme et les machines. Les témoignages se sont généralement tous suivis sur ce modèle. Tantôt ils dévoilaient les promesses d’un monde meilleur où, partant d’une approche exclusivement computationnelle, l’esprit et le monde tout entier pouvaient être compris comme des machines de traitement d’information. Selon cette approche, si l’univers entier, y compris la pensée humaine sont compréhensibles par l’analogie mécanique (même si nous n’en connaissons pas tous les rouages), alors l’explication du monde est algorithmique et nos limites cognitives ne sont que celles que la technologie nous impose. Tantôt ils étaient plus pragmatiques en situant la machine dans le processus de l’évolution humaine. Une évolution externalisée dont ce qu’on appelait déjà l’IA et les big data représentaient le stade le plus élevé de l’augmentation des capacités humaines. Mais jusqu’à très récemment, avec la critique générale au sujet des GAFAM, la problème qui restait en suspend, le tabou si crucial, fut finalement dévoilé : qu’est-ce qui fut augmenté, exactement, au bout de 50 années de développement ?

Je vais vous le dire : la production et les profits du capital, la puissance de contrôle de l’État, l’influence sur nos comportements (qu’il s’agisse de nos comportements économiques ou de nos comportements politiques). Un premier écueil est tombé : ce n’est pas l’Humain (avec un grand H) qui a été augmenté avec l’informatisation de la société, ce sont ses capacités productives par l’algorithmisation des tâches que nous faisions et de celles que nous n’étions alors pas capables de faire, ainsi que la surveillance et le contrôle des processus de production et de décision (par l’analyse statistique).

Mais jusqu’à présent, nous n’avons pas réfléchi à l’État (avec un grand E). Dans tous ces discours technophiles, l’État n’a finalement jamais été réduit qu’à n’être au pire un passage obligé de l’autorité et du financement de projets (des centaines de milliards ont été injectés dans la recherche et le développement numérique), au mieux une caution pratique et un promoteur de stratégies économiques. Nous parlons de l’État, de son rôle dans ce rapport que nous entretenons avec les machines, mais il reste une boîte noire lorsqu’il s’agit d’analyser sa structure et ses institutions dans leur rapport avec le capitalisme de surveillance. Certes, nous avons une idée désormais extrêmement fine au sujet de la manière dont l’État utilise (s’augmente pourrait-on dire) les technologies d’automatisation pour récolter de l’information et contrôler la population, mais lorsqu’il s’agit de capitalisme de surveillance, nous avons tendance à nous concentrer sur les entreprises et la politique en général…

Capitalisme de surveillance et politique

Il est vrai que la question est d’abord politique. Un récent article d’AOC par le sociologue O. Alexandre (Alexandre, 2024) fait le point sur la manière dont les entreprises de la Silicon Valley retournent peu à peu leur veste, partant du soutien au parti démocrate américain pour aboutir, par l’adhésion à l’idéologie libertarienne, au conservatisme le plus dur. Selon cet auteur, cela ne concerne pas seulement la Silicon Valley, mais bel et bien l’ensemble des entreprises de la tech, y compris dans la France de la start-up nation macroniste : « pour chaque promesse de la révolution Internet des années 1990 (société de l’information, désintermédiation, dématérialisation, enrichissement) correspond aujourd’hui une tendance inverse (désinformation, domination des Big Tech, coûts environnementaux, croissance des inégalités) ». Mais la thèse soutenue consiste à affirmer que ces entreprises n’assument pas la « portée sociale » de leurs activités et que si l’État est aveugle, c’est parce que le problème se situe entre politique et entreprises.

Dans mon livre Affaires privées (Masutti, 2020) je pense avoir démontré à quel point, depuis les débuts de l’informatisation de la société, il y a un gouffre entre le discours émancipateur et le capitalisme de surveillance qui est devenu le modèle économique dominant, supplantant aujourd’hui en termes financiers les plus grandes industries historiques. D’autres l’avaient démontré encore mieux que moi. Il y eu d’abord Fred Turner, par l’étude de cas qu’il a consacré à Stewart Brand, démontrant ainsi combien l’idéologie hippie a été dévoyée sur l’autel du capitalisme numérique (Turner, 2012) au nom de la liberté et des idéaux de transformation sociale. Il y eu encore J. B. Foster et R. W. McChesney dans la Monthly Review qui montrent combien le capitalisme de surveillance s’appuie sur la logique impérialiste des États-Unis depuis la Guerre Froide et s’est accentuée par la surfinanciarisation à dessein des multinationales du numérique (Foster, McChesney, 2014). En somme, qu’on se situe sur le plan de la sociologie ou de la géopolitique, rien n’a jamais réellement plaidé en faveur d’une émancipation de l’homme par l’économie numérique si ce ne sont les discours tenus par les entreprises concernées elles-mêmes, relayés par les politiques pour justifier les stratégies de développement.

Si l’on y réfléchit bien, le mouvement pour le logiciel libre qui, dans ses principes, plaide en faveur d’une liberté d’usage, de partage et de création pour l’utilisateur et le programmeur, a été lancé en réaction justement à la tournure que prenait l’économie numérique en adoptant les pires archétypes de la propriété intellectuelle, et verrouillant l’accès au code. Il n’a pas fallu longtemps pour que d’autres réagissent au nom de la conciliation et du compromis capitaliste avec l'open source et il a fallu toutefois un peu plus de temps pour que ce soient les mêmes grandes entreprises qui collaborent le plus à la création de code libre afin d’alimenter un commun dont elles tirent le plus grand profit.

Toujours est-il que, dans cette longue histoire, l’État est rarement envisagé comme un acteur proactif du capitalisme de surveillance. Certes, il encourage, mais il encourage une sorte d’état de fait. Par exemple, depuis la fin des années 1960 aux États-Unis, les courtiers de données tels Demographics/Acxiom ont des relations privilégiées avec les politiques, notamment le parti démocrate, tout simplement parce que leurs services ont toujours démontré leur fiabilité dans le démarchage politique et le profilage en contexte électoral (Masutti, 2021). Les renvois d’ascenseur en termes de placement stratégique sont évidents. C’est ainsi que Charles D. Morgan, CEO d’Acxiom, basé en Arkansas, sera un grand ami intime des Clinton. L’approche peut avoir de quoi surprendre du point de vue européen, mais il ne faut pas oublier que la culture économique américaine est beaucoup plus pragmatique. Si les programmes politiques promettent des financements, c’est aussi parce que ces mêmes programmes sont encouragés par les capitalistes eux-mêmes, avec force donations et promotions, quel que soit le discours politique en vogue, progressiste ou conservateur, quitte à racler les fonds de poubelles pour convaincre les électeurs.

La passivité des institutions n’est toutefois qu’apparente. Dès les années 1970, le sénat américain lance des enquêtes approfondies sur les bases de données et leurs emplois, le concept de privacy est de plus en plus défini et employé dans les lois encadrant l’usage des bases de données, et très vite les dispositions juridiques de protection de la vie privée se déploient en Europe jusqu’à aujourd’hui. Et c’est un travail laborieux, le rocher de Sisyphe. De même, lorsqu’il s’agit de contrôle de la population ou d’équipement militaire, les finalités capitalistes et les objectifs de gouvernement convergent souvent. Les institutions de l’État ne se privent pas pour passer des marchés douteux avec les principales entreprises. C’est ainsi qu’en matière d’espionnage de masse il fut démontré, notamment par les révélations d’E. Sowden, les accointances manifestes des grandes multinationales du numérique avec la NSA dans l’espionnage de masse au niveau mondial. Mais ce scandale n’est pas isolé, loin de là, et de nombreux noms de programmes d’espionnage de masse et de contre-propagande ont fait surface dans l’histoire des États-Unis (Conus Intel, Cointelpro, Minaret, Echelon…).

Si on compare cependant avec la France, force est de constater que, mise à part la tentative maladroite de l’affaire SAFARI (révélée en 1974), l’espionnage des Français est mené par les services appropriés (type DGSE), avec plus ou moins de légitimité, de morale et de pertinence sur des cibles souvent fort discutables (comme récemment les militants environnementalistes) mais l’histoire française retient finalement peu de scandales proprement dits en matière d’espionnage de masse. Au lieu de cela, ce qui se produit, aux yeux d’un public attentif, à bas bruit mais de manière assez publique, c’est le recours systématique à la surveillance sur le mode solutionniste de l’externalisation à des entreprises pour des équipements et des logiciels à des fins d’espionnage. C’est-à-dire la légitimation croissante, par décrets et loi scélérates interposés (le pouvoir administratif supplantant le pouvoir judiciaire), de la surveillance de masse et de la mobilisation des finances de l’État à cette fin, la technopolice.

C’est là que se situe le vrai sujet : même dans ses efforts pour tenter de contrôler la population — disons plutôt surveiller et réprimer, car de contrôle par les dispositifs numériques il n’y a pas, à moins de doter les caméras de surveillance de grands bras mécaniques ou d’agir de manière prédictive, ce qui n’est pas exclu — l’État abandonne ses devoirs moraux et ses prérogatives : par l’automatisation de la décision de justice (c’est la bureaucratisation du pouvoir administratif) et par l’automatisation de la surveillance dont le savoir-faire appartient aux acteurs économiques qui, par lobbying auprès des institutions, engrangent les profits sur les deniers publics.

Une précision toutefois : il est faux de dire qu’il n’y a pas de contrôle, à part le contrôle réglementaire (police — justice — matraque). Il y a d’abord l’effet panoptique de la surveillance : plus on est surveillé plus on contrôle ses faits et gestes pour les conformer à l’attente (supposée ou réelle) de l’autorité (Bentham, 1789 ; Foucault, 1975). Il y a aussi le contrôle par influence, c’est l’application de la théorie néolibérale du nudge (Stiegler, 2019) (qui a fait long feu), la désinformation, l’astro-turfing, etc. bref toutes ces stratégies de communication dont les effets sont à la mesure de la surveillance de nos comportements par récolte de données et profilage marketing au service du politique.

Les États, les capitalistes, la surveillance

Au lieu de parler de l’État, parlons plutôt des États. Notamment parce que cela permet d’avoir une vision beaucoup plus fine de ce qu’est le capitalisme de surveillance. Par exemple, dans l’histoire de la privacy tous les États n’ont pas réagi de la même manière, au point que ce concept, aujourd’hui encore, est loin de signifier la même chose selon le pays dans lequel on se trouve. Les différences ne sont pas seulement continentales mais vraiment territoriales, car elles sont relatives à l’histoire des dispositifs juridiques (c’est pourquoi le RGPD en Europe ne peut jamais être qu’une harmonisation à bas niveau) et à leur confrontation avec les enjeux économiques.

Ensuite, il faut se poser la question de la méthode. La plupart des approches de la surveillance souffrent d’un biais assez gênant qui consiste à s’interroger d’abord sur les conséquences sociales de la surveillance sans se poser la question de ce qui rend effectivement possible la surveillance. Par exemple S. Zuboff se concentre sur la question de la division du savoir et du pouvoir que cela confère aux « capitalistes de la surveillance », ce qui lui permet de conclure la toute puissance de ces derniers qui détiennent, grâce au marché et à la concurrence, un pouvoir instrumentarien de modification des comportements. Dans cette affaire, l’État ne peut que tâcher de réguler, mais aucune critique n’est faite sur la manière dont ce pouvoir instrumentarien est en réalité partie intégrante de l’appareillage politique, notamment américain, et s’inscrit dans une suite de problématiques de pouvoirs au pluriel : géopolitique, clientélisme, militarisme, stratégie de financiarisation, choix économiques. En somme, l’idéologie néolibérale à la source de la connivence entre les acteurs capitalistes et les politiques n’est pas vraiment questionnée chez Zuboff. Ce qui l’est, c’est la moralité de ce capitalisme de surveillance.

D’autres points ne sont pas souvent questionnés à leur juste mesure dans les surveillance studies. D’abord, la technique et son histoire. Je me répète, mais il est plus qu’évident que la question de la surveillance ne peut être détachée des choix collectifs qui ont été faits dans l’histoire quant aux usages des techniques numériques de stockage, de base de données, et autres dispositifs. Ce furent des choix collectifs, dont la responsabilité ne peut être imputée à tels ou tels acteurs, simplement, l’appropriation de ces innovations et leur intégration dans les pratiques des entreprises, qu’il s’agisse de la production ou du marketing, sont autant de marqueurs qui font que la surveillance a une histoire technique qui ne « flotte » pas au-dessus de l’économie, mais répond à des choix réfléchis. En somme la surveillance n’est pas une simple idée qui consisterait à appliquer des techniques préexistantes dans le but de surveiller les comportements, monitorer des process, influencer les décisions : l’informatisation de la société est fondamentalement le choix collectif de la surveillance.

Partant de là, on peut donner (pas entièrement) raison à A. Giddens et sa critique du matérialisme historique dans The Nation State and Violence (Giddens, 1985) lorsqu’il affirme que les caractéristiques de la société capitaliste ne sont pas toutes visibles dans l’histoire marxiste de la production, de la lutte sociale et du capitalisme, mais que ce qui fait une société capitaliste, c’est la jonction entre son profil industriel, les formes de surveillance et de contrôle de sa population et le rôle qu’elle joue en tant qu’État-Nation dans sa confrontation concurrentielle aux autres. Autrement dit, le rapport social que nous entretenons avec les techniques de surveillance s’inscrit dans une configuration de l’État selon laquelle c’est le choix du capitalisme de surveillance qui a été fait, et pas un autre. Et il s’étend par la mondialisation des techniques et des pratiques (politiques, institutionnelles, économiques).

Autre aspect : les données de l’État et les données pour l’État. Dans un article passionnant, l’historienne Kerstin Brückweh étudie le cas de la Grande Bretagne et la manière dont les données de recensement ont consolidé la vision conservatrice d’une société de classes (c’était le Registrar General’s Social Classes, RGSC : upper class, upper middle class, lower middle class) en créant un tri social avec une granularité fine (Brückweh, 2016). Ces données des recensements ont alors permis, par leur mise à disposition publique, des méthodes de collecte et d’analyse de données, d’abord développées et utilisées par les entreprises à des fins d’études de marché et d’opinion, puis adoptées par les gouvernements pour gérer les populations et distribuer les ressources publiques. Il s’avère que pour des études statistiques bien menées, le RGSC ne correspond que très difficilement à la réalité sociale, mais tout le travail des statisticiens britanniques d’après-guerre consista à rechercher les meilleurs modèles de tri social, ne remettant aucunement en cause le paradigme dominant. Une politique de royalties fut mise en place, permettant au gouvernement de valoriser ces données lorsqu’elles étaient utilisées à des fins commerciales. Avec l’apparition de l’informatique, et les méthodes de la géodémographie, la classification par grade fut remise en cause, et des nouvelles classifications virent le jour, à la fois très malléables et qui confirmaient de plus en plus les fournisseurs externes dans leur savoir-faire. Mais la montée en charge et en valorisation des entreprises spécialisées laissa aussi la possibilité au gouvernement néolibéral de M. Thatcher d’externaliser complètement le recensement. Comme le montre K. Brückweh, c’est justement cette externalisation qui confirma une sorte de démission du gouvernement britannique de sa tâche de classification sociale : le néolibéralisme thatcherien niait complètement la société au profit d’une vision extrêmement individualiste, ce qui rendait finalement inutile la tâche gouvernementale de garantir la cohésion sociale, même si la classification par tranche a ses limites et son intérêt faible en termes de contrôle populationnel. Au-delà de cette étude, K. Brückweh montre que l’analyse du travail de l’État, par la standardisation et la simplification ou l’abstraction, comme le décrit James Scott dans L’œil de l’État, constitue une bonne approche dans la mesure où le tri social permet effectivement d’appliquer des décisions publiques.

Ce que j’en conclus, c’est que lorsque ce tri social devient complexe, qu’il acquiert une telle technicité que la seule solution consiste à l’externaliser, ce qui a fini par se produire avec l’informatisation. Ce travail n’est plus une simplification mais une opportunité de valorisation et de services : sondages et influence d’opinion deviennent les clés non plus de la décision publique, mais du placement politique et de l’acceptation de l’idéologie néolibérale. Ce qu’on pourrait appeler les « démissions » de l’État n’en sont donc que les corollaires, et c’est là encore un autre aspect du rapport entre surveillance et État. Si l’on regarde l’État français, les exemples ne manquent pas où les institutions publiques semblent abandonner leurs prérogatives au profit d’acteurs privés, alors qu’il s’agit en réalité de la même face d’une même pièce.

Prenons le cas de Doctolib : sous couvert de service à la population (le concept d’entreprise à mission) le monitoring des transactions sanitaires relève d’un acteur privé. Ce faisant, l’État contrôle mieux les dépenses publiques médicales et leur rentabilité, par exemple lorsque Doctolib propose de surveiller les « lapins » posés par les patients à leurs médecins, ou bien encore dans la mesure où Doctolib noue des contrats très rentables avec les hôpitaux qui ainsi ont l’opportunité de faire valoir leur offre de soins, d’autant plus que Doctolib prend le monopole de ce type de service. L’État transforme l’essai et les patients peuvent y trouver leur intérêt… sauf que le capitalisme rattrape toujours les situations qui lui échappent. Ainsi en Allemagne, Doctolib a déjà été pris la main dans le sac à valoriser les données à des fins publicitaires en utilisant des cookies tiers. De même, jouant le jeu des GAFAM, il a été reconnu que Doctolib héberge ses données, immenses et prometteuses, sur Amazon, bien le Conseil d’État ai jugé que Doctolib apportait les garanties suffisantes en matière de protection des données ; le contraire aurait été étonnant. Ce qui est moins étonnant, c’est que Doctolib a récemment annoncé qu’il allait entraîner de l’IA sur la base des profils utilisateurs, ceci de manière à mettre son nez dans le parcours de soin et même les pratiques médicales. Bref, la pression du besoin de rentabiliser les données est si forte qu’elle dépasse même les simples problèmes de sécurité comme la perte de données ou le chiffrement, et que Doctolib devra toujours s’y conformer. Lorsqu’il sera arrivé au bout de son modèle économique somme toute classique (vendre un service et devenir monopoliste dans le parcours patient auprès des institutions publiques et des structures privées), les données anonymisées, les données de fonctionnement, sans qu’il soit forcément question de données médicales ou de données personnelles au sens du RGPD, finiront par être transmises à des tiers, qui eux-mêmes savent très bien comment les traiter pour leur donner de la valeur à des fins d’influence comportementale, ce qui dans le domaine de la santé pose de grave questions éthiques autant qu’économiques.

Il serait intéressant d’envisager comment, dans certaines configurations politiques, qu’on pourrait nommer « démocraties autoritaires » pour prendre le cas de la France de ces dernières années, l’État devient une machine à transformer la surveillance en contrôle. L’exemple-type en la matière, c’est la pandémie de Covid durant laquelle la mobilité des citoyens était largement mise en question. Quel est l’impact réel d’un déplacement massif, par exemple lorsque la population aisée d’Ile-de-France se carapate en campagne pour écouter les petits oiseaux alors que les « premiers de cordée » continuent à prendre des risques sanitaires pour faire tourner la boutique ? En 2020, l’INSERM dévoile une étude à partir des données du fournisseur téléphonique Orange sur ses abonnés de téléphonie, pour voir quels modèles épidémiologiques il possible d’observer. Mais au fond, c’est exactement ce qu’avait demandé la Commission Européenne à tous les opérateurs téléphoniques. Comprendre l’épidémie, adapter la décision publique à la situation, que l’intention soit justifiée ou plus discutable, là n’est pas le propos : tout cela nécessite évidemment l’absorption de données issues de la surveillance par des entreprises privées qui en ont le pouvoir et la capacité. Cela n’est pas nouveau, mais la question sous-jacente est celle-ci : à quel point les données de la surveillance comportementale produite par des entreprises privées pour des objectifs de marketing et d’influence économique, peuvent aussi servir de nouvelles finalités de contrôle par l’État, démultipliant ainsi son pouvoir d’observation et de prédictibilité statistique tout en organisant sa propre dépendance vis-à-vis de ces acteurs privés, et donc de leurs intérêts ?

Tiens, encore un exemple, plus ancien : on parle peu de l’Association Auxiliaire de l’Automobile, qui durant longtemps se chargeait d’émettre des statistiques sur le secteur économique de l’automobile. Forte d’une base de données énorme spécialisée dans ce secteur industriel et ses filiales, l’AAA était le pendant associatif du Comité des Constructeurs Français d’Automobiles (CCFA) qui avait, jusqu’à la création du Système d’immatriculation des véhicules (SIV) en 2009, le monopole de la gestion du fichier national des immatriculations. Il s’agit d’un vieux fichier sous la responsabilité du ministère des Transports qui, au début des années 1980, en contrepartie de différents services (dont les services de gestion de flotte de véhicules, par exemple) en avait confié la gestion à l’AAA qui s’en servait notamment à des fins de marketing personnalisé. La CNIL n’avait pas trouvé grand-chose à redire à ce propos, mentionnant que « la fourniture d’informations à ces utilisateurs privés qui s’inscrit dans le cadre des activités industrielles ou commerciales du secteur automobile, répond à un intérêt général en assurant la promotion d’un secteur clé de l’économie nationale » (voir la délibération de 1983). La convention qui liait l’AAA et l’État a pris plus ou moins fin en 2009 avec la création du SIV, et quoi qu’il en soit les informations du SIV sont, depuis la directive européenne du 20 juin 2019, complètement ouvertes à des autorisations de réutilisations à des fins de prospection commerciale. Toujours est-il que, pendant des décennies, l’AAA a engrangé des données et développé un savoir-faire, avec l’œil bienveillant de l’État et pour le bien de l’industrie automobile. Aujourd’hui l’AAA est devenue une société à part entière, nommée AAA-Data, filiale du CCFA, elle exploite toujours les données d’immatriculation, et reste un acteur incontournable dans la gestion de données industrielles en France. En 2015, AAA-data a annoncé un partenariat avec Acxiom dans le but de créer un service destiné aux annonceurs, dans le cadre de programmes marketing. Autant dire que la libéralisation de ce marché de la donnée d’immatriculation a surtout fonctionné pour le plus grand bien d’AAA-Data qui, non seulement conserve un certain monopole, mais en plus peut se permettre de monétiser les données d’immatriculation en parfaite légalité, et en toute conformité RGPD, bien sûr.

Quant à Acxiom, cette entreprise américaine domine aujourd’hui en France comme ailleurs en Europe le marché du courtage de données. Elle a racheté des sociétés comme Claritas et Consodata et là où elle ne parvient pas à prendre le contrôle, elle multiplie les partenariats (comme avec AAA-Data, par exemple). Cela pose évidemment un problème de souveraineté sur les données de consommation1. En d’autres termes, avec la libéralisation des fichiers de données publiques (du type SIV, ou les données de recensement, etc.), les pays européens se sont eux-mêmes enfoncés dans un marasme dont il sera difficile de sortir. Bien que tout cela soit évidemment conforme au RGPD, il reste que les données fournies par les puissances publiques sont (ont toujours été) des mines pour les courtiers de données. La différence, aujourd’hui, c’est que non seulement le courtage de données connaît une phase monopoliste dominée par les multinationales américaines, mais en plus sont capables de fournir des solutions marketing (tel le CRM-Onboarding2) dont la puissance d’influence comportementale pose (devrait poser) des problèmes de gouvernance démocratique.

Sauf que ces problèmes de gouvernance sont, dans beaucoup de pays, largement dépassés par l’intérêt des États à traiter avec les courtiers de données. Il s’agit en quelque sorte d’un retour sur investissement (que cet investissement soit celui de la participation des fonds publics à l’économie numérique ou carrément de la fourniture de données publiques). Aux États-Unis, tantôt des sociétés fournissent aux autorités des données de géolocalisation durant la pandémie (Veraset), tantôt elles s’investissent du pouvoir de protéger le droit à l’avortement en choisissant de ne pas stocker les informations relatives aux centres IVG (Google), tantôt elles proposent la reconnaissance faciale pour lutter contre l’immigration illégale (Amazon), ou ciblent les personnes susceptibles de commettre un crime dans le cadre du traitement de données juridiques (LexisNexis), ou encore surveillent pour l’État les passagers aériens (Acxiom post 11/9 et ses grands contrats de surveillance au risque du piratage)…

En France, nous n’en sommes pas encore là… diraient les plus candides. Le site Technopolice dévoile cependant une petite partie de l’écosystème de partenariat public/privé dans le domaine de la surveillance et de la répression des populations. L’accessibilité des données publiques est le faire-valoir de façade : dans le contexte de la smart city, publier des données publiques revient à encourager et rendre plus efficiente la numérisation de la société, et en même temps facilite grandement la mise sous monitoring permanent de la société. Ceci est d’autant plus pertinent que nous avons en France une politique des plus efficaces de gestion et de captation des données par les services publics : la start-up nation du président Macron n’a pas d’autre but que de favoriser ces partenariats public-privés, quelle que soit leur finalité… bienvenue si, en plus, elle permet d’accroître les capacités d’action de la force publique ou de servir les intérêts bourgeois.

En matière de politique, les partis eux-mêmes ont en France déjà largement franchi le pas en matière de profilage à des fins électoralistes, tout comme dans la majorité des pays dans le monde. Moyennant quelques euros, il n’est aujourd’hui pas très difficile d’élaborer une banque de profils. La question n’est plus vraiment de porter l’opprobre sur les utilisateurs des médias sociaux qui dévoilent toute leur vie privée, nous n’en sommes plus là : les techniques élaborées par les courtiers de données, par le pompage tentaculaire d’une pléthore de banque de données publiques et privées, permettent un profilage bien plus pertinent et implacable que les seules données de l’ingénierie sociale (d’ailleurs largement automatisée depuis longtemps).

Spécialiste en études de surveillance, Colin Bennett montre dans une étude comparative, que ce sont les gouvernements néo-conservateurs qui sont le plus susceptibles d’adopter des solutions de surveillance algorithmique avec le concours des entreprises de courtage de données, y compris les Gafam. Si la surveillance comprend aujourd’hui la totalité des processus de production et de consommation, ce n’est pas parce que ces technologies de surveillance sont apparues sur le marché qu’elles furent adoptées comme une fatalité. C’est parce que la décision publique s’est orientée sciemment vers cette tendance. Selon David Lyon (Lyon, 2001, p. 74), les sociétés capitalistes sont les plus enclines à développer des pratiques de gestion de risque (pour pallier aux incertitudes économiques ou aux externalités) ainsi que des pratiques de contrôle identitaire (dans une société capitaliste, le contrat est la forme juridique principale de relation, il faut donc toujours identifier la personne avec le plus d’exactitude). Or, le contrôle identitaire comme la gestion des risques reposent aujourd’hui sur des organisations tierces, autres que l’État. Il y a donc des interrelations rendues nécessaires dans toutes les démocraties libérales pour lesquelles le modèle capitaliste est réputé indépassable, mais avec quelques nuances. Comme l’exprime Collin Bennett :

« Le développement précoce et généralisé de ces techniques aux États-Unis s’explique en partie par un système politique plus fragmenté que dans les régimes parlementaires. La faiblesse et l’incertitude des lignes d’autorité hiérarchique du Congrès et de la présidence permettent une multitude de liens horizontaux complexes et entrelacés entre les fonctionnaires de niveau inférieur. Ces issue networks facilitent le partage de toutes sortes de données et d’informations sur les politiques publiques. L’appariement informatique prospère entre et au sein de l’ensemble d’agences diverses, non intégrées, incohérentes et décentralisées qui constituent la bureaucratie fédérale américaine. » (Bennett, 1992, p. 255)

De manière générale, dans tous les pays, le degré de surveillance dépend pour beaucoup de la qualité des frontières entre l’État et la société civile. Plus les frontières sont floues, plus des acteurs privés tendent à assurer des fonctions normalement publiques, plus il y a de partenariats entre public et privé, moins la protection des libertés civiles est assurée à l’encontre des velléités de contrôle des populations et de l’influence comportementale. La notion de liberté dans le Contrat Social, réputée au fondement des démocraties libérales, n’est donc pas seulement menacée par le capitalisme de surveillance, elle est menacée parce que les institutions et les structures gouvernementales viennent à dépendre de ce capitalisme et œuvrent pour lui.

En façade, toutes les réglementations risquent de ne jamais suffire. Pour reprendre encore C. Bennett :

« Cette étude comparative de la dataveillance a mis en évidence les limites de la réglementation procédurale. Les nouvelles formes de dataveillance mettent à rude épreuve la crédibilité de la théorie de la protection de la vie privée, des lois sur la protection des données qu’elle sous-tend et des agences chargées de faire appliquer ces lois. Dans le meilleur des cas, ces agences ne peuvent réagir qu’au niveau individuel. Elles peuvent assurer une certaine transparence du processus, établir des règles pour la qualité et l’intégrité des données, insister sur des analyses coûts-avantages crédibles avant de procéder à des rapprochements de données, recevoir et résoudre des plaintes individuelles, mais elles ne peuvent pas mettre un terme à la dataveillance. » (Bennett, 1992, p. 256)

Mètis et tactiques : la résistance, de Scott à de Certeau

Face à l’algorithmisation de la décision publique qui impose ses propres rationalités en instaurant un « État-plateforme » et encourage l’action des multinationales du numérique (Mabi, 2019), face au pouvoir des courtiers de données, qui font bien peu les objets d’études sérieuses, certains plaident en faveur d’un nouveau Contrat Social (Reviglio, 2022). Est-ce suffisant ? ou plutôt : est-ce encore pertinent ? Après tout, l’idéologie libertarienne des magnats de la Silicon Valley s’accommode très bien des partis les plus conservateurs et réactionnaires, les subventionne, même. La raison est que, avec de telles idéologies politiques, le profit ne manquera pas à ceux qui proposeront les solutions techniques qui permettent de désengager l’État le plus possible. Le sempiternel refrain du coût exagéré des services publics trouve toujours des oreilles attentives. C’est par exemple la raison pour laquelle la blockchain est tellement plébiscitée, en dépit de son impact écologique : il suffit de comprendre que la blockchain permet au fond de transformer notre rapport au droit. Les notions de propriété ou d’obligation, une fois contractualisée en blockchain peuvent devenir des actifs dont le contrôle n’est plus relatif aux institutions mais à la technologie. Au lieu de réinvestir la parole publique dans le code comme le préconisait L. Lessig (Lessig, 2000), il s’agit non plus d’accepter mais de voir comme une fatalité que le code fait loi, c’est-à-dire créer une société où il n’y aurait plus de négociation mais uniquement la rigidité des contrats et l’inscription de nos relations dans une chaîne algorithmique (supposée) éternelle3. Plus besoin d’institutions.

D’aucuns pourraient alors se réfugier dans le rejet technophobe. Comme je l’ai déjà dit, c’est à la fois une erreur (c’est méconnaître la puissance des technologies de surveillance à moins de se retirer complètement du monde), et une défaite mainte fois explorée, sans issue. Oui, il faut réinvestir socialement les technologies et cela peut se faire de multiples façons. Mais quel est le moteur de cette appropriation sociale ? Hé bien c’est une manière de réviser notre rapport avec l’État, c’est-à-dire opposer à l’État ce qu’il y a de proprement ingouvernable et qui donc échappe par définition à la surveillance.

Qu’est-ce donc qui soit si ingouvernable dans la société, et par extension hors d’atteinte des algorithmes ? Ce sont les sommes de savoirs et savoir-faire que justement nous gardons hors du gouvernement (ou de la bureaucratie privée) parce que nous savons que les y abandonner serait une forme de suicide social. Les définir revient à discuter de deux manières de les concevoir, la première est celle de James Scott, la seconde celle de Michel de Certeau. Dans les deux cas, savoir ce qu’on veut en faire est une question éminemment anarchiste.

Avant d’aborder cette question, faisons un petit détour par le regretté Bernard Stiegler. Pour lui, il y a un concept qui résume bien le fait de priver les individus de savoir et de savoir-faire, c’est la déprolétarisation. C’est la perte, dans la société, de la capacité de l’individu à produire ses modes d’existence et son rapport aux choses. Dans le système productif, c’est la perte de son autonomisation au travail, en particulier par l’automatisation des processus productifs. Et aujourd’hui, cette question ne touche plus seulement l’ouvrier mais tout le monde. C’est ce que Graeber a formulé dans son livre Bullshitjobs (Graeber, 2018), cette perte de sens au travail qui finalement fait aussi écho à la prolétarisation de nos vies en général : la bureaucratisation, si longtemps décriée (au moins depuis Max Weber), a pris des proportions telles que nos vies entières sont soumises à des processus qui en font perdre le sens, mais il s’agit aussi de nos états psychiques, nos désirs, nos relations interpersonnelles, toutes soumises à la fois à l’algorithmisation des « services » numériques et à leur enshitification.

Mais ce que Bernard Stiegler appelle les savoirs et savoir-faire sont en fait ceux qui sont sujets à l’automatisation, c’est-à-dire ces savoirs et savoir-faire que l’on peut définir, mesurer statistiquement, et qui correspondent à des stéréotypes auxquels soit nous essayons de nous conformer, parce que nous influencés dans ce sens, ou auxquels nous sommes contraints au risque de l’exclusion sociale. Et il est vrai que cette conformisation est d’autant plus forte que nos vies se numérisent, car hors du calcul, point de salut.

Cependant, il demeure que les savoirs et savoir-faire sont un puits sans fond. Il existe une foule de choses que savons et faisons, quitte à les inventer ad hoc, qui échappent à la surveillance, et même à la formulation, et par lesquelles néanmoins, la société « se tient »… parce que nous le décidons ainsi. Qui n’a pas constaté par exemple, dans une organisation faite de procédures dûment renseignées et définies, combien le fait de respecter à la lettre ces procédures conduit tout droit à une situation erratique, là où justement, conscient que les procédures ne peuvent jamais couvrir l’infinité des situations possibles, la décision de ne justement pas les respecter permet au système de perdurer. Ce savoir-là, cette manière de faire, issue à la fois de l’expérience et de la théorie sans en être toutefois la déduction, c’est ce que les grecs appelaient la mètis et que James Scott situe au plus haut de l’organisation sociale.

La mètis, c’est Ulysse trompant le Cyclope par la ruse et Ulysse capable de redonner espoir à ses marins tout en réparant le bateau… parce qu’il est Ulysse. Ce n’est pas seulement la ruse, c’est la ruse d’Ulysse, ce n’est pas du management, c’est la manière d’être d’Ulysse, ce n’est pas du bricolage, c’est la capacité d’Ulysse à réparer le bateau. Rien dans ces situations ne peut être préalablement documenté (il n’y a pas de manuel d’odyssée pour marins perdus), rien ne sera documenté ou théorisé si ce n’est l’histoire que l’on raconte (et qui change sans cesse), et c’est justement pourquoi Ulysse plus qu’un autre est capable de rentrer à Ithaque.

On a très souvent confondu la mètis avec la ruse. Cette idée est plutôt une interprétation des écrits d’Aristote, qui la compare à la feinte, à la manière rapide de faire quelque chose et a trait à la contingence, l’indeterminé. Ceci par opposition à un savoir, qu’il soit issu de l’expérience ou de la théorie, mais qui puisse être explicité. Pour rester chez Aristote, ce n’est pas non plus la phronèsis cette « prudence » qu’on pourrait dénommer « sagesse pratique », juste équilibre entre l’excès et lemanque. D’un autre côté, on a aussi traduit mètis par « intelligence pratique », ce qui n’arrange pas vraiment nos affaires. Il faut lire sur ce point le travail remarquable fait au début des années 1970 par M. Detienne et J.-P. Vernant (Detienne, Vernant, 2018) sur la polysémie de la mètis et qui montre combien les grecs y accordaient une grande importance, aussi bien qu’au logos qui s’énonce clairement.

J. Scott, dans L’Œil de l’État, prend une définition qui n’est pas du ressort du logos et en même temps reste une forme de prudence. Pour lui, la mètis ce sont des savoirs et savoir-faire « aussi précis et concis que nécessaires ». Elle s’adapte aux situations toujours différentes. Elle se situe entre le génie (ou le talent) et le savoir codifié. Enfin, elle est toujours locale, relative à un contexte donné, et surtout elle dépend aussi des conditions sociales, par exemple des savoirs et savoir-faire transmis sur plusieurs générations. Il faut une « communauté d’intérêt, un stock d’informations cumulées et des expérimentations continuelles ». La mètis est donc à la fois individuelle – elle dépend d’un « tour de main », et aussi collective – la structure sociale en détermine le besoin pourrait-on dire.

Ceci étant dit, que fait James Scott dans L’Œil de l’État ? il passe en revue une pléthore de cas où l’État finalement échoue dans ses projets de gouvernement ou bien lorsque l’entreprise échoue dans sa tentative de vouloir gouverner les processus de production. Il explique cela en deux temps. Premièrement, le fait que tout projet de gouvernement tend à vouloir simplifier et standardiser, qu’il s’agisse du gouvernement soviétique dans sa volonté de planifier l’agriculture ou l’industrie, ou (avant que les thuriféraires de Hayeck ne se pointent) la standardisation et la simplification du marché libéral (la circulation de l’information économique est une simplification du monde ce qui explique les crises capitalistes et la volonté de ne jamais voir les « externalités »). C’est la même chose selon James Scott. Et deuxièmement, la raison de cet échec, c’est justement la mètis, c’est-à-dire le fait que dans tout projet, chaque acteur au plus bas de l’échelle, chaque non-décisionnaire, n’est jamais déprolétarisé entièrement. Il subsiste toujours une manière de procéder qui est mise en œuvre à bas bruit, à l’échelle locale, qui permet justement que l’ensemble que l’on croit ainsi gouverner, puisse tenir malgré tout. C’est l’exemple de l’agriculture soviétique qui, selon James Scott (car la réalité n’est jamais aussi nette), ne tenait que parce que les paysans dépossédés de leurs terres, conservaient malgré tout un semblant d’économie agricole locale par des petits jardins discrets et des petits échanges, autant de temps de travail et d’espaces géographiques« volés » à l’État central et maintenaient l’ensemble plus ou moins fonctionnel.

C’est cette mètis que James Scott oppose à la gouvernementalité. C’est-à-dire, qu’il y a toujours de l’ingouvernable et que c’est justement ce qui permet aux structures sociales de tenir. Pour J. Scott,ce n’est pas l’information qui stabilise l’ordre du monde, c’est la mètis. Or, l’usine tout comme l’ordre administratif, par leur volonté de simplifier, de standardiser, d’uniformiser, en usant de la violence bien souvent, cherchent justement à briser la mètis :

« Le véritable génie des méthodes modernes de production de masse que fut Frédérick Taylor perçu avec une grande acuité le problème de la destruction de la mètis et de la transformation d’une population d’artisans quasi-autonomes et réfractaire en unité plus aisément contrôlable à savoir les ouvriers. » (Scott, 2024, p. 9)

La conclusion de James Scott, va encore plus loin. Pour lui, la mètis joue un rôle non seulement structurant, mais supérieur au gouvernement des choses. Économies collectivistes ou usines capitalistes dépendent d’une économie informelle étrangère aux schémas simplifiés :

« Tous les systèmes socialement élaborés sont en fait les sous-systèmes d’un système plus vaste dont ils sont au bout du compte dépendants voire parasitaires »

Je peux concéder que ce « vaste système », cette part d’ingouvernable en chacun de nous et qui construit nos relations sociales, souvent il est vrai en réaction à l’autoritarisme de l’État ou de l’entreprise, est aussi l’objet de convoitise. Ne sont-ce pas les partis politiques qui souvent instrumentalisent notre ingouvernabilité pour mieux la canaliser et organiser la congruence idéologique qui permet de détenir le pouvoir dans les régimes (prétendus) démocratiques ? Ceci tendrait à prouver le bien-fondé de la pensée de James Scott. Mais d’un autre côté, lorsque ces mêmes partis politique usent et abusent du profilage numérique pour mieux manœuvrer l’opinion publique, n’est-ce pas aussi une manière de considérer le talon d’Achille de ce « vaste système » ? N’est-ce pas faire la part trop belle à la solidité de cette mètis si universelle que de penser qu’échappant aux statistiques, elle serait à ce point hors de contrôle ?

Pour poursuivre dans la même veine, on pourrait dire que le profilage dans l’économie numérique d’aujourd’hui tend de la même manière à simplifier et standardiser, mais la différence est que l’exercice du pouvoir que cela confère devient total parce que justement il y a abandon. Abandon des prérogatives de l’État par son reniement du Contrat Social (nous l’avons vu plus haut), ou abandon des individus happés qu’ils sont d’un côté par l’administration de leurs vies et de l’autre par leur propre abandon de leurs savoirs et savoir-faire au profit du confort bourgeois que l’on promet à tous. Non, pas tous : je rappelle qu’ici nous parlons exclusivement des sociétés capitalistes, et que le confort bourgeois est celui que l’on envie, pas forcément celui que l’on a…

L’algorithmisation de nos vies est sans doute le plus haut degré de destruction de la mètis. Au point que je pense sincèrement qu’elle est passée d’une forme de structuration (révolutionnaire possiblement) à une forme de résistance. Elle n’est plus supra mais infra sociale.

C’est là qu’une lecture de Michel de Certeau, réactualisée à l’aune de l’économie numérique, peut s’avérer profitable. C’est à cet exercice que se sont récemment livrés B. Latini et J. Rostand (Latini, Rostand, 2022). Je vous laisse découvrir ce dernier texte dont vous trouverez la référence en bibliographie.

Disons pour faire simple que Michel de Certeau est le contrepoint de la pensée post-structuraliste des Foucault et compagnie. Contrepoint, et non opposition. S’il existe des structures qui permettent de comprendre un état social, ce dernier n’en est pas pour autant le prisonnier, et les individus qui composent les « masses », ne sont jamais entièrement déterminés par la structure, les institutions ou les modèles d’interactions. Il est plus facile, en effet, de penser notre assujettissement à l’économie (numérique ou autre) que de penser les manières dont, en pratique, nous nous organisons dans ce terrain hostile.

Peut-être est-ce là la raison de la relative discrétion du travail de M.de Certeau aujourd’hui, à un moment où sa lecture pourrait être profitable. En effet, là où Foucault proposait une critique des institutions pour démontrer les modes d’assujettissement, on a cru voir, en une comparaison trop rapide, un lien évident entre la surveillance et le contrôle panoptique. La lecture de Surveiller et punir est en ce sens une sorte de poncif, surtout lorsqu’on ne tient pas compte la critique du néolibéralisme déjà plus qu’en germe chez Foucault, mais dans d’autres livres.

Là où M. de Certeau se situe, c’est sur un autre plan : nous ne sommes pas que des sujets. Nous sommes capables de nous exprimer de manière autonome, et M. de Certeau nous emmène sur le terrain du quotidien, là où nous opérons nos pratiques et nos créativités, par le fait même que nous trouvons dans ce quotidien la raison créatrice et finalement émancipatrice. Michel de Certeau voit son champ de recherche situé « dans un ensemble de précédents et de voisinages, par exemple les recherches récentes sur l'« intelligence pratique » (la mètis) des grecs ou sur le « sens pratique » et les « stratégies » kabyles et béarnaises » (Certeau, 1990, p. 35). Si l’auteur se réfère explicitement à P. Bourdieu, il ne s’embarque pas pour autant vers la théorie de la pratique. Son objet est de concevoir quels sont les modèles d’action des « gens », ces consommateurs qui sont en réalité les dominés sans toutefois être « ni passifs ni dociles », et comment « le quotidien s’invente avec mille manières de braconner ».

Dans l’économie numérique, il y a de nombreuses figurent qui illustrent très bien ce braconnage. Un autre mot a été utilisé : le bricolage du hacker. La figure historique du hacker est bien celle qui se réapproprie des outils pour en tirer autre chose, pas seulement l’améliorer, mais le transformer pour son usage et le partager, par un processus créatif. Pour autant, nous ne sommes pas tous des hackers, et nous rejoignons là l’idée de James Scott : il y a une inégalité de distribution des « tour de main », des manières de faire et des manières de voir. Par exemple,un hacker évolue dans un milieu social qui rend ses hacks pertinents et sans une communauté de hacker, il est difficile de se reconnaître et d’agir comme tel.

La pensée de M. de Certeau va un peu plus loin que cela. Ce n’est pas la communauté qui est importante, car elle ne sert finalement qu’à prendre conscience de soi. En fait, ce que nous dit de Certeau, c’est qu’en dehors d’un système de représentation et d’identification, nous usons des objets de mille manières différentes, quelles que soient les modes d’utilisation qui nous seraient imposés.

Se souvenant d’une visite dans un village reconstitué, de Certeau envisage les outils anciens exposés dans les maisons, des outils déjà utilisés et marqués par les usages :

« Comme les outils, les proverbes, ou autres discours, sont marqués par des usages ; ils présentent à l’analyse les empreintes d’actes ou de procès d’énonciation ; ils signifient les opérations dont ils ont été l’objet, opérations relatives à des situations et envisageables comme des modalisations conjoncturelles de l’énoncé ou de la pratique ; plus largement, ils indiquent donc une historicité sociale dans laquelle les systèmes de représentations ou les procédés de fabrication n’apparaissent plus seulement comme des cadres normatifs mais comme des outils manipulés par des utilisateurs. » (de Certeau, 1990, p. 39)

Dans le quotidien, les objets ont « mille combinaisons d’existence », et c’est cette presqu’infinité des modes d’usage qui marque la créativité des utilisateurs. Critiquant l’anthropologie et la sociologie institutionnalisée par des paradigmes ou même des dogmes, de Certeau montre qu’elles ont tendance à faire oublier ces infinités de mode d’être, reproduisant ainsi ce que l’ordre bureaucratique, le cadre normatif des institutions, cherchent eux aussi à faire oublier par des artifices comme la « valeur commune », l'« ordre naturel », ou « immémorial » : la résistance naturelle de la métis sort systématiquement de tout cadre normatif :

« L’ordre effectif des choses est justement ce que les tactiques « populaires » détournent à des fins propres, sans l’illusion qu’il va changer de sitôt. Alors qu’il est exploité par un pouvoir dominant, ou simplement dénié par un discours idéologique, ici l’ordre est joué par un art. Dans l’institution à servir, s’insinuent ainsi un style d’échanges sociaux, un style d’inventions techniques et un style de résistance morale, c’est-à-dire une économie du « don » (des générosités à charge de revanche), une esthétique de « coups » (des opérations d’artistes) et une éthique de la ténacité (mille manières de refuser à l’ordre établi le statut de loi, de sens ou de fatalité). La culture « populaire », ce serait cela, et non un corps tenu pour étranger, mis en pièces afin d’être exposé, traité et « cité » par un système qui redouble, avec les objets, la situation qu’il fait aux vivants. » (de Certeau, 1990, p. 46)

Nous bricolons tous, nous sommes tous des braconniers, et nous réagissons par des résistances au pouvoir. La pensée de M. de Certeau permet de mettre en perspective la toute puissance de la surveillance et l’influence comportementale. Les objets numériques font partie de notre quotidien : ce seul constat suffit à faire prendre conscience que nous réagissons toujours à contre-courant de l’illusion normative que l’économie numérique cherche à nous imposer.

Il serait faux de prétendre que, parce que nous consentons de temps à autre à ces contraintes, la société serait devenue amorphe et toute perméable à l’assujettissement algorithmique. Au contraire, il ne faut pas seulement regarder les communautés qui ont conscience de leurs propres efforts de résistance et développent des outils en conséquence. Il faut aussi regarder la manière dont les usages quotidiens recèlent des capacités de résistance. Il existe une culture populaire numérique à laquelle il faut aussi penser lorsque, nantis d’une mission d’évangélisation libriste, nous aimerions que les usages se transforment en vertu d’une autre normativité que nous aimerions voir advenir, celle des libertés numériques. Que voulons-nous vraiment en réalité ? organiser l’opposition frontale avec le capitalisme de surveillance ? ne serait-il pas finalement plus profitable de détourner, machiner, braconner, bricoler, et diffuser ces manières de faire, ces tactiques de résistances ? C’est de guérilla et de subversion dont il s’agit, pas d’une guerre de classes. Au lieu de vouloir un ordre nouveau et créer de nouvelles normativités, il est peut-être plus intéressant de contrefaire l’ordre que l’on veut nous imposer.

Bibliographie

ALEXANDRE, Olivier, 2024. « La Tech sur les chemins d’une contre-révolution ». AOC [en ligne]. 10/7/2024. [Consulté le 19/8/2024]. URL.

BENNETT, Colin J., 1992. Regulating Privacy: Data Protection and Public Policy in Europe and the United States. Ithaca : Cornell University Press.

BENTHAM, Jeremy, 1789. An Introduction to the Principles of Morals and Legislation. London : T. Payne.

BRÜCKWEH, Kerstin, 2016. « Das Eigenleben der Methoden. Eine Wissensgeschichte britischer Konsumenten-klassifikationen im 20. Jahrhundert ». Geschichte und Gesellschaft. Vol. 42, pp. 86‑112.

CERTEAU, Michel de, 1990. L’invention du quotidien. Paris, France : Gallimard.

DETIENNE, Marcel et VERNANT, Jean-Pierre, 2018. Les ruses de l’intelligence: la mètis des Grecs. Paris, France : Flammarion.

FOSTER, John Bellamy et MCCHESNEY, Robert W., 2014. « Surveillance Capitalism. Monopoly-Finance Capital, the Military-Industrial Complex, and the Digital Age ». Monthly Review [en ligne]. 7/2014. Vol. 66. URL.

FOUCAULT, Michel, 1975. Surveiller et punir. Naissance de la prison. Paris : Gallimard.

GIDDENS, Anthony, 1981. A contemporary critique of historical materialism. Vol. 1. Power, Property and the State. London : McMillan.

GIDDENS, Anthony, 1985. A contemporary critique of historical materialism. Vol. 2. The Nation State and Violence. Cambridge : Polity.

GRAEBER, David, 2018. Bullshit jobs. Paris, France : Éditions les Liens qui libèrent.

LATINI, Beatrice et ROSTAND, Jules, 2022. « La libre navigation. Michel de Certeau à l’épreuve du numérique ». Esprit [en ligne]. 2022. Vol. Janvier-Février, n° 1-2, pp. 109‑117. [Consulté le 4/5/2023]. DOI 10.3917/espri.2201.0109. URL.

LESSIG, Lawrence, 2000. « Le code fait loi – De la liberté dans le cyberespace ». Framablog [en ligne]. 2000. URL.

LYON, David, 2001. Surveillance society: monitoring everyday life. Buckingham, Open University Press.

MABI, Clément, 2019. « Gouverner l’État avec le numérique ». Dans : Algorithmes et décision publique. CNRS Éditions. Paris. Les essentiels d’Hermès.

MASUTTI, Christophe, 2020. Affaires privées. Aux sources du capitalisme de surveillance. Paris : C&F Éditions. URL.

MASUTTI, Christophe, 2021. « En passant par l’Arkansas. Ordinateurs, politique et marketing au tournant des années 1970 ». Zilsel [en ligne]. 2021. Vol. 9, n° 2, pp. 29‑70. URL.

REVIGLIO, Urbano, 2022. « The untamed and discreet role of data brokers in surveillance capitalism: a transnational and interdisciplinary overview ». Internet Policy Review [en ligne]. 4/8/2022. Vol. 11, n° 3. [Consulté le 25/8/2024]. URL.

SCOTT, James Campbell, 2024. L’œil de l’État: Moderniser, uniformiser, détruire. Paris, France : la Découverte.

STIEGLER, Barbara, 2019. « Il faut s’adapter » : sur un nouvel impératif politique. Paris, France : Gallimard.

TURNER, Fred, 2012. Aux sources de l’utopie numérique : De la contre culture à la cyberculture. Stewart Brand, un homme d’influence. Caen : C&F Editions.

Notes

-

Cela dit, d’après Wikipédia, « en juillet 2018, Interpublic annonce l’acquisition Acxiom Marketing Solutions, une filiale d’Acxiom, pour 2,3 milliards de dollars. Acxiom Marketing Solutions, représente les 3/4 des revenus d’Acxiom qui ne garde que son unité LiveRamp ». En France par exemple, Acxiom France semble désormais s’appeler Liveramp France depuis 2021. Il va falloir d’ici peu revoir la toile des courtiers de données, et c’est à mon avis Liveramp qui va tenir la barre. ↩︎

-

Voir cette video très simple qui explique le CRM onboarding, concernant la Redoute et Liveramp. ↩︎

-

Ecoutez le podcast (et sa conclusion) de l’excellente émission de Xavier de La Porte, Le Code a changé, « À qui profite le Bitcoin ? », France Inter, septembre 2023. ↩︎

07.07.2024 à 02:00

Organisation et production de texte

Les années passent et il est indéniable que les habitudes prises au fil du temps montrent leur efficacité au regard de la pratique plus que de la logique. Néanmoins, il me semble que mon organisation logicielle et mon flux de production peuvent intéresser. C’est pourquoi je vous les présente ici.

Les objectifs

- Utiliser exclusivement des logiciels libres et des formats ouverts pour assurer la pérennité de la production dans le temps ;

- Pouvoir utiliser les logiciels que je veux (et au fil de mes découvertes) indépendamment de l’organisation de mes fichiers pour ne pas dépendre d’un logiciel en particulier ;

- Ne pas se retrouver prisonnier d’un format, fût-il libre ;

- Assurer la sauvegarde de mes sources et de mes travaux ;

- Pouvoir travailler sur plusieurs machines, à plusieurs endroits si je le souhaite.

Les choix stratégiques

Ayant l’habitude de travailler avec une suite bureautique comme LibreOffice et les formats ouverts, il me fallait trouver un processus qui soit capable de produire de tels formats. En revanche, l’utilisation de logiciels de traitement de texte, comme LibreOffice Writer, est assez lourde : bien qu’il soit possible d’utiliser les raccourcis claviers, l’ensemble propose une pléthore de menus et autres options qu’il n’est finalement pas pertinent d’avoir à disposition lorsqu’on produit du texte. Par ailleurs, la règle qui prévaut avec les suites bureautiques consiste à s’occuper de la mise en page après avoir produit du texte. Dans ce cas, pourquoi ne pas séparer les deux processus ? Séparer la production de texte de sa valorisation finale.

Il existe, d’un côté, des outils pour produire et organiser et, de l’autre côté, des outils pour finaliser et mettre en page. Se concentrer sur la production implique cependant d’avoir des outils spécifiques : faciliter l’écriture, y compris du point de vue ergonomique, permettre d’interagir facilement avec d’autres logiciels (gestion bibliographique, synchronisation des fichiers, etc), privilégier le texte dans l’interface sans l’enfermer dans un formatage dont il sera difficile de s’extraire par la suite.

C’est là qu’un troisième terme intervient : la conversion. À partir d’une production essentiellement textuelle, il doit être possible de convertir la production vers des formats soit directement destinés à être transmis, soit destinés à entrer dans un flux de mise en page spécifique. Par exemple, je convertis du texte vers un format LaTeX pour peaufiner une mise en page ou je le convertis vers un format ODT pour le transmettre à une autre personne qui a besoin de ce format, ou bien encore je produis du HTML ou du epub pour d’autres usages encore. Et cette conversion doit être la plus « propre » possible.

Les outils de production doivent être choisis en fonction des goûts et des pratiques. Comme il s’agit de texte, c’est donc vers les éditeurs de texte qu’il faut se tourner. Parmi ceux-ci, certains sont plus spécialisés que d’autres ou disposent d’options et d’extensions utiles à la production elle-même ou visant à améliorer la pratique de l’utilisateur.

Le format de référence

S’agissant d’un format dont la permanence dans le temps doit être assurée, le format devrait reposer sur une base de texte (plain text), écrit directement dans l’éditeur, formaté de manière simple et lisible humainement. Pour cela on laissera la possibilité d’exprimer des directives de mise en page et de hiérarchisation du texte, faciles à apprendre et gênant le moins possible la lecture. Au lieu de se contenter de texte simplement exprimé, on utilisera le langage markdown, un langage de balisage léger, simple à l’apprentissage comme à l’écriture et qui ne gêne pas la lecture (surtout si l’éditeur dispose d’une interprétation du markdown).

L’organisation

J’utilise une interprétation personnelle de la méthode Zettelkasten pour gérer mes connaissances et mes notes. Cela suppose une gestion rigoureuse des dossiers et des fichiers.

J’utilise aussi un logiciel de gestion bibliographique (Zotero) et un logiciel de gestion de livres numériques (Calibre), et j’apprécie l’utilisation d’un correcteur grammatical (comme Grammalecte).

Je sauvegarde mes sources et mes productions finales sur un serveur distant avec Nextcloud. Je travaille mes textes en les synchronisant avec Git sur un serveur Gitlab. Tandis que Nextcloud me permet d’avoir accès à mes sources depuis n’importe quel dispositif (tablette, liseuse, téléphone portable et ordinateur), travailler avec Git me permet de synchroniser lorsque je travaille sur différentes machines et de versionner mes productions intermédiaires et mes notes. Pour la bagatelle, l’ensemble est de toute façon sauvegardé de manière quotidienne sur un autre serveur avec Borg backup/Borgmatic.

Le choix des éditeurs

Un éditeur de texte doit comprendre à minima une coloration syntaxique permettant de visualiser les balises markdown. Mais ce n’est pas suffisant pour travailler sur des articles de recherche académique, par exemple. Il faut pour cela que l’éditeur puisse :

- proposer une interface agréable et hautement configurable pour une utilisation quotidienne,

- permettre d’écrire « au kilomètre » sans avoir besoin de saisir la souris à la moindre occasion,

- permettre si possible une interaction avec un logiciel de gestion bibliographique, par exemple pour saisir facilement les clés de références bibliographiques citées,

- proposer divers outils destinés à l’organisation de l’écriture : l’arborescence des fichiers, une navigation dans le texte, un gestionnaire de mots-clés pour les références croisées, une correction orthographique et grammaticale, etc.

- permettre de temps à autre une interaction avec le reste du système d’exploitation, par exemple avoir accès au terminal pour lancer des commandes de conversion, ou de gestion de fichiers,

- avoir accès à des petits programme de conversion « intégrés » pour un premier aperçu des résultats de production finale

Certains éditeurs de texte proposent tout cela en même temps, avec un système de plugins et il est parfois facile de se noyer dans la configuration d’un éditeur de texte. Comprenez : un éditeur de texte digne de ce nom doit pourvoir s’adapter à la pratique de son utilisateur, et non l’inverse. Si bien que les besoins étant relatifs, les solutions qui se présentent dans le monde des logiciels libres sont quasiment infinies. Il est même possible de programmer son propre plugin et refaire tout le mapage des commandes si on prend le cas des éditeurs Emacs ou Vim.

J’ai donc porté mes choix vers plusieurs éditeurs qui correspondent à mes usages et me permettent de choisir l’un ou l’autre selon mes envies et ce que je prévois de faire durant une session de travail :

- Zettlr : parce que ce logiciel a été pensé littéralement pour la production de textes scientifiques,

- Vim : parce qu’il s’utilise dans le terminal et qu’un Vim bien configuré avec les bons plugins est très efficace (plugins utilisés: vim-pandoc, vim-pandoc syntax, Nerd Tree, Grammalecte, vim-airline…)

- Gedit : un éditeur simple, prêt à l’emploi, sans fioritures.

- On peut aussi citer les éditeurs spécialisés pour markdown tel Ghostwriter.

Pourquoi ne pas…

- Utiliser Emacs ? je l’ai fait et le ferai encore. En ce moment c’est Vim. Emacs propose, du point de vue de mes besoins, les mêmes possibilités.

- Utiliser directement LibreOffice : certes les extensions de type Zotero et Grammalecte sont disponibles pour LibreOffice, et il est possible d’exporter depuis LibreOffice dans de nombreux formats. Par contre, LibreOffice ne propose pas une interface que je puisse conformer à mes usages et mes besoins, et tout particulièrement la possibilité d’écrire au kilomètre sans que mes mains quittent le clavier pour se saisir à tout bout de champ de la souris. Je réserve donc LibreOffice à un autre usage en fin de processus.

- Utiliser des logiciels de gestion de notes comme Obsidian ou Logseq : parce que justement leur usage spécialisé est trop éloigné de mes usages académiques.

L’organisation

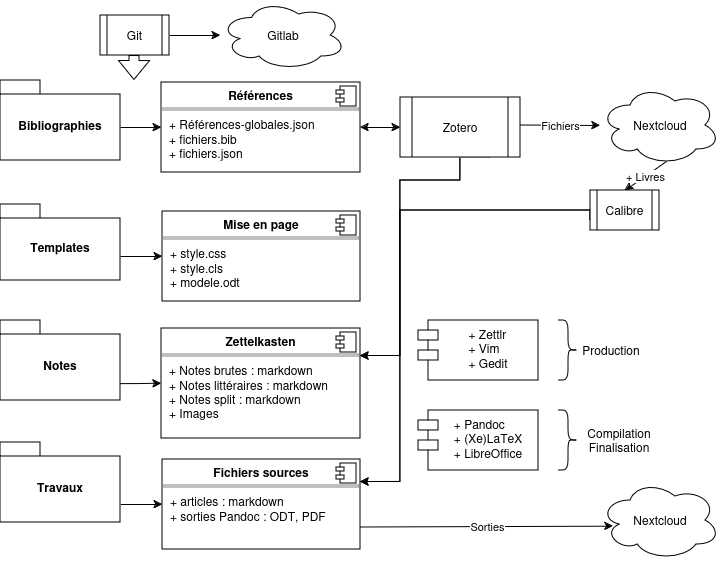

Rien ne vaut un bon vieux diagramme !

Comme on peut le voir, quatre dossiers principaux sont en jeu : Bibliographies, Templates, Notes, Travaux. Je ne sors pas de ces dossiers et ils sont systématiquement synchronisés avec Git sur un dépôt Gitlab.

Bibliographies : il contient les fichiers bibliographiques que j’utilise et tout particulièrement un fichier .json généré avec Zotero et qui se met à jour automatiquement à chaque ajout dans Zotero. C’est sur ce fichier que pointent mes éditeurs (Zettlr et Vim) pour interagir avec la bibliographie et entrer les clés de références.

Templates : il contient les styles et modèles utilisés pour les productions en sortie de flux. À savoir : les fichiers .csl pour les styles bibliographiques utilisés, les fichiers css utilisés pour sortir des fichiers HTML ou certains PDF, ou encore des modèles .odt qui me permettent de plaquer directement des styles à une sortie .odt « brute ».

Notes : Il s’agit de mes fichiers d’écriture selon la méthode Zettelkasten.

Travaux : là où sont rédigés les textes destinés à sortir du flux, par exemple des articles destinés à la publication. Notons que les sorties elles-mêmes n’ont pas vocation à être versionnées avec Git (seuls les fichiers sources le sont), et sont donc exportées dans d’autres dossiers (sauvegardés sur Nextcloud).

La conversion et la production

Pour convertir les fichiers markdown vers toutes sortes de formats (odt, html, pdf, docx pour l’essentiel), j’utilise Pandoc. Ce dernier présente de nombreux avantages :

- une version de Pandoc est directement intégrée à Zettlr

- il permet d’utiliser les templates et les moteurs qui configurent la sortie voulue, par exemple un fichier

.cssqui sera utilisé avec le moteur de rendu wkhtmltopdf pour produire un PDF avec une mise en page satisfaisante, ou encore un fichier.texqui contient déjà les en-têtes voulus pour produire un beau PDF, etc. Voir pour tout cela le manuel de Pandoc. - surtout il permet d’utiliser le moteur Citeproc et les fichiers CSL qui formatent la bibliographie dans le fichier de sortie.

Cependant, j’utilise LaTeX et LibreOffice souvent en phase de pré-production. Par exemple, lorsque je soumets un article à un comité de lecture, ce dernier souhaite un fichier odt ou docx et propose des corrections sur ce fichier ; c’est donc LibreOffice qui entre en scène. Il faut alors quitter le flux de production personnel pour envisager un nouveau flux. Autre situation : je convertis le markdown en .tex lorsque le modèle utilisé ne suffit pas à obtenir une mise en page spéciale et qu’il faut travailler cette fois directement avec LaTeX (bien que, en utilisant Pandoc, il soit possible d’intégrer directement du code LaTeX dans le fichier markdown).

Dans tous les cas, l’essentiel du travail se fait en amont et un article finalisé (et publié) réintègre toujours le flux pour en avoir une version markdown finale.

Un mot sur les autres logiciels

- Zotero : ce logiciel de gestion bibliographique est fort connu. Il présente l’avantage de pouvoir être utilisé dans les autres logiciels avec ses plugins : dans Firefox pour sauvegarder une référence automatiquement, dans Vim, dans Zettlr, dans LibreOffice. Il permet aussi de stocker les articles et autres sources référencées soit sur le serveur de stockage de Zotero (payant) soit sur un Nextcloud (via le protocole

webdav). - Calibre : c’est un logiciel de gestion de livres numériques. Ma collection étant assez importante, il me fallait pouvoir gérer cela autrement qu’avec Zotero, d’autant plus que j’y branche ma liseuse ou ma tablette en vue d’une lecture sur un autre support que l’ordinateur.

Astuces

Je ne vais pas ici vous expliquer comment configurer Vim au poil. Cela demanderait un développement assez long. Mais je vous conseille pour débuter le petit livret de Vincent Jousse, Vim pour les humains. Vous y apprendrez comment prendre en main Vim rapidement et comment installer des plugins. Le reste ira très bien.

Pour commencer avec Zettlr, c’est plus simple : dès l’installation de ce logiciel un tutoriel très bien fait et entièrement en français vous sera proposé.

Le markdown en un tutoriel pour historiens : Dennis Tenen et Grant Wythoff, Rédaction durable avec Pandoc et Markdown.

Comment faire avec Zotero pour obtenir un fichier (.bib ou .json) de bibliographie qui se mettra à jour automatiquement ? Voici :

- Installez le Plugin Better Bibtex pour Zotero,

- Dans Zotero, sélectionnez la bibliothèque que vous souhaitez exporter, clic droit puis

Exporter la bibliothèque, - Sélectionnez le format Better BibTeX Json et cochez la case

Garder à jour - Sauvegardez et entrez le chemin vers ce fichier dans Zettlr (ou dans votre

.vimrcpour configurer le plugin Vim-Pandoc) - Désormais, lorsque la bibliothèque Zotero subira des modifications, le fichier d’export sera toujours à jour (et vous retrouverez vos nouvelles références)

04.06.2024 à 02:00

Guide de survie du vététiste débutant en moyenne montagne

Voici un long billet dont j’ai remis la rédaction depuis bien trop longtemps. Il s’adresse aux grands débutants en VTT qui souhaitent s’y mettre. S’agissant de réflexions tirées de mon expérience personnelle dans les Vosges, il faut considérer que je m’adresse essentiellement aux débutants vététistes en moyenne montagne. Quatre grands thèmes sont abordés : la pratique du VTT, le choix d’un premier VTT, l’équipement et l’entretien.

(màj. juin 2024)

Table des matières

Il faut parfois s’accrocher pour ne pas se perdre parmi les différentes appellations qui désignent les pratiques du VTT. Ce n’est pas qu’elles soient nombreuses, c’est surtout qu’elles sont parfois utilisées de manière indifférenciée. Ainsi, certains sites ou vendeurs vous conseilleront exclusivement un VTT tout-suspendu pour la pratique du « All Mountain », tandis que d’autres vous diront que le semi-rigide comme le tout suspendu conviennent, car il ne s’agit que de randonnée sportive, soit du Cross country…

Les pratiques du VTT

Nommer la pratique que l’on souhaite avoir, c’est aussi conditionner le choix du matériel et donc son achat. Mon avis personnel, c’est que certains sites internet ont tendance à pousser le choix d’un VTT tout suspendu alors que le client débutant en est encore à se questionner sur les équipements de freins et transmission. En contraste, je n’ai encore jamais vu un bon vendeur dans un magasin de cycles soutenir mordicus que le client devrait obligatoirement choisir un type de VTT plutôt qu’un autre : le conseil doit être technique et comparatif dans une même gamme, mais la pratique appartient au pratiquant.

C’est pour cela qu’il faut d’abord réfléchir à la pratique que l’on souhaite. Il faut pouvoir faire confiance au vendeur et à ses conseils, mais auparavant il faut aussi savoir lui communiquer vos attentes. Il ne peut pas les deviner si vous ne savez pas répondre à ses questions ou si vous répondez sans réellement savoir ce que vous voulez.

Nous reviendrons plus loin sur l’éternelle question du choix entre un tout-suspendu et un semi-rigide.

Mais c’est quoi « le VTT » ?

Comme son nom l’indique en français, il s’agit de « vélo tout terrain ». En anglais, il s’agit de vélo de montagne (Mountain Bike). Bien que la version anglophone ai longtemps eu cours, je trouve que la version francophone est bien mieux adaptée : on peut utiliser un VTT sur chemin de campagne dans les collines sous-vosgiennes comme sur les pires aiguilles des Alpes. L’essentiel est que cela puisse rouler sur tous les terrains (il paraît que certains en font en Bretagne, c’est tout dire).

La seule chose que vous tâchez d’éviter, c’est la route, le bitume. Premièrement parce que vous risquez de vous y ennuyer en ayant l’impression de ne pas avancer. Deuxièmement parce que vos pneus et la géométrie d’un VTT ne sont pas faits pour cela.

Il y a plusieurs manières d’aborder le VTT. La première, c’est la petite promenade du dimanche sur des chemins de terre. C’est plus tranquille que sur la route, pas de voiture. Si tel est votre souhait, je ne pense pas qu’il soit utile de lire plus loin. Vous achetez un VTT assez bas prix (en dessous 500 euros, c’est tout à fait envisageable). Si vous en prenez soin, il saura vous durer. Mais un VTT ne sera peut-être pas votre choix le plus éclairé : il existe des vélos « tout chemin » (VTC) qui seront sans doute plus appropriés et, à l’occasion, vous permettront de faire des randonnées plus longues et plus confortables en alternant voies communales et pistes cyclables1.

La seconde et principale manière d’envisager le VTT, c’est le sport. De part sa géométrie, un VTT est d’abord un vélo sportif. Tout comme l’est celle du vélo de route (de course). Et comme toute discipline sportive, cela nécessite un entraînement régulier.

Le VTT n’a certes pas le monopole de la difficulté en sport, mais il faut reconnaître que ce n’est pas une discipline très simple. D’abord, il y a un aspect matériel à prendre en compte. Et surtout, il faut acquérir de l’endurance et de l’aisance de pilotage. Débuter le VTT comme sport vous engage à envisager quelques séances un peu décourageantes et ingrates devant les terrains accidentés et les montées interminables. Mais dès le début vous y trouverez beaucoup de plaisir et de satisfaction pour les distances et le dénivelé accomplis.

Simplement, essayez de choisir des circuits avec des points de vue, donnez-vous des objectifs, et ne présumez pas de vos forces. Soyez conscient·e de votre niveau. Si vous êtes blême en haut des marches et des racines, ou si vous avez le cœur en dehors de sa boîte au milieu d’une côte trop raide, il n’y aucune honte à descendre du vélo et faire quelques pas. Ne vous inquiétez pas, de toute façon, vous descendrez de vélo plus souvent que vous ne le croyez :)

Puisque nous parlons de sport, c’est l’occasion de rappeler quelques principes :

- la régularité : la météo ne doit pas être une excuse pour ne pas rouler. C’est désagréable, certes, mais un petit coup de froid ne fait pas de mal. Par contre, n’oubliez pas les descentes, n’allez pas vous transformer en glaçon. J’ai coutume de ne pas sortir le VTT en dessous 5 degrés à moins d’un grand soleil. Mais vous trouverez toujours quelques givré·es pour le faire quand même. La grosse pluie, en revanche, il vaut mieux l’éviter : le vélo est tout terrain, mais la transmission et les suspensions prennent cher lorsqu’il y a trop d’humidité (et gare au nettoyage).

- la mixité : le VTT est un sport, mais il ne doit pas vous empêcher d’en faire d’autres. La course à pied est un excellent complément pour travailler l’endurance. La natation vous aidera à obtenir plus de gainage (et aussi de l’endurance) tout en préservant vos articulations. Et chaque matin, un peu de musculation (sangle abdominale et pompes) pour améliorer votre pilotage, votre équilibre et résister aux longues sorties.

- mon conseil : si une sortie VTT est votre seule pratique sportive de la semaine, vous risquez de ne pas beaucoup progresser. Essayez, lorsque viennent les beaux jours, de faire au moins deux sorties par semaine, une courte une longue, et alternez avec de l’endurance et du gainage. En hiver, si vous ne sortez pas le VTT du week-end à cause de la météo, faites une séance de trail à la place, au moins deux heures, pour garder le « coffre ».

- en fonction de votre pratique (voir les sections suivantes), votre entraînement ne sera pas le même. Si vous vous lancez dans l’Enduro, je vous conseille de faire pas mal de musculation. Pour le Cross country, privilégiez le cardio.

Ces considérations étant exposées, intéressons-nous désormais aux différentes pratiques du VTT.

All mountain (on dit : Cross country, en fait)

C’est l’expression-valise pour dire « randonnée sportive sur chemins mixtes ». Par chemins mixtes, j’entends aussi bien des sentiers qui nécessitent un peu de pilotage technique (en descente comme en montée) et des grands chemins forestiers, le tout avec une certaine technicité des sentiers.

Et vous allez demander : n’est-ce pas justement la définition du VTT ? Et bien si, justement. Cette expression est selon moi purement issue du marketing, en particulier sur les sites de vente en ligne de matériel sportif. Si on multiplie les appellations de pratiques, on multiplie par conséquent les choix possibles.

Si je vous disais par exemple qu’un VTT tout-suspendu est essentiellement fait pour la descente, vous hésiteriez à juste titre car pour la plupart des gens, descendre des sentiers en vélo est forcément dangereux. Or, il a bien fallu multiplier les ventes de VTT tout-suspendus en les adaptant à ces personnes qui veulent un tel VTT sans pour autant se lancer dans la discipline Enduro. J’exagère à peine : le tout-suspendu a largement gagné le créneau du Cross country, mais comme je vais l’expliquer plus loin, c’est à certaines conditions seulement que ce choix doit être fait, et il est nullement obligatoire.

En fait, il n’y a que deux grandes pratiques de VTT, elles sont citées dans les sections suivantes. Et le choix d’un VTT tout suspendu ou semi-rigide est surtout un choix relatif à la manière de pratiquer et à l’investissement financier.

En moyenne montagne, pour un débutant, il n’y aura pas de grande différence entre un VTT semi-rigide 29 pouces et un tout-suspendu. Pour tout dire, on peut aimer le tout-suspendu parce que dans les grands chemins forestiers, on ressent moins de vibrations, et dans certains sentiers en descente on peut parfois engager un peu mieux des dénivelés… inattendus (parfois l’erreur de pilotage peu être plus facilement corrigée). Mais on aime aussi le semi-rigide car il est beaucoup plus nerveux en montée, il est plus léger, il est plus précis en pilotage dans beaucoup de situation, et les sensations sont plus authentiques. Certains diront même que le tout-suspendu, parce qu’il permet de corriger un peu trop facilement les erreurs de pilotage, fausse carrément les sensations normales d’un VTT (hors enduro). Bref, c’est en pratiquant que l’on se forge une opinion.

Pour résumer à propos du All Mountain :