21.08.2021 à 02:00

Vers une résistance anarchiste

Nos choix et nos usages numériques conditionnent la manière dont nos données personnelles sont extraites, analysées et valorisées. C’est aujourd’hui un poncif et la grande majorité s’accorde sur le manque d’éthique de l’exploitation de nos intimités numériques. Pourtant, un pas supplémentaire mériterait d’être systématiquement franchi vers une réflexion plus globale. En effet, plus nous réfléchissons à la maîtrise de nos outils numériques et de nos données (ce qui implique bien davantage que le seul usage de logiciels libres), plus nous réfléchissons en réalité à des moyens d’émancipation vis-à-vis du capitalisme de surveillance. Ce dernier est une forme de prédation de nos vies privées par la combinaison, d’une part, du modèle monopoliste des entreprises du numérique et, d’autre part, l’État agissant dans un esprit d’intérêt avec ces firmes, soit acteur soit consommateur (ou co-producteur) de solutions de surveillance numérique (ou surveillance de masse). Comme je l’ai toujours affirmé, il y a de la surveillance d’État parce qu’il y a un marché de la surveillance dans une économie qui aujourd’hui repose pour l’essentiel sur la donnée numérique. Ce marché est jusqu’à la caricature l’expression de la prédation du capitalisme qui, au-delà de l’accaparement du temps et de la nature (nos temps et forces de travail), au-delà de la mesure et de la rentabilité, réduit l’individu à ses comportements de consommateur, effectue un tri social implacable et finalement parvient à accaparer nos vies.

Une critique du capitalisme de surveillance ne peut séparer radicalement les acteurs économiques et l’État. Premièrement parce que les nombreux scandales qui jalonnent l’histoire (celle de la transformation des sociétés industrielles en sociétés numérisées) relèvent toujours d’une forme d’économie politique qui a pour objectif soit d’imposer une ordre hégémonique (par ex. la Guerre Froide) ou un modèle social (la société de consommation), soit d’étendre la gouvernementalité non plus des peuples mais des individus dans un mouvement sécuritaire séculaire, ainsi que l’ont montré les Révélations Snowden (accointance entre État et firmes) ou le scandale Facebook-Cambridge Analytica (fausser le dialogue politique public et donc illustrer les failles de la représentativité en démocratie). Ainsi, considérer l’État comme le seul « contre-pouvoir » capable de réguler le capitalisme et le rendre plus compatible avec les libertés, est un leurre : d’une part les jeux d’intérêts financiers ne sont pas compatibles avec ce rôle de de l’État régulateur (compliqué par ailleurs par les questions de souveraineté vis-à-vis de l’hégémonie des grands pays où s’enracinent l’économie numérique et son industrie), et d’autre part l’État a accompli ce passage vers une société de la surveillance des individus en contraignant l’état de citoyenneté (comment un individu agit comme citoyen, sa vie civile) à un ordre automatisé de l’action publique (surveillance de masse et contrôles automatisés, transformation des services publics en suites de plate-formes, éloignement mutuel des institutions et de la vie publique et enfin : répression).

Face à cette situation, le premier réflexe est d’ouvrir une critique du solutionnisme ambiant. On peut en effet se concentrer sur les problèmes liés à la surveillance : biais algorithmiques, tri social, éthique, légitimité du contrôle, prédictibilité comportementale, etc. Lorsque l’État a recours à ces solutions technologiques, c’est qu’elles sont apportées par des entreprises sans scrupules et sont nimbées d’un discours fascisant (la vieille recette de l’ennemi intérieur ou les sempiternels faux dilemmes liberté vs sécurité ou liberté vs santé). Et c’est justement au nom d’une prétendue efficacité technique que de tels discours prennent si facilement auprès d’une classe politique en pleine crise de représentativité et qui se radicalise peu à peu à l’encontre de l’individu, du groupe, du collectif, et donc des libertés. La critique du solutionnisme peut donc être une critique des choix de politiques publiques et de leur efficacité à résoudre des problèmes structurels ou sociaux, mais elle peut être aussi un moyen efficace de pointer les idéologies derrière les choix technologiques (car il n’y a pas de technologie sans idéologie).

Un second réflexe consiste à adopter une position critique plus globale sur la modernité. Éclairée par l’histoire entre technologies et sociétés, cette critique montre qu’en réalité le contexte est le fruit les orientations du capitalisme moderne, ou du néoliberalisme et de l’économie comportementale qui en est l’un des moteurs (avec la militarisation et les monopoles). Face à cette critique, l’idée n’est pas tant de proposer d’autres solutions plus efficaces qui rendraient le monde économico-numérique meilleur (et après tout les solutions technocratiques restent des solutions techniques), mais de proposer des pistes d’émancipation possible qui auraient la difficile tâche de nous sortir des préceptes du néolibéralisme, par une double critique du capitalisme et de l’État moderne.

Jusqu’à présent, la seule piste que je puisse voir est une piste anarchiste. Nous sommes en effet dans une situation d’urgence où il faut promouvoir à la fois de l’éducation populaire censée émanciper les gens vis-à-vis de l’économie numérique, et la création de groupes et autres collectifs censés se réapproprier et reforger les mécanismes démocratiques pour fonder des économies plus équilibrées. Le tout sans pour autant avoir un mot d’ordre unique mais des caractéristiques suffisamment communes pour former un tout cohérent fait de différences et de partages, selon l’idée plus générale d’une archipélisation des initiatives et des groupes. Je me suis déjà exprimé là-dessus (et je ne suis pas le seul à Framasoft), en revanche il est clair que tout cela doit encore être bien approfondi.

Un autre biais de ce que je viens d’affirmer, c’est la pratique. Tout ceci est bien gentil, mais cela ne reste que des mots. Quelle bien piètre résistance que celle qui ne s’exprime qu’entre la chaise et le clavier. Pour donner une teneur bien concrète à l’urgence que je viens de formuler, on peut regarder du côté de l’Afghanistan de ces derniers jours. Les Talibans, après une avancée fulgurante, ont instauré un nouvel État et, ce faisant, ont mis la main sur les données biométriques d’une grande quantité d’Afghans, des données rassemblées précédemment par l’armée américaine sur place. On conçoit aisément les craintes de nombreux Afghans dans une chasse aux sorcières mortelle qui ne fait que commencer dans le pays. Mais cela montre aussi à quel point il est excessivement dangereux de laisser un pouvoir centraliser des données personnelles, surtout si ces données excèdent le strict minimum censé permettre justement à l’État de fonctionner, et afin d’accroître démesurément son pouvoir de coercition (en particulier lorsque le dialogue démocratique est rompu). En France, nous devrions être bien plus attentifs au rognage systématique de nos intimités numériques et (donc) de nos libertés.

Mais par quels mécanismes nous opposer à cette soif de pouvoir, de coercition, propre à l’État et qui met à la manœuvre la pompe à données personnelles que l’économie numérique ne cesse de perfectionner ? Peut-être faut-il aller chercher au plus profond de nous-mêmes, dans notre méfiance pour ainsi dire instinctive de tout ce qui tend à remplacer l’échange par le pouvoir et le consensus par l’autorité. Finalement, sans avoir à comprendre les finesses des technologies qui nous entourent, nous sommes tous prompts à imaginer et mettre en œuvre des stratégies de contournement, des moyens d’auto-défense face au pouvoir. De ce point de vue, à la condition de proposer des alternatives accessibles à tous, y compris chez les non-techniciens, la fabrication d’alternatives logicielles libres basées sur le chiffrement et le pair-à-pair sont selon moi des éléments d’auto-défense collectifs particulièrement efficaces. Tout comme le sont, par exemple, l’échange de graines de légumes anciens interdits à la vente, l’établissement de zones à défendre contre les grands projets inutiles, ou de manière plus fine les initiatives permettant d’instaurer plus de démocratie participative dans des institutions perçues comme trop rigides (cf. la municipalité de Kingersheim).

Mais je mentionnais plus haut la question de l’anarchie. Sur LVSL vient de sortir une petite analyse synthétique sur le travail de James Scott à propos des sociétés des régions montagneuses de l’Asie du Sud-Est, autrement nommées Zomia, qui regroupe des centaines d’ethnies et des millions de personnes. On ne parle donc pas d’un simple groupe de « primitifs » paumés. Même si les conclusions de James Scott sont à mon avis un peu trop généralistes, à la différence d’un Pierre Clastres qui prenait un peu plus de précautions avant de généraliser, le constat est le même : une bonne anthropologie est d’essence anarchiste, tout simplement parce que, méthodologiquement, on ne devrait jamais apposer nos propres schémas historiques d’occidentaux sur la structure sociale du groupe étudié. Et si on a une bonne méthodologie, on constate que oui, en effet, certaines sociétés sont construites à l’encontre de l’idée de l’État.

Ce que pointent P. Clastres et J. Scott (entre autre, on peut aussi compter D. Graeber) c’est l’erreur d’une vision finaliste du développement des sociétés. Nous avons longtemps pensé que le devenir d’un peuple consistait à se développer et tendre « naturellement » vers une structuration en société-État. Ces anthropologues ont en revanche démontré que ce n’est pas du tout le cas, que l’État (et la coercition) ne sont pas le destin de toute société, qu’il y a même des sociétés qui ont développé des mécanismes pour que le pouvoir ne puisse pas émerger, ou bien s’il y a des chefs, ils n’ont aucune autorité (mais incarnent une fonction de lien et d’échange social), ou même encore des sociétés qui ont une histoire basée sur le refus assumé de l’État parce qu’elles l’ont essayé (et n’y ont vu qu’esclavage et soumission). Il en va de même pour l’économie, qui échappe à toute analyse marxiste (totalisante) puisqu’il y a des sociétés qui connaissent une absence de dynamique de forces productives et de lutte de classe, justement à cause de leur condition sans État.

Ces considérations devraient être ramenées à nos conditions de sociétés industrielles modernes. Finalement, est-ce que l’histoire des peuples n’est pas une perpétuelle lutte contre l’État, dans ce qu’il a de plus invasif (et je ne parle pas des néolibéraux soit-disant libertaires alors qu’ils doivent tout à l’État) ? La démocratie au sens Athénien n’est-elle pas une forme de lutte contre le pouvoir (l’aristocratie contre la tyrannie) ? la représentativité et le vote ne sont-ils pas une astuce pour déjouer l’émancipation des peuples en instaurant une délégation de pouvoir là où il ne devrait y avoir qu’une fonction ? Si je lis Pierre Clastres, j’en conclu (sans doute assez stupidement) qu’il peut y avoir une fonction publique sans pouvoir, en tout cas, que ce n’est pas impossible.

Ce que montre l’anthropologie anarchiste (et il n’y a pas que l’anthropologie : l’histoire et la géographie sont bien évidemment de la partie) c’est le potentiel de chaque société à lutter contre le pouvoir. La question n’est pas tant de savoir qui propose quelles alternatives, mais de savoir dans quelle mesure il importe de se regrouper dans des mouvements d’opposition et de construction de lieux et d’espaces d’échanges, aussi divers que nécessaires. La surveillance et la centralisation des données confèrent des pouvoirs exorbitants. Et ils le sont tellement que même la recherche du consentement collectif, tacite ou non, en devient superflue (il suffit de manipuler l’opinion, justement grâce aux données collectées, ou de se passer de l’opinion). Qu’il s’agisse de l’État ou des entreprises de l’économie numérique, le combat doit rester le même : ne pas accepter la valorisation lucratives des données personnelles et encore moins leur centralisation par l’État. Les données numériques et l’économie de plateformes confèrent un trop grand pouvoir aux États. Il faut leur opposer un principe négatif à toute forme de surveillance (ce qui ne veut cependant pas dire qu’il ne peut y avoir des consensus ponctuels). C’est une question de survie sociale et il faut l’inscrire dans l’histoire.

21.08.2021 à 02:00

Pourquoi tant de haine ?

Une mauvaise ambiance règne actuellement dans le massif des Vosges. En plus d’être la cible régulière de tentatives d’homicides par pièges, les pratiquants de VTT se voient aujourd’hui accusés de bien des maux. Des pétitions s’échangent entre les partisans du clivage et ceux qui tentent de le dépasser pour avancer. Les journaux locaux ont couvert les derniers évènements que je vais relater rapidement avant d’essayer de m’intéresser aux raisons profondes de ce malaise entretenu par quelques personnes qui normalement ne devraient pas mériter autant d’attention.

La recrudescence du tourisme après les mois de crise sanitaire y est sans doute pour quelque chose : on ressort les vélos, et cela dérange. Pourtant le problème persiste depuis des années (nos sénateurs l’ont déjà noté) : des pièges à VTT sont posés régulièrement par des individus exceptionnellement malveillants. Cela touche toute la France, mais dans les Vosges tout particulièrement, il peut s’avérer dangereux de sortir son vélo. Les pelotons de gendarmerie commencent à s’inquiéter vraiment du phénomène, et une affaire récente, celle d’un jeune pratiquant d’Enduro passé à deux doigts la mort, donnera peut-être lieu à une enquête en règle. La Mountain Bike Foundation a fait un communiqué à ce sujet.

La presse nationale parle de plus en plus de ce phénomène auparavant relégué à de simples anecdotes. Ainsi le journal l’Equipe en 2019, Le Figaro en octobre 2020, France TV en mars 2021. Dans les canards locaux, on relate avec plus de détails : des pieux, des barbelés, et surtout les fameuses planches à clous.

J’arrête ici la revue de presse, car il est prévisible que ces histoires continuent à tourner régulièrement jusqu’à devenir des marronniers, comme la neige en hiver et le soleil en été.

Dans ma pratique de vététiste, j’avoue ne jamais avoir été confronté à ce genre de pièges élaborés. On les trouve plus généralement là où les vététistes sont censés le plus déranger : sur les pistes d'Enduro plus ou moins improvisées (j’y reviendrai à la fin de ce billet). En revanche, j’ai été confronté comme tous les vététistes quelles que soient leurs pratiques à ces branches ou pierres posées délibérément en travers du chemin ou en appui à hauteur de tête1.

Si je raconte cela, c’est pour mettre sur le même plan les deux comportements : entre improviser un obstacle délibérément mais avec les moyens disponibles sur le moment, et élaborer un piège en prenant le temps de le fabriquer et le poser à un endroit choisi. Il s’agit de la même malveillance. Les deux ont pour ambition de blesser, voire de tuer et en tout cas de punir. Leur seule différence est que la première est une opportunité tandis que l’autre a juste une intentionnalité beaucoup plus forte.

Qu’est-ce qui motive un tel geste ?

Il y d’abord l’agressivité. À la racine, un ensemble d’angoisses et de peurs que l’individu est incapable de surmonter, soit parce qu’il n’a pas en lui les ressorts nécessaires pour le faire (qui s’acquièrent à l’enfance) soit parce qu’il y a chez lui une forme d’inhibition à la transgression de la norme qui consiste à ne pas nuire à autrui. Mais cela n’explique rien : nous sommes ici dans les mécanismes qui expliquent l’acte et non l’intention.

Comment expliquer l’intention, alors ? Nous sommes ici dans un processus d’attribution de responsabilité et de motivation à punir. Il y a des faits qui sont la cause d’un désordre dans la représentation de ce qui, pour l’individu, devrait être la norme. On s’interroge donc sur les valeurs.

Pour un défenseur de la nature à tendance préservationniste, le plus important est que l’homme dérange le moins possible la faune et la flore dans un soucis d’équilibre dit naturel. La valeur placée ainsi au dessus de toutes les autres, c’est cet idéal d’une nature préservée de l’homme. Pour un chasseur passionné, le bon management de la faune consiste en premier lieu à stabiliser et ne pas faire fuir le gibier. La valeur principale est donc le respect de l’équilibre cynégétique qui lui permet de chasser. Pour un promeneur contemplatif, l’essentiel est de trouver dans la montagne un lieu propice à la contemplation, au calme, loin de toute agitation censée troubler sa quiétude personnelle. La valeur principale est le respect de cette quiétude.

On notera qu’il y a un spectre très large d’activités qui pourraient entrer en conflit avec ces valeurs. Par exemple, un chantier forestier avec tronçonneuses et autres engins de débardage. Mais il ne faut pas oublier que les valeurs ne sont jamais exclusives. On parle d’un système de valeurs pour tout un chacun. Ainsi le bûcheronnage étant un travail, il est un effort productif, et n’entre pas forcément en conflit parce qu’il fait appel à d’autres valeurs qui ont une importance tout aussi forte que les précédentes. De même imaginons un groupe d’écoliers qui croise le chemin du promeneur contemplatif : sans doute troublé par les cris des enfants, il y a peu de chances qu’il y voie une atteinte à ses valeurs à moins de détester l’enfance (cela arrive, cependant).

Donc, il ressort de cette psychologie de bazar, qu’en plus de voir ses valeurs remises en question, l’individu doit trouver chez d’autres individus des valeurs qu’il peut condamner dans la mesure où elles entrent en conflit avec son propre système de valeurs dans lequel elles ne peuvent pas s’inscrire.

Les valeurs sportives sont une cible idéale pour cela, surtout chez les personnes qui n’éprouvent aucune attirance pour le sport. Mais c’est encore insuffisant. La tolérance, par exemple, pourrait permettre de mettre un terme au conflit intérieur. Il faut donc encore un autre ingrédient : la légitimation.

La légitimation s’articule en deux temps :

- pouvoir attribuer une responsabilité à autrui,

- estimer que la punition est une prérogative non sociale mais individuelle, dont le but n’est pas de réhabiliter le fautif dans l’ordre social (les valeurs communes), mais rétablir l’ordre des valeurs auxquelles on adhère à titre individuel.

En d’autres termes : estimer que l’on est soi-même légitime à punir autrui non pas en vertu du droit mais en vertu de ses propres représentations morales. On infère donc deux choses :

- la faute à partir d’une expérience personnelle et donc émettre une conclusion dont la logique est erronée (« j’ai vu trois vététistes freiner sur le chemin, donc les vététistes sont la cause de l’érosion de tous les chemins »),

- une responsabilité en vertu d’une charge émotionnelle (« je suis en colère : eux ont le droit et pas moi ») qui déstabilise les normes, et permet le passage à l’acte : poser un piège (la destination).

Et puis, outre la vengeance personnelle contre les vététistes comme chez ce chasseur de l’Hérault, il y a le renforcement de la légitimation. C’est-à-dire tout ce qui chez l’individu malveillant pourra l’aider, de l’extérieur, à attribuer la faute et la responsabilité. Ce peuvent être par exemple :

- un effet de groupe lorsque tout le monde y va de son témoignage personnel (on est toujours dans le jugement d’opinion) dans une bulle de représentation : « on a bien raison de penser ce qu’on pense »,

- une pétition relayée par les médias comme celle de SOS massif des Vosges qui entretien soigneusement une confusion entre ce qui est vrai ou faux (la randonnée devenue impossible), légitime ou légal (le droit des VTT à rouler sur sentier) ou moral et immoral (les bonnes valeurs du randonneur vs celle du sportif) de manière à susciter l’adhésion.

Enfin, on ajoute la victimisation. Tout comme le troll bien connu des réseaux sociaux, l’inversion des rôles est le parfait moyen pour déstabiliser (croit-on) la cible. Ainsi, malgré l’effort de dialogue toujours prôné par la Mountain Bikers Foundation (aboutissant souvent à des ententes scellées comme celle entre chasseurs et vététistes), les chasseurs se voyant accusés eux aussi de bien des maux, n’hésitent pas à jouer les victimes. Sauf que… attisées parfois par les politiques (comme ce député LREM) les tensions se multiplient inutilement avec les chasseurs qui vont même jusqu’à faire interdire une compétition de VTT, alors même que certains chasseurs isolés se croient au Far West devant nos champions nationaux.

Bon… les tensions n’ont pas lieu qu’avec les VTT. Certains coureurs à pied en prennent aussi pour leur grade avec les chasseurs. Néanmoins, cela va mieux en le disant : les chasseurs, dans leur grande majorité, n’ont rien contre les VTT. Mon expérience personnelle confirme absolument la position commune de la Fédération Nationale de Chasse et des la Mountain Bike Foundation : j’ai toujours entretenu des relations très courtoises avec les chasseurs. Il suffit de demander où a lieu la battue et on peut toujours faire un petit effort de contournement, quel que soit son avis sur la chasse.

En fait, la malveillance contre les VTT est avant tout une affaire individuelle. Elle reflète les tensions entretenues par ceux qui ne savent pas partager les usages de la forêt ou de la montagne, et se livrent à du lobbying envers les municipalités pour chercher à tout interdire.

J’avais promis d’y revenir : les pistes d’Enduro. Oui, effectivement, cela crée de l’érosion, cela abîme par endroit les sentiers que d’autres entretiennent. Mais c’est du sport. En tant que discipline, j’ai du mal à comprendre pourquoi les municipalités qui s’enorgueillissent d’accueillir les VTT Cross Country sur des chemins balisés n’offrent pas aussi, dans les endroits concernés, des infrastructures sérieuses pour la descente. Je citerai au hasard (non, pas au hasard!) la municipalité de Barr dans le Bas-Rhin : il y a toute une population qui, ayant goûté dans cette même commune une dynamique favorable au développement de la discipline, se retrouve à se débrouiller comme elle peut pour aménager l’existant. Il y a un créneau à couvrir et un vrai petit trésor à valoriser. Pourquoi ne pas le faire et ainsi limiter les pistes sauvages ?

Une dernière chose : les imbéciles malveillants sont une extrême minorité d’individus qui peuvent cependant faire un tort considérable. Dans les Vosges, le partage de l’espace est de mieux en mieux vécu par les utilisateurs. VTT et randonneurs se croisent en toute cordialité, chasseurs et VTT discutent ensemble, les antennes du Club Vosgien (sauf celles qui n’ont rien compris au film, voir ici et là) ont souvent un groupe de vététistes dans leurs rangs, et quant aux protecteurs de la nature, ce n’est pas chez les vététistes qu’ils trouvent à blâmer pour l’état déplorable de certains milieux.

Notes

-

Oui, il est assez facile de s’en apercevoir lorsqu’on fréquente les mêmes chemins régulièrement. Par exemple : vous passez un jour d’hiver, un arbre est tombé, traversant et endommageant le sentier. Il reste longtemps en place, le temps que des forestiers ou des bénévoles du Club Vosgien ou encore des vététistes locaux viennent le débiter. Vous repassez, le chemin est dégagé et vous rendez grâce à ces bénévoles sans qui la forêt deviendrait vite impraticable. Mais vous n’êtes pas seul à pratiquer le VTT à cet endroit. Vous avisez les morceaux de tronc posés à l’écart et vous ouvrez les paris : combien de temps ? Combien de temps avant qu’un-e imbécile trouve l’idée géniale d’en mettre un morceau en travers du chemin ? Pas juste pour obliger le cycliste à poser pied à terre (s’il s’agissait d’un obstacle à sauter, par défi, il y aurait toujours la place pour passer à côté). La pose malveillante d’obstacles est toujours réfléchie : en travers du chemin, certes, mais tiré avec d’autres branches, avec rage et détermination, vraiment pour faire ch…. Que faites vous ? vous posez le vélo, vous pensez aux autres pratiquants et vous rangez la forêt. Semaine suivante : déception, cela recommence. ↩︎

17.06.2021 à 02:00

Pour une histoire du courtage de données

Les activités des courtiers de données (data brokers) sont assez peu connues du grand public. Pourtant, ces derniers sont situés sur le créneau crucial du marketing, et on peut considérer qu’aucune stratégie marketing rentable ne peut se faire sans la récolte et le traitement de données. Les précieux services que rendent aujourd’hui ces entreprises conditionnent l’activité économique et renforce toujours plus le modèle du capitalisme de surveillance.

Késako ?

Le courtage de données a commencé à se faire connaître du grand public à partir du moment où furent discutées dans les médias les pratiques d’extraction des données personnelles des grandes entreprises du web (les GAFAM en particulier mais pas uniquement). C’est ce que raconte Shoshana Zuboff dans son livre : au début des années 2000, à partir du moment où la pression de l’actionnariat demandait toujours plus de rentabilité à des entreprises comme Google, ces dernières ont vu dans l’extraction et la vente de données comportementales une occasion d’accroître leur rentabilité et de toujours plus innover selon ce modèle économique du service gratuit en échange de nos expériences du quotidien.

En 2016, le rapport de Cracked Lab sur les data brokers fut sans doute l’un des plus éloquents de l’ère post-révélations-Snowden. Au lieu de se concentrer sur le problème déjà bien inquiétant des relations entre les services d’espionnage américains et les entreprises monopolistes du web dans la surveillance mondiale, les membres de Cracked Lab montraient comment certaines entreprises gagnent beaucoup d’argent en monitorant en permanence nos faits et gestes, et s’accaparent une part toujours plus grande de nos intimités numériques sans se soucier vraiment de la régulation imposée par les législations en vigueur.

Un reportage télévisé récent portait justement sur le courtage de données et les passe-droits de ces entreprises, par exemple sur nos données de santé. Ces pratiques sont d’autant plus difficilement interrogeables qu’elles se font en toute discrétion, sans que les individus puissent s’y opposer : il ne s’agit pas d’agir à l’insu des personnes mais bien en aval, auprès des entreprises qui, elles, ont déjà récupéré nos consentements.

On peut surenchérir, après 4 ans d’expérience du RGPD : celui-ci a d’énormes trous dans la raquette. Le RGPD a été initié au départ pour limiter et encadrer les pratiques d’extraction des données personnelles par les entreprises auprès des utilisateurs, mais l’économie du courtage de données a quasiment été laissée de côté, comme si cela ne concernait nos vies privée qu’à la marge. Et pour cause : ce que peuvent faire ces entreprises en matière de profilages et corrélations est non seulement l’un des piliers du paradigme libéral de l’économie comportementale, mais reste aussi avant tout un marché business to business. Or, les innovations en matière de profilage et de travail des données comportementales sont vertigineuses1.

Scoop : rien de nouveau

Si vous me lisez un peu, pas de surprise avec ce que je vais vous dire : c’est pas nouveau. L’idée de récolter et tenir à jour des listes de clientèle est au moins aussi vieille que le commerce. L’idée de les vendre est un peu plus récente mais j’ai ouï-dire (à vérifier) que les banquiers de la Renaissance pratiquaient ce petit commerce (en tout cas, je pense que cela allait de pair avec la possibilité d’utiliser facilement du papier et cela a dû s’accroître avec l’imprimerie).

Tiens, c’est intéressant : on peut partir de l’hypothèse que le commerce des données n’est pas vraiment une innovation, mais que c’est une activité qui a utilisé les innovations pour créer des nouveaux marchés. Ou plutôt une activité basée sur des techniques dont la pratique a initié des marchés. Cette hypothèse peut être mise à l’épreuve avec l’histoire de la révolution informatique de la seconde moitié du XXe siècle.

C’est ce que je montre dans un article qui va bientôt paraître dans la revue Zilsel : le courtage de données a connu une brusque croissance à partir du moment où, grâce aux ordinateurs et aux travaux sur les bases de données relationnelles, on a cherché à automatiser la génération de listes clientèles. C’est cette automatisation qui a permis de passer du prospect publicitaire façon pages jaunes à une révolution fondamentale dans l’histoire du marketing : l’analyse prédictive des données comportementales, géodémographiques et psychographiques.

Alors quand ? exactement au tournant des années 1970. On retient de cette période la seconde révolution informatique que les ordinateurs mainframe ont rendu possible en intégrant les organisations (entreprises comme services publics) pour créer des systèmes d’information. Ce qui se passe alors est très intéressant. Déjà les banques (et sociétés d’évaluation de crédit), sur-équipées par rapport aux autres entreprises, passent du modèle de répertoire/suivi de clientèle à l’évaluation de solvabilité et autres fichages. Les associations de consommateurs aux États-Unis ne seront d’ailleurs pas contentes et provoqueront le vote du Fair Credit Reporting Act en 1970. Même des entreprises qui auparavant n’avaient pas vraiment de rapport avec le crédit bancaire, se mirent à acheter des données justement parce qu’elles étaient en mesure de les traiter. Petit extrait de mon article :

(…) C’est ainsi que l’Union Tank Car Company, spécialisée dans la location de wagons et disposant du matériel informatique suffisant, se lança dans l’évaluation de crédit en créant Trans Union en 1968. Cette dernière mena une politique offensive de rachat d’autres agences et dont l’objectif était de rassembler des millions de fiches consommateurs. En 1972 elle créa CRONUS (Credit Reporting Online Network Utility System), un système d’information de stockage sur bandes et de transfert d’information depuis et vers les guichets locaux. Ce modèle de système d’échange en ligne assurait un gain de temps considérable pour la mise à jour des données consommateurs. Ce ne fut pas le seul exemple. Thompson Ramo Wooldridge Inc. (plus tard nommée TRW), spécialisée dans l’aérospatiale et les composants électroniques (mais agissant en fait dans plusieurs secteurs d’activité dont l’informatique), racheta Credit Data Corporation en 1968 pour se lancer dans l’évaluation de crédit (ce fut en 1996 que le service de TRW devint Experian). Quant à la Retail Credit Company, il s’agissait historiquement de la plus grande agence d’évaluation de crédit des États-Unis. Elle s’informatisa complètement en 1970 mais fut obligée de changer d’image et de nom pour Equifax en 1975, après plus de cinq années d’enquêtes administratives (accompagnées d’auditions à charge) menées sur les pratiques de reporting des agences d’évaluation de crédit et la question de la vie privée.

Étude de cas

Prédire. C’est la question qui taraude l’homme depuis la nuit des temps. Dans un monde incertain, l’économie va mal. Qu’il s’agisse de croyance ou de science, l’économie a un besoin vital d’une rationalité de la vision du monde qui permet de spéculer sur l’avenir plus ou moins proche.

L’économie comportementale a vu ses concepts se développer dans les années 1960. Évidemment, la démarche est ancestrale : on sait depuis longtemps identifier un marché potentiel en fonction d’un contexte, d’une ambiance, d’une culture. C’est même le b.a.ba du bon commerçant. Par contre les avancées scientifiques des disciplines comme la psychologie, la sociologie et l’anthropologie, et même la physique et la biologie, on permis de pousser très loin le curseur de l’analyse comportementale des agents économiques, et tout particulièrement l’analyse des facteurs décisionnels. En agissant sur ces facteurs de manière stratégique et éclairée par les sciences comportementales, la possibilité de conditionner le choix économique (comme celui de l’achat d’un bien) devient une activité marketing redoutable surtout lorsque l’économie est lancée dans une rude dynamique concurrentielle comme ce fut le cas avec l’apparition de la fameuse économie de consommation.

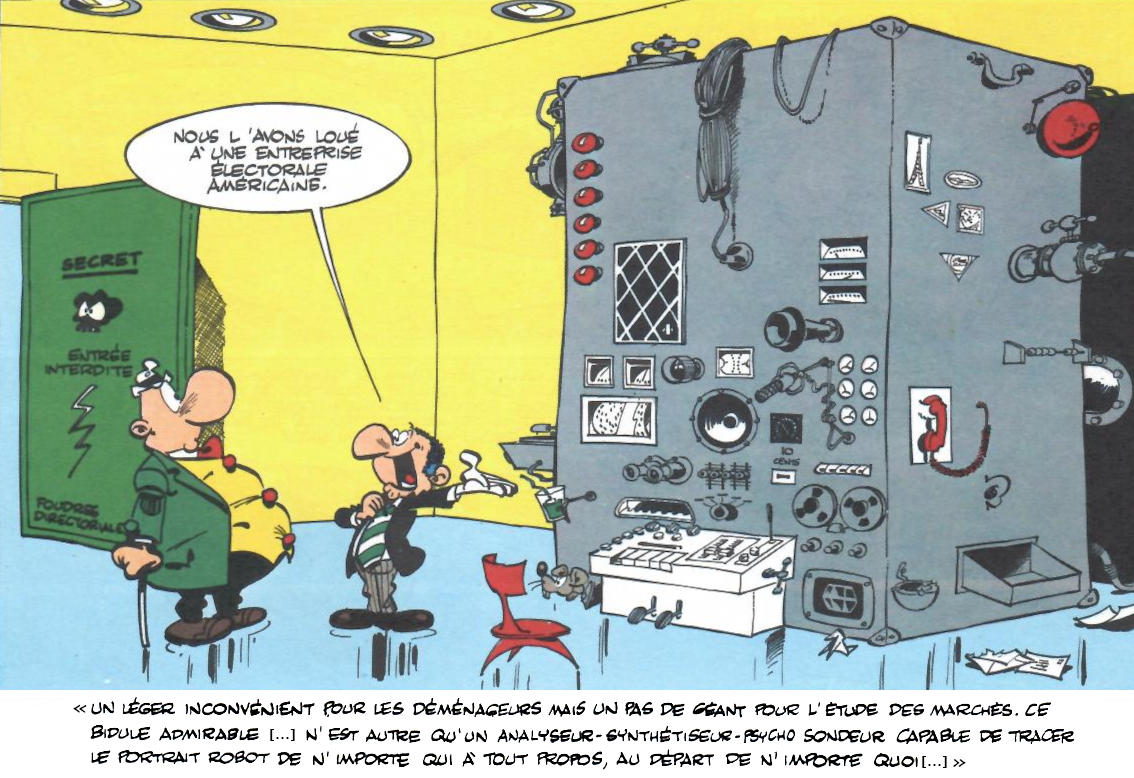

L’étude de cas que je propose concerne les entreprises Acxiom et Claritas Inc.. La première est née sous le nom de Demographics en 1968, la seconde créé en 1972 est connue pour porter le système PRIZM. Ces entreprises démontrent que le capitalisme de surveillance s’inscrit dans une histoire longue qui remonte à bien avant les années 2000 et qui est relative à l’usage des technologies qui ont permis d’automatiser de le travail de la donnée, et donc ont accru la rentabilité de ce travail.

Demographics a commencé comme une entreprise électorale à Conway dans l’Arkansas. Elle est dirigée encore actuellement par certains de ses membres « d’origine », en particulier Charles Morgan, un ancien d’IBM qui y a fait venir ses homologues. Elle fut initiée et fondée par Charles Ward, entrepreneur fort connu de l’Arkansas (et dans le monde), à la tête de la Ward Body Works, aujourd’hui IC Bus, fabriquant des fameux bus jaunes réputés fiables et sécurisés.

À l’occasion de la campagne électorale pour le gouverneur de l’Arkansas, Ward voulait faire profiter le parti démocrate local de son ordinateur (un IBM s/360) afin d’optimiser les démarche de prospect et de publipostage. Il engageait alors le parti démocrate dans une course à un « armement » informatique qui opposait depuis plusieurs années le parti Républicain et le parti Démocrate sur le plan de l’analyse électorale. Il fit venir pour cela Charles Morgan qui fini par imposer à Demographics un modèle de développement typique d’IBM afin d’étendre le modèle économique de l’entreprise au-delà du secteur politique sur le chemin de la haute rentabilité financière. Tout en poursuivant les activités de l’entreprise électorale (qui lui vaudront plus tard d’être un grand ami de Clinton, qui commença dans l’Arkansas) mais en s’émancipant de la Ward, Morgan développa pour cela un système automatisé de traitement de listes de clientèles en réseau afin de proposer ce service business to business basé sur l’exploitation de bases de données enrichies de différentes sources, et l’analyse géodémographique (ce qui avait notamment servi pour l’étude des campagnes électorales).

Outre le fait qu’on validait ainsi l’idée que le marketing s’appliquait aussi bien à la politique qu’au commerce de détail, Demographics montrait aussi qu’en exploitant correctement les technologies à disposition (langages bas niveau pour tirer meilleur parti des machines, passage du stockage de données à l’entrepôt de données, temps partagé et transmission réseau) il était possible de développer une activité économique pour des coûts de développement assez faibles, et basée sur la récupération et l’exploitation astucieuse de données. Parallèlement, un sociologue nommé Jonathan Robbin développait PRIZM (Potential Rating Index for Zip Markets), un système de segmentation et de classification géodémographique des populations croisé avec l’analyse du style de vie (lifestyle). Cet ensemble doit aussi être rapproché des recherches sur les bases de données relationnelles tels les travaux initiés par Edgar Codd en 1970 et toute une communauté de chercheurs avec lui.

Teasing

Bien sûr, ces éléments n’entrent pas en relation par hasard. Pour en comprendre les articulations, il va falloir attendre la publication de mon article (rhooo… ce teasing de malaaade !). Vous devinez néanmoins déjà l’ambition : comprendre comment nous en sommes arrivés à l’acceptation sociale du stéréotypage de nos styles de vie, de l’exploitation de nos données comportementales et des modèles décisionnels, en somme tout ce qui fait qu’aujourd’hui le marketing est non seulement le pilier de l’économie mais concentre aussi l’exploitation lucrative des données personnelles. Comment espérer, dans ce cas, qu’une simple régulation du capitalisme siliconevalléesque puisse résoudre quoi que ce soit, alors que c’est l’ensemble du système économique capitaliste qui se gave de données. Le mieux à faire est de créer des îles et des archipels en dehors de l’exploitation lucrative des données. Tenter d’y échapper.

Greg, Achille Talon, *Pas de pitié pour Achille Talon*, Dargaud, 1976, p.36

-

Il suffit de lire entre les lignes du discours bullshit qui décrit les produits de l’entreprise Liveramp (qui par ailleurs a fusionné récemment avec Acxiom). Il n’y a rien de secret dans ces pratiques, c’est du business, rien que du business… ↩︎

08.05.2021 à 02:00

Les médias sociaux ne sont pas des espaces démocratiques

[Ce billet a été publié sur le Framablog à cette adresse, le 15 mai 2021.]

Lors d’une récente interview avec deux autres framasoftiennes à propos du Fediverse et des réseaux sociaux dits « alternatifs », une question nous fut posée :

dans la mesure où les instances de service de micro-blogging (type Mastodon) ou de vidéo (comme Peertube) peuvent afficher des « lignes éditoriales » très différentes les unes des autres, comment gérer la modération en choisissant de se fédérer ou non avec une instance peuplée de fachos ou comment se comporter vis-à-vis d’une instance communautaire et exclusive qui choisit délibérément de ne pas être fédérée ou très peu ?

De manière assez libérale et pour peu que les conditions d’utilisation du service soient clairement définies dans chaque instance, on peut répondre simplement que la modération demande plus ou moins de travail, que chaque instance est tout à fait libre d’adopter sa propre politique éditoriale, et qu’il s’agit de choix individuels (ceux du propriétaire du serveur qui héberge l’instance) autant que de choix collectifs (si l’hébergeur entretient des relations diplomatiques avec les membres de son instance). C’est une évidence.

La difficulté consistait plutôt à expliquer pourquoi, dans la conception même des logiciels (Mastodon ou Peertube, en l’occurrence) ou dans les clauses de la licence d’utilisation, il n’y a pas de moyen mis en place par l’éditeur du logiciel (Framasoft pour Peertube, par exemple) afin de limiter cette possibilité d’enfermement de communautés d’utilisateurs dans de grandes bulles de filtres en particulier si elles tombent dans l’illégalité. Est-il légitime de faire circuler un logiciel qui permet à #lesgens de se réunir et d’échanger dans un entre-soi homogène tout en prétendant que le Fediverse est un dispositif d’ouverture et d’accès égalitaire ?

Une autre façon de poser la question pourrait être la suivante : comment est-il possible qu’un logiciel libre puisse permettre à des fachos d’ouvrir leurs propres instance de microblogging en déversant impunément sur le réseau leurs flots de haine et de frustrations ?1

Bien sûr nous avons répondu à ces questions, mais à mon avis de manière trop vague. C’est qu’en réalité, il y a plusieurs niveaux de compréhension que je vais tâcher de décrire ici. Il y a trois aspects :

- l'éthique du logiciel libre n’inclut pas la destination morale des logiciels libres, tant que la loyauté des usages est respectée, et la première clause des 4 libertés du logiciel libre implique la liberté d’usage : sélectionner les utilisateurs finaux en fonction de leurs orientations politique, sexuelles, etc. contrevient fondamentalement à cette clause…

- … mais du point de vue technique, on peut en discuter car la conception du logiciel pourrait permettre de repousser ces limites éthiques2,

- et la responsabilité juridique des hébergeurs implique que ces instances fachos sont de toute façon contraintes par l’arsenal juridique adapté ; ce à quoi on pourra toujours rétorquer que cela n’empêche pas les fachos de se réunir dans une cave (mieux : un local poubelle) à l’abri des regards.

Mais est-ce suffisant ? se réfugier derrière une prétendue neutralité de la technique (qui n’est jamais neutre), les limites éthiques ou la loi, ce n’est pas une bonne solution. Il faut se poser la question : que fait-on concrètement non pour interdire certains usages du Fediverse, mais pour en limiter l’impact social négatif ?

La principale réponse, c’est que le modèle économique du Fediverse ne repose pas sur la valorisation lucrative des données, et que se détacher des modèles centralisés implique une remise en question de ce que sont les « réseaux » sociaux. La vocation d’un dispositif technologique comme le Fediverse n’est pas d’éliminer les pensées fascistes et leur expression, pas plus que la vocation des plateformes Twitter et Facebook n’est de diffuser des modèles démocratiques, malgré leur prétention à cet objectif. La démocratie, les échanges d’idées, et de manière générale les interactions sociales ne se décrètent pas par des modèles technologiques, pas plus qu’elles ne s’y résument. Prétendre le contraire serait les restreindre à des modèles et des choix imposés (et on voit bien que la technique ne peut être neutre). Si Facebook, Twitter et consorts ont la prétention d’être les gardiens de la liberté d’expression, c’est bien davantage pour exploiter les données personnelles à des fins lucratives que pour mettre en place un débat démocratique.

Exit le vieux rêve du global village ? En fait, cette vieille idée de Marshall McLuhan ne correspond pas à ce que la plupart des gens en ont retenu. En 1978, lorsque Murray Turoff et Roxanne Hiltz publient The Network Nation, ils conceptualisent vraiment ce qu’on entend par « Communication médiée par ordinateur » : échanges de contenus (volumes et vitesse), communication sociale-émotionnelle (les émoticônes), réduction des distances et isolement, communication synchrone et asynchrone, retombées scientifiques, usages domestiques de la communication en ligne, etc. Récompensés en 1994 par l’EFF Pioneer Award, Murray Turoff et Roxanne Hiltz sont aujourd’hui considérés comme les « parents » des systèmes de forums et de chat massivement utilisés aujourd’hui. Ce qu’on a retenu de leurs travaux, et par la suite des nombreuses applications, c’est que l’avenir du débat démocratique, des processus de décision collective (M. Turoff travaillait pour des institutions publiques) ou de la recherche de consensus, reposent pour l’essentiel sur les technologies de communication. C’est vrai en un sens, mais M. Turoff mettait en garde3 :

Dans la mesure où les communications humaines sont le mécanisme par lequel les valeurs sont transmises, tout changement significatif dans la technologie de cette communication est susceptible de permettre ou même de générer des changements de valeur.

Communiquer avec des ordinateurs, bâtir un système informatisé de communication sociale-émotionnelle ne change pas seulement l’organisation sociale, mais dans la mesure où l’ordinateur se fait de plus en plus le support exclusif des communications (et les prédictions de Turoff s’avéreront très exactes), la communication en réseau fini par déterminer nos valeurs.

Aujourd’hui, communiquer dans un espace unique globalisé, centralisé et ouvert à tous les vents signifie que nous devons nous protéger individuellement contre les atteintes morales et psychiques de celleux qui s’immiscent dans nos échanges. Cela signifie que nos écrits puissent être utilisés et instrumentalisés plus tard à des fins non souhaitées. Cela signifie qu’au lieu du consensus et du débat démocratique nous avons en réalité affaire à des séries de buzz et des cancans. Cela signifie une mise en concurrence farouche entre des contenus discursifs de qualité et de légitimités inégales mais prétendument équivalents, entre une casserole qui braille La donna è mobile et la version Pavarotti, entre une conférence du Collège de France et un historien révisionniste amateur dans sa cuisine, entre des contenus journalistiques et des fake news, entre des débats argumentés et des plateaux-télé nauséabonds.

Tout cela ne relève en aucun cas du consensus et encore moins du débat, mais de l’annulation des chaînes de valeurs (quelles qu’elles soient) au profit d’une mise en concurrence de contenus à des fins lucratives et de captation de l’attention. Le village global est devenu une poubelle globale, et ce n’est pas brillant.

Dans cette perspective, le Fediverse cherche à inverser la tendance. Non par la technologie (le protocole ActivityPub ou autre), mais par le fait qu’il incite à réfléchir sur la manière dont nous voulons conduire nos débats et donc faire circuler l’information.

On pourrait aussi bien affirmer qu’il est normal de se voir fermer les portes (ou du moins être exclu de fait) d’une instance féministe si on est soi-même un homme, ou d’une instance syndicaliste si on est un patron, ou encore d’une instance d’un parti politique si on est d’un autre parti. C’est un comportement tout à fait normal et éminemment social de faire partie d’un groupe d’affinités, avec ses expériences communes, pour parler de ce qui nous regroupe, d’actions, de stratégies ou simplement un partage d’expériences et de subjectivités, sans que ceux qui n’ont pas les mêmes affinités ou subjectivités puissent s’y joindre. De manière ponctuelle on peut se réunir à l’exclusion d’autre groupes, pour en sortir à titre individuel et rejoindre d’autre groupes encore, plus ouverts, tout comme on peut alterner entre l’intimité d’un salon et un hall de gare.

Dans ce texte paru sur le Framablog, A. Mansoux et R. R. Abbing montrent que le Fediverse est une critique de l’ouverture. Ils ont raison. Là où les médias sociaux centralisés impliquaient une ouverture en faveur d’une croissance lucrative du nombre d’utilisateurs, le Fediverse se fout royalement de ce nombre, pourvu qu’il puisse mettre en place des chaînes de confiance.

Un premier mouvement d’approche consiste à se débarrasser d’une conception complètement biaisée d’Internet qui fait passer cet ensemble de réseaux pour une sorte de substrat technique sur lequel poussent des services ouverts aux publics de manière égalitaire. Évidemment ce n’est pas le cas, et surtout parce que les réseaux ne se ressemblent pas, certains sont privés et chiffrés (surtout dans les milieux professionnels), d’autres restreints, d’autres plus ouverts ou complètement ouverts. Tous dépendent de protocoles bien différents. Et concernant les médias sociaux, il n’y a aucune raison pour qu’une solution technique soit conçue pour empêcher la première forme de modération, à savoir le choix des utilisateurs. Dans la mesure où c’est le propriétaire de l’instance (du serveur) qui reste in fine responsable des contenus, il est bien normal qu’il puisse maîtriser l’effort de modération qui lui incombe. Depuis les années 1980 et les groupes usenet, les réseaux sociaux se sont toujours définis selon des groupes d’affinités et des règles de modération clairement énoncées.

À l’inverse, avec des conditions générales d’utilisation le plus souvent obscures ou déloyales, les services centralisés tels Twitter, Youtube ou Facebook ont un modèle économique tel qu’il leur est nécessaire de drainer un maximum d’utilisateurs. En déléguant le choix de filtrage à chaque utilisateur, ces médias sociaux ont proposé une représentation faussée de leurs services :

- Faire croire que c’est à chaque utilisateur de choisir les contenus qu’il veut voir alors que le système repose sur l’économie de l’attention et donc sur la multiplication de contenus marchands (la publicité) et la mise en concurrence de contenus censés capter l’attention. Ces contenus sont ceux qui totalisent plus ou moins d’audience selon les orientations initiales de l’utilisateur. Ainsi on se voit proposer des contenus qui ne correspondent pas forcément à nos goûts mais qui captent notre attention parce de leur nature attrayante ou choquante provoquent des émotions.

- Faire croire qu’ils sont des espaces démocratiques. Ils réduisent la démocratie à la seule idée d’expression libre de chacun (lorsque Trump s’est fait virer de Facebook les politiques se sont sentis outragés… comme si Facebook était un espace public, alors qu’il s’agit d’une entreprise privée).

Les médias sociaux mainstream sont tout sauf des espaces où serait censée s’exercer la démocratie bien qu’ils aient été considérés comme tels, dans une sorte de confusion entre le brouhaha débridé des contenus et la liberté d’expression. Lors du « printemps arabe » de 2010, par exemple, on peut dire que les révoltes ont beaucoup reposé sur la capacité des réseaux sociaux à faire circuler l’information. Mais il a suffi aux gouvernements de censurer les accès à ces services centralisés pour brider les révolutions. Ils se servent encore aujourd’hui de cette censure pour mener des négociations diplomatiques qui tantôt cherchent à attirer l’attention pour obtenir des avantages auprès des puissances hégémoniques tout en prenant la « démocratie » en otage, et tantôt obligent les GAFAM à se plier à la censure tout en facilitant la répression. La collaboration est le sport collectif des GAFAM. En Turquie, Amnesty International s’en inquiète et les exemples concrets ne manquent pas comme au Vietnam récemment.

Si les médias sociaux comme Twitter et Facebook sont devenus des leviers politiques, c’est justement parce qu’ils se sont présentés comme des supports technologiques à la démocratie. Car tout dépend aussi de ce qu’on entend par « démocratie ». Un mot largement privé de son sens initial comme le montre si bien F. Dupuis-Déri4. Toujours est-il que, de manière très réductrice, on tient pour acquis qu’une démocratie s’exerce selon deux conditions : que l’information circule et que le débat public soit possible.

Même en réduisant la démocratie au schéma techno-structurel que lui imposent les acteurs hégémoniques des médias sociaux, la question est de savoir s’il permettent la conjonction de ces conditions. La réponse est non. Ce n’est pas leur raison d’être.

Alors qu’Internet et le Web ont été élaborés au départ pour être des dispositifs égalitaires en émission et réception de pair à pair, la centralisation des accès soumet l’émission aux conditions de l’hébergeur du service. Là où ce dernier pourrait se contenter d’un modèle marchand basique consistant à faire payer l’accès et relayer à l’aveugle les contenus (ce que fait La Poste, encadrée par la loi sur les postes et télécommunications), la salubrité et la fiabilité du service sont fragilisés par la responsabilisation de l’hébergeur par rapport à ces contenus et la nécessité pour l’hébergeur à adopter un modèle économique de rentabilité qui repose sur la captation des données des utilisateurs à des fins de marketing pour prétendre à une prétendue gratuité du service5. Cela implique que les contenus échangés ne sont et ne seront jamais indépendants de toute forme de censure unilatéralement décidée (quoi qu’en pensent les politiques qui entendent légiférer sur l’emploi des dispositifs qui relèveront toujours de la propriété privée), et jamais indépendants des impératifs financiers qui justifient l’économie de surveillance, les atteintes à notre vie privée et le formatage comportemental qui en découlent.

Paradoxalement, le rêve d’un espace public ouvert est tout aussi inatteignable pour les médias sociaux dits « alternatifs », où pour des raisons de responsabilité légale et de choix de politique éditoriale, chaque instance met en place des règles de modération qui pourront toujours être considérées par les utilisateurs comme abusives ou au moins discutables. La différence, c’est que sur des réseaux comme le Fediverse (ou les instances usenet qui reposent sur NNTP), le modèle économique n’est pas celui de l’exploitation lucrative des données et n’enferme pas l’utilisateur sur une instance en particulier. Il est aussi possible d’ouvrir sa propre instance à soi, être le seul utilisateur, et néanmoins se fédérer avec les autres.

De même sur chaque instance, les règles d’usage pourraient être discutées à tout moment entre les utilisateurs et les responsables de l’instance, de manière à créer des consensus. En somme, le Fediverse permet le débat, même s’il est restreint à une communauté d’utilisateurs, là où la centralisation ne fait qu’imposer un état de fait tout en tâchant d’y soumettre le plus grand nombre. Mais dans un pays comme le Vietnam où l’essentiel du trafic Internet passe par Facebook, les utilisateurs ont-ils vraiment le choix ?

Ce sont bien la centralisation et l’exploitation des données qui font des réseaux sociaux comme Facebook, YouTube et Twitter des instruments extrêmement sensibles à la censure d’État, au service des gouvernements totalitaires, et parties prenantes du fascisme néolibéral.

L’affaire Cambridge Analytica a bien montré combien le débat démocratique sur les médias sociaux relève de l’imaginaire, au contraire fortement soumis aux effets de fragmentation discursive. Avant de nous demander quelles idéologies elles permettent de véhiculer nous devons interroger l’idéologie des GAFAM. Ce que je soutiens, c’est que la structure même des services des GAFAM ne permet de véhiculer vers les masses que des idéologies qui correspondent à leurs modèles économiques, c’est-à-dire compatibles avec le profit néolibéral.

En reprenant des méthodes d’analyse des années 1970-80, le marketing psychographique et la socio-démographie6, Cambridge Analytica illustre parfaitement les trente dernières années de perfectionnement de l’analyse des données comportementales des individus en utilisant le big data. Ce qui intéresse le marketing, ce ne sont plus les causes, les déterminants des choix des individus, mais la possibilité de prédire ces choix, peu importent les causes. La différence, c’est que lorsqu’on applique ces principes, on segmente la population par stéréotypage dont la granularité est d’autant plus fine que vous disposez d’un maximum de données. Si vous voulez influencer une décision, dans un milieu où il est possible à la fois de pomper des données et d’en injecter (dans les médias sociaux, donc), il suffit de voir quels sont les paramètres à changer. À l’échelle de millions d’individus, changer le cours d’une élection présidentielle devient tout à fait possible derrière un écran.

C’est la raison pour laquelle les politiques du moment ont surréagi face au bannissement de Trump des plateformes comme Twitter et Facebook (voir ici ou là). Si ces plateformes ont le pouvoir de faire taire le président des États-Unis, c’est que leur capacité de caisse de résonance accrédite l’idée qu’elles sont les principaux espaces médiatiques réellement utiles aux démarches électoralistes. En effet, nulle part ailleurs il n’est possible de s’adresser en masse, simultanément et de manière segmentée (ciblée) aux populations. Ce faisant, le discours politique ne s’adresse plus à des groupes d’affinité (un parti parle à ses sympathisants), il ne cherche pas le consensus dans un espace censé servir d’agora géante où aurait lieu le débat public. Rien de tout cela. Le discours politique s’adresse désormais et en permanence à chaque segment électoral de manière assez fragmentée pour que chacun puisse y trouver ce qu’il désire, orienter et conforter ses choix en fonction de ce que les algorithmes qui scandent les contenus pourront présenter (ou pas). Dans cette dynamique, seul un trumpisme ultra-libéral pourra triompher, nulle place pour un débat démocratique, seules triomphent les polémiques, la démagogie réactionnaire et ce que les gauches ont tant de mal à identifier7 : le fascisme.

Face à cela, et sans préjuger de ce qu’il deviendra, le Fediverse propose une porte de sortie sans toutefois remettre au goût du jour les vieilles représentations du village global. J’aime à le voir comme une multiplication d’espaces (d’instances) plus où moins clos (ou plus ou moins ouverts, c’est selon) mais fortement identifiés et qui s’affirment les uns par rapport aux autres, dans leurs différences ou leurs ressemblances, en somme dans leurs diversités.

C’est justement cette diversité qui est à la base du débat et de la recherche de consensus, mais sans en constituer l’alpha et l’oméga. Les instances du Fediverse, sont des espaces communs d’immeubles qui communiquent entre eux, ou pas, ni plus ni moins. Ils sont des lieux où l’on se regroupe et où peuvent se bâtir des collectifs éphémères ou non. Ils sont les supports utilitaires où des pratiques d’interlocution non-concurrentielles peuvent s’accomplir et s’inventer : microblog, blog, organiseur d’événement, partage de vidéo, partage de contenus audio, et toute application dont l’objectif consiste à outiller la liberté d’expression et non la remplacer.

Angélisme ? Peut-être. En tout cas, c’est ma manière de voir le Fediverse aujourd’hui. L’avenir nous dira ce que les utilisateurs en feront.

Notes

-

On peut se référer au passage de la plateforme suprémaciste Gab aux réseaux du Fediverse, mais qui finalement fut bloquée par la plupart des instances du réseau. ↩︎

-

Par exemple, sans remplacer les outils de modération par du machine learning plus ou moins efficace, on peut rendre visible davantage les procédures de reports de contenus haineux, mais à condition d’avoir une équipe de modérateurs prête à réceptionner le flux : les limites deviennent humaines. ↩︎

-

Turoff, Murray, and Starr Roxane Hiltz. 1994. The Network Nation: Human Communication via Computer. Cambridge: MIT Press, p. 401. ↩︎

-

Dupuis-Déri, Francis. Démocratie, histoire politique d’un mot: aux États-Unis et en France. Montréal (Québec), Canada: Lux, 2013. ↩︎

-

Et même si le service était payant, l’adhésion supposerait un consentement autrement plus poussé à l’exploitation des données personnelles sous prétexte d’une qualité de service et d’un meilleur ciblage marketing ou de propagande. Pire encore s’il disposait d’une offre premium ou de niveaux d’abonnements qui segmenteraient encore davantage les utilisateurs. ↩︎

-

J’en parlerai dans un article à venir au sujet du courtage de données et de la société Acxiom. ↩︎

-

…pas faute d’en connaître les symptômes depuis longtemps. Comme ce texte de Jacques Ellul paru dans la revue Esprit en 1937, intitulé « Le fascisme fils du libéralisme », dont voici un extrait : « [Le fascisme] s’adresse au sentiment et non à l’intelligence, il n’est pas un effort vers un ordre réel mais vers un ordre fictif de la réalité. Il est précédé par tout un courant de tendances vers le fascisme : dans tous les pays nous retrouvons ces mesures de police et de violence, ce désir de restreindre les droits du parlement au profit du gouvernement, décrets-lois et pleins pouvoirs, affolement systématique obtenu par une lente pression des journaux sur la mentalité courante, attaques contre tout ce qui est pensée dissidente et expression de cette pensée, limitation de liberté de parole et de droit de réunion, restriction du droit de grève et de manifester, etc. Toutes ces mesures de fait constituent déjà le fascisme. ». ↩︎

15.04.2021 à 02:00

Contrôler les assistés

Contrôler les assistés s’est imposé à partir des années 1990 en France comme un mot d’ordre politique, bureaucratique et moral. Jamais les bénéficiaires d’aides sociales, et parmi eux les plus précaires, n’avaient été aussi rigoureusement surveillés, ni leurs illégalismes ou leurs erreurs si sévèrement sanctionnés. Ce renforcement du contrôle n’est cependant pas réductible à des préoccupations financières. Ainsi, moins sévèrement réprimés, l’évasion fiscale ou les défauts de paiement des cotisations sociales par les employeurs atteignent des montants sans commune mesure avec ceux qui concernent les erreurs ou abus des bénéficiaires d’aides sociales, traqués sans relâche.

Un mécanisme implacable à plusieurs facettes sous-tend cette spirale rigoriste à l’égard des assistés : des leaders politiques qui pourfendent la fraude sociale et qui parviennent à stigmatiser leurs contradicteurs comme naïfs ou complices ; des administrations qui surenchérissent dans des technologies de contrôle toujours plus performantes ; une division du travail bureaucratique qui déréalise et déshumanise le traitement des cas ; le fonctionnement interne de commissions où la clémence est toujours plus difficile à défendre que la sévérité ; le point d’honneur professionnel du contrôleur de la caisse locale qui traque la moindre erreur au nom de l’exactitude des dossiers.

Au nom de la responsabilisation individuelle, de la lutte contre l’abus, de la maîtrise des dépenses, un service public fondamental qui vise à garantir des conditions de vie dignes à tous les citoyens contribue désormais à un gouvernement néopaternaliste des conduites qui stigmatise et précarise les plus faibles.

Dubois, Vincent. Contrôler les assistés. Genèses et usages d’un mot d’ordre. Raisons d’Agir, 2021.

Lien vers le site de l’éditeur : https://www.raisonsdagir-editions.org/catalogue/controler-les-assistes/

11.04.2021 à 02:00

Lettres et articles avec Zettlr ou Pandoc

Utiliser le célèbre convertisseur de document pandoc signifie manier (un tout petit peu) la ligne de commande. Rien de sorcier, pour peu d’être assez ouvert d’esprit pour comprendre qu’en matière de traitement de texte tout n’est pas censé se régler au clic de souris. Cela dit, le logiciel Zettlr permettent de s’affranchir de la ligne de commande tout en utilisant la puissance de pandoc. Zettlr propose une interface optimale pour écrire du texte en markdown et exporter dans différents formats. Il suffit d’aller voir dans les préférences avancées de Zettlr pour constater que ce dernier utilise une sorte de ligne de commande universelle avec pandoc pour réaliser ses exports. Pour ce qui concerne l’export en PDF, Zettlr utilise aussi LaTeX qu’il faudra installer sur la machine au préalable, tout comme pandoc.

J’ai écrit un petit billet sur Zettlr. Vous pouvez aller le lire pour mieux comprendre ce que je vais raconter ci-dessous.

Si vous n’avez pas envie de lire ce billet et souhaitez directement vous servir des modèles que je propose, vous trouverez l’ensemble sur ce dépôt GIT. Il y a un fichier README suffisant.

Pandoc et LaTeX

Qu’en est-il de la mise en page ? C’est là que les avantages combinés de pandoc et de LaTeX entrent en jeu : il est possible, en quelque sorte, de « programmer » la mise en page en élaborant des modèles qui utilisent différentes variables renseignées dans le fichier source en markdown. Bien entendu, on peut créer des modèles pour tout type d’export avec pandoc et d’ailleurs ce dernier utilise une batterie de modèles par défaut, mais ces derniers ne sont pas toujours adaptés à la sortie finale : qu’on utilise Zettlr ou non (ou n’importe quel éditeur de texte), il faut savoir compléter son fichier markdown avec des informations destinées à être taitées par pandoc.

Pour information, si pandoc s’utilise en ligne de commande, c’est parce qu’il y a toute une batterie d’options et de commandes que pandoc est capable d’exécuter. Pour éviter de les entrer systématiquement en ligne de commande, on peut les indiquer simplement dans l’en-tête du fichier markdown (ou dans un fichier séparé). Pour mieux comprendre de quoi il s’agit, vous pouvez vous reporter à ce document.

Pour donner un exemple trivial : si vous voulez que votre document markdown une fois exporté comporte un titre, un nom d’auteur et une date, il vous suffit de les indiquer de cette manière dans l’en-tête au début du document (on les appellera des « métadonnées ») :

``

% Le titre

% Prénom Nom

% 17/02/2021

``

Ou bien, en utilisant le format YAML :

``

---

title: "Le titre"

date: "17 février 2021"

author: "Prénom Nom"

...

``

Ainsi, pandoc les interprétera et, en utilisant un modèle par défaut ou un modèle de votre cru, reportera ces variables aux emplacements voulus dans la mise en page.

Si vous voulez écrire un article académique et le sortir en PDF en utilisant pandoc qui lui-même utilisera LaTeX, il vous faut donc réunir les éléments suivants :

- un modèle LaTeX (ou se contenter des modèles LaTEX par défaut de pandoc),

- des métadonnées à entrer après s’être bien renseigné sur la manuel d’utilisation de pandoc,

- un fichier de bibliographie,

- un fichier de style de présentation de la bibliographie.

En comptant les options courantes de pandoc que vous souhaitez utiliser, vous risquez de vous retrouver avec une ligne de commande assez longue… pour éviter cela, vous pouvez automatiser le tout avec un makefile que vous pourrez réutiliser plus tard pour d’autres documents, mais bigre… cela commence à devenir bien complexe pour qui n’a pas forcément envie d’y passer trop de temps, à moins de concevoir une fois pour toute une chaîne éditoriale que vous adapterez au fil du temps (c’est une option).

Zettlr et les modèles

Un grand avantage de Zettlr est de vous décharger de plusieurs de ces contraintes, en plus d’offrir une interface vraiment pratique entièrement destinée à l’écriture. Pour réaliser des exports, il vous faudra seulement installer pandoc. Et pour réaliser des exports PDF, il vous faudra installer LaTeX (je préconise une installation complète, par exemple Texlive-full).

Le fichier et le style CSL de bibliographie ? il vous suffit de les renseigner dans les préférences de Zettlr une fois pour toutes.

Le modèle de sortie PDF ? idem, vous le renseignez dans les préférences d’export PDF.

Et pour exporter ? il vous suffira de cliquer sur l’icône PDF.

Tout cela demeure assez simple, sauf que si vous rédigez un article sans chercher à travailler la question des métadonnées, votre sortie PDF risque de vous décevoir : pandoc utilisera le modèle par défaut, c’est-à-dire la classe [article]de LaTeX, qui en soi est une excellente mise en page, mais ne colle pas forcément à vos souhaits.

Réaliser des modèles pour pandoc est chose assez facile. En effet, si vous comprenez des notions informatiques basiques comme « pour…si…ou…alors », la syntaxe des modèles pandoc ne posera guère de problème. Il faudra néanmoins maîtriser LaTeX si vous voulez créer un modèle LaTeX.

Mes modèles article, rapport et lettre

Pour vous éviter d’y passer trop de temps, je vous propose d’utiliser mes modèles élaboré pour des articles, des rapports ou des lettres simples.

J’ai pris le parti de réaliser un modèle LaTeX destiné à chaque fois à la sortie voulue, là où le modèle pandoc par défaut permet de créer un article, une présentation ou un livre en indiquant simplement la classe voulue. Ce modèle par défaut inclu donc de nombreuses variables mais à trop vouloir être généraliste, je pense qu’on loupe l’essentiel.

Pour utiliser mes modèles, il vous suffit de réutiliser les fichiers markdown renseigner les différents éléments présents dans les en-têtes YAML de ces fichiers. Si vous voulez modifier les modèles eux-mêmes, il vous suffit de les éditer : j’ai tâché de commenter et de bien séparer les éléments importants.

Ces modèles utilisent KOMA-script, la classe scrartcl pour les article, scrreprt pour les rapports et scrlttr2 pour les lettres. Si vous connaissez LaTeX, vous comprendrez que KOMA-script est un excellent choix pour des documents européens (il fut créé au départ pour des documents de langue allemande, mais il fut rapidement adapté à différentes pratiques d’écriture, dont le Français).

Pour résumer très simplement :

- si vous écrivez une lettre, renseignez dans Zettlr le chemin vers le modèle dans les préférences d’export PDF,

- si vous écrivez un article ou un rapport, renseignez dans Zettlr le chemin vers le modèle dans les préférences d’export PDF et notez que le modèle utilise les styles CSL pour la bibliographie (pas de biblatex ou de natbib, donc),

- si vous ne voulez pas utiliser Zettlr, et uniquement pandoc, je vous ai indiqué dans le

READMEles lignes de commande à utiliser (ce sont celles qu’utilise Zettlr, en fait).

Vous trouverez l’ensemble sur ce dépôt GIT.

- Persos A à L

- Carmine

- Mona CHOLLET

- Anna COLIN-LEBEDEV

- Julien DEVAUREIX

- Cory DOCTOROW

- Lionel DRICOT (PLOUM)

- EDUC.POP.FR

- Marc ENDEWELD

- Michel GOYA

- Hubert GUILLAUD

- Gérard FILOCHE

- Alain GRANDJEAN

- Hacking-Social

- Samuel HAYAT

- Dana HILLIOT

- François HOUSTE

- Tagrawla INEQQIQI

- Infiltrés (les)

- Clément JEANNEAU

- Paul JORION

- Michel LEPESANT

- Persos M à Z

- Henri MALER

- Christophe MASUTTI

- Jean-Luc MÉLENCHON

- MONDE DIPLO (Blogs persos)

- Richard MONVOISIN

- Corinne MOREL-DARLEUX

- Timothée PARRIQUE

- Thomas PIKETTY

- VisionsCarto

- Yannis YOULOUNTAS

- Michaël ZEMMOUR

- LePartisan.info

- Numérique

- Blog Binaire

- Christophe DESCHAMPS

- Louis DERRAC

- Olivier ERTZSCHEID

- Olivier EZRATY

- Framablog

- Romain LECLAIRE

- Tristan NITOT

- Francis PISANI

- Irénée RÉGNAULD

- Nicolas VIVANT

- Collectifs

- Arguments

- Blogs Mediapart

- Bondy Blog

- Dérivation

- Économistes Atterrés

- Dissidences

- Mr Mondialisation

- Palim Psao

- Paris-Luttes.info

- ROJAVA Info

- Créatifs / Art / Fiction

- Nicole ESTEROLLE

- Julien HERVIEUX

- Alessandro PIGNOCCHI

- Laura VAZQUEZ

- XKCD