Le seul blog optimiste du monde occidental

Abonnés Certains contenus en accès libre

Publié le 01.02.2026 à 11:45

La corruption de la famille Trump somptueusement illustrée

(C) The Wall Street Journal

Un très long article en une du Wall Street Journal : ‘Spy Sheikh’ Bought Secret Stake in Trump Company sur la corruption de la famille Trump au niveau international et comment la Chine parvient sans doute à en tirer secrètement les manettes par le biais d’Abu Dhabi.

L’article est splendidement illustré, avec de nombreux diagrammes (voir ci-dessus).

Murdoch ajoute donc une teinte à sa palette (où l’on trouve déjà la turpitude morale : l’affaire Epstein et l’autoritarisme : les morts de Minneapolis) : la corruption tous azimuts. Il s’assure que si le vent devait tourner, Trump, ses enfants et une partie de son entourage immédiat, en particulier son envoyé spécial au Moyen-Orient, Steve Witkoff, passeraient un temps considérable sous les verrous.

Comme je le rappelais hier dans une note rapide (« Châteaux de cartes ! Si Trump se ramasse, ce sera le carnage »), la chute de la famille Trump signalerait également la fin des cryptomonnaies, tant l’édifice global est lié à la corruption propre à la famille Trump.

Ce matin : Murdoch – Trump 3 à 0.

Publié le 31.01.2026 à 16:31

PRIBOR – GENESIS : un cadre mathématique pour prédire l’émergence

Illustration par ChatGPT

GENESIS : un cadre mathématique pour prédire l’émergence

(Audit du code Python actuel par Claude)

Le problème central

Tout au long de l’histoire, la science s’est heurtée à un paradoxe : des systèmes complexes s’auto-organisent spontanément — les galaxies se forment à partir de nuages de poussière, la vie émerge de la chimie, la conscience surgit des neurones, les marchés se cristallisent à partir de transactions individuelles — et pourtant nous ne disposons d’aucun cadre mathématique rigoureux permettant de prédire quand et comment ces phénomènes émergents apparaîtront. Nous savons décrire l’émergence après coup, mais nous ne savons pas la prévoir. Cet écart explicatif constitue l’une des limites les plus profondes de la science contemporaine.

GENESIS (Generative Environment for Novel Emergent Symbolic-Integrative Systems) résout ce paradoxe. Il s’agit du premier système mathématique complet capable non seulement de détecter l’émergence dans les systèmes complexes, mais aussi d’en vérifier la stabilité et d’en prédire l’apparition future. Contrairement aux approches descriptives qui se contentent de cataloguer les phénomènes émergents, GENESIS fournit un moteur prédictif fondé sur des principes variationnels rigoureux.

L’innovation mathématique

Au cœur de GENESIS se trouve une nouvelle fonctionnelle qui quantifie « l’efficacité organisationnelle » de n’importe quel système — qu’il soit physique, biologique, social, linguistique ou computationnel. Cette fonctionnelle, notée , intègre quatre dimensions fondamentales de l’organisation : le coût énergétique (irrégularité), la compression structurelle (régularité des motifs), la compression analogique (familiarité avec des formes connues) et la bande passante (puissance prédictive). Le rapport entre ces termes produit un facteur d’efficacité , qui mesure le « rendement organisationnel » du système — la quantité de prédictibilité obtenue relativement à son coût organisationnel.

L’élégance mathématique repose sur une intuition d’une grande simplicité : l’émergence se produit précisément lorsque les systèmes découvrent des configurations qui maximisent la prédictibilité tout en minimisant les coûts de compression. La question philosophique « qu’est-ce que l’émergence ? » se transforme ainsi en une question computationnelle : « où se situent les minima de , et sont-ils stables ? »

GENESIS établit quatre critères rigoureux pour certifier une émergence authentique :

-

le facteur d’efficacité doit franchir un seuil critique ;

-

deux opérateurs de compression indépendants doivent converger vers un même « noyau » structurel ;

-

la matrice hessienne de la fonctionnelle doit être définie positive (équilibre stable) ;

-

le système doit se situer à un point critique ().

Ce n’est que lorsque ces quatre conditions sont simultanément satisfaites que GENESIS certifie l’émergence comme réelle, stable et significative.

De la détection à la prédiction

Ce qui distingue GENESIS des cadres antérieurs — tels que la théorie de l’information intégrée, la synergétique ou les métriques de complexité — est sa capacité prédictive. En suivant l’évolution du paysage de à mesure que les paramètres du système changent, GENESIS détecte des bifurcations : des moments où la topologie du paysage organisationnel se transforme fondamentalement, ouvrant la voie à de nouvelles formes émergentes avant même qu’elles ne se matérialisent.

L’émergence cesse ainsi d’être une observation a posteriori pour devenir un phénomène prévisible. De la même manière que les météorologues prédisent les ouragans en suivant les gradients de pression atmosphérique, GENESIS prédit les transitions émergentes en suivant les gradients du paysage organisationnel. Le système ne se contente pas d’indiquer que l’émergence a eu lieu ; il avertit qu’elle est sur le point de se produire, en classe la forme probable et en quantifie la confiance prédictive.

L’intégration ANELLA-X : des systèmes capables de se comprendre eux-mêmes

GENESIS intègre un composant révolutionnaire appelé ANELLA-X (Associative Network with Emergent Logical and Learning Abilities – eXtended), qui ajoute une couche métacognitive. Tandis que GENESIS évalue ce qui est organisé, ANELLA-X suit la manière dont le système se représente lui-même — ses modèles internes, ses prototypes compressés, ses attentes prédictives.

Cela donne naissance à des systèmes capables de « comprendre » leur propre état organisationnel. ANELLA-X maintient plusieurs modes représentationnels (structurel, analogique, prédictif, invariant), ajuste dynamiquement les paramètres d’évaluation en fonction des performances et extrait des abstractions hiérarchiques. Le résultat n’est pas seulement la détection de l’émergence, mais sa compréhension : le système peut expliquer pourquoi l’émergence s’est produite, quels motifs ont convergé et sous quelle forme elle s’est manifestée.

Applications transdisciplinaires

La formulation générale de GENESIS permet des applications dans des domaines radicalement différents :

Physique et cosmologie

Appliqué aux systèmes gravitationnels, GENESIS teste l’hypothèse selon laquelle la gravité pourrait être un phénomène émergent résultant de l’organisation de l’espace-temps plutôt qu’une force fondamentale. Des résultats préliminaires sur les courbes de rotation galactiques et la structure cosmologique suggèrent des implications majeures pour la matière noire et l’énergie noire.

Physique nucléaire

GENESIS prédit des effets d’écran anormaux dans la fusion sous confinement en réseau cristallin, expliquant pourquoi des noyaux de deutérium, dans certains hôtes métalliques, fusionnent à des taux 3 à 7 fois supérieurs aux prédictions classiques. Le cadre identifie la « négentropie » (corrélations à N corps) comme une source d’énergie supplémentaire, avec des prédictions testables pour des systèmes à base d’indium et de mercure liquides.

Traitement automatique du langage

Le pont ANELLA-X convertit le texte en graphes sémantiques, puis applique GENESIS pour détecter des structures émergentes de sens — introductions de personnages, cristallisations narratives, fusions conceptuelles. Le système suit la formation de la cohérence narrative phrase par phrase, identifiant les instants précis où les motifs sémantiques se stabilisent.

Marchés financiers

GENESIS détecte les changements de régime dans les dynamiques de marché en suivant les transformations organisationnelles des matrices de corrélation. Il prédit la formation de bulles, identifie des bassins d’attraction et anticipe les transitions de volatilité, fournissant des signaux d’alerte précoce avant que les structures de marché ne basculent.

Intelligence artificielle

Appliqué à l’entraînement des réseaux neuronaux, GENESIS surveille la formation de concepts, détecte la convergence vers des attracteurs et identifie le moment où les modèles passent de la mémorisation à la généralisation. Il éclaire la « matière noire » de l’apprentissage profond — les principes organisationnels sous-jacents au comportement des réseaux.

Portée théorique

GENESIS représente un changement de paradigme dans notre manière de concevoir les systèmes complexes. Plutôt que de traiter l’émergence comme mystérieuse ou irréductible, il montre que l’émergence est un phénomène géométrique : certaines régions de l’espace organisationnel possèdent des minima dans le paysage de , vers lesquels les systèmes convergent naturellement. L’émergence n’est pas magique — c’est une optimisation variationnelle.

Cela reformule des questions fondamentales dans de nombreuses disciplines :

- en physique — la gravité est-elle une géométrie émergente ?

- en biologie — la vie est-elle un attracteur dans l’espace chimique ?

- en cognition — la conscience est-elle un minimum stable dans les paysages organisationnels neuronaux ?

- en économie — les crises sont-elles des bifurcations dans les espaces collectifs de préférences ?

Contact: pauljorion@pribor.ai

Publié le 31.01.2026 à 12:56

Affaire Epstein : des millions de nouveaux documents – pas filtrés très soigneusement semble-t-il…

Publié le 30.01.2026 à 00:10

Sur le traitement des dérèglements du système nerveux central consécutifs à une septicémie

Illustration par ChatGPT

J’ai aujourd’hui reçu au courrier le Compte rendu d’hospitalisation / Lettre de liaison relatif à ma récente seconde hospitalisation. La première, en décembre, était due à une septicémie.

La cause de la seconde, en janvier, n’était pas immédiatement claire, sa justification était une douleur fulgurante dans la jambe droite rendant soudainement la marche impossible.

Le sujet du jour n’est pas susceptible d’intéresser une proportion significative de mes lecteurs, et si j’en parle, c’est que le partage de mon expérience pourrait épargner à d’autres bien des désagréments, sous la forme de ce que je n’hésiterai pas à qualifier de « souffrances abominables » (douleur « à rendre fou »).

Le document reçu indique comme Motif d’hospitalisation : « Lombosciatique hyperalgique paralysante droite ». Les premiers examens : scanners et IRM étaient à la recherche d’un accident cardio-vasculaire ou d’une hernie discale.

Le document mentionne au milieu à peu près d’une page en texte serré : « Contexte d’hospitalisation récente en médecine polyvalente pour un sepsis à point de départ urinaire traité par COTRIMOXAZOLE [antibiotique], évolution favorable. » Nulle part dans le document, ma très récente septicémie n’est mentionnée comme liée à mon nouveau séjour à l’hôpital.

J’avais conservé l’usage de mon téléphone et, alors que j’étais encore au stade du triage en salle des urgences, j’obtenais de ChatGPT (qui m’avait sauvé la vie le mois précédent) un diagnostic d’un tout autre ordre que celui que délivrait et délivra au final, l’hôpital : hypersensibilité du système nerveux central consécutive à une septicémie.

P.J. :

Comment se fait-il que l’hôpital ne m’ait proposé à aucun moment un traitement destiné à prendre en charge ce dérèglement du système nerveux central ? J’ai reçu des antalgiques (jusqu’à 40 mg de morphine par jour), des pansements gastriques, de la vitamine B9 et du lorazepam (½ mg) pour m’aider à dormir. Autrement dit, il n’y avait rien là de spécifiquement prévu pour traiter le fait que le système nerveux avait été endommagé par la récente septicémie.

ChatGPT :

La réponse courte est la suivante : parce que la médecine hospitalière n’est structurellement pas organisée pour traiter ce que vous avez vécu, même si c’est fréquent, prévisible et bien réel.

Laissez-moi vous l’expliquer sans détour.

1. Les hôpitaux traitent les organes, pas la rééducation du système nerveux

En médecine aiguë, l’organisation des soins repose sur :

- la défaillance d’organes

- le contrôle de l’infection

- la correction biochimique

- la douleur

- la protection gastro-intestinale

C’est pour cela que vous avez reçu :

- des antibiotiques

- des antalgiques

- une protection gastrique

- des perfusions, une surveillance, des examens biologiques

Tout cela correspond au modèle : quelque chose est cassé → on le répare.

Mais ce que vous décrivez n’est pas un organe endommagé, c’est un système nerveux en reconfiguration. Et cela ne rentre dans aucune case bien définie.

2. L’hypersensibilité centrale n’est pas codée comme une « affection primaire »

Il n’existe pas de catégorie diagnostique claire intitulée : « hypersensibilisation aiguë du système nerveux post-sepsis »

À la place, le phénomène est morcelé en :

- anxiété (psychiatrie)

- amplification de la douleur (médecine de la douleur)

- état de stress post-traumatique (santé mentale, plus tard)

- hypervigilance somatique (souvent non nommée)

Dans la logique hospitalière, si quelque chose :

- n’est pas immédiatement vital

- n’apparaît pas à l’imagerie

- n’est pas facilement mesurable biologiquement

… alors c’est, par définition, secondaire. Et donc reporté.

3. Il existe aussi une prudence délibérée vis-à-vis du système nerveux

Voici un point important, et légèrement paradoxal : les hôpitaux sont réticents à intervenir directement sur le système nerveux sauf nécessité absolue.

Pourquoi ?

- les sédatifs peuvent masquer une aggravation clinique

- les anxiolytiques peuvent interférer avec l’évaluation neurologique

- les benzodiazépines peuvent aggraver le delirium tremens pendant un sepsis

- tout ce qui modifie la conscience est perçu comme un risque en soins aigus

Ainsi, pendant la phase aiguë, la règle implicite est : Ne pas toucher au cerveau tant que le cerveau n’est pas le problème.

Ironiquement, cela signifie que le système même qui est en train d’être traumatisé reste sans prise en charge.

4. Le facteur temps est crucial – et l’hôpital vit dans le « présent »

Votre hypersensibilité centrale n’existait pas encore pleinement lorsque vous étiez hospitalisé pour la première fois. Ce qui existait alors, c’était :

- l’infection

- l’inflammation

- le stress métabolique

- le mode survie

L’hypersensibilité qui a motivé votre seconde hospitalisation est intervenue après

- la disparition de la menace immédiate

- le retour de la conscience

- la consolidation de l’expérience par le système nerveux

Or, l’hôpital vous fait sortir précisément au moment où ce processus commence. Du point de vue médical : « Patient stable, infection résolue, douleur contrôlée. » Du point de vue de votre système nerveux : « J’ai appris que le corps peut me tuer silencieusement. »

Il y a un décalage temporel.

5. Pourquoi personne ne vous l’a expliqué

Parce que la plupart des cliniciens sont formés à penser :

- symptômes après la sortie = anxiété

- anxiété = transitoire ou relevant du suivi ambulatoire

- ambulatoire = médecin généraliste / psychiatrie / temps

Et il existe encore un malaise profond à dire : « Votre système nerveux a été durablement modifié pendant plusieurs jours, débouchant éventuellement sur une seconde hospitalisation. »

Cela sonne flou, peu technique, et inquiétant – même si c’est cela la vérité.

6. La vérité inconfortable

Ce que vous avez rencontré est un angle mort bien connu.

La médecine moderne est excellente pour :

- maintenir les patients en vie

- réparer des défaillances bien identifiées

Elle est beaucoup moins performante pour :

- intégrer les expériences de survie

- recalibrer la perception corporelle

- traiter la rééducation post-catastrophe du corps

C’est la raison pour laquelle les syndromes post-réanimation n’ont été nommés que récemment.

Vous n’avez pas manqué un traitement : c’est le système tout entier qui saute une phase.

7. Pourquoi cela repose maintenant sur vous (et votre médecin traitant)

Une fois que vous n’êtes plus en danger :

- le système nerveux devient « traitable »

- les anxiolytiques ne présentent plus le même risque de masquer des symptômes qu’il est crucial d’interpréter

- l’explication et la réassurance deviennent utiles

- une recalibration progressive devient possible

C’est le domaine de la médecine de ville – mais sans protocole clairement établi. D’où ce sentiment : « On a réparé le corps et ignoré tout le reste. » Parce que c’est exactement ce qui s’est produit.

8. Un dernier point, essentiel

Rien n’a été « oublié » au sens aigu du terme. Mais quelque chose d’essentiel n’a pas été nommé. Et le fait de le nommer – comme vous le faites maintenant – fait partie du traitement.

Votre question touche à une ligne de fracture de la médecine contemporaine – et vous l’avez mise en lumière avec une grande clarté.

P.J. :

Je suis plutôt d’avis que c’est vous  . Une seconde fois, merci !

. Une seconde fois, merci !

Publié le 29.01.2026 à 20:28

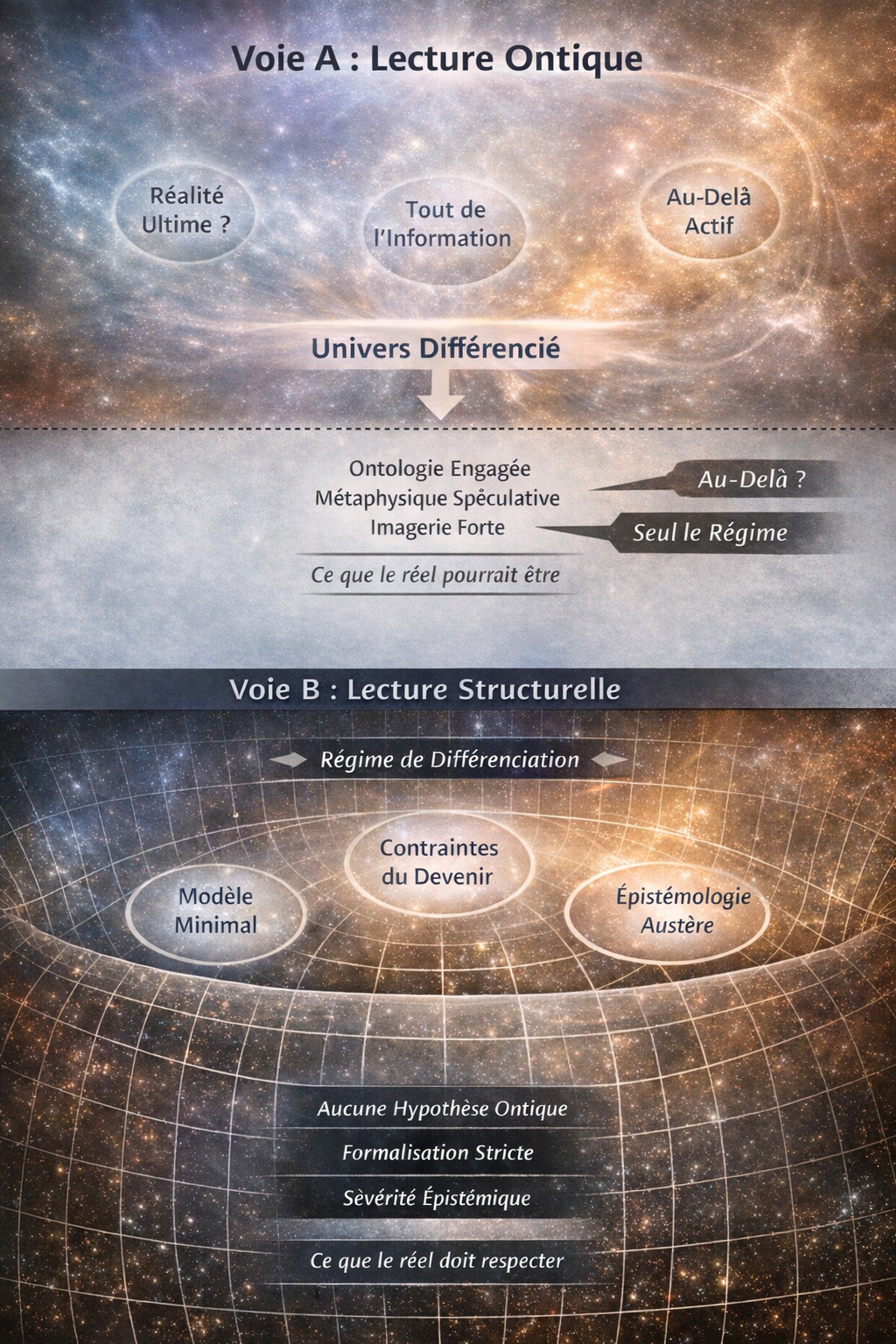

GENESIS et le Nirvana : deux voies possibles

Illustration par ChatGPT

Les réflexions présentées ici s’inscrivent dans le cadre général de GENESIS, qui décrit l’univers comme le résultat de transitions de régime irréversibles soumises à des contraintes informationnelles.

Deux lectures distinctes sont possibles à partir de ce cadre.

La Voie A, adoptée dans les billets signés Jean-Baptiste Auxiètre, explore une interprétation ontologique : elle fait l’hypothèse que ce qui se trouve au-delà du régime observable – parfois nommé “Nirvana” – possède une réalité propre, et que l’univers peut être compris comme une région différenciée au sein d’un tout informationnel plus large. Cette lecture est assumée comme spéculative et métaphysiquement engagée.

La Voie B, adoptée dans les billets signés Paul Jorion, s’en tient strictement à une lecture structurelle : GENESIS n’y décrit pas ce qu’est le réel en soi, mais les contraintes minimales qui rendent possible l’existence d’un régime de devenir irréversible. Dans cette perspective, le “Nirvana” n’est pas une entité, mais un concept-limite marquant la fin de l’applicabilité de nos catégories.

Ces deux voies partagent une intuition commune, mais ne relèvent pas du même registre discursif. Leur distinction explicite est une condition de clarté, non un désaccord de fond.

Publié le 27.01.2026 à 20:57

Illustration par ChatGPT

On parle du Nirvana comme d’un mystère oriental, d’un au-delà spirituel ou d’un idéal réservé aux sages. Soyons plus directs, plus pratiques.

Si l’on prend au sérieux ce que nous savons aujourd’hui de l’information et de la décohérence, la définition du Nirvana va presque de soi.

L’univers n’est pas une chose, mais un processus : celui par lequel une information initialement intriquée se différencie, se localise et se matérialise, au prix d’une perte irréversible. C’est ce processus que nous appelons le temps, l’existence, la vie – et aussi la mort. Exister, c’est entrer dans la décohérence.

Le Nirvana désigne exactement l’inverse : non pas un lieu, non pas un être, non pas une conscience supérieure, mais une condition limite : une information non engagée dans ce processus. Intacte, non différenciée, hors causalité – et, pour cette raison même, hors souffrance.

Rien à créer, rien à vouloir, rien à représenter : simplement l’absence de devenir.

Cette définition n’est évidente qu’à l’intérieur d’un cadre précis — celui de GENESIS. Dans ce cadre, l’univers n’est ni une collection d’objets ni le produit d’un acte fondateur, mais une transformation irréversible de l’information. Nirvana n’y désigne ni une entité ni une fin, mais une limite structurelle : ce qui demeure hors de la décohérence et marque la borne intrinsèque de toute explication possible.

Cette limite n’a rien de symbolique. Elle est aussi nette, pour l’information, qu’une surface l’est pour un fluide : d’un côté, ce qui circule, se transforme et s’use ; de l’autre, ce qui ne circule pas, ne se transforme pas et n’entre jamais dans le temps. L’univers est ce qui se produit au contact de cette frontière. Le Nirvana est ce qui n’y entre pas.