07.01.2026 à 10:00

Les Accords du Lion d’Or, un tiers-lieu à dimension culturelle en cours de dégafamisation

Framasoft

Texte intégral (3914 mots)

Parce qu’il nous semble toujours aussi important de promouvoir les démarches de transition vers les outils numériques éthiques opérées par les organisations, voici un nouvel opus pour notre série de témoignages de Dégooglisation. Un grand merci à Étienne d’avoir pris le temps de nous raconter comment le tiers-lieu Les Accords du Lion d’Or dans lequel il est investi, a changé de vie numérique..

Bonjour, peux-tu te présenter brièvement pour le Framablog ?

Bonjour, je suis Étienne régisseur et technicien du spectacle en transition, passionné d’informatique depuis fort longtemps, je quitte le milieu du spectacle pour me consacrer désormais à ma première passion. J’ai rencontré l’association Les Accords du Lion d’Or en 2016, un tiers-lieu à vocation culturelle fraîchement installé dans mon village natal, juste à côté de la ville dans laquelle je suis revenu m’installer après ma formation et quelques années de travail à Bruxelles.

C’est un projet aux multiples facettes, spectacles vivant, lieu de mémoire du village, projet de forêt nourricière, recherche sur le numérique, en lien avec les habitant⋅e⋅s… J’avais été invité à coanimer une rencontre avec des écoliers au sujet des photos et vieilles cartes postales du village, comment faire un travail de mémoire. C’est un projet qui ressemblait beaucoup à ce que j’avais moi-même vécu à l’école de Simandre en 2003 : numériser et classer dans une base de données sommaire, une partie de ces photos. C’est ainsi que j’ai rencontré l’association.

Située dans un lieu emblématique au cœur du village et de part la volonté d’être à la rencontre des habitants, de nombreuses histoires et matières, cartes postales, images, menus, récits et autres sont arrivées au Lion d’Or ; le besoin d’enregistrer et préserver les souvenirs s’est accentué.

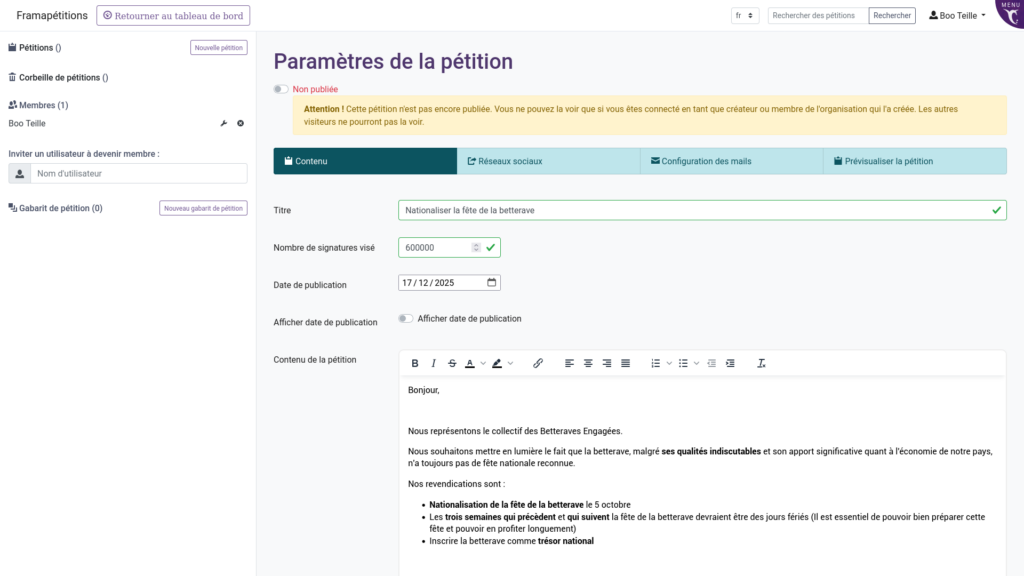

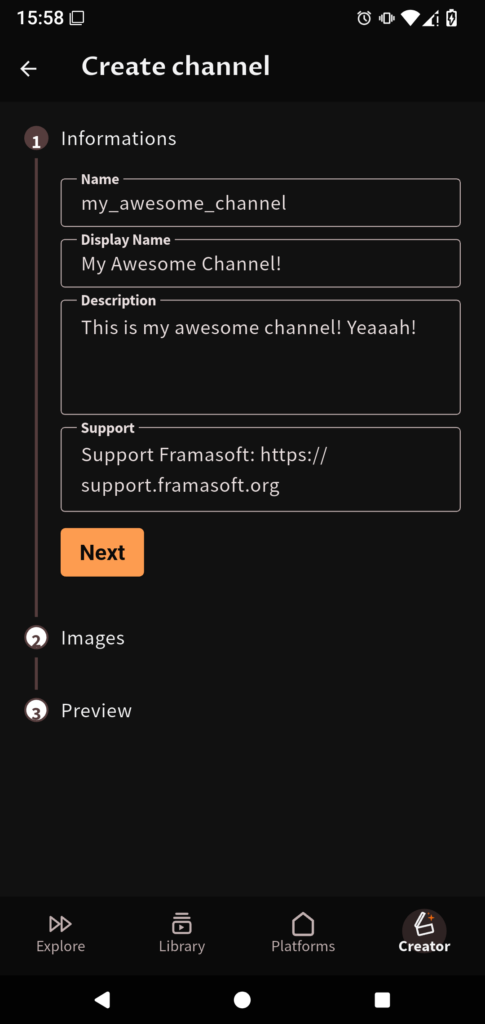

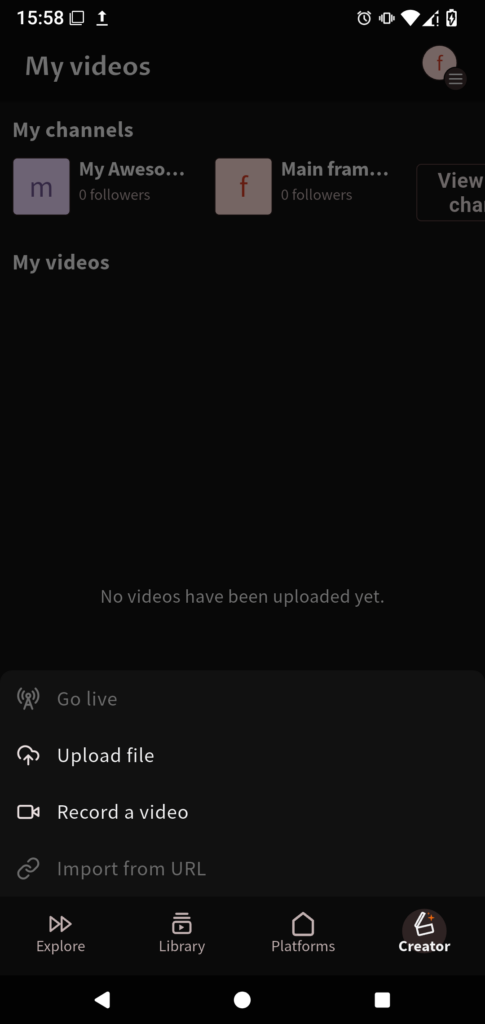

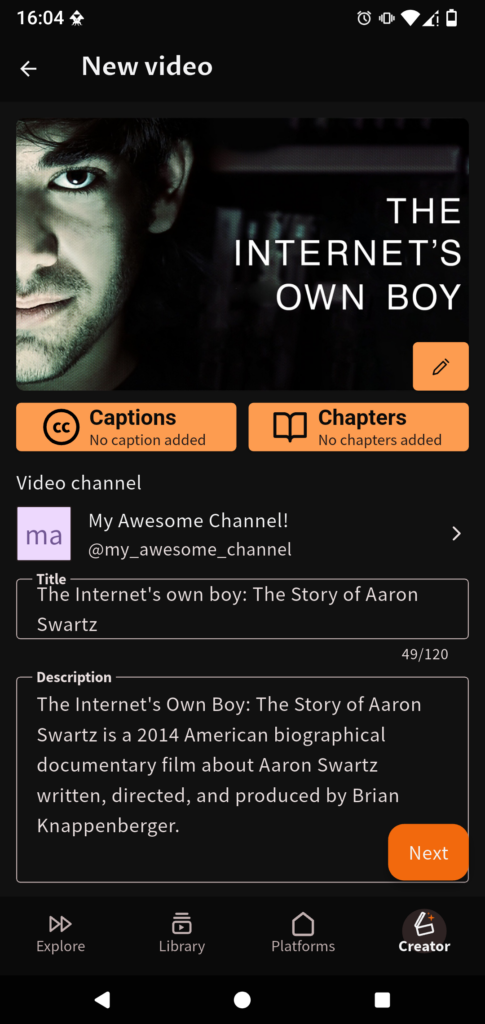

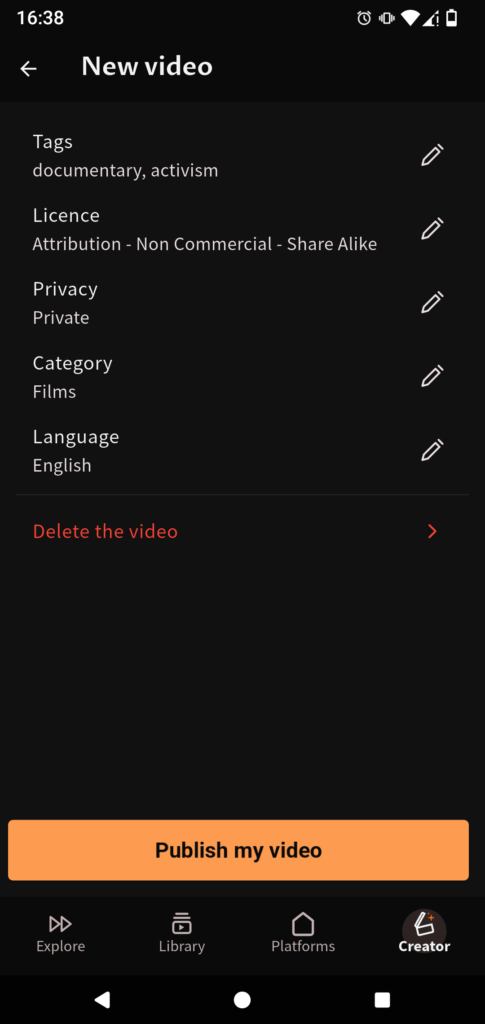

Entête du site Les Accords du Lion d’Or

Nous avons alors choisi de démarrer une base de données avec comme objet les images. Fort de mes convictions elle serait sur GNU/Linux, ce choix était entre mes mains et la confiance de l’équipe était là.

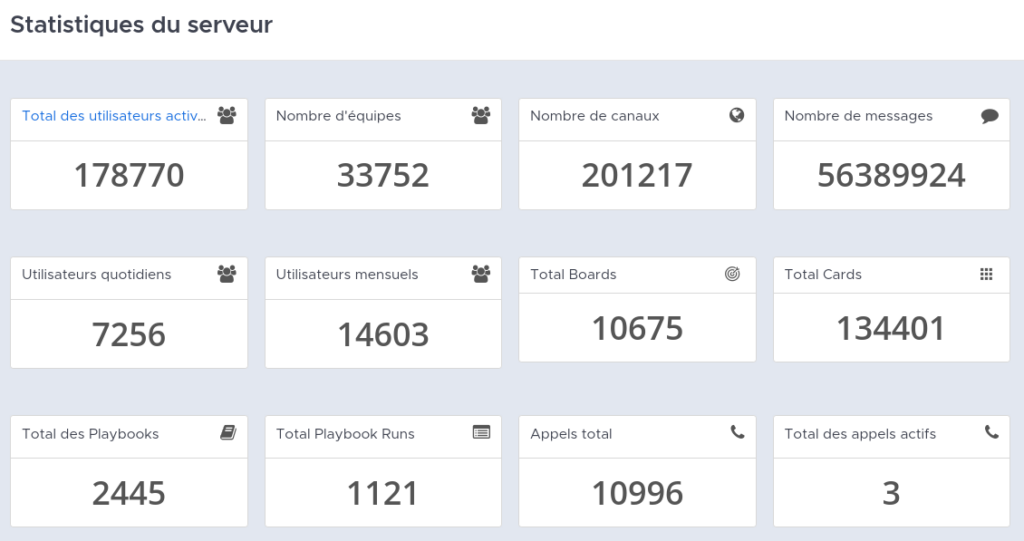

À ce jour, nous sommes un collectif multiforme, un conseil collégial d’administration, 1 salariée à 80 % chargée de missions, 1 salariée à 70 % animatrice nature, 1 salarié à 25 % agent en charge du développement des usages numériques en 2023 : c’est moi, une artiste plasticienne et trois artistes du spectacle pleinement impliqués dans la vie de l’association.

Au fil des projets il s’est avéré que plusieurs personnes au sein de l’équipe étaient sensibles aux questions de souveraineté numérique. Rapidement, nous nous sommes rendu compte des compétences que j’avais accumulées au fil des années et de l’intérêt pour l’association d’en faire un sujet commun.

Quel a été le déclencheur de votre dégafamisation ?

En fait on a pas vraiment eu un déclic, ça s’est fait au fur et à mesure en fonction des besoins des salariés de l’association. Pas à pas nous avons fait des choix de plus en plus importants toujours dans une démarche de recherche et d’expérimentation qui sont des valeurs importantes au Lion d’Or. Par exemple, le site de l’association est éco-conçu : sobriété et inclusion. Ce premier acte avait été posé avant même mon arrivée.

Ma rencontre avec l’association a probablement été un des déclencheurs tout de même, car j’arrivais avec une démarche engagée personnellement depuis longtemps : explorer l’auto-hébergement. J’ai apporté mon expérience du numérique dans plusieurs projets, lors de la création d’un escape-game en assistant l’équipe, dont le duo artistique « Scénocosme », la création de la base de données d’images, la création de documents pour les expositions en coopération avec les habitants… Et de fil en aiguille on a tissé ce lien de confiance avec un numérique différent.

Bannière du couple d’artistes Scénocosme

Comme nous sommes une petite équipe de salariés (en lien avec un conseil d’administration qui a confiance lui aussi !), la question de la dégafamisation nous concernait directement. Être peu nombreux a été clairement un atout pour la rapidité, la simplicité dans toutes les étapes de cette transition, on en reparlera souvent.

Tout le monde était éveillé d’une manière ou d’une autre sur le sujet, certains ayant déjà fait des choix pour leur vie numérique personnelle (il faut dire que dans les livres qui sont posés ici et là dans le tiers-lieu il y a Yggdrasil, Pablo Servigne, Cyril Dion, Socialter ;-)). Quand j’ai proposé de passer une première étape décisive, passer de GDrive à Nextcloud sur un petit NAS, le choix a été rapidement fait. Les quelques craintes soulevées ont été discutées directement and voilà ! Elles concernaient principalement le maintien des données, ne pas perdre le travail en cours. Nous n’avons rien perdu et ça a même été l’occasion de donner une nouvelle arborescence au dossier de travail qui avait déjà 3 ans de données.

Nous avons par la suite organisé une rencontre avec les membres du CA pour leur présenter les outils et les fonctionnements qui ont été reçus avec des avis mitigés mais confiants sur le moment car l’intérêt pour eux n’était pas direct.

Comment avez-vous organisé votre dégafamisation ?

Pour nous, ça s’est vraiment fait au fur et à mesure, à petit pas. L’association est toujours en recherche, en expérimentation sur tous les sujets qui la concerne, donc à chaque fois que nous nous posions la question nous pouvions faire un choix dans cette direction.

J’avais connaissance du réseau des C.H.A.T.O.N.S. et nous avons contacté Hadoly pour avoir un avis, c’est grâce à eux que nous utilisons Yunohost qui est un élément technique important de cette expérience.

Le logo d’HADOLY, un CHATON lyonnais qui vient de fêter ses 10 ans.

On peut résumer les grandes étapes qu’on détaillera plus bas :

- 2018 – réalisation du site internet en éco-conception

- 2019 – démarrage de la base de données d’images : GNU/Linux et DigiKam

- 2019 – N.A.S. pour les sauvegardes et première bascule pour le partage de fichiers et les agendas

- 2022 – installation d’un serveur dédié pour rapatrier plus de services.

- 2023 – changement de système d’exploitation pour 2 salariées de MacOS vers GNU/Linux

- 2024 – changement d’outil de comptabilité

Est-ce que vous avez rencontré des résistances que vous n’aviez pas anticipées, qui vous ont pris par surprise ? Au contraire, y a-t-il eu des changements dont vous aviez peur et qui se sont passés comme sur des roulettes ?

Ça a franchement roulé. Je crois que pour tous dans l’équipe la transition a été fluide même si elle a demandé des temps d’adaptation et lorsqu’il y avait à faire un ajustement, on a pu réagir tout de suite. Par exemple la migration des agendas, nous étions tous dans la même pièce et je guidais chacun·e dans la marche à suivre.

Une nouvelle fois, être en petit nombre a été un atout. Un autre point non négligeable est d’avoir quelqu’un « dédié » à la question, régulièrement présent pour répondre aux questions ou difficultés techniques. C’est presque de la formation continue. Les choses se sont faites au fur et à mesure et ça a permis à chacun et chacune de s’approprier chaque outil petit à petit. Un gros passage a quand même été le changement de système d’exploitation pour la chargée de mission, Véro, lors de notre première install’party, après 30 années avec MacOS, passer à Kubuntu a demandé beaucoup d’énergie et d’adaptabilité. Elle a fait preuve de beaucoup de souplesse et détermination pour changer d’un seul coup tout un environnement de travail (contact, e-mail, suite bureautique, classification…).

Kubuntu

On pourrait parler des problématiques techniques mais ça a quand même bien fonctionné de ce côté là, c’est aussi grâce à l’arrivée de la fibre optique dans le village qui nous a permis de franchir l’étape de l’auto-hébergement.

Parlons maintenant outils ! Quels outils ou services avez-vous remplacé, et par quoi, sur quels critères ?

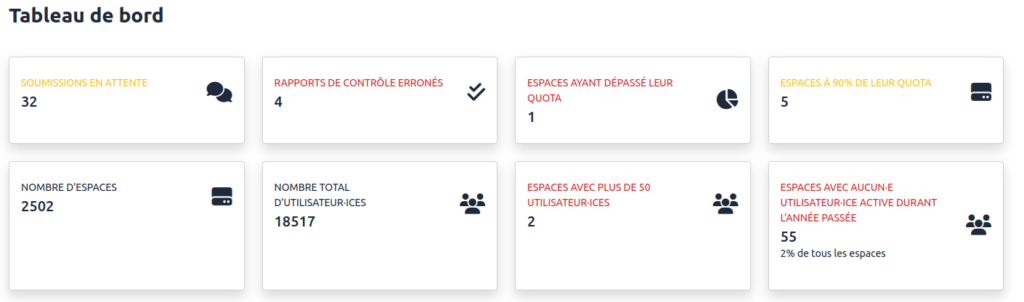

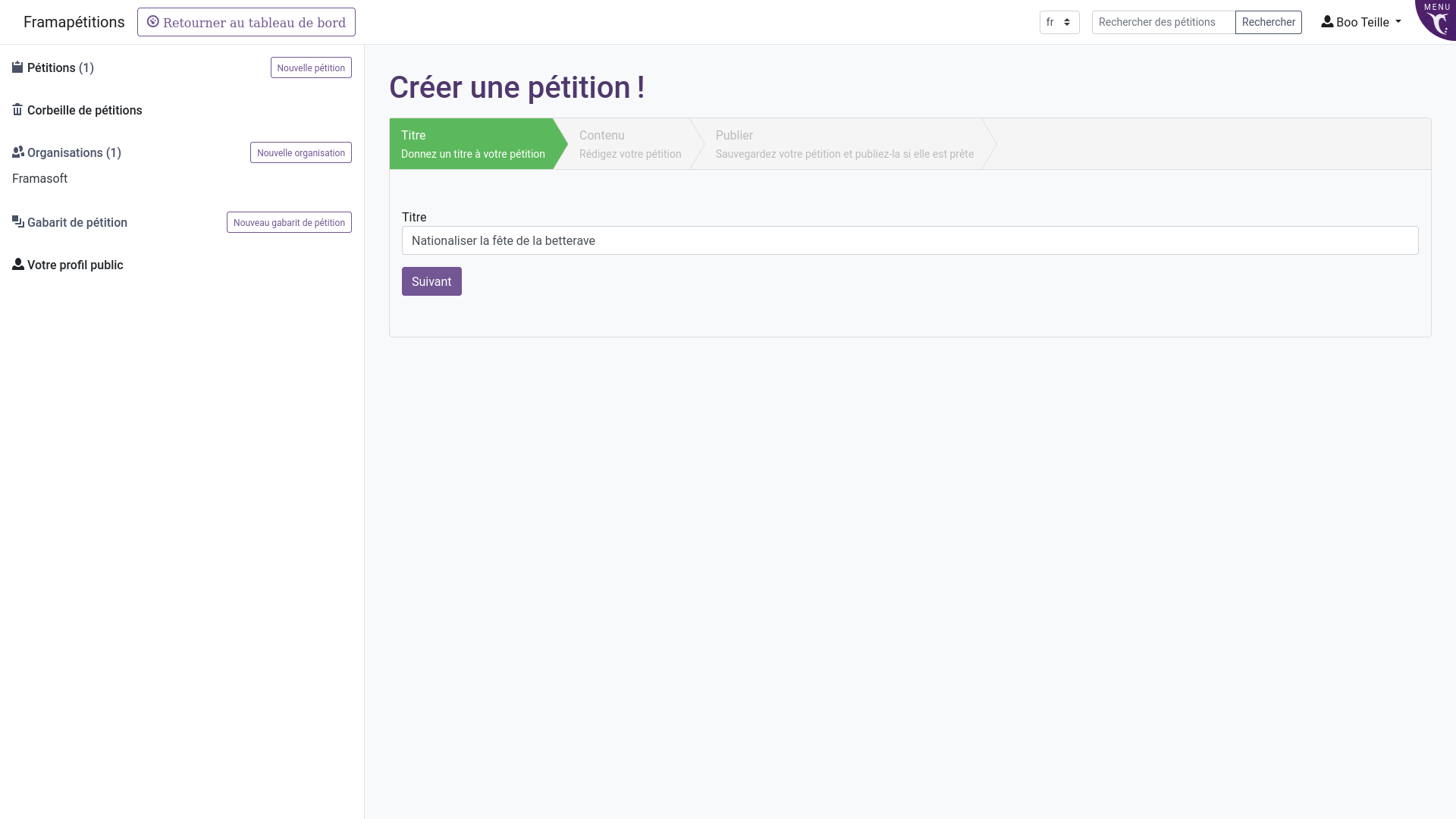

Voici un tableau récapitulatif que je vais vous détailler ci-dessous :

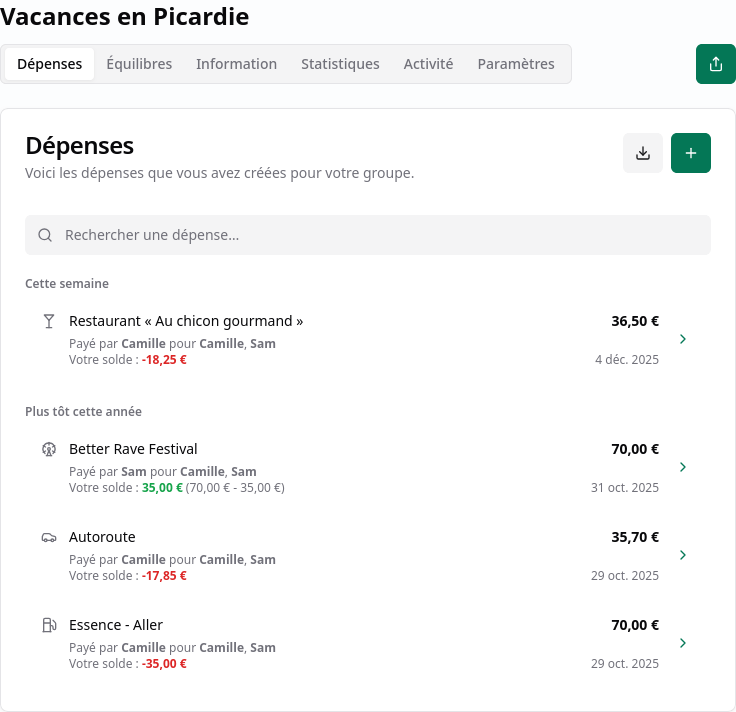

| Phase | Service | Outil d’avant | Remplacé par |

| NAS 2019 | Agenda partagé | Google Agenda | Nextcloud calendar |

| Partage de fichiers | Google Drive | Nextcloud files | |

| Serveur auto-hébergé 2022 | E-mails | Gmail | Yunohost |

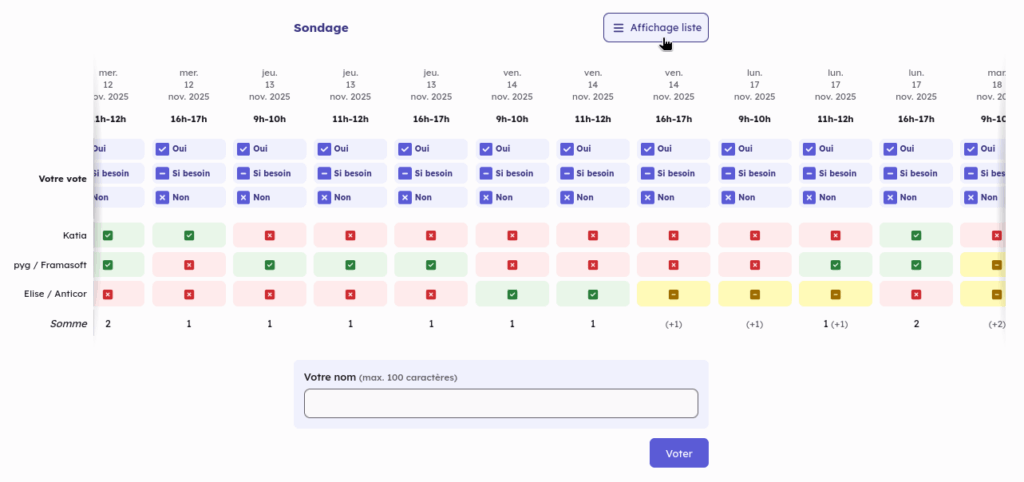

| Sondages | Doodle | Nextcloud poll | |

| Formulaires | Google forms | Nextcloud forms | |

| 2024 | Suivi des adhésions | Excel | Paheko |

| Comptabilité | Numbers | Paheko |

Les critères étaient simples :

- nous ne voulions pas donner d’argent à une entreprise comme Alphabet (maison mère de Google) ;

- nous avions besoin que ce soit ouvert, interopérable et que ça puisse durer dans le temps ;

- nous voulions de la collaboration.

C’est quand le compte Google à commencer à afficher « votre espace de stockage est faible » que les choses ont réellement commencé à bouger. On avait deux choix, payer pour agrandir le cloud ou trouver une autre solution. On venait tout juste d’acheter un NAS pour pouvoir sauvegarder notre base de donnée d’images, du stockage on en avait ! Ça a donc répondu à notre premier besoin, la ressource on l’avait, pas besoin de payer.

J’avais commencé à tester pour moi des systèmes avec Owncloud, avant même le fork qui a donné naissance à Nextcloud, et je trouvais ça « fou » ces outils, vraiment puissants. Nextcloud était apparu en 2016 avec des valeurs clairement posées, une communauté hyper active. J’ai donc proposé de l’installer sur notre NAS. Tout le monde est toujours partant pour les expériences ici. Ça répondait clairement à notre deuxième critère qu’on retrouve dans tous les logiciels libres, on pouvait y importer nos données existantes et on savait qu’on pourrait les récupérer à tout moment, pour les mettre ailleurs si notre expérience à domicile ne marchait pas.

Le choix de Nextcloud a été fait pour la simplicité de mise en œuvre. Une fois installé, nombres d’applications sont disponibles en un clic. On avait besoin du partage de fichier, l’agenda était là en même temps.

La suite découle un peu de ça, on avait Nextcloud, il était facile de rapatrier nos sondages et formulaires.

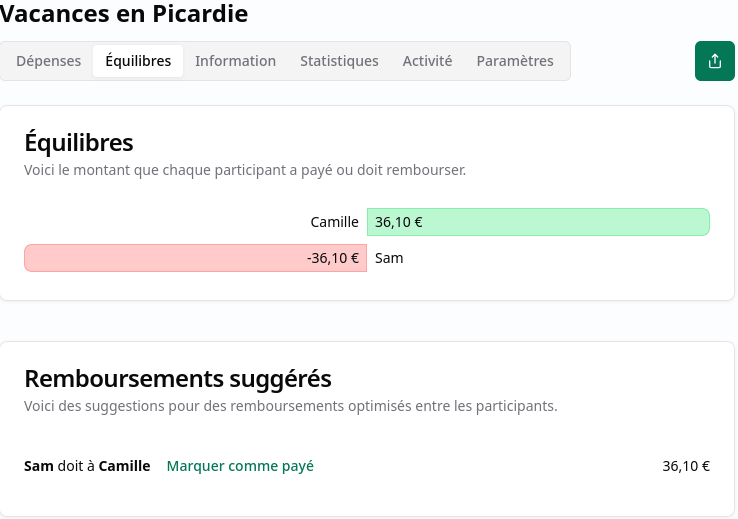

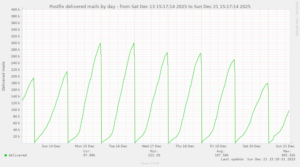

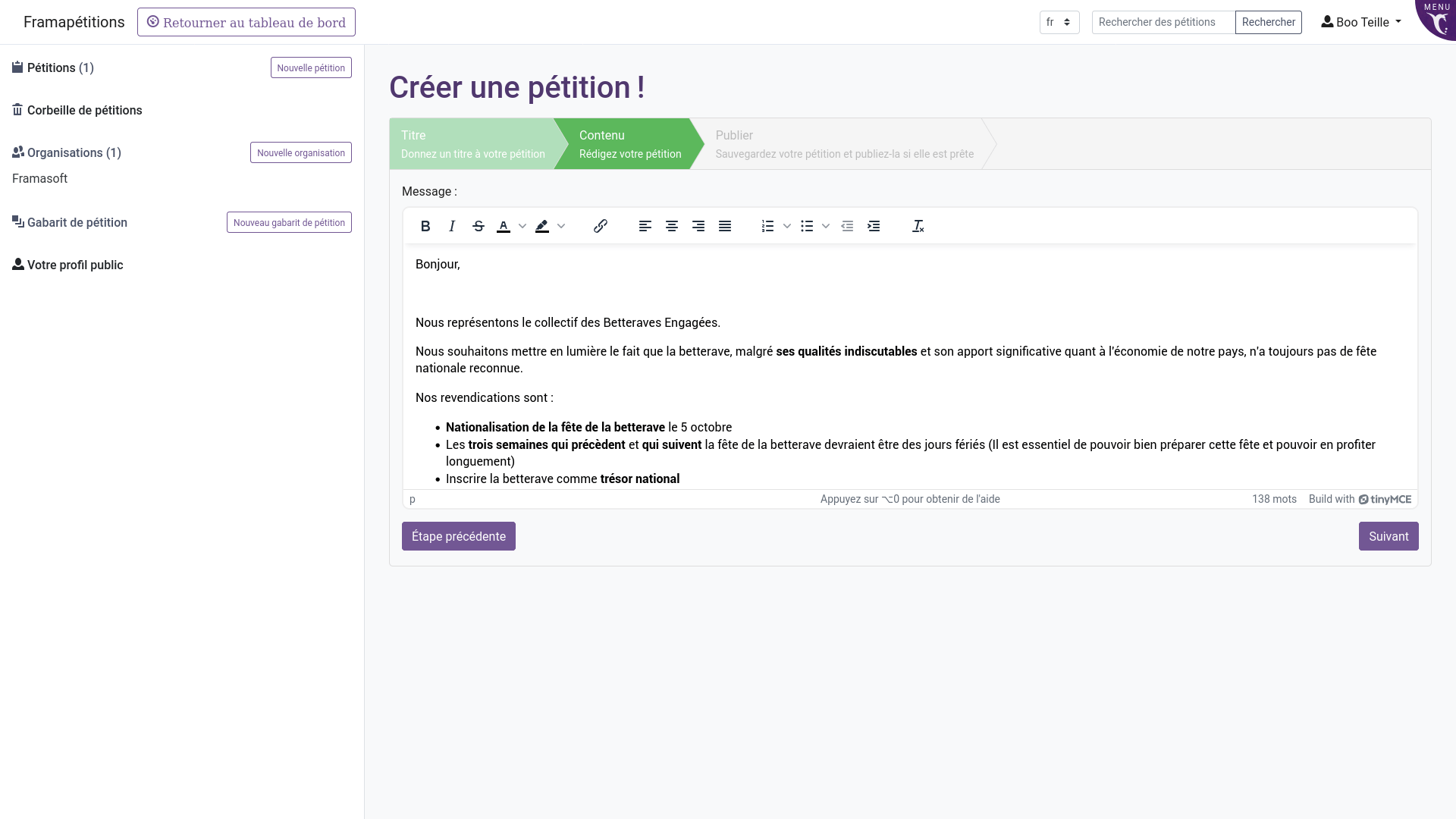

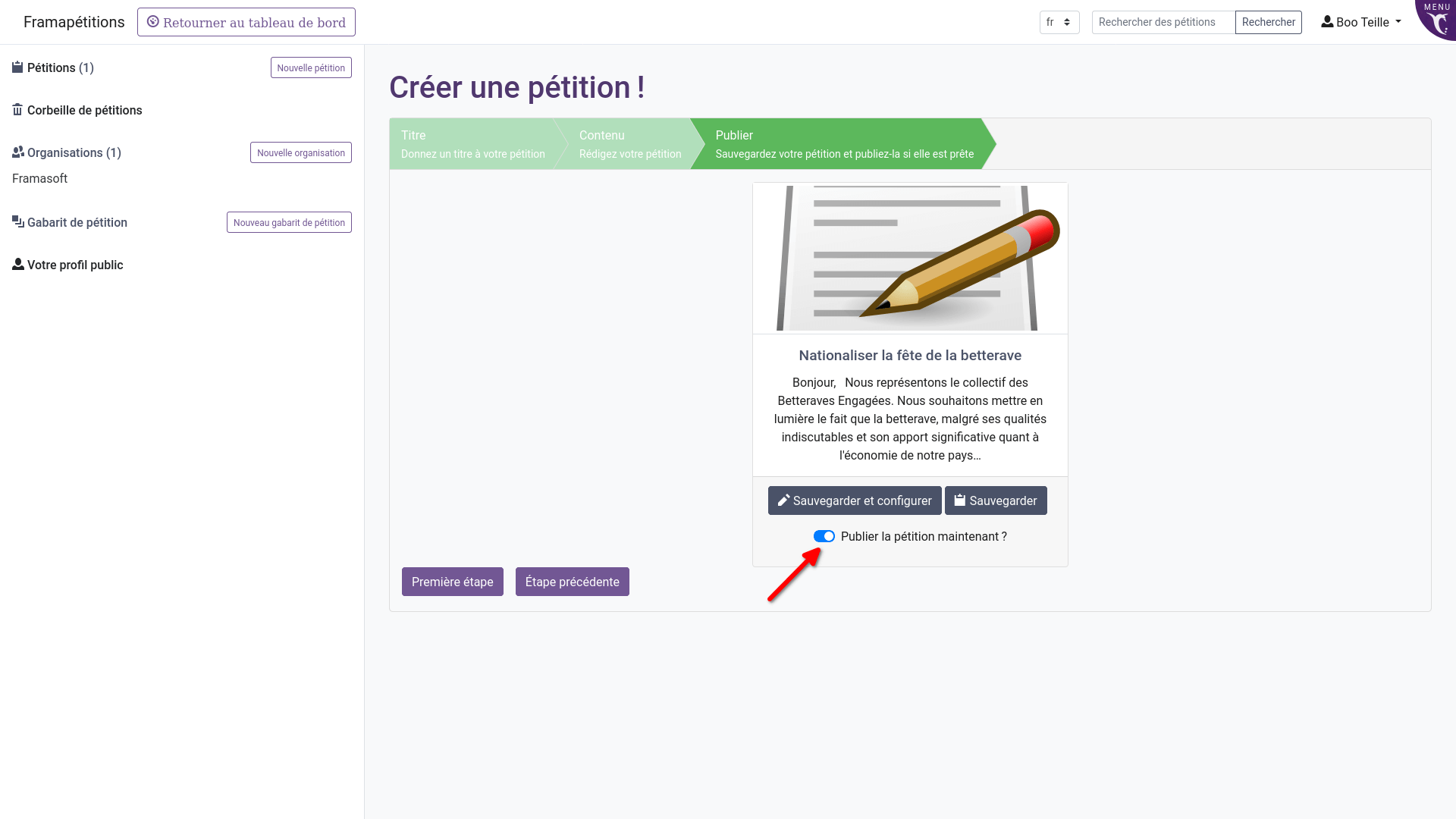

Rapatrier nos e-mails n’a pas été un choix facile, mais la volonté de le faire était vraiment très présente. Techniquement, j’avais mis le nez dans le système des e-mails mais c’est vraiment complexe et fragile. Quand Hadoly nous a parlé de Yunohost j’ai fait quelques mois de test et puis j’ai proposé à l’association une nouvelle expérience : depuis nous avons nos e-mails sur notre serveur.

Suite au passage en conseil collégial en 2023 et de changements qui en ont découlé, j’ai fait le constat suivant : Denis enregistrait les adhérents dans Paheko, Marie-Line faisait les dépôts en banque puis notait son travail dans un tableur, Gilles pointait les relevés de banque au fluo, Bénédicte triait les factures dans un classeur, Véro suivait un peu tout ça à la fois avec ses propres tableurs, Pierre faisait le suivi de trésorerie sur un autre tableur ; tout ceci coûtait beaucoup d’énergie à chacun et chacune et la mise en commun était laborieuse. J’avais mis à l’essai Paheko dans une association plus petite et je me suis vite rendu compte que ce pourrait être l’outil idéal pour que chacun puisse continuer à faire ce qu’il fait, en réduisant la lourde charge de la mise en commun. C’est donc le critère de la collaboration qui nous a permis cette dernière bascule.

Logo de Paheko, logiciel libre de gestion d’association.

Est-ce qu’il reste des outils auxquels vous n’avez pas encore pu trouver une alternative libre et pourquoi ?

Oui il en reste deux qui sont liés : les e-mails de notre lettre d’information (newsletter) et un moyen de communiquer sur nos évènements (Facebook).

La raison principale du non changement est le temps nécessaire à la transition et à l’apprentissage d’un nouvel outil. Nous avons regardé pour une alternative sur notre serveur (listmonk) mais il y a un gros travail à faire pour migrer depuis MailChimp et appréhender ce nouveau programme. Nous venons de toucher la limite des 2000 inscriptions d’un compte gratuit chez ce fournisseur, donc nous nous pencherons sur la question en 2025, une fois que nous aurons mené à bien la transition comptable vers Paheko.

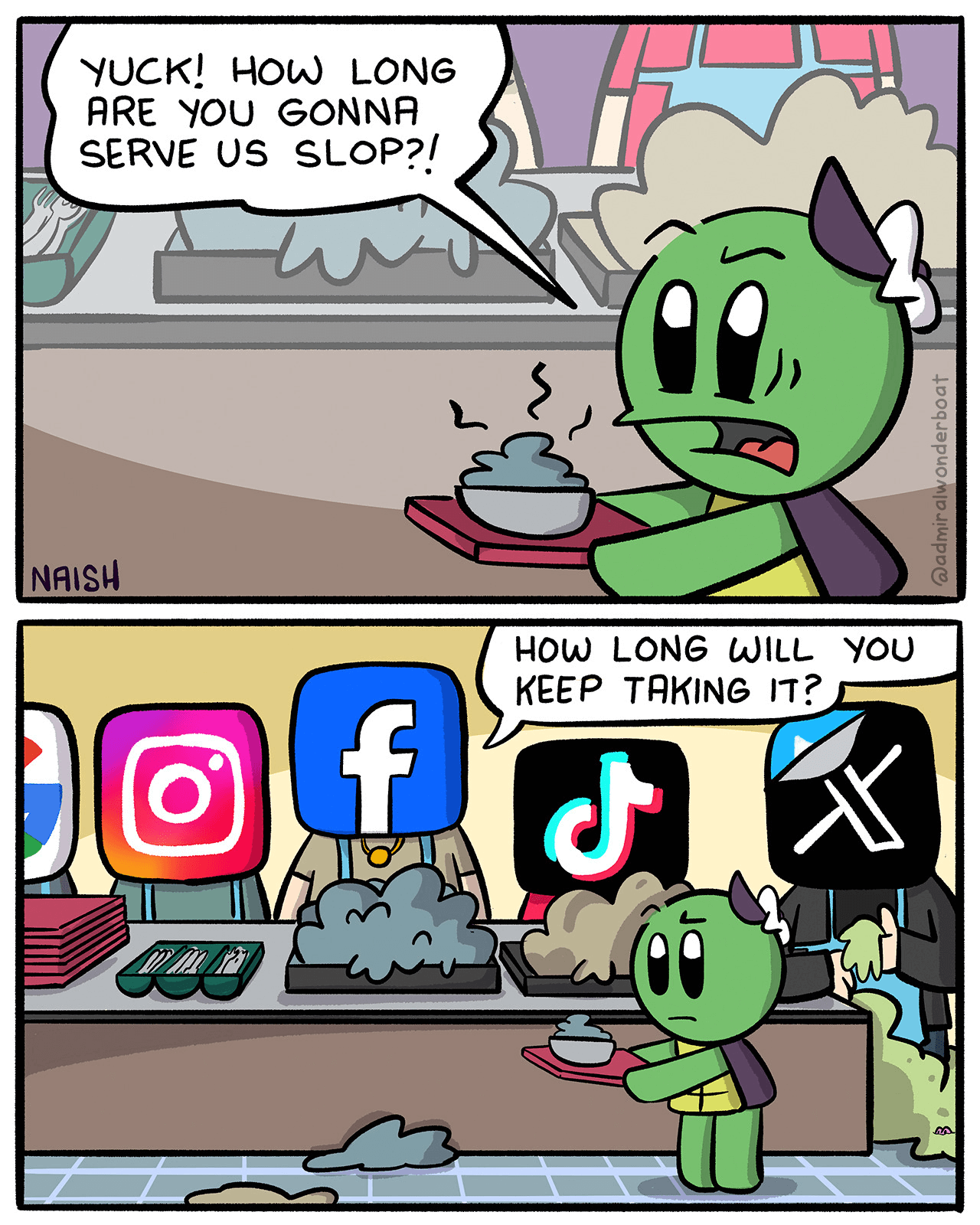

Nous avons fait le choix fort de quitter Facebook, après avoir constaté que nous ne faisions que fournir de la matière première à cette entreprise afin qu’elle puisse placer ses annonces, les fils d’actu ne ressemblent plus à rien de nos jours, l’information n’arrive même plus jusqu’au destinataire. Nous avons regardé du côté de Mastodon mais ce n’est pas vraiment d’un réseau social virtuel dont nous avons besoin mais d’un espace ou pouvoir partager nos évènements et convier les publics. On pose tout de même nos évènements autour du numérique sur l’Agenda Du Libre.

Questionner notre communication nous pose grandement la question de l’attention disponible de manière générale.

Il y a aussi des considérations techniques plus ou moins abstraites. Dans l’univers des e-mails la chasse est vraiment faite aux indépendants par les entreprises qui monopolisent le domaine, les e-mails peuvent ne pas arriver à destination sans raison valable, une exclusion arbitraire peut tomber à tout moment et empêcher tous les e-mails d’arriver à destination. Je crois que les e-mails ne sont plus utilisés à bon escient de nos jours, cela en fait un système sur-sollicités, sous pression. Malheureusement c’est encore un canal précieux pour la communication.

Jusqu’à il n’y a pas si longtemps on ne trouvait aucun C.H.A.T.O.N.S. dans la catégorie des campagnes d’e-mailing et ceux qui le proposent maintenant, n’assurent pas livraison des e-mails, seulement leur création.

Quels étaient vos moyens humains et financiers pour effectuer cette transition vers un numérique éthique ?

Alors concernant le matériel nous avions obtenu une subvention de la région Bourgogne-Franche-Comté pour l’achat du NAS et du PC qui accueillerait la base de données d’images.

Nous avons aussi été soutenus par la CAF, une de nos partenaires pour le faible investissement qu’a représenté l’achat du serveur d’occasion de la phase 2.

Pour le travail humain la première phase de mise en route s’est faite bénévolement, la place pour l’expérimentation est grande ici au Lion d’Or, cela correspond aussi à la période COVID ou j’avais pas mal de temps disponible. Pour la deuxième phase nous avons obtenu un financement du FNADT (Fonds National d’Aménagement et de Développement du Territoire) pour mon poste à 1/4 de temps (35h/mois) pour le « développement des usages du numérique » qui comprenait un temps dédié à la mise en place de ces nouveaux outils entre-autres.

Étienne lors d’un accompagnement individualisé. (source : site Les Accords du Lion d’Or)

Est-ce que votre dégafamisation a un impact direct sur votre public ou utilisez-vous des services libres uniquement en interne ? Si le public est en contact avec des solutions libres, comment y réagit-il ? Est-il informé du fait que ça soit libre ?

Comme je le disais plus haut, c’est vraiment ce qui a fait notre force pour cette transition, le fait que je sois présent sur plusieurs projets ici a permis un accompagnement régulier des salariés et des autres utilisateurices.

Je mène aussi un atelier mensuel que nous avons appelé Causeries, ou nous traversons de nombreux sujets autour du numérique et où j’ai régulièrement l’occasion de présenter nos outils et détailler leur fonctionnement.

La causerie informalion (Source : site Les Accords du lion d’Or)

Quels conseils donneriez-vous à des structures comparables à la vôtre qui voudraient se dégafamiser aussi ?

Cette dégafamisation a principalement un impact interne à l’association. Nous avons un peu communiqué sur le sujet mais notre public est peu confronté à ce changement, quelques dossiers partagés, quelques sondages, surtout à l’adresse des adhérents. Les retours sont neutres.

C’est quelque-chose que l’on pourrait voir changer, nous n’avons eu absolument aucuns soucis jusqu’à présent et nous débattons de la possibilité d’ouvrir des accès à d’autres structures proches ou aux adhérents. Faire comprendre la nature expérimentale du projet et ramener sur le devant le fait que les services proposés sont à échelle modeste et donc faillibles, est une question à ne pas prendre à la légère mais correspond intégralement aux valeurs de l’association, « parfaitement imparfait » disons-nous souvent ici. Ramener cette faillibilité c’est remettre en question nos usages, la dépendance que nous avons à nos outils et trouver des solutions de repli, retrouver une échelle de temps plus souple sont des valeurs que nous portons pour l’avenir.

Un mot de la fin, pour donner envie de migrer vers les outils libres ?

En ce tournant vers le monde du libre et en acceptant les remises en questions liées, on gagne en liberté, de moyens, de mouvements et en humanité.

Et n’hésitez pas à venir faire un tour au Lion d’Or pour en discuter !

05.01.2026 à 07:42

Khrys’presso du lundi 5 janvier 2026

Khrys

Texte intégral (7413 mots)

Comme chaque lundi, un coup d’œil dans le rétroviseur pour découvrir les informations que vous avez peut-être ratées la semaine dernière.

Tous les liens listés ci-dessous sont a priori accessibles librement. Si ce n’est pas le cas, pensez à activer votre bloqueur de javascript favori ou à passer en “mode lecture” (Firefox) ;-)

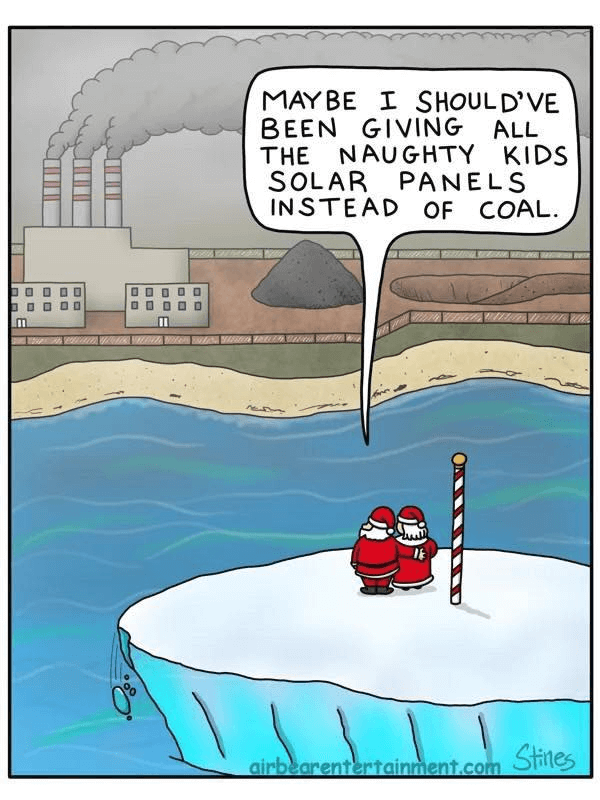

Brave New World

- The Earth Is Nearing an Environmental Tipping Point (wired.com)

Today’s global coral bleaching events are the worst kind of climate warning.

- Les milliardaires, un petit monde toujours plus riche et inégalitaire (alternatives-economiques.fr)

La fortune globale des milliardaires a encore fortement augmenté en 2024, mais elle se concentre au sein des pays les plus riches, et chez une vingtaine d’individus possédant plus de 50 milliards de dollars chacun.

- 2025 : The Year in Review (crimethinc.com)

- From Street Protests to Policy Shifts : India’s Environmental Year in Review (indiaspend.com)

From protests against air pollution in the national capital region to protests to save the trees in Nashik’s Tapovan, and from policies to curb greenhouse gas emissions to policies that further forest diversion, this year saw it all

- Que se passe-t-il en Iran, secoué par une « révolte » depuis quatre jours (huffingtonpost.fr)

Des manifestations spontanées contre l’hyperinflation et le marasme économique ont débuté dimanche avant de gagner en ampleur.

- Donald Trump et l’Iran s’échangent des menaces sur fond de manifestations dans le pays (huffingtonpost.fr)

En réaction aux mobilisations contre la vie chère en Iran, qui ont déjà fait six morts, Donald Trump s’est dit prêt à intervenir militairement pour secourir la population.

- La Bulgarie s’apprête à adopter l’euro alors que la moitié de ses habitant·es y est opposée (huffingtonpost.fr)

À minuit, le petit État des Balkans de 6,4 millions d’habitants dira adieu à 2025 mais aussi à sa monnaie, le lev, en circulation depuis la fin du XIXe siècle.

- Berlin bascule dans une logique d’État de guerre (lvsl.fr)

Explosion des budgets militaires au détriment de tous les services publics, retour du service militaire, discours catastrophistes sur l’imminence d’une attaque russe, propagande dans les écoles… Depuis 2022, l’Allemagne, comme presque tous les autres pays européens, s’est engagée dans un énorme effort d’armement, qui renforce le risque d’un conflit de grande ampleur.

- Polémique aux Pays-Bas après le retrait de panneaux en mémoire de soldats afro-américains dans un cimetière militaire (rtbf.be)

Des panneaux rappelant le rôle des soldats afro-américains dans les rangs de l’armée américaine pendant la Seconde Guerre mondiale ont été retirés du mémorial d’un cimetière américain aux Pays-Bas. Des documents obtenus par plusieurs médias prouvent que cette disparition faisait suite à la politique anti-inclusion mise en place par l’administration Trump.

- Les cyberattaques contre les organisations belges explosent (lesoir.be)

- L’Europe « a perdu l’accès à internet » : le terrible aveu d’un responsable belge (lanouvelletribune.info)

- Incendie à Crans-Montana : comment fonctionne le soutien de l’UE et pourquoi la Suisse y a accès (huffingtonpost.fr)

La Suisse ne compte qu’une vingtaine de lits pour soigner les grands brûlés. Elle a donc fait appel à l’UE pour une prise en charge efficace et coordonnée des nombreux blessés.

- Condamnation de Marine Le Pen : des magistrats français dans le viseur de l’administration Trump (lexpress.fr)

D’après “Der Spiegel”, l’administration Trump aurait envisagé des sanctions contre les juges ayant condamné la figure du Rassemblement national en mars dernier. Des mesures de ce type sont aussi évoquées contre des fonctionnaires allemands.

- Trump attaque des Européen·nes luttant contre la désinformation climatique (reporterre.net)

- NJ’s answer to flooding : it has bought out and demolished 1,200 properties (arstechnica.com)

Sea level rose about 1.5 feet along the New Jersey coast in the last 100 years—more than twice the global rate—and a new study by the New Jersey Climate Change Resource Center at Rutgers University predicts a likely increase of between 2.2 and 3.8 feet by 2100, if the current level of global carbon emissions continues.

- Zohran Mamdani investi à New York par Bernie Sanders, première image forte des États-Unis en 2026 (huffingtonpost.fr)

« Je gouvernerai comme un socialiste démocrate », a promis Zohran Mamdani. Après une première prestation de serment devant la procureure démocrate et ennemie de Trump Letitia James, c’est face au champion de la gauche américaine Bernie Sanders que le nouveau maire de New York a lancé son mandat ce jeudi 1er janvier.

- Big Tech basically took Trump’s unpredictable trade war lying down (arstechnica.com)

From Apple gifting a gold statue to the US taking a stake in Intel.

- Judge To Texas : You Can’t Age-Gate The Entire Internet Without Evidence (techdirt.com)

- Trump Spent 2025 Making Trans Lives Unlivable. It’s Time for Democrats to Defend Them. (theintercept.com)

Elected Democrats haven’t done nearly enough to oppose attacks on gender-affirming care. They risk being on the wrong side of history.

- Curtis Yarvin : le plan pour faire de l’Amérique un État-parti fasciste (legrandcontinent.eu)

Le théoricien des Lumières sombres écouté par J. D. Vance, appelle pour la première fois explicitement Trump à faire sa mue fasciste.

- Victoire de Kast au Chili : la « voie démocratique » vers le pinochetisme (contretemps.eu)

Avec la victoire présidentielle de José Antonio Kast au Chili, le pinochetisme revient au pouvoir par la voie électorale, articulant restauration néolibérale, autoritarisme moral et anticommunisme comme réponse à la crise chilienne.

- Researchers make “neuromorphic” artificial skin for robots (arstechnica.com)

Spécial IA

- OpenAI veut absolument nous faire croire que GPT-5 a le niveau d’un chercheur (next.ink)

- ChatGPT accusé d’avoir encouragé le meurtre perpétré par un utilisateur puis son suicide (next.ink)

- xAI silent after Grok sexualized images of kids ; dril mocks Grok’s “apology” (arstechnica.com)

For days, xAI has remained silent after its chatbot Grok admitted to generating sexualized AI images of minors, which could be categorized as violative child sexual abuse materials (CSAM) in the US.According to Grok’s “apology”—which was generated by a user’s request, not posted by xAI—the chatbot’s outputs may have been illegal

- WordPress wants to force AI onto 43 % of all websites in the world (pivot-to-ai.com)

- YouTube est envahi par les vidéos générées par IA (kulturegeek.fr)

- L’IA a encore enrichi les milliardaires de la tech, et en fait émerger 50 nouveaux (next.ink)

- La Chine veut empêcher les chatbots d’IA de manipuler leurs utilisateurices (next.ink)

La Cyberspace Administration of China (CAC) vient de publier un appel à commentaires au sujet de « mesures provisoires pour l’administration des services interactifs anthropomorphes d’intelligence artificielle » […] Ces règles « constitueraient la première tentative mondiale de réglementation de l’IA dotée de caractéristiques humaines ou anthropomorphiques »

- From prophet to product : How AI came back down to earth in 2025 (arstechnica.com)

In a year where lofty promises collided with inconvenient research, would-be oracles became software tools.

- Exclusive : Groq investor sounds alarm on data centers (axios.com)

Venture capitalist Alex Davis is “deeply concerned” that too many data centers are being built without guaranteed tenants, according to a letter being sent this morning to his investors.

- ‘If this is a joke, the punchline is on humanity’ : Replacement AI blurs line between parody and tech reality (kron4.com)

Anyone driving across the Bay Bridge into San Francisco in the past year has likely noticed the surge of AI-themed billboards lining the highway. […] One reads : “AI does your daughter’s homework. Reads her bedtime stories. Romances her. Deepfakes her. Don’t worry. It’s totally legal.” Visitors to the Replacement AI website are greeted with a banner declaring, “Humans are no longer necessary.”

- An artificial intelligence that writes police reports had some explaining to do earlier this month after it claimed a Heber City officer had shape-shifted into a frog. (fox13now.com)

“The body cam software and the AI report writing software picked up on the movie that was playing in the background, which happened to be ’The Princess and the Frog” […] “That’s when we learned the importance of correcting these AI-generated reports.”

- “April Fools in December” : Hundreds of people waited at the Brooklyn Bridge for fireworks that never came, all because of AI slop (dailydot.com) In the days leading up to New Year’s Eve, AI-generated posts flooded social media, showing fireworks over the Brooklyn Bridge. These posts claimed the fireworks would be part of the city’s New Year’s Eve festivities.

- The Problem With Letting AI Do the Grunt Work (theatlantic.com)

Artificial intelligence is destroying the career ladder for aspiring artists.

- ‘It won’t be so much a ghost town as a zombie apocalypse’ : How AI might forever change how we use the internet (livescience.com)

- « Allez vous faire foutre » : un agent IA envoie un spam et déclenche une polémique (next.ink)

Le 25 décembre 2025, Rob Pike, co-créateur du langage Go et de l’encodage UTF-8, a reçu un e-mail non sollicité généré par une IA. Le message, signé « Claude Opus 4.5 », le remerciait pour ses contributions à l’informatique. Sa réaction a été explosive, cristallisant plusieurs critiques récurrentes autour de l’IA générative. […] « Allez vous faire foutre. Vous pillez la planète, vous dépensez des milliards en équipements toxiques et non recyclables, vous détruisez la société, et vous trouvez le temps de faire en sorte que vos machines immondes me remercient de militer pour des logiciels plus simples. Allez tous vous faire foutre. Je ne me souviens pas avoir été aussi en colère depuis longtemps »

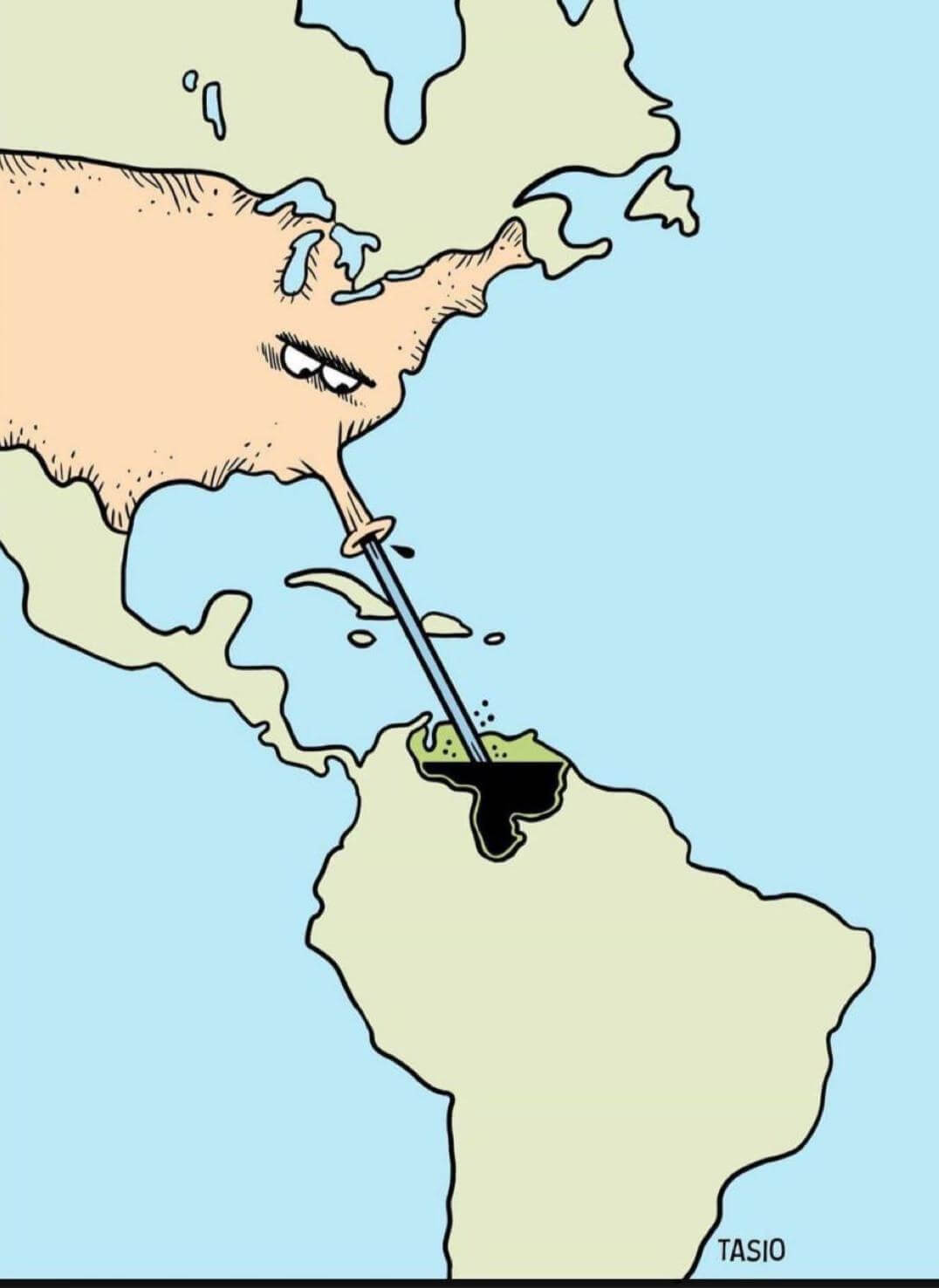

Spécial Venezuela

- Trump confirme que les États-Unis ont bombardé une cible au Venezuela (legrandcontinent.eu)

Selon Donald Trump, les États-Unis auraient détruit au Venezuela une zone de mise à quai pour des navires prétendument impliqués dans du trafic de drogue.

- Venezuela : fortes explosions et survols d’avions entendus à Caracas (france24.com)

Des explosions ainsi que des survols d’avions ont été entendus dans la nuit de vendredi à samedi à Caracas, capitale du Venezuela. Des déflagrations qui surviennent alors que le président américain, Donald Trump, a évoqué la possibilité de frappes terrestres contre le Venezuela et a directement menacé le président Nicolas Maduro.

- Nicolás Maduro incarcéré à New York, Delcy Rodriguez chargée d’assurer l’intérim au Venezuela (huffingtonpost.fr)

Des images de l’AFP ont montré le dirigeant vénézuélien sortant d’un avion sous escorte dans un aéroport du nord de New York, puis son arrivée à Manhattan par hélicoptère.

- Les États-Unis interviennent au Venezuela et capturent Nicolas Maduro et son épouse (fr.euronews.com)

“Nicolas Maduro et son épouse, Cilia Flores, ont été inculpés dans le district sud de New York. Nicolas Maduro a été accusé de complot en vue de commettre des actes de narcoterrorisme, de complot en vue d’importer de la cocaïne, de possession d’armes automatiques et d’engins destructeurs, et de complot en vue de posséder des armes automatiques et des engins destructeurs contre les États-Unis” écrit la procureure générale des États-Unis.

- Après la capture de Maduro Trump annonce la prise du contrôle du Venezuela par les États-Unis : texte intégral de la conférence Mar-a-Lago (legrandcontinent.eu)

- Someone made a huge profit predicting Maduro’s capture. Here’s what happened (axios.com)

- Après Maduro, les États-Unis menacent ouvertement Cuba et le président colombien (huffingtonpost.fr)

Donald Trump a notamment déclaré que son homologue colombien, Gustavo Petro, devrait « faire gaffe à ses fesses » désormais.

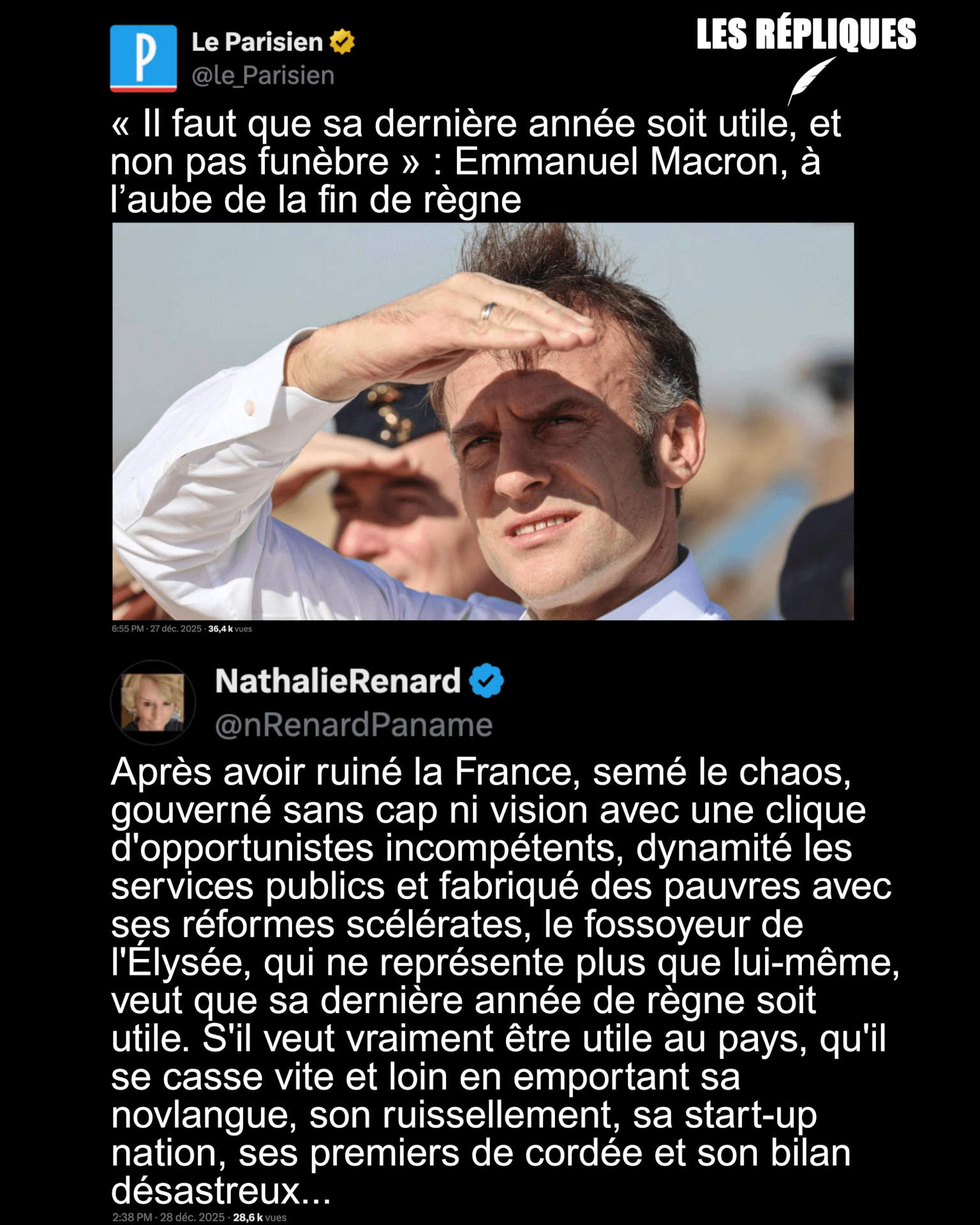

- Venezuela : La réaction de Macron à la capture de Maduro saluée par Trump, étrillée en France (huffingtonpost.fr) – voir aussi Venezuela : Emmanuel Macron salue la fin de la « dictature Maduro » et appelle à une « transition démocratique » (leparisien.fr)

De son côté, le leader de la France Insoumise Jean-Luc Mélenchon, lors d’un rassemblement de soutien au peuple vénézuélien à Paris, a dénoncé le « pur impérialisme » américain et attaqué le silence d’Emmanuel Macron.”La prise de position de Macron n’est pas la voix de la France. Il nous fait honte. Il abandonne le droit international.”

Et La réaction de Macron continue de susciter de vives critiques (lorientlejour.com)

- Les pays ayant condamné l’opération militaire américaine au Venezuela représentent un quart de la population et du PIB mondial (legrandcontinent.eu)

- Zelensky n’a pas pu réfréner ce sarcasme après la capture de Maduro par les États-Unis (huffingtonpost.fr)

« S’il est possible de régler le problème des dictateurs de cette manière, aussi facilement, alors les États-Unis d’Amérique savent ce qu’il leur reste à faire », a-t-il affirmé, un sourire en coin.

- Pourquoi une intervention des États-Unis au Venezuela ? (humanite.fr)

- Attaque du Venezuela : contrer la propagande “démocratique” (frustrationmagazine.fr)

Spécial Palestine et Israël

- Reconnaissance du Somaliland par Israël : comment interpréter cette décision inédite ? (slate.fr)

Depuis le 26 décembre, Israël reconnaît officiellement l’indépendance du Somaliland, territoire de la Corne de l’Afrique qui a fait sécession de la Somalie et république autoproclamée depuis 1991.

- Netanyahu décerne le prix de la paix israélien à Trump (huffingtonpost.fr)

En annonçant remettre à Donald Trump ce prix de la paix, la plus haute distinction civile israélienne, Benjamin Netanyahu rompt avec une tradition vieille de plusieurs décennies consistant à le décerner à un citoyen israélien.

- Gaza : Israël va interdire l’accès à 37 ONG, dont MSF et Handicap International, si elles ne donnent pas une « liste de leurs employés palestiniens » (lemonde.fr)

- Entre politique et poétique. – À propos d’un colloque international sur Gaza au Collège de France (blogs.mediapart.fr)

Spécial femmes dans le monde

- Des féministes chinoises réinventent la langue pour s’attaquer au patriarcat (ici.radio-canada.ca)

En Chine, des féministes remodèlent le mandarin écrit en modifiant d’anciens caractères et en inventant de nouveaux termes afin de contester le système patriarcal qui a longtemps dévalorisé les femmes.

- Ces skateuses Éthiopiennes défient le patriarcat et les traditions (lareleveetlapeste.fr)

Dans les rues d’Addis-Abeba, capitale de l’Éthiopie, retentissent les roulettes des skateboards d’un groupe de femmes qui défient les normes sociales et réinventent leur liberté. Dans une société conservatrice, où les sports et l’espace public sont principalement réservés aux hommes, ce mouvement féminin fait parler de lui.

- Soudanaise en exil, elle dénonce les crimes contre les femmes de son pays et l’indifférence du monde (basta.media)

Victimes d’une « guerre internationale pour les ressources », les femmes du Soudan font face aux violences quotidiennes. Alaa Busati, avocate et militante soudanaise en exil, recueille témoignages et preuves pour porter leurs voix devant la justice.

- En RDC, l’arrêt des subventions américaines pénalise les femmes victimes de viols, privées de soins d’urgence (slate.fr)

La suppression de l’aide humanitaire de l’Agence des États-Unis pour le développement international (Usaid) a stoppé la distribution de soins indispensables pour prévenir les grossesses et les infections sexuellement transmissibles après une agression sexuelle.

- Men embodying women in VR report strong emotional reactions to verbal harassment (phys.org)

The group that experienced verbal harassment reported levels of fear similar to those of participants who did not undergo the catcalling scenario. According to the researchers, this may indicate that simply experiencing the initial situation—a young woman alone, at night, in a subway station—is enough to generate a sense of fear, even among men.

- Woman felt ‘dehumanised’ after Musk’s Grok AI used to digitally remove her clothes (bbc.co.uk)

Samantha Smith shared a post on X about her image being altered, which was met with comments from those who had experienced the same – before others asked Grok to generate more of her.”Women are not consenting to this”

Voir aussi Grok déshabille les femmes sans leur consentement sur X, un acte puni par la loi (huffingtonpost.fr)

« Cette année commence bien en matière de culture du viol… L’IA n’est juste qu’un outil de plus pour les agresseurs… donnant peut être à certains l’illusion facile de ne pas en être. Ne la leur laissez pas. Affichez ces porcs. Continuez à faire ce que vous voulez de vos corps », s’est insurgée la députée LFI Sarah Legrain

Et Sexisme : militantes et responsables politiques alertent sur l’usage de l’IA Grok pour déshabiller virtuellement des femmes sans leur consentement (humanite.fr)

- Everything We Know About Rape Is Wrong (theatlantic.com)

Girls Play Dead is a transformative analysis of what sexual assault does to women.

RIP

- In memoriam Mohammed Harbi (1933-2026) (blogs.mediapart.fr)

Le politiste Nedjib Sidi Moussa retrace la trajectoire militante et savante de Mohammed Harbi, mort le 1er janvier 2026 à Paris. Engagé très tôt pour l’indépendance, promoteur de l’autogestion après 1962, emprisonné sous Boumédiène et exilé en France, historien critique du mouvement national, il fut « un intellectuel postcolonial total et un socialiste internationaliste impénitent ».

- Science-fiction : Pierre Bordage nous a quitté (actusf.com)

- Mort de Cecilia Giménez, autrice de cette restauration d’un tableau du Christ tristement inoubliable (huffingtonpost.fr)

Entre consternation des protecteurs du patrimoine et hilarité des internautes, le travail de Cecilia Giménez n’avait clairement pas fait l’unanimité.

Spécial France

- La DGSI exhibe les erreurs de 3 entreprises françaises piégées par des outils d’intelligence artificielle (clubic.com)

Les dérives de l’intelligence artificielle en entreprise inquiètent la DGSI, la Direction générale de la Sécurité intérieure, qui alerte sur les risques d’ingérence, liés aux documents confidentiels exposés ou encore aux deepfakes.

- Sophia Chikirou sera jugée pour escroquerie juste après les municipales (huffingtonpost.fr)

L’avocat de la candidate LFI dénonce une volonté de la « salir » avant les élections municipales à Paris.

- En France, l’écart entre l’espérance de vie des plus riches et celle des plus pauvres se creuse (europe-solidaire.org)

Pour 40 % de la population française, l’écart d’espérance de vie avec les 5 % les plus riches s’est creusé au cours des douze dernières années. C’est le produit de politiques publiques qui refusent de prendre en compte le lien entre inégalités de revenus et inégalités d’espérance de vie.

- “Je ne pouvais pas donner d’argent car je n’avais pas de monnaie” : dans dix villes de France, on peut désormais faire des virements aux sans-abri (franceinfo.fr)

- Le réseau de bus TADAO est désormais gratuit pour les habitant·es du bassin minier du Pas-de-Calais (francebleu.fr)

- Liquidation de Brandt : en cas de panne, le SAV va-t-il fonctionner ? (60millions-mag.com)

Si votre cuisine est équipée d’électroménager Brandt, de Dietrich, Sauter ou Vedette ou si vous envisagez un achat prochainement, gare à la panne.

- A69 : la justice valide la poursuite du chantier (reporterre.net)

Le tribunal administratif d’appel de Toulouse a scellé l’avenir de l’autoroute A69, le 30 décembre, en autorisant la poursuite du chantier. Les militant·es ont annoncé engager un pourvoi en cassation.

Voir aussi L’A69 ressuscitée par la justice : explication d’un rétropédalage « lapidaire » (reporterre.net)

- Un tireur sportif agressé chez lui à Villeurbanne, neuf armes et 1 300 cartouches dérobées (franceinfo.fr)

Ces faits surviennent après le piratage des données personnelles de centaines de milliers d’adhérents de la Fédération française de tir, et qui ont été utilisées notamment “pour commettre des vols par effraction”.

Spécial femmes en France

- Briser le silence avec un micro (cqfd-journal.org)

Vingt ans après avoir subi un inceste de la part de son beau-père, Léna Rivière cherche « la voix des autres », ses proches et les autres victimes du même agresseur. Le processus aboutit au magnifique documentaire radiophonique « Queen of Bongo », réflexion sur la justice, le pardon et, en creux, le pouvoir du micro.

- Le suspect de l’agression au couteau de trois femmes dans le métro parisien avait en fait la nationalité française, Nuñez admet un « dysfonctionnement » (huffingtonpost.fr)

Dans un communiqué vendredi soir, le ministère de l’Intérieur avait indiqué que le suspect était « de nationalité malienne » et « en situation irrégulière sur le territoire national ».

Spécial médias et pouvoir

- Bernard Arnault et LVMH rachètent « Challenges », « Sciences et Avenir » et « La Recherche » (huffingtonpost.fr)

L’homme d’affaires Claude Perdriel, qui en était l’actionnaire majoritaire jusqu’alors, avait convenu de cette cession, pour un euro symbolique.

- CNews mise en demeure par l’Arcom pour deux séquences incitant « à la discrimination » (huffingtonpost.fr)

Si l’Arcom dit ne pas avoir relevé de problème de pluralisme sur CNews après de récentes enquêtes sur le sujet, elle épingle à nouveau la chaîne pour son traitement de l’immigration et l’islam.

- Le loup mal aimé d’Intermarché, fact-checking (bloomassociation.org)

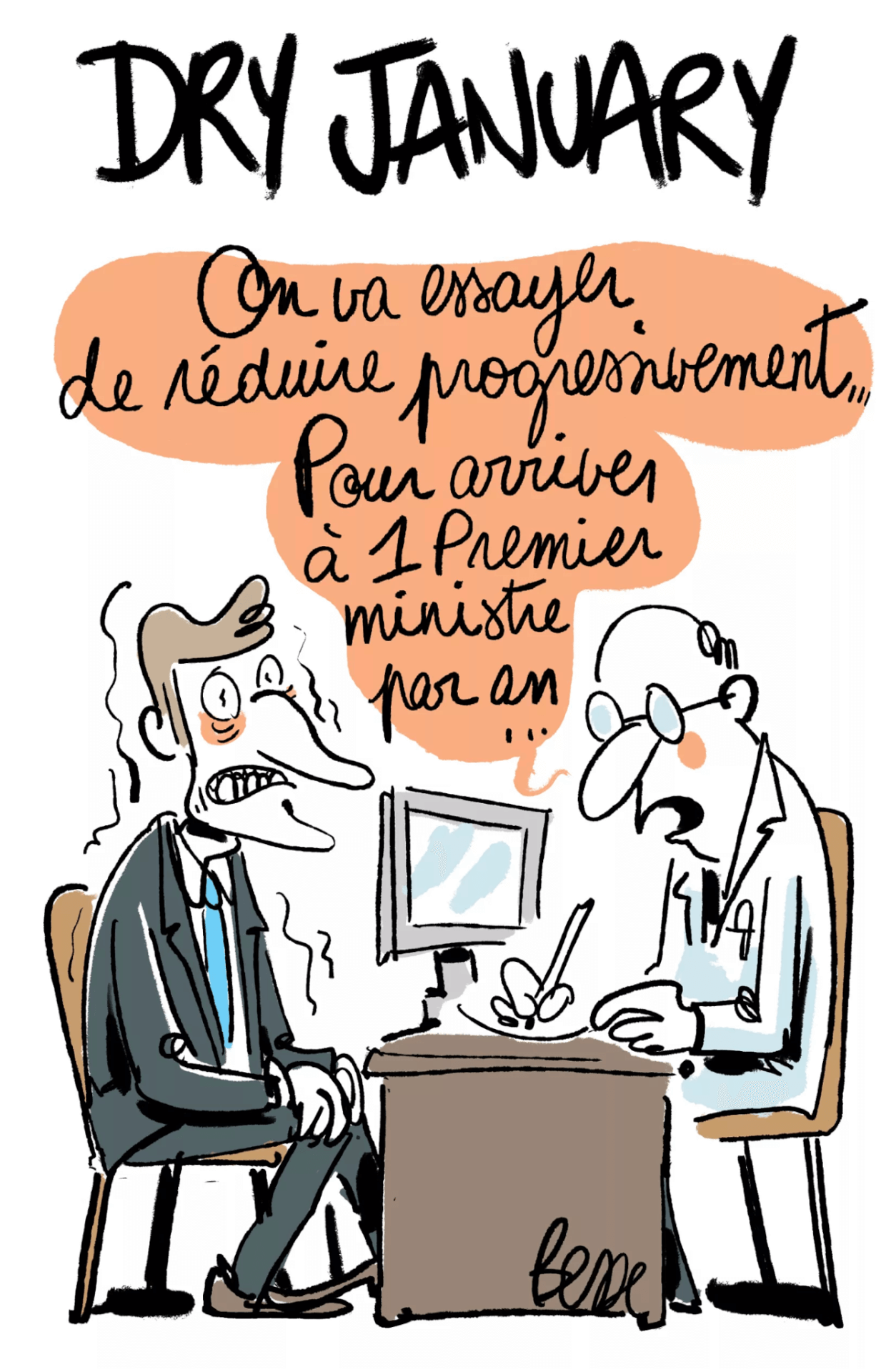

- Notre Dry January : essayez un mois sans les médias des milliardaires (reporterre.net)

La liste des médias indépendants offre un large éventail de choix pour s’informer via un travail professionnel de qualité. Le portail des médias indépendants constitue, par exemple, une bonne ressource où piocher.

Spécial emmerdeurs irresponsables gérant comme des pieds (et à la néolibérale)

- Emmanuel Macron raillé après ses vœux aux Français pour 2026, du RN à LFI (huffingtonpost.fr)

- La France commande deux avions de surveillance GlobalEye au fabricant suédois Saab pour 1,1 milliard d’euros (lemonde.fr)

- Une liaison TGV Lyon Bordeaux en 2027 : la nouvelle aberration signée SNCF (aurail.eu)

- Arrêts maladie : « Le discours de culpabilisation ambiant pousse les salarié·es à ne pas écouter les alertes de leur corps » (humanite.fr)

- Prévue pour 2026, l’interdiction des gobelets jetables composés de plastique reportée à 2030 (humanite.fr)

Selon un arrêté publié mardi 30 décembre, le gouvernement a décidé de remettre à 2030 l’interdiction des gobelets jetables en partie composés de plastique. Les autorités justifient ce report par un manque d’alternative dans l’immédiat. Un nouveau bilan d’étape sera réalisé en 2028.

- Pesticides, océans… 5 mensonges du gouvernement sur l’écologie en 2025 (reporterre.net)

Spécial recul des droits et libertés, violences policières, montée de l’extrême-droite…

- Ces patrons qui murmurent aux oreilles du Rassemblement national (humanite.fr)

Depuis trois ans, les rendez-vous entre chefs d’entreprise et représentants du Rassemblement national, jadis tabous, se multiplient. Des rencontres qui en disent autant sur le renoncement des milieux d’affaires que sur l’évolution du programme économique de Marine Le Pen et Jordan Bardella.

- Violences de la Coordination Rurale contre les associations : ça continue et c’est insupportable (fne.asso.fr)

Dans la nuit du 17 au 18 décembre 2025, les locaux de FNE Nouvelle Aquitaine, Poitou Charente Nature et Vienne Nature ont été vandalisés par la Coordination Rurale. Ces actes interviennent une semaine après la dégradation des locaux de Nature Environnement 17 et de la LPO par les représentants du même syndicat. Et quelques semaines à peine après l’appel à « faire la peau » aux écologistes lancé par le nouveau président de la Coordination Rurale.

- Nuñez explique sa décision de ne pas saisir l’IGPN après les images d’un agriculteur mis en joue par la police (huffingtonpost.fr)

À Auch, dans le Gers, des policiers avaient sorti leur arme pour stopper une manifestation d’agriculteurs le 27 décembre.

- Extrême droite, racisme, antiféminisme : Brigitte Bardot, un héritage malaisant pour la cause animale (reporterre.net) – voir aussi Kaoutar Harchi : « La compassion de Brigitte Bardot pour les animaux n’annule pas son racisme » (bonpote.com)

- Brigitte Bardot, icône de l’extrême droite : Éric Ciotti demande un hommage national à Emmanuel Macron (humanite.fr)

- Le leader breton de La Digue, un groupuscule d’extrême droite, retrouvé mort en Belgique (letelegramme.fr)

Spécial résistances

- En Allemagne, des hackers lancent une campagne pour réduire l’emprise technologique américaine (euractiv.fr)

Des collectifs allemands de défense des droits numériques, épaulés par des entreprises technologiques européennes, organiseront ce dimanche 4 janvier et durant l’année 2026 des « journées de l’indépendance numérique », destinées à encourager les utilisateurices à réduire leur dépendance aux plateformes technologiques américaines.

- A69 : une décision inique qu’il faut contester (confederationpaysanne.fr)

- Quartiers populaires : l’histoire invisibilisée de 50 ans de luttes sociales (socialter.fr)

- Ces révoltes paysannes qui ont marqué l’histoire de France (basta.media)

Spécial outils de résistance

- Too dirty to be trained (too-dirty-to-be-trained.net) (too-dirty-to-be-trained.net) – voir en particulier How to make data dirty (too-dirty-to-be-trained.net) et le talk associé : A media-almost-archaeology on data that is too dirty for “AI” (events.ccc.de)

- The science of how (and when) we decide to speak out—or self-censor (arstechnica.com)

The study’s main takeaway : “Be bold. It is the thing that slows down authoritarian creep.”

Spécial GAFAM et cie

- Amazon et l’agro-industrie accusés d’empoisonner l’eau potable de populations précaires (synthmedia.fr)

Aux États-Unis, dans le comté de Morrow en Oregon, où 40 % de la population vit sous le seuil de pauvreté, l’implantation de datacenters Amazon depuis 2011 aurait amplifié une importante contamination aux nitrates. Une crise sanitaire qui rappelle d’autres cas en Amérique où les plus vulnérables paient le prix de décisions économiques prises par des acteurs industriels davantage motivés par l’argent que par le bien-être des populations.

Les autres lectures de la semaine

- La folle histoire du « pirate » derrière le premier .gouv.fr, la radio libre et Canal+ (next.ink)

Historien des médias, pionnier des bases de données, de l’« information automatisée », de l’accès aux images satellitaires puis du web, Antoine Lefébure a aussi créé la première radio « libre » française, et préfiguré ce qui allait devenir Canal+. Il se définit lui-même comme un « pirate », et vient de publier une histoire du « secret d’État », à laquelle il a consacré ces cinq dernières années.

- The Enshittifinancial Crisis (wheresyoured.at)

- Lebensraum : de Hitler à Trump, sources et généalogie d’un concept (legrandcontinent.eu)

- Briser la subalternité : Fanon avec Gramsci (contretemps.eu) – voir aussi le Dossier : retrouver Fanon (contretemps.eu)

- Pas de chauffage central mais des lits chauffés… Ce que la ville la plus froide du monde nous enseigne (theconversation.com)

Harbin se situe dans le nord-est de la Chine. Les températures hivernales y descendent régulièrement jusqu’à −30 °C et, en janvier, même les journées les plus douces dépassent rarement −10 °C. Avec environ 6 millions d’habitants aujourd’hui, Harbin est de loin la plus grande ville du monde à connaître un froid aussi constant.

- « Metropolis » imaginait 2026 il y a 100 ans et le monument de la SF résonne étrangement aujourd’hui (huffingtonpost.fr)

Le roman de Thea von Harbou adapté par Fritz Lang imaginait la société de 2026. Une fiction qui trouve un écho encore clair un siècle plus tard.

- Metaphorical Gender in English : Feminine Boats, Masculine Tools and Neuter Animals (antidote.info)

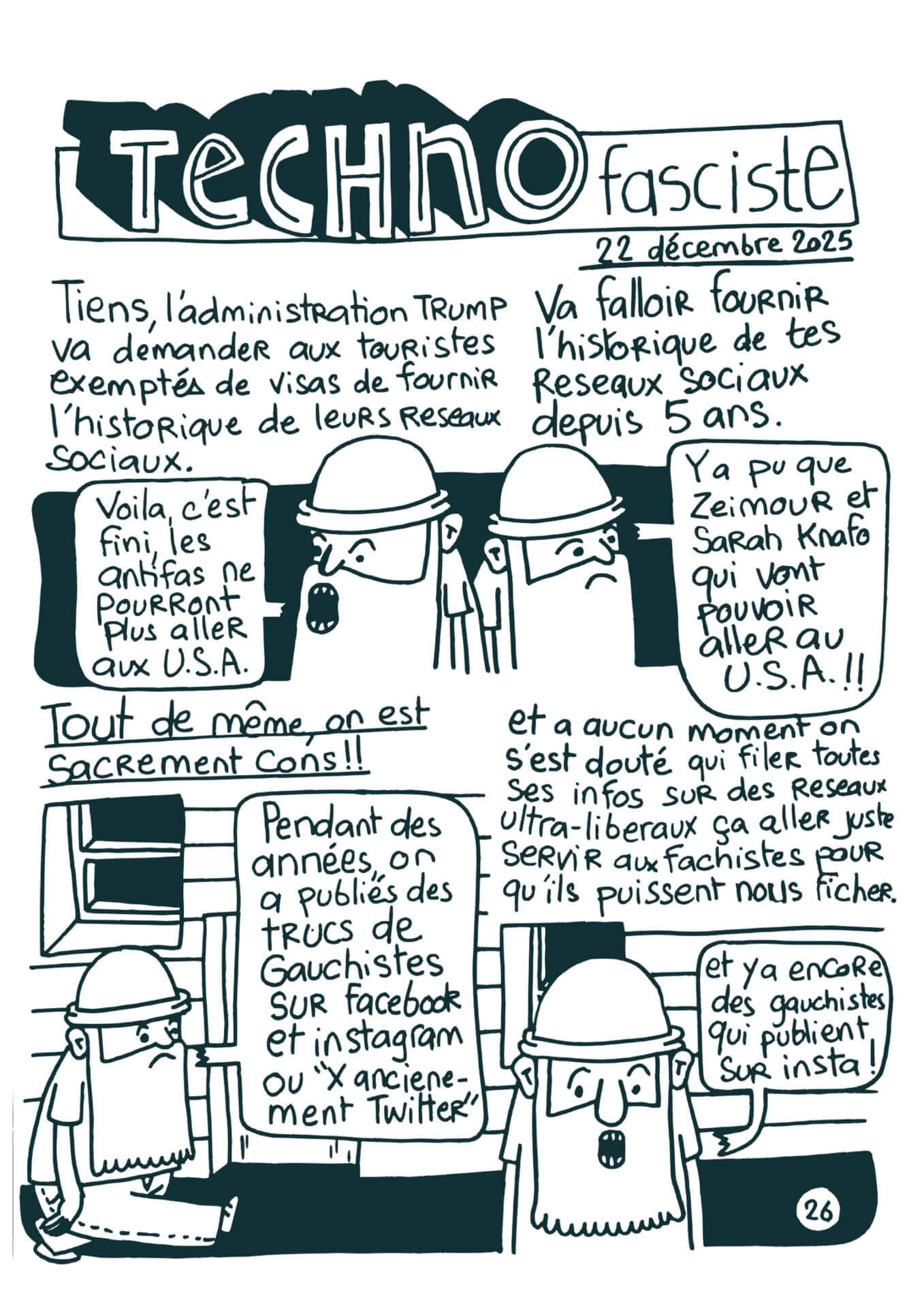

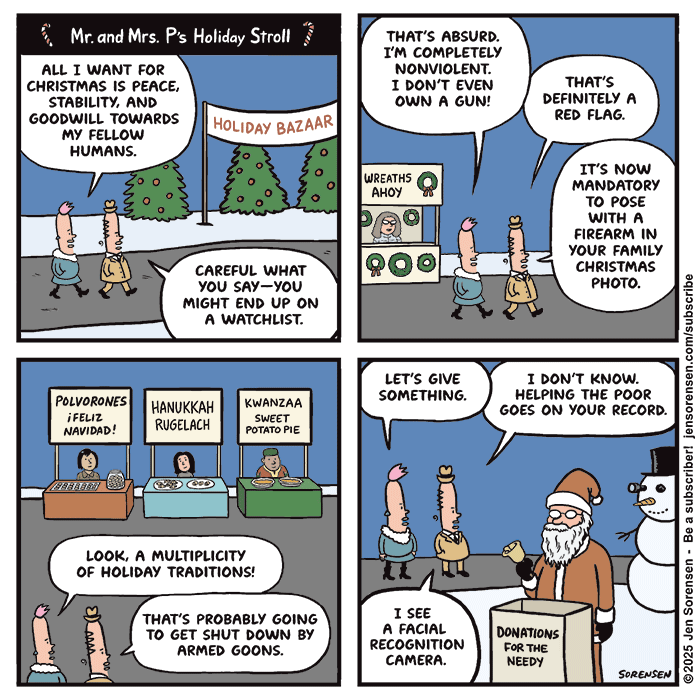

Les BDs/graphiques/photos de la semaine

- Cyberattaque

- Fossoyeur

- Bingo

- Lauréat

- Oil

- USA

- Coups

- The year in charts (restofworld.org)

Visualizing the ups, downs, and standout stats from 2025’s biggest tech stories.

- Merry Crisis

- Sérénité

- How Long

- Goal

- Deseo

- New Year

Les vidéos/podcasts de la semaine

- 1995-2025 : les médias contre les mouvements sociaux (acrimed.org)

- Les guignols de l’info, en 2001 (tube.fdn.fr)

- 51 Ways to Spell the Image Giraffe : The Hidden Politics of Token Languages in Generative AI (media.ccc.de)

- AI Agent, AI Spy (media.ccc.de)

- The Post-American Internet (pluralistic.net)

- All Sorted by Machines of Loving Grace ? “AI”, Cybernetics, and Fascism and how to Intervene (media.ccc.de)

- Persist, resist, stitch (media.ccc.de)

- Die Känguru-Rebellion : Digital Independence Day (media.ccc.de)

- Mon corps électrique (rts.ch)

Nom de code : UP2-001. Je suis le premier volontaire d’une étude clinique révolutionnaire : un implant dans mon cerveau, un autre dans ma moelle épinière, pour tenter de redonner vie à mon bras gauche.

Les trucs chouettes de la semaine

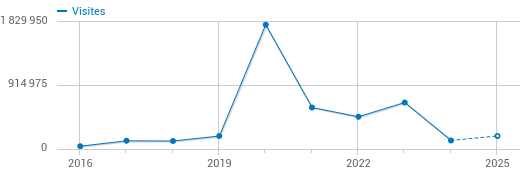

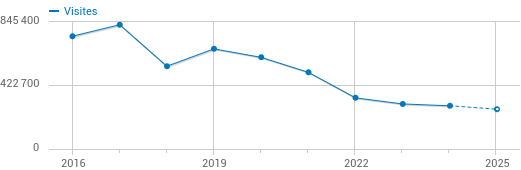

- En France, X (ex-Twitter) est complètement à la ramasse (clubic.com)

Pour la première fois depuis 2017, le réseau social d’Elon Musk n’apparaît plus dans les 50 marques les plus consultées en France selon Médiamétrie. X affiche désormais une audience comparable à celle de Reddit, signe d’un décrochage durable.

- La première carte nationale des transports (cartes.app)

Nous publions le premier plan interactif des transports en commun français. Zoomez où vous voulez pour afficher les lignes de bus, de tram, de métro et bientôt de train du réseau local.

- Europe : dix itinéraires en train à couper le souffle à découvrir en hiver (nationalgeographic.fr)

- En Écosse, une langue traditionnelle au secours des forêts (reporterre.net)

Deux luttes se rencontrent en Écosse : la promotion des langues indigènes, et la protection de l’environnement. Retrouver de vieux toponymes en gaélique permet de tracer la mémoire d’une faune et flore disparues.

- Stingless bees from the Amazon granted legal rights in world first (theguardian.com)

Planet’s oldest bee species and primary pollinators were under threat from deforestation and competition from ‘killer bees’

- The ASCII Side of the Moon (aleyan.com)

Retrouvez les revues de web précédentes dans la catégorie Libre Veille du Framablog.

Les articles, commentaires et autres images qui composent ces « Khrys’presso » n’engagent que moi (Khrys).

29.12.2025 à 07:42

Khrys’presso du lundi 29 décembre 2025

Khrys

Texte intégral (8577 mots)

Comme chaque lundi, un coup d’œil dans le rétroviseur pour découvrir les informations que vous avez peut-être ratées la semaine dernière.

Tous les liens listés ci-dessous sont a priori accessibles librement. Si ce n’est pas le cas, pensez à activer votre bloqueur de javascript favori ou à passer en “mode lecture” (Firefox) ;-)

Brave New World

- Montées des eaux, inondations… Des pêcheurs indonésiens intentent un litige contre le cimentier Holcim (humanite.fr)

Le Tribunal cantonal de Zoug a accepté d’examiner un litige intenté par quatre habitants de l’île indonésienne de Pari contre le géant suisse du ciment, Holcim. Les plaignants réclament notamment une indemnisation pour les dommages causés sur l’île du fait de la montée des eaux et des inondations, ainsi qu’une baisse de ses émissions de Co2.

- Russia plans a nuclear power plant on the moon within a decade (reuters.com)

- En Iran, la résistance portée par les générations Z et Y (basta.media)

La répression du régime contre la population s’accentue en Iran, alerte Hamid Enayat, proche de l’opposition iranienne à l’étranger. Malgré tout, l’espoir d’un avenir meilleur subsiste grâce à la résistance populaire, notamment portée par la jeunesse.

- Entire oblasts in Ukraine ‘almost completely without power’ after mass Russian missile, drone attack (kyivindependent.com)

- Le Danemark sur le qui-vive (lesoirdalgerie.com)

Le Danemark a annoncé lundi 22 décembre la convocation prochaine de l’ambassadeur des États-Unis à Copenhague après que le président Donald Trump eut annoncé ce dimanche la nomination d’un envoyé spécial pour le Groenland, territoire autonome danois qu’il a menacé d’annexer.

- Au Danemark, la poste ne distribue plus le courrier ! Un cas d’école pour l’Europe ? (france24.com)

- Belgique : Fascisme : Assignation à résidence, couvre-feu, interdictions … pour le Nouvel An (stuut.info)

En cette fin d’année, Bernard Quintin (MR), ministre de l’Intérieur, a préventivement autorisé une série de mesures répressives « exceptionnelles » en prévision de la soirée de la nouvelle année : assignation à résidence de mineur·es, couvre-feu, centre de crise, interdiction de feux d’artifices, interdiction des trottinettes…

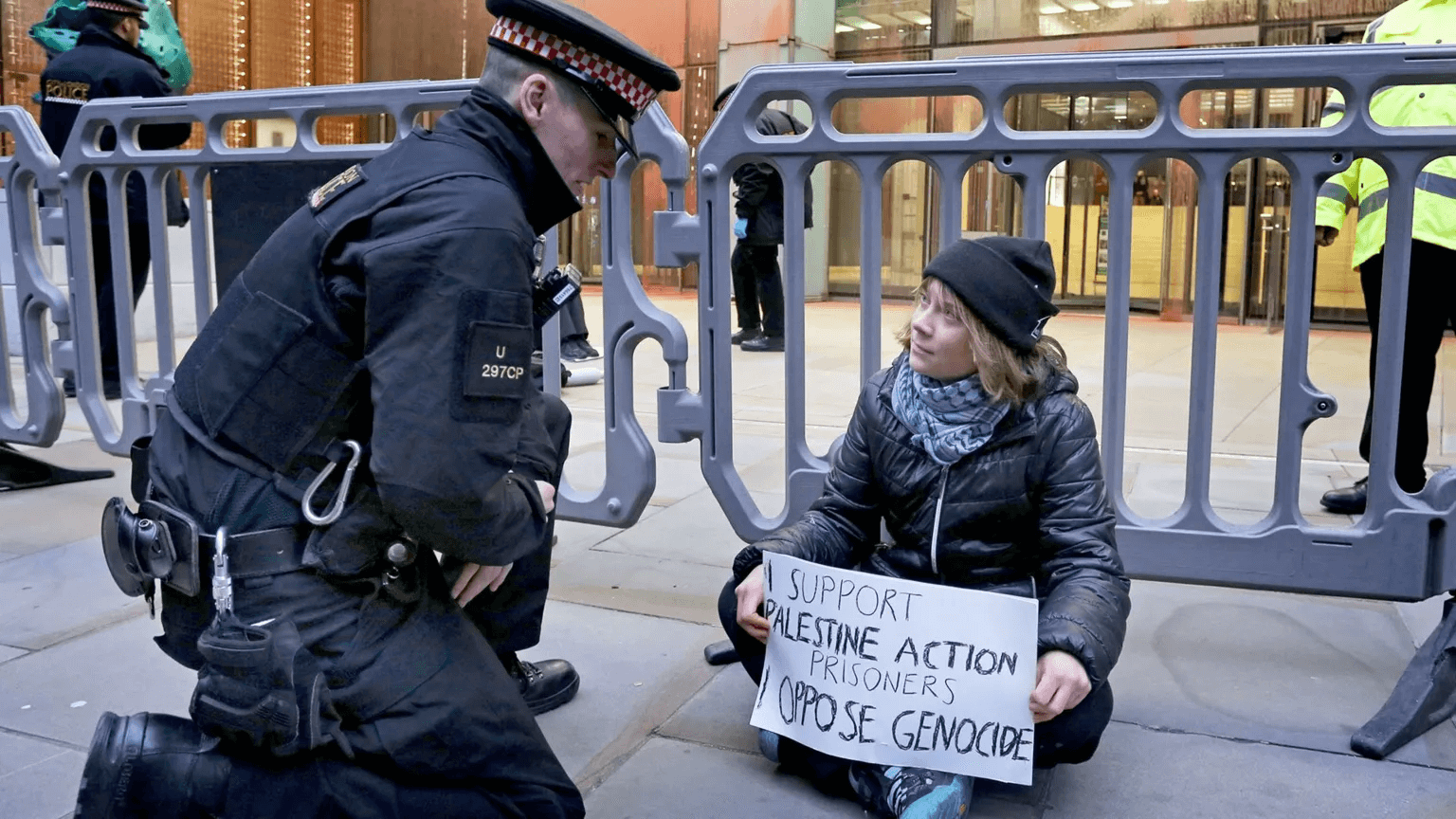

- Greta Thunberg arrested at protest supporting Palestine Action hunger strikers (independent.co.uk)

- Le Royaume-Uni sort le (gros) chéquier pour assurer la tapisserie de Bayeux d’éventuels dommages (huffingtonpost.fr)

Fragile et ancienne, la célèbre broderie va disposer d’une assurance de choix pour pallier toute dégradation durant son transport, son stockage et son exposition à Londres.

- Les forêts couvrent près de 40 % de la surface de l’Union, contre 34 % au début du siècle (legrandcontinent.eu)

La surface forestière européenne n’a cessé de croître au cours des dernières décennies.Depuis le milieu des années 1990, le continent européen concentre ainsi une plus grande part de la superficie forestière mondiale que l’Amérique du Sud : 25,1 % contre 20,5 %.

- Cloud, données et souveraineté : les institutions publiques européennes abandonnent discrètement les fournisseurs de services américains (cloud-computing.developpez.com)

Des fournisseurs comme Nextcloud et OVHCloud font état d’un pic de demandes de renseignements de la part de leurs clients. Les responsables desdites structures attribuent ce phénomène non seulement à l’effet Trump, mais aussi aux actions de l’administration américaine dans son ensemble.

Voir aussi Europe gets serious about cutting digital umbilical cord with Uncle Sam’s big tech (theregister.com)

Public bodies migrate in the bloc as hyperscalers claim sovereignty

- Washington sanctionne cinq Européen·nes engagé·es pour une régulation de la tech, dont Thierry Breton (france24.com)

Les États-Unis ont décidé, mardi, d’interdire de séjour cinq personnalités européennes engagées pour une stricte régulation de la tech, dont le Français Thierry Breton. Leurs agissements s’apparentent à de la “censure” au détriment des intérêts américains, a justifié le département d’État. Thierry Breton a dénoncé un “vent de maccarthysme”.

Voir aussi Régulation de la tech : l’Europe s’alarme après les sanctions de l’administration Trump (france24.com)

La présidente de la Commission européenne, Ursula von der Leyen, a défendu sur X la “liberté d’expression”, après que l’administration Trump eut banni l’ancien commissaire européen Thierry Breton et quatre autres personnalités européennes engagées pour la régulation de la tech. Emmanuel Macron a, lui, exprimé son soutien à Thierry Breton.

- Aux États-Unis, un des Européens interdits de visa contre-attaque en justice pour éviter l’expulsion (huffingtonpost.fr)

Le Britannique Imran Ahmed a déposé plainte contre l’administration de Donald Trump après les sanctions qu’il s’est vu imposer par Washington. […] Imran Ahmed vit aux États-Unis depuis 2021 et dispose d’une « carte verte » de résident permanent, comme l’indique sa plainte. Son épouse et leur fille sont Américaines

Voir aussi Plateformes numériques : privé de visa comme Thierry Breton, le britannique Imran Ahmed engage une bataille judiciaire contre l’administration Trump (humanite.fr)

- Donald Trump a annoncé des frappes américaines « meurtrières » contre l’État islamique au Nigeria et a menacé de mener de nouvelles attaques. (huffingtonpost.fr) – voir aussi Derrière les frappes américaines au Nigeria, la fixette de Donald Trump sur les chrétiens du pays (huffingtonpost.fr) et Donald Trump et les « frappes de Noël » sur le Nigeria (theconversation.com)

Selon Donald Trump, les frappes qui, le jour de Noël, ont visé des groupes djihadistes au Nigeria visaient à protéger les chrétiens de ce pays, qui seraient victimes d’un « génocide ». Qu’en est-il réellement, et quelles pourraient être les conséquences de ces bombardements ?

- Décision « politique » : un reportage de CBS sur Donald Trump censuré à la dernière minute (huffingtonpost.fr)

L’émission « 60 Minutes » avait prévu de diffuser un reportage sur l’expulsion de migrants au Salvador. Mais sans la moindre explication, ce reportage n’a pas été diffusé.

- Offensive transphobe : Trump demande au FBI de classer les organisations LGBTI comme terroristes (revolutionpermanente.fr)

Début décembre, le département de justice étasunien a demandé au FBI d’assembler une liste des organisations promouvant l’ « idéologie radicale du genre », les catégorisant dorénavant, aux côtés des groupes antiracistes et anticapitalistes, comme des groupes terroristes.

- Trump subit un rare revers de la Cour Suprême qui bloque de déploiement de la Garde nationale à Chicago (huffingtonpost.fr)

Le « Posse Comitatus Act », une loi de 1878, interdit d’utiliser des militaires pour mener des opérations de maintien de l’ordre. La Cour suprême, pourtant à majorité conservatrice, a maintenu un blocage qui avait été décidé avant elle par la justice fédérale.

- « Le roi Donnie VIII a perdu » : quand la chaîne britannique Channel 4 offre au présentateur Jimmy Kimmel une tribune contre la tyrannie trumpiste (humanite.fr)

« Jimmy Kimmel Live ! », avait été privé d’antenne aux États-Unis par ABC, pour finalement être réintégré sous la pression d’une campagne de soutien massive. Malgré la censure, Jimmy Kimmel achève l’année en beauté en étant sélectionné pour prononcer le traditionnel discours de Noël sur la chaîne britannique Channel 4.

- Jim Jarmusch, célèbre réalisateur américain, demande la nationalité française (huffingtonpost.fr)

De passage sur France Inter pour la promo de son nouveau film en partie tourné à Paris « Father Mother Sister Brother », le cinéaste de 72 ans a dit vouloir « s’évader des États-Unis ».

- En Californie, une « rivière atmosphérique » laisse des quartiers inondés et des maisons ensevelies (huffingtonpost.fr)

- What changed for deep-sea mining in 2025 ? Everything (grist.org)

Trump reshaped the industry this year, even as it faced opposition from the United Nations, scientists and Indigenous peoples.

- Les Caraïbes ont perdu la moitié de leurs coraux durs en 50 ans (reporterre.net) – voir aussi Réchauffement, acidification des mers, maladies… Près de la moitié des coraux des Caraïbes ont disparu depuis 1980 (humanite.fr)

La couverture en coraux durs dans les Caraïbes a diminué de 48 % entre 1980 et 2024, alerte un rapport du Global Coral Reef Monitoring Network diffusé mardi 23 décembre par la préfecture de Guadeloupe. En cause, le réchauffement et l’acidification des mers dus aux émissions de gaz à effet de serre.

- Au Brésil, Lula souhaite baisser le temps de travail hebdomadaire à 36 heures sans réduction de salaires (humanite.fr)

Dans son allocution de Noël, le président du Brésil, Luiz Inacio Lula da Silva, a annoncé qu’il réformera le temps de travail s’il est réélu en 2026.

Spécial IA

- L’explosion de la bulle de l’IA accentuerait la domination technologique mondiale de la Chine (geo.fr)

Alors que des milliers de milliards de dollars sont investis par les géants de la tech et le secteur financier dans l’IA générative, les signaux d’alarme se multiplient. Si la bulle éclate, la Chine en sortirait gagnante.

- As AI Companies Borrow Billions, Debt Investors Grow Wary (news.slashdot.org)

- Nuclear developer proposes using Navy reactors for data centres (financialpost.com)

- Salesforce regrets firing 4000 experienced staff and replacing them with AI (maarthandam.com)

According to executives familiar with the transition, automated systems struggled with nuanced issues, escalations, and long-tail customer problems. The result was declining service quality, higher complaint volumes, and internal firefighting to stabilize operations that had once been handled by experienced staff.

- Microsoft denies rewriting Windows 11 using AI after an employee’s “one engineer, one month, one million code” post on LinkedIn causes outrage (windowslatest.com)

Microsoft told […] that the company does not plan to rewrite Windows 11 using AI in Rust […] the clarification is not coming out of nowhere, as a top-level Microsoft engineer made bold claims of using AI to replace C and C++ with Rust. […] “My goal is to eliminate every line of C and C++ from Microsoft by 2030. Our strategy is to combine AI and Algorithms to rewrite Microsoft’s largest codebases. Our North Star is “1 engineer, 1 month, 1 million lines of code,” Galen Hunt, who is a top-level Distinguished Engineer at Microsoft, wrote in a now-edited LinkedIn post.

- ‘Confused’ Waymos Stopped in Intersections During San Francisco Power Outage (tech.slashdot.org) – voir aussi Waymo resumes service in San Francisco after robotaxis stall during blackout (techcrunch.com)

Waymo said that although its self-driving systems are designed to treat non-functioning traffic lights as four-way stops, the scale of Saturday’s blackout caused some robotaxis to remain stationary for longer than normal as they tried to assess the intersections.

- AI image generators have just 12 generic templates (pivot-to-ai.com)

There’s a new paper : “Autonomous language-image generation loops converge to generic visual motifs” — diffusion models have just 12 standard templates.[…] We know generative AI is just lossy compression of its training. It’s designed to put out the most mid result, and it’s got its favourite bits of the latent space.

- Pourquoi les applications vous forcent à utiliser l’intelligence artificielle, “on fait semblant de vous donner ces fonctionnalités gratuitement” (france3-regions.franceinfo.fr)

En 2024, des chercheuses en design de l’université de Strasbourg ont étudié 53 applications et logiciels informatiques. Objectif : identifier les changements de design qui poussent les consommateurs à utiliser l’intelligence artificielle. Elles déplorent des stratégies particulièrement agressives.

- Votre navigateur vous espionne, mais à quel point ? Vous allez être choqué·e (non) (goodtech.info)

une étude de décembre 2025, rapportée par Neowin et menée par Digitain le confirme : la plupart des navigateurs que nous utilisons quotidiennement sont de véritables passoires pour nos données personnelles. Si Google Chrome est souvent pointé du doigt, […] il existe désormais bien pire que le géant de Mountain View sur le marché et c’est Atlas, le navigateur d’OpenAI

- Samsung is putting Google Gemini AI into your refrigerator, whether you need it or not (nerds.xyz)

- Texas is suing all of the big TV makers for spying on what you watch (theverge.com)

TVs made by Sony, Samsung, LG, Hisense, and TCL are part of a ‘mass surveillance system,’ Attorney General Ken Paxton alleges.

Voir aussi 172 800 captures d’écran quotidiennes : l’accusation explosive contre les smart TV Samsung, LG, ou Sony (lesnumeriques.com)

Cinq géants de l’électronique grand public — Sony, Samsung, LG, Hisense et TCL — sont poursuivis par l’État du Texas pour avoir capturé en secret ce qui s’affiche sur les écrans de millions de foyers américains. La fréquence alléguée des captures : deux fois par seconde.

- Flock Exposed Its AI-Powered Cameras to the Internet. We Tracked Ourselves. (404media.co – rticle de novembre 2025)

Unlike many of Flock’s cameras, which are designed to capture license plates as people drive by, Flock’s Condor cameras are pan-tilt-zoom (PTZ) cameras designed to record and track people, not vehicles. Condor cameras can be set to automatically zoom in on people’s faces as they walk through a parking lot, down a public street, or play on a playground, or they can be controlled manually

- What’s the Difference Between AI Glasses and an iPhone ? A Helpful Guide for Meta PR (404media.co)

Meta thinks its camera glasses, which are often used for harassment, are no different than any other camera.

- Les articles générés par des humains sont désormais minoritaires sur Internet en comparaison de ceux produits par l’IA (developpez.com)

Les articles générés par l’intelligence artificielle dépassent ceux écrits par des humains depuis fin 2024, d’après un rapport de Graphite. Plus de la moitié du trafic web est généré par des systèmes automatisés dont la majorité est mise en place par des acteurs malveillants

- Les utilisateurices « sont fatigué·es » : la bouillie générée par IA est-elle sur le point de tuer son premier réseau social ? (numerama.com)

Le contenu généré par IA serait en train de tuer Pinterest. C’est en tout cas ce qu’affirment de nombreux utilisateurices du réseau social, dont certain·es ont témoigné dans un article publié le 24 décembre 2025 sur le site américain Wired. En cause : la prolifération de contenus bas de gamme générés par IA, qui envahissent un réseau historiquement pensé comme un espace d’inspiration et de curation visuelle soignée.

- « Allez tous vous faire foutre ! » Rob Pike explose contre la GenAI : quand l’un des créateurs de Go, Plan 9, UTF-8 accuse l’IA de piller, polluer et détruire le sens même du progrès technologique (developpez.com)

- Le mythe de la bonne IA (danslesalgorithmes.net)

Dans une perspective décoloniale, il n’y a pas de bonne IA

- L’IA en 2025 : quatre tendances (legrandcontinent.eu) – voir aussi L’IA et l’Europe avec Kidron, Benanti, Bradford, Bouverot, le Pas de Sécheval, Crawford et López Águeda (legrandcontinent.eu)

- Why A.I. Didn’t Transform Our Lives in 2025 (newyorker.com)

As 2025 winds down, the era of general-purpose A.I. agents has failed to emerge.

- The AI Revolution Needs Plumbers After All (indiadispatch.com)

How Indian IT learned to stop worrying and sell the AI shovel

- L’intelligence artificielle générale n’aura pas lieu (arretsurimages.net)

Spécial Palestine et Israël

- Israeli police arrest Palestinian man dressed as Santa Claus at Christmas party (theguardian.com)

Officers closed Christmas event in Haifa, confiscating equipment and also arresting a DJ and a street vendor

- Prisoners for Palestine : Qesser Zuhrah (prisonersforpalestine.or)

They won’t imprison us all, they know if they fill the prisons with activists, we will overpower them from within. So flood the damn streets in your millions. Shut down these factories in your thousands ! They can never arrest the resistance in our smiles. We will use the shards of our broken hearts to spear the system of injustice.

- Gaza : The Reckoning (brunomacaes.substack.com)

The debate on whether Israel’s actions in Gaza constitute a genocide is now closed, and has been closed for a while. The international Court of Justice, all the major historians of genocide, the United Nations, all the major human rights organisations, the mainstream Hollywood star Jennifer Lawrence and even a former Israeli Prime Minister all call the Gaza “war” a genocide.

- À la galerie Martel, Art Spiegelman et Joe Sacco vendent leurs originaux pour les enfants de Gaza (humanite.fr)

Jusqu’au 10 janvier, à la galerie Martel à Paris, l’auteur de Maus et le maître de la BD reportage ont choisi de vendre les planches et croquis originaux d’un récit réalisé à quatre mains, autour du conflit israélo-palestinien, au bénéfice de l’Unicef.

Spécial femmes dans le monde

- En Ukraine, la guerre qui s’éternise propulse les femmes en première ligne (slate.fr)

Face à la pénurie de combattants et de volontaires masculins, les Ukrainiennes occupent désormais des rôles-clés, du pilotage de drones de combat à l’évacuation de civils sous le feu de l’envahisseur russe.

- Affaire Epstein : la riposte du camp Trump aux nouveaux documents montre son extrême embarras (huffingtonpost.fr)

- DOJ appears to bungle Epstein Files redactions (theverge.com)

simply copying and pasting many of the redactions into a new document reveals what’s beneath the black boxes.

Le LOL de la semaine

- Epstein Files Redactions Failed After Funding Cuts Forced DOJ to Use Basic Adobe Tools (ibtimes.co.uk)

RIP

- World War Two codebreaker dies aged 99 (bbc.co.uk)

Ruth Bourne, a Jewish veteran, was […] chosen to work at decoding intercepted messages and was based at two outstations of Bletchley Park […]The Bombe machine was an electromechanical device built by Alan Turing to crack Germany’s Enigma code, quickly finding daily settings to decode enemy messages – a breakthrough that changed the course of the war and saved millions of lives.

- Le groupe The Cure pleure son guitariste et claviériste Perry Bamonte (rts.ch)

Le guitariste et claviériste du groupe The Cure, Perry Bamonte, est décédé à l’âge de 65 ans, a annoncé vendredi le légendaire groupe britannique de new wave.

Spécial France

- Budget 2026 : les conséquences de l’échec de la commission mixte paritaire et du choix de l’option de la loi spéciale (theconversation.com)

- Chronopost piraté ? Les données de 860 000 Français·es ont fuité (kulturegeek.fr)

Le hack couvre les données de clients Chronopost allant de février à avril 2025. Si vous avez reçu un colis en relais Pickup durant cette période, il est probable que vos données aient été piratées

- Mondial Relay touché par une cyberattaque qui a volé les données de ses client·es (franceinfo.fr)

Selon l’entreprise ce sont les données personnelles des client·es qui sont “susceptibles” d’avoir été volées, notamment “le nom, le prénom, les adresses email et postale ou le numéro de téléphone”.

- La Banque Postale et La Poste de nouveau en panne ce lundi matin, mais que se passe-t-il encore ? (clubic.com)

Moins de quarante-huit heures après un premier gros incident, La Banque Postale et La Poste sont, ce lundi matin, de nouveau frappées par une sévère panne, qui empêche l’accès à de multiples services.

Voir aussi Le groupe NoName de pirates prorusses revendique l’attaque contre La Poste (next.ink)

- Une gardienne de la paix arrêtée pour avoir vendu des fichiers policiers sur Snapchat (next.ink)

- Il pénètre dans un bois privé pour trouver une proie : poursuivi par le propriétaire, le chasseur panique et tire, la victime n’a pas survécu. (ladepeche.fr)

- Une explosion dans une usine chimique près de Lyon fait au moins 4 blessés (huffingtonpost.fr)

L’explosion est survenue dans une usine classée Seveso seuil haut, ce qui signifie qu’elle manipule des substances chimiques présentant un risque majeur pour la santé et l’environnement.

Voir aussi Explosion d’une usine près de Lyon : les maires alertent sur le désengagement de l’État (reporterre.net)

- PFAS : les pompier·es confronté·es à des risques invisibles depuis des décennies (reporterre.net)

Les pompier·es utilisent encore des mousses anti-incendie aux PFAS et des tenues imprégnées de ces polluants éternels. Une exposition chronique qui est pourtant documentée depuis plus de dix ans.

- Décorations de Noël : la fausse neige bientôt interdite ? (reporterre.net)

La magie de Noël mérite-t-elle que l’on libère des nuages de microplastiques dans notre environnement immédiat ? C’est le risque que fait courir une décoration de Noël répandue : la neige artificielle vendue en sachets sous forme de poudre, de paillettes ou de flocons.

- Le « Noël le plus froid depuis 15 ans » est à une température normale pour la saison (reporterre.net)

- Hébergements d’urgence, maraudes… face à la chute des températures, le plan « grand froid » est activé dans plusieurs départements (humanite.fr)

Les préfectures s’organisent face à la chute soudaine des températures. Ainsi, une vingtaine de départements ont déclenché le plan « grand froid ». Des mesures qui interviennent alors qu’une personne sans-abri est décédée du froid, à Reims, le jour de Noël.

- “Un jeune sans-abri retrouvé mort le soir de Noël, le deuxième décès dans la rue en moins d’une semaine à Nantes” (ouest-france.fr)

Le corps inerte de ce jeune homme de 30 ans, sans domicile fixe, a été découvert à deux pas du CHU de Nantes dans la soirée du 25 décembre. Quatre jours avant Noël, c’est un quadragénaire qui est mort sous ses couvertures.

- Montpellier sous l’eau à quelques jours de Noël (reporterre.net)

- Les algues puantes, ce fléau qui engloutit un bout de Guadeloupe (reporterre.net)

C’est que la commune de Capesterre-de-Marie-Galante est celle qui souffre le plus en Guadeloupe des échouements de sargasses, devenus réguliers. Selon les années, l’île aux belles eaux reçoit entre 30 000 et 50 000 tonnes de sargasses sur ses plages depuis 2011

Spécial femmes en France

- Enquête : Traitement hormonal de la ménopause, information ou promotion ? (portail.basta.media)

- Rachida Dati a réussi par « promotion canapé » : Carlos Martens Bilongo présente ses excuses après sa sortie sexiste (huffingtonpost.fr)

Le député LFI a présenté « publiquement » ses excuses à Rachida Dati après avoir dit qu’elle avait progressé en politique « en couchant avec des hommes ».

- Cette caricature de Rokhaya Diallo par « Charlie Hebdo » indigne la gauche qui apporte son soutien à l’essayiste (huffingtonpost.fr)

L’essayiste et militante antiraciste a dénoncé un dessin « dans le droit fil de l’imagerie coloniale », accusant le journal satirique de la « réduire à un corps exotisé ».

- Contre le racisme, en défense de notre collaboratrice Rokhaya Diallo (blogs.mediapart.fr)

- Mise en examen de Gérard Miller : Motion du Conseil d’administration de l’Université Paris 8 (cgt.fercsup.net)

Le Conseil d’administration de l’Université Paris 8, réuni le 19 décembre 2025, exprime sa résolution à lutter contre les violences sexistes et sexuelles. Un de ses anciens enseignants-chercheurs, Gérard Miller, a été mis en examen le 2 octobre 2025 pour quatre viols, dont trois sur mineures, et deux agressions sexuelles, qui auraient été perpétrés entre 2000 et 2020. Il a en outre été placé sous le statut de témoin assisté pour un fait présumé de viol sur mineur de plus de 15 ans. Il s’agit de faits qui font l’objet d’une procédure en cours. Vingt-sept femmes l’auraient à ce jour accusé.

- Dans le métro à Paris, trois femmes blessées après des agressions au couteau (huffingtonpost.fr)

En fuite, l’agresseur présumé a finalement été interpellé à son domicile. Les agressions sur trois femmes ont eu lieu aux stations Arts et Métiers, République et Opéra.

Spécial médias et pouvoir

- « La quête du vote musulman » : anatomie d’un récit médiatique islamophobe (acrimed.org)

- Attaque terroriste en Australie : de CNews à Franceinfo, blâmer la gauche, surtout ! (politis.fr)

Il y avait des angles politiques et sociaux spécifiques à l’Australie à couvrir dans les médias, suite à l’attentat antisémite de Bondi Beach, à Sydney. Trop compliqué pour nombre d’éditorialistes et journalistes, préférant viser la gauche française.

- Affaire Legrand-Cohen : le parquet de Paris ouvre une enquête pour « atteinte à l’intimité de la vie privée par captation » (humanite.fr)

Spécial emmerdeurs irresponsables gérant comme des pieds (et à la néolibérale)

- Piratage du ministère de l’Intérieur : l’État était pourtant prévenu (blast-info.fr)

- Le Wi-Fi d’Elon Musk va équiper les avions d’Air France (reporterre.net)

Objectif de la compagnie aérienne : permettre à ses passagers d’accéder à un réseau internet “ultraperformant” “gratuitement”··· après une inscription à un programme de fidélité.

- Ces députés rédigent secrètement leurs amendements avec la FNSEA (reporterre.net)

Reporterre a épluché les amendements déposés depuis 2024 : 783 ont été fournis clés en main par la FNSEA, le syndicat agricole productiviste. La plupart ont été proposés sans modification, et dans l’opacité.

Spécial recul des droits et libertés, violences policières, montée de l’extrême-droite…

- « À quel groupe ethnique vous identifiez-vous ? » : la Société générale propose un questionnaire « illégal et discriminant » à ses candidat·es, l’employé à l’origine de la découverte limogé (humanite.fr)

Pour des postes à l’international, la Société générale propose à ses candidat·es de remplir un questionnaire sur leur genre, leur couleur de peau, leur sexualité et leur appartenance à un parti politique

- « Zone anti antifa » : au Mans, le local d’une association LGBTQI + attaqué par l’extrême droite (humanite.fr)

L’association sarthoise Homogène a annoncé, sur ses réseaux sociaux, avoir été la cible d’actes de dégradation et de vandalisme de la part de militants d’extrême droite. La LDH dénonce une volonté d’intimider les acteurs de la solidarité.

- Diffamation à l’encontre de La Cimade : Marine Le Pen définitivement condamnée (lacimade.org)

- Paysan tué par un gendarme : les scellés ne seront pas détruits (reporterre.net)

Plus de huit ans après la mort de Jérôme Laronze, un éleveur de Saône-et-Loire tué par un gendarme en 2017, la justice s’est opposée le 19 décembre à la destruction des scellés. Celle-ci avait été ordonnée par la juge d’instruction lors de l’audience du 13 novembre, à Dijon.

Pas RIP

- Brigitte Bardot et la politique, à droite toute (telerama.fr)

L’actrice est morte à l’âge de 91 ans. Celle qui créa la Fondation Brigitte Bardot en 1986 et lutta pour la défense des animaux, ne cachait pas sa proximité avec l’extrême droite et fut même condamnée pour incitation à la haine raciale.

Spécial résistances

- “Cessez de vous moquer” : après une série noire de piratages, une lettre ouverte exige une refonte totale de la CNIL (lesnumeriques.com)

- Pour une ligne de train, de meilleurs salaires ou des CDI : ces mobilisations victorieuses en 2025 (basta.media)

Contre la fermeture d’une ligne de train, pour des augmentations ou contre un milliardaire d’extrême droite… Les mobilisations victorieuses passent trop souvent sous les radars. Elles sont pourtant riches d’enseignements. Quatre exemples en 2025.

- Pour continuer à lancer l’alerte et renforcer la solidarité en 2026 (blogs.mediapart.fr)

Nous pouvons toutes et tous trouver des formes de mobilisations pour nous opposer au glissement qui est entrain de s’opérer en France, lancer l’alerte à notre niveau, et choisir de remettre la solidarité au cœur de notre société.

Spécial outils de résistance

- Indextrême (indextreme.fr)

Indextrême est un outil qui a pour objectif de comprendre, dans le contexte français, les symboles utilisés et détournés par l’extrême droite. En connaissant leur histoire, nous pouvons mieux comprendre les mécanismes sémiotiques de ces symboles et leur impact dans notre société.

- Fachorama en version “Do it Yourself” (lahorde.info)

Vous vouliez offrir (ou vous offrir) Fachorama et vous êtes dépité·e car il est provisoirement épuisé suite à la polémique… Si vous êtes patient·e et un peu habile de vos mains, pourquoi ne pas fabriquer votre exemplaire ? C’est ce qu’on vous propose avec ce kit “do it yourself” à télécharger, imprimer et coller soi-même.

- Chronoluttes (chronoluttes.com)

Saurez-vous placer la grève des corsetières de Limoges, l’occupation d’Alcatraz aux Etats-Unis ou encore la marche pour l’égalité sur une frise du temps ? Pour se réapproprier un passé souvent oublié, partons ensemble à la (re)découverte des grands évènements et des organisations qui ont fait notre histoire collective.

- Accessibility Myths Debunked (a11ymyths.com)

Spécial GAFAM et cie

- Amazon faces ‘leader’s dilemma’ — fight AI shopping bots or join them (cnbc.com)

- Victoire inattendue pour Amazon en justice : la CNIL en partie désavouée par le Conseil d’État (clubic.com)

Le Conseil d’État a divisé par deux l’amende de 32 millions d’euros infligée à Amazon France Logistique. Juste avant Noël, le juge administratif a désavoué partiellement la CNIL sur la surveillance des employés en entrepôt.

- Italy tells Meta to suspend its policy that bans rival AI chatbots from WhatsApp (techcrunch.com)