09.12.2015 à 01:00

Je n'ai pas voté non plus

Bizarre comme titre, n’est-ce pas ? En fait, c’est en écho à cet article du copain Gee, auteur de Grisebouille, qui a su exprimer de manière assez claire les raisons pour lesquelles il ne vote pas (plus). La démocratie représentative serait-elle morte ? Oui. Nous avons besoin d’un reboot de la démocratie et c’est chez Jean-Jacques Rousseau qu’il faut en trouver l’amorce.

Détournements de votes

Comme disait Coluche : « dire qu’il suffirait que les gens n’en n’achètent plus pour que cela ne se vende pas ». Je n’ai jamais trop aimé Coluche – ou plutôt son humour de bistrot dont se sont emparés la plupart des réacs aigris –, mais au moins il avait le sens de la formule. Il suffirait que plus personne n’aille voter pour que la classe politique actuelle s’en aille pour de bon. Imaginons un instant une grève du vote : tous les vieux dinosaures des partis qu’on voit depuis 40 ans verraient soudainement leur légitimité en prendre un coup. Quant aux plus jeunes, persuadés de faire partie d’une « élite » républicaine (autrement dit, une aristocratie politique), ils pourraient retourner sur les bancs d’école, histoire de bien comprendre qu’on ne s’implique pas dans la politique par carriérisme. Oui, mais voilà : de fait, nous sommes des millions à ne pas aller voter. Et plutôt que de se remettre en cause, les politiques multiplient les interventions en se targuant de vouloir « barrer la route au FN » tout en assurant, comme c’est le cas à chaque élection depuis que je suis né, que « le message a été entendu ».

Mais quel message ? Pourquoi les gens s’abstiennent de voter, et pourquoi certains votent pour un parti fasciste ? Parce que contrairement à ce qu’on m’a toujours dit, le vote n’est pas un choix démocratique. C’est un levier qui légitimise l’exercice du pouvoir par certains. Ainsi, depuis que je vote, je n’ai jamais pu dire que mon vote a servi des causes que je défends :

- quand il m’a fallu voter Chirac pour « barrer la route à Le Pen », en 2002 ;

- quand j’ai voté « non » au référendum de 2005 sur le traité européen Rome II (parce que c’est d’une autre Europe dont je rêve), remplacé 4 ans plus tard par son clone, le Traité de Lisbonne, cette fois sans demander l’avis aux citoyens ;

- quand j’ai voté blanc en 2007 devant les choix consternants qui nous étaient livrés, entre une grande nunuche sans programme et un petit nerveux aux idées brunes ;

- quand j’ai voté blanc en 2012 en ayant absolument aucune illusion sur les mensonges de F. Hollande.

La démocratie représentative a vécu

Quel est mon constat, au-delà de la simple déception ? le même que Gee : la démocratie représentative a vécu. Et je coupe court tout de suite aux détracteurs qui viendront me dire que « des gens sont morts pour que nous ayons le droit de voter ». Non : ils ne sont pas morts pour le droit de vote, ils sont morts pour avoir le droit de participer à la vie politique. Ils ne sont pas morts pour que j’aie le droit de désigner un représentant qui, fondé de pouvoir, fera ce qu’il veut pendant son mandat. Ils sont morts pour que la démocratie s’exerce.

Oui, ma bonne dame, et c’est pas pareil du tout. Et pourtant on nous l’apprend depuis tout petit. Lorsqu’à l’école on n’est pas content des décisions du délégué de classe, on s’empresse de nous dire de fermer notre gueule. C’est vraiment cela, la démocratie ? Tiens, voyons ce qu’en disait ce bon vieux Jean-Jacques Rousseau, qu’il serait peut-être temps de relire parce que au pays des Lumières, certains n’ont pas le courant à tous les étages :

L’attiédissement de l’amour de la patrie, l’activité de l’intérêt privé, l’immensité des états, les conquêtes, l’abus du gouvernement, ont fait imaginer la voie des députés ou représentants du peuple dans les assemblées de la nation. C’est ce qu’en certain pays on ose appeler le tiers état. Ainsi l’intérêt particulier de deux ordres est mis au premier et second rang; l’intérêt public n’est qu’au troisième.

La souveraineté ne peut être représentée, par la même raison qu’elle peut être aliénée; elle consiste essentiellement dans la volonté générale, et la volonté ne se représente point : elle est la même, ou elle est autre; il n’y a point de milieu. Les députés du peuple ne sont donc ni ne peuvent être ses représentants, ils ne sont que ses commissaires; ils ne peuvent rien conclure définitivement. Toute loi que le peuple en personne n’a pas ratifiée est nulle; ce n’est point une loi. Le peuple Anglais pense être libre, il se trompe fort; il ne l’est que durant l’élection des membres du parlement: sitôt qu’ils sont élus, il est esclave, il n’est rien. Dans les courts moments de sa liberté, l’usage qu’il en fait mérite bien qu’il la perde. […]

Quoi qu’il en soit, à l’instant qu’un peuple se donne des représentants, il n’est plus libre; il n’est plus.

— Du contrat social ou Principes du droit politique (1762), Chapitre 3.15 – Des députés ou représentants

Un peu d'explication de texte

Au premier paragraphe Rousseau montre que le principe de représentativité est d’abord une affaire de l’Ancien Régime et son administration. Ce qu’on désigne par « tiers état », ce sont les députés, provinciaux pour la plupart, censés être représentatifs des classes sociales (bougeois, commerçants, artisans, etc.) mais qui valident le modèle hiérarchique des trois ordres (noblesse, clergé, bourgeoisie). Lors de la Révolution française, qui interviendra 27 ans après l’ouvrage de ce visionnaire de Rousseau, le principe de souveraineté du peuple sera remis en cause par Sieyès qui, justement, désignera le tiers état comme un élément de la constitution. Sieyès reprendra l’ancien ordre hiérarchique pour montrer que le tiers état, comme les deux autres ordres, doit être représenté de manière proportionelle à sa population. C’était plutôt bien vu, mais en réalité, la représentatitvité de ce tiers état est tellement diversifiée (cela va du paysan au riche industriel) que c’est la haute bourgeoisie, riche et cultivée, qui finira par s’octroyer cette représentativité, pour s’assurer exactement ce que dénonce Rousseau, à savoir la sauvegarde de leurs intérêts privés, face à une noblesse déclinante et une masse « prolétarienne »1 qu’il faut absolument écarter du pouvoir. Rousseau note bien, sous l’Ancien Régime, que c’est l’intérêt public (comprendre : du peuple) qui est mis au troisième rang parce que justement les représentants du peuple ne sont là que pour limiter les intérêts des deux autres ordres, ainsi confortés dans le pouvoir. La Révolution ne changera finalement la donne qu’au regard des intérêts d’une bourgeoisie de plus en plus riche face à la noblesse déclinante, c’est tout.

Rousseau est catégorique, sans appel. Dans le second paragraphe, il répond même à Montesquieu qui, dans l'Esprit des Lois (Livre XI, 1748) se montrait admiratif de la Constitution Anglaise et écrivait pour sa part :

Comme, dans un état libre, tout homme qui est censé avoir une âme libre doit être gouverné par lui-même, il faudrait que le peuple en corps eût la puissance législative. Mais comme cela est impossible dans les grands états, et est sujet à beaucoup d’inconvénients dans les petits, il faut que le peuple fasse par ses représentants tout ce qu’il ne peut faire par lui-même. (…) Le grand avantage des représentants, c’est qu’ils sont capables de discuter les affaires. Le peuple n’y est point du tout propre; ce qui forme un des grands inconvénients de la démocratie.

Mais ce qui distingue notre Rousseau, c’est justement la conception des rôles. La conclusion de Rousseau est terrible, je la redonne ici, rien que pour le plaisir :

(…) Quoi qu’il en soit, à l’instant qu’un peuple se donne des représentants, il n’est plus libre; il n’est plus.

La démocratie ne s’exerce pas tant parce qu’il est possible de rendre la représentativité plus ou moins légitime (de toute façon une impasse pour Rousseau), mais parce qu’il est possible d’y voir s’exercer la volonté générale et, en tant que telle, elle ne peut se déléguer. Donc oui, le peuple (la société civile, dirait-on aujourd’hui) est capable de gouverner, c’est à dire exercer et instruire la volonté générale, au lieu de laisser faire des représentants qui aliènent cette volonté durant leurs mandats.

Ces mots de Rousseau il y a plus de 250 ans, je les ai entendu lors même de la série de renoncements aux engagements du clan de F. Hollande promulgués lors des élections. Pendant toute la durée du mandat, il allait faloir supporter, impuissants, les féodalités financières dont le point d’orgue fut atteint en insultant le peuple grec qui avait eu le culot, en juillet 2015, de réfuser par référendum les pires tentatives de réformes technocratiques pour remédier à un endettement historiquement organisé contre lui. Pour la plupart des électeurs, le fait d’aller voter n’était plus conçu comme l’exercice de la démocratie mais comme le seul moment de liberté avant de s’enchaîner aux grilles infranchissables qu’une classe politique dresse entre elle et le peuple.

Oui, n’en déplaise à ce pédant de Montesquieu qui pensait que le peuple est trop con pour faire de la politique, et tous les coincés du bocal pour qui la politique serait un métier, la société civile est capable à la fois d’expertise, d’expérience et de gouvernement. C’est la raison pour laquelle, sans doute, on a abruti les foules en étouffant leur activisme civique au profit du vote conçu comme une fin en soi, l’acte unique censé être la preuve d’une démocratie vivante. Rien n’est plus faux. Ce n’est pas parce qu’un peuple organise des élections qu’il est sur le chemin de la démocratie. Certains sont présidents à vie, suivez mon regard y compris dans certains fiefs électoraux de notre France.

D’autres modèles existent déjà

Si l’on regarde honnêtement l’histoire de France, en en particulier de la Cinquième République, les exemples sont nombreux où les moyens de formation du peuple à la démocratie ont été étouffés dans l’oeuf. C’est par exemple toute la tragédie de l’éducation populaire, sujet sur lequel je vous laisse la lecture de l’article de Franck Lepage dans Le Monde Diplomatique, De l’éducation populaire à la domestication par la « culture ».

La société n’est pas avare de modèles dits « alternatifs », en réalité, des expériences bien souvent probantes de modèles d’organisation politique qui démontrent les limites de la représentation. Tous ces modèles ont ceci de commun qu’ils remettent explicitement en cause le fonctionnement actuel, et sont bien plus exigeants en matière de probité et d’équité. Démocratie directe, démocratie participative, auto-gestion des entreprises ou des collectifs, partage de connaissances, collaborations techniques, j’en passe et des meilleures. Dans le milieu associatif où j’évolue à mes heures pas perdues pour tout le monde, les solutions collaboratives ne manquent pas non plus. Prendre des décisions stratégiques à plusieurs milliers, y compris sous la forme de référendums permanents, tout cela est rendu possible dans le concept de démocratie liquide, y compris des bases logicielles (plate-formes web, la plupart du temps). La société peut aujourd’hui être conçue comme un gigantesque processeur, une machine à décision ultra rapide, capable de rassembler toutes les voix, en particulier sur des bases de technologies de communication ouvertes. On se réfèrera sur ce point à cet article de Dominik Schiener (trad. fr. sur le Framablog).

Évidemment, l’aristocratie électoraliste n’est pas prête à accepter une remise en cause radicale de ses prérogatives. Les exemples, parfois tragiques, des Zones à Défendre et du militantisme écologique, sont plus qu’éloquents, à tel point que, profitant des libéralités d’un état d’urgence anti-terrorisme, on en vient à faire taire les voix trop bruyantes en plein sommet mondial pour le Climat.

Mais bien plus que les fausses excuses du terrorisme, ce qui caractérise la classe politique, c’est sa crainte de voir le peuple se débarrasser d’elle. Si la démocratie représentative est un modèle qui ne fonctionne plus, le pouvoir n’a plus qu’une seule échapatoire : la violence d’état, qui oppose la classe politique et le peuple (qui se défini alors en opposition à l’aristocratie). Si l’on considère que la représentativité est la seule légitimation de l’ordre public, alors la seule réponse à toute volonté de changement de système, c’est d’imposer un vieux modèle contre un nouveau. C’est selon moi tout le principe des lois scélérates votées récemment (comme la Loi relative au Renseignement…) et dont on voit s’accélérer les tendances, tout spécialement à l’encontre des moyens de communication qui permettent aux citoyens de se faire entendre, d’organiser et planifier l’alternance démocratique.

Après ces dénis de démocratie, les leçons sur le droit de vote sont plus que jamais malvenues. Alors, oui, voilà pourquoi je n’irai pas voter non plus dimanche prochain, et pourquoi je m’emploierai à ma mesure, à l’avènement de solutions vraiment démocratiques.

-

Oui, ici je fais un anachronisme en utilisant ce terme, mais on comprend bien que la paysannerie était exclue de fait, alors même qu’elle représentait alors la grande majorité du peuple. Plus tard, avec la révolution industrielle, ce furent justement les prolétaires qui furent exclus, la voix du peuple étant largement confisquée par les classes bourgeoises capitalistes. Et oui, là, j’ai une lecture marxiste, mais elle en vaut bien une autre. ↩︎

27.11.2015 à 01:00

Sortie trail au Taennchel

C’est déjà vendredi et demain c’est reparti pour un autre tour de trail dans la brume fraîche et humide des Vosges alsaciennes. Il me fallait néanmoins témoigner de ce parcours au Taennchel effectué récemment car il présente de nombreux avantages techniques.

Au dessus de Ribeauvillé, surveillé par ses trois châteaux, on voit poindre le massif du Taennchel, un endroit magnifique avec des rochers aux étranges formes : Rocher des Titans, Rocher des Géants, Rocher des Reptiles… Si l’on sait se laisser bercer par l’atmosphère des lieux, on ne revient pas effrontément d’une visite au Taennchel. La particularité géomorphologique du massif est de présenter une longue crête d’environ 6 kilomètres de la forme d’un « U » entourant le hameau de la Grande Verrerie. Sous la partie Est du massif, on peut aussi admirer le village de Thannenkirsch et, au delà et en face, le château du Haut Koenigsbourg. Quelle que soit la face par laquelle vous abordez ce massif, il faudra compter sur un dénivelé important en peu de kilomètres, ce qui permet d’avoir quelques perspectives intéressantes en matière de technique de montée et de descente sur des sentiers aux morphologies très différentes. Ce massif est d’ailleurs le terrain de jeu de l'Association Sportive Ribeauvillé Athléroute qui organise annuellement les Courses du Taennchel, dont un trail court.

Avec les collègues de l'ASCPA, la sortie du samedi matin nous a conduit en cette contrée. En partant de Ribeauvillé (on peut se garer au niveau du lyçée au nord de la ville), le parcours fait environ 20 km. Il commence et se termine par la montée / descente vers les châteaux St Ulrich et Ribeaupierre (310 m D+). Lors du retour, cette descente est très rocheuse par endroits, presque alpine. La plus grande prudence est de mise surtout avec la fatigue d’une fin de parcours et en particulier sur sol humide. Cependant, c’est un excellent entraînement à renouveler par exemple plusieurs fois sur une boucle plus courte.

Après le sentier des châteaux et un replat aux pieds du Taennchel sur chemin large, c’est vers la Grande Verrerie que l’on se dirige par un sentier en descente régulière et pierreux par endroits, pour remonter en face vers la crête du Taennchel en passant par le Schelmenkopf (380 m D+). C’est le second « coup de cul » à sérieux à supporter sur ce parcours : tout le reste de la crête du Taennchel alterne entre faux plat montant et descendant, ce qui laisse largement le temps d’admirer les lieux (lorsque la météo s’y prête). Une fois dépassé le Rocher des Géants, une longue descente sur sentier régulier s’amorçe jusqu’à l’Abri du Taennchel. Rien de spécialement technique mais attention toutefois aux animaux sauvages : un chevreuil a carrément faille me renverser en passant à 1 m de moi (tous deux lancés en pleine course) ! Magnifique souvenir mais très impressionnant sur le moment.

Les photographies çi-dessous montreront qu’en choisissant ce parcours en plein mois de novembre, ce n’est pas forcément la meilleure saison pour faire un trail touristique. Disons que nous ne nous sommes pas trop attardés à des endroits qui nous auraient incités à ralentir le rythme avec une météo plus clémente.

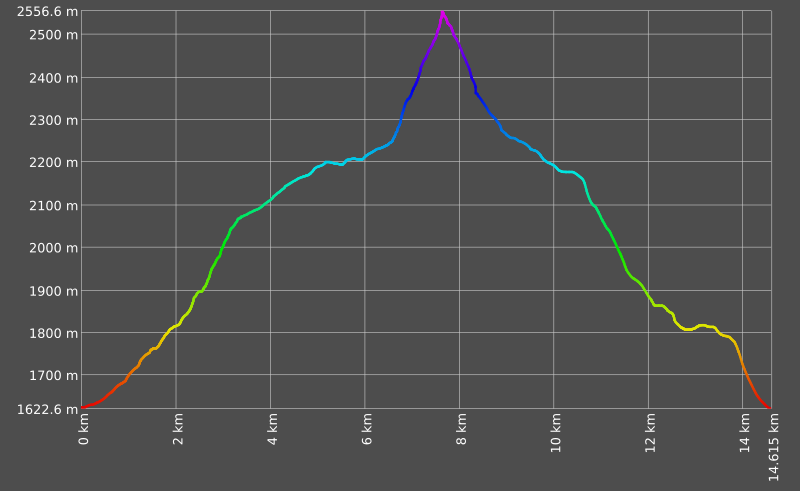

Comme d’habitude, ci-dessous, voici la trace du parcours :

18.11.2015 à 01:00

Alimenter mon dépôt Gitlab

Framasoft a ouvert un service Gitlab très facile d’utilisation. Pour qui ne serait pas encore à l’aise avec Git, voici un petit tutoriel rapide pour alimenter son propre dépôt.

Créer un nouveau dépôt

Un fois son compte créé et configuré (tout se fait en ligne), on peut créer un nouveau dépôt. Ce dernier doit être alimenté en premier par un fichier readme.md c’est à dire un fichier écrit en Markdown. Il est censé décrire le projet, et communiquer régulièrement les principaux changements.

On peut préparer ce fichier readme.md localement en prévision des premières manipulations (ci-dessous).

Générer sa clé SSH

Toutes les connexions sur votre compte Gitlab se feront de préférence de manière chiffrée et authentifiée avec une clé SSH. L’idée est simple : il faut générer une clé SSH, la stocker localement et la recopier dans les paramètres SSH de son compte Gitlab. On peut ajouter autant de clé SSH que l’on souhaite.

Pour générer et stocker une clé SSH

Entrer la commande suivante :

ssh-keygen -t rsa -C "xxxxxxxx"

(remplacer xxxxxxxx par son adresse courriel renseignée dans Gitlab)

La création d’un mot de passe n’est pas obligatoire, mais elle est préférable en tant que sécurité supplémentaire.

Une fois la clé créée, il faut la placer dans son dossier ~\.ssh et la recopier sur son compte Gitlab.

Installer et configurer Git

Après avoir installé Git (sudo apt-get install git), il faut le configurer comme suit :

git config --global user.name "nomutilisateur"

git config --global user.email "adressecourriel"

Premier dépôt

Une fois le dépôt créé via l’interface de Gitlab, on peut travailler localement.

Commencer par cloner le dépôt en local :

git clone git@git.framasoft.org:nomutilisateur/nomdudepot.git

Se rendre dans le dossier du dépôt :

cd nomdudepot

Coller dans ce dossier le readme préparé auparavant (cf. ci-dessus).

Puis ajouter ce fichier dans la file des fichiers que nous allons remonter dans le dépôt :

git add README.md

Annoncer un commit en écrivant un message explicatif :

git commit -m "ajout du fichier readme"

Pousser le tout sur le dépôt :

git push -u origin master

Précéder de la même manière pour tous les autres fichiers. Si l’on souhaite ajouter d’un coup plusieurs fichiers on peut écrire git add fichier1 fichier2 fichier3 etc.

Évidemment il ne s’agit ici que de remonter dans la file principale du projet.

Problème en https

Si l’on veut pousser des gros fichiers en https, on peut tomber sur une erreur de type

error: RPC failed; result=22, HTTP code = 411

fatal: The remote end hung up unexpectedly

C’est en fait parce que la configuration par défaut de Git en http limite à 1Mo la taille maximale des fichiers qu’on peut pousser. Il faut donc configurer Git pour accepter une taille plus importante en entrant une commande idoine :

git config http.postBuffer nombredebytes

où nombredebytes est la taille maximale des fichiers qu’on veut envoyer.

On peut configurer Git de manière globale, ainsi :

git config --global http.postBuffer 524288000

07.09.2015 à 02:00

Trail du Haut Koenigsbourg 2015

J’attendais avec une certaine impatience ce second rendez-vous à Kintzheim pour le trail court du Haut Koenigsbourg. L’engouement ressenti lors de la session de l’année dernière allait-il être encore au rendez-vous ? Et surtout, il faut bien reconnaître que, un an plus tard avec des entraînements réguliers, j’espérais bien diminuer significativement le chrono précédent.

La course

Le nombre de participants n’en fini pas de croître pour ce trail ! De 1664 coureurs en 2014, on est passé à 1900 pour cette session 2015. En voyant les objectifs d’inscrits, j’avais un peu peur que l’équipe d’organisation se laisse dépasser… que nenni ! Ils ont assuré, les bougres. Non seulement l’organisation fut de nouveau exemplaire mais ce n’est plus le seul château du Haut Koenigsbourg qui fut traversé (par le chemin de ronde s’il vous plaît) mais c’est aussi celui de Kintzheim que les coureurs ont pu admirer en fin de parcours.

Dans la fraîcheur matinale et dans les senteurs très caractéristiques à l’approche des vendanges, la ville de Kintzheim avait connu une nuit plutôt agitée, avec les départs des trails de 84 km et 55 km, respectivement à 2:00 et 7:00 du matin. C’est le trail court (25 km) qui, fort de ses 900 participants, contribua sans doute au réveil définitif. Un quart d’heure de retard sur l’horaire prévue s’explique par le succès de l’épreuve. Sur le bitume, les semelles chauffent, on a peur de se refroidir (il fait un peu frais quand même), on se presse, on échange quelques banalités, puis c’est avec un certain soulagement que le départ est finalement donné.

La traversée de la ville n’est pas si rapide, ce qui laisse le temps de se mettre en jambe. On longe la vigne en direction de Châtenois, un point de vue remarquable au soleil levant ferait presque ralentir la cadence pour admirer les belles couleurs d’un paysage typiquement alsacien.

J’aperçois alors Céline, une sympathique coureuse de Kintzheim placée à côté de moi dans la foule du départ et avec qui j’avais échangé quelques mots. Son rythme est régulier, elle connaît le terrain… je me décide à la suivre. Sans le savoir elle me servira de lièvre dans les 5 premiers kilomètres, décisifs sur ce parcours. Si elle passe par ce blog, je lui adresse (de nouveaux) mes chaleureuses salutations ! Nous nous retrouverons au château du Haut Koenigsbourg, kilomètre 16, pour terminer la course presque ensemble.

Sur ce trail, outre les longues montées, il y a deux endroits à appréhender : le premier sentier qui monte au Hahnenberg, où le dépassement est très difficile, et la montée continue aux pieds du Haut Koenigsbourg. J’arrive au premier single avec le net avantage de ne pas être dans le gros du peloton, contrairement à l’année passée. Si bien que la montée se négocie finalement bien avec un rythme agréable. La première descente est très rapide, heureusement, les coureurs sont très espacés et j’en profite pour faire quelques pointes.

Puis tout s’enchaîne sur un rythme plutôt ronflant. Il faut dire – et c’est le principal grief du parcours – que les chemins sont très larges et presque sans aucun obstacle, ce qui instaure une sorte de monotonie. On s’y laisse facilement prendre au risque de ralentir l’allure, ou du moins ne pas adopter celle que l’on aurait dû avoir, dans les limites de ses capacités. Regarder sa vitesse en temps réel sur sa montre est un réflexe qu’il faut parfois savoir prendre. Bref, je n’hésite pas à accélérer un peu en me disant que je pourrai récupérer plus tard, quitte à marcher un peu plus que prévu dans la grande montée.

Ce fut une bonne stratégie, finalement, car c’est lors de cette montée que j’ai du réaliser le meilleur temps par rapport à l’année dernière, tout en modérant l’effort. Je récolte les fruits de mon entraînement estival dans les Alpes. Passé le dernier obstacle de la descente du Haut Koenigsbourg, assez technique par endroits, le reste du parcours s’est déroulé de manière assez rapide. Le grand replat entre les deux montagnes doit se négocier sur la vitesse, sans quoi on y perd vite tous les avantages glanés auparavant.

Le dernier kilomètre, cette année, nous faisait passer au château de Kintzheim. L’intérêt touristique est indéniable, mais l’autre avantage est de nous épargner la longue descente betonnée du parcours précédent. Grâce en soit rendue aux organisateurs : bien que le parcours soit légèrement plus long, c’est bien plus confortable comme cela.

De manière générale, le Trail du Haut koenigsbourg, dans sa version 25 km, est un parcours très rapide. Le premier arrivé est à 1:49 et les derniers à presque 4 heures. Pour ma part, je me situe dans la première moitié (2:46), ce qui fait tout de même 20 minutes de moins que ma performance de 2014, avec 1 km de plus ! Une différence franchement inattendue, mais qui révèle, outre l’entraînement, toute l’importance de faire les bons choix au fil de la course.

Résultats

Classement :

- 32e dans la catégorie Vétérans 1 (sur 51)

- 398e au classement général (sur 839)

- Temps : 2:46:27

- Team : Framasoft

20.08.2015 à 02:00

L'Aiguille Rouge, Névache

Les Alpes, c’est vaste. Si vous cherchez un endroit propice à la randonnée en famille et particulièrement bien situé, je conseille la petite vallée de la Clarée à quelques kilomètres de Briançon, juste à côté de la frontière italienne. Le petit village de Névache est très accueillant et s’organise l’été autour des activités pédestres, lieu de rendez-vous de nombreux randonneurs. On peut notamment saluer le système des navettes qui permettent de ne plus se soucier de sa voiture et emmènent les randonneurs au bout de la vallée, de manière à amorcer de multiples circuits aux paysages admirables.

Entraînement à la vitesse ascensionnelle

Pour le trail, la vallée offre beaucoup d’opportunités et les moyens de se créer des boucles sympathiques avec plusieurs pics, crêtes et lacs facilement accessibles. Le conseil est évidemment de partir de très bonne heure le matin. Inutile de préciser que le soleil a tendance à plomber en journée et que les variantes du GR 5 autour de la vallée se peuplent relativement vite à partir de 9h00.

Pour la quatrième fois que je séjourne dans cette vallée, ce fut une première pour l’entraînement au trail, habitué que je suis aux chemins des Vosges. Alternant entre randonnée et repos estival, je me suis réservé 2 à 2,5 heures de course un jour sur deux, au départ du hameau de Roubion, commune de Névache. Un rythme tout à fait ronflant mais néanmoins régulier qui m’a permit de travailler sérieusement ma technique de montée sans me fatiguer outre mesure (c’est les vacances, après tout).

Le circuit de l’Aiguille Rouge, que je présente ci-dessous, est à la fois touristique et technique. Premièrement, le fait de monter sur une aiguille n’est selon moi pas vraiment intéressant du point de vue de l’entraînement au trail : le paysage est magnifique mais les derniers mètres de dénivelés en montée comme en descente se font avant tout dans le calme en faisant bien attention où l’on pose ses pieds. Néanmoins, on cumule ainsi quelques 1000 m D+ en un minimum de kilomètres, là où, dans les Vosges, il faudrait systématiquement allonger le parcours d’au moins 5 kilomètres pour obtenir le même dénivelé positif. C’est l’avantage de la haute montagne ; par ailleurs, n’importe quel parcours peut se faire sur des très jolis sentiers en évitant les larges et longs chemins forestiers parfois interminables des Vosges. Deuxièmement, ce parcours concentre en un seul coup tous les paysages que l’on trouve dans le briançonnais : si vous n’êtes que rapidement de passage dans le coin, sachez que ce circuit peut se faire en famille pour une randonnée de niveau facile (le sommet de l’Aiguille Rouge est accessible pour des enfants à partir de 12 ans, mais attention à la fréquentation : il peut y avoir beaucoup de monde en journée).

Le parcours

Tout le parcours peut se faire sans carte : les chemins sont très bien indiqués (c’est le cas partout dans la région) et la navigation peut se faire à vue dans ce cas précis. Si, à un moment donné, vous apercevez des pancartes écrites en italien, c’est que vous êtes descendu du mauvais côté !

Au départ du hameau de Roubion, il faut emprunter le GR en direction du col des Thures. On profite ainsi de la fraîcheur (ou de l’abri, en cas de pluie) de la forêt de mélèzes sur toute la combe que l’on remonte à côté du ruisseau (ou torrent, selon la météo !). Cette fraîcheur sera particulièrement appréciable car le chemin monte de manière très régulière, d’abord faiblement puis de plus en plus rapidement sans toutefois offrir de raidillon obligeant à casser le rythme. Il est dès lors possible de moduler sa vitesse pour ne pas avoir à marcher. C’est la partie la plus intéressante du point de vue de l’endurance et, techniquement, elle offre deux à trois petits replats qui permettent de reprendre son souffle.

Arrivé à la fin de cette première partie d’environ 3.5 km, beaucoup de sueur a déjà coulé mais on a encore de la réserve pour amorcer la prairie du magnifique vallon des Thures qui s’offre alors, avec la cabane du berger des Thures et sa fontaine. Sur un peu moins de 2 km on longe l’Aiguille Rouge à droite pour arriver au lac Chavillon à travers le pré. On ne manquera pas de regarder attentivement à droite, à mi-côte de l’Aiguille Rouge, le chemin qui part du lac, c’est lui qu’il faut alors emprunter pour amorcer la montée de l’Aiguille, sans toutefois le confondre avec quelques traces qui longent la crête, plus en amont : elle mènent au même endroit mais sont beaucoup moins confortables pour le trail.

Arrivé à peu près en amont de la cabane du berger, on rejoint le chemin « normal » qui monte à l’Aiguille en provenance du col de l’Échelle au niveau de la courbe de dénivelé des 2340 m. Il suffit ensuite de poursuivre jusqu’au sommet où seuls les derniers mètres se négocient avec prudence.

En haut, il est temps de stopper sa montre et apprécier le paysage, avec, respectivement :

- Au Nord-nord-Ouest, le majestueux Mont Thabor,

- Au Nord, les trois pointes italiennes Balthazard, Melchior et Gaspard,

- Au Nord-Est, une vue sur les pistes de ski alpin de Bardonecchia

- À l’Est, en bas, le col de l’Échelle,

- Au Sud-Est, la vallée de la Clarée vers Plampinet,

- Au Sud, en bas, le hameau de Roubion.

La descente se fera dans le prolongement vers le col de l’Échelle jusqu’à croiser le GR (une pancarte rustique en bois indique la direction des Granges de la Vallée Étroite, qu’il faut suivre jusqu’au-dessus du Roubion). La descente vers le Roubion se fait par le chemin auparavant emprunté à ceci près que, environ 300 m après avoir franchi le ruisseau, un petit sentier (ouvrez l’œil) vers la droite permet, en quittant le GR, d’aller dans la combe du Roubion pour rejoindre le circuit dit des « balcons de Névache ». C’est une variante que l’on peut emprunter jusque Névache Ville Haute (à environ 4 km par ce chemin) ou couper à quelques endroits (indiqués) pour rejoindre le hameau de Sallé ou Névache Ville Basse. Le parcours ci-dessous coupe au plus court pour rejoindre le Roubion, ce qui porte ce tracé à 14,5 km pour environ 1000 m D+.

24.07.2015 à 02:00

Un aperçu de Pandoc

Dans un billet précédent, je parlais des avantages du Markdown dans les processus de conversion vers des formats de sortie comme HTML et LaTeX. Il se trouve que Massimiliano Dominici, passé maître dans l’usage de Pandoc, a publié en 2013 un article remarquable focalisant justement sur les fonctionnalités de Pandoc du point de vue des objectifs de publication HTML et LaTeX (PDF).

Présentation

Avec l’autorisation de l’auteur, je propose une traduction française de cet article qui ne manquera pas d’intéresser ceux qui hésitent encore à franchir le pas de la ligne de commande avec Pandoc ou tout simplement ceux qui ne connaissent pas encore ce logiciel.

Cet article de Massimiliano Dominici est paru sous le titre « An overview of Pandoc », TUGboat 35:1, 2014, pp. 44-50. Originellement publié sous « Una panoramica su Pandoc », ArsTEXnica 15, avril 2013, pp. 31-38. Traduction de l’anglais par Christophe Masutti, avec l’aimable autorisation de l’auteur. Licence du document : CC By-Sa.

Vous trouverez sur ce dépôt GIT les sources qui ont servi à la composition et à la compilation du document, en utilisant Pandoc’s Markdown. Il est possible de télécharger directement la version PDF. Le fichier README.md contient les lignes de commandes destinées aux sorties voulues.

Comment compiler ce document ?

Pour une sortie LaTeX, avec le template LaTeX (ne pas oublier d’installer pandoc-citeproc) :

$pandoc --listings --bibliography=biblio.bib --biblatex metadata.yaml --number-sections -s --template=modele.latex --toc source.markdown -o sortie.tex

Pour la sortie PDF :

$pdflatex sortie.tex

$biber sortie

$pdflatex sortie.tex

Pour la sortie HTML :

$pandoc -s -S --toc --template=modele.html -H style.css --number-sections --bibliography=biblio.bib metadata.yaml source.markdown -o sortie.html

- Persos A à L

- Carmine

- Mona CHOLLET

- Anna COLIN-LEBEDEV

- Julien DEVAUREIX

- Cory DOCTOROW

- Lionel DRICOT (PLOUM)

- EDUC.POP.FR

- Marc ENDEWELD

- Michel GOYA

- Hubert GUILLAUD

- Gérard FILOCHE

- Alain GRANDJEAN

- Hacking-Social

- Samuel HAYAT

- Dana HILLIOT

- François HOUSTE

- Tagrawla INEQQIQI

- Infiltrés (les)

- Clément JEANNEAU

- Paul JORION

- Michel LEPESANT

- Persos M à Z

- Henri MALER

- Christophe MASUTTI

- Jean-Luc MÉLENCHON

- MONDE DIPLO (Blogs persos)

- Richard MONVOISIN

- Corinne MOREL-DARLEUX

- Timothée PARRIQUE

- Thomas PIKETTY

- VisionsCarto

- Yannis YOULOUNTAS

- Michaël ZEMMOUR

- LePartisan.info

- Numérique

- Blog Binaire

- Christophe DESCHAMPS

- Louis DERRAC

- Olivier ERTZSCHEID

- Olivier EZRATY

- Framablog

- Romain LECLAIRE

- Tristan NITOT

- Francis PISANI

- Irénée RÉGNAULD

- Nicolas VIVANT

- Collectifs

- Arguments

- Blogs Mediapart

- Bondy Blog

- Dérivation

- Économistes Atterrés

- Dissidences

- Mr Mondialisation

- Palim Psao

- Paris-Luttes.info

- ROJAVA Info

- Créatifs / Art / Fiction

- Nicole ESTEROLLE

- Julien HERVIEUX

- Alessandro PIGNOCCHI

- Laura VAZQUEZ

- XKCD