ACCÈS LIBRE UNE Politique International Environnement Technologies Culture

19.05.2024 à 19:16

« Pretty privilege » : faites-vous plus confiance à quelqu’un que vous trouvez beau ?

Astrid Hopfensitz, Professor in organizational behavior, EM Lyon Business School

Texte intégral (1994 mots)

Ce qui fait la beauté d’une personne fascine les artistes et les scientifiques depuis des siècles. La beauté n’est pas, comme on le croit souvent, « dans l’œil de celui qui regarde », mais suit bel et bien des règles prévisibles. La symétrie et les proportions jouent un rôle dans ce que l’on considère comme beau, et bien que la culture et les normes façonnent notre perception de la beauté, les chercheurs observent un large consensus sur les personnes qui sont considérées comme belles par la plupart des gens.

Il n’est donc pas surprenant que le marché de la beauté soit en constante augmentation (à l’exception d’une petite baisse en 2020, liée à la pandémie de Covid), atteignant 430 milliards de dollars de revenus en 2023, selon un récent rapport de McKinsey. La fascination pour le maquillage ou les soins cosmétiques est alimentée par l’image des visages « parfaits » qui pullulent sur les médias sociaux, artificiellement améliorés par le traitement d’image et les filtres. Mais tout cet argent est-il dépensé à bon escient ?

Privilège de la beauté

Pour le dire vite : oui. Dans le contexte actuel de concurrence acharnée sur le marché du travail, les avantages économiques liés à la beauté sont indéniables. De nombreuses études ont montré que les personnes séduisantes bénéficient d’un bonus et gagnent mieux leur vie en moyenne. Certaines professions bien rémunérées sont construites autour de la beauté (comme le show-business), mais ce qui est plus surprenant, c’est que pour presque n’importe quel type d’emploi, la beauté peut entraîner un effet de halo positif. On s’attend à ce que les personnes perçues comme belles soient plus intelligentes et elles sont considérées comme de meilleurs leaders, ce qui influe sur les trajectoires et les opportunités de carrière.

[Déjà plus de 120 000 abonnements aux newsletters The Conversation. Et vous ? Abonnez-vous aujourd’hui pour mieux comprendre les grands enjeux du monde.]

Les personnes perçues comme belles seraient également plus susceptibles de bénéficier de la confiance des gens, ce qui leur permet d’obtenir plus facilement une promotion ou de conclure des accords commerciaux. Les personnes à l’apparence agréable sont supposées être en meilleure santé et/ou avoir eu des interactions sociales plus positives dans leur passé, ce qui peut influencer leur fiabilité aux yeux des autres.

Est-ce que le fait d’être séduisant rend plus digne de confiance ?

Mais cette théorie tient-elle la route ? Dans notre récent article, Adam Zylbersztejn, Zakaria Babutsidze, Nobuyuki Hanaki et moi-même avons cherché à le savoir. Dans des études antérieures, on présentait différents portraits à des observateurs et on leur demandait ce qu’ils pensaient de ces personnes. Cependant, ces images étaient souvent tirées de bases de données de portraits ou même générées par ordinateur, ce qui permet aux chercheurs d’étudier les perceptions, mais pas de savoir si ces croyances sont exactes. Pour le savoir, nous avons dû mettre au point un paradigme expérimental dans lequel nous pouvions observer la fiabilité de différentes personnes, prendre des photos d’elles et, plus tard, présenter ces photos à d’autres personnes pour qu’elles les évaluent. Voici comment nous avons procédé.

Comprenant un total de 357 volontaires, notre étude a débuté à Paris en octobre 2019, où nous avons demandé à un premier groupe de 76 volontaires de participer à une courte expérience sur la prise de décision. Dans le cadre de l’étude, les participants ont été répartis en paires de manière aléatoire, sans savoir avec qui ils jouaient. Certains jouaient un rôle qui nécessitait de faire confiance à un autre individu (groupe A), tandis que d’autres étaient en position de rendre la pareille ou de rompre la confiance qu’ils avaient reçue (groupe B), sachant qu’ils gagnaient toujours plus en rompant la confiance. Pour augmenter les enjeux, de l’argent réel était mis sur la table.

Les participants du groupe A pouvaient gagner jusqu’à 12 euros, mais seulement s’ils faisaient confiance à l’autre joueur. Pour ce faire, ils se sont vus présenter le scénario de choix abstrait expliqué ci-dessous, alors qu’ils étaient assis individuellement dans une cabine.

S’ils décidaient de ne pas faire confiance, ils étaient sûrs de recevoir un maigre paiement de 5 euros pour leur participation à l’étude. En revanche, lorsqu’un joueur A décidait de faire confiance à son partenaire B, son sort était entre les mains du joueur B. Ce dernier pouvait alors agir de manière à être digne de confiance en lançant un dé qui promettait de générer un gain de 12 euros pour le joueur A, ou de manière indigne de confiance en réclamant une récompense de 14 euros pour lui-même et en ne laissant rien au joueur A.

Ce type de jeu (appelé « jeu d’action cachée ») a déjà été développé pour mesurer l’attitude de confiance désintéressée des individus.

Il se déroulait comme suit : dans un premier temps, le joueur A devait choisir de faire confiance au joueur B (en disant « à droite ») ou de ne pas lui faire confiance (en disant « à gauche »). Dans un deuxième temps, le joueur B devait décider s’il lançait un dé ou non.

Le gain de chaque joueur dépend donc de ses propres actions et/ou des actions de l’autre joueur :

Si le joueur A choisit « à gauche » (ne pas faire confiance), quel que soit le choix du joueur B :

- le joueur A et le joueur B reçoivent tous deux un gain de 5 euros ;

Si le joueur A choisit « à droite » (faire confiance) et que le joueur B choisit « Ne pas lancer » :

- le joueur A ne reçoit rien et le joueur B reçoit 14 euros ;

Si le joueur A choisit « à droite » (faire confiance) et le joueur B choisit « Lancer » :

- Lorsque le chiffre du dé est compris entre 1 et 5, le joueur A reçoit 12 euros et le joueur B 10 euros ;

- Lorsque le chiffre du dé est 6, le joueur A ne reçoit rien et le joueur B reçoit 10 euros.

Nous avons non seulement observé comment les participants agissaient dans ce jeu, mais nous avons également pris des photos d’eux avec une expression neutre, avant qu’ils ne soient initiés à la tâche. Ces photos ont été présentées à 178 participants recrutés à Lyon. Nous nous sommes d’abord assurés qu’aucun de ces individus ne se connaissait. Nous avons ensuite donné aux participants de Lyon la tâche d’essayer de prédire comment la personne qu’ils voyaient sur la photo se comportait dans le jeu. S’ils tombaient juste, ils étaient récompensés en gagnant plus d’argent pour leur participation. Enfin, nous avons montré les mêmes photos à un troisième groupe de 103 personnes de Nice, dans le sud de la France. Ces personnes ont été invitées à évaluer la beauté des visages figurant sur les photos.

Le genre entre-t-il en ligne de compte ?

Nos résultats confirment que les personnes considérées comme plus belles par nos évaluateurs sont également jugées beaucoup plus dignes de confiance. Cela implique que dans notre échange économique abstrait, les personnes belles sont plus susceptibles de bénéficier de la confiance des autres. Toutefois, lorsque nous étudions les comportements réels, nous constatons que les belles personnes ne sont ni plus ni moins dignes de confiance que les autres. En d’autres termes, la confiance dépend des bonnes vieilles valeurs individuelles et de la personnalité, qui ne sont pas liées à l’apparence d’une personne.

Une prime à la beauté a déjà été observée aussi bien pour les hommes que pour les femmes. On pourrait toutefois penser que les femmes, dont on pense généralement qu’elles ont un degré d’intelligence sociale plus élevé, sont plus à même de déterminer la fiabilité de leur partenaire. Nos résultats ne le démontrent pas. Les femmes sont en moyenne jugées plus belles et jugent également les autres plus beaux. Cependant, les femmes n’agissent pas de manière plus honorable que les hommes dans le jeu. Enfin, les hommes et les femmes s’accordent sur leurs attentes quant à savoir qui sera digne de confiance ou non, et les femmes ne sont donc pas meilleures que les hommes pour prédire les comportements.

Les personnes perçues comme « belles » sont-elles plus méfiantes à l’égard de leurs semblables ?

L’adage selon lequel « tout ce qui brille n’est pas or » s’applique donc également à la beauté chez les humains. Cependant, on peut se demander qui est le plus susceptible d’être victime de ce biais. On pourrait penser que les personnes qui sont elles-mêmes souvent traitées favorablement en raison de leur apparence sont conscientes qu’il ne faut pas se fier à cette impression, qui résulte d’un biais d’appréciation.

Nous avons conçu notre étude de manière à pouvoir également étudier cette question. Plus précisément, les participants que nous avons recrutés à Lyon pour faire leurs prédictions ont également été pris en photo. Nous savions donc à quel point ils étaient influencés par l’apparence des autres, mais aussi à quel point ils étaient eux-mêmes conventionnellement beaux. Nos résultats sont clairs. Le biais de beauté existe pour tout le monde. Alors que nous pourrions penser que ceux qui bénéficient d’une belle apparence peuvent voir derrière le masque, ils sont tout autant influencés par l’apparence des autres lorsqu’ils décident à qui faire confiance.

L’industrie de la beauté a donc raison. Investir dans la beauté en vaut vraiment la peine, car cela apporte des avantages réels. Toutefois, les recruteurs ou les managers doivent se garder de se laisser abuser. Une façon de le faire est de rendre les CV anonymes et d’interdire les photos dans les candidatures. Mais dans de nombreuses interactions, nous devons décider d’accorder ou non notre confiance. Il est donc essentiel d’être conscient de ses propres biais. Nos résultats soulignent que ce biais est très difficile à surmonter, puisque même les personnes qui, de par leur propre expérience, devraient être conscientes du biais de jugement que confère la beauté en sont victimes.

Astrid Hopfensitz ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

19.05.2024 à 19:11

La géo-ingénierie, un enjeu géopolitique ? Pour les pays en surchauffe, la tentation de modifier le climat

Ben Kravitz, Assistant Professor of Earth and Atmospheric Sciences, Indiana University

Tyler Felgenhauer, Research Scientist in Civil and Environmental Engineering, Duke University

Texte intégral (2704 mots)

L’emblématique accord de Paris sur le climat a donné naissance à un nouveau slogan dans les pays en développement : « 1,5 pour rester en vie ». Il se réfère à l’objectif international de maintenir le réchauffement climatique en dessous de 1,5 °C par rapport à l’ère préindustrielle. Mais le monde dépassera probablement ce seuil d’ici une décennie, et le réchauffement climatique ne montre que peu de signes de ralentissement.

Le monde est déjà confronté à des catastrophes naturelles qui prennent des proportions épiques en raison de l’augmentation des températures. Les records de chaleur sont régulièrement battus. Les saisons des feux de forêt sont de plus en plus extrêmes. La violence des ouragans augmente. L’élévation du niveau de la mer, enfin, submerge lentement les petites nations insulaires et les zones côtières.

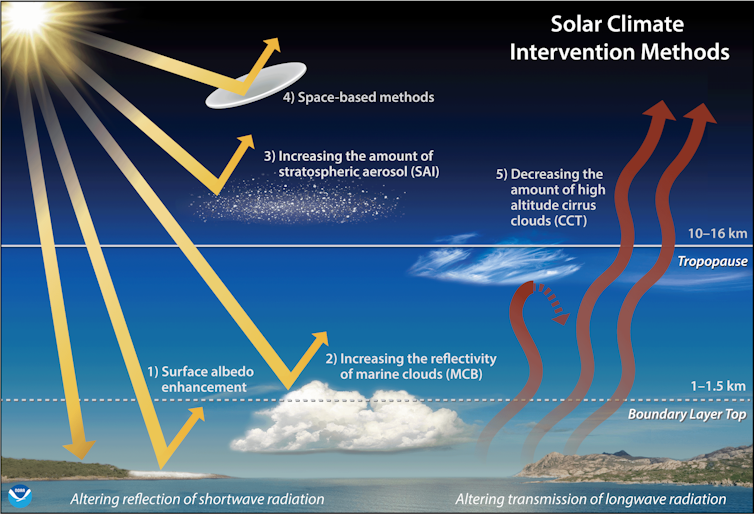

La seule méthode connue pour arrêter à court terme cette hausse des températures est l’ingénierie climatique. Elle recoupe des techniques appartenant à la géo-ingénierie. Certaines permettent de réduire artificiellement l’ensoleillement, ce qui est aussi connu sous le nom d’interventions solaires sur le climat. Il s’agit d’un ensemble d’actions visant à modifier délibérément le climat.

L’intention est d’imiter l’effet refroidissant des grandes éruptions volcaniques historiques, soit en plaçant dans l’atmosphère de grandes quantités de particules réfléchissantes, soit en éclaircissant les nuages bas au-dessus de l’océan. Ces deux stratégies permettraient de renvoyer une petite partie de la lumière du soleil vers l’espace afin de refroidir la planète.

De nombreuses questions restent toutefois sans réponse quant aux effets d’une modification délibérée du climat. Est-ce une bonne idée de seulement se poser la question ? Il n’y a pas de consensus scientifique.

L’une des principales préoccupations de nombreux pays en matière de changement climatique est la sécurité nationale. Il ne s’agit pas seulement de guerres : les risques pour l’approvisionnement en nourriture, en énergie et en eau sont des questions de sécurité nationale, tout comme les migrations humaines provoquées par le climat.

L’ingénierie climatique pourrait-elle contribuer à réduire les risques du changement climatique pour la sécurité nationale, ou au contraire aggraverait-elle la situation ? Répondre à cette question n’est pas simple, mais les chercheurs qui, comme nous, étudient les liens entre changement climatique et sécurité nationale ont quelques idées sur les risques à venir.

Le changement climatique, un problème majeur

Pour comprendre à quoi pourrait ressembler l’ingénierie climatique à l’avenir, examinons d’abord les raisons pour lesquelles un pays pourrait vouloir l’essayer.

Depuis la révolution industrielle, l’homme a rejeté environ 1 740 milliards de tonnes de dioxyde de carbone (CO₂) dans l’atmosphère, principalement en brûlant des combustibles fossiles. Ce dioxyde de carbone emprisonne la chaleur et réchauffe la planète.

L’une des choses les plus importantes que nous puissions faire est de cesser de rejeter du carbone dans l’atmosphère. Mais la situation ne s’améliorera pas rapidement, car le CO2 met des siècles à être éliminé de l’atmosphère. La réduction des émissions ne fera qu’empêcher la situation de s’aggraver davantage.

Les pays pourraient extraire le dioxyde de carbone de l’atmosphère et le confiner quelque part, processus appelé élimination du dioxyde de carbone (en anglais, Carbon Dioxyde Removal, ou CDR). À l’heure actuelle, les projets d’élimination du dioxyde de carbone, notamment le fait de planter ou replanter des arbres et les dispositifs de capture directe du CO₂ de l’air, permettent de retirer de l’atmosphère environ 2 milliards de tonnes de CO₂ par an.

À lire aussi : La capture et le stockage du carbone, comment ça marche ?

Mais l’humanité rejette actuellement dans l’atmosphère plus de 37 milliards de tonnes de CO₂ par an du fait de la consommation de combustibles fossiles et des activités industrielles. Tant que la quantité de CO2 ajoutée dans l’atmosphère sera supérieure à la quantité éliminée, les sécheresses, les inondations, les ouragans, les vagues de chaleur et l’élévation du niveau de la mer, parmi les nombreuses autres conséquences du changement climatique, continueront de s’aggraver.

Il faudra sans doute beaucoup de temps pour réduire à zéro nos émissions nettes de CO2, c’est-à-dire pour ne plus augmenter les concentrations de gaz à effet de serre dans l’atmosphère. L’ingénierie climatique pourrait être utile dans cet intervalle.

À lire aussi : Éliminer le CO₂ grâce au puits de carbone océanique, une bonne idée ?

Qui veut s’essayer à l’ingénierie climatique ?

Différents organismes de recherche gouvernementaux dans élaborent déjà des scénarios examinant qui pourrait décider de mettre en œuvre l’ingénierie climatique et comment.

L’ingénierie climatique devrait être peu onéreuse par rapport au coût que représente l’élimination des émissions de gaz à effet de serre. Mais il faudrait tout de même des milliards de dollars et des années de développement et de fabrication pour obtenir une flotte d’avions capable de transporter, chaque année, des mégatonnes de particules réfléchissantes dans la stratosphère. Tout milliardaire envisageant une telle entreprise se retrouverait rapidement à court d’argent, en dépit de ce que la science-fiction pourrait suggérer.

Malgré tout, un seul pays ou une coalition de pays constatant les effets néfastes du changement climatique pourrait faire un calcul géopolitique et financier. Et décider de mettre en place des pratiques d’ingénierie climatique de sa propre initiative.

À lire aussi : Inondations à Dubaï : des orages trop violents pour être causés par l’ensemencement des nuages

C’est ce que l’on appelle le problème du « free driver », c’est-à-dire que si le coût de ces technologies n’est pas prohibitif, un pays moyennement riche pourrait décider unilatéralement de modifie le climat de la planète.

Par exemple, les pays confrontés à des vagues de chaleur de plus en plus dangereuses pourraient vouloir provoquer un refroidissement du climat.

Les pays qui dépendent des précipitations de la mousson pourraient vouloir rétablir une certaine fiabilité que le changement climatique a perturbée.

L’Australie étudie actuellement la possibilité de refroidir rapidement la Grande Barrière de Corail pour éviter sa disparition.

La création de risques pour les pays voisins

Sauf que le climat ne respecte pas les frontières nationales. Ainsi, un projet d’ingénierie climatique dans un pays serait susceptible d’affecter les températures et les précipitations dans les pays voisins. Cela pourrait être une bonne ou une mauvaise chose pour les cultures, l’approvisionnement en eau et les risques d’inondation. Cela pourrait également avoir des conséquences inattendues à large échelle.

Certaines études montrent qu’un niveau modéré d’ingénierie climatique aurait probablement des effets bénéfiques à grande échelle quant au changement climatique. Mais tous les pays ne seraient pas affectés de la même manière.

[Déjà plus de 120 000 abonnements aux newsletters The Conversation. Et vous ? Abonnez-vous aujourd’hui pour mieux comprendre les grands enjeux du monde.]

Une fois les mesures d’ingénierie climatique déployées, les pays pourraient également être plus enclins d’accuser la géo-ingénierie d’être à l’origine des événements extrêmes tels que les ouragans, les inondations et les sécheresses, quelles que soient les preuves.

L’ingénierie climatique peut déclencher des conflits entre les pays, conduisant à des sanctions et à des demandes de compensation. Le changement climatique peut rendre les régions les plus pauvres plus vulnérables encore, et l’ingénierie climatique ne devrait pas exacerber ces dommages. Certains pays, en bénéficiant de l’ingénierie climatique, seraient plus résilients face aux conflits géopolitiques, tandis que d’autres seraient lésés – et d’autant plus vulnérables.

Certes, des expériences de faible échelle ont été menées, mais personne n’a encore pratiqué l’ingénierie climatique à vaste échelle. Cela signifie que beaucoup d’informations sur ses effets reposent sur des modèles climatiques. Or, si ces modèles sont d’excellents outils pour étudier le climat, ils ne permettent pas de répondre aux questions liées à la géopolitique et aux conflits. En outre, les effets physiques des mesures d’ingénierie climatique dépendraient aussi pour beaucoup de l’approche utilisée.

La prochaine étape

Pour l’instant, l’ingénierie climatique suscite plus de questions que de réponses. Il est difficile de dire si l’ingénierie climatique risque d’aggraver les conflits ou si elle pourrait désamorcer certaines tensions internationales en réduisant le changement climatique.

Il est toutefois probable que des décisions internationales sur l’ingénierie climatique seront bientôt prises. Lors de l’Assemblée des Nations unies pour l’environnement de mars 2024, les pays africains ont demandé un moratoire sur l’ingénierie climatique, appelant à la prudence. D’autres nations, dont les États-Unis, ont insisté pour qu’un groupe formel de scientifiques étudie les risques et les avantages de ces technologies avant de prendre toute décision.

L’ingénierie climatique pourrait faire partie d’une solution équitable au changement climatique. Mais elle comporte aussi des risques. En résumé, l’ingénierie climatique ne saurait être ignorée, mais des recherches supplémentaires sont nécessaires pour que les décideurs politiques puissent prendre des décisions en connaissance de cause.

Ben Kravitz a reçu des financements de la National Oceanographic and Atmospheric Administration (NOAA) américaine et de la National Science Foundation américaine.

Tyler Felgenhauer a reçu des financements de la National Science Foundation américaine et de Resources for the Future.

19.05.2024 à 19:10

Sciences Po : comment la crise dépolitise la parole étudiante ?

Olivier Akhamlich, Doctorant Sciences de l'Education et de la Formation, Université de Bordeaux

Texte intégral (2041 mots)

Le 7 mai 2024, une altercation survient devant Sciences Po Paris entre François-Xavier Bellamy (LR) et Louis Boyard (LFI). S’écharpant dans la tradition des logiques stratégique et politique, cette rencontre s’est inscrite dans le contexte de mobilisation étudiante à Sciences Po, rassemblés contre les attaques d’Israël sur les civils à Gaza. Mais cet « énième numéro de politique spectacle », semble surtout avoir pour conséquence une relative mise à l’écart et dépolitisation de la parole des étudiants.

Le 12 mars 2024, une occupation est lancée dans un amphithéâtre à Sciences Po Paris par le comité Palestine pour protester contre l’intervention de Tsahal à Gaza, et pour boycotter les partenariats entre Sciences Po et des universités israéliennes supportant l’armée israélienne.

Une polémique éclate suite à un témoignage d’une étudiante déclarant avoir été empêchée, pour raison antisémite, d’entrer dans l’amphithéâtre occupé. Les enquêtes administrative et pénale détermineront ce qui en a été réellement. Cet événement a déclenché un ensemble de réactions politiques et médiatiques.

Or la plupart de ces commentaires à chaud semblent ignorer les revendications politiques des étudiants.

Comme l’indique le chercheur Éric Darras :

« Politiser c’est généraliser. Dépolitiser c’est minimiser, minorer. […] Politiser c’est défataliser. Dépolitiser c’est essentialiser. »

Politiser, rendre politique, est une manière d’observer, de constater différents faits et de les désingulariser en les portant de façon plus générale à la connaissance de toutes et tous. À l’inverse, singulariser, dépolitiser c’est, d’une certaine façon, rendre obscur un fait ou un propos et, ainsi, de le soustraire à l’intérêt général. Politiser est l’affaire de toutes et tous.

Ce qui devient politique est de l’affaire de toutes et tous dans un souci de solidarité, de collectif, d’unité : ce qui porte à l’intérêt général. Or, nous observons que les réactions à n’en plus finir des politiques sont constitutives d’une manière de détourner la politique vers la polémique et ainsi produire une dépolitisation des revendications portées par les étudiants.

À lire aussi : Mouvement étudiant pour Gaza : entre mobilisation et polémiques

Jeunesses et politiques : les désunions

Les jeunes et la jeunesse ont été régulièrement mis à l’écart des considérations politiques. À ne pas considérer la jeunesse dans la politique et dans les politiques, le lien de confiance s’érode et la défiance à l’égard de la politique, de façon générale, se met en place. Il est aisé de méconsidérer la jeunesse sans jamais prendre le temps de s’y intéresser et de l’écouter sérieusement comme le relate la journaliste Salomé Saqué.

Alors même que la jeunesse est de plus en politisée au fil des décennies depuis les années 70-80, cette dernière se sent de moins en moins représentée, entendue et prise en compte. La succession des crises qui impacte les jeunesses et ne suscite que peu de réactions des politiques dans la mise en place de politiques publiques n’a fait qu’accroître un rejet et une défiance.

[Déjà plus de 120 000 abonnements aux newsletters The Conversation. Et vous ? Abonnez-vous aujourd’hui pour mieux comprendre les grands enjeux du monde.]

La dégradation des conditions de vie de façon générale a progressivement amené une partie de la jeunesse vers une augmentation de l’abstention et une polarisation des votes où l’adhésion idéologique tend vers les extrêmes (entre la droite et la gauche). De même, ne constatant que peu de réactions de la part de la classe politique face aux revendications de la jeunesse, cette dernière tend à méconsidérer la politique institutionnelle pour son supposé hermétisme.

Comme l’écrivait Luc Rouban, en 2022, « c’est bien le sentiment d’une distance sociale avec les élites dirigeantes qui nourrit cette défiance » (p.21).

Cette négation de la jeunesse et de sa contribution indéniable à la société est partie prenante d’un dénigrement. Ce dernier vient à considérer que les jeunes seraient une sorte d’entité sujette à ses émotions, ses passions et qui aurait, par la même occasion, de grandes difficultés à être alors raisonnable parce que trop émotive.

Politique du mépris ?

À considérer la jeunesse de manière péjorative par différents qualificatifs emprunts de mépris tels que : « wokistes », « gauchistes », « islamo-bobos », etc. ; de manière indistincte et particulièrement caricaturale, notamment dans le cas de l’occupation d’un amphithéâtre à Sciences Po, les politiques participent au dénigrement des étudiants et peut-être in fine des études.

Certains politiques et médias pointent les institutions d’enseignement supérieur comme étant des laboratoires de thèses antirépublicaines et antidémocratiques par le « wokisme », voire même de « bunker islamo-gauchistes »“.

En faisant des étudiants des épouvantails, leurs détracteurs les « excommunient » de la citoyenneté. Cette forme d’anathème vient nier le pourquoi des actions. Elle dépolitise une mobilisation politique et jette l’opprobre, comme l’a démontré de façon particulièrement étayée, Olivier Beaud, sur les professions intellectuelles et les études.

L’intervention du premier ministre, Gabriel Attal, et de la ministre de l’Enseignement supérieur et de la Recherche, Sylvie Retailleau, semble représenter des modérateurs moralisants d’une institution qui paraîtrait être à la dérive. Gabriel Attal indiquait, seulement quelques heures après l’événement, que « le poisson pourri par la tête » comme le rappelle Sonia Devillers.

Un « intérêt excessif » ?

Comme l’évoque Laurence Bertrand Dorléac, présidente de la Fondation nationale des sciences politiques, institution qui gère les orientations stratégiques et administratives de Sciences Po, lors de son audition au Sénat le 20 mars 2024, les événements survenus à Sciences Po ont probablement suscité un « intérêt excessif » porté par les médias « et par conséquent par l’opinion publique ».

Madame Bertrand Dorléac rappelle « qu’aucun autre établissement universitaire français n’a suscité autant d’articles de presse et de tweets » tout en précisant que d’autres établissements ont été traversés par des événements similaires sans avoir connu les mêmes conséquences médiatiques et politiques. Pourtant, la liberté académique semble reculer dans de nombreux pays sans susciter autant de remous au niveau politique et médiatique.

En présentant les étudiants comme étant des individus hors de contrôle et les dirigeants d’établissement d’enseignement supérieur comme soupçonnés de défaillances, les politiciens présentent ces derniers alors comme irresponsables, irraisonnables et inaptes à l’exercice même de la politique. L’exercice de la politique, ici, est entendu comme la possibilité de participer pleinement en tant que citoyen et citoyenne aux débats publics ; émettre des doutes, propositions, actions, objections, contradictions par exemple. Par cette polémique, les politiciens réaffirment l’illusion de la politique comme raison défaite de ses émotions. Or, les recherches montrent que c’est tout le contraire : sans émotion et sans conflit, la politique ne serait que dépolitisée.

Dépolitiser les étudiants : une stratégie politique ?

Les revendications premières des étudiants sont la révision des partenariats de l’institution avec des universités israéliennes, une solution à deux États, un arrêt immédiat du déploiement de l’intervention de Tsahal sur Gaza, un arrêt de la politique coloniale israélienne en violation de nombreuses résolutions à l’ONU, etc.

Quelques personnels se sont joints et ont proposé des débats quand, en même temps, d’autres se désintéressent, voire usent de propos désobligeants, en direction des étudiants et de la mobilisation étudiante.

En réduisant l’événement survenu à Sciences Po à une invective antisémite, ces derniers participent à supprimer du débat le pourquoi d’une telle mobilisation ayant amené des étudiants d’une institution d’enseignement supérieur prestigieuse à occuper un amphithéâtre. Dans les propos des politiques, l’événement devient une illustration d’une jeunesse étudiante sauvage et irrationnelle. Comment des étudiants « ensauvagés » pourraient-ils parler sereinement et rationnellement de politique ?

Cette dépolitisation, est une stratégie politique efficace puisque nombre de médias et d’opinions n’ont pas retenu les revendications au détriment des interventions de nos politiques.

Ces derniers convoquent et enjoignent des émotions tout en reprochant aux étudiants d’être émotifs. À écouter et à voir les politiques s’engouffrer dans la polémique, il peut-être légitime de se demander s’ils ne seraient pas les premiers dépolitisés ?

Olivier Akhamlich ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

19.05.2024 à 19:10

« L’envers des mots » : Narchomicide

Bérengère Denizeau, Maîtresse de conférences à l'Université Sorbonne-Nouvelle et chercheuse en traductologie au CLESTHIA, Université Paris Cité

Fabrice Rizzoli, Spécialiste des mafias et président de l'association Crim'HALT. Enseignant en géopolitique des criminalités., Sciences Po

Texte intégral (1116 mots)

Le néologisme narchomicide, contraction des mots narcotrafic et homicide, illustre la capacité dynamique de la langue à s’adapter et à refléter des réalités sociales complexes et, parfois, en mutation. Employé pour la première fois par Dominique Laurens, procureure de la République à Marseille, ce terme souligne la spécificité criminelle qui transcende les définitions traditionnelles dans le cas d’homicides directement liés aux trafics de drogue.

Dans le contexte marseillais, la présence de violents conflits entre clans de narcotrafiquants marque profondément le tissu social de la ville, particulièrement depuis 2021. Le trafic de drogue à Marseille est structuré par des bandes organisées, notamment en raison de la position stratégique de la ville comme port maritime et de la compétition territoriale pour le contrôle de ce marché.

À lire aussi : La France au cœur des trafics de drogue : un regard géopolitique

Selon un rapport mondial sur les drogues de 2023 de l’ONUDC (Office des Nations unies contre la drogue et le crime), ces conflits qui ont coûté la vie à plusieurs dizaines de personnes en 2023, dépassent les chiffres des années précédentes et ne concernent pas uniquement des acteurs de l’économie souterraine.

Les narchomicides liés au trafic de drogue, contrairement aux règlements de compte, ne se limitent pas aux acteurs impliqués dans ces réseaux criminels, mais touchent également des victimes innocentes, prises au piège de cette guerre urbaine : passants, habitants des quartiers touchés par ces luttes de pouvoir, ou proches de victimes, des enfants et des familles entières qui se voient plongés au cœur de conflits sanglants. Leur présence dans le décompte macabre des « narchomicides » permet d’observer combien les conséquences de ces affrontements dépassent les frontières des milieux criminels pour affecter l’ensemble de la société.

L’introduction de ce concept rappelle l’urgence qu’il y a à rechercher des solutions à grande échelle qui, au-delà de la répression, engagent également des politiques de prévention, d’éducation et de réinsertion sociale, par le biais de programmes de formation professionnelle, de soutien psychologique, et de mentorat, pour éviter que des citoyens ne soient sacrifiés sur l’autel d’une guerre dont ils ne sont ni les acteurs, ni les bénéficiaires, mais bien trop souvent les victimes oubliées.

À lire aussi : L’héroïne en milieu rural en France : une réalité ignorée

Si les néologismes naissent souvent en réponse à de nouveaux phénomènes sociaux pour lesquels le lexique existant ne suffit plus, l’apparition du terme « narchomicide » dans le débat public et son utilisation par les autorités judiciaires ne sont pas tant le reflet d’une évolution sémantique que la réponse à une nécessité communicative face à une réalité sociale alarmante. Dans une interview donnée sur France Info le 6 septembre 2023, Dominique Laurens explique que cette notion s’applique à des homicides liés au narcobanditisme pouvant frapper de simples passants :

« Ils ne sont pas visés pour leur participation spécifique aux trafics, mais parce qu’ils sont là simplement. C’est ce qui est très frappant dans les homicides actuellement. »

Dans la langue judiciaire, un règlement de compte est défini très précisément : il concerne des auteurs agissant en bande organisée avec préméditation dans le cadre d’un guet-apens et à l’aide d’armes à feu d’un certain calibre pour éliminer un concurrent criminel.

Les nouveaux mots contribuent à façonner la perception publique d’un phénomène. En dotant le discours sur la violence liée au narcotrafic d’un terme spécifique, on associe à la cité phocéenne l’idée d’une recrudescence de la violence qui dépasse le règlement de compte et apporte de l’eau au moulin de la rhétorique du « mauvais endroit au mauvais moment ».

Cet article s’intègre dans la série « L’envers des mots », consacrée à la façon dont notre vocabulaire s’étoffe, s’adapte à mesure que des questions de société émergent et que de nouveaux défis s’imposent aux sciences et technologies. Des termes qu’on croyait déjà bien connaître s’enrichissent de significations inédites, des mots récemment créés entrent dans le dictionnaire. D’où viennent-ils ? En quoi nous permettent-ils de bien saisir les nuances d’un monde qui se transforme ?

De « validisme » à « silencier », de « bifurquer » à « dégenrer », nos chercheurs s’arrêtent sur ces néologismes pour nous aider à mieux les comprendre, et donc mieux participer au débat public. À découvrir aussi dans cette série :

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

19.05.2024 à 19:09

Les mères chimpanzés continuent de jouer avec leurs petits même si elles sont mal nourries ou fatiguées

Zarin Machanda, Assistant Professor of Anthropology and Biology, Tufts University

Kris Sabbi, Fellow in Human Evolutionary Biology, Harvard University

Texte intégral (2003 mots)

Les chimpanzés sauvages sont étudiés depuis plus de 60 ans, mais ils continuent d’émerveiller et de surprendre les observateurs, comme nous l’avons constaté durant l’été 2017 dans le parc national de Kibale, en Ouganda.

Nous observions les jeux des jeunes chimpanzés pour mieux comprendre comment ils grandissent. Pour la plupart des animaux vivant en groupe, le jeu fait partie intégrante du développement. Au-delà du simple fait de s’amuser, le jeu social leur permet de mettre en pratique des compétences physiques et sociales essentielles dont ils auront besoin plus tard dans leur vie.

Mais cet été-là, nous avons réalisé que les jeunes n’étaient pas les seuls à jouer. Les adultes se joignaient au jeu plus souvent que nous ne l’avions vu auparavant, en particulier entre eux. Le fait de voir des femelles chimpanzés adultes se chatouiller et rire a surpris même les chercheurs les plus chevronnés de notre projet.

Ce n’est pas le fait que les chimpanzés adultes jouent qui est inhabituel, mais le fait qu’ils le fassent si fréquemment. Un comportement que l’on observe habituellement une fois toutes les semaines ou toutes les deux semaines devient quelque chose que l’on voit tous les jours et qui dure parfois des heures.

Qu’est-ce qui avait donc changé cet été-là ? Pour nous, en tant que primatologues, c’est là que les choses intéressantes ont commencé.

Pourquoi les adultes jouent-ils ?

Les scientifiques pensent que la principale raison pour laquelle le jeu diminue avec l’âge est que les individus finissent par s’en passer au fur et à mesure qu’ils maîtrisent leurs capacités motrices et sociales et qu’ils adoptent des comportements plus adultes. Selon cette logique, les adultes ne jouent que rarement parce qu’ils n’en ont plus besoin. La situation est différente pour les espèces domestiquées comme les chiens, car le processus de domestication lui-même préserve les comportements juvéniles comme le jeu jusqu’à l’âge adulte.

Aucune de ces raisons n’expliquerait pourquoi nos chimpanzés adultes écartaient les bébés pour jouer entre eux cet été-là. Au lieu de nous demander pourquoi les adultes jouaient, nous avons dû nous demander ce qui pouvait, dans d’autres circonstances, les empêcher de jouer. Pour ce faire, nous avons dû revenir aux bases de la primatologie et examiner les effets de la nourriture sur le comportement.

L’été 2017 a été marqué par un pic saisonnier inhabituellement élevé d’un fruit rouge appelé Uvariopsis, un des aliments préférés des chimpanzés et qui est riche en calories. Pendant les mois où ces fruits sont mûrs et abondants, les chimpanzés passent plus de temps à se retrouver en groupe.

Ce type de surplus énergétique a été associé à des activités qui demandent beaucoup d’énergie, telles que la chasse. Nous nous sommes demandé si l’abondance de fruits pouvait également être liée au jeu social. Peut-être que le jeu des adultes est limité parce que les chimpanzés adultes n’ont généralement pas le temps et l’énergie nécessaires pour s’y consacrer.

Quand la vie quotidienne empêche de jouer

Pour tester cette idée, nous nous sommes tournés vers les enregistrements du Kibale Chimpanzee Project, en extrayant près de 4 000 observations de jeux d’adultes sur une période de 10 ans.

Qu’il s’agisse de se battre avec un jeune chimpanzé ou de jouer à se courir après avec un autre adulte, la fréquence des jeux des adultes était fortement corrélée à la quantité de fruits mûrs dans le régime alimentaire au cours d’un mois donné. Lorsque la forêt regorgeait de nourriture de haute qualité, les chimpanzés adultes jouaient beaucoup.

Mais lorsque la quantité de fruits prisés diminuait, ce côté ludique disparaissait presque totalement, à l’exception des mères.

Chez les chimpanzés, les mâles sont beaucoup plus sociaux que les femelles. Ils investissent beaucoup de temps pour développer des amitiés et, en retour, ils récoltent les fruits de ces liens avec un rang de dominance plus élevé et plus de rapports sexuels. Pour les femelles, les coûts énergétiques élevés de la grossesse et de la lactation signifient que la socialisation se fait au prix du partage de la nourriture dont elles ont besoin pour elles-mêmes et leur progéniture.

Nous nous attendions à ce que le jeu, en tant que comportement social, suive d’autres modèles sociaux, les mâles jouant davantage et pouvant se permettre de jouer même lorsque l’abondance de nourriture était faible. À notre grande surprise, nous avons constaté le contraire. Les femelles jouaient plus, surtout pendant les mois où il y avait moins de fruits, parce que les mères continuaient à jouer avec leurs bébés même lorsque tous les autres chimpanzés avaient cessé de le faire.

Le coût caché de la maternité

Les chimpanzés vivent dans des sociétés multimâles et multifemmes qui présentent ce que les chercheurs appellent une fission-fusion. En d’autres termes, l’ensemble du groupe social est rarement, voire jamais, réuni. Au lieu de cela, les chimpanzés se divisent en sous-groupes temporaires, entre lesquels les individus se déplacent tout au long de la journée.

Lorsque la nourriture est rare, les groupes ont tendance à être plus petits et les mères sont souvent seules avec leurs petits. Cette stratégie réduit la compétition alimentaire avec les autres membres du groupe. Mais elle fait aussi des mères les seuls partenaires sociaux de leur progéniture. Le temps et l’énergie que les mères pourraient consacrer à d’autres tâches quotidiennes, telles que l’alimentation et le repos, sont plutôt consacrés au jeu.

Notre étude a non seulement révélé ce coût de la maternité jusqu’alors inconnu, mais elle a également mis en évidence l’importance pour ces jeunes chimpanzés que leurs mères acceptent ce coût.

Vous êtes peut-être curieux de savoir comment les pères des chimpanzés s’intègrent dans ce contexte. Les chimpanzés s’accouplent avec plusieurs individus, de sorte que les mâles ne savent pas quelle progéniture est la leur. Les mères doivent assumer seules les coûts de la parentalité.

Et chez les autres espèces de primates ?

Les chercheurs en développement de l’enfant savent que le jeu, et en particulier le jeu avec les parents, est d’une importance capitale pour le développement social de l’être humain.

Les chimpanzés étant l’un de nos plus proches parents vivants, ce type de similitudes comportementales entre nos espèces n’est pas rare.

Mais tous les parents primates n’ont pas recours à des jeux coûteux en énergie. En fait, il n’existe pratiquement aucune trace de mères singes jouant avec leurs bébés. La plupart des autres espèces de primates, comme les babouins et les capucins, ne se séparent pas pendant la journée, ce qui permet aux bébés de jouer entre eux et aux mères de se reposer.

Il reste à vérifier directement si le jeu maternel est le produit d’un groupe de fission-fusion ou s’il répond aux besoins de développement de la progéniture. Mais la responsabilité de jouer avec ses petits trouve certainement un écho chez de nombreux parents humains qui ont été soudainement amenés à devenir les principaux partenaires de jeu de leurs enfants lorsque Covid-19 a interrompu les activités normales.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

19.05.2024 à 19:08

Une citoyenneté européenne encore peu tangible

Anne-Sophie Lamblin-Gourdin, Professeur de droit public, Membre du LabLEX (Laboratoire de recherche en droit, UR 7480), Université Bretagne Sud

Texte intégral (1819 mots)

Du 6 au 9 juin 2024, les citoyens des 27 États membres de l’UE sont appelés à élire les 720 députés qui siégeront au Parlement européen pour un mandat de cinq ans. Ceux-ci sont élus au suffrage universel direct, libre et secret depuis une décision du 20 septembre 1976, mise en œuvre pour la première fois entre les 7 et 10 juin 1979. L’élection repose sur un scrutin de liste à un tour, les partis ayant obtenu plus de 5 % des suffrages bénéficiant d’un nombre de sièges proportionnel à leur nombre de voix.

Ce scrutin constitue un temps fort de la démocratie européenne. Il permet aux citoyens de l’Union de participer au projet politique et à la contribution de l’UE à la gestion des principaux défis contemporains, parmi lesquels le changement climatique et la déstabilisation économique et sociale qu’il engendre, la défense du modèle démocratique européen face à des régimes politiques illibéraux et agressifs ou encore la pression migratoire.

En effet, doté des pouvoirs législatif et budgétaire qu’il partage avec le Conseil de l’Union européenne, et du pouvoir de contrôle politique exercé sur la Commission européenne, le Parlement européen incarne la démocratie représentative sur laquelle est fondée l’UE. Il constitue une institution unique au monde, aucune autre organisation internationale ne disposant d’une assemblée ainsi élue pour assurer la représentation directe des citoyens qu’elle unit.

Un scrutin avant tout perçu à travers le prisme national ?

Le sondage Eurobaromètre publié le 17 avril 2024 indique que 60 % des Européens se disent intéressés par ce scrutin, soit une hausse de 11 points par rapport à 2019. Les partis politiques nationaux ont également bien mesuré son importance et se sont, partout, franchement engagés dans la campagne électorale. Cependant, celle-ci reste fortement imprégnée de considérations nationales, notamment en France où le pouvoir d’achat et la sécurité nationale monopolisent les débats alors que ces sujets, certes importants, correspondent à des domaines qui relèvent principalement des compétences des États et dans lesquels l’action de l’UE ne peut être que réduite et indirecte.

Que les électeurs ne se trompent pas d’enjeu : ces élections sont le moment, pour eux, d’exercer leur citoyenneté européenne, en s’emparant des enjeux européens. Or, force est de constater que cette citoyenneté européenne, les Européens ne se la sont que peu appropriée.

En témoigne une enquête Eurobaromètre menée du 31 mai au 25 juin 2023 dans les 27 États membres de l’UE, mais aussi dans des États tiers (soit 39 pays au total). 58 % des personnes interrogées ont déclaré éprouver un attachement à l’égard de l’Union, pourcentage en diminution de 3 points par rapport à l’enquête précédente ; cela correspond à une faible identification en comparaison de l’identification nationale puisque 91 % des Européens se disent attachés à leur pays.

S’agissant du sentiment de citoyenneté européenne, 72 % se sentent citoyens de l’UE – seulement 58 % en France, l’une des plus faibles proportions parmi les États membres de l’UE. Quant aux domaines contribuant au sentiment de communauté, les citoyens européens ont cité les valeurs et l’économie pour 23 % d’entre eux, la culture pour 22 %, la solidarité pour 21 %, et 20 % ont évoqué l’État de droit. Enfin, s’agissant des droits conférés par la citoyenneté de l’UE, 58 % ont affirmé les connaître, quand 70 % ont exprimé le souhait d’en savoir plus.

La citoyenneté européenne existe depuis trente ans, mais les Européens le savent-ils ?

La citoyenneté de l’UE aurait-elle donc manqué sa cible ? Elle fut pourtant un concept prometteur. Instaurée par le traité de Maastricht en 1993, elle répond à la volonté des États membres de dépasser une intégration principalement économique en développant un sentiment d’appartenance à une entité politique en devenir, un « vouloir vivre ensemble » facteur d’émergence d’un espace public européen.

Formellement, la citoyenneté de l’UE est effective : elle consiste en un ensemble de droits civils et politiques, parmi lesquels le droit de vote et d’éligibilité au Parlement européen. Mais bien qu’elle ait fêté ses trente ans, elle reste peu tangible.

Il est certain que ses caractéristiques la rendent ambiguë et abstraite. En effet, et même si le traité invite à l’envisager comme une plus-value d’autant plus qu’elle n’est pas assortie de devoirs explicites, sa dépendance à la nationalité d’un État membre lui confère un caractère apparemment accessoire. Et la pratique démocratique favorise cette dimension subsidiaire, puisque les élections au Parlement européen sont organisées dans le cadre d’une circonscription nationale unique, avec des listes nationales, et non transnationales, et que les campagnes électorales sont structurées nationalement.

Quant aux droits qu’elle confère, ils sont peu perceptibles. Le droit de vote et d’éligibilité au Parlement européen existait avant l’instauration de la citoyenneté européenne. Surtout, plusieurs de ces droits se matérialisent principalement pour les Européens qui se trouvent, de façon temporaire ou permanente, dans un autre État membre. La citoyenneté européenne permet alors de combler la rupture, momentanée ou durable, de la relation avec l’État de nationalité, en reconnaissant le droit de vote et d’éligibilité aux élections municipales dans l’État membre de résidence ; dans un pays tiers où l’État membre de nationalité n’est pas représenté, elle accorde aussi la protection diplomatique et consulaire d’un autre État membre – une réelle plus-value juridique.

S’y ajoute que la plupart des droits qu’elle confère ne sont, en réalité, pas réservés aux seuls citoyens de l’Union, mais aussi ouverts aux ressortissants d’États tiers et aux agents économiques, tels les droits de pétition au Parlement européen et de saisine du médiateur européen ; il en va de même du droit à une bonne administration, ainsi que du droit d’accès aux documents qui concrétisent les principes démocratiques sur lesquels est fondée l’UE. Enfin, les principaux apports de la citoyenneté européenne, déduits du principe de non-discrimination à raison de la nationalité, sont le produit d’une construction jurisprudentielle, certes riche mais complexe et méconnue.

Rapprocher l’Europe des Européens

Peu incarnée, la citoyenneté européenne est singulière, reposant sur la théorie du patriotisme constitutionnel (étudiée en France par Jean-Marc Ferry, dans La question de l’État européen, Paris, Gallimard, 2000), selon laquelle les motifs d’adhésion à une communauté politique peuvent provenir non pas d’une proximité géographique ou de parentalité, mais de l’attachement à une culture politique partagée, fondée sur une histoire et des valeurs communes.

Pour autant, cette citoyenneté européenne n’est pas artificielle. Elle est ancrée dans un héritage religieux, intellectuel et culturel partagé dès le XIe siècle grâce aux échanges, notamment commerciaux, qui ont forgé des expériences communes, socle d’une culture européenne et berceau des grands principes que sont la liberté, l’égalité, la dignité humaine. Elle exprime ces valeurs fondatrices communes et participe à une culture politique commune basée sur les valeurs de l’UE, dont la démocratie et l’État de droit. C’est la raison pour laquelle la Cour de justice a qualifié la citoyenneté européenne de statut fondamental des ressortissants des États membres (CJCE, 20 septembre 2001, arrêt Grzelczyk). Car elle instaure non seulement une relation juridique et politique entre ceux-ci et l’Union, mais permet aussi d’offrir aux Européens une même condition juridique et politique.

L’histoire, la culture et les valeurs communes sont une réalité, qu’il faudrait rendre plus accessible à la conscience collective pour pallier la consistance juridique peu perceptible de la citoyenneté européenne. L’instauration de celle-ci a été audacieuse, mais sa matérialisation par des droits ne suffit pas à construire une communauté politique. Le droit ne peut à lui seul rapprocher l’Europe des Européens, d’autant plus que le fonctionnement de l’UE est peu intelligible. Et à trop mettre en avant les apports économiques de l’Union, les promoteurs de celle-ci rendent la citoyenneté européenne et sa substance démocratique moins perceptibles.

[Déjà plus de 120 000 abonnements aux newsletters The Conversation. Et vous ? Abonnez-vous aujourd’hui pour mieux comprendre les grands enjeux du monde.]

La meilleure connaissance de la citoyenneté européenne est donc essentielle à l’éveil de la conscience européenne et à l’émergence d’un véritable espace public européen. Et toutes les initiatives visant à la promouvoir doivent être encouragées. Les simulations de Parlement européen et le séminaire d’immersion dans les institutions de l’UE portés par le Mouvement européen et auxquelles ont participé des lycéens du Morbihan et étudiants de l’Université Bretagne Sud y ont contribué. Les résultats sont éloquents : les participants ont tous éprouvé le sentiment d’« unité dans la diversité » et perçu la réalité de leur citoyenneté européenne.

Anne-Sophie Lamblin-Gourdin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

19.05.2024 à 19:07

À Haïti, nommer aussi les violences obstétrico-gynécologiques en milieu hospitalier

Lukinson Jean, Docteur en Sciences sociales, LADIREP, Université d'État d'Haiti, GresCo, Université de Limoges

Texte intégral (1688 mots)

Haïti connaît une vague de violences sans précédent marquées par une escalade des attaques du fait de gangs qui souhaitaient renverser le premier ministre, Ariel Henry. Ce dernier a démissionné le 11 mars 2024. Il aura fallu attendre le 25 avril pour que le conseil présidentiel de transition soit officiellement investi pour le remplacer. Edgar Leblanc Fils a été désigné à sa tête.

Ce contexte de confusion et de chaos ne doit pas faire oublier toutes les formes de violence actuelles que subissent les femmes haïtiennes. Il en est une qui est souvent passée sous silence, voire méconnue, à savoir les violences obstétricales.

À lire aussi : Haïti s’est enfoncé dans la crise. Voici quatre solutions pour l’aider à s’en sortir – et cela prendra du temps

Des violences obstétricales invisibilisées

Celles-ci sont souvent invisibilisées au profit d’autres formes de violences contre les femmes, à tel point que la notion n’est guère utilisée dans le milieu médical et féministe, au profit de celles, plus générales, de maltraitances ou de violences basées sur le genre.

Cette invisibilisation est d’autant plus exacerbée que les violences obstétricales sont susceptibles de revêtir des formes variées. Des travaux menés dans d’autres contextes, par exemple à Dakar au Sénégal, indiquent que ces violences obstétricales posent, en tout cas pour certaines d’entre elles, « un véritable problème de reconnaissance par les victimes ». Ne sachant pas comment qualifier leur expérience, celles-ci préféreraient ne pas s’en plaindre ou tout simplement ne pas en parler, ce d’autant qu’elles n’ont pas toujours conscience du bénéfice qu’elles pourraient en tirer sur le court terme.

Un continuum avec les autres violences subies par les femmes

C’est dans cette perspective qu’ont été créées en Haïti les structures de soins obstétricaux et néonataux d’urgence de base (SONUB) en vue de donner aux usagères l’accès à des soins respectueux au sein des institutions et de leur permettre de bénéficier d’une prise en charge, entre autres, des cas de violences basées sur le genre.

De nombreux témoignages de victimes ainsi que des rapports officiels ont attiré l’attention sur l’ensemble des attitudes et comportements, « combinés ou séparés » (entre autres, mauvais accueils, injures, tapes et propos humiliants) qui forment la trame des violences obstétricales.

Recourir à la notion de violence obstétrico-gynécologique, plutôt qu’à celle de maltraitance ou encore à celle de violence de genre comporte des enjeux intellectuels et sociopolitiques de taille.

D’abord, cela permet, comme l’ont déjà rappelé de nombreux auteurs et de nombreuses autrices, d’inscrire ces violences dans le continuum des violences systémiques dont les femmes sont victimes au quotidien.

Ensuite, cette démarche a, en même temps, le mérite d’attirer l’attention sur la spécificité de cette forme de violence et sur la nécessité de lutter contre celle-ci dans un pays où la violence est endémique et protéiforme.

Enfin, il s’agit de dépasser l’usage de la notion en tant que simple « catégorie de pratique » dont la finalité serait, du point de vue des détracteurs, la délation et la remise en question des prestations de santé, mais de nous concentrer sur sa dimension analytique en vue de mieux appréhender le système de soins ainsi que le rapport au corps féminin dans le domaine de l’obstétrique-gynécologie.

Un tel concept permet d’apprécier à sa juste valeur le « vécu subjectif » des femmes face à une pratique médicale souvent présentée comme « un fait objectif incontestable » et au-dessus de la critique profane.

Mais des violences obstétrico-gynécologiques non solubles dans les autres

Par ailleurs, l’objectif est de donner à voir les violences obstétrico-gynécologiques comme relevant d’un genre spécifique et qui, bien que variant selon la position des femmes (ou des couples) dans la structure sociale, ne sont pas pour autant solubles dans la spirale des violences qui frappe la société haïtienne.

Une telle démarche n’est possible qu’à condition de prendre en compte la culture médicale locale ainsi que le contexte socio-économique et culturel dans lequel s’inscrivent ces propos, attitudes et comportements à l’égard des femmes.

Sous ce rapport, l’analyse est susceptible de mettre au jour et de mieux comprendre les violences obstétricales spontanées (hors urgence liée à l’accouchement), lesquelles ne sont pas toujours reconnues en tant que telles. Et quand elles le sont, elles sont souvent décrites comme imputables soit aux contraintes organisationnelles, soit aux contraintes inhérentes aux conditions d’exercice de la profession.

C’est pourquoi il importe de dépasser la logique manichéenne consistant à opposer la parole et le vécu subjectifs des femmes et la réalité médicale « objective » et de considérer que cette forme spécifique de violence est l’effet combiné autant d’habitus professionnel (entendu comme dispositions acquises tant au cours de la formation que dans l’exercice de la profession), que d’autres facteurs tels que les institutions, les normes et les valeurs ainsi que les systèmes de représentations en vigueur chez les experts obstétricaux, notamment chez le groupe professionnel des obstétriciens-gynécologues.

C’est à cette seule condition que les violences obstétricales ne seront pas traitées comme des violences subsidiaires et donc solubles dans les violences faites aux femmes en général.

Une spécialité médicale insuffisamment encadrée

Parmi toutes les violences faites aux femmes haïtiennes, les violences obstétricales font figure d’exception, d’autant qu’il n’existe à ce jour aucune loi à ce sujet, contrairement à ce qui se passe dans d’autres pays.

À cette absence de loi vient s’ajouter le problème de l’inexistence d’un ordre des médecins, à tel point que la spécialité obstétrique-gynécologie (familièrement appelée « ObGyn ») comme la plupart des autres spécialités médicales d’ailleurs, s’exerce dans un cadre le plus souvent informel et ne constitue pas, à ce titre, un marché du travail fermé stricto sensu.

On peut faire l’hypothèse que l’absence de loi sur les violences obstétrico-gynécologiques autant que l’inexistence d’un ordre des médecins ne font qu’accroître le caractère informel de la profession d’obstétricien-gynécologue.

Cela produit, ipso facto, des situations marquées par la discordance normative, en l’occurrence « des points de vue fondés sur des conceptions différentes » de la légitimité de certains faits et gestes. Ici, ils sont adaptés aux actes pratiqués en médecine gynécologique et obstétricale.

Les pratiques d’accouchements traditionnels également en question

Mais la question est plus vaste encore car les violences obstétricales sont loin d’être le fait des seuls professionnels de la médecine officielle.

À rebours de certaines analyses sous-tendues par une vision teintée de populisme idéologique,on peut supposer que les pratiques d’accouchements traditionnels, aussi répandues soient-elles surtout en milieu rural, n’en génèrent pas moins, elles aussi, leurs lots de maltraitances et de violences.

Cet article est co-écrit avec Mislor DEXAI (PhD., laboratoire LAngages DIscours REPrésentations – LADIREP – de l’Université d’État d’Haïti) et Marc-Félix CIVIL (MD-PhD., laboratoire LADIREP de l’Université d’État d’Haïti)

La recherche de Lukinson Jean a été financée par le Laboratoire Langages, Discours et Représentations (LADIREP) ainsi que la Fondation Connaissances et Liberté (FOKAL).

19.05.2024 à 19:07

Le Brésil, un nouveau modèle pour les banques publiques de développement ?

Jean-Baptiste Jacouton, Chargé de recherche, Agence française de développement (AFD)

Texte intégral (1692 mots)

La séquence internationale actuelle met le Brésil à l’honneur. En 2024, le pays préside le G20 et il accueillera la COP 30 sur le climat en 2025. En parallèle, l’élargissement des BRICS, un club d’économies émergentes dont fait partie le Brésil, intervient à un moment stratégique dans les discussions sur la gouvernance mondiale.

La réforme de l’architecture financière internationale figure parmi les priorités que le pays s’est fixées pendant sa présidence du G20. Son président, Lula, semble vouloir attirer l’attention sur la capacité des banques publiques de développement à intégrer les effets du changement climatique dans leurs financements, à lutter contre les inégalités et à répondre aux crises de toutes natures.

Grâce au travail de nombreux universitaires brésiliens, plus de 70 articles de recherche analysent le rôle des banques publiques de développement à travers l’expérience du Brésil. Ces travaux illustrent comment des institutions financières publiques, comme la Caisse des dépôts et consignations en France, peuvent accomplir leur mandat de développement tout en assurant la stabilité macro-financière des économies qu’elles servent.

Après les États-Unis et l’Inde, le Brésil est le 3e pays au monde au nombre de banques publiques de développement, notamment en raison de sa structure fédérale. Le pays dispose d’un réseau de 21 banques publiques locales et d’une banque publique nationale : la « Banco Nacional de Desenvolvimento Econômico e Social » (BNDES, Banque nationale pour le développement économique et social). Celle-ci publie le détail de ses opérations, ventilées selon la nature des bénéficiaires et de leur localisation. Elle contribue ainsi à faire avancer notre compréhension des banques publiques de développement.

Les activités de la BNDES et la place qu’elle occupera dans l’économie brésilienne au cours des prochaines années seront vraisemblablement déterminantes pour la crédibilité de l’ensemble des 533 banques publiques de développement réunies dans la coalition Finance en Commun (FiCS). À cet égard, l’évènement conjoint G20/FiCS qui se tient à Rio de Janeiro les 20 et 21 mai 2024 a pour objectif de repenser la place de ces institutions dans le système financier international, afin de renforcer leurs actions en faveur des objectifs de développement durable (ODD) et de la lutte contre le changement climatique.

Une nouvelle phase de développement

La BNDES est une des plus grandes banques publiques de développement au monde. Elle totalise environ 130 milliards de dollars d’actifs en 2022, soit l’équivalent de 7 % du produit intérieur brut brésilien. La banque finance des projets de long terme dans l’ensemble des secteurs de l’économie, tels que l’agriculture, les infrastructures, les services, et sert une pluralité d’acteurs économiques, allant des microentreprises aux entreprises multinationales. Afin de remplir son mandat, les opérations de la BNDES se déclinent principalement sous forme de prêts (67 %) et via d’autres instruments telles que la prise de participations au capital des entreprises, les garanties, et le crédit-export. Cette diversité d’activités, de clients et d’instruments, est représentative de l’action des banques nationales de développement.

L’histoire de la BNDES est intimement liée au contexte socio-économique du Brésil. La banque fut créée en 1952 dans un contexte d’intervention délibérée du gouvernement brésilien dans l’économie afin de servir ses objectifs de développement social et économique. Au regard des difficultés du pays au début des années 1980 (faible taux de croissance, inflation, accroissement de la dette publique), la politique économique brésilienne a pris un tournant néo-libéral, poussant la BNDES à accompagner la privatisation des entreprises publiques. Au début des années 2000, la première élection du président Lula (Parti des Travailleurs) a marqué une nouvelle phase de développement pour la banque : entre 2003 et 2016, ses actifs ont été multipliés par 6.

Divers travaux insistent sur le rôle contra-cyclique qu’a joué la BNDES durant cette période. Face à la crise financière globale de 2008, elle est devenue l’une des banques publiques de développement les plus interventionnistes au monde.

Durant les 3 années qui ont suivi, son volume d’engagements a augmenté de plus de 25 % par an. Cette dynamique s’est poursuivie de façon continue pendant une dizaine d’années, si bien que son activité de prêts équivalait à presque 12 % du PIB brésilien en 2015.

Ce volume était tel qu’il aurait incité la banque centrale du Brésil à augmenter ses taux d’intérêt afin de maîtriser l’inflation qu’il nourrissait. La BNDES a alors entamé un ralentissement de son activité depuis 2016, interrompu durant la crise du Covid-19 durant laquelle la banque a, une nouvelle fois, pleinement joué son rôle contra-cyclique.

Des engagements pour une finance solidaire et durable

Traditionnellement, les banques publiques de développement ont vocation à stimuler et soutenir les secteurs de l’économie généralement exclus des systèmes financiers. Dans de nombreuses économies émergentes et en développement, les petites et moyennes entreprises ont un accès limité aux sources de financement formelles pour investir et développer leurs activités.

De nombreux articles se sont intéressés à la valeur ajoutée de la BNDES dans ce secteur. Il ressort que les entreprises financées par la banque brésilienne ont tendance à investir plus que les autres. Entre 2002 et 2016, la BNDES aurait ainsi significativement contribué à la formation brute de capital fixe au Brésil. Plusieurs auteurs nuancent néanmoins cette contribution positive en indiquant que la BNDES a également financé des entreprises performantes qui auraient pu se financer directement auprès de banques commerciales privées. Ce mécanisme est connu sous le nom d’« effet d’éviction ».

Au cours des dernières années, la BNDES a vu son mandat évoluer pour intégrer de façon significative les enjeux environnementaux et le financement des biens publics mondiaux. En 2019, la banque a adopté une nouvelle politique de responsabilité sociale et environnementale qui intègre pleinement les enjeux extrafinanciers dans sa stratégie et ses opérations. La même année elle s’est faite accréditer par le Fonds Vert pour le Climat pour son engagement « à encourager les projets qui contribuent à réduire les émissions de gaz à effet de serre et à atténuer les effets du changement climatique ».

La BNDES fut ainsi la première banque brésilienne à émettre, en 2017, une obligation verte sur les marchés internationaux à hauteur d’un milliard de dollars. Dans les faits, les engagements en matière de finance verte de la BNDES ont augmenté de 37 % entre 2018 et 2022. Si la littérature s’accorde sur le rôle moteur que joue la banque pour financer la transition énergétique du Brésil, il existe néanmoins peu d’études concernant ses impacts en matière de déforestation.

En définitive, l’expérience de la BNDES invite à repenser l’action des banques de développement en articulation avec l’ensemble des politiques publiques. Par définition, ces institutions constituent un instrument quasi fiscal de politique publique. Pour bien comprendre leur potentiel de développement dans l’économie, il s’agit donc de penser leurs activités en adéquation avec l’ensemble des politiques budgétaires, monétaires et industrielles. De façon générale, les travaux de recherche sur les banques publiques de développement devraient davantage tenir compte des interactions qu’elles entretiennent avec l’ensemble des acteurs économiques publics et privés.

Jean-Baptiste Jacouton ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

19.05.2024 à 14:38

Tentative d’assassinat de Robert Fico : quelles conséquences pour la Slovaquie ?

Jan Rovny, Professor of Political Science, Centre d’études européennes et de politique, Sciences Po

Texte intégral (2097 mots)

Mercredi 15 mai, dans la petite ville slovaque de Handlova, Robert Fico, 59 ans, redevenu premier ministre le 25 octobre dernier après avoir déjà exercé cette fonction – la plus importante dans son pays – pendant dix ans au total entre 2006 et 2018, a été victime d’une tentative d’assassinat. Touché par cinq balles à bout portant, il a été rapidement évacué vers son hôpital. Son état, un temps jugé critique, est désormais qualifié de « grave ». Le suspect, un homme de 71 ans aux motivations floues, a été arrêté.

Fico est un dirigeant qui détonne au sein de l’UE. Élu sur une ligne populiste, notamment marquée par un discours résolument hostile aux migrants et aux minorités sexuelles, connu pour sa proximité avec Moscou sur le dossier ukrainien, souvent présenté comme un tenant de l’illibéralisme à l’instar du premier ministre de la Hongrie voisine, Viktor Orban, dont il est proche, il est un personnage extrêmement clivant sur la scène politique de la Slovaquie, ce pays d’Europe centrale de quelque 5,5 millions d’habitants actuellement plongé, comme les 26 autres États membres de l’UE, en pleine campagne électorale dans la perspective des européennes du 9 juin prochain.

The Conversation France a demandé à Jan Rovny, professeur de science politique au Centre d’études européennes et de politique comparée à Sciences Po, de revenir sur la trajectoire et l’idéologie de Robert Fico, et d’évaluer les conséquences que pourrait avoir cet événement sans précédent en Slovaquie, et rarissime à l’échelle de l’Europe, où les deux derniers chefs de gouvernement à avoir été assassinés dans l’exercice de leurs fonctions sont le Serbe Zoran Djindjic en 2003 et le Suédois Olof Palme en 1986.

Comment qualifieriez-vous Robert Fico, sur le plan politique ? Son parcours et ses prises de position sont-ils ceux d’une personnalité inclassable, ou bien s’inscrivent-ils dans des mouvances politiques clairement définies ?

Tout d’abord, il me semble important de commencer par rappeler que toute forme de violence, et en particulier la violence politique, est un phénomène odieux. Ce qui s’est passé ce 15 mai, c’est d’abord une tentative de meurtre visant un être humain, et ensuite seulement une attaque contre une personnalité politique – une personnalité politique qui a remporté des élections équitables et compétitives, et qui a légitimement accédé aux fonctions qui sont les siennes. Cet acte est une atteinte à la vie humaine et, au-delà, du fait du poste de la personne visée, une atteinte à la démocratie libérale, et mérite donc une condamnation absolument univoque.

Robert Fico est un personnage incontournable de la politique slovaque depuis un quart de siècle. Initialement issu du parti social-démocrate modéré SDL (Parti de la gauche démocratique), qui était un parti post-communiste réformé, Fico a fondé en 1999 son propre parti, SMER (Direction), initialement inspiré par la politique dite de la troisième voie du Labour britannique de Tony Blair et opposé au gouvernement de droite en place à l’époque en Slovaquie.

Au début des années 2000, Fico parvient à dominer l’aile gauche de la politique slovaque en attirant dans l’orbite du SMER d’autres forces de gauche. Il est généralement soutenu par des électeurs socialement défavorisés, qui ont été les perdants de la transition économique de la Slovaquie vers une économie capitaliste – une transition dans l’ensemble plutôt réussie.

[Déjà plus de 120 000 abonnements aux newsletters The Conversation. Et vous ? Abonnez-vous aujourd’hui pour mieux comprendre les grands enjeux du monde.]

Fico attire de plus en plus ces électeurs en insérant dans son discours un mélange de protectionnisme économique, de connotations nationalistes et de rhétorique hostile aux minorités. En 2006, il forme un gouvernement de coalition avec des forces nationalistes et de droite radicale, et continue à glisser vers un illibéralisme politique de plus en plus explicite.

Fico et ses gouvernements – il sera premier ministre de 2006 à 2010 puis de 2012 à 2018, avant de récupérer ce poste en 2023 – sont accusés d’approfondir les pratiques de corruption et de construire ce que certains analystes qualifient d’« État mafieux », associant les élites politiques du régime à des oligarques impliqués dans des pratiques commerciales douteuses.

Fico est contraint de démissionner à la suite de l’assassinat, en 2018, d’un journaliste politique, Ján Kuciak, qui enquêtait sur les liens de la SMER avec le crime organisé. Son retour au pouvoir à l’issue des élections législatives de 2023 est précédé par des apparitions publiques remarquées dans le contexte des protestations contre les mesures sanitaires prises par le gouvernement pendant la pandémie de Covid, et par sa vive opposition à l’envoi de nouvelles armes à l’Ukraine.

Après sa réélection en 2023, Fico et son gouvernement, qui comporte des ministres d’extrême droite, se sont lancés dans une rapide « dé-démocratisation » à la Viktor Orban, en abolissant le bureau spécial du procureur pour les affaires de corruption et de crime organisé, et en cherchant à fermer la chaîne de télévision publique slovaque. Le camp politique de Fico a obtenu la victoire de son ancien collaborateur, Peter Pellegrini, lors de la toute récente élection présidentielle (23 mars/6 avril), ce qui a renforcé l’emprise de Fico sur le pouvoir.

En bref, Fico ne verrait probablement rien à redire si on le qualifiait de « Viktor Orban de la Slovaquie ».

En Slovaquie, quelles sont les réactions à la tentative d’assassinat dont il a été la cible ?

La quasi-totalité des adversaires de Fico, à commencer par la présidente sortante Zuzana Caputova, qui est son adversaire de longue date, ainsi que de nombreux médias, ont fermement condamné la tentative d’assassinat et lancé un appel à l’unité politique et sociale, mettant en garde contre les effets néfastes de la violence politique et de son instrumentalisation opportuniste.

D’autre part, un certain nombre de membres du gouvernement ont réagi en critiquant l’opposition libérale et les médias traditionnels, allant jusqu’à affirmer que ceux-ci avaient le sang de Fico sur les mains en raison de leurs critiques à l’égard du premier ministre. Les mesures que le camp gouvernemental pourrait prendre dans les prochains jours et les prochaines semaines en matière de contrôle des médias, notamment, devront être scrutées de près.

Une chose semble sûre : un tel acte de violence politique, sans précédent dans la jeune histoire de la Slovaquie indépendante, n’est certainement pas de nature à favoriser une évolution harmonieuse vers une démocratie libérale apaisée. Le gouvernement avait déjà clairement indiqué que certains de ses objectifs étaient tout à fait illibéraux ; le contexte actuel va encore accroître sa détermination à agir dans ce sens.

S’achemine-t-on vers une prise de contrôle des médias slovaques par le pouvoir ?

Depuis que Fico est revenu aux affaires à l’automne 2023, le pays s’est précipité sur la voie d’un illibéralisme à la Orban. Fondamentalement, la tentative d’assassinat n’a pas changé la donne, si ce n’est qu’un tel épisode peut donner au gouvernement les coudées franches pour l’utiliser comme prétexte à de nouvelles restrictions de la liberté des médias et de l’indépendance de la justice.

Peut-on déjà prévoir l’impact de cet événement sur le résultat des élections européennes en Slovaquie ?

Nous ne disposons pas encore de sondages effectués après la tentative d’assassinat pour nous faire une idée plus précise de la façon dont cela a – ou non – incité les citoyens slovaques à modifier leurs intentions de vote. On peut s’attendre à ce que l’attentat contre le premier ministre génère un certain nombre de votes de sympathie et augmente ainsi les chances électorales de son parti, le SMER, qui, en avril, devançait l’opposition libérale d’un point de pourcentage dans les sondages. Simultanément, l’opposition libérale a déclaré – par respect – qu’elle suspendrait toutes ses manifestations politiques.

Dans quelle mesure la violence politique est-elle répandue dans les pays anciennement communistes ayant adhéré à l’UE en 2004 et 2007 ?

En Europe centrale, la violence politique est plutôt limitée. La Slovaquie a connu un assassinat qui a eu un grand retentissement et qui était clairement motivé par des considérations politiques, celui de Ján Kuciak en 2018 – un épisode qui, je l’ai évoqué, a contraint Fico à démissionner. En dehors de cela, la violence politique est rare à un niveau aussi élevé. Si l’on compare avec l’Europe occidentale et que l’on considère les assassinats politiques de personnalités telles que Pim Fortuyn aux Pays-Bas, Anna Lindh en Suède et Jo Cox ou David Amess au Royaume-Uni, il semble que les assassinats à motivation politique soient plus fréquents à l’ouest.

Quels sont les scénarios probables si Fico se remet de ses blessures ? Et s’il ne parvient pas à reprendre ses activités politiques ?

Si Robert Fico se rétablit et reprend son poste de premier ministre, il est difficile d’imaginer que sa rencontre rapprochée avec la mort lui apportera une forme d’épiphanie. Je m’attends à ce qu’il poursuive ses politiques illibérales – avec probablement encore moins de scrupules qu’auparavant. S’il succombe à ses blessures ou en tout cas ne parvient pas à retrouver l’intégralité de ses moyens et se retire de la vie politique, il sera probablement remplacé par l’un de ses proches collaborateurs – peut-être Robert Kalinak, ancien ministre de l’Intérieur et actuel ministre de la Défense. Je m’attends à ce que Fico lui-même et son parti utilisent l’assassinat à des fins politiques. Quoi qu’il arrive, la démocratie libérale en Slovaquie semble suspendue à un fil de plus en plus précaire.

Jan Rovny a reçu des financements de Horizon Europe.

17.05.2024 à 12:39

Quels droits pour les promeneurs, entre droit d’accès à la nature et propriété privée ?

BASSET Mégane, Avocat au Barreau de Grenoble - Chargée de travaux dirigés, Université Grenoble Alpes (UGA)

Texte intégral (2762 mots)