04.02.2026 à 15:03

Comment les holdings sont devenues un outil central du capitalisme français

Quentin Belot, Maître de conférences, Grenoble IAE, Université Grenoble Alpes., Université Grenoble Alpes (UGA)

Texte intégral (3000 mots)

Peugeot, Mulliez, Wendel… toutes les grandes familles capitalistes françaises ont recours à des holdings. Retour historique et pédagogique pour comprendre ce dispositif juridique et financier complexe. L’enjeu : transformer la valeur produite par les grandes entreprises en patrimoine privé.

Alors que le débat budgétaire français remet régulièrement sur la table la taxation des « ultrariches », notamment à la suite des propositions de Gabriel Zucman, la réflexion publique se concentre presque exclusivement sur l’aval du système économique. La question centrale : comment taxer les revenus et patrimoines une fois qu’ils sont constitués ?

Cette approche laisse dans l’ombre un point crucial, situé en amont. L’accumulation de la richesse ne se situe pas au niveau des personnes, mais d'abord au sein des sociétés, avant d’être progressivement transformée en patrimoine privé.

L’un des instruments clés : la holding, une société qui ne produit rien, dont la raison d’être n’est que la détention de titre de propriété d’autres sociétés. Comprendre son rôle conduit à déplacer le regard des seuls enjeux distributifs pour s’intéresser aux mécanismes constitutifs de l’enrichissement.

L’enjeu que j’ai étudié dans ma thèse : comprendre son rôle dans la séparation progressive de la responsabilité personnelle des actionnaires et du patrimoine d’un côté, et la responsabilité sociale de l’entreprise de l’autre. De l’usine à la filiale, du groupe industriel au portefeuille d’actifs, puis au « Family Office », les pyramides de holdings organisent la montée en abstraction du capital, transformant la valeur produite collectivement en patrimoine privé durable.

Retour sur l’histoire des holdings, des commenda au Moyen Âge aux Family Offices au XXIe siècle, en passant par les sociétés anonymes pendant la révolution industrielle.

Des commenda au Moyen Âge à la révolution industrielle

Avant de parler d’histoire, parlons de théorie économique.

D'abord, dès le moment où un capital est bloqué dans une activité économique, ou immobilisé en comptabilité, comme par exemple le commerce d’épice, il n’est plus disponible pour d’autres investissements potentiellement plus rentables. Ensuite, pour être valorisé comme patrimoine privé et être transmis aux héritiers, le capital doit in fine se détacher de l’entreprise. La holding répond à ce paradoxe vieux comme le capitalisme : séparer la responsabilité patrimoniale entre sphère professionnelle et personnelle.

Dès le Xe siècle, des dispositifs comme la commenda instaurent une séparation entre l’investisseur, qui apporte le capital, et l’exploitant, qui exécute l’entreprise commerciale, le plus souvent sous la forme d’un voyage maritime. Celles-ci se développent à Venise et à Gênes, contribuant à la prospérité des deux villes.

À partir du XVe siècle, les sociétés par actions émergent dans un contexte de conquêtes coloniales. C’est le modèle juridique des monopoles royaux que sont les compagnies anglaise, néerlandaise et française des Indes orientales et occidentales. Cette forme juridique introduit la divisibilité du capital dans le cadre d’un commerce incertain, nécessitant l’immobilisation d’un capital conséquent.

Au XIXe siècle, parallèlement au mouvement d’industrialisation en Europe, cette séparation du patrimoine et de la responsabilité économique est formalisée à travers des entités juridiques précises.

Création des sociétés anonymes

Le Code français du commerce de 1807 introduit une distinction claire entre patrimoine privé et activité économique, ouvrant la voie à la création des sociétés anonymes (SA). En effaçant le nom des actionnaires de la raison sociale de l’entreprise, la société anonyme devient une entité juridique autonome bénéficiant d’une responsabilité propre. Cette nouvelle donne conduit de nombreux investisseurs particuliers à tirer profit des revenus d’une entreprise jusqu’à la déclaration de la faillite, ce sans en assumer les conséquences.

L’essor des sociétés anonymes est facilité par la loi de 1864 sur les sociétés commerciales. Cette forme juridique permet un financement de l’entreprise par des investisseurs anonymes extérieurs à l’entreprise à travers le marché des capitaux – en actions ou en obligations. Elle devient majoritaire après la Seconde Guerre mondiale.

Concrètement, la société anonyme, en permettant un financement sur une base plus large, introduit aussi un paradoxe. D’un côté, les propriétaires du capital ne sont plus personnellement responsables du capital immobilisé dans l’entreprise. De l’autre, un nouveau problème apparaît : comment les familles d’actionnaires historiques peuvent conserver le contrôle du capital dans un contexte d’élargissement du nombre d’investisseurs ?

C’est dans ce cadre qu’une première structuration juridique du capital familial apparaît. S’il est impossible de parler de holdings à cette époque sans faire d’anachronisme, les bases sont posées.

Construction de groupes industriels

En France, la construction de grands groupes industriels s’organise tardivement à partir des années 1960-1970, sous l’impulsion de l’État et des banques d’affaires, comme Lazare et Rothschild. Les fusions, acquisitions et restructurations donnent naissance à des ensembles industriels de taille inédite, presque toujours chapeautés par des holdings.

La réforme fiscale de 1965 facilite la création et l’organisation des grands groupes que nous connaissons aujourd’hui. En allégeant l’impôt sur les dividendes distribués par les filiales à leur société-mère, elle encourage les firmes à se structurer en plusieurs niveaux de sociétés imbriquées les unes dans les autres. Un système pyramidal se généralise, remplaçant progressivement les structures financières classiques, dans lesquelles les actionnaires possédait personnellement les actions des sociétés du groupe familial.

La holding devient une structure de tête, centralisant la propriété, la trésorerie et le pouvoir de décision, tout en maintenant l’autonomie juridique des filiales. Ces holdings de groupe remplissent plusieurs fonctions : effet de levier financier, outil de croissance externe et d’arbitrage d’actifs, et séparation organisationnelle entre propriété du capital et activité productive.

La création de Peugeot Société anonyme en 1966 comme société mère du groupe industriel familial en est un illustre exemple. Les diverses activités – cycles, outillages ou automobiles – sont auparavant gérées par des sociétés indépendantes, appartenant en direct aux actionnaires, relevant des différentes branches de la famille. La holding Peugeot SA est elle-même contrôlée par Foncière et Financière de Participation (FFP), une holding familiale de contrôle créée en 1929. Cette structuration fiscale et juridique garantit une unification de la gestion financière des différentes filiales, et une centralisation de la gestion du capital familial.

Empires du capital

À partir des années 1990, dans le cadre de l’installation de la stagnation, de l’accélération de l’accumulation du capital et de la financiarisation de l’économie, plusieurs opérations de rachats hostiles d’entreprises se déploient. Des groupes français aujourd’hui majeurs, tels LVMH, Lagardère ou Bolloré, se constituent au travers d’opérations financières d’envergure, plus ou moins agressives.

Ces opérations sont menées par l’intermédiaire de holdings, qui permettent de centraliser la trésorerie, et de facto de bénéficier d’un effet de levier pour ces investissements – avoir recours à de l’endettement pour augmenter la capacité d’investissement de l'entreprise. Indépendante juridiquement et de nom, elles permettent de racheter les actions d’une entreprise d’une manière plus discrète que par une société portant le nom familial. C’est la stratégie déployée à de nombreuses reprises par le groupe Bolloré.

Les holdings sont donc de plus en plus éloignées d’enjeux de développement industriel, et de plus en plus proches de logiques d’optimisation financière dans le cadre de ces nouveaux empires du capital.

Société de capital-investissement

Ces holdings sont progressivement transformées en sociétés de capital-investissement. Elles servent de support à des stratégies de diversification patrimoniale et à une recomposition profonde du capital que l’on associe à la financiarisation.

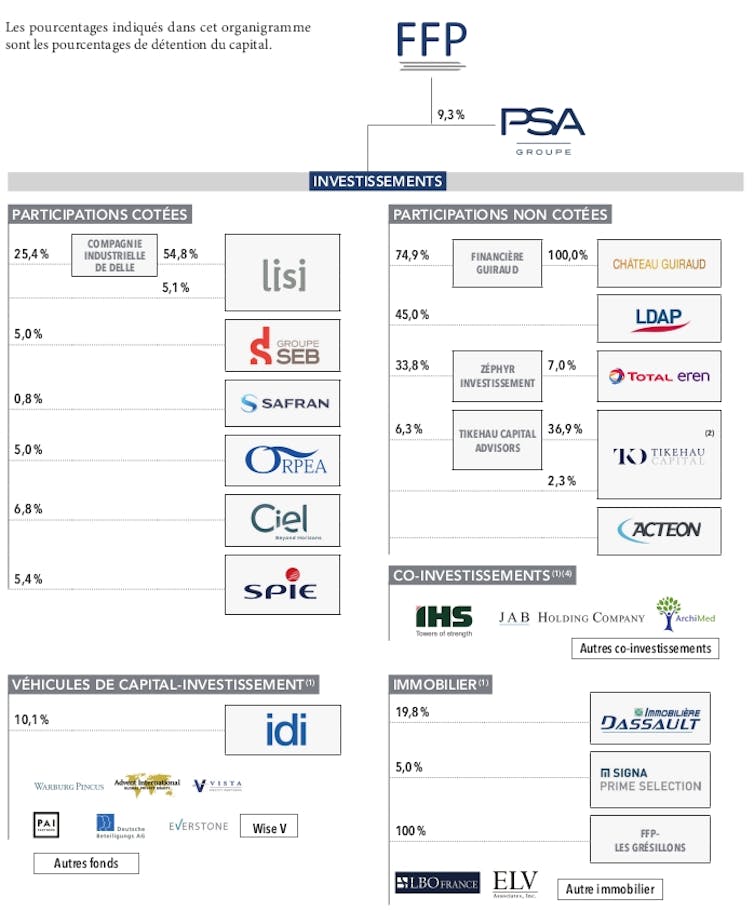

La holding peut être le véhicule d’une diversification du capital familial, ce qui ne s'oppose pas au maintien du contrôle industriel. C’est le cas du groupe FFP, société d’investissement de la famille Peugeot, ancêtre de Peugeot Invest. À partir des années 2000, le mouvement de diversification financière s’accélère : la holding prend des participations dans de nombreux groupes, comme Seb, Orpea, Ipsos, DKSH, Dassault Real Estate, Zodiac, Tikehau, Totan Eren, Spie, des sociétés immobilières, des fonds de capital-investissement, etc. Cet important mouvement est allé de pair avec le maintien d’une partie significative du contrôle du groupe PSA, devenu Stellantis, par la holding de la famille Peugeot (ci-dessous, les investissements de cette holding en 2019).

Family Office, les holdings des holdings

Aux étages supérieurs s’ajoutent aujourd’hui des structures, comme les « Family Offices ». Elles parachèvent la transformation du capital économique en patrimoine privé pour de nombreuses dynasties françaises au sommet des classements de grandes fortunes. Outre la dimension d’ingénierie patrimoniale, ces structures offrent divers services financiers mais aussi de gestion des relations entre actionnaires et parents au sein de ces familles fortunées.

Ce phénomène est général. Le capital des principales dynasties françaises s’organise à présent autour de holdings formant des édifices plus ou moins complexes, mais toujours avec une société financière principale : holding H51 pour la famille Hermès, société Agache pour la famille Arnault, Téthys Invest pour la famille Bettencourt-Meyers, GIMD pour la famille Dassault, Merit France pour les Saadé, NJJ holding pour les Niel, etc.

Au sein de ces empires familiaux, les étages de holdings constituent les échelles permettant la transformation de la valeur produite au sein de l’économie réelle en patrimoine privé. Penser les enjeux économiques en ne prêtant attention qu’au plus bas niveau, celui des filiales industrielles, est donc largement incomplet.

Replacer les holdings au cœur de l’analyse permet donc de comprendre que l’enrichissement n’est ni naturel ni automatique, mais le produit d’une architecture institutionnelle précise, largement invisible dans le débat public.

Quentin Belot ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

04.02.2026 à 11:26

Pourquoi les pénis humains sont-ils si grands ? Une nouvelle étude sur l’évolution révèle deux raisons principales

Upama Aich, Forrest Research Fellow, Centre for Evolutionary Biology, The University of Western Australia

MIchael Jennions, Emeritus Professor, Evolutionary Biology, Australian National University

Texte intégral (2106 mots)

Comparés à ceux des autres grands singes, les pénis humains sont mystérieusement grands, ce qui suggère qu’ils pourraient servir de signal aux partenaires.

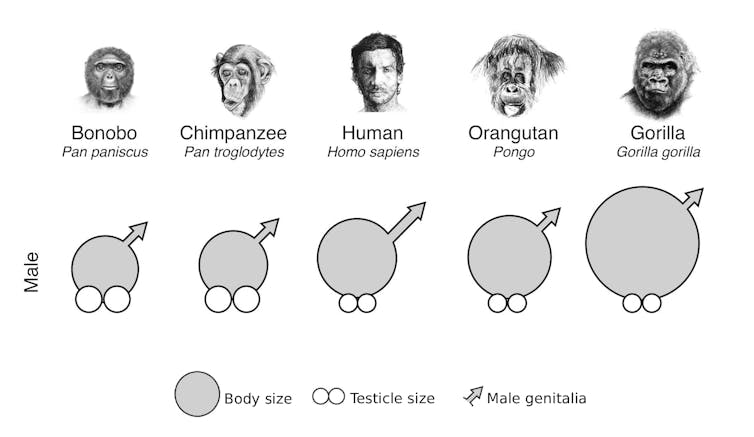

« La taille compte », c'est une phrase assez cliché, mais pour les biologistes de l’évolution, la taille du pénis humain constitue un véritable mystère. Comparé à celui d’autres grands singes, comme les chimpanzés et les gorilles, le pénis humain est plus long et plus épais que ce à quoi on pourrait s’attendre pour un primate de notre taille.

Si la fonction principale du pénis est simplement de transférer le sperme, pourquoi le pénis humain est-il si nettement plus grand que celui de nos plus proches parents ?

Notre nouvelle étude, publiée aujourd’hui dans PLOS Biology révèle qu’un pénis plus grand chez l’être humain remplit deux fonctions supplémentaires : attirer des partenaires et intimider les rivaux.

Pourquoi est-il si proéminent ?

Comprendre pourquoi le corps humain a cette apparence est une question centrale en biologie évolutive. Nous savons déjà que certaines caractéristiques physiques, comme une grande taille ou un torse en forme de V, augmentent l’attrait sexuel d’un homme

En revanche, on sait moins de choses sur l’effet d’un pénis plus grand. Les humains ont marché debout bien avant l’invention des vêtements, ce qui rendait le pénis très visible aux yeux des partenaires et des rivaux pendant une grande partie de notre évolution.

Cette proéminence aurait-elle favorisé la sélection d’une plus grande taille ?

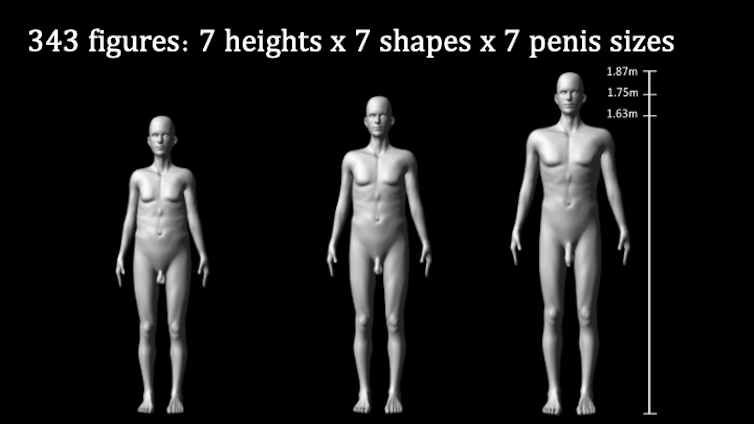

Il y a treize ans, dans une étude qui a fait date, nous avons présenté à des femmes des projections grandeur nature de 343 silhouettes masculines en 3D générées par ordinateur, anatomiquement réalistes, variant selon la taille, le rapport épaules-hanches (silhouette) et la taille du pénis.

Nous avons constaté que les femmes préfèrent généralement les hommes plus grands, avec des épaules plus larges et un pénis plus grand.

Cette étude a fait la une des médias du monde entier, mais elle ne racontait qu’une partie de l’histoire. Dans notre nouvelle étude, nous montrons que les hommes aussi prêtent attention à la taille du pénis.

Une double fonction ?

Chez de nombreuses espèces, les traits plus marqués chez les mâles, comme la crinière du lion ou les bois du cerf remplissent deux fonctions : attirer les femelles et signaler la capacité de combat aux autres mâles. Jusqu’à présent, nous ne savions pas si la taille du pénis humain pouvait elle aussi remplir une telle double fonction.

Dans cette nouvelle étude, nous avons confirmé notre conclusion précédente selon laquelle les femmes trouvent un pénis plus grand plus attirant. Nous avons ensuite cherché à déterminer si les hommes percevaient également un rival doté d’un pénis plus grand comme plus attirant pour les femmes et, pour la première fois, si les hommes considéraient un pénis plus grand comme le signe d’un adversaire plus dangereux en cas de confrontation physique.

Pour répondre à ces questions, nous avons montré à plus de 800 participants les 343 silhouettes variant en taille, en morphologie et en taille de pénis. Les participants ont observé et évalué un sous-ensemble de ces silhouettes, soit en personne sous forme de projections grandeur nature, soit en ligne sur leur propre ordinateur, tablette ou téléphone.

Nous avons demandé aux femmes d’évaluer l’attrait sexuel des personnages, et aux hommes de les évaluer en tant que rivaux potentiels, en indiquant dans quelle mesure chaque personnage leur semblait physiquement menaçant ou sexuellement compétitif.

Ce que nous avons découvert

Pour les femmes, un pénis plus grand, une stature plus élevée et un torse en forme de V augmentaient l’attrait d’un homme. Toutefois, cet effet présentait un rendement décroissant : au-delà d’un certain seuil, une augmentation supplémentaire de la taille du pénis ou de la taille corporelle n’apportait que des bénéfices marginaux.

La véritable révélation est cependant venue des hommes. Ceux-ci percevaient un pénis plus grand comme le signe d’un rival à la fois plus combatif et plus compétitif sur le plan sexuel. Les silhouettes plus grandes et au torse plus en V étaient évaluées de manière similaire.

Cependant, contrairement aux femmes, les hommes classaient systématiquement les individus présentant les traits les plus exagérés comme des concurrents sexuels plus redoutables, ce qui suggère qu’ils ont tendance à surestimer l’attrait de ces caractéristiques pour les femmes.

Nous avons été frappés par la cohérence de nos résultats. Les évaluations des différentes silhouettes ont conduit à des conclusions très similaires, que les participants aient vu les projections grandeur nature en personne ou les aient observées sur un écran plus petit en ligne.

Jugement instantané – avec des limites

Il est important de rappeler que le pénis humain a avant tout évolué pour le transfert du sperme. Néanmoins, nos résultats montrent qu’il fonctionne également comme un signal biologique.

Nous disposons désormais de preuves indiquant que l’évolution de la taille du pénis pourrait avoir été en partie guidée par les préférences sexuelles des femmes et par son rôle de signal de capacité physique entre hommes.

Il convient toutefois de noter que l’effet de la taille du pénis sur l’attractivité était quatre à sept fois plus important que son effet en tant que signal de capacité de combat. Cela suggère que l’augmentation de la taille du pénis chez l’homme a évolué davantage en réponse à son rôle d’ornement sexuel destiné à attirer les femmes qu’en tant que symbole de statut social pour les hommes, bien qu’il remplisse effectivement ces deux fonctions.

Fait intéressant, notre étude a également mis en évidence une particularité psychologique. Nous avons mesuré la rapidité avec laquelle les participants évaluaient les silhouettes. Ceux-ci étaient nettement plus rapides pour juger les silhouettes présentant un pénis plus petit, une taille plus réduite et un haut du corps moins en forme de V. Cette rapidité suggère que ces traits sont évalués inconsciemment, presque instantanément, comme moins attirants sexuellement ou moins menaçants physiquement.

Il existe bien sûr des limites à ce que révèle notre expérience. Nous avons fait varier la taille corporelle, la taille du pénis et la morphologie, mais dans la réalité, des caractéristiques telles que les traits du visage et la personnalité jouent également un rôle important dans la manière dont nous évaluons les autres. Il reste à déterminer comment ces facteurs interagissent entre eux.

Enfin, bien que nos conclusions soient valables pour des hommes et des femmes issus de différentes origines ethniques, nous reconnaissons que les normes culturelles de la masculinité varient à travers le monde et évoluent au fil du temps.

Upama Aich a reçu des financements de la Forrest Research Foundation pour travailler à l'Université d'Australie occidentale et a reçu une bourse de recherche de la Monash University pour mener cette étude.

MIchael Jennions ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

04.02.2026 à 11:26

Quand macaques et hippopotames se baignaient dans la Seine il y a 400 000 ans

Julie Dabkowski, Directrice de recherche CNRS en Géologie de la Préhistoire, Université Paris 1 Panthéon-Sorbonne, Université Paris-Est Créteil Val de Marne (UPEC)

Nicole Limondin-Lozouet, Directrice de Recherche, Malacologue quaternariste, Centre national de la recherche scientifique (CNRS)

Pierre Louis Antoine, Directeur de Recherche CNRS, géoloque et géomorphologue spécialiste des paléoenvironnements du Quaternaire, Centre national de la recherche scientifique (CNRS)

Texte intégral (2476 mots)

S’il est aujourd’hui à nouveau possible de se baigner dans la Seine, pouvez-vous imaginer devoir faire attention aux hippopotames avant de plonger ? C’était bien ce que devaient faire nos ancêtres, il y a 400 000 ans. Une étude récente décrit un paysage insoupçonné.

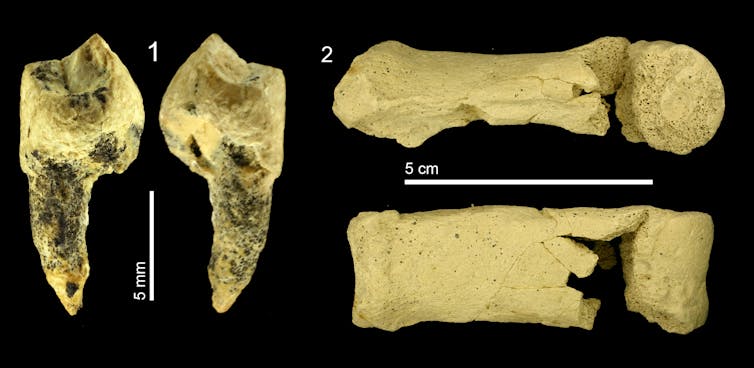

À 15 km de Fontainebleau (Seine-et-Marne), le site de La Celle est connu depuis le XIXᵉ siècle. Il livre à cette époque quelques outils façonnés par des humains préhistoriques mais, surtout, une remarquable collection d’empreintes de végétaux et de coquilles de mollusques. Au cours de nouvelles études entamées en 2003, des restes d’hippopotame et de macaque y sont également découverts.

Notre équipe de recherche constituée d’une quinzaine de spécialistes de disciplines très variées a pu exploiter tout le potentiel de ce site pour reconstituer des conditions climatiques et environnementales particulièrement douces dans la vallée de la Seine, il y a environ 400 000 ans. Retour sur plus de vingt années de recherche dont nous avons récemment publié une synthèse.

Depuis 2,6 millions d’années, le climat de la Terre alterne entre périodes glaciaires et interglaciaires. Les périodes glaciaires sont des phases froides. Les glaciers y étaient bien plus étendus, aux pôles comme en montagne. Ces périodes durent en moyenne 80 000 ans. Les interglaciaires sont, au contraire, des phases chaudes. Elles ressemblent au climat actuel et sont plus courtes, environ 20 000 ans.

Le site de La Celle est daté par des méthodes diverses d’une de ces périodes interglaciaires survenue il y a environ 400 000 ans. Cet interglaciaire en particulier peut être considérée comme une période « modèle » pour comprendre l’évolution récente du climat, depuis une dizaine de milliers d’années, en dehors des effets du dérèglement climatique lié aux activités humaines.

La principale formation géologique observée à La Celle est ce que l’on appelle un tuf calcaire. C’est une roche sédimentaire qui se forme à l’émergence de certaines sources ou dans des cours d’eau peu profonds. Sa formation est favorisée par un climat tempéré et humide, justement typique des périodes interglaciaires. Les tufs sont des archives géologiques particulièrement intéressantes car ils fossilisent des informations riches et diversifiées sur les environnements et climats passés.

À La Celle, plusieurs milliers d’années ont été nécessaires à la formation de près de 15 mètres d’épaisseur de tuf. Dans certains niveaux les empreintes de feuilles d’arbres et de fruits sont conservées et renvoient l’image d’une végétation riche qui se développe sous des conditions plutôt chaudes : chêne, peuplier, saule… mais surtout buis, figuier et micocoulier. Au milieu du dépôt la présence d’ossements de macaque et d’hippopotame est aussi un indice de conditions climatiques clémentes.

Reconstruire les milieux du passé grâce aux escargots

Notre équipe a également étudié de petits fossiles particulièrement intéressants pour reconstituer en détail l’évolution de l’environnement : les coquilles de mollusques (escargots et limaces). Chaque escargot a des contraintes écologiques particulières et porte sur sa coquille des caractères distinctifs qui permettent même sur un petit morceau de reconnaître l’espèce à laquelle elle appartenait. Ainsi, la malacologie, discipline qui étudie ces fossiles de mollusques, permet de déduire à partir des assemblages d’escargots les milieux dans lesquels ils vivaient.

Dans le tuf de La Celle, les coquilles sont particulièrement bien conservées : plus de 42 000 individus ont été collectés, représentant 94 espèces de mollusques ! Elles sont par ailleurs présentes sur toute l’épaisseur du tuf ce qui permet de reconstituer des changements environnementaux sur plusieurs milliers d’années. La succession des faunes d’escargots de La Celle révèle trois étapes environnementales. À la base, une prairie marécageuse évolue vers une forêt de plus en plus dense. Celle-ci est contemporaine des silex taillés par les préhistoriques et des ossements de macaque et d’hippopotame. Dans la partie supérieure du dépôt, la forêt laisse place à une zone humide.

À La Celle les escargots de milieu forestier sont remarquables par leur diversité. Plusieurs espèces sont aujourd’hui éteintes où ne vivent plus que dans des contrées éloignées d’Europe centrale ou de la côte Atlantique sud. Elles constituent ce qui est nommée « la faune à Lyrodiscus » du nom d’un sous-genre d’escargot qui n’existe plus dans la faune moderne qu’aux îles Canaries. La faune à Lyrodiscus a été identifiée dans sept gisements de tuf répartis dans les vallées de la Seine, de la Somme et le sud de l’Angleterre, tous datés du même interglaciaire. Cependant, par son épaisseur exceptionnelle, le tuf de La Celle est le seul qui enregistre en détail l’émergence, le développement et la disparition de cette faune caractéristique d’une forêt tempérée et humide. La Celle sert de modèle pour positionner dans la succession forestière les séries plus courtes des autres gisements.

Des macaques et des hippopotames dans le nord de la « France »

Certaines caractéristiques chimiques du tuf lui-même renseignent sur les conditions de température et d’humidité au moment de sa formation : c’est l’étude géochimique. Ces analyses menées en parallèle de l’étude des mollusques montrent que l’optimum climatique, qui correspond aux conditions les plus chaudes et les plus humides enregistrées au cours de toute la séquence, intervient au même moment que le développement maximal de la forêt. Ces données géochimiques ont été comparées avec celles obtenues sur d’autres tufs du nord de la France datés de périodes interglaciaires plus récentes : le dernier interglaciaire, il y a environ 125 000 ans (enregistré à Caours dans la Somme) et l’interglaciaire actuel. Nous avons ainsi pu montrer que l’interglaciaire de La Celle, il y a 400 000 ans, avait été le plus chaud et le plus humide, ce qui explique, au moins en partie, la très grande richesse des faunes d’escargots, mais également la présence du macaque, de l’hippopotame et de plantes méridionales.

Par son épaisseur importante, rarement observée pour un tuf de cet âge, la diversité et la complémentarité des informations conservées, le tuf de La Celle peut maintenant être considéré comme une référence européenne pour la connaissance des changements environnementaux et climatiques au cours de la période interglaciaire survenue il y a 400 000 ans. De tels sites sont importants, car si les sédiments marins ou les couches de glace en Antarctique nous renseignent de façon spectaculaire sur les variations climatiques globales des dernières centaines de milliers d’années, il est plus complexe d’obtenir des enregistrements longs sur les séries des continents beaucoup plus soumises à l’érosion. Or, les macaques, les hippopotames… et les humains préhistoriques ne vivaient ni au fond des océans, ni au Pôle sud !

Si vous avez envie de voir à quoi ressemble ce tuf en vrai, bonne nouvelle : il est aménagé et accessible librement, alors venez le visiter !

Julie Dabkowski a reçu des financements de CNRS.

Nicole Limondin-Lozouet a reçu des financements de CNRS.

Pierre Louis Antoine a reçu des financements de CNRS

04.02.2026 à 11:26

Comment Sophie Adenot va étudier les effets de la gravité dans l’ISS

Marc-Antoine Custaud, Professeur de Physiologie, Université d’Angers

Texte intégral (1689 mots)

Pour comprendre l’effet de la gravité sur notre corps, il faut être capable de s’en soustraire, et la Station spatiale internationale est l’unique laboratoire où cela est possible sur des périodes prolongées. Sophie Adenot va pouvoir y mener différentes expériences pendant ses huit mois de mission.

Depuis plus de vingt ans, la Station spatiale internationale (ISS) est un laboratoire scientifique unique où l’absence de pesanteur met la physiologie humaine à l’épreuve. La station se déplace très vite autour de la Terre, elle est en chute libre permanente tout en restant en orbite terrestre, c’est cette configuration bien particulière qui fait que tout « flotte » à l’intérieur.

Nous parlerons plutôt d’état de micropesanteur, car il reste tout de même des accélérations minimes. Si l’astronaute dans l’ISS reste bien dans le champ de gravité de la Terre, les effets physiologiques de la gravité sur son organisme sont en revanche totalement supprimés. En conduisant des études biomédicales dans l’ISS, il s’agit non seulement de permettre à l’humain de s’adapter à un environnement extrême caractérisé par cette micropesanteur, mais aussi d’étudier le rôle de la gravité sur les grandes fonctions de notre organisme. Et comment comprendre le rôle de cette force omniprésente sur le vivant si ce n’est en étudiant la suppression de ses effets ?

Gravité et micropesanteur du niveau cellulaire jusqu’à l’organisme

Au niveau tissulaire, il existe des cellules spécialisées dont le rôle est de percevoir précisément la gravité. Ce sont par exemple les cellules ciliées du vestibule situé dans l’oreille interne chez l’humain. C’est l’organe dont la perturbation par l’absence de pesanteur contribue au mal de l’espace qui ressemble au mal de mer. La question de la faculté de graviception pour chacune de nos cellules se pose. Dans quelle mesure la force de gravité interagit-elle sur le cytosquelette, ce réseau de filaments protéiques à l’intérieur de la cellule qui lui donne sa forme et, plus généralement, sur les interactions moléculaires comme celle d’une enzyme avec son substrat ?

Au niveau de l’organisme, si la gravité n’existait pas, nul besoin d’un système cardiovasculaire aussi complexe avec ses mécanismes de protection permettant de maintenir une circulation normale au niveau du cerveau en position debout, cet organe a en effet besoin d’avoir un flux sanguin permanent et suffisant pour pouvoir fonctionner. Le tissu osseux serait inutile, au même titre que le tissu musculaire, puisqu’une partie importante du rôle de ces systèmes est de lutter contre la gravité. L’absence de pesanteur dans une station spatiale induit donc chez nos astronautes une sédentarité poussée avec toutes les conséquences médicales sur leur santé.

Déconditionnement à la gravité

La gravité a façonné le vivant depuis des millions d’années, et, de façon très surprenante, soustraire notre organisme de l’influence de cette force, même partiellement et après quelques jours seulement, conduit à une désadaptation à la gravité. C’est ce que nous appelons le déconditionnement. Ce syndrome comporte principalement un risque de syncope, une diminution de la capacité à effectuer un exercice physique, une amyotrophie, une fragilisation osseuse et des troubles métaboliques. De très nombreuses expériences sont ainsi conduites par les équipages dans l’ISS afin de comprendre l’impact de l’absence de pesanteur sur l’ensemble de nos grandes fonctions. À côté des expériences conduites dans un environnement spatial vrai, nous mettons aussi en place des études sur des analogues au sol par alitement (le sujet est rendu inactif dans un lit) ou par immersion sèche (le sujet flotte dans une grande baignoire au sec isolé par un film élastique). Il est aussi possible d’induire de courtes durées de micropesanteur (de l’ordre de trente secondes) en avion lors de vols paraboliques. Ces études, permettent de conduire des travaux sur un nombre de sujets plus importants et de valider des méthodes prophylactiques (appelées contre-mesures) afin de lutter contre ce déconditionnement, avant de les prescrire aux astronautes.

Le Centre national des études spatiales (CNES) est reconnu pour son soutien aux travaux de médecine et de physiologie spatiale ainsi que pour le développement d’outils spécifiques. Il s’appuie sur ses équipes d’ingénieurs qui ont une longue expérience dans le développement et la qualification de tels instruments biomédicaux. Il a lancé très tôt un programme dans le domaine cardiovasculaire. Citons le programme Physiolab, qui a été mis en œuvre lors de la mission Cassiopée (1996), à bord de la station Mir, par Claudie Haigneré, première astronaute française à être allée dans l’espace. Physiolab a permis une étude fine à l’échelle du battement cardiaque de la régulation cardiovasculaire. Suivre la fréquence cardiaque et la pression artérielle battement par battement permet de décrire et de comprendre la survenue des épisodes de syncope au retour sur terre. Plusieurs évolutions de ce système ont été utilisées depuis Physiolab, aboutissant aujourd’hui au programme « Physiotool ».

Le protocole Physiotool

Pour bien comprendre les effets d’un séjour dans l’espace sur le corps et surveiller de près le système cardiovasculaire des astronautes, il faut une approche intégrative qui permet de suivre non seulement les paramètres cardiovasculaires habituels, mais aussi des flux sanguins périphériques (cérébraux et musculaires), l’activation musculaire elle-même ainsi que les mouvements respiratoires.

C’est ce que permet Physiotool, développé et intégré par le CNES en combinant différents appareils biomédicaux utilisables en ambulatoire. Nous pourrons ainsi réaliser un suivi physiologique de l’astronaute au repos, lors de sessions d’exercices physiques, de stimulations cognitives ou sur de plus longues durées. Après des tests au sol, Physiotool sera utilisé en vol pour la première fois lors de la mission Epsilon.

Cet instrument développé par le CNES, en lien avec l’Agence spatiale européenne (ESA), permettra de réaliser un protocole scientifique porté conjointement par l’Université d’Angers et l’Université de Lorraine avec Benoît Bolmont. Physiotool a pour vocation de devenir un moniteur ambulatoire de la santé cardiovasculaire de l’astronaute !

Le protocole Echo-bones

La physiologie spatiale est une discipline qui favorise les études inter-systèmes. Nous souhaitons connaître dans quelle mesure les vaisseaux sanguins sont impliqués dans la fragilisation osseuse induit par l’absence de pesanteur. Le projet Echo-bones permet d’étudier à la fois la structure de l’os, mais aussi les flux vasculaires intra-osseux avec un échographe innovant.

Ce projet est particulièrement soutenu par le CNES et ouvre des perspectives en médecine pour mieux comprendre par exemple l’ostéoporose et l’arthrose. Ce protocole scientifique est porté en France par le CHU d’Angers, l’Université de Saint-Étienne (Laurence Vico) et aux Pays-Bas par l’Université de Delft (Guillaume Renaud qui est à l’origine du développement de cet échographe innovant). Dans le cadre de la mission Epsilon, des mesures en pré et post vols seront réalisées afin de quantifier les modifications osseuses induites par cette mission de longue durée.

Voici deux exemples d’études dont je suis l’investigateur principal et qui seront conduites à l’occasion de la mission Epsilon dont le décollage est prévu très prochainement. D’autres protocoles en médecine spatiale sont bien entendus mis en place avec le CNES dans le cadre de cette mission, comme Echo-Finder pour faciliter la réalisation, par un astronaute novice, en complète autonomie, d’une échographie afin d’étudier un ensemble d’organes (ce protocole est porté par l’Université de Caen). Ce système prépare les futures missions d’exploration lointaine (Lune, Mars). Et il y aura évidemment aussi tout le programme d’études scientifiques internationales réalisées régulièrement dans le domaine des sciences de la vie !

Et après ?

L’après-ISS se prépare activement (elle sera détruite en 2030), avec la programmation de futures stations spatiales, qu’elles soient privées ou issues de partenariats académiques, et qui ouvriront de nouveaux cadres pour la poursuite de nos études scientifiques et médicales. Parallèlement, des projets d’exploration spatiale se mettent en place, notamment avec les missions Artemis visant le retour très prochain sur la Lune.

Le suivi médical et physiologique des astronautes sera un point critique pour le succès de ces missions. Cette surveillance devra d’autant plus évoluer que de nouvelles problématiques médicales devront être prises en compte, comme l’exposition au régolithe (la poussière lunaire), l’augmentation des risques liés aux radiations cosmiques et l’éloignement de l’équipage dont les conséquences psychologiques doivent être anticipées.

Marc-Antoine Custaud a reçu des financements du CNES, de la région des Pays de la Loire et du CNRS. Il est président de l'ISGP, association scientifique à vocation académique (International Society for Gravitational Physiology)

04.02.2026 à 11:24

ISS : quelles expériences scientifiques va réaliser Sophie Adenot, la nouvelle astronaute française ?

Rémi Canton, Chef de Projet Vols Habités (CADMOS) , Centre national d’études spatiales (CNES)

Texte intégral (1685 mots)

Dans la Station spatiale internationale, les astronautes réalisent de nombreuses expériences scientifiques – c’est même le cœur de leur activité. Aujourd’hui, Rémi Canton, responsable au Centre national d’études spatiales de la préparation des expériences françaises à bord de l’ISS, nous parle des recherches scientifiques à bord.

The Conversation : Sophie Adenot, la nouvelle astronaute française, va partir un peu en avance par rapport à ce qui avait été prévu et devrait rester huit mois à bord d’ISS – ce qui est plus long que la plupart des missions ?

Rémi Canton : Oui, le départ de Sophie va peut-être être légèrement avancé à cause du retour anticipé de la mission précédente, en raison d’un problème de santé d’un des membres de l’équipage. La durée de sa mission en revanche n’est pas liée à des raisons scientifiques ou de santé, mais a été fixée par la Nasa qui souhaite réduire le nombre de lancements de rotation d’équipage pour réduire les coûts et prévoit donc que les missions à bord de l’ISS seront dorénavant plus longues.

Outre les expériences de physiologie dont nous parle votre collègue Marc-Antoine Custaud dans un autre article, Sophie Adenot va travailler sur les contaminations par des microorganismes : bactéries, champignons, virus… Mais honnêtement, on n’imagine pas au premier abord une station spatiale comme un nid à microbes ! D’où viennent ces contaminations ?

R. C. : La biocontamination n’est évidemment pas une spécificité spatiale, et il n’y a pas de problème particulier identifié à bord, mais les enjeux dans un espace confiné sont importants. En premier lieu pour protéger la santé de l’équipage, mais aussi pour minimiser le temps d’entretien afin de maximiser le temps consacré aux expériences scientifiques.

Le matériel que l’on monte est bien sûr désinfecté pour éviter d’amener toute sorte de contamination dans l’ISS. Mais il peut y avoir des résidus et, avec l’équipage à bord, il y a forcément du vivant. Le corps humain contient en grand nombre tout un ensemble de bactéries, de microchampignons et autres microorganismes, que l’on appelle le microbiote. Et qui peut se propager à cause de postillons, par exemple.

Il faut donc en limiter la prolifération, dans cet environnement confiné et que l’on ne peut pas aérer !

Dans quel but étudier ces contaminations ?

R. C. : Il s’agit d’abord de protéger la santé des astronautes, mais aussi la durée de vie du matériel, qui peut être endommagé par la corrosion bactérienne. Il y a des endroits difficiles d’accès et donc compliqués à nettoyer : connectique, derrière des câbles ou des baies informatiques, par exemple.

La première étape est de caractériser les microorganismes présents dans l’ISS et qui sont responsables de la biocontamination. La deuxième étape est de trouver des matériaux et des traitements – physiques et non chimiques – de surface, c’est-à-dire des textures ou revêtements, qui ralentissent ou empêchent la prolifération des contaminants. Soit en les piégeant, soit en les repoussant pour les empêcher de s’accrocher et de proliférer derrière un biofilm protecteur. Cela se fait grâce à l’expérience Matiss-4, dernière itération d’une expérience commencée dès la mission Proxima de Thomas Pesquet en 2016. On étudie par exemple des surfaces hydrophiles et hydrophobes, des surfaces texturées avec des petits plots en silice qui font que c’est plus difficile de s’accrocher d’un point de vue microscopique.

À terme, on espère identifier les meilleurs matériaux et revêtements qui pourraient être utilisés pour les futures stations spatiales et bases lunaires, et qui répondent parfaitement à cette problématique.

À bord, Sophie Adenot n’analysera pas ces surfaces ?

R. C. : Non, Sophie accrochera ces porte-échantillons avec différents types de surfaces dans des endroits stratégiques de l’ISS, près des filtres et bouches d’aération par exemple. Ils seront exposés pendant plusieurs mois à l’environnement ISS avant d’être ramenés sur Terre bien après sa mission pour une analyse au sol par fluorescence X ou spectroscopie Raman, par les scientifiques.

En parallèle, elle utilisera un deuxième instrument, appelé MultISS, caméra multimodale et multispectrale, qui permettra de prendre des photos des surfaces dans différentes longueurs d’onde (ultraviolets notamment) pour évaluer la contamination des surfaces invisible à l’œil nu. Cela permettra d’identifier les zones qui nécessitent le plus d’attention.

Existe-t-il pour ces expériences un objectif de développement d’applications qui soient utiles sur Terre ?

R. C. : Le but du Cadmos, le service dont je m’occupe au CNES, est d’abord de répondre à des objectifs scientifiques pour améliorer la connaissance et la compréhension de phénomènes inobservables sur Terre : nous recevons des demandes de laboratoires de recherche qui veulent observer certains phénomènes physiques, biologiques ou physiologiques en impesanteur, car cela permet de s’affranchir des effets de la gravité, comme le poids, la convection thermique, la poussée d’Archimède, la sédimentation ou la pression hydrostatique. Ces chercheuses et chercheurs ne cherchent pas à aller dans l’espace ! Au contraire, pour eux c’est plus une contrainte qu’autre chose. Mais c’est le seul endroit où ils peuvent avoir accès à l’impesanteur sur de longues périodes, ce qui leur « ouvre les yeux » sur un univers invisible sur Terre.

Donc, pour répondre à votre question : les applications terrestres ne sont pas dans le cahier des charges initial, c’est le principe même de la recherche fondamentale, mais le fait est que l’on découvre ensuite une multitude d’applications terrestres possibles.

Par exemple, nous avons étudié les fluides supercritiques (des fluides sous très haute pression et très haute température) dans l’expérience DECLIC. Parmi les propriétés qui ont été découvertes : en présence d’un oxydant, l’eau supercritique dissout et oxyde les substances organiques sans dégager d’oxyde d’azote… En d’autres termes, il s’agit d’un procédé de combustion « propre », beaucoup moins polluante. Au niveau spatial, cela pourrait être très intéressant pour le traitement des déchets, par exemple, sur une base lunaire. C’est d’ailleurs ce procédé qu’utilise Matt Damon dans Seul sur Mars, avec notre expérience, pour traiter ses déchets organiques. Mais ce serait surtout une technologie très utile sur Terre, car bien moins polluante que les incinérateurs classiques. Peut-être avec un rendement moindre que dans l’ISS, car le fluide supercritique serait moins homogène qu’en impesanteur, mais ce serait une technologie issue de la recherche spatiale, et qui a d’ailleurs commencé à être déployée pour traiter les déchets de certaines usines pétrochimiques.

Au-delà des expériences scientifiques qui nous sont demandées par les chercheurs, nous travaillons aussi à la préparation des technologies nécessaires pour l’exploration habitée plus lointaine. Et même si c’est moins intuitif et que cela peut paraître paradoxal, beaucoup d’applications terrestres découlent de cette branche. Car il s’agit de répondre à des problématiques de gestion et de recyclage de l’eau, le stockage de l’énergie, le traitement des déchets ou l’autonomie en santé. Et en effet, un équipage dans une station ou sur une base spatiale doit utiliser au mieux des ressources limitées, comme nous sur Terre, à une autre échelle. L’environnement exigeant et très contraint du spatial nous force ainsi à trouver des solutions innovantes, et sert ainsi d’accélérateur de technologie. Nous avons par exemple développé des techniques pour faire de l’échographie à distance avec des sondes motorisées et pilotables à distance, qui sont utilisées aujourd’hui en télémédecine dans des déserts médicaux.

Nous parlions de prévention de biocontamination tout à l’heure : l’objectif initial était une application spatiale, mais au final l’application sera surtout terrestre, pour les milieux hospitaliers, les transports en commun (barres de métro…), les lieux publics (boutons d’ascenseur, poignées de porte…), afin d’éviter la propagation d’agents pathogènes.

En parlant de recherche fondamentale : en 2023, l’astronaute danois Andy Morgensen a fait une mousse au chocolat pour étudier la formation d’émulsions en micropesanteur. Est-ce que Sophie Adenot va tester une nouvelle recette ?

R. C. : Oui, mais plus pour le plaisir que pour la science, cette fois-ci ! Nous avons juste décidé d’intégrer un objectif supplémentaire par rapport à la mousse au chocolat : dans un scénario réaliste, il n’y aura ni cacaotier ni d’œufs sur une base lunaire… Sophie va réaliser ce coup-ci une recette incorporant des ingrédients que des astronautes pourraient un jour faire pousser sur une base spatiale. Au menu : houmous et caviar d’aubergine !

Rémi Canton ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

03.02.2026 à 17:14

Addicts à nos écrans : et si tout avait commencé avec la télé en couleurs ?

Jean-Michel Bettembourg, Enseignant, Métiers du multimédia et de l'Internet, Université de Tours

Texte intégral (1882 mots)

Octobre 1967, le premier programme en couleurs est diffusé sur la deuxième chaîne de l’ORTF (aujourd’hui, France 2). Pourtant, la démocratisation de la télévision couleur a pris de nombreuses années, pour s’imposer à la fin des années 1980 dans quasiment tous les foyers de France, créant une forme de séduction qui se poursuit peut-être aujourd’hui à travers l’addiction aux écrans.

Le 1er octobre 1967, dans quelques salons français, le monde bascule avec l’avènement de la télévision en couleurs : une révolution médiatique, mais aussi politique, sociale et culturelle.

Cette première diffusion a lieu sur la deuxième chaîne de l’Office de radiodiffusion-télévision française (ORTF). Mais la télévision en couleurs, au début, n’est pas à la portée de tous. Pour la grande majorité des Français, elle reste un rêve inaccessible. Il y a, d’un côté, une ambition nationale immense pour promouvoir cette vitrine de la modernité et, de l’autre, une réalité sociale qui reste encore largement en noir et blanc.

La décision, très politique, vient d’en haut. La couleur n’était pas qu’une question d’esthétique, et le choix même de la technologie, le fameux procédé Sécam, est une affaire d’État. Plus qu’une décision purement technique, le choix d’un standard de télé est en réalité une affaire de souveraineté nationale.

Pour comprendre ce qui se joue, il faut se replacer dans le contexte de l’époque. Dans la période gaullienne, le maître mot, c’est l’indépendance nationale sur tous les fronts : militaire, diplomatique, mais aussi technologique.

Un standard très politique

Pour le général de Gaulle et son gouvernement, imposer un standard français, le Sécam, est un acte politique aussi fort que de développer le nucléaire civil ou plus tard de lancer le programme Concorde. La France fait alors face à deux géants : d’un côté le standard américain, le NTSC, qui existe déjà depuis 1953, et le PAL, développé par l’Allemagne de l’Ouest. Choisir le Sécam, c’est refuser de s’aligner, de devenir dépendant d’une technologie étrangère.

L’État investit. Des millions de francs de l’époque sont investis pour moderniser les infrastructures, pour former des milliers de techniciens et pour faire de la deuxième chaîne une vitrine de cette modernité à la française. Sécam signifie « Séquentiel couleur à mémoire », un système basé sur une sorte de minimémoire tampon avant l’heure, qui garantit une transmission sur de longues distances et des couleurs stables qui ne bavent pas.

Le pari est audacieux, car si la France opte ainsi pour un système plus robuste, cela l’isole en revanche du reste de l’Occident. Le prix à payer pour cette exception culturelle et technologique est double. Tout d’abord, le coût pour le consommateur : les circuits Sécam étaient beaucoup plus complexes et donc un poste TV français coûtait entre 20 et 30 % plus cher qu’un poste PAL, sans compter les problèmes d’incompatibilité à l’international. L’exportation des programmes français est acrobatique : il faut tout transcoder, ce qui est coûteux et entraîne une perte de qualité. Et ce coût, justement, nous amène directement à la réalité sociale de ce fameux 1er octobre 1967.

Fracture sociale

D’un côté, on avait cette vitrine nationale incroyable et, de l’autre, la réalité des salons français. Le moment clé, c’est l’allocution du ministre de l’information Georges Gorse qui, ce 1er octobre 1967, lance un sobre mais historique « Et voici la couleur… ». Mais c’est une image d’Épinal qui cache la fracture.

Le prix des télévisions nouvelle génération est exorbitant. Un poste couleur coûte au minimum 5 000 francs (soit l’équivalent de 7 544 euros, de nos jours). Pour donner un ordre de grandeur, le smic de l’époque est d’environ 400 francs par mois … 5 000 francs, c’est donc plus d’un an de smic, le prix d’une voiture !

La démocratisation a été extrêmement lente. En 1968, seuls 2 % des foyers environ étaient équipés, et pour atteindre environ 90 %, il faudra attendre jusqu’en… 1990 ! La télévision couleur est donc immédiatement devenue un marqueur social. Une grande partie de la population voyait cette promesse de modernité à l’écran, mais ne pouvait pas y toucher. La première chaîne, TF1, est restée en noir et blanc jusqu’en 1976.

Cette « double diffusion » a accentué la fracture sociale, mais en même temps, elle a aussi permis une transition en douceur. Le noir et blanc n’a pas disparu du jour au lendemain. Et une fois ce premier choc encaissé, la révolution s’est mise en marche.

La couleur a amplifié de manière exponentielle le rôle de la télé comme créatrice d’une culture populaire commune. Les émissions de variétés, les feuilletons, les jeux et surtout le sport, tout devenait infiniment plus spectaculaire. L’attrait visuel était décuplé. Lentement, la télévision est devenue le pivot qui structure les soirées familiales et synchronise les rythmes de vie. Et en coulisses, c’était une vraie révolution industrielle. L’audiovisuel s’est professionnalisé à une vitesse folle. Les budgets de production ont explosé.

Cela a créé des besoins énormes et fait émerger de tout nouveaux métiers, les étalonneurs, par exemple, ces experts qui ajustent la colorimétrie en postproduction. Et bien sûr, il a fallu former des légions de techniciens spécialisés sur la maintenance des caméras et des télés Sécam pour répondre à la demande. Dans ce contexte, l’ORTF et ses partenaires industriels, comme Thomson, ont développé des programmes ambitieux de formation des techniciens, impliquant écoles internes et stages croisés.

Le succès industriel est retentissant. L’impact économique a été à la hauteur de l’investissement politique initial. L’État misait sur la recherche et le développement. Thomson est devenu un leader européen de la production de tubes cathodiques couleur, générant des dizaines de milliers d’emplois directs dans ses usines. C’est une filière entière de la fabrication des composants à la maintenance chez le particulier qui est née.

Et puis il y a eu le succès à l’exportation du système. Malgré son incompatibilité, le Sécam a été vendu à une vingtaine de pays, notamment l’URSS.

La place des écrans dans nos vies

Mais en filigrane, on sentait déjà poindre des questions qui nous sont très familières aujourd’hui, sur la place des écrans dans nos vies. C’est peut-être l’héritage le plus durable de la télévision en couleurs. La puissance de séduction des images colorées a immédiatement renforcé les craintes sur la passivité du spectateur. On commence à parler de « consommation d’images », d’une « perte de distance critique ».

Le débat sur le temps d’écran n’est pas né avec les smartphones, mais bien à ce moment-là, quand l’image est devenue si attractive, si immersive, qu’elle pouvait littéralement « capturer » le spectateur. La télé couleur, avec ses rendez-vous, installait une logique de captation du temps.

Et avec l’arrivée des premières mesures d’audience précises à la fin des années 1960, certains observateurs parlaient déjà d’une forme d’addiction aux écrans. La couleur a ancré durablement la télévision au cœur des industries culturelles, avec le meilleur des créations audacieuses et le moins bon, des divertissements certes très populaires mais de plus en plus standardisés.

L’arrivée de la couleur, c’était la promesse de voir enfin le monde « en vrai » depuis son salon. Cette quête de réalisme spectaculaire, de plus vrai que nature, ne s’est jamais démentie depuis, de la HD à la 4K, 6K et au-delà. On peut alors se demander si cette promesse initiale vendue sur un écran de luxe ne contenait pas déjà en germe notre rapport actuel à nos écrans personnels ultraportables, où la frontière entre le réel et sa représentation est devenue une question centrale.

Jean-Michel Bettembourg ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Time [Fr]

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- L'Autre Quotidien

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- AlterQuebec

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview