11.03.2026 à 16:41

« Une bataille après l'autre », ou le grand spectacle des clandestins

Vincent Amiel, professeur d'histoire et esthétique du cinéma, Université Paris 1 Panthéon-Sorbonne

Texte intégral (1512 mots)

Le dernier long métrage de Paul Thomas Anderson, Une bataille après l’autre, nommé 13 fois aux Oscars dont la cérémonie se tient ce dimanche 15 mars, n’est pas seulement un film à grand spectacle. C’est une œuvre qui utilise ses moyens (considérables) et ses nombreuses références au cinéma américain des années 1970 pour montrer une réalité politique dont le spectacle même en est la ruse ultime.

En exergue de son film sans doute le plus spectaculaire, Il était une fois la révolution, Sergio Leone avait fait figurer cette citation de Mao : « la révolution n’est ni un dîner de gala, ni une œuvre littéraire, ni un dessin, ni une broderie, on ne la fait pas avec élégance et courtoisie. La révolution est un acte de violence… » De cet avertissement, Paul Thomas Anderson a retenu la leçon, mais il a surtout retenu que l’on pouvait en faire un spectacle grandiose : c’est le terme qu’emploie son héroïne au tout début d’Une bataille après l’autre :

« On annonce la révolution ! Je veux du grand, du beau, du grandiose ! »

Trame de références

Nommé 13 fois aux Oscars, le film a tout d’un classique contemporain : il emprunte au cinéma « libéral » des années 1930 le thème de la poursuite à travers le pays, de la lutte individuelle contre le système, utilisant les mêmes effets dramaturgiques autour de héros positifs qui cristallisent l’empathie. Mais il ajoute à cette dynamique une dimension développée par les auteurs du Nouvel Hollywood dans les années 1970, au premier rang desquels se situent par exemple un Francis Ford Coppola ou un Robert Altman, une tension constante entre spectacle et complot, hyper-visibilité et clandestinité.

Ainsi, le spectacle des scènes d’action et de poursuites du film lui-même, de la musique incessante, spectacle ô combien réel et efficace, pourrait n’être interprété que comme une compromission avec le cinéma commercial et ses enjeux économiques. Alors qu’il est celui qui se joue quotidiennement dans la société américaine, à coups d’images télévisées, de déclarations intempestives, de violence permanente. Et dont Trump aujourd’hui s’est fait l’infatigable metteur en scène.

Une bataille après l’autre organise une trame de références aussi bien à l’actualité états-unienne contemporaine qu’à l’histoire des films qui l’ont prise en charge au siècle dernier. Même pour nous, spectateurs peu au fait des événements politiques et quotidiens qui font battre la vie américaine, vus d’Europe au prisme d’une distance qui grandit, nous reconnaissons hélas dans les MKU commandés par Sean Penn dans le film les agents de l’ICE dont les images des actions, glaçantes en effet, ont inondé les écrans après les brutalités de Minneapolis. Leur commandant qui s’avance à visage découvert, avec ses cheveux courts coiffés en épis, au milieu de soldat suréquipés et masqués, est la réplique stupéfiante du personnage de fiction. Et lorsque celui-ci, dans une voiture, se recoiffe avec un peigne sur lequel il a craché, on ne peut que se remémorer la scène où Paul Wolfowitz, sous-secrétaire d’État à la défense et conseiller de George Bush Jr, fait la même chose devant des journalistes éberlués, scène que Michael Moore a gravée dans Fahrenheit 9/11.

Faire du spectacle de la réalité une fiction

Mais tous ces effets de réel sont emportés dans Une bataille après l’autre par une telle énergie spectaculaire qu’ils changent petit à petit de statut. Ils ne constituent plus un fond de réalisme, mais deviennent eux-mêmes, par leur extravagance, les clous du feu d’artifice.

Faisant un pas de côté par rapport à ses modèles classiques ou même postmodernes, Anderson ne met pas en scène la réalité comme un spectacle, il fait du spectacle de la réalité une fiction, qui peine à suivre le rythme de celle-ci. On est très loin des immeubles transparents et panoramiques du Wall Street de Scorsese ou des bureaux aux perspectives infinies de tout un pan du cinéma américain contemporain : tout se joue dans le chaos nocturne de rues prises d’assaut, dans la précipitation de couloirs aveuglés, de tunnels enfumés, de portes dérobées, de cavalcades essoufflées (et la seule séquence, à la toute fin du film, dans laquelle cette transparence architecturale apparaît, hommes de pouvoir et bureaux surplombant la ville, si métaphorique et incontournable soit-elle, est à cet égard très ironique).

Même les espaces désertiques ou les recoins de forêt, qui ont toujours constitué des refuges dans la littérature ou dans le cinéma américains, lesquels profitent de la démesure des paysages, même ces lieux de robinsonnades ou de chevauchées, perdent leur fonction de réserve.

Désincarnation des protagonistes

Le personnage incarné par Leonardo DiCaprio, avec son bonnet et sa robe de chambre, est déjà une figure des contre-héros américains : il emprunte au Jack Nicholson de Cinq pièces faciles ou de Vol au-dessus d’un nid de coucous, mais il emporte dans son sillage maladroit et bousillé par les drogues un mouvement beaucoup plus général, qui ne doit plus rien à l’anecdote, pas plus qu’à la psychologie ou aux conditions sociales : il est l’habitant d’un pays qui n’est plus le sien, l’acteur d’un road-trip qui n’a plus d’horizon, sur des routes qui n’en finissent plus.

L’habileté du film réside dans sa manière de dépersonnaliser tous les personnages, ne leur prêtant ni sentiments ni épaisseur romanesque, les laissant tributaires des courants et des forces qui les portent, aux rangs desquels, indifféremment, on peut trouver les pulsions sexuelles ou les engagements politiques. C’est donc une alchimie étrange qui dans le film mêle le réalisme des situations, ici et maintenant, et la sorte de désincarnation de ses protagonistes.

La pasionaria, le commandant des forces spéciales, le complice lui-même ont abandonné toute épaisseur romanesque : d’où sortent-ils, quels sont leurs véritables sentiments, leurs volontés propres ? Ce n’est plus le ressort de la dramaturgie. Il y a comme une mécanique des forces en présence qui fait à elle seule avancer l’action.

Ancré dans l’actualité, truffé de références précises et identifiables, Une bataille après l’autre se dégage ainsi, paradoxalement, de toute circonstance singulière. Il échappe aussi bien à l’anecdote qu’à la fable, faisant de son histoire l’histoire de la société américaine d’aujourd’hui.

Le film d’Anderson, s’il joue des mêmes effets dramatiques outranciers que ceux que l’on peut trouver chez Quentin Tarantino ou ceux de certains films des frères Coen (violence du montage, cynisme des personnages, fulgurance des actions), en profite pour construire un monde qui inquiète et interroge. Tous les moyens du grand cinéma hollywoodien d’aujourd’hui, au lieu de distraire et divertir, deviennent le sujet de l’intrigue, recentrent sur l’essentiel qui est précisément leur propre envahissement de l’espace public. Ils désignent la spectacularisation même de la réalité – qui n’est pas la même chose que celle de la société, dont le XXᵉ siècle se préoccupait.

Vincent Amiel ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.03.2026 à 12:07

Au plus près des prisonnières politiques dans l’Espagne de Franco

Irène Gimenez, Post-doctorante, Sorbonne Université

Texte intégral (1983 mots)

De nombreuses militantes antifranquistes nées après la guerre ont été arrêtées et emprisonnées en raison de leur engagement politique durant la dictature du Caudillo. Longtemps restés dans l’ombre d’une histoire dominée par les récits masculins, leurs parcours dévoilent une facette spécifique de la répression. Dans son ouvrage Prisonnières politiques en Espagne, qui vient de paraître aux éditions du CNRS, Irène Gimenez, docteure en histoire et post-doctorante à Sorbonne Université, revient sur les expériences intimes et collectives de ces femmes incarcérées et montre que la prison est, dans une large mesure, une affaire de genre. Extraits de l’introduction.

Carme Claramunt. Isabel García Vicente. Victòria Pujolar Amat. Maria Salvo Iborra. Laia Berenguer Puget. Antoñita García. Julia Conesa. Neus Catalá. Mercedes Nuñez Targa. Montserrat Roig Francitorra. Núria Aleu i Sanfeliu. Carme Forcadell.

Ces noms sont ceux des prisonnières dont les témoignages sont au cœur de la pièce de « théâtre-document », montée à l’Athénée populaire de Barcelone en 2019, sous le titre « Que leurs noms ne soient PAS effacés de l’Histoire ». Portée par les associations Teatre dona et Dones a la Palestra, cette production culturelle et militante propose une narration alternative à la mémoire publique qui passe par la construction d’une continuité entre différentes institutions et contextes, au sujet de la répression contre les femmes.

Le récit commence à la prison de Saturrarán (1938-1944), en s’appuyant sur une lettre rédigée par une prisonnière anonyme à sa mère en décembre 1938. Il est ensuite irrigué par des témoignages sur les prisons de Les Corts (Barcelone, 1939-1955), Ventas (Madrid, 1931-1969), sur le camp de Ravensbrück, puis sur les prisons de Yeserías (Madrid, 1974-1991) et Trinidad (Barcelone, 1963-1983). Il se termine à la prison Mac d’Enrich, ouverte en 2015, où sont emprisonnées les responsables politiques inculpées à la suite du référendum du 1er octobre 2017 sur l’indépendance de la Catalogne (le Procés). La dictature qui s’installe après le coup d’État militaire du 18 juillet 1936 et trois ans de guerre se caractérise par sa longue durée. La répression qu’elle génère contre les « rouges » est ici réinscrite dans des mécanismes de reproduction des violences commises contre les femmes.

Núria Aleu i Sanfeliu écrit en octobre 2017 à Carme Forcadell, la présidente du Parlement catalan emprisonnée à Mac Enrich. Sa lettre, lue dans la pièce, contient ces mots : « Je ne t’ai pas écrit avant parce que pour moi la prison est un souvenir pesant que j’ai tenté d’effacer de ma mémoire […] j’espère que mes expériences peuvent t’aider. »

Son parcours intéresse à plusieurs titres. Cette fille de la bourgeoisie catalane née en 1958 n’a de la guerre qu’une connaissance indirecte, transmise. Elle fait partie de cette nouvelle génération de l’antifranquisme qui s’engage dans le sillage des grandes mobilisations étudiantes et ouvrières de 1956. Elle rejoint un groupe anarchiste. À 17 ans à peine, en septembre 1975, elle est arrêtée par la brigade politico-sociale (BPS, la police politique), envoyée à la Préfecture de police de la via Laietana puis à la prison pour femmes de Barcelone, la Trinidad. Elle y passe plusieurs mois et rencontre d’autres militantes avec qui j’ai pu m’entretenir. Son passage par Trinidad, alors gérée par un institut séculier fondé en pleine guerre d’Espagne, les Cruzadas evangélicas de Cristo-Rey [Croisées évangéliques du Christ-Roi], se fait dans la période mouvementée des derniers mois de la vie de Franco, marquée par une forte conflictualité sociale et les espoirs d’amnistie.

Après la mort de Franco le 20 novembre 1975, elle participe à une grève de la faim pour revendiquer l’amélioration des conditions de détention. Elle bénéficie d’une mesure de grâce et sort en liberté provisoire, dans l’attente d’un conseil de guerre qui n’aura jamais lieu.

Elle ne rédige cette lettre que plusieurs décennies après. Faute d’un espace d’écoute jusque-là, c’est à l’occasion d’une crise politique dans son expérience militante actuelle, celle de militante féministe et indépendantiste, qu’elle écrit sur la répression qu’elle a subie. Elle revient sur sa tristesse et sa colère, sur des expériences concrètes d’enfermement, de répression linguistique et de solidarité entre femmes. Cette lettre est un exemple de la manière dont les mobilisations — mémorielles, sociales, politiques — ont percuté mon enquête, commencée en 2015-2016 dans le cadre d’une thèse en histoire.

D’une part, cette enquête s’est déroulée en parallèle du processus de paix au Pays basque (avec l’autodissolution de l’organisation Euskadi Ta Askatasuna, ETA, en 2018) et du renouveau des luttes indépendantistes catalanes.

D’autre part, elle a été marquée par les combats pour l’exhumation des fosses communes, la réparation, la justice et la mémoire des victimes d’une dictature dont les responsables n’ont jamais été jugés du fait de la loi d’amnistie mutuelle votée par le Congrès en octobre 1977, dans un objectif de réconciliation. L’arrivée au pouvoir de la coalition PSOE/Podemos (2018) a ouvert des débouchés politiques et législatifs à ces revendications.

Ce livre paraît dans ce contexte d’exigences mémorielles, peu après le cinquantenaire de la mort de Franco, entre célébration des « 50 ans de liberté », consolidation de la démocratie impulsée par le gouvernement et multiplication des discours et mobilisations révisionnistes. Le parti d’extrême droite Vox participe à normaliser le franquisme, au service de son projet réactionnaire et xénophobe. L’exaltation de Franco dans les mémoires de l’ancien roi Juan Carlos I coïncide avec des messes d’hommage et des mobilisations néofascistes qui croisent nostalgie de la dictature et projets d’intervention politique.

À lire aussi : Les Mémoires de l’ancien roi Juan Carlos suscitent la polémique en Espagne

Comme la metteuse en scène qui met en avant l’importance de nommer, ce livre n’anonymise que partiellement les actrices dont il est question. Dans le cas de personnalités publiques ayant publié ou avec leur accord explicite, j’ai laissé les noms, pour ne pas reproduire l’invisibilité qu’elles sont nombreuses à dénoncer. En revanche, j’ai masqué ceux des personnes identifiées dans les archives. Face au risque de révisionnisme qui pèse sur les luttes antifranquistes et parce que « l’histoire est faite de noms et de prénoms », Carme Travesset Rossellò me demande d’apparaître avec son nom complet. Asun Hernández García m’invite elle aussi à la nommer du fait « qu’elle n’a pas de problème après avoir traversé quatre prisons ». D’autres, en revanche, ont préféré que j’utilise leurs initiales ou n’ont pas répondu. J’ai respecté le souhait de chacune.

La prison, une affaire de genre

Les prisons recouvrent des pratiques, des établissements aux logiques et fonctionnements distincts (les prisons préventives, équivalent des maisons d’arrêt ; les prisons pénales, équivalent des prisons centrales) ou encore des productions discursives. Différents critères de classement entrent en concurrence et dessinent un réseau complexe d’établissements au sein de la géographie des prisons : le sexe, l’âge, l’engagement religieux (en vertu du Concordat [note : un Concordat entre l’Espagne franquiste et le Vatican est signé en 1953. Dans ce cadre, les prêtres sont incarcérés dans une prison spéciale, à Zamora. Les religieuses, en revanche, sont mêlées aux autres prisonnières]), les infractions militaires, la situation pénale (condamné·e ou non), le comportement. La différenciation de genre est, en prison, un principe majeur d’organisation socio-spatiale et de classement des individus. Le règlement de 1968 introduit un système progressif en trois degrés, précédant la liberté conditionnelle : la rééducation, la réadaptation sociale et la préliberté. Les femmes n’en sont pas exclues, mais elles ne disposent pas d’espaces de détention dédiés à cette période.

Que les prisons soient des espaces majoritairement non mixtes, que la prison ait été un espace construit par et pour les hommes et que les prisonnier·es, à l’époque étudiée comme aujourd’hui, soient majoritairement des hommes, invite à différentes perspectives. Il ne s’agit pas ici d’écrire une histoire des prisons de femmes qui serait une annexe d’une histoire générale des prisons écrite au masculin. Attentif aux circulations et aux comparaisons, ce livre opte pour une perspective relationnelle, dans le but d’écrire une histoire mixte. Au-delà du constat de la séparation entre hommes et femmes, cette approche vise à saisir les mécanismes de production des normes, identités et rapports de genre en prison. Quelles sont les masculinités et féminités produites par l’incarcération ?

Les prisons sont des espaces hiérarchisés et différenciés — entre elles et en leur sein —, et elles produisent des expériences matérielles et spatialisées. Elles établissent les contours de ce que la sociologue Coline Cardi nomme des « régimes institutionnels de genre ».

Il importe à ce titre de s’intéresser aux effets de la non-mixité, des inégalités et des normes de genre sur les traitements des hommes et des femmes incarcéré·es, suivant la perspective à laquelle invite Corinne Rostaing : « De nombreuses questions relatives à la mixité n’ont pas été étudiées jusqu’à présent en termes de genre, notamment ce que produit l’entre-soi masculin et l’entre-soi féminin. » En observant les sociabilités aux portes des prisons (d’hommes), Irene Abad a démontré comment les femmes se politisaient dans cet espace liminaire où elles sont majoritaires à gérer la solidarité. Déplacer le regard permet de constituer, à l’instar de Gwénola Ricordeau, la prison comme un problème de femmes, un problème pour les femmes et donc une question féministe.

Irène Gimenez a reçu des financements de l'université Lyon 2 et est actuellement en poste à Sorbonne Université (programme SOUND).

11.03.2026 à 12:06

La famille selon les philosophes classiques : organiser la vie par contrat, un rempart contre le patriarcalisme ?

Gabrielle Radica, Professeure des universités en philosophie, Université de Lille

Texte intégral (2457 mots)

En France, le droit autorise les familles à organiser de larges pans de leur vie par contrat. Cela implique-t-il que la vie domestique soit un espace de liberté pour les individus ? Ou la contractualisation renforce-t-elle au contraire les contraintes et les normes ? Depuis le XVIIe siècle, cette évolution fait débat chez les philosophes. Explications avec Hobbes, Locke ou encore Rousseau, à partir du recueil la Famille des classiques (éditions de l’ENS-Lyon), qui explore ces pensées de l’institution familiale sous différentes facettes.

Si, au contraire de ce qui se fait dans de nombreux pays, le législateur français interdit les contrats de gestation pour autrui, il autorise les familles à organiser de larges pans de leur vie commune par convention et par contrat.

On connaissait depuis longtemps les contrats de mariage, qui organisent la distribution et la gestion des biens matrimoniaux. On voit apparaître désormais d’autres arrangements du même genre, comme ces « conventions parentales » par lesquelles les parents « organisent les modalités d’exercice de l’autorité parentale et fixent la contribution à l’entretien et à l’éducation de l’enfant » après leur séparation et qu’ils peuvent faire homologuer par le juge aux affaires familiales (article 373-2-7 du Code civil).

C’est vrai, on parle ici de « convention » parentale et le juriste distinguera le genre, à savoir ladite convention, qui désigne tout accord de volontés, de l’espèce, le contrat, qui accorde aussi des volontés, mais qui présente la particularité supplémentaire de créer des obligations. Il n’empêche, l’idée règne selon laquelle les liens familiaux seraient devenus toujours plus contractuels et, par là, toujours plus volontaires.

Mais qu’entend-on exactement par là ? La chose n’est pas toujours claire et elle peut revêtir plusieurs significations : que la vie familiale et domestique est devenue plus libre, qu’elle est devenue plus individualisée ou bien, au contraire, qu’elle est toujours plus formalisée et encadrée.

Les philosophes classiques nous aident à apprécier ce phénomène, son histoire et sa complexité. Les noms de Locke, Hobbes, Rousseau ou encore Montesquieu évoquent souvent la figure de philosophes politiques, de penseurs du droit, du pouvoir et du contrat social. On sait moins que ces auteurs ont tous été aussi des penseurs de la famille, qu’ils y ont consacré de nombreuses pages. C’est pour le rappeler qu’est publié le recueil de textes la Famille des classiques aux éditions de l’ENS-Lyon.

Contrat familial et contrat social

De fait, leurs propos sur la famille sont inséparables de leur pensée politique. Pouvoir, autorité, règles, intérêt, ces notions ne sont-elles pas communes à la famille et à l’État ? Soit qu’ils pensent la famille sur le modèle de l’État, le père constituant comme un petit souverain à l’égard de ses enfants, de son épouse et de ses domestiques, soit qu’ils les opposent parce que la famille, à la différence de la société politique, unit ses membres par les sentiments, la proximité et les affaires plus ou moins triviales qui ne concernent qu’eux (éducation, sexualité, subsistance), ces auteurs classiques ont tous été conscients que l’on doit y réfléchir ensemble.

On invite ainsi dans ce livre à relire les pages de Hobbes sur le pouvoir paternel, celles de Locke sur le pouvoir parental partagé et sur la possibilité de divorcer ou encore celles de Rousseau sur la maternité et l’enfance, puis à relier ces réflexions à la sphère politique.

Il ne faut pas exclure dès lors que la fameuse idée de contrat social, c’est-à-dire l’énoncé des conditions sous lesquelles nous sommes réunis dans un État, obéissons aux mêmes lois, bénéficions des mêmes protections collectives, ait trouvé sa source dans le modèle des contrats privés. Ainsi les notions de contrat et de contractualisme (l’idée de cadrer les relations entre des particuliers) fonctionnent à plusieurs échelles, privée et publique, familiale et politique.

Quand le contrat devient piège

L’idée de contrat attire et effraie tout à la fois ceux qui aspirent à garantir la liberté individuelle : le consentement n’est-il pas le meilleur moyen de la liberté ? Chacun ne souhaite-t-il pas définir et poser à l’avance les règles de son existence avec autrui ? Cependant le contrat n’est-il pas un piège et un moyen habile qu’ont trouvé certains pour nous asservir avec notre consentement en bonus ?

Le contractualisme familial a toujours trouvé des défenseurs (Daniel Borrillo le défend aujourd’hui dans la Famille par contrat) et des détracteurs (ainsi de Carole Pateman, le Contrat sexuel). Le savant Henry Maine affirme au XIXe siècle que la société moderne représente l’abandon d’un modèle social fondé sur des statuts rigides au profit d’une société contractuelle où la volonté individuelle prend toujours plus d’importance.

Or, dès le XVIIe siècle, Grotius, Hobbes, Pufendorf, explorent l’importance cruciale du consentement dans l’établissement des relations proprement humaines. Mais nous serons surpris de lire qu’ils le font pour le meilleur et pour le pire. Le contrat étant l’outil universel auquel ils recourent pour penser toutes les relations humaines, ils le mobilisent au sujet du lien conjugal ainsi que du lien parental.

Hobbes considère que, quoique les enfants soient longtemps incapables de passer de tels contrats, on doit faire comme s’ils avaient passé avec leurs parents des conventions qui assurent une obéissance absolue en échange de leur subsistance. Ce n’est pas tout : ces penseurs, philosophes (Hobbes) ou spécialistes du droit (Grotius et Pufendorf), recourent aussi au contrat pour organiser le rapport des maîtres à leurs serviteurs, voire pour penser les conditions juridiques de l’esclavage. Pufendorf va jusqu’à dire que l’esclavage lui-même doit être contractualisé. Ce rappel affligera certainement les partisans du contrat et confortera ses adversaires : le contrat a été bien des fois convoqué pour encadrer diverses formes de servitude domestique et économique.

De deux choses l’une : soit le fait de contracter est tellement général et ambivalent qu’il ne contient par soi aucune promesse de liberté, et peut engendrer le pire comme le meilleur, soit il faut rompre avec des conceptions du contrat qui admettent que l’on puisse contracter pour se donner tout entier à un maître et perdre sa liberté. C’est le second choix qu’opèreront Locke et Rousseau qui rompront avec leurs prédécesseurs, et qui ne pardonneront pas à Grotius, Hobbes et Pufendorf d’avoir fait servir le contrat à de telles fins. « Dire qu’un homme se donne gratuitement, c’est dire une chose absurde et inconcevable ; un tel acte est illégitime et nul », objecte vigoureusement Rousseau à Grotius dans le Contrat social.

Le contrat, moyen de lutter contre le pouvoir intra-familial ?

Ainsi, il serait outré de faire du contrat seulement un moyen habile d’obtenir l’obéissance sans avoir à recourir à la violence. Le contrat a aussi été un outil de lutte contre le patriarcalisme et le philosophe anglais Locke nous intéresse parce qu’il cadre le contrat : on ne peut contracter contre soi-même, on ne peut contracter pour se faire esclave et le contrat est plutôt l’expression d’un échange de bons procédés, d’une association humaine qui ne vaut que si elle se tient dans des limites et un cadre raisonnables.

Là où Hobbes pensait des pères exigeant tout, et ne devant rien à leurs enfants, des maris despotes autorisés par un contrat léonin passé entre puissants et vulnérables à obtenir ce qu’ils veulent des seconds, Locke voit dans le contrat le moyen de limiter le pouvoir intra-familial. Selon Locke, le philosophe de la modération, les époux ne s’associent que dans la poursuite de la subsistance, de la procréation et de l’éducation des enfants. Ils le font librement. Or, ce que la volonté a fait, elle peut le défaire. Aussi, une fois leur mission accomplie, et dans l’hypothèse où ils ne s’entendraient pas, les époux pourraient très bien divorcer si cela se présentait comme la solution la plus raisonnable pour tous. Le contractualisme a donc été l’instrument chez cet auteur, que certains considèrent comme un des premiers penseurs libéraux, d’un adoucissement du pouvoir marital, et d’une relâche de la contrainte s’exerçant au sein de la cellule domestique.

Le contrat reste un mot creux tant qu’on n’a pas identifié ce qui est essentiel pour ceux qui le passent : est-il un lien entre personnes qui cherchent leur subsistance comme chez Hobbes ? Unit-il des personnes dont la liberté est première et inaliénable, comme c’est le cas chez Rousseau ? Contracter ne signifiera pas du tout la même chose pour les uns et les autres.

Dernier point : certains auteurs, comme Grotius, Montesquieu, Rousseau, ne croient pas utile de penser intégralement la famille sur le patron de l’État et rappellent que ce qui peut se décider entre citoyens adultes et rationnels doit être réglé autrement en famille. Entre les époux, entre les frères et les sœurs, entre les parents et les enfants, ne faut-il pas plutôt rappeler l’importance des sentiments, du donné, des corps et pas seulement de la volonté, de tout ce qui nous échappe et aussi de tout ce qui ne se décide pas par un contrat ni par une volonté libre et éclairée, comme le plaisir d’être et de vivre ensemble, ou encore de converser ?

Gabrielle Radica ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.03.2026 à 12:04

Que penserait Churchill de la guerre contre l’Iran ?

Richard Toye, Professor of Modern History, University of Exeter

Texte intégral (1834 mots)

En pleine guerre contre l’Iran, Donald Trump s’est agacé du délai mis par Londres à autoriser l’utilisation d’une base militaire stratégique par les forces américaines. Il s’en est notamment pris au premier ministre Keir Starmer, regrettant que, en sa personne, les États-Unis « n’ont pas affaire à Winston Churchill » – façon de dire que Churchill, lui, se serait aligné sur Washington sans états d’âme. Cette comparaison repose sur une vision très simplifiée de l’histoire et du « Vieux Lion », qui dirigea le gouvernement du Royaume-Uni de mai 1940 à juillet 1945 puis d’octobre 1951 à avril 1955.

Lorsque, le 3 mars dernier, Donald Trump reprocha à Keir Starmer son soutien trop tiède aux opérations américaines et israéliennes contre l’Iran, il glissa dans son propos une référence historique. « Nous n’avons pas affaire à Winston Churchill », déplora-t-il, indiquant ainsi que, à la différence de l’actuel locataire du 10, Downing Street, Churchill, lui, se serait résolument tenu aux côtés de Washington lors de l’actuelle confrontation avec Téhéran. Mais Churchill aurait-il vraiment applaudi la guerre déclenchée contre l’Iran le 28 février ?

La réponse n’est pas aussi évidente que semble le croire Donald Trump. Si Churchill a toujours accordé la plus grande importance à l’alliance entre Londres et Washington, et eu volontiers recours à une rhétorique belliqueuse, il s’est également distingué par une prudence stratégique constante. Loin d’être systématiquement attiré par la confrontation armée, il avait plutôt tendance à considérer la guerre et la diplomatie comme deux éléments indissociables.

Son célèbre discours prononcé à Fulton (Missouri), le 5 mars 1946, en fournit une illustration remarquable. Chacun se souvient de la formule restée fameuse qu’il y employa pour la première fois ; « Un rideau de fer est descendu sur l’Europe. » Mais ce discours – officiellement intitulé The Sinews of Peace (Le nerf de la paix) – ne fut pas seulement un appel aux armes face à l’expansion soviétique. Churchill y souligna à la fois l’importance de comprendre ses adversaires et le besoin de renforcer les Nations unies. Il défendait l’idée que pour préserver la paix, les puissances occidentales devaient se montrer unies et fortes afin de dissuader toute agression.

L’Iran avait déjà été évoqué dans ce discours. À l’époque, les troupes soviétiques ne s’étaient pas retirées du nord de l’Iran malgré des accords conclus pendant la guerre. Cet épisode se trouva partiellement à l’origine des premières tensions qui allaient aboutir à la guerre froide. Churchill considérait donc déjà le dossier iranien à travers le prisme de la rivalité entre grandes puissances.

Cette vision des choses ne datait pas de 1946. Pendant la Seconde Guerre mondiale, en 1943, Churchill s’était rendu à Téhéran pour y rencontrer Frankiln D. Roosevelt et Joseph Staline lors de la première conférence des « trois grands leaders » alliés. Cette réunion se déroula dans la capitale de l’Iran car le pays était devenu un corridor logistique crucial permettant d’acheminer des équipements alliés vers l’Union soviétique.

Pour Churchill, la conférence fut une profonde désillusion. Roosevelt cherchait de plus en plus à s’attirer les bonnes grâces de Staline, parfois au détriment du Royaume-Uni. Churchill racontera plus tard avec amertume qu’il était assis « entre le grand ours russe et le grand bison américain » – un bestiaire où son pays à lui s’apparentait à « un pauvre petit âne britannique ». Cette remarque reflétait une prise de conscience : le Royaume-Uni ne faisait plus partie des grandes puissances dominantes du monde.

Ayant compris cela, Churchill décida, une fois la guerre terminée, de cultiver autant que possible la relation américano-britannique. Son appel lancé à Fulton en faveur d’une « relation spéciale » entre le Commonwealth britannique et les États-Unis n’était pas qu’un geste rhétorique. C’était une tentative d’assurer la sécurité future de son pays dans un ordre international dominé par l’émergence de la puissance américaine.

Churchill et le renversement de Mossadegh en 1953

Mais la réflexion de Churchill sur l’Iran ne s’est pas limitée à la diplomatie de la guerre froide. En 1953, lors de son second mandat de premier ministre, une opération clandestine renversa le premier ministre iranien Mohammad Mossadegh et rétablit l’autorité du shah Mohammad Reza Pahlavi. Le coup d’État avait été principalement organisé par la CIA, sous la direction de Kermit Roosevelt Jr., mais Churchill l’avait soutenu avec enthousiasme. Lorsque Roosevelt lui décrivit plus tard l’opération lors d’une rencontre à Downing Street, le premier ministre aurait déclaré qu’il aurait volontiers servi sous ses ordres dans une telle mission.

Cet épisode, qui indique que Churchill n’avait rien contre le recours à la force lorsqu’il estimait que les intérêts occidentaux étaient menacés, allait avoir de lourdes conséquences : le renversement de Mossadegh devint l’un des principaux griefs mis en avant par les leaders révolutionnaires iraniens. Et depuis son instauration en 1979, la république islamique n’a cessé de rappeler les interventions étrangères – particulièrement le coup d’État américano-britannique de 1953 – afin de légitimer son pouvoir et se présenter comme le défenseur de la souveraineté iranienne contre une domination externe.

Autrement dit, cette interférence occidentale en Iran est devenue, avec le temps, l’une des armes politiques les plus puissantes du régime.

Churchill était bien conscient que les guerres et les interventions pouvaient entraîner des conséquences imprévues. En repensant à son expérience de jeune officier lors de la guerre des Boers, il écrivit qu’une fois le signal du conflit donné, les hommes d’État perdaient le contrôle des événements. La guerre devenait alors soumise à « la Fortune maligne, aux surprises malencontreuses et aux terribles erreurs de calcul politiques ». Ce n’était pas l’opinion d’un pacifiste, mais celle d’une personne ayant vu à quelle vitesse certaines décisions politiques peuvent devenir impossibles à maîtriser.

Que ferait Churchill aujourd’hui ?

Comment ces instincts pourraient-ils s’appliquer à la crise actuelle ? Churchill aurait presque certainement considéré le régime iranien avec une profonde méfiance. Sa vision de la guerre froide le poussait à interpréter la politique internationale en termes de confrontation idéologique et d’équilibre stratégique. Il aurait sans doute estimé que faire preuve de faiblesse face à des régimes jugés agressifs ne ferait qu’encourager ceux-ci à défier les Occidentaux toujours davantage.

Mais Churchill pensait rarement que l’action militaire, à elle seule, pouvait résoudre les conflits géopolitiques. Son approche consistait plutôt à allier fermeté et diplomatie : négocier à partir d’une position de force tout en maintenant des canaux de communication avec ses adversaires. Même au plus fort de la guerre froide, il espérait qu’une position de force des pays occidentaux pourrait, à terme, convaincre les dirigeants soviétiques de parvenir à un compromis.

Avant tout, Churchill estimait que l’influence du Royaume-Uni reposait sur sa relation étroite avec les États-Unis. Mais, dans son esprit, cet alignement ne devait pas se limiter à simplement suivre Washington : il devait également permettre d’orienter la puissance américaine. La « relation spéciale » devait être un partenariat et non l’octroi d’une liberté totale.

La référence de Trump à Churchill repose donc sur une image simplifiée du chef de guerre, présenté comme un partisan instinctif de l’action militaire. L’histoire montre en réalité un personnage plus nuancé : un stratège convaincu de l’importance de la force, certes, mais aussi de la diplomatie, des alliances et d’une gestion prudente des rivalités entre grandes puissances.

Si Churchill était encore vie aujourd’hui, il appellerait probablement les gouvernements occidentaux à faire preuve de fermeté. Mais il reconnaîtrait aussi que le système politique iranien s’est construit sur la mémoire des interventions étrangères passées – et que tout nouveau conflit risquerait de renforcer précisément les forces qu’il prétend affaiblir.

Churchill soulignait d’ailleurs que la guerre, une fois déclenchée, suit rarement les chemins bien ordonnés imaginés par ceux qui l’ont lancée. Un avertissement qui reste, encore aujourd’hui, d’une grande actualité.

Richard Toye a reçu des financements du Leverhulme Trust.

11.03.2026 à 12:04

De la Perse antique à la République islamique : le sport au cœur de la civilisation iranienne

Caroline Azad, Docteure en Sciences politiques, Université Libre de Bruxelles (ULB)

Texte intégral (2366 mots)

De la Perse antique aux massacres de janvier 2026, l’histoire du sport incarne des univers symboliques qui façonnent depuis des millénaires la civilisation iranienne, où les valeurs de bravoure et de courage sont traditionnellement érigées en idéaux d’humanité.

« La connaissance du sport est la clé de la connaissance d’une société. » Cette thèse formulée par les sociologues Norbert Elias et Éric Dunning dans leur ouvrage de référence « Sport et civilisation : la violence maîtrisée » semble prendre une résonance particulière dans le cas de l’Iran.

Partir à la découverte de l’histoire du sport en Iran revient à s’immerger dans celle du pays. Cette plongée vertigineuse permet de saisir la diversité des expériences sociales et de comprendre les rapports de pouvoir et de domination qui traversent la société et structurent ses systèmes de gouvernance. Elle invite aussi à explorer les imaginaires collectifs et les univers symboliques enracinés depuis plusieurs millénaires et qui façonnent encore aujourd’hui la singularité de la culture iranienne.

L’idéal chevaleresque

Dans la Perse antique, l’éducation du corps occupe une place centrale dans l’organisation sociale et se trouve indissociablement liée à la dimension spirituelle de l’existence, alors largement structurée par les valeurs du zoroastrisme.

Si de nombreux récits se sont perdus au fil des guerres, des conquêtes et des traditions orales, le plus ancien qui nous soit parvenu remonte au cinquième siècle avant notre ère. Dans son « enquête » qui relate les guerres médiques opposant les Grecs aux Perses de l’empire achéménide, l’historien hellénique Hérodote (vers 484-425) écrit à propos de certaines traditions athlétiques des Perses, à l’instar de la domestication du cheval, que « leurs enfants, de cinq ans jusqu’à vingt ans, apprennent trois choses : monter à cheval, tirer à l’arc et dire la vérité ».

Plus de 1 400 ans après ce récit, une œuvre fondatrice immortalise la figure du chevalier – et à travers elle un idéal d’humanité. Il s’agit du Shânâmeh du poète Ferdowsi (vers 940-1020). Ce « Livre des rois », rédigé à l’époque de la domination arabe et musulmane en territoire perse, n’est pas seulement une composition d’un genre unique dans la littérature mondiale par la richesse et l’étendue de son récit. Il constitue la matrice mythologique et historique de la culture iranienne.

Composé en persan au début du XIe siècle, cet ouvrage relate une fresque inspirée de faits historiques allant de la création du monde et de l’émergence de la civilisation iranienne préislamique jusqu’à la conquête arabe au milieu du VIIe siècle. À travers un corpus de plusieurs milliers de manuscrits, Ferdowsi met en scène une succession de héros et d’héroïnes dont les exploits militaires, la force physique, les vertus morales et le code de l’honneur ont forgé la mémoire et le patrimoine culturel iraniens. Ces hommes et ces femmes ne sont pas uniquement des combattants : ils sont avant tout porteurs d’une conception exigeante de la morale et de l’éthique, fondée sur les notions de courage, de bravoure, de simplicité, de contrôle des passions, de dépassement des apparences, de l’abandon de l’orgueil ou encore de la connaissance de soi. Ce système de valeurs spirituelles a comme principal dessein l’amélioration de l’être et de la vie.

La lutte, au-delà du sport

Si la guerrière Gordafarid figure parmi les héroïnes de premier plan, l’un des grands héros de cette épopée légendaire est Rostam, symbole par excellence du javânmard, chevalier guidé par un code d’honneur et une bravoure inébranlables. Doté du titre militaire de jahân·e pahlavân (soit le pahlavân du monde, qui fait référence à cet idéal d’humanité mêlant prouesses athlétiques et qualités morales), Rostam allait parfois jusqu’à sceller l’issue d’un combat à mains nues, afin de ne pas tirer avantage des faiblesses de son adversaire et d’obtenir la victoire à armes égales.

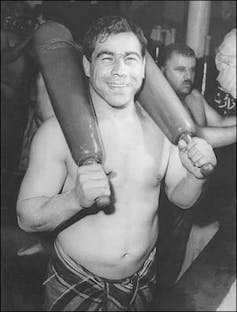

Cette aptitude à ne pas exploiter les incapacités ou les blessures de leurs concurrents fera d’ailleurs la renommée et la légende des plus grands lutteurs iraniens contemporains, à l’exemple de Gholam Reza Takhti (1930-1968), premier champion olympique iranien de lutte libre. Lors d’un combat contre le Soviétique Alexandre Medved, il refusa de s’en prendre au genou blessé de ce dernier, un geste qui lui coûta la victoire mais consacra durablement sa réputation d’homme d’honneur.

Le métier de lutteur professionnel, tel qu’il est décrit dans les textes du monde musulman aux XIIIe et XVe siècles, fut associé à la pensée mystico-religieuse du soufisme qui prédominait dans les cours royales des sultans du Moyen-Âge. Ainsi, les souverains safavides (1501-1736), issus de cet ordre mystique qu’ils entendaient renforcer, favoriseront l’essor de la lutte en tant qu’art véritable, associé à la méditation, à la contemplation et aux vertus spirituelles les plus gratifiantes.

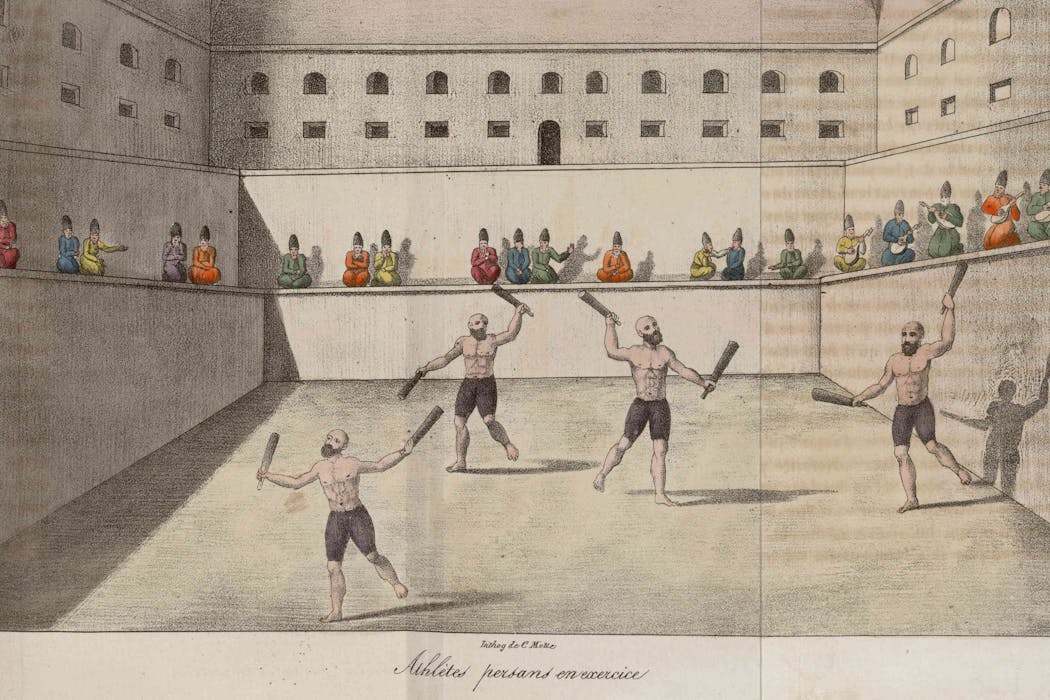

De l’Afrique du Nord à l’Asie centrale, des Balkans jusqu’aux confins de l’Inde, les lutteurs vont former des confréries régies par un officiel de la cour et s’entraîner dans des gymnases traditionnels appelés zurkhâneh (littéralement, maisons de la force). Bien que leur origine reste difficile à retracer, leur existence remonterait à l’empire achéménide où leur fonction principale était d’assurer la consolidation des réseaux militaires, et plus tard la résistance de ces derniers face aux multiples incursions ennemies. Dans la littérature française, l’existence de ces gymnases n’est attestée qu’à partir du XVIIe siècle dans deux récits de voyages : Estat de la Perse en 1660 du père Raphaël du Mans, de son vrai nom Jacques Duterte, traducteur auprès des rois safavides et moine capucin responsable d’un couvent à Ispahan de 1647 à sa mort en 1669 ; et celui du chevalier Jean Chardin (1643-1713), explorateur et auteur du Journal de voyage du chevalier Chardin en Perse et aux Indes orientales.

Le retour en grâce des femmes

Si la littérature reste très avare sur le rôle des femmes dans l’histoire du sport de manière générale, les combats qu’elles mènent aujourd’hui interrogent sur l’existence d’une possible continuité avec des expériences passées. Depuis l’instauration de la République islamique en 1979, les caractéristiques de la lutte ont été remaniées selon des critères issus de la doctrine politique chiite. Celle-ci établit une réglementation inégale entre les hommes et les femmes et conditionne l’accès des Iraniennes au sport à l’imposition d’un code vestimentaire strict. Si elles en demeurent encore exclues, les Iraniennes pratiquent la lutte dans des espaces privés, sans cesser de réclamer l’ouverture des gymnases ni d’imposer leur présence dans un héritage culturel réinterprété à l’aune de considérations idéologiques.

En Iran, le corps féminin actif, visible et compétitif, cristallise les tensions au sein du système de gouvernance, qu’il soit d’ordre clérical ou politique, entre ceux qui cherchent à restreindre les femmes dans un rôle et un statut circonscrits, et d’autres qui ambitionnent de faire du sport un domaine de légitimation (géo) politique et idéologique. Néanmoins, les athlètes iraniennes ont réussi, avec plus ou moins de succès selon les circonstances et les époques, à jouer un rôle actif dans le développement et l’identité de leur discipline.

Par leurs trajectoires individuelles, leurs prises de parole publiques et, surtout, leur persévérance face aux nombreuses contraintes et tentatives de découragement qui leur sont imposées, elles ont fait du sport, souvent au péril de leur vie ou de leur carrière, un véritable territoire de résistance, de désobéissance et de contestation sociale et politique.

La bravoure en héritage

Tous les mouvements de révolte qui ont jalonné l’histoire récente de l’Iran ont impliqué des athlètes. Aujourd’hui encore, à la suite de l’effroyable bain de sang qui s’est abattu sur un nombre incalculable de civils innocents, des défections en série ont lieu dans le monde du sport. Le célèbre attaquant Mehdi Ghayedi fut le premier sportif à annoncer, sur les réseaux, son retrait de l’équipe nationale de football. Il fut suivi par les joueuses Zahra Alizadeh et Kosar Kamali qui prirent à leur tour la décision de quitter le football. La violence inouïe exercée durant quarante-sept ans au nom du pouvoir et de l’idéologie aura brisé la vie de nombreux sportifs et sportives issus de toutes les disciplines.

Alors, qui mieux que cette jeune génération pour s’ériger en digne héritière des valeurs de bravoure et de courage qui irriguent, dans toute sa diversité, la civilisation iranienne ? Une génération qui incarne, au-delà d’elle-même, les aspirations et les indignations d’une population iranienne que rien, pas même la mort, ne semble pourvoir détourner de sa détermination à prendre la place qui lui revient dans l’avenir de son pays.

Caroline Azad ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.03.2026 à 12:03

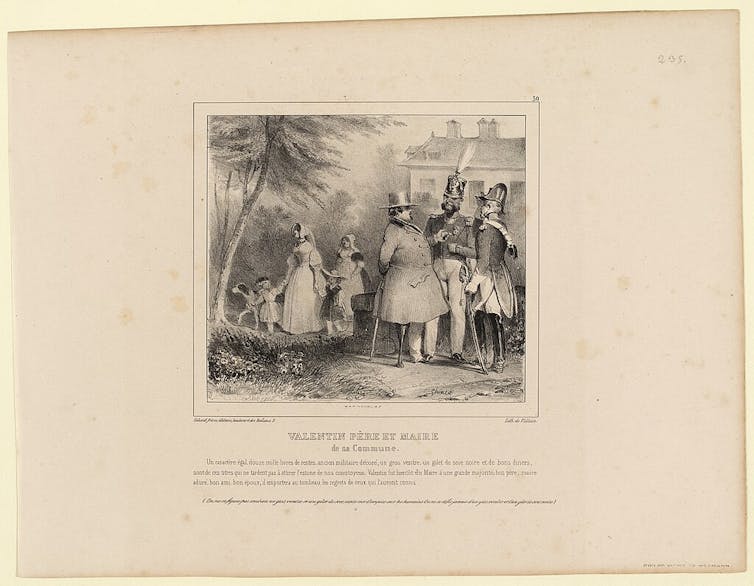

Démissions de maires et conseillers municipaux : des tensions enracinées dans une longue histoire

Gaëlle Charcosset, Historienne, chercheuse associée au Laboratoire d'études rurales (LER), Université Lumière Lyon 2

Texte intégral (1956 mots)

Si les démissions de maires et de conseillers municipaux sont aujourd’hui sous les feux de l’actualité, elles résultent souvent de dissensions dans la gouvernance des communes qui prennent leur source dans l’histoire. Pour les comprendre, il faut revenir sur la manière dont les relations entre maires et conseillers municipaux se sont construites au XIXᵉ siècle et au début du XXᵉ siècle. Une recherche dans la région du Beaujolais éclaire cette incomplète démocratisation de l’institution municipale et la variété des modes de gouvernement.

À l’été 2025, une enquête réalisée par Martial Foucault pour l’Association des maires de France révèle une hausse des démissions de maire durant le mandat en cours. Dans 31 % des cas, ce sont les dissensions avec le conseil municipal qui en sont la cause.

De même, la presse locale se fait souvent l’écho de démissions de conseillers municipaux, seuls ou en bloc, dénonçant l’« incapacité à échanger et le fait qu’il le [maire] décidait de tout » (Chanceaux-sur-Choisille, Indre-et-Loire), un dialogue « rompu » et des décisions « prises sans concertation préalable » (Palazinges, Corrèze), ou encore « le manque de communication, de considération pour les élus et le pouvoir de décision accaparé par des collaborateurs non élus » (Briançon, Hautes-Alpes).

Si leur hausse est récente, les démissions ainsi motivées sont anciennes et paraissent trouver leur source dans la manière même dont les deux institutions municipales, maire et conseil municipal, ont été conçues en interrelation au XIXe siècle.

Ainsi, à partir de la région du Beaujolais entre 1800 et 1940, il est possible de mettre en évidence que, si une progressive démocratisation accentue le rôle des conseillers municipaux, elle reste incomplète. Localement, pour ne pas dire communalement, des modes de gouvernement spécifiques ont défini les prérogatives effectives de chacun.

Une lente démocratisation de l’institution municipale

Si les fonctions municipales se généralisent durant la Révolution, c’est à partir du Consulat qu’elles se stabilisent et prennent la forme actuelle d’un maire et d’un conseil municipal. Dans un premier temps, le conseil municipal a un rôle très restreint. Constitué d’édiles nommés et renouvelés par moitié tous les dix ans, il est peu dynamique, touché par des démissions, des départs ou des décès, tandis que la figure du maire se construit comme agent de l’État, officier de l’état civil et représentant de la commune.

Avec l’introduction du principe électif, censitaire (1831) puis « universel » masculin à partir de 1848, un renouvellement plus fréquent et un élargissement de ses prérogatives (loi de 1837), le conseil municipal se consolide. Cela invite l’administration, qui procède encore à la nomination du maire et de l’adjoint, à ajuster ses choix. Ainsi, sous la monarchie de Juillet (1831-1848), les préfets doivent régulièrement tenir compte des forces en présence. Dans le département du Rhône, ils font alors le choix d’un maire dans le groupe ou « parti » qui paraît majoritaire et d’un adjoint parmi ses adversaires.

Sous le Second Empire, le magistrat et son adjoint peuvent être choisis en dehors et avant même les élections municipales ; cependant, devant les conflits et les critiques de l’autorité, les préfets renoncent dans les années 1860 à un choix hors conseil, si bien qu’ils peuvent concéder la présidence des assemblées municipales à des républicains.

Après six ans d’alternance entre élection du maire par le conseil municipal et nomination par l’administration, le principe électif est définitivement adopté (1876 ; 1882 pour les chefs-lieux de canton). La « charte » de 1884 conforte sur le plan législatif le fonctionnement démocratique de l’institution municipale, confirmant notamment la publicité des délibérations et permettant la permanence des commissions.

Une démocratisation incomplète

Cependant, sur le plan social, la démocratisation reste très relative. L’administration du début du XIXᵉ siècle a choisi pour maires des hommes bénéficiant d’une certaine aisance, le justifiant par l’instruction nécessaire et la capacité à consacrer du temps pour une fonction non rémunérée. En réalité, elle a aussi fait preuve de pragmatisme en recourant à des « notables », souvent grands propriétaires fonciers qui, par leur assise sociale et économique, exercent une autorité, un contrôle sur la société villageoise et qui, évincés, pourraient s’opposer à la municipalité nommée.

En dehors de ces notables, le recrutement au sein des élites villageoises est la règle conduisant à une surreprésentation des grands exploitants agricoles, des professions libérales et des artisans et commerçants. Le choix des électeurs pour leurs conseillers municipaux est par la suite similaire et se maintient sur la longue durée.

Sous la IIIe République, la compétition électorale paraît se réduire davantage autour de « familles éligibles », se caractérisant par leur enracinement, leur patrimoine et leur place dans la mémoire collective locale, ce que les ethnologues, sociologues et politistes ont analysé jusqu’au début du XXIᵉ siècle.

Dans les villages du Beaujolais, les compétitions électorales paraissent se jouer en moyenne entre une trentaine d’hommes et à peine une vingtaine pourrait espérer le succès de leur candidature (pour dix à douze élus). Au début du XXᵉ siècle, le recours au second tour se raréfie tant en nombre de places qu’il reste à pourvoir que de communes où il est nécessaire. Avant la Seconde Guerre mondiale, seuls les renouvellements de 1925 et de 1935 paraissent un peu plus disputés.

Des modes de gouvernement municipaux, de l’exercice solitaire à la collégialité

Derrière cette tendance générale, ce sont des modes de gouvernement différents que les registres des délibérations municipales permettent de mettre au jour. En comparant les conseils municipaux de deux communes distantes d’à peine 20 km, ce sont deux fonctionnements radicalement différents qui émergent et qui se perpétuent pendant un siècle et demi.

À Odenas, le maire, qu’il s’agisse du châtelain légitimiste dans les années 1820 ou de l’avocat radical-socialiste un siècle plus tard, exerce de manière solitaire, le conseil municipal paraissant se limiter à enregistrer ses décisions. Aucun conflit ou désaccord ne transparaît dans les délibérations, les commissions permanentes impulsées par le préfet au début du XXᵉ siècle sont vite abandonnées. L’adjoint et le secrétaire de mairie sont les relais quotidiens du maire.

À Chamelet, c’est la collégialité qui s’impose : le maire est souvent « autorisé », « prié », « invité » à agir en fonction des délibérations prises, la vérification de ses comptes confiée à des édiles dont la fortune et la position sociale garantissent leur indépendance à son égard, la direction des travaux sur les chemins vicinaux exercée par les édiles alors qu’en théorie, elle lui revient. Les délibérations, plus fréquentes, sont marquées par de nombreux échanges que l’on prend soin de transcrire, de propositions faites par les uns, de votes à main levée ou à bulletin secret selon les circonstances ; les commissions y sont précoces, structurées et engagent tous les conseillers en fonction de leurs compétences.

Si les rapports de force sociaux ne sont pas totalement étrangers à ces deux modes de gouvernement, ils ne s’y réduisent pas, mettant en évidence la construction de savoir-faire administratifs et délibératifs, d’habitudes – et la compétition en cercle fermé y contribue pleinement – qui n’empêchent ni les évolutions ni des oscillations d’un mode à l’autre, plus marquées dans d’autres communes, provoquant parfois des crises et des démissions. Ces différences d’une commune à l’autre discutent aussi de la plus ou moins grande démocratisation de l’institution municipale qui s’est opérée.

Les secrétaires de mairie interrogés au début des années 2000 pouvaient témoigner, quand ils exerçaient dans plusieurs communes, de ces modes de gouvernement différents qui se maintenaient.

Gaëlle Charcosset ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Time [Fr]

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- L'Autre Quotidien

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- Gauche.Media

- CETRI

- ESSF

- Inprecor

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview