ACCÈS LIBRE Une Politique International Environnement Technologies Culture

30.10.2025 à 15:50

Gouvernement Lecornu : les enjeux d’une nouvelle décentralisation

Tommaso Germain, Chercheur en science politique, Sciences Po

Texte intégral (2010 mots)

Sébastien Lecornu a donné jusqu’à ce 31 octobre aux élus locaux pour lui remettre des propositions relatives à la décentralisation. Alors qu’Emmanuel Macron a plutôt « recentralisé » depuis 2017, son nouveau premier ministre promet un « grand acte de décentralisation » visant à redéfinir le partage – souvent confus – des compétences entre les acteurs (État, régions, départements, métropoles, communes, intercommunalités…). Une telle ambition est-elle crédible alors que le gouvernement envisage un budget d’austérité impactant lourdement les collectivités territoriales ?

La décentralisation est l’un des principaux chantiers annoncés par le premier ministre Sébastien Lecornu avant sa démission du 6 octobre et qui a été réaffirmé dès la constitution de son second gouvernement. Depuis l’élection d’Emmanuel Macron à la présidence de la République en 2017, aucune loi n’a poursuivi les trois premiers actes de décentralisation (1982, 2004, 2015). Des formes d’organisation locales et hétérogènes se sont multipliées.

Dans sa déclaration de politique générale, le chef du gouvernement entend mettre fin à cette hétérogénéité en clarifiant le partage des compétences entre l’État et les collectivités. Mais une « rupture » avec la décentralisation telle qu’observée aujourd’hui est-elle possible ?

Décentraliser le pouvoir en France, une histoire longue

On sait que la France est un pays historiquement centralisé, des Capétiens à la monarchie absolue, de la révolution jacobine à la Ve République. L’État hérité de la féodalité est d’abord demeuré centré sur des fonctions dites « régaliennes » : l’armée, la fiscalité, la diplomatie, la police ou la justice, avec, en son cœur, un appareil administratif professionnalisé. À l’ère moderne, l’État s’adosse à la nation, et poursuit sa croissance indépendamment du régime politique (monarchie, république, empire). Il faut pourtant signaler que ce qu’on appelle « l’État-providence » s’est en grande partie développé localement, les initiatives territoriales étant parfois reprises et généralisées par le centre, dès le Second Empire et la IIIᵉ République, dans le domaine de l’assistance et de l’action sociale.

Pourtant, depuis plus de quarante ans, une politique de décentralisation est à l’œuvre. Les trois premières étapes ou premiers moments, que l’on appelle « actes » pour leur donner la puissance de l’action, ont profondément modifié le système de pouvoir et d’action publique. D’abord, au début des années 1980, des régions autonomes ont été créées et les échelons communaux et départementaux renforcés, ces trois collectivités disposant de conseils élus. La fonction publique territoriale est également créée.

En 2003-2004, le second acte a renforcé l’autonomie des collectivités tout en transférant certaines compétences, telle la politique sociale, transférée au département, pleinement responsable. D’aucuns y ont vu l’apparition d’un « département-providence ».

Quant au dernier acte en date, il remonte au quinquennat du socialiste François Hollande : regroupement des régions pour atteindre une taille critique, affirmation des métropoles, clarification du partage de compétences.

Parallèlement à ce processus, l’État n’a cessé de revoir son ancrage territorial, depuis les années 1990. La réforme de l’administration territoriale de l’État (dite RéATE), en 2007, a régionalisé l’action de l’État. À la suite de la crise des gilets jaunes (2018-2019), le gouvernement a déployé une réorganisation territoriale discrète, renforçant l’articulation interministérielle et le rôle du préfet.

En revanche, depuis 2017, la décentralisation n’a plus bougé. Emmanuel Macron n’en a pas fait un axe structurant de ses mandats – lesquels sont même perçus comme recentralisateurs.

Des formes locales très différentes ont finalement proliféré, questionnant le principe initial d’une République « une et indivisible ». Que l’on pense au sinueux bâtissage de la métropole du Grand Paris, aux spécificités des métropoles d’Aix-Marseille ou de Lyon, à la communauté européenne d’Alsace qui a uni, en 2021, deux départements historiques, aux intercommunalités rurales souvent indispensables, au regroupement de communes, au statut spécifique de la Corse intégrée depuis 1768 ou encore à Mayotte refondée en 2025 et à la Nouvelle-Calédonie, dont le statut est actuellement négocié.

Sébastien Lecornu a choisi de remettre en ordre cette nature proliférante, résultant à la fois de la réorganisation de l’État localement et de la décentralisation.

Une « rupture » dans le modèle de partage des compétences ?

Dans sa déclaration de politique générale, le premier ministre a assumé sa volonté de « rupture », clé de la légitimité de son gouvernement et des réformes nécessaires au redressement de la France. S’agit-il également d’une rupture avec l’arrêt de la décentralisation sous Emmanuel Macron ? Pour Sébastien Lecornu, la décentralisation ne doit plus suivre l’ancienne logique de rationalisation et de délégation. Il déclare ainsi :

« Je proposerai un principe simple, celui de l’identification d’un seul responsable par politique publique. Il s’agira soit d’un ministre, soit d’un préfet, soit d’un élu. Il ne faut pas décentraliser des compétences. Il faut décentraliser des responsabilités, avec des moyens budgétaires et fiscaux et des libertés, y compris normatives. »

Si le gouvernement semble tout adéquat pour les politiques régaliennes et les préfets pour leur déploiement, quels élus locaux seront responsables ? Le principe d’un décideur par politique publique imposerait de repenser l’ensemble de l’action publique – c’est un chantier pharaonique.

Car malgré les trois actes de décentralisation, les compétences ne sont pas à ce jour clairement réparties : quel citoyen pourrait clairement savoir à quel niveau de gouvernement s’adresser selon sa demande ? Le rapport Ravignon (2024) évoque une « grande confusion » des citoyens devant cette complexité. Il montre aussi que de nombreuses politiques publiques sont éclatées et dépendent parfois de trois acteurs ou plus, comme le tourisme, la culture ou le développement économique. Cela est également visible dans l’aménagement du territoire, où les évolutions dépendent de l’État, de la stratégie régionale et des départements, voire des intercommunalités et des communes.

Pour certaines politiques, on assiste même à une concurrence entre autorités publiques. Les communes (ainsi que certaines métropoles) disposent de la clause générale de compétences, qui leur permet de toucher à tout sujet dont elles souhaitent s’emparer. On les retrouve ainsi intervenant là où le font déjà l’État (logement, transition écologique…), les régions (développement économique, tourisme…) ou les départements (culture, insertion…).

Notons, par ailleurs, la montée en puissance des métropoles qui s’est faite de manière discrète, notamment par le biais des politiques d’aménagement. Créées en 2010 et généralisées en 2014, désormais au nombre de 21, elles tendent à devenir la nouvelle frontière de l’État-providence, c’est-à-dire l’espace où la modernisation du système social se réalise en regroupant un large éventail de compétences. C’est encore plus vrai lorsque les compétences sociales du département sont intégrées à cet éventail, comme dans le cas de Lyon ou de Paris.

On comprend mieux pourquoi le rapport Woerth de 2024 proposait de recentrer l’action des métropoles. Les compétences sociales, qui représentent une lourde charge, restent principalement à la charge des départements, expliquant souvent leurs problèmes financiers, comme dans le cas emblématique de la Seine-Saint-Denis, soutenue directement par l’État. Une clarification sur ce sujet deviendrait nécessaire, d’autant plus que les départements continuent d’investir le développement économique (pourtant responsabilité de la région depuis l’acte III de la décentralisation, en 2015).

Le regroupement de communes et d’intercommunalités mériterait également de se poursuivre, notamment en zone rurale. Si Matignon souhaite un recentrage de l’État sur les fonctions régaliennes, la question du retrait de l’État de politiques qu’il tend à réinvestir, comme l’urbanisme ou la lutte contre la pauvreté, se pose également. Cela supposera également de penser une nouvelle étape de déconcentration.

Enfin, certaines compétences méritent d’être mieux organisées pour faire face à des défis qui ne feront qu’augmenter dans les années et décennies à venir, à l’instar du grand âge. Mais une telle clarification ne saurait se faire sans base financière durable.

La décentralisation en contexte de crise budgétaire

Pour la première fois, le chantier de la décentralisation revient avec grande ambition, à l’heure de la crise budgétaire. Devant le Sénat, Sébastien Lecornu a affirmé que « le grand acte de décentralisation » s’inscrivait pleinement dans cette problématique financière, qui vient en justifier l’urgence également.

S’il y a « rupture », ce serait dans l’idée que seul un transfert massif « des responsabilités » aux collectivités pourra garantir la hausse des moyens des fonctions régaliennes de l’État, alors que l’effort financier demandé aux collectivités représente au moins 4,6 milliards d’euros selon le gouvernement, mais jusque 8 milliards d’euros selon les élus locaux. Face à cet impératif budgétaire, une décentralisation poussée, de « rupture » est-elle envisageable ? Le projet de loi à venir, vraisemblablement début 2026, saura éclairer ces aspects.

Tommaso Germain ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

30.10.2025 à 15:49

L’intelligence peut-elle être expliquée par la génétique et l’épigénétique ?

Corinne Augé, Professeur en génétique moléculaire et biotechnologie, Université de Tours

Stéphane Mortaud, Professeur neurosciences, CNRS, Université d’Orléans

Texte intégral (2210 mots)

Quelle est la part de l’environnement, en particulier social, de l’épigénétique et de la génétique dans les manifestations de l’intelligence (ou des intelligences) chez l’enfant et chez l’adulte ?

Le cerveau humain est un organe fascinant, complexe et remanié en permanence. Au cours du développement de l’embryon, il se développe selon un programme génétique précis. Les cellules souches se divisent, migrent et se différencient en différents types de neurones pour former les réseaux neuronaux qui sous-tendront toutes nos fonctions cognitives, émotionnelles, comportementales et motrices.

Les mécanismes épigénétiques, c’est-à-dire les mécanismes par lesquels une cellule contrôle le niveau d’activité de ses gènes, jouent ici un rôle majeur : méthylation de l’ADN, modification des histones (protéines) et ARN non codants vont soit activer soit réprimer, à la fois dans l’espace et au cours du temps, les gènes nécessaires à la formation et à la migration des neurones, puis à la formation des synapses.

Tandis que le cerveau se construit, chaque neurone reçoit ainsi un ensemble de marques épigénétiques qui déterminent son identité, son activité et sa connectivité aux autres neurones. Ce profil épigénétique, spécifique à chaque type de neurone, se met en place en fonction de signaux environnementaux : contexte hormonal, présence de facteurs morphogéniques (les protéines qui contrôlent la place et la forme des organes), activité électrique naissante. La moindre perturbation peut altérer, cette programmation fine, très sensible non seulement à l’environnement intra-utérin, mais aussi à l’alimentation, voire aux émotions de la future maman.

Des substances comme l’alcool, les drogues, certains médicaments, tout comme les carences alimentaires, peuvent avoir des conséquences durables sur le développement cognitif et émotionnel de l’enfant à naître. Pourquoi ? Parce que les neurones, contrairement à toutes les autres cellules de l’organisme, ne se renouvellent pas. Nous « fonctionnerons » toute notre vie avec les neurones fabriqués in utero.

Le cerveau adulte conserve en réalité une certaine capacité à produire de nouveaux neurones, mais celle-ci est en fait très limitée : jusqu’à 700 neurones par jour. Une goutte d’eau à côté des quelque 86 milliards de neurones qui forment notre cerveau ! Pourtant, cette goutte d’eau joue un rôle crucial. Ces nouveaux neurones vont s’intégrer dans des circuits déjà existants, notamment de l’hippocampe, une structure impliquée dans l’apprentissage et la mémoire. Ce processus participe à la plasticité cérébrale, à la capacité du cerveau à s’adapter aux expériences et à l’environnement.

Pour peu qu’on le fasse travailler, le cerveau continue donc de se construire et surtout de se modifier après la naissance, et ce, durant toute la vie de l’individu… Les mécanismes épigénétiques jouent un rôle important dans ces processus.

L’intelligence, un construit théorique multidimensionnel

Quand on évoque le fonctionnement du cerveau, la première chose qui nous vient à l’esprit est l’intelligence. Dans l’acception populaire, un cerveau performant est un cerveau intelligent. Mais qu’entend-on par là ?

Malgré plus d’un siècle de recherches, l’intelligence reste un concept difficile à définir de manière consensuelle. En 1986, les psychologues américains Sternberg et Detterman demandent à une vingtaine d’experts en psychologie et en sciences cognitives de proposer leur propre définition de l’intelligence. Résultat : aucune définition ne fait consensus, bien que des points de convergence se dessinent autour de l’idée d’adaptation, de résolution de problèmes et d’apprentissage. La tradition psychométrique (l’ensemble des tests et mesures pratiqués en psychologie), dominante au XXe siècle, a réduit l’intelligence à un facteur unique (g) mesuré par différents tests, dont celui de quotient intellectuel (QI).

Bien que ces tests aient une valeur prédictive pour certaines performances scolaires ou professionnelles, ils négligent des dimensions que sont la créativité, les compétences sociales ou émotionnelles. Face à ces limites, des modèles alternatifs ont été proposés.

Ainsi, Gardner a introduit la notion d’intelligences multiples, suggérant l’existence de formes distinctes d’intelligence (logico-mathématique, musicale, interpersonnelle), ou encore Sternberg, qui a développé une théorie triarchique, distinguant intelligences analytiques, créatives et pratiques. Enfin, Goleman a popularisé l’idée d’intelligence émotionnelle, aujourd’hui largement reconnue pour son rôle dans la réussite sociale et professionnelle.

En somme, l’intelligence est un construit théorique multidimensionnel, dont les définitions varient selon les cultures, les disciplines et les objectifs de mesure, mais elles partagent toutes l’idée d’une acquisition ou amélioration de capacités cognitives, spécifiques à chaque type d’intelligence. Les neurosciences cognitives ont aidé à mieux localiser certaines fonctions associées à l’intelligence, mais elles n’ont identifié aucun « centre de l’intelligence » unique dans le cerveau. Les capacités cognitives reposent sur des réseaux distribués, complexes et encore imparfaitement compris.

D’un point de vue scientifique, il semble utile de poser certaines questions : l’intelligence a-t-elle des bases génétiques ? Quelle est la part de l’environnement, en particulier social, de l’épigénétique, dans ses manifestations chez l’enfant et chez l’adulte ? Selon leur discipline, les chercheurs sont enclins à défendre soit une théorie environnementale (pour les sociologues) soit une théorie génétique de l’intelligence, que parfois ils opposent.

Les travaux en la matière ne sont pas neutres, puisqu’ils influencent les politiques publiques en matière d’éducation, après être passés par la moulinette des idéaux politiques de leurs instigateurs.

Que nous apprend la littérature scientifique ?

En tant que phénotype, l’intelligence est définie par les généticiens (de façon assez restrictive) comme une capacité mentale très générale qui inclut le raisonnement, la planification, la résolution de problèmes, la pensée abstraite, l’apprentissage rapide et la capacité à tirer des leçons de l’expérience. Afin d’évaluer cette capacité, on utilise le concept statistique d’intelligence générale (ou facteur g). Le facteur g représente la capacité cognitive commune à toutes les tâches mentales. Cela signifie qu’une personne performante dans un domaine cognitif (mémoire ou raisonnement) tend à l’être aussi dans d’autres. Le facteur g résume, ou mesure, cette covariation des performances.

Les études sur les jumeaux et sur les familles montrent que l’intelligence présente un taux d’héritabilité d’environ 50 %. Ce taux ne dit pas que l’intelligence est héritée à 50 %, mais que 50 % de ce qui fait varier l’intelligence est dû au génotype. Il soutient l’idée selon laquelle l’intelligence est en partie due à des effets génétiques. Un autre résultat complète ce propos, puisque le taux d’héritabilité de l’éducation passe de 29 % à 17 % lorsque les effets génétiques indirects (pour résumer, l’environnement créé par les parents) sont retirés du calcul, ou que l’on compare le taux d’héritabilité de l’éducation entre enfants adoptés et non adoptés. Cela soutient l’idée que l’environnement contribue aussi à la structure phénotypique de l’intelligence. En réalité, ces calculs devraient réconcilier sociologues et généticiens puisqu’ils disent que l’intelligence est à la fois génétique et environnementale, ce dont les généticiens que nous sommes sont absolument convaincus !

L’intelligence étant en partie déterminée par la génétique, la quête des gènes impliqués a commencé. Trois études génomiques (GWAS) ont identifié respectivement 187, 148 et 205 loci (des emplacements de gènes sur les chromosomes) potentiellement impliqués dans ce phénotype. Il est donc clair qu’il n’existe pas un gène de l’intelligence. Il existe un grand nombre de variantes génétiques indépendantes, chacune d’entre elles représentant une infime proportion de la variation de l’intelligence. Sans surprise, les variants génétiques associés aux résultats des tests d’intelligence sont des gènes liés à la neurogenèse, la différenciation des neurones et des oligodendrocytes (qui fabriquent la myéline) et surtout, la synapse.

La recherche sur les déficiences intellectuelles (DI), et la mise en évidence de gènes associés, est d’une grande aide dans cette quête génétique de compréhension de l’intelligence.

Les généticiens ont répertorié au moins 1 700 formes de déficience intellectuelle qui impliquent un gène majeur. Ces DI peuvent être associées ou non à d’autres syndromes (comme l’autisme). Or, l’épigénétique joue un rôle central dans la régulation de nombreux gènes impliqués dans la DI. Dans le syndrome de l’X fragile, le gène FMR1, qui code une protéine régulant la traduction locale d’ARNm au niveau des synapses – fonction essentielle à la communication neuronale – est éteint par hyperméthylation de son promoteur (le segment d’ADN qui contrôle l’expression du gène). Aucune mutation dans la partie codante du gène n’est observée, mais la protéine n’est plus produite. Les syndromes de Rett ou d’Angelman sont des modèles majeurs de DI épigénétiquement déterminée.

Enfin, il a été récemment montré que des ARN non codants (ne conduisant pas à la production d’une protéine) sont aussi responsables de cas de DI. Il s’agit de petits ARN impliqués dans la machinerie moléculaire qui permet la maturation des ARNm, afin qu’ils puissent, eux, être traduits en protéine. L’existence et l’importance de ces variants non codants ouvrent de nouvelles perspectives pour tous les malades dont la DI n’est pas expliquée par des mutations génétiques, soit environ 50 % des cas.

Le cerveau reste « plastique » tout au long de la vie, et les mécanismes épigénétiques sont des contributeurs forts de cette plasticité. Ils modulent l’expression des gènes impliqués dans la structuration et dans la réorganisation des circuits neuronaux.

Ainsi, nos connexions synaptiques évoluent constamment en fonction de ce que nous vivons, ressentons ou apprenons, permettant au cerveau de s’ajuster continuellement à son environnement. Cependant cette précieuse capacité d’adaptation peut être altérée. Lorsque les mécanismes épigénétiques sont déréglés (par l’âge, par le stress chronique, par l’inflammation…), la plasticité cérébrale s’affaiblit voire disparaît. Cette dégradation est impliquée dans le développement de maladies neurodégénératives (Alzheimer ou Parkinson), de troubles du neurodéveloppement (spectre autistique) et de certains cancers cérébraux. Les recherches récentes soulignent à quel point épigénétique et santé mentale sont étroitement intriquées.

Cet article est publié dans le cadre de la Fête de la science (qui a eu lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Corinne Augé a reçu des financements de l'INCa et La Ligue

Stéphane Mortaud ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

30.10.2025 à 15:44

Stabilité affichée, risques cachés : le paradoxe des (cryptoactifs) « stablecoins »

Céline Antonin, Chercheur à Sciences Po (OFCE) et chercheur associé au Collège de France, Sciences Po

Texte intégral (2108 mots)

Présentés comme des ponts entre la finance traditionnelle et l’univers des cryptoactifs, les « stablecoins » (jetons indexés) prétendent révolutionner la monnaie et la finance. Pourtant, ils portent en germe une double menace : la fragilisation de l’ordre monétaire, fondé sur la confiance, et de l’ordre financier, en créant de nouveaux canaux de risque.

Les « stablecoins » sont des « jetons qui ont pour objectif de pallier la forte volatilité des cryptoactifs traditionnels grâce à l’indexation de leur valeur sur celle d’une devise ou d’un panier de devises (dollar, euro, yen) dans un rapport de 1 : 1, ou encore sur une matière première (or, pétrole) » ainsi que nous l’expliquons dans notre ouvrage avec Nadia Antonin. Pour chaque unité de stablecoin émise, la société émettrice conserve en réserve une valeur équivalente, sous forme de monnaie fiduciaire ou d’actifs tangibles servant de garantie.

On peut distinguer trois types de stablecoins en fonction du type d’ancrage :

Les stablecoins centralisés, où l’ancrage est assuré par un fonds de réserve stocké en dehors de la chaîne de blocs (off chain).

Les stablecoins décentralisés garantis par d’autres cryptoactifs, où le collatéral est stocké sur la chaîne de blocs (on chain).

Les stablecoins décentralisés algorithmiques.

Fin octobre 2025, la capitalisation de marché des stablecoins atteint 312 milliards de dollars (plus de 269 milliards d’euros), dont 95 % pour les stablecoins centralisés. Nous nous concentrons sur ces derniers.

Genius Act vs MiCA

Concernant la composition des réserves, les réglementations diffèrent selon les pays. La loi Genius, adoptée par le Congrès des États-Unis en juillet 2025, dispose que chaque stablecoins de paiement doit être garanti à 100 % par des actifs liquides, principalement des dollars américains, des bons du Trésor ou des dépôts bancaires. Il prévoit également des rapports mensuels détaillés et un audit annuel obligatoire pour les grands émetteurs.

Dans l’Union européenne (UE), le règlement MiCA impose des conditions beaucoup plus strictes. Il exige que les actifs soient entièrement garantis par des réserves conservées dans des banques européennes et soumis à des audits indépendants au moins deux fois par an.

Stabilité du système monétaire fragilisée

Bien que plus « stables » en apparence que d’autres cryptoactifs, les stablecoins échouent à satisfaire les trois principes qui, selon la littérature monétaire institutionnelle, définissent la stabilité d’un système monétaire : l’unicité, l’élasticité et l’intégrité.

Historiquement, le principe d’unicité garantit que toutes les formes de monnaie

– billets, dépôts, réserves… – sont convertibles à parité, assurant ainsi une unité de compte stable. Les stablecoins, émis par des acteurs privés et non adossés à la monnaie centrale, mettent fin à cette parité : leur valeur peut s’écarter de celle de la monnaie légale, introduisant un risque de fragmentation de l’unité monétaire.

Le principe d’élasticité renvoie à la capacité du système monétaire à ajuster l’offre de liquidités aux besoins de l’économie réelle. Contrairement aux banques commerciales, qui créent de la monnaie par le crédit sous la supervision de la banque centrale, les émetteurs de stablecoins ne font que transformer des dépôts collatéralisés : ils ne peuvent ajuster la liquidité aux besoins de l’économie.

Le principe d’intégrité suppose un cadre institutionnel garantissant la sécurité, la transparence et la légalité des opérations monétaires. Les stablecoins échappent à la supervision prudentielle, exposant le système à des risques de blanchiment, de fraude et de perte de confiance.

La question des réserves

L’existence et la qualité des réserves sont fragiles. Il faut garder à l’esprit que les actifs mis en réserve ne sont pas équivalents à la monnaie banque centrale : ils sont exposés aux risques de marché, de liquidité et de contrepartie.

Aux États-Unis, les émetteurs (comme Tether ou Circle) publient des attestations périodiques, mais ne produisent pas d’audit en temps réel. Rappelons qu’en 2021, Tether s’était vu infliger une amende de 41 millions de dollars (plus de 35 millions d’euros) par la Commodity Futures Trading Commission des États-Unis, pour avoir fait de fausses déclarations sur la composition de ses réserves. Les réserves sont souvent fragmentées entre plusieurs juridictions et déposées dans des institutions non réglementées.

À lire aussi : Où placer les stablecoins parmi les cryptoactifs ?

Le modèle économique des émetteurs de stablecoins repose sur la rémunération de leurs réserves. Il va de soi qu’ils n’ont aucun intérêt à détenir des actifs sûrs et à faible rendement. Imaginons que survienne une annonce qui sèmerait le doute sur la qualité des réserves. En l’absence d’accès aux facilités de la banque centrale ou à une assurance-dépôts, une perte de confiance se traduirait mécaniquement par une panique et un risque de perte d’ancrage.

Cette fragilité mine l’une des fonctions essentielles de la monnaie : la réserve de valeur.

Instrument de dollarisation et de colonisation monétaire

Les stablecoins apparaissent comme un instrument de dollarisation et une menace pour la souveraineté monétaire des États. En 2025, 99,0 % des stablecoins sont adossés au dollar en termes de capitalisation de marché. En diffusant des stablecoins adossés au dollar dans les économies émergentes ou faiblement bancarisées, les stablecoins favorisent une dollarisation numérique qui érode la souveraineté monétaire des banques centrales.

Pour l’UE, le risque est celui d’une colonisation monétaire numérique : des systèmes de paiement, d’épargne et de règlement opérés par des acteurs privés extra-européens. Les stablecoins conduisent également à une privatisation du seigneuriage – la perception de revenus liés à l’émission de monnaie, normalement perçus par la Banque centrale européenne (BCE). Les émetteurs de stablecoins captent la rémunération des actifs de réserve sans redistribuer ce rendement aux porteurs. Ce modèle détourne la fonction monétaire : la liquidité publique devient une source de profit privé, sans contribution à la création de crédit ou à l’investissement productif.

Risque de crise financière systémique

L’interconnexion entre stablecoins et finance traditionnelle accroît le risque systémique. En cas de perte de confiance, un mouvement de panique pourrait pousser de nombreux détenteurs à échanger leurs stablecoins, mettant en péril la capacité des émetteurs à rembourser. Or, les détenteurs ne sont pas protégés en cas de faillite, ce qui renforce le risque de crise systémique.

Le marché des stablecoins est très lié au marché de la dette souveraine états-unienne. La demande supplémentaire de stablecoins a directement contribué à l’augmentation des émissions de bons du Trésor à court terme (T-bills) aux États-Unis et à la baisse de leur rendement. La liquidation forcée de dizaines de milliards de T-bills perturberait le marché états-unien de la dette à court terme.

Risque de crédit et de fraude

Les stablecoins accroissent le risque de crédit, car comme les autres cryptoactifs, ils offrent un accès facilité à la finance décentralisée. Or, les possibilités d’effets de levier – autrement dit d’amplification des gains et des pertes – sont plus forts dans la finance décentralisée que dans la finance traditionnelle.

Mentionnons le risque de fraude : selon le Groupe d’action financière (Gafi), les stablecoins représentent désormais la majeure partie des activités illicites sur la chaîne de blocs, soit environ 51 milliards de dollars (44 milliards d’euros) en 2024.

Les stablecoins fragilisent la souveraineté des États, introduisent une fragmentation monétaire et ouvrent la voie à de nouvelles vulnérabilités financières. Pour l’Europe, l’alternative réside dans le développement d’une monnaie numérique de banque centrale, où l’innovation se conjugue avec la souveraineté. La vraie innovation ne réside pas dans la privatisation de la monnaie, mais dans l’appropriation par les autorités monétaires des outils numériques.

Cette contribution est publiée en partenariat avec les Journées de l’économie, cycle de conférences-débats qui se tiendront du 4 au 6 novembre 2025, au Lyon (Rhône). Retrouvez ici le programme complet de l’édition 2025, « Vieux démons et nouveaux mondes ».

Céline Antonin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

30.10.2025 à 15:41

« Shutdown » aux États-Unis : quel impact sur la natalité ?

Allane Madanamoothoo, Associate Professor of Law, EDC Paris Business School

Texte intégral (2343 mots)

Le gel du fonctionnement du gouvernement fédéral des États-Unis, depuis le 1er octobre, se traduit notamment par la réduction de différentes aides sociales et par la suspension du versement des salaires de nombreux fonctionnaires. Alors que la natalité est déjà nettement inférieure au seuil de renouvellement des générations, ce contexte pesant pourrait pousser de nombreuses personnes à remettre à plus tard leur projet parental, voire à y renoncer purement et simplement. En outre, la situation actuelle accroît les risques en matière de santé maternelle et néonatale.

C’est un fait : la natalité aux États-Unis est en berne depuis plusieurs années, avec un taux de 1,6 enfant par femme, alors que le seuil de renouvellement des générations est estimé à environ 2,05 enfants par femme, hors immigration. Cette dénatalité s’explique dans une large mesure par les difficultés économiques : augmentation du coût de la vie et de l’éducation des enfants, prix excessifs des logements, des garderies et des assurances privées, remboursement des prêts d’études pendant plusieurs années, etc.

Donald Trump espère inverser la tendance grâce aux mesures financières incitatives contenues dans sa « grande et belle loi budgétaire » promulguée en juillet dernier, mais il faut rappeler que des mesures plus ou moins similaires n’ont pas eu l’effet escompté dans d’autres pays du monde. La politique nataliste de Trump a d’ailleurs fait l’objet de certaines critiques : elle favoriserait la reproduction des riches et des Blancs, au détriment des pauvres et des Noirs, avec un risque d’eugénisme, et creuserait les inégalités raciales en matière de richesse.

Le shutdown qui perdure depuis le 1er octobre aux États-Unis faute d’accord entre les républicains et les démocrates sur le budget fédéral pourrait accroître le déclin de la natalité dans le pays, conduisant certains à renoncer à leur projet parental ; plus grave encore, la mortalité maternelle et néonatale pourrait augmenter.

Chez les fonctionnaires fédéraux

Dans un contexte de shutdown, certains fonctionnaires fédéraux dont les activités sont jugées « non essentielles » sont mis au chômage technique avec leur salaire gelé, pendant que d’autres continuent de travailler. Les uns comme les autres sont rétroactivement rémunérés après le déblocage du shutdown.

En 2013, sous la présidence de Barack Obama, le shutdown avait duré 16 jours. Près de 800 000 fonctionnaires fédéraux avaient été placés au chômage technique. Neuf mois plus tard, la capitale américaine avait connu un pic de natalité, avec une hausse de 30 % des naissances par rapport à la normale à l’époque. Le taux de natalité resta toutefois en berne au niveau national.

Le shutdown qui se poursuit actuellement va-t-il générer un baby-boom, du moins chez les fonctionnaires fédéraux placés au chômage technique ?

Si près de 700 000 fonctionnaires fédéraux sont au chômage technique depuis le 1er octobre, la situation est plus tendue qu’en 2013 et qu'en décembre 2018-janvier 2019, quand le shutdown avait duré 35 jours.

La paralysie budgétaire qui s’étire depuis le 1er octobre est déjà plus longue que celle de 2013, et risque de durer plus longtemps que celle de 2018-2019, car chaque partie semble déterminée à camper sur ses positions. Faute de salaire, certains employés fédéraux sont déjà en situation de précarité et font appel à des banques alimentaires ou à des prêts pour payer leur loyer. Plus de 4 000 fonctionnaires fédéraux ont aussi reçu un avis de licenciement.

Pis : la Maison Blanche a annoncé qu’elle comptait en licencier plus de 10 000 si le shutdown se poursuivait. Bien qu’une juge fédérale ait temporairement bloqué ces licenciements, dans un tel climat d’inquiétude économique de nombreux fonctionnaires fédéraux pourraient différer leur projet parental, voire y renoncer.

Chez les bénéficiaires du programme « Women, Infants and Children »

WIC (Women, Infants and Children) est un programme fédéral d’aide alimentaire et d’éducation à la nutrition et à l’allaitement destiné aux ménages à faibles revenus, quelle que soit la nationalité des bénéficiaires. Il s’adresse aux femmes enceintes ou allaitantes, aux mères en période post-partum ainsi qu’aux enfants de moins de cinq ans présentant un risque de carence nutritionnelle, c’est-à-dire un risque lié à un déséquilibre alimentaire susceptible d’entraîner des problèmes de santé et des maladies.

Durant l’année fiscale 2024, près de 6,7 millions de femmes et d’enfants ont pu bénéficier, chaque mois, des services de ce programme.

À lire aussi : 2 in 5 US babies benefit from the WIC nutrition program

Mi-octobre, l’administration Trump a alloué au programme WIC 300 millions de dollars, en provenance des recettes douanières, afin d’assurer la continuité de son fonctionnement durant le shutdown. Selon la National WIC Association (NWA), ces fonds ne seront plus suffisants au 1ᵉʳ novembre. La NWA réclame 300 millions de dollars (soit, environ 259 millions d’euros) supplémentaires pour garantir la pérennité des différents services de WIC durant les deux premières semaines de novembre.

Et si le shutdown se prolongeait et WIC se retrouvait à court de fonds ?

Le département de la santé du New Jersey a déjà exprimé ses craintes.

Dans le Michigan, une mère célibataire bénéficiaire de WIC, comme beaucoup d’autres, a fait part de son inquiétude :

« Les gens dépendent de WIC pour leurs besoins essentiels : lait, œufs, pain. Ne pas savoir si l’on pourra bénéficier de cette aide le mois prochain… est très angoissant. »

Dans certains États fédérés, les bureaux de WIC sont déjà impactés par la paralysie budgétaire. Au Kansas, un bureau de WIC a dû fermer ses portes, tandis que le département de la santé du Mississippi a été contraint de mettre de nombreuses demandes d’inscription à WIC sur liste d’attente.

Une telle situation met en péril la santé de nombreuses femmes enceintes. En effet, selon un rapport de l’Unicef publié en 2023 et intitulé « Dénutries et oubliées : Une crise nutritionnelle mondiale pour les adolescentes et les femmes », les femmes enceintes ayant une mauvaise alimentation sont plus susceptibles de contracter des infections et de connaître des complications mortelles pendant la grossesse.

De surcroît, les complications résultant du shutdown pourraient avoir une prévalence plus élevée chez les femmes noires bénéficiaires de WIC par rapport aux femmes blanches. Cette hypothèse peut être déduite des données du Centre pour le contrôle et la prévention des maladies, selon lesquelles les femmes noires aux États-Unis présentent un risque de mortalité lié aux complications de la grossesse ou de l’accouchement trois fois supérieur à celui des femmes blanches. Comme le souligne Ebony Hilton, anesthésiste à l’Université de Virginie et experte des disparités dans l’accès aux soins de santé, « Il a été maintes fois démontré que les femmes noires ne reçoivent pas le même niveau de soins. »

En l’absence de financement pour assurer la continuité du programme WIC, les carences nutritionnelles dont seraient victimes les femmes enceintes pourraient également avoir un impact négatif sur la santé de leur enfant à naître : naissance prématurée, faible poids, vulnérabilité aux maladies, augmentation du risque de mortalité néonatale, etc.

À lire aussi : Malnutrition à Gaza : son impact sur les 1 000 premiers jours de vie des bébés

Chez les immigrés

Une politique d’accueil favorable aux immigrés pourrait permettre aux États-Unis de faire face au déclin de la natalité dans le pays. Mais Donald Trump est connu pour son hostilité envers les immigrés, qu’ils soient en situation régulière ou non, à l’exception notable de certains, comme les Afrikaners, les Blancs (descendants de colons néerlandais ou français) d’Afrique du Sud. Depuis son retour au pouvoir, Trump mène une politique anti-immigration agressive, avec des arrestations et des expulsions massives d’immigrants illégaux ou présumés l’être.

À lire aussi : Rafles, expulsions… la gestion de l’immigration, illustration du tournant autoritaire de Donald Trump ?

L’un des principaux points de désaccord ayant conduit au shutdown concerne précisément la couverture médicale de certains immigrés. Les démocrates souhaitent que les immigrés présents légalement (les réfugiés, les demandeurs d’asile, etc.) aux revenus modestes puissent continuer à percevoir des subventions pour souscrire à l’assurance santé dite « Obamacare », officiellement connue sous le nom d’Affordable Care Act (ACA), afin de pouvoir accéder à des soins de base. Ce dispositif a été supprimé pour cette population par la loi budgétaire de juillet dernier. Or, les républicains refusent d’accéder à la requête des démocrates, au faux motif que ces derniers réclameraient une couverture santé gratuite pour les immigrés en situation irrégulière.

À lire aussi : How the government shutdown is hitting the health care system – and what the battle over ACA subsidies means

Sans la couverture médicale de l’ACA, le coût de l’éducation d’un enfant, ajouté à celui de la souscription à une assurance santé privée, pourrait constituer un facteur déterminant pour les immigrés légalement présents à faibles revenus dans le cadre de leur projet parental. Il est donc à craindre que certains des 1,4 million de migrants présents légalement, qui ne seront plus couverts par l’ACA, ainsi que les femmes immigrées qui ne remplissent pas les conditions de revenu pour bénéficier du programme WIC, renoncent à avoir des enfants, ou en aient moins.

In fine, dans le contexte actuel du shutdown ou après son déblocage, des inégalités économiques et raciales risquent, de nouveau, de se creuser en matière de procréation aux États-Unis.

Allane Madanamoothoo ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

30.10.2025 à 15:39

Demain, des virus au service de la médecine pour traiter des cancers, comme alternatives aux antibiotiques notamment

María Teresa Tejedor Junco, Catedrática de Microbiología, Universidad de Las Palmas de Gran Canaria

Texte intégral (3351 mots)

Nous associons les virus à des maladies infectieuses. Mais des recherches sont menées pour, à terme, utiliser des virus modifiés contre des cancers ou pour recourir à des virus bactériophages contre des infections résistantes aux bactéries.

Nous ne devons pas analyser la nature d’un point de vue anthropocentrique. De plus, dans de nombreuses occasions, nous ne disposons pas des connaissances suffisantes pour évaluer le rôle que jouent certains éléments (vivants ou inanimés) dans un écosystème donné.

Mais il est certain que les virus ont « mauvaise réputation ». En général, lorsque nous pensons aux microorganismes, la première chose qui nous vient à l’esprit, ce sont les maladies. Puis, petit à petit, nous nous souvenons d’aspects bénéfiques. Par exemple, la production d’antibiotiques (certaines moisissures et bactéries), des aliments comme le yaourt (bactéries) ou des boissons comme la bière (levures).

Et les virus, à quoi servent-ils ? On pourrait penser qu’ils ne servent qu’à causer des maladies… Ou alors, pas seulement ? Avons-nous des virus dans notre organisme même quand nous ne sommes pas malades ?

À lire aussi : Les virus, ces messagers invisibles de la conversation du vivant

Impossible de résumer dans un seul article tout ce que les virus apportent à notre existence. Mais nous pouvons passer en revue quelques exemples.

Traitement de cancers et d’autres pathologies

Le rétinoblastome est un type de cancer de l’œil qui touche principalement les enfants. Il peut entraîner la cécité et, s’il ne répond pas au traitement, il faut alors retirer les yeux pour éviter qu’il ne se propage à l’ensemble du corps.

Un adénovirus génétiquement modifié a été utilisé avec succès pour traiter cette maladie. Il attaque et élimine les cellules cancéreuses sans affecter les cellules saines.

Il existe également des essais visant à utiliser des virus modifiés dans le traitement d’autres types de tumeurs : mélanomes, glioblastomes. Et même pour traiter le cancer du col de l’utérus, causé par un autre virus.

Parmi les maladies chroniques, l’utilisation de bactériophages (virus qui attaquent les bactéries) est à l’étude pour le traitement de la mucoviscidose et de la colite ulcéreuse.

Quelques études montrent que les personnes en bonne santé ont une composition en phages dans leur intestin différente de celle des personnes atteintes de colite ulcéreuse (appelée également rectocolite hémorragique, ndlr) ou de la maladie de Crohn, deux troubles intestinaux graves.

Cela pourrait également être lié à l’efficacité de la transplantation fécale. Chez la souris, la présence d’un virus entérique semble compenser la fonction bénéfique du microbiome intestinal.

Il existe même un virus, appelé GBV-C, qui contribue à améliorer le pronostic des malades atteints du sida. Les personnes porteuses de ce virus, apparenté à celui de l’hépatite mais qui ne provoque aucune maladie, ne sont pas à l’abri du sida. Cependant, elles présentent moins de symptômes et la mortalité dans ce groupe est plus faible.

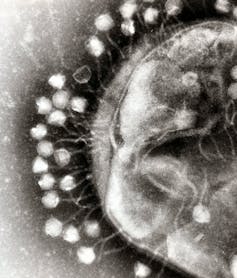

Une alternative aux antibiotiques pour traiter les infections

La phagothérapie consiste à utiliser des bactériophages pour traiter des infections graves. Elle constitue une alternative à l’utilisation d’antibiotiques, en particulier dans le cas d’infections où les bactéries sont résistantes à la plupart des antibiotiques disponibles.

Ces virus sont très spécifiques. Ils peuvent attaquer les bactéries pathogènes sans avoir aucun effet sur notre microbiome « bénéfique ».

En 1919, D’Herelle avait déjà recours à des phages pour traiter les infections. Actuellement, il s’agit d’un type de traitement très contrôlé, qui n’est utilisé que dans les cas d’infections très graves et lorsqu’il n’existe aucune autre option.

D’autre part, les phages pourraient constituer une alternative à l’utilisation d’antibiotiques, ce qui réduirait ainsi la pression sélective et l’apparition de résistances.

Contribuer à la sécurité alimentaire

Plusieurs entreprises travaillent au développement de « cocktails de phages » destinés à être administrés aux animaux d’élevage. Efficaces contre les bactéries pathogènes les plus courantes chez chaque espèce, ils améliorent la santé des animaux. Ils contribuent également à réduire le recours aux antibiotiques.

Les industries alimentaires sont particulièrement intéressées par l’utilisation des phages contre les principales bactéries pathogènes d’origine alimentaire. Ils pourraient même être utilisés pour désinfecter les installations de production.

Leur utilisation est également proposée pour lutter contre les microorganismes qui altèrent les aliments.

Les virus comme bioinsecticides

Les insecticides chimiques présentent plusieurs inconvénients. D’une part, ils génèrent des résistances. D’autre part, ils peuvent affecter des espèces d’insectes utiles et être toxiques pour l’être humain et d’autres vertébrés.

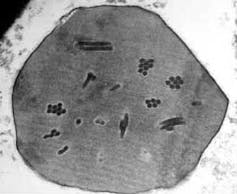

Les baculovirus présentent le grand avantage d’être hautement spécifiques à certaines espèces d’insectes. Ils ne sont pas pathogènes pour les plantes ni pour les vertébrés. De plus, ils n’affectent pas les autres espèces d’insectes.

Ils forment une capsule protéique qui les protège de l’environnement. Ils infectent les cellules de l’intestin moyen de l’organisme parasite et passent directement dans l’hémolymphe, ce qui provoque la mort de l’insecte responsable du ravage.

Fabriquer des vaccins

Outre leur utilisation comme bioinsecticides, les baculovirus sont également utilisés pour fabriquer des vaccins (à usages vétérinaires, ndlr). Pour ce faire, le gène d’intérêt est introduit dans le virus, puis l’insecte est infecté, ce qui le transforme en une petite « bio-usine » qui produit les protéines d’intérêt.

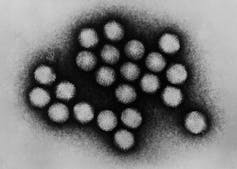

Certains vaccins mis au point contre le SARS-CoV-2 utilisent des adénovirus (les vaccins AstraZeneca et Janssen, notamment, reposent sur cette technologie mais il ne s’agit pas des vaccins recommandés aujourd’hui par le ministère de la santé français contre le Covid-19, ndlr). Des adenovirus ont également été utilisés pour fabriquer un vaccin contre Ebola et des recherches sont menées chez l’animal pour développer des vaccins contre Zika.

Un vaccin polyvalent contre la grippe aviaire et la maladie de Newcastle a été créé à partir d’un virus recombinant.

Virus marins

On estime qu’il existe entre 1028 et 1030 virus dans les océans. Ils constituent des éléments clés des écosystèmes marins. Ils peuvent infecter les animaux, les algues et les plantes marines ou d’autres microorganismes.

La grande majorité de ces virus sont des bactériophages. Certains auteurs ont calculé que les virus libèrent 145 gigatonnes de carbone par an dans les océans tropicaux et subtropicaux. Ils constituent donc un élément fondamental du cycle du carbone dans les écosystèmes.

De plus, ils sont responsables du transfert horizontal de gènes dans les océans.

D’autres bénéfices des virus

En 2017, une thérapie génique à base d’adénovirus a été approuvée aux États-Unis pour traiter une maladie héréditaire rare causant la cécité.

Les patients présentent une mutation au niveau des deux copies d’un gène. Cela les empêche de synthétiser une enzyme essentielle au développement normal de l’œil. À l’aide d’un adénovirus modifié, une copie normale du gène est ajoutée directement dans la rétine. Une seule injection suffit pour leur redonner la vue.

Les virus en général, et pas seulement les virus marins, sont de grands générateurs de diversité génétique. Ils ont généralement un taux de mutation élevé, ont tendance à se mélanger entre eux et peuvent s’intégrer (et se désintégrer) dans le génome de leur hôte.

Ils confèrent aux bactéries la capacité de résister à certains antibiotiques ou de produire des toxines, ce qui est bon pour elles, mais pas pour nous. Il existe également des virus insérés dans le génome des vertébrés, y compris des humains. Ils semblent être impliqués dans la régulation génétique et peuvent contribuer à l’apparition de nouvelles fonctions.

Le plus surprenant chez les virus est peut-être leur rôle dans le développement de la vie humaine. Le génome humain contient 8 % d’ADN viral. Il s’agit de restes de rétrovirus qui se sont insérés dans notre ADN au cours de l’histoire de l’humanité. Jusqu’à récemment, on les considérait comme de l’« ADN poubelle ». Cependant, plusieurs études ont démontré leur importance.

Cet ADN viral code une protéine, la syncytine, qui est essentielle à la formation du placenta, l’organe qui permet l’échange de substances entre le sang de la mère et celui du fœtus.

Il existe de nombreux autres aspects dans lesquels les virus contribuent à améliorer notre existence. N’oublions pas que seul un faible pourcentage d’entre eux peut l’aggraver… mais de manière drastique.

María Teresa Tejedor Junco ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

30.10.2025 à 11:55

Les fantômes des pesticides hantent nos environnements pour longtemps

Gaspard Conseil, Docteur en écotoxicologie, attaché temporaire d’enseignement et de recherche à l’Université de Lorraine (UL, ENSAIA, L2A), Université de Lorraine

Damien Banas, Professeur en Agronomie/Hydrobiologie, Université de Lorraine

Texte intégral (2979 mots)

De l’autre côté du miroir d’eau paisible des étangs, on rencontre en réalité de véritables « fantômes moléculaires » laissés par les pesticides utilisés pour l’agriculture. Même lorsque la substance originelle a été depuis interdite, ses produits de transformation – parfois plus toxiques – peuvent persister longtemps. Et si l’on envisageait les étangs différemment ? Les considérer comme des archives biochimiques des pollutions passées pourrait nous aider à améliorer la surveillance sanitaire et à prendre de meilleurs décisions réglementaires aujourd’hui.

Sous la surface calme des étangs (et, en particulier, des étangs agricoles) se cache une contamination invisible mais omniprésente. Sur l’ensemble des substances chimiques surveillées en milieu aquatique, 86 % sont des produits de transformation de pesticides plutôt que des pesticides eux-mêmes. Ce paysage est dominé par des dérivés du chlorothalonil, pesticide pourtant interdit en Europe et en Suisse depuis 2019, qui ont depuis été détectés d’abord en Suisse, puis signalés au sein d’unités françaises de traitement de l’eau potable.

Ces « fantômes moléculaires », souvent ignorés des suivis classiques, sont pourtant impliqués dans la dégradation silencieuse de la qualité des eaux. Dans une recherche scientifique publiée en 2025, nous avons mis en évidence qu’ils modifient le comportement et le métabolisme de petits crustacés d’eau douce (ici, Gammarus roeseli) utilisés comme sentinelles biologiques.

À la fois témoins et victimes des pollutions chimiques successives de l’environnement, ces organismes livrent une histoire préoccupante, inscrite dans le vivant, que les simples mesures chimiques ne permettent pas de lire.

La mémoire chimique des étangs

Les étangs ne sont pas de simples plans d’eau, mais des archives vivantes de l’activité humaine environnante. Souvent connectés aux rivières, ils s’imprègnent de l’héritage chimique des pratiques agricoles, à travers les métabolites de produits phytopharmaceutiques, ou produits de transformation (PT), qui en résultent.

Quand bien même un pesticide est amené à être retiré du marché, son empreinte chimique demeure. Des PT issus de la dégradation d’une molécule mère peuvent ainsi persister longtemps dans l’eau, dans les sédiments ou dans les organismes vivants. Longtemps invisibles, car peu connus et peu étudiés, ils rappellent que la contamination environnementale n’est pas qu’une affaire du présent, mais aussi une mémoire du passé.

Nous vivons ainsi avec les cicatrices laissées par des produits chimiques utilisés à d’autres époques, lorsque leurs effets étaient encore mal connus. Et pourtant, nous continuons de répéter la même erreur : autoriser la commercialisation de produits aux effets mal compris. Nous déléguons alors de nouveaux problèmes à nos enfants.

Même lorsqu’on interdit un pesticide, ses descendants sont toujours là

L’herbicide atrazine, interdit depuis 2003, illustre très bien le problème. Ses métabolites sont encore détectés vingt ans après son interdiction dans de nombreuses masses d’eau françaises.

Les progrès de la recherche et les nouvelles connaissances acquises ont conduit à des réglementations plus strictes, comme le Règlement européen (CE) no 1107/2009, qui exclut l’autorisation de mise sur le marché de substances persistantes ou qui s’accumulent dans les organismes.

La relation entre l’humain et son environnement reste complexe. L’histoire que nous commençons à lire grâce aux outils analytiques mobilisés en écotoxicologie, qui intègrent à la fois des approches chimiques et biologiques, devrait éclairer nos choix présents et nous permettre d’éviter de les regretter demain.

Le fongicide chlorothalonil, interdit en 2019, fournit un exemple récent de ce décalage entre décision réglementaire et réalité environnementale. Son métabolite R471811 est aujourd’hui retrouvé dans de nombreuses eaux de surface et souterraines européennes. Il n’existe a priori pas de preuves qu’il présente un risque avéré, mais cela pourrait être réévalué dans cinq, dix ou trente ans.

Ces reliquats chimiques révèlent l’inertie propre des cycles environnementaux, souvent difficiles à cerner ou à mesurer. Ils soulignent aussi les limites de nos politiques de retrait, capables de réagir vite, mais impuissantes face à la persistance du passé et à la multiplicité des substances chimiques encore autorisées (422 en Europe en octobre 2025.

Expositions chimiques invisibles, ou difficiles à cerner ?

Les milieux aquatiques sont exposés à une mosaïque de contaminants que les scientifiques appellent exposome chimique, c’est-à-dire l’ensemble des substances auxquelles un organisme ou un écosystème est exposé au cours de sa vie.

Si les substances actives sont surveillées via la réglementation européenne, les PT passent souvent sous le radar. Un seul pesticide peut engendrer plusieurs molécules filles, parfois plus durables et plus mobiles que la molécule mère. Les connaissances sur leur toxicité sont encore très lacunaires, avec peu de tests de toxicité, peu de standards analytiques et très peu de données sur leurs effets cumulés. Ainsi, une part importante du risque nous échappe encore.

Dans un travail antérieur, mené en 2024, sur les étangs agricoles du nord-est de la France, nous avions déjà montré que plus d’une molécule détectée sur deux était un PT encore dépourvu de profil écotoxicologique connu. En d’autres termes, une partie du risque reste littéralement dans l’ombre.

À lire aussi : « L’envers des mots » : Exposome

Des crevettes pour sonder l’eau des étangs

Les grands cours d’eau font l’objet de suivis réguliers. Les étangs, eux, sont les parents pauvres de la limnologie (c’est-à-dire la science des lacs) et restent peu étudiés. Pourtant, ils ponctuent nos paysages et abritent souvent une large biodiversité constituée de poissons, d’oiseaux, de batraciens, de reptiles, d’insectes et de végétaux divers. Ils jouent aussi un rôle d’interface entre terres agricoles et nappes souterraines. Exposés aux polluants au fil du temps, ils jouent un rôle de « mémoire tampon » entre terres cultivées et milieux naturels, entre les eaux de surface et les nappes souterraines.

Pour explorer cette mémoire chimique, notre équipe a eu recours à une approche de biosurveillance active, où l’on utilise le vivant pour évaluer la qualité de l’eau. Cette méthode consiste à confronter des organismes sentinelles à l’environnement étudié afin d’observer leurs réactions biologiques, en parallèle de l’analyse chimique dite de l’exposome, décrit précédemment (l’ensemble des substances auxquelles le milieu est exposé, et de facto, nous aussi).

Croiser ces deux lectures, chimique et biologique, permet d’obtenir un indicateur global de l’état de santé d’une masse d’eau bien plus représentatif que la simple mesure de concentrations d’une liste de contaminants strictement définis.

Concrètement, nous avons placé dans sept étangs lorrains implantés le long d’un gradient de terres agricoles aux pratiques diversifiées (sans activité agricole, en agriculture biologique ou en agriculture conventionnelle) de petits crustacés d’eau douce, Gammarus roeseli, enfermés dans de fines cages perméables.

Ces gammares, discrets habitants des rivières, sont de véritables sentinelles biologiques. Leur respiration, leurs mouvements et leurs activités enzymatiques reflètent fidèlement la qualité du milieu où ils vivent. Pendant une semaine, ces organismes ont été exposés à l’eau et leur état de santé a été suivi. En parallèle, dans chaque étang, 136 substances (herbicides, insecticides, fongicides, et leurs PT) ont été recherchées.

Les résultats montrent une prédominance écrasante des produits de transformation, qui représentaient 86 % des contaminants détectés, dominés par les dérivés du chlorothalonil et du métazachlore.

Les gammares ont survécu, mais leur comportement et leur métabolisme ont changé. Ralentissement des déplacements, troubles de la respiration et activation des mécanismes de détoxification traduisent le signal précoce d’un potentiel stress toxique. Ces réactions biologiques confirment que la contamination, bien qu’étant une affaire de chimie, s’inscrit profondément dans le vivant. En d’autres termes, les organismes racontent ce que les analyses chimiques ne suffisent pas toujours à voir.

De la science au terrain : comment gouverner l’invisible ?

Reste à savoir comment intégrer au mieux ces signaux biologiques et cette mémoire chimique dans les décisions publiques et réglementaires.

Aujourd’hui, la surveillance réglementaire reste essentiellement centrée sur les substances actives autorisées. Pourtant, le risque dépasse largement ces molécules. Il s’étend dans le temps, change de forme, interagit avec d’autres contaminants et varie selon les conditions environnementales. L’environnement et sa biodiversité sont aussi le siège d’une diversité de voies de transformation et de transfert des contaminants.

La surveillance doit donc évoluer, élargir les listes de substances suivies, développer les outils biologiques, et, surtout, agir avec précaution dans un contexte où tout ne peut être mesuré ni anticipé : il serait illusoire de vouloir tout tester et suivre toutes les substances possibles et imaginables. L’enjeu est donc surtout de prioriser les composés les plus à risque et de protéger les milieux les plus vulnérables.

Il existe ainsi trois leviers pour mieux protéger les milieux aquatiques :

élargir la couverture analytique, c'est-à-dire les méthodes et techniques utilisées pour identifier et quantifier les PT issus de la dégradation des pesticides dans les suivis de routine,

renforcer les outils biologiques capables de traduire la complexité chimique en signaux écologiques mesurables, par exemple, le recours à des organismes sentinelles,

enfin, prioriser localement les actions de gestion (par exemple, rotation des cultures, zones tampons sans traitement, meilleure gestion des effluents et du ruissellement, ou encore l'aménagement de réseaux de drainage) adaptées aux usages et aux vulnérabilités des territoires.

De récentes observations nous montrent que les dynamiques observées en Lorraine ressemblent à celles de sites agricoles en Suisse, dans le canton de Genève. Nous menons depuis l’été 2025 des recherches avec la Haute école du paysage, d’ingénierie et d’architecture de Genève (Hépia) à ce sujet.

Ces enjeux de pollution franchissent donc les frontières, mais les solutions doivent émerger localement, en combinant restauration de zones tampons (qui permettent d’atténuer les transferts de contaminants d’origine agricole vers les milieux aquatiques), diversification des pratiques et surveillance chimique et biologique intégrée.

Une écologie de la mémoire

Les étangs sont les miroirs de nos paysages agricoles, mais en constituent surtout des archives. Ils accumulent, filtrent et témoignent des usages passés. Reconnaître cette mémoire chimique, c’est accepter que certaines traces mettent des décennies à s’effacer.

Les produits de transformation des pesticides ne sont ni marginaux ni nouveaux. Ils incarnent une génération de micropolluants qui s’ancre dans la mémoire chimique de nos agroécosystèmes. Les inclure, les considérer, c’est comprendre qu’un étang, aussi petit soit-il, peut raconter une histoire de pollutions passées, mais aussi celle d’une vigilance à retrouver.

À l’heure où les politiques de transition agricole s’accélèrent, prendre en compte ces produits de transformation est essentiel pour éviter que ces fantômes chimiques ne pèsent sur les générations futures. Ce que nous faisons aujourd’hui s’inscrira dans la mémoire environnementale de demain. À nous de choisir l’histoire que ces étangs raconteront aux générations futures.

Gaspard Conseil a reçu des financements de l'Office français de la biodiversité (OFB).

Damien Banas a coordonné le projet CABARETox (ContAmination des matrices Biotiques et Abiotiques par les Résidus phytopharmaceutiques en Étangs : volet écotoxicologie), financé par l’Office Français de la Biodiversité (OFB), dont sont issus les résultats présentés dans le présent article.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr