24.02.2026 à 19:44

Chiens de race : l’esthétique peut-elle justifier la souffrance ?

Valérie Chansigaud, Historienne des sciences et de l'environnement, chercheuse associée au laboratoire Sphère (Paris Cité - CNRS), Université Paris Cité

Texte intégral (2735 mots)

Afin de limiter la souffrance animale, la Commission européenne tâche de poser des limites à la sélection génétique des races de chiens et de chats aux traits dits extrêmes. Si cette avancée demeure inédite, elle réagit à un phénomène tout sauf nouveau : l’obsession de l’être humain pour l’apparence des animaux domestiques.

Le Conseil et le Parlement européens ont récemment adopté une accord provisoire visant à encadrer plus strictement l’élevage des chiens et des chats, en interdisant notamment la reproduction et la mise en avant d’animaux présentant des « formes extrêmes ».

Sont particulièrement concernées certaines morphologies associées à des troubles graves et durables, comme les chiens au museau écrasé, chez lesquels les difficultés respiratoires, l’intolérance à l’effort ou les problèmes locomoteurs sont désormais bien documentés.

Cette évolution réglementaire répond à des alertes répétées du monde vétérinaire et à une sensibilité croissante de l’opinion publique à la souffrance animale. Elle s’inscrit également dans une longue histoire de la place démesurée accordée par les sociétés humaines à l’apparence des animaux domestiques et à leur volonté de la façonner.

Sélectionner l’apparence : une pratique ancienne aux usages multiples

Il est impossible de dater précisément le moment où les humains auraient commencé à sélectionner des animaux sur des critères esthétiques. Bien avant l’existence des « races » au sens moderne (un phénomène qui émerge au XIXᵉ siècle), des animaux étaient déjà choisis en fonction de leur sexe, de leur âge, de leur couleur ou de leur conformation.

Dans de nombreuses sociétés anciennes, les animaux destinés au sacrifice devaient ainsi répondre à des critères précis d’apparence et d’intégrité corporelle : dans les cultes grecs et romains, seuls des animaux « sans défauts » étaient admis devant les divinités ; en Chine, sous la dynastie Zhou (XIᵉ siècle avant notre ère), les sacrifices royaux exigeaient également des bêtes jugées parfaites, tant extérieurement qu’intérieurement.

Autrement dit la sélection sur l’apparence est probablement aussi ancienne que la domestication elle-même. Elle n’était jamais isolée : elle s’entremêlait à des critères religieux, sociaux, économiques ou politiques, par exemple lorsque le pouvoir politique affirme sa puissance en imposant des animaux sacrificiels répondant à des normes précises.

Ce qui change à l’époque contemporaine, c’est que l’apparence peut devenir, dans certains cas, le critère central, voire exclusif, de la création des races. Posséder un chien de race peut ainsi marquer un rang, une appartenance sociale ou un certain rapport au monde, comme d’autres animaux ont pu, à différentes époques, signaler le prestige ou le pouvoir de leur propriétaire, à commencer par le cheval, mais aussi certains chiens de chasse.

Une préoccupation tardive pour la santé et le bien-être

Les races modernes émergent au XIXᵉ siècle, dans un contexte marqué par le goût pour la classification, la hiérarchisation et la distinction sociale fondée sur la notion de « race ». Cette passion pour les lignées « pures » n’est pas sans lien avec les cadres intellectuels qui, à la même époque, voient se développer les théories raciales appliquées aux humains.

Pendant longtemps, les effets de la sélection ont été évalués presque exclusivement à l’aune de la productivité, de l’efficacité ou de la conformité à un standard. La souffrance animale était connue, mais largement tolérée, considérée comme secondaire, voire inévitable. Les pratiques vétérinaires elles-mêmes en témoignent : pendant une longue période, des interventions lourdes ont été pratiquées sans anesthésie, comme la stérilisation des chiennes.

D’autres gestes, aujourd’hui reconnus comme inutiles et douloureux, étaient également courants : on sectionnait par exemple le frein de la langue chez les chiens, dans l’idée erronée de prévenir la rage.

Ces pratiques témoignent d’un rapport au corps animal dans lequel la souffrance était largement ignorée, par indifférence plus que par méconnaissance.

Ce n’est qu’à partir de la seconde moitié du XXᵉ siècle que la douleur chronique, la qualité de vie ou la santé à long terme des animaux commencent à être pensées comme des problèmes en tant que tels. Les inquiétudes actuelles concernant les chiens aux morphologies extrêmes – difficultés respiratoires, troubles locomoteurs, intolérance à l’effort – s’inscrivent pleinement dans cette histoire récente de la sensibilité au bien-être animal.

Des chats qui ont longtemps échappé à cette logique

La récente réglementation européenne semble concerner plus directement les chiens que les chats, et cette impression correspond à une réalité historique, biologique et sociologique. En France, comme dans de nombreux pays européens, les chiens de race sont proportionnellement plus nombreux que les chats de race. Cette différence s’explique en grande partie par l’histoire de l’élevage.

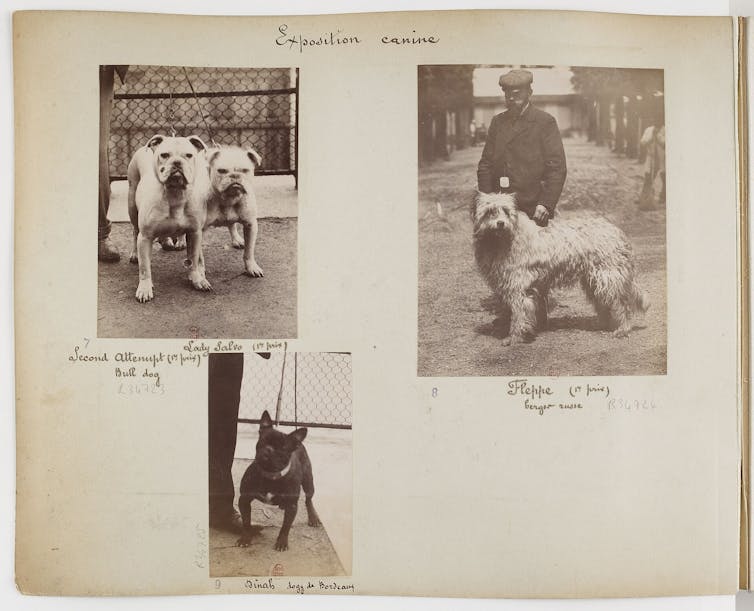

L’intérêt pour les races de chiens est ancien et structurant. La sélection de types morphologiques spécifiques devient l’un des moteurs centraux de l’élevage canin au XIXᵉ siècle, en systématisant et en normant des pratiques bien plus anciennes de différenciation fonctionnelle. Dès l’Antiquité, certains chiens sont ainsi recherchés pour des usages guerriers ou de combat, en fonction de leur taille, de leur puissance ou de leur agressivité.

Ce type de sélection n’est d’ailleurs pas propre aux chiens : chez les gallinacés, des individus ont été privilégiés très tôt pour des usages non alimentaires, notamment pour le combat de coqs ou comme animaux d’ornement, bien avant que ne s’impose une sélection orientée vers la production de chair ou d’œufs.

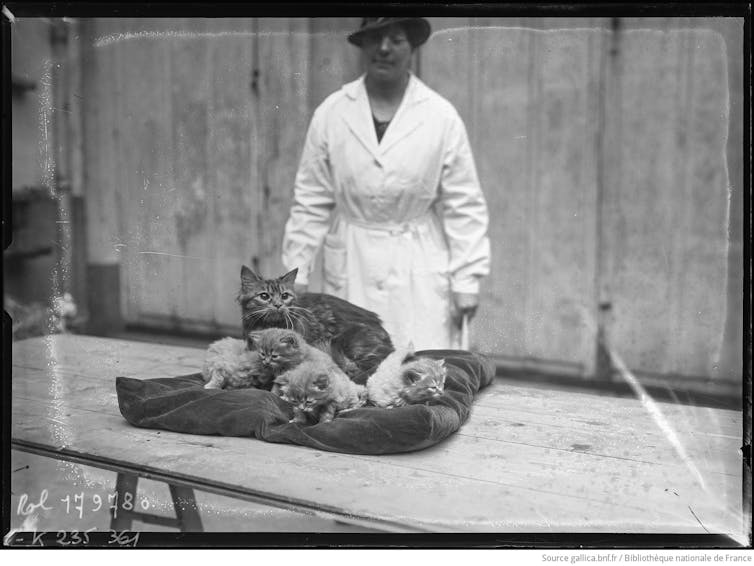

À l’inverse, les chats ont longtemps échappé à cette logique. Les premiers concours félins du XIXᵉ siècle récompensaient des individus – souvent des chats de gouttière – et non des représentants de races qui n’étaient pas encore standardisées. Le chat est resté plus longtemps un animal ordinaire, moins soumis aux impératifs de sélection morphologique.

Quels chiens demain ?

Les croisements récents, comme le pomsky (issu du croisement du husky sibérien et du spitz nain), témoignent aujourd’hui d’une forte demande pour des animaux perçus comme originaux et attendrissants, mais qui sont surtout emblématiques d’un effet de mode.

Le choix de ces chiens relève moins d’une réflexion sur leurs besoins ou leur santé que d’une logique de distinction : on choisit un chien comme on choisirait une paire de chaussures, parce qu’il flatte l’ego de son propriétaire et signale une position sociale. Dénoncées depuis longtemps par les vétérinaires, qui constatent au quotidien les conséquences de la sélection de morphologies extrêmes, ces pratiques pourraient être freinées par la nouvelle réglementation européenne, en rappelant clairement que tout croisement n’est pas acceptable dès lors qu’il compromet la santé ou le bien-être des animaux concernés.

Prédire à quoi ressembleront les chiens du futur reste toutefois hasardeux. L’histoire montre que les avancées en matière de protection animale ne sont ni linéaires ni irréversibles. L’émergence d’idéologies brutales ou violentes pourrait très bien conduire à un recul de la prise en compte de la souffrance animale. L’interdiction des formes extrêmes révèle ainsi une tension ancienne entre la vanité des désirs humains parfois cruels et la nécessité d’établir des règles morales pour en limiter les effets – un débat aussi vieux que la philosophie elle-même.

Cette réflexion trouve un écho particulier dans certaines initiatives muséales récentes. L’exposition « Domestique-moi, si tu peux », présentée au Muséum de Toulouse (Haute-Garonne), propose ainsi de revisiter l’histoire longue de la domestication en montrant qu’il ne s’agit pas d’un phénomène « naturel » et qu’elle est façonnée par des choix humains parfois irrationnels. Elle met surtout en évidence la place centrale de la domestication dans la construction des cultures humaines, la sélection artificielle ayant pour objectif principal de rendre des organismes vivants – animaux comme végétaux – compatibles avec les modes de vie et les besoins humains.

L’exposition « Domestique-moi, si tu peux » retrace l’histoire des domestications animales et végétales et leurs conséquences sur la biodiversité. On peut la visiter jusqu’au 5 juillet 2026 au Muséum de Toulouse. L’historienne Valérie Chansigaud en est la commissaire scientifique.

Valérie Chansigaud ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

24.02.2026 à 17:03

Les raisons de la mobilisation agricole en Europe expliquées par les agriculteurs eux-mêmes

Sophie Thoyer, Directrice de département Scientifique, Inrae

Pauline Lecole, Maitresse de conférence en économie et politiques agricoles, Montpellier SupAgro

Texte intégral (2049 mots)

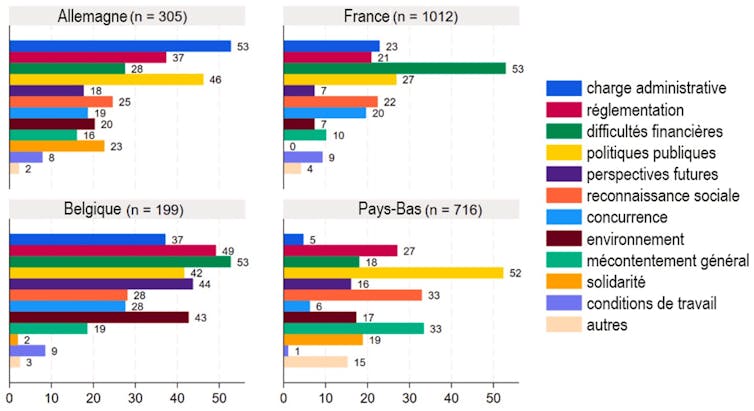

Depuis l’hiver 2024, les mobilisations agricoles ont été largement interprétées, au plan médiatique, comme un rejet massif des normes environnementales. Mais est-ce vraiment le cas ? Qu’en disent eux-mêmes les agriculteurs mobilisés ? Une vaste étude a recensé leurs réponses en France, en Allemagne, en Belgique et aux Pays-Bas. Elle livre une image bien plus nuancée en fonction des États, où le poids des normes environnementales n’est finalement qu’un enjeu secondaire. Celui-ci a pourtant été au cœur de la réponse politique.

Blocages d’autoroutes, convois de tracteurs vers les capitales, déversements de fumier devant les bâtiments publics… depuis l’hiver 2024, les agriculteurs européens se mobilisent de façon spectaculaire. Très visibles, ces mouvements restent pourtant mal compris. Entre cadrages médiatiques hâtifs et récupérations politiques, leurs revendications ont souvent été résumées à un rejet des normes environnementales. Mais est-ce réellement ce que disent les agriculteurs eux-mêmes ?

Pour répondre à cette question, nous avons récemment publié une étude qui s’est appuyée sur une vase enquête en ligne, menée entre avril et juillet 2024, auprès de plus de 2 200 agriculteurs ayant participé aux mobilisations en France, en Allemagne, en Belgique et aux Pays-Bas.

Plutôt qu’une liste fermée de griefs, nous avons préféré leur poser une question simple et surtout ouverte : « Pourquoi vous mobilisez-vous ? » Les agriculteurs ont ainsi pu répondre de façon anonyme et sous une forme libre : parfois en quelques mots, parfois en plusieurs paragraphes.

À lire aussi : Colère des agriculteurs : « Ce qui était cohérent et cohésif est devenu explosif »

Une pluralité de motivations

Cette méthode a permis d’éviter d’orienter les réponses et de saisir les motivations telles que formulées spontanément par les intéressés eux-mêmes. Les textes ont ensuite été analysés, dans leur langue d’origine, grâce à un grand modèle de langage (LLM), type d’outil relevant de l’intelligence artificielle (IA), pour identifier les principales revendications. Un codage manuel a ensuite permis, pour la France, de vérifier la cohérence de l’analyse faite par l’IA.

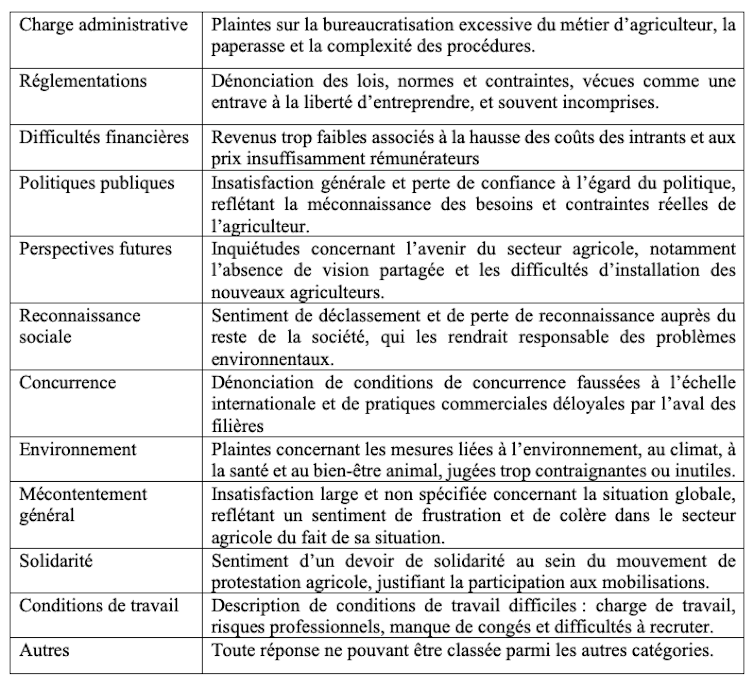

Nous avons ainsi pu identifier les grands thèmes récurrents, et ceci en limitant les biais d’interprétation. À la clé, une dizaine de catégories de motivations, que nous avons résumées dans le tableau ci-dessous :

En termes de codage, une réponse peut entrer dans plusieurs catégories de motivations à la fois. Par exemple, un exploitant français cultivant 175 hectares (ha) a indiqué en réponse à l’enquête :

« On nous fait marcher à la baguette, on nous pond des interdictions de partout qui nous compliquent [le] travail, alors que l’on travaille beaucoup à un tarif horaire de misère. »

Cette réponse a pu ainsi être classée à la fois dans les catégories « réglementation », « difficultés financières », « politiques publiques » et « conditions de travail ».

Des revendications différenciées en Europe

Contrairement à l’idée d’un mouvement unifié partout en Europe autour du rejet des normes environnementales et des insatisfactions liées au revenu, les motivations sont apparues comme fortement différenciées selon les pays.

En France et en Belgique, les difficultés financières dominent largement : plus d’un agriculteur sur deux évoque la faiblesse des revenus, la hausse des coûts des intrants et des prix jugés insuffisamment rémunérateurs.

En Allemagne, la première préoccupation concerne la charge administrative, citée dans plus de la moitié des réponses.

Aux Pays-Bas, les critiques visent plus directement l’inadéquation des réponses en terme de politiques publiques aux besoins et contraintes du monde agricole.

La dénonciation explicite des règles environnementales arrive loin derrière, sauf dans le cas de la Belgique. En France, elle n’est mentionnée que dans une faible proportion des réponses, bien en deçà des enjeux de revenu, de reconnaissance ou de concurrence.

Le mouvement de 2024 apparaît ainsi loin d’être homogène à l’échelle européenne, malgré les tentatives de certains acteurs syndicaux de porter un message unitaire.

À lire aussi : La FNSEA, syndicat radical ? Derrière le mal-être des agriculteurs, des tensions plus profondes

Un décalage entre les revendications et les réponses politiques

Nous avons ensuite comparé ces motivations aux mesures politiques adoptées entre fin 2023 et septembre 2024 aux niveaux national et européen.

Dans certains cas, les réponses publiques ont été en phase avec les préoccupations exprimées. En Allemagne, l’accent a été mis sur la simplification administrative, qui correspond à la principale revendication identifiée dans notre enquête. En France et en Belgique, plusieurs mesures ont visé à atténuer les difficultés de revenu, mais les moyens mis en œuvre sont restés limités.

En revanche, certaines thématiques ont reçu une attention politique disproportionnée au regard de leur poids réel dans les déclarations des agriculteurs. C’est notamment le cas des régulations environnementales.

Cela s’est traduit notamment dans le paquet simplification de la politique agricole commune (PAC) de mai 2024, qui a accordé des dérogations et des flexibilités supplémentaires à l’application des règles de conditionnalité dans les États membres.

Alors qu’elle n’arrivait qu’en septième position des préoccupations déclarées par les agriculteurs, la réduction des contraintes environnementales a été le troisième chantier législatif en Allemagne, en terme de nombre de mesures prises. Aux Pays-Bas, ce fut même le premier.

De la même manière en France, seuls 7 % des agriculteurs se sont exprimés explicitement pour critiquer le poids des normes environnementales. Pourtant, le gouvernement français a répondu par une suspension du plan Écophyto (destiné à réduire l’usage des pesticides) et par l’allègement des contrôles liés aux obligations environnementales.

Plus tard, une grande partie des débats sur le contenu de la loi d’orientation pour la souveraineté alimentaire et le renouvellement des générations en agriculture, finalement promulguée en mars 2025, et de la proposition de loi sur les contraintes à l’exercice du métier d’agriculteur (dite « loi Duplomb »), ont été extrêmement concentrés sur l’allègement des normes environnementales.

À lire aussi : Loi Duplomb et pesticides : comment la FNSEA a imposé ses revendications

Entre expression sociale et cadrage stratégique

Cette focalisation sur les normes environnementales interroge. Elle suggère que certaines revendications ont été amplifiées dans l’espace public, au croisement d’intérêts syndicaux, économiques et politiques. Comme dans tout mouvement social, les mots d’ordre qui circulent ne reflètent pas toujours l’ensemble des préoccupations individuelles.

Donner directement la parole aux agriculteurs ne permet pas seulement de nuancer le récit dominant : cela met en lumière la profondeur du malaise. Au-delà des normes ou des aides, beaucoup expriment un sentiment de déclassement, de perte de sens et d’absence de perspectives pour les générations futures.

Comprendre ces mobilisations suppose donc d’aller au-delà des slogans et de reconnaître leur diversité interne. Faute de quoi, les réponses politiques risquent de traiter seulement les symptômes stratégiquement mis en visibilité par les groupes d’influence plutôt que les causes structurelles du malaise agricole européen.

Solal Courtois-Thobois a participé à la réalisation de cet article.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

23.02.2026 à 17:18

Municipales 2026 : comprendre la gratuité des transports en graphiques

Félicien Boiron, Doctorant en science politique (LAET-ENTPE), ENTPE; Université Lumière Lyon 2

Texte intégral (2091 mots)

Dunkerque, Montpellier, Calais, Nantes… toutes ces villes ont mis en place la gratuité totale des transports en commun. Promue par certains candidats, conspuée par d’autres, cette mesure devient un élément central des campagnes électorales municipales de 2026. Mais qu’en disent les experts ? Quels sont ses effets bénéfiques et pernicieux ? Décryptage en graphique et en données.

La gratuité des transports en commun, rarement débattue aux élections municipales de 2014 et encore relativement discrète en 2020, se trouve désormais au cœur des campagnes municipales de 2026. Mobiliser une forme de gratuité semble être devenu un passage obligé des débats locaux.

À Lyon (Rhône), après avoir mis en place la gratuité pour les moins de 10 ans, le président de la Métropole Bruno Bernard (Les Écologistes) fait campagne en mobilisant la gratuité des enfants abonnés TCL. De son côté Jean-Michel Aulas (LR, Ensemble) propose une gratuité pour les personnes gagnant moins de 2 500 euros.

Des débats similaires s’ouvrent dans des villes de tailles et de contexte variés comme Angers (Maine-et-Loire), Dijon (Côte-d’Or), Marseille (Bouches-du-Rhône), Paris.

Gratuité totale des transports

Alors même que les transports en commun relèvent le plus souvent de la compétence des intercommunalités, les décisions de gratuité sont prises par une large diversité de collectivités locales, parfois au titre d’autres compétences.

La gratuité est longtemps restée cantonnée à des territoires de petites tailles, avec des transports en commun peu utilisés et de faibles recettes de billetique. À présent, elle s’invite dans des territoires pluriels. Si elle reste principalement mise en œuvre à l’échelle territoriale des villes, elle se développe au sein de communautés urbaines, comme Poher Communauté en Bretagne, ou par les syndicats de transport comme dans le Douaisis, dans le nord de la France.

Après les records de mise en place de cette mesure dans les villes d’Aubagne (100 000 habitants, Bouches-du-Rhône) en 2009, puis de Dunkerque (200 000 habitants, Nord) en 2018, Montpellier (Hérault) a fait franchir un nouveau seuil à la gratuité à partir de 2021 en instaurant la mesure pour ses habitants sur un réseau comprenant plusieurs lignes de trams. Pour sa part, depuis janvier 2026, le syndicat de transports de l’Artois, dans le Nord, est devenu le plus grand territoire français aux transports totalement gratuits avec 650 000 habitants pouvant bénéficier d’une telle mesure.

Si certains partis ont fait de la gratuité des transports un élément fréquent dans leur programme comme le Parti communiste français (PCF), ou plus récemment La France insoumise (LFI), la gratuité n’est pas réservée aux politiques de gauche. Elle est mise en œuvre aussi bien par la droite, comme à Calais (Pas-de-Calais) ou à Châteauroux (Indre), que par la gauche, comme à Morlaix (Finistère) ou Libourne (Gironde). La mesure résiste aux alternances politiques, en étant rarement remise en question.

Report modal de la marche vers les transports en commun

Depuis plusieurs années, les rapports et positions sur la gratuité des transports en commun font légion. Alors que, jusque dans les années 2010, la mesure était peu étudiée, essentiellement par les services du ministère de l’environnement, de nombreuses évaluations se sont développées. Des études ont été commandées par la Ville de Paris, par l’Île-de-France Mobilités ou encore par le syndicat de transports lyonnais (Sytral).

Dans ces études, la gratuité des transports en commun est largement évaluée selon ses effets sur la répartition modale, comprise comme le pourcentage d’utilisation des différents modes de transports. La gratuité est jugée bonne si elle permet un bon report modal, c’est-à-dire d’un mode polluant vers un mode moins polluant – de la voiture au vélo, par exemple. Les rapports concluent que la gratuité est inefficace, puisqu’elle engendrerait un report modal, essentiellement depuis la marche et le vélo vers les transports en commun. Même la Cour des comptes a récemment pointé cette inefficacité à produire un bon report modal.

À lire aussi : Gratuité des transports : comprendre un débat aux multiples enjeux

Ce constat d’inefficacité est alors largement relayé au-delà de la sphère experte, notamment par des acteurs institutionnels et des groupes d’intérêts du transport, qui s’appuient sur ces évaluations pour structurer leur opposition à la gratuité. Les groupes d’intérêts du transport, comme le GART, qui regroupe les collectivités, ou l’UTPF, qui regroupe les entreprises de transport, s’appuient sur ces constats pour s’opposer à la mesure. Les groupes d’intérêts du transport mobilisent ces expertises pour s’opposer assez unanimement à la gratuité. La FNAUT qui représente les usagers et usagères des transports défend que « la gratuité totale, isolée de toute autre mesure, ne favorise pas un report modal ».

Politique publique de mobilité

Si la gratuité des transports est fréquemment étudiée comme une politique publique de mobilité, les élus qui la mobilisent le font au nom d’une grande variété d’objectifs. Nombreux sont les motifs évoqués pour défendre la gratuité, tels que réduction de la pollution de l’air, attractivité territoriale et des commerces, protection du pouvoir d’achat, etc.

À Aubagne, c’est la recherche de liberté et d’accessibilité sociale accrue aux transports qui sont mises en avant. À Dunkerque, on y voit un instrument d’aménagement urbain pour redynamiser le centre-ville. À Montpellier, la mesure est présentée comme un instrument de gouvernance territoriale, pour améliorer le pouvoir d’achat des classes moyennes et populaires. À Calais, on souhaite répondre au mouvement des gilets jaunes et au coût des déplacements. À Nantes (Loire-Atlantique), la gratuité le week-end est associée à des objectifs sociaux et de réduction de l’autosolisme.

Une grande partie des effets prétendus à la gratuité des transports échappe à l’évaluation. Les effets sociaux de la mesure, notamment sur l’isolement de certaines populations, sur la facilité d’accès au transport, ont été encore peu étudiés. Même lorsque l’Observatoire des villes du transport gratuit s’intéresse aux conséquences sur les automobilistes ou sur les jeunes, ce sont essentiellement leurs chiffres sur le report modal qui sont repris dans les débats.

Financer les transports

En France, les transports en commun sont financés par trois sources principales :

le versement mobilité, impôt sur la masse salariale, payée par les entreprises, administrations et associations ;

les recettes tarifaires, payées par les usagers et usagères ;

les subventions des collectivités locales.

Les proportions de ces trois sources varient en fonction des territoires, mais le versement mobilité est souvent la source principale du financement. Les territoires denses et au réseau de transport bien structuré présentent en général des recettes tarifaires plus élevées. Aussi, si la gratuité totale des transports en commun supprime des coûts liés à la billetique (distributeurs automatiques de titres, valideurs, logiciels, application, contrôleurs, etc.), dans les grands réseaux, ces coûts sont généralement plus faibles que ce que rapportent les recettes commerciales.

Une politique totem

Si l’opposition à la gratuité totale des transports en commun est si forte, c’est que, pour beaucoup, la mesure dévaloriserait le transport. « Aucun service n’est réellement gratuit », « la gratuité n’existe pas » sont autant d’expressions révélant une valorisation d’un service par son prix.

Parler de gratuité des transports en commun est révélateur du caractère anormal de la mesure. Parlons-nous ainsi de « gratuité de la police » ? Dans un secteur plus proche, nous ne parlons pas non plus de gratuité des routes, alors que celles-ci sont très largement gratuites et que leur coût est largement supporté par les contribuables plutôt que les usagers et usagères. Comme pour les transports en commun, beaucoup d’économistes défendent pourtant une tarification de la route.

La gratuité des transports est une politique totem. Souvent intégrée à des projets de mobilités, l’intégralité des effets de la mesure demeure encore largement inconnue, tant les sens associés à la mesure sont divers. Les débats sur la gratuité des transports interrogent ainsi la légitimité d’un financement collectif renforcé des mobilités, mais aussi les cadres d’expertise à partir desquels les politiques publiques sont évaluées et jugées.

La thèse de Félicien Boiron est financée par le ministère de la Transition écologique.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Time [Fr]

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- L'Autre Quotidien

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- Gauche.Media

- CETRI

- ESSF

- Inprecor

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview