15.02.2026 à 17:02

Comment une mairie peut équilibrer son budget ?

Sébastien Bourdin, Professeur de géographie économique, IÉSEG School of Management

Texte intégral (1858 mots)

En vue des élections municipales, l’équation du budget des collectivités locales semble insoluble : l’État souhaite réduire son financement, les candidats proposent de renforcer les services publics. En parallèle, les dépenses des administrations publiques locales (APUL) explosent et la suppression de la taxe d’habitation se fait ressentir dans les communes. Alors, comment rétablir un équilibre ?

Les collectivités territoriales sont appelées à la sobriété… mais doivent être toujours plus attractives pour faire venir sur leur territoire des entreprises, des cadres et des touristes tout en maintenant les résidents sur place et éviter les délocalisations. À l’approche des élections municipales des 15 et 22 mars 2026, la tension est d’autant plus forte que les attentes locales – services publics, transition écologique, sécurité du quotidien – montent, tandis que l’État cherche à contenir la dépense publique.

Dix ans après les débats de la « réforme territoriale », l’enjeu central n’est plus seulement institutionnel, il est budgétaire et macroéconomique. En 2024, les dépenses des administrations publiques locales (APUL) atteignent 329,7 milliards d’euros, dont une augmentation de 7 % rien qu’en 2023. Structurellement, le fonctionnement pèse lourd : environ 76 % des dépenses des APUL relèvent du fonctionnement, contre 24 % pour l’investissement.

Les interrogations sur les économies budgétaires possibles sont nombreuses et les solutions ne coulent pas toujours de source. Si la nécessité d’un redressement des finances publiques ne fait plus aucun doute, il convient de s’interroger sur la manière dont il est réalisé et les conséquences qu’il a sur les collectivités.

Dépenses peu compressibles à court terme

À l’approche des municipales de mars 2026, la question budgétaire devient un sujet de campagne à part entière. Les équipes sortantes doivent montrer des résultats, tout en démontrant qu’elles savent tenir une trajectoire financière crédible.

L’enjeu est de piloter finement les charges et les priorités. En pratique, les marges se jouent moins sur des « grands soirs » institutionnels que sur quatre postes très concrets : la masse salariale, l’énergie, les achats/contrats, et le coût de la dette. Or, le cœur des budgets locaux est composé de dépenses peu compressibles à court terme – écoles, crèches, propreté, eau-déchets, action sociale, mobilités ou entretien du patrimoine –, ce qui limite les coupes rapides sans effet sur la qualité du service rendu.

Dans les communes de 3 500 habitants et plus, près de 35 € sur 100 de fonctionnement financent les services généraux, 19 € la culture/sport/jeunesse, et 17 € l’école et le périscolaire. À l’intérieur de ce dernier poste, la restauration scolaire avec 2,9 milliards d’euros, et les écoles maternelles avec deux milliards d’euros pèsent lourd, dont la dépense reste très majoritairement liée au financement du personnel.

La séquence 2022–2024 (inflation, énergie, revalorisations) a déplacé le problème. La question n’est plus seulement « où couper ? », mais « comment arbitrer » entre fonctionnement et investissement ? Ce sans dégrader les services du quotidien, tout en finançant les transitions comme la rénovation énergétique ou l’adaptation aux canicules/inondations ?

D’où un déplacement du débat municipal vers des choix de gestion très opérationnels : mutualisation ciblée, réduction des dépenses « subies » (énergie/achats), priorisation de l’investissement à impact, et transparence sur les coûts complets – maintenance, fonctionnement futur des équipements – avant de lancer de nouveaux projets.

Fonctionnement vs investissement

Trois quarts du budget correspondent au fonctionnement et le dernier quart à l’investissement. La principale difficulté : les collectivités semblent prioriser des baisses sur l’investissement plutôt que sur le fonctionnement – ce qui ne semble pas des plus stratégique si l’on pense à l’intérêt pour elles d’être toujours plus attractives.

Paradoxalement, le cycle électoral pousse aussi à « accélérer » avant le scrutin. La Cour des comptes note une forte hausse de l’investissement en 2024 à + 13,1 % entre janvier-août 2024 et janvier-août 2023, portée notamment par les communes et les intercommunalités qui cherchent à livrer des projets avant les élections.

Le risque est double : un pic d’investissement prémunicipal, puis un « trou d’air » après 2026, au moment même où les besoins de transition écologique et les besoins en services publics deviennent structurels. C’est exactement le type d’arbitrage qui, à moyen terme, affaiblit l’attractivité – mobilités, écoles, équipements, qualité urbaine – et renchérit les coûts futurs – entretien différé, vulnérabilité climatique.

Dépendance accrue à l’État central

Au cœur de l’ajustement se trouve toujours la question des ressources, et notamment des transferts de l’État. La dotation globale de fonctionnement (DGF) reste la principale dotation de fonctionnement : 27,4 milliards d’euros en 2025 en moyenne. Elle représente environ 15 % du budget des communes, 18 % de celui des établissements publics de coopération intercommunale (EPCI) et 11 % du budget des départements.

Depuis dix ans, la vraie bascule est ailleurs, avec la montée de la fiscalité « transférée » (par l’État) et de la TVA dans le panier de recettes des collectivités. Cette nouvelle donne change la nature de l’autonomie locale. En clair, une partie croissante des ressources locales ne dépend plus d’un « impôt dont on vote le taux », mais de recettes nationales « affectées », notamment des fractions de TVA. Elles sont souvent plus stables, mais beaucoup moins pilotables par les élus.

Deux réformes ont tout particulièrement reconfiguré les budgets locaux. En premier lieu, la suppression de la taxe d’habitation sur les résidences principales (effective pour tous depuis le 1er janvier 2023), qui a fait disparaître un levier fiscal très visible politiquement. En deuxième lieu, la trajectoire de suppression de la cotisation sur la valeur ajoutée des entreprises (CVAE). Son taux a été divisé par deux en 2023. Son calendrier a été de nouveau révisé ; la loi de finances pour 2025 a reporté sa suppression totale à 2030, avec une baisse progressive des taux.

À lire aussi : CVAE, Territoires d’industrie : les contradictions de la politique de réindustrialisation à la française

Conséquence : une partie décisive des recettes locales dépend désormais de la conjoncture nationale… et des arbitrages budgétaires de l’État.

Financer la transition écologique

La contrainte 2026 n’est pas seulement comptable, elle est aussi climatique. Les collectivités portent une grande partie de l’investissement public civil et des politiques concrètes liées à la transition écologique – bâtiments, mobilités, aménagement, friches, renaturation. Or leur capacité d’autofinancement est fragilisée quand le fonctionnement dérive.

De ce point de vue, la montée en puissance des subventions est devenue centrale. Le « Fonds vert » illustre cette logique. Reconduit en 2025 avec une enveloppe annoncée de 1,15 milliard d’euros, il a financé plus de 19 000 projets en 2023-2024 pour 3,6 milliards d’euros de subventions. Son niveau futur est débattu. Un rapport budgétaire du Sénat sur le projet de loi de finances (PLF) 2026 évoque une forte baisse des autorisations d’engagement à 650 millions d’euros, tout en maintenant des crédits de paiement élevés.

Les dépenses de personnel, une vraie ligne de crête

Une critique revient systématiquement : l’augmentation du personnel au sein des communes et des intercommunalités au cours des dix dernières années. Cette hausse des effectifs est la conséquence d’une décentralisation accélérée (davantage de compétences déléguées aux collectivités) et de réformes qui ont transféré des charges. En 2026, le sujet se durcit, car la masse salariale est devenue l’un des moteurs principaux du fonctionnement, tout en conditionnant la qualité du service rendu.

Les collectivités territoriales comptent deux millions d’agents et le bloc communal concentre plus d’un million de postes. L’école et la petite enfance représentent à elles seules des dizaines de milliers d’agents – près de 40 000 agents territoriaux spécialisés des écoles maternelles (Atsem), plus de 70 000 adjoints techniques des établissements d’enseignement, plus de 29 000 auxiliaires de puériculture, etc.

La hausse récente des effectifs se concentre surtout du côté des intercommunalités et de quelques filières en croissance rapide (police municipale, animation), sur fond de progression marquée des contractuels.

Couper dans les dépenses de fonctionnement n’est pas si simple si l’on veut assurer un service public de qualité… auquel les résidents sont aussi très sensibles. Trouver l’équilibre entre recettes et dépenses n’est pas chose aisée. C’est ici que des stratégies peuvent être mises en place :

Mutualiser ce qui est mutualisable : fonctions support, achats, informatique, etc.

Ajuster les effectifs en fonction des priorités de service, plutôt que de recruter poste par poste, au gré des urgences et des remplacements.

Sécuriser les contrats et les consommations : énergie, prestations, etc.

Partager l’ingénierie à l’échelle intercommunale, et généraliser une logique d’évaluation (quels dispositifs coûtent cher pour peu d’impact) avant d’ajouter de nouvelles dépenses récurrentes.

Dans le contexte de grande incertitude dans lequel le personnel est plongé actuellement, la communication et la concertation sont essentielles pour assurer une transition.

Sébastien Bourdin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

15.02.2026 à 15:32

Le mouvement anti-CPE de 2006 : la dernière grande victoire étudiante de France ?

Paolo Stuppia, Sociologue, membre du CESSP (Centre Européen de Sociologie et de Science Politique), Université Paris 1 Panthéon-Sorbonne

Texte intégral (2004 mots)

Il y a vingt ans, entre févier et avril 2006, une large mobilisation de la jeunesse étudiante et lycéenne, épaulée par les syndicats, enterrait le contrat première embauche. Alors que renaît l’idée d’un CDI résiliable pour les entrants sur le marché du travail, revenons sur cette contestation d’une ampleur sans précédent depuis 1968.

À l’heure où l’organisation patronale Medef reprend des propositions historiques de la droite pour « faciliter le recrutement de ceux qui entrent dans le monde du travail » via un nouveau CDI sous rémunéré et résiliable à tout moment, l’histoire montre les dangers que recouvre une telle démarche.

Il y a tout juste vingt ans, alors qu’était envisagée la mise en place d’un contrat première embauche (CPE), contrat précaire réservé aux jeunes de moins de 26 ans prévoyant une période d’essai de deux ans, le gouvernement avait fini par reculer sous la pression de la mobilisation des lycéens et des étudiants, rejoints dans la rue par les confédérations syndicales de salariés.

En quoi cette victoire a-t-elle été marquante dans l’histoire des mobilisations sociales ? Que dit-elle des cohésions et fractures au sein de la jeunesse et quelles traces a-t-elle laissées dans le monde politique ?

Mobilisation contre le CPE : une dynamique inégalée

En l’espace de deux mois, du 7 février au 10 avril 2006, la combinaison du blocage des trois quarts des établissements d’enseignement supérieur du pays, des actions « coup de poing » et de cinq journées nationales de manifestation réunissant jusqu’à trois millions de personnes mettait en échec une réforme emblématique. La victoire qui a suivi est restée dans les mémoires collectives comme la dernière victoire d’envergure d’un mouvement social en France.

Les effets de cette séquence demeurent toutefois plus ambivalents. Si tous les gouvernements successifs ont eu le sentiment d’avancer en terrain miné à chaque grande réforme touchant la jeunesse ou le marché de l’emploi, ni l’issue ni l’ampleur du mouvement contre le CPE n’ont été égalées depuis.

Certes, le spectre d’un « blocage généralisé » du pays a été agité à maintes reprises, de la lutte contre la « loi travail » en 2016 jusqu’à celle contre la réforme des retraites de 2023. Mais l’alliance inédite nouée dans l’intersyndicale anti-CPE entre organisations professionnelles, syndicats étudiants et coordination nationale étudiante, obtenant un recul public du gouvernement, demeure un cas rare et, à bien des égards, singulier depuis 1968.

Dans le même temps, la mobilisation anti-CPE a révélé des fractures durables au sein de la jeunesse, allant bien au-delà de l’hostilité, de l’indifférence ou du soutien aux piquets de grève lycéens et universitaires.

Le CPE, entre rendez-vous réussis et manqués

Rappelant pour certains aspects le contrat d’insertion professionnelle (CIP), déjà retiré face à une mobilisation étudiante en 1994, le contrat première embauche (CPE) est proposé dans un contexte particulier, deux mois à peine après les émeutes qui ont secoué les quartiers populaires à l’automne 2005.

Cette année 2005 a déjà été riche en rebondissements : d’abord, au printemps, un mouvement lycéen contre une réforme du baccalauréat ; puis la victoire du « Non » au référendum sur la Constitution européenne, le 29 mai, conduisant à la mise en place d’un exécutif où coexistaient malgré eux deux potentiels présidentiables pour 2007, le premier ministre Dominique de Villepin et le ministre de l’intérieur Nicolas Sarkozy. Enfin, en août, l’adoption par ordonnance du contrat nouvelle embauche (CNE), dispositif identique au CPE mais destiné aux petites entreprises, suscitant une mobilisation restée sans effet.

À l’automne, les « émeutes de banlieue » ont représenté une première épreuve politique pour le gouvernement. La stratégie d’apaisement défendue par Villepin l’a emporté sur la ligne dure de Sarkozy. Il n’en demeure pas moins qu’il faut alors répondre à la crise. C’est dans ce contexte qu’une « loi pour l’égalité des chances » (LEC), censée résorber la fracture sociale du pays, est proposée. Le CPE en constitue l’article 8.

L’adoption de la LEC débute en janvier, mais Villepin commet une faute majeure : il déclare l’urgence autour du CPE, puis recourt au 49.3, cristallisant l’opposition. Celle-ci s’exprime d’abord dans un collectif, Stop CPE, réunissant l’ensemble de la gauche et les syndicats. Il faut cependant attendre les premiers blocages universitaires, engagés de manière décentralisée et auto-organisée par des étudiants d’universités de province – Rennes 2, Toulouse-Rangueuil, Poitiers – pour qu’un véritable mouvement social émerge. Une coordination nationale étudiante d’un côté, une intersyndicale de l’autre, se mettent alors en place, prenant le relais de Stop CPE.

Contrairement à l’automne précédent, c’est donc la jeunesse scolarisée qui se présente au rendez-vous : si celui des syndicats et partis traditionnels commence à se dessiner, le rendez-vous avec la jeunesse des grands ensembles demeure largement manqué, un leitmotiv qui accompagnera l’ensemble du mouvement.

Une dynamique lente avec une accélération soudaine

C’est dans la semaine du 7 mars, au terme des vacances d’hiver, que le mouvement entre dans une séquence décisive, connaissant une accélération soudaine. Paradoxalement la mobilisation s’installe alors même que le CPE est voté, ce qui constitue, du point de vue des temporalités protestataires, une anomalie.

La journée d’action du 7 mars marque ce tournant. Rassemblant étudiants et salariés, elle est un succès quantitatif, avec près d’un million de manifestants selon les organisateurs. Dans le même temps, les blocages d’universités se multiplient, contribuant à installer un climat d’incertitude, tandis que tous les sondages confirment une opposition montante envers le CPE. Un symbole fort s’impose alors : l’occupation de la Sorbonne pendant trois jours, événement inédit depuis 1968 (à l’exclusion d’une brève parenthèse en 1986). L’idée d’une séquence exceptionnelle, voire d’une véritable crise politique et sociale, fait son chemin.

À partir de là, tout s’accélère. Les blocages de facultés se généralisent, les lycéens entrent massivement dans la mobilisation et les formes d’action se radicalisent progressivement. Les journées d’action organisées par l’intersyndicale prennent une ampleur inédite depuis les grèves de 1995, rassemblant jusqu’à trois millions de participants les 28 mars et 4 avril. Toutefois, cette massification s’accompagne de tensions. À l’issue de certains cortèges, comme celui du 23 mars, surgissent des violences attribuées aux « casseurs des banlieues », ravivant la question sensible des rapports entre la mobilisation étudiante et une partie de la jeunesse des quartiers populaires.

Parallèlement, l’intersyndicale est contrainte d’intégrer des représentants de la coordination nationale étudiante, dont l’influence ne cesse de croître. Unis, et alors que des divisions manifestes apparaissent au sein même du gouvernement (Sarkozy, se déclarant hostile au CPE, offre une porte de sortie aux contestataires tout en fragilisant Villepin), les acteurs du mouvement refusent toute négociation.

Nouveau paradoxe le 31 mars : le président de la République promulgue la LEC, validée par le Conseil constitutionnel, tout en appelant à ne pas signer de CPE. Dix jours plus tard, après une nouvelle journée de manifestations et au début des vacances universitaires de printemps, Jacques Chirac annonce le « remplacement du CPE ».

Le CPE et ses vies ultérieures

Après l’annonce du 10 avril, la plupart des organisations syndicales et étudiantes proclament la victoire, mais elles peinent à s’accorder sur les suites à donner au mouvement. Si certains appellent à une démobilisation rapide, d’autres tentent de maintenir la pression autour de la LEC et du CNE, sans grand succès.

Dernière grande manifestation, les défilés du 1er mai 2006 voient apparaître des tensions entre des étudiants organisés derrière des banderoles proclamant la victoire, à l’image du syndicat étudiant l’Unef, et la fraction la plus mobilisée, partageant un sentiment de gain symbolique mais d’échec sur le reste des revendications.

Avec le recul, ni le récit d’un succès plein et entier ni celui d’un revers ne s’imposent. D’un côté, le retrait du CPE continue d’inquiéter les gouvernements et de faire figure de modèle pour les mouvements sociaux. De l’autre, la « génération CPE » renvoie moins à une cohorte homogène qu’à une expérience politique contrastée : simple parenthèse dans la vie universitaire pour les uns, véritable vecteur de politisation ou de consolidation militante pour les autres, comme en témoignent plusieurs figures publiques contemporaines, issues tant des rangs des opposants au CPE – la secrétaire générale de la CGT Sophie Binet, les députés LFI Danièle Obono et Adrien Quatennens, plus surprenant le commissaire européen Stéphane Séjourné – que de ceux qui l’ont soutenu (Gérald Darmanin).

Reste enfin la question du « rendez-vous manqué » entre jeunesses scolarisée et populaire. Si cette lecture a été nuancée depuis par certains travaux, rappelant que nombre d’étudiants mobilisés en 2006 résidaient aussi dans les grands ensembles, les protestations récentes de la Gen Z dans plusieurs pays du Sud global montrent qu’une convergence plus large entre jeunesses, scolarisées ou non, peut produire des effets bien plus significatifs que le seul retrait d’une mesure gouvernementale.

Dans un contexte mondialisé, où l’aggravation des inégalités s’articule à la circulation et à l’imitation des répertoires d’action et des symboles contestataires, cette question demeure centrale.

Paolo Stuppia ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

15.02.2026 à 15:32

Indépendance du parquet : pourquoi une réforme est indispensable

Vincent Sizaire, Maître de conférence associé, membre du centre de droit pénal et de criminologie, Université Paris Nanterre

Texte intégral (1955 mots)

Alors que s’annoncent plusieurs procès sensibles en 2026, la question de l’indépendance de la justice revient sur le devant de la scène. Les deux plus hauts magistrats de France ont récemment fait part de leurs préoccupations vis-à-vis du climat politique et plaidé pour l’adoption de la réforme de la nomination des procureurs. Enlisé depuis plusieurs années, le projet de loi constitutionnelle, voté en 2016 par les deux chambres, vient d’être remis à l’agenda par la présidente de l’Assemblée nationale. Que permettrait réellement cette réforme si elle voyait le jour ?

Le 13 janvier 2026, la présidente de l’Assemblée nationale Yaël Braun-Pivet a officiellement proposé de relancer la procédure d’adoption de la réforme constitutionnelle modifiant les règles de nomination des procureurs de la République. Actuellement, ceux-ci sont nommés par décret du président de la République sur proposition du ministre de la justice, après un avis simple, non contraignant, du Conseil supérieur de la magistrature (CSM).

Cette réforme prévoit d’aligner partiellement les modalités de nomination des magistrats du parquet sur celles des magistrats du siège, en soumettant les choix du ministre de la justice à l’avis conforme du CSM : concrètement, cela signifie qu’un procureur ne pourrait plus être nommé sans l’accord du CSM.

Cette réforme a été adoptée en termes identiques par l’Assemblée nationale et le Sénat en 2016, mais pour être définitivement consacrée, elle doit encore être approuvée par au moins deux tiers des parlementaires réunis en Congrès, sur convocation du président de la République. Or, à ce jour, rien n’indique que ce dernier entende mettre en œuvre cette procédure ni, surtout, que le texte puisse effectivement être adopté par un Parlement dont la composition a fortement changé en dix ans : alors que la gauche y était majoritaire, les forces de droite et d’extrême droite qui n’ont jamais caché leur hostilité à une telle évolution n’ont cessé de s’y renforcer.

Une dépendance statutaire maintenue

Même adoptée, cette évolution ne constituerait qu’une victoire essentiellement symbolique. Prévoir que les procureurs ne peuvent être nommés sans avis conforme du CSM ne modifie en rien les principaux facteurs de dépendance structurelle de ces magistrats au pouvoir exécutif. Une dépendance d’abord statutaire : même s’il devait désormais se plier à l’avis du CSM s’agissant des nominations des parquetiers, le ministre de la justice demeurerait seul compétent pour prononcer à leur encontre des sanctions disciplinaires. Il demeurerait aussi seul compétent pour proposer à la nomination tel ou tel magistrat, l’intervention du Conseil n’étant requise que pour valider – ou non – la proposition faite. Par ailleurs, la réforme ne modifierait en rien la stricte subordination hiérarchique des procureurs au garde des Sceaux, laquelle se traduit en particulier par l’obligation d’exécuter les instructions générales qu’il leur adresse – une prérogative dont les ministres ne se privent guère, multipliant les circulaires de politique pénale toujours plus détaillées et comminatoires.

L’enquête au quotidien : une autonomie théorique, une dépendance pratique

Cette dépendance statutaire se double en outre d’une dépendance fonctionnelle à l’égard de l’institution policière et, partant, du pouvoir exécutif. Certes, les agents et officiers de police judiciaire sont officiellement placés sous la direction du procureur de la République dans la conduite de leurs enquêtes. Mais les services de police et de gendarmerie n’en demeurent pas moins principalement placés sous l’autorité du ministre de l’intérieur, seul compétent pour décider de leur avancement, de leurs mutations et, plus largement, de leurs conditions générales de travail. C’est en particulier le ministère qui décide, seul, de l’affectation des agents à tel ou tel service d’enquête, du nombre d’enquêteurs affectés à tel service et des moyens matériels qui leur sont alloués. Autant de facteurs qui expliquent que, depuis 2008, la Cour européenne des droits de l’homme considère que les procureurs français ne peuvent être regardés comme une autorité judiciaire indépendante.

Cette dépendance fonctionnelle est encore aggravée par la mutation profonde de l’organisation du travail qu’ont connu les magistrats du parquet au tournant du siècle. Depuis la fin des années 1990, la très grande majorité des décisions qu’ils rendent sur le déclenchement de l’action publique, c’est-à-dire sur l’opportunité de poursuivre ou non une personne devant une juridiction répressive et, le cas échéant, le choix de ses modalités (simple convocation, saisine d’un juge d’instruction, comparution immédiate…), sont prises dans l’urgence, sur la base d’un simple compte-rendu téléphonique. Cette approche promue par les autorités comme un « traitement en temps réel [sic] » des procédures a certes eu pour effet de réduire le délai de traitement des dossiers par les magistrats du parquet.

Mais, alors que ces derniers connaissent une surcharge de travail chronique consécutive à l’insuffisance des moyens qui leur sont alloués, elle les rend particulièrement dépendants du compte-rendu de chaque situation faite par l’enquêteur, dont ils n’ont que très rarement le temps de contrôler le travail fait avant de prendre leur décision. Ce mode de traitement est en outre à l’origine de la montée en puissance d’une logique productiviste au sein des tribunaux : il ne s’agit moins de donner à chaque infraction signalée la réponse adaptée que de gérer au mieux les stocks et les flux de dossiers, au risque de confondre justice et précipitation. En contribuant ainsi à la perte de sens du métier, cette évolution est enfin à l’origine d’une indéniable souffrance au travail des magistrats du parquet.

Garantir les libertés face à un pouvoir répressif : le rôle décisif du procureur

Ainsi, ces derniers sont aujourd’hui loin d’être en mesure d’exercer leurs missions en pleine indépendance. Une telle indépendance répondrait pourtant à une exigence démocratique de première importance. Comme l’ont récemment rappelé les chefs de la Cour de cassation à l’occasion de leur audience solennelle, le procureur de la République constitue le premier garant des droits et libertés des citoyens, notamment quand ces derniers sont confrontés au pouvoir répressif.

Dans un contexte politique marqué, en France et en Europe, par la montée d’un autoritarisme se traduisant notamment par la criminalisation de l’opposition politique, conférer aux procureurs un statut plus protecteur permettrait de prévenir plus efficacement le risque de répression abusive. Plus largement, si l’on veut que ce soit la loi – et non la force – qui régisse effectivement les rapports sociaux et que chacun dispose du même degré de protection juridique, il est nécessaire que le ministère public, en tant qu’autorité chargée de demander l’application de la loi au nom de l’ensemble des citoyens, puisse exercer cette mission de façon totalement indépendante et impartiale. Qu’il puisse en particulier poursuivre les personnes indépendamment de leur statut social et de leur position de pouvoir au sein de la société.

Si le parquet national financier a pu sans entrave poursuivre d’anciens chefs d’État et des figures politiques de premier plan, c’est parce qu’il avait acquis, en pratique, une réelle indépendance. Mais qu’en sera-t-il demain si, comme la loi le lui permet, le pouvoir exécutif choisit de s’immiscer dans le cours des affaires qui lui sont confiées ?

À l’image de la rhétorique du gouvernement des juges, l’opposition à l’indépendance du parquet trahit nécessairement la volonté de contrôler le cours de la Justice et, au-delà, de conserver le plus longtemps possible le relatif privilège d’impunité dont ont longtemps bénéficié les classes dirigeantes. À cet égard, il est intéressant d’observer que la réforme du corps judiciaire que le gouvernement néofasciste italien veut aujourd’hui faire adopter par referendum pour remettre en cause le statut des procureurs a pour origine profonde les grands procès ayant régulièrement mis en cause les membres de l’élite dirigeante à partir du début des années 1990. Depuis l’opération « manu pulite » ayant abouti à la condamnation de nombreux politiciens ayant des liens avec la mafia jusqu’à la poursuite de l’ancien ministre de l’intérieur Mateo Salvini pour son refus de laisser débarquer un navire ayant recueilli des réfugiés, en passant bien sûr par les nombreux procès intentés à l’ancien président du conseil Silvio Berlusconi, l’indépendance des parquetiers italiens n’a jamais cessé d’irriter celles et ceux qui considèrent que le principe d’égalité devant la loi ne devrait pas s’appliquer à ceux qui la façonnent. Et c’est précisément pour cela que l’indépendance de leurs homologues français constitue une revendication de toute personne attachée à la construction d’une démocratie pleine et entière.

Vincent Sizaire est magistrat

14.02.2026 à 10:05

Tout comprendre à la taxe foncière pour les prochaines élections municipales

Thomas Eisinger, Professeur associé en droit, gestion financière et management des collectivités, Aix-Marseille Université (AMU)

Texte intégral (2157 mots)

En vue des élections municipales, de nombreux candidates et candidats proposent de créer de nouveaux services pour leurs électeurs. Une solution évidente pour financer ces nouvelles dépenses : la taxe foncière sur les propriétés bâties, pourtant déjà en hausse de 19 % entre 2020 et 2024. Décryptage de cette taxe locale incontournable.

Cet article est une version mise à jour et enrichie d’un article publié le 13 septembre 2023 : « Hausse de la taxe foncière : vers l’infini et au-delà ? »

La campagne pour les élections municipales des 15 et 22 mars prochain bat son plein. Une chose est sûre, quel que soit le résultat des urnes, il va falloir trouver de l’argent. Les candidats de tous bords ne manquent pas d’idées qui, quels que soient leurs mérites sociaux ou économiques (c’est un autre débat), ont pour dénominateur commun de mettre sous pression les fragiles équilibres budgétaires communaux.

La gratuité de certains services publics est une proposition à la mode, que ce soit pour les transports ou pour l’école primaire – kits de rentrée, cantine scolaire. Des augmentations d’effectifs sont annoncées, de préférence pour des agents bien visibles sur le terrain comme les policiers municipaux. Il faudra bien trouver des ressources pour financer toutes ces mesures. Le volontaire tout trouvé, comme sur la précédente mandature, ce serait la taxe foncière sur les propriétés bâties, première recette fiscale de nos communes.

Mais pourra-t-elle, sur les six prochaines années, être aussi sollicitée que sur les six dernières ? Divulgachie : a priori non.

Comment est déterminée votre taxe foncière

Attention, nous ne parlerons ici que de votre seule taxe foncière sur les propriétés bâties, qui ne représente, aussi contre-intuitif que cela puisse paraître, qu’une partie de la somme à payer figurant sur la première page de votre avis d’imposition. D’autres prélèvements sont effectués avec la taxe foncière sur les propriétés bâties : la taxe d’enlèvement des ordures ménagères (à l’objet éponyme), la taxe dite GEMAPI (visant à financer la gestion des milieux aquatiques et la prévention des inondations), certaines taxes spéciales d’équipement, etc.

Concernant votre taxe foncière sur les propriétés bâties, son mode de calcul est assez simple : elle est le résultat du produit d’une assiette, en l’espèce l’estimation de la valeur de votre bien immobilier, par un taux d’imposition. La responsabilité de l’évolution annuelle de ces deux composantes est partagée.

La valeur locative cadastrale – l’estimation évoquée plus haut dans son appellation administrative – fluctue chaque année en fonction d’un indice de révision. Jusqu’à récemment (on y reviendra), ce dernier était voté par les parlementaires dans le cadre de la loi de finances. Le taux lui relève, depuis le début des années 1980, des collectivités locales récipiendaires de l’impôt (aujourd’hui, les communes et les intercommunalités), qui le votent chaque année en parallèle de l’adoption de leur budget primitif.

Hausse incontrôlée de l’assiette, à l’insu de notre plein gré

En 2025, l’indexation générale des bases de votre taxe foncière a augmenté de 1,7 %. En 2026, ce devrait être de 0,8 %. Une séquence de relative modération, qui fait suite une augmentation beaucoup plus significative – 3,4 % en 2022 et 7,1 % en 2023. Pour mémoire, la hausse annuelle était en moyenne de 1,6 % entre 2005 et 2015. La mandature 2020-2026 aura ainsi été marquée par une forte hausse de l’assiette de cet impôt.

Comment expliquer une telle augmentation, alors que l’on pourrait imaginer les députés et sénateurs soucieux de préserver le pouvoir d’achat de nos concitoyens ? Depuis le début des années 1980, ce sont bien les parlementaires qui déterminaient l’indexation annuelle de cette assiette. Officiellement, ils tenaient « compte de la variation des loyers ». En réalité, ils étaient toujours attentifs au contexte économique et social.

Dans le cadre de la loi de finances pour 2017, dans une démarche positiviste qui collait bien à l’esprit (initial) de la législature, ces mêmes parlementaires ont fait le choix d’automatiser et donc de dépolitiser cette hausse. Elle se fera désormais sur la base de l’indice des prix à la consommation. S’il était impossible à l’époque d’anticiper le retour de l’inflation que nous avons connu par la mandature 2020-2026, on peut reconnaître que les parlementaires ont été bien malheureux de renoncer à l’époque à cette prérogative (discutable certes) qui était historiquement la leur.

Entre 2020 et 2024, une hausse déjà significative du taux voté par certaines communes

On pourrait légitimement se dire que, si l’assiette augmente au niveau de l’inflation comme nous venons de le voir, le taux de la taxe foncière aurait pu justement lui rester stable. Il n’en a rien été, pour plusieurs raisons.

D’une part, parce que les autres recettes de fonctionnement des communes et de leurs intercommunalités augmentent elles bien moins vite que l’inflation. Les dotations versées par l’État, qui rappelons-le augmentaient il y a encore une quinzaine d’années du niveau de l’inflation et d’une partie de la croissance, se stabilisent après avoir connu quelques années de baisse (contribution du secteur local à la maîtrise des finances publiques).

D’autre part, parce que la taxe d’habitation a disparu, comme une décennie avant elle la taxe professionnelle. Bien qu’elle ait été compensée à l’euro près dans les budgets locaux, aucun nouveau levier fiscal n’est venu combler le vide qu’elle laissait. Résultat, quand il s’agit d’augmenter les ressources budgétaires, les exécutifs locaux ne peuvent plus mettre en œuvre de réelle stratégie fiscale (quelle catégorie de contribuables solliciter davantage cette année ?) et n’ont presque plus qu’une seule option : augmenter la taxe foncière.

Et ce ne sont là que les principales explications. Restaurer les équilibres budgétaires après quelques années de « quoi qu’il en coûte » à la sauce locale, absorber les hausses budgétaires imposées par l’État comme la hausse de la rémunération des fonctionnaires, trouver les moyens de contribuer à la transition écologique… Autant de raisons, plus ou moins légitimes, que les élus locaux ont mobilisées pour justifier la hausse des taux qu’ils ont décidé.

Certes, lorsque l'on regarde les chiffres globaux, la mandature qui s'achève ne se caractérise pas par une hausse générale et massive des taux de taxe foncière (+7 % « seulement » entre 2020 et 2024). Mais certaines des plus grandes villes de France ont effectivement fait le choix d'utiliser ce levier fiscal dans des proportions inédites et largement relayées à l'époque par le presse quotidienne régionale et nationale. Autant de marges de manoeuvre qu'il sera, sur les territoires concernés, inenvisageagbles de remobiliser après 2026.

Un levier fiscal injuste… donc en théorie moins légitime à mobiliser ?

Au-delà de l’explosion constatée sur la mandature qui s’achève de l’assiette indexée et des taux votés, la taxe foncière sur les propriétés bâties porte en elle, dans la configuration actuelle, plusieurs problématiques significatives de justice fiscale.

Un, la valeur de votre habitation n’est structurellement pas le meilleur moyen d’appréhender votre capacité contributive, vos « facultés » sur la base desquelles les impôts sont sensés être levés. S’il n’est pas illégitime d’avoir une assiette autre que les revenus pour certains impôts, cela devient plus problématique lorsque cette assiette concerne un prélèvement significatif en termes de volume. C’est le cas pour la taxe foncière aujourd’hui pour bon nombre de ménages. Selon l’Insee, la taxe foncière représente plus de 4 % du revenu disponible pour les 20 % des propriétaires aux revenus les plus modestes.

Deux, l’appréciation par l’administration de la valeur de votre habitation n’est même pas bonne. Calculée au début des années 1970, elle est aujourd’hui largement déconnectée de la réalité du marché immobilier. Malheureusement, et c’est un des paradoxes informels de la légistique fiscale, plus une situation est injuste et plus il est difficile d’y remédier. La séquence de l’automne dernier peut laisser songeur quant à notre capacité collective à réaliser un jour cet exercice de réforme.

Trois, avec la suppression de la taxe d’habitation, l’augmentation de la pression fiscale, désormais concentrée sur la taxe foncière sur les propriétés bâties, soulève une véritable question de démocratie locale. En effet, une partie des financeurs de la dynamique budgétaire communale sont les propriétaires non-résidents (non-électeurs, serait-on tentés de souligner), alors que dans le même temps les locataires (électeurs) sont eux dispensés de presque tout effort fiscal. Taxation without representation + representation without taxation : tout cela ne semble pas tenable sur le temps long.

Au regard de la double dynamique inédite de l’assiette et des taux constatés sur la mandature 2020-2026 et de ces questionnements afférents à la justice fiscale (un sujet désormais majeur dans le débat public), la modération fiscale devrait en théorie être de rigueur en 2026-2022. Elle aurait même pu être une proposition de campagne majeure. Cependant, il est peu probable que la facture ne s’alourdisse pas dans les prochaines années, au regard des ambitions affichées par les candidats de tout bord. Reste à voir ce qu’en seront les répercussions, sur les finances publiques comme (et c’est peut-être plus problématique) sur la démocratie locale.

Thomas Eisinger est administrateur de l'AFIGESE (association des financiers, contrôleurs de gestion et évaluateurs du secteur public local)

12.02.2026 à 16:12

Élections municipales : quelle place pour les femmes, les minorités et les classes populaires ? Enquête en Seine-Saint-Denis

Violette Arnoulet, Urbaniste et maître de conférences en sociologie à l'université Paris Dauphine - PSL, Université Paris Dauphine – PSL

Claudette Lafaye, Maitresse de conférence en sociologie, Université Paris 8 – Vincennes Saint-Denis

Texte intégral (2351 mots)

Dans certains départements français, dont la Seine-Saint-Denis, les mandats municipaux se sont largement ouverts aux femmes et aux personnes appartenant à une minorité visible. Mais cette évolution masque une reconfiguration du « plafond de verre », entre discriminations, exclusion des classes populaires et limitation à des postes stéréotypés.

À quelques semaines des élections municipales de mars 2026 se repose la question de la faible représentativité du personnel politique français. Dans les conseils municipaux comme à l’Assemblée nationale, la professionnalisation des élu·e·s s’accompagne de la quasi-disparition des classes populaires et du maintien d’assemblées majoritairement blanches et le plus souvent présidées par des hommes. En 2025, 21 % seulement des maires étaient des femmes et 9 % déclaraient une profession d’employé ou d’ouvrier.

Qu’en est-il en Seine-Saint-Denis, département marqué par l’histoire de la « banlieue rouge », la présence des classes populaires et d’une immigration ancienne ? Les listes candidates et les conseils municipaux sont-ils, dans ce département comme ailleurs, de plus en plus éloignés de la population qu’ils représentent ?

Pour nourrir ces réflexions, nous partageons les premiers résultats d’une enquête sur les 40 communes de ce département, menée par une équipe des universités Paris Nanterre, Paris 8 et Paris Dauphine. Cette recherche documente les évolutions des candidats et candidates aux élections municipales et celles des membres des conseils municipaux de 2001 à 2020, au prisme de la classe sociale, du genre et de l’assignation raciale. Elle analyse notamment la place en politique des personnes renvoyées à un statut social inférieur, sur la base de leur origine supposée, de leur apparence ou de leur nom. On désigne ici ces personnes comme « racisées » ou « minorités visibles ».

Une percée des femmes et des minorités racisées dans les conseils municipaux

Depuis les élections municipales de 2001, l’évolution du personnel politique en Seine-Saint-Denis suit les tendances nationales. Si l’implantation du Parti communiste français (PCF) a longtemps favorisé l’élection de conseillers municipaux et de maires ouvriers, la présence des classes populaires dans les assemblées municipales est désormais résiduelle : seuls 11 % des personnes élues en 2020 sont employées ou ouvrières, alors que ces catégories représentent 53 % de la population active du département. Comme dans le reste des communes urbaines, les conseils municipaux de Seine-Saint-Denis sont plus accessibles aux cadres (42 % des personnes élues en 2020, pour 21 % de la population active du département). Ces dynamiques sont encore plus vraies pour le mandat de maire : 25 maires sur 40 sont des cadres en 2020.

Du côté du genre, les lois sur la parité en politique ont renforcé la présence des femmes. En 2020, elles représentaient 48 % des personnes élues du département. Leur part reste néanmoins inférieure à 50 %, signe que les têtes de liste sont, ici comme ailleurs, plus souvent des hommes. Cette féminisation s’accompagne, par ailleurs, d’une forte sélection sociale des femmes élues qui, comme les hommes, sont très souvent des cadres (40 % des élues).

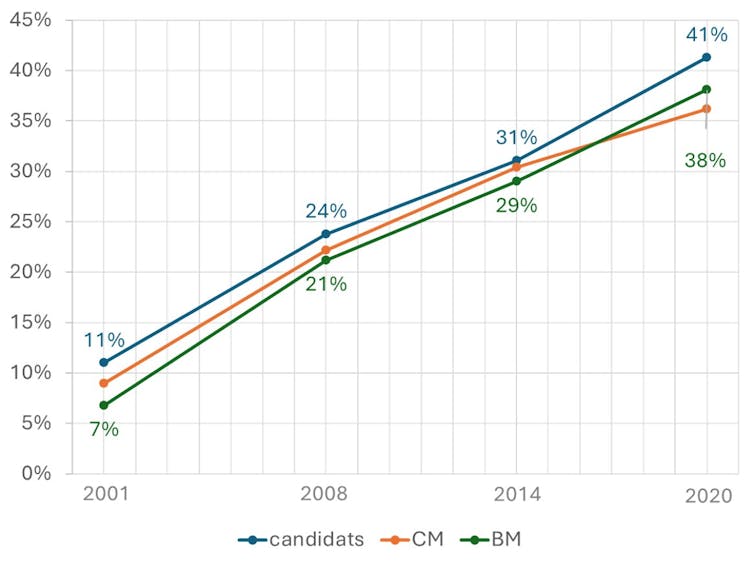

Dans ce contexte, c’est une évolution moins commentée qui a retenu notre attention. Depuis 2001, la présence de personnes appartenant aux minorités visibles se renforce dans les conseils municipaux du département. Les élections de 2008 qui suivent les révoltes urbaines de 2005 marquent un tournant : la part des personnes racisées double sur les listes candidates et augmente fortement dans les conseils municipaux. Elle triple même au sein des bureaux municipaux (composés d’un·e maire et de ses adjoint·es) qui concentrent la réalité du pouvoir communal.

En 2020, les personnes racisées représentent désormais plus du tiers (36,2 %) des membres des conseils municipaux, améliorant ainsi la représentation politique de la population du département.

Comme pour les femmes, cette ouverture bénéficie surtout aux classes moyennes et supérieures : 5 des 7 maires racisés élus en 2020 sont des cadres ou des chefs d’entreprise, et aucun n’est ouvrier ou employé. Néanmoins, beaucoup d’élu·es racisé·es sont des enfants ou des petits enfants d’immigré·es de milieu populaire qui ont connu une ascension sociale. Au sein des conseils municipaux, cette trajectoire les distingue des autres élu·e·s, de même que leur jeunesse (19 % ont moins de 30 ans en 2020).

Figure : La part des personnes racisées parmi les candidat·es aux élections municipales, les élu·es des conseils municipaux et des bureaux municipaux est en progression constante depuis les élections de 2008

Dans les communes de Seine-Saint-Denis, représentation des classes populaires et diversité de genre ou ethnoraciale ne vont ainsi pas de pair. Au contraire, l’entrée de femmes et de personnes racisées dans les conseils municipaux s’accommode du renforcement de la sélection sociale, aboutissant à l’invisibilisation des classes populaires. Peut-on pour autant conclure de cette avancée relative que le racisme et le sexisme auraient disparu en politique ?

Le « plafond de verre » n’a pas disparu, il s’est reconfiguré

Premier constat, les femmes et les personnes racisées continuent à faire face à des obstacles dans l’accès aux responsabilités. C’est pour le mandat de maire que le « plafond de verre » résiste le mieux, en particulier pour les femmes. Dans les 40 communes du département, seules 5 femmes sont élues maires en 2020, sans amélioration vis-à-vis des scrutins précédents.

Pour les personnes racisées, ce plafond de verre, longtemps impénétrable, commence à se fissurer. En 2014, Stains est la première ville de Seine-Saint-Denis à élire un descendant de l’immigration algérienne en la personne d’Azzedine Taïbi. En 2020, c’est le cas de six autres communes, ce qui porte à sept le nombre de maires racisés. Deux femmes racisées accèdent également à cette fonction en cours de mandat en 2016 et 2022, à la faveur de la démission du maire en place. La première n’est pas reconduite aux élections suivantes et la seconde a depuis rétrocédé sa place à son prédécesseur.

Au-delà des limitations imposées à leurs ambitions, les personnes racisées comme les femmes font face à des inégalités dans la répartition des rôles au sein des conseils municipaux, qui tendent à reconduire des stéréotypes genrés ou racialisés. Ainsi, les femmes sont souvent en charge des affaires sociales, de l’enfance ou des familles, et les personnes racisées se voient confier la lutte contre les discriminations ou la jeunesse, surtout en début de carrière.

Cette situation est in fine particulièrement défavorable pour les femmes racisées, largement évincées des délégations clés – finances de la commune, urbanisme et aménagement – généralement confiées aux premiers adjoints ou adjointes du maire. Dans ce contexte, elles sont nombreuses à exprimer en entretien le sentiment d’être considérées comme des « décorations » ou des « cautions féminines ».

Un engagement politique marqué par l’expérience des inégalités

Second constat, les limitations imposées aux ambitions des femmes et des personnes racisées ne sont que l’un des aspects des discriminations rencontrées par ces dernières en politique. Si l’importance du sexisme est désormais connue, le racisme exerce aussi une influence sur les parcours en politique. Il peut nourrir un désir de s’engager comme freiner l’accès à la candidature et favoriser l’usure au cours du mandat.

Les personnes racisées témoignent d’abord souvent du rôle joué par l’expérience des discriminations dans leur politisation et leur désir d’engagement. Certaines ont fait de l’amélioration de la représentation des habitants et habitantes des quartiers populaires un enjeu de campagne, en s’engageant sur des listes citoyennes, portées par des militantes et militants associatifs. On a pu voir ce type de liste dans des villes comme Aubervilliers ou le Blanc-Mesnil, aux élections de 2008, 2014 et 2020.

D’autres, plus nombreuses, ont été renvoyées à leurs origines supposées ou à leur appartenance à une minorité visible au cours de leur mandat, parfois de façon positive. À Gagny, par exemple, l’élection du maire Rolin Cranoly en 2019 a été saluée par la presse antillaise, conduisant cet édile à prendre conscience du caractère symbolique de son parcours. Le plus souvent cependant, ces assignations relèvent du racisme ordinaire, comme en témoigne en entretien une adjointe d’une commune de gauche :

« Ah, c’est subtil, c’est très subtil. Au début, on doute en disant : “C’est pas possible.” On écorche votre nom, puis on vous demande de le répéter ; quand vous dites une phrase, on vous demande de la répéter deux ou trois fois ; on vient vous demander si vous faites le ramadan. »

Enfin, certains sont la cible d’attaques virulentes, comme Azzedine Taïbi, maire de Stains depuis 2014 : des militants d’extrême droite ont cherché à s’introduire dans la mairie après la dénonciation publique par l’édile d’injures racistes et de menaces de mort proférées à son encontre.

À l’approche des élections municipales de mars 2026, des initiatives s’emparent de ces questions. Les militants et militantes de l’Assemblée des quartiers ont obtenu l’ouverture de certaines listes de gauche à des candidatures issues des quartiers populaires. Le collectif Démocratiser la politique défend quant à lui l’institution d’une parité sociale en politique pour remédier à l’exclusion des classes populaires.

Ces enjeux sont particulièrement vifs en Seine-Saint-Denis, où de nombreuses villes verront s’affronter des listes menées par des femmes et des personnes racisées. Alors que pour les classes populaires, le défi est plus que jamais celui de l’accès à la représentation politique locale, les femmes et les personnes racisées sont désormais face à la tâche difficile de politiser l’expérience du plafond de verre et des discriminations, pour transformer le jeu politique local.

Cet article s’appuie sur une recherche conduite par Marie-Hélène Bacqué, Jeanne Demoulin, Claudette Lafaye, Hélène Haztfeld, Violette Arnoulet et Yasmina Dris. Elle a donné lieu à l’écriture d’un livre : Élus des banlieues populaires, « La vie des idées », Presses universitaires de France, 2026.

J'ai travaillé 6 ans pour l'établissement public territorial Plaine Commune de 2014 à 2019 en tant qu'urbaniste. J'étais chargée de mission au sein de la direction de la rénovation urbaine sur les projets de Stains. J'ai ensuite consacré ma thèse (soutenue en 2023) à la commune de Stains.

Claudette Lafaye ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

11.02.2026 à 16:26

La grande démission citoyenne : 59 % des Français ne soutiennent aucun parti politique

Vincent Tiberj, Professeur des universités, délégué recherche de Sciences Po Bordeaux, Sciences Po Bordeaux

Texte intégral (2261 mots)

Les partis politiques sont de moins en moins soutenus – aucun ne dépasse 10 % de soutien –, et les citoyens « sans parti » ont atteint le nombre inédit de 60 %. Les débats continuent à s’organiser autour des partis politiques comme si de rien n’était, mais les fondements de notre démocratie « représentative » sont en péril.

Nous vivons une étrange période politique. La coalition qui gouverne n’est pas celle qui est sortie victorieuse des élections de 2024. Les débats continuent à s’organiser autour des figures et partis politiques comme si de rien n’était. La perspective de la présidentielle est dans les têtes et elle est préparée activement dans les cercles partisans. Pourtant, les niveaux de défiance n’ont jamais été aussi forts en France et la classe politique est devenue un des sujets majeurs de préoccupations des répondants aux sondages. La « grande démission civique » aboutit à ce que de plus en plus de citoyens se détournent des urnes et des partis pour faire politique autrement.

Ici, je me focalise sur un aspect particulier de cette grande démission, celui qui interroge les liens entre citoyens et partis. Dans les routines de pensée sondagières, il y a cette habitude de continuer à analyser les réponses en fonction de la proximité partisane. Cette approche est doublement trompeuse : elle laisse supposer que les partis sont encore soutenus alors que leurs racines populaires sont de plus en plus ténues, et elle sort de l’analyse tous les démissionnaires, faisant comme si, parce qu’ils n’ont pas de parti proche, ils n’auraient pas de préférences. On va voir que ces « sans-parti » ne sont pas n’importe qui et que leur nombre grandissant oblige à penser différemment notre démocratie.

L’érosion du lien positif aux partis

Figure 1 : lien et absence de proximité partisane en France (1999-2023)

Les « sans-parti », dans la version stricte de l’ESS ou élargie des enquêtes françaises sont déjà nombreux dès le début du XXIᵉ siècle : en 2002-2016, on comptait entre 45 % et 51 % pour l’ESS tandis que, dans le baromètre CNCDH, on a assisté à une progression des sans-parti de 30 % en 1999 à 44 % en 2010, puis à une baisse après la présidentielle de 2012 (25 %) avant qu’ils ne remontent à 34 % en 2016. De plus, les noyaux durs partisans, ces répondants qui se disent « très ou assez proches » d’une formation peinent à dépasser le tiers des répondants. Ceci dénote déjà l’ampleur de l’insatisfaction d’un nombre conséquent de citoyens français face à l’ensemble des partis qui se disputent leurs suffrages.

On aurait pu penser qu’il s’agissait là de l’épuisement des « vieux » partis Union pour un mouvement populaire (UMP) et Parti socialiste (PS), avant l’émergence d’Emmanuel Macron. Pourtant 2017 n’a pas changé la donne : entre 2016 et 2020, les sans-parti dans l’ESS passent de 51 % à 59 % tandis que les noyaux durs partisans ont reculé jusqu’à 23 % en 2020. Dans les enquêtes CNCDH, on a atteint 45 % en 2018 et 42 % en 2019. Surtout, cette faiblesse des partis se confirme après 2022. Pour se rendre compte de l’érosion des partis dans l’électorat, analysons en détail les proximités partisanes.

Figure 2 : le détail des proximités partisanes

Certaines évolutions sont les échos de moments politiques particuliers, notamment les victoires électorales : l’UMP en 2008, La République en marche (LREM) en 2018, après la victoire d’Emmanuel Macron. La décennie 2000 est marquée par la domination du duo PS/UMP. On parlait alors d’un « bipartisme à la française », selon l’expression de Gérard Grunberg et Florence Haegel.

En 2008, le troisième parti, le Mouvement démocratique (MoDem), rassemble quatre fois moins de soutiens que le PS (16 %) et l’UMP (17 %). Pourtant, même cumulés, les soutiens de ces deux partis ne pesaient qu’un peu plus d’un tiers des répondants.

Le mandat de François Hollande (2012-2017) voit reculer ces deux partis traditionnels : le PS passe de 16 % en 2012 à 7 % en 2018, et l’UMP (transformée en LR en 2015) de 14 % à 7 %. Cette érosion des partis de l’« ancien monde » ne s’est pas traduite pour autant par la montée en puissance des partis du « nouveau monde ». Le Rassemblement national (RN, ex-FN) ne séduit au mieux que 8 % des répondants en 2014. Quant au mouvement macroniste, il atteint 10 % de soutien en 2018, mais 8,5 % en 2020, soit guère mieux que le PS, Les Républicains (LR, ex-UMP) ou Europe Écologie-Les Verts (EELV) qui recueillent entre 6 % et 7 %. Quant à La France insoumise (LFI), elle reste largement en dessous des 5 %.

La vague post-2022 confirme la faiblesse numérique des partis français : le RN revient à son niveau de 2014, devant le parti macroniste (6 %), mais les Verts, le PS, LFI et LR comptent environ 5 % des suffrages chacun.

Dans la France des années 2020, on peut résumer ainsi la situation : la proportion des sans-parti n’a jamais été aussi forte, et l’on assiste à un fractionnement partisan sans précédent puisqu’aucun parti ne domine nettement. Surtout, la faiblesse numérique des soutiens pour chaque parti ne peut qu’interroger quand on la met en miroir d’un mode de scrutin qui favorise le fait majoritaire. Les présidents obtiennent bien une majorité de suffrages, mais leur parti peine à dépasser les 10 % de soutien, tout comme les finalistes du second tour. Cela doit nous interroger.

Les logiques sociales et générationnelles du recul partisan

Figure 3. Les évolutions des sans-parti selon le diplôme, la profession et les générations

Longtemps l’absence de lien partisan était signe d’incompétence politique. De fait la difficulté à prendre parti est plus fréquente chez les citoyens ordinaires tandis que les citoyens sophistiqués sont à la fois connaissants (ils sont informés du champ et des acteurs politiques) et « appétents » (ils sont intéressés). Mais cette explication ne suffit plus.

Certes, les apartisans sont plus nombreux parmi les moins diplômés, les catégories populaires (ici, les travailleurs qualifiés et non qualifiés) et les plus jeunes, ce qui va dans le sens d’une lecture privilégiant l’incompétence politique. Mais, dès le début de la période étudiée, parmi les groupes socialement les plus favorisés, la part des sans-parti est loin d’être négligeable. En 2004, les membres de la génération 1961-1980 ont entre 23 et 44 ans et comptent beaucoup plus de diplômés du supérieur que les générations précédentes, et pourtant 54 % d’entre eux ne se sentent proches d’aucun parti.

À partir du milieu des années 2010, l’augmentation des sans-parti vient démontrer qu’il se passe beaucoup plus qu’un simple effet de compétence politique. Entre 2012 et 2020, leur proportion gagne + 11 points parmi les plus diplômés, + 7 points dans la génération 1940-1960, + 7 points parmi la service class qualifiée (managers et cadres).

Les niveaux de sans-parti sont particulièrement importants dans les catégories populaires (en 2020, 62 % chez les travailleurs qualifiés et 70 % chez les non qualifiés, au-delà de 60 % chez ceux qui ont moins de 16 ans d’études), mais aussi chez les post-baby-boomers (59 %) et les millennials (68 %). Il reste des citoyens alignés, mais ils sont de moins en moins représentatifs de l’ensemble des Français.

La négativisation du lien partisan

Voter « pour » était évident, mais c’est le vote négatif (Catt, 1996) qui prend de plus en plus de place. Une tendance qui permet de comprendre pourquoi choisir un bulletin est de moins en moins synonyme de soutien et de plus en plus un choix faute de mieux.

Pour cela, on dispose depuis longtemps de questions qui mesurent la probabilité de voter pour différents partis, de 0 (exclut totalement de voter pour ce parti) à 10 (sûr de voter pour ce parti). Elles permettent de distinguer les ennemis (qui obtiennent la note de 0) des adversaires (notes de 1 à 4, voire 5) et des partenaires (notes supérieures à 5). Par ailleurs, on peut aussi mesurer les « supporters » (notes de 8 à 10).

Figure 4 : Les probabilités de vote pour les différents partis français en 2012 et en 2023

Les probabilités de vote mesurées en 2012 rendent compte d’un monde politique où il y avait certes de la négativité mais contenue. Seul le FN suscitait un rejet absolu chez plus de 40 % des répondants. Le second parti le plus rejeté était le Front de gauche (dont est issu LFI) avec environ 20 %. Du côté du lien positif au parti, quatre organisations recueillaient plus de 30 % de notes supérieures à 5 sur 10, le Front de gauche (30 %), le PS (31 %), les écologistes (53 %) et l’UMP (31 %).

La négativisation du rapport à l’offre politique est un phénomène majeur dans la France d’après 2022. Les partis considérés comme les plus à gauche et les plus à droite suscitent plus de rejet, 47 % des répondants donnent une note de 0 à LFI, 46 % font de même pour le RN et 69 % pour Reconquête d’Éric Zemmour. Cette négativité dépasse largement la part des électeurs qui ont des chances de voter pour ces mêmes partis. LFI compte 8 % de soutien fort (notes supérieures à 8), le RN 13 %, et le parti zemmouriste 2 %. Si l’on rajoute les notes 6 et 7, soit des préférences plus faibles, on atteint 14 %, 18 % et 4 %.

Mais le rejet et surtout la difficulté à fédérer des soutiens positifs touchent désormais l’ensemble de l’offre politique. EELV suscite 29 % de notes nulles, LR et LREM autour de 36 %, le PS et EELV autour de 30 %. Ce rejet est très différent de 2012. Tous ces partis entrent au mieux dans la catégorie des adversaires pour nombre de répondants. Politiquement, cela équivaut à ce qu’une victoire à la présidentielle de chacun des quatre plus importants partis se fasse « par défaut », dans une logique d’élimination du pire par rapport au moins pire.

Une situation dangereuse

La France se trouve dans une situation inédite et potentiellement dangereuse. D’un côté, les institutions fonctionnent et les partis politiques y opèrent. Mais de l’autre, ils le font avec des racines de plus en plus fragiles et de moins en moins représentatives de la société, en particulier en ce qui concerne les classes populaires et les nouvelles générations. On pourrait dire que les absents, les non-partisans, ont tort, mais c’est oublier qu’ils ont des préférences et des revendications spécifiques, et que l’offre politique française n’est pas en mesure d’y répondre. Plus grave encore, ont-elles l’intention de le faire ?

En 2024, les grands perdants des élections législatives ont été LR et les macronistes et pourtant ils gouvernent. Les partis peuvent faire comme d’habitude, mais c’est agir comme si ces citoyennes et ces citoyens qui se détournent des partis ne comptaient pour rien. D’ailleurs, il n’y a pas que les partis qui sont touchés. Il en va de même de l’éloignement des urnes d’une fraction croissante de l’électorat potentiel.

Tenir pour négligeable cette « grande démission citoyenne » met sous tension les équilibres politiques et notre modèle démocratique. C’est faire comme si les apartisans ou les abstentionnistes n’avaient pas d’opinions et de préférences ou faire comme si ceux qui restent alignés étaient représentatifs. C’est de moins en moins le cas et dans le cadre d’une démocratie qui reste centrée sur les élus, c’est nourrir la distance et le rejet d’un nombre de plus en plus important de Français.

Cet article est tiré de l’ouvrage French Democracy in Distress. Challenges and Opportunities in French Politics (Palgrave Macmillan, 2025), sous la direction d’Élodie Druez, Frédéric Gonthier, Camille Kelbel, Nonna Mayer, Felix-Christopher von Nostitz et Vincent Tiberj.

Vincent Tiberj ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.02.2026 à 16:51

Tout sauf l’Ehpad ? Les ambiguïtés de la politique du grand âge

Dominique Argoud, Professeur des Universités en sociologie, Université Paris-Est Créteil Val de Marne (UPEC)

Texte intégral (2011 mots)

En France, les établissements d’hébergement pour personnes âgées dépendantes (Ehpad) font figure de repoussoirs. En 2001, 53 % des Français déclaraient en ne pas souhaiter vivre dans un établissement pour personnes âgées dans le futur, ce pourcentage s’élève aujourd’hui à 74 %. Les pouvoirs publics cherchent à promouvoir d’autres formes d’hébergement moins médicalisées. Est-ce une bonne approche ?

Les établissements d’hébergement pour personnes âgées dépendantes (Ehpad) constituent aujourd’hui le mode dominant d’accueil pour les personnes âgées ne pouvant pas rester à leur domicile. Fin 2023, sur les 700 000 personnes fréquentant un établissement d’hébergement pour personnes âgées, près de 80 % vivent en Ehpad. Compte tenu du vieillissement démographique, si les pratiques d’entrée en institution restent inchangées, il faudra ouvrir 108 000 places en Ehpad d’ici à 2030, puis 211 000 places entre 2030 et 2050. Cela reviendrait à un peu plus que doubler, dans la durée, le rythme d’ouverture de places observé depuis 2012.

Or, une telle projection se heurte à l’image dégradée dont bénéficient les Ehpad en France. Ceux-ci font office de repoussoir pour un grand nombre de personnes âgées et de familles, encore plus depuis l’affaire Orpea et la parution du livre Les fossoyeurs du journaliste Victor Castanet. La crainte de perdre sa liberté en établissement d’hébergement, voire d’être maltraité, conduit à plébisciter le maintien à domicile pour ses vieux jours. Ainsi, selon le baromètre de la DREES, alors que 53 % des Français déclaraient en 2001 de ne pas souhaiter vivre dans un établissement pour personnes âgées dans le futur, ce pourcentage s’élève aujourd’hui à 74 %. 44 % des Français feraient en sorte de s’occuper de son parent âgé à son domicile, 21 % seraient prêts à l’accueillir chez eux et 16 % les soutiendraient financièrement afin qu’il puisse bénéficier d’aides à domicile. Entre 2014 et 2023, la proportion de personnes qui privilégient de s’occuper de leur proche à son domicile a augmenté de presque 20 points, passant de 25 % en 2014 à 44 % en 2023.

Une politique domiciliaire en panne

Dans ce contexte, quelles sont les orientations de la politique vieillesse ? Depuis quelques années, l’État s’engage à promouvoir une approche domiciliaire pour tenir compte des réticences croissantes manifestées à l’égard des institutions d’hébergement. Cette approche est confortée par les projections des attentes des nouvelles générations de personnes âgées, qui correspondront aux baby-boomers (nés entre 1946 et 1964) atteignant le grand âge au cours des prochaines décennies. Ainsi, il est attendu que ces nouvelles générations soient plus enclines à vouloir préserver leur pleine et entière citoyenneté et à moins dépendre de décisions leur échappant.

Schématiquement, la politique domiciliaire engagée par l’État se structure autour de deux axes. Le premier consiste à renforcer les capacités du domicile pour que les gens puissent s’y maintenir plus nombreux et dans de bonnes conditions. Le second axe vise à transformer le fonctionnement des Ehpad pour qu’ils deviennent des lieux de vie ouverts sur la cité et où les résidents puissent y être « comme chez eux ». En réalité, cette politique relativement consensuelle se situe dans le prolongement des orientations antérieures. Mais de sérieux doutes ont été émis par l’Inspection générale des affaires sociales quant à la capacité de l’État à la mettre réellement en œuvre. Le coût budgétaire de la politique domiciliaire de même que la faible attractivité des métiers du grand âge en constituent autant de freins.

Une volonté politique d’encourager les habitats intermédiaires

D’un côté, l’Ehpad comme mode d’hébergement des personnes âgées n’a plus le vent en poupe, et de l’autre, le maintien à domicile des personnes en perte d’autonomie présente des limites. C’est pourquoi, pour mettre en œuvre l’approche domiciliaire, les pouvoirs publics misent fortement sur le développement de « l’habitat intermédiaire ».

Par habitat intermédiaire, il faut entendre toutes les formes d’habitat qui se situent entre le domicile historique et les établissements proposant un hébergement collectif. La Caisse nationale de solidarité pour l’autonomie (CNSA) estime qu’il y aurait aujourd’hui 275 000 places en habitat intermédiaire (résidences autonomie, résidences services seniors, habitats inclusifs, accueil familial, résidences intergénérationnelles…). Compte tenu des besoins liés au vieillissement de la population, elle projette la nécessité de créer 500 000 solutions de logement en habitat intermédiaire d’ici 2050.

La justification de cette incitation publique en faveur de l’habitat intermédiaire est qu’il s’agit d’une formule qui répond au souhait des personnes de vivre chez elles sans êtres seules, tout en préservant leur intimité et leur liberté de choix.

Une autre de ses caractéristiques est que le public visé est plutôt constitué de personnes ayant une perte d’autonomie modérée, dont l’isolement ou les problèmes de santé les inciteraient à rejoindre un cadre de vie plus sécurisant. De fait, l’habitat intermédiaire apparaît comme une formule aux antipodes de l’Ehpad. Ce dernier accueille en effet des personnes plus dépendantes et représente un coût plus important pour les finances publiques compte tenu de la présence de personnels soignants.

Les Ehpad condamnés à faire figure de repoussoir

Cette politique en faveur de l’habitat intermédiaire contient un implicite : demain, encore plus qu’aujourd’hui, les Ehpad auront vocation à accueillir les personnes âgées très dépendantes. Malgré toute l’énergie que mettent les directions d’Ehpad pour ouvrir leurs établissements sur la vie de la cité, l’image repoussoir risque de se renforcer : la moitié des résidents en Ehpad a plus de 88 ans et 85 % sont en perte d’autonomie (classés en GIR 1 à 4) ; 38 % sont atteint d’une maladie neurodégénérative, soit 4 points de plus qu’en 2019. Parallèlement, le nombre de personnes autonomes qui intègrent un établissement a encore reculé en l’espace de quatre ans.

Pourtant, cette évolution n’est pas inéluctable. Les Ehpad ont toujours accueilli des personnes en situation de perte d’autonomie modérée. En effet, l’entrée en établissement d’hébergement ne résulte pas d’un processus linéaire qui rendrait le maintien à domicile impossible à partir d’un certain seuil de dépendance. De multiples facteurs entrent en ligne de compte dans ce processus, mêlant tant des éléments subjectifs (la perception individuelle de la situation) que des éléments objectifs comme la qualité de son cadre de vie ou la présence d’aidants mobilisables pour intervenir à domicile.

Une approche alternative aurait été possible

En favorisant le développement d’un habitat intermédiaire, quoi qu’il s’en défende, l’État contribue à segmenter l’offre en fonction du degré de dépendance. Toute catégorisation qui se veut positive tend à produire son contraire, à savoir une catégorie qui concentre les éléments négatifs. Que va-t-il advenir des personnes dont l’état de santé ne permettra plus de rester en habitat intermédiaire si ce dernier est amené à se développer ?

Un modèle alternatif était pourtant possible. Il a été défendu à partir des années 1980 par la Fondation de France qui encourageait la création de « lieux de vie jusqu’à la mort ». Contre l’idée de segmentation, il s’agissait de promouvoir des petites unités de vie, bien insérées dans le tissu social local, où les personnes auraient pu être accompagnées par des services d’aide et de soins à domicile jusqu’à la fin de leur vie. Ces structures, de petite taille, reposaient sur un mode de vie et d’accompagnement familial, prenant le contre-pied des grands établissements hospitaliers et médicalisés.

À la différence de beaucoup d’habitats intermédiaires actuels, leur ambition était de pouvoir accompagner jusqu’au bout des personnes âgées en perte d’autonomie. C’est sur ce modèle que se sont développées ces dernières années, par exemple, des colocations accueillant des personnes atteintes de la maladie d’Alzheimer.

Mais, pour l’essentiel, cette option a peu été soutenue par les pouvoirs publics et beaucoup d’opérateurs sont restés prisonniers de cadres organisationnels et économiques favorables à la réalisation d’économies d’échelle, aboutissant à la constitution de lieux de relégation. Dans les faits, il s’est avéré plus aisé de produire une offre segmentée avec, d’un côté, des Ehpad ou des unités spécialisées hébergeant des personnes très dépendantes et, de l’autre, des habitats intermédiaires accueillant une population fragilisée mais encore peu dépendante. Ce processus de segmentation s’est opéré avec l’assentiment des élus locaux soucieux de proposer une offre non stigmatisée sur leur territoire, qui est elle-même valorisée par les familles.

Il n’est toutefois pas certain que le mot d’ordre « tout sauf l’Ehpad » contribue à rendre la société plus inclusive pour faire face au vieillissement de la population. Alors que les lieux de vie visent à accompagner l’ensemble des « gens du coin » dans leur vieillissement, le paysage gérontologique tend au contraire à spécialiser les réponses d’hébergement, enfermant un peu plus la figure du « vieux dépendant » dans son rôle de repoussoir.

Dominique Argoud ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

10.02.2026 à 12:22

Pourquoi l’obésité progresse-t-elle depuis trente ans ?

Arnaud Alessandrin, Sociologue, Université de Bordeaux

Thibault Bossy, Maître de conférences en sociologie, Université de Bordeaux

Texte intégral (1894 mots)

Le ministère de la santé vient de lancer sa feuille de route 2026-2030 pour la prise en charge des personnes en situation d’obésité. Ce cadre stratégique invite à questionner un paradoxe : l’État a déployé dès 2001 un ensemble d’actions autour de l’activité physique et la nutrition en vue de réduire la prévalence de cette maladie, et, pourtant, celle-ci augmente régulièrement depuis une trentaine d’années.

L’obésité est une maladie dont les causes et conséquences sont désormais bien documentées par la littérature médicale comme sociologique. Sa prévalence n’a cessé d’augmenter depuis les années 1990 dans le monde. La France ne fait pas exception. De 8,5 % en 1997, la population adulte en situation d’obésité est passée à 15 % en 2012, puis à 17 % en 2020. Des écarts importants existent entre les personnes suivant leur âge, leur sexe, leur région, leur niveau d’éducation et leur catégorie socioprofessionnelle.

Ces données épidémiologiques et sanitaires ont participé à une prise de conscience (certes, partielle) des pouvoirs publics quant à la nécessité d’agir. Mais les politiques publiques menées contre l’obésité en France sont inefficaces. Comment l’expliquer ? Quelles stratégies sont mises à l’œuvre par les lobbies pour contrer les mesures ? Et comment concilier lutte contre l’obésité et lutte contre la grossophobie ? Faisons le point.

Les années 1990, ou la prise de conscience du lien entre alimentation et santé

La reconnaissance de l’obésité comme une « épidémie » par l’Organisation mondiale de la santé (OMS) en 1997 incite les autorités sanitaires nationales à se saisir de cet enjeu.

En France, il faut attendre la fin des années 1990 pour voir le ministère de la santé s’intéresser à la question. Plusieurs dynamiques politiques et sociales se croisent alors. Le débat sur la « malbouffe » s’impose dans l’espace médiatique à cette période, notamment après le démontage d’un restaurant d’une célèbre chaîne de fast-food à Millau en 1999.

Il s’insère dans une séquence plus large de préoccupations sur le lien entre santé et alimentation, amorcée dès le début de la décennie avec les épisodes liés au variant de la maladie de Creutzfeldt-Jakob, surnommé « maladie de la vache folle ».

Un plan national nutrition santé depuis 2001

Pour que les différentes dynamiques se combinent, il faudra néanmoins attendre l’apparition d’une « fenêtre d’opportunité politique » en 2000.

Le gouvernement cherche alors des thèmes à proposer à ses partenaires européens, en vue de sa présidence de l’Union européenne en 2001. Le ministère de la santé suggère celui de la nutrition santé, et en profite pour lancer un plan national, le Plan national nutrition santé (PNNS). Cette mise à l’agenda discrète, à la croisée de préoccupations nutritionnelles, sanitaires et politiques, constitue sans doute la première inscription de l’obésité comme problème de santé publique en France. La version actuelle du PNNS se décline en dix mesures phares présentées sur le site MangerBouger.

Avec notamment des recommandations en direction des professionnels et du grand public, le PNNS a pour objectif d’améliorer l’état de santé de la population en agissant sur la nutrition, qui est l’un de ses déterminants majeurs. Le plan vise à réduire la prévalence de l’obésité chez les adultes – le même objectif de réduction sera intégré à la loi 2004-806 du 9 août 2004 relative à la politique de santé publique, sans que des moyens supplémentaires soient adoptés.

À lire aussi : Lutte contre l’obésité : deux nouvelles mesures efficaces

Plan obésité, taxe soda et autres mesures

« Problème fluide » par excellence, l’obésité fera l’objet après 2001 de nouvelles inscriptions régulières à l’agenda, sans que cet intérêt entraîne de diminution de la prévalence. Elle fera de nouveau l’objet d’une attention politique et sociale à travers les débats parlementaires sur la loi de santé publique de 2004 et ceux entourant les messages sanitaires dans les publicités alimentaires en 2007.

D’autres mesures seront prises, parmi lesquelles :

la mise en place d’un plan obésité en 2010 (pour améliorer la prise en charge),

le développement d’initiatives locales (villes-santé, santé-environnement, etc.), par exemple ici, dans les Hauts-de-France, et de plans autour de l’activité physique ou encore

Mais le poids des lobbies, et la complexité des actions à mener pour réduire la prévalence de l’obésité en font un problème insoluble – en tout cas sans changements sociaux structurels.

Alors, plus de vingt ans après le lancement du premier PNNS, le constat est sans appel : la prévalence de l’obésité continue de croître. Cet échec relatif s’explique par plusieurs facteurs structurels.

Une approche trop centrée sur la responsabilité individuelle

Tout d’abord, les politiques publiques françaises ont adopté une approche essentiellement comportementale, centrée sur la responsabilité individuelle : mieux manger, bouger davantage, équilibrer son alimentation.

Ce cadrage moral et sanitaire tend à négliger les déterminants sociaux de la santé, alors que les études montrent que l’obésité touche davantage les classes populaires, les femmes et les habitants de certaines régions. En ciblant les comportements sans agir sur les conditions de vie – précarité, urbanisme, accès à des aliments de qualité –, ces politiques ne font qu’effleurer les causes profondes du phénomène.

Ensuite, les politiques de lutte contre l’obésité se caractérisent par une forte dispersion institutionnelle (ministère de la santé, de l’éducation nationale, de la ville…). Les mesures se succèdent sans continuité, souvent diluées dans des programmes plus larges (nutrition, prévention, activité physique). L’obésité n’apparaît que comme un sous-thème, rarement comme une priorité politique autonome. Cette dilution empêche la mise en place d’une stratégie nationale cohérente et dotée de moyens pérennes.

Le poids de l’agro-industrie

Enfin, le poids des industries agroalimentaires constitue un frein structurel à l’effectivité des politiques nutritionnelles. Dotées de ressources économiques, juridiques et communicationnelles considérables, ces industries développent des stratégies d’influence visant à affaiblir, retarder ou contourner les mesures de santé publique adoptées par les pouvoirs publics.