ACCÈS LIBRE Une Politique International Environnement Technologies Culture

26.10.2025 à 09:00

Médecine, transports, technologies numériques… Et si on arrêtait d’inventer de nouveaux matériaux ?

Mathilde Laurent-Brocq, Docteure - chercheuse en science des matériaux, Université Paris-Est Créteil Val de Marne (UPEC); Centre national de la recherche scientifique (CNRS)

Texte intégral (3198 mots)

Développer des matériaux nouveaux semble toujours nécessaire pour répondre à des besoins urgents en médecine ou dans le registre de la transition écologique. Pourtant, l’extraction des matières premières nécessaires à leur fabrication et leur mauvaise capacité de recyclage engendrent des impacts environnementaux très lourds. Comment résoudre ce dilemme ?

« L’un des pires scandales sanitaires depuis des décennies », « une famille de 10 000 polluants éternels », « la France empoisonnée à perpétuité », « la pollution sans fin des PFAS » : voilà ce que titrait la presse à propos des PFAS, acronyme anglais de per- and polyfluoroalkyl substances. Il est loin le temps où ces nouveaux composés chimiques étaient admirés et développés pour leurs nombreuses propriétés : antiadhésifs, ignifuges, antitaches, imperméabilisants… Aujourd’hui, c’est plutôt leur toxicité qui inquiète. Cela nous rappelle évidemment l’histoire de l’amiante, un très bon isolant, mais qui s’est révélé hautement toxique. Face à ces scandales à répétition, la question se pose : et si on arrêtait d’inventer de nouveaux matériaux ?

Mais tout d’abord, qu’est-ce qu’un matériau ? C’est une matière que nous utilisons pour fabriquer des objets. Scientifiquement, un matériau est caractérisé par une composition chimique (la concentration en atomes de fer, de silicium, de carbone, d’azote, de fluor…) et une microstructure (l’organisation de ces atomes à toutes les échelles). Ces deux caractéristiques déterminent les propriétés du matériau – mécaniques, électriques, magnétiques, esthétiques… – qui guideront le choix de l’utiliser dans un objet en particulier. Après avoir exploité les matériaux d’origine naturelle, nous avons conçu et produit de très nombreux matériaux artificiels, de plus en plus performants et sophistiqués. Bien sûr, personne ne souhaite revenir à l’âge de fer, mais a-t-on encore besoin de continuer cette course folle ?

D’autant que l’impact sur la santé n’est pas le seul inconvénient des nouveaux matériaux. Ces derniers requièrent souvent des matières premières ayant un impact environnemental majeur. Prenons l’exemple des fameuses terres rares, tels que l’erbium ou le dysprosium, omniprésents dans les aimants des éoliennes ou dans les écrans des appareils électroniques. Leur concentration dans les gisements varie de 1 % à 10 %, à comparer aux plus de 60 % des mines brésiliennes de fer.

On extrait donc énormément de roches pour obtenir une maigre quantité de terres rares. Il reste encore à traiter le minerai, à en séparer les terres rares, ce qui est coûteux en énergie, en eau et en produits chimiques. Donnons aussi l’exemple du titane, étoile montante de l’aéronautique et du secteur biomédical. La transformation de son minerai émet environ 30 tonnes de CO₂ par tonne de titane produite, soit 15 fois plus que pour le minerai de fer.

Des composés si complexes qu’on ne peut pas les recycler

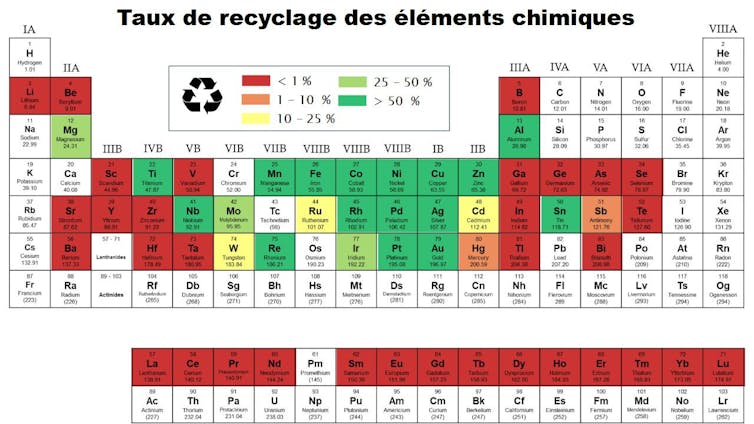

Autre inconvénient des nouveaux matériaux : leur recyclage est peu performant, voire inexistant, du fait de leurs compositions chimiques complexes. Par exemple, la quatrième génération de superalliages, utilisés dans les moteurs d’avion, contient au moins 10 éléments chimiques différents. Un smartphone en contient facilement une trentaine. Il existe une très grande variété de ces nouveaux matériaux. On dénombre 600 alliages d’aluminium classés dans 17 familles et une centaine de plastiques durs largement utilisés dans l’industrie, bien plus en comptant les nombreux additifs qui y sont incorporés.

Alors, imaginez nos petits atomes de dysprosium perdus à l’échelle atomique dans un aimant, lui-même imbriqué à d’autres matériaux du moteur de l’éolienne, le tout enseveli sous une montagne de déchets en tous genres. Il existe des techniques capables de trier puis de séparer ces éléments, mais elles font encore l’objet de nombreuses recherches. En attendant, plus d’une trentaine d’éléments chimiques ont un taux de recyclage inférieur à 1 %, autant dire nul.

Nous aurons pourtant besoin de nouveaux matériaux

Mais, au moins, est-ce que cela vaut la peine de produire et de (trop peu) recycler à grands frais environnementaux ces matériaux ? Laissons de côté les applications gadget et inutiles, tels que les écrans pliables, pour nous concentrer sur la transition énergétique.

Le déploiement des véhicules électriques et des énergies renouvelables semble indissociable du développement des matériaux qui les constitueront. Pour l’énergie nucléaire produite dans les réacteurs de quatrième génération ou par l’ambitieux projet de fusion nucléaire, les matériaux sont même le principal verrou technologique.

Ces nouveaux matériaux tiendront-ils leurs promesses ? Engendreront-ils un bénéfice global pour la société et pour l’environnement ? Le passé nous montre que c’est loin d’être évident.

Prenons l’exemple de l’allègement des matériaux de structure, mené pendant des dizaines d’années, avec l’objectif final (et louable) de réduire la consommation en carburant des véhicules. Ce fut un grand succès scientifique. Néanmoins le poids des voitures n’a cessé d’augmenter, les nouvelles fonctionnalités annulant les gains de l’allègement. C’est ce que l’on appelle l’« effet rebond », phénomène qui se manifeste malheureusement très souvent dès qu’une avancée permet des économies d’énergie et/ou de matériau.

À lire aussi : L'effet rebond : quand la surconsommation annule les efforts de sobriété

J’ai participé à l’organisation d’une session du Tribunal pour les générations futures (TGF), une conférence-spectacle qui reprend la mise en scène d’un procès pour discuter de grands enjeux de société. La question était « Faut-il encore inventer des matériaux ? » Plusieurs témoins ont été appelés à la barre : des chercheurs en science des matériaux, mais aussi un responsable d’un centre de recherche et développement (R&D) et une autrice de science-fiction. Après les avoir écoutés, les jurés ont répondu « Oui » à une large majorité.

Personnellement, malgré toute la conscience des effets délétères que je vous ai présentés, je pense également que cela reste nécessaire, car nous ne pouvons pas priver les générations futures des découvertes à venir. Actuellement, des laboratoires travaillent sur des matériaux qui permettraient de purifier l’air intérieur ou d’administrer des médicaments de manière ciblée.

Évidemment que nous souhaitons donner leur chance à ces nouveaux matériaux ! Sans parler des découvertes dont nous n’avons aucune idée aujourd’hui et qui ouvriront de nouvelles perspectives. De plus, nous ne souhaitons pas entraver notre soif de connaissances. Étudier un nouveau matériau, c’est comme explorer des galeries souterraines et chercher à comprendre comment elles se sont formées.

Dès la conception, prendre en compte les impacts environnementaux

Alors oui, continuons à inventer des matériaux, mais faisons-le autrement. Commençons par questionner les objectifs de nos recherches : pour remplir quels objectifs ? Qui tire profit de ces recherches ? Quelle science pour quelle société ?

Ces questions, pourtant anciennes, sont peu familières des chercheurs en sciences des matériaux. La science participative, par exemple grâce à des consultations citoyennes ou en impliquant des citoyens dans la collecte de données, permet de créer des interactions avec la société.

Cette démarche se développe en sciences naturelles où des citoyens peuvent compter la présence d’une espèce sur un territoire. Des collectifs citoyens espèrent même intervenir dans les discussions concernant les budgets et les objectifs des programmes de recherche. En science des matériaux, de telles démarches n’ont pas encore émergé, probablement limitées par le recours fréquent à des équipements expérimentaux complexes et coûteux ou à des simulations numériques non moins complexes.

Ensuite, éliminons dès le départ les applications néfastes et intégrons les enjeux environnementaux dès le début d’un projet de développement d’un matériau. Appliquons la démarche d’écoconception, qui a été définie pour les produits et les services. Évaluons les émissions de gaz à effet de serre, mais aussi la consommation de ressources, la pollution ou encore la perte de biodiversité qui seront induites par la production, l’utilisation et la fin de vie d’un matériau. Pour un nouveau matériau, la plupart de ces informations n’existeront pas et devront donc être mesurées en laboratoire puis extrapolées. C’est un défi en soi et, pour le relever, une unité d’appui et de recherche (UAR) baptisée Unité transdisciplinaire d’orientation et de prospective des impacts environnementaux de la recherche en ingénierie (Utopii), regroupant le CNRS ainsi que plusieurs universités et écoles d’ingénieur, vient d’être créée.

Et dans les nombreux cas de matériaux à l’impact environnemental néfaste, mais aux performances très prometteuses, que faire ? Les superalliages, dont la liste des composants est longue comme le bras, n’ont pas été développés par un irréductible ennemi du recyclage, mais parce que leur tenue à haute température est bien plus intéressante que leurs prédécesseurs. C’est le choix cornélien actuel de nombreux matériaux : performance, parfois au profit de la transition énergétique, ou respect de l’environnement.

Changer notre façon de faire

Pour sortir de cette impasse, un changement de point de vue s’impose. Et si, comme le propose le chercheur en biologie Olivier Hamant, on s’inspirait du vivant pour basculer de la performance vers la robustesse ?

La performance, c’est atteindre à court terme un objectif très précis : une bonne stratégie dans un monde stable aux ressources abondantes. La robustesse au contraire, c’est la capacité de s’adapter aux fluctuations, grâce à de la polyvalence, de la redondance, de la diversité.

Dans notre monde aux aléas croissants, la robustesse est très probablement préférable. Alors, comment l’appliquer aux nouveaux matériaux ? En créant des matériaux réparables, au moins en partie, qui supportent les contaminations du recyclage, ou bien qui s’adaptent à plusieurs applications ? Il semble que tout reste à inventer.

Mathilde Laurent-Brocq a reçu des financements du CNRS et de l'Université Paris Est Créteil.

23.10.2025 à 16:17

Les virus, ces messagers invisibles de la conversation du vivant

Armand Namekong Fokeng, Doctorant en biologie cellulaire et épidémiologie, Université de Corse Pascal-Paoli

Texte intégral (1856 mots)

Bien que les virus n’aient ni cerveau ni langage, leur circulation entre tiques, animaux et humains dans un environnement donné pourrait se lire comme un flux d’informations qui modifierait à jamais des comportements et qui façonnerait notre évolution.

La plupart des animaux ont un mode de communication évident : les cris d’alarme des suricates alertent au danger, les danses des abeilles signalent le nectar, les infrasons des éléphants permettent le maintien de la cohésion des groupes. Ainsi, c’est un nouveau message codé qui circule chaque fois et qui est ensuite interprété pour induire une action collective. Imaginez alors un instant, des virus qui parlent… pas un langage sonore ni gestuel, mais une conversation génétique, gravée dans des molécules (ADN, ARN) qui traversent les espèces en modifiant les corps.

Pour faire simple, un virus n’est qu’un morceau d’information génétique. Dénué de toute autonomie propre, il n’a de vie qu’à travers les cellules hôtes qu’il infecte. Le code génétique du virus est lu et exécuté comme un programme. En conséquence, la cellule cesse ses activités nobles (respiration, reproduction, réparation, etc.) et devient une usine à virus.

Cependant, le message viral n’est presque jamais stable. En effet, la fidélité est limitée dans la réplication des virus à ARN, tels que celui de la fièvre hémorragique de Crimée-Congo (CCHFV) sur lequel porte mon projet de thèse.

Chaque nouvelle infection draine avec elle une nuée de variants génétiques, appelés « quasi-espèces ». L’information virale est donc en perpétuelle réécriture pour s’adapter aux environnements et aux hôtes. Parfois, elle s’inscrit dans la mémoire profonde des organismes ayant été en contact avec le virus.

On sait, actuellement, qu’environ 8 % du génome humain provient de séquences virales anciennes parmi lesquelles certaines ont été intégrées à nos fonctions vitales. À titre d’exemple, la protéine syncytine, issue d’un rétrovirus, est indispensable à la formation du placenta chez les mammifères.

Les virus sont-ils toujours des intrus nuisibles ? Eh bien non ! Ils peuvent se présenter comme des créateurs invisibles de notre histoire génétique.

Une communication sans intention

Un virus est sans voix et ne choisit pas ses mots. Cependant, son interaction avec la cellule rappelle un échange de signaux.

En effet, dans le processus de l’infection, il doit reconnaître un récepteur spécifique sur la membrane de la cellule hôte : c’est la clé moléculaire qui lui ouvre la porte. Un exemple assez connu est celui du virus de l’immunodéficience humaine (VIH) qui cible les lymphocytes T, en exploitant la très célèbre molécule CD4 à laquelle il se lie, et utilise les corécepteurs CCR5 ou CXCR4 pour infecter la cellule.

En réponse, l’organisme infecté met en place une véritable conversation immunitaire entretenue par de nombreux messagers chimiques : cytokines, interférons, fièvre, etc. Ces derniers modifient le comportement des cellules et, parfois, de l’individu lui-même.

À l’échelle sociale, l’infection induit des réactions telles que l’isolement, les soins, les nouvelles pratiques de prévention, etc. Ainsi, sans aucune intention, le virus modifie pourtant les relations collectives.

Virus de la fièvre hémorragique de Crimée-Congo : un connecteur écologique

Le virus de la fièvre hémorragique de Crimée-Congo est une parfaite illustration de cette logique. En effet, il circule dans un réseau où chaque espèce joue un rôle.

En ce sens, les tiques du genre Hyalomma sont à la fois vecteurs et réservoirs. Leur salive est riche en molécules immunomodulatrices, un cocktail de protéines ou de peptides (lipocalines, serpines, évasines, etc.) qui, en neutralisant les défenses immunitaires locales de l’hôte, préparent discrètement la transmission du virus.

Une fois infectés par les tiques, les mammifères domestiques (bovins, ovins, caprins), en tant qu’amplificateurs silencieux, hébergent le virus sans symptômes.

Chez l’humain, le scénario est différent. Ici, l’infection peut entraîner des fièvres hémorragiques potentiellement mortelles (de 10 % à 30 %) en cas d’apparition de symptômes. On estime de 10 000 à 15 000 cas environ, le nombre annuel de nouvelles infections à CCHFV. Ces dernières conduisent à environ 500 décès, soit une létalité moyenne globale d’environ 3-5 %.

En ce qui concerne la France, aucun cas humain symptomatique n’a été rapporté à ce jour. Cependant, des preuves d’une circulation virale dans le sang des animaux hôtes et dans les tiques vectrices prélevées dans ce pays ont été documentées. Bien qu’ayant un risque humain relativement faible pour le moment, la France est située au carrefour de plusieurs zones endémiques (la Turquie, les Balkans, l’Asie, l’Afrique).

À travers son cycle de transmission viral, le CCHV se présente comme un fil invisible qui relie tiques, animaux et humains. C’est un véritable message moléculaire qui circule, traverse les corps et remodèle les dynamiques écologiques et sociales.

Les devenirs d’un message viral

Il importe également de souligner qu’une fois dans la cellule, un virus a un destin riche en opportunités. Il peut ainsi être neutralisé par les défenses immunitaires ou se répliquer jusqu’à consumer entièrement son hôte.

Certains virus ont une présence latente et choisissent de rester silencieux ou endormis dans le génome ou le noyau. Cependant, dès que les conditions sont favorables (stress ou immunodépression), ils se réactivent et causent des dommages.

D’autres s’intègrent durablement dans le génome, modifiant ainsi la biologie de la cellule. Ainsi, ils peuvent dans certains cas activer des oncogènes et conduire à certains cancers, tels que celui du col de l’utérus pour le papillomavirus, ou simplement déclencher des dérèglements immunitaires qui débouchent sur l’expression de certaines maladies auto-immunes. Mais, dans certains cas, les virus passent inaperçus et disparaissent en silence.

La médecine, un nouvel interlocuteur moléculaire

Quand il faut barrer la voie aux virus, on s’attaque à leurs signaux moléculaires. Les antiviraux sont des brouilleurs de signal dans ce dialogue moléculaire.

Ainsi, certains empêchent l’entrée du virus, d’autres inhibent la copie de son génome : c’est le cas du favipiravir, par exemple, qui inhibe la polymérase des virus à ARN. Ce médicament est traditionnellement utilisé contre les pandémies grippales.

D’autres traitements agissent comme amplificateurs. C’est le cas des interférons, qui administrés comme médicament, renforcent l’expression des cellules et leur permettent d’alerter leurs voisines.

Ce jeu demeure toutefois dynamique. Face aux pressions thérapeutiques toujours plus nombreuses, les virus mutent en de nouveaux variants, enrichissant ainsi leur « vocabulaire moléculaire ». Le VIH en constitue un bel exemple ; en effet, il a rapidement développé des résistances aux premiers traitements en mutant. Ainsi, la médecine et la pharmacopée deviennent elles-mêmes des acteurs involontaires de cette conversation évolutive.

Et si l’on élargissait notre vision de la vie, en classant les virus parmi les acteurs de la communication ? Ainsi, la communication ne se limiterait plus seulement aux cris des animaux et aux paroles ou gestes d’humains. Elle pourrait également être inscrite dans la circulation d’informations génétiques entre les espèces.

De ce fait, les virus cesseraient d’être uniquement des ennemis pour devenir aussi, et surtout, des agents de mise en réseau, qui relient les tiques, les animaux et les humains. Ce faisant, ils laisseraient des traces dans nos génomes et modifieraient nos comportements sociaux en cas d’épidémie.

Vue sous cet angle, chaque infection virale deviendrait une conversation biologique, un échange franc où virus, cellules et écosystèmes négocieraient chacun leur position. De la simple chorégraphie d’une abeille au passage d’un virus dans un troupeau, le vivant deviendrait une immense polyphonie de messages.

Loin d’être un simple agent pathogène, le virus apparaît comme une voix invisible de la grande conversation du vivant.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Armand Namekong Fokeng ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

21.10.2025 à 15:05

Créer des ovules humains à partir de la peau : vers une nouvelle fertilité ?

Jean-François Bodart, Professeur des Universités, en Biologie Cellulaire et Biologie du Développement, Université de Lille

Texte intégral (2035 mots)

L’absence d’ovocytes fonctionnels constitue une cause fréquente d’infertilité féminine. Une solution pourrait-elle être de créer des ovules à partir d’autres cellules ? Il faudra d’abord répondre à de nombreuses questions techniques et éthiques.

Créer des ovules humains à partir de simples cellules de peau est le défi scientifique qui vient d’être relevé pour la première fois chez l’humain. Ce type de méthode avait déjà été testée avec succès chez des animaux comme les souris. Les chercheurs de l’Oregon Health and Science University ont publié ces résultats dans la revue Nature Communications.

Les cellules de peau sont couramment utilisées dans ces approches, car leur prélèvement est simple, peu invasif et sûr pour les donneurs, tout en permettant une culture aisée en laboratoire. Malgré le succès expérimental, très peu des ovocytes fécondés ont atteint le stade d’embryons précoces (quelques jours de croissance) et avec des défauts génétiques importants, empêchant tout développement.

Cette preuve de faisabilité ouvre des perspectives prometteuses pour des couples stériles mais soulève de nombreuses questions éthiques : encadrement législatif, définition du consentement, protection de l’embryon et gouvernance de ces technologies.

L’infertilité liée à la perte fonctionnelle des ovaires

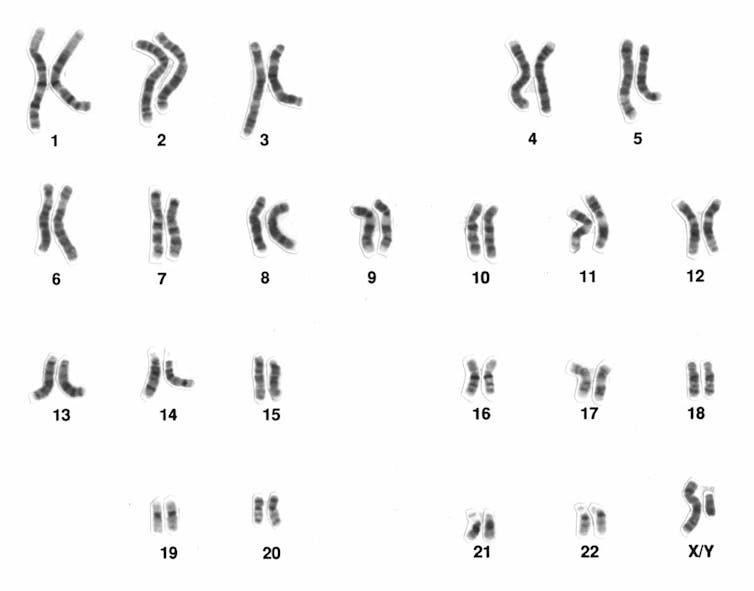

La reproduction sexuée repose sur la rencontre et la fusion de gamètes. Un gamète est une cellule sexuelle : chez la femme, il s’agit de l’ovocyte produit dans les ovaires ; chez l’homme, du spermatozoïde, produit dans les testicules. Les gamètes contiennent la moitié du patrimoine génétique de l’individu – on dit qu’ils sont « haploïdes » –, et leur fusion lors de la fécondation forme la première cellule de l’embryon, qui est diploïde et qui contient la totalité des 46 chromosomes organisés par paire.

L’absence d’ovocytes fonctionnels constitue une cause fréquente d’infertilité féminine. Cette situation concerne notamment les femmes atteintes d’insuffisance ovarienne prématurée, celles dont les ovaires ont été endommagés ou retirés par chirurgie, celles présentant des troubles hormonaux graves qui perturbent la maturation des ovocytes ainsi que des patientes ayant subi une chimiothérapie ou une radiothérapie, pouvant entraîner une stérilité irréversible. Parmi les cas les plus courants figurent aussi le syndrome des ovaires polykystiques (SOPK). D’autres maladies génétiques, comme le syndrome de Turner, empêchent également la production d’ovocytes.

Pour ces femmes privées de gamètes, les solutions actuelles restent limitées : la fécondation in vitro classique n’est envisageable qu’avec un don d’ovocytes, ce qui exclut tout lien génétique direct avec l’enfant. Les nouvelles technologies de procréation assistée fondées sur la création d’ovocytes à partir de cellules non sexuelles offrent, à terme, l’espoir inédit de restaurer la fertilité avec un patrimoine génétique propre à la patiente.

Comment des cellules de peau peuvent-elles devenir des ovocytes ?

La première étape de la génération d’ovocytes humains débute par le prélèvement de cellules de peau chez un donneur. Ces cellules, qui ne font pas partie de la lignée germinale, contiennent tout le patrimoine génétique de la personne. Outre leur prélèvement simple, peu invasif, ces cellules de peau sont ensuite sélectionnées alors qu’elles sont en « pause », c’est-à-dire avant qu’elles commencent à se diviser. Cette condition expérimentale est importante, qui évite une duplication des chromosomes de et facilite le contrôle du contenu d’ADN. Après isolement, le noyau d’une cellule cutanée est extrait afin de servir de donneur de matériel génétique. Ce noyau est ensuite transféré (injecté) dans un ovocyte de donneuse, dont le propre noyau a été retiré en laboratoire – il s’agit de la technique du transfert nucléaire.

L’ovocyte ainsi modifié porte alors la totalité des chromosomes (46) de la cellule de peau, mais il n’est pas encore apte à la fécondation : il doit posséder seulement 23 chromosomes pour être considéré comme « haploïde » et fonctionner comme un gamète. Afin de réaliser cette étape, les chercheurs utilisent une technique très récente appelée « mitoméiose ». La cellule est artificiellement « conduite » à éliminer la moitié de ses chromosomes, en simulant une division équivalente à la méiose, processus naturel de production des gamètes. Cette approche permettrait d’obtenir une cellule haploïde, présentant les caractéristiques essentielles d’un ovocyte prêt à être fécondé par un spermatozoïde.

Les résultats de cette étude soulignent que cette étape est encore source de nombreuses anomalies chromosomiques : défaut de ségrégation, chromosomes en trop (trisomies) ou en moins (monosomies). La grande majorité des ovocytes artificiels ainsi obtenus ne sont pas viables.

Ces ovocytes artificiels fécondés ont-ils produit des embryons viables ?

Dans cette étude, 82 ovocytes artificiels ont été produits par transfert nucléaire et mitoméiose, puis fécondés par l’injection de spermatozoïde à l’intérieur de l’ovocyte. La grande majorité des embryons n’a pas progressé au-delà du stade de 4 à 8 cellules. Parmi ces ovocytes fécondés, seulement environ 9 % ont atteint le stade du sixième jour du développement embryonnaire, mais dont la viabilité et la compatibilité avec une future implantation restent à démontrer. Tous présentaient cependant des anomalies majeures dont des défauts de ségrégation chromosomique ayant entraîné des aneuploïdies, c’est-à-dire des déséquilibres dans le nombre de chromosomes.

Ces anomalies sont aggravées par l’absence de recombinaison génétique normalement assurée lors d’une méiose naturelle, ce qui compromet le développement embryonnaire. En effet, lors de la reproduction humaine, la recombinaison génétique pendant la méiose permet des échanges de fragments d’ADN des chromosomes paternels et maternels, offrant à chaque enfant un patrimoine génétique unique, ce qui favorise la diversité et la santé des individus. Malgré un taux limité de fécondation et quelques embryons atteignant un stade avancé, les anomalies génétiques constatées empêchent donc à ce jour la production d’embryons viables à partir d’ovocytes synthétiques humains.

D’inévitables questions éthiques

L’utilisation expérimentale de ces ovocytes artificiels issus de cellules somatiques soulève des interrogations qu’il est nécessaire d’anticiper avant toute application clinique et qui doivent faire l’objet d’évaluations complémentaires. À ce jour, aucun pays n’autorise l’application clinique des gamètes artificiels.

En matière de consentement, il est nécessaire de définir qui contrôle l’usage des cellules somatiques utilisées pour produire des gamètes et quels sont les droits des enfants issus de ces techniques, notamment concernant leur accès à l’information sur leurs origines génétiques.

La sécurité et la santé des enfants représentent un autre enjeu fondamental. Les risques épigénétiques et génomiques liés à ces gamètes de synthèse sont encore mal connus. Il existe notamment une possibilité d’altérations de l’empreinte génétique : un mécanisme où certains gènes ne s’expriment que s’ils viennent du père ou de la mère. Ce dernier est crucial pour le développement normal, car un défaut de cette empreinte peut provoquer des maladies génétiques.

Les gamètes artificiels humains, comme les embryons humains de synthèse, posent des problèmes inédits, même si les régimes légaux de ces derniers sont différents. Le recours à ces nouvelles méthodes pourrait conduire à une multiplication d’embryons créés pour la recherche ou la validation technique.

En France, la loi de bioéthique interdit la création d’embryons à des fins de recherche : la recherche ne peut porter que sur des embryons conçus in vitro dans le cadre d’une assistance médicale à la procréation, qui ne font plus l’objet d’un projet parental, et dans le respect d’un cadre réglementaire strict (autorisation, pertinence scientifique, finalité médicale ou amélioration des connaissances, interdiction de culture au-delà de quatorze jours).

Entre promesses et vigilance

Ces méthodes ouvrent des perspectives pour offrir des possibilités thérapeutiques à la perte fonctionnelle des ovaires, mais aussi des opportunités de comprendre les toutes premières étapes du développement humain et d’explorer la réparation ou la création de tissus humains pour d’autres usages médicaux, au-delà de la reproduction. Chaque innovation scientifique relative au domaine de l’embryon humain ou de la reproduction doit conduire à de nouvelles exigences sur un encadrement juridique strict, une réflexion collective et une gouvernance transparente pour garantir le respect des droits des personnes et des principes fondamentaux des droits humains.

Jean-François Bodart ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

20.10.2025 à 15:59

Des parasites découverts chez les vers plats envahissants, enfin une piste de lutte ?

Jean-Lou Justine, Professeur, UMR ISYEB (Institut de Systématique, Évolution, Biodiversité), Muséum national d’histoire naturelle (MNHN)

Archie K. Murchie, Agricultural entomologist, Agri Food and Biosciences Institute

Leigh Winsor, Adjunct Senior Research Fellow, James Cook University

Romain Gastineau, Professeur assistant (Institut des sciences de la mer et de l'environnement), University of Szczecin

Texte intégral (2514 mots)

Les vers plats terrestres (ou, plathelminthes) causent d’importants dégâts écologiques en France, car ces espèces n’ont pas de prédateurs dans l’Hexagone. La découverte très récente de parasites va-t-elle permettre de lutter contre ces espèces ?

Depuis une dizaine d’années, nous étudions l’invasion de la France et de l’Europe par des vers plats terrestres (ou, plathelminthes). Ces animaux exotiques, généralement longs comme le doigt, sont arrivés en Europe par l’intermédiaire du transport des plantes en pots. Une dizaine d’espèces sont maintenant chez nous, venant principalement de l’hémisphère Sud (Argentine, Australie, Nouvelle-Guinée, Asie du Sud-Est). Elles se sont largement installées dans les jardins, en particulier Obama nungara, désormais présent dans plus de 70 départements. D’autres sont aussi connues du public, comme Bipalium kewense, qui peut atteindre une trentaine de centimètres, ou Vermiviatum covidum.

Quand une espèce envahit un écosystème, elle provoque souvent toute une série de problèmes écologiques. Les plathelminthes terrestres sont des prédateurs, et on sait qu’ils consomment (en particulier dans le cas d’Obama nungara) les vers de terre, ces précieux alliés du jardinier pour la fertilité des sols.

À lire aussi : L’invasion des vers plats est loin d’être terminée

La fameuse théorie du « relâchement de la pression des ennemis »

Et là, se pose la question, comment lutter contre ces envahisseurs ? Aucun produit chimique n’étant homologué ni même testé, oublions immédiatement cette solution. Des prédateurs qui mangeraient ces vers ? On n’en connaît pas en Europe. Des parasites qui pourraient limiter leur prolifération ? Inconnus aussi.

Les scientifiques qui étudient les invasions considèrent généralement qu’une espèce envahissante abandonne derrière elle prédateurs et parasites en arrivant dans un nouveau territoire, ce qui supprime tout frein à sa prolifération : c’est la théorie du « relâchement de la pression des ennemis ». C’est bien le cas des plathelminthes terrestres en France et en Europe.

La découverte de parasites

Nous avons sursauté quand nous avons trouvé les premières traces de parasites dans des plathelminthes terrestres envahissants. Mais, comme vous allez le lire, cette découverte n’a pas été aussi facile qu’on pourrait l’imaginer.

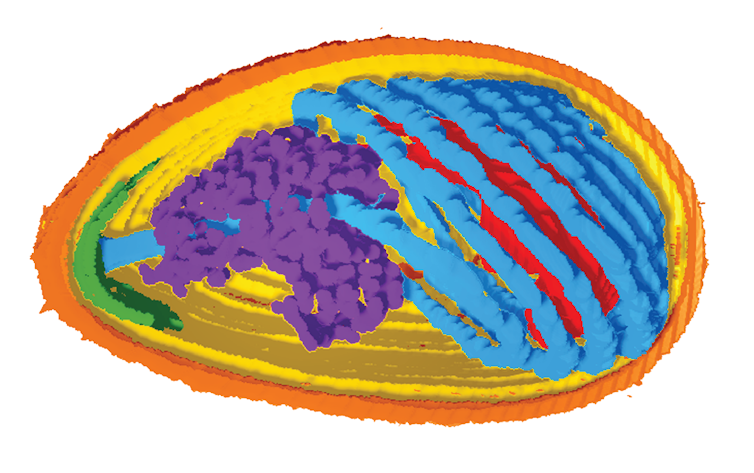

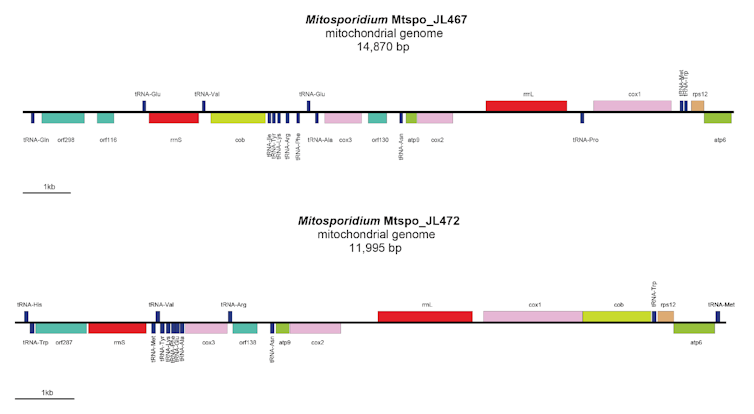

Nous n’avons pas vu ces parasites. Comment, alors, ont-ils été découverts ? Nous faisons, depuis plusieurs années, une analyse moléculaire des plathelminthes terrestres. En particulier, nous avons décrit, non pas le génome entier, ce qui serait très long et coûteux, mais le génome mitochondrial de plus d’une dizaine d’espèces.

Le génome mitochondrial, ou mitogénome, est celui qui permet aux mitochondries, ces petits éléments présents dans toutes les cellules, de fonctionner. Chez les plathelminthes, les organes sont noyés dans un tissu mou appelé parenchyme. Ainsi, lorsqu’on analyse un individu, on obtient non seulement son propre ADN, mais aussi celui de ses proies présentes dans l’intestin. Cela permet de mieux comprendre leur régime alimentaire en identifiant les espèces consommées.

Nous voilà donc faisant une analyse de routine sur deux espèces trouvées en Irlande du Nord, Kontikia andersoni et Australoplana sanguinea. Ces deux espèces viennent d’Australie et de Nouvelle-Zélande et ont envahi les îles Britanniques, mais pas (encore) l’Europe continentale. Les analyses ont rapidement permis de caractériser les mitogénomes des plathelminthes et de déterminer leurs proies, qui sont, dans les deux cas, des vers de terre. Mais une surprise nous attendait.

Des mitogénomes de parasites ?

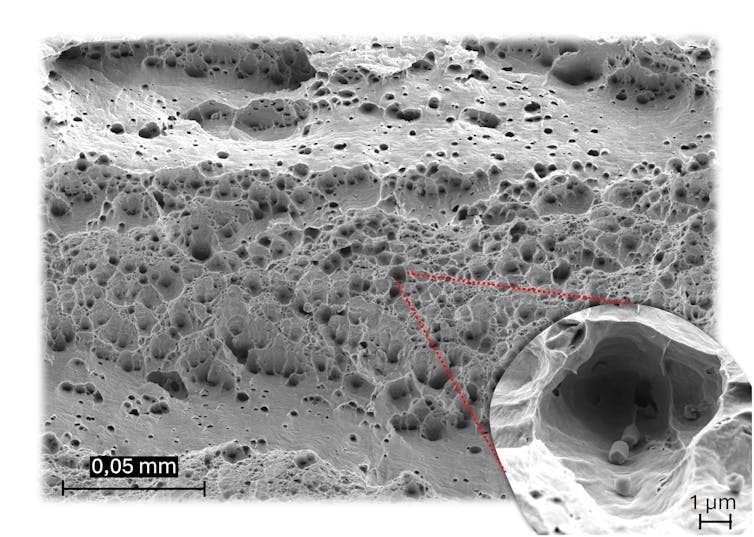

Dans chacune des espèces de plathelminthes, nous avons trouvé un signal moléculaire d’une espèce du genre Mitosporidium. Jusqu’ici, le genre Mitosporidium ne contenait qu’une seule espèce, Mitosporidium daphniae, qui est un parasite des daphnies, des petits crustacés d’eau douce. Mitosporidium est très original : c’est une microsporidie « primitive ». Que sont les microsporidies ? Des parasites unicellulaires.

Une microsporidie est devenue tristement célèbre dans les années 1980, Enterocytozoon bieneusi, qui infectait les patients atteints du sida dont l’immunité était compromise. Avant la génétique moléculaire, on classait les microsporidies dans les « protozoaires » et on les reconnaissait par leurs spores très caractéristiques. On a depuis compris que ce sont des champignons très modifiés par le parasitisme, en particulier par la perte des mitochondries.

Comme mentionné plus haut, les mitochondries sont des organites présents dans toutes les cellules des eucaryotes, mais les microsporidies, qui vivent dans les cellules de leurs hôtes, n’en ont plus besoin et s’en sont débarrassées.

Mais la nature aime les exceptions, et les scientifiques aiment les exceptions quand elles permettent de mieux comprendre la nature… Mitosporidium daphniae a toutes les caractéristiques d’une microsporidie, sauf qu’elle a conservé un génome de mitochondrie. C’est pour cela que l’on considère cette espèce comme « basale » : elle représenterait une étape de l’évolution des champignons vers les microsporidies, en ayant déjà la morphologie et la vie intracellulaire d’une microsporidie, mais en ayant gardé le mitogénome.

Et donc, nous avons trouvé deux nouvelles espèces de Mitosporidium, une dans chaque espèce de ver plat. Rien que le fait de faire passer ce genre d’une seule espèce à trois était déjà une découverte significative ; la seule espèce connue avait été décrite en 2014, et aucune depuis.

Parasites de quoi ?

Un gros problème est apparu. Pour des raisons techniques, nous n’avons pas vu les microsporidies. On ne les reconnaît facilement que quand elles sont au stade de spores, et les autres stades, dans les tissus de l’hôte, sont difficiles à détecter. Et puis surtout, la question a été : de qui sont parasites ces microsporidies ? Rappelez-vous, notre analyse a été faite sur un mélange de tissus : tissus du plathelminthe prédateur et tissus du ver de terre dans son intestin. Ces Mitosporidium étaient-ils des parasites des plathelminthes eux-mêmes ou de leurs proies, les vers de terre ?

Pour l’instant, nous ne pouvons pas trancher définitivement, mais un principe biologique nous guide : la spécificité parasitaire. En effet, un parasite est souvent associé à une seule espèce d’hôte. Or, dans chaque plathelminthe terrestre étudié, nous avons trouvé une espèce unique de Mitosporidium.

Deux hypothèses sont possibles. Soit ces parasites viennent des vers de terre que les plathelminthes consomment – mais il faudrait alors admettre un hasard improbable : que chaque plathelminthe ait mangé une seule espèce de ver de terre, elle-même infectée par son parasite spécifique. Soit, plus simplement, chaque plathelminthe possède son propre Mitosporidium. C’est cette seconde hypothèse qui nous paraît la plus plausible, en attendant des analyses plus larges.

Un avenir pour la lutte contre les vers plats ?

Nous supposons, donc, maintenant avoir découvert des parasites de vers plats envahissants. Selon la théorie générale du « relâchement de la pression des ennemis », un moyen de se débarrasser d’une espèce envahissante est de l’infecter par un parasite ou par un pathogène qui va réduire ses populations. Un exemple classique est celui du lapin en Australie : libéré de ses prédateurs et parasites, il s’est multiplié de façon incontrôlable et seule l’introduction de la myxomatose a permis de réduire un peu sa population. Mais ce n’est pas toujours facile : pour le frelon asiatique, envahissant en Europe, plusieurs parasites ont été identifiés, sans qu’aucun ne puisse freiner réellement son expansion.

Introduire des microsporidies pour réduire les populations de plathelminthes terrestres envahissants ? Une idée séduisante, mais nous en sommes très loin.

D’abord, comme expliqué plus haut, nous ne sommes pas encore sûrs que les Mitosporidium soient des parasites de plathelminthes. Ensuite, on ne sait pas du tout s’ils sont pathogènes ! La seule espèce connue avant notre travail, Mitosporidium daphniae, n’a qu’une petite influence négative sur la fertilité des daphnies infectées. Des années de recherche sont encore nécessaires.

Jean-Lou Justine est Rédacteur-en-Chef de Parasite, la revue scientifique de la Société Française de Parasitologie, dans laquelle a été publiée cette étude. Toutes les précautions éthiques ont été prises, en suivant les recommandations de COPE https://publicationethics.org/ .

Archie K. Murchie a reçu des financements du Department of Agriculture, Environment & Rural Affairs, Northern Ireland

Romain Gastineau a reçu des financements du ministère de la recherche et de l'éducation de Pologne.

Leigh Winsor ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

15.10.2025 à 16:48

La liberté académique dans le monde et en France : un bien de première nécessité

Stéphanie Balme, Director, CERI (Centre de recherches internationales), Sciences Po

Texte intégral (1901 mots)

Stéphanie Balme a mené pour France Universités une étude intitulée « Défendre et promouvoir la liberté académique : un enjeu mondial, une urgence pour la France et l’Europe. Constats et 65 propositions d’action ». Elle en livre ici quelques enseignements.

Dévoilé officieusement le 2 octobre 2025, le Compact for Academic Excellence in Higher Education de Donald Trump illustre de manière paroxystique la politisation du savoir et la volonté de contrôle idéologique de la production scientifique aux États-Unis. Derrière le discours de « restauration de l’excellence » se profile une nouvelle étape dans l’institutionnalisation du sciento-populisme : la défiance envers la science y est exploitée de manière stratégique afin de flatter les affects populistes et de transformer les universitaires en boucs émissaires, rendus responsables du « déclin » de l’hégémonie civilisationnelle américaine.

Ce phénomène, bien que caricatural, n’est pas isolé. Simultanément à l’annonce de Donald Trump, l’édition 2025 du Global Innovation Index (GII) révèle que la Chine intègre pour la première fois le top 10 des nations les plus innovantes, tandis que les États-Unis, encore troisièmes, montrent des fragilités structurelles. Huit pays européens, fait trop peu connu, figurent parmi les quinze premiers de ce classement. La France, quant à elle, est rétrogradée mais conserve néanmoins la treizième place, celle qu’occupait la Chine trois ans auparavant.

Les 80 indicateurs du GII, couvrant près de 140 pays, ne se limitent pas à mesurer la performance technologique ou scientifique : ils évaluent également la capacité des États à garantir un environnement politico-institutionnel, économique et financier complet, libre et sûr. En croisant ces données avec celles de l’Academic Freedom Index, principal outil de référence élaboré depuis 2019, on constate que la liberté académique n’est plus uniquement menacée dans les régimes autoritaires. Elle se fragilise désormais au cœur même des démocraties, affectant à parts égales les sciences humaines et sociales et les sciences expérimentales.

L’attribution du prix Nobel d’économie 2025 à Philippe Aghion, Peter Howitt et Joel Mokyr rappelle opportunément que la croissance et l’innovation reposent sur un écosystème fondé sur la liberté de recherche et la circulation des idées. Leurs travaux sur les conditions historiques et structurelles du progrès technologique montrent qu’aucune économie ne peut prospérer durablement lorsque la connaissance est contrainte ou soumise à un contrôle idéologique.

Régimes autoritaires et technonationalisme

Paradoxalement, les régimes autoritaires comptent aujourd’hui parmi les principaux investisseurs dans la recherche, dont ils orientent néanmoins strictement les finalités selon leurs priorités politiques. Engagés dans une phase ascendante de développement technonationaliste, ils investissent massivement dans la science et la technologie comme instruments de puissance, sans encore subir les effets corrosifs de la défiance envers le savoir.

Les démocraties, à l’inverse, peinent à financer la recherche tout en soutenant leurs dépenses de défense et doivent affronter la montée de mouvements contestant la légitimité même de la science telle qu’elle se pratique. C’est afin de mieux comprendre ces dynamiques que j’ai conduit pour France Universités une étude intitulée « Défendre et promouvoir la liberté académique : un enjeu mondial, une urgence pour la France et l’Europe. Constats et 65 propositions d’action ».

Des atteintes multiples en France

La France illustre particulièrement les vulnérabilités décrites plus haut. En 2024‑2025, les atteintes à la liberté académique y ont pris des formes multiples : ingérences étrangères accrues, conditionnement des financements publics régionaux à des chartes aux critères flous, pressions idéologiques sur les contenus d’enseignement et de recherche, annulations de conférences, campagnes de stigmatisation d’enseignants-chercheurs sur les réseaux sociaux, interventions de responsables politiques jusque dans les conseils d’administration d’universités, restrictions d’accès aux terrains ou à des bourses de recherche, et enfin, multiplication des procédures-bâillons.

Contrairement à d’autres droits fondamentaux, la liberté académique en France se distingue par l’absence d’une culture politique, professionnelle et citoyenne solidement enracinée. Les universitaires victimes d’atteintes dans leur liberté d’exercer leur métier se retrouvent souvent isolés, tandis que la capacité institutionnelle des universités à jouer un rôle de contre-pouvoir demeure limitée.

Cette vulnérabilité est aggravée par la dépendance aux financements publics, la précarisation des carrières, la surcharge administrative et l’absence d’autonomie institutionnelle réelle. Néanmoins, cette fragilité actuelle pourrait se transformer en levier de refondation, favoriser l’émergence d’une culture solide de la liberté académique et, ce faisant, renforcer la position de la France dans la géopolitique scientifique mondiale.

Une stratégie multidimensionnelle

L’étude pour France Universités propose une stratégie proactive articulée autour de plusieurs axes complémentaires, visant quatre catégories d’acteurs : l’État, les universités, la société civile et l’échelon européen.

Le premier axe concerne le renforcement du socle juridique : constitutionnaliser la liberté académique, réaffirmer l’autonomie des établissements et l’indépendance des personnels ; enfin, reconnaître le principe du secret des sources comme pour les journalistes et intégrer un régime spécifique dans le Code de la recherche pour les données sensibles. Il est également proposé d’étendre le dispositif de protection du potentiel scientifique et technique de la nation (PPST) aux sciences humaines et sociales en intégrant les risques d’ingérence pour concilier sécurité et liberté scientifiques.

Le deuxième axe porte sur l’action des universités : coordonner les initiatives à l’échelle nationale via un organisme indépendant, généraliser les chartes de liberté académique dans l’ensemble des établissements et organismes de recherche, renforcer la protection fonctionnelle des enseignants grâce à un fonds national dédié et instaurer des protocoles d’assistance rapide. Il prévoit également la création d’un observatoire indépendant des atteintes à la liberté académique, la formation des directions et des référents à ces enjeux, ainsi que la coordination d’un soutien juridique, psychologique et numérique pour les universitaires pris pour cibles. Enfin, cet axe vise à favoriser une collaboration croisée entre fonctionnaires sécurité‑défense et chercheurs et enseignants-chercheurs.

Le troisième axe vise à promouvoir une véritable culture de la liberté académique dans l’espace public : lancer une campagne nationale de sensibilisation, encourager les initiatives étudiantes, transformer la Fête de la science en Fête de la science et de la liberté académique, organiser des États généraux pour définir un plan d’action participatif, et déployer une vaste campagne de valorisation de la recherche en partenariat avec l’ensemble des opérateurs, à commencer par le CNRS. Cette campagne, appuyée sur des supports visuels, des affiches, des dessins et un hashtag fédérateur, doit célébrer la recherche dans tous les médias et rappeler son rôle essentiel au service d’une société démocratique.

Le quatrième et dernier axe vise à inscrire ces mesures dans la diplomatie scientifique européenne, en rétablissant un classement européen des universités du monde entier intégrant un indice de liberté académique, et en œuvrant à son inclusion dans les grands classements internationaux ; renforcer la coopération entre l’Association européenne des universités et les alliances universitaires européennes ; instaurer un observatoire européen de la liberté académique ; créer un passeport européen des talents pour les chercheurs réfugiés ; faire de l’Europe un espace-refuge pour les scientifiques en danger, jusqu’à obtenir, à terme, une reconnaissance sous la forme d’un prix Nobel de la paix dédié à la liberté académique.

La condition d’une démocratie vivante

Défendre la liberté académique n’est pas un réflexe corporatiste : c’est, au contraire, protéger un bien commun précieux et la condition même d’une démocratie vivante. Ce droit n’appartient qu’à un petit nombre, certes, mais il profite à toutes et à tous, à l’instar de la liberté de la presse, garantie par la loi de 1881. Contrairement à une idée reçue, les universitaires sont souvent les derniers à défendre leur droit professionnel, quand les journalistes, à juste titre, protègent activement le leur.

Le système universitaire français, tel qu’il s’est construit depuis 1945, et plus encore après 1968, n’a pas été pensé pour affronter l’autoritarisme. Aujourd’hui, les établissements français ne seraient pas en mesure de résister très longtemps à des attaques systématiques en cas d’arrivée au pouvoir d’un régime populiste et/ou autoritaire. Puissantes, riches et autonomes, les universités de l’Ivy League ont elles-mêmes vacillé face au mouvement MAGA et peinent encore à s’en relever. De nombreux scientifiques américains rejoignent aujourd’hui l’Europe, le Japon ou la Corée du Sud.

Comment, dès lors, les universités françaises, à la fois financièrement et institutionnellement dépendantes, et ne disposant que d’associations d’anciens élèves (alumni) encore récentes, pourraient-elles faire face à un tel assaut ? Sans compter que ce serait, à terme, la fin de l’ambition portée par le programme Choose Europe For Science.

Malgré la gravité de la situation, celle-ci ouvre un espace inédit pour l’action collective, l’innovation démocratique et la construction de solutions concrètes. Il est désormais temps d’agir collectivement, de coordonner les acteurs et de lancer une vaste campagne nationale et européenne en faveur de la liberté académique : tel est l’objet de ce rapport.

Stéphanie Balme ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

15.10.2025 à 11:41

Les « marques de cure-dents » sur les fossiles préhistoriques n’en étaient peut-être pas

Ian Towle, Research Fellow in Biological Anthropology, Monash University

Luca Fiorenza, Senior Lecturer in Anatomical Sciences, Monash University

Texte intégral (2386 mots)

Une étude sur plus de 500 primates sauvages montre que les « sillons de cure-dents » sur les dents fossiles peuvent se former naturellement, tandis que certaines pathologies modernes, comme les abfractions, sont propres aux humains.

Depuis des décennies, de fines rainures observées sur des dents humaines préhistoriques étaient interprétées comme la preuve d’un geste délibéré : des humains nettoyant leurs dents à l’aide de petits bâtons ou de fibres végétales, ou cherchant à soulager une douleur gingivale. Certains chercheurs y ont même vu la plus vieille habitude humaine.

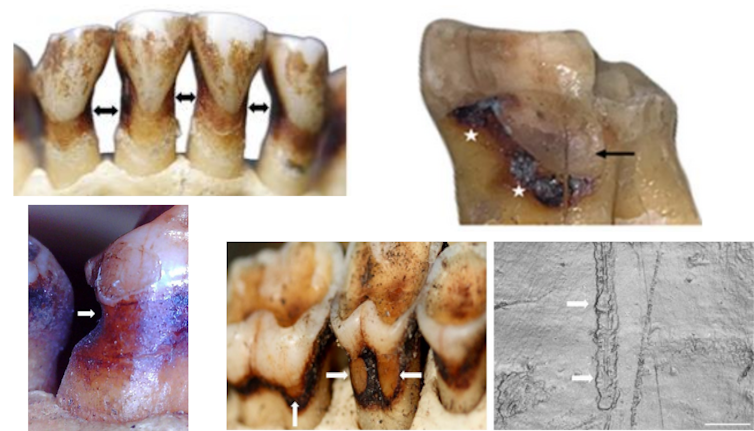

Mais selon une étude publiée dans l’American Journal of Biological Anthropology, cette hypothèse serait à revoir. Les auteurs ont constaté que ces mêmes stries apparaissent aussi naturellement chez des primates sauvages, sans qu’aucun comportement de curetage dentaire ne soit observé. Encore plus surprenant : l’analyse de plus de 500 primates, appartenant à 27 espèces vivantes ou fossiles, n’a révélé aucune trace d’une maladie dentaire fréquente chez l’humain moderne, les lésions dites d’abfraction – ces entailles profondes en forme de V au niveau de la gencive.

Ces découvertes invitent à repenser l’interprétation des fossiles et ouvrir de nouvelles pistes sur ce qui, dans l’usure et les pathologies de nos dents, témoigne d’une évolution proprement humaine.

Pourquoi les dents comptent dans l’évolution humaine

Les dents sont la partie la plus résistante du squelette et survivent souvent bien après la décomposition du reste du corps. Les anthropologues s’en servent pour reconstituer les régimes alimentaires, les modes de vie et l’état de santé des populations anciennes.

Même les plus petites marques peuvent avoir une grande signification. L’une des plus fréquentes est une fine rainure qui traverse la racine exposée de certaines dents, souvent entre deux d’entre elles. Depuis le début du XXᵉ siècle, ces traces ont été baptisées « marques de cure-dent » et interprétées comme les signes d’un usage d’outils ou de pratiques d’hygiène dentaire.

On en a signalé tout au long de notre histoire évolutive, sur des fossiles vieux de deux millions d’années jusqu’aux Néandertaliens. Mais jusqu’ici, personne n’avait réellement vérifié si d’autres primates présentaient ces mêmes marques. Une autre affection, appelée abfraction, se manifeste différemment : par des entailles profondes en forme de coin à la base de la gencive. Très fréquentes en dentisterie moderne, elles sont souvent associées au grincement des dents, à un brossage trop vigoureux ou à la consommation de boissons acides. Leur absence sur les fossiles connus intrigue depuis longtemps les chercheurs : les autres primates en sont-ils vraiment exempts ?

Ce que nous avons fait

Pour vérifier ces hypothèses, nous avons analysé plus de 500 dents appartenant à 27 espèces de primates, actuelles et fossiles. L’échantillon comprenait notamment des gorilles, des orang-outans, des macaques, des colobes et plusieurs singes disparus. Fait essentiel, tous les spécimens provenaient de populations sauvages, ce qui signifie que l’usure de leurs dents n’a pas pu être influencée par les brosses à dents, les boissons gazeuses ou les aliments transformés.

Nous avons recherché des lésions cervicales non carieuses – un terme désignant une perte de tissu au niveau du col de la dent qui n’est pas causée par la carie. À l’aide de microscopes, de scanners 3D et de mesures de perte de tissu, nous avons documenté même les plus petites lésions.

Ce que nous avons découvert

Environ 4 % des individus présentaient des lésions. Certaines ressemblaient presque exactement aux classiques « sillons de cure-dents » observés sur les fossiles humains fossiles, avec de fines rayures parallèles et des formes effilées. D’autres lésions étaient peu profondes et lisses, surtout sur les dents de devant, probablement causées par les fruits acides que beaucoup de primates consomment en grande quantité.

Mais une absence nous a frappé. Nous n’avons trouvé aucune lésion par abfraction. Malgré l’étude d’espèces ayant une alimentation extrêmement dure et des forces de mastication puissantes, aucun primate n’a présenté les défauts en forme de coin si couramment observés dans les cliniques dentaires modernes.

Qu’est-ce que cela signifie ?

Premièrement, cela signifie que les sillons ressemblant à des marques de cure-dents ne prouvent pas nécessairement l’utilisation d’outils. La mastication naturelle, les aliments abrasifs, ou même le sable ingéré peuvent produire des motifs similaires. Dans certains cas, des comportements spécialisés, comme arracher de la végétation avec les dents, peuvent également y contribuer. Il faut donc rester prudent avant d’interpréter chaque sillon fossile comme un acte délibéré de curetage dentaire.

Deuxièmement, l’absence totale de lésions par abfraction chez les primates suggère fortement qu’il s’agit d’un problème propre aux humains, lié à nos habitudes modernes. Elles sont beaucoup plus probablement causées par un brossage trop vigoureux, les boissons acides et les régimes alimentaires transformés que par les forces de mastication naturelles. Cela place les abfractions aux côtés d’autres problèmes dentaires, comme les dents de sagesse incluses ou les dents mal alignées, qui sont rares chez les primates sauvages mais fréquents chez l’homme aujourd’hui. Ces observations alimentent un domaine de recherche émergent appelé odontologie évolutive, qui utilise notre passé évolutif pour comprendre les problèmes dentaires actuels.

Pourquoi est-ce important aujourd’hui ?

À première vue, les sillons sur les dents fossiles peuvent sembler anecdotiques. Pourtant, ils ont une importance à la fois pour l’anthropologie et pour la dentisterie. Pour la science évolutive, ils montrent qu’il est essentiel d’observer nos plus proches parents avant de conclure à une explication culturelle spécifique ou unique. Pour la santé moderne, ils mettent en évidence à quel point nos régimes alimentaires et nos modes de vie modifient profondément nos dents, nous distinguant des autres primates.

En comparant les dents humaines à celles des autres primates, il devient possible de distinguer ce qui est universel (l’usure inévitable due à la mastication) de ce qui est propre à l’homme – le résultat des régimes alimentaires, des comportements et des soins dentaires modernes.

Et ensuite ?

Les recherches futures porteront sur des échantillons plus larges de primates, examineront les liens entre régime alimentaire et usure dentaire dans la nature, et utiliseront des techniques d’imagerie avancées pour observer la formation des lésions. L’objectif est d’affiner notre interprétation du passé tout en découvrant de nouvelles façons de prévenir les maladies dentaires aujourd’hui.

Ce qui peut ressembler à un sillon de cure-dents sur une dent humaine fossile pourrait tout aussi bien être un simple sous-produit de la mastication quotidienne. De même, il pourrait refléter d’autres comportements culturels ou alimentaires laissant des marques similaires. Pour démêler ces possibilités, il faut disposer de jeux de données comparatifs beaucoup plus larges sur les lésions des primates sauvages ; ce n’est qu’ainsi que l’on pourra identifier des tendances générales et affiner nos interprétations du registre fossile.

Parallèlement, l’absence de lésions par abfraction chez les primates suggère que certains de nos problèmes dentaires les plus courants sont propres à l’homme. Cela rappelle que même dans quelque chose d’aussi quotidien qu’un mal de dents, notre histoire évolutive est inscrite dans nos dents, mais façonnée autant par nos habitudes modernes que par notre biologie ancienne.

Ian Towle reçoit un financement du Conseil australien de la recherche (Australian Research Council, ARC DP240101081).

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr