15.12.2025 à 16:14

Et si la nature brillait plus que ce que nous voyons ? À la découverte de la vie fluo

Romain Garrouste, Chercheur à l’Institut de systématique, évolution, biodiversité (ISYEB), Muséum national d’histoire naturelle (MNHN)

Bernd Schöllhorn, Professor, Université Paris Cité

Serge Berthier, Professeur, Institut des Nanosciences de Paris, Sorbonne Université

Texte intégral (3128 mots)

Le parcours nocturne Lumières de la nature, proposé par le Jardin des plantes de Paris jusqu’au 16 janvier 2026, a été inspiré d’études menées en Guyane. Derrière cette exposition, on trouve notamment trois chercheurs qui ont inspecté la forêt amazonienne, armés de lampes UV. Ils nous livrent ici les secrets de la fluorescence naturelle, le plus souvent invisible pour les humains mais omniprésente dans le vivant.

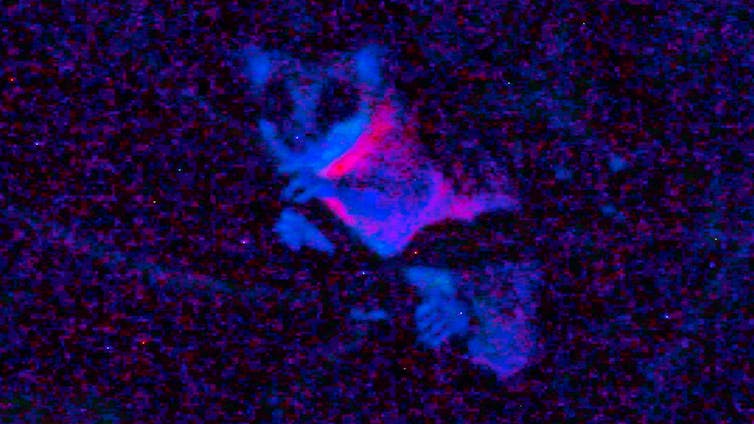

Dans la pénombre de la forêt guyanaise, en début de nuit, nos lampes UV éclairent une forme mouvante dans les arbres, mauve, presque rose et assez intense. C’est un mammifère marsupial, un Marmosa, qui nous révèle un phénomène physique longtemps passé inaperçu dans le vivant… Non loin de là, sur un tronc à hauteur d’homme, une grosse grenouille arboricole montre elle une intense couleur bleu-vert, alors que sa peau est brun-vert en lumière normale, presque mimétique des troncs où elle se déplace.

Ce phénomène physique s’appelle la fluorescence, un type de photoluminescence qui se manifeste dans la nature, au sein d’une étonnante diversité d’organismes : lichens, plantes, champignons, insectes, araignées, scorpions, reptiles, poissons, oiseaux et même… mammifères. Dans ce contexte on parle de la « fluorescence naturelle » qui implique l’absorption d’un rayonnement du spectre lumineux

– l’ultraviolet (UV), le visible ou l’infrarouge (IR) – suivie de l’émission spontanée (à l’échelle de la nanoseconde) d’une lumière moins énergétique, souvent visible, mais pas uniquement.

Longtemps considérée comme une curiosité, la fluorescence naturelle se révèle plus répandue et intrigante qu’on ne l’imaginait. Elle intéresse de plus en plus la recherche, notamment dans le cadre d’applications technologiques ou biomédicales (par exemple des nouveaux marqueurs cellulaires pour la recherche). Les chercheuses et chercheurs l’étudient davantage dans la nature, une nouvelle exploration du vivant étant permise par des instruments portatifs de mesures (photo-spectromètres) et d’émissions (torches LED UV). Notre équipe de recherche se spécialise depuis plusieurs années sur l’exploration des fluorescences du vivant. Nous revenons d’une mission scientifique en Guyane dans le but d’appréhender ce phénomène dans la forêt amazonienne, et plus spécialement dans les biotopes autour de la station de recherche des Nouragues

À lire aussi : Ces champignons qui brillent dans la nuit : la bioluminescence fongique décryptée

Un éclat discret mais omniprésent

La fluorescence naturelle, à ne pas confondre avec la bioluminescence, repose sur la capacité de certaines molécules, les fluorophores, à absorber un photon d’énergie élevée (par exemple dans l’UV) et à en réémettre un autre, d’énergie moindre (dans le visible ou l’IR). La vie, à toutes ses échelles, en est imprégnée. On trouve quelquefois le terme d’autofluorescence pour bien insister sur le fait qu’il ne s’agit pas de fluorescence de composés artificiels. C’est le cas également de nombreux minéraux, comme la fluorite (CaF2), qui a donné son nom au phénomène de fluorescence du fait de sa fluorescence spectaculaire aux UV.

La fluorescence des plantes est connue depuis longtemps, notamment à travers celle de la chlorophylle : lorsqu’elle absorbe la lumière, une partie de l’énergie non utilisée pour la photosynthèse est réémise sous forme de fluorescence rouge. Ce signal est si caractéristique qu’il sert à mesurer à distance la vitalité de la végétation, y compris depuis les satellites. Mais la chlorophylle n’est pas seule à briller. D’autres composés végétaux, comme les flavonoïdes, les anthocyanes ou les ptérines, peuvent émettre une fluorescence bleue ou verte lorsqu’ils sont excités par la lumière ultraviolette.

Plus largement, des études récentes ont révélé que la fluorescence existe dans presque tous les grands groupes du vivant.

À quoi sert la fluorescence ?

Chez certains animaux, elle pourrait jouer un rôle avant tout dans la protection contre les UV, mais aussi dans la communication visuelle telle que la reconnaissance entre congénères (comme chez l’araignée Cosmophasis umbratica, les perruches australiennes ou encore une grenouille arboricole), ou dans l’avertissement, et même le camouflage. Cela peut sembler contre-intuitif de se camoufler en étant « fluo » mais il ne faut pas oublier que d’autres organismes n’ont pas la même vision que les humains.

La fluorescence de certaines fleurs, à la lumière du jour souvent cachée aux yeux humains mais perceptible pour les insectes pollinisateurs, pourrait jouer un rôle attractif. Pour la plupart des autres organismes fluorescents, nous ignorons si cette propriété possède une fonction biologique ou s’il ne s’agit pas simplement d’un effet optique sans conséquence pour l’animal ou la plante. La frontière reste floue si l’on ne possède pas les clés pour déchiffrer les phénomènes. Encore faut-il les voir…

Chez les mammifères : quand les marsupiaux s’y mettent

La découverte a surpris la communauté scientifique : des mammifères fluorescents, vraiment ? Depuis 2020, plusieurs études ont montré que des marsupiaux – notamment les opossums américains (Didelphis spp.), mais aussi des espèces australiennes comme le planeur à sucre (Petaurus breviceps) ou phalanger, émettent une fluorescence rose ou bleutée sous lumière ultraviolette.

En Guyane, comme nous l’avons observé, des petits opossums sont également fluo, comme les Marmosa.

Des travaux récents ont élargi le constat : plus de 125 espèces de mammifères présentent un certain degré de fluorescence. Celle-ci se manifeste surtout sur les zones claires ou peu pigmentées : pelage blanc, moustaches, griffes, dents ou piquants. Sur le terrain, nous avons souvent observé des rats fluorescents dans la nature (Rattus spp.) que ce soit en Europe, en Asie ou en Guyane.

Chez les insectes, des signaux souvent cachés

Les insectes offrent une extraordinaire diversité de structures fluorescentes. Les ailes de certaines libellules et cigales contiennent de la résiline, une protéine élastique qui émet une lumière bleue sous UV. L’un des plus spectaculaires reste les nids de guêpes asiatiques (Polistes sp.), que nous avons observés au Vietnam qui battent des records de fluorescence induite par l’UV avec un rendement quantique (le rapport entre le nombre de photons émis et absorbés) exceptionnellement élevé jusqu’à 36 % (champion des matériaux biologiques terrestre à ce jour).

Les élytres des coléoptères, quant à eux, peuvent renfermer des pigments fluorescents enchâssés dans des micro ou nanostructures photoniques, capables d’amplifier, de restreindre ou de diriger la lumière émise. Chez le scarabée Hoplia coerulea, par exemple, ces structures créent une fluorescence directionnelle d’un bleu métallique saisissant. Quelques exemples ont été étudiés mais certainement beaucoup d’autres restent à découvrir.

En Amazonie, chez le Morpho sulkowskyi, un papillon iridescent et spectaculaire, la fluorescence fait aussi partie des signaux renvoyés par les ailes colorées.

Une lumière sur l’évolution… et sur la recherche

Cette redécouverte de la fluorescence naturelle dans autant de groupes vivants change notre regard sur la biodiversité et nous incite à mieux la comprendre. L’anthropomorphisme nous a conduits à croire que nous vivions dans un monde visible universel alors que c’est loin d’être le cas, par exemple, notre totale non-perception des UV qui pourtant imprègnent une grande partie du monde animal, des insectes aux poissons (la plupart des requins sont fluorescents !), et déterminent un grand nombre d’interactions écologiques, comme la pollinisation et les relations proie-prédateur, ou modifie notre perception du mimétisme (que voient réellement les prédateurs ?).

Pour comprendre ces phénomènes, la chimie et la physique doivent s’associer à la biologie qui peine seule à élucider les mécanismes, et qui peut les ignorer ou les minimiser.

Ne négligeons pas les applications potentielles (par fois bio-inspirées) qui peuvent découler de la meilleure connaissance et de la compréhension des systèmes naturels. La fluorescence est déjà au cœur de nombreuses applications scientifiques : microscopie de fluorescence, imagerie médicale, biologie cellulaire. Aujourd’hui, la GFP (protéine fluorescente verte), trouvée dans une méduse, est l’un des outils les plus largement utilisés en biologie moléculaire, et sa découverte a été récompensée par un prix Nobel en 2008. La découverte de nouvelles molécules fluorescentes performantes pourrait améliorer les outils de diagnostics médicaux et ouvrir la voie à des dispositifs photoniques inédits, capables d’améliorer l’efficacité des panneaux solaires, par exemple.

Le monde vivant n’est pas seulement coloré, il recèle aussi un « spectre caché » de lumières invisibles à l’œil humain. Pour le comprendre, il nous faut l’appréhender et revoir notre perception du monde, ainsi que de nombreuses certitudes. C’est ce qui fait la beauté de la science face à la merveilleuse complexité de la nature. Et si le monde était encore plus beau que ce que l’on croyait ?

Pour en savoir plus, vous pouvez visiter l’exposition « En voie d’illumination : les lumières de la nature » jusqu’au 18 janvier 2026 au Jardin des plantes (Paris), où vous verrez une reconstitution de la forêt tropicale d’Amérique du Sud, avec sa bioluminescence et sa fluorescence.

Romain Garrouste a reçu des financements de MNHN, CNRS, Sorbonne Université, National Geographic, MRAE, MTE, Labex BCDiv, Labex CEBA, WWF

Bernd SCHÖLLHORN a reçu des financements du CNRS (MITI et OVNI) et de l'Université Paris Cité (IDEX et laboratoire ITODYS)

Serge Berthier a reçu des financements de ANR, CNRS, Sorbonne Université.

14.12.2025 à 17:59

Airbus : D’où vient la panne qui a conduit l’entreprise à immobiliser des milliers d’avions ?

David Monniaux, Chercheur en informatique, Centre national de la recherche scientifique (CNRS), Université Grenoble Alpes (UGA)

Texte intégral (2101 mots)

Fin octobre, Airbus demande aux compagnies aériennes de maintenir au sol 6 000 A320, à la suite d’un incident survenu en vol. L’entreprise l’explique par une mise à jour logicielle qui serait plus sensible aux rayonnements cosmiques. Si ce genre de problèmes existe, ils sont cependant détectés immédiatement en temps normal.

Le 30 octobre dernier, un vol de Cancún vers le New Jersey de la compagnie JetBlue a rapidement chuté en plein vol, avant que les pilotes puissent rétablir sa trajectoire, au bout de quelques secondes. Après un atterrissage en urgence en Floride, quelques passagers ont reçu des soins. À la suite de cet incident, Airbus a dû changer en urgence un logiciel de pilotage dans 6000 appareils de la famille A320. On a évoqué une « perturbation par une particule isolée » et le rôle des éruptions solaires. Qu’en est-il ?

Le palliatif proposé par Airbus est de faire revenir la version de certains logiciels de pilotage à une version antérieure. Sur les forums spécialisés, on spécule sur les causes techniques de ce dysfonctionnement, sur d’éventuelles fonctionnalités ajoutées entre ces deux versions, qui seraient insuffisamment protégées contre les effets que des rayonnements cosmiques peuvent avoir dans les composants informatiques. Il vaut mieux, toutefois, attendre le rapport officiel de l’enquête sur l’incident. En attendant, nous pouvons revenir sur l’explication invoquée et en quoi elle peut surprendre.

Les rayons cosmiques, ennemis de nos systèmes électroniques

La Terre est en permanence bombardée par des particules venant de l’espace – du Soleil ou de corps plus lointains. La plupart de ces particules sont déviées par le champ magnétique terrestre, une autre partie est absorbée ou transformée par l’atmosphère, mais certaines d’entre elles peuvent atteindre la surface terrestre. Elles forment une partie de la radioactivité naturelle, et sont plus abondantes en périodes d’éruption solaire.

Ces particules arrivant de l’espace ont des effets variés. Dans les régions polaires, moins protégées par le champ magnétique terrestre, elles provoquent de magnifiques aurores dans le ciel de nuit. On leur attribue également les flashes lumineux que les astronautes perçoivent dans leurs yeux. Comme il s’agit de rayonnements ionisants, les particules reçues peuvent avoir des effets sur la santé. Ainsi, Thomas Pesquet, en six mois de séjour dans la station spatiale internationale, a bien dépassé le quota annuel maximum d’exposition aux radiations permis pour un travailleur français.

Les particules issues de l’espace peuvent provoquer des dysfonctionnements dans les circuits électroniques. Par exemple, dans les années 1990, des composants électroniques de puissance, notamment conçus pour des trains, grillaient pour des raisons mystérieuses. Pour trier parmi les diverses hypothèses envisagées, on a essayé ces composants à la surface et dans une mine de sel, sous 140 mètres de roche : les problèmes ne se produisaient pas dans la mine ! Une fois le problème identifié, on a pu concevoir des composants et des modes d’utilisation beaucoup moins vulnérables.

Qu’est-ce qu’une perturbation par une particule isolée ?

Il est plus courant que, plutôt que de griller un composant, les particules modifient une donnée qui y est stockée. Les ordinateurs retiennent les informations sous forme de 0 et de 1, et une particule peut provoquer le basculement d’un 0 en 1 ou l’inverse, ce qu’on appelle une « perturbation par une particule isolée », ou single event upset en anglais.

En 2003, dans la commune belge de Schaerbeek, une liste a obtenu lors d’une élection un excès de précisément 4 096 voix, ce qui correspond exactement au basculement d’un 0 en 1 à l’intérieur d’un nombre écrit en binaire. Un tel basculement s’expliquerait par un single event upset.

Bien évidemment, et notamment pour les applications aérospatiales, particulièrement exposées, on a développé des parades. Certaines parades sont matérielles : par exemple, les mémoires vives peuvent être munies de codes correcteurs d’erreurs fondés sur du matériel spécifique pour coder et décoder très rapidement. C’est habituellement le cas de la mémoire vive des serveurs, les machines qui stockent des données dans les data centers, mais pas des ordinateurs de bureau ou des portables, du fait de leur coût. Ces codes permettent de corriger à coup sûr certaines erreurs et, dans d’autres cas, d’au moins signaler qu’il s’est passé quelque chose d’incorrect.

D’autres parades sont logicielles : procéder régulièrement à certaines vérifications, dupliquer des données à conserver sur de longues durées, éviter de garder trop longtemps des données dans des mémoires vulnérables, enregistrer certaines informations importantes d’une façon telle que le basculement d’un chiffre fournit une valeur absurde, donc détectable… Les possibilités sont nombreuses. Il y a par ailleurs des protocoles de test, y compris consistant à placer les circuits dans le faisceau d’un accélérateur de particules (grand instrument de sciences physiques).

Des commandes de vol électriques touchées par une panne

Voyons maintenant les implications pour l’aviation. La transmission des ordres des pilotes de ligne à leurs gouvernes, les parties mobiles de l’avion qui permettent de contrôler sa trajectoire, se faisait historiquement par des systèmes de câbles, de poulies ou de circuits hydrauliques assez compliqués. Il faut en plus assurer la redondance, c’est-à-dire prévoir plusieurs modes de transmission en cas de panne. Depuis les années 1980, les nouveaux modèles d’avions utilisent des commandes de vol électriques, c’est-à-dire que ces transmissions mécaniques sont remplacées par des câblages et des calculateurs électroniques.

Ces calculateurs diminuent la charge de pilotage (ils automatisent des actions que les pilotes devraient sinon faire manuellement) et augmentent ainsi la sécurité. Ils peuvent vérifier si les pilotes commandent une manœuvre qui sortirait l’avion du domaine des manœuvres qu’il peut faire en sécurité, et peuvent par exemple prévenir le décrochage. La panne qui a valu le rappel des avions Airbus concerne un calculateur appelé ELAC, qui commande les élévateurs et les ailerons, qui sont respectivement des gouvernes situées sur le stabilisateur arrière de l’avion et sur l’arrière du bout des ailes.

Les commandes de vol sont particulièrement sécurisées

Un point qui peut tout d’abord nous rassurer est que les problèmes de particules venues de l’espace se produisent plutôt à haute altitude, lorsqu’il y a moins d’atmosphère protectrice, alors que les étapes les plus dangereuses dans un vol sont plutôt le décollage et l’atterrissage. Ceci n’excuse cependant pas le dysfonctionnement constaté. Voyons un peu pourquoi ce problème n’aurait pas dû se produire.

Les calculateurs informatisés d’aviation civile sont classés, suivant les standards internationaux de l’aviation civile, en cinq niveaux de criticité, selon la sévérité des conséquences possibles d’un dysfonctionnement : du niveau A, où un dysfonctionnement peut provoquer une catastrophe aérienne, au niveau E, où il n’y aurait pas de conséquences pour la sécurité de l’aéronef. Les commandes de vol électriques sont du niveau A, elles sont donc soumises aux normes les plus sévères. On peut donc raisonnablement supposer que les commandes de vol des A320 sont équipées de mécanismes de détection et/ou de remédiation de dysfonctionnements, y compris dus aux radiations.

Sur les Airbus A330/A340, par exemple, il existe deux niveaux de commande de vol, primaires et secondaires. Il y a trois boîtiers de commandes primaires, et lorsqu’un boîtier a subi un problème, il est temporairement désactivé – ce n’est pas grave, car il en a deux autres pour le relayer. S’il y avait un problème générique sur les commandes primaires, on pourrait fonctionner avec les commandes secondaires, qui utilisent d’autres types de composants.

Chaque boîtier de commande de vol primaire consiste en deux calculateurs, l’un qui commande les gouvernes, l’autre qui surveille celui qui commande – ils doivent produire environ les mêmes résultats, sinon le système détecte que quelque chose ne va pas. Normalement, sur un tel système, en cas de dysfonctionnement d’un des calculateurs, le problème est rapidement détecté, le boîtier est désactivé, on passe sur un autre et une chute comme celle qui s’est passée en octobre est impossible.

Pourquoi les systèmes n’ont-ils pas détecté le problème ?

J’ai personnellement travaillé sur l’analyseur statique Astrée, un outil destiné à vérifier que des logiciels de contrôle ne se mettent jamais dans des situations d’erreur. Il a notamment été utilisé par Airbus sur ses commandes de vol électriques. J’ai eu l’occasion, au fil des années, d’apprécier le sérieux et la volonté de cette société de se doter d’approches à la pointe de l’état de l’art en matière de technologies logicielles, notamment de vérification formelle.

Plus récemment, j’ai également travaillé sur des contre-mesures à des erreurs de fonctionnement informatique provoquées volontairement à l’aide de rayonnements électromagnétiques. Il existe en effet la possibilité que des personnes induisent volontairement des pannes afin de les exploiter dans un but frauduleux, c’est donc nécessaire de travailler à prévenir ces tentatives pour des cartes à puce et d’autres équipements sécurisés.

L’hypothèse qu’il s’agisse bien d’une perturbation par une particule isolée reste plausible, mais il est surprenant qu’il ait fallu plusieurs secondes pour traiter le problème. Le système de sécurité du boîtier de commande affecté par l’irradiation aurait dû détecter l’incident, le boîtier touché aurait dû être automatiquement désactivé et l’avion basculé sur un autre, en secours. Il faut donc attendre d’autres éléments pour déterminer si c’est la bonne explication, et comment cela a pu alors se produire, ou si d’autres scénarios sont à envisager.

David Monniaux a reçu des financements de l'ANR (PEPR Cybersécurité). En tant que co-développeur de l'analyseur Astrée, il touche une prime d'intéressement à la valorisation de ce logiciel, donc à ses ventes.

10.12.2025 à 16:07

Dans les torrents, des insectes tissent de minuscules filets de pêche qui inspirent de nouveaux matériaux

Christophe Mori, Maitre de conférences, Université de Corse Pascal-Paoli

Texte intégral (1519 mots)

Au fond des torrents et des ruisseaux, de petites larves d’insecte construisent des filets pour attraper leur nourriture et font preuve d’une intelligence remarquable pour s’adapter au courant. Des comportements qui inspirent nos propres innovations techniques.

Imaginez-vous au bord d’un torrent, où l’eau surgit avec une force capable d’emporter des pierres. Au fond de ce tumulte, des larves de quelques millimètres, non seulement survivent, mais prospèrent en bâtissant des pièges ingénieux pour capturer leur nourriture. Sur leurs filets de soie de 2 à 3 cm de diamètre, on les voit s’affairer, le nettoyant régulièrement des petits morceaux de feuilles, de bois, des algues et des petits organismes qui s’y piègent.

Ces larves sont des hydropsychés, des insectes de l’ordre des trichoptères. Après avoir vécu sous la forme de larve dans une rivière pendant un à deux ans, ils s’envolent une fois leur forme adulte atteinte, durant laquelle il ressemble à un petit papillon de nuit. La fin de leur vie sera alors très courte, de 10 à 20 jours seulement.

Les hydropsychés, petits ingénieurs des ruisseaux

Les hydropsychés sont des insectes aquatiques ingénieux qui construisent ces tamis de soie pour filtrer passivement leur nourriture dans les eaux courantes. Cette capacité démontre une réelle intelligence comportementale, d’autant qu’ils savent s’ajuster aux flux de nutriments et qu’elles défendent leur territoire. Les larves tricotent des mailles fines (entre 1/50 e et 1/10 e de mm) adaptées à la vitesse du courant : plus il est fort, plus elles fabriquent un filet aux mailles serrées pour résister au courant ! Et lorsqu’il est obstrué ou endommagé, par exemple par des sédiments ou un courant trop fort, elles sont capables de le reconstruire ou le modifier. Il reste à comprendre le déclencheur précis de cette adaptation – est-ce purement génétique ou influencé par l’apprentissage individuel ?

Un si petit organisme, de seulement 1 à 2 cm de long, et qui possède un cerveau de 0,3 mm3 est non seulement capable de concevoir son filet avec une maille variable, de l’ancrer au substrat et de l’orienter face au courant. Mais il est sait aussi repousser ses congénères qui pourraient s’installer trop près et lui voler sa pêche ! Pour cela, les hydropsychés utilisent des ultrasons (d’une fréquence de 64 à 100 kHz, bien au-delà de ce que l’oreille humaine peut percevoir) pour indiquer leur présence à leurs voisins.

À la manière des cigales, les larves génèrent ces sons par stridulation, en frottant certaines parties de leur corps entre elles. Cette technique acoustique facilite leur navigation dans le tumulte sonore des eaux agitées, et est associée à des signaux chimiques tels que des phéromones qui facilitent l’identification et l’interaction sociale dans des milieux agités.

Des petites larves témoin de la qualité des eaux

Dans les communautés aquatiques, les hydropsychés coexistent avec d’autres espèces filtreuses, comme des larves de diptères, pour optimiser les ressources. Elles influencent la stabilité des cours d’eau en modulant les sédiments organiques et les différents flux nutritifs. Les organismes filtreurs sont de véritables nettoyeurs des rivières et des torrents, de petits ingénieurs qui améliorent la qualité des eaux. Ils sont déterminants dans l’architecture des écosystèmes d’eaux courantes, puisqu’ils constituent des proies pour les autres organismes, et sont donc à la base des chaînes alimentaires.

D’un point de vue morphologique, les branchies spécialisées des hydropsychés leur permettent d’extraire l’oxygène même dans des conditions tumultueuses ou déficientes. Cependant, ce sont aussi des organismes fragiles. Cela en fait de bons indicateurs biologiques qui servent aux scientifiques à évaluer la qualité de l’eau et les impacts de la pollution ou du changement climatique.

De plus, les hydropsyché inspirent le biomimétisme pour des technologies filtrantes durables, des colles aquatiques et la recherche médicale. Contrairement à la soie de ver à soie ou d’araignée, celle des hydropsychés est synthétisée sous l’eau, ce qui lui confère une résistance exceptionnelle à l’humidité, une haute élasticité et une biodégradabilité contrôlée. Ces caractéristiques en font un modèle idéal pour développer des biomatériaux innovants en médecine.

Quand l’hydropsyché inspire nos propres innovations

Dans ce monde aquatique en perpétuel mouvement, ces organismes démontrent que la survie dépend d’une vigilance constante et de l’adaptation face à l’instabilité. L’humanité peut s’inspirer de cette résilience et, plus spécifiquement, des stratégies de ces petits insectes aquatiques. La soie des larves d’hydropsychés intéresse la recherche, car elle adhère facilement aux surfaces immergées tout en restant flexible. Elle présente également une résistance mécanique jusqu’à plusieurs fois celle de l’acier à poids égal, n’induit pas de réactions immunitaires fortes et est biodégradable sans laisser de résidus toxiques.

En imitant la composition de la soie des larves d’hydropsyché, les scientifiques développent des colles synthétiques qui fonctionnent en milieu humide, comme dans le corps humain. Ces adhésifs pourraient révolutionner la chirurgie en permettant de refermer des tissus mous (comme le foie ou le cœur) sans points de suture, réduisant les risques d’infection et accélérant la guérison. Des prototypes sont déjà testés pour sceller des vaisseaux sanguins ou réparer des organes internes.

Le filet adaptable des hydropsychés inspire aussi des filtres intelligents qui ajustent leur porosité selon le débit d’eau et la taille des particules, et qui seraient utiles dans les usines de traitement des eaux et les stations d’épuration. Ce composé intéresse aussi les industries marines, pour créer des matériaux qui absorberaient l’énergie des vagues sans se briser, prolongeant la durée de vie des structures. Cela pourrait notamment être exploité par le secteur de l’énergie, pour les éoliennes marines ou les hydroliennes.

Les habitants des cours d’eau : un exemple à suivre

En nous inspirant de ce petit ingénieur, nous ouvrons des voies pour des avancées concrètes. Les solutions les plus élégantes et durables ne viennent pas toujours de laboratoires, mais souvent de la nature elle-même, où l’ingénieuse simplicité du vivant surpasse notre créativité. Et à l’instar des communautés d’organismes fluviaux qui se soutiennent mutuellement, les sociétés humaines doivent établir des réseaux solidaires pour affronter l’incertitude. La remarquable résilience de ces larves nous exhorte à repenser nos modes de vie, en mettant l’accent sur une adaptation préventive plutôt que sur une réaction tardive.

En fin de compte, les hydropsychés et les organismes aquatiques en général nous offrent un exemple à suivre : dans un environnement instable, la survie réside dans la diversité des adaptations et une réelle persévérance. Dans un monde en mutation, elle n’est pas innée, mais elle peut être cultivée. Ces organismes nous montrent que même dans l’agitation structurelle permanente, la vie persiste. En protégeant les écosystèmes fluviaux, nous préservons non seulement la biodiversité, mais aussi un trésor d’inspirations pour un avenir plus résilient et innovant.

Cet article est publié dans le cadre de la Fête de la science (qui a lieu du 3 au 13 octobre 2025), dont The Conversation France est partenaire. Cette nouvelle édition porte sur la thématique « Intelligence(s) ». Retrouvez tous les événements de votre région sur le site Fetedelascience.fr.

Christophe Mori ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Issues

- Korii

- Lava

- La revue des médias

- Mouais

- Multitudes

- Positivr

- Regards

- Slate

- Smolny

- Socialter

- UPMagazine

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- À Contretemps

- Alter-éditions

- Contre-Attaque

- Contretemps

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview