06.01.2026 à 16:54

Que retenir de la présidence malaisienne de l’Asean ?

Paco Milhiet, Visiting fellow au sein de la Rajaratnam School of International Studies ( NTU-Singapour), chercheur associé à l'Institut catholique de Paris, Institut catholique de Paris (ICP)

Texte intégral (2216 mots)

Avec désormais 11 membres, l’Association des nations de l’Asie du Sud-Est a toujours l’ambition de jouer un rôle central en Asie du Sud-Est. La Malaisie, qui a exercé la présidence tournante de l’organisation en 2025, a profité de l’occasion pour se repositionner comme un acteur important dans la région et au-delà.

Cet article a été co-rédigé avec Colin Doridant, analyste des relations entre la France et l’Asie.

Ancienne colonie britannique, la Malaisie est l’un des rares États d’Asie du Sud-Est à être passé d’une stratégie d’alliance à une posture de non-alignement sur la scène internationale. Indépendante depuis 1957, sa politique étrangère est restée, dans un premier temps, étroitement liée aux garanties de sécurité britanniques à travers l’Anglo-Malayan Defence Agreement (1957-1971), puis les Five Power Defence Arrangements, un pacte défensif non contraignant réunissant le Royaume-Uni, la Malaisie et Singapour, l’Australie et la Nouvelle-Zélande. Le progressif retrait britannique, la reconnaissance de la République populaire de Chine (RPC) en 1974 ainsi que l’arrivée au pouvoir de Mahathir Mohamad – une figure politique majeure en Asie – ont posé les bases d’une politique étrangère plus autonome et tournée vers le continent asiatique.

En 2025, la Malaisie a cherché à exploiter sa présidence de l’Association des nations de l’Asie du Sud-Est (Asean) pour affirmer son rôle sur la scène régionale et internationale. Une stratégie qui s’est révélée payante pour Kuala Lumpur, mais en demi-teinte pour l’Asean.

Une politique étrangère neutre mais proactive

Après avoir adhéré au mouvement des non-alignés en 1970 et réaffirmé son non-alignement dans son Livre Blanc de la défense de 2020, la Malaisie semble aujourd’hui poursuivre une politique étrangère d’équilibre stratégique dynamique entre Pékin et Washington, centrée autour de l’Asean dont elle a été l’un des cinq membres fondateurs en 1967 (l’organisation compte désormais 11 membres).

Si la Malaisie, publiquement, n’hésite pas à aller dans le sens de la RPC – comme l’a encore montré la visite d’État de Xi Jinping en avril –, elle a également fait du respect de sa souveraineté en mer de Chine méridionale une de ses priorités stratégiques face à Pékin.

Avec les États-Unis, la relation bilatérale est de plus en plus tendue – que ce soit à propos du conflit israélo-palestinien ou de la nomination du très controversé prochain ambassadeur des États-Unis en Malaisie. La coopération reste néanmoins résiliente, comme en témoigne la signature d’accords de défense et d’accès aux terres rares lors de la visite de Donald Trump en octobre 2025.

Dans les relations avec ses voisins, la Malaisie privilégie un pragmatisme discret en matière de gestion des litiges frontaliers, comme avec les Philippines sur l’État de Sabah ou avec l’Indonésie autour d’Ambalat en mer de Célèbes.

Vis-à-vis de Singapour, ancien membre de la fédération qui s’est détaché en 1965, les relations sont largement normalisées avec des initiatives comme l’ouverture prochaine du Johor Bahru–Singapore Rapid Transit System ou la formalisation en janvier 2025 de la Johor-Singapore Special Economic Zone qui illustrent une approche axée sur l’interdépendance économique, évitant les confrontations publiques.

La présidence de l’Asean 2025 : un succès politique pour Anwar Ibrahim et diplomatique pour la Malaisie

Dix ans après sa dernière présidence de l’Asean, la Malaisie reprenait en 2025 les rênes de l’organisation dans un climat interne et international bien différent de celui qui prévalait une décennie auparavant.

Premier ministre depuis novembre 2022, Anwar Ibrahim, ancien dauphin puis rival de Mahathir, assurait cette présidence de l’Asean, plateforme unique pour rétablir une position d’acteur régional clé. La présidence malaisienne de l’Asean s’est inscrite dans la continuité de sa politique étrangère, qui vise à promouvoir le multilatéralisme et faire de Kuala Lumpur une capitale diplomatique en Asie du Sud-Est. Une mission réussie, avec les visites de plus de 25 chefs d’État différents en Malaisie au cours de l’année 2025, dont celles de Recep Tayyip Erdoğan, de Xi Jinping, de Donald Trump ou encore l’organisation de la rencontre Rubio-Lavrov en juillet.

Autre facette de la diplomatie malaisienne en 2025 : une forte solidarité avec les peuples « opprimés », en particulier les Palestiniens, et une critique des « doubles standards » occidentaux. Les efforts d’Anwar pour concrétiser l’organisation du premier sommet « Asean-GCC-China » entre l’Asean, les six pays du Conseil de coopération du Golfe et la RPC, sont également à souligner. La Malaisie tente de se positionner comme un pont (bridging linchpin vision) entre les différentes régions et cultures, particulièrement entre le monde islamique, l’Occident, mais aussi le « Sud Global », le pays ayant obtenu le statut de partenaire des BRICS en 2024.

Une année 2025 où la Malaisie aura donc pu rayonner à l’international, à l’instar de son premier ministre qui prépare déjà les prochaines élections générales de février 2028.

Asean : des horizons incertains

Point d’orgue d’une année intense, le 47e sommet de l’Asean, organisé concomitamment avec d’autres réunions (Partenariat économique régional global, Sommet de l’Asie orientale) et en présence de Donald Trump, fut historique par l’adhésion d’un onzième membre : le Timor-Leste.

Néanmoins, sur les plans économique et diplomatique, les résultats ont été mitigés. En effet, si le renforcement de l’Asean Trade in Goods Agreement (ATIGA) et de l’Asean-China Free Trade Agreement (ACFTA) ont marqué des avancées vers plus d’intégration régionale, des critiques ont surtout été formulées à l’encontre des accords bilatéraux de réduction des tarifs douaniers signés par la Malaisie et le Cambodge avec les États-Unis. Ces derniers contiendraient des « clauses empoisonnées » visant à renforcer le commerce avec les États-Unis et à limiter celui avec la RPC. Des accords-cadres similaires ont été signés avec le Vietnam et la Thaïlande. Ces dispositions symbolisent les difficultés de l’Asean à s’adapter à la diplomatie économique trumpienne, qualifiée par certains de « diplomatie du cowboy ».

Sur le plan régional, c’est principalement le réveil du conflit larvé entre la Thaïlande et le Cambodge en mai 2025 qui a pesé sur la présidence malaisienne de l’Asean. Malgré des efforts – plus sino-malaisiens qu’états-uniens – qui ont mené à la conclusion lors du sommet de l’Asean de « l’accord de paix de Kuala Lumpur » entre les deux belligérants en octobre, les hostilités ont repris dès le mois de novembre.

En s’ajoutant à l’échec d’avancées concrètes sur le dossier birman et de la mer de Chine méridionale, la confrontation entre Bangkok et Phnom Penh n’a fait que souligner l’incapacité de l’Asean à régler les conflits régionaux. Un rappel supplémentaire de la complexité de ces défis persistants et des limites des mécanismes dont dispose l’Asean pour y faire face.

Les prochaines présidences de l’Asean – les Philippines en 2026, qui ont annoncé qu’elles feraient du Code de conduite en mer de Chine méridionale leur priorité, et Singapour en 2027, année des 60 ans de l’organisation et du prochain Congrès national du Parti communiste chinois – sont d’ores et déjà toutes deux sous pression face à l’accumulation des crises en Asie du Sud-Est.

Ces dynamiques auront des ramifications géopolitiques qui dépassent le seul cadre régional et offrent à des acteurs extérieurs, la France par exemple, des opportunités de coopération et d’influence dans la région.

Les perspectives françaises

Dans le cadre de la mise en œuvre de la nouvelle stratégie Indopacifique française, la Malaisie constitue aujourd’hui un partenaire important en Asie du Sud-Est.

Le pays accueille environ 300 filiales d’entreprises françaises représentant quelque 30 000 emplois. Mais c’est dans le domaine de la défense que la coopération s’est révélée la plus soutenue, la Malaisie s’imposant, dans la première décennie du XXIe siècle, comme le principal partenaire de défense de la France en Asie du Sud-Est (aux côtés de Singapour), notamment à travers la vente de matériel militaire (sous-marins Scorpène, avions A400M, hélicoptères H225). La coopération militaire se poursuit actuellement, qu’il s’agisse des déploiements français (missions CLEMENCEAU 25 et PEGASE), de l’exercice terrestre conjoint MALFRENCH DAGGERT, ou encore des escales et exercices navals réguliers.

La relation connut une certaine accalmie, marquée par des périodes de tensions. Ainsi, en 2018, le retrait de l’huile de palme de la liste des biocarburants bénéficiant d’une exonération fiscale en France fut interprété par la Malaisie comme une interdiction déguisée d’importation, fragilisant un secteur stratégique.

La visite officielle à Paris d’Anwar Ibrahim en juillet 2025 semblait indiquer « la relance » de la relation bilatérale pour reprendre les mots du président Emmanuel Macron. Mais le discours d’Anwar à la Sorbonne pouvait toutefois être perçu comme un avertissement adressé aux Européens, les invitant à recalibrer leurs relations avec l’Asie du Sud-Est et à mieux appréhender les sensibilités d’une région qui « a l’habitude d’être décrite, mais beaucoup moins celle d’être écoutée ».

Il pourrait être intéressant pour la France de renforcer son soutien à la gestion des crises en Asie du Sud-Est, dans la dynamique de la nomination en 2024 d’un envoyé spécial pour la Birmanie en appui des efforts internationaux. En effet, le contentieux territorial entre la Thaïlande et le Cambodge trouve son origine dans le découpage territorial de l’Indochine française et des traités franco-siamois de 1904 et 1907. Or, la reprise du conflit coïncide avec l’organisation en 2026 du XXe Sommet de la Francophonie qui se tiendra au Cambodge (la Thaïlande est également membre l’organisation avec le statut observateur) et auquel participera Emmanuel Macron.

Un déplacement français en Asie du Sud-Est qui ne devra pas, cette fois, oublier la Malaisie, comme le rappelait avec humour le premier ministre malaisien à son homologue français dans la cour de l’Élysée en juillet 2025 : « Avant que vous n’atteigniez le Cambodge pour le Sommet de la Francophonie, vous n’aurez aucune excuse de ne pas visiter la Malaisie. »

Paco Milhiet ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

06.01.2026 à 16:53

Du sauveur à l’éboueur : comment les lycéens perçoivent leurs éco-délégués

Lise Trégloze, Doctorante au Centre de Recherche sur l’Éducation, les Apprentissages et la Didactique, Université Rennes 2

Texte intégral (3205 mots)

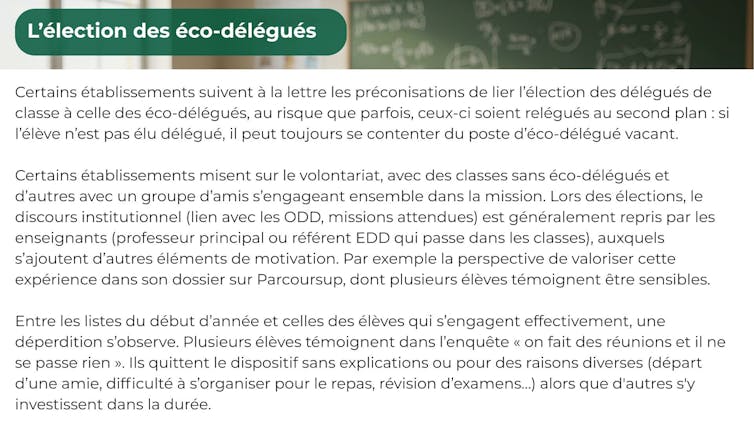

Voilà cinq ans que les élèves du secondaire ont l’obligation d’élire des éco-délégués dans chaque classe. Dans les faits cependant, cette intention n’est pas toujours respectée, et les perceptions quant à leur rôle varient fortement d’un établissement à l’autre.

À quoi servent les éco-délégués ? « Je ne sais pas », « aucune idée », « on n’a pas d’infos », ont répondu la moitié des 380 lycéens interrogés au sujet de leur expérience de l’éducation au développement durable dans leur lycée. Pourtant, chaque établissement scolaire a l’obligation d’organiser l’élection d’au moins un éco-délégué par classe, et ce depuis 2020.

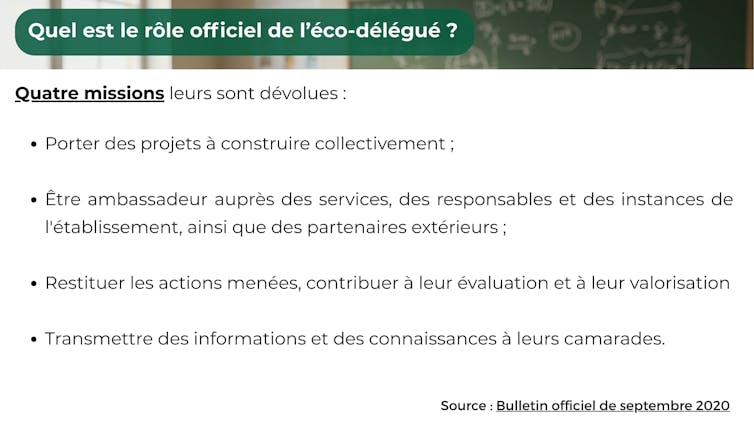

Considérés comme les « pivots du développement durable dans les établissements », l’État les exhorte à devenir les « acteurs du changement » au sein d’un « peuple de colibris », à travers la voix de Jean-Michel Blanquer, alors ministre de l’éducation nationale.

Cinq ans après cette mise en place obligatoire des éco-délégués, « la tension entre ces injonctions et les réalités du terrain » déjà évoquée en 2023 par les chercheuses Évelyne Bois, Aurélie Zwang et Mandarine Hugon, est toujours palpable.

À lire aussi : Être éco-délégués au collège ou au lycée : quels moyens d’action ?

Un bilan difficile à dresser en l’absence de données officielles

Le ministère de l’éducation nationale affiche certes l’ambition de 250 000 éco-délégués et promeut des ressources et dispositifs d’appui (guides pratiques, prix de l’action de l’éco-délégué, etc.). Cependant, aucun recensement officiel n’est disponible, ni à l’échelle de la direction de l’évaluation, de la prospective et de la performance (DEPP), ni à celle des académies, ni même parfois à celle des établissements. Il est donc compliqué de savoir si chaque classe compte actuellement une ou un éco-délégué. Le travail de terrain nous permet toutefois de déceler que cette obligation n’est pas toujours suivie dans les faits.

Pour tenter de comprendre malgré tout le rôle effectif des éco-délégués, plusieurs ressources sont néanmoins disponibles :

une enquête menée en 2023-2024 en région Bretagne auprès d’établissements engagés dans des projets d’éducation au développement durable (EDD), relevant de l’éducation nationale ou de l’enseignement agricole, du secteur public ou privé, de la voie générale ou professionnelle.

les quelques travaux existants en science de l’éducation sur l’engagement des éco-délégués.

un discret et polémique rapport parlementaire portant sur l’animation des éco-délégués.

À la rencontre des éco-délégués

Des 380 répondants au questionnaire administré auprès de lycéens de Bretagne, 85 % indiquent la présence d’éco-délégués dans leur établissement, même au sein d’un lycée n’ayant pas encore mis en place le dispositif. Moins de 5 % déclarent être eux-mêmes éco-délégué au moment de l’enquête.

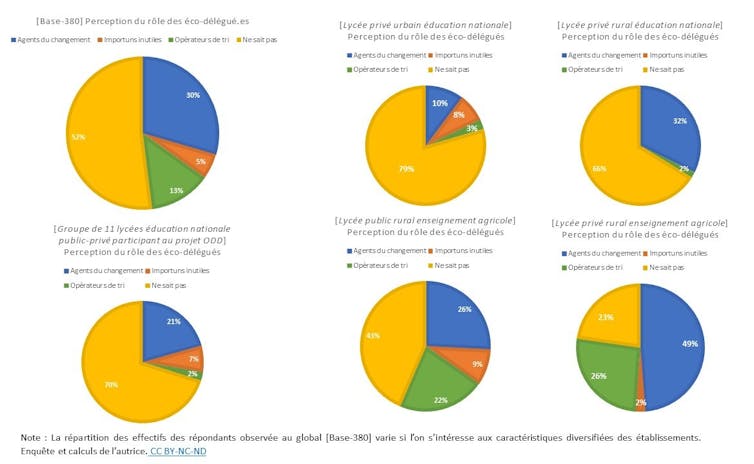

À la question « Quelles sont les activités menées par les éco-délégué·es ? », la réponse la plus fréquente (52 %) est donc « Je ne sais pas » ou sans réponse. La question étant ouverte, nous avons pu classer les réponses détaillées des 173 élèves ayant une idée des activités menées. Trois catégories d’acteurs peuvent alors se distinguer dans leurs perceptions du rôle des éco-délégués.

- Les « agents du changement » (30 %) : les éco-délégués sont avant tout perçus comme les prescripteurs des éco-gestes : ils « trouvent des activités sympas pour insister à ne pas polluer », note une lycéenne. Ils développent, souvent à l’aide de prestataires extérieurs, des nudges inspirés des théories du comportement, pour inciter à la préservation des ressources : une « affiche pour éteindre la lumière », un « autocollant qui se complète que lorsque l’on ferme la fenêtre », un « totem pour recycler le papier »… avec plus ou moins d’efficacité.

Ils peuvent aussi investir des espaces spécifiques, comme un potager, un jardin, un « club nature », ou contribuer à végétaliser la cour. Ils se réunissent souvent le midi, seul temps disponible pour les enseignants comme pour les élèves.

L’éco-délégué est parfois identifié comme l’ambassadeur dont on attend qu’il soit : celui qui « explique les actions et réfléchit à de nouvelles stratégies », qui « présente et propose les projets et motive les élèves », résument des enquêtés. Sa mission de sensibilisation peut progressivement consister à « s’interroger », « trouver des idées pour améliorer le monde pour plus tard », voire à « donner des cours aux camarades », énumèrent d’autres lycéens. Leurs actions « parfois petites mais qui font grandir le lycée » sont vues avec bienveillance. Ils contribuent à « améliorer la vie en communauté pour ne pas avoir à souffrir plus tard », assure une élève. Ils peuvent être perçus comme des innovateurs et apporter des solutions pour « sauver notre terre et l’améliorer », comme l’indique une éco-déléguée.

De façon très marginale, des actions en dehors de la sphère environnementale qui domine les discours sont parfois citées : comme de la sensibilisation sur le handicap, la mise en place de produits d’hygiène féminine ou des « boîtes à livres ».

« Les importuns inutiles » (5 %) : Pour certains, les éco-délégués ne font « rien », ou « pas grand-chose ». Leurs rencontres sont identifiées comme l’occasion de « rater les cours pour faire des réunions souvent inutiles » ou pour lesquelles « nous n’avons aucun retour », déplore un élève. Les élèves d’un lycée agricole public en zone rurale sont parmi ceux qui ont les mots les plus durs : les éco-délégués « nous cassent les oreilles » ou sont là « pour faire joli et apporter des idées qui n’aboutissent jamais ».

« Les opérateurs de tri » (13 %) : Les éco-délégués ramassent, trient, nettoient, compostent, luttent contre le gaspillage, construisent des poubelles, font des « clean walk » dans leurs lycées, dans leurs villes, sur les plages… Les déchets identifiés sont ceux qui sont visibles, comme le papier ou les mégots, alors que les déchets numériques qui ne cessent de croître ne sont pas mentionnés.

Agir sur les déchets demeure l’activité concrète la plus citée dans l’enquête : qu’elle soit l’unique action ou bien associée à d’autres, perçue de façon conforme aux attendus d’un éco-délégué « acteur du changement » ou de manière plus critique, comme chez ce lycéen qui ironise. « Ils ramassent les poubelles, on ne sait pas s’ils sont délégués ou éboueurs. »

Rappelons que la gestion des déchets dans un établissement scolaire public est une attribution des collectivités qui gèrent les bâtiments. Les projets des éco-délégués peuvent donc impliquer la collaboration d’agents de la collectivité qui sont rarement consultés et, au final, souvent dans l’incapacité de donner suite aux projets commencés, comme la création de composts abandonnés l’année suivante faute de personnel identifié pour les gérer. Il en est de même avec les actions des élèves autour des économies d’énergie dont la portée reste limitée face au défi que représente la rénovation énergétique des bâtiments scolaires, décidée à un tout autre niveau.

Sans remettre en cause l’importance de la gestion des déchets pour la cause écologique et sociale, nous pouvons cependant nous questionner sur l’intérêt d’en faire la mission principale des éco-délégués. Peu de réflexions sur l’origine de ces déchets (surconsommation, obsolescence programmée, mauvaise qualité, réglementation non respectée) ont été observées. Or, sans remise en cause du système à l’origine de la production de ces déchets, les éco-délégués risquent bien de n’occuper qu’une « fonction utilitariste au service des politiques libérales de croissance », pour reprendre les termes des chercheurs Jean-Marc Lange et Angela Barthes.

Un fort effet établissement

Le dispositif des éco-délégués peut également être perçu de manière très différente selon les contextes d’établissements. Dans l’enquête de terrain, les élèves de l’enseignement agricole considèrent les éco-délégués comme des « agents du changement » ou des « opérateurs du tri » dans une proportion supérieure aux attentes. Les élèves de l’éducation nationale suivant une voie de formation générale sont eux beaucoup plus que prévu à répondre ne pas savoir quelles sont les missions des éco-délégués.

Plus surprenant, les élèves d’un lycée pourtant labellisé « établissement en démarche de développement durable (E3D) » et ceux ayant participé à un projet régional sur les ODD (Objectifs de développement durable définis par les Nations unies) sont ceux qui affichent le plus haut pourcentage des « Je ne sais pas » (79 % et 70 %). À l’inverse, les élèves d’un lycée n’ayant pourtant pas encore organisé d’élections d’éco-délégués sont ceux qui les considèrent le plus comme « agents du changement » (49 %).

L’analyse du questionnaire indique par ailleurs que les perceptions des activités des éco-délégués ne varient pas significativement selon le genre, le niveau scolaire ni même selon le vécu scolaire : les élèves se déclarant en réussite ou en échec scolaire et les élèves déclarant avoir une expérience positive ou négative de leur scolarité ont des taux de réponse équivalents. Ainsi, l’effet établissement semble agir plus que le profil socio-scolaire des élèves sur leur perception du rôle de l’éco-délégué. Ces premiers résultats mériteraient cependant d’être consolidés à une échelle plus importante.

Enfin, qu’elle soit conforme aux prescriptions du ministère, restreinte aux déchets ou plus critique, la perception du rôle des éco-délégués se cantonne à la sphère écologique. Les systèmes politiques et économiques à l’origine de l’épuisement des ressources et de la surproduction de déchets ne sont quasiment jamais mentionnés. Cette dépolitisation de la question écologique, notamment dans un contexte scolaire, et « l’invisibilisation des enjeux sociaux » qui l’accompagne sont une tendance déjà bien repérée par les recherches en éducation, comme en témoigne le récent ouvrage d’Irène Pereira sur l’éco-pédagogie (2024).

Quant au profil socio-scolaire des éco-délégués, sans étude statistique nationale, difficile de dresser le portrait type. Le rapport parlementaire réalisé sur ce sujet par une députée de la majorité, dresse un panorama assez mitigé. Le dispositif des éco-délégué est accusé de renforcer les stéréotypes de genre en confiant les tâches du « care », et notamment du maintien de la propreté des lieux, aux filles plus qu’aux garçons. Constat déjà largement documenté en sociologie.

Si les éco-délégués perçoivent bien que l’on attend d’eux qu’ils soient force de propositions, ils sont pourtant dirigés, de manière explicite ou plus implicite, vers les actions déjà en cours ou impulsées par leurs encadrants, considérées comme réalisables et « allant dans le bon sens ». Un acteur du changement donc, mais dans les limites de l’acceptable.

Parmi les éco-délégués interrogés pendant l’enquête, certains s’épanouissent clairement dans leur mission, regrettent parfois qu’elle ne puisse pas s’étendre davantage ou se pérenniser d’une année sur l’autre ou d’un établissement à l’autre. Pour d’autres, elle est synonyme d’usure ou de déception, comme en témoigne cet éco-délégué élève de seconde (lycée privé, zone rurale) :

« C’est bien gentil de faire les petits gestes, mais un moment il va falloir faire les grands, et c’est pas le gouvernement qui s’en occupe. »

Tantôt colibris, tantôt ambassadeurs, tantôt sauveurs, tantôt éboueurs… les éco-délégués cumulent ainsi les casquettes sans véritables moyens pour agir, alors même que les défis auxquels ils sont censés répondre ne cessent de croître dramatiquement.

Certes, nous pouvons convenir que les cinq dernières années n’ont pas été de tout repos pour le milieu scolaire : crise sanitaire de la Covid et huit ministres de l’éducation nationale qui se sont succédé. Cependant, nous pouvons constater qu’après un engouement pour les enjeux de développement durable post-COP21, les moyens attribués au déploiement de l’éducation au développement durable peinent encore à être rassemblés à la hauteur des objectifs auxquels la France continue de s’engager, COP après COP.

À lire aussi : De COP en COP, une géopolitique de la procrastination climatique

Lise Trégloze a reçu une bourse de recherche doctorale de la région Bretagne (dispositif ARED).

06.01.2026 à 16:50

Comment promouvoir la durabilité grâce à des applications géolocalisées, sans pour autant inquiéter la vie privée des utilisateurs ?

Catherine Lejealle, Enseignant-chercheur en marketing digital, Responsable de l'axe de recherche Création de matériaux et cas pédagogiques, ISC Paris Business School

Renard Damien, Professeur en sciences de l'Information et de la Communication

Thierry Delécolle, Directeur général adjoint, Pôle Léonard de Vinci

Zhenzhen Zhao, Professeur associé, SKEMA Business School

Texte intégral (1021 mots)

En mettant en relation des inconnus autour du don, du partage et de la solidarité locale, les applications de géomatching apparaissent comme de puissants leviers des Objectifs de développement durable élaborés par l’ONU. Leur succès dépend pourtant d’un équilibre délicat entre impact sociétal, exposition des données personnelles et sentiment de sécurité.

Les 17 Objectifs de développement durable (ODD), élaborés par les Nations unies pour transformer le monde d’ici à 2030, nécessitent l’implication du plus grand nombre. Or, de nombreuses applications géolocalisées, fondées sur la mise en relation entre particuliers, offrent un potentiel considérable pour accélérer ce changement. Chaque ODD peut aujourd’hui s’appuyer sur des centaines d’initiatives de « géomatching ».

Pour l’ODD 1 (« pas de pauvreté »), par exemple, FallingFruit met à disposition des glaneurs plus de 4 039 ressources alimentaires distinctes, réparties sur près de deux millions de sites. GEEV permet de récupérer gratuitement des meubles près de chez soi, tandis qu’Olio facilite le partage des surplus alimentaires entre voisins grâce à une communauté de plus de 8 millions de membres.

Ces plates-formes génèrent des impacts concrets sur les trois piliers du développement durable :

Social : elles renforcent la solidarité locale et créent de nouveaux liens sociaux ;

Économique : elles réduisent la pauvreté et améliorent le quotidien de chacun ;

Environnemental : elles diminuent les déchets et prolongent la durée de vie des objets.

Une épineuse question de sécurité

Cependant, leur fonctionnement repose sur la divulgation de données personnelles, notamment la géolocalisation reconnue comme particulièrement sensible par la Commission européenne. Contrairement aux transactions classiques sur des plates-formes comme Leboncoin ou Vinted, les applications de géomatching impliquent souvent une rencontre physique, parfois au domicile d’un particulier.

Aller chez un inconnu ou accueillir un inconnu chez soi n’est pas anodin. La confiance que l’on peut accorder à une marque pour personnaliser des offres ne suffit plus : ici, les données doivent être partagées directement avec d’autres utilisateurs. Ce besoin de sécurité explique le succès d’applications comme Gensdeconfiance, fondées sur la recommandation entre membres.

Les risques perçus sont renforcés par le contexte : augmentation des violations de données, multiplication des infox, usurpations d’identité… Les internautes sont méfiants : 72 % se disent préoccupés par la traçabilité de leurs activités en ligne (enquête de l’Insee auprès des ménages sur les technologies de l’information et de la communication de 2021) surtout que les violations notifiées à la CNIL ont augmenté de 20 % en 2024. Ainsi 76 % ont limité ou renoncé, selon l’enquête Insee TIC de 2019, à une activité en ligne à cause de craintes sur la sécurité.

Une piste : la présence sociale

Face à ces inquiétudes, une piste prometteuse émerge : la présence sociale. Elle désigne la capacité d’une interface numérique à faire ressentir une présence humaine. En humanisant l’expérience, elle rassure et contrebalance partiellement le sentiment de sacrifice inhérent au partage de données personnelles. Elle donne à l’utilisateur l’impression d’intégrer une communauté active, plutôt que de confier ses informations à un espace impersonnel.

Concrètement, cette présence sociale peut être renforcée grâce à des indicateurs communautaires :

nombre de visites déjà effectuées chez un membre,

quantité de fruits glanés,

photos du lieu,

retours d’expérience visibles et authentifiés.

Plutôt que de mettre en avant les « meilleures ventes » comme le font de nombreuses plates-formes, le design de l’application pourrait valoriser les interactions réelles, les contributions et les preuves d’activité. Cela rendrait la communauté plus vivante, plus incarnée, et donc plus rassurante.

Le rôle ambivalent des algorithmes

Dans les applications de géomatching, la confiance ne repose pas uniquement sur des recommandations explicites, comme dans Gensdeconfiance, mais aussi sur cette impression de proximité humaine. Les algorithmes et l’IA ont un rôle ambivalent : ils peuvent enrichir cette présence (avec, par exemple, des agents conversationnels sociaux) ou au contraire nourrir la méfiance (en renforçant la crainte des faux avis ou des profils fictifs). L’enjeu est donc de concevoir des technologies qui servent la confiance, plutôt que de l’éroder.

Si ces conditions sont réunies, les applications de géomatching pourraient connaître une adoption bien plus large et contribuer véritablement à l’atteinte des 17 ODD. Alors, pourquoi ne pas commencer dès maintenant à explorer ces initiatives et à agir, à votre échelle, en faveur de la planète ?

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

06.01.2026 à 16:48

Ce que l’Athènes antique nous enseigne sur le débat – et la dissidence – à l’ère des réseaux sociaux

Sara Kells, Director of Program Management at IE Digital Learning and Adjunct Professor of Humanities, IE University

Texte intégral (1620 mots)

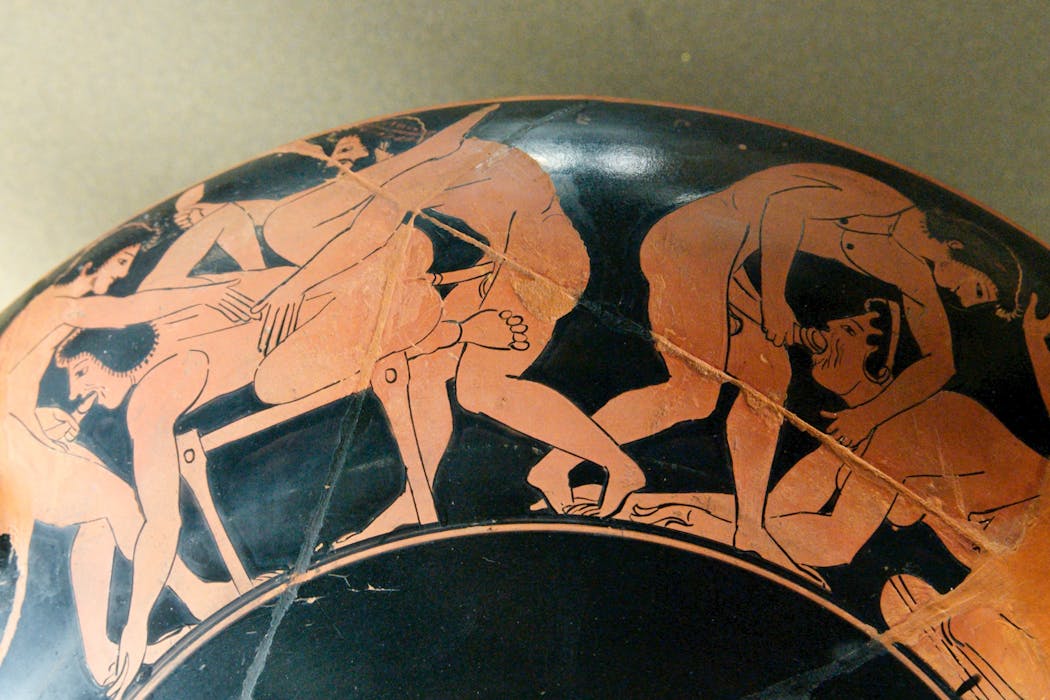

Dans l’Athènes antique, l’agora était un forum public où les citoyens pouvaient se réunir pour délibérer, débattre et prendre des décisions ensemble. Elle était régie par des principes sociaux profondément enracinés qui garantissaient des débats animés, inclusifs et sains.

Aujourd’hui, nos places publiques se sont déplacées en ligne vers les flux numériques et les forums des réseaux sociaux. Ces espaces sont pour la plupart dépourvus de règles et de codes communautaires. Ce sont plutôt des algorithmes qui décident quelles voix s’élèvent au-dessus du tumulte et lesquelles sont étouffées.

L’idée optimiste selon laquelle Internet serait un espace radicalement démocratique semble désormais un lointain souvenir. Nos conversations sont désormais façonnées par des systèmes opaques conçus pour maximiser l’engagement, et non la compréhension mutuelle. C’est la popularité algorithmique, et non l’exactitude ou la diversité des voix, qui détermine la portée des propos publiés en ligne.

Cela a créé un paradoxe. Nous jouissons d’une liberté d’expression sans précédent, mais notre discours est limité par des forces qui échappent à notre contrôle. Les voix fortes dominent. Les voix nuancées s’estompent. L’indignation se propage plus vite que la réflexion. Dans ce contexte, la participation égalitaire est pratiquement inaccessible, et s’exprimer honnêtement peut comporter un risque très réel.

Entre les marches de pierre d’Athènes et les écrans d’aujourd’hui, nous avons perdu quelque chose d’essentiel à notre vie démocratique et à notre dialogue : l’équilibre entre l’égalité de la parole et le courage de dire la vérité, même lorsque cela est dangereux. Deux anciens idéaux athéniens de liberté d’expression, l’isegoria et la parrhesia, peuvent nous aider à le retrouver.

Des idées anciennes qui nous guident encore aujourd’hui

À Athènes, l’isegoria désignait le droit de s’exprimer, mais elle ne se limitait pas à un simple droit. Elle représentait une responsabilité partagée, un engagement en faveur de l’équité et l’idée que la vie publique ne devait pas être gouvernée uniquement par les puissants.

Le terme parrhesia peut être défini comme l’audace ou la liberté d’expression. Là encore, il y a une nuance : la parrhesia n’est pas une franchise imprudente, mais un courage éthique. Elle désignait le devoir de dire la vérité, même lorsque celle-ci provoquait un malaise ou un danger.

Ces idéaux n’étaient pas des principes abstraits. Il s’agissait de pratiques civiques, apprises et renforcées par la participation. Les Athéniens comprenaient que le discours démocratique était à la fois un droit et une responsabilité, et que la qualité de la vie publique dépendait du caractère de ses citoyens.

La sphère numérique a changé le contexte, mais pas l’importance de ces vertus. L’accès seul ne suffit pas. Sans normes qui soutiennent l’égalité des voix et encouragent la vérité, la liberté d’expression devient vulnérable à la distorsion, à l’intimidation et à la manipulation.

L’émergence de contenus générés par l’intelligence artificielle (IA) intensifie ces pressions. Les citoyens doivent désormais naviguer non seulement parmi les voix humaines, mais aussi parmi celles produites par des machines qui brouillent les frontières entre crédibilité et intention.

Quand être entendu devient un privilège

Sur les plateformes contemporaines, la visibilité est répartie de manière inégale et souvent imprévisible. Les algorithmes ont tendance à amplifier les idées qui suscitent des émotions fortes, quelle que soit leur valeur. Les communautés déjà marginalisées peuvent se retrouver ignorées, tandis que celles qui prospèrent grâce à la provocation peuvent dominer la conversation.

Sur Internet, l’isegoria est remise en question d’une nouvelle manière. Peu de personnes en sont formellement exclues, mais beaucoup sont structurellement invisibles. Le droit de s’exprimer demeure, mais la possibilité d’être entendu est inégale.

Dans le même temps, la parrhesia devient plus précaire. S’exprimer avec honnêteté, en particulier sur des questions controversées, peut exposer les individus à du harcèlement, à des déformations ou à une atteinte à leur réputation. Le prix du courage a augmenté, tandis que les incitations à rester silencieux ou à se réfugier dans des chambres d’écho se sont multipliées.

À lire aussi : Social media can cause stress in real life – our 'digital thermometer' helps track it

Former des citoyens, pas des spectateurs

Les Athéniens avaient compris que les vertus démocratiques ne surgissent pas toutes seules. L’isegoria et la parrhesia se maintenaient grâce à des habitudes acquises au fil du temps : écouter était considéré comme un devoir civique, parler comme une responsabilité partagée, tout en reconnaissant que la vie publique dépendait de la personnalité de ses participants. À notre époque, c’est à travers l’éducation civique que les citoyens mettent en pratique les dispositions requises par le discours démocratique.

En transformant les salles de classe en agoras à petite échelle, les élèves peuvent apprendre à vivre la tension éthique entre l’égalité des voix et l’intégrité de la parole. Les activités qui invitent au dialogue partagé, à la prise de parole équitable et à l’attention portée aux voix les plus discrètes les aident à faire l’expérience de l’isegoria, non pas comme un droit abstrait, mais comme une pratique vécue de l’équité.

Dans la pratique, cela prend la forme de discussions et de débats au cours desquels les élèves doivent vérifier des informations, formuler et justifier des arguments, réviser leurs opinions publiquement ou débattre de manière respectueuse avec des arguments contraires. Toutes ces compétences cultivent le courage intellectuel associé à la parrhesia.

Il est important de noter que ces expériences ne dictent pas ce que les élèves doivent croire. Elles leur permettent plutôt de s’exercer à adopter des habitudes qui les rendent responsables de leurs convictions : la discipline de l’écoute, la volonté d’exposer ses arguments et la disposition à affiner sa position à la lumière de nouvelles connaissances. De telles pratiques rétablissent le sentiment que la participation démocratique n’est pas seulement liée à la liberté d’expression individuelle, mais relationnelle et construite grâce à un effort commun.

Ce que l’éducation civique offre en fin de compte, c’est de la pratique. Elle crée des agoras miniatures où les élèves s’entraînent aux compétences dont ils ont besoin en tant que citoyens : s’exprimer clairement, écouter généreusement, remettre en question les idées reçues et dialoguer avec ceux qui pensent différemment.

Ces habitudes contrebalancent les pressions du monde numérique. Elles ralentissent la conversation dans des espaces conçus pour la rapidité. Elles introduisent la réflexion dans des environnements conçus pour la réaction. Elles nous rappellent que le discours démocratique n’est pas une performance, mais une responsabilité partagée.

Retrouver l’esprit de l’agora

Le défi de notre époque n’est pas seulement technologique, mais aussi éducatif. Aucun algorithme ne peut enseigner la responsabilité, le courage ou l’équité. Ce sont des qualités qui s’acquièrent par l’expérience, la réflexion et la pratique. Les Athéniens l’avaient compris intuitivement, car leur démocratie reposait sur la capacité des citoyens ordinaires à apprendre à s’exprimer d’égal à égal et avec intégrité.

Nous sommes confrontés au même défi aujourd’hui. Si nous voulons des places publiques numériques qui soutiennent la vie démocratique, nous devons préparer les citoyens à les utiliser à bon escient. L’éducation civique n’est pas un enrichissement facultatif, c’est le terrain d’entraînement des habitudes qui soutiennent la liberté.

L’agora a peut-être changé de forme, mais son objectif demeure. Se parler et s’écouter d’égal à égal, avec honnêteté, courage et attention, reste au cœur de la démocratie. Et c’est quelque chose que nous pouvons enseigner.

Sara Kells ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

06.01.2026 à 15:32

Le Venezuela, un dominion des États-Unis ?

Florent Parmentier, Secrétaire général du CEVIPOF. Enseignant, Sciences Po

Cyrille Bret, Géopoliticien, Sciences Po

Texte intégral (2099 mots)

Dans la nuit du 2 au 3 janvier 2026, les forces armées américaines ont lancé et conduit l’opération militaire massive « Absolute resolve » afin de kidnapper le président vénézuélien Nicolas Maduro au palais Miraflores, à Caracas. Dans la foulée, Donald Trump a annoncé que les États-Unis « dirigeraient » temporairement le Venezuela en attendant la prise de pouvoir d’un gouvernement favorable aux États-Unis (like minded). Pourtant, la vice-présidente Delcy Rodriguez, légalement au pouvoir depuis l’incarcération de Maduro, annonce désormais son intention d’assumer la direction de l’État. Quel destin se prépare pour le pays, entre interventionnisme trumpiste, sursaut nationaliste anti-impérialiste et protestations internationales ?

Une intervention militaire conduite sans base légale et au nom de la « sécurité des États-Unis » ; la destitution et l’emprisonnement du dictateur au pouvoir ; l’annonce de la future prise de contrôle du pays par les forces armées et les entreprises états-uniennes : tout cela rappelle l’opération contre l’Irak et Saddam Hussein de 2003.

Le parallèle avec l’opération irakienne – officiellement destinée à prévenir l’usage d’armes de destruction massive (demeurées introuvables) – est limité : cette fois, derrière le prétexte de la lutte contre le « narcoterrorisme », Donald Trump reconnaît sans ambages le rôle clé qu’occupent les ressources pétrolières dans les motivations profondes de cette opération. Ceux qui veulent y voir une défense de la démocratie en seront pour leurs frais : la promotion de la démocratie et la lutte contre les dictatures sont au centre des discours européens, mais pratiquement absents de ceux de l’équipe Trump.

En outre, l’invasion de 2003 visait à détruire l’État du parti Baas irakien ; or, ce n’est pas l’opposante Maria Corina Machado, prix Nobel de la paix 2025, qui est appelée à gouverner le Venezuela, mais la vice-présidente en exercice Delcy Rodriguez. La situation fait dès lors penser, à ce stade, à l’accaparement des ressources vénézuéliennes par une puissance extérieure, couplé à un lâchage interne de Maduro au sein du régime, quand bien même Rodriguez a exigé sa libération.

Par conséquent, la question cruciale n’est sans doute pas « qui gouverne », mais « comment gouverner après ».

Le Venezuela de Rodriguez, entre souveraineté limitée et nationalisme blessé

L’enlèvement de Nicolas Maduro n’empêche pas la Constitution vénézuélienne de 1999 de continuer de s’appliquer.

L’opération militaire conduite par les États-Unis destitue un des titulaires du pouvoir, mais ne transforme pas mécaniquement les structures politiques, sociales ou économiques du pays. Elle introduit en revanche une contrainte durable. Le nouveau régime doit gouverner sous le regard simultané d’une puissance extérieure tutélaire, qui a montré sa capacité d’intervention, et dont sa survie dépend aujourd’hui, et d’une société nationale très attentive aux signes d’autonomie ou de mise sous tutelle, et foncièrement divisée.

Cette tension place le pouvoir de Delcy Rodriguez dans une double contrainte : d’une part, éviter une nouvelle intervention en se conciliant la faveur de l’administration Trump ; d’autre part, satisfaire les aspirations de la population au respect d’une souveraineté mise à mal par l’ingérence américaine. En un mot, elle doit combiner survie face à Trump et rhétorique nationaliste compensatoire : elle a par exemple dénoncé la teneur « sioniste » (comprenez colonisatrice) de l’expédition américaine, qualifiée de « kidnapping » et de « barbarie » violant le droit international.

Si Rodriguez et son entourage optent pour un discours trop musclé et offensif à l’égard de Washington, cela offrira à Donald Trump un prétexte pour procéder à un changement de régime complet, ce qui supposerait une action et un investissement beaucoup plus conséquents. Le Venezuela vit donc dorénavant dans un régime de « souveraineté limitée », comme l’annonçait en décembre la nouvelle stratégie nationale de sécurité américaine.

À lire aussi : L’internationale trumpiste : la Stratégie de sécurité nationale 2025 comme manifeste idéologique

Dans ce contexte, trois destinées sont aujourd’hui ouvertes pour le pays.

Scénario 1, le chavisme sans Chavez ni Maduro : un Thermidor caribéen sous surveillance états-unienne

Premier scénario : une continuité réelle malgré une rupture affichée. Pour les élites bolivariennes, lâcher Maduro a peut-être été le prix à payer pour sauver l’État, restaurer une forme de rationalité, sortir le pays de l’isolement.

Les visages changent à peine, les uniformes pas encore. Durant les six premiers mois, les sanctions américaines pourraient être partiellement suspendues, les marchés pourraient réagir avec prudence, et les institutions seraient « normalisées » plutôt que transformées. Dans ce scénario, le nouveau pouvoir ne parle que de stabilité, jamais de refondation, et gouverne par décrets techniques sous la surveillance discrète des États-Unis, dont l’attention sera focalisée sur la possession des champs pétroliers.

Au bout d’un an, la démocratie revendiquée par les opposants au chavisme sera renvoyée à plus tard, et les structures du pouvoir resteront quasiment intactes. Comme lors du 9-Thermidor en 1794, les excès ont été liquidés, pas le système.

Scénario 2, la souveraineté limitée : un « moment Kadar » tropical

Tout commence par une fracture interne inattendue. Ni chaviste orthodoxe ni opposition traditionnelle, un nouveau centre de gravité politique émerge dans l’entre‑deux, porté par des acteurs fatigués des extrêmes et décidés à stabiliser le pays. Les différentes oppositions (MAGA-compatibles ou non) convergent et s’allient aux « chavistes modérés » (gouverneurs pragmatiques, militaires de second rang, technocrates issus du Parti socialiste unifié du Venezuela (PSUV)

– la formation chaviste –, qui veulent éviter l’effondrement total) pour proposer au pays un régime de transition qui garantit une certaine souveraineté nationale. Dans les six premiers mois, un pacte social minimal est proposé, la coercition recule temporairement, et l’économie redémarre grâce à une série de mesures pragmatiques.

La surprise vient de la société elle‑même : la demande de « vie normale » devient dominante, affaiblissant (peut-être momentanément) la polarisation. Le pays semble entrer dans une phase de pacification inattendue, presque involontaire.

Mais au bout de quelques mois, probablement vers l’automne 2026, surgissent des troubles internes : grèves sectorielles, protestations corporatistes, tensions régionales. Rien de décisif pour la stabilité du régime, mais suffisamment pour rappeler que celui-ci reste fragile. Le pouvoir répond par une combinaison de concessions ciblées et de fermeté mesurée, évitant l’escalade tout en réaffirmant son autorité.

Ces turbulences, paradoxalement, renforcent le récit du compromis : le régime se présente comme le seul capable de contenir le chaos sans revenir à la répression systématique. Comme avec le pouvoir de Janos Kadar instauré en Hongrie après 1956 (à la suite de l’écrasement par l’URSS de l’insurrection de Budapest), ce n’est ni une victoire idéologique ni une défaite politique : c’est la fatigue historique qui gouverne, et la société accepte le compromis, faute de mieux.

Dans ce scénario, les États-Unis jouent un rôle bien plus important : ils soutiennent l’arrivée au pouvoir d’un dirigeant d’inspiration MAGA à Caracas, à l’instar des Soviétiques qui ont porté Janos Kadar à la tête de la Hongrie.

Scénario 3, une évolution à la cubaine pré-castriste : un dominion américain

Si la souveraineté reste intacte sur le papier, la capacité de négociation du pouvoir chaviste est déjà très entamée en ce début d’année 2026. Une fois installé le nouveau leadership, soutenu par Washington et aligné sur ses priorités, vient alors la phase de réouverture sous contrainte : levée conditionnelle des sanctions, retour des majors états-uniennes, accords d’exploitation conclus dans l’urgence. Les nouveaux contrats s’étendent sur des décennies, verrouillés par des clauses de stabilisation et une fiscalité avantageuse pour les intérêts des majors. Le pétrole demeure vénézuélien, mais la rente, elle, devient extraterritoriale, profitable aux milieux économiques des États-Unis.

La troisième phase consacre la captation de la valeur : technologies, assurances, transport et raffinage sont externalisés, les revenus rapatriés hors du pays, et l’État réduit à une fonction fiscale minimale. Le Venezuela produit beaucoup, capte peu et dépend désormais de flux qu’il ne contrôle plus.

Enfin, cette dépendance se normalise. Le récit dominant affirme que « c’est le prix de la stabilité » ; la souveraineté pétrolière est dépolitisée ; et les fractures sociales s’approfondissent. Le pillage n’est plus seulement visible : il est institutionnalisé.

En somme, le Venezuela subit le sort de Cuba entre l’adoption de l’amendement Platt (1901), qui officialisa le droit d’ingérence des États-Unis sur la République de Cuba, et la révolution castriste (1959) : il devient un dominion des États-Unis.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

06.01.2026 à 15:27

Denaturalization in the Trump era: When the State questions the citizenship of millions of Americans

Ashley Mantha-Hollands, Max Weber Fellow, Max Weber Programme for Postdoctoral Studies, European University Institute

Texte intégral (2436 mots)

It is recognised in US law that the government may not take away a naturalized person’s citizenship except in cases of fraud or error on a naturalization application. The Supreme Court has clearly established that unless citizenship was unlawfully procured, denaturalization is unconstitutional. However, a memo issued by the Department of Justice (DoJ) in June attempts to broaden the grounds for denaturalization, potentially putting over 24.5 million naturalized US citizens at risk.

The memo states that the current US administration has directed the DoJ’s Civil Division to “advance the administration’s policy objectives”, among which is “prioritizing denaturalization”. Under this directive, the division is to investigate individuals who either “illegally procured” or “conceal[ed] a material fact” in their naturalization applications. The text outlines 10 “categories” of priority cases, which include individuals who “pose a potential danger to national security”; who “engaged in various forms of financial fraud”, including fraud associated with the Medicaid and Medicare healthcare programmes; and “any other cases referred to the Civil Division that the Division determines to be sufficiently important to pursue”.

The memo could broaden the scope of grounds previously used for denaturalization and will likely face legal challenge. Since September, the DoJ has filed denaturalization complaints against individuals for reasons such as providing false testimony and concealing identity, and for other crimes. In November, following a DoJ complaint filed in August, a US judge revoked the citizenship of a naturalized individual who had pleaded guilty to conspiracy to commit health care fraud. President Donald Trump, in a recent post on Truth Social, reaffirmed his commitment to “denaturalize migrants who undermine domestic tranquillity” and further stated, on November 30, in response to a shooting in Washington, DC, “if I have the power to do it… I would denaturalize, absolutely”.**

The DoJ memo represents a departure from 50 years of US policy between 1967 and mid-June 2017 – nearly five months into Donald Trump’s first term as president. During this period, the practice of citizenship stripping was rare and used primarily in extreme cases, such as for war criminals. In contrast, between 1906 and 1967, the US denaturalized more citizens than any other democracy. Several news and academic sources have highlighted what some see as similar motivations behind the current administration’s directive and past initiatives. It is also important to note that the DoJ memo will afford a discretion that could be much wider than in the past.

Denaturalization in the 20th Century

The original purpose of denaturalization in the US, put into force by the Naturalization Act of 1906, was to wipe out so-called “disbelievers in organized government” from society. The early cases were against political dissidents – some self-described, and some alleged socialists, anarchists and radicals – and often included journalists or labour unionists. One notable case is that of Emma Goldman, the first person to be denaturalized for her political views. Goldman was an anarchist who eventually lost her citizenship due to her activism against US involvement in the First World War. Denaturalization for political views was linked to two provisions in naturalization law: the requirement that a person have “good moral character” and that applicants be “attached to the principles of the US Constitution.”

One of the largest citizenship-stripping campaigns started in the 1940s, after the Nationality Act of 1940 gave naturalization authority to the DoJ. Once more, the primary targets were those with so-called “subversive” beliefs, particularly those with any affiliations to the Communist Party or the German American Bund. After the government denaturalized more than 22,000 people, this particular wave was halted by the Supreme Court in 1943, which declared that a person could not be denaturalized without “clear, unequivocal, and convincing evidence” that they were planning for the violent overthrow of the government. This became a standard impossible to prove, and cases of denaturalization subsided. In 1967, the Court decided that denaturalization was altogether unconstitutional except in cases of fraud or error in a naturalization application, and since, there have been only a handful of cases per year.

The DoJ memo doesn’t refer to ideological views such as “communism” or “socialism”, although the policy manual for US Citizen and Immigration Services (USCIS) states that an individual may be denaturalized “if the person becomes a member of, or affiliated with, the Communist party”. However, the first priority in the memo mentions anyone who “[poses] a potential danger to national security”, which can be broadly interpreted.

Threatening comments

In July, Trump made comments that raised questions about whether the beliefs of some naturalized individuals may put them at risk. These comments were about New York City mayor-elect Zohran Mamdani and actor Rosie O’Donnell. After US Congressman Andy Ogles threatened Mamdani, then a mayoral candidate, with a denaturalization investigation for rap lyrics Mamdani wrote in 2017 that Ogles viewed as “publicly praising” individuals convicted of supporting the militant Palestinian group Hamas, Trump said “a lot of people are saying he’s here illegally” and “we’re going to look at everything”. And the president threatened the birthright citizenship of O’Donnell, who was born in New York, saying that she “is not in the best interests of our Great Country”. Because O’Donnell is a natural-born citizen, there is no provision in US law to revoke her citizenship unless she provides her explicit consent. It’s also worth noting that Trump said he would “take a look” into the question of deporting billionaire Elon Musk, who became a naturalized citizen in 2002, after the Tesla CEO criticised the spending bill that passed into law in early July.“

Threatening denaturalization for opinions or statements, that while perhaps controversial are peaceful, reaches much further than the historical standard of believing in the "violent takeover of government” used to start a denaturalization proceeding in the past. Such threats generate a climate of fear where certain individuals and groups may be scared to voice opinions out of the threat of ending up in a denaturalization trial.

The expanded notion of ‘fraudulent acquisition’

Since 1967, fraudulent acquisition of citizenship has been the exclusive justification for denaturalization. Up until recently, this has been interpreted as a nondisclosure of information on a naturalization application that would have impacted the outcome of the application.

There has been an increasing number of investigations of fraudulent acquisition since 2008, the year that saw “Operation Janus”. This Obama-era policy targeted individuals who had been sent a deportation letter as an immigrant but had subsequently naturalized using a different name. The main driver was the digitization of records and fingerprint testing, which made it easier to identify discrepancies. In 2016, Trump expanded the operation to allow USCIS to investigate over 700,000 cases, marking the first push to “revive denaturalization”.

As scholars have argued, identifying fraud or a mistake is not always clear cut. For example, the US naturalization form asks whether a person has ever committed a crime, but does not specify what is included in its definition of a crime. It is unknown whether a crime committed in another jurisdiction that is not a crime under US law would count. This could have implications for same-sex couples or trans persons who come from countries where their status is illegal – such as in Uganda.

The June DoJ memo further expands what is considered as fraud for denaturalization to include instances of “loan fraud” or “Medicaid/Medicare fraud.” These types of fraud would likely not have previously met the standard of “willful misrepresentation” or “concealing material fact” that would have impacted the outcome of the naturalization process, since they are not related to a person’s immigration history.

Looking at denaturalization through the lens of race

While the memo does not mention race or ethnicity, some lawyers and legal scholars are concerned that, read alongside other developments in the current administration’s management of immigration, it will disproportionately affect certain minority and low-income communities.

Historically, race has been an explicit factor in immigration and denaturalization. Up until 1952, US citizenship law stated that only “white persons, persons of African nativity or descent, and descendants of races indigenous to the Western hemisphere” could be naturalized. In the 1920s, more than 50 naturalized individuals of Indian origin had their citizenship revoked after the Supreme Court decided that people from India were not “white” in “the understanding of the common man”

The DoJ memo came nearly three months after the deportation of hundreds of Venezuelan men with tenuous or non-existent ties to gangs or drug cartels, and nearly two months before a Supreme Court decision that allowed Immigration and Customs Enforcement (ICE) agents to use racial profiling in immigration raids in Los Angeles.

Some human rights groups and journalists have compared ICE immigration enforcement to how the US “War on Drugs” fuelled the mass incarceration of certain low-income and minority groups. As Sarah Tosh, a professor at Rutgers University, wrote in 2021, “these processes draw from a long history of targeted drug enforcement that has served to scapegoat, punish, and exclude immigrants and native-born racial minorities”.

Repeat of history or something bigger?

Unlike some European countries, the US previously had strong safeguards against denaturalization since the Supreme Court’s 1967 ruling. Since the end of September, the government has filed at least thirteen denaturalization actions (exact numbers are not publicly available), 11 of these actions were filed and publicly disclosed between September 30 and January 20, 2025, the beginning of Trump’s second term.

The “One Big Beautiful Bill Act” that passed in July allocated more than $3 billion in additional funds to the DoJ to exercise the administration’s immigration priorities – such as hiring immigration judges, staffing, and investigations.

The expansion of the potential grounds for denaturalization, the upcoming Supreme Court review of birthright citizenship, and even Ohio Senator Bernie Moreno’s recently proposed legislation to ban dual citizenship mark the potential for some of the most fundamental shifts in US citizenship to date. While some have rightly made the connection between present and past denaturalization initiatives, it remains to be seen how the Justice Department will make use of the memo’s criteria for denaturalization during the rest of Trump’s mandate.

Ashley Mantha-Hollands ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

06.01.2026 à 15:01

Apprendre les maths autrement : les pistes de la recherche

Florence Peteers, MCF Didactique des mathématiques, CY Cergy Paris Université

Elann Lesnes, Maître de conférences en didactique des mathématiques, Université de Rouen Normandie

Texte intégral (1632 mots)

Si les mathématiques sont unanimement considérées comme décisives dans notre société, elles suscitent nombre de craintes chez les élèves. Les rendre plus accessibles suppose donc de changer leur enseignement. Mais comment ? Le succès de situations « adidactiques » offre quelques pistes à la recherche. Explications.

Parus en décembre 2025, les résultats de la grande consultation nationale sur la place des mathématiques lancée par le CNRS montrent que beaucoup de Français se sentent peu à l’aise avec les mathématiques même s’ils reconnaissent l’importance de cette discipline pour la société. À la suite de cette consultation et des Assises des mathématiques de 2022, le CRNS a défini des orientations prioritaires, dont l’amélioration de l’inclusion. Mais comment rendre les mathématiques plus accessibles à tous ?

Les participants à la consultation de 2025 suggèrent notamment de « généraliser des méthodes d’enseignement variées, concrètes, ludiques et encourageantes, qui valorisent notamment le droit à l’erreur, tout au long de la scolarité ».

Dans ce sens, depuis plusieurs années, nous expérimentons dans des classes ordinaires (avec l’hétérogénéité des profils d’élèves qui les caractérisent !) des séquences de mathématiques inclusives. En quoi se distinguent-elles des modes d’enseignement classiques ? Et que nous apprennent leurs résultats ?

Mettre l’élève en situation de recherche

Ces séquences de maths inclusives s’appuient sur des situations à dimension adidactique, c’est-à-dire des situations qui intègrent des rétroactions de sorte que l’élève n’ait pas besoin que l’enseignant lui apporte des connaissances. C’est en interagissant avec la situation et en s’adaptant aux contraintes de celle-ci que l’élève construit de nouvelles connaissances. Il ne le fait pas en essayant de deviner les intentions didactiques de l’enseignant (c’est-à-dire en essayant de deviner ce que l’enseignant veut lui enseigner), d’où l’appellation « adidactique ».

Comme le dit le spécialiste de l’enseignement des maths Guy Brousseau, à l’origine de ce concept dans les années 1970-1980 :

« L’élève sait bien que le problème a été choisi pour lui faire acquérir une connaissance nouvelle, mais il doit savoir aussi que cette connaissance est entièrement justifiée par la logique interne de la situation et qu’il peut la construire sans faire appel à des raisons didactiques. »

Ces situations ont un potentiel identifié depuis longtemps et mis à l’épreuve dans les classes à grande échelle depuis 40 ans (surtout du premier degré, notamment dans l’école associée au Centre d’observation et de recherches sur l’enseignement). Ces travaux ont également donné lieu à des ressources pour les enseignants, par exemple la collection Ermel.

Dans le cadre de nos recherches, nous avons, par exemple, conçu et testé dans plusieurs écoles (REP+, milieu rural, milieu urbain…) une séquence en CM1-CM2 qui s’appuie sur la situation des napperons de Marie-Lise Peltier. Les élèves y ont à disposition une feuille de papier carrée, ils doivent reproduire un modèle de napperon en pliant et en découpant leur feuille. C’est la notion de symétrie axiale qui permet de découper un napperon conforme au modèle, et l’élève peut s’autovalider en comparant sa production au modèle donné.

Mettre en œuvre une situation à dimension adidactique peut s’avérer complexe, car le rôle de l’enseignant diffère de ce dont il a l’habitude ; ici, il n’apporte pas directement les connaissances même s’il peut aider les élèves à résoudre la tâche.

De plus, les élèves peuvent élaborer des stratégies très diverses, ce qui peut les déstabiliser. Cependant, cette diversité constitue également une richesse du point de vue de l’inclusion, car chaque élève peut s’investir à la hauteur de ses moyens. Par ailleurs, ces situations permettent de stimuler l’engagement des élèves et les mettent dans une véritable activité de recherche, ce qui constitue le cœur des mathématiques.

Donner du sens aux notions mathématiques

À l’heure actuelle, ce type de situations est peu mis en œuvre, en particulier auprès des élèves en difficulté, car les enseignants ont plutôt tendance à penser qu’il faut découper les problèmes complexes en tâches les plus simples possibles pour s’assurer de la réussite des élèves. Cependant, la réalisation juxtaposée de tâches simples et isolées ne permet pas, souvent, de donner du sens aux notions mathématiques en jeu ni de motiver les élèves.

Dans l’exemple autour des napperons, nous avons constaté qu’en s’appuyant sur les rétroactions, mais aussi parfois sur leurs pairs et sur les conseils de l’enseignant, la majorité des élèves de CM1-CM2 que nous avons observés réussit à produire un napperon conforme au modèle, alors même que, parmi ces élèves, plusieurs avaient été signalés comme étant « en difficulté ».

Même les élèves n’étant pas arrivés à produire un napperon conforme dans le temps imparti se sont fortement engagés, comme en témoigne le nombre important de réalisations. Nous pouvons faire l’hypothèse que cette situation pourra constituer une situation de référence pour eux quand ils aborderont de nouveau la notion de symétrie axiale.

À lire aussi : Six façons de faire aimer les maths à votre enfant

Les aspects positifs et les défis que nous avons pu identifier dans notre recherche corroborent les résultats obtenus par d’autres chercheurs et chercheuses qui ont étudié la mise en œuvre de situations à dimension adidactique pour travailler diverses notions mathématiques, à différents niveaux scolaires, auprès de publics variés, notamment auprès d’élèves présentant une déficience intellectuelle ou un trouble dys, en France et au Québec.

Ainsi, même si ce concept n’est pas nouveau, l’appui sur les situations à dimension adidactique nous semble toujours une piste intéressante et actuelle pour penser l’enseignement des mathématiques pour tous. Cependant, il est nécessaire de donner aux enseignants les moyens de les mettre en œuvre de manière satisfaisante, par exemple en allégeant le nombre d’élèves par classe et en les accompagnant en formation initiale et continue.

Florence Peteers est porteuse de la Chaire Junior SHS RIEMa financée par la région Île-de-France et a reçu des financements du PIA3 100% IDT (inclusion, un défi, un territoire) porté par l’Université de Picardie Jules Verne.

Elann Lesnes a reçu reçu des financements du PIA3 100% IDT (inclusion, un défi, un territoire) porté par l’Université de Picardie Jules Verne.

06.01.2026 à 11:59

Pourquoi l’obésité est, avant tout, une maladie du cerveau

Rosalia Rodriguez Rodriguez, Catedrática. Departamento de Ciencias Biomédicas, Universitat Internacional de Catalunya

Texte intégral (1786 mots)

L’obésité n’est pas due à un manque de volonté. Il ne s’agit pas non plus d’un problème individuel. C’est une maladie complexe profondément enracinée dans un cerveau adapté pour survivre à la pénurie.

L’obésité débute dans le cerveau, et nous savons aujourd’hui que son développement tout comme son traitement ne sont pas les mêmes chez les hommes et les femmes. Cette pandémie silencieuse, qui progresse parallèlement au diabète de type 2 – l’une de ses principales complications – touche déjà plus d’un milliard de personnes dans le monde.

Alors que notre environnement devient de plus en plus obésogène, le cerveau continue de fonctionner selon des règles ancestrales qui rendent difficile le maintien de la perte de poids, même avec des médicaments aussi révolutionnaires que le sémaglutide (Ozempic). Ce changement de perspective transforme les traitements actuels et ouvre la voie à de nouvelles thérapies ciblant directement le cerveau.

Un cerveau ancestral dans un environnement moderne

L’obésité et le surpoids sont habituellement décrits comme un excès de graisse ou un problème métabolique. Mais leur origine profonde réside dans le système nerveux central, en particulier dans l’hypothalamus, la région qui agit comme un « thermostat énergétique ». Pendant 95 % de notre histoire évolutive, nous avons vécu dans la pénurie : marcher, chasser et cueillir étaient indispensables, et le cerveau a développé des mécanismes très efficaces pour défendre la masse graisseuse, car la perdre pouvait signifier ne pas survivre.

Ce « cerveau ancestral » fonctionne aujourd’hui dans un environnement totalement opposé : aliments hypercaloriques disponibles 24 heures sur 24, sédentarité, stress chronique, troubles du sommeil et régimes alimentaires ultratransformés.

À lire aussi : Aliments ultratransformés : quels effets sur notre santé et comment réduire notre exposition ?

Il en résulte un déséquilibre entre notre biologie et notre mode de vie, qui est amplifié chez les personnes qui présentent des prédispositions génétiques. À cela s’ajoute un élément que la recherche commence à explorer clairement : le système qui régule le poids ne fonctionne pas de la même manière chez les hommes et chez les femmes.

L’hypothalamus : là où commence l’obésité

L’hypothalamus intègre des signaux hormonaux (comme la leptine ou l’insuline), métaboliques et sensoriels afin d’équilibrer l’énergie ingérée et celle qui est dépensée. Quand nous perdons du poids, le cerveau interprète la situation comme une menace et il active de puissants mécanismes de défense : il augmente l’appétit, réduit la dépense énergétique et renforce une « mémoire métabolique ou obésogène » qui pousse à reprendre le poids perdu.

C’est pourquoi, même si l’alimentation et l’exercice physique sont essentiels à la santé et doivent toujours constituer la première prise en charge, ils ne suffisent pas chez de nombreuses personnes pour inverser l’obésité lorsque les circuits cérébraux sont déjà altérés. Ce point n’invalide pas les bienfaits d’un mode de vie sain : il reconnaît simplement que, dans certains cas, le cerveau a besoin d’un soutien pharmacologique pour sortir de la boucle obésogène.

Quand l’hypothalamus s’enflamme (à cause du stress, d’un régime hypercalorique, d’un manque de sommeil, de troubles hormonaux ou d’une prédisposition génétique), l’activité des neurones qui régulent la faim et la satiété est perturbée. Certaines personnes parviennent à retrouver spontanément leur poids initial après avoir trop mangé ; d’autres, en revanche, présentent un « frein hypothalamique » moins efficace et prennent plus facilement du poids. La différence réside dans le cerveau.

Perspective de genre : deux cerveaux, deux réponses

Les neurones hypothalamiques AgRP (qui stimulent la faim) et POMC (qui favorisent la satiété) régulent avec précision le comportement alimentaire. Cependant, l’hypothalamus n’est pas seulement un ensemble de neurones : il comprend également la microglie et les cellules immunitaires du cerveau, dont le rôle s’est avéré déterminant. Notre groupe a décrit trois phases d’activation microgliale dans les premiers stades de la suralimentation :

Une activation précoce, rapide et réversible.

Une phase inflammatoire prolongée, qui perturbe les circuits de satiété.

Une phase finale de dérégulation, au cours de laquelle les mécanismes censés limiter la prise de poids ne fonctionnent plus.

Ces phases ne se comportent pas de la même manière chez les hommes et chez les femmes. Chez les modèles murins, les femelles présentent une réponse neuro-immune plus stable et protectrice, ce qui pourrait expliquer pourquoi elles développent l’obésité plus tardivement. Ce schéma rappelle ce que l’on observe chez les femmes préménopausées.

À lire aussi : Ménopause et prise de poids : des mesures précoces pour accompagner les changements hormonaux

Avant la ménopause, les femmes ont un risque moindre de maladies métaboliques et cardiovasculaires que les hommes, grâce à l’effet protecteur des œstrogènes. Mais cette protection diminue pendant la périménopause et la ménopause, une période encore très peu étudiée et critique pour le risque cardiométabolique.

À lire aussi : À la ménopause, savez-vous que le risque cardiovasculaire augmente ? L’activité physique peut aider

De plus, dans les modèles animaux et les cultures cellulaires, nous avons détecté des altérations très précoces (au niveau de la microglie, de signaux lipidiques comme les endocannabinoïdes et de la sensibilité neuronale à l’insuline) avant même l’apparition de changements visibles dans les tissus périphériques. Cela suggère que le déclencheur initial de l’obésité est cérébral. Il est essentiel d’intégrer cette perspective de genre pour progresser vers des traitements plus précis et plus efficaces.

Nouvelles thérapies contre l’obésité : incrétines et nanomédecine ciblant le cerveau

Le traitement de l’obésité a radicalement changé depuis 2021 avec les agonistes du récepteur GLP-1. Le semaglutide et d’autres médicaments de la famille des incrétines, initialement développés pour le diabète de type 2, ont démontré une capacité remarquable à réduire le poids grâce à des actions à la fois périphériques et centrales. Cependant, ils présentent des limites connues : effets gastro-intestinaux, perte de masse maigre, reprise de poids après l’arrêt du traitement ou réponses variables selon le profil biologique du patient.

Des études récentes montrent également des différences selon le sexe : les femmes préménopausées ont tendance à mieux répondre à ces traitements que les hommes.

Un défi doit donc être relevé : nous avons besoin de traitements qui agissent directement sur le cerveau, avec une plus grande précision et moins d’effets systémiques. C’est là que la nanomédecine qui cible le cerveau ouvre de nouvelles perspectives. Au sein de notre groupe, nous développons des nanoplateformes (micelles polymères, nanoparticules protéiques ou formulations intranasales) capables de transporter des médicaments de manière sélective vers le cerveau. Ces technologies permettent d’encapsuler des molécules qui, si elles étaient administrées sans protection, seraient inefficaces ou toxiques, afin de les diriger vers les cellules qui contrôlent l’appétit et l’homéostasie énergétique.

Ces approches pourraient compléter ou renforcer les incrétines, réduire leurs effets secondaires, améliorer l’observance aux traitements et augmenter le nombre de patients qui y répondent. Elles constituent un moyen de traiter l’obésité depuis son origine cérébrale, grâce à des interventions plus personnalisées et durables.

Un regard neuf sur un problème ancien

L’obésité n’est pas due à un manque de volonté, malgré la stigmatisation dont elle fait l’objet au niveau social. Il ne s’agit pas non plus d’un problème individuel. L’obésité est une maladie complexe, profondément enracinée dans un cerveau adapté à la survie en période de pénurie. Pour la traiter, il faut adopter une double approche : promouvoir des modes de vie sains et, quand cela se révèle nécessaire, recourir à des thérapies qui agissent sur les circuits cérébraux régulant le poids.

Comprendre comment fonctionne – et comment échoue – l’hypothalamus sera essentiel pour freiner cette pandémie silencieuse du XXIe siècle. Et c’est là, dans le cerveau, que se livre la bataille scientifique la plus prometteuse.

Rosalia Rodriguez Rodriguez reçoit des financements du ministère des sciences, de l'innovation et des universités, de l'AGAUR-Generalitat de Catalogne (PRODUCTE, INNOVADORS) et du Centre de recherche biomédicale en réseau-obésité (CIBER-Obn).

06.01.2026 à 11:59

Et si quelques minutes de méditation de pleine conscience pouvaient aider à réduire le stress ?

Alexis Barbry, Maître de conférences en STAPS, Université de Lorraine

Annie Carton, Psychologie, Université d'Artois

Jérémy Coquart, Professeur des Universités (74ème section : STAPS : Sciences et Techniques des Activités Physiques et Sportives), Université de Lille

Texte intégral (1899 mots)

Une revue systématique de la littérature scientifique met en évidence les effets bénéfiques de temps courts de pleine conscience sur un marqueur physiologique du stress. Cela plaide pour une intégration de ce type de méditation dans la vie quotidienne.

Nous sommes toutes et tous confrontés au stress dans notre vie de tous les jours. Il est tout à fait normal de le ressentir. Il peut se définir comme un état de tension interne causé par une situation complexe, qui excède nos ressources cognitives, sociales ou affectives. L’important n’est pas tant le stress, mais plutôt la manière dont nous y réagissons.

La recherche souligne la nécessité de s’équiper d’outils issus de la psychologie pour nous apprendre à mieux gérer les situations perçues comme menaçantes dans l’objectif de réguler le stress.

La pleine conscience : un outil de régulation du stress ?

Parmi les techniques psychologiques, la pleine conscience a récemment connu un essor important. Bien que cette dernière soit considérée comme un concept « à la mode », elle dispose d’une longue histoire, qui aurait débuté il y a plus de 2 500 ans à travers la pensée bouddhiste. Cette pleine conscience, également connue sous le nom de mindfulness, est une technique de méditation attentionnelle simple qui consiste à porter délibérément son attention sur ce qui se passe ici et maintenant, sans jugement. Autrement dit, c’est être attentif au moment présent, sans se laisser contaminer par ses pensées !

La pleine conscience a pris un essor scientifique sous l’impulsion du professeur Jon Kabat-Zinn dans les années 1980. Le premier programme de pleine conscience ayant vu le jour est le Mindfulness-Based Stress Reduction (MBSR), qui signifie « programme de réduction du stress par la pleine conscience ». Depuis le début des années 1980, d’autres programmes de pleine conscience ont émergé. Ces derniers se sont adaptés aux caractéristiques de différents publics (personnes souffrant d’épisodes dépressifs, sportifs, etc.…).

Aujourd’hui, les bienfaits de ces programmes sur la réduction du stress sont bien établis. Cependant, un des freins à la pratique de la pleine conscience réside dans la durée et dans l’engagement requis. Par exemple, le MBSR nécessite un engagement sur huit semaines, comportant une pratique quotidienne individuelle de 45 minutes et une pratique hebdomadaire en groupe de 2,5 heures.

Bien qu’efficace pour réguler les intensités de stress, la durée de ces programmes ne semble pas s’adapter à nos rythmes de vie actuels. Compte tenu de leur dimension chronophage, certains chercheurs ont proposé des temps plus courts de pleine conscience.

Quelle efficacité des temps brefs de pleine conscience contre le stress

Un programme bref de pleine conscience se réalise sur quatre semaines et engendre une pratique inférieure à 1,6 heure (100 minutes, soit une heure et quarante minutes) par semaine. La durée de la séance ne doit pas excéder 30 minutes. Bref, nous sommes bien loin des temps proposés par les programmes plus classiques comme le MBSR… Si ces temps courts s’accordent davantage à nos contraintes temporelles, leurs bénéfices sur le stress restent mal connus.

Notre interrogation a donc été la suivante : est-ce que les temps brefs de pleine conscience pourraient réduire notre stress ?

Pour répondre à cette question, nous avons effectué une revue systématique de la littérature évaluant les effets des temps brefs de pleine conscience sur un marqueur physiologique du stress : la variabilité de la fréquence cardiaque (VFC). La VFC reflète l’activité du système nerveux autonome jouant un rôle crucial dans le maintien de notre équilibre.

Ce système nerveux autonome se divise en deux branches : le système nerveux sympathique (qui prédomine lors des situations stressantes) et le système nerveux parasympathique (qui prédomine lors des situations de repos). Une faible VFC est représentative d’une moindre capacité à gérer les situations stressantes, alors qu’une VFC plus élevée reflète une meilleure capacité à réguler les situations stressantes.