09.12.2025 à 15:22

La société civile syrienne un an après la chute du régime Assad

Léo Fourn, Docteur en sociologie, Institut de recherche pour le développement (IRD)

Texte intégral (2291 mots)

Le 8 décembre 2024 a refermé un demi-siècle de pouvoir autoritaire du clan Assad en Syrie, renversé par le groupe islamiste rebelle Hayat Tahrir al-Cham. Le pays émerge enfin d’une guerre civile qui l’a ravagé pendant quatorze ans. Une année s’est écoulée depuis ce basculement historique : assez pour esquisser les contours d’une transition politique encore fragile, mais déjà révélatrice de profondes recompositions au sein de la société civile. Entre cooptation, coopération et vigilance critique, les acteurs de la société civile syrienne jouent un rôle déterminant dans la reconstruction politique du pays.

En cette fin d’année 2025, de très nombreux rassemblements sont organisés en Syrie pour célébrer le premier anniversaire de la chute du régime dirigé par Bachar al-Assad le 8 décembre 2024.

La foule agite le nouveau drapeau officiel en scandant des chants révolutionnaires, tandis que les représentants du nouveau pouvoir paradent en héros libérateurs. Ces nouvelles autorités, dominées par Hayat Tahrir al-Cham (HTC) et son leader désigné président, Ahmad al-Charaa, tentent de mettre en œuvre un processus de transition politique et d’entamer la reconstruction d’un pays dévasté par plus d’une décennie de guerre. Les défis qu’elles affrontent sont énormes et leurs capacités très limitées. Le territoire national demeure divisé, le pouvoir central étant contesté par l’administration kurde autonome du Nord-Est, des groupes armés druzes et l’incursion de l’armée israélienne dans le Sud.

Dans ce contexte, quelle est la situation de ce que l’on appelle communément la « société civile syrienne », c’est-à-dire l’ensemble hétéroclite de groupes ni étatiques, ni partisans, ni militaires, mais engagés dans la défense de causes publiques ?

Cet article propose de dresser le bilan des changements vécus par cette société civile lors de la première année de la transition. La chute de l’ancien régime a bouleversé en profondeur les relations qui liaient l’État à la société. En l’absence d’opposition partisane solide, les organisations composant la société civile tiennent un rôle de premier plan, entre coopération et vigilance. Leur situation est donc révélatrice de l’orientation que prend la transition politique.

L’épanouissement de la société civile syrienne, de la révolution à la chute du régime

Avant 2011, le régime limitait drastiquement toute activité politique et toute action de la société civile hors de marges très restreintes, autorisant par exemple le travail des organisations caritatives et autres ONG parrainées par lui.

Le soulèvement qui démarre en 2011 va donner lieu à un épanouissement sans précédent de la société civile syrienne.

On l’observe d’abord dans la rue, lors des nombreuses manifestations demandant la chute du régime, davantage de liberté et de dignité. Puis par la multiplication des médias indépendants et la création de milliers d’organisations dédiées à la défense des droits humains ou à l’action humanitaire.

L’exil vécu par plus de 7 millions de Syriens produit une transnationalisation de cette société civile, dispersée entre la Syrie de l’intérieur et les pays de la diaspora. Des espaces comme la ville turque de Gaziantep et plus tard Berlin deviennent des centres majeurs de la mobilisation en exil. Ces organisations connaissent une professionnalisation de leurs activités, qui contribue à leur pérennité mais accroît également leur dépendance à l’égard des bailleurs internationaux. Elles tentent de s’unir en formant des coalitions afin d’augmenter leur influence, à l’exemple de la coalition la plus récente et la plus importante, Madaniya, qui regroupe plus de 200 organisations.

Lors des dernières années du conflit, ces organisations ont vu l’intérêt des bailleurs internationaux à leur endroit se réduire, ce qui a entraîné une baisse des financements. Ces financements ne vont pas s’accroître de sitôt, à la suite de la suspension de l’USAID par Donald Trump.

Mais la chute du régime va leur donner un nouveau souffle : elles peuvent enfin travailler dans l’ensemble du pays sans être réprimées. Les organisations agissant auparavant depuis les zones sous contrôle des rebelles et celles qui étaient installées en exil reviennent très rapidement ouvrir des bureaux à Damas. Après des années de fragmentation et de dispersion, on assiste alors à une relocalisation et une centralisation de la société civile dans la capitale syrienne.

Plusieurs réunions et événements publics sont organisés chaque semaine, par exemple au siège de la coalition Madaniya. Le 15 novembre, pour la première fois, une « Journée du Dialogue » est organisée par l’Union européenne à Damas, avec la participation d’ONG et du gouvernement syrien.

Les multiples facettes de la mobilisation de la société civile

Les domaines d’activité de ces organisations n’ont pas fondamentalement changé depuis la chute du régime, si ce n’est qu’elles ne luttent désormais plus dans ce but. Derrière le terme générique de « société civile » se cache en réalité une très grande diversité d’acteurs aux positionnements politiques multiples. L’usage de ce terme en Syrie fait toutefois principalement référence à des organisations pouvant être qualifiées de « libérales », c’est-à-dire favorables à une démocratie libérale. Leurs activités – qu’elles soient de nature humanitaire ou plus contestataire – sont pour la plupart des réponses aux exactions commises par l’ancien régime.

Elles comprennent un ensemble de mobilisations pour la justice dite transitionnelle, désormais mises en œuvre depuis le territoire syrien et plus seulement depuis les pays d’exil.

De la même façon, la cause du sort des victimes et plus particulièrement des personnes victimes de disparitions forcées fait l’objet d’une mobilisation constante. Elle a pris la forme des tentes de la vérité dressées temporairement dans plusieurs localités ou de soutien psychologique apporté aux proches et survivants.

Les besoins en matière d’aide humanitaire et de développement demeurent également massifs, la situation du pays restant fortement affectée par les conséquences de la guerre. Auparavant fragmentée entre les différentes zones d’influence au sein du territoire syrien et depuis les pays frontaliers, ce type d’aide peut désormais s’étendre à l’ensemble du territoire national. Mais elle souffre, comme les autres domaines, de la diminution des fonds internationaux, ce qui incite les organisations humanitaires à tenter de réduire la dépendance à l’aide en favorisant des programmes d’empowerment économique, particulièrement à destination de la jeunesse, en partenariat avec le secteur privé, comme le programme Dollani mis en œuvre par le Syrian Forum.

D’autres domaines ont gagné en importance lors de la dernière année. C’est le cas des groupes spécialisés dans le dialogue intercommunautaire et la « paix civile », à l’exemple de la plate-forme The Syrian Family.

Cette question du dialogue intercommunautaire, déjà centrale avant 2025, est effectivement au cœur des préoccupations actuelles du fait des massacres perpétrés sur la côte à l’égard de la communauté alaouite en mars et de la communauté druze dans le sud en juillet, sans oublier les tensions persistantes dans des espaces multiconfessionnels comme la ville de Homs.

De la même façon, le retour des réfugiés est devenu une question essentielle pour les organisations syriennes et internationales.

Enfin, il existe désormais à Damas un nouveau type d’organisation de la société civile qui était inexistant avant 2011, à savoir les centres de recherche indépendants et think tanks, qui fournissent des conseils au pouvoir et assurent des formations para-universitaires, comme le centre Jusoor.

La société civile face au nouveau pouvoir : entre coopération et méfiance

Le changement de régime a des conséquences majeures sur l’évolution des relations entre le pouvoir politique et la société civile.

Issus d’un mouvement militaire islamiste, les nouveaux dirigeants étaient a priori peu enclins à collaborer avec la société civile. Cependant, avant d’accéder au pouvoir en renversant Bachar Al-Assad, ce mouvement avait connu un processus de déradicalisation et d’ouverture relative vers d’autres composantes de la société syrienne.

La formation du nouveau gouvernement, le renouvellement et la création d’institutions étatiques ou encore les élections/nominations législatives partielles ont ainsi représenté des étapes permettant d’évaluer la position des dirigeants à l’égard des acteurs de la société civile. Nous pouvons observer trois modes de relations entre ces deux ensembles d’acteurs.

Le premier est la cooptation, qui a vu un certain nombre d’acteurs jusqu’alors engagés dans des organisations de la société civile intégrer des ministères ou des commissions formées par les nouvelles autorités. C’est le cas par exemple de la ministre des affaires sociales et du travail Hind Kabawat qui était à la fois active dans une ONG et dans l’opposition politique à Bachar.

C’est également le cas du ministre des situations d’urgence et de la gestion des catastrophes, Raed Saleh, auparavant responsable de la Défense civile syrienne, surnommée les Casques blancs. Cet exemple est particulièrement emblématique, puisque c’est presque l’ensemble de cette organisation qui a intégré le ministère.

Pour la plupart des individus et organisations de la société civile, la relation avec les autorités prend la forme d’une coopération dans le cadre de laquelle leur indépendance est maintenue. Les très faibles ressources dont dispose l’État ne lui permettent pas de mettre en œuvre une action publique répondant aux besoins de la population. Il n’a donc d’autre choix que de la déléguer aux organisations, qui tenaient déjà ce rôle avant la chute de l’ancien régime dans de multiples domaines, comme l’éducation et la santé. Elles collaborent également avec les ONG internationales et les organisations onusiennes et se rendent ainsi indispensables pour la reconstruction du pays.

Malgré cette coopération, de nombreux acteurs de la société civile restent méfiants à l’égard du nouveau pouvoir et exercent une forme de vigilance. Leurs craintes concernent les pratiques à dimension autoritaire qui demeurent très présentes. À titre d’exemple, plusieurs organisations se sont exprimées début octobre pour critiquer une circulaire du ministère des affaires sociales et du travail concernant la déclaration de l’origine des financements des ONG. Elles doivent effectivement désormais composer avec les exigences d’un État en restructuration.

Leurs responsables affirment disposer pour le moment de marges de liberté relativement larges, mais craignent que celles-ci se réduisent rapidement lorsque le pouvoir des dirigeants de l’État sera plus assuré. En ce sens, on peut considérer que les organisations de la société civile représentent toujours un contre-pouvoir, comme c’était dans le cas face à l’ancien régime.

Léo Fourn est chercheur postdoctorant à l'Institut de Recherche pour le Développement (IRD), membre du Centre Population & Développement (Ceped) et du projet LIVE-AR, financé par le Conseil Européen de la Recherche (ERC). Il a reçu pour cette recherche des financements de la Fondation Croix-Rouge française.

09.12.2025 à 15:21

Atteindre les objectifs climatiques améliorera aussi la santé publique

Kévin Jean, Professeur junior en Santé et Changements Globaux, Université Paris Dauphine – PSL

Laura Temime, Professor, Conservatoire national des arts et métiers (CNAM)

Léo Moutet, Doctorant en sécurité sanitaire, Conservatoire national des arts et métiers (CNAM)

Texte intégral (2049 mots)

Le 12 décembre 2015, 196 gouvernements adoptaient l’accord de Paris, qui ambitionnait de réduire les émissions de gaz à effet de serre pour lutter contre le changement climatique. Dix ans plus tard, les mesures prises par les États restent insuffisantes pour atteindre les objectifs fixés. Un retard d’autant plus dommageable que les mesures permettant d’améliorer le climat ont aussi des bénéfices conséquents en matière de santé publique. Explications.

L’urgence climatique impose une transformation profonde de nos systèmes énergétiques, de notre économie et de nos modes de vie. Or, ces transformations sont largement présentées dans le débat public sous l’angle des coûts à payer : investissements publics et privés, possibles pertes d’emplois dans certains secteurs, ou tout simplement coût du changement. Or, la transition écologique en vue de l’atteinte de la neutralité carbone (qui, rappelons-le, constitue la condition physique à la stabilisation du climat) peut également représenter des bénéfices, et en particulier dans le domaine de la santé.

C’est pour documenter l’ampleur de ces bénéfices que nous avons effectué une revue systématique de la littérature scientifique récente, et synthétisé 58 études ayant modélisé l’impact sur la santé humaine de 125 scénarios atteignant la neutralité carbone en 2050.

Les résultats de nos travaux, parus dans la revue The Lancet Planetary Health, sont sans appel : en plus d’être indispensables pour limiter les changements climatiques, les mesures prises dans ces scénarios ont le potentiel d’offrir des gains importants et immédiats pour la santé des populations.

Un enjeu non seulement climatique, mais également de santé publique

Alors que 3,6 milliards de personnes vivent déjà dans des zones très sensibles au changement climatique, celui-ci pourrait causer environ 250 000 décès supplémentaires par an d’ici 2030 et engendrer entre 2 et 4 milliards de dollars de dommages sanitaires directs chaque année, selon les projections de l’Organisation mondiale de la santé (OMS).

Il y a dix ans, le 12 décembre 2015, 196 gouvernements ont adopté l’accord de Paris, qui visait à réduire les émissions anthropiques de gaz à effet de serre (GES) afin de contenir l’élévation de la température moyenne de la planète en dessous de 2 °C par rapport aux niveaux préindustriels.

Malheureusement, les engagements nationaux actuels restent insuffisants pour atteindre ces objectifs. Ils placent actuellement nos sociétés sur une trajectoire de réchauffement de + 2 à + 3 °C d’ici la fin du siècle.

Or, les conséquences du changement climatique ont des effets sur la santé humaine. Ces derniers peuvent être directs, lorsqu’ils résultent de modifications des schémas climatiques, ou indirects, quand ils découlent de perturbations des écosystèmes, des systèmes alimentaires, des infrastructures ou des conditions sociales.

Les canicules relèvent par exemple de la première catégorie : à l’échelle européenne, on estime que sur les 2 300 décès dus à la chaleur survenus lors de la canicule de juin 2025, 1 500 sont directement attribuables au changement climatique.

En ce qui concerne les conséquences indirectes, on peut citer l’expansion des insectes vecteurs de certaines maladies, comme le moustique tigre (Aedes albopictus). Cet insecte propage notamment le virus chikungunya, à l’origine d’un nombre de cas autochtones sans précédent dans l’Hexagone en 2025.

Pourtant, si ces risques pour la santé sont de mieux en mieux décrits, leur connaissance ne suffit à l’évidence pas à impulser des mesures d’atténuation suffisantes.

Étant donné que la menace climatique, pourtant étayée scientifiquement, ne semble pas constituer un levier suffisant pour entraîner l’action, nous proposons d’adopter une autre approche, plus positive : expliquer les impacts, très souvent bénéfiques, que les politiques de réduction des gaz à effet de serre peuvent avoir sur la santé publique.

Les résultats de notre revue de la littérature scientifique sur ce sujet sont éloquents.

Des bénéfices sanitaires d’ampleur

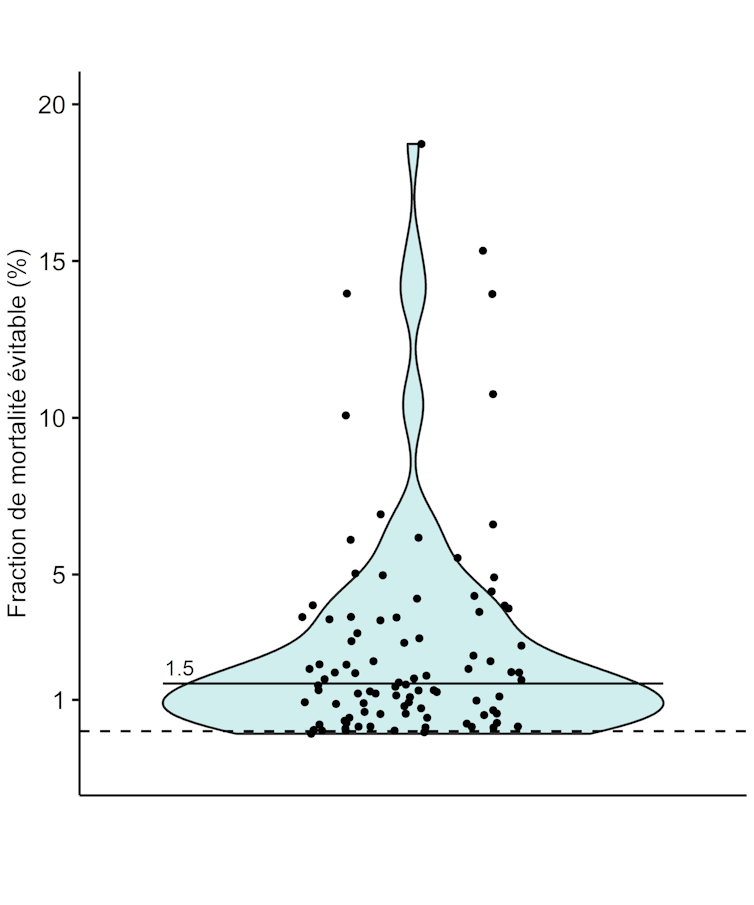

Parmi 96 scénarios visant à atteindre la neutralité carbone comparés dans notre revue de littérature, 94 ont prédit que les politiques préconisées pour améliorer le climat auront aussi des impacts sanitaires favorables. Et ce, avant même que les effets des mesures d’atténuation prises ne modifient l’évolution du climat (laquelle devrait avoir elle aussi, à terme, des effets bénéfiques sur la santé).

Les études disponibles se concentrent principalement sur l’amélioration de trois déterminants de santé : l’alimentation, la qualité de l’air et l’activité physique.

La moitié des scénarios anticipent une réduction de la mortalité de plus de 1,5 %, soit environ 10 000 décès par an en France. Pour donner un ordre d’idée, ce chiffre représente le nombre de décès annuels par suicide ou à cause du cancer du foie. Les accidents dus aux transports représentent quant à eux environ 2 500 décès par an. De plus, cette valeur de 1,5 % de réduction de la mortalité prématurée est très vraisemblablement à interpréter comme une sous-estimation des bénéfices sanitaires de politiques de neutralité carbone, car une grande partie des scénarios ne se sont intéressés qu’à la qualité de l’air, en négligeant l’alimentation et l’activité physique.

Ces résultats sont cohérents avec ceux d’autres études établissant que l’adoption de régimes alimentaires plus sains, l’arrêt de la combustion d’énergie fossile et la pratique régulière d’une activité physique pourraient éviter respectivement 10, 5 et 4 millions de décès annuel dans le monde.

Ces co-bénéfices mèneraient à des améliorations de l’ordre de celles attendues à la suite de la mise en place de politiques de santé publique ambitieuses. Et ce, alors qu’ils ne font que découler de la mise en place de mesures visant à améliorer le climat, rappelons-le…

Trois caractéristiques intéressantes

Les co-bénéfices sanitaires auraient également trois caractéristiques particulièrement intéressantes :

1. Ils s’accompagnent de co-bénéfices économiques : onze des treize études ayant comparé les coûts de mise en œuvre des politiques climatiques avec leurs bénéfices sanitaires concluent que les gains économiques issus de la réduction de la mortalité dépassent les investissements initiaux. La diminution des maladies cardiovasculaires et respiratoires réduirait les pressions sur les systèmes de santé, entraînerait des gains de productivité et une baisse des arrêts maladie. Par ailleurs, d’autres bénéfices économiques apparaissent également, tels que la création d’emplois, l’amélioration de la résilience énergétique et l’augmentation des rendements agricoles.

2. Ils permettent une amélioration à court terme de la santé publique : comme mentionné précédemment, ces co-bénéfices permettent d’améliorer rapidement la santé humaine, car ils sont consécutifs à la mise en place des stratégies d’atténuation destinées à atteindre la neutralité carbone. Diminuer la pollution de l’air et promouvoir les modes de transport actifs ainsi qu’une alimentation de meilleure qualité se traduit par une amélioration immédiate des capacités cardiovasculaires, respiratoires et de la santé mentale, tout en diminuant l’incidence de certains cancers à plus long terme.

Nul besoin d’attendre d’avoir atteint la neutralité carbone, laquelle pourrait n’être atteinte qu’à moyen terme, voire à long terme (2030 à 2035 dans le meilleur des cas pour l’agriculture, 2050 pour l’industrie), étant donné la durée pendant laquelle persistent les gaz à effet de serre dans l’atmosphère (en particulier le CO2).

3. Ils ne nécessitent pas d’action coordonnée à l’échelle mondiale : les co-bénéfices sanitaires des politiques d’atténuation se manifestent indépendamment des efforts d’autres pays. Autrement dit, un pays qui adopte des mesures de réduction des émissions profite directement d’une amélioration de la santé de sa population, même si d’autres nations tardent à agir. Ce n’est pas le cas des bénéfices climatiques, puisque leur obtention nécessite que tous les pays participent. Cet aspect est crucial pour l’adhésion politique et citoyenne aux politiques climatiques.

Un appel à l’action pour une politique climatique et sanitaire conjointe

Prendre du retard dans la transition vers la neutralité carbone, ce n’est donc pas seulement payer un coût environnemental plus élevé : c’est aussi manquer l’opportunité d’améliorer la santé humaine.

Les politiques d’atténuation devraient être considérées non seulement comme une nécessité climatique, mais aussi comme un levier efficace de transformation de la santé publique. Plutôt que de voir la transition écologique comme un coût, les décideurs politiques et les acteurs économiques doivent la considérer comme un investissement dans la santé et le bien-être présent et futur des populations.

Cette perspective pourrait accélérer l’adoption de mesures ambitieuses et renforcer l’acceptabilité sociale et la mise en place de politiques climatiques cohérentes avec l’accord de Paris.

Kévin Jean est membre du conseil d'administration de l'association Science Citoyennes.

Laura Temime et Léo Moutet ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur poste universitaire.

09.12.2025 à 15:17

‘We need to rethink how we approach biodiversity’: an interview with IPCC ecologist and ‘refugee scientist’ Camille Parmesan

Camille Parmesan, Director, Theoretical and Experimental Ecology Station (SETE), Centre national de la recherche scientifique (CNRS); University of Plymouth; The University of Texas at Austin

Texte intégral (6220 mots)

She is an ecologist recognized worldwide for being the first to unequivocally demonstrate the impact of climate change on a wild species: the Edith’s checkerspot butterfly. In recent years, however, Camille Parmesan has been interviewed not only for her expertise on the future of biodiversity in a warming world or for her share in the Nobel Prize awarded to the IPCC, but for her status as a refugee scientist.

Twice in her life, she has chosen to move to another country in order to continue working under political conditions that support research on climate change. She left Trump’s America in 2016, and later post-Brexit Britain. She now lives in Moulis in the Ariège region of southwestern France, where she heads the CNRS’s Theoretical and Experimental Ecology Station.

Speaking with her offers deeper insight into how to protect biodiversity – whose responses to climate change continue to surprise scientists – what to do about species that are increasingly hybridizing, and how to pursue research on a planet that is becoming ever more climate-skeptical.

The Conversation: Your early work on the habitats of the Edith’s checkerspot butterfly quickly brought you international recognition. In practical terms, how did you demonstrate that a butterfly can be affected by climate change? What tools did you use?

Camille Parmesan: A pickup truck, a tent, and a butterfly net, good strong reading glasses to search for very tiny eggs and caterpillar damage to leaves, a notebook and a pencil to write notes in! In the field, you don’t need more than that. But before doing my fieldwork, I had spent a year going around museums all across the USA, a couple in Canada, and even in London and Paris collecting all the records for Edith’s checkerspot. I was looking for really precise location information like ‘it was at this spot, one mile down Parsons Road, on June the 19th, 1952’, because this species lives in tiny populations and is sedentary. That process alone took about a year, since at the time there were no digitized records and I had to look at pinned specimens and write their collecting information down by hand.

Once in the field, my work consisted of visiting each of these sites during the butterfly’s flight season. Since the season lasts only about a month, you have to estimate when they will be flying in each location in order to run a proper census. For this, you start by looking for adults. If you do not see adults, you do not stop there. You look for eggs, evidence of web, like bits of silks, damage from the overwintering larvae starting to feed…

You also look at the habitat: does it have a good quantity of healthy host plants? A good quantity of healthy nectar plants for adult food? If the habitat was not good, that location did not go into my study. Because I wanted to isolate the impact of climate change, from other factors like habitat degradation, pollution… At the larger sites, I often searched more than 900 plants before I felt like I had censused enough.

Today, when you go back to the fields you started monitoring decades ago, do you see things you were not able to see at the beginning of your work?

C. P.: I know to look for things I didn’t really look for when I started 40 years ago, or that my husband Michael [the biologist Michael Singer] didn’t look for when he started 50 years ago. For instance, we discovered that the height at which the eggs are laid is a bit higher now, and that turns out to be a really significant adaptation to climate change.

The eggs are being laid higher because the ground is getting far too hot. Last summer, we measured temperatures of 78°C (172.4°F) on the ground. So if a caterpillar falls, it dies. You can also see butterflies landing and immediately flying up, as it is way too hot for their feet and they’ll then fly onto vegetation or land on you.

In my early days, it wouldn’t have occurred to me that the height of where the eggs are laid could be important. That is why it is so important for biologists to simply watch their study organism, their habitat, to really pay attention. I see a lot of young biologists today who want to run in, grab a bunch of whatever their organism is, take it back to the lab, grind it up and do genetics or look at it in the lab. That’s fine, but if you don’t spend time watching your organism and its habitat, you can’t relate all your lab results back to what is actually happening in the wild.

Thanks to your work and that of your colleagues, we now know that living organisms are greatly affected by climate change and that many species must shift their range in order to survive. But we also know that it can be difficult to predict where they will be able to persist in the future. So what can be done to protect them? Where should we be protecting lands for them?

C. P.: That is the big question plaguing conservation biologists. If you go to the conservation biology meetings, a lot of people are getting depression because they don’t know what to do. We actually need to change the way we think of conservation, away from strict protection toward something more like a good insurance portfolio. We don’t know the future, therefore we need to develop a very flexible plan, one that we can adjust as we observe what’s happening on the ground. In other words, don’t lock yourself into one plan, Start instead with an array of approaches, because you don’t know which one will work.

We just published a paper on adapting, for land conservation, some decision-making approaches that have been around since the 1960s in fields known to be unpredictable, like economics, for instance, or urban water policy, where you don’t know in advance if it is going to be a wet year or a dry year. So urban planners came up with these approaches for dealing with uncertainty.

With modern computers, you can simulate 1000 futures and ask: if we take this action, what is happening? And you see it is good in these futures, but bad in those, and not too bad in others. What you’re looking for is a set of actions that is what they call robust – that performs well across the largest number of futures. For conservation, we did so by starting with standard bioclimatic models. We had about 700 futures for 22 species. It turns out that if we just protect where these species occur today, most organisms don’t survive. Only 1 or 2% of the futures actually contain those species in the same place. But what if you protect where it is now, but also where it’s expected to be 30% of the time, 50% of the time, 70% and so on? You have these different thresholds. And from these different future possibilities, we can determine, for instance, that if we protect this location and that one, we can cover 50% of areas where the models predict the organism persists in the future. By doing that, you can see that some actions are actually pretty robust, and they include combinations of traditional conservation, plus protecting new areas outside of where the species are now. Protecting where it is now is usually a good thing, but it is often not enough.

Another thing to bear in mind is that bigger is better. We do still need to protect lands for sure, and the bigger the better, especially in high biodiversity areas. You still want to protect those places, because species will be moving out, but also moving in. The area might end up with a completely different set of species than it has today, yet still remain a biodiversity hotspot, perhaps because it has a lot of mountains and valleys, and a diversity of microclimates.

On a global scale, we need to have 30 to 50 percent of land and ocean as relatively natural habitat, without necessarily requiring strict protection.

Between these areas we also need corridors to allow organisms to move without being killed immediately. If you have a bunch of crop land, wheat fields for example, anything trying to move through them is likely to die. So you need to develop seminatural habitats winding through these areas. If you have a river going through, a really good way to do this is just have a big buffer zone on either side of the river so that organisms can move though. It doesn’t have to be a perfect habitat for any particular organism, it just has to not kill them. Another point to highlight is that the public often doesn’t realize their own backyards can serve as corridors. If you have a reasonably sized garden, leave part of it unmown, with weeds. The nettles and the bramble are actually important corridors for a lot of animals. This can be done also on the side of roads.

Some incentives could encourage this. For example, giving people tax breaks for leaving certain private areas undeveloped. There are just all kinds of ways of thinking about it once you shift your mindset. But for scientists, the important shift is to not put all your eggs in one basket. You cannot just protect where it is now, or just pick one spot where you think an organism is going because your favorite model says so, or the guy down the corridor from you uses this model. At the same time, you cannot save everywhere a species might be in the future, it would be too expensive and impractical. Instead, you need to develop a portfolio of sites that is as robust as possible, given financial constraints and available partnerships, to make sure we won’t completely lose this organism. Then, when we stabilize the climate and eventually bring it back down, it’s got the habitat to recolonize and become happy and healthy and whole again.

Another issue that is very much on the minds of those involved in biodiversity protection today is hybridization. How do you view this phenomenon, which is becoming increasingly common?

C. P.: Species are moving around in ways they haven’t done in many thousands of years. As they are moving around, they keep bumping into each other. For example, polar bears are forced out of their habitat because the sea ice is melting. It forces them to be in contact with brown bears, grizzly bears, and so they mate. Once in a while, it’s a fertile mating, and you get a hybrid.

Historically, conservation biologists did not want hybridization, they wanted to protect the differences between species, the distinct behavior, look, diet, genetics… They wanted to preserve that diversity. Also, hybrids usually don’t do as well as the original two species, you get this depression of their fitness. So people tried to keep species separate, and were sometimes motivated to kill the hybrids to do so.

But climate change is challenging all of that. The species are running into each other all the time, so it is a losing battle. Also, we need to rethink how we approach biodiversity. Historically, conserving biodiversity meant protecting every species, and variety. But I believe we need to think more broadly: the goal should be to conserve a wide variety of genes.

Because when a population has strong genetic variation, it can evolve and adapt to an incredibly rapidly changing environment. If we fight hybridization, we may actually reduce the ability of species to evolve with climate change. To maintain high diversity after climate change – if that day ever comes – we need to retain as many genes as possible, in whatever form they exist. That may mean losing what we perceive as being a unique species, but if those genes are still there, it can revolve fairly rapidly, and that’s what we’ve seen with polar bears and grizzly bears.

In past warm periods, these species came into contact and hybridized. In the fossil record, polar bears disappear during certain periods, which suggests there were very few of them at the time. But then, when it got cold again, polar bears reappeared much faster than you’d expect if they were evolving from nothing. They likely evolved from genes that persisted in grizzly bears. We have evidence that this works and it is incredibly important.

Something that can be hard for non-scientists to understand is that, on the one hand we see remarkable examples of adaptation and evolution in nature (for instance trees changing the chemistry of their leaves in response to herbivores, or butterflies changing colors with altitude… ) while, on the other hand, we are experiencing massive biodiversity loss worldwide. Biodiversity seems incredibly adaptable, but is still collapsing. These two realities are sometimes hard to connect. How would you explain this to a non-specialist?

C. P.: Part of the reason is that ongoing climate change is happening very quickly. Another reason is that species have a pretty fixed physiological niche that they can live in. It is what we call a climate space, a particular mix of rainfall, humidity and dryness. There is some variation, but when you get to the edge of that space, the organism dies. We don’t really know why that is such a hard boundary.

When species face other types of changes like copper pollution, light and noise pollution, many of them have some genetic variation to adapt. That doesn’t mean these changes won’t harm them, but some species are able to adjust. For example, in urban environments today, we see house sparrows and pigeons that have managed to adapt.

So there are some things that humans are doing that species can adapt to, but not all. Facing climate change, most organisms don’t have existing genetic variation that would allow them to survive. The only thing that can bring in new variation to adapt to a new climate is either hybridizing – which will bring in new genes – or mutations, which is a very slow process. In 1-2 million years, today’s species would eventually evolve to deal with whatever climate we’re going into.

If you look back hundreds of thousands of years when you had the Pleistocene glaciations, when global temperatures changed by 10 to 12°C, what we saw is species moving. You didn’t see them staying in place and evolving.

Going back even further to the Eocene, the shifts were even bigger, with enormously higher CO2 and enormously warmer temperatures, species went extinct. As they can’t shift far enough, they die off. So that tells you that evolution to climate change is not something you expect on the time scale of a few 100 years. It’s on the time scale of hundreds of thousands to a couple of million years.

In one of your publications, you write: “Populations that appear to be at high risk from climate change may nonetheless resist extinction, making it worthwhile to continue to protect them, reduce other stressors and monitor for adaptive responses.” Can you give an example of this?

C. P.: Sure, let me talk about the Edith’s checkerspot, as that’s what I know the best. Edith’s checkerspot has several really distinctive subspecies that are genetically quite different from each other, with distinct behaviors, and host plants. One subspecies in southern California has been isolated long enough from the others that it is quite a genetic outlier. It’s called the Quino checkerspot.

It is a subspecies at the southern part of the range, and it’s being really slammed by climate change. It already has lost a lot of populations due to warming and drying. Its tiny host plant just dries up too fast. It’s lost a lot due to urbanization too: San Diego and Los Angeles have just wiped out most of its habitat. So you might say, well, give up on it, right?

My husband and I were on the conservation habitat planning for the Quino Checkerspot in the early 2000s. By that time, about 70% of its population had gone extinct.

My husband and I argued that climate change is going to slam them if we only protected the areas where they currently existed, because they were low elevation sites. But we thought, what about protecting sites, such as at higher elevations, where they don’t exist now?

There were potential host plants at higher elevation. They were different species that looked completely different, but in other areas Edith’s checkerspot used similar species. We brought some low elevation butterflies to this new host plant, and the butterflies liked it. That showed us that no evolution was needed. It just needed the Quino checkerspot to get up that high, and it would eat this, it could survive.

Therefore, we needed to protect the area where they were at the time, for them to be able to migrate, as well as this novel, higher habitat.

That’s what was done. Luckily, the higher area was owned by US Forest Service and Native American tribal lands. These tribes were really happy to be part of a conservation plan.

In the original area, a vernal pool was also restored. Vernal pools are little depressions in the grounds that are clay at the bottom. They fill up with water in the winter and entire ecosystems develop. Plants come up from seeds that were in the dry, baked dirt. You also get fairy shrimp and all kinds of little aquatic animals. The host plant of the Quino checkerspot pops out at the edge of the vernal pool. It is a very special habitat that dries up around April. By that time, the Quino checkerspot has gone through its whole life cycle, and it’s now asleep. All the seeds have dropped and are also dormant. The cycle then starts again the next November.

Sadly, San Diego’s been bulldozing all the vernal pools to create houses and condos. So in order to protect the Quino checkerspot, the Endangered fish and wildlife service restored a vernal pool on a small piece of land that had been full of trash and all-terrain vehicles. They carefully dug out a shallow depression, lined it with clay and planted vegetation to get it going. Among other things, they planted Plantago erecta, which Quino checkerspot lives off.

Within three years, this restored land had almost all of the endangered species it was designed for. Most of them had not been brought in. They just colonized this new pool, including Quino checkerspot.

After that, some Quino checkerspot were also found in the higher-environment habitat. I was blown away to be honest. We didn’t know this butterfly would be able to get up the mountain. I thought we’d have to pick up eggs and move them. The distances aren’t large (a few kilometers over, or 200 m upward), but remember that this butterfly doesn’t normally move much – it mostly stays where it was born.

Was there a wildlife corridor between these two areas?

C. P.: There were some houses, but they were very sparse, with lots of natural scrubby stuff in between. There weren’t really host plants for the Quino checkerspots. But it would allow them to fly through, have wild nectar plants on the way and not be killed. That’s the big point. A corridor doesn’t have to support a population. It just has to not kill it.

You too have had to relocate during your career in order to continue your research in ecology without being affected by the political climate. Over the past year in France, you have been asked to speak about this on numerous occasions and have been the subject of many articles describing you as a scientific refugee. In the United States, does this background also generate curiosity and media interest?

C. P.: A lot of colleagues, but also just people I know and have not necessarily collaborated with have asked me: How did you do that? How hard is it to get a visa? Do people speak English in France? But what’s interesting is the media in the USA has taken no interest. The media attention has been entirely outside of the USA, in Canada and Europe.

I don’t think Americans understand how much damage is being done to academia, education and research. I mean, even my own family doesn’t understand how much harm is being done. It’s difficult to explain to them because several of them are Trump supporters, but you would think the media would talk about that.

Most of the media have articles about damage to the university structure and damage to education, banning of books for instance, or the attempt to have an education system that only teaches what JD Vance wants people to learn. But you don’t really have a lot in those articles about people leaving. I think Americans can sometimes be very arrogant. They just presume America is the best and that no one would leave America to work somewhere else.

And it’s true that the USA traditionally has had such amazing opportunities, with so much funding from all kinds: many governmental agencies, funding many different projects, but also private donors, NGOs… All of this really literally stopped just cold.

In order to get people interested in biodiversity conservation and move them out of denial, it can be tempting to highlight certain topics, such as the impact on human health. This is a topic you have already worked on. Does it resonate more?

C. P.: I’ve always been interested in human health. I was going to be a medical researcher early on and I switched. But as soon as I started publishing the results that we were getting on the extent of species movements, the first thing I thought of was, ‘well diseases are going to be moving too’. So my lab’s work on human health focuses on how climate change is affecting where diseases, their vectors, and their reservoirs are spreading. One of my grad students documented the movement of leishmaniasis into Texas, going northward into Texas related to climate change.

In the IPCC we documented malaria, dengue and three other tropical diseases that have moved into Nepal, where they’ve never been before, at least in historical record, and that’s related to climate change, not to agricultural changes.

We also have new diseases emerging in the high Arctic. But not many people live in the high Arctic. It’s the Inuit communities that are being affected, so it gets downplayed by politicians. In Europe,the tiger mosquito is spreading into France, carrying its diseases with it.

Leishmaniasis is also already present in France, one species so far, but predictions suggest that four or five more species could arrive very soon. Tick-borne diseases are also increasing and moving north across Europe. So we are seeing the effect of climate change on human disease risk in Europe right now. People just aren’t aware of it.

You mentioned your family, some of whom are Trump supporters. Are you able to talk about your work with them?

C. P.: In my family, the only option is to not talk about it, and it’s agreed upon by everyone. It’s been that way for a long time about politics, even religion. We all love each other. We want to get along. We don’t want any divisions. So we kind of grow up knowing there are just certain topics you don’t talk about. Occasionally, climate change does come up and it gets difficult and it’s like, that’s why we don’t talk about it. So it’s not been possible to have an open conversation about it. I’m sorry about that, but I’m not going to lose my family. Nor, obviously, just push to convince them. I mean, if they want to know about it, they know where to come.

But I’ve also experienced working with people who have very different beliefs from mine. When I was still in Texas I worked with the National Evangelical Association. We both wanted to preserve biodiversity. They see it as God’s creation, I just think it’s just none of man’s business to destroy the Earth and I am an atheist, but that is fine. We did a series of videos together where I explained the effect of global warming. The result was wonderful.

This article is published as part of the 20th anniversary celebrations of the French Agence Nationale de la Recherche (ANR). Camille Parmesan is a winner of the “Make Our Planet Great Again” (MOPGA) program managed by the ANR on behalf of the French government. The ANR’s mission is to support and promote the development of fundamental and applied research in all disciplines, and to strengthen the dialogue between science and society.

Camille Parmesan ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

09.12.2025 à 15:17

Radiographie du soft power russe au Sénégal

Ibrahima Dabo, Docteur en science politique (relations internationales, Russie), Université Paris-Panthéon-Assas

Texte intégral (2188 mots)

C’est avant tout via son soft power – médias, langue, culture, bourses pour les étudiants… – que la Russie renforce son implantation au Sénégal, même si les dimensions géopolitique, militaire, énergétique et économique des relations bilatérales sont également en progression.

Dans un contexte mondial marqué par une recomposition des alliances, le Sénégal cherche – tout spécialement depuis l’arrivée à la présidence en mars 2024 de Bassirou Diomaye Faye – à diversifier ses partenariats tout en préservant sa souveraineté. L’évolution des relations entre Dakar et Moscou reflète les mutations plus larges du rôle de la Russie en Afrique de l’Ouest.

Au niveau économique, la présence russe reste faible en Afrique en général, y compris au Sénégal. Et même si un accord de coopération militaire a été signé fin 2023 avec Dakar, c’est surtout à travers l’expansion de son soft power que Moscou s’impose, s’appuyant notamment sur ses instruments culturels et éducatifs tels que l’agence fédérale Rossotroudnitchestvo (« Coopération russe »), la Fondation Russkiy Mir (« Monde russe ») et sur ses médias internationaux Sputnik et RT.

Une présence économique très marginale

La Chambre de commerce et d’investissement d’Afrique, de Russie et d’Eurasie a été ouverte à Dakar en 2024, ce qui témoigne d’une volonté d’explorer de nouvelles opportunités de coopération. Mais malgré l’existence de perspectives de collaboration dans des secteurs stratégiques tels que l’énergie, les ressources naturelles, les infrastructures et l’agriculture, les échanges économiques entre les deux pays restent à ce stade limités.

Dans une interview accordée début 2025 à Dakartimes, l’ambassadeur de la Fédération de Russie à Dakar, Dimitri Kourakov, a indiqué que les échanges entre le Sénégal et la Russie étaient estimés à 850 milliards de FCFA (1,3 milliard d’euros) pour cette année, contre environ 700 milliards de FCFA pour l’année 2024 (1,07 milliard d’euros). Les exportations de la Russie vers le Sénégal sont principalement constituées de produits pétroliers, d’engrais et de blé.

Dans le transport urbain, la filiale du géant technologique russe Yandex, Yango est devenue indispensable pour de nombreux déplacements quotidiens à Dakar. L’arrivée de Yango a créé de nombreuses opportunités d’emploi pour les chauffeurs locaux. Il n’empêche : la Russie est un partenaire économique secondaire et ses relations économiques avec le Sénégal restent modestes.

La coopération militaire entre Dakar et Moscou

À ce jour, la coopération militaire entre le Sénégal et la Russie demeure quasiment inexistante comparée à celle que Dakar entretient avec la Turquie, la Chine ou avec ses partenaires traditionnels, notamment les États-Unis ou la France malgré le départ des troupes françaises. Un accord bilatéral relatif à la coopération militaro-technique a été signé le 14 septembre 2007 qui prévoit la fourniture d’armes et de matériel militaire, ainsi que le détachement de spécialistes pour aider à la mise en œuvre de programmes conjoints dans le domaine de la coopération militaro-technique.

Un pas significatif a été franchi lorsque le gouvernement russe a approuvé un projet d’accord de coopération militaire avec le Sénégal le 3 novembre 2023, conformément à un décret du gouvernement de la Fédération de Russie. Cet accord porte sur la formation militaire et la lutte contre le terrorisme. Force est de constater qu’il existe un intérêt mutuel en ce qui concerne la coopération militaro-technique.

Une coopération éducative et culturelle en pleine expansion

Durant l’époque soviétique, l’URSS offrait des bourses d’étude aux étudiants sénégalais. Plusieurs cadres sénégalais ont été formés dans les universités soviétiques. La chute de l’Union soviétique a mis un coup d’arrêt à la présence culturelle de Moscou au Sénégal.

À partir de 2012, la coopération éducative s’est imposée comme un pilier de la relation sénégalo-russe. Le nombre de bourses d’études offertes par la Russie au Sénégal a alors fortement augmenté. Moins de 20 bourses étaient offertes par an au début des années 2000. Ce chiffre n’a cessé de monter, s’élevant à 130 au titre de l’année académique 2026-2027. En Russie, les jeunes Sénégalais étudient dans des domaines variés tels que l’ingénierie, la médecine, les relations internationales ou encore l’agriculture.

L’éducation et la culture sont au cœur de la politique africaine de la Russie. À l’instar de modèles tels que l’Alliance française, le British Council, les Instituts Confucius ou les Maisons russes dans d’autres pays, la Russie mise pour le moment au Sénégal sur l’implantation d’une médiathèque. À Dakar, la fondation Innopraktika offre une médiathèque à l’Université Cheikh Anta Diop pour faire la promotion de la langue et de la culture russe au Sénégal. L’apprentissage de la langue russe et la formation pour les enseignants du russe avec des méthodes innovantes sont au cœur des actions de la Fondation Russkiy Mir au Sénégal.

Rossotroudnitchestvo soutient ces initiatives en fournissant des manuels et des ressources pédagogiques, facilitant ainsi l’enseignement du russe. Dans le cadre de la coopération éducative, l’Agence fédérale, en collaboration avec l’Université électronique d’État de Saint-Pétersbourg (LETI), a lancé au Sénégal la semaine russe des mathématiques, de la physique et de l’informatique.

S’y ajoute la coopération entre la Bibliothèque d’État russe et l’Université Cheikh Anta Diop de Dakar. Dans le domaine culturel, chaque année, une célébration de l’anniversaire du poète russe Alexandre Pouchkine est organisée à Dakar. Dans le cadre de la promotion de la culture russe, une association privée, non gouvernementale et apolitique, CCR Kalinka a été lancée en 2009. Ce Centre culturel russe a pour objectif de familiariser la société sénégalaise avec la culture russe et les « valeurs traditionnelles slaves ». La coopération cinématographique Sénégal-Russie s’impose aussi aujourd’hui comme un pilier du dialogue culturel entre Dakar et Moscou.

L’évolution de l’influence médiatique russe au Sénégal depuis le changement de régime

Les relations tendues entre Dakar et Paris, qui se sont récemment manifestées par la fin de plus de 60 ans de présence militaire française au Sénégal, constituent une aubaine pour la Russie, qui cherche à étendre sa zone d’influence en Afrique de l’Ouest, plus particulièrement au Sahel.

De plus en plus, les médias deviennent des acteurs incontournables de la diplomatie des États. Dans ce contexte, les organes russes d’information, tels que RT et Sputnik, jouent un rôle central dans la diffusion de narratifs souvent critiques à l’égard de l’Occident et séduisants pour une partie des opinions publiques africaines francophones.

À lire aussi : RT et Sputnik : comment les médias internationaux russes se restructurent après leur interdiction dans les pays occidentaux

L’Afrique de l’Ouest est devenue un terrain stratégique pour Moscou dans sa guerre d’influence contre l’Occident. Depuis l’interdiction de RT et Sputnik dans l’espace européen, la Russie a recentré ses efforts médiatiques sur les pays africains où le rejet du néocolonialisme et la contestation de l’ordre occidental rencontrent un fort écho.

Au Sénégal, cette stratégie trouve un écho favorable avec l’arrivée au pouvoir de Bassirou Diomaye Faye, président de la « rupture », issu d’un parti souverainiste porté par un discours hostile au système néocolonial et à la Françafrique. Même si le régime n’a pas rompu avec les partenaires traditionnels, il affiche une réelle volonté de diversification de ses partenariats, notamment avec les pays arabes du Golfe et les BRICS.

RT dispose désormais d’un correspondant établi à Dakar, ce qui témoigne d’une stratégie de maillage territorial plus affirmée en Afrique de l’Ouest. Cette présence permet une meilleure couverture de l’actualité locale, et implique une meilleure compréhension des dynamiques politiques et sociales sénégalaises, ce qui laisse penser que RT est sur une trajectoire propice à l’accroissement de son influence.

Sputnik et RT veulent s’imposer comme des sources alternatives de narratifs favorables à la Russie en Afrique. Les contenus de RT dénonçant les bases militaires françaises en Afrique, le franc CFA, le néocolonialisme ou la Françafrique sont partagés par une partie de la jeunesse sénégalaise sur les réseaux sociaux pour légitimer son rejet de la présence française. Le discours souverainiste des nouvelles autorités du Sénégal et leur décision d’ordonner le retrait des troupes françaises sont salués par RT sur ses différentes plates-formes.

Il reste que l’influence directe des médias internationaux russes au Sénégal est très modeste en comparaison avec celle d’autres médias internationaux. Néanmoins, toutes les conditions semblent réunies pour une progression significative de la présence médiatique de la Russie au Sénégal.

Poursuivant la ligne déjà établie, les nouvelles autorités sénégalaises maintiennent une posture de neutralité au sujet de la guerre entre la Russie et l’Ukraine et encouragent les deux camps à parvenir à une issue pacifique. Le récent incident autour du navire Mersin à Dakar, présumé avoir un lien avec Moscou, remet au premier plan la question des conséquences pour le Sénégal du conflit russo-ukrainien.

Ibrahima Dabo ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

09.12.2025 à 11:59

Plantes médicinales : valider la tradition, prévenir les risques

François Chassagne, Chargé de recherche en ethnopharmacologie, Institut de recherche pour le développement (IRD)

Texte intégral (3772 mots)

En France, dans les territoires d’outre-mer en particulier, mais aussi ailleurs dans le monde, l’ethnopharmacologie doit faire face à plusieurs enjeux. Les laboratoires spécialisés dans cette discipline sont sollicités pour confirmer, ou non, l’intérêt thérapeutique de remèdes, à base de plantes notamment, utilisés dans les traditions. Mais ils doivent mener ce travail en préservant ces savoirs dans leurs contextes culturels.

Saviez-vous que près d’une plante sur dix dans le monde était utilisée à des fins médicinales ? Certaines ont même donné naissance à des médicaments que nous connaissons tous : l’aspirine, dérivé du saule (Salix alba L.), ou la morphine, isolée du pavot à opium (Papaver somniferum L.).

Au fil des siècles, les remèdes traditionnels, consignés dans des textes comme ceux de la médecine traditionnelle chinoise ou ayurvédique, ou transmis oralement, ont permis de soulager une multitude de maux. Ainsi, en Chine, les tiges de l’éphédra (Ephedra sinica Stapf), contenant de l’éphédrine (un puissant décongestionnant), étaient employées contre le rhume, la toux et l’asthme il y a déjà 5 000 ans. En Europe, les feuilles de digitale (Digitalis purpurea L.), d’où est extraite la digoxine (un cardiotonique), servaient dès le Moyen Âge à traiter les œdèmes.

En Amérique du Sud, l’écorce du quinquina (Cinchona pubescens Vahl.), contenant de la quinine (antipaludique), étaient utilisées par des communautés indigènes pour combattre les fièvres. En Inde, les racines de rauvolfia (Rauvolfia serpentina (L.) Benth. ex Kurz) contenant de la réserpine (antihypertenseur), furent même employées par Mahatma Gandhi pour traiter son hypertension.

Aujourd’hui encore, les plantes médicinales restent très utilisées, notamment dans les régions où l’accès aux médicaments conventionnels est limité. Mais une question demeure : sont-elles toutes réellement efficaces ? Leur action va-t-elle au-delà d’un simple effet placebo ? Et peuvent-elles être dangereuses ?

C’est à ces interrogations que répond l’ethnopharmacologie : une science à la croisée de l’ethnobotanique et de la pharmacologie. Elle vise à étudier les remèdes traditionnels pour en comprendre leurs effets, valider leur usage et prévenir les risques. Elle contribue aussi à préserver et valoriser les savoirs médicinaux issus des cultures du monde.

Un patrimoine mondial… encore peu étudié

Ces études sont d’autant plus cruciales que les plantes occupent encore une place centrale dans la vie quotidienne de nombreuses sociétés. En Afrique subsaharienne, environ 60 % de la population a recours à la médecine traditionnelle. En Asie, ce chiffre avoisine les 50 %. Et en Europe, 35 % de la population française déclare avoir utilisé des plantes médicinales ou d’autres types de médecines non conventionnelles dans les douze derniers mois – l’un des taux les plus élevés du continent !

Cette spécificité française s’explique par un faisceau de facteurs : une culture de résistance à l’autorité (face à la rigidité bureaucratique ou au monopole médical), un héritage rural (valorisation des « simples » de nos campagnes et méfiance envers une médecine jugée trop technologique), mais aussi une ouverture au religieux, au spirituel et au « paranormal » (pèlerinages de Lourdes, magnétisme, voyance…).

Ces chiffres ne reflètent pourtant pas toute la richesse de la phytothérapie française (la phytothérapie correspondant littéralement à l’usage thérapeutique des plantes). Dans les territoires d’outre-mer, les savoirs traditionnels sont particulièrement vivants.

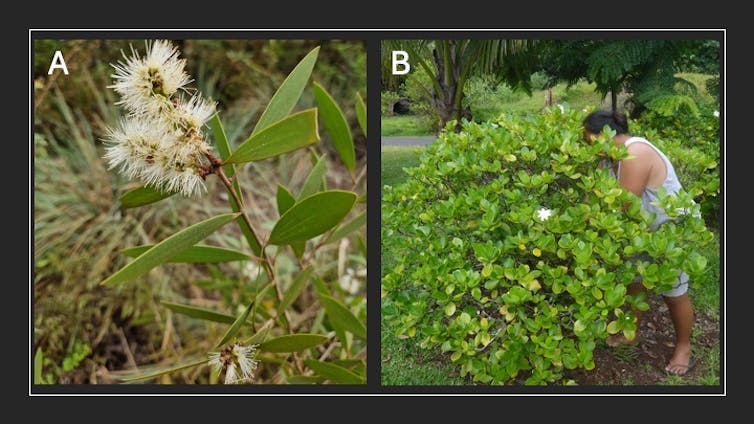

Que ce soit en Nouvelle-Calédonie, où se côtoient traditions kanak, polynésienne, wallisienne, chinoise et vietnamienne, ou en Guyane française, avec les médecines créole, amérindienne, hmong ou noir-marron. Au total, les 13 territoires ultramarins apportent une richesse indéniable à la pharmacopée française. Preuve en est : 75 plantes ultramarines utilisées en Guadeloupe, en Guyane française, à la Martinique et à La Réunion ont récemment été intégrées à la pharmacopée nationale, un document officiel recensant les matières premières autorisées pour la fabrication des médicaments. Parmi elles, le gros thym (Coleus amboinicus Lour.) dont les feuilles sont utilisées pour traiter les rhumatismes, les fièvres ou encore l’asthme dans ces quatre territoires.

Mais cela reste l’arbre qui cache la forêt : sur les quelques 610 plantes inscrites à la pharmacopée française, seules quelques-unes proviennent des territoires ultramarins, alors même que les Antilles, la Guyane française et la Nouvelle-Calédonie comptent chacune environ 600 espèces médicinales recensées par la recherche. Plus largement encore, à l’échelle mondiale, seules 16 % des 28 187 plantes médicinales connues figurent aujourd’hui dans une pharmacopée officielle ou un ouvrage réglementaire. Autrement dit, l’immense majorité de ce patrimoine reste à explorer, comprendre et valoriser.

Étudier, valider, protéger

Dans les pharmacopées officielles, chaque plante fait l’objet d’une monographie : un document scientifique qui rassemble son identité botanique, ses composés bioactifs connus, ses données pharmacologiques et toxicologiques ainsi que les usages traditionnels et établis scientifiquement (indications thérapeutiques, posologies, modes d’administration, précautions d’emploi). En somme, une monographie joue à la fois le rôle de carte d’identité et de notice d’emploi de la plante. Validée par des comités d’experts, elle constitue une référence solide pour les professionnels de santé comme pour les autorités sanitaires.

Lorsqu’une plante n’est pas intégrée dans une pharmacopée, son usage reste donc empirique : on peut l’utiliser depuis des siècles, mais sans données claires sur son efficacité, la sécurité ou les risques d’interactions avec d’autres traitements.

Pour avancer vers la création de monographies et mieux intégrer ces plantes aux systèmes de santé, plusieurs outils sont à notre disposition :

des enquêtes ethnobotaniques, pour recenser les savoirs traditionnels et décrire les remèdes utilisés ;

des tests pharmacologiques, pour comprendre l’effet biologique des plantes et le lien avec leur usage (ex. : une plante utilisée contre les furoncles peut être testée contre le staphylocoque doré) ;

des analyses toxicologiques, pour évaluer l’innocuité des plantes, sur cellules humaines ou organismes vivants ;

des analyses phytochimiques, pour identifier les molécules actives, grâce à des techniques comme la chromatographie ou la spectrométrie de masse.

Au sein de nos laboratoires PharmaDev à Toulouse (Haute-Garonne) et à Nouméa (Nouvelle-Calédonie), nous combinons ces approches pour mieux comprendre les plantes et les intégrer, à terme, dans les systèmes de soins. Nous étudions des pharmacopées issues de Mayotte, de Nouvelle-Calédonie, de Polynésie française, mais aussi du Bénin, du Pérou, du Cambodge ou du Vanuatu.

Par exemple, nous avons analysé des remèdes du Pacifique utilisés chez les enfants pour en comprendre les bénéfices thérapeutiques et les risques toxiques. En Nouvelle-Calédonie, les feuilles de niaouli (Melaleuca quinquenervia (Cav.) S.T.Blake) sont couramment utilisées contre les rhumes en automédication. Or, elles contiennent de l’eucalyptol, susceptible de provoquer des convulsions chez les enfants de moins de 36 mois. Il est donc recommandé de ne pas employer ce remède chez les enfants de cet âge et/ou ayant eu des antécédents d’épilepsie ou de convulsions fébriles et, en cas de doute, de se référer à un professionnel de santé (médecin, pharmacien…). D’ailleurs, certains médicaments à base d’huile essentielle de niaouli peuvent, en fonction du dosage, être réservés à l’adulte. C’est précisément pour cela que nous diffusons nos résultats à travers des articles scientifiques, des séminaires et des livrets de vulgarisation, afin que chacun puisse faire un usage éclairé de ces remèdes.

Médecine traditionnelle et enjeux de développement durable

En Polynésie française, nous étudions la médecine traditionnelle à travers le développement durable. Plusieurs menaces pèsent aujourd’hui sur ces pratiques : la migration des jeunes, qui fragilise la transmission intergénérationnelle des savoirs ; le changement climatique, qui modifie la répartition des plantes ; ou encore les espèces invasives, qui concurrencent et parfois supplantent les espèces locales.

Or, ces savoirs sont essentiels pour assurer un usage sûr et efficace des plantes médicinales. Sortis de leur contexte ou mal interprétés, ils peuvent conduire à une perte d’efficacité, voire à des intoxications.

Un exemple concret est celui du faux-tabac (Heliotropium arboreum), ou tahinu en tahitien, dont les feuilles sont traditionnellement utilisées dans le traitement de la ciguatera, une intoxication alimentaire liée à la consommation de poissons, en Polynésie et ailleurs dans le Pacifique. Des études scientifiques ont confirmé son activité neuroprotectrice et identifié la molécule responsable : l’acide rosmarinique. Mais une réinterprétation erronée de ces résultats a conduit certaines personnes à utiliser l’huile essentielle de romarin. Or, malgré son nom, cette huile ne contient pas d’acide rosmarinique. Résultat : non seulement le traitement est inefficace, mais il peut même devenir toxique, car les huiles essentielles doivent être manipulées avec une grande précaution.

Cet exemple illustre un double enjeu : la nécessité de préserver les savoirs traditionnels dans leur contexte culturel et celle de les valider scientifiquement pour éviter les dérives.

En ce sens, la médecine traditionnelle est indissociable des objectifs de développement durable : elle offre une approche biologique, sociale, psychologique et spirituelle de la santé, elle permet de maintenir les savoirs intergénérationnels, de valoriser la biodiversité locale et de réduire la dépendance aux médicaments importés.

C’est dans cette perspective que notre programme de recherche s’attache à identifier les menaces, proposer des solutions, par exemple en renforçant les liens intergénérationnels ou en intégrant les connaissances sur les plantes dans le système scolaire, et à valider scientifiquement les plantes les plus utilisées.

François Chassagne a reçu des financements de l'ANR (Agence Nationale de la Recherche)

09.12.2025 à 11:59

Et si la masturbation pouvait réduire les effets indésirables de la ménopause ?

Jennifer Power, Principal Research Fellow, Australian Research Centre in Sex, Health and Society, La Trobe University

Texte intégral (1520 mots)

Une étude récente relayée dans le monde entier suggère que la masturbation pourrait atténuer certains symptômes désagréables chez les femmes en périménopause ou ménopause. Si cette attention médiatique peut surprendre, c’est sans doute parce que la masturbation reste peu évoquée, surtout chez les femmes plus âgées, et apparaît ici comme une stratégie inédite – voire audacieuse – de soulagement. Mais cette pratique peut-elle réellement améliorer les troubles liés à la ménopause ?

Selon une étude qui a suscité l’intérêt des médias dans le monde entier, une femme périménopausée et ménopausée sur dix se masturbe pour adoucir (soulager) les symptômes de la ménopause.

Cette attention s’explique sans doute par le fait que la masturbation est une méthode nouvelle – et peut-être un peu audacieuse – pour soulager les symptômes désagréables de la ménopause, tandis que les femmes, à partir d’un certain âge, sont souvent perçues comme asexuées.

La masturbation soulage-t-elle vraiment les effets indésirables, comme le suggère l’étude publiée dans la revue scientifique américaine Menopause ? Examinons la solidité des preuves.

Les bienfaits de la masturbation pour la santé

L’étude, menée aux États-Unis par des chercheurs du Kinsey Institute de l’Université de l’Indiana – l’un des instituts de recherche les plus reconnus dans le domaine du sexe et des relations –, a été financée par la société de sex-toys Womanizer.

Les chercheurs ont interrogé un échantillon représentatif de 1 178 femmes âgées de 40 à 65 ans, en périménopause et ménopause.

Celles ayant constaté des changements dans leurs règles tout en ayant eu au moins une menstruation durant l’année précédente ont été classées comme périménopausées, tandis que celles n’ayant plus eu de règles depuis un an ou plus ont été classées comme ménopausées.

Environ quatre femmes sur cinq ont déjà pratiqué la masturbation. Parmi elles, environ 20 % ont déclaré qu’elle soulageait leurs symptômes dans une certaine mesure. Chez les femmes en périménopause, les symptômes les plus atténués concernaient les troubles du sommeil et l’irritabilité. Chez un petit nombre de femmes ménopausées, la masturbation semblait surtout aider à réduire les inconforts sexuels, les ballonnements et les mictions douloureuses.

Ces résultats rejoignent ceux d’études antérieures montrant que la masturbation jusqu’à l’orgasme peut aider à réduire l’anxiété et la détresse psychologique, améliorer le sommeil et réduire les inconforts sexuels.

Toutefois, les recherches portant sur les bienfaits de la masturbation – sur la santé, la vie sociale, les relations ou le soulagement des symptômes de la ménopause – restent rares.

Nous ne savons donc pas précisément par quels mécanismes la masturbation pourrait améliorer ces symptômes. Les chercheurs avancent néanmoins que les effets relaxants de l’orgasme et la libération d’endorphines peuvent améliorer l’humeur, favoriser le sommeil et réduire les irritations et les douleurs lors des rapports sexuels. L’afflux sanguin induit par la masturbation au niveau de la zone génitale serait en effet de nature à améliorer les symptômes, à redonner de l'élasticité aux tissus et à réduire la sécheresse vaginale.

Un petit nombre de femmes ont toutefois indiqué que la masturbation avait aggravé leurs symptômes, sans que les raisons ne soient claires.

La masturbation reste stigmatisée

La masturbation n’est généralement plus considérée comme un péché ou un acte dangereux. Mais elle demeure stigmatisée. Les femmes, en particulier, l’associent souvent à quelque chose de honteux et ont tendance à en parler peu. La stigmatisation et l’invisibilité qui l’entourent expliquent qu’elle soit rarement étudiée dans des recherches cliniques.

Il en découle un manque de preuves concernant son efficacité pour soulager les symptômes de la ménopause, surtout en comparaison avec d’autres interventions non médicales, telles que l’activité physique ou la réduction du stress.

L’étude états-unienne montre d’ailleurs que les femmes s’appuient beaucoup plus volontiers sur des stratégies validées scientifiquement – activité physique, alimentation, gestion du stress, que sur la masturbation, même si beaucoup n’avaient probablement jamais envisagé cette dernière comme une option.

La masturbation ne convient pas à tout le monde

La masturbation est gratuite, relativement simple et, pour la plupart des femmes, agréable. Il n’y a donc aucune raison de ne pas la promouvoir comme une stratégie accessible pouvant soulager les symptômes chez certaines femmes. Mais la réalité est plus complexe : certaines rencontrent des obstacles.

Toutes les femmes ne se masturbent pas et ne trouvent pas forcément la pratique plaisante. Près d’une femme sur cinq interrogée dans l’étude américaine n’avait jamais pratiqué la masturbation. Ce chiffre, plus élevé chez les femmes plus âgées et ménopausées, reflète peut-être un changement générationnel dans les attitudes. Certaines participantes évoquaient des réticences morales ou religieuses.

D’autres études ont également montré qu’un nombre significatif de femmes ne se masturbent pas. Il peut y avoir de nombreuses raisons à cela, allant du manque de désir à un manque d’intimité ou de « temps pour soi ». Les femmes plus âgées peuvent rencontrer des obstacles physiques complexes : baisse de libido, mobilité réduite, douleur, etc.

Le silence et la stigmatisation entourant la masturbation rendent également difficile pour les professionnels de santé d’aborder ce sujet. L’étude américaine révèle ainsi que presque toutes les participantes n’avaient jamais parlé de masturbation avec un médecin.

Pourtant, beaucoup se sont montrées ouvertes à l’idée : environ 56 % des femmes en périménopause seraient prêtes à inclure la masturbation à leur routine bien-être si le médecin le leur conseillait.

La masturbation comme nouvelle stratégie

Même s’il n’existe aucune garantie que la masturbation soulagera les symptômes de la ménopause chez toutes les femmes, la proposer comme piste ne présente pas de risque : il s’agit de la pratique sexuelle la plus sûre qui soit.

Nous parlons peu de la masturbation, surtout chez les femmes d’un certain âge. En montrant que la majorité d’entre elles s’y adonnent et que cela peut offrir des effets bénéfiques sur la santé, cette étude représente une contribution. Importante et novatrice.

Jennifer Power a reçu des financements de l'Australian Research Council et du ministère australien de la Santé, du Handicap et du Vieillissement, et a précédemment reçu des financements de ViiV Healthcare et Gilead Sciences pour des projets sans rapport avec ce sujet.

08.12.2025 à 16:22

Apprentissage, service civique, stages… Les politiques d’insertion des jeunes, entre promesses d’embauche et faux espoirs

Florence Ihaddadene, Maîtresse de conférences en sciences de l'éducation et sociologie, Université de Picardie Jules Verne (UPJV)

Texte intégral (2155 mots)

Du stage au service civique, en passant par l’apprentissage, les dispositifs visant à favoriser l’insertion des jeunes se sont multipliés ces dernières décennies. Au-delà de leur diversité, tous reposent sur une politique de l’espoir qui cache des dérogations au droit du travail et d’importantes inégalités.

Revenu au cœur de l’actualité pendant les débats sur le budget à l’Assemblée nationale, le soutien aux entreprises qui recrutent en apprentissage est remis en cause par le gouvernement. Largement financé par le plan « Un jeune, une solution » qui faisait suite à la crise sanitaire, l’apprentissage a vécu un âge d’or depuis 2020, avec un objectif affiché de 1 million d’apprenties et apprentis en 2027 (en 2017, ils étaient 295 000).

Cette voie de formation est alors décrite comme la voie royale vers l’insertion professionnelle et ses bénéfices pour les jeunes sont rarement discutés. Comme d’autres programmes à destination de ce public, il repose surtout sur un espoir, celui de se rendre « employable », c’est-à-dire conforme aux exigences des employeurs, et de se distinguer dans la course à l’emploi.

Exposée dans l’ouvrage Promesse d’embauche. Comment l’État met l’espoir des jeunes au travail (éditions La Dispute, 2025), l’étude de ces programmes montre qu’ils génèrent, à partir d’une injonction à l’activité et souvent au travail (quasi) gratuit, d’importantes dérogations au droit du travail et aux droits sociaux, dont le service civique est emblématique. L’apprentissage n’échappe pas à ces logiques en générant des effets d’aubaine et de sélection.

Des politiques d’insertion aux politiques d’activation

Dans les années 1980 surgit le problème social du chômage, notamment celui des jeunes, et avec lui, les politiques d’insertion. À partir du Pacte national pour l’emploi de jeunes, de Raymond Barre, en 1977, des dispositifs sont créés pour faciliter l’embauche des jeunes de moins de 25 ans.

Globalement, ils mènent à une subvention des emplois par l’État, souvent dans le public ou l’associatif, comme dans le cas des emplois aidés, ou à une prise en charge des cotisations patronales (et sociales) par l’État (notamment dans le secteur privé lucratif). Par exemple, les 1,7 million de jeunes qui s’engagent dans les travaux d’utilité collective (TUC), entre 1984 et 1990, ne verront pas cette période reconnue pour leur retraite.

En parallèle, le rapport de Bertrand Schwartz au premier ministre mène à la création des missions locales en 1982, qui vont être spécifiquement chargées de l’insertion professionnelle et sociale des moins de 25 ans. Ce traitement particulier, différent de celui du reste de la population active, justifiera ensuite que les jeunes n’aient pas accès au RSA de droit commun. Aujourd’hui encore, les missions locales, qui sont des associations, assument le rôle de service public de l’emploi pour les jeunes.

Depuis la fin des années 2000, sous la double influence de l’Union européenne et des discours du président Nicolas Sarkozy sur l’« assistanat », les politiques d’insertion vont peu à peu être remplacées par des politiques dites d’activation. Celles-ci ont comme spécificité, pour « activer » les dépenses sociales, de demander aux publics concernés de prouver leur activité. Traquant l’oisiveté supposée des bénéficiaires des allocations sociales, particulièrement lorsqu’ils sont jeunes, ces programmes font reposer la responsabilité de l’insertion sur les individus qui doivent faire preuve de leur bonne volonté et même parfois de leur citoyenneté.

Ces politiques visent également de plus en plus l’individualisation des parcours d’insertion. Le plan « Un jeune, une solution », par exemple, propose une palette de dispositifs, dans laquelle chaque jeune doit piocher pour trouver sa solution et créer son propre parcours, à la manière du nouveau baccalauréat par combinaison d’options.

Une dérogation au droit du travail au nom de l’insertion

Avec ces politiques d’activation, il s’agit désormais de travailler à son « employabilité ». Il s’agit de prouver que l’on peut et veut travailler, quitte à le faire gratuitement. C’est le hope labor décrit aux États-Unis par la chercheuse Kathleen Kuehn et le chercheur Thomas F. Corrigan, travail gratuit réalisé dans l’espoir d’une embauche.

C’est sur cet espoir que vont reposer un grand nombre de dispositifs d’insertion promus par les gouvernements successifs depuis les années 2010, énonçant à demi-mot une promesse non d’emploi mais d’« employabilité ». Le public jeune est alors poussé à s’inscrire dans un certain nombre de dispositifs de courte durée, pour construire des parcours d’insertion. Ce qui paradoxalement tend à rallonger la durée d’attente avant le premier emploi.

Déployé à partir de 2010 pour les jeunes de 16 à 25 ans, le service civique est emblématique de ces logiques. Ce programme de volontariat (site officiel du service civique suppose un engagement pour une période qui varie de six à douze mois dans une mission dite d’intérêt général en association ou dans le public, dans le cadre d’une durée hebdomadaire de 24 à 48 heures en contrepartie d’une indemnité de 620 euros (en 2025) et d’un accompagnement au « projet d’avenir ». Ce contrat, inscrit au Code du service national ne permet pas d’accéder à l’assurance chômage pourtant cruciale pour des jeunes qui, rappelons-le, n’ont pas droit au RSA.

À lire aussi : « Une jeunesse, des jeunesses » : des diplômes pour imaginer l’avenir ?