ACCÈS LIBRE Une Politique International Environnement Technologies Culture

03.11.2025 à 16:18

Comment la photographie de guerre a transformé le regard de la France sur la révolution irlandaise

Claire Dubois, Professeure de civilisation irlandaise, Université de Lille

Síobhra Aiken, Senior Lecturer, Queen's University Belfast

Texte intégral (2997 mots)

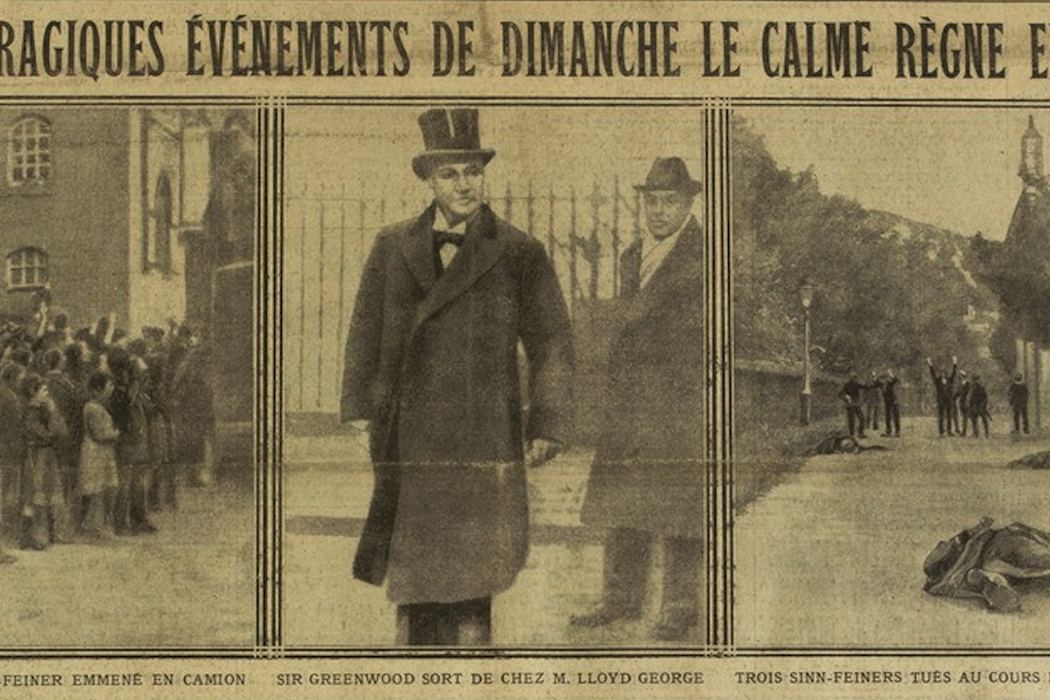

Marquée par la violence et les bouleversements politiques, la révolution irlandaise (1912-1923, selon la plupart des historiens) voit l’opinion nationaliste irlandaise se tourner vers le mouvement républicain Sinn Féin pour obtenir l’indépendance par la force. Une exposition en ligne met en lumière le récit de ces années turbulentes dans la presse française.

Au tournant des années 1920, la France se passionne pour la cause irlandaise. Si la révolution a été le sujet de nombreux articles dans les journaux français, elle a aussi été suivie de près grâce aux images. Ce sont peut-être même les photographes qui ont transformé le regard de la France sur ces événements. Avant ces reportages photographiques, les Français s’intéressaient peu au sujet et beaucoup doutaient que l’Irlande soit capable de se gouverner seule.

C’est avec l’« Insurrection de Pâques » (Easter Rising), en 1916, que le public français a réellement pris conscience de la détermination des indépendantistes irlandais. Dans le contexte de la Première Guerre mondiale et de la Triple-Entente avec la Grande-Bretagne, ces événements sont d’abord perçus avec une certaine méfiance en France. Pourquoi, en effet, organiser une insurrection à Dublin alors que la guerre bat son plein sur le continent ?

Bien que les journalistes aient d’abord présenté l’Insurrection de Pâques comme un complot allemand, l’événement se révèle finalement être un coup de maître dans la lutte pour l’indépendance, notamment sur le plan de l’opinion publique internationale. Dépêchés sur place, les photographes ont alors joué un rôle majeur dans la perception de la cause irlandaise sur le plan européen et international.

Les balbutiements du photojournalisme

En effet, les événements de la période révolutionnaire en Irlande, dont les plus connus du grand public sont le soulèvement de Pâques en 1916, la guerre d’indépendance (1919-1921) et la guerre civile (1922-1923), ont souvent figuré en bonne place dans les pages des journaux français de l’époque.

À cette période, l’utilisation de la photographie dans la presse était encore un art balbutiant, mais cette technologie connut un essor rapide, de même que la circulation des images entre les îles britanniques et le continent. Les agences françaises de presse, telles que Rol et Meurisse, achètent alors des clichés à des photographes locaux (dont le nom n’était jamais crédité) et inondent les rédactions d’images qui, reproduites sous forme de gravures puis directement de photographies, créent une nouvelle proximité avec le conflit. Les journaux illustrés, comme Excelsior et le Miroir, ont aussi contribué au développent d’un photojournalisme plus approfondi, et frappé l’esprit des lecteurs avec leurs unes couvertes de photographies.

Une célèbre photographie publiée en 1916 en une du Miroir montre ainsi la comtesse Constance Markievicz à l’arrière d’un camion de police après le procès qui lui a valu une condamnation à mort, commuée en emprisonnement à vie en raison de son sexe. Souvent interrogée par les reporters français dépêchés sur place lors de la guerre d’indépendance, Markievicz, ancienne élève de l’Académie Julian à Paris, tente de convaincre la France du bien-fondé de l’indépendance irlandaise et condamne les exactions de l’armée britannique en Irlande.

Dans une interview accordée à Joseph Kessel en 1920, elle souligne également l’importance des femmes dans le camp séparatiste et regrette que le socialisme radical ne soit pas aussi populaire en Irlande que sur le continent. Elle contribuera à populariser la cause irlandaise auprès du public français, de même que d’autres indépendantistes francophiles.

Des événements très présents dans la presse française

Pendant la guerre anglo-irlandaise, les journaux français de tous bords se font l’écho des événements en Irlande, publiant des interviews comme des articles de fond retraçant l’histoire du conflit. Le journal illustré parisien Excelsior publie régulièrement des photographies du conflit, y compris plusieurs unes au cours de la période révolutionnaire. L’annonce de la signature du Traité anglo-irlandais figure ainsi en [première page, le 8 décembre 1921], accompagnée, dans un souci didactique, de photographies de séances aux Parlements de Dublin et de Belfast et d’une carte de l’Irlande.

À une semaine d’intervalle, deux unes de la première semaine de juillet 1922 documentent les effets de la guerre civile sur la population irlandaise et les destructions infligées à la ville de Dublin, lors de la bataille opposant les opposants et les supporters du Traité anglo-irlandais.

La publication régulière de portraits et d’entretiens avec les différents protagonistes permet au public de se familiariser avec les acteurs du conflit et de se faire sa propre opinion sur les représailles britanniques pendant la guerre d’indépendance, puis sur la détermination des opposants au Traité pendant la guerre civile. Si la majorité des journaux français semble soutenir la cause indépendantiste, la guerre civile n’est pas comprise par l’opinion, choquée par le meurtre de Michael Collins perpétré par les opposants à l’État libre en août 1922.

Un cliché reproduit en une d’Excelsior le 24 novembre 1920 pousse la propagande à l’extrême. Situé en haut à droite, il montre les cadavres de rebelles vaincus lors de la bataille de Tralee (Kerry). Il s’agit en réalité d’une mise en scène pour des photographes officiels à Killeney dans le comté de Dublin, censée montrer les avancées des Britanniques.

Susciter l’empathie

Au-delà des tentatives de manipulation de l’opinion, de nombreuses photographies disent l’histoire de la résistance irlandaise à l’oppression anglaise et pointent du doigt les destructions et la souffrance de la population civile, familières au public français de l’après-guerre. Les photographies choisies pour accompagner l’article de Joseph Kessel publié dans la Liberté, le 28 septembre 1920, représentent l’ampleur des destructions après le sac de Balbriggan par les « Black and Tans ». L’esthétique des ruines et le désespoir de la femme dont la photographie figure en médaillon ne sont pas sans rappeler la Grande Famine qui frappa l’Irlande quelques décennies auparavant.

Représenter la souffrance est loin d’être aisé.

« Les récits peuvent nous amener à comprendre. Les photographies font autre chose : elles nous hantent », souligne Susan Sontag dans « Devant la douleur des autres », 2003.

Donner à voir ces visages, ces ruines et ces drames humains crée une plus grande proximité avec l’expérience du lecteur français d’après-guerre. Grâce à ces photographies, l’Irlande n’est plus une simple abstraction politique, mais devient une réalité tangible.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

03.11.2025 à 11:49

Peut-on être trop riche ? Tout dépend de vos convictions profondes et du contexte économique national

Jackson Trager, Ph.D. Candidate in Psychology, USC Dornsife College of Letters, Arts and Sciences

Texte intégral (1208 mots)

Des milliardaires à l’intelligence artificielle, la question reste la même : à partir de quand l’accumulation devient-elle excessive ? Une étude internationale montre que nos réponses dépendent autant de nos valeurs morales que du contexte économique et culturel.

À travers les cultures, les mêmes questions reviennent : avoir beaucoup d’argent est-il une bénédiction, un fardeau ou un problème moral ? Selon nos nouvelles recherches, la façon dont on perçoit les milliardaires ne relève pas seulement de l’économie. Le jugement dépend aussi de certains instincts culturels et moraux, ce qui aide à expliquer pourquoi les opinions sur la richesse sont si polarisées.

L’étude, que mon collègue Mohammad Atari et moi avons publiée en juin 2025 dans la revue scientifique PNAS Nexus, s’appuie sur des données d’enquêtes menées auprès de plus de 4 300 personnes dans 20 pays. Nous avons constaté que, si la plupart des gens dans le monde ne condamnent pas fermement le fait de posséder « trop d’argent », il existe des différences culturelles marquées.

Dans les pays riches et plus égalitaires sur le plan économique, comme la Suisse ou la Belgique, les personnes interrogées étaient plus enclines à juger immoral le fait de détenir trop de richesses. À l’inverse, dans des pays plus pauvres et plus inégalitaires, comme le Pérou ou le Nigeria, l’accumulation de richesses était perçue comme davantage acceptable.

Au-delà des aspects économiques, nous avons constaté que les jugements sur la richesse excessive sont aussi façonnés par des intuitions morales plus profondes. Notre étude s’appuie sur la moral foundations theory (théorie des fondements moraux), qui propose que le sens du bien et du mal repose sur six valeurs fondamentales : le soin, l’égalité, la proportionnalité, la loyauté, l’autorité et la pureté. Nous avons observé que les personnes attachées à l’égalité et à la pureté étaient plus susceptibles de considérer la richesse excessive comme répréhensible.

Le résultat concernant l’égalité était attendu, mais le rôle de la « pureté » est plus surprenant. La notion de pureté est généralement associée à des idées de propreté, de sacralité ou d’évitement de la contamination – découvrir qu’elle est liée à une perception négative de la richesse donne un nouveau sens à l’expression anglaise « filthy rich » (mot à mot « salement richenbsp;», de « filth » qui signifie «dégoûtant, obscène, corrompu »).

En tant que chercheur en psychologie sociale étudiant la morale, la culture et la technologie, je m’intéresse à la façon dont ce type de jugements varie selon les groupes et les sociétés. Les systèmes sociaux et institutionnels interagissent avec les croyances morales individuelles, façonnant la manière dont les gens perçoivent des sujets de société clivants comme la richesse et les inégalités – et, en retour, la façon dont ils s’engagent face aux politiques et aux conflits qui en découlent.

Pourquoi est-ce important ?

Les milliardaires exercent une influence croissante dans la politique, la technologie et le développement mondial. Selon l’organisation Oxfam, qui lutte contre la pauvreté, le 1 % le plus riche de la planète détenait en 2024 plus de richesses que 95 % de l’humanité réunie.

Les tentatives de réduction des inégalités par l’impôt ou la régulation des plus riches reposent toutefois peut-être sur une hypothèse erronée : celle selon laquelle l’opinion publique condamnerait largement les richesses extrêmes. Si, au contraire, la majorité considère l’accumulation de richesses comme moralement justifiable, de telles réformes risquent de rencontrer un soutien limité.

Si notre étude montre que la plupart des gens dans le monde ne considèrent pas la richesse excessive comme moralement condamnable, ceux vivant dans des pays plus riches et plus égalitaires sont en revanche bien plus enclins à la critiquer. Ce contraste soulève une question plus aiguë : lorsque les habitants de sociétés privilégiées dénoncent les milliardaires et cherchent à limiter leur influence, mettent-ils réellement en lumière une injustice mondiale – ou projettent-ils leur propre sentiment de culpabilité ?

Imposent-ils un principe moral façonné par leur prospérité à des pays plus pauvres, où la richesse peut représenter la survie, le progrès ou même l’espoir ?

Ce qu’on ignore encore

Une question reste ouverte : comment ces perceptions évoluent-elles avec le temps ? Les attitudes changent-elles à mesure que les sociétés deviennent plus riches ou plus égalitaires ? Les jeunes sont-ils plus enclins que les générations plus âgées à condamner les milliardaires ? Notre étude offre un instantané, mais des recherches menées sur le long terme pourraient montrer si les jugements moraux suivent les évolutions économiques ou culturelles plus larges.

Une autre incertitude concerne le rôle inattendu de la pureté. Pourquoi une valeur associée à la propreté et à la sacralité influencerait-elle la manière dont on juge les milliardaires ? Notre étude complémentaire a révélé que les préoccupations liées à la pureté dépassent la question de l’argent et s’étendent à d’autres formes d’« excès », comme le rejet d’« une trop grande » ambition, sexualité ou recherche de plaisir. Cela suggère que les individus perçoivent peut-être l’excès en lui-même – et pas seulement l’inégalité – comme une forme de corruption.

Et ensuite ?

Nous poursuivons nos recherches sur la manière dont les valeurs culturelles, les systèmes sociaux et les intuitions morales façonnent les jugements portés sur l’équité et sur l’excès – qu’il s’agisse de la richesse et de l’ambition, ou encore du savoir et de la puissance de calcul de l’intelligence artificielle.

Comprendre ces réactions morales instinctives au sein de systèmes sociaux plus larges est essentiel pour les débats sur les inégalités. Mais cela peut aussi aider à expliquer comment les individus évaluent les technologies, les dirigeants et les institutions qui accumulent un pouvoir ou une influence disproportionnés, jugés excessifs.

Jackson Trager ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

03.11.2025 à 11:25

Quand l’enseignement supérieur s’enracine dans son territoire : déni de mondialisation ou stratégie gagnante ?

Jean-Marie Cardebat, Professeur d'économie à l'Université de Bordeaux et Professeur affilié à l'INSEEC Grande Ecole, Université de Bordeaux

Olivier Guyottot, Enseignant-chercheur en stratégie et en sciences politiques, INSEEC Grande École

Texte intégral (1492 mots)

Et si la reconnaissance internationale des universités et des écoles de commerce passait par le terroir ? Alors que la course mondiale aux classements – celui de Shanghai ou d’autres – tend à uniformiser les programmes d’enseignement supérieur, l’ancrage local constitue aussi un atout stratégique.

Dans un paysage académique mondialisé, les grandes marques universitaires se livrent une compétition féroce pour figurer aux premières places des différents palmarès et classements internationaux. La réputation et la légitimité des universités et des écoles reposent encore largement sur la performance de leur recherche académique, comme en témoignent la culture du « Publish or perish » ou les critères du classement de Shanghai. Cette dynamique tend à renforcer la polarisation entre des universités de rang mondial et des établissements régionaux dans un contexte de mimétisme institutionnel et d’uniformisation des programmes d’enseignement supérieur.

Orientation des financements

Mais derrière cette image globalisée de la performance, les établissements d’enseignement supérieur demeurent intimement liés à leur territoire d’implantation. Cet ancrage local est notamment scruté de près par les pouvoirs publics, qui en font un critère pour orienter leurs financements, et par les acteurs institutionnels et les organismes d’accréditation, qui l’intègrent dans leurs critères de qualité pour octroyer le droit de délivrer des diplômes et accréditer des programmes.

Ce rapport au territoire ne se réduit toutefois pas à une logique réglementaire ou budgétaire et soulève une interrogation plus stratégique : la proximité avec les acteurs économiques, sociaux et culturels locaux peut-elle paradoxalement constituer une voie d’accès au rayonnement international pour les établissements d’enseignement supérieur ?

À lire aussi : Les secrets de la domination de l’Université Harvard au classement de Shanghai

Pour tenter de répondre à cette question, nous avons mené un travail d’investigation qui a donné lieu à un article de recherche publié dans la revue internationale Higher Education. Notre publication interroge et invite à repenser la relation entre enracinement local et visibilité mondiale des établissements d’enseignement supérieur à travers un cas emblématique : les régions viticoles françaises et les formations d’enseignement supérieur dédiées au secteur du vin.

Pour essayer de savoir si l’ancrage régional de ces programmes d’enseignement supérieur pouvait constituer un atout dans la compétition internationale entre établissements, notre projet de recherche repose sur une double méthodologie, à la fois quantitative (classement, attractivité, employabilité, résultats académiques de 72 formations en vin réparties sur l’ensemble des régions françaises) et qualitative (22 entretiens semi-directifs menés auprès de responsables académiques, étudiants et diplômés de programmes en vin et de professionnels du secteur viticole).

Attractivité internationale accrue

Notre travail est fondé sur deux hypothèses. La première postule que la réputation d’une région et la richesse de son écosystème (c’est-à-dire la densité des acteurs économiques, culturels et institutionnels liés à ce secteur) influencent directement la performance et la visibilité des formations supérieures spécialisées dans ce domaine. La seconde avance l’idée que ces formations confèrent alors à leurs établissements d’origine une attractivité internationale accrue au lieu de les limiter à un rayonnement local.

Pour explorer cette relation, notre travail a mobilisé deux concepts :

l’heuristique « glonacale », soit un cadre théorique qui permet d’analyser le positionnement des établissements d’enseignement supérieur en considérant simultanément leurs échelles globale, nationale et locale ;

l’échelle « géo-cognitive », qui désigne l’espace géographique dans lequel les établissements d’enseignement supérieur se positionnent. Cet outil permet de prendre en compte et d’interpréter la proximité et la portée symboliques et fonctionnelles des acteurs de cet espace.

Des liens stratégiques

Les résultats de notre étude révèlent ainsi une forte corrélation entre la réputation d’une région spécialisée dans un secteur et la performance des programmes de formation implantés dans cette région et dédiés à ce secteur. Dans le cas des régions viticoles françaises, plus un territoire est identifié et réputé pour son activité, sa culture et son histoire viticoles (Bordeaux, Champagne, Bourgogne…), plus les formations viticoles implantées sur ce territoire bénéficient d’une image de qualité.

Surtout, les liens de ces formations avec l’écosystème local (entreprises, syndicats, institutions) renforcent leurs contenus pédagogiques, favorisent l’employabilité de leurs diplômés et améliorent leur légitimité académique. C’est l’ensemble des critères de performance des programmes d’enseignement qui sont ainsi renforcés par le territoire d’accueil, en particulier l’attractivité auprès des étudiants étrangers.

Contourner la hiérarchie classique

Mais au-delà de ces résultats, qui peuvent sembler logiques, notre étude démontre surtout que les régions dotées d’une spécialisation historique, culturelle ou économique forte, telle que celle en lien avec les bassins viticoles, offrent un espace stratégique alternatif aux universités et aux écoles. Les échelles géo-cognitives liées aux programmes en lien avec le vin permettent de contourner la hiérarchie académique classique centrée sur la recherche.

Ces formations offrent notamment la possibilité de valoriser des caractéristiques distinctives dans les processus d’audit et d’accréditation des universités et des écoles. Elles créent ainsi, pour les établissements d’enseignement supérieur, un espace parallèle de légitimité stable et attractif qui leur permet de se distinguer dans un environnement universitaire dominé par les dynamiques de concurrence et de standardisation fondées sur la taille et les disciplines académiques.

Cette recherche démontre ainsi que les formations spécialisées peuvent jouer un rôle stratégique dans l’ancrage territorial des établissements d’enseignement supérieur tout en leur offrant des avantages compétitifs sur la scène mondiale.

L’enseignement supérieur globalisé ne s’oppose donc pas à la logique de spécialisation régionale : bien au contraire, celle-ci peut constituer un levier majeur de segmentation et de rayonnement stratégique. Pour les universités et les écoles, miser sur les atouts locaux de leurs régions d’implantation est aussi une manière de renforcer leur rayonnement global et de se distinguer dans un monde académique de plus en plus concurrentiel et mondialisé. Un exemple à méditer pour les établissements d’enseignement supérieur présents dans des régions réputées pour des spécialisations fortes similaires au vin.

Président de l'European Association of Wine Economists

Olivier Guyottot ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

03.11.2025 à 11:25

Utilisation de l’écriture inclusive par les marques : indifférence des hommes, soutien nuancé des femmes

Magali Trelohan, Enseignante-chercheuse, comportements de consommations, sociaux et environnementaux, EM Normandie

Abdul Zahid, Lecturer Marketing Management, Anglia Ruskin University

Texte intégral (1360 mots)

L’écriture inclusive fait régulièrement la une des journaux en France. Entre défenseurs et opposants, le débat semble sans fin. Mais que se passe-t-il lorsque des marques utilisent cette écriture pour communiquer ? Une étude révèle que les réactions sont loin d’être homogènes.

La linguistique distingue trois types de langues à travers le monde :

les langues genrées, comme le français ou l’espagnol, qui attribuent un genre grammatical aux noms communs : le bateau, la mer, la plage, le sable, etc. ;

les langues à genre naturel, comme l’anglais, qui ne marquent pas le genre des noms communs – le déterminant est the pour tous les objets –, mais qui marquent le genre principalement dans les pronoms pour les personnes – she/her pour une fille ou une femme et he/his pour un homme ou un garçon ;

Les langues non genrées, comme le chinois ou le turc, qui n’intègrent pas de distinctions grammaticales de genre.

En France, langue dite genrée, le masculin est considéré comme « neutre » et, au pluriel, il « l’emporte sur » le féminin, selon la formule consacrée. Pourtant, des formes dites inclusives, comme le point médian de « salarié·es », se développent pour tenter de rendre visible la diversité des genres. Cette volonté s’appuie sur les travaux en sociolinguistiques qui montrent que la langue façonne notre perception du monde et de notre environnement. Si le sujet fait polémique, c’est parce que l’écriture inclusive interroge le pouvoir symbolique de la langue : qui est inclus ou exclu par les mots que nous choisissons ?

Notre étude, menée auprès de 800 consommatrices et consommateurs français, en analyse le phénomène.

Réaction envers la marque

Pour comprendre ces réactions, nous avons mené une expérience. Chaque participante ou participant à notre étude voyait un post d’une marque de jus de fruits, rédigé avec différentes formes d’écriture inclusive – comme « les client·es » – ou sans, et avec ou sans explication de ce choix par la marque. Nous avons ensuite mesuré leurs réactions, leur attitude envers la marque et leur intention d’achat. Il existe plusieurs formes d’écriture inclusive, nous les avons toutes testées.

- La double flexion consiste à écrire les deux genres séparés par « et » (ex. : « toutes et tous ») ;

- La double flexion contractée fusionne les terminaisons féminines et masculines grâce à un point médian ou un point (ex. : « étudiant·e·s ») ;

- Les termes épicènes ou collectifs que nous appelons forme « dégenrée », ne marquent pas le genre (ex. : « le lectorat » plutôt que « les lecteurs ») ;

- Le masculin générique, la forme usuelle en français avec le masculin qui l’emporte sur le féminin ;

- Le féminin générique, avec l’ensemble des accords au féminin. C’est d’ailleurs cette forme qui est perçue comme la plus sexiste et la moins inclusive par l’ensemble des répondants.

Les hommes indifférents… sauf si la marque explique son choix

Les résultats indiquent que, globalement, les hommes ne réagissent pas différemment à un post utilisant l’écriture inclusive par rapport à un post classique.

Leur attitude, leur intention d’achat ou leur perception de la marque ne changent pas. Cependant, un point intéressant émerge : lorsque la marque explique son choix d’utiliser l’écriture inclusive, en rappelant qu’il s’agit d’une démarche d’égalité ou d’inclusivité, l’attitude des hommes devient plus positive.

Cette explication semble lever une forme de méfiance et permet d’intégrer le message sans rejet.

Les femmes soutiennent l’inclusif mais pas toutes ses formes

Globalement, les femmes affichent une attitude plus favorable que les hommes à l’égard de la marque lorsque celle-ci utilise une écriture inclusive. Elles perçoivent la marque comme plus proche de leurs valeurs et se disent plus enclines à acheter le produit.

Cet effet varie toutefois selon leur vision des rôles de genre.

Les femmes qui adhèrent fortement aux stéréotypes traditionnels – par exemple, l’idée que les hommes et les femmes ont des « rôles naturels » différents – se montrent plus réticentes à l’égard de l’écriture inclusive. Chez elles, l’écriture inclusive (en particulier la forme contractée, c’est-à-dire le point médian, et la forme dégenrée) tend à provoquer un rejet de la marque.

On ne retrouve pas cet effet de l’adhésion aux stéréotypes de genre chez les hommes. Ce n’est pas cela qui influence leurs perceptions et comportements liés à l’écriture inclusive.

Notre étude montre que la forme d’écriture inclusive la plus controversée, celle avec le point médian, suscite davantage de réactions négatives. Comme pour les hommes, lorsque la marque justifie son choix, cette forme controversée est toutefois mieux acceptée.

Puissance idéologique de la langue

Ces résultats mettent en lumière le poids idéologique de la langue. Le masculin reste perçu comme neutre.

Ce constat rejoint les travaux en sociolinguistique sur l’androcentrisme (une vision du monde qui voit l’homme comme l’humain neutre ou typique) et sur la domination symbolique.

Il révèle aussi une ligne de fracture : les femmes ne constituent pas un groupe homogène sur ces questions. Celles qui adhèrent aux normes traditionnelles deviennent les gardiennes d’un certain conservatisme linguistique.

Quelles implications pour les marques ?

Pour les professionnels du marketing, l’écriture inclusive n’est pas qu’une question de style : elle engage la perception de la marque.

Notre étude conseille :

d’expliquer son choix d’écriture inclusive, notamment pour rassurer les consommateurs qui y sont indifférents ou qui sont sceptiques. Ainsi, les marques remporteront leur adhésion ;

d’adapter la forme utilisée : certaines sont perçues comme plus acceptables que d’autres. Le point médian, plus controversé, peut être mis de côté au profit de termes épicènes ou de la double flexion dans le cadre d’une communication qui se veut consensuelle. En revanche, une marque militante pourra choisir la double flexion contractée (le point médian) ;

de connaître son audience : les femmes y sont majoritairement favorables, mais il existe des nuances idéologiques. Comme nous l’avons montré, celles qui adhèrent aux stéréotypes de genre auront tendance à rejeter les marques utilisant l’écriture inclusive.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

03.11.2025 à 11:25

Quand les imaginaires des marques nous inspirent

Valérie Zeitoun, Maitre de Conférences, IAE Paris – Sorbonne Business School

Géraldine Michel, Professeur, IAE Paris – Sorbonne Business School

Texte intégral (3668 mots)

Traversé par de multiples crises, le réel est devenu anxiogène. Il réclame de nouveaux modèles et de nouveaux rêves. Dans ce contexte, les imaginaires des marques viennent se substituer aux grands récits collectifs défaillants, en offrant aux individus de quoi se projeter, espérer, et peut-être apporter de nouvelles raisons de croire. C’est ce qu’analysent ici Valérie Zeitoun et Géraldine Michel, avec Raphaël LLorca, expert associé à la Fondation Jean-Jaurès, Arnaud Caré, directeur général délégué d’Ipsos, et Nicolas Cardon, directeur de l’expérience client d’Ipsos.

« L’esprit du voyage par Louis Vuitton », « La beauté plurielle de Dove », « Le sport inclusif » de Nike, ces imaginaires irriguent notre quotidien. Ils deviennent des forces de projection et de conviction collective, bien au-delà de leur valeur marchande. Face à l’évolution de leur rôle se pose la question de leur influence dans l’ordre social et/ou politique, au-delà de l’ordre marchand.

Comment, dans leur mission d’agent social, les marques participent-elles et poussent-elles au progrès social et environnemental, et permettent-elles ainsi de renouer avec de nouvelles utopies ?

L’imaginaire

L’imaginaire est le fruit de l’imagination d’un individu, d’un groupe ou d’une société. Il produit des représentations ou des mythes qui entretiennent un rapport plus ou moins détaché de la réalité.

Poser l’imaginaire et le réel en parallèle tend à accentuer la tension qui existe entre ces deux notions. Leur relation relève d’une dialectique qui interroge la manière dont l’imaginaire se rapporte au réel et réciproquement. Pour explorer ce rapport complexe, il est possible de distinguer trois dynamiques principales : une dynamique d’opposition, une dynamique de substitution et une dynamique d’enrichissement.

L’imaginaire comme illusion

Depuis l’allégorie de la caverne de Platon, la tradition philosophique a longtemps pensé l’imaginaire et le réel de manière adverse. Pour Platon, les individus vivent souvent dans l’ignorance, attachés aux apparences, et il faut un effort de pensée pour accéder à la vérité, c’est-à-dire au « monde des Idées ». Dans cette perspective, le réel renvoie au monde des idées invariables et immuables tandis que l’imaginaire est lui entendu comme illusoire, fictif, sans réalité.

Notre culture occidentale est profondément ancrée dans cette opposition, valorisant le réel comme domaine de la vérité et de la connaissance, reléguant l’imaginaire au rang du fantasme.

Dans le domaine de la consommation, la célèbre réclame de Persil (« lave plus blanc ») est emblématique d’une rhétorique publicitaire fondée sur l’excès de promesse. En invoquant l’idée d’un « plus blanc que blanc », elle promet l’inatteignable et participe à une forme d’aliénation ou d’asservissement. Le récit de marque se réduit alors à l’idée d’une illusion, voire d’une tromperie.

L’imaginaire comme idéalisation

Le philosophe Jean Baudrillard propose une autre perspective. Selon lui, l’imaginaire ne s’oppose plus simplement au réel, mais s’y substitue. Le simulacre n’est pas une simple copie du réel : il en efface la référence. Il produit l’illusion d’un monde réel, mais entièrement artificiel, forme d’hyperréalité, saturée d’images et de signes.

L’imaginaire, dès lors, se substitue au réel et l’idéalise. Les campagnes publicitaires de la marque McDonald’s qui reposent sur une représentation parfaite du hamburger – comparée à la réalité du hamburger servi dans les restaurants – génèrent un simulacre. Les consommateurs n’achètent pas un hamburger, mais l’image idyllique du hamburger.

L’imaginaire comme ressource du réel

Une troisième approche, initiée par le philosophe Maurice Merleau-Ponty, envisage au contraire l’imaginaire comme une composante fondamentale du réel. Dans cette perspective, l’imaginaire ne s’oppose pas au réel, il en est le prolongement, voire un producteur. L’imaginaire permettrait d’accéder au réel autrement, éventuellement de le transformer en lui imprimant de nouvelles formes.

L’imaginaire ouvre vers d’autres réels possibles. C’est dans cette dynamique que certaines marques s’inscrivent, et ce faisant réinventent les modalités de notre environnement. C’est le cas de la marque Apple. À son lancement, elle apporte une nouvelle vision de l’ordinateur personnel axée sur la convivialité et le design de l’objet pour s’inscrire dans le quotidien des individus, et se positionner contre des usages de l’époque qui considéraient l’ordinateur comme strict objet du monde du travail.

La fabrique de nouveaux réels collectifs

Dès 1957, le sémiologue Roland Barthes met en évidence la capacité des objets et des signes de consommation à produire un imaginaire socialement partagé. La marque se définit comme objet social et réservoir symbolique. Elle ne se réduit pas à un simple signe marchand, elle agit comme un médiateur symbolique, capable de relier les individus à des univers de significations collectives.

Elle produit du sens et génère de la valeur en projetant des imaginaires partagés. Dans cette direction, les marques iconiques le deviennent, justement, parce qu’elles articulent des imaginaires culturels qui viennent répondre à des enjeux sociaux forts. Nike, en soutenant publiquement le footballeur Colin Kaepernick dans sa protestation contre les violences policières faites aux Afro-Américains, incarne un imaginaire de résistance.

Avec sa campagne « Don’t Buy This Jacket », la marque outdoor Patagonia a supporté un imaginaire plus sobre. Elle incite les consommateurs à ne pas céder au consumérisme. Cet imaginaire s’incarne aussi dans les actes – réparabilité des produits, soutien à des actions environnementales, etc. – et, de fait, devient le réel.

D’autres marques pourraient être ici mentionnées, Dove et le nouvel imaginaire de la beauté : vision alternative qui remet en cause une beauté normative pour la rendre plurielle, femmes de toutes morphologies, âges, origines ou couleurs de peau. C’est encore Ikea ou Levi’s qui participent d’imaginaires plus inclusifs en soutenant la cause LGBTQIA+. Toutes ces marques participent d’une forme d’engagement, fondé sur de nouveaux imaginaires sociaux et/ou culturels, qui permet d’enrichir, de modifier, de transformer le réel.

La marque, un acteur politique ?

Les marques produisent des imaginaires collectifs, en ce sens, comme le propose Raphaël LLorca, elles peuvent être considérées comme « des acteurs politiques » qui structurent et façonnent notre appréhension du réel. L’imaginaire national et la signification « d’être français » se fonde aujourd’hui, en partie, sur des projections et/ou des incarnations proposées par les acteurs marchands tous secteurs confondus, la mode, les transports ou la grande distribution.

L’ironie, souligne Raphaël LLorca, c’est que ce sont souvent des marques étrangères, et singulièrement états-uniennes, comme Burger King ou Nike, qui proposent leur version du roman national français !

Dans tous les cas, la sécrétion d’imaginaires politiques de la part d’acteurs marchands constitue une rupture profonde dans l’équilibre des forces entre les trois ordres traditionnels – ordres politique, religieux et marchand.

Imaginaires de marques et engagement

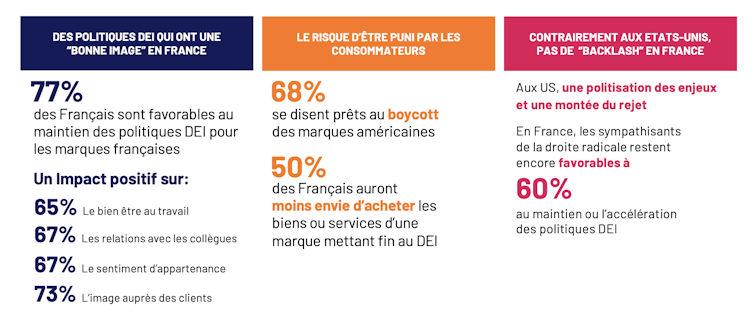

Une étude Ipsos fait le constat d’un lien entre engagement individuel et engagement des marques. Il apparaît ainsi que les fans de marques engagées, comme Disney, Deezer ou Heineken, sont eux-mêmes plus impliqués que la moyenne française dans les causes d’équité et d’égalité entre les populations.

Plus important, en termes de gestion de marque, il apparaît que cette adhésion aux marques, porteuses d’imaginaires positifs, va au-delà d’une élection de principe. 50 % des Français interrogés déclarent, dans le contexte actuel, qu’ils seraient prêts à acheter moins de produits provenant de marques éloignées de leur engagement pour l’équité, la diversité et l’inclusion. Ces résultats montrent que les marques ont le pouvoir de nourrir le réel d’imaginaires sociaux, culturels voire politiques.

Mais comment peuvent-elles le faire ? À cette question, une seconde étude Ipsos explore les conditions d’émergence de nouveaux réels aspirationnels.

Les marques doivent incarner ces imaginaires si elles souhaitent construire des liens émotionnels avec les consommateurs et citoyens. Près de 69 % des interrogés affirment être disposés à rompre avec des marques qui ne tiendraient pas leurs promesses sur des sujets sociaux ; 70 % se déclarent prêts à suivre une marque à laquelle ils sont émotionnellement liés, contre 45 % lorsque ce lien n’est que fonctionnel.

Les imaginaires des marques deviennent des forces de projection et de conviction collective, bien au-delà de leur valeur marchande. Les marques qui s’engagent dans de nouveaux imaginaires et qui leur donnent une réalité tangible favorisent l’engagement des individus, collaborateurs et clients. Ainsi, elles génèrent une adhésion et une implication pérenne, mais, surtout, elles participent d’un élan transformatif social et peut-être politique.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

03.11.2025 à 11:24

Ce que font vraiment les analystes financiers

Pierre Lescoat, Professeur Assistant, Neoma Business School

Pénélope Van den Bussche, Maîtresse de conférences en Sciences de gestion, Université Paris Dauphine – PSL

Texte intégral (1730 mots)

Que font réellement ces analystes financiers, dits analystes « sell-side », au sein des grandes banques d’affaires ? Une étude consacrée à leur travail à travers les pratiques d’évaluation de la performance montre la complexité de ce métier finalement peu connu.

Les analystes financiers dits sell-side conseillent des milliers de professionnels, en particulier les fonds d’investissement qui gèrent les retraites et l’épargne de nombreuses personnes à travers le monde. La recherche en finance s’est beaucoup concentrée sur la fiabilité de leurs recommandations et sur la façon dont elles informent des mouvements de marché, le travail des analystes étant de produire des prévisions fiables.

S’inscrivant dans les travaux en sociologie de la finance, notre étude ne se penche pas tant sur le rôle des analystes, mais sur ce que leur organisation attend d’eux. Nous appréhendons les analystes non pas comme membre des marchés financiers, mais comme membres d’une organisation marchande – la banque qui les emploie – qui les rémunère et les évalue.

Interface des entreprises et des fonds d’investissement

Les analystes sell-side vendent des services financiers à différents clients (d’où le nom sell-side). Ils émettent des conseils sur la vente ou l’achat d’actions boursières de sociétés cotées. Ces analystes sont soumis à une régulation stricte. Ils sont l’interface entre les départements de communication financière des grandes entreprises cotées et les fonds d’investissement, qui investissent en bourse l’argent de leurs clients.

La régulation porte particulièrement sur la prévention des conflits d’intérêts et du délit d’initié, réglementant les informations que les analystes ont le droit ou non de transmettre en fonction de leurs interlocuteurs, selon quels moyens – rapport écrit public, discussions informelles, etc.

Indispensables aux banques

Profession plus discrète que celle de traders, les analystes financiers sont indispensables aux banques. Ils leur fournissent une légitimité puisqu’ils sont reconnus comme des experts sur les marchés financiers. Pour autant, la multiplication des bases de données, ainsi que la concurrence d’ « activistes », les short-seller, remet en question cette expertise et notamment l’objectivité des rapports publiés par les analystes sell-side.

Notre étude se concentre sur le système d’évaluation de la performance des analystes par leur banque. Ce système est particulièrement complexe, car il fait intervenir des groupes professionnels internes et externes à la banque. En externe, les équipes d’analystes sell-side sont soumises chaque année à des classements réalisés par des sites, tels que Extel.

Classement des analystes financiers

Ces classements mettent en compétition les équipes d’analystes entre banques, mais aussi à l’intérieur des banques – entre secteurs d’activités ou zones géographiques couverts –, voire à l’intérieur de leur équipe. Les classements sont constitués suite à la collecte des votes effectués par les analystes buy-side, c’est-à-dire les analystes financiers présents chez les clients des banques (d’où le nom buy-side).

À lire aussi : Vendeurs activistes et analystes financiers, des expertises antagonistes

Ces classements sont par la suite intégrés dans l’évaluation interne de la performance des analystes dans leur banque. D’autres groupes professionnels de la banque comme les vendeurs et les traders sont également amenés à voter pour les analystes, les classant à nouveau.

Plus un analyste sell-side marque la mémoire d’un analyste buy-side ou d’un vendeur, plus ce dernier a des chances de voter pour lui. Selon certains participants à notre étude, il n’existe pas de norme pour marquer la mémoire d’un investisseurs. Un analyste peut aussi bien plaire à un client pour la qualité de ses analyses que pour sa personnalité, ou encore sa capacité à aider les analystes buy-side dans leurs propres analyses. Ce qui importe c’est que le votant se souvienne de lui.

Des analystes entrepreneurs de leur réputation

Dans le but d’obtenir une bonne évaluation de leur performance, les analystes doivent travailler leur réputation en externe, mais aussi en interne. Si on les imagine régulièrement en contact avec leurs clients investisseurs, notre étude met en lumière l’existence d’un gatekeeper : le vendeur, appelé encore sales, en charge de gérer la relation client.

Le vendeur, ou sales, constitue un intermédiaire incontournable qui transmet les arguments des analystes pour appuyer son discours commercial. Les analystes doivent à ce titre effectuer un travail de mise en valeur de leurs recherches. En effet, les vendeurs lisent rarement les rapports, surtout écrits, comme le montrent le professeur de comptabilité Crawford Spence et ses co-auteurs dans une logique de conformité à la loi.

La régulation encadre ces échanges : les espaces de travail des analystes et des vendeurs sont strictement séparés. Il existe donc une ambiguïté entre ce qu’exige la régulation – une séparation stricte des activités – et ce que reflète le système d’évaluation de la performance des analystes, devoir être apprécié et reconnu par les vendeurs.

Performativité des narratifs d’analyste

L’économiste Robert Shiller a mis en avant à quel point l’économie se constitue à partir de récits, c’est-à-dire d’histoires, ou stories, qui circulent et donnent un sens des évènements économiques. Chez les analystes financiers, ces « narratifs » correspondent aux interprétations et recommandations que font les analystes pour leurs clients. Notre étude prolonge ces travaux, ainsi que ceux de l’anthropologue Stefan Leins en mobilisant le concept d’autorité narrative. Cette autorité, et la compétition qui existe entre analystes pour l’obtenir, est au fondement de leur évaluation.

C’est en faisant circuler ces narratifs d’analystes qu’on voit leur « performativité ». Par l’intermédiaire des vendeurs, les narratifs des analystes sell-side atteignent les clients investisseurs qui peuvent eux-mêmes les réutiliser pour défendre leurs idées auprès de leurs propres clients. C’est ainsi que les narratifs circulent sur les marchés. Or, la valeur de ces narratifs dépend aussi des « modes » existantes sur les marchés, modes dont la dimension éphémère contraste avec le temps long nécessaire à un analystes pour développer une expertise. Comme dit l’une de nos sources, Michael, analyste sell-side dans une banque d’une capitale financière européenne :

« Si tu es réputé comme étant le meilleur fabricant de cabines téléphoniques aujourd’hui, tu es peut-être la star des cabines téléphoniques, mais plus personne n’en veut donc ça ne sert à rien. »

Ces modes sont cruciales pour les banques, car ces dernières se rémunèrent sur les transactions effectuées pour le compte de leurs clients. Les secteurs « à la mode » génèrent potentiellement plus de commissions, puisque le volume de transaction y est plus important. Elles ont comme contrepartie de remettre en cause régulièrement la valeur de l’expertise des analystes.

Notre étude rappelle ainsi qu’au-delà des transactions et des rapports écrits, les marchés sont bien animés par des professionnels incarnés qui parlent, échangent, analysent au quotidien. Ils font de ces termes un peu abstraits une communauté d’humains qui constituent sans toujours en avoir clairement l’idée les marchés qu’ils ne cessent de décrire tout au long de leurs carrières.

Cette étude a été menée dans le cadre d'une thèse de doctorat financée par l'ESCP Europe et le réseau Netw@rks.

Pénélope Van den Bussche ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr