ACCÈS LIBRE Une Politique International Environnement Technologies Culture

04.11.2025 à 17:18

Combien l’employeur doit-il payer pour attirer des cadres en dehors des zones urbaines ?

Pierre Fleckinger, Professeur d'économie, chercheur associé à Paris School of Economics, titulaire de la chaire etilab, Mines Paris - PSL

Antoine Prevet, Directeur exécutif Chaire etilab, Chercheur en économie, Mines Paris - PSL

Texte intégral (1892 mots)

Pourquoi certaines régions, comme l’Île-de-France, continuent-elles à concentrer richesses et habitants, tandis que d’autres peinent à se développer ? La clé se trouve dans le cercle vertueux – ou vicieux – de la densité. Le prix de l’immobilier joue un rôle non négligeable dans cette problématique stratégique à l’heure d’une éventuelle ré-industrialisation.

La question du développement économique des territoires est avant tout une histoire de poule et d’œuf. Comme la poule est issue de l’œuf qu’a pondu… une poule, un territoire a besoin de travailleurs pour prospérer… mais ces mêmes travailleurs ne s’y installent que si le territoire est suffisamment attractif. Ainsi, un territoire dense offre de meilleures perspectives professionnelles mais aussi des commodités recherchées, comme des écoles, des hôpitaux, des théâtres, des transports ou encore des services publics… Autant de raisons pour les travailleurs de préférer les régions plus développées.

Nous avons étudié cette dynamique à travers une question précise : comment font les entreprises situées dans des territoires peu denses pour attirer malgré tout des talents ? Une réponse pzut être trouvée du côté de la théorie économique des « différences compensatrices », qui explique les écarts de salaires en fonction des professions et de l’hétérogénéité des territoires.

Quand la réalité dément la théorie…

Selon cette théorie des différences compensatrices, les écarts de salaires s’expliquent à la fois par les compétences des individus et par les conditions de travail – qui incluent la qualité de vie. Plus les conditions proposées sont difficiles, plus le salaire doit être élevé pour attirer des travailleurs. Dit autrement, imaginons deux individus possédant des compétences équivalentes, si l’un des deux vit dans une zone moins dense que l’autre, offrant moins de commodités, alors il devrait logiquement être mieux payé (pour compenser cet écart).

À lire aussi : « Réindustrialiser ne fera pas revenir à la situation des années 1980 »

Or, les données racontent une tout autre histoire. Au contraire, comme on l’observe dans le tableau 1 ci-dessous, les salaires moyens bruts horaires diminuent avec la densité. Pour les cadres, par exemple, ils passent de 43 euros dans les zones les plus denses à 35 euros dans les zones les moins denses – soit une différence de plus de 23 %.

Le prix de la densité

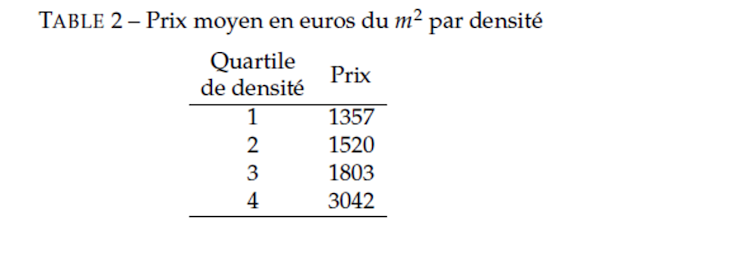

Mais ce constat est incomplet. Car les avantages liés à la densité ont un prix : logements plus chers, congestion urbaine, coût de la vie plus élevé… Les prix des logements, en particulier, comme l’illustre le tableau 2, passent de 1 357 euros par m2 dans les zones les moins denses à 3 042 euros par m2 dans les zones les plus denses, soit un rapport de plus de 1 pour 2 entre le premier et le dernier quartile.

Deux intuitions émergent de ces chiffres :

Le pouvoir d’achat immobilier constitue un facteur clé de compensation pour les ménages vivant dans des zones peu denses, car le logement représente une part importante du budget (environ 20 % en 2017) [Insee, Revenus et patrimoine des ménages, 2021] et son prix varie fortement selon la densité locale.

De plus, la baisse des prix immobiliers tend à jouer un rôle de compensation lorsque les autres avantages liés à la densité (prix à la consommation, qualité de vie, accès aux services, etc.) s’amenuisent. Cette compensation est donc plus marquée dans les zones les moins denses et pour les personnes qui valorisent particulièrement les bénéfices de la densité urbaine.

En somme, ce n’est pas tant le salaire en valeur absolue qui compense la faible densité, mais bien le niveau de vie relatif, que nous pouvons mesurer par le rapport entre revenu et prix de l’immobilier.

Moins dense mais meilleur niveau de vie

Comment vérifier que vivre dans une zone moins dense se traduise vraiment par un gain de niveau de vie, surtout pour les plus qualifiés ? Pour répondre à cette question, il faut comparer non plus seulement les salaires, mais le rapport entre revenu et coût de la vie – que nous avons estimé en intégrant le prix de l’immobilier.

C’est un exercice difficile, car de nombreux facteurs entrent en jeu : compétences individuelles (âge, diplôme, genre), caractéristiques du marché du travail (offre et demande d’emplois, organisation des entreprises, exportations, automatisation), et enfin éléments territoriaux (densité, infrastructures, effets d’agglomération). Si l’on ne prend pas systématiquement en compte ces variables, on risque de confondre l’effet réel de la densité avec d’autres déterminants.

Pour dépasser cet obstacle, nous avons mobilisé un volume de données considérable : l’ensemble des contrats de travail signés dans l’industrie manufacturière en 2019, enrichi de données d’entreprises et d’indicateurs locaux. Cette richesse statistique nous a permis d’isoler au mieux l’effet propre de la densité, en comparant des profils similaires à travers des territoires de différentes densités.

Un salaire qui progresse comme le prix de l’immobilier

Les résultats sont clairs. Plus la densité augmente, plus le salaire brut nominal progresse… mais le pouvoir d’achat immobilier recule. Une hausse de 1 % de la densité accroît de 0,15 % le temps de travail nécessaire pour acheter un mètre carré de logement. Autrement dit, les salaires montent avec la densité, mais pas assez pour compenser l’explosion des prix immobiliers.

Cet effet touche particulièrement les cadres. Ce sont eux qui voient le plus leurs salaires progresser dans les zones denses… mais ce sont aussi ceux qui perdent le plus en pouvoir d’achat immobilier. En choisissant de s’installer dans une zone moins dense, ils acceptent un sacrifice salarial, mais bénéficient d’un gain considérable sur le logement.

Pourquoi cette « prime » est-elle plus forte pour les cadres ? Dans une optique de différences compensatrices, notre résultat indique que les cadres sont les plus sensibles aux avantages liés à la densité, puisqu’ils sont prêts pour en bénéficier à perdre relativement plus en pouvoir d’achat immobilier.

Un enjeu de politique publique

Nos résultats doivent toutefois être interprétés avec prudence. Plusieurs éléments méritent d’être approfondis :

Le niveau de formation des travailleurs : faute de données sur le niveau de formation, il est possible que les différences observées reflètent en partie une disparité de profils entre zones denses et moins denses. Si l’on pouvait isoler mieux l’effet de cette variable, la prime identifiée serait probablement encore plus marquée.

La dimension familiale : les décisions de mobilité se prennent rarement seul. L’attractivité d’un territoire dépend aussi des emplois pour le conjoint, des écoles pour les enfants, ou encore des infrastructures de santé.

L’évolution au cours de la vie : les priorités changent avec l’âge. La proximité d’un lycée importe peu sans enfants adolescents, tandis que l’accès aux soins devient crucial en vieillissant.

L’effet du Covid et du télétravail : les données mobilisées datent de 2019. Or, la crise sanitaire a modifié l’arbitrage entre grands centres et territoires moins denses, en donnant un nouvel élan au travail à distance.

Ceci étant rappelé, les zones moins denses sont des candidates naturelles à l’effort de réindustrialisation, ne serait-ce que pour des raisons foncières évidentes. Y attirer des travailleurs qualifiés est un enjeu de taille pour les entreprises. La politique publique se doit d’intégrer ces considérations d’attractivité de l’emploi selon la densité, tandis que les entreprises peuvent trouver un équilibre en s’y installant et bénéficiant du coût de la vie moins cher, à condition que les commodités et l’infrastructure ne soient pas dissuasives.

L’écart grandissant sur ce plan entre zones (très) denses et zones moins denses risque de priver durablement des espaces ayant pourtant un important potentiel de (re)développement industriel. Pour résoudre le problème de la poule et de l’œuf et enclencher des cercles vertueux, seule une coordination de la puissance publique et des entreprises au niveau local pourra permettre une réindustrialisation pérenne, qui bénéficiera aux employés, aux entreprises et aux territoires.

Antoine Prevet est directeur executif de l'etilab financé notamment par la Région Île-de-France, Crédit Agricole Île-de-France, Forvis Mazars ainsi que des ETI partenaires : Réseau DEF, Septodont, ETPO, SOCOTEC, Diot-Siaci, Acorus, Henner, Ceva, Prova, E'nergys et Hopscotch.

Pierre Fleckinger ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

04.11.2025 à 17:17

« L’Étranger » : pourquoi le roman de Camus déchaîne toujours les passions

Catherine Brun, Professeur de littérature de langue française, Université Sorbonne Nouvelle, Paris 3

Texte intégral (1224 mots)

Depuis sa publication en 1942, il y a plus de quatre-vingts ans, « l’Étranger », ce roman devenu un classique traduit en plus de 70 langues, best-seller des éditions Gallimard, n’a cessé de fasciner, de susciter des adaptations de tous ordres et de déclencher des polémiques. Comme s’il pouvait encore tendre à notre temps un miroir sagace et en révéler les fractures.

Ces dernières années, les essais se suivent pour dénoncer un Camus colonial sinon colonialiste. Et l’on répète volontiers ce que Mouloud Feraoun d’abord, Kateb Yacine ensuite, lui ont reproché, le premier « que parmi tous ces personnages de [la Peste] il n’y eût aucun indigène et qu’Oran ne fût à [ses] yeux qu’une banale préfecture française », et le second de s’en être tenu à une position « morale » plutôt que politique.

Un débat sans fin

Les analyses de l’universitaire, théoricien littéraire et critique palestino-américain Edward Saïd allaient dans ce sens : selon lui, outre que Camus « a eu tort historiquement puisque les Français ont abandonné l’Algérie et toute revendication sur elle », il a « ignor[é] ou néglig[é] l’histoire ».

Les récentes écritures fictionnelles de l’Étranger, dont la plus connue est à ce jour le Meursault, contre-enquête, de Kamel Daoud, qui fut précédé de peu par Aujourd’hui Meursault est mort, de Salah Guemriche, ont encore creusé ce sillon en faisant de l’anonymat de « l’Arabe » assassiné sur la plage l’objet d’un renversement nécessaire, et le symptôme de « la déshumanisation systématique » attachée au colonialisme, pour reprendre les termes du psychiatre, écrivain et et militant anticolonialiste Frantz Fanon, qui fut fortement impliqué dans la lutte pour l’indépendance de l’Algérie.

Les camusiens, eux, rappellent que Camus a voulu faire œuvre de dire « le moins », que l’écrivain ne fait que refléter dans son œuvre la tragique séparation des communautés et leur ignorance réciproque, et qu’un auteur ne doit pas à être confondu avec son personnage.

Le débat semble, toutefois, voué à la répétition. Aucun consensus ne se dégage quant aux véritables positions de l’auteur de l’Étranger en matière de fait colonial en général et d’Algérie coloniale en particulier. Chacun paraît attaché à « son » Camus, et l’Étranger, selon les lectures, est regardé comme le révélateur de la conscience ou de l’inconscience coloniale.

Une lecture passionnée

Car il s’agit moins de l’Étranger dans ces échanges – de sa composition, de son style, de ses images, de sa philosophie – que de ce qu’il incarne pour chacune des composantes de la société française postcoloniale – si l’on veut bien entendre, comme y invite la philosophe franco-algérienne Seloua Luste Boulbina, que la colonisation imprègne tout autant l’inconscient collectif du pays colonisateur que celui du pays colonisé – quoique de façon fort différente.

La matité de l’Étranger, son opacité nous révèlent à nous-mêmes. Ses énigmes nous parlent de nous : de ce que nous avons saisi du roman lorsque nous l’avons lu d’abord, de ce qu’on nous en a dit, de ce qu’on en a entendu, de ce que nous en percevons au fil du temps, du malaise qu’il a fait (ou pas) naître en nous. Avions-nous véritablement été heurtés par l’anonymat de l’Arabe, à la première lecture ? N’est-ce pas le drame de Meursault, identifié à l’étranger, que nous avions épousé d’abord ? N’avions-nous pas condamné l’inhumanité d’une société vouée à condamner ses réfractaires ? Et si, à l’inverse, nous avions d’emblée été sensibilisés aux enjeux (post)coloniaux du roman, cette lecture avait-elle été programmée par d’autres lecteurs ? Lesquels ? Et pour quoi faire ?

Comment s’étonner que la place de l’Étranger demeure sinon passionnelle, du moins éminemment embarquée en France? Comme l’a fait apparaître le chercheur en sciences politiques Paul Max Morin, sur la base d’une enquête menée auprès de 3 000 jeunes âgés de 18 ans à 25 ans et après une centaine d’entretiens avec des petits-enfants d’appelés, de pieds-noirs, de harkis, de juifs d’Algérie, de militants du Front de libération nationale (FLN) ou de l’Organisation de l'armée secrète (OAS), 39 % des jeunes Français déclarent « avoir un lien familial avec une personne ayant été […] concernée d’une façon ou d’une autre par la guerre d’Algérie ». Comment ne pas admettre que l’actualité de l’Étranger ou plutôt que ses actualités soient d’autant plus vives que son inactualité est grande et que le roman s’offre comme une surface de projection de nos rêves ou de nos refus de reconnaissance ?

Certes, il serait souhaitable de ne pas dissocier les textes de leurs contextes, et les travaux académiques se doivent de resituer ce qui peut l’être, de batailler contre les anachronismes et les amalgames. Mais peut-on, et doit-on, nier le caractère inévitablement situé, pour ne pas dire impliqué et passionné de nos démarches – même les plus savantes ? Sans cet ancrage vital, sans une vectorisation profonde de nos interrogations, que vaudrait notre besoin d’art ? Dans le même temps, une telle affectivité n’expose-t-elle pas à toutes les instrumentalisations politiques ? De quel « étranger » nous parle-t-on quand on nous parle, aujourd’hui, de l’Étranger ? Depuis quelle rive, et à quelles fins ?

De ce point de vue, rien ne vaut le retour aux textes, aux contextes : non pour prétendre opposer quelque objectivité ou quelque scientificité aux lectures manifestement subjectives, mais pour les border, les borner, les mettre en perspective et les prendre pour ce qu’elles sont – des témoignages de nos blessures, de nos vulnérabilités.

Catherine Brun ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

04.11.2025 à 12:34

Les vaccins à ARNm anti-Covid 19 vont-ils révolutionner le traitement du cancer ?

Adam Grippin, Physician Scientist in Cancer Immunotherapy, The University of Texas MD Anderson Cancer Center

Christiano Marconi, Ph.D. Candidate in Immunotherapy, University of Florida

Texte intégral (1976 mots)

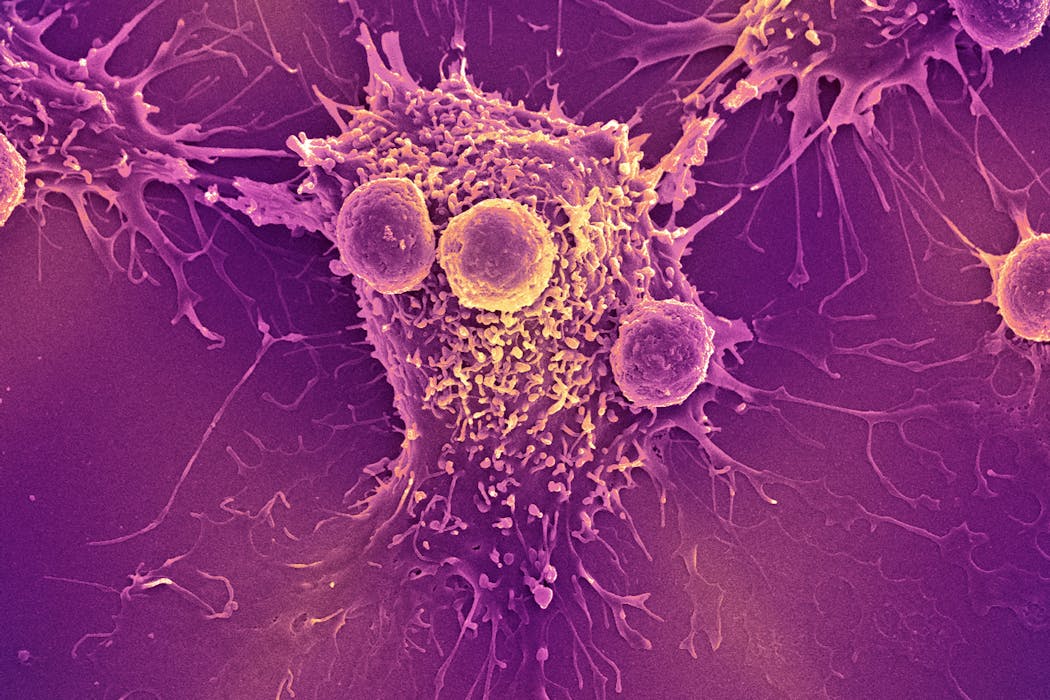

Les vaccins contre le Covid-19 à base d’ARN messager, qui ont sauvé 2,5 millions de vies dans le monde pendant la pandémie, pourraient aussi stimuler le système immunitaire, aidant ainsi à combattre le cancer. C’est la conclusion, aussi inattendue que marquante, d’une nouvelle étude publiée dans la revue Nature.

En 2016, notre équipe, dirigée par le pédiatre oncologue Elias Sayour, développait des vaccins à ARN messager (ARNm) pour tenter de soigner des patients atteints de tumeurs cérébrales. Au cours de ces travaux, nous avons découvert que l’ARNm était capable d’entraîner le système immunitaire à détruire les tumeurs. Et ce, même lorsque ledit ARNm n’a aucun lien avec le cancer.

Partant de ce constat, nous avons émis l’hypothèse que les vaccins à ARNm conçus pour cibler le SARS-CoV-2, le virus responsable du Covid-19, pourraient également présenter des effets antitumoraux.

Renforcer les capacités naturelles de l’organisme

Afin de le vérifier, nous avons examiné les résultats cliniques de plus de 1 000 patients atteints de mélanome ou de cancer du poumon à un stade avancé, auxquels avait été prescrit un traitement par inhibiteurs de points de contrôle immunitaire. Cette prise en charge fait partie des immunothérapies : son objectif est de renforcer les capacités naturelles de l’organisme à éliminer les cellules cancéreuses.

Couramment utilisée par les médecins, l’approche basée sur l’emploi d’inhibiteurs de point de contrôle consiste à bloquer une protéine produite et utilisée par les cellules tumorales. Ladite protéine est employée par ces dernières « pour éteindre » les cellules immunitaires, et ainsi éviter d’être repérées et éliminées par les défenses de l’organisme. Bloquer cette protéine tumorale permet de remettre les cellules cancéreuses sur le radar du système immunitaire.

Nos résultats ont révélé que, de façon remarquable, les patients qui ont reçu le vaccin anti-Covid-19 à ARNm des laboratoires Pfizer ou Moderna dans les cent jours qui ont suivi le début de l’immunothérapie avaient plus de deux fois plus de chances d’être en vie au bout de trois ans que ceux qui n’avaient reçu aucun des deux vaccins.

Fait surprenant, les patients porteurs de tumeurs connues pour répondre généralement mal à l’immunothérapie ont eux aussi tiré un bénéfice très important de cette vaccination : leur taux de survie globale à trois ans s’est nettement amélioré, puisqu’il a été multiplié par cinq.

Ce lien entre administration d’un vaccin anti-Covid-19 à ARNm et amélioration de la survie est resté robuste même après ajustement pour des facteurs tels que la gravité de la maladie et la prise en compte d’éventuelles comorbidités (des pathologies ou troubles présents en même temps que la maladie, ndlr).

Pour comprendre le mécanisme sous-jacent à ces résultats, nous avons eu recours à des modèles animaux. Ces travaux nous ont permis de découvrir que les vaccins anti-Covid-19 à ARNm agissent comme un signal d’alarme. Ils déclenchent la reconnaissance et la destruction des cellules tumorales par le système immunitaire, contrecarrant ainsi la capacité du cancer à désactiver les cellules immunitaires.

Lorsque de tels vaccins sont associés à une immunothérapie par inhibiteurs de points de contrôle, les deux traitements se coordonnent, ce qui libère contre les cellules cancéreuses toute la puissance du système immunitaire.

En quoi est-ce important ?

Au cours de la dernière décennie, l’immunothérapie par inhibiteurs de points de contrôle a révolutionné le traitement du cancer. Elle a permis de guérir de nombreux patients auparavant considérés comme incurables. Toutefois, ces thérapies restent inefficaces chez les patients présentant des « tumeurs froides » (peu infiltrées par les cellules immunitaires, ndlr), qui parviennent à échapper à la détection immunitaire.

Nos observations laissent penser que les vaccins à ARNm pourraient fournir l’étincelle nécessaire pour transformer ces « tumeurs froides » en « tumeurs chaudes » (qui contiennent des lymphocytes T et répondent mieux aux immunothérapies, ndlr). Nous sommes en train de monter un essai clinique pour confirmer ces résultats. Si ses conclusions sont positives, nous espérons que le recours à cette intervention, largement disponible et peu coûteuse, permettra à des millions de patients de profiter des bénéfices de l’immunothérapie.

D’autres travaux de recherche sont en cours

Contrairement aux vaccins destinés à lutter contre les maladies infectieuses, qui sont utilisés pour prévenir une infection, les vaccins thérapeutiques contre le cancer sont employés en vue d’entraîner le système immunitaire des patients à mieux combattre les tumeurs.

Comme de nombreux autres scientifiques, nous travaillons activement à concevoir des vaccins à ARNm personnalisés destinés aux patients atteints de cancer. Pour y parvenir, nous prélevons un petit échantillon de la tumeur d’un patient, puis nous cherchons à prédire quelles protéines tumorales constitueraient, pour cet individu, les meilleures cibles pour le vaccin en question, grâce à des algorithmes d’apprentissage automatique. Toutefois, cette approche peut s’avérer coûteuse et les vaccins résultants, complexes à fabriquer.

A contrario, les vaccins à ARNm anti-Covid-19 n’ont pas besoin d’être personnalisés. Par ailleurs, ils sont déjà disponibles dans le monde entier, à faible coût ou gratuitement, et pourraient être administrés à tout moment au cours du traitement d’un patient.

Nos résultats, qui indiquent que ces vaccins possèdent d’importants effets antitumoraux, suggèrent que l’on pourrait aussi les utiliser pour contribuer à étendre à tous les patients les bénéfices anticancéreux des vaccins à ARNm. Dans cette optique, nous nous préparons à tester cette stratégie thérapeutique dans le cadre d’un essai clinique national.

Perspectives

L’essai clinique que nous allons mener concernera des personnes atteintes d’un cancer du poumon. Les participants recevant un inhibiteur de point de contrôle immunitaire seront répartis aléatoirement dans deux groupes. Les membres de l’un des groupes recevront un vaccin anti-Covid-19 à ARNm au cours de leur traitement, tandis que ceux de l’autre n’en recevront pas.

Cette étude nous permettra de déterminer si les vaccins à ARNm contre la Covid-19 devraient être inclus dans les protocoles de soins standards prodigués aux personnes qui reçoivent un inhibiteur de point de contrôle immunitaire. En définitive, nous espérons que cette approche aidera de nombreux patients traités par immunothérapie, en particulier ceux qui, aujourd’hui, disposent de peu d’options thérapeutiques efficaces.

Ce travail illustre comment un outil né d’une pandémie mondiale pourrait se transformer en une nouvelle arme pour lutter contre le cancer, étendant rapidement à des millions de patients les avantages des traitements existants. En exploitant un vaccin familier d’une nouvelle manière, nous espérons que des patients atteints du cancer et jusqu’à présent laissés pour compte pourront avoir accès aux bénéfices de l’immunothérapie.

Adam Grippin reçoit des financements du National Cancer Institute (NCI), de l'American Brain Tumor Association et de la Radiological Society of North America. Il est l'inventeur de brevets liés aux thérapies à base d'ARNm qui font l'objet d'une option de licence par iOncology. Il est actuellement employé par le MD Anderson Cancer Center et consultant pour Sift Biosciences.

Christiano Marconi travaille pour l'université de Floride. Il reçoit des fonds du centre de cancérologie UF Health Cancer Center.

04.11.2025 à 12:34

Obésité : pourquoi les nouveaux médicaments ne sont pas des remèdes miracles

Alexandre Duparc, Cardiologue, Université de Toulouse

Olivier Lairez, Professeur des Universités - Praticien Hospitalier, Université de Toulouse

Philippe Terral, Sociologue - CreSco - Vice-Président Science Avec et Pour la Société, Université de Toulouse

Tania Pacheff, Diététicienne-nuritionniste au CHU Amiens, Université de Picardie Jules Verne (UPJV)

Texte intégral (2782 mots)

Wegovy, Mounjaro, Saxenda… Les analogues de l’hormone intestinale glucagon-like peptide-1 (GLP-1) ont beaucoup fait parler d’eux ces dernières années, en raison de leur efficacité en matière de perte de poids. Mais ces médicaments ne suffiront pas à vaincre l’obésité, dont la forte progression est due à de nombreux facteurs.

La lutte contre l’obésité est l’un des enjeux majeurs de la médecine du XXIe siècle. Cette maladie chronique, aux nombreuses complications physiques, psychologiques et sociales a vu sa prévalence mondiale doubler entre 1990 et 2022, date à laquelle elle touche, selon l’Organisation mondiale de la santé (OMS), plus d’un milliard de personnes (880 millions d’adultes et 160 millions d’enfants).

La France n’est pas épargnée. On considère qu’environ 8 millions de Françaises et de Français sont actuellement concernés par l’obésité. Sa prévalence est passée de 8,5 % en 1997 à 15 % en 2012, puis 17 % en 2020 et cette tendance va se poursuivre dans les années à venir.

Récemment, de nouveaux médicaments – les analogues de l’hormone intestinale glucagon-like peptide-1 (GLP-1) – ont intégré l’arsenal thérapeutique, suscitant de nouveaux espoirs. Cependant, ils ne permettront pas à eux seuls de vaincre l’obésité. Explications.

De nouvelles molécules efficaces

L’OMS définit le surpoids et l’obésité comme une accumulation anormale ou excessive de graisse, présentant un risque pour la santé. Une personne est considérée comme en surpoids si son indice de masse corporelle (IMC) est supérieur à 25, et comme obèse si celui-ci dépasse 30.

À lire aussi : Pourquoi il est possible d’être obèse sans être en surpoids

Historiquement, la prise en charge thérapeutique de cette maladie s’est structurée autour d’une approche pluridisciplinaire et globale alliant conseils d’hygiène de vie (activité physique, alimentation), suivi psychologique, prévention et traitement des complications. Pour les cas les plus sévères, le recours à la chirurgie bariatrique peut être envisagé.

Les thérapeutiques médicamenteuses sont longtemps restées en retrait. On se souvient de l’échec du dexfenfluramine (nom commercial Isomeride, autorisé en France de 1985 à 1997), puis du benfluorex (nom commercial Mediator, autorisé de 1976 à 2009). Tous deux ont été retirés du marché en raison de leurs effets secondaires aux conséquences dramatiques, notamment cardiaques (dégradation des valves cardiaques) et pulmonaires (hypertension artérielle pulmonaire). Le Mediator reste associé à l’un des plus retentissants scandales sanitaires des dernières décennies.

Depuis peu, une nouvelle classe de molécules est à la disposition du corps médical pour lutter contre l’obésité : les analogues du peptide glucagon-like 1 (GLP-1). Cette petite hormone permet d’augmenter la production d’insuline, et donc de mieux absorber le glucose. Elle a un effet central bénéfique sur la satiété et retarde la vidange gastrique (le vidage de l’estomac). Parmi ces nouveaux médicaments figurent le liraglutide (commercialisé sous les noms Saxenda pour l’obésité ou Victoza pour le diabète), le sémaglutide (noms commerciaux Wegovy pour l’obésité ou Ozempic pour le diabète) et le tirzépatide (Mounjaro).

Prescrites sous forme d’injections hebdomadaires, ces molécules étaient déjà indiquées en routine dans la prise en charge du diabète de type 2. Plusieurs essais cliniques de grande envergure chez les sujets obèses ou en surpoids mais indemnes de diabète ont démontré l’efficacité de ces médicaments en complément d’une prise en charge alliant diététique et activité physique. Le bénéfice semble dépasser la seule perte de poids, puisqu’on constate également une amélioration de certains paramètres cardiovasculaires et métaboliques.

L’autorisation de mise sur le marché permet actuellement de les prescrire en complément d’un régime hypocalorique et d’une augmentation de l’activité physique, chez l’adulte ayant un indice de masse corporelle supérieur à 30 kg/m2 ou supérieur à 27 en cas de co-morbidité liée au poids. Toutefois, l’Assurance maladie ne les rembourse pas.

À lire aussi : Ozempic, Wegovy : quels risques d’usage détourné avec ces médicaments pour le diabète et l’obésité ?

Ces traitements, qui apparaissent comme simples, efficaces et moins invasifs que la chirurgie, ont soulevé un enthousiasme légitime. Il est cependant illusoire d’imaginer que le combat contre l’obésité puisse se réduire à l’injection hebdomadaire d’un médicament. En effet, les causes de l’obésité et du surpoids sont multifactorielles, et dépassent la problématique du seul déséquilibre entre apports et dépenses caloriques.

Obésité, surpoids : des multiples causes

Les travaux de recherche ont révélé que les risques de surpoids et d’obésité dépendent de plusieurs déterminants : des facteurs génétiques (et épigénétiques), endocriniens (autrement dit, hormonaux), médicamenteux (certains traitements augmentent le risque), psychologiques, sociologiques ou encore environnementaux.

Concernant ce dernier point, on sait aujourd’hui que de nombreuses substances omniprésentes dans l’environnement sont classées comme obésogènes. Elles peuvent perturber notre métabolisme hormonal (perturbateurs endocriniens), modifier notre microbiote intestinal, ou agir à l’échelle génétique et épigénétique.

Dans ce contexte, le concept d’exposome, défini comme « l’ensemble des expositions environnementales au cours de la vie, y compris les facteurs liés au mode de vie, dès la période prénatale », prend tout son sens.

À lire aussi : Épigénétique, inactivation du chromosome X et santé des femmes : conversation avec Edith Heard

Dans certains cas, les effets des déterminants impliqués dans l’obésité peuvent rester latents pendant de nombreuses années, et les conséquences ne s’exprimer que tardivement, voire aux générations suivantes. Le diéthylstilbestrol (plus connu sous son nom commercial Distilbène) est un exemple emblématique de ces effets métaboliques transgénérationnels, non seulement en matière de surpoids et d’obésité, mais également en ce qui concerne le risque de cancers.

C’est pour rendre compte de ces phénomènes causaux que le concept de developmental origins of health and disease (DOHaD) – origines développementales de la santé et des maladies – a été forgé.

Une fois exposée la complexité de l’obésité, il apparaît donc évident que les cibles sur lesquelles agissent les analogues du GLP-1 (production d’insuline, satiété) sont loin d’être les seules impliquées dans la maladie.

Par ailleurs, on constate que les sources d’obésité ont, pour la plupart, des conséquences négatives sur la santé qui vont au-delà de la seule prise de poids. Ainsi, la consommation excessive de sucres raffinés, d’aliments ultratransformés, de viande rouge, de charcuterie, le manque de fibres, l’exposition à des toxiques, ou encore la sédentarité sont autant de facteurs de risques de santé dégradée.

Des molécules qui ne font pas de miracles

Les analogues du GLP-1 ne peuvent pas « guérir » l’obésité. Ce n’est d’ailleurs pas ce que prétendent les auteurs des études qui en ont testé l’efficacité.

Selon les résultats de l’étude STEP3, la perte de poids sous sémaglutide est de 15 % après 68 semaines de traitement (contre 5 % dans le groupe placebo). Si l’on considère le profil « type » des patients inclus dans cette étude, soit des individus ayant un IMC moyen à 37 (ce qui correspond à un poids de 100 kg pour une taille de 1m65), une perte de poids de 15 % les mènera à un IMC à 31. Ils passeront alors d’une obésité sévère à une obésité modérée. Si le gain en termes de santé est considérable, ces sujets présenteront encore un surrisque médical significatif.

Il convient également de se questionner sur la tolérance du traitement, ainsi que sur son observance chez des patients dont les ordonnances peuvent être très longues du fait des polypathologies. Par ailleurs, le maintien de l’efficacité au long cours reste à déterminer, a fortiori si l’ensemble des facteurs causaux n’est pas éradiqué.

Se posent aussi les problématiques de la prise de poids à l’arrêt du traitement, ainsi que de la sarcopénie, c’est-à-dire la perte musculaire, qualitative ou quantitative. En effet, une perte de poids ne se résume jamais seulement à une perte de masse graisseuse, mais s’accompagne également d’une perte de masse maigre, notamment musculaire. Ce phénomène pourrait être prévenu ou compensé grâce à l’exercice physique.

L’importance de la prévention

À ce jour, les analogues du GLP-1 sont envisagés comme traitement de l’obésité une fois que celle-ci est installée. Il s’agit donc d’une approche curative. Les articles scientifiques partent du principe que les mesures de préventions, dites « hygiénodiététiques » sont insuffisantes alors que les modalités d’élaboration de ces mesures ne sont que rarement questionnées, pas plus que la possibilité de s’attaquer aux nombreux facteurs qui entravent leur mise en pratique.

Les conseils adressés au grand public sont en effet essentiellement diffusés sous forme de messages ou d’injonctions à modifier les comportements individuels. Ils font donc implicitement reposer la responsabilité sur chacun et chacune, et sont, en ce sens, potentiellement culpabilisants. Parallèlement, ils passent le plus souvent sous silence les autres facteurs causaux qui structurent notre exposition globale.

Parmi les facteurs qui entravent la prévention, citons :

la facilité d’accès à des aliments favorisant l’obésité (sucrés, salés, ultratransformés), bon marché, vantés par la publicité, peu régulés et peu taxés alors que leur caractère néfaste est avéré ;

l’obstruction à la généralisation d’outils pourtant largement validés tels que le Nutri-Score, illustrant le fait que la question sanitaire passe généralement après les intérêts économiques, tant à l’échelle française qu’européenne ;

le contexte environnemental défavorable, exposant les individus à de multiples polluants. Nombre d’entre eux favorisent l’obésité, notamment via des mécanismes hormonaux ;

les manquements des politiques d’aménagement du territoire qui devraient promouvoir les mobilités actives et l’accès aux infrastructures d’activités physiques et sportives sur l’ensemble du territoire (urbain, semi-urbain et rural) et lutter ainsi contre la sédentarité et le manque d’activité physique ;

l’impact des déterminants socio-économiques ou psychologiques qui rendent difficilement applicables les comportements vertueux en termes d’alimentation et d’activité physique.

Rappelons le poids des inégalités (socio-économiques, de genre, ethno-raciales, territoriales…) dans la santé en général et particulièrement dans les questions touchant à l’obésité . En France, 17 % des individus dont le niveau de vie est inférieur au premier quart de la distribution sont obèses contre 10 % pour ceux dont le niveau de vie appartient au quartile de niveau de vie supérieur.

À lire aussi : Obésité et « manque de volonté » : les préjugés négatifs ont la vie dure

L’augmentation de la pauvreté, de la précarité et le creusement des inégalités sociales sont à ce titre inquiétants, car ils ne peuvent que dégrader les conditions de santé des populations les plus défavorisées.

Prévenir coûterait moins cher que guérir

Terminons sur un point impossible à ne pas considérer : celui du coût du traitement par analogues du GLP-1, évalué à environ 300 euros par mois et par patient.

Sans remboursement, ce traitement ne sera accessible qu’aux plus aisés. S’il est pris en charge par l’Assurance maladie, le coût potentiel apparaît comme vertigineux. L’OMS prévoit en effet que d’ici 2030, près de 30 % de la population française pourrait être concernée par l’obésité.

Conclusion, la communauté des soignants, associée à celle des patients, ne peut compter exagérément sur cette classe de médicaments. Pour lutter contre l’obésité, il faut continuer à valoriser une prise en charge pluridisciplinaire, alliant des savoirs académiques, issus de différentes disciplines scientifiques, avec des savoirs souvent qualifiés d’« expérientiels » : ceux des patients, des professionnels de l’éducation et de la prévention en santé, des décideurs en matière de politiques de santé, etc.

Cette approche est certes moins spectaculaire et moins facilement médiatisable que les annonces tonitruantes qui accompagnent les découvertes de thérapies innovantes, mais elle est indispensable. La prévention ne s’oppose pas au traitement curatif : elle le précède, et l’accompagne.

On ne peut espérer diminuer significativement et durablement la prévalence de l’obésité qu’en ciblant l’ensemble des facteurs qui la sous-tendent, individuels, sociaux et environnementaux. Cela implique l’élaboration et la mise en œuvre de politiques de santé publique larges, ambitieuses et respectueuses de la démocratie sanitaire.

Il faut avoir conscience que cela ira vraisemblablement à l’encontre d’intérêts économiques de court terme. Mais la santé publique en vaut sans aucun doute la chandelle.

Alexandre Duparc n'a pas de conflit d'intérêt financier à déclarer. Il est membre de L'Atecopol et de Scientifiques en Rébellion

Philippe Terral a reçu des financements de l'ANR, l'INCa, l'IRESP, la Fondation de France.

Tania Pacheff est membre de l'association « no plastic in my food » (ex-Cantine sans plastique France)

Olivier Lairez ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

03.11.2025 à 16:20

Loi Duplomb : le poisson zèbre est un outil d’alerte précoce

Pierre-Olivier Angrand, Professeur des Universités, Université de Lille

Texte intégral (2095 mots)

Pour évaluer la toxicité de pesticides, tels que l’acétamipride, rendu célèbre par la loi Duplomb, des chercheurs étudient leurs effets sur des invertébrés, à commencer par des insectes pollinisateurs comme l’abeille. Mais concernant leurs impacts sur la santé des humains et des autres vertébrés, qui restent mal pris en compte, le poisson zèbre est un modèle animal pertinent qui permet, notamment, de développer des tests de toxicité plus éthiques.

Avant d’être censuré par le Conseil constitutionnel qui l’a jugé contraire à la Charte de l’environnement, l’article 2 de la loi dite « Duplomb » prévoyait des dérogations aux interdictions de l’utilisation en France des pesticides acétamipride, sulfoxaflor et flupyradifurone.

La possibilité d’utiliser ces molécules dans certaines filières agricoles a suscité un vif débat et une mobilisation citoyenne inédite en raison d’effets négatifs sur la biodiversité et d’un danger potentiel pour la santé humaine.

Toxicité de l’acétamipride, du sulfoxaflor et du flupyradifurone sur les insectes

Ces pesticides de la famille des néonicotinoïdes, ou apparentés par leur mode d’action, sont solubles, facilement absorbés par les plantes et neurotoxiques pour les arthropodes, les insectes et de nombreuses autres espèces. Ils agissent en ciblant certaines protéines au niveau du système nerveux de l’insecte (les récepteurs nicotiniques de l’acétylcholine), provoquant sa paralysie, puis sa mort.

L’acétamipride est un composé organochloré préoccupant en raison de son accumulation dans les pollens et de son action sur les pollinisateurs. En effet, il est toxique pour les abeilles et altère leur comportement, leur métabolisme quand elles sont au stade larvaire et leur microbiote intestinal à des doses sublétales (qui n’entraînent pas la mort des abeilles, ndlr). Il présente également une toxicité accrue lorsqu’il est combiné à d’autres pesticides.

Par ailleurs, des effets sublétaux majeurs de l’acétamipride sont observés, à des doses inférieures à celles utilisées en champs, sur un organisme auxiliaire de l’agriculture, le parasitoïde oophage Trichogramma dendrolimi, essentiel à la lutte biologique contre les ravageurs agricoles. Au niveau des écosystèmes, l’acétamipride perturbe la structure trophique des sols en affectant notamment le comportement fouisseur et la reproduction des vers de terre. De plus, la solubilité de l’acétamipride lui permet de se retrouver dans les cours d’eau.

Si l’acétamipride n’est pas considéré comme fortement toxique pour les organismes aquatiques, il est toutefois responsable de lésions tissulaires chez les moules d’eau douce. Chez les souris ou les rats de laboratoire, une exposition à cette substance induit un stress oxydatif responsable de dommages à l’ADN et étroitement associé à une toxicité tissulaire, reproductive et développementale.

Le sulfoxaflor (classé parmi les sulfoximines) et le flupyradifurone (biocide de la classe des buténolides) ont été présentés comme des successeurs des néonicotinoïdes. Ces nouvelles molécules s’avèrent particulièrement efficaces pour lutter contre un large éventail de ravageurs, mais présentent des effets toxiques sur les insectes pollinisateurs et sur les auxiliaires de lutte contre les pucerons comme les coccinelles ou les vers de terre.

En revanche, l’éventuelle toxicité de ces molécules pour les vertébrés est peu connue, et l’essentiel des informations disponibles provient d’études effectuées chez le poisson zèbre.

Le poisson zèbre, un organisme modèle en écotoxicologie

Le poisson zèbre (Danio rerio) est un petit téléostéen d’eau douce originaire d’Asie du Sud, notamment des rivières peu profondes à faible débit d’Inde, du Bangladesh, du Népal et du Pakistan. Il est utilisé dès les années 1970 comme modèle d’étude du développement. Le poisson zèbre s’impose également comme un modèle de choix en écotoxicologie réglementaire en raison de ses caractéristiques biologiques favorables à l’étude des effets toxiques des contaminants environnementaux.

Son développement externe, rapide et sa transparence permettent une observation directe des altérations morphologiques, physiologiques et comportementales induites par des substances chimiques, dès les stades embryonnaires. Sur le plan neurotoxique, le poisson zèbre possède comme l’humain, une barrière hématoencéphalique qui protège le système nerveux central en limitant la pénétration des substances chimiques étrangères. Comme l’humain également, le poisson zèbre est doté d’un système enzymatique hépatique responsable de la métabolisation des pesticides, perturbateurs endocriniens et autres résidus pharmaceutiques.

Ce modèle vertébré aquatique est donc particulièrement pertinent pour les études toxicologiques et est aujourd’hui intégré dans plusieurs lignes directrices de l’Organisation de coopération et de développement économiques (OCDE) (test de toxicité aiguë sur poissons juvéniles et adultes, OCDE TG 203 ; test de toxicité embryonnaire (Fish Embryo Toxicity, FET) OCDE TG 236). En particulier, le test de toxicité embryonnaire chez le poisson zèbre permet d’évaluer la toxicité aiguë des substances chimiques dès les stades précoces du développement et est considéré comme une alternative éthique aux tests sur animaux adultes dans la mesure où les embryons de poisson zèbre de moins de cinq jours ne sont pas considérés comme des animaux protégés, selon la législation (conformément à la Directive européenne 2010/63/UE).

Ce test qui utilise l’embryon de poisson zèbre est utilisé dans le cadre des réglementations internationales : l’enregistrement, évaluation, autorisation et restriction des substances chimiques acronyme anglophone, REACH dans l’Union européenne reconnu par les organismes, tels que l’Agence européenne des produits chimiques (ECHA), l’Autorité européenne de sécurité des aliments (EFSA) ou, en France, l’Agence nationale de sécurité sanitaire de l’alimentation, de l’environnement et du travail (Anses).

Ainsi, l’analyse conjointe des altérations comportementales ou développementales chez les embryons et les larves de poisson zèbre représente une approche intégrée, scientifiquement robuste et réglementaire pour évaluer le danger des contaminants environnementaux, en particulier ceux présentant un potentiel neurotoxique ou développemental, comme les pesticides de la famille des néonicotinoïdes, des sulfoximines ou des buténolides.

Quels effets de l’acétamipride, du sulfoxaflor et du flupyradifurone sur le poisson zèbre ?

Chez l’embryon et la larve de poisson zèbre, l’acétamipride induit des troubles locomoteurs dès les faibles concentrations (5 % de la dose létale ou comparables à celles trouvées dans l’environnement). À plus fortes doses sublétales, l’acétamipride réduit le rythme cardiaque et entraîne diverses anomalies morphologiques (colonne vertébrale courbée, œdème péricardique).

Bien que les concentrations environnementales soient très faibles, les effets synergiques avec d’autres polluants, comme le cadmium, un polluant métallique agricole issu des engrais minéraux phosphatés, aggravent la toxicité de l’acétamipride pour provoquer des effets développementaux aigus (inhibition de la croissance, malformations morphologiques, perturbations endocriniennes et immunitaires).

Enfin, l’exposition de poissons zèbres juvéniles à des concentrations environnementales d’acétamipride pendant 154 jours (soit cinq mois, ndlr) montre une bioaccumulation du pesticide, une féminisation des adultes, des perturbations hormonales ainsi que des effets transgénérationnels sur la descendance, tels qu’une baisse de la fécondité, une réduction du taux d’éclosion et la survenue de malformations embryonnaires.

Concernant le sulfoxaflor, les données sont limitées mais préoccupantes. Chez l’embryon et la larve de poisson zèbre, le sulfoxaflor provoque des retards d’éclosion et de croissance, des malformations caudales et des anomalies cardiaques. À l’échelle moléculaire, il module l’expression de gènes liés au stress oxydatif et à la signalisation neuronale. L’exposition au sulfoxaflor réduit également le nombre de cellules immunitaires et active les voies inflammatoires, indiquant un potentiel toxique systémique similaire à celui des néonicotinoïdes.

Quant au flupyradifurone, il s’agit d’un nouvel insecticide de type buténolide produit par Bayer et présenté comme « faiblement toxique ». Il diminue pourtant la survie, la croissance, développement et la fréquence cardiaque des embryons de poisson zèbre. À ce jour, cette étude est la seule qui évalue l’effet du flupyradifurone sur un vertébré et elle indique que la présence de ce pesticide dans les produits agricoles et dans l’environnement pourrait être source de préoccupation.

Des données en faveur d’une réévaluation toxicologique de ces pesticides

Ainsi, ces pesticides, l’acétamipride, le sulfoxaflor et le flupyradifurone, interfèrent avec des processus fondamentaux du développement neurologique et endocrinien chez le poisson zèbre, même à faibles doses et pour des expositions de courte durée. La conservation évolutive des voies neurochimiques et hormonales entre poissons et mammifères suggère un risque potentiel pour l’humain, notamment en cas d’exposition chronique ou prénatale.

La présence de ces composés dans les eaux de surface, dans les sols et même dans certains aliments invite à une réévaluation rigoureuse de leur profil toxicologique, en intégrant les effets cumulés, les fenêtres de vulnérabilité et les expositions multiples.

Le modèle du poisson zèbre constitue à ce titre un précieux outil d’alerte précoce, à même d’anticiper des risques sanitaires encore mal caractérisés.

Pierre-Olivier Angrand ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

03.11.2025 à 16:20

Populisme : quand la démocratie perd son centre de gravité

Alexandre Chirat, Maître de conférences en sciences économiques (UMLP - CRESE), Université Marie et Louis Pasteur (UMLP)

Cyril Hédoin, Philosophie, politique et économie, Université de Reims Champagne-Ardenne (URCA)

Texte intégral (1893 mots)

La crise politique française actuelle ne se résume pas à une succession de démissions et de votes manqués. Elle traduit une faille plus profonde : la perte d’une conception majoritaire de l’intérêt général. C’est dans ce vide que prospère le populisme, nourri par le désalignement entre les actions des partis politiques et les attentes des citoyens.

Le populisme qui prospère depuis une décennie, aussi bien dans l’Hexagone qu’au niveau mondial a, selon nos travaux de recherche, deux causes profondes. D’une part, une instabilité démocratique liée à un renforcement de la polarisation idéologique qui s’exprime, dans le cas français, par une tripartition inédite sous la Ve République. D’autre part, un désalignement entre l’offre électorale des partis et les préférences des citoyens, dont l’abstention croissante est le premier symptôme. En 2009, les partis politiques en Europe sont systématiquement moins conservateurs que leurs électeurs, dans presque tous les pays, sur presque tous les sujets culturels : immigration, condamnations pénales, autorité enseignante, relation entre les sexes, etc.

Notre affirmation selon laquelle le populisme est la conséquence d’un déséquilibre politique combiné à une instabilité démocratique est déduite, par un raisonnement hypothético-déductif, de la théorie économique de la démocratie d’Anthony Downs. Formulée en 1957 dans son ouvrage An Economic Theory of Democracy, elle constitue une application de la théorie du choix rationnel au comportement des acteurs politiques en démocratie – celle-ci étant définie par la concurrence électorale entre partis pour le vote des citoyens, par analogie avec la concurrence sur un marché. Du côté de la demande, les citoyens votent, à partir d’une analyse coûts-bénéfices, pour le parti qui maximise leurs bénéfices. Du côté de l’offre, les partis choisissent le positionnement politique qui maximise le nombre de votes reçus.

Ce cadre théorique a d’abord permis de déterminer les conditions garantissant l’existence d’un équilibre politique. On a néanmoins trop souvent réduit ce classique de la science économique et de la science politique au théorème de l’électeur médian, lui-même réduit à l’idée que « les élections se gagnent au centre ». Pourtant, une leçon oubliée du travail de Downs est que, non seulement cette convergence vers le centre dépend de conditions hautement particulières (dont l’absence d’abstention notamment), mais aussi que l’alignement entre l’offre politique et les préférences des électeurs n’est pas systématique. Or, pour que de nouveaux partis prospèrent, il faut nécessairement que le positionnement électoral des partis dominants diverge suffisamment des préférences de nombreux citoyens. Dans le cas contraire, il n’existe pas d’espace politique suffisant pour l’entrée d’un nouveau concurrent. Cependant, un déséquilibre politique n’est pas une condition suffisante pour expliquer l’émergence d’un parti populiste.

Des conceptions de l’intérêt général qui divergent

Downs a par la suite enrichi sa théorie de la démocratie en insistant sur la nécessité d’introduire dans les analyses économiques des phénomènes politiques le concept d’intérêt général. En démocratie, il est au cœur de la rhétorique de tous les partis politiques. La conception de l’intérêt général d’un citoyen, explique Downs, désigne la vision qu’il va former de ce que le gouvernement doit faire, compte tenu des valeurs que ce citoyen attribue à la société. Cette vision détermine alors ses décisions en matière de vote. Or Downs montre que la stabilité d’un régime démocratique requiert un consensus démocratique minimal, c’est-à-dire que les conceptions plurielles de l’intérêt général des citoyens s’accordent sur un socle minimal de principes gouvernant le fonctionnement du système démocratique et l’action politique. L’absence d’un tel consensus, soit l’existence d’une polarisation idéologique, engendre une remise en cause de la légitimité tant des règles de fonctionnement d’une démocratie que des résultats de l’action des pouvoirs publics.

Polarisation idéologique et déséquilibre politique

La polarisation idéologique, particulièrement visible lors des élections présidentielles de 2017 et 2022, n’est pas non plus suffisante à elle seule pour expliquer l’émergence puis les succès électoraux des partis dits populistes. Ainsi, l’après Seconde-Guerre mondiale en Europe a été marquée par une forte polarisation entre communistes, sociaux-démocrates et conservateurs, sans que le populisme n’ait été un phénomène politique majeur dans les démocraties occidentales de l’époque. Il n’existait en effet pas de déséquilibre majeur entre l’offre des partis et la distribution des préférences des citoyens.

Il existe aujourd’hui un accord dans la littérature scientifique pour définir le populisme à partir d’attributs fondamentaux tels que le manichéisme politique, l’anti-élitisme et l’idéalisation du peuple. En se fondant sur la théorie économique de la démocratie de Downs, une théorie générale du populisme, par-delà la diversité de ses manifestations historiques, devient possible.

Dans un tel cadre, nous montrons qu’un parti populiste propose une idéologie politique bâtie autour d’une conception de l’intérêt général alternative à la conception caractérisant le consensus démocratique minimal préalablement établi au sein de la société. Les partis dits mainstream ou de gouvernement, en dépit de leurs désaccords sur les politiques à mettre en œuvre, ont précisément en commun d’adhérer à ce consensus.

Des années 1980 aux années 2000, les partis dits de gouvernement en France (Parti socialiste [PS] et l’Union pour un mouvement populaire [UMP]) partageaient une adhésion commune au projet européen dans le cadre de la mondialisation économique et financière (avec certes des dissensions internes). La nature du consensus, dont l’affaiblissement s’est accéléré à la suite de la crise des dettes souveraines, explique pourquoi les partis populistes en France (La France insoumise [LFI] et Rassemblement national [RN]) ont exprimé un fort euroscepticisme.

Adopter une idéologie populiste ne constitue une stratégie politique rationnelle que lorsque la polarisation idéologique a suffisamment affaibli le consensus minimal préexistant. Sans cette polarisation, la concurrence électorale a lieu uniquement entre partis de gouvernement et porte seulement sur la sélection des instruments de politique publique, mais non sur les objectifs fondamentaux de l’action politique. Quant au déséquilibre politique, il incite à recourir à une rhétorique anti-élites et à promouvoir une conception de l’intérêt général qui dit privilégier la volonté majoritaire du peuple (le principe démocratique) par rapport à la protection des droits individuels (le principe libéral) lorsque ceux-ci entrent en conflit, par exemple sur des thèmes tels que l’avortement, l’écologie, ou l’immigration.

La crise politique en France

Cette analyse théorique pose deux questions.

Premièrement : quelles sont les causes de la polarisation idéologique ? L’évolution de long terme des préférences des individus en réponse aux dislocations économiques et sociales – notamment causées par la mondialisation commerciale, la crise bancaire et financière de 2008-2012 et le progrès technologique – est généralement mise en avant. Elle interagit avec la fin du monopole de la production d’information des médias et partis traditionnels consécutive à la digitalisation de nos sociétés.

Deuxièmement : quels sont les causes du déséquilibre politique actuel ? L’explication principale réside dans le processus de convergence au centre des programmes des partis politiques en Occident dans les années 1980-2000. Majoritaire à un moment donné, les promesses non tenues de la mondialisation et de la construction européenne ont affaibli – comme l’avait déjà illustré le Non au référendum de 2005 – le consensus incarné par l’UMP et par le PS, puis par le « macronisme ».

Il serait néanmoins trop facile d’attribuer seulement aux élites politiques des anciens et des nouveaux partis dits « de gouvernement », comme le font les partis dits populistes, l’instabilité démocratique et la polarisation idéologique actuelles. Les hommes et femmes issus des partis populistes, de gauche comme de droite, n’ont pas non plus été capables de forger un consensus démocratique minimal autour d’une conception renouvelée de l’intérêt général qui suscite l’adhésion d’une majorité de citoyens.

C’est cette double faillite qui entraîne une succession de crises à l’intérieur du régime politique. Or, face à la succession de gouvernements depuis 2022, il est probable que la régulation du déséquilibre politique présent n’ait lieu qu’au cours d’une crise politique d’une ampleur que la France n’a pas connu depuis plusieurs décennies. Puissions-nous espérer qu’un consensus majoritaire renouvelé naisse rapidement des cendres du consensus en faillite.

Alexandre Chirat vient de recevoir un financement de l'ANR pour un projet de recherche sur l'économie politique du populisme (ANR-24-CE26-2354).

Cyril Hédoin ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

- GÉNÉRALISTES

- Ballast

- Fakir

- Interstices

- Lava

- La revue des médias

- Le Grand Continent

- Le Diplo

- Le Nouvel Obs

- Lundi Matin

- Mouais

- Multitudes

- Politis

- Regards

- Smolny

- Socialter

- The Conversation

- UPMagazine

- Usbek & Rica

- Le Zéphyr

- Idées ‧ Politique ‧ A à F

- Accattone

- Contretemps

- A Contretemps

- Alter-éditions

- CQFD

- Comptoir (Le)

- Déferlante (La)

- Esprit

- Frustration

- Idées ‧ Politique ‧ i à z

- L'Intimiste

- Jef Klak

- Lignes de Crêtes

- NonFiction

- Nouveaux Cahiers du Socialisme

- Période

- Philo Mag

- Terrestres

- Vie des Idées

- ARTS

- Villa Albertine

- THINK-TANKS

- Fondation Copernic

- Institut La Boétie

- Institut Rousseau

- TECH

- Dans les algorithmes

- Framablog

- Gigawatts.fr

- Goodtech.info

- Quadrature du Net

- INTERNATIONAL

- Alencontre

- Alterinfos

- CETRI

- ESSF

- Inprecor

- Journal des Alternatives

- Guitinews

- MULTILINGUES

- Kedistan

- Quatrième Internationale

- Viewpoint Magazine

- +972 mag

- PODCASTS

- Arrêt sur Images

- Le Diplo

- LSD

- Thinkerview

- Fiabilité 3/5

- Slate

- Fiabilité 1/5

- Contre-Attaque

- Issues

- Korii

- Positivr