26.02.2026 à 15:33

Municipales 2026 : l’extinction nocturne de l’éclairage augmente-t-elle vraiment la délinquance ?

Chloé Beaudet, Doctorante en économie de l’environnement, AgroParisTech – Université Paris-Saclay

Texte intégral (2153 mots)

À l’approche des élections municipales de mars prochain, l’extinction nocturne de l’éclairage public, qui s’est généralisée ces dernières années sur fond d’augmentation des coûts de l’énergie et de prise de conscience des dangers pour la biodiversité, cristallise les inquiétudes en matière de sécurité. Pourtant, la première étude nationale menée en France montre que cette politique n’entraîne pas d’augmentation générale des faits de délinquance. Elle n’a qu’un effet limité sur les cambriolages, qui reste très faible : un cambriolage supplémentaire par tranche de 3 000 logements.

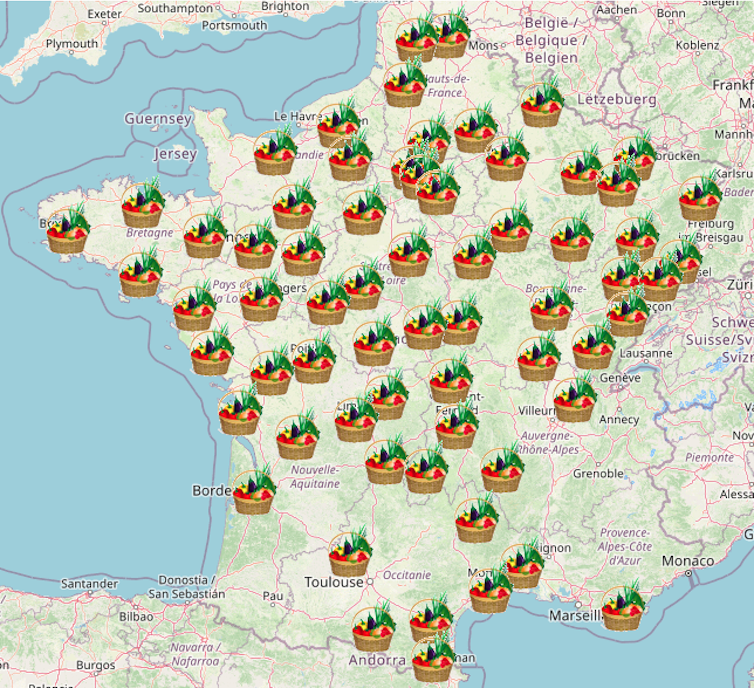

De nombreuses communes françaises ont choisi, ces dernières années, d’éteindre partiellement ou totalement leur éclairage public la nuit. Cette tendance s’est fortement accélérée à l’automne 2022, dans un contexte de flambée des prix de l’électricité. Une cartographie des extinctions nocturnes, publiée par le Centre d’études et d’expertise sur les risques, l’environnement, la mobilité et l’aménagement (Cerema) à l’été 2025, montre ainsi que 62 % des communes (sur les 19 262 étudiées) ont mis en place une politique d’extinction nocturne de l’éclairage public.

Ces décisions permettent aux collectivités de réaliser des économies d’énergie et de réduire leurs dépenses, tout en limitant les effets néfastes de la pollution lumineuse sur la biodiversité et la santé humaine, en forte augmentation ces dernières années.

À l’approche des élections municipales des 15 et 22 mars 2026, ces mesures sont toutefois de plus en plus contestées dans certaines villes en raison du sentiment d’insécurité qu’elles suscitent chez une partie de la population.

Jusqu’à présent, aucune étude scientifique en France n’avait analysé le lien entre l’extinction de l’éclairage public et la délinquance. À l’international, les travaux sur cette question sont rares et ont, jusqu’à présent, abouti à des résultats contrastés.

C’est pour combler ce manque que je me suis intéressée à cette problématique dans le cadre de ma thèse, soutenue en décembre 2025, en menant la première étude empirique évaluant l’impact de l’extinction de l’éclairage public sur la délinquance, à l’échelle nationale. Ses résultats montrent qu’éteindre l’éclairage la nuit n’a pas d’effet sur la plupart des faits de délinquance étudiés. Elle a toutefois un impact léger sur les cambriolages, qui reste très limité et s’applique surtout aux contextes urbains.

Pas d’effet sur la majorité des faits de délinquance

L’étude, qui a passé au crible les statistiques de délinquance entre 2017 et 2023 des communes de plus de 1 500 habitants, montre que l’extinction de l’éclairage public n’a aucun effet pour la grande majorité des faits de délinquance étudiés : dégradations et destructions volontaires, violences sexuelles, vols non violents, vols de véhicules et d’accessoires ainsi que trafic et usage de stupéfiants.

Un faible effet positif a toutefois été mis en évidence pour les cambriolages. Celui-ci est statistiquement significatif, mais reste limité : on parle ici d’une augmentation de 0,35 cambriolage pour 1 000 logements (soit environ 1 cambriolage supplémentaire par tranche de 3 000 logements). Autrement dit cet impact correspond à environ 3,4 % du nombre de cambriolages observés en moyenne par an dans les communes ayant recours à l’extinction nocturne.

Des analyses plus fines montrent que cet effet est concentré dans les communes à forte densité de population, que l’Insee considère comme « grands centres urbains » et « centres urbains intermédiaires ». Aucun impact n’est observé dans les communes à plus faible densité, telles que les ceintures urbaines et les petites villes.

Pour les faits de délinquance, tels que la violence physique, les vols violents avec ou sans arme et les vols dans les véhicules, le modèle utilisé dans l’étude n’était pas applicable. Il n’est donc pas possible de conclure, pour ces faits, à la présence ou à l’absence d’un effet de l’extinction de l’éclairage public.

À lire aussi : Éclairer la ville ou protéger la biodiversité : faux dilemme

Délinquance et éclairage nocturne, des données inédites

Pour parvenir à ces résultats, j’ai croisé deux sources de données.

La première est une base inédite qui identifie, pour chaque commune, si et depuis quand l’éclairage public est éteint. Elle s’appuie sur les travaux du Cerema, qui a eu recours à des images satellites nocturnes pour détecter des ruptures soudaines dans les séries temporelles de radiance – c’est-à-dire la lumière visible depuis l’espace – susceptibles de correspondre à des extinctions de l’éclairage public.

J’ai ainsi adapté cette méthodologie pour améliorer les performances de l’algorithme de détection et mieux distinguer les extinctions des autres changements de l’éclairage public, comme le passage à des lampes LED. La performance du modèle a ensuite été vérifiée à partir d’une base de données regroupant plusieurs centaines de communes dont les pratiques d’extinction étaient connues, notamment grâce à un partenariat avec le programme ACTEE, ce qui a permis de valider empiriquement la robustesse de l’algorithme.

Cette base de données a ensuite été croisée avec les données administratives du ministère de l’intérieur, qui recensent, pour chaque commune et chaque année, le nombre de faits de délinquance sur la période 2017-2023.

Une fois les données croisées, l’enjeu était d’identifier un lien de causalité – et non d’établir une simple corrélation – entre extinction de l’éclairage public et la délinquance. Pour cela, l’étude s’est appuyée sur la méthode des « doubles différences », couramment utilisée en économie.

Concrètement, cette approche consiste à comparer l’évolution de la délinquance dans les communes qui ont éteint leur éclairage public, avant et après la mise en place de la mesure, à celle observée dans des communes comparables n’ayant pas procédé à une extinction.

Le principe est d’isoler l’effet propre de l’extinction nocturne, en neutralisant les tendances temporelles et les différences structurelles entre les deux groupes. De plus, les autres facteurs susceptibles d’influencer la délinquance, (par exemple, la taille de l’unité urbaine, la couleur politique du maire, ou la distance de la ville au quartier prioritaire de la ville le plus proche), ont ainsi été pris en compte.

Les cambriolages ont-ils été déplacés vers les communes éclairées ?

Des analyses complémentaires suggèrent que, s’agissant des cambriolages, il n’y a pas, a priori, de phénomène de déplacement vers les communes voisines restées éclairées lorsque certaines communes pratiquent l’extinction nocturne. En revanche, il serait pertinent de mener des travaux supplémentaires pour déterminer si de tels effets de report existent à une échelle plus fine, au sein même des communes, entre des quartiers éteints et des quartiers adjacents restés éclairés.

Une étude menée en Angleterre et publiée en 2023 apporte à cet égard des éléments intéressants : elle met en évidence une baisse des vols dans les véhicules dans les rues éteintes, accompagnée d’une hausse de ces faits dans les rues voisines demeurées éclairées. En France, la granularité des données actuellement disponibles ne permet pas d’analyser ces phénomènes à une échelle infracommunale.

Plus largement, malgré l’absence d’effets ou les effets très limités observés, de futures recherches pourraient permettre de mieux comprendre les mécanismes à l’œuvre derrière ces résultats pour l’ensemble des faits de délinquance étudiés. Il serait notamment utile d’examiner si les effets – lorsqu’ils existent – varient selon le moment de la journée ou de l’année, selon certaines caractéristiques du tissu urbain, ou encore si l’extinction de l’éclairage modifie les comportements, comme la vigilance des riverains ou la fréquentation de l’espace public. Ces approfondissements contribueraient à concevoir des politiques publiques adaptées.

Ce que les collectivités locales peuvent en retenir

Les résultats de cette étude ne permettent pas de conclure à une augmentation massive de la délinquance liée à l’extinction de l’éclairage public. Pour les communes qui souhaitent mettre en place ces politiques afin de réduire la pollution lumineuse ou maîtriser leurs dépenses énergétiques, ce constat est rassurant. Pour autant, ces mesures peuvent susciter un sentiment d’insécurité chez une partie de la population, qui ne doit pas être négligé.

Dans une autre étude, nous avons montré qu’il est possible de concevoir des politiques d’éclairage à la fois socialement acceptables et bénéfiques pour la biodiversité. Les résultats soulignent qu’une approche uniforme est peu efficace : les politiques d’éclairage nocturne doivent être pensées localement, à une échelle fine, au lampadaire près, afin d’être efficaces.

Enfin, il est important de rappeler que la lutte contre la pollution lumineuse ne se limite pas à l’extinction de l’éclairage public. De nombreuses mesures de réduction – comme l’adaptation de l’intensité ou de la température de couleur – sont largement mieux accueillies par la population, comme l’illustrent notamment les retours observés à Montpellier (Hérault).

À lire aussi : Éclairage public : les Français sont-ils prêts à éteindre la lumière ?

Chloé Beaudet est membre du GDR 2202 Lumière & environnement nocturne (LUMEN) et de l'Observatoire de l'Environnement Nocturne du CNRS. Elle a reçu des financements de l'INRAE et AgroParisTech en tant que chercheuse à l'UMR Paris-Saclay Applied Economics (PSAE).

26.02.2026 à 11:29

Le droit civil n’aime pas les chats, mais il aime la responsabilité

Jordy Bony, Docteur et Professeur en droit à l'EM Lyon, EM Lyon Business School

Texte intégral (2721 mots)

Quand le chat, malgré sa liberté légendaire, se heurte à un adversaire aussi têtu que le Code civil, quand un plaignant obtient, outre des dommages et intérêts, le versement d’une astreinte financière de 30 euros chaque fois que le félin domestique de sa voisine entrera dans son jardin, cela donne un jugement qui fait beaucoup jaser médiatiquement, mais qui n’est pas du tout surprenant quand on regarde ce que dit le droit.

Le Code civil n’aime pas les chats parce qu’ils sont indisciplinés, imprévisibles et libres, trois qualités que le droit supporte mal. En revanche, il aime la responsabilité, car elle permet de réparer sans juger.

Retour sur une actualité surprenante datant de 2025 : une propriétaire de chat a été condamnée à payer 1 250 euros à son voisin pour des dégradations causées par son animal. Si cette décision a suscité beaucoup d’émoi, elle permet aussi de mieux comprendre une logique du droit civil méconnue du grand public, celle de la réparation sans faute du fait de l’animal, et, de façon plus globale les enjeux juridiques concernant le statut de nos compagnons domestiques.

Les faits et la décision de justice

En l’espèce, une propriétaire de chat vivant dans une maison individuelle laissait son animal circuler librement à l’extérieur. À plusieurs reprises, le chat s’est introduit dans la propriété voisine, où il a causé diverses dégradations, notamment dans le jardin et les aménagements extérieurs. Malgré les démarches amiables entreprises par le voisin pour faire cesser ces intrusions, les passages répétés de l’animal se sont poursuivis.

Estimant subir un préjudice anormal et récurrent, le voisin a alors saisi le tribunal judiciaire compétent. Il reprochait à la propriétaire de ne pas avoir pris les mesures nécessaires pour empêcher son chat de pénétrer sur sa propriété et sollicitait une indemnisation au titre des nuisances et dégradations subies.

Par une ordonnance rendue en janvier 2025, le tribunal de Béziers (Hérault) a fait droit à cette demande. Il a condamné la propriétaire du chat à verser une somme totale de 1 250 euros, comprenant des dommages et intérêts ainsi que des frais de justice. Le juge a également assorti sa décision d’une astreinte financière en cas de nouvelles intrusions de l’animal sur la propriété voisine (soit 30 euros à chaque passage de l’animal chez le voisin), afin d’inciter la propriétaire à prendre des mesures effectives pour y mettre fin. À noter que le voisin avait installé des caméras chez lui pour prouver le passage du chat.

Cette décision, largement relayée dans les médias, a pu surprendre par son montant et par l’idée même qu’un propriétaire puisse être tenu de réparer le comportement d’un chat, animal souvent perçu comme indépendant et difficilement contrôlable. Elle s’inscrit pourtant dans une logique juridique bien établie en droit civil, fondée sur la responsabilité du gardien de l’animal et sur la protection des victimes de troubles anormaux de voisinage.

Explication de la logique juridique

La première clé de compréhension, très pragmatique, est la suivante : le droit civil ne s’intéresse pas à l’intention de l’animal. Il s’intéresse à une question plus terre-à-terre : qui doit réparer le dommage survenu à la suite des intrusions du chat ?

C’est précisément l’objet de la responsabilité civile : remettre la victime du dommage, autant que possible, dans la situation où elle se serait trouvée si le dommage n’avait pas eu lieu. Et c’est là que le chat, malgré son indépendance légendaire, tombe sur un adversaire plus têtu que lui : le Code civil.

En droit civil français, la responsabilité civile est encadrée par les articles 1240 et suivants du code civil. L’article 1243 intéresse particulièrement notre cas. Il énonce la chose suivante :

« Le propriétaire d’un animal, ou celui qui s’en sert, pendant qu’il est à son usage, est responsable du dommage que l’animal a causé, soit que l’animal fût sous sa garde, soit qu’il fût égaré ou échappé. »

Autrement dit le propriétaire dont le chat erre dans le voisinage devra répondre des dégradations commises par ce dernier, qu’importe que cela soit le résultat d’un manque de diligence ou non. Le Code civil est plutôt clair sur la question.

Il en va de même pour les parents responsables de leurs enfants mineurs causant des dégradations ou des instituteurs et artisans qui sont responsables de leurs élèves et apprentis lorsqu’ils sont sous leur surveillance.

Il faut insister sur un point qui explique, à lui seul, le sentiment de « sévérité » que cette affaire peut susciter : la responsabilité du fait des animaux est une responsabilité de plein droit. Concrètement, le voisin n’a pas à démontrer que la propriétaire a été négligente ni qu’elle « aurait pu faire mieux » : il doit surtout établir que l’animal a joué un rôle dans la survenance du dommage et que la personne poursuivie en était le propriétaire ou, plus largement, le gardien. Qu’importe, d’ailleurs, que l’animal viennent une seule fois ou de façon récurrente. À partir du moment où le lien peut être établi avec certitude entre un dommage certain, la venue du chat et le propriétaire, la responsabilité peut être engagée.

En droit, la notion de « garde » renvoie à l’idée de maîtrise : celui qui a l’usage, le contrôle et la direction de l’animal. Dans l’immense majorité des cas, c’est le propriétaire. Et c’est précisément parce que le chat est un chat (mobile, autonome, parfois fugueur) que le droit choisit une règle simple : la victime ne supporte pas le risque de cette autonomie ; le gardien, si, lorsqu’il est parfaitement identifiable.

C’est quelque chose qui peut être sous-estimé, mais adopter un animal est de fait vecteur de responsabilité. La Société protectrice des animaux (SPA) met d’ailleurs régulièrement à jour la liste des obligations des propriétaires d’animaux domestiques.

À ce stade, le raisonnement est clair, mais l’affaire ne se limite pas à un pot de fleurs renversé. Elle parle aussi de voisinage. En effet, le deuxième fondement utile pour comprendre la décision est la théorie du trouble anormal de voisinage, désormais consacrée dans le Code civil. L’article 1253 dispose que

« Le propriétaire […] qui est à l’origine d’un trouble excédant les inconvénients normaux de voisinage est responsable de plein droit du dommage qui en résulte. »

Dans le langage juridique, « de plein droit » signifie ici que la victime n’a pas à prouver une faute, à condition d’établir l’existence d’un trouble anormal et un lien de causalité entre ce trouble et le chat.

Là encore, la logique est accessible : vivre en société implique d’accepter des désagréments ordinaires. Mais lorsqu’une nuisance dépasse ce qu’on peut raisonnablement tolérer (par sa répétition, sa durée, sa fréquence ou son intensité), le droit ouvre droit à réparation. Dans cette affaire, la répétition des intrusions (et la persistance malgré les démarches amiables) est précisément ce qui fait basculer le dossier du simple incident vers un trouble que le juge peut considérer comme anormal.

Reste enfin une question plus générale, qui explique aussi l’étonnement du public : quel est, au juste, le statut juridique d’un animal ?

Un animal sensible… mais pas responsable au sens du droit

Le droit français reconnaît la singularité de l’animal : l’article 515-14 du Code civil dispose que les animaux sont des êtres vivants doués de sensibilité, tout en précisant qu’ils demeurent soumis au régime des biens (sous réserve des lois qui les protègent).

Autrement dit l’animal n’est pas reconnu comme un bien classique au sens du Code civil, mais il n’est pas non plus un sujet de droit civilement « débiteur » : il ne peut pas, juridiquement, être condamné à indemniser. Le droit civil se tourne donc vers une personne : le gardien, parce que c’est le seul acteur doté d’un patrimoine sur lequel la réparation peut s’exécuter. C’est cette singularité qui permet d’affirmer avec humour que « le droit civil n’aime pas les chats » dans le sens où l’animal, en général, s’est révélé être un des enjeux juridiques de la modernisation du droit civil.

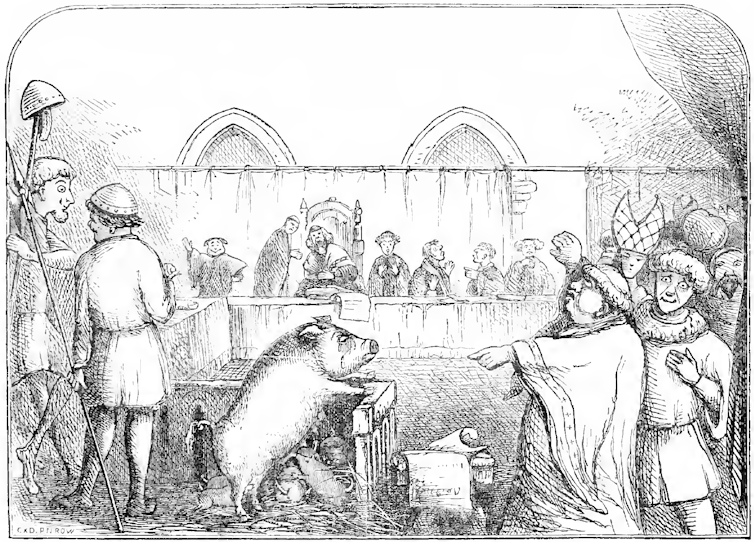

Le statut juridique de l’animal demeure toujours un sujet d’intenses débats, riches également en précédents historiques qui peuvent sembler étonnants, à l’instar des procès des animaux qui ont été rendus du XIIIᵉ au XVIᵉ siècle. Aujourd’hui, les poursuites pénales à l’encontre des animaux ne sont pas possibles puisqu’ils sont dénués de personnalité juridique. C’est un élément auquel il faut cependant faire attention, car certaines personnes défendent aujourd’hui l’octroi d’une personnalité juridique animale.

Au fond, cette affaire en dit moins sur les chats que sur le droit civil : ce dernier ne moralise pas, il œuvre pour la réparation. Le propriétaire d’un animal peut trouver cela injuste, surtout lorsque l’animal échappe en partie à son contrôle. Mais c’est précisément la logique du système : éviter que la victime supporte seule un trouble qu’elle n’a pas choisi. Le droit civil n’a pas de préférence pour les chats ou contre eux. Il a une préférence constante : identifier un responsable et réparer.

Si le chat fauteur de troubles avait été un animal errant sans propriétaire, il aurait été manifestement impossible pour le propriétaire du jardin d’obtenir réparation, en l’absence de gardien identifié du félin. Idem pour les animaux non domestiques qui doivent faire l’objet d’une autre forme de contrôle.

À cet égard, le statut du chat peut troubler. Si le droit le considère comme un animal domestique quand il a un gardien, certains peuvent questionner cette nature. C’est ce que souligne l’historienne des sciences Valérie Chansigaud dans Histoire de la domestication animale (2020), lorsqu’elle rappelle le statut atypique du chat. À la différence de nombreuses races de chiens dont l’aptitude à la chasse s’est trouvée « altérée par la domestication », le chat conserve généralement ses capacités de prédateur. Il peut s’éloigner de son gardien, et il reste « difficile de distinguer morphologiquement » les chats domestiques des chats sauvages. Le chat demeure ainsi, écrit-elle, « une énigme » qui « interroge la notion même de domestication ».

Jordy Bony ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

25.02.2026 à 16:52

Toutes pour une, une pour toutes, les coopératives agricoles françaises s’unissent

Maryline Filippi, Professeure d'économie Bordeaux Sciences Agro - Université de Bordeaux, Chercheuse associée INRAE à AgroParisTech, Université de Paris Saclay., AgroParisTech – Université Paris-Saclay

Texte intégral (1997 mots)

En 2025, les 2 100 coopératives agricoles françaises sont dans la tourmente. Résultat, entre la guerre tarifaire de Donald Trump, le conflit en Ukraine et les accords du Mercosur, elles s’unissent en groupes coopératifs pour affronter les mastodontes mondiaux de l’agroalimentaire. Mais, concrètement, comment ces entreprises singulières peuvent-elles conserver leurs principes coopératifs dans des structures aussi gigantesques ?

Le Salon international de l’agriculture de Paris est l’occasion ici de vous demander si vous savez quelles sont les entreprises qui représentent trois agriculteurs sur quatre, une marque alimentaire sur trois et 70 % de la production agricole française ? Réponse : les coopératives agricoles.

Ces derniers mois, des projets de rapprochement d’envergure conduisent à envisager la création de groupes coopératifs pesant plusieurs milliards d’euros de chiffres d’affaires. À titre d’exemple, le montant évoqué pour la fusion de la coopérative normande Agrial avec son homologue des Pays de la Loire Terrena est estimé à 12 milliards d’euros. Ce groupe regrouperait un portefeuille de marques iconiques, comme Florette, Soignon, Tipiak ou Père Dodu.

Ces processus de rapprochement concernent également des coopératives de taille plus modeste comme les coopératives viticoles de Vinay et de Mancy, à Épernay (Marne).

Derrière ces montants qui peuvent sembler stratosphériques, ces groupes conservent un statut coopératif, défini comme « une association autonome de personnes volontairement réunies pour satisfaire leurs aspirations et besoins économiques, sociaux et culturels communs au moyen d’une entreprise dont la propriété est collective et où le pouvoir est exercé démocratiquement ».

Alors, peut-on considérer que ces concentrations restent compatibles avec le modèle coopératif ? La taille économique rime-t-elle avec l’intérêt des associés coopérateurs ?

3ᵉ secteur industriel français

En France, les coopératives sont régies par la loi de 1947, déclinée pour les coopératives agricoles dans le Code rural de la pêche maritime. Peu de modifications législatives sont intervenues depuis. Cependant, les lois n°91-005 du 3 janvier 1991 et celle n°92-643 du 13 juillet 1992 ont ajouté des dispositifs conduisant à leur développement conséquent sous forme de groupe coopératif et impactant leur gouvernance démocratique.

- Plus de 2 100 coopératives agricoles dont 93 % en TPE-PME

- 10 400 coopératives d’utilisation de matériel agricole

- Plus de 200 000 emplois incluant les filiales

- 3ᵉ secteur industriel français

- 34 milliards d’euros de capital détenu par les agriculteurs

- 75 % des exploitations adhérentes

Ces groupes coopératifs sont devenus des acteurs économiques de premier plan. Ils concentrent plus de 90 % du chiffre d’affaires de la coopération agricole. Le premier groupe coopératif français InVivo, union de 187 coopératives mères, dirige plus de 200 filiales pour un chiffre d’affaires consolidé de 11,7 milliards d’euros. En parallèle, quatre groupes sont dans le top 10 des entreprises de l’agroalimentaire en France : le groupe Agrial en 4e position, Sodiaal en 7e, Terrena en 9e et Cooperl Arc Atlantique en 10e.

Taille critique

Derrière ces montants impressionnants, la situation financière de certaines coopératives, y compris céréalières, s’est dégradée. Le ratio dettes financières nettes sur fonds propres de ces dernières est passé de 74,88 % en 2018-2019 à 93,88 % en 2023-2024. Côté rentabilité, la marge est restée relativement stable, passant de 3,28 % en 2018-2019 à 3,31 % en 2023-2024.

C’est pourquoi les récents rapprochements entre coopératives, comme Agrial et Terrena, sont liés à la recherche de l’amélioration de la rentabilité économique, sur des marchés de plus en plus concurrentiels et dans un contexte géopolitique instable. Ils concernent tous les secteurs d’activité, céréales, lait ou vin, etc.

L’obtention d’une taille critique – taille minimale du marché nécessaire pour que l’entreprise puisse être viable – s’avère indispensable en raison des capacités financières limitées des coopératives agricoles classiques. L’objectif : structurer une offre commerciale, consolider les filières et aborder des marchés qui se mondialisent.

Les coopératives cherchent ainsi à partager des risques, à mutualiser des coûts d’investissement et d’innovation incontournables pour procéder aux transitions – agro-écologique, énergétique, numérique – dans tous les secteurs et les territoires.

Acquisition de sociétés de droit commercial

Ces dernières années, les groupes coopératifs multiplient les créations et les acquisitions de sociétés de droit commercial, les imbriquant dans des consortiums d’activités complexes. Derrière cette tendance de fond, il est question de rechercher de nouveaux financements, tout en garantissant aux associés coopérateurs, ou agriculteurs-adhérents, de garder leur pouvoir de décision.

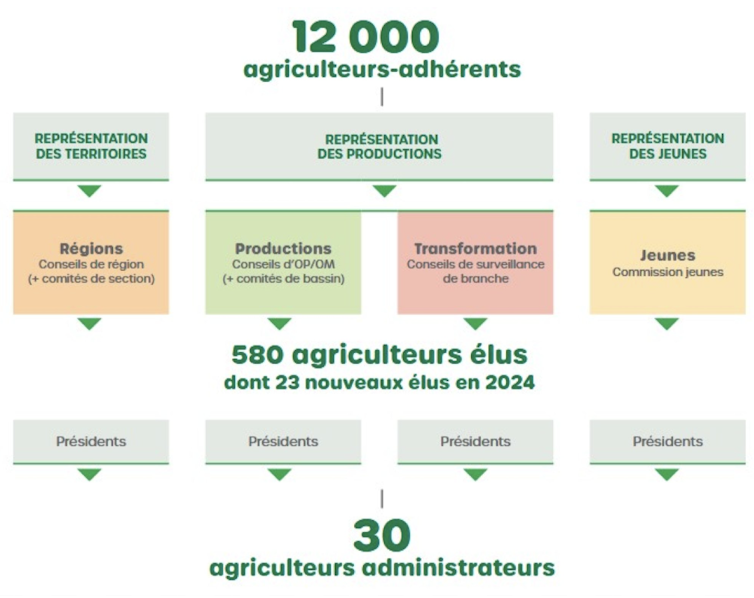

Ces groupes coopératifs sont structurés entre une maison mère de statut coopératif (coopérative ou union de coopératives) et des filiales majoritairement de droit commercial. Ces coopératives agricoles françaises sont considérées au niveau international comme des coopératives traditionnelles au regard des principes premiers établis par les équitables pionniers de Rochedale (Angleterre, XIXᵉ siècle). Concrètement, la propriété capitalistique de la tête du groupe coopératif reste aux seules mains des agriculteurs-adhérents et de leurs représentants, régie par un pouvoir démocratique selon le principe « une personne = une voix ».

En effet, l’ouverture du capital des coopératives à des associés non coopérateurs est restreinte, voire impossible. Le contrôle de la société reste le droit premier des associés coopérateurs, propriétaires de la société grâce à la détention de parts sociales. Ces derniers sont les principaux financeurs des fonds propres de la coopérative.

En créant des partenariats avec des investisseurs au niveau des filiales de droit commercial, et non via la tête de groupe sous un statut de coopérative, la difficulté d’attirer des capitaux extérieurs est ainsi contournée.

Pas d’associés hors de France

Les coopératives agricoles sont des entreprises ancrées territorialement. Elles ont une caractéristique juridique unique au monde : la circonscription territoriale, un périmètre géographique associé à leur activité économique et validé par le Haut Conseil de la coopération agricole (HCCA). Cette dernière définit la zone d’adhésion dans laquelle il est possible pour les producteurs y résidant d’adhérer à la coopérative. Comment ? En prenant des parts sociales, contrepartie de leur engagement via l’apport de ressources ou l’utilisation de services de la coopérative.

Hors de cette « circonscription territoriale » ou de la non-adhésion, la coopérative a une dérogation pour réaliser des opérations limitées à 20 % de son chiffre d’affaires avec des « tiers non associés », pour s’approvisionner en matières ou délivrer un service. Évidemment, elle peut librement vendre les productions de ses associés sans aucune restriction de chiffres d’affaires et de zone géographique. Cet assouplissement autorisé par le ministère de l’agriculture a pour objectif de compenser les éventuelles pertes liées à de mauvaises récoltes, susceptibles de remettre en cause l’équilibre économique de la coopérative. Cette règle ne concerne évidemment pas les filiales de droit commercial.

Le statut d’associé ne peut non plus être obtenu pour des producteurs qui résideraient hors de France contrairement à la pratique dans d’autres pays. Par exemple, les 12 000 producteurs laitiers de la coopérative laitière Arla Foods résident dans sept pays : Royaume-Uni, Belgique, Pays-Bas, Luxembourg, Danemark, Suède et Allemagne.

Le cas du développement de coopératives polyvalentes, comme Agrial ou Terrena, reste une caractéristique des coopératives agricoles françaises, non délocalisables et actrices clés de la souveraineté alimentaire. Avec in fine, un objectif de mettre en œuvre une gouvernance leur permettant à la fois de conserver une proximité avec leurs associés coopérateurs et garantir leur place dans la prise de décision.

Maryline Filippi ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

25.02.2026 à 16:50

One Health : un label parfois flou, mais une approche scientifique éprouvée

Marisa Peyre, Deputy head of ASTRE research unit, epidemiologist, Cirad

François Roger, Directeur régional Asie du Sud-Est, vétérinaire et épidémiologiste, Cirad

Texte intégral (2128 mots)

La pandémie de Covid-19 a révélé l’urgence de repenser notre approche de la santé. Aujourd’hui, « One Health », qui relie la santé humaine, animale et environnementale, s’est imposée dans les discours, mais fait parfois l’objet de confusion, voire de détournements. Bien mise en œuvre, elle constitue pourtant une conception éprouvée pour renforcer la prévention sanitaire mondiale.

Pandémies, résistance antimicrobienne, maladies vectorielles, effondrement de la biodiversité, dégradation des sols, pollutions chimiques, crises alimentaires… nous avons aujourd’hui une conscience aiguë des liens étroits entre enjeux de santé humaine, animale et environnementale. Face à la multiplication des crises sanitaires, environnementales et climatiques, le concept « One Health » est devenu central pour les analyser et y répondre.

Issues de réflexions anciennes, ses bases fondatrices actuelles ont été posées par les principes de Manhattan, formulés en 2004 lors de la conférence « One World, One Health » organisée par la Wildlife Conservation Society. Ils reconnaissent l’interdépendance étroite entre la santé humaine, la santé animale et la santé des écosystèmes, et appellent à une approche intégrée pour prévenir les crises sanitaires, environnementales et sociales. Cette vision, qui dépasse la seule gestion des risques sanitaires, invite à repenser les modes de production, de consommation et de gouvernance. L’enjeu ? Préserver durablement les socioécosystèmes et les communautés qui en dépendent.

Malgré l’intérêt croissant que le One Health suscite, son utilisation en recherche et ses applications restent floues et souvent mal comprises. Trop souvent, il est réduit à un slogan politique ou à une gestion biomédicale des zoonoses, sans prendre en compte l’interdépendance des facteurs écologiques, sociaux et économiques. Ces derniers conditionnent pourtant la santé globale et la dynamique des crises sanitaires.

Un cadre opérationnel de prévention

Depuis plus de vingt ans, des initiatives portées par la science se développent pour mettre en œuvre de façon concrète l’approche « One Health ». Au Cirad, des travaux sur les maladies animales émergentes, les interfaces faune-élevage-humains et les systèmes agricoles tropicaux ont mis en évidence, dès les années 2000, les liens étroits entre santé, biodiversité et usages des territoires.

Nos recherches ont peu à peu intégré les dimensions environnementales, sociales et alimentaires. L’enjeu est de passer d’une logique de gestion des crises à une approche de prévention des risques d’émergence. En 2021, une coalition internationale portée par la recherche et baptisée PREZODE a été créée pour mener des opérations de prévention fondée sur l’approche One Health.

Elle intervient en Afrique, en Asie, en Amérique latine et dans les Caraïbes pour comprendre, réduire et détecter de façon précoce les risques en santé et éviter les épidémies.

Gestion des écosystèmes, agroécologie et surveillance sanitaire

En Guinée, ses équipes ont ainsi observé comment les pratiques agricoles intensives affectant la ressource forestière favorisaient l’intensification des contacts humains-faune. Ces contacts favorisent la transmission entre humains et animaux sauvages de maladies zoonotiques, comme les fièvres hémorragiques (Ebola, Lassa, Marburg).

Avec les communautés locales, des stratégies de prévention basées sur la gestion des écosystèmes ont été mises en place pour limiter le risque d’émergence de nouvelles épidémies.

À Madagascar, des scientifiques du Cirad, en partenariat avec l’ONG Pivot et l’Institut de recherche et de développement (IRD), ont développé une méthode de surveillance intégrée des risques sanitaires. Elle combine les données vétérinaires, humaines et environnementales, pour mieux anticiper les épidémies émergentes.

Au Gabon, dans le cadre d’un projet qui soutient les associations de chasseurs dans leur gestion des ressources forestières – y compris la biodiversité – nous avons mis en place un système de surveillance communautaire pour détecter très rapidement les évènements sanitaires suspects. Ceci a été mené en collaboration, avec le Centre interdisciplinaire de recherche médicale de Franceville (CIRMF).

En Asie du Sud-Est, les actions s’inscrivent dans une approche agroécologique qui articule les enjeux de santé et de gouvernance territoriale. Elles visent à accompagner des transitions agricoles et à réduire les pressions sur les écosystèmes (déforestation, usage des intrants, artificialisation). L’enjeu est d’améliorer la résilience des systèmes alimentaires locaux et la prévention des risques sanitaires, à l’interface entre humains, animaux et environnement.

Ces démarches reposent sur des diagnostics territoriaux participatifs, le croisement de données agricoles, écologiques et sanitaires et le soutien à des pratiques agroécologiques adaptées aux contextes locaux (diversification des cultures, gestion intégrée des élevages, restauration des paysages). L’objectif est de faire de l’agroécologie un levier pour prévenir les émergences infectieuses, améliorer la sécurité alimentaire et permettre un développement territorial durable, en cohérence avec l’approche One Health.

Une gouvernance fragmentée

Ces exemples illustrent l’efficacité d’une prévention alliant une vision systémique des enjeux sanitaires et une gouvernance partagée entre acteurs locaux, scientifiques et autorités gouvernementales. Malgré tout, de nombreux obstacles subsistent.

La fragmentation institutionnelle reste l’un des plus grands défis. À toutes les échelles, les secteurs de la santé, de l’agriculture et de l’environnement ne communiquent pas assez, ce qui freine la mise en œuvre d’une gouvernance efficace. La voix des communautés est rarement sollicitée. Les projets One Health sont, en outre, souvent financés à court terme et souvent fléchés sur les zoonoses uniquement. Cela alimente le flou autour du concept et n’encourage pas son appropriation par les pays qui en auraient pourtant le plus besoin.

Les acteurs de terrain soulignent que l’accès en temps utile à des données locales et nationales – depuis leur collecte jusqu’à leur partage et leur analyse – est central. Ce sont elles qui permettent de renforcer la surveillance et la prévention des maladies zoonotiques et construire des systèmes plus résilients, capables d’anticiper et d’atténuer en temps réel les menaces sanitaires actuelles et futures. Il est nécessaire, pour cela, d’être doté d’infrastructures de données solides et partagées entre les secteurs concernés, et de les mobiliser pour développer des outils de modélisation prédictive pertinents. Mais pas seulement : une réponse rapide, adaptée et coordonnée au niveau local peut suffire à prévenir les risques d’émergence.

Risque de « One Health washing »

Sans une collaboration efficace entre les secteurs, le risque est de voir se développer un « One Health washing ». Il existe de nombreux projets qui se revendiquent du concept, mais sans mettre en place de travaux ou d’actions réellement intégrées.

C’est le cas de publications traitant de pathogènes zoonotiques, mais uniquement focalisées sur la santé humaine. Idem pour certaines initiatives agricoles qui utilisent le terme abusivement. Toujours dans ce cadre, certaines études se réclament de l’approche One Health principalement au titre d’une mobilisation interprofessionnelle – par exemple via l’implication de réseaux vétérinaires dans le diagnostic humain – sans pour autant mettre en œuvre un véritable design d’étude intégrant conjointement des données humaines, animales et environnementales, ni analyser les effets d’une action spécifique sur les différents secteurs.

Pour autant, ces projets sont importants. Ils peuvent contribuer à renforcer des approches plus intégrées de la santé. À ce titre, ils constituent des étapes intermédiaires vers un One Health plus abouti. Le principal risque réside plutôt dans l’usage extensif et peu exigeant du terme One Health, qui, en devenant un label fourre-tout, finit par en affaiblir la portée scientifique, opérationnelle et politique.

Dans ce contexte, clarifier les fondements et les modalités d’application du One Health est essentiel. C’est l’objectif de l’Atlas One Health, qui propose une lecture de cette approche articulant santé humaine, animale, des écosystèmes, mais aussi agricultures et systèmes alimentaires, dynamiques sociales, gouvernance et territoires. Avec des études de cas, des cadres analytiques et des outils issus du terrain, cet ouvrage vise à faire du One Health un véritable cadre d’action collective et de prévention.

L’un des défis les plus importants est d’intégrer la dimension sociale et de genre pour garantir des solutions inclusives et efficaces. Ceci évitera des interventions mal adaptées qui risqueraient de creuser davantage les inégalités. En milieu rural notamment, les femmes jouent un rôle clé dans l’alimentation, l’approvisionnement en eau et la gestion des ressources naturelles. Elles restent pourtant souvent invisibles dans les politiques de santé publique et de prévention.

Un investissement plus qu’un coût

Le financement de la prévention One Health doit être considéré comme un investissement stratégique, et non comme un coût. Moins spectaculaires que la gestion des crises sanitaires, les approches préventives sont largement plus rentables et engendrent des co-bénéfices majeurs : adaptation et atténuation du changement climatique, systèmes agricoles plus durables, réduction des intrants chimiques, protection de la biodiversité et amélioration de la qualité de l’alimentation.

Les travaux menés par le Cirad, l’initiative PREZODE et toute la communauté internationale en faveur de ces principes s’accordent sur le constat que ces actions renforcent simultanément la santé, les moyens de subsistance et la résilience des territoires. Or, la prévention demeure trop dépendante de financements internationaux ponctuels : elle doit être inscrite dans des budgets nationaux pluriannuels intégrés aux politiques agricoles, sanitaires, environnementales et alimentaires, afin de soutenir des transformations structurelles durables.

Anticiper les crises demande de repenser fondamentalement nos systèmes. Une approche « One Health » transformatrice nécessite un engagement politique durable, de la coopération internationale et une volonté commune d’intégrer les dimensions sociales et écologiques dans la gestion des risques sanitaires. Un travail de longue haleine qui est déjà en marche. Ces messages seront portés au cours des évènements organisés par PREZODE lors du Sommet One Health, qui se tiendra à Lyon (Rhône), le 7 avril 2026 sous la présidence française du G7.

Marisa Peyre est membre de PREZODE

François Roger est affilié au CIRAD, partenaire du programme PREZODE mentionné dans cet article.

24.02.2026 à 19:44

Chiens de race : l’esthétique peut-elle justifier la souffrance ?

Valérie Chansigaud, Historienne des sciences et de l'environnement, chercheuse associée au laboratoire Sphère (Paris Cité - CNRS), Université Paris Cité

Texte intégral (2735 mots)

Afin de limiter la souffrance animale, la Commission européenne tâche de poser des limites à la sélection génétique des races de chiens et de chats aux traits dits extrêmes. Si cette avancée demeure inédite, elle réagit à un phénomène tout sauf nouveau : l’obsession de l’être humain pour l’apparence des animaux domestiques.

Le Conseil et le Parlement européens ont récemment adopté une accord provisoire visant à encadrer plus strictement l’élevage des chiens et des chats, en interdisant notamment la reproduction et la mise en avant d’animaux présentant des « formes extrêmes ».

Sont particulièrement concernées certaines morphologies associées à des troubles graves et durables, comme les chiens au museau écrasé, chez lesquels les difficultés respiratoires, l’intolérance à l’effort ou les problèmes locomoteurs sont désormais bien documentés.

Cette évolution réglementaire répond à des alertes répétées du monde vétérinaire et à une sensibilité croissante de l’opinion publique à la souffrance animale. Elle s’inscrit également dans une longue histoire de la place démesurée accordée par les sociétés humaines à l’apparence des animaux domestiques et à leur volonté de la façonner.

Sélectionner l’apparence : une pratique ancienne aux usages multiples

Il est impossible de dater précisément le moment où les humains auraient commencé à sélectionner des animaux sur des critères esthétiques. Bien avant l’existence des « races » au sens moderne (un phénomène qui émerge au XIXᵉ siècle), des animaux étaient déjà choisis en fonction de leur sexe, de leur âge, de leur couleur ou de leur conformation.

Dans de nombreuses sociétés anciennes, les animaux destinés au sacrifice devaient ainsi répondre à des critères précis d’apparence et d’intégrité corporelle : dans les cultes grecs et romains, seuls des animaux « sans défauts » étaient admis devant les divinités ; en Chine, sous la dynastie Zhou (XIᵉ siècle avant notre ère), les sacrifices royaux exigeaient également des bêtes jugées parfaites, tant extérieurement qu’intérieurement.

Autrement dit la sélection sur l’apparence est probablement aussi ancienne que la domestication elle-même. Elle n’était jamais isolée : elle s’entremêlait à des critères religieux, sociaux, économiques ou politiques, par exemple lorsque le pouvoir politique affirme sa puissance en imposant des animaux sacrificiels répondant à des normes précises.

Ce qui change à l’époque contemporaine, c’est que l’apparence peut devenir, dans certains cas, le critère central, voire exclusif, de la création des races. Posséder un chien de race peut ainsi marquer un rang, une appartenance sociale ou un certain rapport au monde, comme d’autres animaux ont pu, à différentes époques, signaler le prestige ou le pouvoir de leur propriétaire, à commencer par le cheval, mais aussi certains chiens de chasse.

Une préoccupation tardive pour la santé et le bien-être

Les races modernes émergent au XIXᵉ siècle, dans un contexte marqué par le goût pour la classification, la hiérarchisation et la distinction sociale fondée sur la notion de « race ». Cette passion pour les lignées « pures » n’est pas sans lien avec les cadres intellectuels qui, à la même époque, voient se développer les théories raciales appliquées aux humains.

Pendant longtemps, les effets de la sélection ont été évalués presque exclusivement à l’aune de la productivité, de l’efficacité ou de la conformité à un standard. La souffrance animale était connue, mais largement tolérée, considérée comme secondaire, voire inévitable. Les pratiques vétérinaires elles-mêmes en témoignent : pendant une longue période, des interventions lourdes ont été pratiquées sans anesthésie, comme la stérilisation des chiennes.

D’autres gestes, aujourd’hui reconnus comme inutiles et douloureux, étaient également courants : on sectionnait par exemple le frein de la langue chez les chiens, dans l’idée erronée de prévenir la rage.

Ces pratiques témoignent d’un rapport au corps animal dans lequel la souffrance était largement ignorée, par indifférence plus que par méconnaissance.

Ce n’est qu’à partir de la seconde moitié du XXᵉ siècle que la douleur chronique, la qualité de vie ou la santé à long terme des animaux commencent à être pensées comme des problèmes en tant que tels. Les inquiétudes actuelles concernant les chiens aux morphologies extrêmes – difficultés respiratoires, troubles locomoteurs, intolérance à l’effort – s’inscrivent pleinement dans cette histoire récente de la sensibilité au bien-être animal.

Des chats qui ont longtemps échappé à cette logique

La récente réglementation européenne semble concerner plus directement les chiens que les chats, et cette impression correspond à une réalité historique, biologique et sociologique. En France, comme dans de nombreux pays européens, les chiens de race sont proportionnellement plus nombreux que les chats de race. Cette différence s’explique en grande partie par l’histoire de l’élevage.

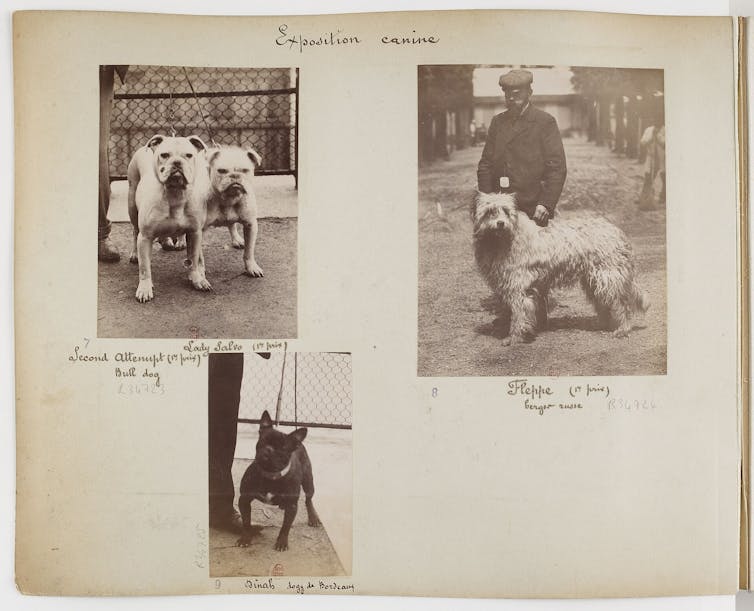

L’intérêt pour les races de chiens est ancien et structurant. La sélection de types morphologiques spécifiques devient l’un des moteurs centraux de l’élevage canin au XIXᵉ siècle, en systématisant et en normant des pratiques bien plus anciennes de différenciation fonctionnelle. Dès l’Antiquité, certains chiens sont ainsi recherchés pour des usages guerriers ou de combat, en fonction de leur taille, de leur puissance ou de leur agressivité.

Ce type de sélection n’est d’ailleurs pas propre aux chiens : chez les gallinacés, des individus ont été privilégiés très tôt pour des usages non alimentaires, notamment pour le combat de coqs ou comme animaux d’ornement, bien avant que ne s’impose une sélection orientée vers la production de chair ou d’œufs.

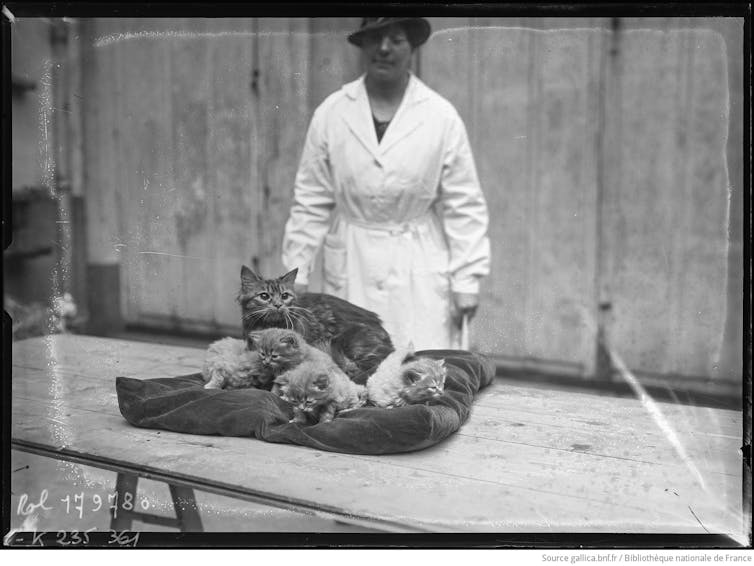

À l’inverse, les chats ont longtemps échappé à cette logique. Les premiers concours félins du XIXᵉ siècle récompensaient des individus – souvent des chats de gouttière – et non des représentants de races qui n’étaient pas encore standardisées. Le chat est resté plus longtemps un animal ordinaire, moins soumis aux impératifs de sélection morphologique.

Quels chiens demain ?

Les croisements récents, comme le pomsky (issu du croisement du husky sibérien et du spitz nain), témoignent aujourd’hui d’une forte demande pour des animaux perçus comme originaux et attendrissants, mais qui sont surtout emblématiques d’un effet de mode.

Le choix de ces chiens relève moins d’une réflexion sur leurs besoins ou leur santé que d’une logique de distinction : on choisit un chien comme on choisirait une paire de chaussures, parce qu’il flatte l’ego de son propriétaire et signale une position sociale. Dénoncées depuis longtemps par les vétérinaires, qui constatent au quotidien les conséquences de la sélection de morphologies extrêmes, ces pratiques pourraient être freinées par la nouvelle réglementation européenne, en rappelant clairement que tout croisement n’est pas acceptable dès lors qu’il compromet la santé ou le bien-être des animaux concernés.

Prédire à quoi ressembleront les chiens du futur reste toutefois hasardeux. L’histoire montre que les avancées en matière de protection animale ne sont ni linéaires ni irréversibles. L’émergence d’idéologies brutales ou violentes pourrait très bien conduire à un recul de la prise en compte de la souffrance animale. L’interdiction des formes extrêmes révèle ainsi une tension ancienne entre la vanité des désirs humains parfois cruels et la nécessité d’établir des règles morales pour en limiter les effets – un débat aussi vieux que la philosophie elle-même.

Cette réflexion trouve un écho particulier dans certaines initiatives muséales récentes. L’exposition « Domestique-moi, si tu peux », présentée au Muséum de Toulouse (Haute-Garonne), propose ainsi de revisiter l’histoire longue de la domestication en montrant qu’il ne s’agit pas d’un phénomène « naturel » et qu’elle est façonnée par des choix humains parfois irrationnels. Elle met surtout en évidence la place centrale de la domestication dans la construction des cultures humaines, la sélection artificielle ayant pour objectif principal de rendre des organismes vivants – animaux comme végétaux – compatibles avec les modes de vie et les besoins humains.

L’exposition « Domestique-moi, si tu peux » retrace l’histoire des domestications animales et végétales et leurs conséquences sur la biodiversité. On peut la visiter jusqu’au 5 juillet 2026 au Muséum de Toulouse. L’historienne Valérie Chansigaud en est la commissaire scientifique.

Valérie Chansigaud ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

24.02.2026 à 17:03

Les raisons de la mobilisation agricole en Europe expliquées par les agriculteurs eux-mêmes

Sophie Thoyer, Directrice de département Scientifique, Inrae

Pauline Lecole, Maitresse de conférence en économie et politiques agricoles, Montpellier SupAgro

Texte intégral (2049 mots)

Depuis l’hiver 2024, les mobilisations agricoles ont été largement interprétées, au plan médiatique, comme un rejet massif des normes environnementales. Mais est-ce vraiment le cas ? Qu’en disent eux-mêmes les agriculteurs mobilisés ? Une vaste étude a recensé leurs réponses en France, en Allemagne, en Belgique et aux Pays-Bas. Elle livre une image bien plus nuancée en fonction des États, où le poids des normes environnementales n’est finalement qu’un enjeu secondaire. Celui-ci a pourtant été au cœur de la réponse politique.

Blocages d’autoroutes, convois de tracteurs vers les capitales, déversements de fumier devant les bâtiments publics… depuis l’hiver 2024, les agriculteurs européens se mobilisent de façon spectaculaire. Très visibles, ces mouvements restent pourtant mal compris. Entre cadrages médiatiques hâtifs et récupérations politiques, leurs revendications ont souvent été résumées à un rejet des normes environnementales. Mais est-ce réellement ce que disent les agriculteurs eux-mêmes ?

Pour répondre à cette question, nous avons récemment publié une étude qui s’est appuyée sur une vase enquête en ligne, menée entre avril et juillet 2024, auprès de plus de 2 200 agriculteurs ayant participé aux mobilisations en France, en Allemagne, en Belgique et aux Pays-Bas.

Plutôt qu’une liste fermée de griefs, nous avons préféré leur poser une question simple et surtout ouverte : « Pourquoi vous mobilisez-vous ? » Les agriculteurs ont ainsi pu répondre de façon anonyme et sous une forme libre : parfois en quelques mots, parfois en plusieurs paragraphes.

À lire aussi : Colère des agriculteurs : « Ce qui était cohérent et cohésif est devenu explosif »

Une pluralité de motivations

Cette méthode a permis d’éviter d’orienter les réponses et de saisir les motivations telles que formulées spontanément par les intéressés eux-mêmes. Les textes ont ensuite été analysés, dans leur langue d’origine, grâce à un grand modèle de langage (LLM), type d’outil relevant de l’intelligence artificielle (IA), pour identifier les principales revendications. Un codage manuel a ensuite permis, pour la France, de vérifier la cohérence de l’analyse faite par l’IA.

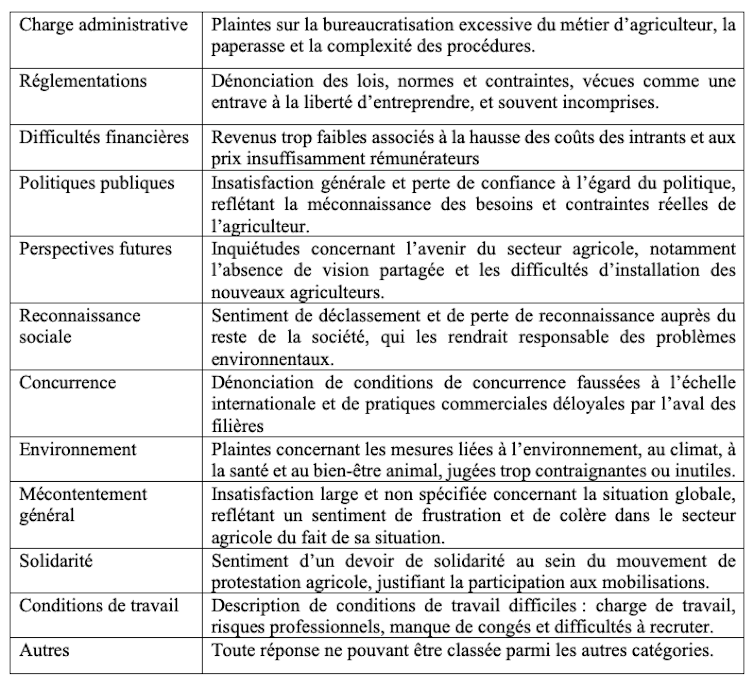

Nous avons ainsi pu identifier les grands thèmes récurrents, et ceci en limitant les biais d’interprétation. À la clé, une dizaine de catégories de motivations, que nous avons résumées dans le tableau ci-dessous :

En termes de codage, une réponse peut entrer dans plusieurs catégories de motivations à la fois. Par exemple, un exploitant français cultivant 175 hectares (ha) a indiqué en réponse à l’enquête :

« On nous fait marcher à la baguette, on nous pond des interdictions de partout qui nous compliquent [le] travail, alors que l’on travaille beaucoup à un tarif horaire de misère. »

Cette réponse a pu ainsi être classée à la fois dans les catégories « réglementation », « difficultés financières », « politiques publiques » et « conditions de travail ».

Des revendications différenciées en Europe

Contrairement à l’idée d’un mouvement unifié partout en Europe autour du rejet des normes environnementales et des insatisfactions liées au revenu, les motivations sont apparues comme fortement différenciées selon les pays.

En France et en Belgique, les difficultés financières dominent largement : plus d’un agriculteur sur deux évoque la faiblesse des revenus, la hausse des coûts des intrants et des prix jugés insuffisamment rémunérateurs.

En Allemagne, la première préoccupation concerne la charge administrative, citée dans plus de la moitié des réponses.

Aux Pays-Bas, les critiques visent plus directement l’inadéquation des réponses en terme de politiques publiques aux besoins et contraintes du monde agricole.

La dénonciation explicite des règles environnementales arrive loin derrière, sauf dans le cas de la Belgique. En France, elle n’est mentionnée que dans une faible proportion des réponses, bien en deçà des enjeux de revenu, de reconnaissance ou de concurrence.

Le mouvement de 2024 apparaît ainsi loin d’être homogène à l’échelle européenne, malgré les tentatives de certains acteurs syndicaux de porter un message unitaire.

À lire aussi : La FNSEA, syndicat radical ? Derrière le mal-être des agriculteurs, des tensions plus profondes

Un décalage entre les revendications et les réponses politiques

Nous avons ensuite comparé ces motivations aux mesures politiques adoptées entre fin 2023 et septembre 2024 aux niveaux national et européen.

Dans certains cas, les réponses publiques ont été en phase avec les préoccupations exprimées. En Allemagne, l’accent a été mis sur la simplification administrative, qui correspond à la principale revendication identifiée dans notre enquête. En France et en Belgique, plusieurs mesures ont visé à atténuer les difficultés de revenu, mais les moyens mis en œuvre sont restés limités.

En revanche, certaines thématiques ont reçu une attention politique disproportionnée au regard de leur poids réel dans les déclarations des agriculteurs. C’est notamment le cas des régulations environnementales.

Cela s’est traduit notamment dans le paquet simplification de la politique agricole commune (PAC) de mai 2024, qui a accordé des dérogations et des flexibilités supplémentaires à l’application des règles de conditionnalité dans les États membres.

Alors qu’elle n’arrivait qu’en septième position des préoccupations déclarées par les agriculteurs, la réduction des contraintes environnementales a été le troisième chantier législatif en Allemagne, en terme de nombre de mesures prises. Aux Pays-Bas, ce fut même le premier.

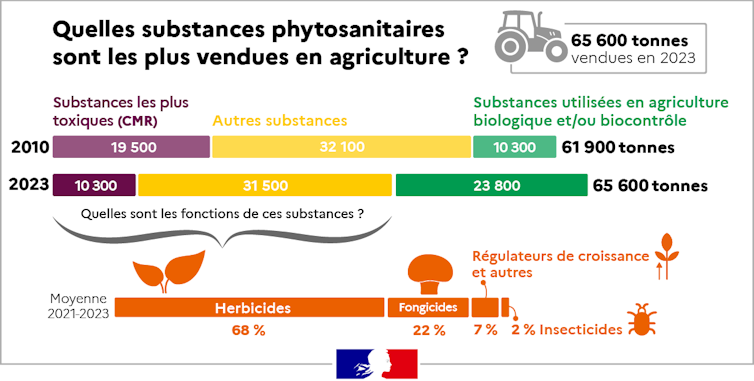

De la même manière en France, seuls 7 % des agriculteurs se sont exprimés explicitement pour critiquer le poids des normes environnementales. Pourtant, le gouvernement français a répondu par une suspension du plan Écophyto (destiné à réduire l’usage des pesticides) et par l’allègement des contrôles liés aux obligations environnementales.

Plus tard, une grande partie des débats sur le contenu de la loi d’orientation pour la souveraineté alimentaire et le renouvellement des générations en agriculture, finalement promulguée en mars 2025, et de la proposition de loi sur les contraintes à l’exercice du métier d’agriculteur (dite « loi Duplomb »), ont été extrêmement concentrés sur l’allègement des normes environnementales.

À lire aussi : Loi Duplomb et pesticides : comment la FNSEA a imposé ses revendications

Entre expression sociale et cadrage stratégique

Cette focalisation sur les normes environnementales interroge. Elle suggère que certaines revendications ont été amplifiées dans l’espace public, au croisement d’intérêts syndicaux, économiques et politiques. Comme dans tout mouvement social, les mots d’ordre qui circulent ne reflètent pas toujours l’ensemble des préoccupations individuelles.

Donner directement la parole aux agriculteurs ne permet pas seulement de nuancer le récit dominant : cela met en lumière la profondeur du malaise. Au-delà des normes ou des aides, beaucoup expriment un sentiment de déclassement, de perte de sens et d’absence de perspectives pour les générations futures.

Comprendre ces mobilisations suppose donc d’aller au-delà des slogans et de reconnaître leur diversité interne. Faute de quoi, les réponses politiques risquent de traiter seulement les symptômes stratégiquement mis en visibilité par les groupes d’influence plutôt que les causes structurelles du malaise agricole européen.

Solal Courtois-Thobois a participé à la réalisation de cet article.

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

23.02.2026 à 17:18

Municipales 2026 : comprendre la gratuité des transports en graphiques

Félicien Boiron, Doctorant en science politique (LAET-ENTPE), ENTPE; Université Lumière Lyon 2

Texte intégral (2091 mots)

Dunkerque, Montpellier, Calais, Nantes… toutes ces villes ont mis en place la gratuité totale des transports en commun. Promue par certains candidats, conspuée par d’autres, cette mesure devient un élément central des campagnes électorales municipales de 2026. Mais qu’en disent les experts ? Quels sont ses effets bénéfiques et pernicieux ? Décryptage en graphique et en données.

La gratuité des transports en commun, rarement débattue aux élections municipales de 2014 et encore relativement discrète en 2020, se trouve désormais au cœur des campagnes municipales de 2026. Mobiliser une forme de gratuité semble être devenu un passage obligé des débats locaux.

À Lyon (Rhône), après avoir mis en place la gratuité pour les moins de 10 ans, le président de la Métropole Bruno Bernard (Les Écologistes) fait campagne en mobilisant la gratuité des enfants abonnés TCL. De son côté Jean-Michel Aulas (LR, Ensemble) propose une gratuité pour les personnes gagnant moins de 2 500 euros.

Des débats similaires s’ouvrent dans des villes de tailles et de contexte variés comme Angers (Maine-et-Loire), Dijon (Côte-d’Or), Marseille (Bouches-du-Rhône), Paris.

Gratuité totale des transports

Alors même que les transports en commun relèvent le plus souvent de la compétence des intercommunalités, les décisions de gratuité sont prises par une large diversité de collectivités locales, parfois au titre d’autres compétences.

La gratuité est longtemps restée cantonnée à des territoires de petites tailles, avec des transports en commun peu utilisés et de faibles recettes de billetique. À présent, elle s’invite dans des territoires pluriels. Si elle reste principalement mise en œuvre à l’échelle territoriale des villes, elle se développe au sein de communautés urbaines, comme Poher Communauté en Bretagne, ou par les syndicats de transport comme dans le Douaisis, dans le nord de la France.

Après les records de mise en place de cette mesure dans les villes d’Aubagne (100 000 habitants, Bouches-du-Rhône) en 2009, puis de Dunkerque (200 000 habitants, Nord) en 2018, Montpellier (Hérault) a fait franchir un nouveau seuil à la gratuité à partir de 2021 en instaurant la mesure pour ses habitants sur un réseau comprenant plusieurs lignes de trams. Pour sa part, depuis janvier 2026, le syndicat de transports de l’Artois, dans le Nord, est devenu le plus grand territoire français aux transports totalement gratuits avec 650 000 habitants pouvant bénéficier d’une telle mesure.

Si certains partis ont fait de la gratuité des transports un élément fréquent dans leur programme comme le Parti communiste français (PCF), ou plus récemment La France insoumise (LFI), la gratuité n’est pas réservée aux politiques de gauche. Elle est mise en œuvre aussi bien par la droite, comme à Calais (Pas-de-Calais) ou à Châteauroux (Indre), que par la gauche, comme à Morlaix (Finistère) ou Libourne (Gironde). La mesure résiste aux alternances politiques, en étant rarement remise en question.

Report modal de la marche vers les transports en commun

Depuis plusieurs années, les rapports et positions sur la gratuité des transports en commun font légion. Alors que, jusque dans les années 2010, la mesure était peu étudiée, essentiellement par les services du ministère de l’environnement, de nombreuses évaluations se sont développées. Des études ont été commandées par la Ville de Paris, par l’Île-de-France Mobilités ou encore par le syndicat de transports lyonnais (Sytral).

Dans ces études, la gratuité des transports en commun est largement évaluée selon ses effets sur la répartition modale, comprise comme le pourcentage d’utilisation des différents modes de transports. La gratuité est jugée bonne si elle permet un bon report modal, c’est-à-dire d’un mode polluant vers un mode moins polluant – de la voiture au vélo, par exemple. Les rapports concluent que la gratuité est inefficace, puisqu’elle engendrerait un report modal, essentiellement depuis la marche et le vélo vers les transports en commun. Même la Cour des comptes a récemment pointé cette inefficacité à produire un bon report modal.

À lire aussi : Gratuité des transports : comprendre un débat aux multiples enjeux

Ce constat d’inefficacité est alors largement relayé au-delà de la sphère experte, notamment par des acteurs institutionnels et des groupes d’intérêts du transport, qui s’appuient sur ces évaluations pour structurer leur opposition à la gratuité. Les groupes d’intérêts du transport, comme le GART, qui regroupe les collectivités, ou l’UTPF, qui regroupe les entreprises de transport, s’appuient sur ces constats pour s’opposer à la mesure. Les groupes d’intérêts du transport mobilisent ces expertises pour s’opposer assez unanimement à la gratuité. La FNAUT qui représente les usagers et usagères des transports défend que « la gratuité totale, isolée de toute autre mesure, ne favorise pas un report modal ».

Politique publique de mobilité

Si la gratuité des transports est fréquemment étudiée comme une politique publique de mobilité, les élus qui la mobilisent le font au nom d’une grande variété d’objectifs. Nombreux sont les motifs évoqués pour défendre la gratuité, tels que réduction de la pollution de l’air, attractivité territoriale et des commerces, protection du pouvoir d’achat, etc.

À Aubagne, c’est la recherche de liberté et d’accessibilité sociale accrue aux transports qui sont mises en avant. À Dunkerque, on y voit un instrument d’aménagement urbain pour redynamiser le centre-ville. À Montpellier, la mesure est présentée comme un instrument de gouvernance territoriale, pour améliorer le pouvoir d’achat des classes moyennes et populaires. À Calais, on souhaite répondre au mouvement des gilets jaunes et au coût des déplacements. À Nantes (Loire-Atlantique), la gratuité le week-end est associée à des objectifs sociaux et de réduction de l’autosolisme.

Une grande partie des effets prétendus à la gratuité des transports échappe à l’évaluation. Les effets sociaux de la mesure, notamment sur l’isolement de certaines populations, sur la facilité d’accès au transport, ont été encore peu étudiés. Même lorsque l’Observatoire des villes du transport gratuit s’intéresse aux conséquences sur les automobilistes ou sur les jeunes, ce sont essentiellement leurs chiffres sur le report modal qui sont repris dans les débats.

Financer les transports

En France, les transports en commun sont financés par trois sources principales :

le versement mobilité, impôt sur la masse salariale, payée par les entreprises, administrations et associations ;

les recettes tarifaires, payées par les usagers et usagères ;

les subventions des collectivités locales.

Les proportions de ces trois sources varient en fonction des territoires, mais le versement mobilité est souvent la source principale du financement. Les territoires denses et au réseau de transport bien structuré présentent en général des recettes tarifaires plus élevées. Aussi, si la gratuité totale des transports en commun supprime des coûts liés à la billetique (distributeurs automatiques de titres, valideurs, logiciels, application, contrôleurs, etc.), dans les grands réseaux, ces coûts sont généralement plus faibles que ce que rapportent les recettes commerciales.

Une politique totem

Si l’opposition à la gratuité totale des transports en commun est si forte, c’est que, pour beaucoup, la mesure dévaloriserait le transport. « Aucun service n’est réellement gratuit », « la gratuité n’existe pas » sont autant d’expressions révélant une valorisation d’un service par son prix.

Parler de gratuité des transports en commun est révélateur du caractère anormal de la mesure. Parlons-nous ainsi de « gratuité de la police » ? Dans un secteur plus proche, nous ne parlons pas non plus de gratuité des routes, alors que celles-ci sont très largement gratuites et que leur coût est largement supporté par les contribuables plutôt que les usagers et usagères. Comme pour les transports en commun, beaucoup d’économistes défendent pourtant une tarification de la route.

La gratuité des transports est une politique totem. Souvent intégrée à des projets de mobilités, l’intégralité des effets de la mesure demeure encore largement inconnue, tant les sens associés à la mesure sont divers. Les débats sur la gratuité des transports interrogent ainsi la légitimité d’un financement collectif renforcé des mobilités, mais aussi les cadres d’expertise à partir desquels les politiques publiques sont évaluées et jugées.

La thèse de Félicien Boiron est financée par le ministère de la Transition écologique.

23.02.2026 à 17:17

Moins de déchets mais un tri encore imparfait : plongée dans les poubelles des Français

Romuald Caumont, Chef du service Coordination, évaluation et valorisation à la direction économie circulaire l’Ademe, Ademe (Agence de la transition écologique)

Texte intégral (1610 mots)

Que contiennent vraiment nos poubelles et comment leur composition a-t-elle évolué au cours des dernières années ? Une vaste étude de l’Ademe révèle les progrès du tri en France : la poubelle grise s’allège et les nouvelles filières de collecte s’inscrivent peu à peu dans les habitudes. Pourtant, un peu moins de 70 % du contenu de nos poubelles grises ne devrait pas s’y trouver : des axes de progression restent donc à développer.

Nos déchets constituent, sans doute, l’objet le plus tangible qui nous lie aux enjeux écologiques. Nous utilisons une poubelle plusieurs fois par jour et c’est, pour beaucoup d’entre nous, le premier sujet par lequel nous avons été sensibilisés à l’environnement. Au cours des dernières décennies, le tri et ses évolutions se sont peu à peu inscrits dans nos habitudes, même s’il reste une marge de progression pour qu’il soit parfaitement mis en œuvre.

Afin de comprendre comment la composition des déchets a évolué dans le temps, l’Agence de la transition écologique (Ademe) a fait l’exercice de se plonger dans le contenu de nos poubelles. L’enjeu était de connaître leur composition détaillée dans un certain nombre de communes, selon des protocoles et des plans d’échantillonnage bien précis afin de s’assurer que ces chiffres soient représentatifs. Ces résultats, publiés fin 2025, ont porté sur les chiffres de 2024.

De telles études avaient déjà été menées par le passé : en 1993, en 2007 puis en 2017. L’objectif, désormais, est d’annualiser cette enquête afin de mieux évaluer l’efficacité des politiques publiques de gestion des déchets. Une démarche qui permet d’identifier les gisements de déchets d’emballages plastiques, autrement dit les potentiels de valorisation à développer. En se penchant sur chaque type de déchets, ce premier travail livre déjà un certain nombre d’enseignements.

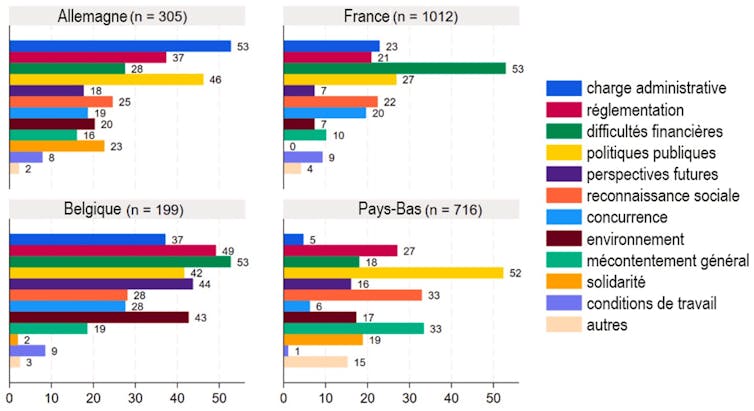

La poubelle grise au régime : 44 % moins lourde qu’il y a trente ans

Débutons par la fameuse poubelle grise vouée aux ordures ménagères résiduelles. Entre 1993 et 2024, son poids moyen a diminué de 44 %, passant de 396 kg à 223 kg par habitant. Un résultat encourageant, qui s’explique en partie par l’accroissement au cours de cette période de la mise en place du tri, qui n’était pas généralisé il y a trente ans.

Depuis 2017 en particulier, des progrès notables ont eu lieu : 30 kg en moins, là aussi, sans doute, grâce à l’amélioration du tri à la source et la mise en place de la collecte des biodéchets, qui ont chuté de 10 % sur cette période dans les poubelles grises.

Ce bilan appelle toutefois quelques nuances. Certes, le poids de nos poubelles grises diminue, mais, aujourd’hui encore, 69 % des déchets présents dans les poubelles grises ne devraient pas s’y trouver. Une proportion qui n’évolue pas. Leur composition se répartit comme suit :

un tiers correspond à des biodéchets ;

près d’un autre tiers, à des emballages et des papiers destinés à la poubelle jaune ;

5 %, à du verre ;

et 6 %, à des déchets qui devraient faire l’objet d’autres collectes, en particulier textiles et électroniques.

Par ailleurs, si la part des biodéchets et certains emballages et papiers recyclables ont diminué (respectivement, de 10 et 17 % en moins), la quantité de textiles sanitaires (couches, lingettes, essuie-tout, etc.), en revanche, connaît une forte hausse.

À lire aussi : L’histoire peu connue du compost en France : de la chasse à l’engrais à la chasse au déchet

Dans les poubelles jaunes : moins de papiers mais plus d’erreurs

Du côté des déchets de la poubelle jaune, vouée aux emballages et au papier, la tendance est inverse. Leur poids, qui s’élève aujourd’hui à 52,8 kg par an et par habitant, a légèrement augmenté. Ils représentaient 49,4 kg en 2017, contre 45,8 en 2007. Cette hausse de 15 % en plus de quinze ans est logique, le tri étant depuis entré dans les mœurs et ses consignes ayant été élargies. Ce chiffre est une bonne nouvelle : les Français trient davantage.

Toutefois, on observe en même temps une augmentation des erreurs de tri, avec une part de déchets non conformes en progression depuis 2017. Ainsi, en 2024, ces erreurs concernent 19 % des déchets qui se retrouvent dans les bacs jaunes, contre 12,4 % en 2017. Dans la grande majorité, elles concernent des déchets résiduels qui devraient être dans la poubelle grise.

On y observe par ailleurs une forte diminution des papiers entre 2017 et 2024, probablement liée à la numérisation des usages, et au contraire une hausse des cartons – sans doute causée par la progression des livraisons du fait du commerce en ligne – et des emballages plastiques. Cela se rattache à l’extension des consignes de tri en 2023 à l’ensemble des emballages plastiques, qui semble produire des effets.

Une appropriation progressive du tri des biodéchets

Depuis la généralisation du tri à la source des biodéchets au 1er janvier 2024, les collectivités territoriales se sont massivement mobilisées. Aujourd’hui, la quasi-totalité d’entre elles propose une solution de proximité (compostage individuel ou partagé) tandis qu’environ 30 % ont également déployé un service de collecte spécifique.

En moyenne, 13 % des déchets déposés dans les bacs de biodéchets sont des erreurs de tri. Le contenu de ces bacs se compose majoritairement de biodéchets alimentaires (69 %), dont 12,5 % relèvent encore du gaspillage alimentaire, et de déchets verts (5,5 %).

Le bilan est donc plutôt positif. Des disparités territoriales subsistent toutefois, notamment entre les collectivités ayant installé une collecte séparée et celles qui privilégient uniquement des solutions de compostage de proximité. Les études annuelles permettront de voir à quelle vitesse la pratique se généralise, à la fois par la mise en place de solutions par les communes et l’appropriation par les citoyens.

Un dernier aspect pointé par l’étude concerne les déchetteries, où la composition des bennes de tout-venant présente une grande diversité, avec 75 % de déchets qui devraient être traités en amont par une filière responsabilité élargie du producteur, dite filière REP, particulière – notamment pour les produits de matériaux de construction du bâtiment, qui occupent un quart des bennes. Cela témoigne d’une forte marge de manœuvre existante sur la structuration des filières REP, et sans doute d’une amélioration de l’information vis-à-vis des usagers.

De manière générale, l’étude menée ici se concentre sur une caractérisation des déchets ménagers et apporte des résultats encourageants sur l’impact des politiques publiques. Elle mériterait toutefois d’être complétée par une approche comportementale auprès des ménages afin de mieux comprendre les freins et les obstacles qui expliquent, notamment, que 69 % du contenu des poubelles grises n’y ait pas sa place.

Romuald Caumont ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

23.02.2026 à 17:14

« Nudges », sciences comportementales… Faut-il en finir avec les incitations à mieux gérer nos déchets ?

Service Environnement, The Conversation France

Texte intégral (697 mots)

Pour réduire la quantité de déchets, les politiques publiques misent de plus en plus sur les sciences comportementales, par exemple les « nudges ». Au risque d’invisibiliser les déterminants matériels, sociaux et politiques de la production des déchets.

Depuis une dizaine d’années, les collectivités territoriales, les agences nationales et une partie du secteur privé se sont engouffrés dans l’application des sciences comportementales à la réduction des déchets. L’idée ? Si les individus trient mal, les jettent au mauvais endroit ou en produisent trop, c’est qu’ils manquent d’information et de motivation. Il suffirait de mener des campagnes bien ciblées pour les rendre plus vertueux.

Ce récit est séduisant, car il permet d’agir vite, à moindre coût et sans remettre en cause les logiques structurelles qui génèrent les déchets. Il est pourtant réducteur, dans la mesure où il méconnaît les rapports sociaux et les inégalités. Il ramène la question politique des déchets à l’échelle individuelle : les habitants sont vus comme des acteurs indisciplinés mais rationnalisables à coup de micro-incitations.

Logique de salubrité contre récupération informelle

Sur le terrain, mes observations ethnographiques montrent que ce sujet est davantage structuré par des dispositifs sociotechniques, économiques, et organisationnels que par les intentions individuelles. Dans de nombreux quartiers, le tri est entravé par des infrastructures inadaptées : par exemple, vide-ordures encore en usage qui empêchent toute séparation des flux à la source, bacs trop éloignés ou difficilement d’accès…

Dans les quartiers populaires, des pratiques de circulation d’objets – don, récupération informelle… – se trouvent également placées sous un régime de suspicions et de sanctions. Les acteurs institutionnels chargés de la gestion des déchets valorisent avant tout une logique de salubrité et se concentrent sur l’entretien visuel de la voie publique. Le déchet y est traité comme un rebut dont il faut se débarrasser au plus vite, et non comme une ressource susceptible d’être valorisée.

Les déchets deviennent alors des marqueurs sociaux. Ils servent à requalifier des groupes, à leur attribuer des comportements naturalisés, à désigner des « responsabilités » qui coïncident souvent avec des groupes ethno-sociaux déjà stigmatisés. Les plus précaires sont ainsi les premiers visés par les dispositifs correctifs.

Un cadrage qui élude des problèmes réels

Dans ce contexte, le recours aux sciences comportementales détourne l’attention des problèmes concrets qui structurent la gestion des déchets au quotidien : infrastructures défaillantes ou mal pensées, conditions de travail éprouvantes (par exemple pour les éboueurs ou les gardiens d’immeubles), conflits entre acteurs (par exemple, entre bailleurs, métropole, prestataires…). Au lieu de rendre ces dysfonctionnements visibles, l’analyse se concentre sur le dernier maillon de la chaîne : l’habitant.

Au-delà de l’argument du coût, les institutions plébiscitent cette approche car elle évite de rouvrir le dossier, plus conflictuel, de la réduction à la source (régulation de la production par exemple) ou de la reconfiguration des infrastructures. Elle s’accorde enfin avec une conception néolibérale de l’action publique où chacun est sommé d’être responsable de son empreinte. Or, si les sciences comportementales peuvent livrer des outils ponctuels, elles ne constituent ni une théorie sociale ni une politique publique durable.

Service Environnement ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

21.02.2026 à 16:28

Salon de l’agriculture : les Amap redonnent le pouvoir aux agriculteurs et agricultrices

Pascale Bueno Merino, Directrice de la Recherche, Enseignant-Chercheur en Management Stratégique, Pôle Léonard de Vinci

Hamdi Hamza, Docteur en sciences de gestion, Université Le Havre Normandie

Samuel Grandval, Professeur des Universités en sciences de gestion, Université Le Havre Normandie

Sonia Aissaoui, Maître de Conférences en Sciences de Gestion, Université de Caen Normandie

Texte intégral (1715 mots)

À l’occasion du Salon international de l’agriculture de Paris, une étude met en lumière le double bénéfice des associations pour le maintien d’une agriculture paysanne, dites Amap : renforcer l’autonomie des agriculteurs et permettre aux bénévoles d’être des entrepreneurs… collectivement.

L’importance des échanges citoyens pour mettre en œuvre une agriculture durable est au cœur du programme de conférences du Salon international de l’agriculture. Les interrogations sur le « comment mieux manger ? » ou sur le « comment produire autrement ? » continuent de retenir l’attention.