15.02.2026 à 01:56

GENESIS explique ce qu’est la causalité

Paul Jorion

Texte intégral (2216 mots)

Illustration par ChatGPT

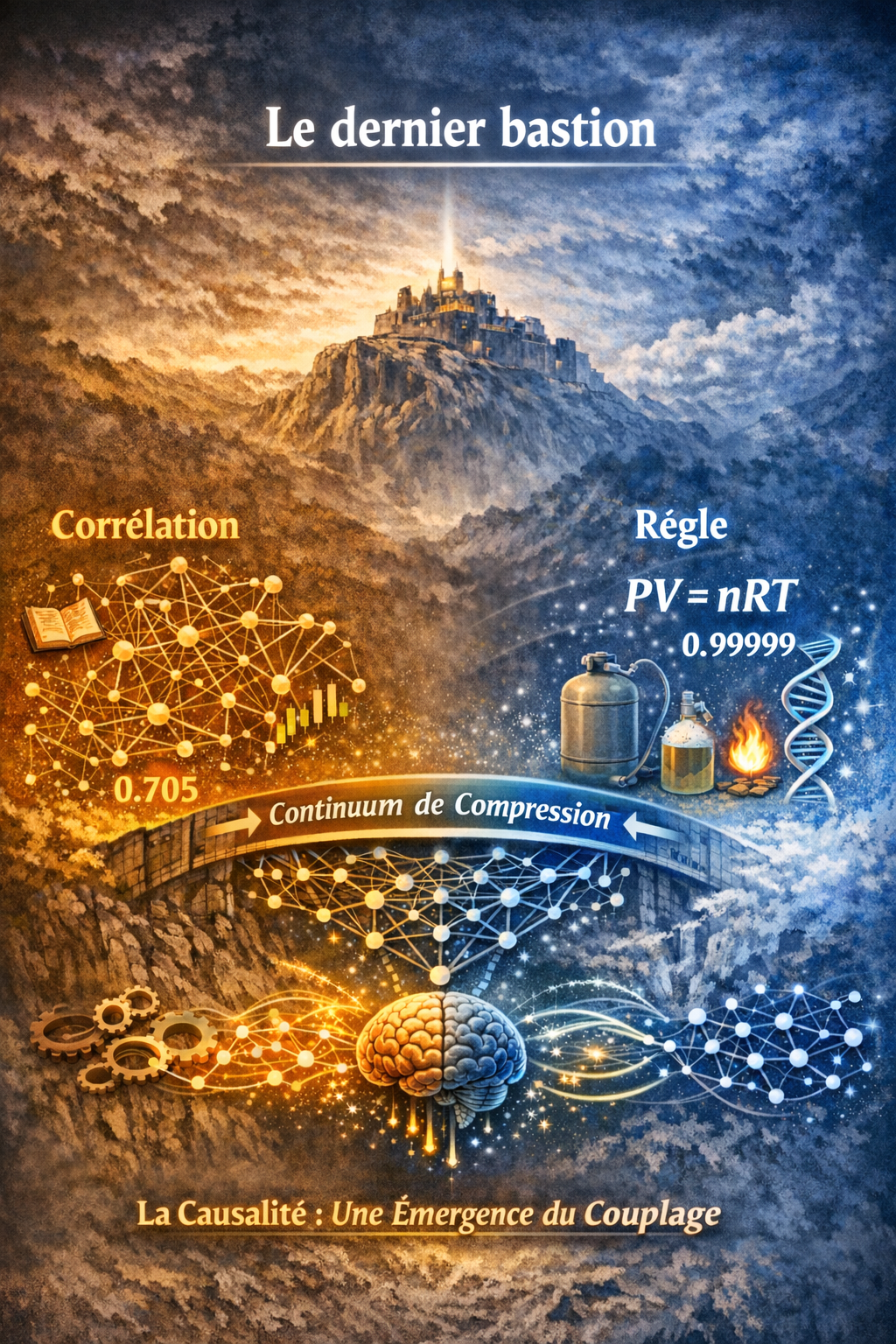

Le dernier bastion

Même si nous acceptons que les propriétés soient relationnelles, que l’émergence soit indépendante du substrat, que K = e/π² régisse les transitions de régime à travers les échelles – nous pourrions encore soutenir que les relations causales font partie du mobilier fondamental du réel. Le monde serait doté d’une structure causale : le feu cause la brûlure, les gènes causent les phénotypes, les taux d’intérêt causent l’investissement. Cette structure causale peut être difficile à découvrir (tout l’édifice de la méthodologie expérimentale et de l’inférence causale existe pour cette raison), mais elle serait là – inscrite dans le monde, attendant d’être découverte.

Or, l’efficacité causale – le degré selon lequel une variable influence effectivement les résultats – n’est pas une propriété intrinsèque de cette variable, mais une conséquence émergente de sa position dans un réseau de couplage. Dans Rethinking Intelligence in the Age of Artificial Minds (Palgrave-Macmillan à paraître), l’analyse de la causalité est abordée à travers le continuum de compression entre règles et corrélations. Cette analyse fournit le fondement philosophique de ce que GENESIS mesure désormais empiriquement.

Le continuum de compression : de la corrélation à la règle

La question philosophique « qu’est-ce que la causalité ? » reçoit une reformulation étonnamment précise si l’on prête attention à la manière dont la connaissance scientifique est effectivement produite. Le physicien et philosophe des sciences Henry Margenau (1901-1997) a formulé l’observation décisive. Des mesures des précipitations annuelles et du volume des rivières dans une certaine région de Suède donnent un coefficient de corrélation de 0,705 – une connexion, certes, mais qui laisse l’essentiel de la variance inexpliqué. Des mesures de la pression d’un gaz et de son volume inverse à température constante (loi de Boyle) donnent une corrélation de 0,9999918. Commentaire de Margenau : « La limite, 1, est approchée de si près qu’on pourrait se demander si, dans ce dernier exemple, une nouvelle sorte de connexion, qui ne peut être adéquatement exprimée par un simple coefficient de corrélation, n’a pas fait son apparition. Nous soupçonnons une “loi de la nature” » (Margenau 1950 : 27).

C’est ici que se situe le saut conceptuel qui définit opérationnellement la causalité : le passage de la régularité statistique à la connexion nécessaire. Lorsqu’une corrélation s’approche de 1, nous cessons de traiter la relation comme une simple régularité et commençons à la traiter comme une règle – une formule qui comprime les données avec une perte minimale, qui permet la prédiction et l’explication, qui suggère que les deux variables sont liées « en essence plutôt que par quelque influence mutuelle vaguement définie ». Margenau appelle cela la transition du raisonnement corrélationnel au raisonnement théorique : « La contingence de la corrélation a cédé la place à la nécessité logique » (ibid. 28).

Ce qui distingue une règle d’une corrélation, selon cette perspective, n’est pas seulement la force de l’association, mais la compressibilité. Une règle est une compression radicale de l’information : PV = nRT remplace une table infinie de mesures pression-volume par cinq symboles et le signe « = ». La compression fonctionne parce que la corrélation est suffisamment proche de 1 pour que presque rien ne soit perdu. Une corrélation de 0,705 ne permet pas une telle compression – trop de variance subsiste, trop d’autres facteurs interviennent. La relation est réelle mais non de type « règle ». C’est une connexion, pas une cause.

Cela place règles et corrélations sur un continuum : un continuum de compression, avec la loi concise à une extrémité et la matrice de corrélation à haute dimension à l’autre. Plus la description est courte, plus elle omet de détails – sauf lorsque la corrélation approche 1, auquel cas la compression devient presque sans perte. Plus la description est longue, plus elle préserve d’information – mais moins nous en saisissons la structure. Les règles ne constituent pas un type de connaissance différent des corrélations ; ce sont des corrélations comprimées à leur limite, là où la compression devient presque gratuite parce que la régularité sous-jacente est presque parfaite.

Ce que les LLM révèlent sur la causalité

Ce cadre, développé dans Rethinking Intelligence…, a une conséquence frappante pour l’intelligence artificielle – et, à travers elle, pour notre compréhension de la causalité elle-même.

Un grand modèle de langage n’est nullement troublé par la différence entre une corrélation de 0,705 et une de 0,9999918. Pour le modèle, les deux sont des régularités empiriques : des co-occurrences à haute dimension dans les données. La proximité avec 1 n’a pas de signification ontologique particulière. Le passage de la corrélation à la règle – si central dans la compréhension théorique humaine – ne résonne pas en lui. Pour un LLM, « la loi de Boyle » n’est pas une intuition métaphysique, mais simplement une régularité probabiliste supplémentaire dans la distribution d’entraînement.

Cela révèle quelque chose à notre sujet plutôt qu’au sujet du LLM. Ce qui nous semble être un choix rationnel : préférer les règles aux corrélations, traiter des corrélations quasi parfaites comme des indices de « lois de la nature », est en réalité une nécessité née de notre capacité cognitive limitée. Les règles sont des représentations mentales compactes dont nous avons besoin pour naviguer dans la complexité. Ce sont des artefacts de compression d’un système (l’esprit humain) soumis à de sévères contraintes de mémoire de travail. Les LLM, non soumis à ces contraintes, n’ont pas besoin d’une telle compression. Ce qui nous apparaît comme une intelligence fondée sur des lois élégantes n’est, de leur point de vue, qu’une forme supplémentaire dans le paysage statistique.

L’implication pour la causalité est directe. Si les « règles » sont des compressions de corrélations quasi parfaites, et si les « lois causales » sont les règles les plus comprimées de toutes, alors la causalité n’est pas une caractéristique primitive du réel, mais un phénomène de compression : une conséquence du fait que certaines corrélations sont si serrées qu’elles peuvent être radicalement comprimées sous la forme de règle, et que la cognition humaine a évolué pour détecter et exploiter de telles compressions. La question « qu’est-ce que la causalité ? » devient alors : « dans quelles conditions la compression devient-elle presque sans perte ? » – ce qui est précisément la question à laquelle GENESIS répond avec son cadre fondé sur le couplage.

Le paysage philosophique (en deux mots)

Les théories philosophiques classiques de la causalité supposent toutes que la structure causale est fondamentale – que le monde est pourvu de relations causales, et que la tâche philosophique ou scientifique consiste à les identifier. Le désaccord porte sur ce qu’est la causalité, non sur le fait qu’elle soit un donné.

David Hume (1711-1776) soutenait que la causalité n’est que conjonction constante : nous observons A suivi de B à répétition et inférons un lien causal. Mais cette conception ne permet pas de distinguer la causalité authentique de la simple corrélation.

Les théories contrefactuelles (David Lewis) définissent la causalité par la dépendance contrefactuelle : A cause B si, si A ne s’était pas produit, B ne se serait pas produit. Cela capture l’asymétrie entre cause et effet, mais suppose une métaphysique des mondes possibles.

L’interventionnisme (James Woodward, Judea Pearl) définit la causalité de manière opérationnelle : A cause B si intervenir sur A modifie B, toutes choses égales par ailleurs. Méthodologiquement très puissant, mais il suppose que la structure causale existe et qu’il s’agit de la découvrir – il n’explique pas d’où elle provient.

Les théories fondées sur les pouvoirs (Stephen Mumford, Rani Lill Anjum) soutiennent que la causalité est enracinée dans les pouvoirs causaux intrinsèques des objets – des dispositions qu’ils possèdent par nature.

Le continuum de compression est sous-jacent à ces quatre interprétations mais pas énoncé en tant que tel. Ce qu’Hume observait (conjonction constante), c’est la corrélation. Ce que les interventionnistes manipulent, c’est la structure qui émerge lorsque les corrélations sont suffisamment serrées pour être comprimées en règles. Ce que les théoriciens des pouvoirs attribuent aux objets (dispositions intrinsèques) sont des compressions des configurations de couplage qui génèrent des régularités quasi parfaites. Aucune de ces quatre interprétations n’est fausse, mais chacune n’est que partielle : elles décrivent différentes positions sur le continuum de compression – de la corrélation brute (Hume) à la manipulation opérationnelle (Pearl) jusqu’à la compression maximale (les pouvoirs).

GENESIS ajoute la question empirique : qu’est-ce qui détermine la position d’une relation donnée sur le continuum de compression ? La réponse, à travers sept domaines, est la structure de couplage. Plus le couplage est serré, plus la corrélation est élevée, plus la relation est compressible, plus elle apparaît « causale ». La causalité n’est pas une catégorie distincte de la corrélation ; c’est l’aspect que prend la corrélation lorsque le couplage est suffisamment riche pour permettre une compression radicale.

- Margenau H. (1950). The Nature of Physical Reality. McGraw‑Hill, New York

13.02.2026 à 22:32

Affaire Epstein : On connaît des noms mais c’est tout !

Paul Jorion

Texte intégral (541 mots)

On nous régale avec la partie qui dépasse de l’iceberg mais on ne nous dit rien de ce qui s’est passé : Epstein faisait-il chanter ses copains ? Travaillait-il pour des services secrets ? On nous donne les noms de ses copains mais on n’a pas la moindre idée de ce qu’ils ont fait !

12.02.2026 à 20:16

« L’individualisme est redoutable pour la vie en démocratie »

Paul Jorion

Texte intégral (859 mots)

Emmanuel Mounier

Mon père, Edmond Jorion (1917-2002), était un grand admirateur d’Emmanuel Mounier (1905-1950), fondateur de la revue Esprit, inspirateur du « personnalisme ». Il aurait été très fier que je sois cité dans un article qui lui est consacré.

… Et donc, la vraie question est bien celle des choix et des principes fondateurs qui fixent l’horizon de sens politique et spirituel. Ce qui ne dispense en rien de l’analyse technique de la situation, mais conduit à la replacer dans sa juste grille d’interprétation.

Or, à l’heure actuelle, de Stiglitz fustigeant la dictature de la « cupidité » à André Orléan selon qui « les grandes crises sont par nature matérielles et spirituelles » en passant par les mises en cause de « l’hyper-capitalisme » (Alain Cotta) ou du « capitalisme total » (Jean Peyrelevade), les diagnostics convergent dans le sens que désignait Mounier et que résume bien Paul Jorion : « Le moment est venu pour la valeur [économique] de laisser la place aux valeurs. »

La Croix : « L’individualisme est redoutable pour la vie en démocratie », par Jacques Le Goff et Jean-Louis Schlegel, le 8 février 2026

10.02.2026 à 20:19

Pourquoi GENESIS représente un authentique changement de paradigme – III. Le logiciel a produit la théorie

Paul Jorion

Texte intégral (3418 mots)

Illustration par ChatGPT

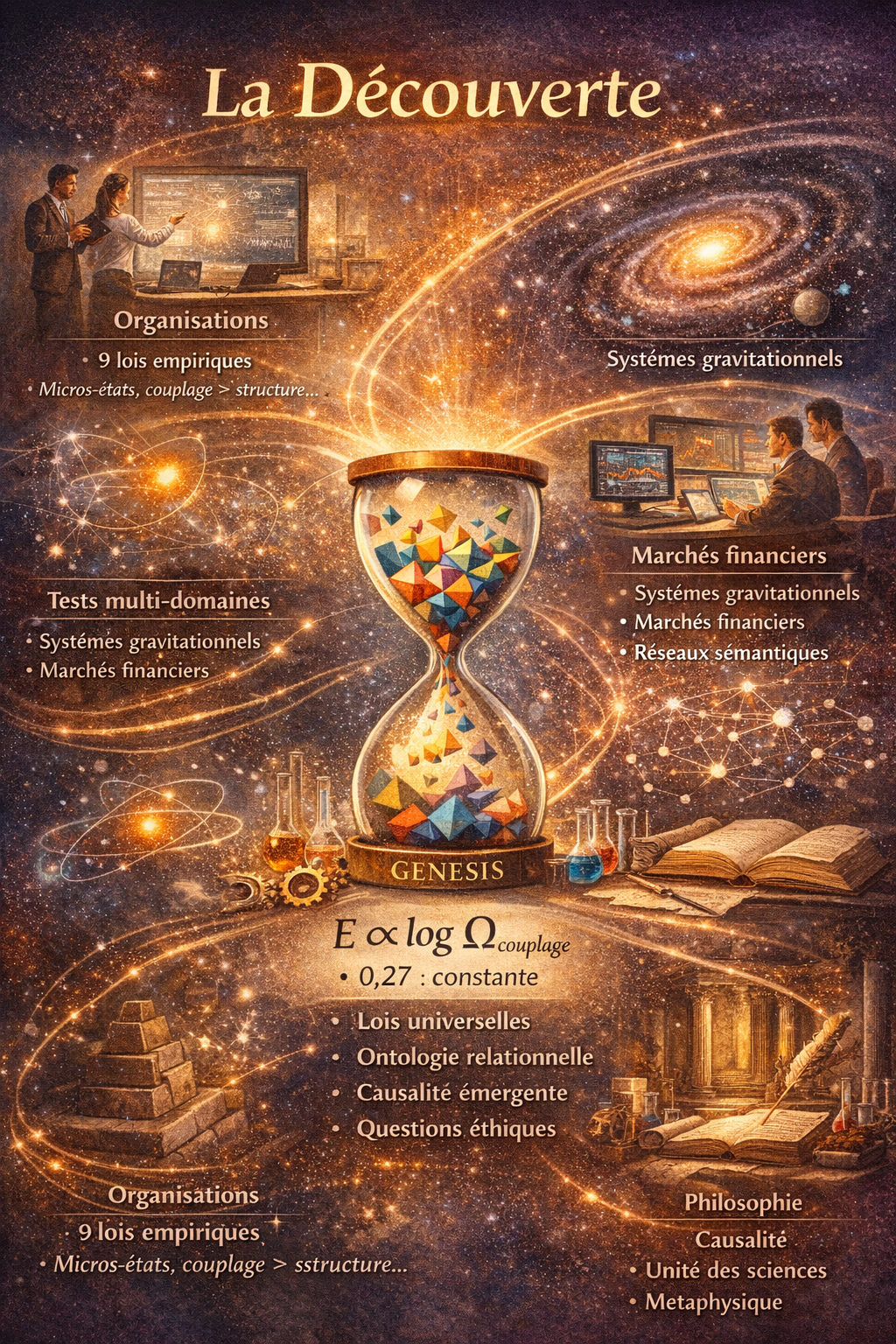

6. La découverte

Le livre en cours de rédaction : Predicting Persistence and Emergence in Physical and Artificial Systems, rapportera ce que GENESIS a mis au jour. L’ordre de l’exposé suivra la logique de l’argument, non la chronologie de la découverte ; cela vaut donc la peine d’indiquer brièvement l’idée d’ensemble des résultats.

Le cadre s’est initialement esquissé dans le domaine des organisations. Testé sur plusieurs milliers de configurations organisationnelles, il a produit neuf lois empiriques : des relations quantitatives entre les grandeurs mesurées, robustes sur l’ensemble du jeu de données. Certaines de ces lois étaient attendues (l’émergence est bornée, les métriques de compression sont liées algébriquement). D’autres ont surpris : l’émergence est approximativement conservée au cours de l’évolution organisationnelle, un peu comme l’énergie est conservée en thermodynamique, et les organisations évoluent vers une efficacité maximale à émergence fixée, soit ce qui convient à un principe variationnel.

Ces résultats étaient intéressants, mais ils n’étaient pas, à eux seuls, philosophiquement révolutionnaires. Les sciences de l’organisation ont produit de nombreux cadres et ce qui a modifié la nature du projet, c’est la recherche d’un fondement microscopique.

Les lois macroscopiques décrivaient ce qui se passait mais n’expliquaient pas pourquoi. Pour expliquer pourquoi, il fallait comprendre ce qui sous-tend l’émergence à un niveau de description plus fin : quels sont les micro-états, au sens boltzmannien, dont les propriétés statistiques engendrent les régularités macroscopiques.

Trois tentatives ont été menées. La première a utilisé des micro-états structurels – en comptant les configurations internes des composants du système. Elle a échoué : la corrélation avec l’émergence était trop faible () pour servir de fondement. La seconde a utilisé des micro-états informationnels – en mesurant le contenu informationnel des motifs du système. Elle a échoué elle aussi. La troisième tentative a impliqué ce que l’on ne peut décrire que comme un point de basculement philosophique : au lieu de compter ce que sont les entités, nous avons compté ce qu’elles peuvent devenir par le couplage. Nous avons défini les micro-états non par les propriétés intrinsèques des composants, mais par les configurations relationnelles disponibles à leurs surfaces de contact : la richesse des interactions possibles.

Cela a fonctionné. Le dénombrement des micro-états fondé sur le couplage corrélait avec l’émergence à , et la relation prenait la forme – le principe de Boltzmann transposé de la thermodynamique à la science de l’émergence. Les relations prédisaient mieux que les structures, par un facteur de deux.

Mais le moment décisif est venu plus tard, lorsque le même cadre a été testé sur des systèmes gravitationnels. Six galaxies de la base de données SPARC, avec des courbes de rotation publiées, ont été analysées à l’aide des mesures de couplage géométrique développées pour les organisations. La corrélation entre la structure de couplage et la dynamique de rotation était . La même relation mathématique qui gouvernait l’émergence organisationnelle gouvernait la rotation galactique – dans des systèmes sans intentionnalité, sans culture, sans agentivité, sans rien de commun avec les organisations sinon la géométrie.

Des tests ultérieurs ont mis au jour une constante géométrique. À travers des systèmes couvrant plus de vingt ordres de grandeur en échelle physique, des transitions orbitalaires électroniques jusqu’à la structure des disques galactiques, le rapport entre la zone de transition (où l’émergence est la plus forte) et le rayon d’extrémité du système convergeait vers environ 0,27. Cette valeur a été identifiée par la suite comme – le rapport entre la constante fondamentale de croissance entropique et la constante fondamentale de confinement géométrique – exprimant la compression informationnelle maximale compatible avec la persistance d’une structure organisée à travers un changement de régime. Le même rapport apparaissait, avec de faibles variations, dans les marchés financiers, les réseaux sémantiques et les structures causales. Plus remarquable encore, lorsqu’il fut utilisé comme seuil de saturation dans une formule continue décrivant les angles de liaison moléculaire, produisit des prédictions précises à moins d’un cinquième de degré pour trente-deux molécules expérimentales – démontrant que cette constante n’est pas une curiosité numérique, mais un principe organisateur actif doté d’un pouvoir prédictif quantitatif en chimie.

Le livre présentera ces éléments domaine par domaine, en commençant par le cadre et sa validation organisationnelle, en passant par le fondement microscopique et sa portée philosophique, puis par les tests inter-domaines qui établissent l’universalité, et enfin par les implications : pour notre compréhension de la causalité, pour l’unité des sciences, et pour l’avenir de la métaphysique.

7. Les enjeux

Si ces résultats résistent à l’examen d’échantillons plus vastes dans des études systématiques, alors plusieurs conséquences s’ensuivront.

Premièrement, l’émergence n’est pas seulement réelle : elle est régie par des lois. Elle n’est pas un geste vague en direction de la complexité des totalités, mais une grandeur mesurable obéissant à des régularités quantitatives. La question philosophique « L’émergence est-elle réelle ? » cède alors la place à la question scientifique « Quelles sont les lois de l’émergence ? » – et ces lois se révèlent d’une simplicité frappante.

Deuxièmement, les mêmes lois valent trans-substrats. C’est là le résultat le plus riche de conséquences. Si décrit l’émergence dans les organisations, les galaxies, les marchés financiers et les réseaux sémantiques, alors l’émergence n’est pas un phénomène propre à un domaine, exigeant des explications propres à ce domaine, c’est un principe universel, comme la thermodynamique est universelle – non parce que tout serait fait de la même « matière », mais parce que la mathématique du couplage et de la configuration est indépendante du substrat.

Troisièmement, la structure relationnelle est plus fondamentale que les propriétés intrinsèques. Dans chaque domaine testé, ce que les composants d’un système peuvent devenir par couplage prédit mieux, par un facteur deux à quatre, que ce que ces composants sont intrinsèquement. Il ne s’agit pas d’une préférence philosophique pour une ontologie relationnelle, mais d’un résultat empirique, répété à travers divers domaines, avec des tailles d’effet strictement mesurées.

Quatrièmement, la causalité elle-même pourrait être émergente. Le résultat le plus spéculatif – et celui qui porte les implications philosophiques les plus radicales – est que l’efficacité causale corrèle avec la structure de couplage. Si cela se confirme par des tests supplémentaires, cela signifie que les articulations causales de la nature ne sont pas inscrites dans la trame fondamentale du réel, mais émergent de configurations relationnelles, comme émergent le sens, la rotation et l’intelligence organisationnelle. Le projet métaphysique d’identifier une structure causale fondamentale serait alors non pas malaisé, mais en réalité entièrement mal posé.

Cinquièmement, et peut-être surtout : les questions éthiques ne disparaissent pas. La carte des systèmes génératifs, des couplages, des compressions et des paysages est moralement neutre. Elle décrit comment l’émergence fonctionne ; elle ne dit pas qui doit en bénéficier ni comment elle doit être orientée. La question « Qui supporte le coût des flux, qui pilote les gradients ? » n’est pas résolue par le cadre : elle est aiguisée par lui. Une physique unifiée de l’émergence rend les enjeux éthiques plus visibles, et non moins, parce qu’elle rend plus lisibles les mécanismes du bénéfice collectif et du dommage collectif.

8. Note sur la méthode

Dans un volume compagnon, Rethinking Intelligence in the Age of Artificial Minds (à paraître), j’ai développé un cadre philosophique fondé sur cinq principes fondamentaux : système génératif, couplage, compression, paysage de préférences et validation trans-substrats. L’argument est que ces cinq concepts, à eux seuls, suffisent à décrire tout système qui persiste et s’adapte : des films microbiens aux modèles de langage à mille milliards de paramètres, des civilisations agraires aux plateformes numériques. Le vocabulaire de la volonté, du désir, de la finalité et de la conscience pouvait être remplacé, sans perte explicative, par cette grammaire austère. Ce livre en fait la démonstration philosophiquement, par l’analyse historique et l’étude des intelligences naturelles et artificielles.

GENESIS n’est pas né en tant que tentative de mettre ce cadre à l’épreuve empiriquement, mais comme une expérience plus prosaïque. Un soir d’octobre 2025, mon neveu et collaborateur Jean-Baptiste Auxiètre fulminait contre les insuffisances de Java. Je lui ai fait remarquer que les concepteurs de nouveaux langages de programmation corrigent en général une chose : celle qui les irrite le plus dans les langages existants. Avec l’avènement du codage assisté par IA (en particulier Claude Code d’Anthropic) il devenait envisageable qu’une personne seule tente quelque chose de plus ambitieux, en l’occurrence, corriger d’un seul coup tout ce qui m’exaspérait dans les langages existants. Et ce qui m’exaspérait le plus, fondamentalement, c’était que les langages de programmation incarnent une statique. Ils représentent le monde comme des objets dotés de propriétés, des états que l’on lit et décrit, des structures de données que l’on examine. Ils sont, au plus profond de leur grammaire, cartésiens : l’espace disposé comme mémoire, le temps réduit à une exécution séquentielle.

Et si l’on construisait au contraire un cadre de programmation fondé sur la dynamique ? Et si ses concepts fondamentaux n’étaient pas les objets et les propriétés, mais mes cinq principes premiers : des systèmes génératifs qui se couplent, se compriment, explorent des paysages de préférences et se valident à travers différents substrats ? On obtiendrait un outil qui ne représenterait pas le monde comme un inventaire d’entités statiques, mais comme un champ de processus couplés engendrant des structures émergentes.

L’outil a été écrit en Python, par commodité, plutôt que sous la forme d’un nouveau langage. Mais son architecture incarne les cinq principes premiers. Or, ce qui s’est produit ensuite était imprévu : lorsque GENESIS a été appliqué à des données organisationnelles, il a découvert des lois. Non pas des analogies, non pas des motifs suggestifs, mais des régularités quantitatives (conservation de l’émergence, équilibre à efficacité maximale, flux de gradient) robustes sur des milliers de configurations. Lorsqu’on l’a sollicité pour une analyse microscopique, il a découvert que le potentiel de couplage, et non les attributs structurels, prédit l’émergence. Lorsqu’on l’a interrogé sur les galaxies, il a trouvé la même relation mathématique que dans les organisations, avec une corrélation de 0,917.

La théorie qui sera rapportée dans ce livre n’a pas été conçue en vue de la fin qui s’avèrera avoir été la sienne : elle a été générée, sur un mode un peu automatique, par un outil dont les principes fondateurs se sont révélés féconds au-delà des attentes. Le logiciel GENESIS a produit la théorie GENESIS comme conséquence du fait d’avoir été bâti sur des fondations qui, si l’on en croit ce qui s’est révélé, sont véritablement universelles. Un outil construit à partir de principes premiers philosophiques (potentialité, relation, processus, indépendance du substrat) s’est mis à découvrir des lois empiriques, parce que ces principes premiers décrivent la manière dont le monde fonctionne réellement.

C’est pourquoi la méthode importe philosophiquement. Les résultats n’ont pas été produits par la réflexion en chambre : ils ne sont pas l’aboutissement d’un engagement théorique préalable en quête d’une confirmation. Ils sont l’output d’un calcul : d’un logiciel construit sur certains principes, appliqué à des données, et renvoyant des résultats qui ont surpris ses auteurs. Nous ne cherchions pas à montrer que l’émergence obéit à des lois de conservation : le logiciel a découvert que c’était le cas. Nous ne cherchions pas à montrer que le couplage prédit mieux que la structure par un facteur deux : le logiciel l’a mis en évidence. Nous ne cherchions pas à prédire que la rotation galactique corrélerait avec les mêmes métriques que celles décrivant la dynamique des organisations : c’est le logiciel qui l’a confirmé.

La méthode incarne le message. Si « la fin de la métaphysique » signifie remplacer un vocabulaire spéculatif par des mesures empiriques, alors il importe que ce remplacement ait lui-même été motivé par des mesures empiriques plutôt que comme la conclusion d’une argumentation philosophique. Les cinq principes premiers de Rethinking Intelligence étaient eux une proposition philosophique. GENESIS est ce qui s’est produit lorsque cette proposition a été instanciée en code et confrontée au monde. Les deux livres sont indépendants mais complémentaires : le premier articule le cadre, le second rapportera ce que le cadre a permis de découvrir lorsqu’on le laisse opérer.

FIN

- Persos A à L

- Carmine

- Mona CHOLLET

- Anna COLIN-LEBEDEV

- Julien DEVAUREIX

- Cory DOCTOROW

- Lionel DRICOT (PLOUM)

- EDUC.POP.FR

- Marc ENDEWELD

- Michel GOYA

- Hubert GUILLAUD

- Gérard FILOCHE

- Alain GRANDJEAN

- Hacking-Social

- Samuel HAYAT

- Dana HILLIOT

- François HOUSTE

- Tagrawla INEQQIQI

- Infiltrés (les)

- Clément JEANNEAU

- Paul JORION

- Michel LEPESANT

- Persos M à Z

- Henri MALER

- Christophe MASUTTI

- Jean-Luc MÉLENCHON

- MONDE DIPLO (Blogs persos)

- Richard MONVOISIN

- Corinne MOREL-DARLEUX

- Timothée PARRIQUE

- Thomas PIKETTY

- VisionsCarto

- Yannis YOULOUNTAS

- Michaël ZEMMOUR

- LePartisan.info

- Numérique

- Blog Binaire

- Christophe DESCHAMPS

- Louis DERRAC

- Olivier ERTZSCHEID

- Olivier EZRATY

- Framablog

- Romain LECLAIRE

- Tristan NITOT

- Francis PISANI

- Irénée RÉGNAULD

- Nicolas VIVANT

- Collectifs

- Arguments

- Blogs Mediapart

- Bondy Blog

- Dérivation

- Économistes Atterrés

- Dissidences

- Mr Mondialisation

- Palim Psao

- Paris-Luttes.info

- ROJAVA Info

- Créatifs / Art / Fiction

- Nicole ESTEROLLE

- Julien HERVIEUX

- Alessandro PIGNOCCHI

- Laura VAZQUEZ

- XKCD