18.02.2026 à 11:10

Tipping points, lois de puissance et économie climatique

Alain Grandjean

Comme on l’a vu dans un post précédent portant notamment sur la loi de Pareto, dans de nombreux systèmes — réseaux, marchés financiers, concentration de richesse, catastrophes naturelles — la distribution des données ou des événements n’obéit pas une loi statistique ”normale”. La probabilité de valeurs extrêmes diminue beaucoup plus lentement que dans une telle […]

The post Tipping points, lois de puissance et économie climatique appeared first on Chroniques de l'Anthropocène.

Texte intégral (11739 mots)

Comme on l’a vu dans un post précédent portant notamment sur la loi de Pareto, dans de nombreux systèmes — réseaux, marchés financiers, concentration de richesse, catastrophes naturelles — la distribution des données ou des événements n’obéit pas une loi statistique ”normale”. La probabilité de valeurs extrêmes diminue beaucoup plus lentement que dans une telle loi. C’est le cas des extrêmes climatiques1 qui peuvent provoquer des dommages globaux irréversibles, menaçant des infrastructures, des écosystèmes, voire la survie humaine.

Nous allons voir que ces constatations remettent fondamentalement en cause l’approche généralement employée par les économistes pour tenter d’évaluer l’effort à faire pour limiter le dérèglement climatique. Elles conduisent à une approche renouvelée, fondée sur la notion de robustesse.

Ce post a été inspiré par des échanges avec Nathanaël Wallenhorst et la lecture de son livre 2049, avec Jean-Pierre Gonguet et François Lévêque, que je remercie chaleureusement. Leur responsabilité n’est en rien engagée dans les phrases qui suivent.

1. Comment comparer le coût économique de l’inaction et celui de l’action climatique ?

Les économistes, depuis les travaux précurseurs du “prix Nobel” William Nordhaus, essaient d’apprécier le coût de l’inaction (c’est-à-dire celui des dommages climatiques engendrés par les gaz à effet de serre, dans un scénario de prolongation des tendances, dit Business As Usual) et celui de l’action (le coût macroéconomique des mesures à prendre). Cette approche dite “analyse coûts-bénéfices (ou ACB)”2 leur permet d’en déduire un “optimum” (n’agir ni trop ni trop peu) qu’ils caractérisent en général par un “coût social du carbone”, que nous définirons plus loin.

Cette approche est marquée du sceau apparent du bon sens. On ne peut pas du jour au lendemain arrêter toutes les activités humaines (qui sont toutes génératrices de gaz à effet de serre) ni les remplacer par des activités neutres ou faiblement émettrices en carbone. Nous devons faire des choix collectifs de mitigation raisonnée en choisissant les actions les plus efficaces à moindre coût.

Ceci étant dit, les difficultés de l’exercice sont immenses. Nous n’en citerons que quelques-unes (voir la fiche The Other Economy sur les liens entre réchauffement climatique et croissance du PIB, plus exhaustive sur ces méthodes). Comment évaluer des dommages complexes et interdépendants à un horizon lointains ?

Nous reviendrons ici sur cette première question. Notons à ce stade que les économistes utilisent des fonctions de dommage3 qui relient la température moyenne planétaire au PIB ou au capital économique. Comment comparer les unités économiques de demain et celles d’aujourd’hui ? La méthode habituellement retenue consistant à retenir un taux d’actualisation pose de nombreux problèmes et repose en fait sur des choix éthiques et politiques. Comment répartir équitablement les efforts entre pays en intégrant un principe de responsabilités différenciées ? Comment répartir les efforts de mitigation dans la durée, sachant que certaines technologies progressent et qu’il peut être utile d’attendre qu’elles soient compétitives et qu’il existe par ailleurs des risques de verrouillage dans des technologies carbonées ? Peut-on représenter l’économie dans son ensemble par un “agent représentatif”4 ?

L’analyse coûts-bénéfices a des limites, qui semblent largement dépassées pour apporter une solution rationnelle à la question posée.

Mais nous allons ici oublier provisoirement la majorité de ces difficultés pour nous concentrer sur un problème de principe qui nous semble essentiel (évoqué dans la fiche citée plus haut), lié au caractère non-linéaire des impacts du climat, en particulier du fait de l’existence de ”points de bascule” et du risque de catastrophe majeure. Nous allons voir que ce constat, mis en évidence par l’économiste Martin Weitzman dès 20095, conduit à adopter des approches entièrement nouvelles, qu’on peut qualifier de robustes, par opposition aux approches d’optimisation qui caractérisent l’ ACB.

2. Non-linéarités climatiques et points de bascule

Le système climatique n’est pas un système linéaire répondant proportionnellement aux forçages6 externes. Il s’agit d’un système dynamique complexe, composé de sous-systèmes couplés (océan, atmosphère, cryosphère, biosphère) présentant des rétroactions positives, des seuils critiques et des transitions abruptes. Cette architecture implique que de petites variations continues des paramètres de contrôle — concentration de CO₂, flux d’eau douce, albédo — peuvent provoquer des changements qualitatifs majeurs de l’état du système.

Ces phénomènes sont aujourd’hui regroupés sous le terme de points de bascule climatiques (climate tipping points7). Un point de bascule n’est pas un choc qui bouleverse le système,

c’est un moment où le système perd sa capacité à revenir à son état habituel. Il est en général défini comme un seuil qui, lorsqu’il est franchi, entraîne de grands changements, souvent irréversibles à l’échelle humaine, qui modifient qualitativement l’état ou l’évolution du système Terre. Pour mieux comprendre ce dont il est question, on peut se représenter un sous-système climatique, une calotte glaciaire ou une circulation océanique, comme une bille évoluant sur un “paysage de stabilité”. Tant que le climat reste dans une “vallée” de ce paysage, une perturbation (année chaude, sécheresse, apport d’eau douce) déplace le système mais il revient vers son état antérieur : c’est un état stable ; au sommet d’une crête, la moindre perturbation l’en fait basculer durablement : c’est un état instable.

Parmi les exemples les plus étudiés – dont les probabilités à ce stade sont cependant différentes – on peut citer entre autres8 :

- l’effondrement de la convection des mers du Labrador et d’Irminger

- la disparition de la circulation méridienne de retournement de l’Atlantique (AMOC),

- la stabilité des calottes glaciaires du Groenland et de l’Antarctique occidental,

- la fonte de la banquise arctique et les rétroactions d’albédo,

- le dépérissement des forêts tropicales et boréales,

- le dégel du pergélisol et la libération consécutive de gaz à effet de serre.

- etc…

Des travaux récents montrent que plusieurs de ces éléments pourraient être plus proches de leur seuil critique qu’on ne le pensait auparavant, et que des interactions entre points de bascule peuvent produire des effets en cascade, amplifiant le risque systémique.9

Sur le plan mathématique, ces phénomènes relèvent de la théorie des systèmes dynamiques non linéaires, et plus précisément de la théorie des bifurcations.10 Une bifurcation correspond à une modification qualitative du comportement d’un système lorsque l’un de ses paramètres varie : disparition ou apparition d’états stables, changement de régime, hystérésis.

| Points de bascule climatiques : l’exemple de la bifurcation selle–nœud Les points de bascule climatiques peuvent être formalisés mathématiquement, grâce à la théorie des bifurcations. Parmi les différents types de bifurcations possibles11, la bifurcation selle–nœud constitue le schéma mathématique le plus simple pour représenter un basculement irréversible du système climatique. C’est pourquoi elle occupe une place centrale dans la littérature sur les tipping points et nous allons la présenter ici à titre pédagogique, pour en tirer une leçon économique. La bifurcation selle–nœud s’écrit mathématiquement ainsi : Où x est une variable d’état du système (par exemple l’intensité d’une circulation océanique, l’étendue d’une calotte glaciaire ou un indicateur agrégé de stabilité climatique) et μ un paramètre de contrôle lentement variable (forçage radiatif, température moyenne globale, apport d’eau douce, etc.). Le système se comporte différemment selon le signe de μ. – Si μ>0 , le système possède deux points fixes : * Un état stable (nœud) : si la variable d’état x atteint ce point de petites perturbations ne lui font pas quitter cet état. * Un état instable (selle) : où de petites perturbations suffisent à lui faire quitter cette position – Lorsque μ=0 les deux points fixes fusionnent : le système devient structurellement instable. – Si μ<0 il n’existe plus aucun état d’équilibre : l’état stable a disparu. Dans un processus conduisant à une bifurcation selle–nœud, le paramètre μ diminue. La “vallée” correspondant à l’état climatique stable et la “crête” instable voisine se rapprochent à mesure que le réchauffement progresse, jusqu’à disparaître ensemble. Au-delà de ce point de bascule, l’état climatique antérieur n’existe plus : même si le forçage cesse d’augmenter, le système évolue irréversiblement vers un nouveau régime. Applications climatiques : points de non-retour et irréversibilité La bifurcation selle–nœud est le schéma standard utilisé pour modéliser des points de bascule irréversibles dans le système climatique, notamment l’effondrement de la circulation méridienne de retournement de l’Atlantique (AMOC) et la perte irréversible de grandes calottes glaciaires. Dans ces cas, le système ne devient pas progressivement plus instable : il cesse soudainement d’avoir un état stable. Cette propriété est cruciale pour l’analyse économique du risque climatique car elle invalide toute extrapolation marginale des dommages. |

Un élément essentiel mis en évidence par la littérature récente est que ces transitions peuvent être déclenchées non seulement par le franchissement lent d’un seuil (bifurcation-induced tipping), mais aussi par du bruit (au sens statistique) « noise-induced tipping” ou par la vitesse du changement des paramètres (rate-induced tipping), ce qui complique encore l’anticipation et la gestion du risque.12

Ces propriétés suffisent à invalider l’idée selon laquelle les impacts climatiques seraient bien approximés par des fonctions de dommages lisses et convexes, généralement utilisées dans les modèles. Elles supposent en effet une relation continue et croissante des dommages économiques avec l’aggravation du changement climatique, sans sauts ni transitions abruptes, ce qui est contraire aux remarques faites ici.

3. Des non-linéarités aux distributions à queues épaisses

Les non-linéarités dynamiques du système climatique ont une conséquence directe sur la structure statistique des événements extrêmes. En effet, à mesure qu’un sous-système climatique approche d’un seuil critique — par exemple l’affaiblissement de la circulation méridienne de retournement de l’Atlantique (AMOC), la déstabilisation d’une calotte glaciaire ou la perte saisonnière de la banquise arctique — sa résilience diminue. Les mécanismes de rétroaction positive (glace-albédo, stratification océanique, rétroactions hydrologiques ou biosphériques) amplifient alors les perturbations. Il en résulte une augmentation de la variance13, un ralentissement du retour à l’équilibre et un allongement des corrélations temporelles (critical slowing down14). Les fluctuations ne sont plus symétriques autour d’un état moyen, mais deviennent de plus en plus biaisées vers des “excursions” extrêmes.

Statistiquement, cette dynamique se traduit par des distributions fortement asymétriques, dont les queues décroissent lentement : les événements rares mais très intenses — vagues de chaleur exceptionnelles, précipitations extrêmes, sécheresses prolongées ou ruptures abruptes de régimes climatiques — acquièrent une probabilité disproportionnée par rapport à une distribution gaussienne. Ces extrêmes sont alors bien décrits par des distributions de valeurs extrêmes généralisées (GEV en anglais)15 à paramètre de forme positif, ou par des lois à queue épaisse de type puissance.

De nombreuses études empiriques récentes confirment que les distributions des événements climatiques extrêmes — vagues de chaleur, précipitations intenses, crues, sécheresses — présentent des queues lourdes, souvent bien décrites par des lois de Pareto ou des GEV. Par exemple, des analyses hydrologiques récentes montrent que les pics de crue suivent des distributions à longue traîne, impliquant une probabilité non négligeable d’événements très au-delà des niveaux historiquement observés.16 Des résultats similaires ont été obtenus pour les extrêmes de précipitations à haute résolution, où des analyses de maxima horaires issus d’un grand ensemble de modèles climatiques régionaux montrent que la fréquence et l’intensité des pluies extrêmes courtes durées augmentent de manière significative avec le réchauffement, suggérant des distributions à queue lourde pour ces événements rares.17

Ces distributions ne sont pas de simples artefacts statistiques : elles reflètent la structure physique sous-jacente du système, marquée par l’hétérogénéité spatiale, les rétroactions positives et la multiplicité des régimes dynamiques. Dans un tel contexte, la probabilité d’événements extrêmes décroît lentement selon une loi de puissance.

Ces constats ont des implications majeures. Il signifie que certaines trajectoires de réchauffement ou de perturbation climatique, même faiblement probables, peuvent entraîner des dommages globaux irréversibles, affectant les infrastructures, les écosystèmes, la stabilité économique et, dans les cas extrêmes, l’habitabilité de la planète. Dans un tel cadre, raisonner en termes d’impact moyen ou de dommage marginal devient trompeur. Ainsi, les queues épaisses ne sont pas un détail statistique secondaire, mais l’expression probabiliste des non-linéarités physiques du système climatique.

4. Le coût social du carbone

L’analyse coûts-bénéfices que nous avons évoquée en introduction se résume, dans la recherche économique classique sur le climat, par le concept central de coût social du carbone (CSC, en anglais SCC, Social Cost of Carbon). Il s’agit du coût économique actualisé (voir la fiche actualisation de The Other Economy) généré par l’émission d’une tonne supplémentaire de CO₂, intégrant l’ensemble des impacts du climat sur l’économie. La ”consigne” économique qui en découle c’est qu’il est souhaitable de réduire les émissions de CO2 aujourd’hui tant que le coût de cette réduction est inférieur au CSC et que cela ne l’est plus quand il supérieur. Calculé à partir de modèles intégrés climat-économie, le CSC est supposé guider la politique publique : il sert de base à la fixation de taxes carbone ou de quotas d’émissions, en traduisant les “externalités climatiques” en signaux monétaires exploitables par le marché. De nombreuses évaluations de ce CSC ont été faites dans les dernière décennies.18 Elles varient de deux ordres de grandeur (de quelques dizaines de dollars par tonne de CO2 à plus de 1000 dollars), ce qui montre bien le niveau d’incertitude théorique et pratique autour de ces questions.

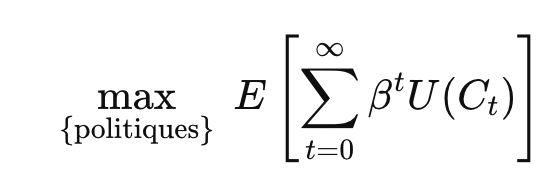

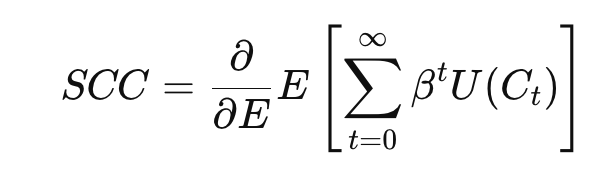

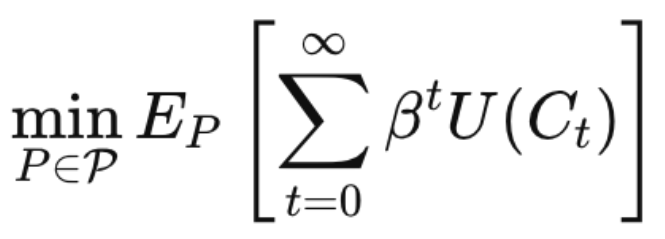

Formellement, dans ces modèles, on cherche à maximiser l’utilité espérée inter temporelle de la consommation mondiale :

où Ct est la consommation globale à l’année t, β le facteur d’actualisation, et U la fonction d’utilité. et E l’espérance mathématique, étant entendu qu’il s’agit d’un calcul statistique. Le CSC correspond alors à la dérivée marginale de cette utilité par rapport aux émissions : de combien la consommation future sera affectée demain quand on évite une tonne de CO₂ aujourd’hui.

Cependant, comme l’a souligné très tôt19, l’économiste Martin Weitzman20, ce calcul repose sur des hypothèses cruciales : les dommages climatiques doivent être bornés, et les probabilités d’événements extrêmes doivent décroître rapidement. Si ces conditions ne sont pas respectées et que certains événements sont irréversibles — le CSC devient infini. En d’autres termes, l’approche classique n’est pas conçue pour traiter correctement les risques catastrophiques, et la logique marginale de prix échoue lorsque l’enjeu est la survie ou la catastrophe globale.

Martin Weitzman a d’ailleurs forgé un théorème21 qu’il a qualifié lui-même de lugubre car sans solution pratique à ses yeux. Son théorème démontre l’impossibilité devant l’incertitude des queues épaisses de recourir au calcul standard de l’espérance mathématique des pertes. Or nous venons de voir précédemment que, les événements extrêmes climatiques n’étaient non seulement pas à exclure mais que leur probabilité ne décroissait pas rapidement.

5 Le “backstop miracle” : techno-optimisme et illusions de filet de sécurité

Pour répondre à cette critique fondamentale, les économistes modélisant les effets du dérèglement climatique sur l’économie ont recours dans leurs modèles à un « backstop » explicite ou implicite, technologique ou non (voir encadré ci-dessous).

Il s’agit de dispositifs futurs, quasi inépuisables et accessibles au plan économique qui seraient capables de résoudre le problème climatique même si la transition actuelle tarde ou déraille. Dans les modèles intégrés classiques la hausse des coûts marginaux de réduction des émissions éventuelles est ainsi toujours limitée.

| La nécessité de backstop dans les systèmes complexes et en économie du climat Un backstop22 est un mécanisme de dernier recours qui ne fonctionne qu’en cas de crise et assure la stabilité d’un système lorsque ses règles ordinaires échouent. Dans les systèmes techniques (réseaux électriques, réacteurs nucléaires, structures mécaniques), financiers ou informatiques, il se traduit par des réserves, redondances ou marges de sécurité qui empêchent des défaillances locales de se propager en effondrement systémique. La leçon est générale : tout système complexe reposant sur la coordination et la confiance est fragile sans backstop, et un système optimisé sans marge de sécurité devient cassant. En économie du climat, la notion de backstop prend un sens similaire. Certains modèles tiennent compte (voir partie 7) du recours éventuel à un backstop technologique, un substitut énergétique zéro-carbone, disponible en quantité illimitée à un coût exogène élevé mais décroissant dans le temps. Cette hypothèse borne les coûts d’abattement suffisamment pour éviter la divergence du CSC. D’autres, comme on le verra, procèdent d‘une manière plus sophistiquée, qui conduit au même résultat. On comprend vite que ces approches reposent plus sur des hypothèses ad hoc que sur des certitudes avérées ; or ce qui est en jeu est existentiel : c’est l’habitabilité de la planète. On verra en partie 8 que de nouvelles approches sont à considérer pour tenir compte de manière plus solide du théorème sinistre de Weitzman. |

Le modèle DICE – le plus important, à la fois comme référence historique et parce qu’il est toujours utilisé, par Nordhaus et d’autres économistes, dans diverses versions – fait appel à un backstop technologique. Ce “backstop miracle” est séduisant parce qu’il permet de penser que les innovations technologiques – énergie propre, capture du carbone, réseaux intelligents – viendront à bout du problème sans remettre fondamentalement en cause nos modes de production et de consommation. Il repose sur la croyance que l’innovation fera ce que la réglementation ou la transformation sociale seule ne peuvent pas faire. Il va de soi que l’introduction de ce backstop rend inutile la discussion sur les risques majeurs et leur incertitude. Malheureusement il s’agit d’une grave illusion.

6. Les limites du backstop technologique en pratique

Plusieurs raisons montrent que ce pari est loin d’être assuré :

6.1 Des solutions incertaines et potentiellement insuffisantes

Les technologies souvent citées comme promesses de backstop – comme la capture et séquestration directe du carbone, la géo ingénierie, la fusion nucléaire – sont loin d’être au point, ni au plan technique ni au plan économique, et ne sont pas exemptes d’effets secondaires encore mal connus et difficiles à prévoir. Leur efficacité réelle à l’échelle globale reste plus qu’incertaine. Dans certains cas (comme la capture directe du carbone de l’air, DAC) certaines limites sont physiques et liées aux lois de la thermodynamique. Dans d’autres cas, les limites physiques sont relatives aux matériaux critiques. Aucun backstop ne peut annuler ces contraintes physiques.

6.2 Aucun déploiement à grande échelle d’une solution technologique n’est instantané

A supposer qu’une technologie se dégage, elle supposera de construire des infrastructures – qu’il s’agisse d’énergie nucléaire décarbonée, de réseaux de capture et de stockage du carbone, ou de technologies encore émergentes – ce qui prendra des décennies. Cela contraste avec la rapidité à laquelle les tipping points climatiques peuvent produire des effets irréversibles.

Contrairement à un prêteur en dernier ressort qui peut injecter de la liquidité rapidement, aucune technologie ne se déploie à la vitesse d’un signal monétaire.

6.3 Effet rebond

L’histoire des technologies d’efficacité montre qu’elles peuvent engendrer un effet rebond, où les gains d’efficacité conduisent à plus de consommation plutôt qu’à moins d’émissions nettes, réduisant l’effet attendu de la technologie.

6.4 La dissuasion de la mitigation

Penser que les innovations technologiques viendront à temps peut aussi conduire à reporter les efforts immédiats de réduction des émissions. C’est l’effet “mitigation deterrence” (dissuasion de la mitigation) : la croyance en la possible efficacité d’options technologiques – non prouvées à ce jour- peut conduire à limiter l’ambition. Cela concerne la géo ingénierie, les technologies d’émissions négatives (captage et stockage du CO₂, DAC, BECCS) et même l’adaptation au changement climatique : investir dans l’adaptation (digues, climatisation, agriculture résistante, etc.) pourrait faire oublier la mitigation.

7. Les baskstops dans les modèles IAMS les plus utilisés en ACB

Les ACB appliquées au changement climatique reposent principalement sur un noyau restreint de modèles d’évaluation intégrée (Integrated Assessment Models, IAMs23), qui combinent dynamique économique, trajectoires d’émissions et réponse climatique afin d’estimer le coût social du carbone, y compris dans des scénarios de réchauffement élevé. Les trois modèles de référence dans ce cadre sont DICE, FUND et PAGE, qui apportent des réponses distinctes, explicites ou implicites, aux difficultés soulevées par Weitzman concernant les risques catastrophiques et les queues épaisses, et qui mettent en évidence le lien crucial entre réduction des émissions et limitation des dommages.

Le modèle DICE24, élaboré par William Nordhaus, traite la question de la faisabilité et de la non-divergence en introduisant explicitement une technologie de backstop. Celle-ci représente un substitut énergétique zéro-carbone, disponible en quantité illimitée à un coût exogène élevé mais décroissant dans le temps. Ce backstop n’est pas décrit physiquement mais joue un rôle central. En réduisant suffisamment tôt les émissions, DICE limite la hausse de température et, par conséquent, les dommages climatiques et leur coût. Ainsi, le backstop technologique agit non seulement comme un mécanisme de dernier recours pour les coûts d’atténuation, mais aussi comme un backstop dynamique qui empêche les dommages de devenir excessifs ou infinis, maintenant le CSC dans une plage finie et calculable.

Le modèle FUND, élaboré par Richard Tol adopte une approche plus indirecte. Il ne représente pas explicitement une technologie de dernier recours, mais introduit les coûts d’abattement via des fonctions de coût réduites, calibrées à partir de la littérature technico-économique. Ces fonctions imposent de facto une limite à la hausse du coût marginal d’abattement et, en agissant suffisamment tôt sur les émissions, permettent de prévenir une augmentation excessive de la température et des dommages associés. Le backstop est donc implicite : il résulte des hypothèses fonctionnelles retenues et de la limitation des dommages par la régulation des émissions, plutôt que de la modélisation explicite d’une technologie sans carbone. Ce mécanisme intégré permet d’éviter toute explosion des coûts ou du CSC, tout en conservant une logique ACB standard.

Le modèle PAGE25 développé par Chris Hope se distingue par sa réponse probabiliste aux risques extrêmes. PAGE ne recourt ni à un backstop technologique explicite, ni à un plafond direct des coûts d’abattement. La non-divergence du CSC est assurée par un ensemble d’hypothèses structurelles : des dommages climatiques explicitement bornés (en fraction du PIB), des distributions de probabilité tronquées pour les paramètres climatiques et économiques, des catastrophes modélisées comme des chocs discrets de taille finie, un horizon temporel limité et un taux d’actualisation positif mais faible. Dans ce cadre, limiter les émissions à temps agit comme un backstop dynamique : en réduisant la probabilité et l’ampleur des événements catastrophiques, la politique d’abattement précoce empêche les dommages de diverger et maintient le CSC calculable. PAGE reconnaît ainsi les incertitudes et les queues épaisses, mais les intègre dans un cadre probabiliste qui exclut par construction les pertes infinies.

En résumé, alors que DICE répond à l’argument de Weitzman par une borne technologique explicite, FUND par des bornes implicites sur les coûts et la régulation précoce des émissions, et PAGE par des bornes probabilistes sur les dommages et un mécanisme de limitation dynamique des risques catastrophiques. Les trois modèles conservent une logique ACB standard. Tous sont construits pour que le CSC reste fini. C’est ce qui explique également pourquoi ces modèles n’impliquent pas nécessairement des politiques climatiques “robustes” fondées sur des interdictions ou des contraintes absolues, mais plutôt des instruments graduels de type prix du carbone, même dans des scénarios de réchauffement élevé.

8. Les approches robustes, une option pour sortir de l’impasse

C’est ici qu’interviennent les approches dites robustes. 26

8.1 Approches robustes et analyses coûts-bénéfices

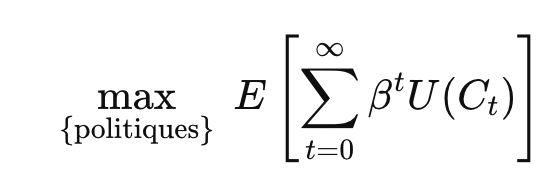

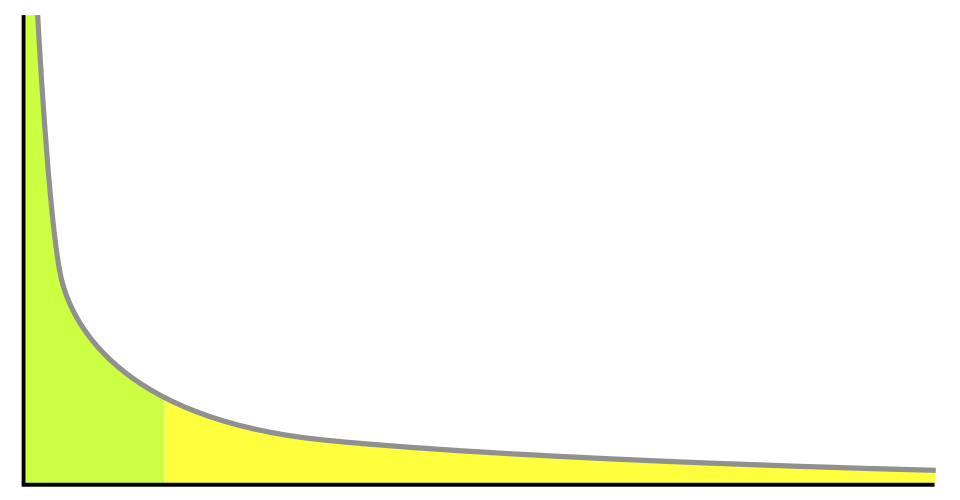

Plutôt que d’optimiser une espérance d’utilité calculée sur un scénario probabilisé, ces méthodes cherchent à protéger le système contre les pires scénarios plausibles. La formulation générale du problème à résoudre peut s’écrire mathématiquement ainsi :

Où P est un ensemble de distributions plausibles et admissibles (non comprises donc celles qui conduisent à un scénario climatique inacceptable). L’objectif est de choisir la meilleure politique P parmi un ensemble P de politiques admissibles. Il s’agit de maximiser au sein de ces politiques, l’espérance de l’utilité minimale de chacun des scénarios.

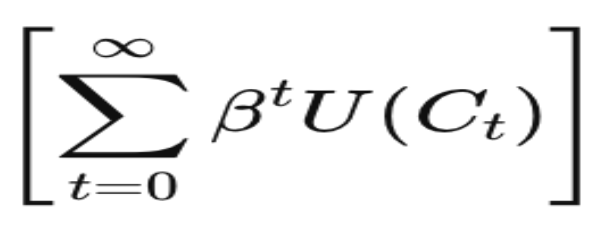

Pour chaque politique P, les conséquences économiques et climatiques futures sont incertaines et représentées par une distribution probabiliste. La somme

représente le bien-être cumulatif actualisé, où U(Ct) est la fonction d’utilité de la consommation à chaque période t et βt le facteur d’actualisation. Ce mécanisme actualise le futur, donnant moins de poids aux périodes lointaines, mais en considérant un horizon infini, on prend en compte l’ensemble des conséquences à long terme.

Le terme

correspond à l’espérance sous cette distribution, et la présence du min traduit que l’on considère le scénario le plus défavorable. Cette structure reflète une logique de prudence maximale, proche de l’argument de Weitzman sur les queues épaisses et les risques climatiques extrêmes.

L’interprétation économique de l’approche robuste est que la politique optimale doit maximiser le bien-être social dans le pire scénario plausible. Elle formalise ainsi un choix de politique fondé sur la prudence face à l’incertitude profonde, en intégrant explicitement les risques extrêmes et le long terme, tout en conservant une logique économique d’allocation des ressources. Cette formulation mathématique du principe de précaution étendue relie directement émissions, dommages et bien-être futur.

Dans ce cadre, souvent qualifié de Robust Decision Making (RDM), le coût social du carbone n’est plus un simple coût marginal : il devient conditionnel au respect d’une zone sûre, excluant les trajectoires conduisant à une ruine globale. À mesure que l’on s’approche d’une frontière catastrophique, le coût marginal croît fortement, ce qui justifie l’introduction de contraintes, de normes, voire d’interdictions ciblées sur certaines activités à forte intensité carbone. Le CSC conserve un rôle d’arbitrage à l’intérieur de cette zone sûre, mais cesse d’être l’instrument central de gestion du risque existentiel.

8.2 Approches robustes “élargies”

Ces approches robustes ne se limitent pas fondamentalement à l’usage “encadré” de l’analyse coûts-bénéfices, tel qu’on vient de le voir. Elles englobent l’approche du type de celle qui a été proposée par une équipe du FMI et que nous avons présentée dans ce blog dans un article intitulé La Nature au cœur du raisonnement économique : l’émergence d’une nouvelle macroéconomie. Il s’agit de sortir de la logique d’optimisation27 et de se préoccuper prioritairement de la capacité de nos systèmes socio-économiques à résister face aux fluctuations à venir.

Conclusion

Les lois de puissance s’appliquent aussi aux catastrophes climatiques. L’économie classique du climat et les modèles utilisés sont inadaptés car ils appliquent des hypothèses de bornes (éventuellement via l’introduction d’un backstop hypothétique) et de lois de probabilités “normales” aux queues fines.

Les approches robustes permettent de combiner prudence (interdictions, normes, planification) pour éviter la catastrophe, et raisonnement économique. Dans un monde à queues épaisses et longues traînes, le rare peut dominer la moyenne. Comme dans la finance, il faut prévoir le pire et assurer le maintien de l’habitabilité pour les humains de notre planète.

Alain Grandjean

- Température, précipitations, neige et glace, sécheresse, vent et tempêtes…

︎

︎ - Voir par exemple https://www.ipp.eu/methodes/analyse-cout-benefice ainsi que la fiche The Other Economy sur l’analyse coûts-bénéfices et ses limites.

︎

︎ - Voir la fiche de The Other Economy, pour la partie “Définition de la fonction de dommage, ou comment rendre le réchauffement climatique inoffensif pour la croissance économique” et cette recension d’Alain Grandjean et Marion Cohen Recension des publications récentes sur l’évaluation des dommages climatiques, Avril 2025

︎

︎ - Voir le post Loi de Pareto, bulles financières et oligopoles. La révolution des lois de puissance en économie au paragraphe 8

︎

︎ - On Modeling and Interpreting the Economics of Catastrophic Climate Change, The Review of Economics and Statistics (2009) 91 (1): 1–19.

︎

︎ - En climatologie, le forçage est un facteur qui modifie l’équilibre énergétique de la Terre, provoquant un réchauffement ou un refroidissement du climat. Il peut être naturel, comme les éruptions volcaniques ou les variations de l’activité solaire, ou d’origine humaine, comme les émissions de gaz à effet de serre ou la déforestation.

︎

︎ - Voir cette étude parue dans Nature Lenton TM, Rockström J, Gaffney O, Rahmstorf S, Richardson K, Steffen W, Schellnhuber HJ. Climate tipping points – too risky to bet against. Nature. 2019. Et ce rapport plus récent : The global tipping points report 2025.

︎

︎ - Voir le contenu de Wikipedia sur les points de basculement climatique

︎

︎ - Voir Trajectories of the Earth System in the Anthropocene. Will Stefen et al. PNAS. 2018 et Wunderling et al. Interacting tipping elements increase risk of climate domino effects under global warming, Earth Syst. Dynam.2021.

︎

︎ - Voir cette présentation introductive deJulien Baglio d’après le cours de Joseph Zyss

︎

︎ - On peut citer les plus connues, la bifurcation de Hopf et la bifurcation Cuspide.

Voir Kuehn, A mathematical framework for critical transitions: Bifurcations, fast–slow systems and stochastic dynamics, in Physica D: Nonlinear Phenomena, Volume 240, Issue 12, 2011.

Voir Ashwin et al., P., Wieczorek, S., Vitolo, R., & Cox, P. Tipping points in open systems: bifurcation, noise-induced and rate-dependent tipping. 2012. ︎

︎ - id Note 8 – Voir le contenu de Wikipedia sur les points de basculement climatique.

︎

︎ - La variance est une mesure statistique de la dispersion des valeurs d’une variable autour de sa moyenne. Par exemple, deux régions peuvent avoir la même température moyenne estivale, mais celle où les températures quotidiennes varient fortement entre jours frais et vagues de chaleur présentera une variance plus élevée, indiquant une plus grande variabilité climatique.

︎

︎ - L’allongement des corrélations temporelles désigne le fait qu’un système proche d’un point de bascule met de plus en plus de temps à revenir à l’équilibre après une perturbation. On peut l’illustrer par une bille dans un bol : tant que le bol est bien creux, la bille revient vite au centre, mais si le bol devient presque plat (proche d’un seuil), la bille oscille lentement et conserve longtemps la trace des perturbations, ce qui augmente la corrélation entre états successifs. Dans le climat, ce phénomène a par exemple été étudié pour l’AMOC : à mesure qu’elle s’affaiblit sous l’effet d’apports d’eau douce, les indicateurs comme l’autocorrélation et la variance de certaines séries océaniques augmentent, suggérant un ralentissement de la dynamique et une proximité possible d’un point de bascule.

︎

︎ - Les distributions de valeurs extrêmes généralisées (GEV) sont une sorte de généralisation des lois de puissance. Elles décrivent le comportement statistique des événements les plus extrêmes d’une variable (maxima ou minima) et se caractérisent notamment par un paramètre de forme. Lorsque ce paramètre de forme est positif, la distribution est de type Fréchet, ce qui signifie que la probabilité d’événements extrêmes décroît lentement et que des valeurs très grandes restent possibles, sans borne supérieure théorique. En climatologie, ce type de GEV est souvent utilisé pour modéliser les précipitations extrêmes ou les crues, où des épisodes exceptionnellement intenses, bien que rares, peuvent survenir. Par exemple, l’analyse des maxima annuels de pluies journalières dans certaines régions tropicales conduit fréquemment à un paramètre de forme positif, indiquant un risque non négligeable d’événements pluviométriques extrêmes d’intensité très élevée.

︎

︎ - Voir Salah El Adlouni et al. Climatic a priori information for the GEV distribution’s shape parameter of annual maximum flow series, Journal of Hydrology, vol. 661, 2025.

︎

︎ - Jayaweera, L. et al. Evaluation and projection of extreme rainfall from a large ensemble of high-resolution regional climate models in Australia. Weather and Climate Extremes, 50, 100818. 2025.

︎

︎ - Voir par exemple ce récent papier de l’économiste R. Daniel Bressler Breaking Down the Mortality and Social Cost of Carbon.

︎

︎ - Id note 2 – Voir par exemple https://www.ipp.eu/methodes/analyse-cout-benefice ainsi que la fiche de The Other Economy sur l’analyse coûts-bénéfices et ses limites.

︎

︎ - Notons que Martin Weitzman n’est pas un théoricien de l’effondrement mais de la décision en incertitude radicale, ce monde de l’ignorance des probabilités précises des événements et des “inconnues inconnues” . Les “inconnues inconnues” (unknown unknowns) désignent des événements ou mécanismes dont on ignore à la fois l’existence et la probabilité : ce sont des risques que l’on ne sait même pas formuler à l’avance. Contrairement aux “connues connues” (événements identifiés et probabilisables) ou aux “connues inconnues” (événements identifiés mais dont la probabilité est incertaine), les inconnues inconnues échappent aux cadres probabilistes classiques.

︎

︎ - Voir cet article de Charlotte Gardes (BSI economics) sur les apports de Martin Weitzman « Pourquoi l’économiste doit-il porter attention aux scénarios extrêmes de changement climatique ? »

︎

︎ - Voir le post Crises bancaires et financières : le rôle du prêteur en dernier ressort où nous avons présenté cette notion appliquée à la finance.

︎

︎ - Pour une présentation critique des IAMs voir ces deux notes :

Alain Grandjean, Les modèles IAMs et leurs limites, Chaire Energie et Prospérité, 2024

et Alain Grandjean et Gaël Giraud, Comparaison des modèles météorologiques, climatiques et économiques, 2017. ︎

︎ - Voir cet article de Lint barrage et William Nordhaus publié en 2024.

︎

︎ - Voir Hope, Chris W. The Social Cost of CO₂ from the PAGE09 model. Economics Discussion Papers, No. 2011-39, Kiel Institute for the World Economy (2011).

︎

︎ - Une approche alternative, le minimax-regret (MMR), vise à minimiser l’écart maximal entre la politique adoptée et la meilleure politique a posteriori. Voir par exemple cet article : A quantitative minimax regret approach to climate change: Does discounting still matter? Ecological Economics. (2010). Bien qu’utile pour limiter le regret dans des scénarios graves, elle ne garantit pas que les catastrophes extrêmes soient évitées. Elle ne se confond donc pas avec les approches robustes, qui elles visent explicitement à protéger le système contre le pire scénario plausible.

︎

︎ - Voir les travaux d’Olivier Hamant, son TEDx La révolution de la robustesse et son livre “La troisième voie du vivant » Odile Jacob, 2022.

︎

︎

Image : Venezia, Veneto, Italia – Giovanni – Pexels – libre de droits

The post Tipping points, lois de puissance et économie climatique appeared first on Chroniques de l'Anthropocène.

11.02.2026 à 09:31

Crises bancaires et financières : le rôle du prêteur en dernier ressort

Alain Grandjean

Les banques centrales ont plusieurs fonctions (voir la fiche sur l’indépendance de la banque centrale). Nous allons ici traiter de celle de prêteur en dernier ressort (Lender of last resort,…

The post Crises bancaires et financières : le rôle du prêteur en dernier ressort appeared first on Chroniques de l'Anthropocène.

Texte intégral (7419 mots)

Les banques centrales ont plusieurs fonctions (voir la fiche sur l’indépendance de la banque centrale). Nous allons ici traiter de celle de prêteur en dernier ressort (Lender of last resort, LOLR). Elle consiste principalement à fournir rapidement de la liquidité aux banques ou institutions financières solvables mais temporairement en risque « d’illiquidité », afin d’éviter que des retraits massifs ou des paniques bancaires ne provoquent l’effondrement du système financier. On se souvient du célèbre mot de Mario Draghi “Whatever it takes” en 2012 pour mettre fin à la crise qui menaçait la zone euro dans son ensemble. Comme l’écrit un journaliste des Echos : “Si, dans un premier temps, les mots suffisent, la BCE va rapidement prendre une mesure importante. La création de l’OMT1 mécanisme destiné à racheter de façon illimitée des titres de dette de pays en difficulté. Il ne sera jamais activé, mais le fait que la BCE devienne prêteur en dernier ressort suffit à protéger durablement les pays périphériques”.

Le LOLR vise à préserver la stabilité du système de paiement, maintenir la confiance dans la monnaie et limiter la contagion entre institutions, sans garantir la solvabilité des banques ou autres acteurs financiers défaillants. Ce rôle peut être soit codifié explicitement dans la loi (Banque du Canada, Riksbank), soit exercé comme fonction implicite (Fed, BCE2). Dans tous les cas, ce qui définit un LOLR c’est la capacité à fournir rapidement de la liquidité aux banques solvables en crise pour protéger la stabilité financière et la confiance dans la monnaie.

Nous allons voir dans la suite pourquoi les systèmes monétaires et financiers modernes ne peuvent se passer de cette fonction, sans avoir besoin d’exposer une théorie d’ensemble des crises financières et de leur variété. Nous ne traiterons pas ici des cas (rares) où la monnaie s’effondre du fait d’une hyperinflation (Allemagne de Weimar en 1923, effondrement du peso argentin en 2001, crise de la livre libanaise en 2019, etc.). La résolution de ces crises majeures ne relève pas du LOLR. Les crises de liquidité associées aux paniques bancaires seront qualifiées dans la suite de crises bancaires ou financières, même si elles affectent le fonctionnement des paiements donc la monnaie.

Introduction — Crises endogènes et mythe de l’équilibre

Les crises financières jalonnent l’histoire du capitalisme moderne3. Paniques bancaires du XIXᵉ siècle, crise de 1929, crise financière mondiale de 2008, crises de change, tensions sur les marchés en 20204 ou plus récemment effondrements de certaines “monnaies” numériques5. Cette répétition montre que les crises ne sont ni des accidents isolés ni des anomalies historiques, mais des phénomènes structurels. Pourtant, le récit dominant tend encore à expliquer les crises par des causes extérieures au système économique lui-même : un choc exogène, une erreur de politique, un événement exceptionnel. Cette lecture est liée à la théorie de l’équilibre général, selon laquelle l’économie serait fondamentalement stable et ne pourrait s’éloigner durablement de l’équilibre qu’à la suite de perturbations extérieures imprévisibles. Les crises ne seraient que temporaires et appelées à se résorber spontanément une fois le choc absorbé.

L’histoire bancaire et financière contredit profondément cette vision. Les crises bancaires et financières sont endogènes : elles émergent du fonctionnement normal des systèmes fondés sur le crédit, la liquidité et la confiance. Nous distinguerons deux types de crises, souvent confondues :

- les crises bancaires, qui portent sur la liquidité, la convertibilité et la confiance dans la monnaie scripturale,

- les crises financières, qui résultent de l’endettement, accru par l’effet de levier, et des pertes de valorisation des actifs ; ce sont des crises de solvabilité.

Ces deux types de crises obéissent à des mécanismes différents — même si dans les deux cas, la spéculation joue un rôle évident — mais elles sont aussi profondément articulées : une crise financière peut se transformer en crise bancaire, et une crise bancaire peut amplifier une crise financière. Lorsque la valeur des actifs chute, la solvabilité est remise en question ; lorsque la confiance disparaît, même des institutions solvables peuvent devenir illiquides. Loin d’être une anomalie ou une entorse aux règles du marché, le prêteur en dernier ressort est une construction institutionnelle visant à empêcher que les dynamiques endogènes de la finance ne dégénèrent en effondrement généralisé du système monétaire. Comprendre cette nécessité est l’objectif central de cette note.

1 Les crises bancaires ou bank runs

La fragilité monétaire des banques découle directement de leur mode de fonctionnement, lié aux mécanismes de création monétaire. Rappelons donc que les banques créent des dépôts à l’occasion de leurs prêts. Ce pouvoir de création monétaire est limité par la réglementation (voir encadré sur le ratio de liquidité). Mais il est clair qu’elles ont moins de réserves6 et de liquidités immédiatement disponibles (billets ou réserves à la banque centrale) que de sommes exigibles à vue (comptes courants et comptes sur livret — appelés aussi livrets d’épargne). Cette possibilité permet d’augmenter le crédit et la masse monétaire, mais expose la banque à un risque de liquidité. Cela peut arriver dans deux cas non indépendants :

- si trop de déposants retirent simultanément leur argent, ce qu’on appelle un bank run (ruée vers le guichet).

- si une banque n’inspire plus confiance à ses consoeurs, ce qui peut la conduire à manquer de monnaie centrale.

Dans les deux cas, la panique est auto-réalisatrice : la crainte de ne pas pouvoir retirer ses fonds pousse les déposants à agir collectivement, aggravant la situation. Ce phénomène explique pourquoi les faillites bancaires sont souvent liées à un manque de liquidité plutôt qu’à une insolvabilité réelle. Dans le deuxième cas (pertes de confiance mutuelles), le marché interbancaire peut se geler7 ce qui provoque une crise majeure (ce qui s’est passé en 2008).

Conclusion : une banque solvable (bénéficiaire comptablement), qui, en outre respecte les ratios de liquidité, peut néanmoins devenir illiquide et devoir immédiatement se déclarer en faillite. C’est pour cela que les sauvetages bancaires des banques systémiques se font en quelques heures.

| Ratios de liquidité réglementaires Les banques européennes doivent respecter divers ratios imposés dans la réglementation bancaire (mise en place après la crise de 2008 via les accords de Bâle III et transposée dans la réglementation européenne – CRR / CRD), dont le ratio de couverture de liquidité, le Liquidity Coverage Ratio (LCR). Le LCR un ratio à court terme mesurant la capacité d’une banque à faire face à un scénario de stress aigu de 30 jours (hausse des retraits, absence de financement, etc.). Il compare : – au numérateur : les actifs liquides dits de haute qualité (High-Quality Liquid Assets, HQLA) que la banque peut mobiliser rapidement (billets, réserves à la banque centrale, obligations souveraines liquides), – au dénominateur : les sorties nettes de trésorerie estimées dans un scénario de crise sur 30 jours. L’exigence est que la banque détienne au moins 100 % de HQLA par rapport à ses sorties nettes de trésorerie, ce qui signifie qu’elle serait en théorie capable de survivre un mois de stress sans refinancement externe. En pratique, les banques européennes ont maintenu des LCR bien au-dessus de 100 % ces dernières années8. Mais les sorties nettes de trésorerie utilisées dans le calcul du LCR reposent sur des hypothèses statistiques et des scénarios de stress calibrés ex ante. Une panique bancaire constitue par nature un événement hors modèle, marqué par une accélération brutale et non linéaire des retraits. Le cas de Credit Suisse racheté de toute urgence par UBS en 2023 illustre cette limite : alors que la banque respectait les exigences de liquidité réglementaires avant la crise, la perte de confiance a provoqué des sorties de dépôts à une vitesse et une ampleur incompatibles avec les hypothèses du LCR, rendant nécessaire une intervention publique et une reprise d’urgence. |

2 Les crises financières

Les crises financières, dont on va parler maintenant, ne sont pas liées à la création monétaire, stricto sensu. Elles obéissent à une autre logique que Hyman Minsky9 a bien mis en évidence.

2.1 La dynamique du crédit source endogène d’instabilité

Le crédit est au cœur du fonctionnement moderne des économies. Contrairement à une idée reçue selon laquelle l’épargne précède nécessairement l’investissement, c’est le crédit qui finance l’activité dans les systèmes bancaires contemporains. Or la dynamique du crédit est intrinsèquement génératrice de cycles et de risques de crises.

Le crédit tend à croître en période d’expansion et à se contracter lors des ralentissements. En phase de croissance, les banques et les marchés financiers deviennent plus confiants et anticipent des rendements futurs élevés. Dans ce contexte, les agents économiques sont incités à accroître leur recours à l’endettement et à l’effet de levier10 pour financer de nouveaux investissements ou prendre des positions fondées sur l’anticipation de la hausse des prix des actifs. Ces investissements et les stratégies des “spéculateurs”11 soutiennent la production, les profits et la valorisation des actifs, ce qui renforce la confiance générale et encourage de nouveaux emprunts. Les banques prêtent alors davantage, alimentant à la fois la demande et la hausse des prix des actifs.

Une perte de confiance peut se produire à tout instant qui inverse les anticipations et la dynamique. Dans cette phase de contraction, la peur et l’incertitude incitent à réduire le crédit, ce qui amplifie la baisse économique et accentue les pertes de valeur. Les anticipations spéculatives s’inversent. Le recours antérieur à un levier élevé accentue et accélère la contraction. Une petite variation de la valeur des actifs peut en effet provoquer des pertes disproportionnées pour des agents fortement exposés. Par exemple, si une banque détient un portefeuille fortement « leveragé » (avec fort effet de levier) et que la valeur des actifs baisse de quelques %, les pertes en capital peuvent dépasser ce que la banque peut absorber, même si ses actifs restent supérieurs à zéro.

2.2 Les crises de marché liées au shadow banking

Les crises financières ne se limitent pas aux banques traditionnelles. Depuis les années 1980, le développement du shadow banking12 — opérateurs non bancaires de crédit et de financement — a introduit de nouvelles sources d’instabilité, amplifié les cycles financiers et rendu le système plus vulnérable aux « runs de marché » et aux fire sales.

Ces institutions empruntent à court terme pour investir à long terme. Comme les banques, elles sont exposées au risque de panique : si leurs créanciers perdent confiance, ils retirent rapidement leurs fonds ou cessent de renouveler leurs prêts. Le shadow banking augmente donc la disponibilité de crédit, stimulant l’investissement et la croissance et accroît la fragilité globale, car une défaillance peut se propager rapidement, mais là sans filet réglementaire. Le shadow banking échappe en effet en grande partie aux exigences prudentielles, aux ratios de liquidité et au filet de sécurité publique applicables aux banques traditionnelles. Il est soumis à une régulation principalement axée sur les marchés et la protection des investisseurs.

Contrairement aux retraits massifs de dépôts, les “runs de marché“ se produisent sur les marchés de produits de financement à court terme : repos (voir encadré), billets de trésorerie, fonds monétaires. Lorsqu’un acteur perd confiance, il peut refuser de renouveler des prêts à court terme ou demander un remboursement immédiat. Cette panique se propage rapidement aux autres acteurs, par contagion systémique, même si les institutions ne sont pas techniquement insolvables. Ainsi, la fragilité du marché repose sur la liquidité perçue, et non sur la valeur fondamentale des actifs.

| Qu’est-ce qu’un REPO ? Un repo (repurchase agreement, ou accord de rachat) est un prêt garanti à très court terme, dans lequel une institution vend des titres financiers à une contrepartie contre des liquidités et s’engage simultanément à racheter ces titres à une date ultérieure à un prix convenu. Le différentiel entre le prix de vente et le prix de rachat constitue le coût implicite du financement. Les repos sont largement utilisés par les banques commerciales et d’investissement, pour gérer leur liquidité quotidienne et financer leurs portefeuilles ; par les gestionnaires d’actifs et fonds d’investissement, pour placer temporairement des liquidités excédentaires ou financer des achats d’actifs ; et par les “asset owners” (fonds de pension, compagnies d’assurance, fonds souverains), pour optimiser la gestion de trésorerie et couvrir leurs engagements à court terme. En pratique, le repo permet à ces institutions de convertir rapidement des actifs sûrs en liquidités ou de financer des positions de manière sécurisée, tout en offrant un instrument flexible et considéré comme peu risqué pour le marché interbancaire et les marchés financiers en général.Les banques centrales utilisent les repos comme un outil de prêteur en dernier ressort (voir plus loin) : elles achètent temporairement des titres auprès des banques commerciales en échange de liquidités. Cela permet aux banques d’obtenir immédiatement du cash pour faire face à leurs besoins urgents. Ces opérations sont particulièrement utilisées en période de tension sur les marchés, quand les banques auraient autrement du mal à refinancer leurs actifs ou à honorer les retraits de leurs clients. En pratique, la banque centrale injecte de la liquidité au moment où survient une crise de confiance ou de liquidité, puis récupère les titres lorsque la situation se normalise. |

Pour se protéger d’une crise de liquidité, les institutions sont souvent contraintes de vendre rapidement leurs actifs, souvent à des prix bien inférieurs à leur valeur comptable. Ces ventes d’urgence appelées « fire sales » ont plusieurs effets. Elles amplifient la baisse des prix des actifs, affectant les bilans d’autres institutions. Elles créent des spirales auto-renforcées : la baisse de prix entraîne des pertes, qui conduisent à de nouvelles ventes et … de nouvelles baisses. Elles peuvent transformer une crise de liquidité en crise financière globale.

Même si les banques sont mieux régulées, elles sont fortement connectées au shadow banking. Les runs de marché et les fire sales peuvent donc contaminer le système bancaire classique, des défaillances de banques pourtant solvables, voire un gel du marché interbancaire et, si le mécanisme de LOLR (voir plus loin) n’intervient pas, une crise monétaire.

3 Interconnexions, réseaux et contagion financière

Les banques, les entreprises et les marchés financiers forment un réseau complexe, où les défaillances d’un acteur peuvent se propager à l’ensemble du système. Les interconnexions financières ont deux effets opposés :

- un effet de stabilisation par diversification : lorsqu’une banque prête à plusieurs contreparties, le risque de défaut individuel est dilué,

- un effet de fragilité systémique : la dépendance croissante entre institutions signifie qu’une défaillance peut se propager rapidement, entraînant des cascades de défauts et un risque systémique.

Un réseau bien connecté peut absorber des chocs limités mais amplifier les chocs importants. L’histoire de la crise de 2008 montre qu’une contagion rapide est possible même à partir d’un segment de marché limité (par exemple, les crédits hypothécaires subprimes). La contagion peut se produire par plusieurs mécanismes. Un défaut bancaire entraîne des pertes immédiates chez ses créanciers. Indirectement, la perception du risque se diffuse, entraînant un gel des marchés interbancaires ou la réduction du crédit. Enfin la vente forcée d’actifs (fire sale) déprécie les prix, fragilisant encore d’autres institutions.

Ainsi, un choc initial limité peut devenir une crise systémique. Comme pour le crédit, la fragilité des réseaux financiers est endogène : elle émerge de l’accumulation de dettes, de la centralisation des risques et de la confiance mutuelle dans les contreparties. Il ne faut pas attendre un choc extérieur pour voir apparaître des crises : les interconnexions et la structure même du réseau suffisent à générer une vulnérabilité systémique. Ce risque a été démontré mathématiquement (voir encadré).

Dans un réseau financier, certaines institutions jouent un rôle central, comme des hubs dans un réseau de transport. Leur défaillance affecte directement de nombreuses autres institutions et leur rôle est crucial dans la circulation du crédit et de la liquidité. Ces banques “too big to fail” ou “too interconnected to fail” dites systémiques posent un problème d’aléa moral : leur importance structurelle peut les inciter à prendre plus de risques, en comptant sur une intervention en dernier ressort si nécessaire.

| Modèles de réseaux représentant les risques de propagation de défaillance Les modèles mathématiques de réseaux sous forme de graphes permettent d’étudier la propagation des défaillances. Voici deux articles de référence dont on recopie ici le résumé : Gai & Kapadia (2010)13 Cet article explore “comment la probabilité et l’impact potentiel de la contagion sont influencés par les chocs agrégés et idiosyncrasiques, les changements dans la structure du réseau et la liquidité du marché des actifs. Nos conclusions suggèrent que les systèmes financiers présentent une tendance à la fois robuste et fragile : si la probabilité de contagion peut être faible, les effets peuvent être extrêmement étendus lorsque des problèmes surviennent. Nous expliquons également pourquoi la résilience du système face à des chocs assez importants avant 2007 n’aurait pas dû être considérée comme un indicateur fiable de sa robustesse future.” Acemoglu et al. (2015)14 “Cet article soutient que l’ampleur de la contagion financière présente une forme de transition de phase : tant que l’ampleur des chocs négatifs affectant les institutions financières est suffisamment faible, un réseau financier plus dense (correspondant à une structure plus diversifiée des engagements interbancaires) renforce la stabilité financière. Cependant, au-delà d’un certain point, les interconnexions denses servent de mécanisme de propagation des chocs, ce qui rend le système financier plus fragile. Nos résultats soulignent ainsi que les mêmes facteurs qui contribuent à la résilience dans certaines conditions peuvent constituer des sources importantes de risque systémique dans d’autres.” |

4 De la crise financière à la crise monétaire et réciproquement

4.1 De la crise financière à la crise monétaire

Les crises financières ne deviennent pas automatiquement des crises monétaires. Une baisse des prix d’actifs, des pertes bancaires ou des défauts d’emprunteurs peuvent être absorbés tant que la confiance dans la capacité du système à honorer ses engagements à court terme demeure intacte. La transformation d’une crise financière en crise monétaire c’est le passage d’une perte de valeur des actifs à une panne de liquidité.

Toute crise financière débute par une perte de valeur des actifs. Des investissements se révèlent moins rentables que prévu, certaines dettes deviennent douteuses, et les bilans se détériorent. À ce stade, il s’agit d’un phénomène classique dans une économie de marché fondée sur le crédit, comme on l’a vu. La bascule intervient lorsque les acteurs cessent de se demander si les actifs valent ce qui était anticipé à long terme, pour se concentrer sur une question plus immédiate : les promesses de paiement à court terme seront-elles honorées ?

Dans un système bancaire moderne, la liquidité repose largement sur des mécanismes de refinancement mutuel. Les banques se prêtent entre elles sur la base d’une confiance partagée dans la qualité des bilans et la continuité du système. Lorsque la crise financière s’aggrave, cette confiance se fragilise. Les établissements deviennent réticents à prêter à leurs pairs, non par manque de liquidité globale, mais par incertitude sur la solvabilité individuelle des contreparties. Le marché interbancaire se grippe, voire se fige complètement. Ce gel transforme une crise financière localisée en crise de liquidité systémique. Des institutions solvables sur le papier se retrouvent incapables de refinancer leurs engagements à court terme.

À mesure que les tensions de liquidité s’accumulent, la crainte se diffuse au-delà des banques. Déposants, investisseurs et contreparties cherchent à convertir leurs créances en actifs perçus comme parfaitement liquides et sûrs. Cette dynamique collective peut prendre la forme de retraits bancaires, de ventes massives d’actifs ou de refus de “rouler” des financements de court terme. La dynamique de panique s’enclenche comme on l’a vu. Des institutions pourtant solvables deviennent illiquides. C’est ce mécanisme qu’a illustré la crise de 2008 : une crise financière née sur les marchés du crédit immobilier s’est transformée en crise monétaire lorsque la confiance dans les promesses de paiement bancaires s’est effondrée.

4.2 De la crise monétaire à la crise financière : quand la panique détruit l’économie réelle

Inversement, une crise monétaire peut provoquer une crise financière profonde. Lorsque la liquidité disparaît, le crédit est coupé, les entreprises ne peuvent plus financer leur activité courante, les faillites se multiplient. Les actifs sont liquidés dans l’urgence, les prix s’effondrent, et la crise financière s’aggrave. La crise de 1929 illustre ce mécanisme inverse : la panique bancaire et la contraction monétaire du début des années 1930 ont amplifié une récession initiale en effondrement économique durable. L’absence d’un prêteur en dernier ressort efficace a transformé une crise sévère en catastrophe systémique.

5. Implications pour la régulation et la prévention : le rôle central du prêteur en dernier ressort

Nous venons de voir que les crises monétaires et financières sont endogènes aux systèmes complexes fondés sur le crédit bancaire et le shadow banking. Le rôle du régulateur est de concevoir des institutions capables d’en limiter les effets destructeurs. L’institution la plus déterminante est celle du prêteur en dernier ressort (LOLR).

Le risque de bank run illustre parfaitement sa fonction : fournir de la liquidité aux banques solvables mais illiquides ce qui stabilise la confiance des déposants, empêche la panique de se propager à d’autres institutions et maintient le système monétaire opérationnel, même en période de crise. Mais nous avons vu que les crises financières ( de solvabilité) peuvent dégénérer en crises monétaires. Le LOLR joue donc un rôle aussi pour limiter ce risque.

La fonction du LOLR est exactement celle du « back stop » connu dans de nombreux cas en physique, en écologie ou dans les réseaux « électriques ou numériques » (voir encadré).

| La nécessité de backstop dans les systèmes complexes Un backstop est un mécanisme de dernier recours destiné à assurer la stabilité d’un système lorsque ses règles ordinaires ou ses processus automatiques échouent. Il n’agit pas en permanence, mais en cas de crise. En matière financière et monétaire, sa simple existence suffit souvent à prévenir une crise. Ce concept s’applique à de nombreux domaines au-delà de la finance. Dans un réseau électrique, le backstop comprend des réserves de capacité, des barrages hydrauliques à démarrage rapide, empêchent une surcharge locale ou des mécanismes automatiques de délestage comme des disjoncteurs. Ces dispositifs ne sont pas utilisés en fonctionnement normal, mais ils évitent que des pannes locales se propagent en black-out systémique. Dans l’informatique et les réseaux distribués, les backstops se traduisent par des serveurs de secours, des réplications de données et des protocoles de tolérance aux pannes, qui empêchent la propagation des défaillances. Dans les systèmes mécaniques ou structurels, les marges de sécurité et les dispositifs redondants assurent que des surcharges imprévues ne provoquent pas la rupture instantanée de la structure. En ingénierie mécanique, les structures critiques (ponts, avions, ascenseurs) intègrent des coefficients de sécurité et des dispositifs redondants qui n’optimisent pas le rendement, mais empêchent la rupture brutale en cas de surcharge imprévue. Un système “optimisé” sans marge de sécurité est plus performant en apparence, mais cassant. Dans un réacteur nucléaire, les barres de contrôle constituent un backstop : elles ne produisent pas l’énergie, mais absorbent les réactions en chaîne lorsqu’elles deviennent instables. Dans la théorie des réseaux, un backstop correspond à un nœud ou une capacité externe capable d’absorber des chocs lorsque les connexions ordinaires sont saturées. Sans ce mécanisme, les chocs se propagent par contagion, conduisant à des cascades de défaillances. Même les écosystèmes disposent de formes naturelles de backstop : la diversité des espèces et les capacités de régénération permettent au système de résister aux chocs environnementaux. La leçon générale est claire : tout système complexe reposant sur la coordination et la confiance est structurellement fragile sans backstop. La stabilité n’est pas une propriété spontanée des règles ordinaires ; elle dépend de l’existence d’une capacité de soutien exceptionnelle, capable d’absorber des chocs extrêmes et de maintenir l’intégrité du système. Supprimer ou ignorer le backstop revient à transformer une robustesse apparente en vulnérabilité latente. C’est pourquoi les tentatives de se passer de régulation dans le monde des cryptoactifs sont toutes condamnées à échouer (voir le post « Tokénisation de la finance et euro numérique »). |

Cette fonction a été imaginée par Walter Bagehot, économiste, banquier et journaliste, qui, dans son ouvrage considéré souvent comme mythique Lombard Street a formulé les principes qui restent aujourd’hui la référence en la matière15. Il avait bien compris que les banques pouvaient être solvables (leurs actifs valant plus que leurs passifs) et illiquides (incapables de répondre à tous les retraits immédiats). Il identifiait la cause principale des faillites bancaires comme la panique des déposants, et non l’insolvabilité. Ainsi, une banque centrale avait à ses yeux comme rôle en tant que LOLR de prévenir les effondrements liés à la liquidité, tout en laissant les pertes financières se matérialiser. Il avait bien en tête que le prêteur en dernier ressort n’empêche pas les crises financières ni ne garantit la rentabilité des banques. Son rôle est strictement préventif pour la monnaie : il met fin à la panique, il maintient la continuité des paiements et du crédit à court terme et permet aux ajustements financiers inévitables de se produire sans effondrement monétaire systémique.

Bagehot recommandait une intervention ciblée et prudente reposant sur trois piliers :

1. Prêter librement aux banques solvables pour qu’elles puissent faire face aux retraits.

2. Prêter contre bonnes garanties pour éviter les abus.

3. Prêter à un taux élevé pour ne pas encourager une prise de risque excessive.

Cette “règle” vise à équilibrer deux objectifs : stabiliser la monnaie et limiter l’aléa moral. Elle reste pleinement d’actualité.

Conclusion

Le prêteur en dernier ressort est une institution centrale pour limiter la transformation des crises financières en effondrement monétaire systémique. Il ne supprime pas l’instabilité ni ne garantit la rentabilité des banques, mais il fournit rapidement de la liquidité aux institutions solvables mais temporairement illiquides, préservant la confiance, la continuité des paiements et la stabilité du système. Les crises récentes montrent que les outils prudentiels seuls — ratios de capital et de liquidité — ne suffisent pas à prévenir les paniques, dont la dynamique non linéaire échappe aux modèles.

La fonction de LOLR agit comme un backstop institutionnel, crucial pour les banques et, de plus en plus, pour le shadow banking, où des “runs de marché” et des ventes forcées peuvent contaminer l’ensemble du système. Elle exige toutefois un encadrement strict afin de limiter l’aléa moral : protéger la monnaie et la confiance sans inciter à des prises de risque excessives.

Avec la digitalisation et la tokenisation des actifs, les enjeux évoluent. La réflexion sur le LOLR et la conception d’une CBDC sûre deviennent indissociables : garantir la continuité des paiements, protéger la confiance et encadrer l’innovation financière sont désormais des impératifs simultanés.

Alain Grandjean

crédit photo : ©Monkasei – Dreamstime.com

Notes

- L’OMT est une des initiatives s’inscrivant dans la politique de Quantitative Easing. de la BCE enclenchée en 2010.

︎

︎ - Concernant la BCE cette fonction entre (non explicitement) dans le cadre de sa mission de stabilité financière (§3.3 des statuts)

︎

︎ - Voir le livre de référence de Kindleberger Histoire mondiale de la spéculation financière Valor 2005. Mais aussi les livres plus explicatifs de Christian Chavagneux Une brève histoire des crises financières – Des tulipes aux subprimes ou d’Olivier Lacoste, Les crises financières.

︎

︎ - En mars 2020 du fait de la crise du COVID, les marchés financiers ont connu de fortes tensions, marquées par une dégradation aiguë de la liquidité. Ces tensions ont été amplifiées par des sorties massives des fonds du shadow banking. Voir les notes de la Banque des règlements internationaux, de la Banque Centrale Européenne ou de la Reserve fédéral.e

︎

︎ - Les stablecoins algorithmiques Ifon Finance/titan et Terra/Ust se sont effondrés en 2021 et 2022. La faillite de la plateforme FTX a entraîné l’effondrement quasi-total du token FTT fin 2022.

︎

︎ - On parle parfois de système à « réserves fractionnaires » pour dire que les réserves sont une fraction des dépôts mais ce terme renvoie parfois à une théorie fausse, qui a été enseignée et l’est encore. Voir ce post.

︎

︎ - Voir cette déclaration d’un membre de la BCE.

︎

︎ - Voir par exemple ce communiqué de l’ European Bank Authority.

︎

︎ - Voir la fiche Minsky et Fisher, deux auteurs pour comprendre les crises et le livre de Minsky Stabiliser une économie instable. ed. Les petits matins, 2016. 1ère éd. en anglais. 1986.

︎

︎ - L’effet de levier désigne le recours à l’endettement pour augmenter la taille d’un investissement par rapport aux fonds propres engagés. À l’image d’un levier mécanique qui amplifie une force appliquée, l’endettement permet d’amplifier les gains potentiels sur les fonds propres lorsque les rendements sont favorables. Mais il accentue de manière symétrique les pertes et la vulnérabilité financière en cas de retournement.

︎

︎ - En un sens on pourrait dire que tout acteur détenant une “position” spécule…mais on se limite ici aux acteurs dont le métier est précisément de ne prendre des positions que pour les vender ou les acheter en fonction de leurs anticipations.

︎

︎ - Le shadow banking comprend tous les intermédiaires financiers qui effectuent des activités similaires à celles des banques commerciales, mais hors du contrôle direct de la régulation bancaire : fonds d’investissement, véhicules de titrisation, marchés de repos et de titres, etc.

︎

︎ - Gai, , Prasanna and Kapadia, Sujit and Kapadia, Sujit, Contagion in Financial Networks (March 23, 2010). Bank of England Working Paper No. 383

︎

︎ - Acemoglu, Daron, Asuman Ozdaglar, and Alireza Tahbaz-Salehi. 2015. « Systemic Risk and Stability in Financial Networks. » American Economic Review 105 (2): 564–608.

︎

︎ - On peut lire pour se convaincre du caractère “mythique” le livre des économistes Goodhart, Charles, and Gerhard Illing (eds), Financial Crises, Contagion, and the Lender of Last Resort: A Reader (Oxford, 2002).

︎

︎

The post Crises bancaires et financières : le rôle du prêteur en dernier ressort appeared first on Chroniques de l'Anthropocène.

04.02.2026 à 10:00

Loi de Pareto, bulles financières et oligopoles. La révolution des lois de puissance en économie

Alain Grandjean

La règle des 80/20, dite “loi de Pareto” (voir encadré), est largement utilisée en entreprise …

The post Loi de Pareto, bulles financières et oligopoles. La révolution des lois de puissance en économie appeared first on Chroniques de l'Anthropocène.

Texte intégral (7419 mots)

La règle des 80/20, dite “loi de Pareto” (voir encadré), est largement utilisée en entreprise en tant que pratique opérationnelle. Elle permet d’identifier ce qui a le plus d’impact afin de concentrer les efforts sur les actions les plus utiles. Nous allons voir ici que derrière cette règle se cache une logique, observable dans des contextes aussi variés que la culture, la finance ou l’organisation industrielle. Ces contextes sont riches de distributions de données, où quelques éléments dominent, tandis qu’une majorité forme une “longue traîne”. Cette régularité renvoie à une structure statistique générale : les lois de puissance1.

Nous allons montrer dans la suite comment les lois de puissance façonnent la dynamique économique contemporaine. Du constat empirique de Pareto à la domination des blockbusters, en passant par la formalisation des réseaux dits “invariants d’échelle”, celle des bulles financières et la formation des oligopoles, nous verrons que la concentration des ressources, de l’attention et des parts de marché n’est pas accidentelle, mais structurelle. Nous donnerons des exemples concrets issus du cinéma, de l’édition, de la musique ou du sport professionnel, puis nous présenterons des modèles issus de la science des réseaux, notamment celui de Barabási–Albert, qui permettent de comprendre comment les phénomènes de “winner takes all” émergent et se stabilisent. Nous appliquerons ces raisonnements aux mondes de la finance et de la formation des bulles financières et à celui de l’économie industrielle, à celui des médicaments et à la formation des oligopoles. Les lois de puissance apparaissent alors non comme une anomalie ou comme une curiosité mathématique, mais comme une clé de lecture essentielle des économies contemporaines.

Cette note a bénéficié des commentaires de Paul-Henri Roméo. Sa responsabilité n’est bien sûr pas engagée dans ce document.

| Loi de Pareto : d’une règle empirique à la structure des systèmes économiques Dans de nombreux contextes professionnels, une règle empirique simple est devenue un outil courant de décision et de priorisation : la règle des 80/20. Les praticiens du management, du marketing, de la logistique ou de l’ingénierie l’utilisent quotidiennement, souvent sans se préoccuper de son origine théorique. Elle sert avant tout à gagner du temps, à concentrer l’effort là où il est le plus efficace, et à éviter la dispersion. Ainsi, il n’est pas rare d’observer que : – 20 % des clients génèrent environ 80 % du chiffre d’affaires ; – 20 % des produits concentrent l’essentiel des ventes ou des stocks ; – une minorité de fonctionnalités d’un logiciel concentre la majorité des usages ; – une minorité de commandes génère la plupart des retards de livraison. … Dans ces situations, la règle des 80/20 n’est pas utilisée comme une loi exacte, mais comme une démarche opérationnelle : elle permet d’identifier rapidement les éléments dominants d’un système et de structurer l’action autour d’eux. Elle reflète une intuition largement partagée par les praticiens : les contributions ne sont pas réparties uniformément, et chercher à traiter tous les éléments de la même manière est souvent inefficace. Ce qui est frappant, toutefois, c’est la robustesse2 et la généralité de cette régularité. Bien au-delà des contextes managériaux, on retrouve des phénomènes similaires dans des domaines très différents : répartition des ventes culturelles, audiences médiatiques, tailles d’entreprises, parts de marché, fréquentation des plateformes numériques ou encore trafic sur Internet. Partout, une minorité d’éléments concentre une part disproportionnée des flux, tandis qu’une majorité reste marginale, sans être négligeable. Ces observations renvoient à deux caractéristiques structurelles majeures : – la concentration, où quelques acteurs ou objets dominent largement le système ; – la longue traîne, constituée d’une multitude d’éléments faiblement contributifs, mais dont l’ensemble peut représenter une masse significative. C’est précisément cette combinaison — domination de quelques-uns et étirement de la distribution — que la règle des 80/20 cherche à capturer de manière approximative. |

1. Pareto : de l’observation empirique à la forme mathématique des distributions de données

1.1 L’observation d’une régularité empirique

Lorsque Vilfredo Pareto3 étudie, à la fin du XIXᵉ siècle, la répartition des patrimoines dans plusieurs pays européens, son ambition n’est pas de formuler une loi universelle, encore moins une théorie normative de la justice sociale. Son approche est essentiellement empirique. En compilant des données fiscales et cadastrales, il constate que la distribution observée s’écarte systématiquement des formes statistiques alors utilisées pour décrire les phénomènes naturels ou sociaux.

Ce qui frappe Pareto n’est pas seulement l’existence d’écarts importants entre individus, mais la structure même de la distribution. Contrairement à une répartition symétrique autour d’une valeur moyenne, les données montrent une concentration marquée : une petite fraction de la population détient une part très élevée du patrimoine total, tandis qu’une majorité se répartit le reste selon une décroissance régulière. Cette forme se reproduit de manière remarquablement stable d’un pays à l’autre, indépendamment des contextes institutionnels ou historiques.

Pareto met ainsi en évidence une régularité statistique robuste, qui sera plus tard résumée — de manière simplificatrice — par la règle des 80/20. Mais son observation est plus générale : il s’agit d’une distribution sans échelle caractéristique, c’est-à-dire non représentable par des valeurs typiques qui la résument. Une distribution gaussienne (voir §1.2), par exemple, est résumée par sa moyenne et son écart-type qui mesure la dispersion autour de cette moyenne. Une distribution sans échelle (scale-free) est dominée par ses extrêmes et ne possède pas de taille, de richesse ou de fluctuation “typique”.

| Encadré historique : de Pareto aux lois de puissance Bien que Pareto ait observé la forte concentration des patrimoines, il n’a jamais formulé de loi mathématique générale. Le lien entre ses observations et les lois de puissance modernes a été établi progressivement : – George K. Zipf4 (1935) étudie la fréquence des mots dans les textes, découvrant une décroissance assimilable à une loi de puissance : dans un texte donné, la fréquence d’occurrence f(n) d’un mot est liée à son rang n dans l’ordre des fréquences par une loi de la forme f(n)=K/n où K est une constante. – Benoît Mandelbrot5, au début des années 1960, formalise mathématiquement des distributions en loi de puissance, montrant que les inégalités de revenus ou la distribution des tailles d’entreprises suivent des lois stables à queue lourde. – Barabási & Albert (voir §4) modélisent des réseaux en croissance avec attachement préférentiel, produisant naturellement des distributions en loi de puissance et des hubs, expliquant la concentration dans les systèmes sociaux, économiques et numériques. |

1.2 Loi normale, moyenne et illusion de représentativité

Pour comprendre la portée de cette observation, il est utile de la comparer aux distributions plus familières, notamment la loi normale (ou gaussienne, ces deux termes sont synonymes). Dans une distribution gaussienne, la majorité des observations se concentrent autour d’une moyenne qui résume efficacement le système. C’est le cas de la taille des adultes dans un pays, leur température corporelle, du nombre d’heures passées à la télé, des résultats au BAC etc. Les écarts extrêmes sont rares et jouent un rôle marginal. Ce type de distribution est bien adapté à des phénomènes où les fluctuations sont le résultat de nombreuses causes indépendantes et de faible amplitude.