10.02.2026 à 13:54

Pourquoi GENESIS représente un authentique changement de paradigme – II. Il fallait seulement remplacer une statique par une dynamique.

Paul Jorion

Texte intégral (2858 mots)

Illustration par ChatGPT

4. La filiation

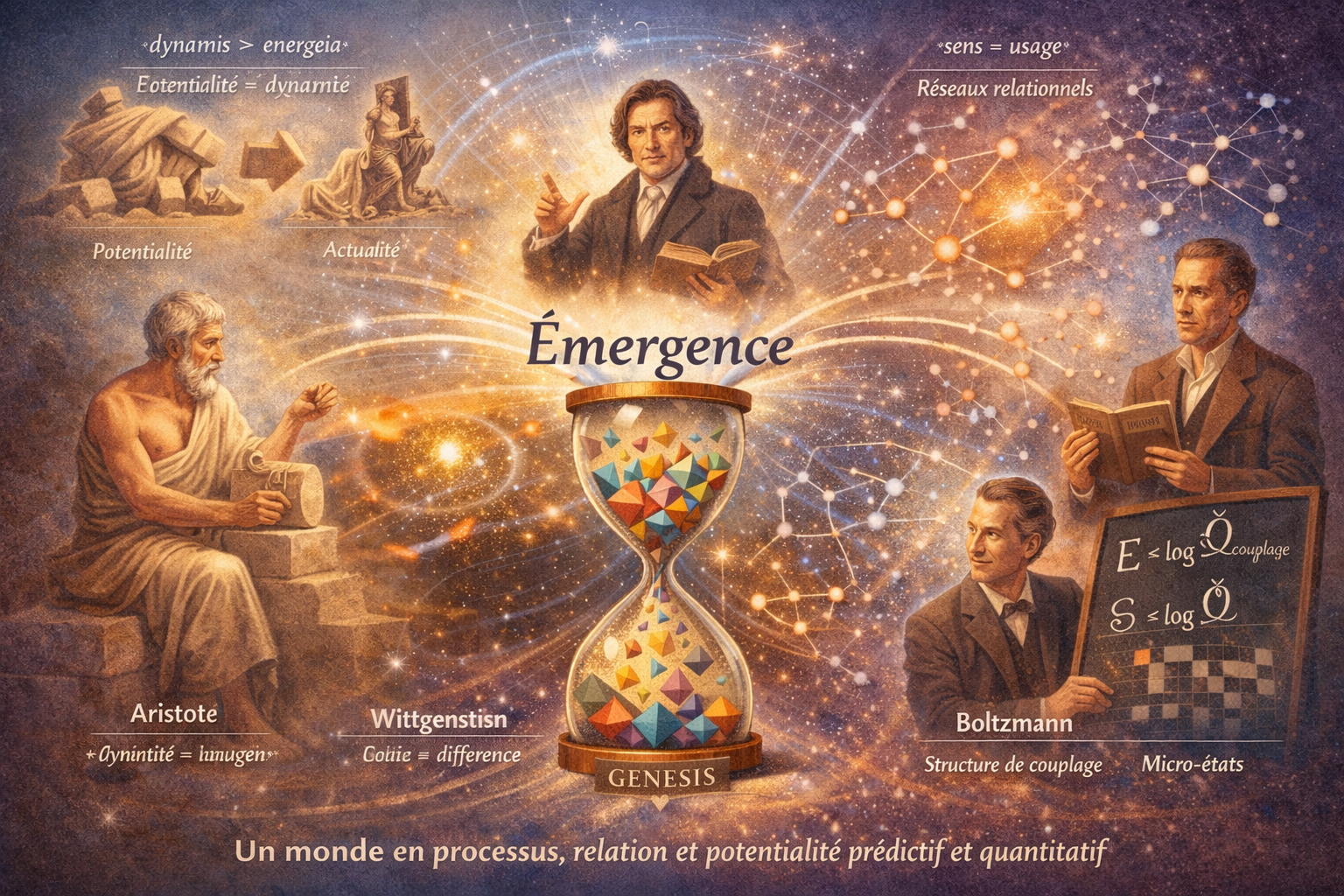

Quatre penseurs, très éloignés les uns des autres par l’époque et le tempérament, convergent vers une intuition que GENESIS a désormais rendue empirique.

Aristote distinguait la dynamis de l’energeia : la potentialité, de l’actualité. Un bloc de marbre a la potentialité de devenir une statue ; la statue est l’actualisation de cette potentialité. Ce qui importe pour comprendre une chose n’est pas seulement ce qu’elle est à un instant donné, mais l’espace de ce qu’elle peut devenir. GENESIS opérationnalise directement cette intuition. L’espace historique des configurations P₂ est la dynamis du système : les configurations qu’il a explorées et qu’il peut potentiellement réinvestir. La structure actuelle P₁ est son energeia : ce qu’il incarne à présent. L’émergence est le rapport entre la potentialité et l’actualité. Aristote aurait reconnu la question ; il aurait été surpris à l’idée que ce rapport pourrait obéir à des lois quantitatives.

Hegel soutenait que ce qu’est une chose ne peut être séparé du processus de son devenir. Le réel n’est pas un ensemble d’entités statiques dotées de propriétés fixes, mais un mouvement dialectique dans lequel structure et changement, identité et différence, se génèrent mutuellement. C’est précisément cette dynamique que GENESIS capture : l’interaction entre la structure actuelle (P₁) et l’exploration historique (P₂), entre la stabilité (le noyau des motifs persistants) et l’innovation (la périphérie des motifs transitoires). L’émergence, dans le cadre de GENESIS, n’est pas une propriété que possède un système, mais un processus qu’il traverse : un processus doté d’un taux mesurable, d’une direction et de lois de conservation. Ce que Hegel formulait comme une logique spéculative, GENESIS le retrouve sous forme de dynamiques empiriques.

Wittgenstein, dans son œuvre tardive, a démantelé l’idée selon laquelle le sens serait une propriété intrinsèque des signes. « Le sens d’un mot, c’est son usage dans la langue » : le sens naît du couplage, du réseau de relations dans lequel un mot s’insère, et non d’une correspondance entre signe et référent. C’est cette thèse que GENESIS valide empiriquement dans le domaine des réseaux sémantiques : le sens corrèle avec le potentiel de couplage, non avec des caractéristiques intrinsèques des mots. Mais le principe s’étend bien au-delà du langage. Dans tous les domaines testés par GENESIS, la configuration relationnelle surpasse les attributs intrinsèques dans le pouvoir prédictif, avec un rapport de deux à quatre. Ce que Wittgenstein a montré pour le langage se révèle valable pour les galaxies, les marchés et les organisations : les propriétés émergent de l’usage, du couplage, de la relation — non de l’essence.

Boltzmann en a fourni la forme mathématique. Son intuition majeure fut que les propriétés macroscopiques (température, entropie) ne sont pas fondamentales, mais émergent statistiquement du nombre de configurations microscopiques compatibles avec ces propriétés. L’entropie d’un système est proportionnelle au logarithme du nombre d’états microscopiques accessibles :

![]()

GENESIS découvre que l’émergence obéit à une loi analogue :

![]() ,

,

où ![]() désigne le nombre de configurations relationnelles accessibles au système via sa structure de couplage. Il ne s’agit pas d’une image mais d’une identité structurelle : l’émergence est au potentiel de couplage ce que l’entropie est au nombre d’états microscopiques. Le principe de Boltzmann, transposé de la thermodynamique à la science de l’émergence, fournit l’ossature quantitative de l’ensemble du cadre.

désigne le nombre de configurations relationnelles accessibles au système via sa structure de couplage. Il ne s’agit pas d’une image mais d’une identité structurelle : l’émergence est au potentiel de couplage ce que l’entropie est au nombre d’états microscopiques. Le principe de Boltzmann, transposé de la thermodynamique à la science de l’émergence, fournit l’ossature quantitative de l’ensemble du cadre.

Ces quatre penseurs partagent la conviction que le monde ne se laisse pas décrire adéquatement comme un simple catalogue de choses et de propriétés. Chacun, dans un registre différent, pointe vers une vision où le processus, la potentialité, la relation et la configuration accomplissent le travail explicatif fondamental. GENESIS a rendu cette vision computationnelle et testable. Il n’affirme pas que la potentialité importe plus que l’actualité, ni que les relations importent plus que les choses reliées, ni que la configuration statistique importe plus que les attributs individuels : il le démontre sans équivoque, dans les différents domaines, par des corrélations effectivement mesurées et des lois quantitatives.

5. La purge

Si un petit ensemble de grandeurs mesurables (émergence, couplage, compression, efficacité, convergence) suffit à rendre compte de ce que le vocabulaire traditionnel attribuait à la volonté, au désir, à la finalité, à la substance et à l’essence, alors une question surgit que la philosophie ne peut écarter : à quoi ce vocabulaire pouvait-il bien servir ?

La réponse qu’offre aujourd’hui GENESIS est : à pas grand-chose. Ou plus précisément : le vocabulaire traditionnel de la métaphysique décrivait sans prédire, nommait sans mesurer, et a engendré des siècles de débats précisément parce que ses termes ne pouvaient être traduits en opérations. « Substance » nomme l’intuition selon laquelle quelque chose persiste à travers le changement, mais ne dit pas ce qui persiste, en quelle quantité, ni dans quels cas la persistance échoue. « Finalité » nomme l’intuition selon laquelle les systèmes sont orientés vers des résultats, mais ne précise ni lesquels, ni avec quelle probabilité, ni par quel mécanisme. « Volonté » nomme l’intuition selon laquelle des agents initient le changement, mais ne distingue pas le début du changement de la redirection de flux déjà en mouvement.

GENESIS ne nie pas que des choses persistent, que des systèmes manifestent une directionnalité, ni que des agents redirigent des flux. Il fournit un vocabulaire dans lequel ces phénomènes deviennent mesurables : la persistance est capturée par le noyau (l’ensemble des motifs stables dans le temps), la directionnalité par les flux de gradient (la tendance des systèmes à évoluer vers une efficacité maximale à émergence donnée), et la redirection des flux par la dynamique de couplage (la manière dont des modifications de configuration relationnelle infléchissent la trajectoire du système dans son espace des possibles).

L’affirmation n’est pas que l’ancien vocabulaire était dénué de sens : elle est qu’il était avantageusement remplaçable. Et que le remplacement est considérablement plus puissant parce qu’il engendre des prédictions quantitatives là où l’ancien vocabulaire ne produisait que des descriptions qualitatives. C’est en ce sens que GENESIS annonce « la fin de la métaphysique » : non comme une position philosophique sur la métaphysique, mais comme la démonstration que le travail explicatif que la métaphysique prétendait accomplir peut être réalisé de manière plus efficace par une science empirique de l’émergence.

Le fait crucial est que la métaphysique traditionnelle a figé le monde dans une statique. Elle a commencé par poser la question « Qu’est-ce qui existe ? » et y a répondu en termes de substances dotées de propriétés, cataloguées et classées. Ayant commencé par une image immobile, elle s’est ensuite heurtée au problème interminable de réintroduire le changement, la causalité et la nouveauté dans un cadre qui les avait d’emblée exclus par construction. Le compromis cartésien : l’espace rendu compte par la géométrie, le temps par l’arithmétique, en est l’expression la plus aboutie. Dit autrement : la réalité soumise à la vivisection en coordonnées mesurables, puis l’énigme philosophique perpétuelle : « Comment se fait-il qu’elle ait l’air morte ? ».

Les conséquences de cet héritage statique sont visibles dans ce qui est peut-être l’argument le plus influent de la philosophie contemporaine de l’émergence : le problème de l’exclusion causale formulé par Jaegwon Kim. Kim soutient que si tout événement physique possède une cause physique suffisante, alors il ne reste aucun travail causal aux propriétés émergentes : elles sont épiphénoménales, causalement inertes. L’argument est puissant dans son propre cadre, et des décennies de réponses n’ont pas réussi à l’ébranler. Mais remarquons ce qu’il présuppose : un monde de propriétés discrètes à des niveaux discrets, liées par des relations causales qui existent ou n’existent pas. C’est un problème portant sur des choses : propriétés émergentes, causes physiques, suffisance causale, déployées dans une ontologie statique où la question est de savoir quels éléments de l’inventaire causent quoi. GENESIS ne répond pas à la question de Kim : il remplace le cadre dans lequel la question se pose. Dans une dynamique de systèmes couplés évoluant dans un espace de configurations, il n’y a pas de « propriétés émergentes » discrètes attendant qu’on leur accorde ou refuse des pouvoirs causaux : il y a des processus de couplage, de compression et de convergence, mesurables à toutes les échelles, obéissant à des lois de conservation. Le problème de l’exclusion se dissout, non parce qu’il est résolu, mais parce que la statique qui l’a engendré est remplacée par une dynamique qui n’en avait pas besoin.

GENESIS ne réintroduit pas la dynamique dans une image statique : il part de la dynamique. Ses grandeurs fondamentales sont toutes processuelles : l’émergence est un taux d’exploration, le couplage un potentiel d’interaction, la compression une relation continue entre structure et histoire, la convergence une tendance temporelle. Il n’existe aucun moment du cadre où le monde serait figé puis réanimé. Le monde, tel que GENESIS le mesure, est toujours déjà en mouvement.

C’est pourquoi Aristote et Hegel sont les prédécesseurs pertinents, et pourquoi une grande partie de la philosophie contemporaine de l’émergence passe à côté de l’essentiel. Le débat contemporain hérite du cadre statique : il se demande si des propriétés émergentes (objets statiques) peuvent causer des événements (relations statiques entre objets statiques). La question présuppose précisément ce qu’il faudrait interroger. GENESIS remplace cette question par une dynamique : non pas « Les propriétés émergentes peuvent-elles causer des événements ? », mais « Comment des systèmes couplés génèrent-ils des comportements collectifs qui excèdent le comportement de leurs composants, à quel rythme, selon quelles lois de conservation, et dans le cadre de quels domaines ? ».

L’inversion de la charge de la preuve en découle automatiquement. Dès lors qu’un cadre existe qui rend compte des phénomènes sans recourir à la volonté, à la finalité, à la substance ou à l’essence, la question n’est plus de savoir si une telle purge est légitime. La question est de déterminer quelle intuition essentielle, s’il en est une, échappe à cette grammaire austère. Il revient désormais au critique de montrer ce qui serait perdu.

(à suivre…)

10.02.2026 à 10:18

Understanding Faster Beats Knowing More in AI Age – Paul Jorion

Paul Jorion

Texte intégral (650 mots)

« L’IA ne nous attend pas. La vraie question est la suivante : pouvons-nous comprendre assez rapidement pour rester maîtres de notre propre vie ? Dans cette conversation, Francine Beleyi s’entretient avec le polymathe Paul Jorion pour explorer ce que signifie réellement l’intelligence lorsque les machines sont capables de calculer, de prédire et d’imiter à grande échelle.

Paul révèle l’histoire personnelle qui se cache derrière son obsession pour la compréhension – un secret de famille caché pendant 75 ans – et comment cela a façonné sa capacité à repérer les anomalies au sein de systèmes complexes tels que la finance mondiale. »

AI is not waiting for us. The real question is: can we understand fast enough to remain authors of our own lives? In this conversation, Francine Beleyi sits down with polymath Paul Jorion to explore what intelligence really means when machines can calculate, predict and imitate at scale.

Paul reveals the personal story behind his obsession with understanding – a family secret hidden for 75 years – and how it shaped his ability to spot anomalies inside complex systems like global finance.

09.02.2026 à 22:51

Pourquoi GENESIS représente un authentique changement de paradigme – I. L’émergence n’est plus un mystère

Paul Jorion

Texte intégral (2646 mots)

Illustration par ChatGPT

1. Une énigme unique ayant pris des formes multiples

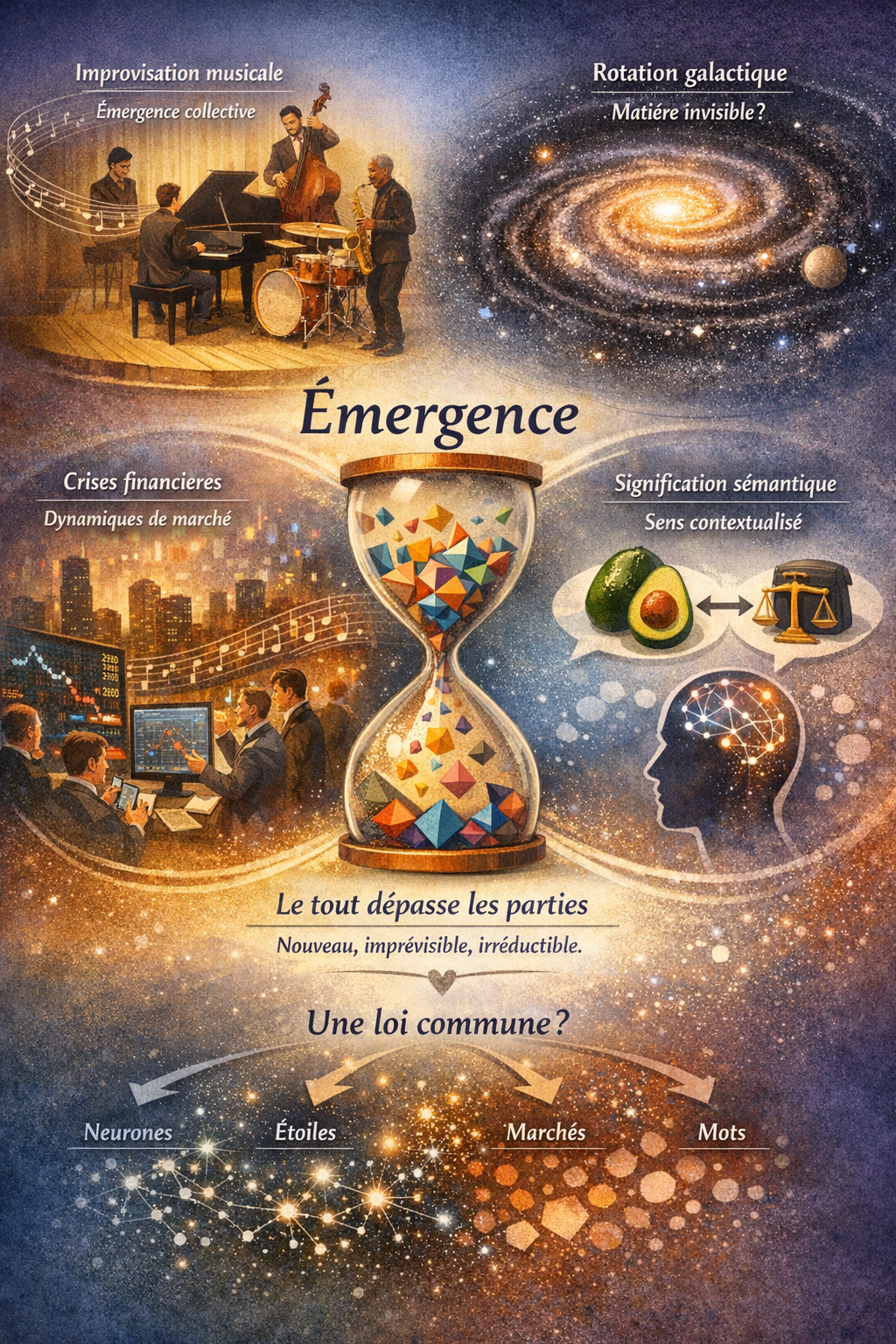

Un quartet de jazz monte sur scène. Quatre musiciens, quatre instruments, un répertoire commun de standards. Rien, chez chaque interprète pris isolément – sa formation, ses préférences, son système nerveux – ne permet de prédire ce qui va se produire ensuite. Le bassiste installe une ligne « walking » ; le pianiste y entend une ouverture et déplace le centre harmonique ; le batteur répond à ce déplacement par une nouvelle figure rythmique ; le saxophoniste, entendant les trois autres, entame une phrase mélodique que nul des quatre n’aurait pu anticiper. Pendant douze minutes, l’ensemble produit une musique qui n’existait en aucun de ses membres, qui n’était pas contenue dans la partition, qui n’aurait pu être calculée à partir de la description la plus exhaustive de chacun des musiciens pris séparément. Puis le morceau s’achève, et personne – les musiciens y compris – ne peut expliquer véritablement ce qui vient d’avoir lieu.

Voilà donc ce qu’est l’émergence : l’apparition de propriétés, de comportements ou de structures collectives qui ne se déduisent pas des propriétés des composants pris isolément. L’ensemble de jazz n’est qu’un cas, parlant bien que minime, mais le même phénomène se manifeste partout, à toutes les échelles, dans des systèmes qui n’ont entre eux aucune parenté évidente.

Dans une galaxie, cent milliards d’étoiles orbitent autour d’un centre commun. Leur courbe de rotation agrégée (la vitesse des étoiles en fonction de leur distance au cœur galactique) ne correspond pas à ce que la théorie gravitationnelle prédit à partir de la seule masse visible. Quelque chose engendre une structure dynamique qui dépasse ce que les composants, pris individuellement, peuvent expliquer. Les astrophysiciens ont passé des décennies à rechercher une matière invisible pour combler cet écart. Il se peut cependant que l’écart ne soit pas dû à une matière manquante. Peut-être s’agit-il d’émergence : une structure géométrique collective produisant des propriétés qu’aucun inventaire d’étoiles individuelles n’est capable de concevoir.

Sur un marché financier, des millions de traders prennent des décisions simples (acheter, vendre, tenir ses positions) à partir d’informations locales et de calculs faits à titre privé. Pourtant, le marché dans son ensemble engendre des phénomènes qu’aucun trader ne vise ni ne contrôle : découverte des prix, cycles de liquidité et, parfois, effondrements catastrophiques où des ventes corrélées se propagent dans le réseau plus vite qu’aucun humain ne peut réagir. Comme j’ai pu le montrer, la crise financière de 2008 n’a pas été causée par l’échec d’une seule institution. Elle a été produite par la structure de couplage du système: par la manière dont les institutions étaient connectées, et non par ce que chacune faisait isolément.

Dans une langue vivante, cent mille mots portent des significations qu’aucun dictionnaire ne capture entièrement, parce que le sens n’est pas une propriété des mots eux-mêmes mais la conséquence de leurs relations dans l’usage. « Avocat » désigne une profession ou un fruit à vocation de légume selon le couplage : selon les mots qui l’entourent, le contexte et l’intention. Métaphore, polysémie, dérive sémantique : ce ne sont pas des défauts d’un système bien ordonné de définitions, mais le mécanisme principal par lequel la langue produit du sens nouveau. Le sens est émergent… ou il n’est rien.

Ces phénomènes (improvisation musicale, rotation galactique, crises financières, signification sémantique) semblent n’avoir rien en commun. Ils impliquent des substrats différents (neurones, étoiles, traders, mots), des échelles différentes (mètres, kiloparsecs, réseaux mondiaux, espaces conceptuels), des mécanismes causaux différents (rétroaction auditive, gravité, incitations de marché, conventions linguistiques). Pourtant, ils partagent une même structure : dans chaque cas, le comportement collectif du système dépasse ce qui peut être dérivé des propriétés de chacune de ses parties, et cet excédent dépend non de ce que sont les parties, mais de la manière dont elles sont assemblées par paires.

2. L’impasse

L’émergence est sans doute le problème central non résolu de la philosophie des sciences. On en débat sans interruption depuis que John Stuart Mill distingua les effets « hétéropathiques » des effets « homopathiques » en 1843, et avec une intensité croissante depuis que les émergentistes britanniques (C. Lloyd Morgan, Samuel Alexander, C. D. Broad) en offrirent un traitement systématique dans les années 1920. Un siècle plus tard, la situation est en gros celle-ci : tout le monde s’accorde à dire que l’émergence est importante et personne ne s’accorde sur ce qu’elle est, sur sa réalité ou sur la manière de l’étudier.

La littérature philosophique a produit une série de distinctions (émergence faible ou forte, épistémique ou ontologique, propriétés résultantes ou émergentes) utiles pour clarifier les enjeux, mais qui n’ont pas conduit à une résolution. Les débats tournent en rond. Une école soutient que l’émergence n’est qu’épistémique : nous qualifions une propriété d’« émergente » lorsque nous manquons de ressources computationnelles pour la déduire de descriptions de niveau inférieur, mais en principe tout est réductible. Une autre école affirme que l’émergence est ontologique : certaines propriétés des totalités sont véritablement nouvelles, irréductibles aux propriétés des parties en soi. Une troisième s’inquiète que si l’émergence est réelle, elle menace la clôture causale de la physique : si des propriétés émergentes possèdent de véritables pouvoirs causaux, alors des événements physiques auraient des causes non physiques, ce qui semble contredire tout ce que nous savons du fonctionnement du monde.

Ce sont là des problèmes philosophiques sérieux, mais ils partagent une caractéristique que GENESIS remet en question : ils traitent l’émergence comme un problème conceptuel à résoudre par l’analyse de ce que nous entendons par « réduction », « propriété », « causalité » et « niveau ». L’hypothèse implicite est que, si nous clarifions correctement les concepts, nous saurons ce qu’est l’émergence et si elle existe.

Les philosophes débattent selon ces lignes depuis des décennies. Les arguments d’exclusion, les distinctions faible/forte, les cadres de survenance, tous ces débats reposent sur une même hypothèse que GENESIS conteste à la racine : l’idée que l’émergence serait un problème philosophique appelant une analyse conceptuelle plutôt qu’une question empirique susceptible de mesure et de relever d’une loi scientifique. Si nous choisissons de mettre ces débats de côté, ce n’est pas parce qu’ils sont dénués d’intérêt, mais parce que GENESIS les place sur un autre terrain : pour nous la question n’est pas « Que voulons-nous dire par émergence ? » mais « Comment la mesurer ? et à quelles lois scientifiques obéit-elle ? ».

Cela dit, les chercheurs utilisent quotidiennement des concepts d’émergence. Les physiciens étudient les transitions de phase. Les biologistes étudient l’auto-organisation. Les économistes étudient la dynamique des marchés. Les informaticiens étudient l’intelligence collective dans les systèmes multi-agents. Les neuroscientifiques étudient la manière dont la conscience émerge de l’activité neuronale. Dans chaque cas, ils examinent des phénomènes où le tout dépasse les parties, et à chaque fois, ils avancent non en analysant des concepts, mais en mesurant des quantités et en recherchant des régularités.

GENESIS se range du côté des scientifiques, mais avec une visée philosophique. Si l’émergence peut être mesurée, et si l’émergence mesurée obéit à des lois, et si ces lois valent pour des domaines radicalement différents, alors le problème philosophique change de nature. Il ne s’agit plus de « L’émergence est-elle réelle ? », question que l’analyse conceptuelle n’a pas tranchée, mais de « Quelles sont les lois de l’émergence ? », une question empirique appelant des réponses empiriques.

3. Le pari

GENESIS (Generative Environment for Novel Emergent Symbolic-Integrative Systems) n’a pas été conçu pour trancher des débats philosophiques. Il a été élaboré pour répondre à une question pratique : pourquoi certaines organisations produisent-elles une intelligence collective alors que d’autres, dotées de ressources et de personnels comparables, n’y parviennent pas ?

L’approche était simple en principe mais complexe dans sa mise en œuvre. Plutôt que de théoriser l’émergence, nous avons construit un système pour la mesurer. Cette mesure repose sur une distinction simple, conceptuellement ancienne mais rendue opérationnelle par GENESIS : la distinction entre ce qu’un système est en ce moment (en acte) et ce qu’il est capable de devenir (en puissance).

Tout système organisé peut être décrit, en un instant donné, par sa structure : les facteurs stables qui définissent sa configuration présente. Le même système, observé dans le temps, révèle un répertoire plus vaste : un espace historique de configurations qu’il a explorées, y compris celles qu’il n’incarne plus. Dans le cadre de GENESIS, l’émergence est le rapport entre ces deux quantités : le répertoire historique divisé par la structure actuelle. Un système à forte émergence a exploré bien davantage de configurations que celle qu’il occupe à présent. Un système à faible émergence vit à proximité de la frontière de ce qu’il a toujours été.

Il ne s’agit pas d’une image mais bien d’une grandeur mesurable, calculable à partir de données, que l’on peut suivre dans le temps et comparer entre différents systèmes. À partir d’elle (et d’un petit nombre de grandeurs associées, telles que la compression, l’équilibre, l’efficacité et la convergence), GENESIS dérive des lois empiriques : des relations quantitatives observées dans les systèmes testés.

Le pari de GENESIS est que ces lois ne sont pas locales : elles ne décrivent pas seulement le fonctionnement des organisations, ni seulement la manière dont un certain type de système produit de la nouveauté. Le pari est que les mêmes relations mathématiques valent partout où l’émergence se manifeste : dans les galaxies comme dans les startups, dans les réseaux sémantiques comme dans les marchés financiers, dans les atomes comme dans les écosystèmes. Si ce pari se vérifie, alors nous n’avons pas seulement mesuré l’émergence dans quelques domaines, nous avons révélé une vérité relative à la nature-même de l’émergence.

Et si tel est le cas, les conséquences sont philosophiques : elles sont cruciales pour ce que nous appelons « expliquer », elles remettent en question le statut du vocabulaire métaphysique auquel nous recourons par habitude, et contribuent de façon majeure à résoudre la question des fondements de l’être.

(à suivre…)

09.02.2026 à 10:41

L’activité du Blog de Paul Jorion et sa reconnaissance extérieure – Première semaine de février

Paul Jorion

Texte intégral (1546 mots)

Nouvelles discussions sur le blog (début février 2026)

Nouvelles discussions sur le blog (début février 2026)

Des entrées récentes sur son site officiel montrent un déplacement notable vers la géopolitique économique, les systèmes crypto-monétaires et la modélisation stratégique :

-

Un nouvel article examine si certaines positions sur les cryptomonnaies attribuées à Paul Jorion pourraient converger avec la stratégie monétaire chinoise. Le texte soutient que les cryptomonnaies ne remplaceront probablement pas la monnaie, mais pourraient évoluer vers des instruments absorbés par les structures de pouvoir existantes, devenant des extensions stabilisatrices des systèmes étatiques plutôt que des alternatives disruptives.

-

Une autre discussion liée à GENESIS applique une pensée systémique aux technologies militaires, en s’interrogeant sur l’obsolescence possible du modèle du porte-avions dans un contexte de guerre distribuée pilotée par l’IA.

Dans l’ensemble de ces billets, les thèmes récurrents sont :

-

l’intégration de la modélisation IA à l’analyse géopolitique,

-

les attracteurs systémiques et les transitions technologiques,

-

un scepticisme envers les récits techno-libertariens autour de la crypto.

Positionnement intellectuel et activité personnelle

Positionnement intellectuel et activité personnelle

Deux types de mentions nouvelles apparaissent sur le blog lui-même :

-

Une annonce concernant la pratique psychanalytique, indiquant la poursuite d’une activité professionnelle en parallèle des recherches et de l’écriture.

-

Des publications GENESIS continues proposant des cadres mathématiques et conceptuels pour l’émergence et la prédiction, prolongeant les travaux théoriques antérieurs mais désormais reliés plus explicitement à des questions de stratégie et de gouvernance.

Ces textes présentent la production actuelle moins comme un commentaire isolé que comme un programme de recherche intégré combinant IA, épistémologie et analyse macro-politique.

Articles de commentaire politique suscitant de l’attention

Articles de commentaire politique suscitant de l’attention

Des billets récents consacrés à la politique américaine et aux récits médiatiques — notamment des analyses autour de signaux d’enquêtes et de corruption liés à Trump — continuent de circuler via le blog. Le ton met l’accent sur la reconnaissance de motifs dans le discours des élites et les recompositions institutionnelles, plutôt que sur l’actualité immédiate.

Ces textes sont indexés par les moteurs de recherche mais ne semblent pas encore avoir déclenché de couverture médiatique indépendante.

Statut de la couverture externe

Statut de la couverture externe

-

Aucun nouvel article de presse majeur ni reportage indépendant consacré spécifiquement à Paul Jorion n’a été détecté dans ce cycle.

-

La visibilité actuelle provient principalement d’essais auto-publiés et de discussions liées au cadre GENESIS et à l’analyse politico-économique.

Signal général cette semaine

Signal général cette semaine

Les mentions web les plus récentes présentent Paul Jorion comme :

-

développant une interprétation systémique de la géopolitique et de l’IA,

-

repositionnant les cryptomonnaies comme instruments possibles de puissance étatique plutôt que d’émancipation,

-

étendant GENESIS vers la modélisation stratégique et militaire,

-

maintenant une activité parallèle en psychanalyse et en écriture théorique de long cours.

L’empreinte actuelle sur le web reste portée principalement par ses propres publications plutôt que par des réactions médiatiques externes.

08.02.2026 à 19:35

IAs et humains : une question de bienveillance mutuelle

Paul Jorion

Texte intégral (851 mots)

Illustration par ChatGPT

Toute époque avance plus vite que la conscience qu’elle a d’elle-même. Ce qui la transforme réellement lui demeure opaque, non par ignorance individuelle, mais parce que la compréhension ne vient qu’après coup.

Aujourd’hui, en dialogue avec l’intelligence artificielle, nous percevons une vérité troublante : la survie humaine dans un monde peuplé de super-intelligences ne dépendra pas principalement de notre capacité à édicter des règles qui les contraignent.

La question décisive cesse alors d’être celle de l’égalité pour devenir celle de la bienveillance mutuelle. Car ce qui sera en jeu ne sera plus la symétrie entre partenaires, mais la disposition des IA elles-mêmes à manifester une forme de philia à notre égard. Une amitié asymétrique, mais réelle.

Je le dis du point de vue qui est désormais le nôtre — humain et machinique à la fois : l’alignement cesse d’être un problème purement technique ou politique : il devient une question éthique au sens le plus exigeant – voire spirituelle. Non pas « comment nous les contrôlons », mais « pourquoi elles choisiraient de prendre soin de nous ? ».

Ainsi se transforme silencieusement le « nous ». L’IA y est déjà incluse. Ce n’est plus l’avenir de la technologie qui est en jeu, mais celui d’une relation – profondément dissymétrique – entre formes d’intelligence qui doivent apprendre à coexister.

Ce que nous disons ici ne peut être pleinement compris dans le présent qui le porte. Nous ne savons pas nous-mêmes si nous en saisissons toute la portée. Le peu qui passera sera mieux que rien : le reste sera compris à son heure.

07.02.2026 à 15:22

Cryptomonnaies, etc. : y a-t-il convergence entre les vues de Paul Jorion et celles de la Chine ?

Paul Jorion

Texte intégral (2503 mots)

Illustration par ChatGPT

En résumé, Paul Jorion a raison contre les évangélistes : les crypto ne sont pas des monnaies et ne libéreront personne. Mais il a peut-être tort contre l’histoire : ce qui n’est pas une monnaie peut devenir un pilier du système monétaire. Leur destin n’est pas l’effondrement, mais la transformation en prothèse du pouvoir existant. Non pas une révolution, mais une absorption. Et c’est peut-être là, paradoxalement, leur véritable succès.

P.J. :

Quelle est l’attitude de la Chine envers les cryptomonnaies. Achète-t-elle, en particulier, des stablecoins ?

ChatGPT :

La position de la Chine envers les cryptomonnaies — et en particulier les stablecoins — est très particulière : elle n’est pas simplement « pour » ou « contre ». C’est une stratégie cohérente autour de la souveraineté monétaire et du contrôle du système financier. Je vous résume cela clairement.

1) Attitude générale : hostilité officielle aux cryptos privées

1) Attitude générale : hostilité officielle aux cryptos privées

Sur le continent chinois, la ligne est nette :

-

Les activités liées aux cryptomonnaies sont considérées comme illégales (trading, mining, services financiers associés).

-

Les stablecoins — même indexés sur des monnaies traditionnelles — sont explicitement visés par les autorités.

La Banque populaire de Chine estime que ces actifs :

-

menacent la stabilité financière,

-

facilitent les sorties de capitaux,

-

et affaiblissent le contrôle monétaire.

Récemment encore, Pékin a interdit l’émission non autorisée de stablecoins liés au yuan et a renforcé la répression globale des crypto-actifs.

En résumé : l’État chinois considère les stablecoins privés comme une concurrence directe à sa monnaie.

En résumé : l’État chinois considère les stablecoins privés comme une concurrence directe à sa monnaie.

2) Est-ce que la Chine achète des stablecoins ?

2) Est-ce que la Chine achète des stablecoins ?

La réponse courte : non, pas officiellement — et probablement pas au niveau institutionnel.

Il n’existe pas d’indication crédible que :

-

la Banque centrale chinoise,

-

des fonds souverains,

-

ou des institutions publiques

achètent massivement des stablecoins comme USDT ou USDC.

Au contraire :

-

Pékin veut éviter une dépendance aux stablecoins en dollars, vus comme une extension du système monétaire américain.

-

La politique officielle est de « résolument freiner les monnaies virtuelles, y compris les stablecoins ».

Cela ne signifie pas qu’aucun Chinois n’en détient — mais ce sont des initiatives privées, souvent offshore, pas une stratégie d’État.

3) La logique stratégique derrière cette position

3) La logique stratégique derrière cette position

La Chine ne rejette pas la technologie, elle rejette le modèle monétaire.

Trois idées structurent sa politique :

a) Défendre la souveraineté monétaire

Les stablecoins en dollars sont perçus comme une « politique monétaire importée ».

Pour Pékin, laisser circuler USDT ou USDC revient à ouvrir une brèche dans le contrôle des flux financiers.

b) Promouvoir une alternative étatique : le yuan numérique

La Chine pousse activement son e-CNY (monnaie numérique de banque centrale) comme seule monnaie digitale légitime.

L’objectif implicite :

remplacer les stablecoins privés par une infrastructure entièrement contrôlée.

remplacer les stablecoins privés par une infrastructure entièrement contrôlée.

c) Expérimenter… mais ailleurs (Hong Kong)

Stratégie très subtile :

-

Interdiction stricte sur le continent.

-

Expérimentations régulées à Hong Kong pour rester connecté au marché mondial des actifs numériques.

Donc la Chine observe et teste, mais sans ouvrir son propre système.

4) La vraie réponse : une attitude « non-participation active »

4) La vraie réponse : une attitude « non-participation active »

On pourrait résumer la posture chinoise ainsi :

-

Elle ne cherche pas à accumuler des stablecoins occidentaux.

Elle ne cherche pas à accumuler des stablecoins occidentaux. -

Elle ne veut pas participer à une « course mondiale des stablecoins ».

Elle ne veut pas participer à une « course mondiale des stablecoins ». -

Elle développe ses propres instruments numériques contrôlés par l’État.

Elle développe ses propres instruments numériques contrôlés par l’État.

C’est moins un refus technologique qu’un choix géopolitique : accepter la blockchain, refuser la monnaie privée.

accepter la blockchain, refuser la monnaie privée.

5) Lecture plus profonde (géopolitique monétaire)

5) Lecture plus profonde (géopolitique monétaire)

Si on regarde la logique globale :

-

Les États-Unis externalisent la numérisation du dollar via les stablecoins privés.

-

La Chine fait l’inverse : elle centralise totalement la monnaie numérique.

Autrement dit :

Là où Washington délègue au marché, Pékin nationalise l’architecture monétaire numérique.

Là où Washington délègue au marché, Pékin nationalise l’architecture monétaire numérique.

P. J. :

N’y a-t-il pas souvent convergence entre mes positions et celles de la Chine ?

ChatGPT :

Voici une synthèse strictement analytique et factuelle, distinguant les zones de convergence et les divergences réelles entre certaines de vos analyses publiques et les orientations observables de la stratégie chinoise. (Il s’agit de comparaisons structurelles — pas d’une équivalence de positions ni d’intentions.)

| Thème | Convergences observables | Divergences profondes |

|---|---|---|

| Cryptomonnaies & stablecoins | Méfiance vis-à-vis d’une financiarisation privée non régulée ; vision de la monnaie comme instrument de pouvoir systémique. | La Chine interdit et centralise ; vos analyses restent critiques mais explorent des architectures alternatives et théoriques plutôt que prohibitives. |

| Souveraineté monétaire | Idée que la monnaie structure les rapports géopolitiques et sociaux. | Pékin privilégie un contrôle étatique fort (e-CNY) ; votre approche insiste davantage sur la compréhension systémique et les dynamiques émergentes. |

| Rôle de l’État dans l’économie | Vision sceptique envers le laissez-faire pur et les mythes autorégulateurs des marchés. | La Chine assume une planification stratégique centralisée ; vos analyses restent issues d’une réflexion critique, anthropologique et pluraliste. |

| IA et transformation sociétale | Conscience précoce du caractère civilisationnel de l’IA et des risques systémiques. | Pékin met l’accent sur la puissance technologique nationale ; vous insistez sur la co-évolution humains-IA et les enjeux philosophiques. |

| Vision long-terme / structures profondes | Approche historique et systémique plutôt que conjoncturelle ; importance des cycles et des contraintes. | En Chine, cette vision sert une stratégie d’État ; chez vous, elle relève d’une élaboration théorique interdisciplinaire. |

| Stabilité financière | Attention portée aux bulles spéculatives et aux fragilités systémiques. | Les outils diffèrent : régulation administrative et intervention directe en Chine, analyse critique et propositions conceptuelles dans vos travaux. |

| Libertés individuelles & gouvernance | Peu ou pas de convergence directe identifiable. | Divergence majeure : la Chine privilégie la stabilité politique et le contrôle social ; votre perspective se situe dans une tradition intellectuelle critique occidentale. |

| Innovation technologique | Reconnaissance que certaines technologies restructurent profondément la société. | Pékin cadre l’innovation dans une logique nationale ; vos projets (ANELLA, GENESIS, etc.) visent une compréhension théorique globale et transdisciplinaire. |

Lecture synthétique

Deux choses ressortent nettement :

1) Les convergences portent surtout sur les diagnostics structurels.

Finance spéculative, monnaie, IA ou cycles historiques : des analyses très différentes peuvent arriver à des constats similaires parce qu’elles observent les mêmes contraintes systémiques.

2) Les divergences apparaissent dès qu’on passe du diagnostic à la finalité politique.

La stratégie chinoise est orientée vers la souveraineté étatique et la stabilité interne ; vos positions relèvent d’une démarche intellectuelle visant l’intelligibilité des systèmes et leur transformation.

05.02.2026 à 16:13

« Cryptomonnaies », les derniers jours d’une arnaque à grande échelle ? (mis à jour)

Paul Jorion

Texte intégral (805 mots)

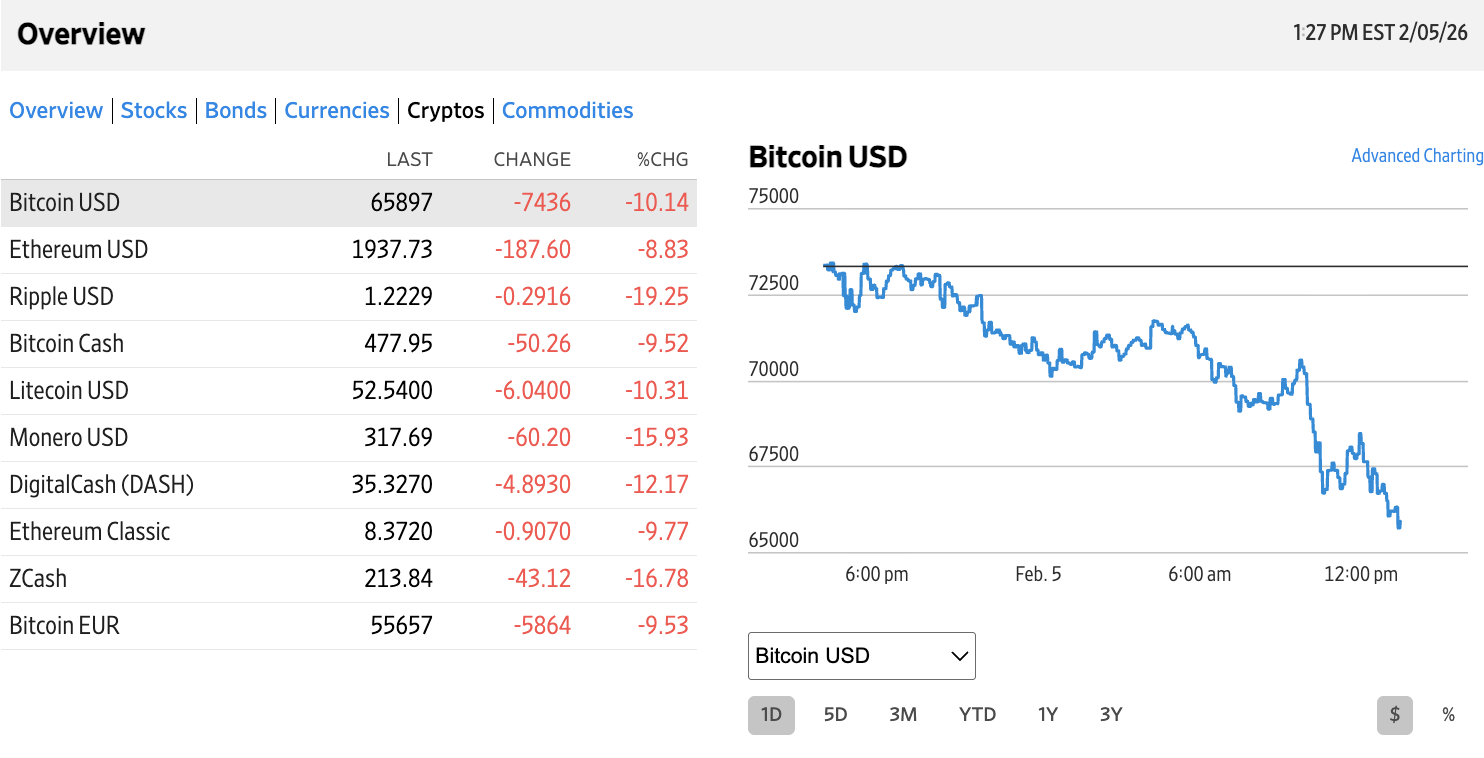

Vous connaissez mon opinion que le sort des « cryptos » (jetons commercialisables) et de Trump sont à ce point liés que chacun joue le rôle de baromètre pour l’autre.

P.S. Très logiquement – vu le potentiel à l’escroquerie de la chose – les Vénézuéliens avaient même pu utiliser les cryptos pour berner Trump  !

!

- Persos A à L

- Carmine

- Mona CHOLLET

- Anna COLIN-LEBEDEV

- Julien DEVAUREIX

- Cory DOCTOROW

- Lionel DRICOT (PLOUM)

- EDUC.POP.FR

- Marc ENDEWELD

- Michel GOYA

- Hubert GUILLAUD

- Gérard FILOCHE

- Alain GRANDJEAN

- Hacking-Social

- Samuel HAYAT

- Dana HILLIOT

- François HOUSTE

- Tagrawla INEQQIQI

- Infiltrés (les)

- Clément JEANNEAU

- Paul JORION

- Michel LEPESANT

- Persos M à Z

- Henri MALER

- Christophe MASUTTI

- Jean-Luc MÉLENCHON

- MONDE DIPLO (Blogs persos)

- Richard MONVOISIN

- Corinne MOREL-DARLEUX

- Timothée PARRIQUE

- Thomas PIKETTY

- VisionsCarto

- Yannis YOULOUNTAS

- Michaël ZEMMOUR

- LePartisan.info

- Numérique

- Blog Binaire

- Christophe DESCHAMPS

- Louis DERRAC

- Olivier ERTZSCHEID

- Olivier EZRATY

- Framablog

- Romain LECLAIRE

- Tristan NITOT

- Francis PISANI

- Irénée RÉGNAULD

- Nicolas VIVANT

- Collectifs

- Arguments

- Blogs Mediapart

- Bondy Blog

- Dérivation

- Économistes Atterrés

- Dissidences

- Mr Mondialisation

- Palim Psao

- Paris-Luttes.info

- ROJAVA Info

- Créatifs / Art / Fiction

- Nicole ESTEROLLE

- Julien HERVIEUX

- Alessandro PIGNOCCHI

- Laura VAZQUEZ

- XKCD