25.02.2026 à 16:50

One Health : un label parfois flou, mais une approche scientifique éprouvée

Marisa Peyre, Deputy head of ASTRE research unit, epidemiologist, Cirad

François Roger, Directeur régional Asie du Sud-Est, vétérinaire et épidémiologiste, Cirad

Texte intégral (2128 mots)

La pandémie de Covid-19 a révélé l’urgence de repenser notre approche de la santé. Aujourd’hui, « One Health », qui relie la santé humaine, animale et environnementale, s’est imposée dans les discours, mais fait parfois l’objet de confusion, voire de détournements. Bien mise en œuvre, elle constitue pourtant une conception éprouvée pour renforcer la prévention sanitaire mondiale.

Pandémies, résistance antimicrobienne, maladies vectorielles, effondrement de la biodiversité, dégradation des sols, pollutions chimiques, crises alimentaires… nous avons aujourd’hui une conscience aiguë des liens étroits entre enjeux de santé humaine, animale et environnementale. Face à la multiplication des crises sanitaires, environnementales et climatiques, le concept « One Health » est devenu central pour les analyser et y répondre.

Issues de réflexions anciennes, ses bases fondatrices actuelles ont été posées par les principes de Manhattan, formulés en 2004 lors de la conférence « One World, One Health » organisée par la Wildlife Conservation Society. Ils reconnaissent l’interdépendance étroite entre la santé humaine, la santé animale et la santé des écosystèmes, et appellent à une approche intégrée pour prévenir les crises sanitaires, environnementales et sociales. Cette vision, qui dépasse la seule gestion des risques sanitaires, invite à repenser les modes de production, de consommation et de gouvernance. L’enjeu ? Préserver durablement les socioécosystèmes et les communautés qui en dépendent.

Malgré l’intérêt croissant que le One Health suscite, son utilisation en recherche et ses applications restent floues et souvent mal comprises. Trop souvent, il est réduit à un slogan politique ou à une gestion biomédicale des zoonoses, sans prendre en compte l’interdépendance des facteurs écologiques, sociaux et économiques. Ces derniers conditionnent pourtant la santé globale et la dynamique des crises sanitaires.

Un cadre opérationnel de prévention

Depuis plus de vingt ans, des initiatives portées par la science se développent pour mettre en œuvre de façon concrète l’approche « One Health ». Au Cirad, des travaux sur les maladies animales émergentes, les interfaces faune-élevage-humains et les systèmes agricoles tropicaux ont mis en évidence, dès les années 2000, les liens étroits entre santé, biodiversité et usages des territoires.

Nos recherches ont peu à peu intégré les dimensions environnementales, sociales et alimentaires. L’enjeu est de passer d’une logique de gestion des crises à une approche de prévention des risques d’émergence. En 2021, une coalition internationale portée par la recherche et baptisée PREZODE a été créée pour mener des opérations de prévention fondée sur l’approche One Health.

Elle intervient en Afrique, en Asie, en Amérique latine et dans les Caraïbes pour comprendre, réduire et détecter de façon précoce les risques en santé et éviter les épidémies.

Gestion des écosystèmes, agroécologie et surveillance sanitaire

En Guinée, ses équipes ont ainsi observé comment les pratiques agricoles intensives affectant la ressource forestière favorisaient l’intensification des contacts humains-faune. Ces contacts favorisent la transmission entre humains et animaux sauvages de maladies zoonotiques, comme les fièvres hémorragiques (Ebola, Lassa, Marburg).

Avec les communautés locales, des stratégies de prévention basées sur la gestion des écosystèmes ont été mises en place pour limiter le risque d’émergence de nouvelles épidémies.

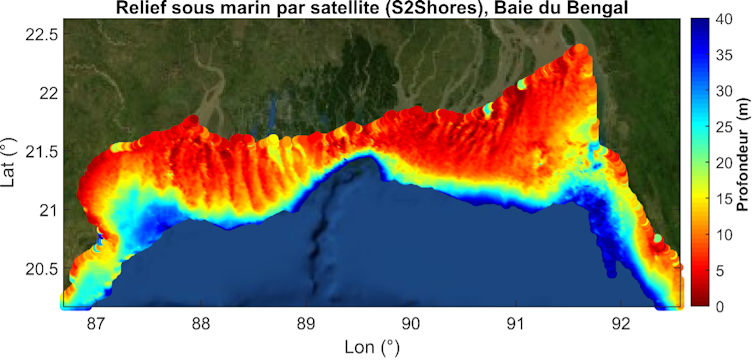

À Madagascar, des scientifiques du Cirad, en partenariat avec l’ONG Pivot et l’Institut de recherche et de développement (IRD), ont développé une méthode de surveillance intégrée des risques sanitaires. Elle combine les données vétérinaires, humaines et environnementales, pour mieux anticiper les épidémies émergentes.

Au Gabon, dans le cadre d’un projet qui soutient les associations de chasseurs dans leur gestion des ressources forestières – y compris la biodiversité – nous avons mis en place un système de surveillance communautaire pour détecter très rapidement les évènements sanitaires suspects. Ceci a été mené en collaboration, avec le Centre interdisciplinaire de recherche médicale de Franceville (CIRMF).

En Asie du Sud-Est, les actions s’inscrivent dans une approche agroécologique qui articule les enjeux de santé et de gouvernance territoriale. Elles visent à accompagner des transitions agricoles et à réduire les pressions sur les écosystèmes (déforestation, usage des intrants, artificialisation). L’enjeu est d’améliorer la résilience des systèmes alimentaires locaux et la prévention des risques sanitaires, à l’interface entre humains, animaux et environnement.

Ces démarches reposent sur des diagnostics territoriaux participatifs, le croisement de données agricoles, écologiques et sanitaires et le soutien à des pratiques agroécologiques adaptées aux contextes locaux (diversification des cultures, gestion intégrée des élevages, restauration des paysages). L’objectif est de faire de l’agroécologie un levier pour prévenir les émergences infectieuses, améliorer la sécurité alimentaire et permettre un développement territorial durable, en cohérence avec l’approche One Health.

Une gouvernance fragmentée

Ces exemples illustrent l’efficacité d’une prévention alliant une vision systémique des enjeux sanitaires et une gouvernance partagée entre acteurs locaux, scientifiques et autorités gouvernementales. Malgré tout, de nombreux obstacles subsistent.

La fragmentation institutionnelle reste l’un des plus grands défis. À toutes les échelles, les secteurs de la santé, de l’agriculture et de l’environnement ne communiquent pas assez, ce qui freine la mise en œuvre d’une gouvernance efficace. La voix des communautés est rarement sollicitée. Les projets One Health sont, en outre, souvent financés à court terme et souvent fléchés sur les zoonoses uniquement. Cela alimente le flou autour du concept et n’encourage pas son appropriation par les pays qui en auraient pourtant le plus besoin.

Les acteurs de terrain soulignent que l’accès en temps utile à des données locales et nationales – depuis leur collecte jusqu’à leur partage et leur analyse – est central. Ce sont elles qui permettent de renforcer la surveillance et la prévention des maladies zoonotiques et construire des systèmes plus résilients, capables d’anticiper et d’atténuer en temps réel les menaces sanitaires actuelles et futures. Il est nécessaire, pour cela, d’être doté d’infrastructures de données solides et partagées entre les secteurs concernés, et de les mobiliser pour développer des outils de modélisation prédictive pertinents. Mais pas seulement : une réponse rapide, adaptée et coordonnée au niveau local peut suffire à prévenir les risques d’émergence.

Risque de « One Health washing »

Sans une collaboration efficace entre les secteurs, le risque est de voir se développer un « One Health washing ». Il existe de nombreux projets qui se revendiquent du concept, mais sans mettre en place de travaux ou d’actions réellement intégrées.

C’est le cas de publications traitant de pathogènes zoonotiques, mais uniquement focalisées sur la santé humaine. Idem pour certaines initiatives agricoles qui utilisent le terme abusivement. Toujours dans ce cadre, certaines études se réclament de l’approche One Health principalement au titre d’une mobilisation interprofessionnelle – par exemple via l’implication de réseaux vétérinaires dans le diagnostic humain – sans pour autant mettre en œuvre un véritable design d’étude intégrant conjointement des données humaines, animales et environnementales, ni analyser les effets d’une action spécifique sur les différents secteurs.

Pour autant, ces projets sont importants. Ils peuvent contribuer à renforcer des approches plus intégrées de la santé. À ce titre, ils constituent des étapes intermédiaires vers un One Health plus abouti. Le principal risque réside plutôt dans l’usage extensif et peu exigeant du terme One Health, qui, en devenant un label fourre-tout, finit par en affaiblir la portée scientifique, opérationnelle et politique.

Dans ce contexte, clarifier les fondements et les modalités d’application du One Health est essentiel. C’est l’objectif de l’Atlas One Health, qui propose une lecture de cette approche articulant santé humaine, animale, des écosystèmes, mais aussi agricultures et systèmes alimentaires, dynamiques sociales, gouvernance et territoires. Avec des études de cas, des cadres analytiques et des outils issus du terrain, cet ouvrage vise à faire du One Health un véritable cadre d’action collective et de prévention.

L’un des défis les plus importants est d’intégrer la dimension sociale et de genre pour garantir des solutions inclusives et efficaces. Ceci évitera des interventions mal adaptées qui risqueraient de creuser davantage les inégalités. En milieu rural notamment, les femmes jouent un rôle clé dans l’alimentation, l’approvisionnement en eau et la gestion des ressources naturelles. Elles restent pourtant souvent invisibles dans les politiques de santé publique et de prévention.

Un investissement plus qu’un coût

Le financement de la prévention One Health doit être considéré comme un investissement stratégique, et non comme un coût. Moins spectaculaires que la gestion des crises sanitaires, les approches préventives sont largement plus rentables et engendrent des co-bénéfices majeurs : adaptation et atténuation du changement climatique, systèmes agricoles plus durables, réduction des intrants chimiques, protection de la biodiversité et amélioration de la qualité de l’alimentation.

Les travaux menés par le Cirad, l’initiative PREZODE et toute la communauté internationale en faveur de ces principes s’accordent sur le constat que ces actions renforcent simultanément la santé, les moyens de subsistance et la résilience des territoires. Or, la prévention demeure trop dépendante de financements internationaux ponctuels : elle doit être inscrite dans des budgets nationaux pluriannuels intégrés aux politiques agricoles, sanitaires, environnementales et alimentaires, afin de soutenir des transformations structurelles durables.

Anticiper les crises demande de repenser fondamentalement nos systèmes. Une approche « One Health » transformatrice nécessite un engagement politique durable, de la coopération internationale et une volonté commune d’intégrer les dimensions sociales et écologiques dans la gestion des risques sanitaires. Un travail de longue haleine qui est déjà en marche. Ces messages seront portés au cours des évènements organisés par PREZODE lors du Sommet One Health, qui se tiendra à Lyon (Rhône), le 7 avril 2026 sous la présidence française du G7.

Marisa Peyre est membre de PREZODE

François Roger est affilié au CIRAD, partenaire du programme PREZODE mentionné dans cet article.

25.02.2026 à 16:49

Realpolitik et fiabilité : le dilemme des négociations avec la République islamique d’Iran

Djamchid Assadi, Professeur associé au département « Digital Management », Burgundy School of Business

Texte intégral (2749 mots)

Négocier avec l’Iran sur son programme nucléaire est possible, mais il convient, pour obtenir des résultats tangibles, de s’appuyer sur les leçons du passé et sur les réflexions théoriques conduites par divers politologues majeurs des dernières décennies.

Le dilemme est ancien et pourtant intact : négocier est parfois nécessaire pour éviter le pire. Mais les démocraties peuvent-elles, sans affaiblir les principes mêmes qu’elles prétendent défendre, négocier avec des régimes régulièrement mis en cause par des organisations internationales pour violations des droits fondamentaux de la même façon qu’elles négocient entre elles ?

Des compromis signés seront-ils respectés ?

Le régime auquel nous pensons ici en premier lieu est la République islamique d’Iran, et les mises en cause évoquées ci-dessus ne relèvent pas d’une appréciation polémique : elles sont régulièrement documentées par des organisations indépendantes comme Amnesty International ou Reporters sans frontières, par des think tanks comme Freedom House, ainsi que par divers indicateurs internationaux sur la démocratie et l’État de droit.

Chez Raymond Aron, la tension entre valeurs démocratiques et possibilité de négocier avec des régimes autoritaires n’oppose pas naïvement morale et intérêt, mais deux exigences constitutives de la politique étrangère : la prudence stratégique – éviter la guerre dans un monde anarchique – et la fidélité à des normes sans lesquelles l’ordre international ne serait qu’un rapport de forces dépourvu de légitimité.

La question n’est donc pas de savoir s’il faut dialoguer avec des régimes à faible redevabilité institutionnelle et à structure décisionnelle opaque. Mais si l’on admet que la négociation peut être nécessaire pour prévenir des risques majeurs, encore faut-il s’interroger sur les conditions de fiabilité des engagements qui en résultent. Comment s’assurer que les compromis conclus ne restent pas des promesses réversibles ?

L’histoire offre des illustrations concrètes de ce risque de réversibilité. En 1938, la France et le Royaume-Uni négocient avec l’Allemagne nazie d’Adolf Hitler les accords de Munich, acceptant l’annexion des Sudètes – région frontalière de la Tchécoslovaquie majoritairement peuplée d’Allemands – dans l’espoir de préserver la paix européenne. Faute de mécanismes contraignants de mise en œuvre et de garanties crédibles, les accords offrent simplement un répit stratégique à Hitler, qu’il exploite pour consolider son réarmement et poursuivre son expansion territoriale, avant d’envahir la Pologne en 1939.

Dans les années 1990, les Nations unies, l’Union européenne (UE) et les États-Unis négocient avec le président serbe Slobodan Milosevic plusieurs cessez-le-feu destinés à mettre fin aux opérations coercitives en Bosnie. Ces engagements restent seulement partiellement appliqués tant qu’ils ne sont pas adossés à un dispositif contraignant, celui des accords de Dayton de 1995, soutenus par une présence militaire de l’Otan chargée d’en garantir l’exécution. Dans les deux cas, la leçon est claire : sans dispositifs de vérification et de contrainte capables de rendre la défection coûteuse, la négociation risque de demeurer un levier tactique plutôt qu’un instrument de stabilisation durable.

La question centrale devient alors celle de la crédibilité des engagements issus d’une négociation destinée à prévenir un risque stratégique majeur : comment s’assurer que les promesses formulées ne demeurent pas réversibles ? Les penseurs libéraux des relations internationales ont précisément analysé cette question.

L’éclairage de la science politique

Dans After Hegemony (1984, sorti en français en 2015 aux éditions de l’Université de Bruxelles sous le titre Après l’hégémonie, Coopération et désaccord dans l’économie politique internationale), Robert Keohane n’aborde pas directement la négociation, mais les conditions institutionnelles qui rendent des engagements internationaux crédibles dans un système anarchique, dépourvu d’autorité centrale. Il montre qu’un accord ne devient fiable que lorsque des mécanismes institutionnels rendent observable et coûteuse la défection des engagements pris. Transparence, inspections, répétition des interactions : ces dispositifs permettent de vérifier le respect des engagements et de transformer un compromis politique en obligation crédible. Keohane prolonge cette réflexion dans Power and Governance in a Partially Globalized World (2002), confirmant le rôle central des institutions dans la fiabilité des engagements internationaux.

Andrew Moravcsik, dans The Choice for Europe (1998), met l’accent sur l’ancrage domestique des engagements. Selon son approche libérale intergouvernementale, un accord international ne devient solide que s’il est soutenu, à l’intérieur même du régime signataire, par des acteurs ayant intérêt à son maintien. Lorsque le coût politique interne d’un abandon des engagements augmente, la crédibilité externe de ces engagements s’en trouve renforcée.

Anne-Marie Slaughter, dans A New World Order (2004), insiste pour sa part sur la mise en œuvre transgouvernementale des engagements. Un compromis ne devient robuste que s’il s’inscrit dans des réseaux d’autorités administratives, de régulateurs et d’agences spécialisées capables d’en assurer l’application concrète et la continuité au-delà des alternances politiques. À défaut de tels relais institutionnels, un engagement obtenu au sommet demeure fragile.

Il ressort de ces analyses qu’un engagement issu de négociations internationales n’est crédible que s’il réunit plusieurs conditions complémentaires : être vérifiable par des mécanismes de transparence et d’inspection ; s’inscrire dans des interactions répétées qui rendent la défection stratégiquement coûteuse ; être soutenu à l’intérieur du régime signataire par des acteurs ayant intérêt à son maintien ; et être relayé par des réseaux transgouvernementaux – administratifs, régulatoires ou judiciaires – capables d’en assurer l’application et la continuité au-delà des alternances politiques.

Hannah Arendt apporte un éclairage complémentaire. Dans les Origines du totalitarisme (1951), elle montre que dans certains systèmes politiques, la responsabilité décisionnelle se dilue dans des structures bureaucratiques et idéologiques peu transparentes. Lorsque les centres effectifs de décision sont difficiles à identifier et que les mécanismes de redevabilité sont limités, la logique même de l’engagement politique s’en trouve fragilisée. La question n’est plus seulement celle de la volonté déclarée, mais celle de la capacité institutionnelle à garantir la continuité et l’imputabilité des décisions prises.

Les négociations sur le nucléaire iranien et leurs faiblesses

Le dossier du programme nucléaire de la République islamique d’Iran peut être relu à l’aune de ces critères. En novembre 2004, sous la présidence de Mohammad Khatami, présenté comme modéré par rapport aux radicaux du régime, l’accord de Paris formalise une suspension volontaire d’activités sensibles sous vérification internationale. Le dispositif répond partiellement à l’exigence de vérifiabilité. Toutefois, l’élection en 2005 d’un président nettement plus radical, Mahmoud Ahmadinejad, modifie la trajectoire : certaines activités reprennent dès 2005, puis l’enrichissement est relancé en 2006. L’épisode suggère que l’engagement n’est pas suffisamment soutenu par des acteurs internes capables d’en garantir la continuité, et que le coût politique domestique d’une révision apparaît limité.

La dynamique se rejoue avec le Joint Comprehensive Plan of Action (JCPoA) de 2015, dit Accord de Vienne. L’accord prévoit des mécanismes de contrôle détaillés sous supervision de l’Agence internationale de l’énergie atomique et s’inscrit dans un cadre multilatéral. Jusqu’en 2018, l’AIEA certifie à plusieurs reprises que la République islamique respecte les obligations techniques prévues par le texte. En mai 2018, lors du premier mandat de Donald Trump, les États-Unis annoncent pourtant leur retrait unilatéral, l’administration estimant que l’accord ne traitait ni du programme balistique iranien ni des clauses dites « sunset » – dispositions prévoyant l’expiration progressive de certaines limitations nucléaires après un délai déterminé. À la suite de ce retrait, Téhéran engage des dépassements progressifs des seuils d’enrichissement fixés par le JCPOA. La réversibilité apparaît alors des deux côtés : retrait américain d’un engagement multilatéral d’une part, non-respect graduel de certaines clauses par Téhéran d’autre part.

Cette fragilité tient aussi au faible ancrage institutionnel transversal de l’accord : contesté par une partie du Congrès américain et par des acteurs influents au sein du système politico-stratégique iranien, il ne créait pas de coûts domestiques suffisamment élevés pour rendre la défection politiquement dissuasive.

Le dossier des arrestations de ressortissants binationaux éclaire plus spécifiquement le cas de la République islamique d’Iran. Ces dernières années, plusieurs binationaux – notamment Nazanin Zaghari-Ratcliffe (britannique-iranienne) ou Fariba Adelkhah (franco-iranienne) – ont été arrêtés et détenus en Iran dans des contextes de tension diplomatique. Parallèlement, des échanges de prisonniers ont eu lieu, comme celui impliquant le chercheur américain Xiyue Wang en 2019 ou l’accord d’échange conclu avec Washington en 2023. Cette coexistence d’un dialogue diplomatique et de mesures coercitives suggère que les interactions ne sont pas pleinement encadrées par des mécanismes stabilisés et réciproques comparables à ceux existant entre États liés par des accords formalisés d’extradition. Dans ces différents domaines – nucléaire et détentions – la négociation demeure exposée aux variations du rapport de forces plutôt qu’inscrite dans une architecture institutionnelle consolidée.

La question n’est donc pas de qualifier moralement ces séquences, mais d’évaluer si les engagements pris répondent aux critères de crédibilité précédemment établis.

Les conditions d’une négociation fiable

Si l’on souhaite maintenir la négociation tout en renforçant sa fiabilité, plusieurs pistes peuvent être envisagées dans le cadre théorique esquissé plus haut.

Premièrement, renforcer les dispositifs de vérification et inscrire les engagements dans des interactions réellement répétées et conditionnelles, de manière à accroître le coût stratégique d’une défection.

Deuxièmement, structurer les accords de manière à créer des incitations internes à leur continuité. Il ne faut pas se leurrer : les négociateurs occidentaux ne peuvent « fabriquer » des relais domestiques au sein de la République islamique d’Iran. En revanche, ils peuvent concevoir des engagements qui s’inscrivent dans des lignes de différenciation déjà présentes au sein du système politico-institutionnel. Les séquences nucléaires conduites sous la présidence de Mohammad Khatami (1997-2005), puis lors de la négociation du JCPOA en 2013-2015, ont reposé sur l’existence de sensibilités plus favorables à l’ouverture internationale.

Lorsque des bénéfices économiques, scientifiques ou techniques sont clairement identifiables, ils tendent à renforcer ces segments administratifs et économiques ayant intérêt à la stabilité des engagements. Des dynamiques comparables ont été observées ailleurs : les accords d’Helsinki de 1975 ont offert des points d’appui normatifs aux réformateurs d’Europe de l’Est dans les années 1980 ; l’ouverture économique de la Chine à partir de 1978, puis son accession à l’OMC en 2001 ont consolidé des coalitions technocratiques favorables à l’intégration internationale ; la normalisation américano-vietnamienne engagée en 1995 a accompagné des réformes économiques internes. Toutefois, plus les fractions conservatrices et radicales deviennent prédominantes, plus cette condition devient difficile à satisfaire : la crédibilité d’un accord dépend alors de sa capacité à produire des coûts politiques internes suffisants pour dissuader les radicaux de le remettre en cause.

Troisièmement, élargir les réseaux transgouvernementaux au-delà du seul niveau exécutif. Certes, des mécanismes existent déjà : l’Agence internationale de l’énergie atomique (AIEA) assure un contrôle technique central. Mais l’expérience montre que ces dispositifs ne suffisent pas toujours à dissiper durablement la défiance. La révélation tardive de certains sites nucléaires non déclarés – comme Natanz en 2002 ou Fordow en 2009 – a illustré les limites d’un système reposant principalement sur la déclaration et l’inspection encadrée.

En outre, la robustesse d’un accord nucléaire dépend aussi de son articulation avec d’autres préoccupations stratégiques, notamment les capacités balistiques ou le soutien logistique et financier à certains groupes armés désignés comme terroristes par plusieurs États. Lorsque ces dimensions restent en dehors du cadre négocié, elles alimentent la contestation politique de l’accord. D’où l’intérêt d’une architecture plus dense associant autorités de régulation, réseaux techniques et canaux académiques – y compris au sein de la diaspora iranienne – afin de renforcer l’environnement institutionnel dans lequel les engagements sont appliqués.

Une telle approche ne relève ni du contournement ni de l’ingérence. Elle vise à inscrire la négociation dans une profondeur institutionnelle susceptible d’en réduire la fragilité.

La realpolitik, chez Aron, n’est pas l’abandon des principes ; elle est l’acceptation lucide des contraintes. Mais lorsqu’elle se limite à des arrangements temporaires sans architecture institutionnelle capable d’en garantir la continuité, elle risque d’affaiblir la crédibilité normative qu’elle cherche précisément à préserver.

La question n’est donc pas de savoir s’il faut négocier avec la République islamique d’Iran. Elle est de déterminer si la négociation peut être structurée de manière à rendre les engagements vérifiables, coûteux à violer et institutionnellement consolidés – condition pour que la prudence stratégique ne se transforme pas, malgré elle, en normalisation fragile.

Djamchid Assadi ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

25.02.2026 à 16:49

Le rôle des entreprises dans le processus de paix colombien

Frédéric Martineau, PhD - Relations Internationales. Spécialisation en Diplomatie des affaires, Centre d'études diplomatiques et stratégiques (CEDS)

Texte intégral (2433 mots)

Les entreprises colombiennes se sont impliquées dans le processus de paix, depuis les premiers tâtonnements des années 1980 jusqu’aux négociations de La Havane avec les FARC en 2016. Cet engagement a fait du secteur privé un acteur désormais incontournable mais loin d’être homogène. Malgré l’accord de 2016, la paix demeure inachevée et la pérennité de l’engagement entrepreneurial dépend en bonne partie de l’environnement institutionnel.

À l’approche de l’élection présidentielle qui se déroulera en mai 2026, et alors que le président en exercice Gustavo Petro ne peut pas se représenter, le candidat de son parti (la coalition Pacto Historico, classée à gauche), Ivan Cepeda, se trouve actuellement en tête des sondages.

Les menaces exprimées par Donald Trump à l’encontre du gouvernement colombien, qui se sont renforcées dans la foulée de l’enlèvement de Nicolas Maduro au Venezuela voisin, participent sans doute de la désaffection populaire pour le principal candidat de la droite, Abelardo de la Espriella. Il n’en reste pas moins que les intentions de vote témoignent également de l’indulgence de la population colombienne à l’égard du parti au pouvoir, en dépit de l’échec de l’initiative de « paix totale » du président actuel.

Cette politique ambitieuse visait à négocier simultanément avec tous les groupes armés encore actifs dans le pays (guérillas, paramilitaires ou organisations criminelles) afin de parachever le processus de paix sur l’ensemble du territoire colombien. Rappelons que les autorités de Bogota et les Forces armées révolutionnaires de Colombie (FARC) ont signé en 2016 à La Havane un accord historique censé mettre fin à des décennies de guerre civile sanglante dont le bilan humain est évalué à au moins 450 664 morts, 121 768 disparus et 7,7 millions de déplacés.

Une paix inachevée

Depuis 2016, en dépit de l’accord, la violence continue de gangrener le pays. Elle est entretenue par l’Armée de libération nationale (ELN), groupe armé de gauche non signataire de l’accord de 2016 ; par des factions dissidentes des FARC, lesquelles ont été majoritairement démobilisées ; mais surtout par des organisations mafieuses devenues multicartes (drogue, trafic d’êtres humains, minerais) et de véritables multinationales du crime.

Le Clan del Golfo, héritier des groupes paramilitaires très à droite du spectre politique qui avaient pris part à la guerre civile contre les FARC, gère un chiffre d’affaires annuel de près de 18 milliards de dollars (plus de 15 milliards d’euros). C’est la plus grande organisation criminelle du pays ; elle cohabite avec une multitude de gangs locaux et avec les groupes armés dissidents. Les idéologies marxistes qui animaient les guérillas au début des années 1960 se sont progressivement transformées en un pragmatisme mêlant collaboration avec les cartels et prébendes du trafic de cocaïne. Le narratif révolutionnaire a disparu au profit du dieu Dollar.

Face à cette réalité persistante, il est instructif de retracer l’évolution du rôle joué par les entreprises dans ce processus de paix inachevé. En effet, dès le début des pourparlers et jusqu’à la signature des accords de La Havane, les entreprises ont joué un rôle important dans le processus de construction de la paix.

Aujourd’hui encore, elles demeurent des acteurs clés. Cependant, leur engagement n’est ni homogène, ni linéaire, ni constant. Les fondements structurels ou idéologiques de cette participation répondent à des intérêts économiques, territoriaux et politiques variés et complexes, comme le montre l’étude empirique menée par Rettberg et Aceros.

La diplomatie des affaires au service de la consolidation de la paix

Les modèles conceptuels de la diplomatie ont largement évolué. Le constat de l’inefficacité de la seule médiation gouvernementale pour la résolution des conflits avait conduit l’ancien diplomate américain Joseph Montville à développer dans les années 1980 la notion de « diplomatie parallèle ». Elle traduit la partie informelle qui sous-tend les relations internationales.

Dans les années 1990, le modèle à voies multiples proposé par Louise Diamond et complété par l’ambassadeur John McDonald reflète mieux la complexité des diplomaties alternatives et l’augmentation des parties prenantes qui y participent. Les entreprises et la diplomatie des affaires deviennent une voie possible et crédible pour la résolution des conflits.

Le début de la décennie suivante offre une reconnaissance internationale du rôle accru des entreprises dans la bonne marche du monde. Le programme Global Compact des Nations unies tient compte de la puissance économique des multinationales – dont le chiffre d’affaires dépasse parfois le PIB de certains États – et les considère comme des acteurs essentiels pour atteindre certains objectifs de développement durable de l’Agenda 2030, notamment l’ODD 16, qui consiste à s’engager pour la paix, la justice et des institutions efficaces. Le plan stratégique (2024-2025) embarque les PME dans le programme.

Ce n’est pas seulement la philanthropie qui incite les entreprises à s’impliquer dans un processus de consolidation de la paix. Surtout lorsque le pays en conflit est riche en ressources renouvelables (terres agricoles fertiles, potentiel hydroélectrique, forêts…) ou en réserves épuisables (pétrole, gaz, charbon, or, diamants…).

Néanmoins, quel que soit l’intérêt qu’elles y trouvent (marges conséquentes, parts de marché, avantage concurrentiel, croissance rapide, RSE), les entreprises jouent indéniablement un rôle. Celui-ci peut être positif ou négatif. Elles ne sont en effet ni facilitatrices de la résolution d’un conflit par nature ni a contrario nécessairement alimentatrices de tensions existantes. Leur implication est toujours nuancée, elle dépend du contexte dans lequel elles opèrent. Les ONG documentent autant de cas montrant leurs apports à la construction de la paix que leurs comportements prédateurs.

Dans le cas de la Colombie, des acteurs du secteur privé ont participé aux négociations et à la signature des accords de paix avec les FARC en 2016. Ce succès représentait l’espoir de mettre fin au conflit le plus long du monde occidental, impliquant à partir des années 1990, la communauté internationale, qui apporta soutien et coopération aux autorités du pays.

Un référendum rejeta dans un premier temps le traité de paix. Mais, il fut révisé et approuvé par le Congrès colombien (plutôt que soumis à une autre validation populaire), sous le nom d’accord du théâtre Colón le 24 novembre 2016.

Une implication progressive des entreprises

L’engagement des entreprises colombiennes dans le processus de paix s’inscrit dans une trajectoire marquée par une intensification progressive et une professionnalisation croissante.

La période 1982-1998 constitue une phase d’apprentissage timide. En 1984, dans un discours télévisé, le président Belisario Betancur évoque l’importance des milieux d’affaires dans la recherche d’une solution pacifique au conflit. Cette reconnaissance marque le début d’une action accrue des entrepreneurs au sein des sphères publique et politique, dans un contexte marqué par des processus de négociation avec les groupes armés. Des personnalités du monde des affaires sont directement impliquées : Nicanor Restrepo, alors à la tête du Grupo Empresarial Antioqueño (GEA), un conglomérat regroupant près de 125 entreprises, est nommé Haut Commissaire pour la paix. À partir de 1992, le gouvernement prélève des impôts pour financer le processus de paix, une contribution largement acceptée par les entreprises.

Le tournant survient au milieu des années 1990 lorsque l’explosion de la violence multiplie les coûts pour les entreprises. Celles-ci soutiennent alors les marches citoyennes et le Mandat pour la paix, un vote symbolique non officiel lors des élections locales d’octobre 1997, qui recueille dix millions de voix. Les Colombiens expriment ainsi leur désir de voir la fin du conflit armé, faisant de ce geste l’une des plus grandes mobilisations citoyennes pour la paix de l’histoire latino-américaine. Néanmoins, peu d’entrepreneurs désirent faire partie intégrante de l’effort national pour la paix. Le conflit épargnant la majeure partie du tissu économique, qui est concentré dans les quatre grandes métropoles (Bogota, Barranquilla, Cali, Medellin), nombre d’entre eux adoptent une position prudente ou attentiste.

L’administration Pastrana (1998-2002) marque un changement radical. Le conflit affecte désormais directement les entreprises avec l’explosion du nombre d’enlèvements, dont près de 15 % touchent la communauté des affaires. Les FARC imposent, sur les territoires qu’elles contrôlent directement ou indirectement, une taxe de 10 % sur les actifs dépassant un million de dollars (849 000 euros environ), tandis que les dépenses de sécurité privée explosent pour représenter de 4 à 6 % des budgets d’entreprise. Les entrepreneurs participent activement aux négociations de San Vicente del Caguán, créent des think tanks et multiplient les actions locales.

Des initiatives structurées émergent et essaiment, comme le réseau national de programmes régionaux de développement et de paix. Elles tentent de s’attaquer aux causes structurelles de la violence que sont la pauvreté, l’accès à l’éducation et à la santé en associant les entreprises, l’Église (souvent la plus légitime à l’échelon territorial), les organisations internationales et les communautés locales.

Toutefois, l’échec du processus et l’escalade de la violence érodent progressivement ce soutien.

L’illusion d’une victoire militaire

Sous l’administration Uribe (2002-2010), l’approche se durcit. Le président privilégie la stratégie sécuritaire et la lutte armée. Le secteur privé soutient massivement cette orientation en acceptant une réforme fiscale sévère, payant simultanément pour la paix et la guerre. La réduction des homicides et des enlèvements améliore la perception de sécurité, conduisant certains entrepreneurs à envisager une solution purement militaire. Mais ils réalisent finalement qu’une paix durable ne peut résulter d’une politique exclusivement sécuritaire. Une étude de l’Université de Los Andes auprès de 1 113 entreprises révèle qu’en l’absence de violence, les entreprises investiraient davantage, confirmant l’existence d’un important « dividende de la paix ».

L’administration Santos (2012-2016) représente l’apogée de l’implication entrepreneuriale. Le gouvernement consulte régulièrement la communauté des affaires dès la phase exploratoire secrète. Les entreprises financent discrètement les contacts préliminaires et participent directement aux négociations. Une délégation de huit organisations patronales se rend à La Havane en novembre 2015, aboutissant à la création du Conseil d’entreprises pour la paix durable. Néanmoins, cette implication ne fait pas consensus. Certains entrepreneurs, craignant des concessions excessives, financent la campagne du « Non » au référendum d’octobre 2016.

La période post-accord, une occasion ratée ?

Un travail de recherche publié en 2019 montre que peu d’entreprises perçoivent un changement majeur dans leurs opérations. Le secteur minier constate que les groupes illégaux ont simplement remplacé les FARC. L’avantage principal reste l’accélération de projets déjà prévus et l’accès à de nouvelles zones d’opération qui bénéficient d’un classement spécial – les programmes de développement avec approche territoriale (PDET) et les zones les plus affectées par le conflit armé (ZOMAC) – qui donnent droit à des exonérations fiscales en contrepartie d’investissements notamment dans les infrastructures.

Ainsi, à travers ces quatre décennies, le secteur privé colombien est devenu un acteur incontournable du processus de paix, tout en restant fondamentalement hétérogène dans ses motivations, ses perceptions et ses actions. Cette trajectoire illustre la façon dont l’intensification du conflit, la perception croissante des coûts économiques, le développement de la culture RSE et l’apprentissage institutionnel ont transformé des entrepreneurs initialement distants en parties prenantes essentielles de la construction de la paix colombienne.

L’engagement du secteur privé, bien que motivé par des intérêts économiques, peut constituer un levier puissant pour la consolidation de la paix – à condition qu’il s’inscrive dans un cadre institutionnel solide et qu’il soit accompagné d’une véritable volonté politique et d’une collaboration entre l’ensemble des parties prenantes à une situation de conflit. La question qui se pose désormais est celle de la durabilité : comment maintenir cet engagement entrepreneurial dans la durée, particulièrement lorsque les « dividendes de la paix » tardent à se matérialiser ?

Frédéric Martineau est président de l'AMAEPF.

25.02.2026 à 16:48

Un singe star du Net, sa peluche et une expérience vieille de 70 ans : ce que Punch nous dit de la théorie de l’attachement

Mark Nielsen, Associate Professor, School of Psychology, The University of Queensland

Texte intégral (1554 mots)

La vidéo d’un petit singe blotti contre une peluche a ému la planète. Derrière l’émotion, elle rappelle une leçon majeure de la psychologie : on ne grandit pas seulement avec de la nourriture, mais avec du lien.

Sa quête de réconfort a ému des millions d’internautes. Punch, un bébé macaque, est devenu une célébrité d’Internet. Abandonné par sa mère et rejeté par le reste de son groupe, il s’est vu offrir par les soigneurs du zoo municipal d’Ichikawa, au Japon, une peluche d’orang-outan pour lui servir de mère de substitution. Les vidéos le montrant agrippé au jouet ont depuis fait le tour du monde.

Mais l’attachement de Punch à son compagnon inanimé ne se résume pas à une vidéo bouleversante. Il renvoie aussi à l’histoire d’une célèbre série d’expériences en psychologie, menées dans les années 1950 par le chercheur américain Harry Harlow.

Les résultats de ces travaux ont nourri plusieurs des principes fondamentaux de la théorie de l’attachement, selon laquelle le lien entre le parent et l’enfant joue un rôle déterminant dans le développement de ce dernier.

En quoi consistaient les expériences de Harlow ?

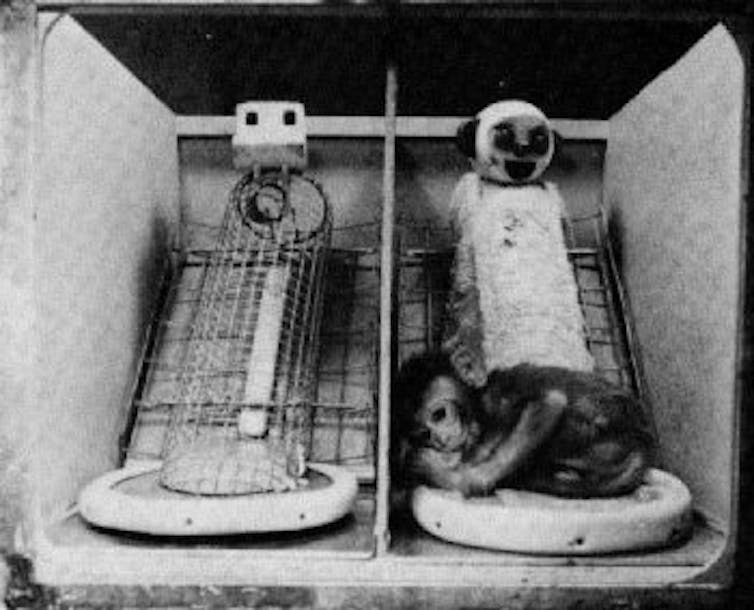

Harry Harlow a séparé des singes rhésus de leur mère dès la naissance. Ces petits ont ensuite été élevés dans un enclos où ils avaient accès à deux « mères » de substitution.

La première était une structure en fil de fer, à laquelle on avait donné la forme d’une guenon, équipée d’un petit dispositif permettant de fournir nourriture et boisson.

La seconde était une poupée en forme de singe, recouverte d’éponge et de tissu éponge. Douce et réconfortante, elle n’apportait pourtant ni nourriture ni eau : ce n’était guère plus qu’une silhouette moelleuse à laquelle le petit pouvait s’agripper.

On se retrouve donc avec, d’un côté, une « mère » qui offre du réconfort mais ni nourriture ni boisson, et, de l’autre, une structure froide, dure et métallique, qui assure l’apport alimentaire.

Ces expériences répondaient au béhaviorisme, courant théorique dominant à l’époque. Les béhavioristes soutenaient que les bébés s’attachent à celles et ceux qui satisfont leurs besoins biologiques, comme la nourriture et l’abri.

Harlow a ainsi battu en brèche cette théorie en affirmant qu’un bébé ne se construit pas seulement à coups de biberons : il a besoin de contact, de chaleur et d’attention pour s’attacher.

Selon une lecture strictement béhavioriste, les petits singes auraient dû rester en permanence auprès de la « mère » en fil de fer, celle qui les nourrissait. C’est l’inverse qui s’est produit. Ils passaient l’essentiel de leur temps agrippés à la « mère » en tissu, douce mais incapable de leur donner à manger.

Dans les années 1950, Harlow a ainsi démontré que l’attachement repose d’abord sur le réconfort et la tendresse. Face au choix, les bébés privilégient la sécurité affective à la simple satisfaction des besoins alimentaires.

En quoi cela a-t-il influencé la théorie moderne de l’attachement ?

La découverte de Harlow a marqué un tournant, car elle a profondément remis en cause la vision béhavioriste dominante à l’époque. Selon cette approche, les primates – humains compris – fonctionneraient avant tout selon des mécanismes de récompense et de punition, et s’attacheraient à celles et ceux qui répondent à leurs besoins physiques, comme la faim ou la soif.

Dans ce cadre théorique, la dimension affective n’avait pas sa place. En menant ses expériences, Harlow a renversé cette grille de lecture : il a montré que l’attachement ne se réduit pas à la satisfaction des besoins biologiques, mais repose aussi, et surtout, sur le lien émotionnel.

La préférence des petits singes pour la « nourriture émotionnelle » – en l’occurrence les câlins à la mère de substitution recouverte de tissu éponge – a posé les bases de la théorie de l’attachement.

Selon cette théorie, le développement harmonieux d’un enfant dépend de la qualité du lien qu’il tisse avec la personne qui s’occupe de lui. On parle d’attachement « sécurisé » lorsque le parent ou le proche référent apporte chaleur, attention, bienveillance et disponibilité. À l’inverse, un attachement insécure se construit dans la froideur, la distance, la négligence ou la maltraitance.

Comme chez les singes rhésus, nourrir un bébé humain ne suffit pas. Vous pouvez couvrir tous ses besoins alimentaires, mais sans affection ni chaleur, il ne développera pas de véritable attachement envers vous.

Que nous apprend le cas de Punch ?

Le zoo ne menait évidemment aucune expérience. Mais la situation de Punch reproduit, presque malgré elle, le dispositif imaginé par Harlow. Cette fois, ce n’est plus un laboratoire, mais un environnement bien réel – et pourtant, le résultat est étonnamment similaire. Comme les petits singes de Harlow qui privilégiaient la « mère » en tissu éponge, Punch s’est attaché à sa peluche Ikea.

Dans le cas du zoo, il manque évidemment un élément clé de l’expérience originale : il n’y a pas, en face, d’option dure mais nourricière avec laquelle comparer. Mais au fond, ce n’est pas ce que cherchait le singe. Ce qu’il voulait, c’était un refuge doux et rassurant – et c’est précisément ce que lui offrait la peluche.

Les expériences de Harlow étaient-elles éthiques ?

Aujourd’hui, une grande partie de la communauté internationale reconnaît aux primates des droits qui, dans certains cas, s’apparentent à ceux accordés aux humains.

Avec le recul, les expériences de Harlow apparaissent comme particulièrement cruelles. On n’envisagerait pas de séparer un bébé humain de sa mère pour mener une telle étude ; pour beaucoup, il ne devrait pas davantage être acceptable de l’infliger à des primates.

Il est frappant de voir à quel point ce parallèle avec une expérience menée il y a plus de 70 ans continue de fasciner. Punch n’est pas seulement la nouvelle star animale d’Internet : il nous rappelle l’importance du réconfort et du lien.

Nous avons tous besoin d’espaces doux. Nous avons tous besoin d’endroits où nous sentir en sécurité. Pour notre équilibre et notre capacité à avancer, l’amour et la chaleur humaine comptent bien davantage que la simple satisfaction des besoins physiques.

Mark Nielsen a reçu des financements de l'Australian Research Council.

25.02.2026 à 16:40

European Capitals of Culture: a diplomatic linchpin in an unstable world?

Maria Elena Buslacchi, socio-anthropologue, chercheuse post-doc à L'Observatoire des publics et pratiques de la culture, MESOPOLHIS UMR 7064, Sciences Po / CNRS / Aix-Marseille Université, Aix-Marseille Université (AMU)

Texte intégral (2236 mots)

This year the cities of Trenčín in Slovakia and Oulu in Finland took the helm as Europe’s cultural beacon cities. As the Old Continent redefines its role on the global geopolitical stage, the European Capitals of Culture (ECoC) programme is at a turning point. The European Commission recently launched a public forum initiative to collectively rethink the future of the programme after 2033. ECoC’s role as a tool for cultural diplomacy is now more important than ever.

Created in 1985 against a backdrop of thawing Cold war tensions and the political construction of the European Union project, the European Capital of Culture initiative was initially designed to celebrate the continent’s cultural diversity. Since then, it has become a laboratory for contemporary policies, but also a barometer of the hopes, contradictions and challenges of Europe itself.

Historical context is key to understanding the launch of the European Capitals of Culture: the end of the Cold War, in a divided Europe where the Iron Curtain was beginning to crumble and the European Economic Community (EEC) was gradually expanding. The programme came about, incidentally, thanks to a chance conversation at an airport between two prominent politicians: Jack Lang, who was France’s Minister for Culture Culture at the time, and Melina Mercouri, an activist actress who was then Greece’s Secretary of State for Culture.

Both had an ambitious vision: to use culture as a vehicle for unity, even though it seemed an overlooked aspect of European policy, as Monica Sassatelli, a sociologist at the University of Bologna, points out in her study on the role of culture in the historiography of European politics. The first cities which were chosen – Athens, Florence, Amsterdam, then Paris translates an aspiration for awarding the future European Union symbolic legitimacy. These historical capitals, as beacons of artistic and intellectual heritage, embody Europe’s arts, creativity and traditions, which transcend political and economic division.

Culture as a tool for urban generation

Next up was Glasgow (Scotland, UK). A declining industrial city marked by deindustrialisation and endemic unemployment, Glasgow City Council developed a strategy to revitalise the city centre in the late 1980s, aiming to mark a symbolic turning point and pave the way for its title as European Capital of Culture in 1990.

The promotional campaign “Glasgow’s Miles Better” pioneered the mix of former warehouses and culture, with the aim of revamping certain key cultural institutions (Scottish Opera, Ballet and Orchestra, BBC Symphony Orchestra, Citizen Theatre) and creating a new exhibition centre capable of hosting local and international artists and events. The Scottish city’s Arts Director Robert Palmer, future author of the first report on the initiative in 2004, considered the 1990 event as the starting point for a participatory process of redefining local culture “from the bottom up”, which could include artistic excellence as well as historical, rural and industrial traditions, and reconnect with a well-established tradition of popular culture and leisure activities.

Alongside major concerts by Luciano Pavarotti and Frank Sinatra, a whole series of associations and small local collectives took to the stage. In Glasgow, the year 1990 redefined the boundaries of the word “culture”, ultimately embracing the city’s industrial history and allowing its population to identify with it.

According to sociologist Beatriz Garcia, this regenerative effect on images and local identities is the strongest and most lasting legacy of the ECoC, beyond its economic and material impacts. This pioneering case, alongside other contemporary examples such as Bilbao and Barcelona in Spain, serves as a model. In other European cities, industrial premises are being transformed into theatres, museums or festival venues: the “Creative City” attracts millions of visitors and stimulates the local economy. When Lille in Northern France was elected “ECoC 2004”, it unveiled a dozen “maisons folies” across greater Lille and Belgium. These “crucibles of artistic and cultural innovation”, local initiatives cropped up, for the most part, on abandoned sites or former industrial wasteland.

In 2008, Liverpool (England, UK) used the programme to regenerate its waterfront and attract investment. At the turn of the century, the ECoC initiative was no longer limited to promoting cities that were already shining a light on international cultural scene, but became a real tool for urban transformation, used by places that were struggling to economically or socially reinvent and reposition themselves.

This change marks an evolution in urban policy, where culture is increasingly seen as a lever for economic development, on a par with infrastructure and policies designed to attract visitors. European Capitals of Culture are becoming an instrument of this policy, capable of attracting public and private funding, creating jobs in the cultural and tourism sectors, and improving the image of cities that are often stigmatised.

ECoC: an experimental space for testing contemporary transitions

However, this approach has its critics. The first reflective studies conducted in the early 2010s highlight how they can also exacerbate social and spatial inequalities if they are not accompanied by inclusive public policies. In Marseille in the South of France, in 2013, the issue became public with the organisation of an unofficial programme on the sidelines – i.e. parallel and alternative fringe events denouncing the side effects and undesirable consequences of the official programme. While Marseille’s stint as an ECoC was still an expression of the regeneration logic at work in previous years, it also marked the moment when social inclusion emerged as a central issue for these mega-events.

The Europe-wide cultural initiative has always been open to criticism, partly thanks to the very mechanics of the project, which often sees people who played a key role in previous editions of the programme returning to the selection panels for electing new European Capitals of Culture. Their participation, which had been questioned during Marseille-Provence 2013, has thus become an essential part of successive editions – in Matera-Basilicata (Italy) 2019, and citizen involvement will be one of the project’s key themes.

At the end of the 2010s, European Capitals of Culture also became a platform for the major challenges of the 21st century and a space for experimenting with ecological, social and digital transitions. Rijeka, Croatia, European Capital of Culture in 2020, illustrates the evolution. The city, marked by its industrial past and significant migration flows, focuses its programme on issues of migration and minorities, echoing the humanitarian crises affecting Europe. The cultural projects that have been set up: exhibitions, artist residencies, public debates brought together under the slogan ‘Port of Diversity’ – aim to promote intercultural dialogue and question the multiple identities of contemporary Europe. Similarly in the French town Bourges, in the running for 2028, is building its bid around ecological transition. The “Bourges, territory of the future” project is taking on the challenge of carbon neutrality for the event, using the ECoC as a springboard for climate action at the local level.

2033 and beyond: ECoC facing geopolitical and environmental challenges

While the European Capitals of Culture scheme is currently scheduled to run until 2033, the future of the title is under debate. The European Commission has launched a public consultation to imagine tomorrow’s ECoCs, in a context marked by geopolitical and environmental crises. The 2025 European Capitals of Culture, Chemnitz (Germany) and Nova Gorica/Gorizia (Slovenia), have developed a white paper on the future of the cultural initiative, based on observations from 64 past and future European Capitals of Culture. Forty recommendations are proposed to influence the programme reform process in the post-2034 cycle.

Among its key themes, the white paper emphasises the desire to strengthen the European dimension. This could be achieved by introducing a fundamental selection criterion based on European identity, emphasising European values in programming, developing a unified branding strategy and strengthening cross-border cooperation.

The selection and monitoring process, deemed too bureaucratic, is also being called into question, with the main recommendation being to favour encouraging rather than punitive monitoring. The legacy of the event is also up for debate: cities should be held accountable for delivering on the promises made in their bids, and national governments should be more involved in supporting cities during and after their capital year. The dissemination of good practices, peer review and mentoring between former and future ECoCs, which already exist informally, should be recognised and institutionalised, in particular through the possible creation of a central platform supported by the European institutions.

The challenge now is reconciling its symbolic and strategic role, ensuring that future editions do not merely celebrate, but aim to bolster democratic participation and transnational solidarity in an increasingly fragmented geopolitical landscape.

A weekly e-mail in English featuring expertise from scholars and researchers. It provides an introduction to the diversity of research coming out of the continent and considers some of the key issues facing European countries. Get the newsletter!

Maria Elena Buslacchi ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

25.02.2026 à 12:48

Autrefois dissimulés, les « assassinats ciblés » sont devenus des instruments assumés du pouvoir d’État

Kevin Foster, Associate Professor, School of Languages, Literatures, Cultures and Linguistics, Monash University

Texte intégral (3598 mots)

Frappes de drones, annonces sur les réseaux sociaux, revendications publiques : l’assassinat n’est plus une opération clandestine honteuse mais un message politique. Dans son nouveau livre, l’historien Simon Ball enquête sur la normalisation d’une violence d’État.

En novembre 2012, les Forces de défense israéliennes (FDI) ont utilisé Twitter – comme on l’appelait alors – pour annoncer qu’elles avaient tué Ahmed al-Jabari, chef des Brigades al-Qassam, la branche militaire du Hamas, à Gaza.

Cette annonce, accompagnée d’un lien vers une vidéo pixellisée de la frappe aérienne visant la voiture d’al-Jabari, marquait le début d’une nouvelle incursion des FDI à Gaza. Comme l’ont noté les historiennes Adi Kuntsman et Rebecca L. Stein dans leur livre Digital Militarism, elle a fait de l’opération « Pilier de défense » d’Israël « la première campagne militaire à avoir été déclarée via Twitter ».

Ce qui frappait également dans cette annonce, c’était la fierté et l’audace avec lesquelles les FDI célébraient ce qu’elles avaient fait. À peine une décennie plus tôt, Israël, comme les États-Unis, le Royaume-Uni et les puissances européennes, aurait éludé les questions sur sa responsabilité dans l’attaque ou nié avec ténacité. Les gouvernements n’assassinaient pas des personnes – c’était le fait de fanatiques politiques et d’extrémistes religieux.

Les choses avaient changé. Et profondément. La même année, le président Barack Obama demanda à John Brennan, son conseiller adjoint à la sécurité intérieure et à la lutte contre le terrorisme, de faire une déclaration publique sans ambiguïté sur la politique des États-Unis concernant l’usage de frappes de drones pour cibler des ennemis nommément désignés des États-Unis. Dans un discours au Wilson Center, Brennan déclara :

en totale conformité avec la loi, et afin de prévenir des attaques terroristes contre les États-Unis et de sauver des vies américaines, le gouvernement des États-Unis mène des frappes ciblées contre des terroristes spécifiques d’al-Qaida.

Le fait que les Américains, ainsi qu’un certain nombre de leurs alliés, tuaient – ou tentaient de tuer – leurs ennemis était, observa Brennan, « le secret le moins bien gardé du monde ». Il était temps que la « mascarade » prenne fin, d’appeler les choses par leur nom – ou, plus précisément, d’appeler une mise à mort ciblée un assassinat.

La nouvelle, cette semaine, selon laquelle le dissident russe Alexeï Navalny est mort après avoir prétendument ingéré du poison provenant d’une grenouille sud-américaine alors qu’il était emprisonné dans l’Arctique, rappelle que la Russie possède elle aussi une longue histoire d’assassinats de critiques du régime.

Dans Death to Order : A Modern History of Assassination (non traduit en français), Simon Ball propose une histoire de l’assassinat au cours du dernier siècle environ, fondée sur des recherches minutieuses et d’une lecture particulièrement captivante. Ball est professeur d’histoire et de politique internationales, et ces spécialités structurent l’approche du livre.

En conséquence, son livre s’intéresse moins à l’évolution des armes ou aux changements tactiques nécessaires aux mises à mort ciblées – jusqu’au développement du drone, ceux-ci sont restés en grande partie inchangés pendant plus d’un siècle – qu’à l’assassinat en tant qu’instrument de la politique d’État.

Dans une comparaison particulièrement imagée, Ball affirme que l’étude de l’assassinat « revient à faire glisser une lame de rasoir le long de l’histoire de la politique internationale ». La coupure qui en résulte peut être étroite, mais elle est longue et profonde. Elle révèle « l’exercice réel du pouvoir dans la politique internationale ».

Assauts déterminés

Si nombre des assassinats les plus marquants du siècle dernier – Mahatma Gandhi, John F. Kennedy, Martin Luther King Jr., Robert Kennedy, le Premier ministre suédois Olof Palme – sont évoqués, ils ne constituent pas le cœur de l’ouvrage.

Chacun de ces assassinats a donné lieu à des enquêtes approfondies et souvent prolongées, visant à établir un mobile politique et à identifier la main cachée d’une puissance hostile. Ainsi, l’enquête officielle sur le meurtre de Palme, en février 1986, n’a été close qu’en 2020.

Dans une affaire plus célèbre encore, l’assassinat du président Kennedy à Dallas en novembre 1963, les enquêteurs américains se sont employés avec ténacité à établir une éventuelle implication soviétique, d’abord au sein de la Commission Warren, puis de la Commission spéciale de la Chambre des représentants sur les assassinats, convoquée treize ans après les faits.

Malgré la soif du public et du monde politique pour des révélations de complots dignes de romans d’espionnage, Ball rappelle avec constance qu’aucune preuve n’est venue étayer une telle thèse. Ces assassinats furent le fait d’individus isolés, animés par des vendettas personnelles, des haines intimes ou des troubles psychiques.

Ils ne sont donc pas au cœur de son propos. Les victimes qu’il étudie sont moins des chefs d’État que leurs serviteurs loyaux. Son enquête révèle à quel point proconsuls, diplomates et responsables de la sécurité des grandes puissances étaient exposés aux attaques résolues de leurs adversaires.

Ne pas paraître faible

Pendant près d’un siècle, les partisans de l’émancipation face à la domination étrangère et à l’oppression économique ont fait exploser des bombes, parfois poignardé, mais le plus souvent abattu à bout portant, à l’arme légère, des représentants des puissances occupantes. Des assassinats ciblés ont eu lieu en Inde, en Irlande, en Algérie, en Malaisie, au Vietnam, en Palestine, en Égypte – bref, dans presque toutes les régions du monde passées sous la coupe d’un empire. La violence a même gagné les capitales des puissances coloniales.

L’une des révélations les plus frappantes du livre tient au temps qu’il fallut aux Britanniques surtout – mais aussi aux Français et aux Américains – pour admettre que la menace pesant sur leurs agents en poste à l’étranger, dans des environnements instables, était démesurément élevée. Pendant des décennies, le prestige impérial interdisait à ses représentants toute manifestation visible d’inquiétude pour leur sécurité personnelle. À Londres, bien après la Seconde Guerre mondiale, on estimait encore qu’une attention excessive portée à la sécurité risquait d’entamer la mystique d’autorité de la puissance dominante et de donner le sentiment d’un aveu de faiblesse.

Sur le terrain, les agents ne partageaient pas cet état d’esprit. Des dizaines d’entre eux furent poignardés ou abattus avant de convaincre leurs ministres de revoir leur position et de mettre en place des dispositifs de protection adéquats.

Si ce tournant se fit tant attendre, c’est que, tout en reconnaissant en privé la menace que des oppositions bien organisées faisaient peser sur leur domination, les gouvernements s’astreignaient publiquement à minimiser la portée d’actes de violence politique présentés comme isolés – ainsi que l’ampleur du soutien dont ces mouvements bénéficiaient parmi les populations occupées ou opprimées.

Le règlement de ces questions, plus larges, de légitimité et d’autorité reposait sur un dialogue prolongé entre les administrations coloniales et les élites politiques émergentes dans les territoires occupés. Il exigeait des négociations minutieuses et des compromis douloureux, impossibles à arracher dans la fournaise d’un soulèvement populaire. D’où la nécessité d’entretenir l’illusion du calme.

Le « script libéral » qui a façonné, pendant une grande partie du XXe siècle, la réponse du gouvernement britannique aux assassinats de ses représentants a pris forme sous le gouvernement de H.H. Asquith (1908-1916). Il s’articulait autour de trois principes essentiels :

1) Il existait des preuves d’un complot organisé visant à commettre des assassinats.

2) Très peu de personnes étaient impliquées dans ce complot.

3) Ce complot était dangereux en raison de la violence de ses méthodes, et non parce qu’il constituait la partie émergée d’un mouvement plus large.

En soutenant que ces meurtres étaient le fait d’un petit nombre de fanatiques – et non l’expression d’une opposition vaste et structurée –, les autorités pouvaient circonscrire, voire étouffer, l’agitation politique. Dans le même temps, les négociations se poursuivaient lentement, à huis clos.

« Assassins d’honneur » et activités clandestines

L’assassinat n’a eu aucune influence significative sur le cours, la conduite ou l’issue de la Seconde Guerre mondiale. En revanche, la guerre a profondément transformé l’assassinat en tant qu’outil d’État.

L’action des deux Tchèques qui tuèrent le général nazi Reinhard Heydrich, les multiples tentatives avortées d’assassinat contre Hitler, ou encore le geste de l’aristocrate irlandaise, troublée ou animée de principes inébranlables, Violet Gibson, qui, en avril 1926, tira sur Mussolini au « museau » (« In the snout », selon la formule inimitable de la chanteuse folk Lisa O’Neill) sans parvenir à le tuer, ont offert de nombreux exemples – plus souvent morts que vivants – de ce que l’on a appelé « l’assassin d’honneur ».

Pour ceux attachés à la démocratie libérale, il n’y avait qu’un pas entre la figure du tueur agissant par principe et l’idée que des puissances démocratiques fortes devaient elles aussi se doter de la capacité de procéder à des éliminations ciblées. Il s’agissait de prévenir la montée de l’intolérance en supprimant ses porte-voix, de combattre le feu par le feu.

Dans les années 1950 et 1960, certains gouvernements démocratiques, au premier rang desquels la France et les États-Unis, ont supervisé – ou laissé faire – des assassinats politiques de représailles contre leurs ennemis. Cette pratique a fini par être admise au point que les conflits militaires de grande ampleur en Algérie et au Vietnam ont été menés, pour une part non négligeable, à travers des programmes d’assassinats conduits à l’échelle industrielle.

Les questions d’autorité et de protocole devinrent centrales. Au début des années 1960, la branche spécialisée de la CIA chargée des « opérations exécutives » s’employait à déstabiliser des régimes en Amérique centrale, en organisant et en armant des insurrections, et en appuyant des opérations d’assassinat. D’autres services de l’agence rédigeaient les textes nécessaires – un véritable manuel d’assassinat à l’usage de l’homme de terrain – et définissaient la doctrine encadrant ces activités clandestines. En somme, il s’agissait de décider qui était habilité à autoriser un assassinat.

À mesure que cette responsabilité remontait progressivement jusqu’au bureau du président, l’assassinat s’imposa comme un instrument explosif de l’art de gouverner – un outil susceptible de faire voler en éclats la façade du gouvernement en place et de mettre en cause son discours sur la défense des principes démocratiques.

Assassinats ciblés

Au fil des années 1970 et jusque dans les années 1980, les troubles en Irlande du Nord se sont progressivement étendus au territoire britannique. À mesure que le conflit gagnait le continent, les efforts du gouvernement pour maintenir le scénario « asquithien » se sont effondrés. L’idée implicite selon laquelle un certain niveau d’assassinats constituait le prix à payer pour exercer le pouvoir dans une société libérale, ouverte et démocratique n’était plus tenable.

À mesure que les attaques de l’IRA contre l’élite politique britannique devenaient plus sophistiquées, plus ciblées et plus meurtrières, un tournant décisif s’est opéré dans les cercles dirigeants en matière de sécurité. En 1982, la « Protection » est devenue un commandement permanent au sein de la Metropolitan Police, la police de Londres.

Alors que des débouchés lucratifs s’ouvraient pour d’anciens membres des forces spéciales dans les nouvelles industries de la sécurité, les chercheurs américains en matière de défense continuaient d’affiner les capacités permettant de frapper des ennemis avec une précision accrue, à des distances toujours plus grandes.

Avec l’entrée en service des premiers drones armés, l’administration de George W. Bush a redéfini la notion d’assassinat afin d’en exclure les frappes « défensives » préventives visant des individus nommément désignés et considérés comme une menace pour les États-Unis ou leurs personnels. De là, il n’y eut qu’un pas vers le recours massif aux assassinats ciblés en Asie centrale, au Moyen-Orient et en Afrique de l’Ouest.

Alors que d’anciens membres des forces spéciales trouvaient des débouchés très rémunérateurs dans les nouvelles entreprises privées de sécurité, les chercheurs américains travaillant pour la défense perfectionnaient, eux, des technologies permettant de viser leurs ennemis avec une précision croissante, à des distances toujours plus grandes.

Avec l’entrée en service des premiers drones armés, l’administration de George W. Bush a redéfini la notion d’assassinat afin d’en exclure les frappes « défensives » préventives visant des individus nommément désignés et considérés comme une menace pour les États-Unis ou leurs personnels. De là, il n’y eut qu’un pas vers le recours massif aux assassinats ciblés en Asie centrale, au Moyen-Orient et en Afrique de l’Ouest.

En 2007, l’armée américaine disposait de 24 drones dédiés aux opérations d’élimination ciblée. Deux ans plus tard, ce chiffre atteignait 180 appareils, dotés d’une capacité d’emport quinze fois supérieure à celle des modèles précédents. En 2025, le département américain de la Défense – récemment rebaptisé « département de la Guerre » – comptait plus de 11 000 aéronefs sans pilote dans son arsenal. Tous ne sont pas destinés à des missions d’élimination, certes. Mais les ordres de grandeur parlent d’eux-mêmes.

Autrefois arme privilégiée des combattants de la liberté, des mouvements d’indépendance et de leurs branches insurrectionnelles, l’assassinat est devenu aujourd’hui un instrument assumé de l’État et une composante à part entière de l’arsenal de ses forces armées.

Death to Order regorge d’épisodes saisissants et d’anecdotes frappantes – notamment celle d’une jeune Elizabeth II s’étonnant que personne n’ait glissé quelque chose dans le café du turbulent dirigeant nationaliste égyptien, le général Gamal Abdel Nasser.

Mais l’apport le plus marquant de l’ouvrage de Ball tient sans doute à la manière dont il retrace avec précision la sortie progressive de l’assassinat des coulisses du secret gouvernemental et militaire pour son exposition en pleine lumière, au cœur de la communication et de la propagande.

Depuis les attentats du 11 septembre 2001 – et plus encore au cours de la dernière décennie – la mise en scène de l’assassinat comme symbole concentré de la puissance étatique et de sa volonté implacable est devenue un puissant instrument de dissuasion contre toute opposition active, ainsi qu’un levier majeur de guerre informationnelle.

Doté d’un pouvoir de surveillance quasi divin, de son œil omniscient dans le ciel, le drone sait ce que vous avez fait et où vous vous trouvez. Nul n’échappe à sa vengeance. Les ides de mars sont là.

Kevin Foster ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

25.02.2026 à 12:44

La crise des vocations enseignantes, un défi récurrent dans l’histoire de l’école ?

Sébastien-Akira Alix, Professeur des universités en sciences de l'éducation et de la formation, Université Paris-Est Créteil Val de Marne (UPEC)

Texte intégral (2359 mots)

Les difficultés à recruter des enseignants reviennent régulièrement dans l’actualité. Mais sont-elles si récentes ? Autour de quels enjeux s’articulent-elles ? Publié en février 2026 aux Presses du Septentrion, sous la coordination de Sébastien-Akira Alix, l’ouvrage Crises dans et hors l’école en France. Éclairages socio-historiques (des années 1960 à nos jours) nous aide à replacer dans une perspective historique le sujet, ainsi que d’autres questions comme la « baisse du niveau » des élèves, la dilution de l’autorité, les violences scolaires. Les analyses qui suivent sont extraites de l’introduction de l’ouvrage.

D’une manière générale, les recherches sur l’histoire de l’enseignement en France interdisent de penser que ce qu’on appelle communément dans le débat public « la crise des vocations enseignantes », « la crise d’attractivité des métiers de l’enseignement » ou « la crise du recrutement des enseignants » serait un phénomène d’origine récente et le signe d’un malaise propre au XXIe siècle. À cet égard, dans son ouvrage la Formation des maîtres en France, 1792-1914, l’historien Marcel Grandière a bien mis en lumière les importantes difficultés de recrutement que rencontrent les écoles normales primaires en France à partir de 1887, période pourtant souvent présentée dans le débat public comme un « âge d’or » de l’École sous la IIIe République.

À l’époque, ces écoles normales primaires, en charge de la formation des instituteurs et des institutrices du primaire, connaissent une baisse notable d’admissions alors que de nombreuses places sont disponibles et que les besoins de recrutement demeurent importants. Pour pallier ce manque, « les inspecteurs d’académie puisent largement dans le vivier des brevetés, sans formation ». Cette situation s’inscrit, à l’époque, dans la durée puisqu’en 1911, « une moyenne de 2 500 instituteurs et 3 200 institutrices sont recrutés chaque année, sur lesquels les normaliens ne comptent que pour 1 500, et les normaliennes 1 800. Les moyens manquent pour faire mieux ». Dans ce contexte spécifique, la crise devient, d’après Marcel Grandière, un problème public :

« Car, pour ajouter à la difficulté, les écoles normales souffrent, à partir de 1888, d’une sensible et durable crise des vocations. À partir de 1890 surtout, les revues spécialisées, puis la presse, s’en émeuvent : la crise du recrutement devient un problème public. À la chambre des députés, on parle de “péril primaire” en évoquant la difficulté du recrutement : “Le nombre de candidats à ces écoles normales, qui était inférieur de beaucoup à ce qu’il était antérieurement, s’est à peine relevé, si bien que la sélection n’a pu opérer comme on était en droit de le penser, et qu’on peut craindre que l’avenir ne révèle entre ces dernières promotions et celles qui les ont précédées une différence marquée. […] Il y a là pour l’avenir de nos écoles publiques un danger qui constitue ce qu’on a appelé le péril primaire.” »

À l’époque, cette baisse sensible du nombre de candidats – il y en avait 6 000 en 1882 contre 2 848 en 1888 – s’explique, en partie, par des raisons économiques, la loi du 19 juillet 1889 n’ayant « pas donné aux instituteurs les améliorations de revenus qu’ils attendaient depuis longtemps ».

À lire aussi : Le boom des profs non titulaires, un tournant pour l’Éducation nationale ?

D’autres travaux, comme ceux de Frédéric Charles sur les instituteurs entre 1955 et 1984, ont cherché à expliquer, à partir de « l’étude de l’évolution et des transformations du recrutement des normaliens et normaliennes des deux Écoles normales de Paris », la crise de recrutement que connaît l’enseignement primaire français au début des années 1980, en particulier en 1986, année où « l’Éducation nationale n’a pas réussi à recruter tous les instituteurs dont elle avait besoin : sur 5 000 postes, seulement 4 700 furent pourvus ». D’après Frédéric Charles, cette crise est alors liée à la dévalorisation du statut social des enseignants du primaire – ressentie fortement par les jeunes instituteurs – dans le contexte de la démocratisation quantitative du système éducatif, qui fait perdre à l’école primaire sa place centrale. Au cours de ces années, le métier d’instituteur fait, en effet, l’objet d’un processus de dévaluation lié « aux effets des réformes de 1959 qui […] situent désormais l’enseignement primaire comme une simple étape du cursus scolaire » ainsi qu’à la transformation corrélative des « dispositions des candidats, [et de] leurs rapports à l’institution ».

Sous l’effet de l’allongement de la scolarité obligatoire, la valeur distinctive du niveau de diplôme des enseignants est fortement relativisée, contribuant à une perte de prestige du métier : l’instituteur voit désormais « sa fonction se banaliser et sa reconnaissance sociale décroître ». Le métier cesse ainsi progressivement d’être une voie de promotion sociale pour les candidats, en particulier à partir de 1973, date à laquelle le recrutement en école normale ne se fait plus qu’après le baccalauréat. La composition sociale des écoles normales et le rapport que les élèves entretiennent à son égard s’en trouvent modifiés : « Faute d’avoir réussi dans l’entreprise de leurs études supérieures à l’Université, mais surtout d’avoir pu accéder à une grande école ou à l’École normale supérieure », une partie des normaliens « ont été amenés alors, pour éviter un déclassement social, à se rabattre sur la petite École normale d’instituteurs ». L’École normale n’apparaît ainsi pratiquement plus génératrice de mobilité sociale et l’intégration en son sein correspond, pour beaucoup de candidats, à « des stratégies de reclassement ou de lutte contre un déclassement social », sauf pour des jeunes femmes qui ont pu valoriser ces diplômes.

À côté de cette problématique propre aux normaliens, qui constituent 50 % du personnel enseignant primaire de la région parisienne, l’enseignement primaire fait face, dès les années 1950, à une « très grave crise » du recrutement. Pour y pallier, on recrute des « bacheliers sans aucune formation professionnelle » comme auxiliaires.

Selon une enquête d’Ida Berger, menée auprès des personnels enseignants du premier degré en 1957 pour le Centre d’études sociologiques de Paris, cette crise est, pour partie, liée au « malaise socio-professionnel », dont les causes sont liées à des salaires trop faibles ; au « manque de perspectives d’avenir dans la profession » ; à « la perte du prestige social de leur profession » ; ainsi qu’à la vétusté des bâtiments et au trop grand nombre d’élèves par classe. À cet égard, Ida Berger note :

« En face de 45-50 enfants, habitant souvent des taudis, mal nourris et hypernerveux, combien d’instituteurs sont à contrecœur obligés d’abdiquer en tant que pédagogues et de se transformer en “gendarmes” pour maintenir un semblant de discipline dans leur classe ? »

Dans l’enseignement secondaire, l’explosion scolaire, engagée dès les années 1960, conduit également à l’émergence d’une crise aiguë du recrutement entre 1955 et 1965. Avec l’arrivée de nouveaux publics, « la distance subjectivement vécue entre la carrière ambitionnée et la réalité actuellement perçue du professorat » est, pour un certain nombre d’enseignants, symptomatique d’une crise révélatrice d’« une baisse du statut du professorat de l’enseignement secondaire ». Le malaise enseignant devient, d’ailleurs, à cette époque une « catégorie médiatique ».

À lire aussi : Pourquoi tant de difficultés à recruter des enseignants ?