ACCÈS LIBRE Une Politique International Environnement Technologies Culture

02.11.2025 à 17:02

Dix ans après, quel bilan pour l’accord de Paris ?

Christian de Perthuis, Professeur d’économie, fondateur de la chaire « Économie du climat », Université Paris Dauphine – PSL

Texte intégral (2406 mots)

Que reste-t-il de l’accord de Paris, dix ans après sa signature, au moment de l’ouverture de la COP30 au Brésil, dans un contexte de tensions géopolitiques et de « backlash » climatique mené par les États-Unis ? Des signaux encourageants subsistent malgré tout, notamment l’accélération des transitions énergétiques dans les pays émergents. De quoi garder entrouverte une fenêtre, certes bien étroite, sur la voie de la stabilisation de la température mondiale.

Lors de son adoption en 2015, l’accord de Paris a généré beaucoup d’espoirs, car il embarquait l’ensemble des signataires. De par son caractère universel, il allait donner une tout autre dimension à la lutte contre le réchauffement planétaire.

Changement d’ambiance, dix ans après, à l’ouverture de la COP30 sur le climat à Belém au Brésil, qui doit se tenir du 10 au 21 novembre 2025. En 2024, le thermomètre a affiché un réchauffement de 1,5 °C, les émissions mondiales de CO2 ont continué d’augmenter et sa concentration dans l’atmosphère a battu tous ses records. Avec la défection des États-Unis après la réélection de Donald Trump, l’universalisme de l’accord en a pris un sérieux coup.

Ni tout rose ni tout noir, notre bilan de dix années d’application de l’accord de Paris s’écarte d’une telle vision simpliste suggérant que rien n’a bougé durant les dix dernières années. Depuis 2015, des progrès substantiels ont été réalisés.

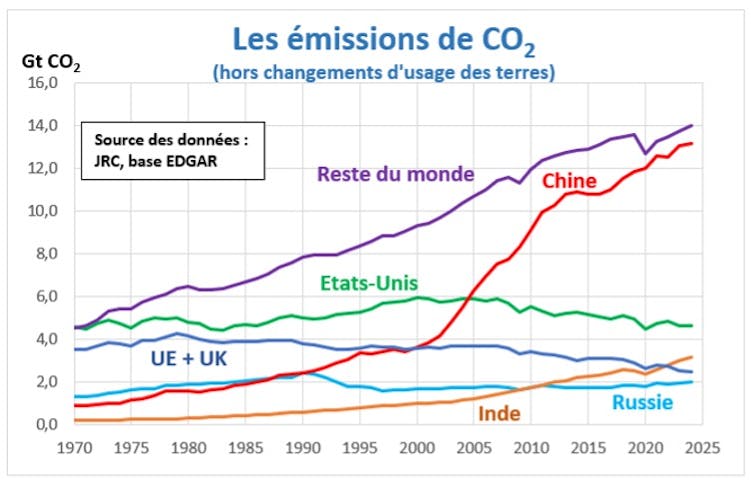

« Les émissions mondiales ne cessent d’augmenter ». Oui, mais…

Le premier bilan global des émissions de gaz à effet de serre discuté à la COP de Dubaï en 2023 a certes rappelé que les émissions mondiales de gaz à effet de serre n’étaient pas encore stabilisées. Diagnostic confirmé en 2024, mais qui reste insuffisant à ce stade pour analyser l’impact de l’accord de Paris sur le régime des émissions.

On peut également relever que :

Au cours de la dernière décennie, le rythme de croissance des émissions mondiales de CO2, le principal gaz à effet de serre d’origine anthropique, a été divisé par trois relativement à la décennie précédente.

Cette inflexion majeure s’explique par le déploiement, bien plus rapide qu’escompté, des capacités de production d’énergie solaire et éolienne.

La transition d’un système économique reposant sur les énergies de stock (fossile et biomasse) vers des énergies de flux (soleil, vent, hydraulique…) a donc été bel et bien amorcée durant les dix premières années de l’accord. Elle semble désormais irréversible, car ces énergies sont devenues bien moins coûteuses pour les sociétés que l’énergie fossile.

De plus, on ne saurait jauger de l’efficacité de l’accord à partir du seul rétroviseur. Il faut également se projeter dans le futur.

Du fait de ses investissements massifs dans la production et l’utilisation d’énergie renouvelable, la Chine est en train de franchir son pic d’émissions, pour des rejets de CO2 de l’ordre de 9 tonnes par habitant, quand les États-Unis ont passé leur pic à 20 tonnes, et l’Europe à 11 tonnes. L’Inde pourrait d’ici une dizaine d’années franchir le sien à environ 4 tonnes.

Le fait que ces pics d’émissions soient substantiellement plus bas que ceux des vieux pays industrialisés est une information importante. Les pays moins avancés peuvent désormais construire des stratégies de développement sautant la case fossile. Ceci laisse une fenêtre entrouverte pour limiter le réchauffement planétaire en dessous de 2 °C.

Des objectifs de température désormais inatteignables ?

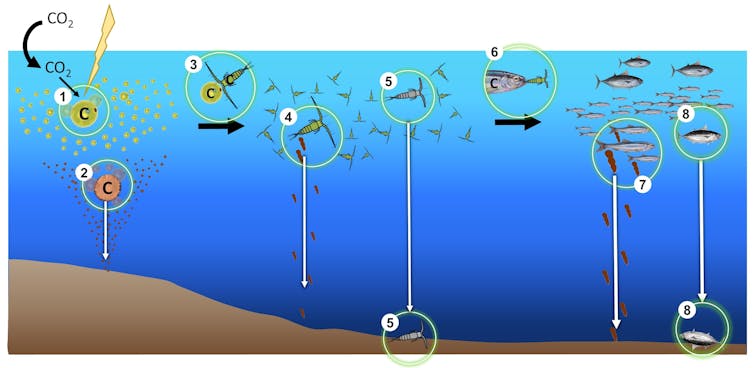

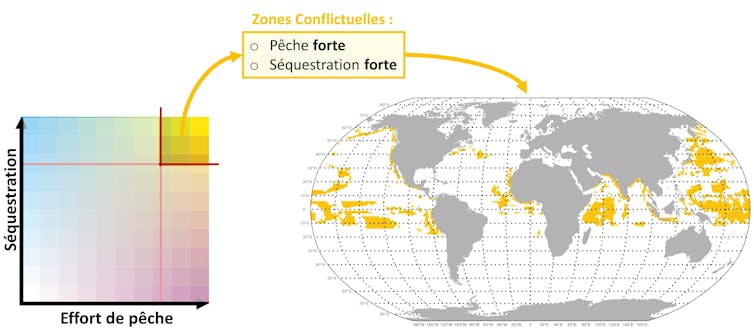

L’Organisation météorologique mondiale (OMM) a indiqué que le thermomètre avait franchi 1,5 °C en 2025, soit la cible de réchauffement la plus ambitieuse de l’accord. Cette poussée du thermomètre reflète en partie la variabilité à court terme du climat (épisode El Niño, par exemple). Elle résulte également de dangereuses rétroactions : le réchauffement altère la capacité des puits de carbone naturels (forêts et océan) à séquestrer le CO2 de l’atmosphère.

Faut-il pour autant en conclure que les objectifs sont désormais inatteignables, au risque d’ouvrir un peu plus les vannes du backlash climatique ?

L’alerte de 2024 confirme ce qui était déjà apparu dans les scénarios prospectifs du 6ᵉ rapport d’évaluation du Groupe d’experts intergouvernemental sur l’évolution du climat (Giec). Du fait de l’inertie du stock de CO2 déjà présent dans l’atmosphère, la cible de 1,5 °C est en réalité dépassée avant 2035 dans la majorité des scénarios.

Cela n’exclut pas qu’on puisse limiter le réchauffement en dessous de 2 °C, l’autre cible de l’accord de Paris, à condition de réduire massivement les émissions de CO2 une fois le pic d’émission atteint. D’après le Global Carbon Budget, le budget carbone résiduel pour limiter le réchauffement à 2 °C s’établit à environ vingt-cinq années au rythme actuel d’émissions.

Et pour viser 1,5 °C ? Il faut alors passer en régime d’émissions nettes négatives durant la seconde partie du siècle. Dans ces scénarios dits du « dépassement » (overshooting), les puits de carbone séquestrent plus de CO2 qu’il n’en est émis, ce qui permet de faire redescendre le thermomètre après le franchissement du seuil. Ce serait toutefois aller au-delà de l’accord de Paris, qui se contente de fixer un objectif de zéro émission nette.

Comment financer une transition juste ?

L’accord de Paris stipule que les financements climatiques internationaux à la charge des pays développés doivent atteindre au minimum 100 milliards de dollars (86,4 milliards d’euros) par an à partir de 2020, puis être fortement réévalués.

Le bilan est ici en demi-teinte :

La barre des 100 milliards de dollars (86,4 milliards d’euros) n’a été franchie qu’en 2022, avec trois ans de retard.

À la COP29 de Bakou, un nouvel objectif de 300 milliards de dollars (259,2 milliards d’euros) par an à atteindre d’ici 2030 a été acté. Un tel triplement, s’il est effectif, ne permettra de couvrir qu’une partie des besoins de financement, au titre de l’adaptation au changement climatique, et des pertes et dommages.

Durant les dix premières années de mise en œuvre de l’accord, il n’y a toutefois guère eu d’avancée sur les instruments financiers à utiliser. En particulier, les dispositions de l’article 6 ouvrant la possibilité d’appliquer la tarification carbone n’ont pas été traduites dans un cadre opérationnel permettant leur montée en puissance.

Manque également à l’appel un accord plus précis sur qui paye quoi en matière de financement climatique. Ce flou artistique quant à qui sont les bailleurs de fonds et à hauteur de combien chacun doit contribuer fragilise la portée réelle de l’engament financier.

Il reste donc beaucoup de chemin à parcourir pour traduire la promesse de 300 milliards de dollars (259,2 milliards d’euros) par an en engagements crédibles.

Les COP sur le climat, l’énergie fossile et le jeu des lobbies

Pas plus que la Convention climat datant de 1992, l’accord de Paris ne mentionne la question de la sortie des énergies fossiles, le terme lui-même n’étant nulle part utilisé.

En 2021, la décision finale de la COP26 mentionnait pour la première fois le nécessaire abandon du charbon ; celle de la COP28 à Dubaï élargissait la focale à l’ensemble des énergies fossiles. C’est un progrès, tant la marche vers le net zéro est indissociable de la sortie accélérée des énergies fossiles.

Paradoxalement, depuis que les COP ont inscrit la question de l’énergie fossile à leur ordre du jour, la présence des lobbies pétrogaziers s’y fait de plus en plus pesante.

Elle est visible dans les multiples évènements qui se tiennent parallèlement aux sessions de négociation, et plus discrète au sein des délégations officielles conduisant les négociations. Une situation régulièrement dénoncée par les ONG qui réclament plus de transparence et une gouvernance prévenant les conflits d’intérêts lorsque le pays hôte de la COP est un pays pétrolier, comme cela a été le cas à Dubaï (2023) et à Bakou (2024).

En réalité, l’accord de Paris n’a pas accru l’influence des lobbies proénergie fossile : ces derniers s’appliquent à freiner les avancées de la négociation climatique depuis ses débuts. Il n’a pas non plus réduit leur pouvoir de nuisance, qui résulte de la prise de décision au consensus, qui donne un poids disproportionné aux minorités de blocage. Pas plus qu’il ne prévoit de mécanisme retenant ou pénalisant ceux qui font défection.

Un « backlash » climatique impulsé par l’Amérique trumpienne

Parmi les décrets signés par Donald Trump le premier jour de sa présidence figurait celui annonçant le retrait des États-Unis de l’accord de Paris sur le climat. Une façon particulière de souffler la dixième bougie d’anniversaire.

Si la sortie lors du premier mandat avait été un non-événement, il en fut autrement cette fois-ci. En quittant l’accord, l’Amérique trumpienne ne s’est nullement mise en retrait. L’offensive engagée au plan interne par l’administration républicaine contre toute forme de politique climatique s’est doublée d’une diplomatie anti-climat agressive, comme l’a illustré le torpillage en règle de l’accord sur la décarbonation du transport maritime de l’Organisation maritime internationale.

Cette diplomatie repose sur les mêmes fondements que la nouvelle politique étrangère du pays : la défense de ses intérêts commerciaux, à commencer par ceux des énergies fossiles, à l’exclusion de toute autre considération portant sur les normes internationales en matière de droits humains, de défense de l’environnement ou de lutte contre le réchauffement planétaire.

Cette offensive anti-climat peut-elle sonner le glas de l’accord de Paris ? Les États-Unis disposent d’alliés parmi les grands exportateurs d’énergie fossile et leur idéologie anti-climat se diffuse insidieusement au-delà de leurs frontières. S’ils faisaient trop d’émules, l’accord de Paris perdrait rapidement de sa consistance.

Un autre scénario peut encore s’écrire : celui d’un front commun entre la Chine, l’Union européenne et l’ensemble des pays réaffirmant leurs engagements climatiques. Un tel jeu d’alliance serait inédit et pas facile à construire. Il sera peut-être rendu possible par la démesure de l’offensive anti-climat de l’Amérique trumpienne. Le premier acte se jouera à la COP de Belém, dès novembre prochain.

Christian de Perthuis ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

02.11.2025 à 17:01

Aliments sans gluten : qui les achète et pourquoi ? quels ingrédients inattendus contiennent-ils ?

Marie-Françoise Samson, Chercheuse en biochimie alimentaire, Inrae

Dominique Desclaux, Chercheure en Agronomie et Génétique, Inrae

Texte intégral (2056 mots)

Celles et ceux qui privilégient les aliments sans gluten font souvent ce choix car ces produits sont perçus comme plus sains. Mais certaines recettes incorporent une longue liste d’ingrédients (agents de texture, protéines, matières grasses, sucres et autres additifs) et… beaucoup d’eau. C’est ce que révèlent Dominique Desclaux et Marie-Françoise Samson, de l’Inrae, dans « Gluten, alimentation et santé » (éditions Quae).

La proportion de gens qui évitent/bannissent le gluten de leur alimentation est variable. En 2013 par exemple, 30 % des Américains se déclaraient intéressés par un régime sans gluten. Soixante-cinq pour cent pensent aussi que ce régime est plus sain et 27 % le choisissent pour perdre du poids (Jones, 2017).

En France, selon des données de l’enquête Nutrinet collectées en 2016, sur un peu plus de 20 000 personnes, 10,31 % d’entre elles éviteraient le gluten et 1,65 % de façon stricte. Selon une autre enquête réalisée en Angleterre en 2019, parmi les personnes qui évitent le gluten, 76 % le font parce qu’elles ont la maladie cœliaque, 8 % parce qu’elles sont intolérantes au gluten, 10 % parce qu’elles vivent avec une personne cœliaque et seulement 6 % pour d’autres raisons (Vriesekoop et al., 2020).

Parmi ces autres raisons vient en tête la perception que le régime sans gluten est plus sain, qu’il peut procurer un bien-être et un confort physique immédiats et sur le long terme. Vient ensuite la volonté de perdre du poids. Parmi ces consommateurs, on retrouve beaucoup de femmes, plutôt jeunes.

En France et dans différents pays, les consommateurs qui font le choix d’une alimentation sans gluten pour des raisons liées au bien-être ont recours à d’autres pratiques qui, pour eux, vont dans le même sens : plus de fruits et légumes, moins d’alcool et de produits gras et sucrés, mais aussi moins de produits laitiers. Ces mêmes personnes privilégient les produits issus de l’agriculture biologique, les circuits courts et évitent les aliments ultratransformés.

Une liste d’ingrédients longue comme un jour sans pain

Soixante-dix pour cent des aliments consommés par les Français contiendraient du gluten. On rappelle que, dans les produits à base de blé, comme le pain ou les gâteaux, le réseau de gluten se développe lors du pétrissage et de la formation de la pâte. Une structure protéique tridimensionnelle est créée, qui apporte de l’élasticité au mélange. Ce réseau piège aussi le gaz carbonique (CO2) produit lors de la fermentation, dans le cas du pain, ou généré par la levure chimique dans le cas des gâteaux. Les bulles de gaz formées vont alors s’expanser tout en étant contenues par le réseau et provoquer la levée de la pâte. Lors de la cuisson, le réseau se fige, contribuant ainsi à la stabilité du produit.

Ces propriétés uniques rendent le gluten presque indispensable à la formulation de produits tels que le pain ou les gâteaux. Dans le cas des produits type « pain sans gluten », la fabrication est un défi, car rien ne peut rivaliser avec les protéines du blé, mais des formulations complexes vont permettre de s’en approcher.

Si la liste des ingrédients est restreinte dans un pain de tradition française – une farine de blé panifiable, de l’eau, du sel, un levain ou une levure, et éventuellement d’autres farines (farines de fève 2 % max., farine de soja 0,5 % max., farine de blé malté 0,3 % max.) –, il n’en va pas de même pour leurs analogues sans gluten vendus dans le commerce. Parfois, une vingtaine d’ingrédients sont nécessaires pour obtenir un pain.

Quelles farines pour du sans-gluten ?

Se passer de gluten nécessite d’avoir recours à d’autres céréales et d’autres ingrédients ou additifs. L’élément principal est le plus souvent un amidon, comme dans les pains à base de blé (l’amidon est le constituant majeur de la farine de blé). Celui du maïs est l’ingrédient principal dans environ 60 % des recettes (Roman et al., 2019). Il est très souvent associé à une farine de riz blanc (dans 30 % des formulations). L’amidon de maïs donne des pains avec un volume important, mais avec une texture plutôt sèche et friable.

D’autres types d’amidon sont parfois incorporés dans des proportions plus faibles, comme le tapioca, la fécule de pommes de terre ou des amidons modifiés. D’autres farines peuvent venir compléter la liste des ingrédients de base, comme des farines de riz complet ou de sarrasin.

Ces ingrédients de base sont une réalité commerciale, mais la littérature scientifique fait état d’essais avec des farines de céréales autres que le riz ou le maïs : sorgho, millet, teff ; de pseudo-céréales : amarante, quinoa, chia ; de légumineuses (pois chiches, pois, soja) ; ou encore de châtaignes. Les légumineuses sont intéressantes sur le plan nutritionnel (teneur en protéines plus élevée et composition en acides aminés différente et complémentaire de celle des céréales), mais, si elles sont utilisées en proportions trop importantes, les études sensorielles révèlent qu’elles apportent de l’amertume ou des goûts inhabituels mal perçus par les jurys et les consommateurs.

Comment épaissir et retenir l’eau ?

Des agents de texture (hydrocolloïdes) sont incorporés dans plus de 80 % des recettes pour leurs propriétés épaississantes et leur forte capacité à retenir l’eau. Ils permettent aussi d’augmenter la viscosité du mélange, afin de mieux retenir les gaz de fermentation et la levée de la pâte. Le plus fréquemment utilisé est l’hydroxypropyl méthylcellulose (HPMC). Les gommes de xanthane, de guar ou de caroube sont aussi utilisées, car elles présentent une meilleure capacité de rétention d’eau. Des pectines sont parfois ajoutées, mais moins fréquemment que le psyllium (plantain des Indes), reconnu aussi pour ses effets bénéfiques sur la santé (traitement des diarrhées et de la constipation, régulation de la glycémie et de la lipidémie).

Quelles protéines rajouter ?

À côté de l’amidon et des ingrédients structurants, les protéines les plus fréquemment incorporées proviennent de l’œuf, entier ou blanc, ou du soja. On peut citer aussi les protéines de pois, de lupin ou de lait. L’ajout de protéines permet en outre de développer des arômes lors de la cuisson, par le biais de la réaction de Maillard.

Pourquoi rajouter du sucre ?

La plupart des pains sans gluten contiennent des sucres ajoutés : saccharose le plus souvent, glucose, fructose, sirops d’origines diverses (betterave, canne à sucre, sirop de maïs, de riz ou d’agave). Les sucres sont ajoutés pour servir de « carburant » aux levures et amener le développement d’arômes et de la coloration lors de la cuisson, toujours par le biais de la réaction de Maillard.

À lire aussi : Les aliments sans gluten contiennent souvent moins de fibres et plus de sucre que leurs contreparties avec gluten

Certains rajoutent aussi du gras…

Des huiles et des matières grasses sont également incorporées afin de renforcer la sensation d’humidité en bouche, d’améliorer la texture (pains moins durs, mie plus souple) ainsi que la durée de conservation, très souvent jugée décevante. Les huiles de colza/canola, tournesol et soja sont les plus utilisées devant l’huile d’olive, la margarine ou l’huile de palme.

… et encore de nombreux additifs

Parmi les ingrédients mineurs, on retrouve :

des émulsifiants utilisés pour stabiliser les bulles et les uniformiser dans la pâte, ou encore pour limiter les pertes en eau au cours du temps. Parmi les plus employés, on trouve les mon – -o- et diglycérides d’acides gras et les lécithines ;

les conservateurs comme l’acide propionique, le glycérol, les sorbates ;

des agents levants, naturels comme les levures et les levains, ou chimiques comme le bicarbonate de sodium ;

des acides pour améliorer la conservation en diminuant le pH et pour produire du CO2 avec le bicarbonate ;

des arômes ;

des graines entières ou broyées de lin, tournesol, sésame, pavot, chia ou courge qui vont apporter des oméga-3 et des oméga-6 et masquer certains goûts désagréables ;

des fibres en plus des hydrocolloïdes, pour enrichir les pains sur le plan nutritionnel et pour augmenter la capacité de rétention d’eau (inuline, fibres de pomme ou de betterave) ;

des enzymes pour former des liaisons entre les polymères entrant dans la composition du pain ou pour produire des sucres pour les levures ;

du sel…

Et de l’eau, dont la proportion varie, selon les ingrédients ajoutés, de 50 à 220 %.

Les pâtes et biscuits sans gluten : moins d’additifs ?

Contrairement au pain, les pâtes alimentaires et les biscuits ont des listes d’ingrédients beaucoup plus courtes. Dans le cas des pâtes alimentaires, la substitution du blé dur par 100 % de légumineuses (pois chiches, lentilles) est maintenant fréquente. Cependant, la grande majorité des pâtes sont élaborées à partir de farine de riz ou de maïs ou encore de mélanges des deux. Dans quelques cas, on retrouve des émulsifiants (mono – et diglycérides d’acides gras). La composition des biscuits est également plus « légère », dans la mesure où la pâte n’est pas levée. Là encore, les ingrédients de base sont l’amidon de maïs et la farine de riz, additionnés de sucre, de matières grasses, de levure chimique et de sel.

Les produits sans gluten sont-ils ultratransformés ?

Sur le plan organoleptique, des efforts ont été réalisés par les industriels pour améliorer les propriétés des produits sans gluten. À propos du pain, les critiques les plus fréquentes portent sur la texture qualifiée de dure et de friable, sur l’aspect des alvéoles parfois très grosses, sur le goût qualifié de fade ou de « carton ». Les reproches concernent aussi sa conservation. Les pâtes alimentaires sont, pour leur part, jugées plus proches, voire équivalentes aux analogues contenant du gluten.

Sur le plan nutritionnel, les produits sans gluten apparaissent de qualité inférieure à celle des équivalents qui en contiennent (pains, pâtes, biscuits, gâteaux, snacks, pizza).

Les auteurs ne travaillent pas, ne conseillent pas, ne possèdent pas de parts, ne reçoivent pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'ont déclaré aucune autre affiliation que leur organisme de recherche.

02.11.2025 à 08:56

Les frappes des États-Unis contre des bateaux en mer des Caraïbes répondent-elles à une stratégie cohérente ?

Jeffrey Fields, Professor of the Practice of International Relations, USC Dornsife College of Letters, Arts and Sciences

Texte intégral (2307 mots)

Une quinzaine de bateaux supposément remplis de drogue et de trafiquants ont été détruits par des frappes conduites par les forces armées des États-Unis au cours de ces dernières semaines. Des opérations illégales au regard du droit international, que l’administration Trump justifie en affirmant que le trafic de drogue relève du terrorisme. Alors que le Venezuela de Nicolas Maduro n’est qu’un acteur secondaire dans l’afflux de drogue vers les États-Unis, Washington affirme que le régime de Caracas organise sciemment ce trafic et laisse entendre qu’une opération de changement de régime pourrait être prochainement menée à son encontre.

« Je pense que nous allons simplement tuer les personnes qui font entrer de la drogue dans notre pays. D’accord ? Nous allons les tuer. Vous savez, ils vont être, genre, morts », a déclaré Donald Trump fin octobre 2025 à propos des frappes militaires américaines contre des bateaux dans la mer des Caraïbes, au nord du Venezuela.

À ce jour, quatorze bateaux ont été frappés, ce qui a causé la mort de 43 personnes. L’administration a affirmé, sans en fournir la moindre preuve, que ces embarcations étaient exploitées par des trafiquants de drogue.

Le 24 octobre, Washington a lancé un renforcement militaire de grande envergure dans la région. Le Pentagone a déployé dans les Caraïbes le porte-avions USS Gerald-R.-Ford et une partie de son groupe aéronaval, ainsi que plusieurs autres navires de guerre, et a transféré à Porto Rico des avions de combat F-35. Il s’agit du plus important déploiement naval américain dans la mer des Caraïbes depuis la crise de Cuba en 1962.

Selon la Maison Blanche, ce renforcement naval et les frappes contre des bateaux dans les eaux internationales s’inscrivent dans les opérations de lutte contre le trafic de drogue. Les navires visés appartiendraient à des trafiquants de drogue vénézuéliens, bien que l’administration n’ait fourni aucune preuve de la présence de drogue à bord ni précisé de quelles drogues il s’agirait, Trump ayant seulement affirmé que du fentanyl pourrait être transporté par ce biais.

À plusieurs reprises, le président et certains de ses conseillers ont qualifié les exploitants et les occupants des bateaux de « narco-terroristes ». Mais ils n’ont jamais expliqué pourquoi ces personnes devraient être considérées comme des terroristes. Au-delà de la question de la lutte contre le trafic de drogue, Trump et son entourage ont également laissé entendre qu’ils cherchent à renverser le gouvernement de Nicolás Maduro au Venezuela.

Ancien analyste politico-militaire et ancien conseiller principal au département de la défense, je peine à discerner dans l’action de l’administration Trump une stratégie ou un objectif cohérent.

La lutte contre le trafic de drogue, une justification discutable

Les bateaux qui ont été interceptés provenaient tous du Venezuela ou avaient des liens avec ce pays, et tous ont été interceptés dans la mer des Caraïbes et dans le Pacifique au nord de la Colombie, ce qui rend cette opération particulièrement déroutante.

Le Venezuela n’est pas un grand producteur de fentanyl ou de cocaïne. Les principales routes du trafic de cocaïne se trouvent dans l’océan Pacifique, et non dans les Caraïbes.

En règle générale, c’est dans les eaux internationales que les garde-côtes états-uniens interceptent les navires soupçonnés de transporter de la drogue. En 2025, la garde côtière a intercepté une quantité record de drogues et de précurseurs chimiques dans les Caraïbes. Il est à noter que la quantité de précurseurs chimiques de la méthamphétamine interceptée dépasse de loin celle du fentanyl.

Après l’interception, les garde-côtes sont censés engager une procédure conforme aux contraintes légales, en interpellant l’équipage avant de le remettre à une agence états-unienne chargée de l’application de la loi.

Mais les frappes de Trump ont tué sans sommation la plupart des personnes se trouvant à bord des bateaux et ont vraisemblablement détruit toutes les drogues illicites présumées. De nombreux observateurs et experts juridiques estiment que ces meurtres équivalaient à des assassinats extrajudiciaires.

Le Venezuela dans le viseur de Donald Trump

Trump est obsédé depuis un certain temps par le gang vénézuélien Tren de Aragua, ce qui renforce l’intérêt que son administration porte au Venezuela.

En janvier, Washington a désigné Tren de Aragua comme organisation terroriste, au même titre que plusieurs autres cartels de la drogue. Mais le communiqué de la Maison Blanche annonçant cette désignation ne mentionnait aucun comportement ou activité constitutifs de terrorisme. En effet, la législation des États-Unis définit le terrorisme comme un acte de violence à motivation politique, visant généralement la population civile, dans le but de provoquer un changement politique.

La désignation d’un groupe, quel qu’il soit, comme « organisation terroriste étrangère » présente l’avantage de permettre au gouvernement de prendre des mesures telles que la saisie des avoirs et l’imposition de restrictions de voyage à l’encontre des personnes qui y sont associées.

Il reste qu’accoler cette qualification à un gang criminel dénué d’idéologie et d’objectifs politiques clairs donne une image erronée de Tren de Aragua, et invite à s’interroger sur les motivations de la Maison Blanche.

Et puis, il y a eu l’étrange incident de l’opération secrète qui ne fut pas si secrète que ça.

Début octobre, le New York Times a rapporté que Trump avait donné son aval à des opérations secrètes au Venezuela et autorisé la CIA à mener des « frappes meurtrières » à l’intérieur du pays.

Étonnamment, Trump a confirmé qu’il avait effectivement donné son feu vert à des opérations secrètes. Or, la caractéristique principale d’une opération secrète est normalement que le rôle du gouvernement qui l’ordonne demeure caché.

L’obsession de Trump pour le Venezuela remonte à son premier mandat, lorsqu’il avait déjà le régime de Maduro dans le collimateur. En mars 2020, son administration a accusé Maduro d’être à la tête du Cartel de los Soles – le cartel des soleils – un réseau criminel informel lié à de hauts responsables militaires vénézuéliens soupçonnés d’avoir organisé un trafic de drogue vers les États-Unis. Et en 2025, la Maison Blanche a affirmé que Maduro contrôlait Tren de Aragua.

Des observateurs indépendants affirment que le leader de l’opposition Edmundo González Urrutia a facilement remporté l’élection présidentielle de 2024. La commission électorale, contrôlée par le gouvernement, a toutefois déclaré Maduro vainqueur. Si la Maison Blanche entend favoriser un changement de régime au Venezuela, comme l’ont suggéré certains responsables anonymes, les récents propos de Trump ont sans doute incité Maduro à se préparer à une telle éventualité.

Aspects juridiques

Si l’objectif de l’administration est d’interdire les drogues dangereuses comme la cocaïne, la Colombie est une source beaucoup plus importante. Le Venezuela joue principalement un rôle de canal de transit mineur plutôt que celui de producteur.

En ce qui concerne l’atténuation des effets des drogues et des stupéfiants aux États-Unis, de nombreuses études menées au cours des dernières décennies ont montré que les mesures prises pour réduire la demande à l’intérieur du pays plutôt qu’à s’en prendre à l’offre sont plus efficaces en la matière.

En l’absence d’informations publiques suggérant l’existence d’une stratégie ou d’un objectif global, les problèmes juridiques liés aux frappes maritimes deviennent évidents.

Le secrétaire d’État Marco Rubio a déclaré que tout cela relevait d’« opérations de lutte contre le trafic de drogue ». Mais il est allé plus loin en affirmant qu’au lieu d’intercepter les bateaux, ceux-ci seraient détruits.

La méthode consistant à intercepter et détruire les bateaux et à tuer les personnes à bord pose de nombreux problèmes juridiques, notamment en ce qui concerne l’exécution de missions de maintien de l’ordre par les forces armées des États-Unis. Cela est interdit par la loi Posse Comitatus Act, qui interdit clairement aux forces armées fédérales d’exercer des activités de maintien de l’ordre.

En ce qui concerne les mesures visant le Venezuela, Trump a affirmé qu’il ne demanderait pas au Congrès de déclarer la guerre, mais qu’il l’informerait de toute opération terrestre.

Le War Powers Act (loi sur les pouvoirs de guerre, adoptée en 1973) qui oblige le président à informer le Congrès avant toute opération militaire et à lui rendre compte après coup, devrait s’appliquer à cette situation. Mais depuis son adoption, presque tous les présidents l’ont ignorée à un moment ou à un autre.

Bien que certains républicains au Congrès se soient opposés aux actions militaires menées jusqu’à présent, le Sénat a rejeté début octobre une résolution qui aurait empêché de nouvelles frappes dans les Caraïbes.

L’administration Trump continue de présenter ses activités dans les eaux internationales comme une opération militaire et les passeurs comme des combattants ennemis. La plupart des spécialistes du droit rejettent cette position et qualifient ces frappes d’exécutions extrajudiciaires.

En réponse à une réaction désinvolte du vice-président J. D. Vance au sujet de ces opérations, le sénateur républicain Rand Paul a écrit sur X : « S’est-il déjà demandé ce qui se passerait si les accusés étaient immédiatement exécutés sans procès ni représentation ? Quelle pensée méprisable et irréfléchie que de glorifier le fait de tuer quelqu’un sans procès. »

Sur les opérations liées au Venezuela, les déclarations éparses de Trump et de ses conseillers, tels que Marco Rubio et le secrétaire à la défense Pete Hegseth, laissent en suspens de nombreuses questions : à ce stade, rien ne justifie que les bateaux soient détruits et leurs occupants tués plutôt qu’interceptés et arrêtés.

Jeffrey Fields a reçu des financements de la Carnegie Corporation de New York.

02.11.2025 à 08:56

Du car scolaire aux rues piétonnes, repenser le chemin de l’école

Sylvain Wagnon, Professeur des universités en sciences de l'éducation, Faculté d'éducation, Université de Montpellier

Texte intégral (1808 mots)

Selon leur lieu d’habitation, les enfants et les adolescents peuvent rejoindre en quelques minutes à pied leur établissement scolaire ou passer une dizaine d’heures par semaine dans les transports. Penser ces trajets n’est pas seulement une question de logistique et d’écologie, mais aussi d’égalité.

Chaque jour, près de 13 millions d’élèves en France effectuent un trajet plus ou moins long entre leur domicile et leur établissement scolaire. Qu’il dure quelques minutes à pied ou plus d’une heure en car, ce temps invisible structure les journées, pèse sur le sommeil et influence la réussite éducative.

Longtemps négligée, cette mobilité quotidienne fait aujourd’hui l’objet d’une attention nouvelle. En septembre 2025, l’Agence de la transition écologique (Ademe) a publié la première étude nationale à grande échelle sur la mobilité des enfants et adolescents intégrant les chemins de l’école : le transport scolaire est désormais un enjeu de santé publique, d’égalité et d’écologie.

Cars scolaires et inégalités territoriales

Le transport scolaire a une histoire. C’est une réalité depuis les années 1960, quand les premiers services départementaux se sont organisés pour desservir les collèges et lycées éloignés. En 1963, on comptait environ 4 000 circuits de car scolaire ; dix ans plus tard, ils étaient déjà plus de 23 000, bien au-delà de la simple croissance démographique. Ce développement répondait à une exigence d’égalité d’accès à l’enseignement dans les territoires ruraux.

Aujourd’hui, la compétence relève des Régions depuis la réforme de 2017. Elles organisent le transport de plus de 2 millions d’élèves en zones non urbaines, auxquels s’ajoutent environ 2 millions d’élèves transportés par les réseaux urbains (bus, tram, métro).

Au total, près d’un tiers des jeunes scolarisés utilisent chaque jour un mode de transport collectif pour rejoindre leur établissement. La pénurie actuelle de conducteurs de bus scolaires fragilise l’égalité d’accès à l’école, surtout dans les zones rurales dépendantes de ce mode de transport. Elle révèle une fracture territoriale croissante : quand certains élèves bénéficient de transports réguliers, d’autres voient leurs trajets rallongés ou compromis.

Quels moyens de transport pour aller à l’école ?

L’étude de 2025 de l’Ademe confirme la place centrale de la voiture dans les trajets domicile-école : un tiers des enfants l’utilisent chaque jour, et cette proportion grimpe à 54 % dans les DROM.

Les chiffres sont proches de ceux déjà relevés dans une étude de 2020 : la marche représente de son côté 25 % des déplacements, devant les transports collectifs urbains (19 %), le car scolaire (18 %) et le vélo (2 %). Si la marche reste dominante sur les trajets courts, son usage recule avec l’âge des élèves.

Toutefois, ces moyennes nationales masquent de fortes dynamiques locales : dans certaines villes, l’usage du vélo progresse de manière significative, porté par la création de pistes cyclables sécurisées. Ensuite, de multiples initiatives émergent pour favoriser les mobilités actives entre le domicile et l’école. Objet de plusieurs études, le pédibus, trajets encadrés à pied, organisés par des parents d’élèves et des bénévoles ou par les collectivités locales, demande une organisation et une réglementation, mais donnerait de réels résultats dans le domaine de la santé des élèves.

À lire aussi : Lutter contre la sédentarité des enfants : quel bilan pour les bus pédestres ?

De son côté, le vélobus, groupes d’enfants à vélo accompagnés par des adultes, connaît un réel succès, tout comme encore l’hippobus, calèche tirée par des chevaux expérimentée dans certaines communes. Ces dispositifs traduisent une volonté croissante des collectivités locales mais aussi des parents de repenser le trajet scolaire.

La géographie des trajets scolaires révèle de fortes disparités. Dans certains départements ruraux, un collégien peut passer jusqu’à deux heures par jour dans les transports, contre quelques minutes pour un élève de centre-ville.

À ces inégalités territoriales s’ajoutent des inégalités sociales : le coût des abonnements de transport peut peser lourdement sur les familles modestes, malgré les aides régionales ou départementales. Certaines collectivités pratiquent la gratuité, d’autres imposent des tarifs variables selon les revenus, ce qui nourrit un sentiment d’injustice.

L’étude de l’Ademe met également en lumière un recul de l’autonomie : l’âge du premier déplacement seul est aujourd’hui de 11,6 ans, contre 10,6 ans pour leurs parents. Les craintes parentales liées à la sécurité expliquent en partie ce recul, avec une différence marquée selon le genre. Les filles sont jugées plus vulnérables : 40 % des parents estiment qu’elles sont davantage exposées aux agressions, ce qui retarde leur autonomie.

Le poids du temps de trajet

Si le transport scolaire garantit l’accès à l’éducation, il pèse aussi sur le quotidien. Dans certains territoires, ce temps peut représenter jusqu’à dix heures hebdomadaires passées dans un car, réduisant le temps disponible pour les devoirs, pour les loisirs ou pour le repos.

Un élève qui passe plus d’une heure par jour dans les transports dort en moyenne une demi-heure de moins que ses camarades proches de l’école. Une enquête menée sur des lycéens a montré cette corrélation. Le transport scolaire n’est donc pas neutre : il conditionne directement la réussite éducative et le bien-être.

Une étude sur des adolescents montre que les longs trajets compromettent non seulement le sommeil, mais aussi les capacités cognitives, l’équilibre mental et les notes scolaires.

Les « rues scolaires » : des laboratoires d’innovation

Inspirées de la Grande-Bretagne et de la Belgique, les « rues scolaires » se développent en France depuis 2019. Le principe est simple : fermer temporairement à la circulation automobile la rue située devant une école aux heures d’entrée et de sortie scolaires. Les bénéfices observés sont nombreux : baisse mesurable de la pollution de l’air, réduction du bruit, amélioration du sentiment de sécurité et essor des mobilités actives.

À Paris, plus de 300 rues apaisées existent à cette rentrée 2025, couvrant près de la moitié des écoles primaires. Le mouvement s’étend désormais aux métropoles, mais aussi aux villes moyennes et aux villages, qui y voient un outil concret pour sécuriser et transformer les trajets domicile-école, mais aussi réduire leur pollution atmosphérique. Ces dispositifs contribuent également à renforcer l’autonomie des enfants, en leur permettant de se déplacer seuls ou entre pairs dans un environnement plus serein et moins anxiogène.

Les rues scolaires permettent de tester de nouvelles façons d’organiser l’espace public, tout en favorisant une appropriation collective de la rue par les enfants et les familles. Elles ne constituent pas seulement un aménagement technique, mais aussi une réflexion sociale et politique sur la place que l’on souhaite donner aux enfants dans la ville.

Transformer le trajet scolaire en moment éducatif

Ces expérimentations invitent à changer de regard sur le transport scolaire qui n’est pas un temps perdu, mais un espace d’apprentissage. Marcher ou pédaler vers l’école contribue à la santé physique et à l’autonomie. L’aménagement d’environnements sécurisés transforme le chemin de l’école en moment de socialisation entre parents, adultes et enfants. Dans certaines écoles, on l’intègre à des projets pédagogiques autour de la mobilité durable ou à des apprentissages sur l’espace local.

Le transport scolaire est donc bien plus qu’un dispositif technique : il structure le quotidien de millions d’élèves, il révèle les fractures territoriales et il influence directement la réussite éducative. Longtemps invisible, ce temps mérite d’être reconnu et repensé. Car l’expérience éducative ne se limite pas aux murs de la classe, elle commence dès le trajet et se prolonge dans la vie quotidienne des enfants.

Sylvain Wagnon n'a pas participé à l'étude de l'Ademe citée dans cet article.

02.11.2025 à 08:55

La notation de la France dégradée par les agences financières, mais toujours emprunteuse « sans risque » pour les régulateurs

Rémy Estran, CEO – Scientific Climate Ratings, EDHEC Business School

Texte intégral (1807 mots)

Malgré la dégradation de la note de la France de AA- à A+ en septembre 2025 par l’agence Fitch, puis en octobre 2025 par Standard & Poor’s, l’Hexagone est toujours considéré comme un emprunteur « sans risque » dans les bilans des banques et des assureurs. Pourquoi ce décalage ?

Vendredi 12 septembre 2025, Fitch a dégradé la note de la France de AA- à A+, après la clôture des marchés. Symboliquement, c’est un coup dur. Pour la première fois depuis plus de dix ans, la France a perdu son badge « double A ». Et pourtant, le lundi suivant, rien n’avait changé : le CAC 40 était en hausse et les spreads de crédit de la France étaient stables.

Rebelote un mois plus tard : le 18 octobre, Standard & Poor’s (S&P) abaisse à son tour la note de la France à A+. Là encore, aucune réaction notable des marchés – ni sur les spreads obligataires ni sur l’indice CAC 40. Le 24 octobre, Moody’s a pour sa part placé la note AA- de la France sous perspective négative.

L’explication courante ? Les marchés avaient déjà anticipé ces décisions. Mais est-ce vraiment toute l’histoire ?

Dans cet article, nous expliquons pourquoi, tant dans le cadre de la réglementation bancaire (Capital Requirements Regulation, CRR) relative aux exigences de fonds propres, que de la réglementation des assurances (Solvency II), la France est toujours considérée comme un emprunteur entrant dans la définition d’un pays « sans risque ».

Cela peut aider à comprendre l’impact limité jusqu’à présent des dégradations successives de Fitch et de Standard & Poor’s, tout en soulignant que les mécanismes bancaires et assurantiels à l’œuvre peuvent soudainement se transformer en couperet.

Notations vs échelons

Dans le cadre des approches standardisées, les réglementations prudentielles européennes (2024/1820 et 2024/1872 essentiellement) ne fonctionnent pas directement avec des notations alphabétiques, mais s’appuient sur des credit quality step (CQS), soit des échelons de qualité de crédit. Ces échelons sont des catégories générales qui regroupent plusieurs notations :

– CQS 0 : AAA (Solvency II uniquement ; le CRR ne comporte pas de niveau 0), comme l’Allemagne, la Suisse, le Danemark, les Pays-Bas ou la Suède.

– CQS 1 : AAA à AA- (CRR)/CQS 1 et AA+ à AA- (Solvency II), comme l’Autriche, la Finlande, l’Estonie, la Belgique ou la République tchèque.

– CQS 2 : A+ à A-, comme la Slovénie, la Slovaquie, la Pologne, la Lituanie ou la Lettonie.

– CQS 3 : BBB+ à BBB-, comme l’Italie, la Roumanie, la Bulgarie, la Croatie, ou la Hongrie.

– CQS 4-6 : notations spéculatives (BB+ et inférieures), comme la Serbie, le Monténégro, la Macédoine du Nord ou le Kosovo.

Techniquement, selon les réglementations bancaires et assurantielles, la dégradation de la note de la France par Fitch en septembre 2025 aurait pu la faire passer de CQS 1 à CQS 2. Mais ce n’est pas le cas.

Jusqu’en octobre 2025, date de la dégradation de la note française par Standard & Poor’s, ces deux cadres réglementaires continuaient de traiter la France comme un émetteur de très haute qualité, c’est-à-dire « AA » et non « A ». Cela tient à la manière dont les réglementations traitent les notes multiples : ni les banques ni les assureurs ne retiennent mécaniquement la note la plus basse.

Règle de la deuxième meilleure notation

En vertu de la réglementation bancaire et assurantielle européenne, la règle de la deuxième meilleure notation s’applique.

Par exemple, si un débiteur est noté par trois agences (S&P, Moody’s, Fitch), les notations la plus élevée et la plus basse sont écartées, et celle du milieu est retenue. Tant que deux des trois agences maintenaient la France dans la catégorie AA, la notation de référence aux fins du capital réglementaire restait CQS 1.

À lire aussi : Moody’s, Standard & Poor’s, Fitch… plongée au cœur du pouvoir des agences de notation

En d’autres termes, même après la dégradation par Fitch à A+, les régulateurs continuaient de classer la France comme « AA ». Ce n’est qu’après la dégradation par S&P, le 17 octobre 2025, que la France est effectivement passée en CQS 2. Moody’s, de son côté, a maintenu sa note AA-, mais l’a placée sous perspective négative le 24 octobre – un signal d’alerte, certes, mais sans conséquence réglementaire à ce stade.

Toutes les dégradations ne se valent pas. Certaines modifient immédiatement la manière dont les institutions financières européennes doivent traiter le risque. D’autres, en revanche, restent sans effet opérationnel. Et pourtant, aucune n’a véritablement fait réagir les marchés.

Illusion réglementaire de la sécurité

Pour la plupart des débiteurs, tels que les entreprises ou les institutions financières, le passage d’un échelon de qualité de crédit, ou credit quality step (CQS), à un autre a une incidence directe sur les exigences de fonds propres. Dans le cas particulier des États souverains européens, même un passage officiel au CQS 2 n’a guère d’importance.

En vertu des règles actuelles, les obligations souveraines de l’Union européenne libellées dans leur propre devise ont en effet une pondération de risque de 0 %. Pourquoi ?

Dans la pratique, les banques ne sont pas tenues de mettre de côté des fonds propres pour couvrir le risque de défaut des emprunts de la France libellés en euros, et ce, quelle que soit la note attribuée à cette dette par les agences de notation.

De même, les assureurs qui détiennent des obligations émises par les États de l’Union européenne (libellées dans leur propre monnaie) ne sont soumis à aucune exigence de capital pour se prémunir contre un éventuel défaut de paiement sur ces titres.

Les seules exigences de fonds propres pour ces obligations proviennent des risques dits « de marché » : le risque de taux d’intérêt, c’est-à-dire la perte potentielle liée à une hausse des taux, et le risque de change, en cas de variation défavorable des devises étrangères. Aucun capital n’est exigé au titre du spread de crédit, c’est-à-dire du risque que le marché exige une prime plus élevée pour prêter à l’État.

Les prêts à la France – ou à tout autre État souverain européen dans sa monnaie nationale – sont considérés comme sans risque de crédit. Ce cadre a été conçu pour éviter la fragmentation et traiter la dette publique de tout État membre européen comme la base du système financier, quelle que soit la situation individuelle de chaque pays.

Paradoxe systémique

Les marchés font bien sûr déjà la distinction entre les États souverains. Les écarts se creusent, les prix des credit defaut swaps (CDS) – qui permettent aux investisseurs de s’assurer contre le défaut d’un émetteur de dette – augmentent et les investisseurs exigent une prime pour les crédits les plus faibles, bien avant que la dégradation ne soit officielle.

Du point de vue des fonds propres réglementaires, le cadre existant ne laisse aucune place à une distinction progressive au sein de l’Union européenne. La conséquence est claire : les États souverains européens sont considérés comme « sûrs » par définition, jusqu’à ce qu’ils ne le soient plus…

Cela crée une sorte d’« effet de falaise » organique. Tant que la confiance institutionnelle reste suffisante, la réglementation atténue partiellement la reconnaissance du risque. Dès qu’un seuil est franchi – souvent un seuil de confiance, plutôt que purement comptable –, la correction devient brutale. Ce qui devrait être une réévaluation progressive se transforme en rupture systémique.

Il y a quinze ans, la crise de la dette publique en Grèce avait suffi à déclencher une crise à l’échelle européenne. Aujourd’hui, la France nous rappelle que l’architecture même de la réglementation européenne rend sa stabilité financière moins graduelle que binaire. Tant que les marchés y croient, tout tient. Mais si la confiance venait à se dérober, ce n’est pas seulement la France qui vacillerait – ce serait toute l’Europe.

Rémy Estran est président de l'EACRA (European Association of Credit Rating Agencies).

01.11.2025 à 19:48

Délibération budgétaire : le lent apprentissage de la démocratie parlementaire

Damien Lecomte, Chercheur associé en sciences politiques, Université Paris 1 Panthéon-Sorbonne

Texte intégral (1686 mots)

Avec le renoncement au 49.3, des discussions budgétaires inédites ont lieu entre groupes politiques à l’Assemblée nationale : le Parlement redevient un lieu de débats décisifs. Est-ce là une nouvelle étape dans le « réapprentissage » de la délibération parlementaire selon des standards européens ?

Après l’éclatement rapide de son gouvernement initial, le premier ministre Sébastien Lecornu est parvenu à survivre aux premières motions de censure déposées contre lui le 16 octobre en échange de deux engagements principaux envers la gauche – le Parti socialiste en particulier : la suspension de la réforme des retraites et le renoncement à l’article 49.3 de la Constitution.

Cette situation ouvre la voie à une vraie expérience de délibération parlementaire. De fait, les débats budgétaires à l’Assemblée nationale depuis le début de la session offrent un spectacle inhabituel : des députés mobilisés et nombreux, des chefs de partis très présents, des négociations pratiquées en pleine séance ou pendant les suspensions entre des blocs opposés… Le Parlement redevient un lieu de débats décisifs. Néanmoins, les chances de succès des discussions budgétaires sont minces et l’apprentissage du parlementarisme « à l’européenne » prend du temps.

Un budget dépendant des aléas de la délibération parlementaire

La décision de Sébastien Lecornu de renoncer à l’article 49.3 semblait s’imposer au premier ministre : en l’absence de majorité, cet article n’est plus une arme à toute épreuve pour le gouvernement, comme l’a démontré la censure de Michel Barnier en décembre 2024. Reste que la construction d’un compromis budgétaire par l’Assemblée nationale est très incertaine.

Le 49.3 offre en principe deux avantages principaux au premier ministre. D’une part, il dispense d’un vote sur le texte de loi lui-même – remplacé par un éventuel vote de censure. D’autre part, il lui permet de conserver le texte dans la version de son choix, avec les amendements déposés ou acceptés par lui. Il peut alors présenter à l’Assemblée nationale un choix de « tout ou rien », c’est-à-dire un budget à laisser passer tel quel ou à rejeter en bloc par la censure.

En l’absence de cette arme et pour la première fois depuis 2021, le projet de loi de finances (PLF) et le projet de loi de financement de la Sécurité sociale (PLFSS) dépendent donc des débats à l’Assemblée nationale. À partir du texte initial déposé par le gouvernement (rectifié pour inclure la suspension de la réforme des retraites), le texte final résultera des votes des députés sur chaque article et chaque amendement déposé. Cela implique de trouver une majorité de suffrages exprimés favorables à chaque disposition pour que celle-ci figure dans le texte de l’Assemblée nationale.

Le droit d’amendement des députés et les discussions parlementaires restent certes enserrés de contraintes, entre la recevabilité financière des amendements déposés par les élus (exigée par l’article 40 de la Constitution), la possibilité pour le gouvernement d’imposer un vote unique sur un ensemble de dispositions (procédure du « vote bloqué » de l’article 44.3) et la poursuite de la navette parlementaire à laquelle participera le Sénat. Il n’en reste pas moins que les députés auront le dernier mot et qu’une majorité de votes « pour » à l’Assemblée nationale sera nécessaire à l’adoption du texte. Autrement dit, l’adoption du PLF et du PLFSS par le Parlement nécessitera le vote « pour » d’au moins une partie des groupes d’opposition, et non pas seulement leur abstention.

Toute la difficulté est donc de trouver le point d’équilibre – s’il existe – qui fasse le moins mal possible à des groupes d’opposition pour leur permettre d’assumer de voter le texte – de revendiquer des victoires malgré les concessions.

Le risque est donc grand que les débats dans l’hémicycle aboutissent plutôt, que ce soit sur chaque article ou sur le texte final, à des majorités « négatives » qui coalisent les votes « contre » de plusieurs groupes, parfois pour des raisons opposées. Les différents blocs parlementaires pourraient donc rejeter mutuellement leurs propositions sans parvenir à un accord majoritaire – une issue fort vraisemblable.

L’absence persistante d’un vrai accord préalable

Devant la crise politique qui s’éternise depuis l’été 2024, les pratiques évoluent doucement. L’importance prise par les négociations entre Sébastien Lecornu et le Parti socialiste et les vraies concessions annoncées par le premier ministre vont bien plus loin que ce que François Bayrou avait pu tenter. Mais les pratiques françaises ne rejoignent pas encore les standards des pratiques européennes.

L’adoption des lois budgétaires nécessiterait un compromis global préalable, même a minima, entre le gouvernement, les groupes minoritaires – principalement LR – et une partie des groupes d’opposition – le PS étant a priori le plus ouvert à cet égard. Un tel compromis global devrait fixer les grands équilibres et les principales concessions que les parties prenantes s’engagent à se faire mutuellement, quitte à se faire violence.

Dans les régimes parlementaires européens plus habitués à la négociation parlementaire et à la construction de coalitions post-électorales – dont l’Allemagne est l’exemple le plus évident – la pratique la plus courante consiste à mettre au clair, avant les débats au Parlement proprement dits, un accord entre forces politiques. Les gouvernements de coalition les plus durables sont, sans surprise, ceux qui s’appuient sur un « contrat de coalition » le plus complet et détaillé possible. Dans ce cas, les parlementaires peuvent devoir voter des textes qui leur déplaisent, mais le font pour remplir leur part du « contrat de coalition », en échange de la même discipline de la part de leurs partenaires pour les dispositions qui leur tiennent à cœur.

Lorsque les partis partenaires ne parviennent pas à se mettre d’accord au préalable sur certains sujets plus clivants, ils se mettent d’accord sur un renvoi ultérieur du débat et sur des procédures pour trancher les désaccords – par exemple en prévoyant un « comité de coalition » réunissant les membres des directions partisanes et chargé d’arbitrer le moment venu lorsqu’une décision doit être prise. Des procédures visant à éviter les mauvaises surprises et ne pas s’en remettre à l’incertitude des rapports de force en assemblée ou à la cacophonie gouvernementale.

La France est encore loin d’avoir institutionnalisé un mode de fonctionnement parlementaire fondé sur la négociation et le compromis. Aucun accord formel et encore moins de contrat de législature n’existe entre le gouvernement et les groupes minoritaires et d’opposition – pas plus qu’il n’en a existé entre les partenaires de la défunte coalition du « socle commun ».

Une adoption du budget très improbable

À cet égard, il est très révélateur que l’annonce de la suspension de la réforme des retraites par le premier ministre, la plus importante concession faite au PS en échange de sa non-censure, n’engage pas automatiquement sa propre base parlementaire, puisque les députés Renaissance sont divisés sur le vote de ce compromis, mollement défendu par le président Macron, et que la position collective du groupe s’est orientée vers un refus de la voter, quitte à mettre en péril l’adoption du PLFSS.

Elle engage encore moins les parlementaires LR : le président du Sénat Gérard Larcher a déjà annoncé que la droite sénatoriale supprimerait la suspension de la réforme des retraites. À tout cela s’ajoute les désaccords apparemment irréductibles entre PS et LR sur la fiscalité et notamment la taxation des plus riches, alors qu’une version même « allégée » de la taxe Zucman est exigée par les socialistes.

L’absence d’accord de compromis préalable sur au moins quelques grandes mesures, acceptées par une majorité de groupes parlementaires, donne certes tout son intérêt à la délibération dans l’hémicycle, mais laisse très incertaine, pour ne pas dire très improbable, l’adoption d’un budget pour l’État et la Sécurité sociale. Le processus d’adaptation de la politique française à l’absence de majorité à l’Assemblée nationale est donc loin d’être terminé.

Damien Lecomte ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

01.11.2025 à 15:21

La course à la bombe : encore ?

Cyrille Bret, Géopoliticien, Sciences Po

Texte intégral (2338 mots)

L’arme nucléaire revient sur le devant de la scène internationale, avec les annonces successives, par Vladimir Poutine, du développement de nouveaux armements, et par Donald Trump de la reprise d’essais. Les traités de limitation des armements sont de plus en plus ignorés et cette nouvelle course entre les deux (anciens) Grands de la guerre froide pourrait, cette fois, inciter plusieurs nouveaux participants à entrer dans la compétition…

Depuis une semaine, l’actualité stratégique est devenue retro. Elle a repris une chorégraphie très « années 1950 » car elle a été bousculée par le retour du nucléaire au-devant de la scène internationale.

Le 26 octobre dernier, en treillis et en vidéo, Vladimir Poutine présente (à nouveau) le missile expérimental russe Bourevstnik (« annonceur de tempête »), doté d’une tête et d’un système de propulsion nucléaires. Quelques jours plus tard, c’est au tour d’un drone sous-marin à propulsion nucléaire, le Poséidon, déjà présenté il y a quelques années, d’avoir les honneurs des autorités russes qui proclament qu’il est indétectable et pourrait venir percuter les côtes ennemies et y faire exploser une charge nucléaire. Enfin, le 29 octobre, Donald Trump annonce sur le réseau Truth Social la reprise des essais pour « les armes nucléaires », une première depuis l’adoption du Traité sur l’interdiction des essais nucléaires en 1996.

Cette guerre des communiqués a déclenché l’onde de choc d’une bombe – médiatique, fort heureusement – dans les milieux stratégiques. En effet, depuis l’invasion de l’Ukraine par la Russie en 2022, la guerre d’Israël contre le Hamas dans la bande de Gaza, le bombardement de l’Iran par les États-Unis et la guerre Inde-Pakistan du début de l’année, l’attention des analystes militaires s’était portée sur les armements traditionnels (blindés, missiles, munitions, chasseurs) et sur les systèmes innovants (drones, artillerie mobile, munitions guidées, bombes perforatrices).

Dans cette séquence en Technicolor et en Mondovision, tout se passe comme si le célèbre Dr. Folamour du film de Stanley Kubrick (1964) faisait son grand retour : ce personnage de fiction, scientifique nazi employé par l’armée américaine, paraît comme rappelé à la vie par la nouvelle guerre froide que se livrent les grandes puissances militaires dotées de l’arme atomique, à savoir les États-Unis, la Fédération de Russie et la République populaire de Chine, respectivement pourvues d’environ 3700, 4200 et 600 ogives nucléaires. Ce parfum de course à la bombe fleure bon les années 1950, les Cadillac roses et les défilés sur la place Rouge.

Pourquoi la course aux armements nucléaires est-elle aujourd’hui relancée, du moins au niveau médiatique ? Et quels sont les risques dont elle est porteuse ?

Essais nucléaires américains et surenchères médiatiques

En annonçant la reprise des essais nucléaires sur le sol des États-Unis, Donald Trump s’est montré aussi tonitruant que flou. Dans ce domaine-là comme dans tous les autres, il a voulu claironner le Make America Great Again qui constitue son slogan d’action universelle pour rendre à l’Amérique la première place dans tous les domaines.

En bon dirigeant narcissique, il a voulu occuper seul le devant de la scène médiatique en répliquant immédiatement aux annonces du Kremlin. En bon animateur de reality show, il a volé la vedette atomique à son homologue russe. Invoquant les initiatives étrangères en la matière, il a endossé son rôle favori, celui de briseur de tabous, en l’occurrence le traité d’interdiction complète des essais nucléaires (TICEN) adopté en 1996 par l’Assemblée générale des Nations unies, avec le soutien des États-Unis de Bill Clinton, érigés en gendarme du monde.

Le message trumpien procède d’une surenchère évidente sur les annonces du Kremlin : comment Donald Trump aurait-il pu laisser toute la lumière à Vladimir Poutine en matière d’innovations nucléaires de défense ? Il lui fallait réagir par une annonce plus forte, plus choquante et plus massive. C’est tout le sens de la reprise des essais sur « les armements nucléaires ». Personne ne sait s’il s’agit de tester de nouvelles ogives, de nouveaux vecteurs, de nouveaux modes de propulsion ou de nouvelles technologies de guidage. Mais tout le monde retient que c’est le président américain qui a officiellement relancé et pris la tête de la course mondiale à la bombe. C’était le but visé. Examinons maintenant ses conséquences.

À moyen terme, cette déclaration n’a rien de rassurant : les États-Unis, première puissance dotée historiquement et deuxième puissance nucléaire par le nombre d’ogives, envoient par cette annonce un « signalement stratégique » clair au monde. Ils revendiquent le leadership en matière d’armes nucléaires (dans tous les domaines) en dépit du rôle essentiel qu’ils ont joué depuis les années 1980 pour le contrôle, la limitation et la réduction des armes nucléaires.

En effet, les différents traités signés et renouvelés par Washington – Traité sur les forces nucléaires à portée intermédiaire (1987), START I (1991), II (1993) et New START (2010), TICEN, etc. – avaient tous pour vocation de dire au monde que les États-Unis se donnaient comme horizon la dénucléarisation des relations internationales ainsi que de l’espace et même la suppression de l’arme comme le souhaitait le président Obama.

Avec cette annonce – qu’on espère réfléchie même si elle paraît compulsive –, les États-Unis changent de rôle mondial : ils cessent officiellement d’être un modérateur nucléaire pour devenir un moteur de la nucléarisation des relations internationales.

L’avenir du nucléaire : dissuasion ou suprématie ?

La tonalité qui se dégage de cette guerre des communiqués atomiques ressemble à s’y méprendre à la première guerre froide et à la course-poursuite à laquelle elle avait donné lieu. Après avoir conçu, produit et même utilisé l’arme atomique en 1945 contre Hiroshima et Nagasaki, les États-Unis avaient continué leur effort pour obtenir la suprématie nucléaire dans le domaine des vecteurs, des milieux (air, terre, mer) et des technologies de guidage. L’URSS de Staline avait, elle, d’abord cherché à briser le monopole américain sur l’arme nucléaire puis gravi tous les échelons technologiques pour devenir une puissance nucléaire à parité avec ce qu’on appelait alors le leader du monde libre.

Le pivot historique doit être noté, surtout s’il se confirme par une course aux armements. Jusqu’à la guerre d’Ukraine, les armes nucléaires faisaient l’objet de perfectionnements technologiques réguliers. Mais le cadre de leur possession restait inchangé : elles devaient constituer un outil de dissuasion. Autrement dit, elles devaient rester des armements à ne jamais utiliser. Les signalements stratégiques sont aujourd’hui sensiblement en rupture avec cette logique établie depuis les années 1980.

Depuis le début de la guerre d’Ukraine, le Kremlin laisse régulièrement entendre qu’un usage sur le champ de bataille (le fameux « nucléaire tactique ») n’est pas à exclure en cas de risque pour les intérêts vitaux russes. De même, les États-Unis viennent de faire comprendre que leur priorité n’est plus la lutte contre la prolifération nucléaire, qu’elle soit nord-coréenne ou iranienne. Si le message de Donald Trump sur Truth Social est suivi d’effets, la priorité nucléaire américaine sera la reconquête de la suprématie nucléaire en termes de quantité et de qualité.

Autrement dit, les anciens rivaux de la guerre froide relancent une course aux armements nucléaires au moment où les instruments internationaux de limitation et de contrôle sont démantelés ou obsolètes. Ils ne luttent plus pour se dissuader les uns les autres d’agir. Ils participent à la course pour l’emporter sur leurs rivaux. Le but n’est plus la MAD (Mutual Assured Destruction) mais la suprématie et l’hégémonie atomique.

L’effet d’imitation risque d’être puissant, donnant un nouvel élan aux proliférations.

De la compétition internationale à la prolifération mondiale ?

Si les annonces russo-américaines se confirment, se réalisent et s’amplifient sous la forme d’une nouvelle course aux armements nucléaires, trois ondes de choc peuvent frapper les relations stratégiques à court et moyen terme.

Premier effet de souffle, au sein du club des puissances officiellement dotées de l’arme nucléaire au sens du Traité de Non-Prolifération (TNP), la République populaire de Chine ne pourra pas se laisser distancer (quantitativement et qualitativement) par son rival principal, les États-Unis et par son « brillant second », la Russie. En conséquence, la RPC s’engagera progressivement dans un programme visant à combler son retard en nombre de têtes et dans la propulsion des vecteurs. Cela militarisera encore un peu plus la rivalité avec les États-Unis et « l’amitié infinie » avec la Russie. Il est à prévoir que de nouveaux armements nucléaires seront développés, adaptés à l’aire Pacifique et dans les espaces que la Chine conteste aux États-Unis : Arctique, espace, fonds marins… Il est également à prévoir que la Chine s’attachera à développer des systèmes de lutte contre ces nouveaux vecteurs à propulsion nucléaire.

Le deuxième effet sera, pour les Européens, une interrogation sur les ressources à consacrer à leurs propres programmes nucléaires, de taille réduite car ils sont essentiellement axés sur la dissuasion stratégique. S’ils refusent de s’y engager pour concentrer leurs ressources sur les armes conventionnelles, ils risquent un nouveau déclassement. Mais s’ils se lancent dans la compétition, ils risquent de s’y épuiser, tant leur retard est grand. Nucléarisés mais appauvris. Ou bien vulnérables mais capables de financer le réarmement conventionnel.

À lire aussi : Les défis du réarmement de l’Europe : réveil stratégique ou chaos organisé ?

Enfin, le troisième effet indirect des déclarations russo-américaines sur la reprise de la course aux armements sera la tentation, pour de nombreux États, de se rapprocher du seuil afin de garantir leur sécurité. Si l’Arabie saoudite, la Corée du Sud, la Pologne et même le Japon et l’Allemagne considèrent que leur sécurité nécessite des armes nucléaires et que le cadre du TNP est obsolète, alors la prolifération risque de reprendre de plus belle, à l’ombre des menaces nord-coréennes et iraniennes.

À lire aussi : Nouveau partenariat Arabie saoudite-Pakistan : quelles conséquences internationales ?

De Dr. Folamour à Dr. Frankenstein

Les annonces russes, américaines et, n’en doutons pas, bientôt chinoises sur les armements nucléaires présagent d’une nouvelle phase dans les affaires stratégiques, celle d’une compétition majeure sur toutes les technologies liées à ces armes complexes. Si la tendance se confirme, les armes nucléaires, leurs vecteurs, leurs usages et leurs doctrines seront de nouveau propulsés au premier plan du dialogue compétitif entre puissances. Et l’espace sera lui-même susceptible de devenir le nouvel espace de la compétition nucléaire.

Vivons-nous pour autant une régression historique vers la guerre froide ?

La donne est bien différente de celle des années 1950, quand le but des puissances communistes était de rattraper leur retard sur les armes américaines (acquisition de la bombe, passage au thermonucléaire). Et le débat stratégique est bien distinct de celui des années 1970, quand la compétition était quantitative (combien de têtes ? Combien de vecteurs ?).

Aujourd’hui, les risques liés aux armes nucléaires sont différents : démantèlement progressif des traités de limitation et de contrôle de ces armes, tentation retrouvée de se porter au seuil pour les puissances non dotées et surtout réflexion sur un usage (et non plus sur la dissuasion).

Ce n’est pas Dr. Folamour qui a connu une résurrection, c’est un nouveau Dr. Frankenstein qui s’est lancé dans des expérimentations.

Cyrille Bret ne travaille pas, ne conseille pas, ne possède pas de parts, ne reçoit pas de fonds d'une organisation qui pourrait tirer profit de cet article, et n'a déclaré aucune autre affiliation que son organisme de recherche.

01.11.2025 à 15:19

Au Royaume-Uni, l'influence cachée des militaires derrière le nouvel engouement pour les petits réacteurs nucléaires

Phil Johnstone, Visiting Fellow, School of Global Studies, University of Sussex; University of Tartu; Utrecht University

Andy Stirling, Professor of Science & Technology Policy, SPRU, University of Sussex Business School, University of Sussex

Texte intégral (2170 mots)

Outre-Manche, les petits réacteurs modulaires sont présentés comme une solution énergétique, mais servent d'abord les besoins stratégiques des armées. En subventionnant le nucléaire civil, citoyens et consommateurs financent indirectement la puissance militaire.

La récente visite de Donald Trump au Royaume-Uni a donné lieu à un «partenariat historique» sur l'énergie nucléaire. Londres et Washington ont annoncé leur intention de construire 20 petits réacteurs modulaires et de développer également la technologie des microréacteurs – et ce alors qu'aucune de ces installations n'a encore été construite commercialement nulle part dans le monde.

Le premier ministre britannique, Keir Starmer, a promis que ces projets inaugureraient un «âge d'or» du nucléaire qui permettrait aussi de «faire baisser les factures». Pourtant, l'histoire de l'énergie nucléaire est faite de décennies de surenchère, de coûts faramineux et de retards à répétition. Partout dans le monde, les tendances vont dans la mauvaise direction.

Alors pourquoi un tel regain d'enthousiasme pour le nucléaire ? Les véritables raisons tiennent moins à la sécurité énergétique ou au changement climatique – et bien davantage à la puissance militaire.

À première vue, l'argument semble évident. Les partisans du nucléaire présentent les petits réacteurs modulaires, ou SMR, comme indispensables pour réduire les émissions et répondre à une demande croissante d'électricité, alimentée par les voitures et les centres de données. Les grandes centrales nucléaires étant désormais devenues trop coûteuses, les réacteurs de taille réduite sont promus comme une alternative enthousiasmante.

Mais aujourd'hui, même les analyses les plus optimistes de l'industrie reconnaissent que le nucléaire – y compris les SMR – a peu de chances de rivaliser avec les énergies renouvelables. Une étude publiée plus tôt cette année dans le New Civil Engineer concluait que les SMR sont «la source d'électricité la plus coûteuse par kilowatt produit, comparée au gaz naturel, au nucléaire traditionnel et aux renouvelables».

Des évaluations indépendantes – notamment celle de l'ex-pro-nucléaire Royal Society – montrent que des systèmes 100 % renouvelables surpassent tout système incluant du nucléaire en termes de coût, de flexibilité et de sécurité. Cela contribue à expliquer pourquoi des analyses statistiques mondiales révèlent que l'énergie nucléaire n'est généralement pas associée à une réduction des émissions de carbone, contrairement aux renouvelables.

En partie, l'enthousiasme pour les SMR s'explique par le fait que les voix institutionnelles les plus audibles ont souvent un mandat ou des intérêts pronucléaires : il s'agit de l'industrie elle-même et de ses fournisseurs, des agences nucléaires et des gouvernements dotés de programmes militaires nucléaires bien ancrés. Pour ces acteurs, la seule question est de savoir quels types de réacteurs développer, et à quelle vitesse. Ils ne se demandent pas s'il faut construire des réacteurs en premier lieu : la nécessité est considérée comme une évidence.

Au moins, les grandes centrales nucléaires ont bénéficié d'économies d'échelle et de décennies d'optimisation technologique. Beaucoup de conceptions de SMR ne sont encore que des «réacteurs PowerPoint», existant uniquement sous forme de diapositives et d'études de faisabilité. Les affirmations selon lesquelles ces projets non réalisés «coûteront moins cher» relèvent au mieux de la spéculation.

Les marchés financiers le savent. Si les investisseurs considèrent la frénésie autour des SMR comme une occasion de profiter de milliards de subventions publiques, leurs propres analyses se montrent nettement moins enthousiastes quant à la technologie elle-même.

Alors pourquoi, dès lors, un tel intérêt pour le nucléaire en général et pour les réacteurs de petite taille en particulier ? Il est évident que quelque chose d'autre se joue derrière cette mise en avant.

Le lien caché

Le facteur négligé est la dépendance des programmes militaires vis-à-vis des industries nucléaires civiles. Le maintien d'une marine nucléaire ou d'un arsenal nucléaire exige un accès constant à des technologies de réacteurs génériques, à une main-d'œuvre hautement qualifiée et à des matériaux spécifiques. Sans industrie nucléaire civile, les capacités militaires nucléaires deviennent beaucoup plus difficiles et coûteuses à entretenir.

Les sous-marins nucléaires occupent une place particulièrement centrale, car ils nécessiteraient très probablement l'existence d'industries nationales de réacteurs et de leurs chaînes d'approvisionnement même en l'absence d'un programme nucléaire civil. Déjà difficilement abordables pris individuellement, les sous-marins nucléaires deviennent encore plus coûteux si l'on prend en compte l'ensemble de cette «base industrielle sous-marine».

Rolls-Royce constitue un maillon essentiel de cette chaîne : l'entreprise construit déjà les réacteurs des sous-marins britanniques et doit produire les SMR civils récemment annoncés. Elle déclarait d'ailleurs ouvertement en 2017 qu'un programme de SMR civils permettrait de «décharger le ministère de la Défense du fardeau que représente le développement et le maintien des compétences et des capacités».

Ici, comme le soulignait Nuclear Intelligence Weekly en 2020, le programme de SMR de Rolls-Royce entretient une importante «symbiose avec les besoins militaires du Royaume-Uni». C'est cette dépendance qui permet aux coûts militaires (selon les termes d'un ancien dirigeant du constructeur de sous-marins BAE Systems) d'être «masqués» derrière des programmes civils.

En finançant les projets nucléaires civils, les contribuables et les consommateurs prennent en charge les usages militaires de l'énergie nucléaire par le biais de subventions et de factures plus élevées – sans que ces dépenses supplémentaires apparaissent dans les budgets de la défense.

Lorsque le gouvernement britannique nous a financés pour évaluer l'ampleur de ce transfert, nous l'avons estimé à environ 5 milliards de livres par an rien qu'au Royaume-Uni. Ces coûts échappent à la vue du public, car ils sont absorbés par les recettes provenant de factures d'électricité plus élevées et par les budgets d'agences gouvernementales supposément civiles.

Il ne s'agit pas d'un complot, mais plutôt d'une sorte de champ gravitationnel politique. Dès lors que les gouvernements considèrent l'arme nucléaire comme un marqueur de statut mondial, les financements et le soutien politique s'auto-entretiennent. Il en résulte une étrange forme de circularité : l'énergie nucléaire est justifiée par des arguments de sécurité énergétique et de coûts qui ne tiennent pas la route, mais elle est en réalité maintenue pour des raisons stratégiques qui demeurent inavouées.

Un schéma mondial

Le Royaume-Uni n'a rien d'exceptionnel, même si d'autres puissances nucléaires se montrent beaucoup plus franches. Le secrétaire américain à l'énergie, Chris Wright, a ainsi décrit l'accord nucléaire entre les États-Unis et le Royaume-Uni comme essentiel pour «sécuriser les chaînes d'approvisionnement nucléaires à travers l'Atlantique». Chaque année, environ 25 milliards de dollars (18,7 milliards de livres) transitent ainsi du nucléaire civil vers le nucléaire militaire aux États-Unis.

La Russie et la Chine sont elles aussi assez transparentes sur leurs liens indissociables entre civil et militaire. Le président français Emmanuel Macron l'a dit sans détour : «Sans nucléaire civil, pas de nucléaire militaire ; sans nucléaire militaire, pas de nucléaire civil».

Dans ces pays, les capacités nucléaires militaires sont perçues comme un moyen de rester à la «table des grands». Mettre fin à leur programme civil menacerait non seulement l'emploi et l'approvisionnement énergétique, mais aussi leur statut de grande puissance.

La prochaine frontière

Au-delà des sous-marins, le développement des «microréacteurs» ouvre de nouveaux usages militaires pour l'énergie nucléaire. Les microréacteurs sont encore plus petits et plus expérimentaux que les SMR. Bien qu'ils puissent tirer des profits en exploitant les budgets d'achats militaires, ils n'ont aucun sens d'un point de vue commercial pour l'énergie. Cependant, les microréacteurs sont considérés comme essentiels dans les plans américains pour l'alimentation sur le champ de bataille, les infrastructures spatiales et de nouvelles armes à haute puissance énergétique. Préparez-vous à les voir occuper une place croissante dans les débats «civils» – précisément parce qu'ils servent des objectifs militaires.

Quel que soit le regard porté sur ces évolutions militaires, il n'a aucun sens de prétendre qu'elles n'ont aucun lien avec le secteur nucléaire civil. Les véritables moteurs du récent accord nucléaire entre les États-Unis et le Royaume-Uni résident dans la projection de puissance militaire, et non dans la production civile d'électricité. Pourtant, cet aspect demeure absent de la plupart des débats sur la politique énergétique.

Il s'agit pourtant d'un enjeu démocratique essentiel : il faut de la transparence sur ce qui se joue réellement.