Accès libre

24.04.2024 à 19:38

L’intelligence artificielle au cœur de la multiplication des victimes civiles à Gaza

Politicoboy

Texte intégral (3737 mots)

Le média israélien +972mag a révélé l’usage déterminant de deux programmes d’intelligence artificielle (IA) lors de la campagne de bombardement contre la bande de Gaza. Le premier, Lavender, sert à sélectionner des cibles en attribuant à chaque Gazaoui une probabilité qu’il soit affilié à la branche armée du Hamas. Le second, Where’s Daddy ? (« où est Papa ? »), permet de déterminer lorsque ces cibles rejoignent leur domicile. C’est seulement à ce moment qu’une personne intervient dans la chaîne décisionnelle : vingt secondes pour valider une frappe aérienne sur la résidence, le plus souvent avec des bombes non-guidées rasant des immeubles entiers. Pour un simple homme de main, jusqu’à vingt victimes collatérales étaient autorisées. Pour un commandant, plusieurs centaines. Une rupture avec le droit de la guerre et le principe de proportionnalité, aggravée par le fait que l’IA commet de nombreuses erreurs à tous les niveaux de la chaine décisionnelle. Retour sur les implications d’une enquête précise et détaillée.

« L’accent, dans cette opération, a été mis sur l’ampleur des dégâts, pas sur la précision des frappes » déclarait le 10 octobre 2023 le porte-parole de l’armée israélienne. Pour défendre le nombre inédit de victimes civiles causé par l’offensive contre Gaza en réponse à l’attaque terroriste du 7 octobre, le gouvernement israélien et ses nombreux relais ont répété que de telles pertes résultaient de l’emploi de bouclier humain par le Hamas. Cet argument vient de voler en éclat.

Dans une longue enquête, le média indépendant israélien +972mag détaille comment l’armée a utilisé l’intelligence artificielle pour cibler délibérément et massivement des civils. Ces révélations reposent six sources militaires israéliennes. +972mag a déjà été à l’origine de révélations majeures sur le conflit et l’auteur Yuval Abraham, basé à Jérusalem, est un journaliste travaillant fréquemment pour des médias américains. Les autorités israéliennes n’ont apporté qu’un démenti partiel reposant sur des affirmations contredites par des déclarations antérieures.

En plus des sources militaires, dont certaines assument pleinement l’usage de ces outils et ont perdu des proches dans l’attaque terroriste du 7 octobre, l’enquête cite trois éléments susceptibles de corroborer ses affirmations. D’abord un livre publié en 2021 par le responsable de l’unité de renseignement d’élite « Unit 8200 » qui détaille le concept du programme d’Intelligence artificielle incriminé et justifie son usage, comme l’avait déjà rapporté le quotidien israélien Haaretz.

Deuxièmement, une conférence tenue en 2023 à l’université de Tel-Aviv par des officiers du renseignement, où ils avaient détaillé, à l’aide de PowerPoint, le fonctionnement du programme. Enfin, l’enquête note que ses conclusions permettent d’expliquer le nombre important de familles entièrement tuées lors des premières semaines de bombardements et de confirmer les révélations de CNN qui affirmaient qu’une munition sur deux employée à Gaza était une dumb bomb (« bombe idiote » ou non-guidée). Ces différents éléments expliquent le crédit apporté à l’enquête par de nombreuses grandes rédactions occidentales – malgré son peu d’écho médiatique.

Lavender : comment bombarder des cibles à leur domicile

L’enquête de Yuval Abraham est divisée en six parties qui décrivent chaque étape menant au bombardement volontaire d’un nombre disproportionné de civils, ce qui constituerait un cas flagrant de crime de guerre. Tout commence par l’identification des cibles potentielles. Elle est effectuée par Lavender, un programme informatique fonctionnant à l’aide du deep learning [« apprentissage profond » : une intelligence artificielle évolutive, modifiant ses algorithmes en fonction des données qu’elle capte NDLR].

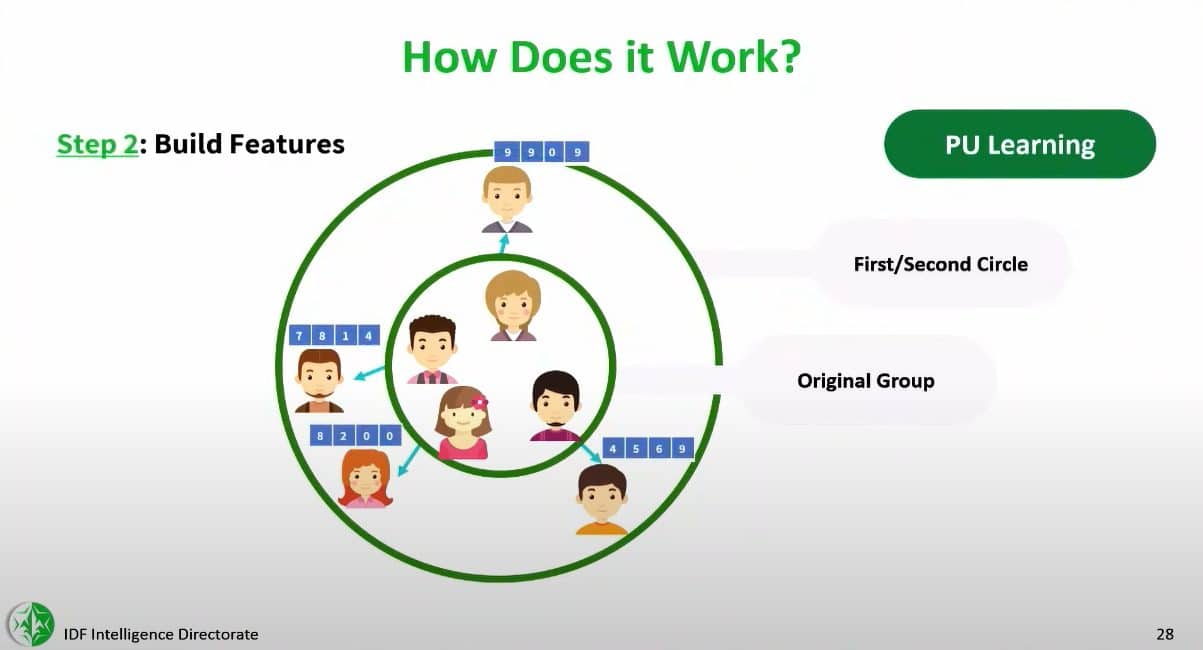

En entrée, le programme reçoit deux types de données : des très larges quantités d’information collectées sur les habitants de Gaza par le système de surveillance de masse du renseignement israélien et les éléments de profils-types de combattants du Hamas connus des services d’espionnage (quel type d’usage font-ils de leurs téléphones portables ? où se déplacent-ils ? avec qui interagissent-ils ? Etc).

Le programme a ensuite été entraîné à reconnaître les comportements et indices propres aux membres du Hamas pour les comparer à ceux collectés sur le reste de la population. Le simple fait d’être dans un groupe Whatsapp avec une personne suspecte est un motif incriminant, comme recevoir un paiement du Hamas, avoir appartenu à ce groupe par le passé ou posséder l’ancien appareil électronique d’un suspect.

L’algorithme attribue à chaque habitant de Gaza un score de 1 à 100 représentant sa probabilité d’être affilié à la branche armée du Hamas. Les services de renseignements déterminent ensuite un score minimal à atteindre pour être placé sur la kill list et devenir une cible. La limite d’âge de 17 ans ayant été supprimée, des enfants ont été ciblés, explique l’une des sources de l’enquête.

Comme pour tout programme d’intelligence artificielle de cette nature, les erreurs sont courantes. Dans au moins 10 % des cas, Lavender fiche des « innocents ». Parmi les causes fréquentes, l’enquête cite le fait d’avoir le même nom ou surnom qu’un membre de la branche armée du Hamas, ou d’interagir avec le mauvais téléphone portable. Une fois validée, la cible est placée sur l’agenda de bombardement de l’armée. Une seule intervention humaine a lieu avant d’autoriser la frappe : une vérification visant à confirmer que la cible est bien un homme (la branche armée du Hamas n’employant pas de femmes). Selon l’enquête, cette vérification prend vingt secondes tout au plus.

« Si une cible donne son téléphone à son fils, son frère ou juste un inconnu, cette personne sera bombardée dans sa maison avec toute sa famille. Ça arrive souvent. C’est comme cela qu’ont été commises les principales erreurs », selon une des sources cites par l’enquête.

L’étape suivante consiste à localiser la cible. C’est là qu’intervient un second programme d’intelligence artificielle, au nom quelque peu obscène : Where’s Daddy ? (« où est Papa ? »). Le programme utilise les différentes sources d’informations et données disponibles pour déclencher une alerte lorsque « Papa » est rentré chez lui. C’est uniquement à ce moment qu’une frappe aérienne est ordonnée. Il peut s’écouler de nombreuses heures entre l’ordre et l’exécution de la frappe. La cible a parfois quitté son logement lorsque le bâtiment est détruit, tuant les voisins et la famille sans supprimer le suspect.

La principale raison citée pour frapper les cibles à leur domicile, où aucune activité militaire n’a lieu, est qu’il est plus facile de les localiser dans leurs logements qu’à l’extérieur du domicile familial. Cela découle du fait que chaque Gazaoui possédait une adresse physique associée à son profil. Bien entendu, si l’adresse n’a pas été mise à jour ou que l’individu a déménagé, des « innocents » et leurs voisins périssent pour rien, précise une source citée par l’enquête.

Where’s Daddy ? : bombes non-guidées et dommages collatéraux assumés

L’armée israélienne dispose de différents types de bombes et munitions. Les missiles tirés depuis les drones sont capables d’une très haute précision et causent des dégâts limités, ce qui explique pourquoi ils sont en priorité utilisés contre des véhicules ou des piétons. Les bombes conventionnelles guidées permettent de cibler un appartement précis, dans un immeuble ou un étage particulier d’une maison. Les bombes non-guidées et « anti-bunker » d’une tonne, quant à elles, disposent d’un pouvoir de destruction largement supérieur. Au minimum, elles permettent de raser un bâtiment entier. Les plus grosses peuvent sévèrement endommager un pâté de maisons.

L’essentiel des cibles identifiées par Lavender étaient des simples militants ou combattants du Hamas sans responsabilités. Pour éviter de « gaspiller » des munitions précieuses et coûteuses sur de la « piétaille », ces cibles ont été systématiquement visées avec des bombes non-guidées. Ce qui signifie que pour tuer un membre présumé du Hamas, une maison ou un appartement entier est détruit, ensevelissant sous les décombres la famille et les voisins de la cible.

L’enquête révèle que l’armée acceptait de tuer entre dix et vingt « innocents » par membre présumé du Hamas. Pour les commandants, responsables et officiers, ce chiffre pouvait monter à plusieurs centaines. Ainsi, pour tuer Ayman Nofal, le commandant du bataillon de Gaza centre, un quartier entier a été détruit par plusieurs frappes simultanées (entre seize et dix-huit maisons rasées). Pas moins de trois cents pertes civiles avaient été autorisées.

Pour tuer Oussama Ben Laden, Yuval Abraham note que les États-Unis avaient fixé la limite à trente pertes civiles. En Afghanistan et en Irak, les dommages collatéraux autorisés pour supprimer un membre de base des organisations terroristes étaient « simplement de zéro ».

L’autre problème lié à cette tolérance inédite pour les pertes civiles et qu’elles sont souvent mal estimées. Les femmes et enfants ne faisant pas l’objet de traçage aussi précis, le nombre de victimes potentielles retenu avant d’autoriser une frappe s’est fréquemment révélé inférieur à la réalité. L’armée israélienne a ainsi pu valider des frappes censées tuer un membre du Hamas et quinze femmes et enfants avant de raser un immeuble où se trouvaient deux fois plus de civils. Par exemple, en partant du principe qu’un bâtiment situé dans une zone où des consignes d’évacuations avaient été données était vide ou à moitié vide, sans se donner la peine de vérifier. Et pour ces troupes de base, l’armée ne procédait à aucune vérification post-frappes pour évaluer les dégâts et confirmer la mort de la cible.

« Uniquement lorsque c’est un haut responsable du Hamas, on suit les procédures d’évaluation post-bombardement. Pour le reste on s’en fout. On reçoit un rapport de l’armée qui confirme si le bâtiment a été détruit, et c’est tout. Nous n’avons aucune idée du niveau des dégâts collatéraux, nous passons immédiatement à la cible suivante. L’objectif est de générer autant de cibles que possible aussi vite que possible. »

Source militaire israélienne citée par l’enquête de +972mag.

Après plusieurs semaines de bombardements intensifs, le tarissement des cibles potentielles a poussé les autorités israéliennes à abaisser le seuil à partir duquel le programme Lavender plaçait une personne sur la kill list. Cet algorithme a également été entraîné à partir des profils de simples fonctionnaires apparentés au Hamas mais ne faisant pas partie de la branche armée, ce qui a considérablement accru le risque pour tout civil gazaoui de se retrouver sur la liste, puisque les comportements suspects ne se limitaient plus à ceux des combattants et leurs soutiens directs.

Au paroxysme de la campagne de bombardement, qui aurait fait plus de 15 000 morts en quatre semaines, Lavender a placé plus de 37 000 personnes sur sa kill list.

Des implications multiples et préoccupantes

La lecture de l’enquête et les citations des sources dépeignent une profonde perte de repère des autorités et membres de l’armée israélienne, tout en témoignant d’une déshumanisation totale des Palestiniens. Un comble pour une guerre présentée comme un combat existentiel entre la civilisation et la barbarie.

Si l’on résume : un programme ayant recours à l’intelligence artificielle est chargé de générer des cibles sur la base de critères extrêmement vagues, en croisant des données collectées par un gigantesque système de surveillance de masse à la légalité douteuse. Selon ses propres critères contestés en interne, Lavender se trompait au moins une fois sur dix. Cela n’a pas empêché de transmettre la liste de personnes à éliminer à un second programme, Where’s Daddy ?, reposant lui aussi sur des données incomplètes et pas toujours à jour, pour déterminer quand une cible regagnait son domicile. Quelques heures plus tard, une bombe non-guidée d’une tonne était larguée sur la maison où la cible pouvait ne plus se trouver, tuant les habitants du dit immeuble sans distinction. Ces frappes étaient autorisées après un contrôle prenant moins de vingt secondes. Aucune vérification visant à confirmer l’étendue des pertes civiles ou la mort de la cible n’était ensuite menée.

Le choix de viser les combattants présumés du Hamas chez eux, au milieu de leurs familles et de leurs voisins plutôt que lorsqu’ils sont à l’extérieur de leur domicile – et occupés à des activités militaires -, fait voler en éclat l’idée que les pertes civils records seraient dues à l’emploi de boucliers humains par le Hamas. Bien au contraire : c’est l’armée israélienne qui attendait que ses cibles soient au milieu de civils pour les frapper avec des bombes non-guidées et surdimensionnées.

L’autre point sur lequel insiste Yuval Abraham est la contradiction dans l’approche de l’armée israélienne. Pour justifier l’emploi d’armes non-guidées, la quasi-absence de vérification de l’identité de la cible avant la frappe et l’absence d’évaluation de celle-ci après le bombardement, les militaires citent le manque d’intérêt stratégique de la cible. Les bombes guidées et le temps des officiers étaient trop précieux pour être gaspillé sur ce type de cibles à faible valeur militaire. Mais dans ce cas, comment justifier autant de dommages collatéraux sans violer le principe de proportionnalité situé au coeur de droit de la guerre ?

Les révélations posent des problèmes plus larges. La quasi-suppression du facteur humain dans la décision de tuer est généralement considérée comme une ligne rouge, avec laquelle l’État hébreu semble flirter dangereusement. Un élément d’autant plus inquiétant que le gouvernement israélien a déployé des robots en forme de chiens à Gaza et fait un usage massif de drones de combat. En parallèle, le complexe militaro-industriel israélien met en avant l’utilisation de ces outils technologiques sur le champ de bataille comme autant d’arguments de vente à l’international.

Enfin, les révélations de +972mag mentionnent l’emploi de donnée Whatsapp pour cibler des Palestiniens, certains pouvant être simplement pris pour cible pour s’être retrouvé dans un groupe Whatsapp avec un membre du Hamas. Dans le contexte des bombardements indiscriminés et du siège total imposé à Gaza, les groupes de voisins se retrouvant sur des boucles Whatsapp pour coordonner l’entraide ont certainement éclos un peu partout, aggravant le risque de se trouver dans le mauvais groupe au mauvais moment. Ce qui rend l’usage de ces données pour cibler des suspects encore plus problématique. Plus largement, cette enquête pose la question de la collaboration de Meta (ex-Facebook) avec le gouvernement israélien, que soutiennent activement les principaux dirigeants de l’entreprise, et qui ne semble manifestement pas préoccupée par la sécurité de ses clients.

L’intelligence artificielle à l’heure du « risque de génocide »

Le système décrit dans l’enquête de Yuval Abraham n’est plus utilisé à Gaza. Une des principales raisons citées par ce dernier est le fait qu’il n’est plus possible de lier un suspect à sa résidence, l’écrasante majorité des maisons ayant été détruites et leurs habitants transformés en réfugiés. Mais alors que les États-Unis viennent d’approuver une offensive sur Rafah contre la promesse qu’Israël ne réplique pas trop sévèrement contre l’Iran, Yuval Abraham craint que le système soit de nouveau déployé contre la seule ville encore debout, où se sont réfugiés plus d’un million de Palestiniens. Trois mois après l’arrêt de la Cour internationale de justice (CIJ), qui pointe un « risque de génocide » à Gaza, se dirige-t-on vers un crime majeur assisté par ordinateur ?

- GÉNÉRALISTES

- Basta

- Blast

- L'Autre Quotidien

- Alternatives Eco.

- La Croix

- Euronews

- Le Figaro

- France 24

- FTVI

- HuffPost

- L'Humanité

- LCP

- Le Media

- Le Monde

- Libération

- Mediapart

- La Tribune

- EUROPE

- Courrier Europe Centle

- Euractiv

- Toute l'Europe

- INTERNATIONAL

- Equaltimes

- CADTM

- Courrier International

- Global Voices

- Info Asie

- Inkyfada

- I.R.I.S

- Jeune Afrique

- Kurdistan au féminin

- N-Y Times

- Orient XXI

- Of AFP

- Rojava I.C

- OSINT / INVESTIGATION

- OFF Investigation

- OpenFacto°

- Bellingcat

- Disclose

- G.I.J.N

- MÉDIAS D'OPINION

- AOC

- Au Poste

- Cause Commune

- CrimethInc.

- Issues

- Les Jours

- Le Monde Moderne

- LVSL

- Marianne

- Médias Libres

- Quartier Général

- Rapports de force

- Reflets

- Rézo

- StreetPress

- OBSERVATOIRES

- Armements

- Acrimed

- Catastrophes naturelles

- Conspis

- Culture

- Extrême-droite

- Human Rights

- Inégalités

- Information

- Internet actu ✝

- Justice fiscale

- Liberté de création

- Multinationales

- Situationnisme

- Sondages

- Street-Médics

- Routes de la Soie

- Vrai ou Fake ?